Материалы по тегу: dpu

|

26.02.2025 [23:40], Владимир Мироненко

Неожиданный союз: Cisco и NVIDIA поделятся друг с другом сетевыми чипами и решениями для ИИ-инфраструктурCisco объявила о расширенном партнёрстве с NVIDIA. Совместно компании намерены предоставить заказчикам гибкость выбора сетевых инфраструктур для обслуживания всё более интенсивных рабочих нагрузках ИИ и высокую производительность обмена данными между и внутри ЦОД, а также между облаками и между пользователями. По словам Чака Роббинса (Chuck Robbins), председателя и генерального директора Cisco, сотрудничество «устранит барьеры для клиентов» и позволит им «оптимизировать свои инвестиции в инфраструктуру, чтобы раскрыть потенциал ИИ». Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) добавил, что ИИ развивается со «скоростью света», отметив преобразующий потенциал объединения глобального охвата Cisco с оптимизированными для ИИ Ethernet-решениями NVIDIA, что поможет компаниям по всему миру создать современную ИИ-инфраструктуру. В рамках расширенного сотрудничества сетевая платформа NVIDIA Spectrum-X Ethernet на базе ASIC Cisco и NVIDIA послужит основой для многих корпоративных рабочих нагрузок ИИ. Использование унифицированной архитектуры, которая упрощает интеграцию и стандартизацию технологий Cisco и NVIDIA в корпоративных средах, позволит клиентам оптимизировать свои инвестиции в инфраструктуру, используя имеющиеся инструменты и процессы управления, охватывающие разные виды сетей. Партнёрство двух компаний позволит их клиентам получать выгоду от текущих и будущих технологических достижений платформы NVIDIA Spectrum-X, таких как адаптивная маршрутизация, телеметрия, управление заторами и низкая задержка, а также предоставит им доступ к более широкому портфелю сетевых решений, безопасности и цифровой устойчивости Cisco, включая платформу Splunk. Поскольку компании развивают возможности ИИ и обучают модели на собственных данных, наличие комплексной стратегии безопасности становится критически важным, отмечено в пресс-релизе. Если отбросить красивые маркетинговые слова, то новое сотрудничество сводится к двум основным пунктам. Во-первых, в состав платформы NVIDIA Spectrum-X теперь будут входить решения на базе ASIC Cisco Silicon One и DPU NVIDIA SuperNIC, причём допущены к платформе будут только чипы Cisco. У самой Cisco уже есть похожее решение на базе DPU Pensando от AMD. Во-вторых, Cisco портирует на ASIC NVIDIA Spectrum фирменную сетевую ОС NX-OS, что позволит стандартизировать сетевые инфраструктуры в ЦОД, организовать единую точку управления всей сетью и интегрировать решения NVIDIA со стеком Nexus и с другими сервисами и продуктами Cisco, включая Nexus Dashboard, Nexus Hyperfabric AI, UCS и др. Cisco сама будет выпускать продукты на базе ASIC NVIDIA Spectrum. Сотрудничество Cisco и NVIDIA распространяется на совместную разработку эталонных архитектур, включая NVIDIA Cloud Partner (NCP) и Enterprise Reference Architectures. Также Cisco и NVIDIA планируют продолжить сотрудничество для решения важных задач, таких как управление перегрузками и балансировка, и других эксплуатационных проблем, с которыми сталкиваются предприятия при масштабировании рабочих нагрузок ИИ. Любопытно, что NVIDIA в конце концов присоединилась к консорциуму Ultra Ethernet, основанному Arista, Broadcom, Cisco и др. с целью создания современного интерконнекта для HCP- и ИИ-нагрузок на базе Ethernet. Фактически же консорциум во многом призван создать работающую альтернативу технологии Infiniband, которая монопольно контролируется и продвигается NVIDIA.

12.02.2025 [16:44], Сергей Карасёв

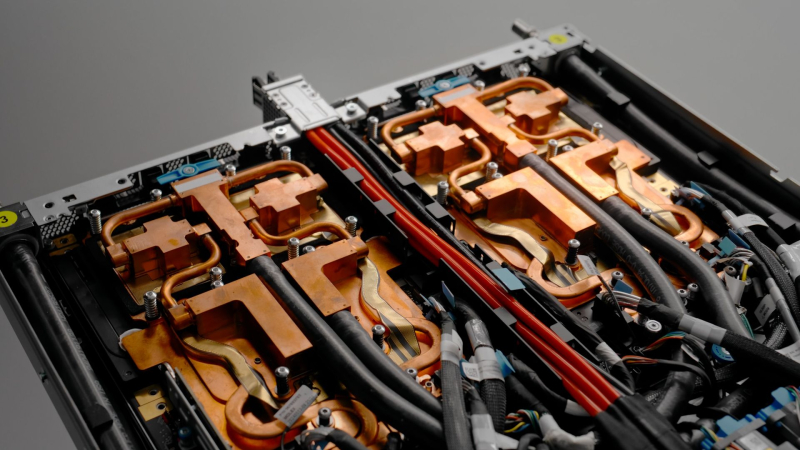

Cisco представила умные коммутаторы N9300 на базе DPU AMD Pensando и ASIC Silicon One E100Компания Cisco анонсировала интеллектуальные коммутаторы семейства N9300 Series Smart Switches, которые, как утверждаются, позволяют переосмыслить подход к обеспечению безопасности в ИИ ЦОД путём интеграции средств защиты непосредственно в сетевую структуру. В серию N9300 вошли модели Cisco 9324C-SE1U и Cisco 9348Y2C6D-SE1U типоразмера 1U. Они оснащены неназванным процессором Intel с 16 вычислительными ядрами, 96 Гбайт системной памяти и SSD вместимостью 480 Гбайт. Есть порт USB 3.0, а также порты управления RJ-45 и SFP (1 × 1GbE SFP у первой из названных версий и 2 × 10GbE SFP+ у второй). Коммутаторы несут на борту ASIC Cisco Silicon One E100, которая отвечает за сетевые функции. Кроме того, имеются сетевые сопроцессоры (DPU) AMD Pensando второго поколения: четыре чипа Elba у модели Cisco 9324C-SE1U и два чипа Giglio у модификации Cisco 9348Y2C6D-SE1U. Эти DPU отвечают за такие задачи, как распределение данных, балансировка нагрузки, обеспечение безопасности, шифрование и пр. По заявлениям Cisco, трафик интеллектуально перенаправляется между ASIC и DPU для достижения оптимальной производительности. Такой подход обеспечивает экономию средств благодаря консолидации оборудования, снижению энергопотребления и упрощению сетевой инфраструктуры. Клиенты получают возможность масштабировать сервисы и быстро адаптироваться к меняющимся бизнес-потребностям без необходимости в каких-либо дополнительных аппаратных решениях. В составе коммутаторов DPU обеспечивают сервисную пропускную способность до 800 Гбит/с. Устройство Cisco 9324C-SE1U оснащено 24 портами 100G, а ToR-вариант Cisco 9348Y2C6D-SE1U — 48 портами 25G, двумя портами 100G и шестью портами 400G. За охлаждение отвечают шесть вентиляторов, а питание обеспечивает блок мощностью 1400 Вт. Диапазон рабочих температур — от 0 до +40 °C. На устройствах применяется программная платформа Cisco NX-OS. Задействована фирменная система безопасности Cisco Hypershield на основе ИИ. По заявлениям разработчика, Hypershield интегрируется в коммутационный уровень, позволяя операторам дата-центров создавать защитный «микропериметр» вокруг каждой службы. Продажи младшей модели коммутатора начнутся предстоящей весной, старшей — летом.

09.02.2025 [13:32], Сергей Карасёв

Kalray продала подразделение Data Acceleration Platform на фоне падения годовой выручкиБазирующийся во Франции компания Kalray, которая занимается разработкой сетевых сопроцессоров (DPU), в 2024 году зафиксировала сокращение выручки на 3,9 %: €24,83 млн против €25,83 млн в 2023-м. На этом фоне Kalray объявила о продаже подразделения Data Acceleration Platform. Как сообщил Эрик Баиссус (Eric Baissus), председатель совета директоров Kalray, отрицательная динамика обусловлена двумя ключевыми факторами: макроэкономическая ситуация и высокая концентрация рынка в руках нескольких крупных игроков, ресурсы которых значительно превосходят возможности Kalray. В 2024 году в общем объёме выручки Kalray около 85 % пришлось на корпоративные решения (платформа управления данными NGenea), а оставшиеся 15 % — на аппаратные ускорители. В географическом плане львиную долю выручки обеспечили США — примерно 49 %. Вклад Европы (включая Великобританию) составил 42 %, тогда как все прочие регионы мира вместе взятые принесли 9 %. Kalray говорит о значительном снижении показателя EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений), который оказался на уровне €8 млн. Это снижение объясняется прежде всего более низкой маржой в связи с экономической обстановкой и значительными инвестициями, сделанными в начале 2024 года, в частности, в разработку чипов нового поколения Dolomites.

Источник изображения: Kalray Что касается подразделения Data Acceleration Platform, то его покупателем стала американская компания DataCore Software. Общая сумма сделки может достигнуть $20 млн. Она включает в себя первоначальную выплату в размере $12,5 млн, а также контракт на оказание услуг на сумму $2,5 млн, счёт по которому будет выставлен в 2025 финансовом году. Кроме того, условиями сделки оговорён потенциальный доход до $5 млн, который зависит от коммерческих результатов DataCore по продвижению приобретённых продуктов NGenea (выплаты будут осуществлены в I половине 2026 года).

17.01.2025 [00:06], Владимир Мироненко

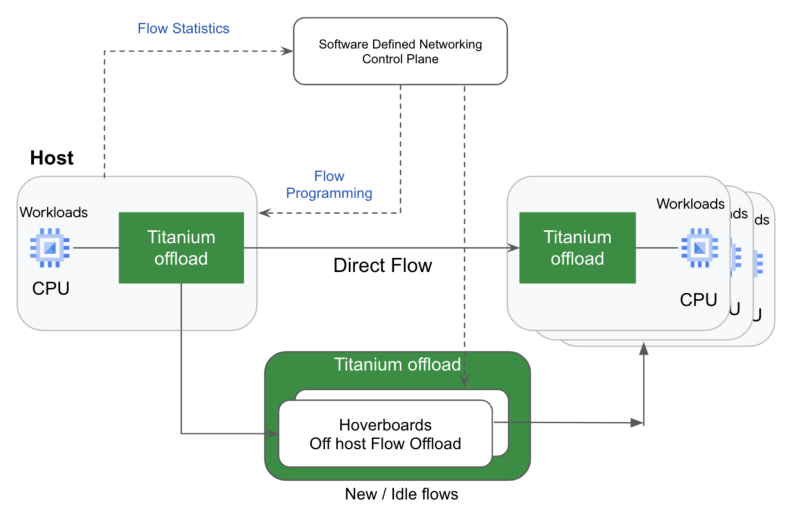

Google представила инстансы C4A с фирменными Titanium SSD и Arm-процессорами AxiomGoogle объявила о доступности инстансов C4A с кастомными накопителями Titanium SSD, специально разработанными для облачных нагрузок, требующих обработки данных в реальном времени, с низкой задержкой и высокой пропускной способностью хранилища. Titanium SSD в составе инстансов C4A, построенных на Arm-процессорах Axion собственной разработки, обеспечивают производительность до 2,4 млн IOPS на операциях случайного чтения, до 10,4 ГиБ/с пропускной способности чтения и до 35 % более низкую задержку доступа по сравнению с SSD предыдущего поколения. Titanium SSD — первое поколение SSD Google, интегрированных с DPU Titanium, обеспечивающей повышение производительности выполнения приложений за счет разгрузки операций по работе с сетью и хранилищем, а также управления. Семейство инстансов C4A на базе процессоров Google Axion обеспечивает до 65 % выше производительность и до 60 % лучше энергоэффективность по сравнению с аналогичными инстансами текущего поколения на базе архитектуры x86. Как сообщает Google, C4A с Titanium SSD обеспечивают самое выгодное в отрасли соотношение цены и производительности для широкого спектра совместимых с Arm универсальных рабочих нагрузок, таких как высокопроизводительные базы данных, аналитические системы, поисковые и рабочие нагрузки, которые выигрывают от кеширования и использования локального хранилища. Конфигурация C4A с Titanium SSD включает до 72 vCPU, 576 Гбайт памяти и 6 Тбайт локального хранилища в двух вариантах — Standard (4 Гбайт RAM на vCPU) и High-memory (8 Гбайт/vCPU). Сетевое подключение C4A имеет пропускную способностью до 50 Гбит/с или до 100 Гбит/с. Инстансы также поддерживают новейшее поколение хранилища Balanced и Extreme Hyperdisk с производительностью до 350 тыс. IOPS и пропускной способностью до 5 Гбайт/с на виртуальную машину. Клиенты Google Cloud могут использовать C4A с Titanium SSD для сервисов Compute Engine, Google Kubernetes Engine (GKE), Batch, Dataproc и т.д. Инстансы C4A теперь также доступны в версии превью в Dataflow с поддержкой Cloud SQL, AlloyDB и других сервисов, которые появятся в ближайшее время. C4A доступны по запросу, в качестве спотовых и зарезервированных инстансов, со скидками за обязательное использование (CUD) и FlexCUD в регионах us-central1 (Айова), us-east4 (Вирджиния), us-east1 (Южная Каролина), europe-west1 (Бельгия), europe-west4 (Нидерланды), europe-west3 (Франкфурт), europe-west2 (Лондон) и asia-southeast1 (Сингапур). Вскоре они появятся в других регионах.

24.11.2024 [09:54], Сергей Карасёв

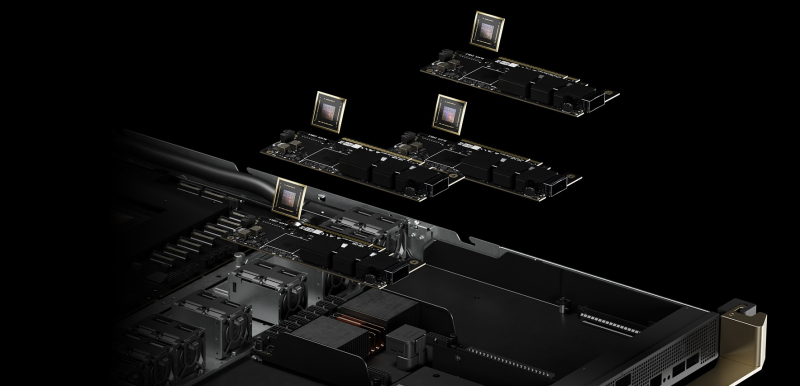

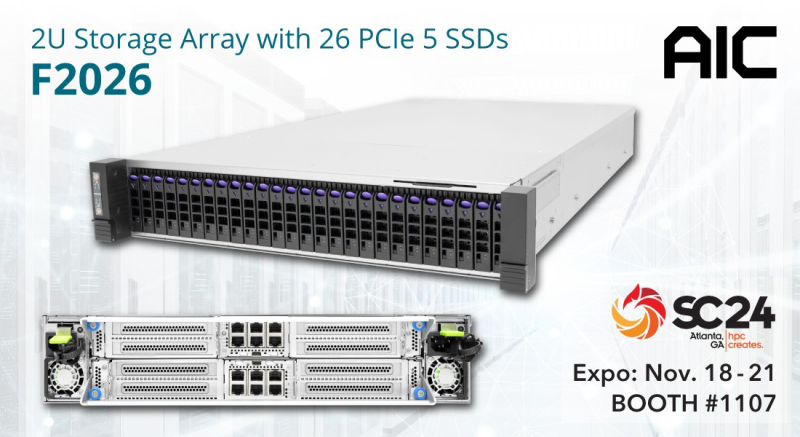

AIC и ScaleFlux представили JBOF-массив на основе NVIDIA BlueField-3Компании AIC и ScaleFlux анонсировали систему F2026 Inference AI для ресурсоёмких приложений ИИ с интенсивным использованием данных. Решение выполнено в форм-факторе 2U. В оснащение входят два DPU NVIDIA BlueField-3, которые могут работать на скорости до 400 Гбит/с. Эти изделия способны ускорять различные сетевые функции, а также операции, связанные с передачей и обработкой больших массивов информации. Во фронтальной части F2026 Inference AI расположены 26 отсеков для высокопроизводительных вычислительных SSD семейства ScaleFlux CSD5000 (U.2). Накопители с интерфейсом PCIe 5.0 (NVMe 2.0b) имеют вместимость 3,84, 7,68, 15,36, 30,72, 61,44 и 122,88 Тбайт, а с учётом компрессии эффективная ёмкость может достигать приблизительно 256 Тбайт. Реализована поддержка TCG Opal 2.02 и шифрования AES-256, NVMe Thin Provisioned Namespaces Virtualization (48PF/32VF), ZNS, FDP. Платформа F2026 Inference AI представляет собой JBOF-массив, способный на сегодняшний день хранить 1,6 Пбайт информации (эффективный объём). В следующем году показатель будет доведён до 6,6 Пбайт. Утверждается, что сочетание BlueField-3 и энергоэффективной технологии хранения ScaleFlux помогает минимизировать энергопотребление, а также повысить долговечность и надёжность. Результаты проведённого тестирования F2026 Inference AI демонстрируют пропускную способность при чтении до 59,49 Гбайт/с, при записи — более 74,52 Гбайт/с. Благодаря объединению средств хранения, сетевых функций и инструментов безопасности в одну систему достигается снижение эксплуатационных расходов, что позволяет оптимизировать совокупную стоимость владения (TCO). Новинка является лишь одной из вариаций решений на базе F2026. Платформа, в частности, поддерживает работу других DPU, включая Kalray 200 и Chelsio T7. Также упоминается вариант шасси на 32 накопителя EDSFF E3.S/E3.L.

20.11.2024 [01:40], Владимир Мироненко

Microsoft представила кастомные чипы Azure Boost DPU и Integrated HSM, уникальный AMD EPYC 9V64H с HBM и собственный вариант NVIDIA GB200 NVL72

amd

azure arc

azure stack

dpu

epyc

gb200

hardware

hbm

hpc

microsoft

microsoft azure

nvidia

гибридное облако

ии

информационная безопасность

облако

ускоритель

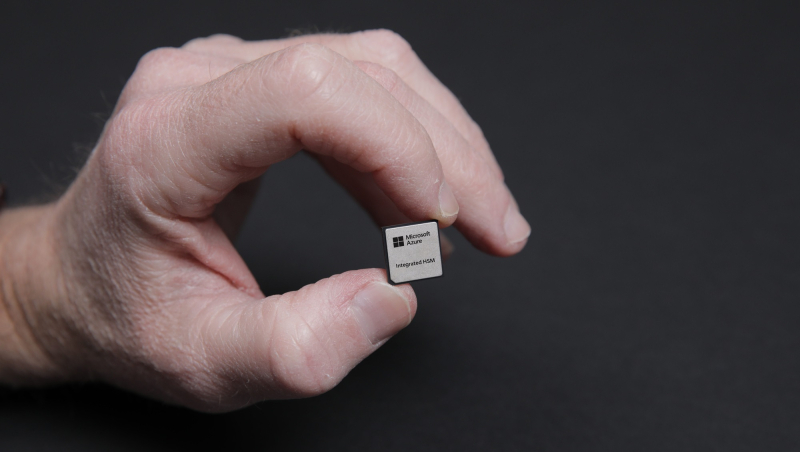

Microsoft представила на конференции Microsoft Ignite новые специализированные чипы Azure Boost DPU и Azure integrated Hardware Security Module (HSM), предназначенные для использования в ЦОД с целью поддержки рабочих нагрузок в облаке Azure и повышения безопасности.

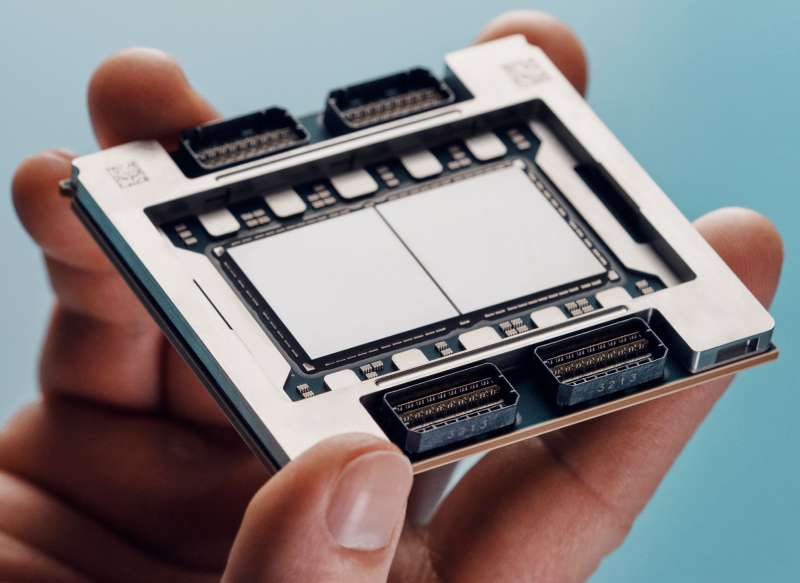

Источник изображений: Microsoft Чтобы снизить зависимость от поставок чипов сторонних компаний, Microsoft занимается разработкой собственных решений для ЦОД. Например, на прошлогодней конференции Microsoft Ignite компания представила Arm-процессор Azure Cobalt 100 и ИИ-ускоритель Azure Maia 100 собственной разработки. Azure Boost DPU включает специализированные ускорители для работы с сетью и хранилищем, а также предлагает функции безопасности. Так, скорость работы с хранилищем у будущих инстансов Azure будет вчетверо выше, чем у нынешних, а энергоэффективность при этом вырастет втрое. Не вызывает сомнений, что в разработке Azure Boost DPU участвовали инженеры Fungible, производителя DPU, который Microsoft приобрела в декабре прошлого года. Как отмечает TechCrunch, в последние годы популярность DPU резко увеличилась. AWS разработала уже несколько поколений Nitro, Google совместно с Intel создала IPU, AMD предлагает DPU Pensando, а NVIDIA — BlueField. Есть и другие нишевые игроки. Согласно оценкам Allied Analytics, рынок чипов DPU может составить к 2031 году $5,5 млрд. Ещё один кастомный чип — Azure integrated Hardware Security Module (HSM) — отвечает за хранение цифровых криптографических подписей и ключей шифрования в защищённом модуле «без ущерба для производительности или увеличения задержки». «Azure Integrated HSM будет устанавливаться на каждом новом сервере в ЦОД Microsoft, начиная со следующего года, чтобы повысить защиту всего парка оборудования Azure как для конфиденциальных, так и для общих рабочих нагрузок», — заявила Microsoft. Azure Integrated HSM работает со всем стеком Azure, обеспечивая сквозную безопасность и защиту. Microsoft также объявила, что задействует ускорители NVIDIA Blackwell и кастомные серверные процессоры AMD EPYC. Так, инстансы Azure ND GB200 v6 будут использовать суперускорители NVIDIA GB200 NVL 72 в собственном исполнении Microsoft, а интерконнект Quantum InfiniBand позволит объединить десятки тысяч ускорителей Blackwell. Компания стремительно наращивает закупки этих систем. А инстансы Azure HBv5 получат уникальные 88-ядерные AMD EPYC 9V64H с памятью HBM, которые будут доступны только в облаке Azure. Каждый инстанс включает четыре таких CPU и до 450 Гбайт памяти с агрегированной пропускной способностью 6,9 Тбайт/с. Кроме того, Microsoft анонсировала новое решение Azure Local, которое заменит семейство Azure Stack. Azure Local — это облачная гибридная инфраструктурная платформа, поддерживаемая Azure Arc, которая объединяет локальные среды с «большим» облаком Azure. По словам компании, клиенты получат обновление до Azure Local в автоматическом режиме. Наконец, Microsoft анонсировала новые возможности в Azure AI Foundry, новой «унифицированной» платформе приложений ИИ, где организации смогут проектировать, настраивать и управлять своими приложениями и агентами ИИ. В числе новых опций — Azure AI Foundry SDK (пока в виде превью).

21.10.2024 [13:21], Сергей Карасёв

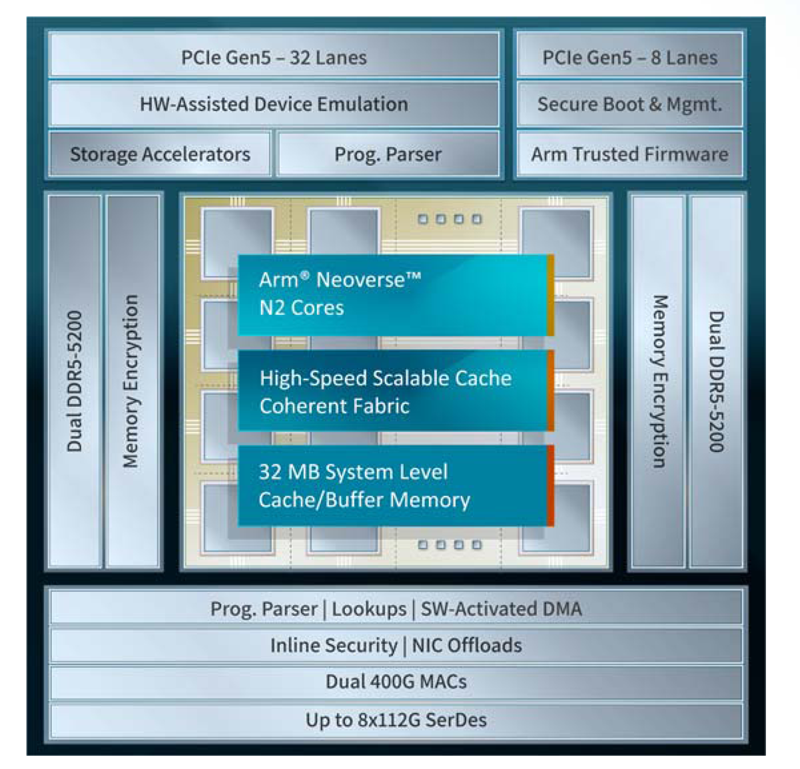

Xsight Labs представила 400GbE DPU серии E1Компания Xsight Labs анонсировала, как утверждается, самую производительную на рынке программно-определяемую «систему на чипе» (SoC), предназначенную для создания DPU с поддержкой RoCEv2 и UET (Ultra Ethernet Transport). Изделие под названием E1 станет доступно заказчикам для тестирования во II квартале 2025 года. Чип будет предлагаться в модификациях E1-32 и E1-64. Первая содержит 32 ядра Arm Neoverse N2 v9.0-A, имеет 16 Мбайт кеша и использует конфигурацию памяти 2 × DDR5-5200. Показатель TDP равен 65 Вт. У второго варианта количество ядер составляет 64, размер конфигурируемого кеша/буфера — 32 Мбайт. Конфигурация памяти — 4 × DDR5-5200, величина TDP — 90 Вт. В обоих случаях используется полное шифрование памяти на лету (AES-XTS). Новинка использует до восьми блоков SerDes, обеспечивая сетевую пропускную способность до 800 Гбит/с. Возможны следующие конфигурации портов: 2 × 400GbE, 4 × 200GbE и 8 × 100/50/25/10GbE. Заявлена производительность на уровне 200 Mpps и 20 млн подключений в секунду. Также есть пара 1GbE-портов для внешнего управления. Доступны программируемые DMA-движки (до 3 Тбит/с) и разгрузка типовых операций, включая шифрование AES-GCM (для IPSec) и AES-XTS (для СХД) на лету.

Источник изображения: Xsight Labs Есть восемь двухрежимных контроллеров и 40 (32+8) линий PCIe 5.0, а также поддержка P2P-коммутации PCIe. Упомянуты поддержка до четырёх хостов/устройств, SR-IOV (64K PF/VF), а также программная эмуляция и пространства MMIO. Реализована поддержка интерфейсов I2C/I3C/SMBus, SPI/QSPI, SMI, UART, GPIO, 1588 RTC, JTAG. Говорится о высоком уровне обеспечения безопасности: возможно создание изолированных и защищённых сред, которые аутентифицируют каждого клиента. Поддерживается функция безопасной загрузки UEFI Secure Boot with Arm Trusted Firmware (TF-A). Заявлена возможность работы «из коробки» в Debian, Ubuntu, SONiC и Lightbits Labs LightOS, а также совместимость с Netdev, VirtIO, XNA/XDP и DPDK/SPDK. В частности, возможна эмуляция NVMe-, RDMA- и сетевых устройств. Изделие E1 производится по 5-нм технологии TSMC. Оно, как утверждает Xsight Labs, обеспечивает беспрецедентную энергоэффективность и вычислительные возможности, устанавливая новый стандарт производительности для DPU SoC. Новинка ориентирована на облачные платформы и периферийные дата-центры, поддерживающие интенсивные ИИ-нагрузки. DPU позволяет создавать SDN/SDS-решения, брандмауэры, NVMe-oF СХД, вычислительные хранилища, CDN-платформы, балансировщики и т.п.

11.10.2024 [11:55], Сергей Карасёв

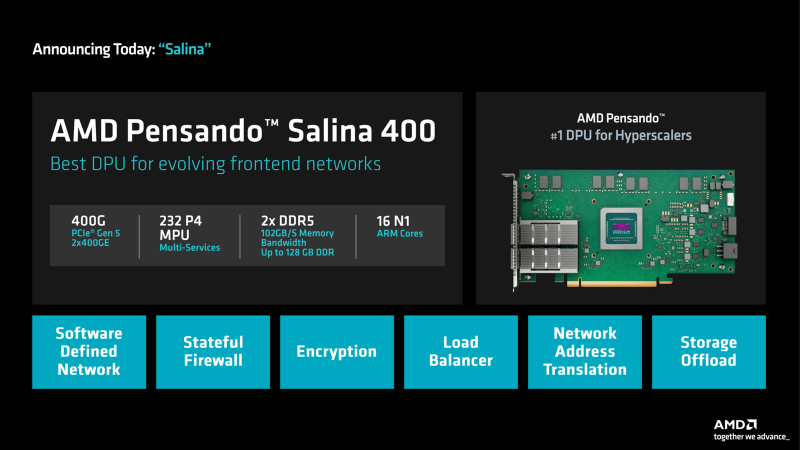

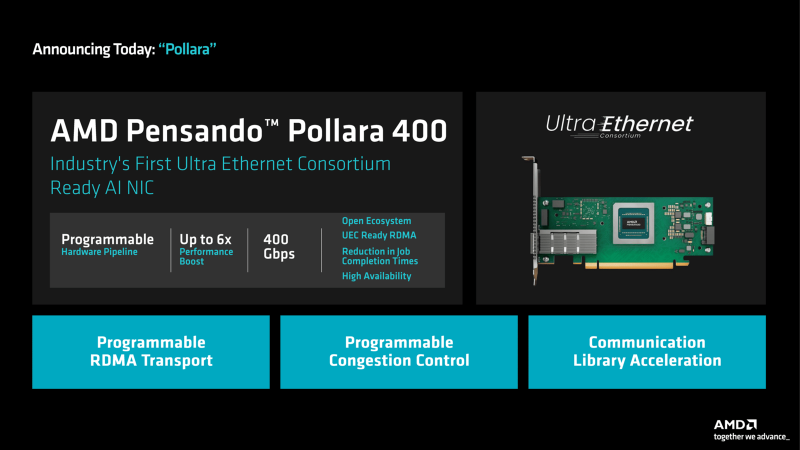

DPU + UEC: AMD представила 400G-адаптеры Pensando Salina и PollaraКомпания AMD анонсировала сетевой сопроцессор (DPU) третьего поколения Pensando Salina 400, а также сетевую карту Pensando Pollara 400, ориентированную на применение в составе ИИ-систем. Образцы изделий станут доступны заказчикам в текущем квартале, тогда как массовые продажи начнутся в I половине 2025 года. Решение Pensando Salina 400, рассчитанное на сетевые кластеры гиперскейлеров, обеспечивает пропускную способность до 400 Гбит/с. Утверждается, что по сравнению с DPU предыдущего поколения производительность увеличилась в два раза. Устройство Pensando Salina 400 выполнено в виде карты PCIe 5.0 с двумя портами 400GbE. Задействованы 16 ядер Arm Neoverse-N1 и 232 ядра P4 MPU. Объём памяти DDR5 достигает 128 Гбайт, её пропускная способность — 102 Гбайт/с. Новинка будет применяться в том числе в интеллектуальных коммутаторах, предназначенных для решения различных задач во внешней зоне: это может быть распределение данных, балансировка нагрузки, обеспечение безопасности, шифрование и пр. В свою очередь, Pensando Pollara 400 представляет собой интеллектуальный сетевой адаптер с одним портом 400 Гбит/с. Изделие выполнено на том же чипе, что и Pensando Salina 400. Компания AMD называет Pensando Pollara 400 первой в мире сетевой картой для приложений ИИ, соответствующей стандартам, которые определяет консорциум Ultra Ethernet (UEC). Примечательно, что первые спецификации консорциум намерен представить не раньше конца текущего года. Цель UEC — разработка основанной на Ethernet открытой высокопроизводительной архитектуры с полным коммуникационным стеком, отвечающей задачам современных рабочих нагрузок ИИ и НРС. Благодаря программируемой архитектуре P4 адаптер можно настраивать с учётом конкретных требований. В целом, как утверждается, новинка является мощным решением для повышения производительности рабочих нагрузок ИИ и улучшения надёжности сети.

08.09.2024 [23:18], Владимир Мироненко

Стартап Xockets обвинил NVIDIA и Microsoft в нарушении патентов на DPU и требует запретить выпуск ИИ-систем на базе BlackwellТехасский стартап Xockets подал в Окружной суд США по Западному округу Техаса в городе Уэйко (Waco) на NVIDIA и Microsoft, обвинив их в нарушении антимонопольного законодательства и патентных прав. Сам иск был опубликован на этой неделе на сайте Xockets. Согласно иску, NVIDIA незаконно использунт запатентованную Xockets технологию нового класса процессоров — Data Processing Unit (DPU), изобретённую соучредителем Xockets Парином Далалом (Parin Dalal) в 2012 году. Эта технология повышает эффективность облачной инфраструктуры, позволяя разгружать CPU, перенося на DPU рабочие нагрузки с интенсивным использованием данных, такие как обеспечение безопасности, обслуживание сетей и хранилищ, которые делают возможными распределённые вычисления в облачных ЦОД, а также обучение больших языковых моделей. Xockets подала свою первую патентную заявку на DPU в мае 2012 года и теперь владеет несколькими патентами, которые касаются её архитектуры и компоненты DPU. Как утверждает Xockets, технология является основополагающей для систем ИИ на базе ускорителей NVIDIA и ИИ-платформ Microsoft. По её словам, решения NVIDIA BlueField, ConnectX и NVLink Switch, основаны на её запатентованной технологии. Xockets сообщила, что её патенты были изначально нарушены компанией Mellanox после того, как DPU Xockets был продемонстрирован на конференции в 2015 году. И NVIDIA продолжила деор Mellanox после её приобретения в марте 2019 года за $6,9 млрд. Microsoft также указана в качестве нарушителя патентных прав, поскольку, являясь клиентом NVIDIA, имеет «привилегированный доступ к нарушающим права GPU-серверам NVIDIA для ИИ».

Источник изображения: Xockets После подачи иска Xockets заявила: «Использование NVIDIA запатентованной технологии DPU Xockets позволило NVIDIA монополизировать сферу серверов ИИ на базе GPU, а Microsoft — сферу ИИ-платформ на базе GPU, что имеет решающее значение для их успеха и рыночной капитализации». Xockets также обвинила компании в картельном соглашении, выразившемся в создании организации под названием RPX по управлению патентными рисками, которая, по словам стартапа, была «сформирована по просьбе крупных технологических компаний для создания картелей покупателей интеллектуальной собственности», чтобы избежать уплаты справедливой рыночной цены за запатентованную технологию DPU Xockets. В иске указано, что Xockets пыталась лицензировать свою технологию NVIDIA и Microsoft, но компании заключили соглашение о проведении любых переговоров по лицензированию через RPX, которая также указана в иске в числе ответчиков. Xockets потребовала установить судебный запрет на деятельность незаконного картеля и выпуск новых ИИ-систем на базе ускорителей NVIDIA Blackwell, а также использование Microsoft систем Blackwell для своих платформ генеративного ИИ. Xockets также требует возмещения ущерба в максимально допустимом законом объёме.

30.08.2024 [23:53], Алексей Степин

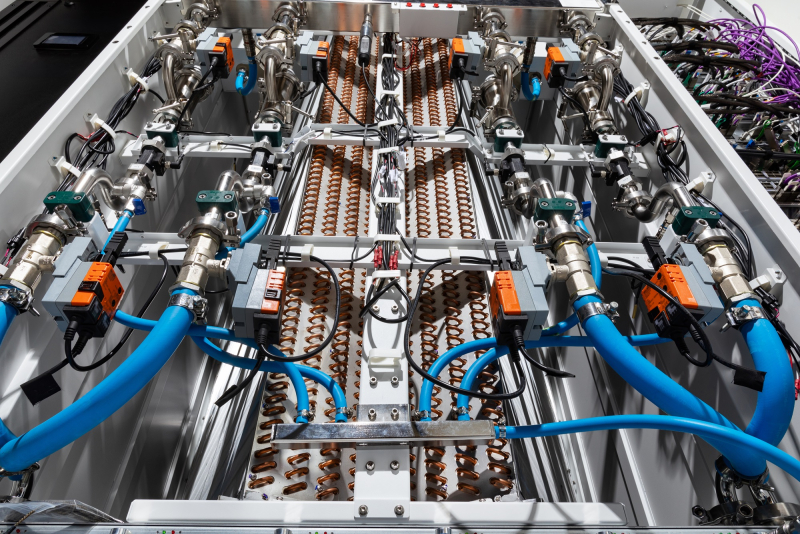

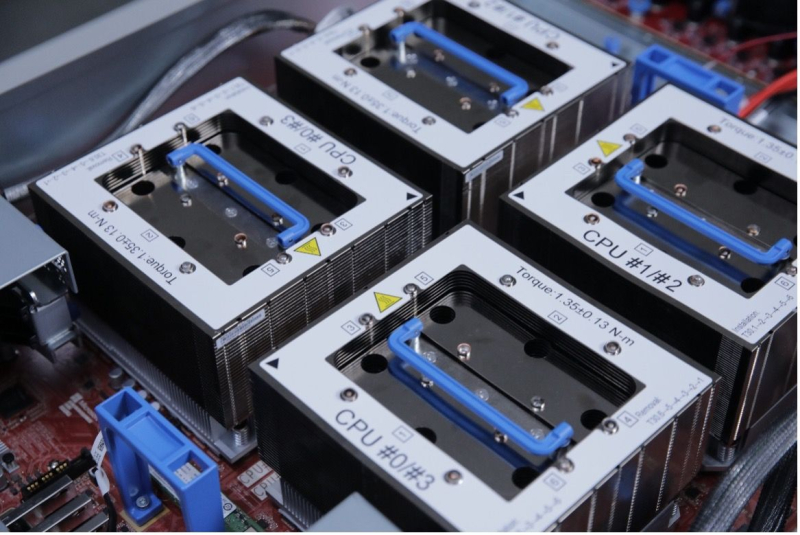

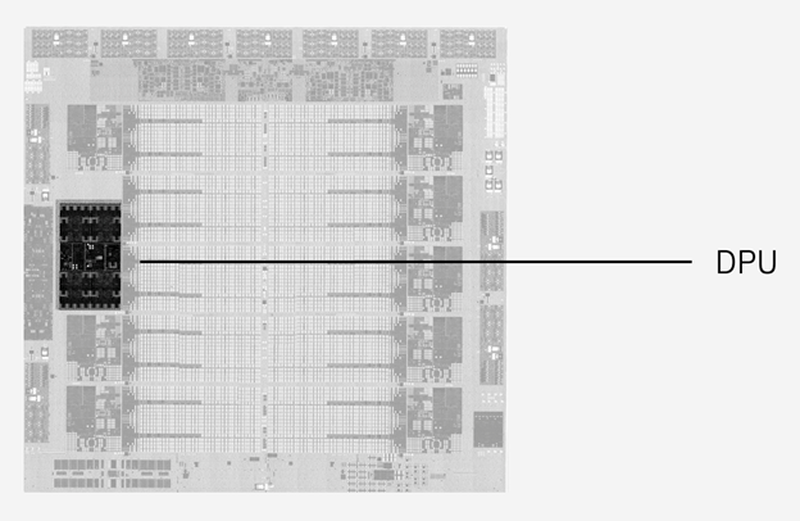

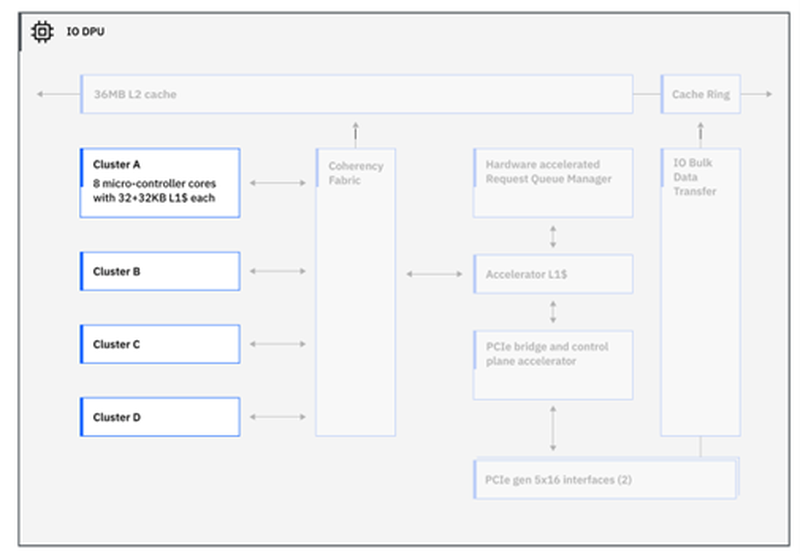

IBM представила процессор Telum II: 8 × 5,5 ГГц, 2,88 Гбайт L4-кеш, улучшенный ИИ-ускоритель и встроенный DPUНесмотря на доминирование архитектур x86 и Arm, а также растущую популярность RISC-V, востребованность классических мейнфреймов IBM на базе z/Architecture по-прежнему остаётся высокой, и компания продолжает активно развивать данное направление. На этой неделе IBM представила наследника Telum — процессор Telum II, в котором не только получили развитие заложенные ранее идеи, но и были реализованы достаточно серьёзные нововведения. Telum II будет выпускаться Samsung по 5-нм техпроцессу 5HPP (43 млрд транзисторов, 600 мм2). Он по-прежнему имеет восемь ядер с фиксированной рабочей частотой 5,5 ГГц. Сами ядра подверглись усовершенствованию, пусть и достаточно минорному: повышена точность предсказания ветвлений, улучшены механизмы сквозной записи и трансляции адресов. Это должно обеспечить новинке 20 % преимущества в пересчёте на процессорный разъём в сравнении с предшественником. Также благодаря новому техпроцессу удалось снизить площадь ядра на 20 %, а энергопотребление — на 15 %. Для поддержания постоянной тактовой частоты в Telum II используется новый блок управления напряжениями. Серьёзно улучшена подсистема кешей: объём кеш-памяти подрос на 40 %, всего разделов L2-кеша десять. Каждый из них имеет объём 36 Мбайт, а латентность не превышает 3,6 нс. Объёмы виртуальных кешей L3 (11,5 нс) и L4 (48,5 нс) выросли до 360 Мбайт (на процессор) и 2,88 Гбайт (на узел) соответственно. Сама технология виртуального кеширования такова, что текущее свободное место в L2 может использоваться для любой задачи, где может быть востребовано. На 30 % повышена пропускная способность связи чипа с внешним миром, а общение на межузловом уровне теперь шифруется. Встроенный ИИ-блок в Telum II в сравнении с предыдущим поколением стал вчетверо быстрее — 24 Топс. Сам сопроцессор имеет архитектуру, оптимальную для работы с LLM и нагрузками, в которых активно используется сравнительный анализ структурных или текстовых массивов данных. Есть поддержка INT8/FP16. При этом любой ИИ-ускоритель Telum II может работать с любым из ядер в пределах узла (drawer), что в предельной конфигурации даёт производительность на уровне 192 Топс, а для полностью сконфигурированной системы этот показатель равен 768 Топс. «Снаружи» ИИ-ускоритель доступен в виде набора CISC-инструкций.  А вот блок DPU дебютировал в Telum II впервые. Что интересно, архитектурно он не располагается «позади» PCI Express, как это бывает в системах на базе x86 или Arm, а имеет когерентное подключение к кешу L2 процессорных ядер, и при этом имеет свою подсистему кешей. Применение DPU, по словам IBM, позволило снизить энергозатраты на обслуживание операций ввода-вывода на 70 %. DPU жизненно необходим, поскольку на мейнфреймах будут работать тысячи инстансов, а самим системам теперь полагается и внешний ИИ-ускоритель Spyre.  Всего в состав DPU входит четыре кластера по по восемь программируемых микроядер, каждое из которых имеет кеш L1 объёмом 32+32 Кбайт и работает под управлением кастомных протоколов, разработанных IBM. DPU предоставляет шину PCI Express 5.0 и в полной конфигурации c 32 процессорами и 12 модулями расширения по 16 слотов x16 в каждом система на базе Telum II может работать со 192 адаптерами PCIe.  Компания-производитель позиционирует новые системы, как enterpise-решения широкого спектра для сценариев с использованием ИИ, в том числе, в режиме Ensemble AI, в котором одновременно над задачей могут работать модели разного размера и сложности. В этом режиме малая модель выявления мошеннических атак может работать как быстрое средство, а для отдельных, особенно важных транзакций в работу включается более сложная, но и более эффективная модель класса LLM. Процессоры Telum II станут основой как новых мейнфреймов IBM Z, работающих под управлением классической z/OS, так и Linux. Ожидается, что платформы IBM z17 на базе Telum II будут доступны уже в следующем году. |

|