Материалы по тегу: cloud

|

02.07.2024 [23:55], Алексей Степин

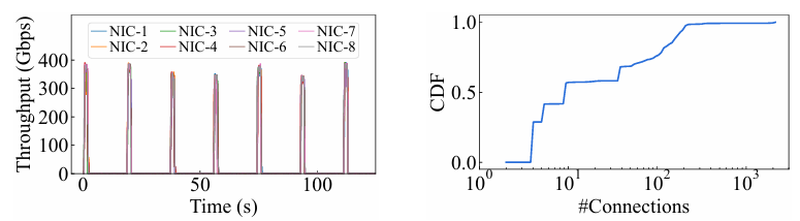

15 тыс. ускорителей на один ЦОД: Alibaba Cloud рассказала о сетевой фабрике, используемой для обучения ИИAlibaba Cloud раскрыла ряд сведений технического характера, касающихся сетевой инфраструктуры и устройства своих дата-центров, занятых обработкой ИИ-нагрузок, в частности, обслуживанием LLM. Один из ведущих инженеров компании, Эньнань Чжай (Ennan Zhai), опубликовал доклад «Alibaba HPN: A Data Center Network for Large Language Model Training», который будет представлен на конференции SIGCOMM в августе этого года. В качестве основы для сетевой фабрики Alibaba Cloud выбрала Ethernet, а не, например, InfiniBand. Новая платформа используется при обучении масштабных LLM уже в течение восьми месяцев. Выбор обусловлен открытостью и универсальностью стека технологий Ethernet, что позволяет не привязываться к конкретному вендору. Кроме того, меньше шансы пострадать от очередных санкций США. Отмечается, что традиционный облачный трафик состоит из множества относительно небыстрых потоков (к примеру, менее 10 Гбит/с), тогда как трафик при обучении LLM включает относительно немного потоков, имеющих периодический характер со всплесками скорости до очень высоких значений (400 Гбит/с). При такой картине требуются новые подходы к управлению трафиком, поскольку традиционные алгоритмы балансировки склонны к перегрузке отдельных участков сети.

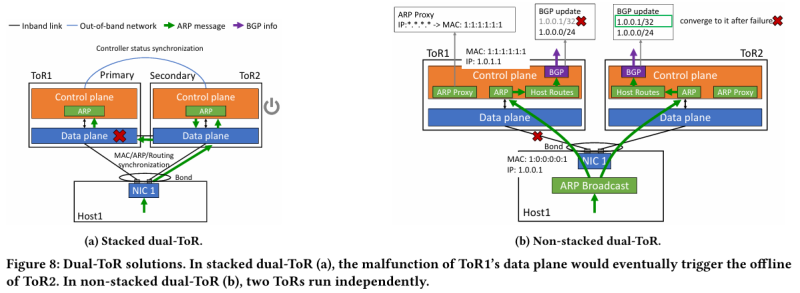

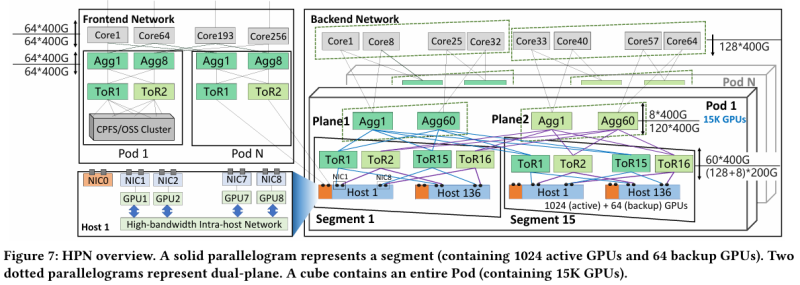

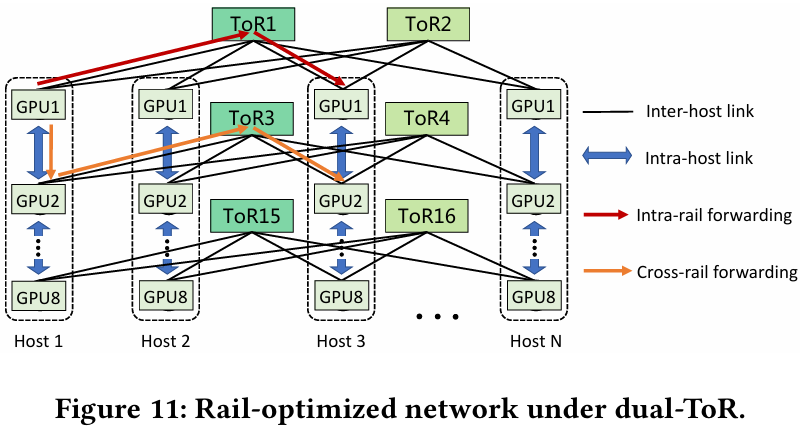

Источник здесь и далее: Alibaba Cloud Разработанная Alibaba Cloud альтернатива носит название High Performance Network (HPN). Она учитывает многие аспекты работы именно с LLM. Например, при обучении важна синхронизация работы многих ускорителей, что делает сетевую инфраструктуру уязвимой даже к единичным точкам отказа, особенно на уровне внутристоечных коммутаторов. Alibaba Cloud использует для решения этой проблемы парные коммутаторы, но не в стековой конфигурации, рекомендуемой производителями.

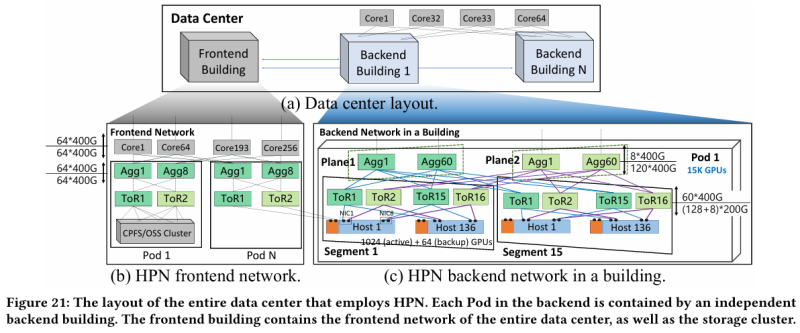

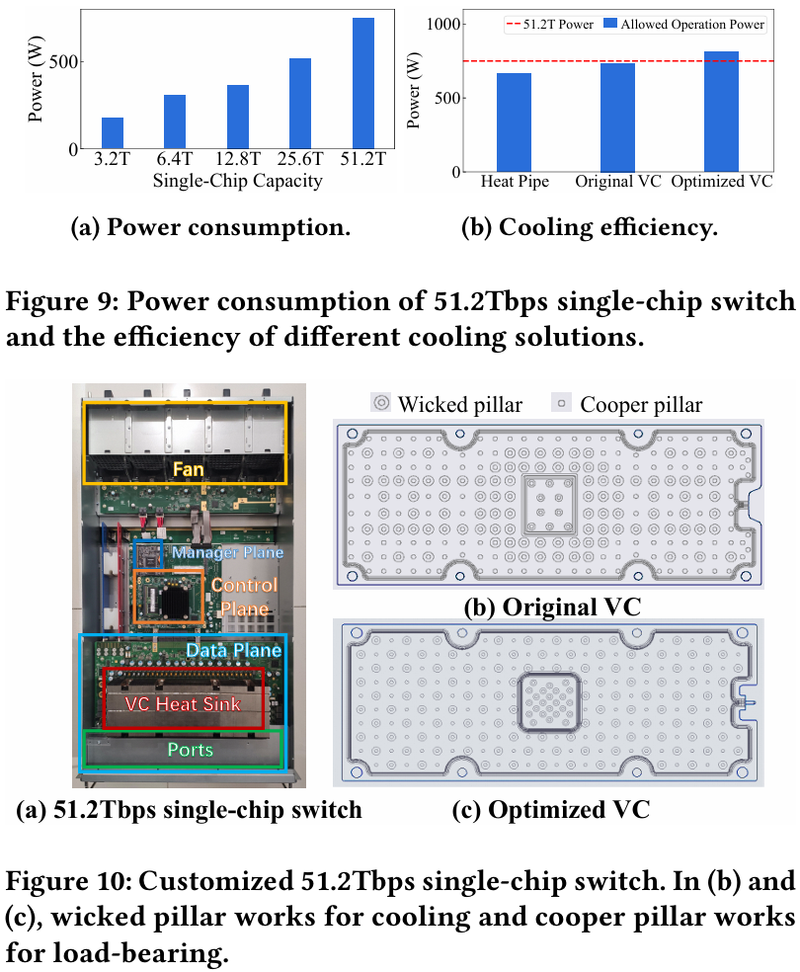

Характер трафика при обучении LLM Каждый хост содержит восемь ИИ-ускорителей и девять сетевых адаптеров. Каждый из NIC имеет по паре портов 200GbE. Девятый адаптер нужен для служебной сети. Между собой внутри хоста ускорители общаются посредством NVLink на скорости 400–900 Гбайт/с, а для общения с внешним миром каждому из них полагается свой 400GbE-канал с поддержкой RDMA. При этом порты сетевых адаптеров подключены к разным коммутаторам из «стоечной пары», что серьёзно уменьшает вероятность отказа.  В докладе говорится, что Alibaba Cloud использует современные одночиповые коммутаторы с пропускной способностью 51,2 Тбит/с. Этим условиям отвечают либо устройства на базе Broadcom Tomahawk 5 (март 2023 года), либо Cisco Silicon One G200 (июнь того же года). Судя по использованию выражения «начало 2023 года», речь идёт именно об ASIC Broadcom. Своё предпочтение именно одночиповых коммутаторов компания объясняет просто: хотя многочиповые решения с большей пропускной способностью существуют, в долгосрочной перспективе они менее надёжны и стабильны в работе. Статистика показывает, что аппаратные проблемы у подобных коммутаторов возникают в 3,77 раза чаще, нежели у одночиповых. Одночиповые решения класса 51,2 Тбит/с выделяют много тепла, но ни один поставщик оборудования не смог предложить Alibaba Cloud готовые решения, способные удерживать температуру ASIC в пределах 105 °C. Выше этого порога срабатывает автоматическая защита. Поэтому для охлаждения коммутаторов Alibaba Cloud создала собственное решение на базе испарительных камер.  Сетевая фабрика позволяет создавать кластеры, каждый из которых содержит 15360 ускорителей и располагается в отдельном здании ЦОД. Такое высокоплотное размещение позволяет использовать оптические кабели длиной менее 100 м и более дешёвые многомодовые трансиверы, которые дешевле одномодовых примерно на 70 %. Ёмкость такого дата-центра составляет около 18 МВт. Но есть у HPN и недостаток: использование топологии с двумя внутристоечными коммутаторами и другие особенности архитектуры усложняют кабельную подсистему, поэтому инженеры поначалу столкнулись с ростом ошибок при подключении сетевых интерфейсов. В настоящее время активно используются тесты, позволяющие проверить каждое подключение на соответствие идентификаторов портов и коммутаторов рабочим схемам. Отмечается, что параметры Ethernet-коммутаторов удваиваются каждые два года, поэтому компания уже разрабатывает сетевую архитектуру следующего поколения, рассчитанную на применение будущих ASIC 102,4 Тбит/с. По словам Alibaba Cloud, обучение LLM с сотнями миллиардов параметров потребует огромного распределённого кластера, количество ускорителей в котором исчисляется миллионами. И ему требуется соответствующая сетевая инфраструктура.

29.06.2024 [21:30], Сергей Карасёв

Alibaba Cloud закроет дата-центры в Австралии и Индии, чтобы сфокусироваться на Юго-Восточной Азии и МексикеОблачная платформа Alibaba Cloud, по сообщению ресурса Datacenter Dynamics, намерена закрыть ЦОД в Австралии и Индии. Речь идёт о площадках в Сиднее и Мумбаи, работа которых будет свёрнута до конца текущего года. Решение связано с изменением стратегии по развитию инфраструктуры дата-центров. Alibaba Cloud запустила облачный регион в Сиднее в 2016 году: на сегодняшний день он имеет две зоны доступности. Регион в Мумбаи был открыт в 2018 году и также включает две зоны доступности. ЦОД в Индии прекратят работу уже 15 июля, а объекты в Австралии — 30 сентября 2024 года. Alibaba Cloud рекомендует всем клиентам этих дата-центров при первой возможности перенести свои рабочие нагрузки на площадки компании в Сингапуре или в других регионах. После сворачивания деятельности в Австралии и Индии усилия компании будут направлены на развитие облачного бизнеса в Юго-Восточной Азии и Мексике. В частности, в мае Alibaba Cloud объявила о планах по формированию мексиканского региона, а также заявила, что в ближайшие три года создаст дополнительные ЦОД на некоторых рынках присутствия, включая Малайзию, Филиппины, Таиланд и Южную Корею.

Источник изображения: Alibaba Индонезия, Малайзия и Таиланд в последнее время смогли привлечь миллиарды долларов инвестиций на развитие ЦОД как от американских, так и азиатских операторов и гиперскейлеров. Индийскому рынку дата-центров тоже предрекают стремительный рост, а вот Сингапур, похоже, вскоре может потерять статус не только регионального, но и международного лидера индустрии ЦОД. Осенью прошлого года Alibaba объявила о намерении привлечь $3 млрд для развития облачного бизнеса. Компания рассчитывала провести масштабную реорганизацию, в ходе которой на базе облачных активов планировалось создать отдельную структуру. Однако впоследствии от этой инициативы пришлось отказаться в связи с американскими санкциями в отношении Китая. В целом, Alibaba Cloud управляет 89 зонами доступности в 30 регионах мира.

11.06.2024 [14:17], Руслан Авдеев

Alibaba Cloud открыла в Мозамбике второй в Африке облачный регион ALP CloudПодразделение системного интегратора Telkom Group, компания BCX, объединила усилия с Alibaba для организации облачных сервисов Alibaba Cloud в Мозамбике. По данным Datacenter Dynamics, BCX обеспечит хостинг т.н. Africa Local Public (ALP) Cloud в дата-центре в Мапуту. По словам главы BCX, сотрудничество с Alibaba Cloud позволяет предоставлять новейшие технологии при посредничестве местной компании, которая понимает сложности и особенности ведения бизнеса на африканском континенте. В BCX признают чрезвычайную важность цифрового суверенитета для мозамбикского бизнеса, поэтому BCX и запустила облако ALP Cloud в Мапуту. Говорится о нескольких зонах доступности, местной службе поддержки и возможности оплаты в местной валюте. Это уже вторая африканская страна, где появились облачные сервисы Africa Local Public Cloud компании Alibaba. Запуск в Южной Африке состоялся ещё в октябре 2023 года. Китайская компания разместила свои сервисы в двух южноафриканских ЦОД, создав две зоны доступности — в ЦОД BCX в Мидранде и принадлежащем Teraco Data Environment дата-центре в Исандо. Следующий этап внедрения ALP Cloud предусматривает создание зоны доступности в ЦОД в Кейптауне. Также в Южной Африке предлагают свои облачные сервисы Microsoft Azure, Amazon (AWS) и Google. BCX, основанная в 1996 году как Business Connexion, считается одним из крупнейших системных интеграторов в Африке, Telkom Group купила бизнес в 2015 году. BCX анонсировала партнёрство с Alibaba в октябре 2022 года — африканскому контрагенту дали эксклюзивные права распространять продукты и сервисы Alibaba Cloud в Южной Африке. Сегодня Alibaba управляет 89 зонами доступности в 30 регионах по всему миру.

29.05.2024 [12:08], Сергей Карасёв

Edge-оборудование Alibaba Cloud построено на Intel TofinoОблачная платформа Alibaba Cloud, по сообщению ресурса The Register, раскрыла аппаратную конфигурацию сетевого оборудования, которое используется на периферии. Речь идёт об устройствах под названием LuoShen, которые рассматриваются в качестве «серверов-коммутаторов».

Источник изображения: Alibaba Отмечается, что изделия LuoShen находятся в производстве приблизительно два года. На сегодняшний день они эксплуатируются на «сотнях периферийных площадок» в составе облачной инфраструктуры Alibaba Cloud. LuoShen имеет форм-фактор 2U. Конструкция включает два CPU общего назначения, FPGA, а также чип Intel Tofino — интегральную схему специального назначения (ASIC) с возможностью программирования. Tofino представляет собой сетевой Ethernet-процессор, ориентированный на дата-центры. Утверждается, что LuoShen обеспечивает пропускную способность до 1,2 Тбит/с. Чип Tofino отвечает за перераспределение 64 портов 100G под различные цели. Это, в частности, обработка трафика виртуальных машин, интернет-трафика и пр. В зависимости от выполняемых задач данные направляются к CPU и FPGA, а после обработки отправляются в конечную точку. Отмечается, что устройствам LuoShen приходится обрабатывать трафик разных типов, а поэтому возможность программирования Tofino имела для Alibaba Cloud ключевое значение — облачная платформа смогла оптимизировать работу оборудования под собственные нужды. Благодаря переходу на LuoShen компания смогла сократить первоначальные затраты, занимаемое место и энергопотребление на 75 %, 87 % и 60 % соответственно по сравнению с ранее использовавшейся сетевой архитектурой.

27.05.2024 [10:43], Сергей Карасёв

Облачный регион Huawei Cloud заработал в ЕгиптеКомпания Huawei объявила об открытии облачного региона в Египте. В рамках данного проекта китайская корпорация сообщила о намерении в течение пяти лет инвестировать $300 млн в развитие сервисов и услуг, а также в обучение местных разработчиков и подготовку IT-специалистов. О том, что Huawei планирует скорый запуск облачной площадки в Египте, стало известно в феврале нынешнего года. Отмечается, что новый Каирский регион послужит центром доступа для стран Северной Африки. Таким образом, Huawei стала первым облачным провайдером, развернувшим публичную облачную инфраструктуру на территории Египта.

Источник изображения: Huawei Планируемые инвестиции будут направлены на создание более чем 200 облачных сервисов, включая системы ИИ, платформы больших данных и средства разработки. Huawei намерена поддерживать примерно 200 местных партнёров в области ПО, а также развивать сеть из 1,3 тыс. торговых партнёров. Конечная цель заключается в формировании развитой экосистемы софта и приложений в регионе. Кроме того, в течение следующих пяти лет Huawei обучит 10 тыс. местных разработчиков и 100 тыс. IT-специалистов, что поможет обеспечить цифровую трансформацию. Huawei также сообщила о расширении своей программы поддержки стартапов. Инициатива Huawei Cloud Startup Program предусматривает формирование специальных команд для оказания помощи молодым компаниям при внедрении облачных технологий. Проект предполагает в том числе субсидирование: один стартап может подать заявку на облачные кредиты на сумму до $150 тыс. Наконец, платформа Huawei Cloud представила новую большую языковую модель (LLM) для арабского рынка. Система автоматического распознавания речи (ASR) охватывает более 20 арабоязычных стран. При этом точность работы достигает 96%. Отмечается, что на сегодняшний день инфраструктура Huawei Cloud состоит из 33 регионов и 93 зон доступности по всему миру. У компании есть облачные объекты в материковом Китае и Гонконге, Ирландии, Нидерландах, Франции, Таиланде, Сингапуре, Индонезии, Саудовской Аравии, Турции, Южной Африке, Бразилии, Аргентине, Перу, Чили и пр.

23.05.2024 [21:32], Алексей Степин

Бери да пользуйся: IBM представила частное облако на базе POWER10IBM представила платформу POWER Virtual Server Private Cloud для локального развёртывания частного облака, за обслуживание и корректное функционирование которого отвечает сама IBM. Это решение, по словам компании, позволяет сохранить «ИТ-суверенитет» и избежать существенных финансовых затрат благодаря гибкой ценовой политике. Базовая конфигурация (Small Pod) начинается с 2–4 серверов с 8 Тбайт оперативной памяти, до 340 ядер и до 438 Тбайт пространства для хранения данных. Занимают такие комплекты одну стандартную стойку. Среднего размера «капсула» (Medium Pod) может насчитывать до 40 серверов, в том числе в варианте с 32 Тбайт памяти. Максимальная конфигурация насчитывает 1615 ядер и примерно 3,5 Пбайт дискового пространства.

Источник изображения: IBM В основе платформы лежат серверы IBM POWER S1022 и E1050/1080, использующие процессоры POWER10. Первая система может иметь один или два 20-ядерных процессора с поддержкой SMT8, дополненных 2-4 Тбайт памяти. POWER E1050/1080 поддерживают до четырёх процессоров. Объём памяти в этом случае варьируется в пределах 4–32 Тбайт на сервер. В состав локального облака также могут входить СХД IBM FlashSystem ёмкостью 460 или 920 Тбайт. Сетевые коммутаторы и управляющие серверы входят в стоимость услуги. В качестве базовых ОС доступны Red Hat Enterprise Linux и классические решения IBM — IBM i и AIX. Доступна и сертификация SAP HANA и SAP NetWeaver. Сама услуга предлагается сроком на один год с возможностью возобновления, также доступны трёх- и пятилетние контракты. При этом само оборудование и лицензии приобретать не придётся, платить надо только за их фактическое использование, а сама платформа управляется из IBM Cloud.

13.05.2024 [22:33], Владимир Мироненко

Ресурсы в обмен на технологии: Alibaba Cloud предлагает ИИ-стартапам GPU-мощности за долю в компанииКитайский гигант электронной коммерции Alibaba по примеру Microsoft, финансировавшей успешный ИИ-стартап OpenAI, пытается расширить своё присутствие на рынке ИИ-технологий с помощью инвестиций в китайские стартапы в области генеративного ИИ. Разница лишь в том, что Alibaba предлагает большей частью не традиционное финансирование деньгами, а кредиты на использование своей облачной инфраструктуры для обучения ИИ-моделей, пишет газета Financial Times. В числе стартапов, пользующихся поддержкой Alibaba, газета назвала Moonshot, Zhipu, MiniMax и 01.ai, которые разрабатывают локальные версии американских приложений, таких как ChatGPT и чат-бот-аватар Character.ai. Так, в феврале этого года Alibaba возглавила раунд финансирования Moonshot AI, разработчика ИИ-решений для компаний в сфере электронной коммерции, включая чат-бот Kimi AI, привлёкшего $1 млрд инвестиций, после чего его рыночная стоимость оценивалась в $2,5 млрд. По словам источников Financial Times, Alibaba инвестировала в Moonshot AI $800 млн, но лишь чуть больше половины было предоставлено деньгами, а остальная часть поступила в виде кредитов на облачные вычисления. Как утверждают источники, в течение 2023 года глава Alibaba Эдди Юнмин У (Eddie Yongming Wu) лично контролировал выделение инвестиций четырём ведущим ИИ-стартапам Китая, что говорит о том, какое значение компания придаёт этому направлению. После отказа из-за санкций США от амбициозного плана реструктуризации, предполагавшего проведение IPO облачным подразделением, на фоне растущей конкуренцией со стороны ByteDance и PDD Holdings на своём основном рынке электронной коммерции, Alibaba пытается найти новые драйверы роста. После отмены реструктуризации Эдди Юнмин У взял под личный контроль облачный бизнес, сделав ставку на ИИ в скорректированной стратегии по стимулированию роста компании. Порядок выделения инвестиций Alibaba в Moonshot повторяет подход Microsoft и Amazon, согласно которому денежные средства передаются ИИ-стартапам при условии, что те будут использовать их для обучения и запуска моделей в облаках Azure и AWS соответственно. Разница заключается в том, что в случае Alibaba напрямую деньги никогда не передаются китайским стартапам. Вместо этого они хранятся на условном депонировании, который компания может считать поступающим доходом. «Предоставление вычислений на самом деле более ценно, чем наличные, — заявил китайский эксперт в области ИИ. — Из-за нехватки чипов очень сложно получить доступ к кластеру Alibaba из 10 тыс. ускорителей». Alibaba Cloud и другие игроки успели приобрести крупные объёмы современных ускорителей NVIDIA, в том числе урезанные A800 и H800, прежде чем США ввели ограничения. И теперь компания стремится извлечь из владения ими выгоду, прежде чем они устареют. Крупнейшие интернет-компании Китая, в том числе Alibaba, Meituan, Xiaohongshu и Tencent, играют огромную роль в финансировании новой волны ИИ-стартапов по сравнению с предыдущим поколением стартапов, где доминировали компании SenseTime и Megvii, специализирующиеся на разработке решений для распознавания лиц и видеонаблюдения.

11.05.2024 [00:11], Сергей Карасёв

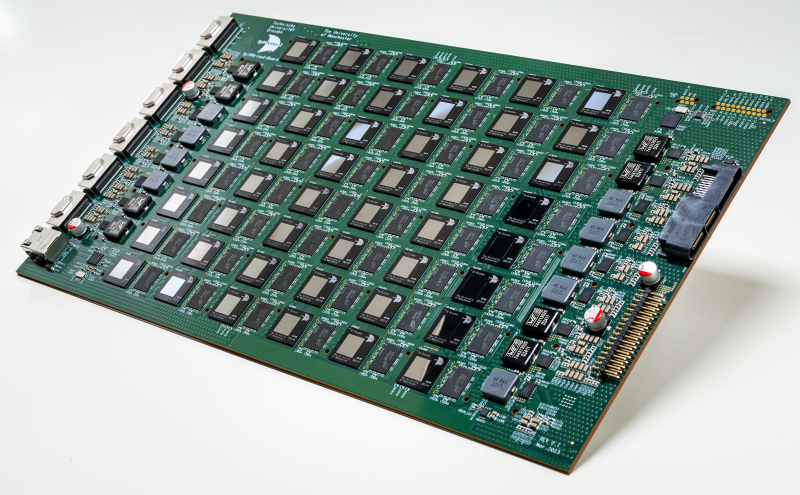

SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе ArmКомпания SpiNNcloud Systems анонсировала «нейроморфный суперкомпьютер» — гибридную высокопроизводительную вычислительную ИИ-систему, основанную, по словам компании, на принципах работы человеческого мозга. Утверждается, что это первое коммерчески доступное решение данного типа. Изделие базируется на архитектуре, разработанной Стивом Фербером (Steve Furber), одним из создателей оригинального процессора Arm. Идея заключается в применении большого количества маломощных чипов для более эффективной обработки ИИ-задач и других рабочих нагрузок. SpiNNaker2 представляет собой специализированную серверную плату с 48 чипами, каждый из которых насчитывает 152 ядра Arm. Таким образом, общее количество ядер составляет 7296. В состав чипов также входят различные дополнительные узлы, включая распределённые GPU-подобные блоки для ускорения обработки нейроморфных, гибридных и обычных моделей ИИ. В одну стойку могут монтироваться до 90 плат SpiNNaker2. Масштабирование осуществляется путём объединения таких стоек в кластер. В результате, как утверждается, возможно эмулирование в реальном времени как минимум 10 млрд взаимосвязанных нейронов. На операциях машинного обучения производительность может достигать 0,3 Эопс (1018 операций в секунду). Для сравнения — исследовательский нейроморфный компьютер Intel Hala Point поддерживает до 1,15 млрд нейронов и производительность до 30 Попс. От традиционных ИИ-платформ на базе GPU новое решение отличается универсальностью, говорит компания. Благодаря использованию многочисленных асинхронных блоков с низким энергопотреблением достигается более эффективное управление рабочими нагрузками. Со II половины 2024 года изделия SpiNNaker2 будут доступны в составе облачной платформы. В I половине 2025-го планируется организовать поставки самостоятельных систем. В число первых заказчиков SpiNNaker2 вошли Национальные лаборатории Сандия (Sandia National Laboratories), Технический университет Мюнхена (TUM) и Гёттингенский университет (Universität Göttingen).

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

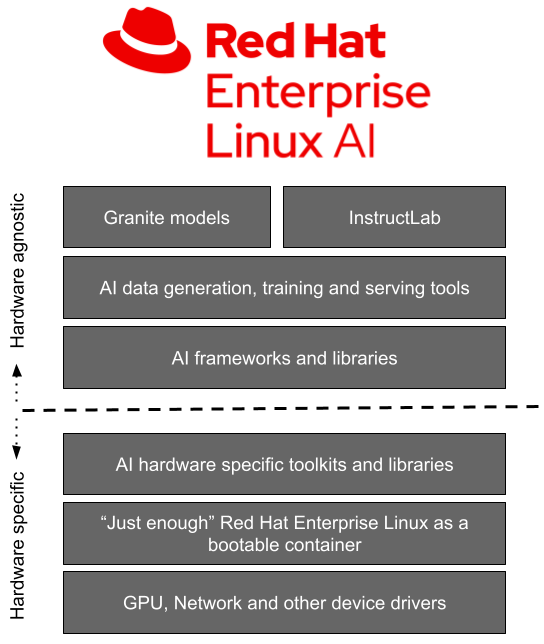

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

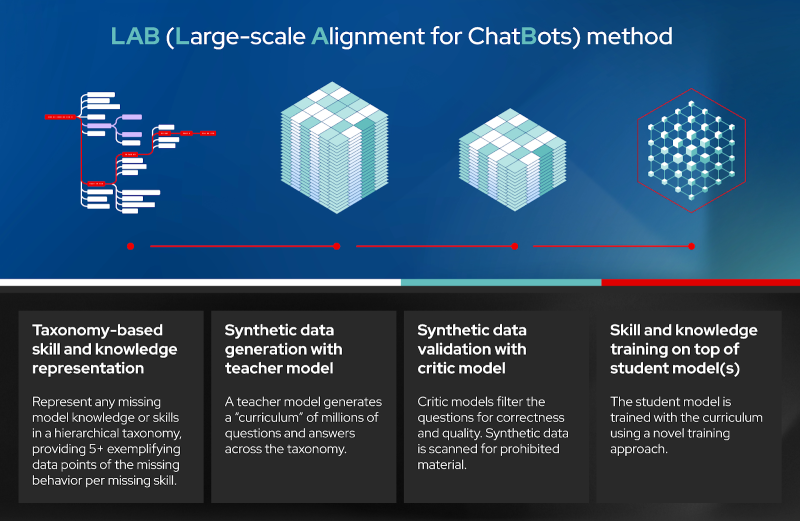

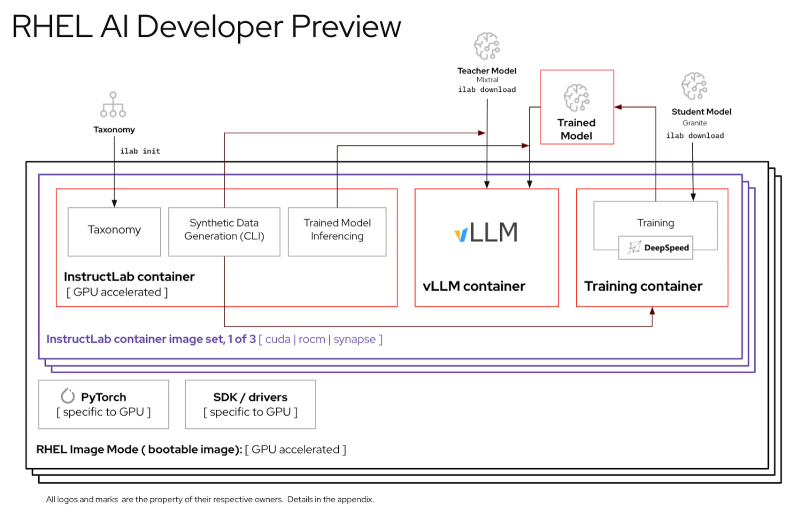

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

07.05.2024 [17:30], Руслан Авдеев

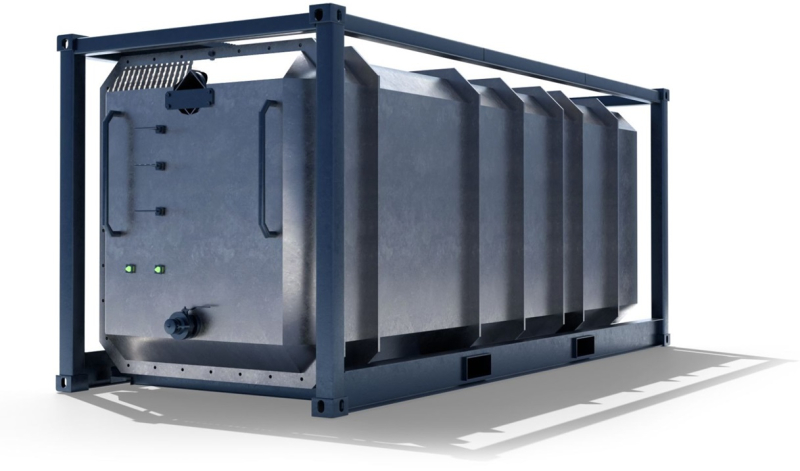

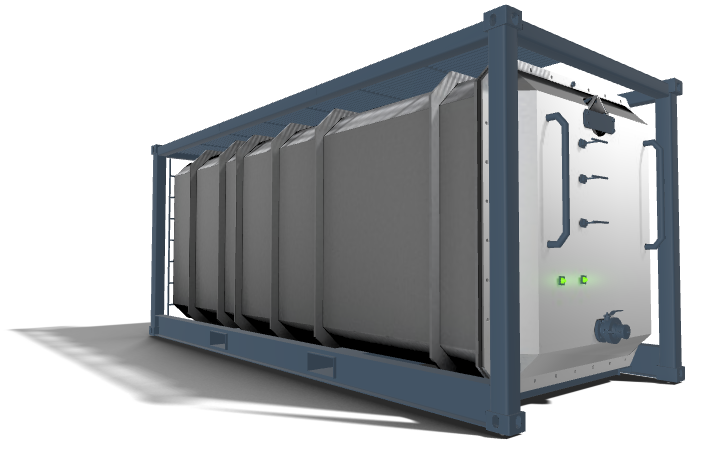

Subsea Cloud предложила протестировать её подводный дата-центр у берегов НорвегииОператор глубоководных дата-центров Subsea Cloud предложил потенциальным клиентам оценить возможности своего ЦОД в течение 90 дней. Как сообщает The Register, так компания пытается привлечь новых пользователей — если в последние три года дорогостоящие испытания проводились индивидуально, то теперь доступ к необычным дата-центрам упростится. В Subsea заявляют, её дата-центры имеют на 40 % меньше углеродных выбросов, а операционные расходы для клиентов на 30 % меньше в сравнении с наземными ЦОД. Наконец, затрат энергии и воды на охлаждение вовсе нет. Изюминка Subsea Cloud в том, что компания предлагает не просто подводные, а именно глубоководные (до 3000 м) решения. В 2022 году компания сообщала о внедрении первого коммерческого подводного проекта в районе Порт-Анджелеса (штат Вашингтон), дополнительные ЦОД планировалось развернуть в Мексиканском заливе и Северном море. В рамках Project OTTO компания предложит протетсировать возможности своего ЦОД недалеко от юго-западного побережья Норвегии. Первая фаза стартует в октябре. Участникам будут доступны тестовые периоди длительностью 30, 60 и 90 дней. При этом поучаствовать в тестировании можно только один раз — за исключением случаев, когда потенциальные клиенты захотят значительно изменить аппаратную составляющую своего оборудования, что потребует дальнейших тестов. О стоимости тестирования ничего не говорится, но компания предупреждает, что в случае отказать подписать соглашение о дальнейшем развёртывании мощностей продление тестирования не будет доступно. Базовый модуль Subsea Cloud представляет собой ёмкость размерами 6,1 × 2,6 м, практически тех же габаритов, что и стандартный 20-футовый контейнер — в нём можно разместить до 16 стоек мощностью до 150 кВт каждая (суммарно до 1,5 МВт) или 826 серверов. Для охлаждения используется погружная СЖО. Компания может предоставить клиентам и собственные серверы. В целом конфигурация ЦОД рассчитана на высокоплотное размещение энергоёмких систем, например, для ИИ- и HPC-нагрузок. Срок службы модуля составляет 25–30 лет.

Источник изображения: Subsea Cloud Подводные ЦОД пытаются внедрять не впервые. Microsoft в течение нескольких лет развивала Project Natick. Этот проект был признан успешным, но коммерциализировать компания его не стала в отличие от аналогичного проекта Highlander в Китае. Одним из сдерживающих клиентов факторов является отсутствие лёгкого доступа к оборудованию в подводных дата-центрах. По словам Subsea Cloud на то, чтобы добраться до модуля и заменить или обслужить серверы, уйдёт 4–16 часов. В Subsea Cloud рассчитывают на сотрудничество с офшорными ветряными электростанциями — это обеспечит подводным ЦОД удобный доступ к возобновляемой энергии. Кроме того, компания намерена подключать свои подводные кампусы непосредственно к подводным ВОЛС. При этом в компании подчёркивают, что общая стоимость обслуживания значительно ниже, чем у обычных ЦОД. Правда, сама же говорит, что экономически целесообразно развёртывание не менее 20 модулей. |

|