Материалы по тегу: cloud

|

30.04.2024 [13:02], Сергей Карасёв

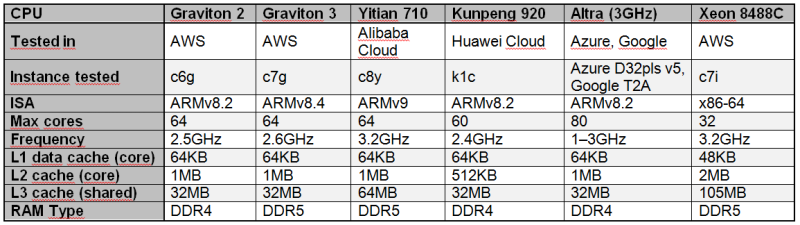

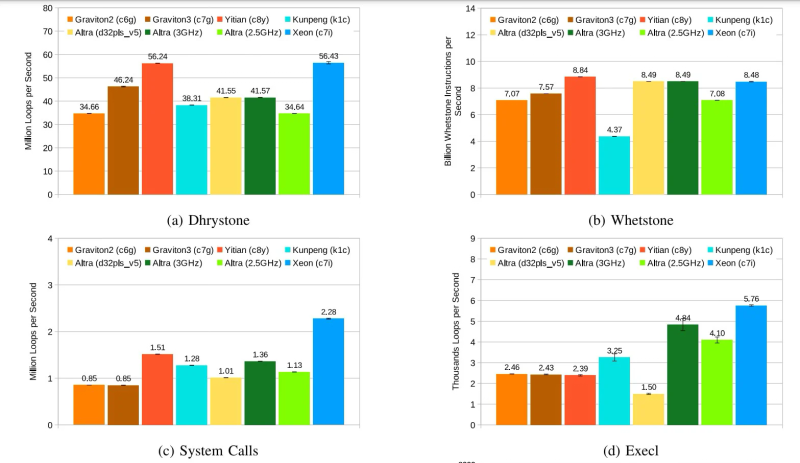

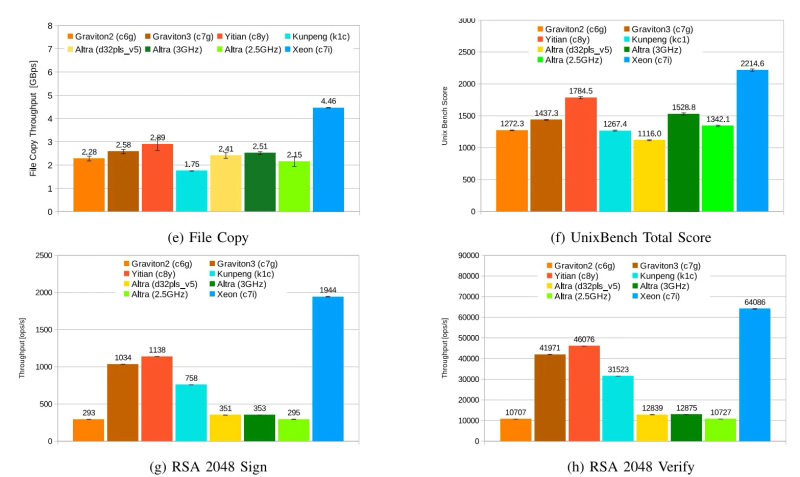

Alibaba Yitian 710 признан самым быстрым облачным Arm-процессором в ряде бенчмарковСогласно результатам исследования, обнародованным Институтом инженеров электротехники и электроники (IEEE) в журнале Transactions on Cloud Computing, процессор Alibaba Yitian 710 на сегодняшний день является самым производительным серверным чипом с архитектурой Arm из тех, которые доступны в составе различных облачных платформ, передаёт The Register. Изделие Yitian 710 было создано подразделением T-Head специально для нужд Alibaba Cloud и дебютировало в 2021 году. Этот 5-нм процессор на базе Armv9 насчитывает до 128 ядер с частотой до 3,2 ГГц. Обеспечивается поддержка восьми каналов памяти DDR5 и 96 линий PCIe 5.0. При этом чипы отличаются высокой энергетической эффективностью. Alibaba Cloud рассчитывала перенести пятую часть своих мощностей на собственные Arm-чипы к 2025 году. В ходе исследования чип Yitian 710 в конфигурации с 64 ядрами сравнивался с Arm-процессорами Amazon Graviton 2/3 (64 ядра), Huawei Kunpeng 920 (60 ядер) и Ampere Altra (80 ядер), а также с х86-чипом Intel Xeon Platinum 8488C поколения Sapphire Rapids. Тестирование проводилось в различных облачных средах, включая Amazon Web Services (AWS), Alibaba Cloud, Huawei Cloud, Microsoft Azure, Google Cloud Platform. Оценивалось быстродействие при выполнении различных задач: классические бенчмарки Dhrystone и Whetstone, ряд системных вызовов ядра и вызовов execl, скорость копирования файлов, показатель UnixBench, подписи и аутентификация с использованием криптографического алгоритма RSA 2048, а также работа с СУБД. Как отмечается, практически во всех перечисленных тестах процессор Alibaba опережал конкурирующие чипы с архитектурой Arm. В задачах Whetstone изделие Yitian 710 также превзошло процессор Xeon Platinum и чип Altra. Вместе с тем Graviton 3 показал превосходство в тесте Redis. Тем не менее, Yitian 710 сохранил своё преимущество в двух из трёх задач RocksDB. В плане эффективности чипам Arm требуется больше системных вызовов, чем их конкурентам Intel. Но в некоторых сценариях использования решения Arm всё равно оказываются более предпочтительными.

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

11.04.2024 [17:57], Владимир Мироненко

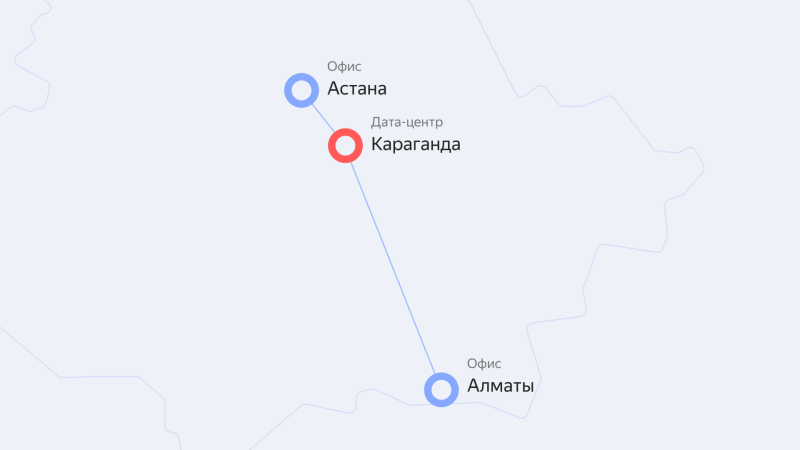

Yandex Cloud запустила облачные сервисы для пользователей в Казахстане и Центральной Азии на базе ЦОД в КарагандеОблачная платформа Yandex Cloud объявила о запуске нового региона kz1 на базе ЦОД в Казахстане, благодаря чему пользователям республики и Центральной Азии стал доступен широкий выбор облачных сервисов и технологий Yandex. Тарификация сервисов производится в тенге. А для развития IT-рынка в Казахстане компания выделила гранты 74 компаниям на сумму свыше 160 млн тенге в рамках программы Yandex Cloud Boost. Компании региона получили возможность использовать решения Yandex Cloud для хранения и обработки данных, технологии искусственного интеллекта (ИИ), машинного обучения, а также различные инструменты для разработки, тестирования и запуска собственных цифровых продуктов. ЦОД с серверной инфраструктурой находится в Караганде, а офисы компании — в Астане и Алматы. В казахстанском офисе работает команда технических специалистов и экспертов. С помощью сервиса распознавания и синтеза речи Yandex SpeechKit с поддержкой казахского и узбекского языков компании смогут создавать голосовых помощников и роботов для кол-центров. Также они смогут использовать решения для хранения, обработки и анализа данных, средства мониторинга и управления ресурсами облака, а также решения для обеспечения безопасности облачной инфраструктуры Yandex Cloud. Запуск нового региона выполнен в рамках долгосрочной стратегии развития Yandex Cloud в Казахстане и Центральной Азии. Как сообщает компания, её сервисы и решения уже используют в своей работе десятки казахстанских компаний крупного и среднего бизнеса, стартапы и организации государственного сектора, включая Kolesa Group, Technodom, Бухта, HR Messenger, TargetAI, 1Fit, Demetra и Rocket Firm.

08.04.2024 [22:49], Руслан Авдеев

Alibaba снизит стоимость облачных сервисов в попытке вернуть бизнес к ростуКитайский IT-гигант Alibaba Group Holding Ltd. инициировала масштабное снижение цен на свои облачные сервисы для клиентов по всему миру. По данным Bloomberg, речь идёт о дисконте до 59 % — ранее стоимость услуг уже была снижена в КНР в попытке потеснить локальных соперников и вернуть бизнес к росту. Новые меры совпали с ростом спроса на облачные вычисления для ИИ-решений, а также сложной внутренней реструктуризацией бизнеса компании. Её глава надеется придать второе дыхание основному бизнесу холдинга, включая, например, сегмент электронной коммерции. В своё время облачное подразделение отказалось от идеи отделиться и выйти на IPO, сославшись на трудности с получением необходимых ей чипов NVIDIA, а также растущую конкуренцию с китайской же Tencent Holdings Ltd. и рядом поддерживаемых государством облачных провайдеров.

Источник изображения: Alibaba В понедельник она снизила цены в среднем на 23 % на порядка 500 вариантов облачных продуктов. Такие дисконты теперь доступны в 13 регионах. На сегодня Alibaba Cloud является крупнейшим облачным провайдером в Китае, но на мировом рынке это сравнительно небольшой игрок, особенно на фоне AWS или Microsoft Azure. В последние годы компания потеряла часть позиций в Китае, уступив долю рынка окологосударственным бизнесам, а экономическая война США с Китаем помешала экспансии Alibaba за рубежом. Хотя в прошлом фискальном году выручка превысила $11 млрд, в I квартале этого года она, как ожидается, упадёт на 2 %. На прошлой неделе представители компании заявили, что ограничения на поставку чипов составляют большую проблему для китайских облачных провайдеров — запасов хватит на обучение больших языковых моделей (LLM) ещё в течение 12–18 мес., но ограниченный доступ к передовым ускорителям NVIDIA не может не сказаться на конкурентоспособности компании в среднесрочной перспективе, пока не появятся сильные альтернативы китайского производства. В Bloomberg считают, что снижение цен свидетельствует о желании поднять выручку, но не прибыльность в фискальном году, заканчивающемся в марте 2025-го. Рост EBITA на 2 п.п. год к году в тот же период оценивается экспертами как «чересчур оптимистичный» прогноз. Изменения на международном рынке последовали за февральским снижением цен на более 100 облачных предложений Alibaba в КНР, которое начало ценовую войну, поскольку конкуренты вроде JD тут же предложили собственные дисконты. Более того, это уже второе понижение цен Alibaba Cloud за последний год. Новые дисконты, в частности, ожидают существующих международных клиентов. Дополнительно компания обещает увеличить дисконты и улучшить другие условия для продавцов-посредников. Также ИИ-платформа PAI-Lingjun станет доступна в Сингапуре. В целом в Alibaba Cloud намерены не только смягчить условия для клиентов, но и дать понять, что компанией заложена основа для долгосрочного стратегического развития.

22.03.2024 [16:52], Владимир Мироненко

Рост выручки VK Cloud за 2023 год составил 75,4 %VK сообщила финансовые результаты IV квартала и всего 2023 года. По итогам квартала выручка компании выросла на 34 % год к году до 42,5 млрд руб. Выручка за год составила 132,8 млрд руб., превысив показатель 2022 года на 36 %. Наибольший рост показал сегмент «Технологии для бизнеса» (VK Tech), увеличивший выручку в 2023 году на 67,5 % до 9,7 млрд руб. Основными драйверами роста сегмента были облачные сервисы платформы VK Cloud (рост год к году на 75,4 %) и коммуникационные решения VK WorkSpace (рост — 68 %). Выручка HR Tech-сервисов увеличилась за год в 3,1 раза.

Источник изображения: VK По итогам IV квартала выручка VK Cloud выросла год к году в 2 раза, коммуникационной платформы VK WorkSpace — на 36 %, сервисов HR Tech — в 4 раза. Реализация промежуточного ПО для хранения и обработки данных Tarantool увеличилась в 3 раза. Компания сообщила, что в IV квартале 2023 года VK Teams расширил возможности для видеоконференций. За отчётный квартал средняя месячная аудитория сервиса «Облако Mail.ru», входящего в сегмент «Экосистемные сервисы и прочие направления», составила 21,9 млн человек, а средняя дневная аудитория — 2,4 млн человек. Всего за квартал пользователи загрузили в «Облако Mail.ru» около 7,8 млрд файлов. Компания сообщила о формировании резерва сетевого и серверного оборудования. В частности, VK приступила к строительству собственных ЦОД с целью масштабирования, повышения надёжности и отказоустойчивости инфраструктуры. Также был реализован ряд технических обновлений и программ по повышению информационной безопасности и защите персональных данных пользователей.

21.03.2024 [23:54], Владимир Мироненко

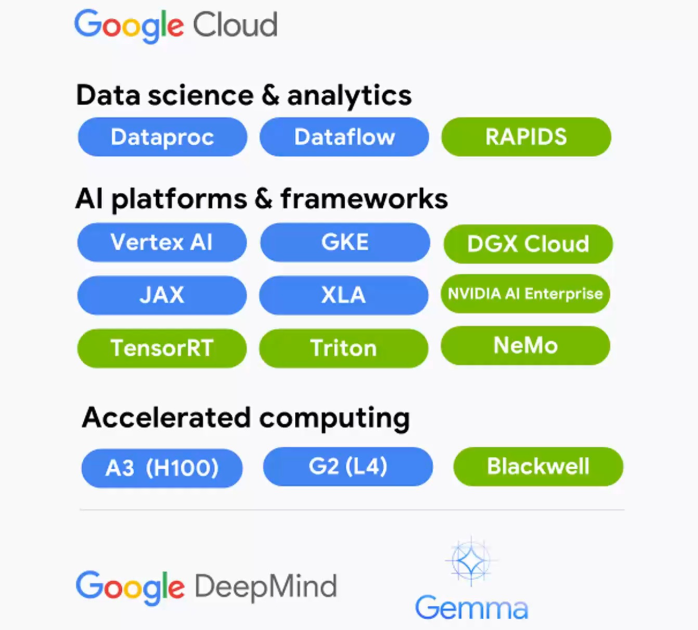

В Google Cloud появятся ускорители NVIDIA Grace BlackwellGoogle Cloud и NVIDIA объявили о расширении партнёрства, в рамках которого новая ИИ-платформа NVIDIA Grace Blackwell и NVIDIA DGX Cloud на её основе появятся в Google Cloud Platform, а клиентам станут доступны инференс-микросервисы NVIDIA NIM. Также было сказано об общедоступности DGX Cloud на базе NVIDIA H100.

Источник изображения: NVIDIA Среди ключевых нововведений отмечены следующие:

21.03.2024 [00:51], Владимир Мироненко

Облачный ИИ-суперкомпьютер AWS Project Ceiba получит 21 тыс. суперчипов NVIDIA GB200

aws

b100

dgx cloud

gb200

gtc 2024

hardware

nvidia

ии

инференс

информационная безопасность

облако

суперкомпьютер

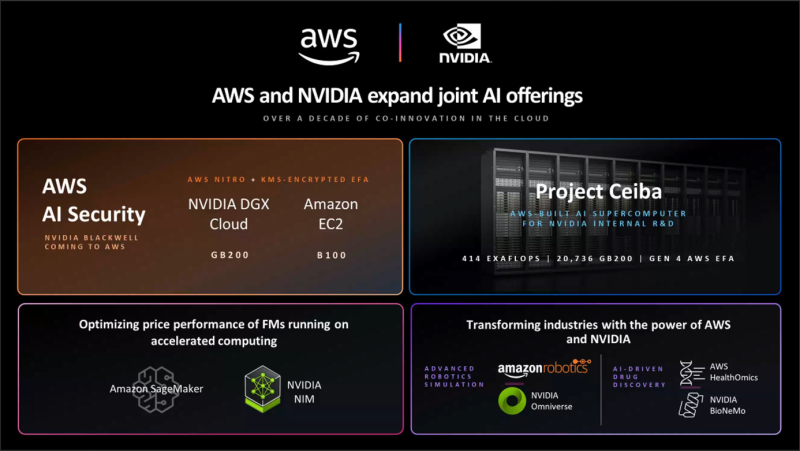

Amazon Web Services (AWS) и NVIDIA объявили о расширении сотрудничества, в рамках которого ускорители GB200 и B100 вскоре появятся в облаке AWS. Кроме того, компании объявили об интеграции Amazon SageMaker с NVIDIA NIM для предоставления клиентам более быстрого и дешёвого инференса, о появлении в AWS HealthOmics новых базовых моделей NVIDIA BioNeMo, а также о поддержке AWS обновлённой платформы NVIDIA AI Enterprise. Сотрудничество двух компаний позволило объединить в единую инфраструктуру их новейшие технологии, в том числе многоузловые системы на базе чипов NVIDIA Blackwell, ПО для ИИ, AWS Nitro, сервис управления ключами AWS Key Management Service (AWS KMS), сетевые адаптеры Elastic Fabric (EFA) и кластеры EC2 UltraCluster. Предложенная инфраструктура и инструменты позволят клиентам создавать и запускать LLM с несколькими триллионами параметров быстрее, в больших масштабах и с меньшими затратами, чем позволяли EC2-инстансы с ускорителями NVIDIA прошлого поколения. AWS предложит кластеры EC2 UltraClusters из суперускорителей GB200 NVL72, которые позволят объединить тысячи чипов GB200. GB200 будут доступны и в составе инстансов NVIDIA DGX Cloud. AWS также предложит EC2 UltraClusters с ускорителями B100. Amazon отмечает, что сочетание AWS Nitro и NVIDIA GB200 ещё больше повысит защиту ИИ-моделей: GB200 обеспечивает шифрование NVLink, EFA шифрует данные при передаче между узлами кластера, а KMS позволяет централизованно управлять ключами шифрования. Аппаратный гипервизор AWS Nitro, как и прежде, разгружает CPU узлов, беря на себя обработку IO-операций, а также защищает код и данные во время работы с ними. Эта возможность, доступная только в сервисах AWS, была проверена и подтверждена NCC Group. Инстансы с GB200 поддерживают анклавы AWS Nitro Enclaves, что позволяет напрямую взаимодействовать с ускорителем и данными в изолированной и защищённой среде, доступа к которой нет даже у сотрудников Amazon. Чипы Blackwell будут использоваться в обновлённом облачном суперкомпьютере AWS Project Ceiba, который будет использоваться NVIDIA для исследований и разработок в области LLM, генерация изображений/видео/3D, моделирования, цифровой биологии, робототехники, беспилотных авто, предсказания климата и т.д. Эта первая в своём роде машина на базе GB200 NVL72 будет состоять из 20 736 суперчипов GB200, причём каждый из них получит 800-Гбит/с EFA-подключение. Пиковая FP8-производительность системы составит 414 Эфлопс.

20.03.2024 [02:17], Владимир Мироненко

Oracle и NVIDIA предложат суверенные ИИ-фабрики

dgx cloud

gb200

gtc 2024

nvidia

oracle

oracle cloud infrastructure

software

ии

конфиденциальность

облако

частное облако

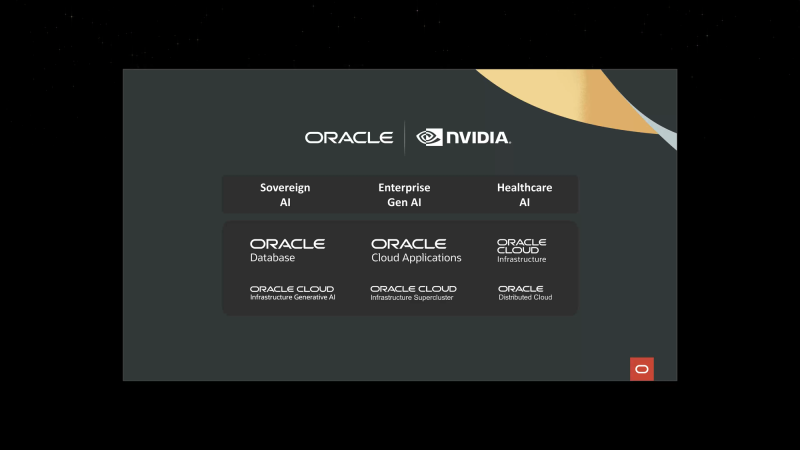

Oracle и NVIDIA объявили о расширении сотрудничества для предоставления суверенного ИИ клиентам по всему миру — программно-аппаратные решения обеих компаний позволят правительствам и предприятиями формировать ИИ-фабрики, говорится в пресс-релизе. Облачные сервисы Oracle используют ряд платформ NVIDIA, включая аппаратную инфраструктуру и программную платформу NVIDIA AI Enterprise, в том числе недавно анонсированные микросервисы вывода NVIDIA NIM. Такие ИИ-фабрики позволят развернуть облачные сервисы, работающие локально и размещённые в безопасных кампусах на территории страны или организации. Сочетание полнофункциональной ИИ-платформы NVIDIA с корпоративным ИИ-инструментами Oracle, которые можно развернуть в выделенном регионе OCI, позволит получить современное ИИ-решение с повышенным уровенем контроля, защиты и безопасности. По словам Oracle, компания является единственным гиперскейлером, способным предоставлять ИИ-решения и полноценные облачные услуги локально и в любом месте. Oracle также задействует чипы NVIDIA Blackwell (GB200 и B200) в OCI Supercluster и OCI Compute. OCI Supercluster станет значительно быстрее благодаря новым bare metal-инстансам, RDMA-сети со сверхмалой задержкой и высокопроизводительному хранилищу. В OCI появятся и сервисы NVIDIA NIM и CUDA-X, а также NVIDIA NeMo Retriever. Наконец, в DGX Cloud on OCI станут доступны инстансы на базе суперускорителей GB200 NVL72 для работы с LLM с триллионами параметров. Полный кластер DGX Cloud будет включать более 20 тыс. ускорителей GB200, интерконнект NVLink 5 и сеть NVIDIA InfiniBand XDR.

01.03.2024 [13:32], Сергей Карасёв

Alibaba значительно снизила цены на облачные услуги в КитаеОблачная платформа Alibaba Cloud, по сообщению ресурса The Register, существенно снизила стоимость услуг для клиентов в Китае, которые заключают многолетние соглашения на обслуживание. Цены на определённые сервисы на базе Alibaba Cloud Elastic Compute Service (ECS) снижены на 36 %. В рамках некоторых соглашений тарифы на объектное хранилище упали на 55 % — при условии увеличения сроков резервирования ресурсов Alibaba Cloud с одного года до двух–пяти лет. Стоимость облачных баз данных снижена до 40 %. При этом удвоен объём бесплатного трафика: он теперь составляет 20 Гбайт против прежних 10 Гбайт. Новая политика, как ожидается, поможет платформе Alibaba Cloud увеличить количество клиентов в КНР и дополнительно стимулировать местные предприятия к переходу на облачные услуги. Кроме того, снижение цен может способствовать развитию приложений на основе ИИ. Причём это уже второе снижение тарифов за год. Ранее облачное подразделение Alibaba столкнулось со снижением темпов роста. В конце прошлого года Alibaba отказалась от планов по выделению облачного бизнеса в самостоятельную публичную компанию. Связано это с ужесточение санкций со стороны США. Говорится, что политика американских властей может негативно повлиять на возможности группы предлагать облачные продукты и услуги, а также выполнять обязательства по существующим контрактам. В такой ситуации Alibaba вынуждена более активно развивать облачный бизнес на китайском рынке. Гиперскейлер также стремился избавиться от низкорентабельных клиентов. Alibaba — не единственная компания, которая пытается сделать долгосрочные контракты более привлекательными для заказчиков. AWS и Microsoft Azure уже сделали резервирование мощностей самым доступным способом потребления своих услуг. Эта тактика позволяет более предсказуемо оценивать расходы на развитие и поддержание облачных инфраструктур.

27.02.2024 [20:45], Руслан Авдеев

Huawei Cloud запустит облачный регион в Египте и построит ИИ-центр в ГонконгеУже в следующем месяце в Египте должен заработать новый облачный регион компании Huawei. Datacenter Dynamics сообщает, что у компании есть и другие планы — она намерена построить облачный вычислительный ИИ-центр в Гонконге. Это первый проект такого рода за пределами материкового Китая. Регион в Египте станет очередным дополнением к 85 зонам Huawei Cloud, разбросанным по 30 странам и территориям планеты. В Китае Huawei является вторым по величине облачным провайдером, но наращивает и глобальное присутствие. Только в прошлом году она ввела в эксплуатацию облачные регионы в Турции и Саудовской Аравии. Кроме того, компания активно осваивает рынки облачных сервисов Латинской Америки. В частности, ведётся строительство регионов в Бразилии и Мексике. Пока нет данных, в каком ЦОД будет размещён египетский регион. Ещё в 2019 году Huawei сообщала о намерении арендовать ЦОД Telecom Egypt в Каире, но, похоже, с тех пор планы по экспансии в Африке и на Ближнем Востоке изменились. Заодно Huawei поделилась планами создания облачного ИИ-центра в Гонконге. Хотя компания имеет несколько подобных объектов на материковой территории КНР, в Гонконге пока ничего подобного у неё нет. При этом в компании назвали ИИ одним из приоритетов для её облачных проектов. Сейчас у оператора есть облачные объекты в материковом Китае и Гонконге, Ирландии, Нидерландах, Франции, Таиланде, Сингапуре, Индонезии, Саудовской Аравии, Турции, Южной Африке, Бразилии, Аргентине, Перу, Чили и других странах. В то же время многие государства по-прежнему считают компанию поставщиком услуг с высоким риском из-за вероятных тесных связей с китайскими властями и крайне напряжённых отношений с США. |

|