Материалы по тегу: amd

|

17.11.2024 [11:32], Сергей Карасёв

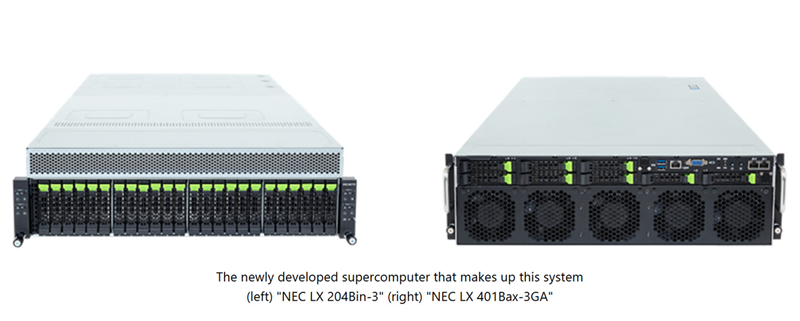

NEC создаст в Японии суперкомпьютер на базе Intel Xeon 6900P и AMD Instinct MI300A для исследований термоядерного синтезаКорпорация NEC займётся созданием нового НРС-комплекса, который планируется ввести в эксплуатацию в Японии в июле 2025 года. Система, базирующаяся на компонентах AMD и Intel, будет использоваться для различных исследований и разработок в области термоядерного синтеза. Заказ на создание суперкомпьютера поступил от Национальных институтов квантовой науки и технологий Японии (QST) при Национальном агентстве исследований и разработок (ANID), а также от Национального института термоядерных наук (NIFS) в составе Национальных институтов естественных наук (NINS). Система будет установлена в Институте термоядерной энергии Rokkasho (входит в QST) в Аомори (Япония). Основой проектируемого суперкомпьютера послужат 360 узлов NEC LX 204Bin-3, в состав каждого из которых войдут два процессора Intel Xeon 6900P поколения Granite Rapids (всего 720 чипов) и память DDR5 MRDIMM. Кроме того, будут задействованы 70 узлов NEC LX 401Bax-3GA, несущих на борту по четыре ускорителя AMD Instinct MI300A (в общей сложности 280 изделий). Говорится о применении интерконнекта InfiniBand с 400G-коммутаторами NVIDIA QM9700, а также хранилища DDN EXAScaler ES400NVX2 вместимостью 42,2 Пбайт с файловой системой Lustre. Для управления рабочими нагрузками будет использоваться софт Altair PBS Professional.

Источник изображения: NEC Ожидается, что производительность суперкомпьютера достигнет 40,4 Пфлопс. Это в 2,7 раза больше суммарных показателей двух нынешних НРС-систем, установленных в рамках независимых проектов QST и NIFS. Учёные намерены применять новый НРС-комплекс для точного прогнозирования экспериментов и создания сценариев работы для Международного экспериментального термоядерного реактора (ITER). Кроме того, мощности суперкомпьютера будут востребованы исследовательскими группами токамака Satellite Tokamak JT-60SA и электростанции DEMO (DEMOnstration Power Plant), использующей термоядерный синтез.

14.11.2024 [14:30], Руслан Авдеев

AMD сократит 4 % штата и сосредоточится на ИИ и серверном рынкеКомпания AMD подтвердила планы сокращения около 4 % штата по всему миру. The Register сообщает, что речь идёт об увольнении около 1 тыс. человек из приблизительно 26 тыс. Новость появилась после публикации воодушевляющего финансового отчёта AMD за III квартал — чистая прибыль составила $771 млн при выручке $6,8 млрд. Рост год к году составил 158 % и 18 % соответственно. Несмотря на это, сотрудников решено уволить, чтобы уделить больше внимания ИИ-продуктам и рынку серверных решений. Недавняя серия увольнений Intel была значительно масштабнее, поскольку работу потеряли около 15 тыс. человек в самых разных подразделения. Впрочем, у AMD не всё так замечательно, как могло бы быть. Выручка игрового подразделения год к году упала на 69 %. В самой компании объясняют это падением доходов от кастомных решений. Другими словами, упал спрос на чипсеты для PlayStation и Xbox. Это вполне ожидаемо — желающие купить консоли текущего поколения на базе аппаратных решений AMD в основном уже приобрели их и ждут нового поколения.

Источник изображения: Campaign Creators/unsplash.com Некоторые эксперты сравнивают подходы AMD и Intel с хирургической операцией и пропуском подразделений через измельчитель. В AMD подчёркивают, что новые меры — не показатель финансовой нестабильности компании. Речь идёт именно о смене фокуса на более маржинальные продукты в сферах ЦОД и ИИ. Ранее уже сообщалось, что Intel теряет позиции на рынке серверных чипов под натиском AMD, а уже в ноябре появилась информация, что компания отстала от AMD и NVIDIA по продажам ускорителей. Представитель AMD заявил The Register, что, корректируя распределение ресурсов в соответствии с ключевыми возможностями роста, приходится принимать ряд целевых мер, которые, к сожалению для руководства, ведут к сокращению сотрудников. В компании обещают отнестись к ним «с уважением» и помочь по мере возможностей. Какие именно подразделения подвергнутся сокращениям, AMD уточнять не стала, сообщив, что принимает «целевые меры», касающиеся разных функций в компании.

11.11.2024 [11:43], Сергей Карасёв

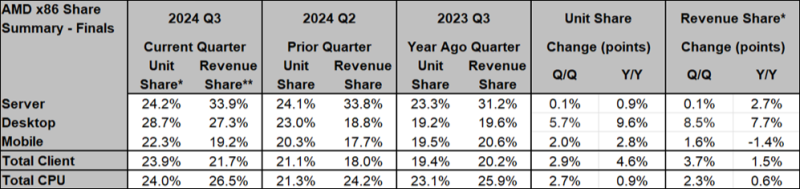

AMD наращивает долю на рынке серверных чипов на фоне проблем IntelКомпания AMD быстро укрепляет позиции на рынке процессоров с архитектурой х86. Причём, как сообщает ресурс Tom's Hardware, ссылаясь на данные аналитиков Mercury Research, речь идёт обо всех ключевых сегментах — серверном, настольном и мобильном. По итогам III квартала 2024 года доля AMD на глобальном рынке CPU с учётом всех сегментов достигла 24,0 % в штучном выражении. Для сравнения: во II четверти 2024-го этот показатель равнялся 21,3 %, а годом ранее — 23,1 %. Если рассматривать продажи в денежном исчислении, то AMD заняла 26,5 % против 24,2 % во II квартале текущего года и 25,9 % в III квартале 2023-го. AMD наращивает долю на рынке серверных чипов: показатель достиг 24,2 % в натуральном выражении. Во II четверти 2024 года компания контролировала 24,1 % сегмента, а годом ранее — 23,3 %. Если оценивать отгрузки в деньгах, то доля AMD зафиксирована на отметке 33,9 %. Кварталом ранее это значение составляло 33,8 %, а год назад — 31,2 %. В исследовании отмечается, что Intel остаётся лидером в области серверных процессоров с архитектурой х86: доля корпорации в III квартале 2024 года равна 75,8 %. Тем не менее, AMD смогла реализовать больше чипов высокого класса, на что указывает более высокая доля рынка в денежном выражении по сравнению с натуральным. Кроме того, впервые подразделение дата-центров AMD превзошло по выручке группу DCAI в составе Intel — $3,549 млрд против $3,3 млрд по итогам III квартала 2024 года. Отчёт не включает заказные чипы AMD, которые устанавливаются в игровые консоли, а также процессоры для оборудования IoT. Успехи AMD отчасти связаны с проблемами Intel, которая оказалась в очень сложном положении: она борется с жёсткой конкуренцией, а прогресс в сфере ИИ оставляет желать лучшего. Intel вынуждена сокращать тысячи сотрудников по всему миру, уменьшать офисные площади и отказываться от неактуальных продуктов ради улучшения финансовых показателей.

05.11.2024 [15:40], Сергей Карасёв

MONAKA + Instinct: AMD и Fujitsu вместе создадут Arm-платформы для ИИ и HPCAMD и Fujitsu объявили о подписании меморандума о взаимопонимании с целью формирования стратегического партнёрства, направленного на создание вычислительных платформ для ИИ и HPC. Предполагается, что сотрудничество охватит различные сферы — от разработки специализированных решений до коммерциализации. Речь идёт об объединении передовых аппаратных решений в области CPU и GPU с сопутствующим ПО. Партнёры намерены содействовать формированию открытой экосистемы для задач ИИ. В частности, упомянуты Arm-процессоры Fujitsu MONAKA и ускорители AMD Instinct. Стороны намерены задействовать открытый программный стек AMD ROCm и специализированный софт Fujitsu для изделий с архитектурой Arm. В целом, сотрудничество будет сосредоточено на трёх ключевых направлениях — инжиниринг, экосистемы и бизнес. Партнёры рассчитывают создать инновационные вычислительные платформы для ИИ и HPC к 2027 году. AMD и Fujitsu также будут сообща работать над маркетинговыми кампаниями и улучшать взаимодействие с заказчиками. Например, планируется создание совместного центра для клиентов. «Объединяя инновационную технологию графических чипов AMD с эффективными и высокопроизводительными процессорами Fujitsu, мы стремимся создать среду, в которой больше компаний смогут использовать инструменты ИИ при одновременном снижении энергопотребления в дата-центрах», — говорит Вивек Махаджан (Vivek Mahajan), корпоративный вице-президент и технический директор Fujitsu. Нужно отметить, что ранее Fujitsu заключила соглашение о сотрудничестве с Supermicro. Компании займутся разработкой СЖО для ЦОД, а также серверов следующего поколения на чипах Fujitsu MONAKA для широкого спектра рабочих нагрузок — от ИИ и НРС до облачных и периферийных задач. Два года назад AMD также подписала аналогичное соглашение о сотрудничестве с европейским разработчиком серверных Arm-процессоров SiPearl.

01.11.2024 [12:28], Руслан Авдеев

1 ГВт для AMD Instinct: TECfusions сформирует для ИИ-облака TensorWave масштабную инфраструктуру ЦОДСпециализирующаяся на строительстве и управлении ЦОД американская TECfusions заключила соглашение с TensorWave, предусматривающее предоставление последней ИИ-инфраструктуры. По информации Datacenter Dynamics, в рамках договора TensorWave будет арендовать у оператора 1 ГВт ёмкости ЦОД. По словам представителя TECfusions, сотрудничество знаменует собой переломный момент в развитии ИИ-инфраструктуры. Как говорит компания, в ЦОД в Кларксвилле (Clarksville) уже размещён один из крупнейших в мире кластеров ускорителей, а сделка является свидетельством готовности TECfusions к самым ресурсоёмким проектам. Развёртывание 1 ГВт будет происходить поэтапно, но доступ к значимой доле ёмкости должен появиться уже к началу 2025 года. Tecfusion намерена использовать локальные генерирующие мощности, функционирующие в основном на природном газе, для обеспечения стабильных поставок энергии и во избежание скачков цен на неё. Компания уже владеет микросетями на территории ЦОД в Нью-Кенсингтоне (200 МВт, Пенсильвания) и Кларксвилле (220 МВт, Вирджиния).

Источник изображения: Henry Deng/unsplash.com Партнёрство сформировано по итогам SAFE-раунда финансирования TensorWaves, в ходе него привлечено $43 млн. Основанный в 2023 году стартап из Лас-Вегаса предоставляет клиентам доступ к вычислительным ИИ-мощностям на основе ускорителей AMD. На полученные средства TensorWave оснастит ЦОД ускорителями AMD Instinct MI300X, расширит команду и начнёт подготовку к внедрению следующего поколения ускорителей Instinct MI325X. На IV квартал намечен запуск новой инференс-платформы Manifest в IV. Как заявляют в TensorWave, способность TECfusions выводить на рынок масштабные, готовые к ИИ-задачам ёмкости за считанные месяцы значительно ускорит освоение рынка компанией. Партнёрство имеет ключевое значение для сохранения конкурентоспособности в ИИ-секторе. Сейчас TECfusions управляет тремя действующими ЦОД — в Аризоне, Пенсильвании и Вирджинии. В сентябре оператор объявил о завершении строительства третьего зала для ИИ-оборудования в Кларксвилле. Теперь общая ёмкость этого дата-центра достигла 34,5 МВт. До конца года будет оснащён четвёртый зал на 13,5 МВт.

31.10.2024 [11:33], Сергей Карасёв

Cisco представила ИИ-сервер UCS C885A M8 на базе NVIDIA H100/H200 или AMD Instinct MI300XКомпания Cisco анонсировала сервер высокой плотности UCS C885A M8, предназначенный для решения задач в области ИИ, таких как обучение больших языковых моделей (LLM), тонкая настройка моделей, инференс, RAG и пр. Устройство выполнено в форм-факторе 8U. В зависимости от модификации устанавливаются два процессора AMD EPYC 9554 поколения Genoa (64 ядра; 128 потоков; 3,1–3,75 ГГц; 360 Вт) или два чипа EPYC 9575F семейства Turin (64 ядра; 128 потоков; 3,3–5,0 ГГц; 400 Вт). Доступны 24 слота для модулей DDR5-600 суммарным объёмом 2,3 Тбайт. В максимальной конфигурации могут быть задействованы восемь SXM-ускорителей NVIDIA H100, H200 или AMD Instinct MI300X. Каждый ускоритель дополнен сетевым адаптером NVIDIA ConnectX-7 или NVIDIA BlueField-3 SuperNIC. Кроме того, в состав сервера входит DPU BlueField-3. Слоты расширения выполнены по схеме 5 × PCIe 5.0 x16 FHHL плюс 8 × PCIe 5.0 x16 HHHL и 1 × OCP 3.0 PCIe 5.0 x8 (для карты X710-T2L 2x10G RJ45 NIC). Новинка оборудована загрузочным SSD вместимостью 1 Тбайт (M.2 NVMe), а также 16 накопителями U.2 NVMe SSD на 1,92 Тбайт каждый. Установлены два блока питания мощностью 2700 Вт и шесть блоков на 3000 Вт с возможностью горячей замены. Cisco также представила инфраструктурные стеки AI POD, адаптированные для конкретных вариантов использования ИИ в различных отраслях. Они объединяют вычислительные узлы, сетевые компоненты, средства хранения и управления. Стеки, как утверждается, обеспечивают хорошую масштабируемость и высокую эффективность при решении ИИ-задач.

30.10.2024 [13:53], Владимир Мироненко

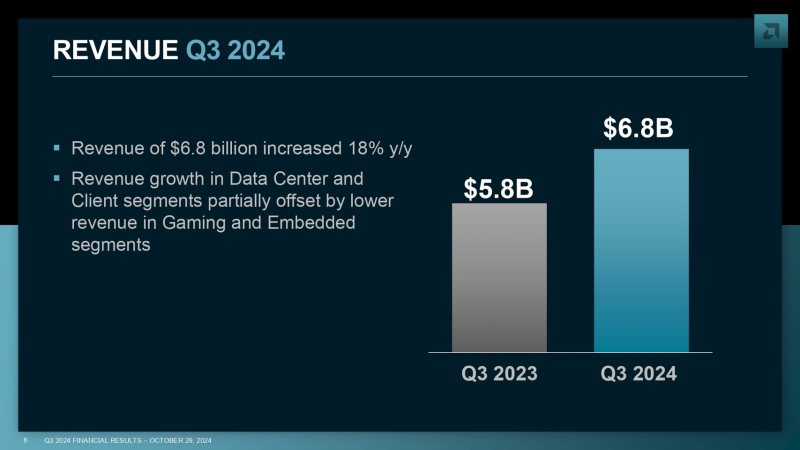

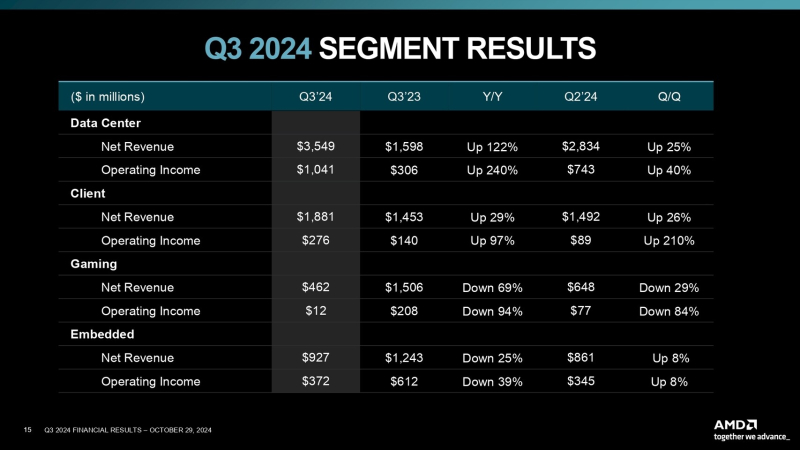

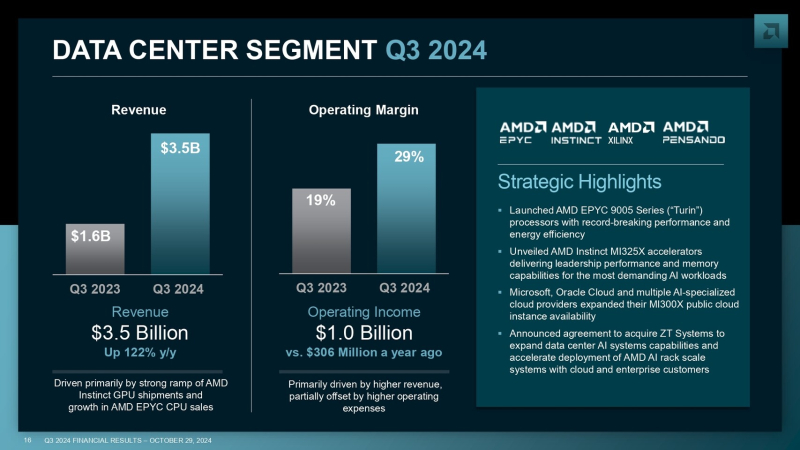

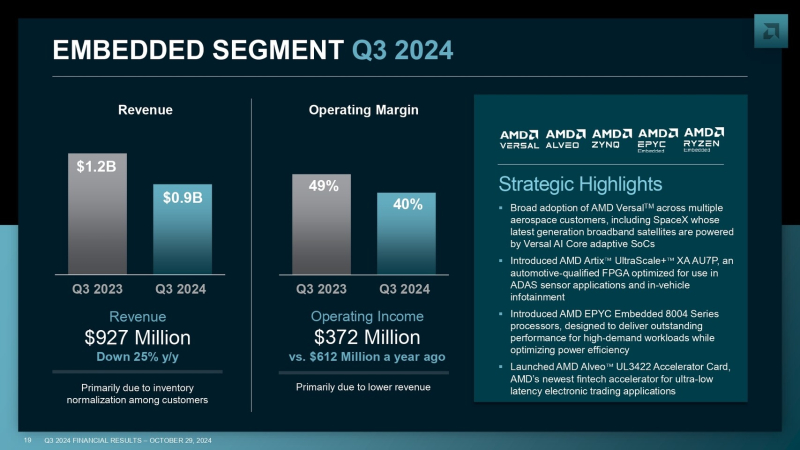

Квартальные показатели AMD превысили прогнозы аналитиков, но инвесторы остались недовольны — акции упали на 7 %Advanced Micro Devices (AMD) сообщила финансовые результаты III квартала, завершившегося 28 сентября 2024 года. Несмотря на то, что прибыль совпала с прогнозами, а выручка немного превзошла ожидания Уолл-стрит, акции компании упали после оглашения итогов на 7 %, поскольку инвесторов не устроил прогноз на IV квартал и ожидания по выпуску ИИ-ускорителей в 2025 году. Выручка AMD в III квартале составила $6,82 млрд, что выше результата аналогичного квартала в 2023 году на 18 %, а также выше консенсус-прогноза аналитиков, опрошенных LSEG, составившего $6,71 млрд. Чистая прибыль (GAAP) в размере $771 млн или 47 центов на акцию превысила на 158 % показатель III квартала прошлого года, равный $299 млн (18 центов на акцию). Скорректированная прибыль (Non-GAAP) равняется $1,50 млрд или $0,92 на акцию, что на 33 % больше показателя годичной давности и совпало с консенсус-прогнозом аналитиков, предоставленным LSEG. «Мы добились сильных финансовых результатов в III квартале с рекордной выручкой, обусловленной ростом продаж продуктов для ЦОД EPYC и Instinct, а также высоким спросом на наши процессоры Ryzen для ПК», — заявила генеральный директор AMD д-р Лиза Су (Lisa Su). Выручка компании в сегменте ЦОД выросла более чем в два раза (на 122 %) год к году и на 25 % последовательно, составив $3,5 млрд. Драйверами роста были рост поставок ускорителей AMD Instinct и увеличение продаж процессоров AMD EPYC. В отчётном квартале продажи чипов для ЦОД принесли AMD более половины выручки. Лиза Су не назвала конкретные цифры продаж, отметив, что выручка от реализации ускорителей AMD Instinct в минувшем квартале составила более $1,5 млрд. Для сравнения, во II квартале было продано AMD Instinct на более, чем $1 млрд. Продажи в сегменте встраиваемых систем упали год к году на 25% до $927 млн, поскольку клиенты привели к норме уровень запасов. Впрочем, здесь зафиксированы признаки восстановления, так как продажи выросли последовательно на 8 %. Сегмент клиентских решений увеличил выручку год к году на 29 % до $1,9 млрд, а в игровом сегменте выручка упала год к году на 69 % до $462 млн. В IV квартале 2024 года AMD ожидает, что выручка составит около $7,5 млрд ± $300 млн, что в средней точке выше прошлогоднего показателя на 22 % и соответствует консенсус-прогнозу аналитиков Уолл-стрит, ожидающим $1,16 скорректированной прибыли (Non-GAAP) на акцию при $7,54 млрд выручки. Также AMD повысила прогноз продаж по ИИ-ускорителям до $5 млрд в 2025 году.

30.10.2024 [11:49], Сергей Карасёв

OpenAI разрабатывает собственные ИИ-чипы совместно с Broadcom и TSMC, а пока задействует AMD Instinct MI300XКомпания OpenAI, по информации Reuters, разрабатывает собственные чипы для обработки ИИ-задач. Партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC ориентировочно в 2026 году. Слухи о том, что OpenAI обсуждает с Broadcom возможность создания собственного ИИ-ускорителя, появились минувшим летом. Тогда говорилось, что эта инициатива является частью более масштабной программы OpenAI по увеличению вычислительных мощностей компании для разработки ИИ, преодолению дефицита ускорителей и снижению зависимости от NVIDIA. Как теперь стало известно, OpenAI уже несколько месяцев работает с Broadcom над своим первым чипом ИИ, ориентированным на задачи инференса. Соответствующая команда разработчиков насчитывает около 20 человек, включая специалистов, которые ранее принимали участие в проектировании ускорителей TPU в Google, в том числе Томаса Норри (Thomas Norrie) и Ричарда Хо (Richard Ho). Подробности о проекте не раскрываются. Reuters, ссылаясь на собственные источники, также сообщает, что OpenAI в дополнение к ИИ-ускорителям NVIDIA намерена взять на вооружение решения AMD, что позволит диверсифицировать поставки оборудования. Речь идёт о применении изделий Instinct MI300X, ресурсы которых будут использоваться через облачную платформу Microsoft Azure. Это позволит увеличить вычислительные мощности: компания OpenAI только в 2024 году намерена потратить на обучение ИИ-моделей и задачи инференса около $7 млрд. Вместе с тем, как отмечается, OpenAI пока отказалась от амбициозных планов по созданию собственного производства ИИ-чипов. Связано это с большими финансовыми и временными затратами, необходимыми для строительства предприятий.

29.10.2024 [11:45], Сергей Карасёв

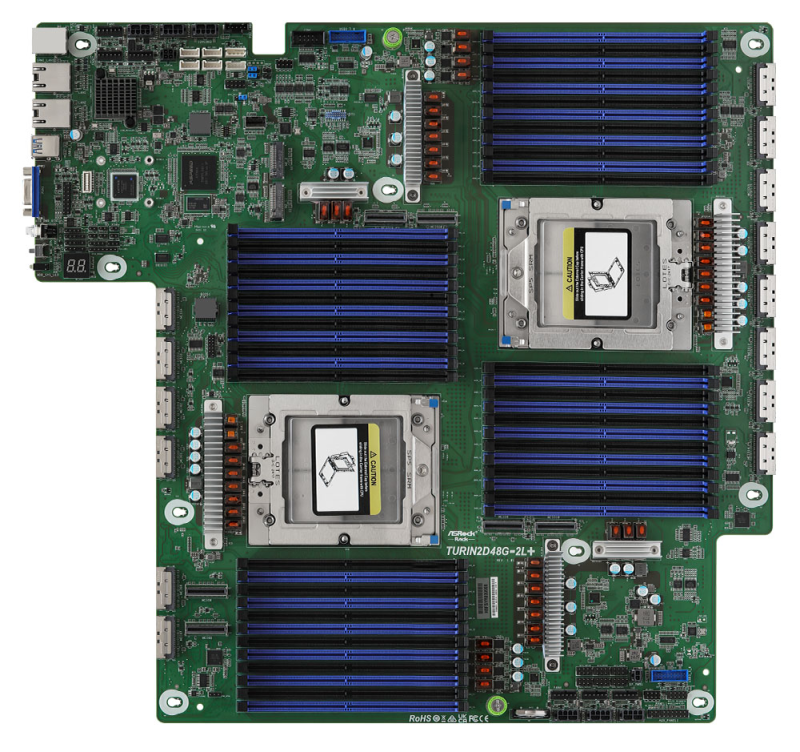

ASRock Rack представила плату TURIN2D48G-2L+, которая поддерживает 24 Тбайт DDR5Компания ASRock Rack анонсировала материнскую плату TURIN2D48G-2L+, предназначенную для построения серверов на платформе AMD. Новинка, выполненная в проприетарном форм-факторе, допускает установку двух процессоров семейства EPYC 9005 (Turin) или EPYC 9004 (Genoa) в исполнении Socket SP5 (LGA 6096) с показателем TDP до 500 Вт. Особенность платы заключается в наличии 48 слотов для модулей DDR5-5200 (24 слота в расчёте на CPU). При использовании изделий RDIMM-3DS ёмкостью 512 Гбайт суммарный объём ОЗУ в системе может достигать 24 Тбайт. Реализованы 12 коннекторов MCIO (PCIe 5.0 / CXL 2.0 x8), четыре разъёма MCIO (PCIe 5.0 / CXL 2.0 x8 или 8 × SATA-3), по два коннектора MCIO (PCIe 5.0 или 8 × SATA-3) и MCIO (PCIe 5.0 x8). Есть также разъём SlimSAS (PCIe 3.0 x2) и два коннектора M.2 для SSD типоразмеров 22110/2280 с интерфейсом PCIe 3.0 x4 или SATA-3. В общей сложности могут быть задействованы до 34 портов SATA-3 для подключения накопителей. В оснащение входят BMC-контроллер ASPEED AST2600, двухпортовый сетевой адаптер Intel i350 стандарта 1GbE и контроллер Realtek RTL8211F, на базе которого выполнен выделенный сетевой порт управления. Интерфейсный блок содержит три гнезда RJ45 для сетевых кабелей, два порта USB 3.2 Gen1 Type-A и аналоговый разъём D-Sub. Через разъёмы на плате можно использовать ещё два порта USB 3.2 Gen1, последовательный порт и пр. Есть шесть гнёзд для подключения вентиляторов охлаждения. Диапазон рабочих температур — от +10 до +35 °C.

20.10.2024 [11:09], Сергей Карасёв

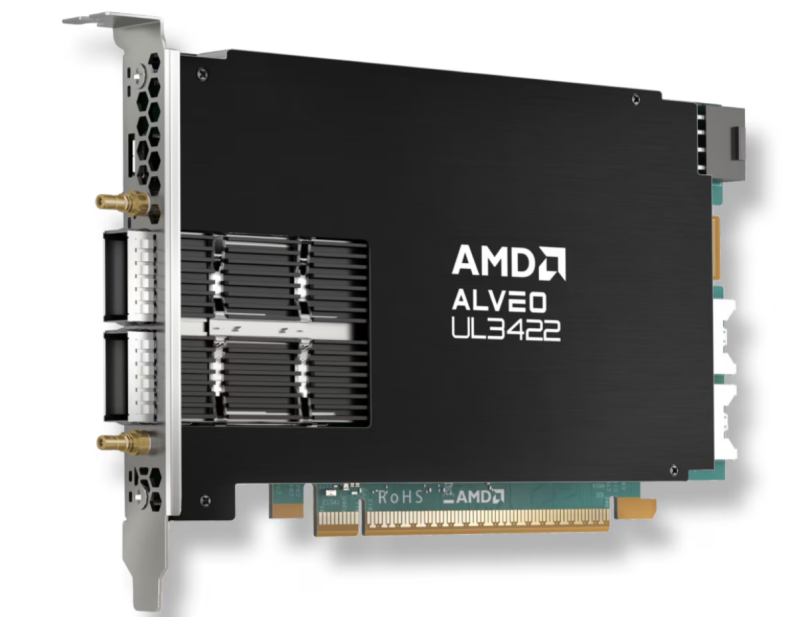

AMD выпустила ускоритель для трейдеров Alveo UL3422 на базе FPGA Virtex UltraScale+ VU2PКомпания AMD анонсировала изделие Alveo UL3422: это, как утверждается, самый быстрый в мире однослотовый ускоритель половинной длины (FHHL) для брокерских и биржевых приложений. Новинка уже поставляется заказчикам из финансового сектора по всему миру. В устройстве применена FPGA Virtex UltraScale+ VU2P. Конфигурация включает 32 трансивера с ультранизкой задержкой, 787 тыс. LUT и 1680 DSP. В состав FPGA входят 256 Мбайт встроенной памяти — 76 Мбайт блочной RAM и 180 Мбайт UltraRAM. Заявленная задержка на уровне трансиверов составляет менее 3 нс. Карта использует интерфейс PCIe 4.0 x8 (коннектор x16). Заявленный показатель TDP равен 120 Вт; используется пассивное охлаждение. В оснащение входят 16 Гбайт памяти DDR4-2400. Предусмотрены два разъёма QSFP-DD (16×10/25G) и два коннектора ARF6. Ускоритель Alveo UL3422 может использоваться в комплексе с платформой разработки Vivado Design Suite. AMD также предоставляет клиентам среду разработки FINN с открытым исходным кодом и поддержкой сообщества, что позволяет интегрировать модели ИИ с низкими задержками в высокопроизводительные торговые системы. FINN использует PyTorch и методы квантования нейронных сетей. Ускоритель поставляется с набором референсных проектов и тестов производительности. Среди ключевых сфер применения новинки названы торговые операции со сверхнизкими задержками и анализ рисков. |

|