Материалы по тегу: разработка

|

21.08.2024 [15:02], Елена Копытова

AMD взялась за поддержку современных EPYC во FreeBSDПроект FreeBSD опубликовал отчёт за II квартал 2024 года, в котором описана проделанная работа ведущими разработчиками BSD. По данным Phoronix, среди выполненных за последний квартал задач FreeBSD Foundation выделяются проекты по улучшению аудиостека, улучшению OpenZFS, переносу VPP (Vector Packet Processing) на FreeBSD и улучшению поддержки беспроводных сетей. Также стало известно, что AMD и FreeBSD Foundation сотрудничают в разработке полноценного драйвера AMD IOMMU. Цель проекта — улучшить поддержку серверов на базе AMD EPYC во FreeBSD, в том числе с более чем 256 ядрами, сделать интеграцию с системой виртуализации Bhyve и другие усовершенствования. «Продолжалась работа над совместным проектом Advanced Micro Devices (AMD) и FreeBSD Foundation по разработке драйвера AMD IOMMU. Этот драйвер позволит FreeBSD полностью поддерживать более 256 ядер с такими функциями, как отображение [mapping] CPU, а также будет включать интеграцию Bhyve. Константин Белоусов работал над различными частями проекта, включая подключение драйвера, определение регистров, парсер таблиц ACPI и реализацию служебных функций. Два ключевых компонента, которые необходимо доделать, — это обработка контекста, которая в основном является обобщением кода Intel DMAR, и создание таблиц страниц. После этого можно будет активировать драйвер AMD для тестирования. Чтобы следить за работой Константина, ищите коммиты в репозитории с тегом «Sponsored by fields for Advanced Micro Devices (AMD) and The FreeBSD Foundation»», — говорится в отчёте.

Источник изображения: FreeBSD Появление поддержки со стороны AMD для сообщества FreeBSD является значимым событием, поскольку ранее только Intel славилась активным вкладом в развитие проекта и предоставлением инженерных ресурсов на протяжении многих лет. В этом свете интересно, является ли поддержка AMD жестом доброй воли или же у компании есть клиенты, которым необходимы совместимость и оптимизации для FreeBSD. Среди крупных игроков, в инфраструктуре которых активно используется FreeBSD, есть, например, Netflix. В последние годы Arm также начала активно участвовать в развитии ОС. Кроме того, FreeBSD продолжает активную работу по поддержке архитектуры RISC-V. Так, уже существует экспериментальная поддержка Bhyve. Кроме того, одной из новых разработок для ядра FreeBSD стало создание Zcond — легковесного механизма условного выполнения, аналогичного интерфейсу static_key в Linux.

26.07.2024 [14:37], Руслан Авдеев

Швейцарские власти переходят на открытое ПОНесколько европейских стран уже делают ставку на открытое ПО (open source) для государственного сектора. По данным ZDNet, на этот раз важный шаг навстречу открытым программным решениям сделала Швейцария, приняв «Федеральный закон об использовании электронных средств выполнения государственных задач» (EMBAG). В частности, он предписывает использование открытого ПО в государственном секторе. Новый закон требует от всех государственных органов раскрыть код программного обеспечения, разработанного ими или для них, за исключением случаев, когда это нецелесообразно по соображениям безопасности или нарушает сторонние права. Такой подход должен способствовать прозрачности, безопасности и эффективности правительственной деятельности. Подобный переход осуществить нелегко. В 2011 году Федеральный верховный суд Швейцарии (Swiss Federal Supreme Court) опубликовал судебное приложение Open Justitia под открытой лицензией. Компания Weblaw, занимающаяся проприетарным юридическим ПО, выступила категорически против такого решения. Разбирательства длились более 10 лет, пока в 2023 году не был принят закон EMBAG. Он не просто разрешает публиковать код программного обеспечения органам власти или их подрядчиками под открытой лицензией, но и требует этого — с учётом названных исключений.

Источник изображения: Henrique Ferreira/unsplash.com По словам сторонников закона, EMBAG открывает большие возможности для правительства, IT-индустрии и общества. Предполагается, что государственный сектор избавится от зависимости от конкретных вендоров, у компаний появится больше возможностей для развития своих цифровых решений, что потенциально позволит снизить себестоимость информационных технологий и улучшить обслуживание налогоплательщиков. Дополнительно EMBAG предписывает публикацию неперсональных и не несущих угрозу безопасности государственных данных в формате Open Government Data (OGD). Другими словами, открытость данных по умолчанию обеспечит большую открытость и многократное практическое применение ПО и информации. Применение EMBAG может послужить примером и другим странам, рассматривающим аналогичные меры. Закон предназначен для продвижения концепции цифрового суверенитета и поощряет инновации и сотрудничество в пределах структур государственного сектора. Федеральное статистическое управление Швейцарии (Swiss Federal Statistical Office, BFS) возглавит применение закона, но организационные и финансовые аспекты всё ещё предстоит прояснить. Некоторые другие страны Европы уже довольно давно поддерживают open source в госструктурах. Например, Национальная жандармерия Франции давно пользуется Linux, а Евросоюз в целом давно способствует продвижению open source с помощью проекта Free and Open Source Software Auditing (FOSSA), направленного на проверку ПО с открытым кодом. Впрочем, многие опасаются, что Еврокомиссия урежет финансирование фонду NGI Zero Commons — важному источнику средств для открытых разработок. В США поддержка «открытой» концепции гораздо ниже, чем в Европе. Доктрина Federal Source Code Policy предписывает федеральным органам делать открытым не менее 20 % выпускаемого ими кода. При этом использование open source решений не обязательно. Управление общих служб США (GSA) также предписывает своим структурам публиковать открытый исходный код, продвигая политику «открытость в первую очередь» при разработке ПО. Другими словами, пока Швейцария фактически является одним из мировых лидеров движения за внедрение open source, Европе и США придётся проделать в этом направлении ещё немало работы.

17.06.2024 [22:49], Илья Коваль

Три квантовых компьютера, NVIDIA DGX Quantum, немножко HPC и облако: в Израиле открыт уникальный центр квантовых вычислений IQCC

aws

gh200

grace

hardware

hpc

nvidia

quantum machines

израиль

квантовые вычисления

квантовый компьютер

облако

разработка

Стартап Quantum Machines, разработчик систем управления квантовыми компьютерами, открыл Израильский центр квантовых вычислений (Israeli Quantum Computing Center, IQCC). Площадка, создание которой было частично профинансировано правительством страны, располагается в Тель-Авивском университете. По словам основателей, это первый в мире центр, располагающий квантовыми компьютерами разных типов, которые интегрированы с системой NVIDIA DGX Quantum, HPC-инфраструктурой и облаком. Приоритетный доступ со скидкой получат исследовательские организации Израиля, но в целом центр будет открыт для компаний со всего света. Как говорят создатели, IQCC — это лучший в мире полигон для создания новых технологий в области квантовых вычислений, а открытая архитектура площадки позволяет регулярно проводить обновления и упрощает дальнейшее масштабирование возможностей и вычислительных мощностей. Сейчас в IQCC установлены 21-кубитный компьютер Galilee от Quantware на сверхпроводящих кубитах (ещё один такой же используется в качестве тестовой платформы) и фотонный компьютер Negev от ORCA (8 кумод). Системы управляются контроллерами OPX1000 от самой Quantum Machines. HPC-инфраструктура представлена DGX A100, четырьмя GH200 и 128 vCPU на базе AMD EPYC 9334 (Genoa). Дополнительные ресурсы можно арендовать в облаке AWS. Для Galilee и Negev доступна интеграция с DGX Quantum, платформой для гибридных квантово-классических вычислений, которая была создана NVIDIA и Quantum Machines и впервые в мире развёрнута именно в IQCC. Управлять компьютерами и разрабатывать ПО можно с использованием Qiskit, QUA, OpenQASM3, QBridge, а также Classiq. К системе организован облачный доступ. В ближайшие месяцы в IQCC будут развёрнуты ещё несколько квантовых компьютеров и QPU.

02.06.2024 [15:30], Владимир Мироненко

NVIDIA объявила о доступности NIM для разработчиков ИИNVIDIA объявила о доступности NVIDIA NIM, микросервисов инференса, которые предоставляют готовые модели в виде заранее оптимизированных контейнеров, доступных для развёртывания в облаках, ЦОД или на рабочих станциях. Это, по словам компании, позволяет разработчикам возможность без труда создавать приложения генеративного ИИ за считанные минуты, хотя ранее на это уходили недели. Сложность приложений генеративного ИИ растёт и часто в них используется несколько моделей с различными возможностями для генерации текста, изображений, видео, речи и т.д. NVIDIA NIM позволяет значительно повысить производительность разработчиков, предоставляя простой стандартизированный способ добавления генеративного ИИ в их приложения. NIM также позволяет компаниям максимизировать свои инвестиции в инфраструктуру. Например, NIM-контейнер с оптимизированным вариантом Meta✴ Llama 3-8B выдаёт втрое больше токенов за единицу времени, чем LLM без оптимизаций. Более 200 технологических партнёров NVIDIA, включая Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI и Synopsys, уже используют NIM, чтобы ускорить развёртывание генеративного ИИ для приложений, специфичных для их индустрии, таких как ИИ-помощники, помощники по созданию кода, цифровые человеческие аватары и многое другое. Кроме того, экосистему NIM поддерживают Canonical, Red Hat, Nutanix, VMware, Kinetica и Redis. Доступна и интеграция с KServe. NIM интегрирован в платформу NVIDIA AI Enterprise. Начиная со следующего месяца участники программы NVIDIA Developer Program получат бесплатный доступ к NIM для исследований, разработки и тестирования. Контейнеры NIM могут включать ПО NVIDIA CUDA, NVIDIA Triton Inference Server и NVIDIA TensorRT-LLM. А на ai.nvidia.com уже доступно более 40 готовых моделей, включая Databricks DBRX, Google Gemma, Meta✴ Llama 3, Microsoft Phi-3, Mistral Large, Mixtral 8x22B и Snowflake Arctic. Компания также представила и NVIDIA BioNeMo NIM для биомедицинской сферы. Ведущие провайдеры ИИ-решений и MLOps-платформ, включая Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot, deepset, Domino Data Lab, LangChain, Llama Index, Replicate, Run.ai, ServiceNow, Securiti AI и Weights & Biases также внедрили NIM. Hugging Face теперь тоже предлагает NIM-контейнейры и позволяет развернуть модели в различных облаках всего за несколько кликов. Микросервисы NIM также интегрированы в AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Наконец, компетенциями в области NIM обзавелись Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS и Wipro. Предприятия могут запускать приложения с поддержкой NIM практически в любом месте, в том числе на сертифицированных NVIDIA системах Cisco, Dell, HPE, Lenovo и Supermicro, а также ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron и Wiwynn. Более того, например, Foxconn и Pegatron уже используют NIM для разработки предметно-ориентированных LLM для собственных производственных нужд.

22.05.2024 [12:54], Сергей Карасёв

Поставщик данных для обучения ИИ Scale AI привлёк $1 млрдСтартап Scale AI, основанный в 2016 году, объявил о проведении раунда финансирования Series F, в ходе которого привлекла $1 млрд, а оценка компании составила $13,8 млрд. Сложные ИИ-модели обучаются на огромных массивах данных, для сбора и подготовки которых может потребоваться много времени. Scale AI предоставляет облачный сервис Generative AI Data Engine, который ускоряет и упрощает этот процесс. Клиенты Scale AI указывают, данные какого типа им необходимы для обучения ИИ-моделей, после чего стартап занимается подготовкой соответствующих наборов. Кроме того, платформа Scale AI упрощает задачу разметки данных. Поддерживается работа с текстовой информацией, изображениями и аудиоматериалами, а также более специализированными данными, такими как журналы датчиков (лидаров) беспилотных автомобилей.

Источник изображения: Scale AI Scale AI также предоставляет ряд дополнительных услуг. В их число входит сервис проверки новый сетей на наличие уязвимостей, галлюцинаций и других проблем. Для организаций государственного сектора компания разработала чат-бота Donovan, который рассчитан на работу с конфиденциальной информацией. Программу финансирования Series F возглавила Accel. Кроме того, средства предоставили существующие инвесторы — Y Combinator, Nat Friedman, Index Ventures, Founders Fund, Coatue, Thrive Capital, Spark Capital, NVIDIA, Tiger Global Management, Greenoaks и Wellington Management. В число новых инвесторов вошли Cisco Investments, DFJ Growth, Intel Capital, ServiceNow Ventures, AMD Ventures, WCM, Amazon, Elad Gil и Meta✴. Полученные деньги будут направлены на улучшение существующих продуктов и развитие новых проектов.

13.05.2024 [09:00], Сергей Карасёв

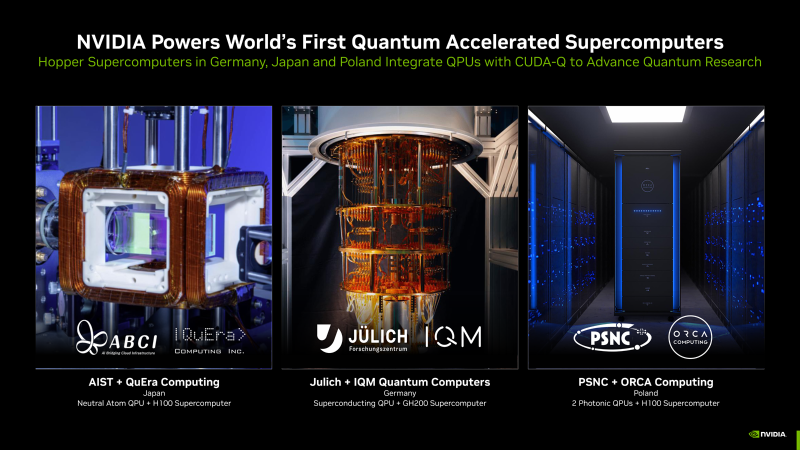

NVIDIA представила гибридные квантовые системы на платформе CUDA-QКомпания NVIDIA сообщила о том, что её платформа CUDA-Q будет использоваться в суперкомпьютерных центрах по всему миру. Она поможет ускорить исследования в области квантовых вычислений, что в перспективе позволит решать наиболее сложные научные задачи. Технология CUDA-Q предназначена для интеграции CPU, GPU и квантовых процессоров (QPU) и разработки приложений для них. Она даёт возможность выполнять сложные симуляции квантовых схем. О намерении использовать CUDA-Q в составе своих НРС-систем объявили организации в Германии, Японии и Польше. В частности, Юлихский суперкомпьютерный центр в Германии (JSC) намерен использовать квантовое решение производства IQM Quantum Computers в качестве дополнения к Jupiter — первому европейскому суперкомпьютеру экзафлопсного класса. Этот комплекс будет смонтирован в Юлихском исследовательском центре (FZJ). Суперкомпьютер Jupiter получит приблизительно 24 тыс. гибридных суперчипов NVIDIA GH200 Grace Hopper. Ещё одной гибридной системой, объединяющей классические и квантовые технологии, станет комплексе ABCI-Q, который расположится в суперкомпьютерном центре ABCI (AI Bridging Cloud Infrastructure) Национального института передовых промышленных наук и технологий Японии (AIST). В состав суперкомпьютера войдут QPU разработки QuEra, а также более 2000 ускорителей NVIDIA H100. Ввод ABCI-Q в эксплуатацию состоится в начале 2025 года. Применять систему планируется при проведении исследований в области ИИ, энергетики, биологии и пр. Вместе с тем Познаньский центр суперкомпьютерных и сетевых технологий (PSNC) в Польше приобрёл две квантовые вычислительные системы британской компании ORCA Computing. Они интегрированы в существующую HPC-инфраструктуру PSNC, которая в числе прочего использует изделия NVIDIA Hopper. Узлы на базе QPU помогут в решении задач в области химии, биологии и машинного обучения.

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

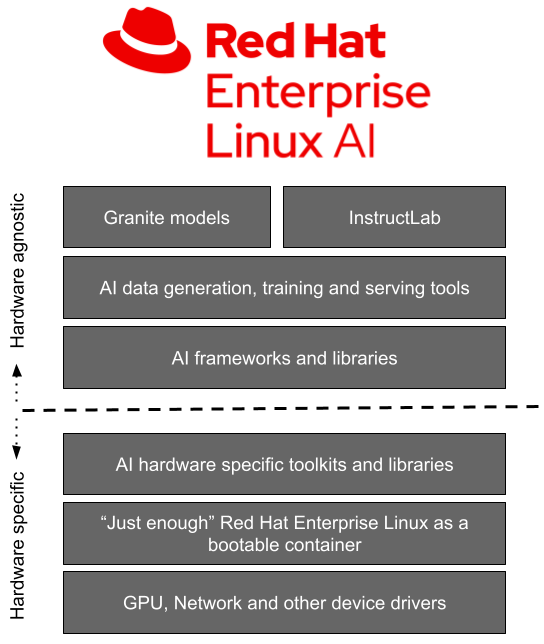

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

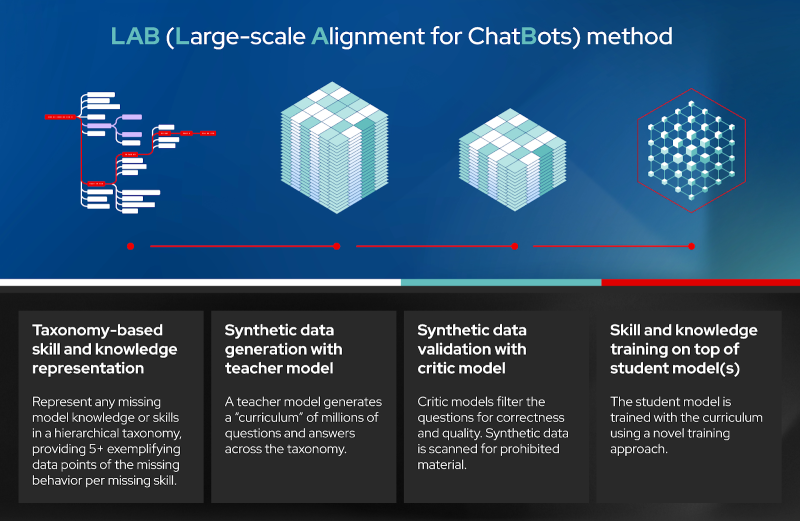

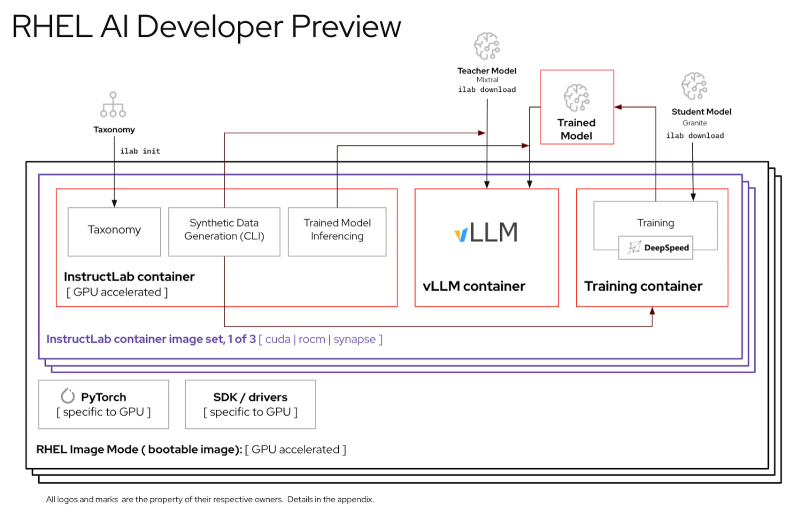

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

07.05.2024 [21:26], Руслан Авдеев

Apple работает над собственными серверными ИИ-ускорителямиКомпания Apple занимается разработкой собственных ИИ-полупроводников для дата-центров, передаёт The Wall Street Journal. В перспективе это поможет ей в «гонке вооружений», развернувшейся на рынке ИИ-решений. И у Apple есть ресурсы для создания передовых ИИ-чипов. В последние десять лет компания уже выбилась в лидеры полупроводниковой индустрии, представляя всё новые чипсеты для мобильных устройств и компьютеров Mac-серии. Как свидетельствуют источники СМИ, серверный проект Project ACDC (Apple Chips in Data Center) задействует компетенции компании в деле создания решений для ЦОД. Недавно сообщалось, что Apple наняла создателя ИИ-кластеров Google. Реализацию проекта Apple начала несколько лет назад, но данных о том, когда будут готовые первые чипы, пока нет. По имеющимся данным, компания уже тесно сотрудничает с TSMC. Предполагается, что чипы для серверов Apple будут оптимизированы для запуска ИИ-моделей, а не их обучения — на этом рынке по-прежнему будет доминировать NVIDIA. Время поджимает, поскольку Google и Microsoft уже имеют собственные ИИ-ускорители, хотя и разных классов — TPU и Maia 100. Обе компании имеют компетенции в области LLM, а Microsoft весьма дружна с OpenAI, которая тоже не прочь заняться «железом». Такое положение дел не устраивает инвесторов Apple, поскольку компания не продемонстрировала никаких впечатляющих успехов в соответствующей сфере, в то время как цена акций конкурентов продолжает расти на фоне новостей об их достижениях. В Apple пытаются убедить инвесторов, что это лишь временное явление и скоро грядут анонсы, связанные с ИИ. Опыт Apple в сфере разработки современных полупроводников должен помочь в создании ИИ-чипов. Сегодня компания представила 3-нм процессор M4 с самым мощным, по её словам, NPU в мире. Хотя компания добилась определённых успехов в разработке чипов для потребительской и профессиональной электроники, определённые задачи даются ей с трудом. Например, она всё ещё бьётся над созданием собственного беспроводного модуля. Хотя в Apple предпочли бы, чтобы большинство ИИ-вычислений осуществлялись силами самих чипов, некоторые задачи будут по-прежнему выполняться в облаке, где и пригодятся новые полупроводники. Это позволит компании лучше контролировать свою стратегию развития в сфере ИИ.

24.04.2024 [12:25], Владимир Мироненко

SAS Institute представила новые инструменты для разработчиков ИИ-приложений — Viya Copilot и SAS Viya WorkbenchSAS Institute Inc. сообщила о расширении ИИ-платформы SAS Viya, с помощью которой компании могут интегрировать самые мощные большие языковые модели (LLM), такие как GPT-4 и Gemini Pro 1.5, в свои существующие бизнес-процессы. Благодаря этому компании могут использовать LLM для создания индивидуальных моделей и агентов ИИ, точно настроенных на выполнение конкретных бизнес-задач с объяснимыми результатами и повышенной конфиденциальностью и безопасностью, а также гарантией, что они будут соответствовать определённым требованиям. В частности, SAS Viya пополнилась новым предложением Viya Copilot для разработчиков, специалистов по обработке данных и бизнес-пользователей. Решение Viya Copilot похоже на личного помощника, призванного ускорить выполнение различных бизнес-задач. По словам компании, для этого решение использует комплексный набор инструментов, включающий генерацию кода, очистку данных, исследование данных и анализ пробелов в знаниях.

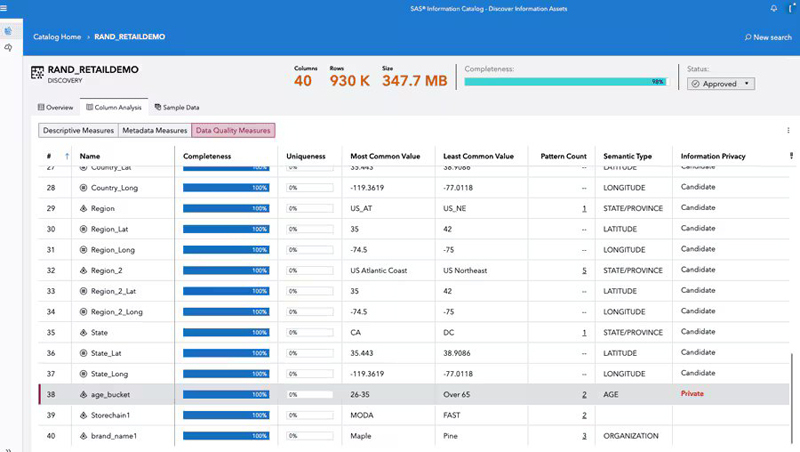

Источник изображений: SAS Institute Обновление SAS Viya также улучшило флагманскую маркетинговую платформу компании SAS Customer Intelligence 360. Маркетологи теперь могут использовать генеративный ИИ для создания рекомендуемой аудитории на основе подсказок на естественном языке, подбора темы электронных писем и извлечения данных об аудитории. Компания также запустила для разработчиков ИИ-приложений новую платформу SAS Data Maker, целью которой является устранение проблемы конфиденциальности и решение проблем с нехваткой данных. SAS Data Maker может генерировать «высококачественные синтетические табличные данные» для обучения ИИ вместо использования конфиденциальных данных. В то же время новая платформа поможет в ситуациях, когда компаниям не хватает данных для обучения моделей. Вице-президент и главный аналитик Constellation Research, отметил в интервью ресурсу SiliconANGLE, что на данный момент SAS Data Maker может создавать синтетические данные только в табличных форматах, и поэтому вряд ли будет востребована многими компаниями.  Также была представлена SAS Viya Workbench — специализированная платформа для разработки ИИ в SAS Viya, предоставляющая вычислительную среду самообслуживания по требованию для таких задач, как подготовка данных, исследовательский анализ данных и построение аналитических моделей ИИ. Платформа будет запущена во II квартале на AWS Marketplace с поддержкой SAS и Python, а также поддержкой R к концу года. Пользователи получат доступ к двум вариантам среды разработки в SAS Viya Workbench, включая Visual Studio Code и Jupyter Notebooks. Для тех, кто по каким-то причинам не может разрабатывать собственные ИИ-модели и ищет готовые решения, которые можно просто подключить к своим бизнес-системам и сразу приступить к работе, SAS представила первую из целого каталога «облегчённых» отраслевых моделей ИИ, предназначенных для клиентов в сфере финансовых услуг, здравоохранения, государственных учреждений, производства и т.д. По словам SAS, пакетные ИИ-модели создаются с использованием запатентованных LLM и предназначены для пользователей нетехнологического сектора с целью оптимизации рабочих процессов и улучшения процесса принятия решений. SAS анонсировала свою первую комплексную модель — помощника с ИИ для оптимизации складских помещений, который может оценивать планировку складов клиентов и предлагать лучшие способы организации, чтобы максимизировать ёмкость или повысить эффективность.

23.04.2024 [11:45], Сергей Карасёв

Samsung откроет в Кремниевой долине лабораторию по созданию ИИ-чипов на базе RISC-V, чтобы побороться с NVIDIAКомпания Samsung Electronics, по сообщению ресурса Business Korea, откроет новую научно-исследовательскую и опытно-конструкторскую (R&D) лабораторию в Кремниевой долине. Её специалисты займутся прежде всего созданием ИИ-чипов на открытой архитектуре RISC-V. По имеющейся информации, Технологический институт Samsung SAIT (Samsung Advanced Institute of Technology) учредил исследовательский центр Advanced Processor Lab (APL). Южнокорейская компания намерена расширить свои возможности в области разработки ИИ-решений, чтобы в перспективе бросить вызов американским корпорациям, в числе которых называется NVIDIA. Около месяца назад Samsung сформировала лабораторию Semiconductor AGI Computing Lab, сотрудники которой разрабатывают чипы следующего поколения для ИИ-приложений. Офисы данного подразделения располагаются в Южной Корее и США. Основным направлением исследований являются системы «общего искусственного интеллекта» (Artificial General Intelligence, AGI). В заявлении в LinkedIn глава Samsung Semiconductor Ке Хён Гён (Kye Hyun Kyung) отметил, что на первом этапе лаборатория сосредоточит усилия на разработке чипов для больших языковых моделей (LLM), тогда как реализация проектов в области AGI начнётся позднее.

Источник изображения: pixabay.com Между тем власти США в рамках «Закона о чипах» выделили Samsung $6,4 млрд безвозвратных субсидий на строительство предприятий в Техасе. По условиям соглашения, в городе Тейлоре будут построены два завода по выпуску полупроводниковых изделий с нормами 4 и 2 нм. «Мы считаем, что полупроводниковые технологии нового поколения, созданные с использованием ИИ и компьютерной техники, сыграют ключевую роль в повышении качества жизни. Именно поэтому SAIT тесно сотрудничает с учёными и экспертами в поисках новых долгосрочных драйверов роста для Samsung», — говорит Гёйонг Джин (Gyoyoung Jin), президент SAIT. |

|