Материалы по тегу: контейнеризация

|

29.08.2025 [09:20], Владимир Мироненко

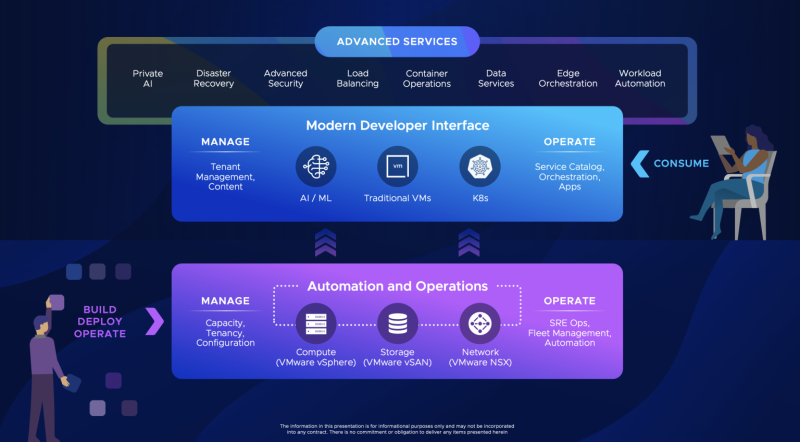

Broadcom расширила инструментарий VCF 9.0, преобразовав её в «унифицированную платформу»Broadcom позиционирует VMware Cloud Foundation (VCF) 9.0 как единую унифицированную платформу, которую можно использовать как для ИИ, так и для других рабочих нагрузок, и с этой целью анонсировала ряд обновлений. Для дальнейшей поддержки ИИ и других ресурсоёмких нагрузок Broadcom объявила о доступности VMware Tanzu Data Intelligence — платформы-хранилища, которая обеспечит унифицированный доступ к разнообразным данным. VMware vSAN получила встроенную поддержку S3-интерфейсов объектного хранилища, что позволит создавать унифицированные политики хранения для блочного, файлового и объектного хранения и снизить сложность инфраструктуры хранения. Компания также интегрировала VCF 9.0 с GitOps, Argo CD и Istio для обеспечения безопасности доставки приложений, используя Git в качестве источника данных для Kubernetes. Теперь разработчики смогут хранить свою инфраструктуру и приложения в виде кода в Git и использовать Argo CD для автоматизации согласованных развёртываний. Кроме того, Istio Service Mesh обеспечивает сетевое взаимодействие с нулевым доверием, управление трафиком и возможность наблюдения для контейнеров. Наряду с VMware Private AI Services платформа VCF 9.0 получила совершенно новый Cyber Compliance Advanced Service — сервис, разработанный для строго регулируемых сред, который обеспечивает улучшенное соответствие кибертребованиям, отказоустойчивость и безопасность платформы для сред VCF. VMware vDefend Security получил новые автоматизированные элементы управления для ускорения внедрения защиты с нулевым доверием, а также расширенные инструменты обнаружения угроз на уровне сети (Network Detection and Response). Также была добавлена функция защиты от бесфайловых атак, использующих PowerShell, VBScript и Jscript. По словам Broadcom, она позволяет проверять и перехватывать вредоносные скрипты до их выполнения, закрывая важнейшую «слепую зону» в кибербезопасности. Avi Load Balancer получил новый инструмент оценки WAF и защиту трафика MCP для агентских рабочих нагрузок. По словам Пола Тернера (Paul Turner), вице-президента по продуктам VMware Cloud Foundation, новые инструменты предоставляют компаниям унифицированный подход к защите инфраструктуры, предотвращению угроз, обеспечению соответствия требованиям и восстановлению после кибератак. Прашант Шеной (Prashanth Shenoy), вице-президент по маркетингу продуктов подразделения VCF, заявил, что ориентация Broadcom на частное облако получила поддержку среди клиентов, особенно среди крупных предприятий и стратегических корпораций. По данным Broadcom, девять из десяти крупнейших компаний из списка Fortune 500 в настоящее время используют VCF. Продажа по всему миру более 100 млн лицензий VCF говорит о значительном доверии к платформе крупных организаций.

04.09.2024 [08:08], Владимир Мироненко

Broadcom анонсировала VMware Cloud Foundation 9 и Tanzu Platform 10

broadcom

kubernetes

software

vmware

виртуализация

гибридное облако

ии

контейнеризация

частное облако

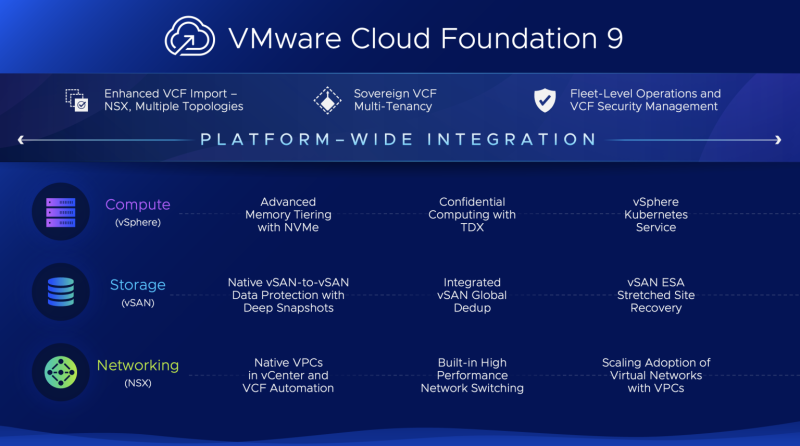

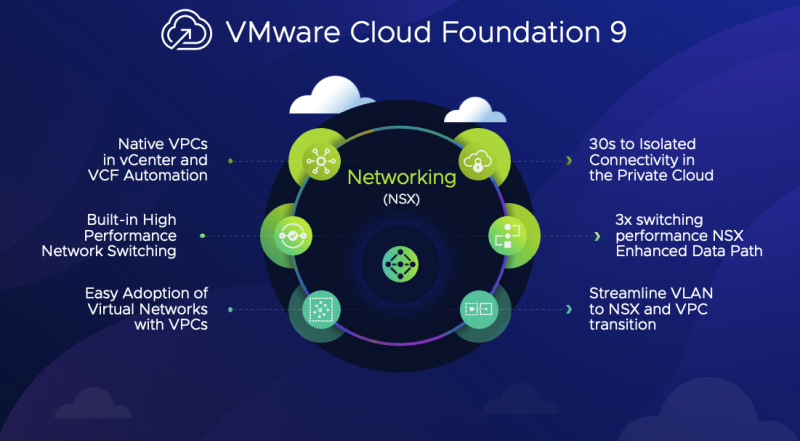

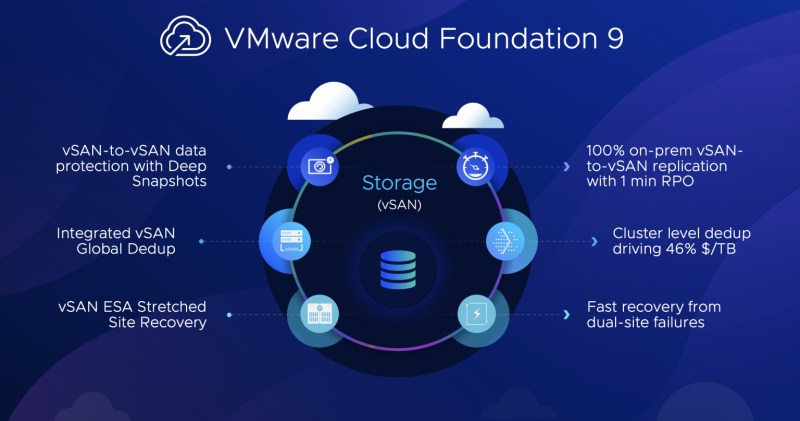

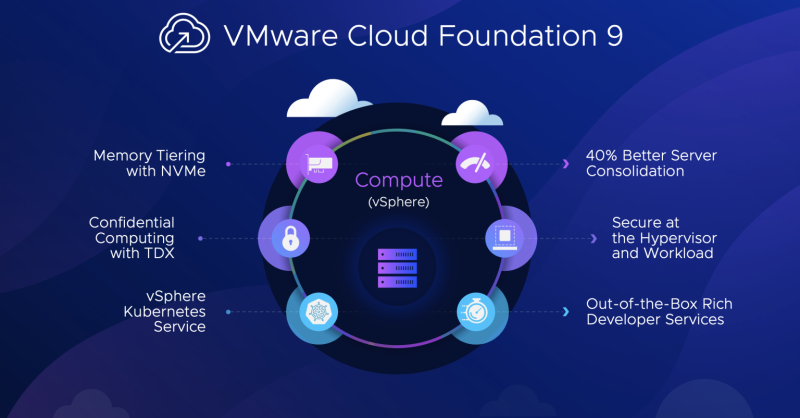

Broadcom представила новейшую версию платформы для управления виртуальными машинами и оркестрации контейнеров VMware Cloud Foundation (VCF) 9, назвав её «будущим» своей платформы частного облака, которая ускорит переход клиентов от разрозненных ИТ-архитектур к унифицированной и интегрированной частной облачной платформе с меньшими затратами и рисками. Основной упор в новой версии сделан на создание частных облаков и, конечно же, ИИ. Broadcom заявила, что VMware Cloud Foundation — первая в отрасли облачная платформа, сочетающая масштабируемость и гибкость публичного облака с безопасностью, устойчивостью и производительностью частного облака и низкой совокупной стоимостью владения. VCF поддержит цифровые инновации клиентов с более быстрой модернизацией инфраструктуры, унифицированным облачным опытом, а также лучшей киберустойчивостью и безопасностью, говорит Broadcom. Компания сослалась на спонсируемое ею исследование IDC, в котором сообщалось, что VCF обеспечивает в среднем на 34 % более низкие затраты на инфраструктуру, на 42 % более низкую общую стоимость эксплуатации и 564 % окупаемости инвестиций в течение трёх лет. VCF помогает организациям быстро перейти на современную и интегрированную инфраструктуру, снижая сложность и время простоя, связанные с ручной миграцией существующих сред в частную облачную платформу. С VMware Cloud Foundation 9 Broadcom добавила возможность клиентам импортировать конфигурации NSX, vDefend, Avi Load Balancer и сложные топологии хранения в существующие среды VCF, а также использовать и интегрировать старые версии существующей инфраструктуры. Этому будет способствовать новый интуитивно понятный пользовательский интерфейс — VCF 9 включает в себя портал самообслуживания с единой консолью управления (вместо десятка с лишним панелей ранее), которая упрощает операции и автоматизацию. Кроме того, компания представила VMware Cloud Foundation (VCF) Advanced Services, каталог готовых к развёртыванию решений, упрощающих работу клиентов в своих частных облачных средах. VMware Cloud Foundation 9Обновлений платформы целое множество. Так, расширение пула DRAM посредством NVMe SSD (CXL) в VCF 9 позволит значительно улучшить работу приложений с интенсивным использованием данных, такие как ИИ, СУБД и аналитика в реальном времени, а также сократит задержку и ускорит передачу информации, что имеет решающее значение для задач обучения и инференса. Также это позволяет масштабировать производительность без чрезмерных затрат. А удалённая репликация снимков между vSAN поддерживает глубокую историю неизменяемых снимков, сокращая время простоя и упрощая оркестрацию аварийного восстановления, в том числе в изолированных on-premise окружениях. Также в VCF 9 включена функциональность VMware Cloud Director, благодаря чему в рамках одной платформы можно поддерживать несколько организаций или, например, групп разработки, сегментируя инфраструктуру на основе их конкретных требований к доступу, управлению рабочими нагрузками, безопасности и конфиденциальности. Кроме того, значительно упростилось создание виртуальных частных облаков (VPC), которые теперь можно формировать буквально в один клик, не занимаясь ручной настройкой VLAN и интеграцией с существующими сетями. Возможности VPC можно расшириить службами VMware vDefend и VMware Avi Load Balancer, которые также получили существенные обновления. Например, Avi Load Balancer лучше оптимизирован для сред VCF и Kubernetes и интегрирован со службой Tanzu Application Service. По словам Broadcom, это сокращает время развёртывания с недель до минут и повышает прозрачность работы на уровне L4–L7. Kubernetes-системы получат расширенными возможности по управлению трафиком и конвейерами CI/CD. vDefend был расширен с помощью распределённого анализа влияния правил брандмауэра и распределённой же системы IPS. Он поддерживает крупные и сложные среды, позволяя провести быструю оценку и профилирование угроз, в том числе в изолированных (air-gapped) окружениях. А в рамках Project Cypress компания готовит для vDefent интеллектуального помощника на базе генеративного ИИ, который будет проактивно находить возможные вектора атак, предлагать возможные варианты защиты, выявлять малоэффектвные политики безопасности и т.д. Пообщаться с ним можно будет на естественном языке. А гипервизор VMware может выступать в качестве датчика угроз для быстрой оценки защиты инфраструктуры. Broadcom также сообщила об обновлении платформы VMware Private AI Foundation with NVIDIA, предназначенный для предприятий, которые хотят использовать возможности ИИ, сохраняя при этом преимущества частного облака, представляющей собой комплексное решение для безопасного и эффективного развёртывания, управления и масштабирования ИИ-приложений на базе VCF. В VCF 9 компания упростила развёртывания платформ генеративного ИИ, расширив возможности управления и мониторинга vGPU и GPU, добавив службу индексации и извлечения данных, а также службу создания ИИ-агентов. Tanzu 10На конференции также была представлена 10-я версия унифицированной платформы VMware Tanzu, с помощью котороый разработчики могут автоматизировать защищённые сборки контейнеров, привязывать сервисы к приложениям, развёртывать код одной командой и легко масштабировать приложения, заявила Broadcom. Tanzu 10 также автоматизирует задачи управления приложениями и платформами, такие как исправление уязвимостей, развёртывание непрерывных обновлений и применение политик. Tanzu предоставляет ряд пакетных сервисов для VCF для автоматизированной и защищённой работы с контейнерами и данными. Новые функции включают поддержку изолированных среды, глобальный балансирощик, расширенные сетевые возможности (Avi Load Balancer), защищённые виртуальные машины, каталог образов с open source ПО. Наконец, встроенная среда разработки ИИ платформы Tanzu позволяет разработчикам создавать приложения Python без знания языка. Решения Tanzu AI Solutions включают, в том числе, такие функции:

Поддержка VMware Private AI Foundation with NVIDIA встроена в сервис GenAI on Tanzu Platform.

28.08.2024 [00:10], Владимир Мироненко

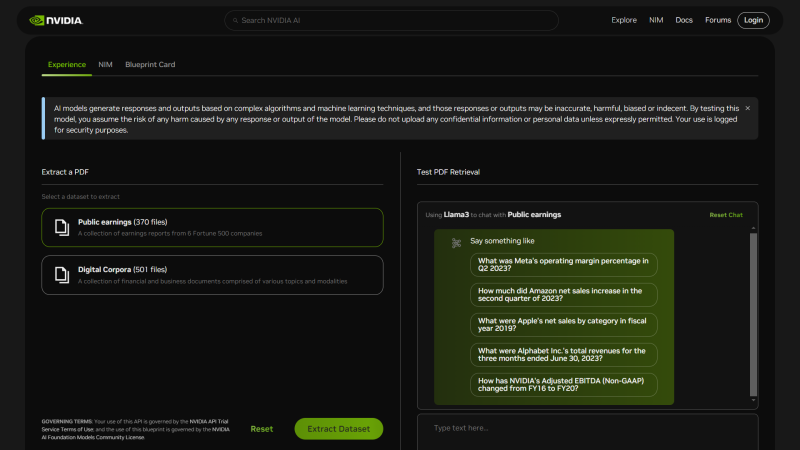

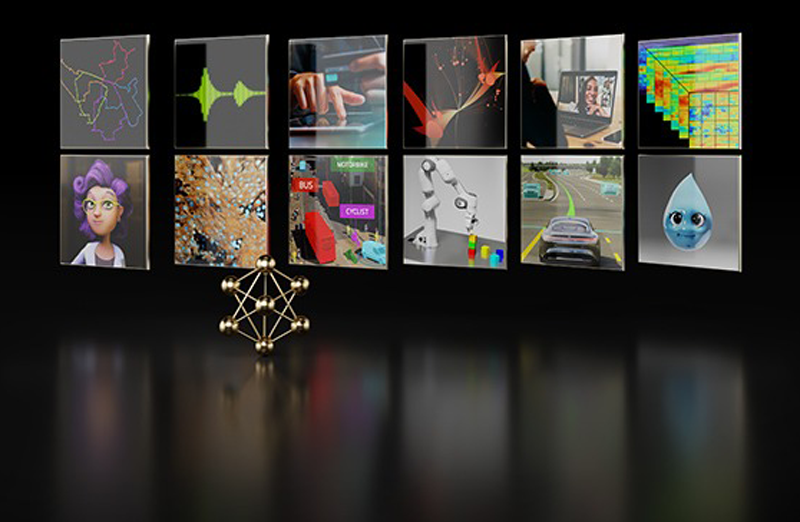

NVIDIA представила шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задачNVIDIA анонсировала NIM Agent Blueprints, каталог предварительно обученных, настраиваемых программных решений, предоставляющий разработчикам набор инструментов для создания и развёртывания приложений генеративного ИИ для типовых вариантов использования, таких как аватары для обслуживания клиентов, RAG, виртуальный скрининг для разработки лекарственных препаратов и т.д. Предлагая бесплатные шаблоны для частых бизнес-задач, компания помогает разработчикам ускорить создание и вывод на рынок ИИ-приложений. NIM Agent Blueprints включает примеры приложений, созданных с помощью NVIDIA NeMo, NVIDIA NIM и микросервисов партнёров, примеры кода, документацию по настройке и Helm Chart'ы для быстрого развёртывания. Предприятия могут модифицировать NIM Agent Blueprints, используя свои бизнес-данные, и запускать приложения генеративного ИИ в ЦОД и облаках (в том числе в рамках NVIDIA AI Enterprise), постоянно совершенствуя их благодаря обратной связи. На текущий момент NIM Agent Blueprints предлагают готовые рабочие процессы (workflow) для систем обслуживания клиентов, для скрининга с целью автоматизированного поиска необходимых соединений при разработке лекарств и для мультимодального извлечения данных из PDF для RAG, что позволит обрабатывать огромные объёмы бизнес-данных для получения более точных ответов, благодаря чему ИИ-агенты чат-боты службы станут экспертами по темам компании. С примерами можно ознакомиться здесь. Каталог NVIDIA NIM Agent Blueprints вскоре станет доступен у глобальных системных интеграторов и поставщиков технологических решений, включая Accenture, Deloitte, SoftServe и World Wide Technology (WWT). А такие компании как Cisco, Dell, HPE и Lenovo предложат полнофункциональную ИИ-инфраструктуру с ускорителями NVIDIA для развёртывания NIM Agent Blueprints. NVIDIA пообещала, что ежемесячно будут выпускаться дополнительные шаблоны для различных бизнес-кейсов.

03.06.2024 [09:21], Владимир Мироненко

NVIDIA объявила об интеграции NIM с KServeNVIDIA объявила, что набор инференес-микросервисов NVIDIA NIM будет работать с open source платформой KServe на базе Kubernetes, которая позволит автоматизировать развёртывание ИИ-моделей. Это также делает NIM широкодоступным на платформах различных компаний, таких как Canonical, Nutanix и Red Hat. Интеграция NIM в KServe позволяет расширить возможность использования технологий NVIDIA сообществом, партнёрами по экосистеме и клиентами. Благодаря интеграции с KServe пользователи смогут получить доступ к NIM на многих корпоративных платформах, таких как Charmed KubeFlow от Canonical, Charmed Kubernetes, Nutanix GPT-in-a-Box 2.0, Red Hat OpenShift AI и многих других.

Источник изображения: NVIDIA В рамках интеграции NIM компания NVIDIA планирует активно участвовать в продвижении KServe, опираясь на свой портфель ПО с открытым исходным кодом, включая Triton и TensorRT-LLM. NVIDIA также является активным членом фонда Cloud Native Computing Foundation. NVIDIA и ранее участвовала в разработке KServe и адаптации этого инструмента под свои нужды, равно как и AWS, Bloomberg, Canonical, Cisco, Hewlett Packard Enterprise, IBM, Red Hat, Zillow.

02.06.2024 [15:30], Владимир Мироненко

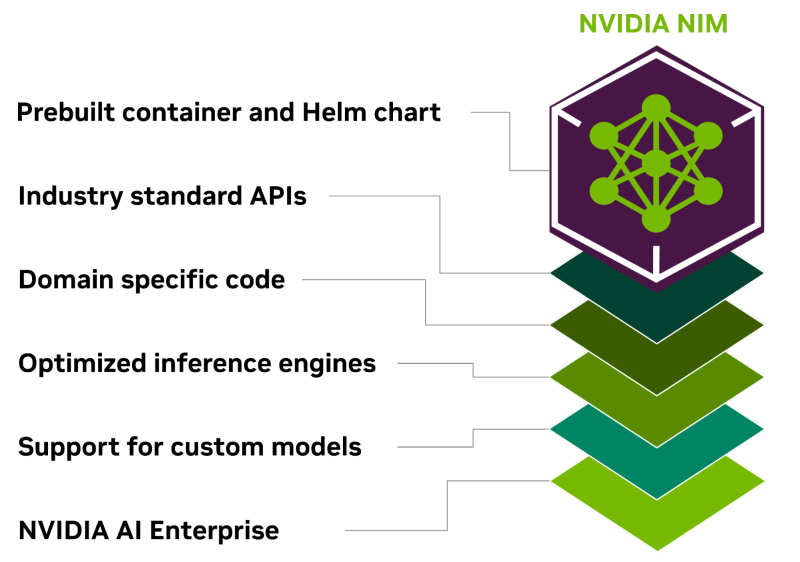

NVIDIA объявила о доступности NIM для разработчиков ИИNVIDIA объявила о доступности NVIDIA NIM, микросервисов инференса, которые предоставляют готовые модели в виде заранее оптимизированных контейнеров, доступных для развёртывания в облаках, ЦОД или на рабочих станциях. Это, по словам компании, позволяет разработчикам возможность без труда создавать приложения генеративного ИИ за считанные минуты, хотя ранее на это уходили недели. Сложность приложений генеративного ИИ растёт и часто в них используется несколько моделей с различными возможностями для генерации текста, изображений, видео, речи и т.д. NVIDIA NIM позволяет значительно повысить производительность разработчиков, предоставляя простой стандартизированный способ добавления генеративного ИИ в их приложения. NIM также позволяет компаниям максимизировать свои инвестиции в инфраструктуру. Например, NIM-контейнер с оптимизированным вариантом Meta✴ Llama 3-8B выдаёт втрое больше токенов за единицу времени, чем LLM без оптимизаций. Более 200 технологических партнёров NVIDIA, включая Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI и Synopsys, уже используют NIM, чтобы ускорить развёртывание генеративного ИИ для приложений, специфичных для их индустрии, таких как ИИ-помощники, помощники по созданию кода, цифровые человеческие аватары и многое другое. Кроме того, экосистему NIM поддерживают Canonical, Red Hat, Nutanix, VMware, Kinetica и Redis. Доступна и интеграция с KServe. NIM интегрирован в платформу NVIDIA AI Enterprise. Начиная со следующего месяца участники программы NVIDIA Developer Program получат бесплатный доступ к NIM для исследований, разработки и тестирования. Контейнеры NIM могут включать ПО NVIDIA CUDA, NVIDIA Triton Inference Server и NVIDIA TensorRT-LLM. А на ai.nvidia.com уже доступно более 40 готовых моделей, включая Databricks DBRX, Google Gemma, Meta✴ Llama 3, Microsoft Phi-3, Mistral Large, Mixtral 8x22B и Snowflake Arctic. Компания также представила и NVIDIA BioNeMo NIM для биомедицинской сферы. Ведущие провайдеры ИИ-решений и MLOps-платформ, включая Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot, deepset, Domino Data Lab, LangChain, Llama Index, Replicate, Run.ai, ServiceNow, Securiti AI и Weights & Biases также внедрили NIM. Hugging Face теперь тоже предлагает NIM-контейнейры и позволяет развернуть модели в различных облаках всего за несколько кликов. Микросервисы NIM также интегрированы в AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Наконец, компетенциями в области NIM обзавелись Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS и Wipro. Предприятия могут запускать приложения с поддержкой NIM практически в любом месте, в том числе на сертифицированных NVIDIA системах Cisco, Dell, HPE, Lenovo и Supermicro, а также ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron и Wiwynn. Более того, например, Foxconn и Pegatron уже используют NIM для разработки предметно-ориентированных LLM для собственных производственных нужд.

19.03.2024 [03:18], Владимир Мироненко

Всё своё ношу с собой: NVIDIA представила контейнеры NIM для быстрого развёртывания оптимизированных ИИ-моделейКомпания NVIDIA представила микросервис NIM, входящий в платформу NVIDIA AI Enterprise 5.0 и предназначенный для оптимизации запуска различных популярных моделей ИИ от NVIDIA и её партнёров. NVIDIA NIM позволяет развёртывать ИИ-модели в различных инфраструктурах: от локальных рабочих станций до облаков. Предварительно созданные контейнеры и Helm Chart'ы с оптимизированными моделями тщательно проверяются и тестируются на различных аппаратных платформах NVIDIA, у поставщиков облачных услуг и на дистрибутивах Kubernetes. Это обеспечивает поддержку всех сред с ускорителями NVIDIA и гарантирует, что компании смогут развёртывать свои приложения генеративного ИИ где угодно, сохраняя полный контроль над своими приложениями и данными, которые они обрабатывают. Разработчики могут получить доступ к моделям посредством стандартизированных API, что упрощает разработку и обновление приложений. NIM также может использоваться для оптимизации исполнения специализированных решений, поскольку не только использует NVIDIA CUDA, но и предлагает адаптацию для различных областей, таких как большие языковые модели (LLM), визуальные модели (VLM), а также модели речи, изображений, видео, 3D, разработки лекарств, медицинской визуализации и т.д. NIM использует оптимизированные механизмы инференса для каждой модели и конфигурации оборудования, обеспечивая наилучшую задержку и пропускную способность и позволяя более просто и быстро масштабироваться по мере роста нагрузок. В то же время NIM позволяет дообучить и настроить модели на собственных данных, поскольку можно не только воспользоваться облачными API NVIDIA для доступа к готовым моделями, но и самостоятельно развернуть NIM в Kubernetes-средах у крупных облачных провайдеров или локально, что сокращает время разработки, сложность и стоимость подобных проектов и позволяет интегрировать NIM в существующие приложения без необходимости глубокой настройки или специальных знаний.

19.03.2024 [02:16], Владимир Мироненко

NVIDIA AI Enterprise 5.0 предложит микросервисы, которые ускорят развёртывание ИИNVIDIA представила свежую версию платформы для работы с ИИ-приложениями NVIDIA AI Enterprise 5.0, которая включает микросервисы на базе загружаемых программных контейнеров для быстрого развёртывания приложений генеративного ИИ. NVIDIA отметила, что уже микросервисы адаптируются ведущими поставщиками ПО и платформ кибербезопасности, а все функции AI Enterprise 5.0 вскоре будут доступны в облачных маркетплейсах AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Микросервисы позиционируются компанией как эффективный инструмент для создания разработчиками современных корпоративных приложений в глобальном масштабе. Работая прямо в браузере, разработчики могут используют для создания приложений облачные API. NVIDIA AI Enterprise 5.0 теперь включает предназначенные для развёртывания моделей ИИ микросервисы NIM и микросервисы CUDA-X. Сюда входит и NVIDIA cuOpt, ИИ-микросервис для задачи логистики, который позволяет значительно ускорить оптимизации маршрута и расширить возможности динамического принятия решений, снижая затраты, экономя время и позволяя сократить выбросы CO2.

Источник изображения: NVIDIA NIM оптимизирует инференс-нагрузки для различных популярных моделей ИИ от NVIDIA и партнёров. Используя ПО NVIDIA для инференса, включая Triton Inference Server, TensorRT и TensorRT-LLM, NIM позволяет сократить развёртывание моделей с недель до минут и вместе с тем обеспечивает безопасность и управляемость в соответствии с отраслевыми стандартами, а также совместимость с инструментами управления корпоративного уровня. В настоящее время компания работает над расширением возможностей AI Enterprise. С выходом версии NVIDIA AI Enterprise 5.0 платформа получила ряд дополнений. В частности, она теперь включает NVIDIA AI Workbench, набор инструментов для разработчиков, обеспечивающих быструю загрузку, настройку и запуск проектов генеративного ИИ. ПО теперь общедоступно и поддерживается NVIDIA. NVIDIA AI Enterprise 5.0 также теперь поддерживает платформу Red Hat OpenStack. Кроме того, в NVIDIA AI Enterprise 5.0 расширена поддержка широкого спектра новейших ускорителей NVIDIA, сетевого оборудования и ПО для виртуализации.

06.01.2024 [23:17], Владимир Мироненко

Микроконтейнеры для микроконтроллеров: представлена платформа NXP Platform Accelerator на базе MicroEJ VEE

iot

linux

nxp semiconductor

rtos

software

встраиваемая система

контейнеризация

микроконтроллер

разработка

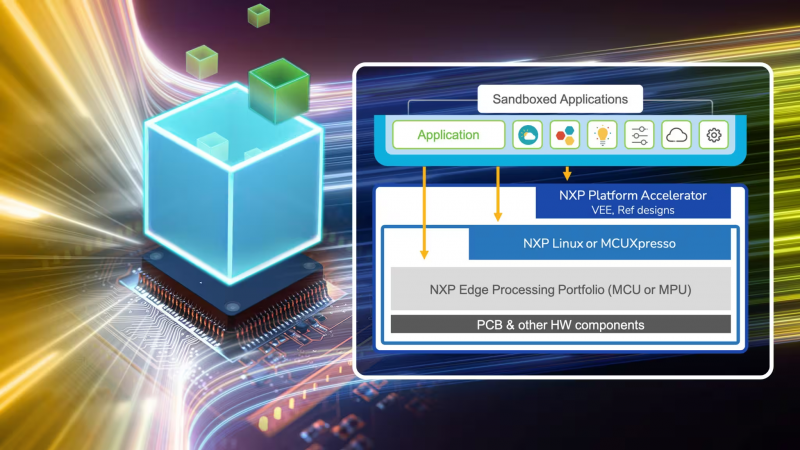

Компания NXP Semiconductors анонсировала новую платформу NXP Platform Accelerator, разработанную в сотрудничестве с MicroEJ, которая обеспечивает переносимость ПО для чипов NXP, позволяя ускорить разработку и масштабирование новые умных промышленных продуктов и решений Интернета вещей. NXP Platform Accelerator использует программные контейнеры со стандартизированными API, чтобы обеспечить гибкость проектирования ПО и значительно сократить затраты клиентов на разработку и время вывода на рынок. Использование среды MicroEJ VEE обеспечивает переносимость ПО среди широкого спектра микроконтроллеров NXP с RTOS и процессоров приложений на базе Linux. Кроме того, NXP Platform Accelerator предоставляет специальные API для обеспечения простого доступа к расширенным функциям чипов NXP, таким как управление питанием и 3D/2D-графика. Уже доступны примеры и документация для энергоэффективных i.MX RT595 и высокопроизводительных i.MX RT1170. Интеллектуальные устройства для промышленного сектора и IoT сложно разрабатывать и внедрять. Многие из них предназначены для одной цели, имеют фиксированную функциональность и ограниченные вычислительные возможности. Масштабирование возможностей продукта зачастую требует разработки с нулия и интеграции низкоуровневого ПО, RTOS или ОС более высокого уровня, а также промежуточного ПО, что отражается на скорости создания продукта.

Источник изображения: NXP По словам компании, NXP Platform Accelerator позволяет решить эту проблему благодаря контейнеризации, которая обеспечивает переносимость ПО для всего портфолио аппаратных решений NXP, от микроконтроллеров до процессоров. Возможность повторного использования бинарных сборок позволяет клиентам максимально быстро создавать прототипы новых продуктов. Кроме того, NXP Platform Accelerator позволяет управлять развёртыванием ПО на периферии, предоставляя возможности, подобные имеющиеся у приложений для смартфонов, такие как частичные или полные обновления по воздуху, загружаемые приложения и микросервисы. Новая платформа объединяет передовые инструменты разработки, включая моделирование, управление виртуальными устройствами, возможность использования C/Java/JavaScript, совместную работу и интеграцию с Android Studio, IntelliJ и Eclipse. Кроме того, NXP Platform Accelerator объединяет различные API для работы с IP-блоками, которые, к примеру, позволяют быстро переключаться между профилями энергопотребления. А сами контейнеры задействуют специальные оптимизации и библиотеки от NXP.

31.10.2023 [02:20], Владимир Мироненко

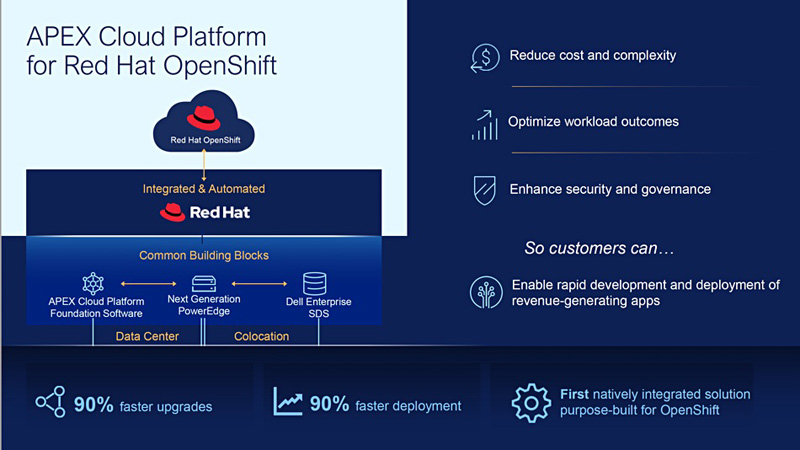

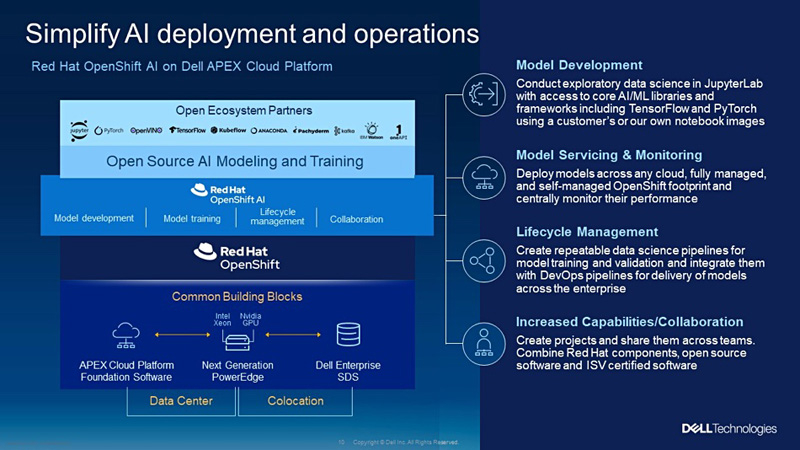

Dell и Red Hat анонсировали интегрированную облачную платформу APEX Cloud Platform for Red Hat OpenShiftDell и Red Hat представили облачную платформу APEX Cloud Platform for Red Hat OpenShift. Как сообщается в блоге Dell, это первая полностью интегрированная платформа доставки приложений для Red Hat OpenShift на рынке. APEX Cloud Platform for Red Hat OpenShift позволяет клиентам развёртывать, управлять и запускать контейнеры вместе с виртуальными машинами локально. Платформа, разработанная Dell совместно с Red Hat, использует серверы нового поколения PowerEdge MC-760/MC-660 с процессорами Intel Xeon Sapphire Rapids и масштабируемую СХД Dell на базе PowerFlex с NVMe/SAS SSD. Платформа упрощает мультиоблачные операции, ускоряет развёртывание приложений и оптимизирует размещение рабочих нагрузок. APEX Cloud Platform обеспечивает плавное перемещение приложений и наборов данных в мультиоблачных средах. А СХД обеспечивает совместимость между локальным и публичным облачным хранилищем.

Источник изображения: Dell/Blocks and Files В мультиоблачной среде клиентам требуется производительность, надёжность и безопасность локальной инфраструктуры в сочетании с гибкостью публичного облака. Платформа устраняет сложности, связанные с развёртыванием и управлением Kubernetes, предлагая готовое интегрированное решение bare-metal. Решение автоматизирует развёртывание Red Hat OpenShift, сокращая время обновления компонентов на 90 % по сравнению с обновлением вручную.  Также было анонсировано решение Dell Validated Design for Red Hat OpenShift AI on APEX Cloud Platform, которое предлагает компаниям упрощённое решение по развёртыванию цифрового ассистента с использованием большой языковой модели (LLM) и ИИ-фреймворка Retrieval Augmented Generation (RAG), повышающего качество сгенерированных ИИ ответов. |

|