Материалы по тегу: сервер

|

04.01.2025 [15:21], Руслан Авдеев

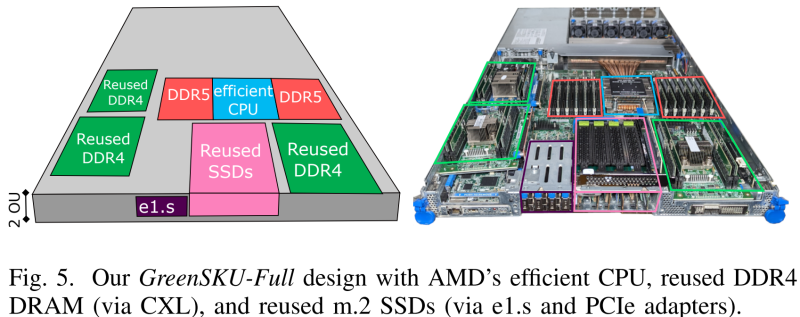

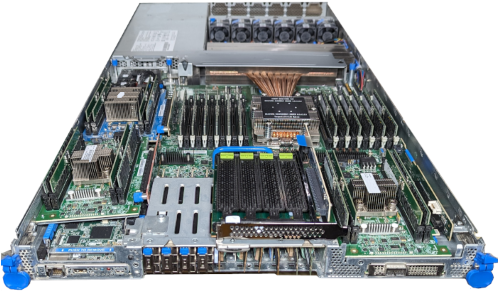

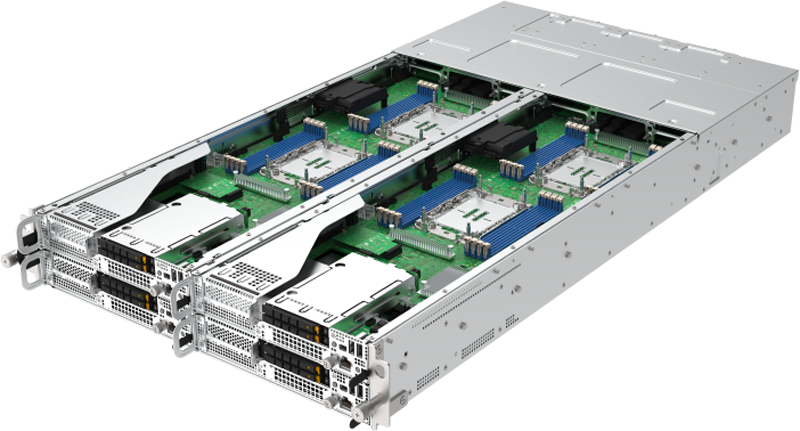

Microsoft совместно с учёными США разработала экологичные облачные серверы GreenSKU, которые используют RAM и SSD из старых системУчёные из Microsoft, Университета Карнеги-Меллона и Вашингтонского университета разработали новый стандарт экологичных серверов GreenSKU, которые позволят снизят углеродные выбросы ЦОД, сообщает IEEE Spectrum. Кроме того, была представлена модель GreenSKU Framework для расчёта целесообразности использования подобных систем в дата-центрах гиперскейлеров и подбора оптимальных конфигураций. Созданные в рамках концепции GreenSKU прототипы серверов были протестированы в ЦОД Azure.

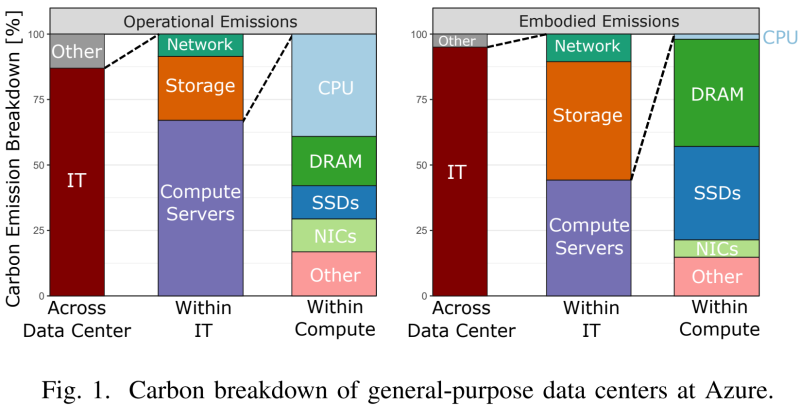

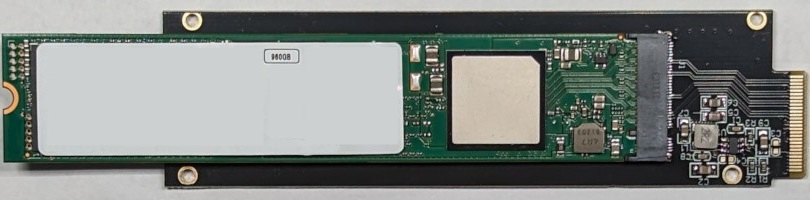

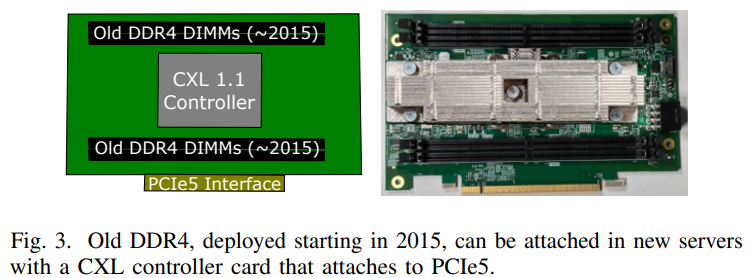

Источник изображений: Microsoft Исследование, вышедшее минувшим летом, изучает возможность использования компонентов из списанных серверов. Это важно, поскольку сегодня во многих случаях при сбое одного компонента из эксплуатации выводится сервер целиком. Кроме того, Microsoft меняет серверы Azure каждые 3–5 лет для оптимизации производительности. И в этом случае работоспособные компоненты всё равно обычно не используются в других серверах. Согласно выкладкам исследователей, уровень сбоев оперативной памяти (AFR) после кратковременного всплеска вскоре после развёртывания остаётся примерно одинаковым на протяжении не менее семи лет. А износ SSD составляет около половины. Впрочем, в данном случае речь идёт об M.2-накопителях. Их надёжность и скорость работы можно повысить простым объединением в RAID-массив. А для их использования в современных платформах с E1.S-корзинами есть готовые пассивные адаптеры, благо стандарт PCIe обладает обратной совместимостью.  С памятью дело обстоит не так просто. Предыдущие поколения серверов использовали DDR4, тогда как актуальные платформы работают только с DDR5. Однако выход есть — в современных CPU появилась поддержка CXL. Точнее, CXL Type 3 (CXL.mem), что позволяет подключать по PCIe пулы DRAM. Они представлены в виде NUMA-узлов без CPU. Такое подключение памяти даёт большую задержку, но современные гипервизоры умеют работать с такими пулами, отправляя в них редко используемые массивы данных.  Старые процессоры переиспользовать не выйдет. Они гораздо менее энергоэффективны и производительны, при этом на CPU приходится основная часть энергопотребления и, соответственно, углеродных выбросов. Исследователи изучили актуальные предложения вендоров и пришли к выводу, что среди доступных на рынке процессоров наилучшим образом для GreenSKU подходят AMD EPYC Bergamo, которые предлагает большое количество ядер и потоков при сравнимом уровне TDP, пусть и при пониженной производительности каждого ядра, а также поддерживают необходимые протоколы CXL. Для распределения нагрузок используется отдельный программный слой, определяющий, какие задачи можно выполнять на серверах GreenSKU, а какие — на стандартных серверах Azure в зависимости от требований к производительности. Как отмечают исследователи, три четверти развёрнутых в Azure инстансов в среднем используют лишь 25 % выделенных ресурсов CPU и около 15 % от доступной пропускной способности памяти. Точно так же далеко не в полной мере используются и SSD. Вместе с тем есть клиенты, которые выживают максимум из каждого инстанcа. Снижение углеродных выбросов имеет большое значение для облачных вычислений, поскольку они могут составить 20 % всех выбросов к 2030 году — об этом свидетельствуют данные НКО Ассоциация вычислительной техники. В пересчёте на ядро выбросы серверов GreenSKU на 28 % ниже, чем выбросы обычных серверов Azure. А на уровне ЦОД с учётом всех накладных расходов снижение выбросов составляет 8 %.

02.01.2025 [15:18], Владимир Мироненко

ИИ останется драйвером роста полупроводниковой отрасли в 2025 году, но политика США может принести сюрпризы

digitimes research

hardware

анализ рынка

ии

импортозамещение

китай

прогноз

производство

санкции

сервер

сша

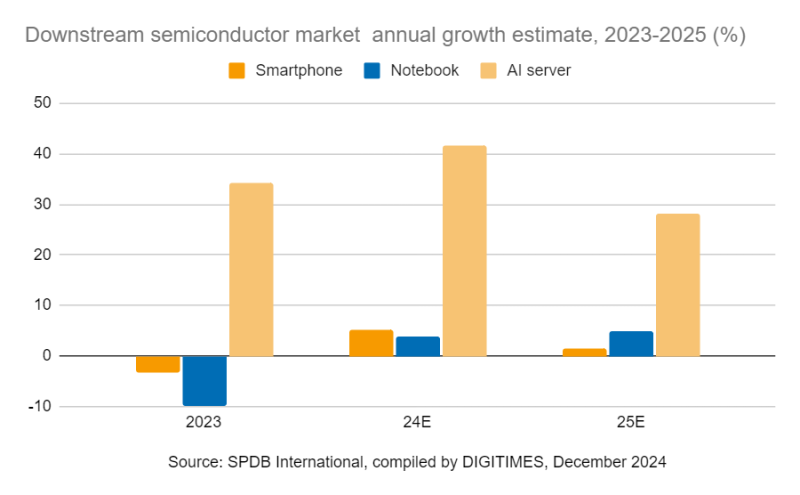

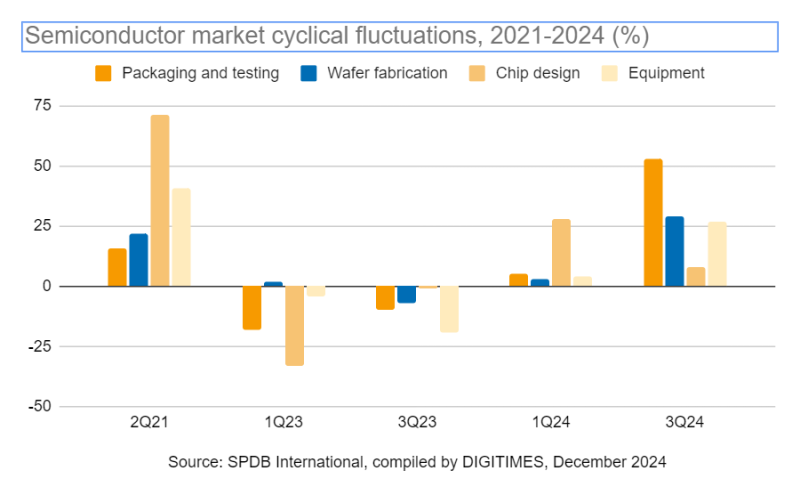

В 2025 году, как и в прошлом, ИИ по-прежнему будет драйвером роста индустрии полупроводников, стимулируя и без того повышенный спрос на производство микросхем. Однако с возвращением Дональда Трампа (Donald Trump) на пост президента США, на рынке возникнет потенциальная неопределённость, поскольку, судя по уже сделанным им заявлениям, политика его администрации может привести к инфляции и экономическому охлаждению, совпадая с прогнозируемым спадом в цикле рынка полупроводников, предупреждают в DIGITIMES Research. По оценкам World Semiconductor Trade Statistics (WSTS), в 2024 году мировой рынок полупроводников вырос в годовом исчислении на 19 %, а в 2025 году его рост может составить 11,2 %. Ключевым фактором этого роста остаётся ИИ. При этом секторы логических микросхем и микросхем памяти, связанные с ИИ, согласно прогнозу, покажут двузначный рост в процентах, тогда как в других сегментах полупроводников ожидается более скромный рост, исчисляемый однозначными числами. Ожидается, что ИИ-серверы покажут двузначный рост, в то время как в сегментах смартфонов и ноутбуков будет наблюдаться однозначный рост. Увеличение популярности генеративного ИИ будет стимулировать рост в технологическом секторе и укреплять динамику полупроводниковой промышленности. От этого тренда лидеры отрасли, включая TSMC и NVIDIA, могут значительно выиграть, поскольку являются ведущими производителями ИИ-ускорителей. Аналитики DIGITIMES Research отметили, что в 2025 году циклические закономерности полупроводниковой промышленности остаются очевидными. Предыдущий подъём отрасли, наблюдавшийся с середины 2019 года до середины 2021 года, продолжался около 25 месяцев, что было обусловлено повышенным спросом на потребительскую электронику и ПК во время пандемии COVID-19, а также стремлением компаний пополнить запасы. Текущая фаза восстановления, стартовавшая во II квартале 2023 года, характеризуется ростом мировых продаж полупроводников год к году, чему будет способствовать рост спроса на ИИ-вычисления, подпитываемый использованием генеративного ИИ, а также возросшей потребностью в микросхемах памяти и электронике, в том числе в смартфонах и ПК. По словам DIGITIMES Research, спрос на ИИ-серверы продолжает расти, и сегмент ИИ-чипов для обучения и инференса в облаке демонстрирует быстрый рост. В то же время выполение ИИ-нагрузок проникает на периферию, что подпитывает спрос на потребительскую электронику, такую как смартфоны и ПК. TSMC является главным бенефициаром роста спроса на микросхемы для ИИ. Ведущие производители ИИ-чипов — NVIDIA, AMD, Qualcomm и MediaTek — по прогнозам, сохранят в текущем году устойчивый рост производства ускорителей для обучения ИИ и мобильных SoC-продуктов. Аналитики отметили, что сохраняющаяся напряжённость во взаимоотношениях США и Китая создает геополитические риски, которые добавляют неопределённости в модель циклического развития полупроводниковой промышленности. Санкции США усилили стремление Поднебесной к достижению самодостаточности. Вместе с тем за последние два-три года мировые бренды значительно расширили литографические мощности в Китае, достигнув пика. Как ожидают в DIGITIMES Research, тренд на импортозамещение получит продолжение в Китае в 2025 году. Во всяком случае, китайские производители электроники всё чаще используют компоненты местного производства, стремясь свести к нулю влияние потенциальных торговых конфликтов. Отмечено, что такие европейские вендоры, как STMicroelectronics, NXP и Infineon, демонстрируют растущий интерес к изготовлению пластин на китайских заводах, что приносит пользу ключевым игрокам рынка, в том числе SMIC и Shanghai Huahong Group. Всё это приведёт в 2025 году к углублению локализации производства полупроводников в Китае.

30.12.2024 [12:56], Сергей Карасёв

Firefly представила серверы CSB1-N10 для создания ИИ-кластеров из одноплатных компьютеровКомпания Firefly Technology, по сообщению ресурса CNX-Software, выпустила серверы серии CSB1-N10 для построения ИИ-кластеров. Устройства, выполненные в форм-факторе 1U, подходят для дата-центров, периферийных развёртываний и локальных площадок. В семейство вошли пять моделей: CSB1-N10S1688, CSB1-N10R3588, CSB1-N10R3576, CSB1-N10NOrinNano и CSB1-N10NOrinNX. Узлы систем оснащены соответственно процессором Sophgo Sophon BM1688 (8 ядер, до 1,6 ГГц), Rockchip RK3588 (8 ядер, до 2,4 ГГц), Rockchip RK3576 (8 ядер, до 2,2 ГГц), NVIDIA Jetson Orin Nano (6 ядер, до 1,5 ГГц) и Jetson Orin NX (8 ядер, до 2,0 ГГц). Первые три из перечисленных узлов комплектуются оперативной памятью LPDDR4 объёмом 8, 16 и 8 Гбайт соответственно, а также флеш-модулем eMMC вместимостью 32, 256 и 64 Гбайт. Варианты Orin оборудованы 8 и 16 Гбайт памяти LPDDR5 и накопителем NVMe SSD на 256 Гбайт. Все серверы содержат десять вычислительных узлов и дополнительный управляющий узел на чипе RK3588. Присутствует слот для SSD с интерфейсом SATA-3. В оснащение входят по два сетевых порта 10GbE (SFP+) и 1GbE (RJ45), выделенный сетевой порт управления 1GbE, аналоговый разъём D-Sub (1080p60), два порта USB 3.0, а также последовательный порт. Применяется воздушное охлаждение. За питание отвечает блок мощностью 550 Вт. Диапазон рабочих температур — от 0 до +45 °C. Кластер на базе CSB1-N10S1688 обеспечивает ИИ-производительность до 160 TOPS на операциях INT8. В случае CSB1-N10R3588 и CSB1-N10R3576 это показатель составляет 60 TOPS. Эти три системы поддерживают работу с большими языковыми моделями (LLM), а также фреймворками TensorFlow, PyTorch, PaddlePaddle, ONNX, Caffe. В случае CSB1-N10NOrinNano и CSB1-N10NOrinNX быстродействие достигает 400 и 1000 TOPS. Говорится о поддержке LLaMa3 и Phi-3 Mini, фреймворков TensorFlow, PyTorch, Matlab и др. Цена варьируется от $2059 до $14 709.

25.12.2024 [13:05], Сергей Карасёв

Compal представила сервер SD220-8 с «высокоточной» погружной СЖО Intel Targeted Flow

compal electronics

emerald rapids

hardware

intel

sapphire rapids

xeon

погружное охлаждение

сервер

сжо

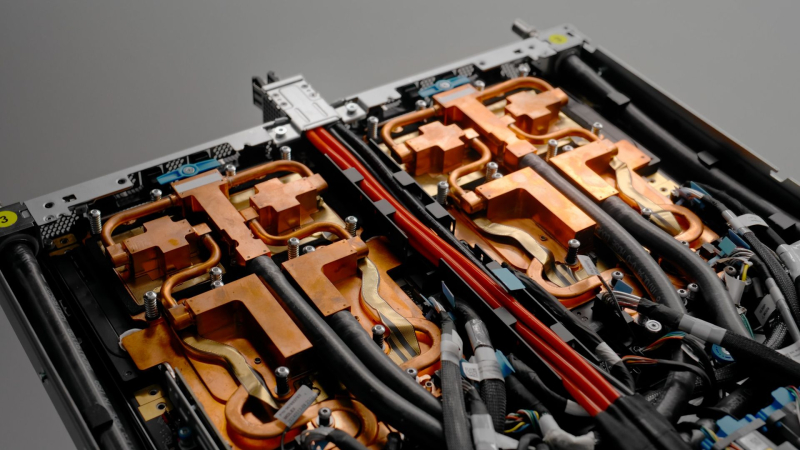

Компания Compal Electronics, по сообщению ресурса DigiTimes, объединила усилия с Intel, BP Castrol, JWS и Priver Technology с целью создания решений с передовой системой жидкостного охлаждения Targeted Flow. Эта технология применяется во флагманском сервере SD220-8. Инновационная СЖО использует запатентованную технологию Intel Targeted Flow, включая проприетарные резервуар Targeted Flow Tank и теплоотвод Targeted Flow Heat Sink. В последнем задействованы специальные методы для направления охлаждающей жидкости именно в те зоны процессора, которые имеют самую высокую температуру. Такой подход гарантирует максимальную эффективность охлаждения и минимизирует вероятность перегрева. В СЖО применяется улучшенная охлаждающая жидкость BP Castrol DC 20 — это синтетический углеводородный диэлектрический хладагент с низкой вязкостью и хорошей текучестью. Применённая система охлаждения допускает повторное использование сгенерированного тепла.

Источник изображений: Compal Сервер SD220-8 представляет собой четырёхузловое решение в форм-факторе 2U. Каждый узел может нести на борту два процессора Intel Xeon Sapphire Rapids или Emerald Rapids, а также 16 модулей DDR5-5600 (L)RDIMM. Во фронтальной части узлов могут быть установлены четыре SFF-накопителя SATA/SAS/NVMe U.2. Кроме того, есть два внутренних коннектора для SSD M.2 2280. Предусмотрен разъём OCP 3.0, а также один или два слота (в зависимости от конфигурации — два или четыре фронтальных SSD) для карт PCIe 5.0 x16 HHHL.  Узлы располагают контроллером BMC/CMC Aspeed AST 2600/2620, опциональным модулем TPM 2.0, портом USB 3.2 Gen1 Type-A. Сервер комплектуется четырьмя блоками питания мощностью 1600 Вт с сертификатом 80 Plus Platinum/Titanium.

20.12.2024 [01:38], Владимир Мироненко

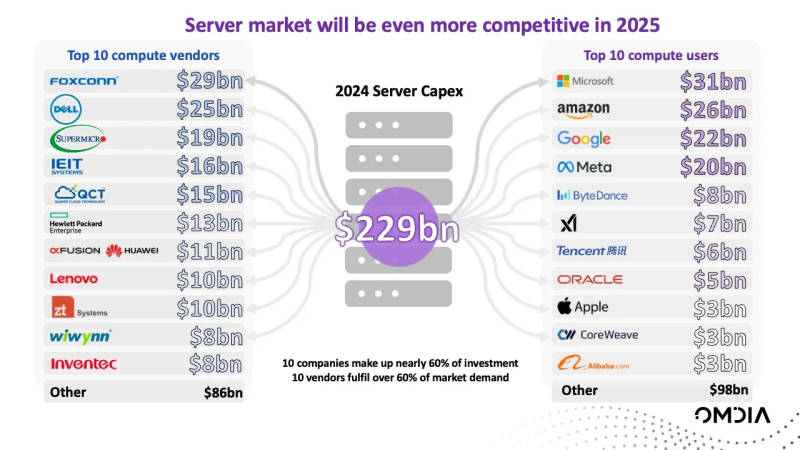

Foxconn вот-вот станет крупнейшим в мире поставщиком серверовПо данным Omdia, тайваньский технологический гигант Foxconn в этом году может стать первой неамериканской компанией, ставшей лидером мирового рынка серверов, сообщил ресурс Data Center Knowledge. Согласно прогнозу, общие затраты на серверы в 2024 году составят $229 млрд, из них $29 млрд достанутся Foxconn. На фоне растущего спроса со стороны крупных американских поставщиков облачных услуг на оптимизированные для обработки ИИ-нагрузок серверы ODM-бизнес Foxconn достигнет астрономического роста в 2024 году. Вскоре компания опередит Dell ($25 млрд по итогам года), которая, в свою очередь, обошла в 2018 году HPE ($13 млрд в 2024 году) на рынке серверов, предсказывают аналитики. По словам Влада Галабова (Vlad Galabov), старшего директора Omdia, в 2024 году на четырёх крупнейших провайдеров облачных услуг — Microsoft, Amazon, Google и Meta✴ — будет приходиться почти половина всего объёма капитальных затрат на ЦОД, что позволит им усилить влияние на высококонкурентном рынке серверов. «Поскольку разработка и развёртывание приложений ИИ доминируют, поставщики, сотрудничающие с NVIDIA, процветают. Эта динамика вывела Foxconn на первое место», — отметил аналитик. В числе бенефициаров резкого роста спроса на оптимизированные для ИИ серверы также стали Quanta Cloud Technologies (QCT; пятое место, $15 млрд), ZT Systems (девятое место, $19 млрд) и SuperMicro (третье место, $19 млрд), более чем вдвое увеличившие доход от продаж серверов в 2024 году. При этом на рынке произошли перестановки. AMD купила ZT Systems, однако производственное подразделение будет продано. Доля Inventec в ZT Systems также достанется AMD. А Supermicro испытывает трудности и уже лишилась ряда крупных заказов. Завершающийся год был успешным и для Dell, у которой появились новые крупные стратегические клиенты, такие как CoreWeave и xAI. Она также разработала портфель профессиональных сервисов и эталонных проектов, включая консалтинговые услуги в области ИИ. «Несмотря на изменения в рейтинге, все поставщики серверов будут считать, что 2024 год принёс им крупный успех из-за значительного роста рынка», — сообщил Манодж Сукумаран (Manoj Sukumaran), ведущий аналитик Omdia. В Omdia отметили, что консолидированный характер инвестиций сделал 2024 год уникальным годом на рынке серверов. Omdia прогнозирует, что на 10 компаний будет приходиться почти 60 % мировых инвестиций в серверы и 10 компаний удовлетворят более 70 % спроса на рынке. Как ожидает Omdia, что устойчивый рост продолжится в течение десятилетия, и к 2028 году рынок серверов достигнет $380 млрд, приблизившись в 2030 году к $500 млрд. «Мы увидели только верхушку айсберга формирования и расходов облачных провайдеров, специализирующихся на ИИ. Их капитальные затраты на серверы должны значительно вырасти, и CoreWeave потенциально превзойдет Oracle в 2025 году», — отметил Галабов.

17.12.2024 [12:00], Сергей Карасёв

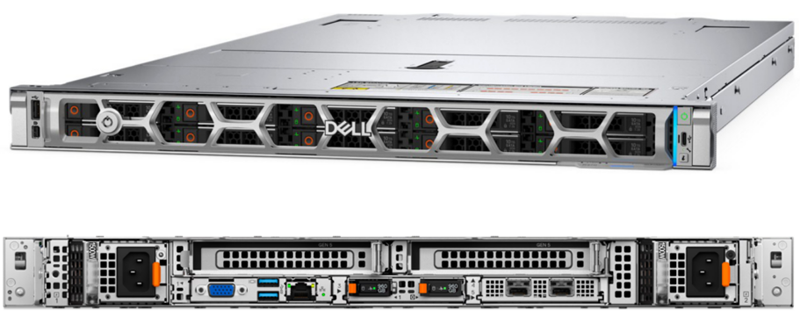

Dell анонсировала односокетные серверы PowerEdge R470/R570 на базе Intel Xeon Sierra ForestDell анонсировала серверы PowerEdge R470 и PowerEdge R570 на платформе Intel Xeon 6, сочетающие в себе производительность и энергоэффективность. Устройства подходят для таких рабочих нагрузок, как облачные микросервисы, масштабируемые базы данных и пр. Новинки выполнены в форм-факторе 1U и 2U соответственно. Серверы имеют односокетное исполнение; возможна установка процессора Xeon 6700E с энергоэффективными ядрами E-core семейства Sierra Forest (до 144 вычислительных ядер). Модель PowerEdge R470 оборудована 16 слотами для модулей DDR5-6400 ECC DIMM. Во фронтальной части в зависимости от конфигурации располагаются восемь отсеков для накопителей EDSFF E3.S NVMe или SFF SSD (SAS/SATA/NVMe). Кроме того, можно установить два внутренних SSD формата M.2 (NVMe). Предусмотрены два разъёма для карт PCIe 5.0 x16 FHHL. За питание отвечают два блока стандарта 80 Plus Platinum на 800 Вт или 80 Plus Titanium мощностью 1500 Вт с возможностью горячей замены. Задействовано воздушное охлаждение.

Источник изображения: Dell Сервер имеет габариты 816,92 × 482 × 42,8 мм. Спереди находятся по одному порту USB 2.0 Type-C, USB 2.0 Type-A (опционально) и Mini-DisplayPort, последовательный порт и выделенный сетевой порт управления (RJ-45). Сзади размещены ещё один сетевой разъём Ethernet, два порта USB 3.1 Type-A и аналоговый порт D-Sub. Заявлена совместимость с Canonical Ubuntu Server LTS, Red Hat Enterprise Linux и SUSE Linux Enterprise Server. Сервер PowerEdge R470 уже доступен для заказа, тогда как продажи PowerEdge R570 будут организованы в начале следующего года (тогда же Dell раскроет подробную информацию об этой модели).

11.12.2024 [15:39], Руслан Авдеев

HPE отказалась продать неизвестному клиенту ИИ-серверы на $700 млнВ ходе отчёта за IV квартал 2024 года HPE упомянула, что отказалась от заказа на поставку ИИ-оборудования на $700 млн, усомнившись в неназванном покупателе, сообщает Network World. Общий объём бронирования по итогам квартала составил ожидамеые $1,2 млрд, а портфель необработанных заказов вырос до $3,5 млрд. В компании подчеркнули, что заказы на ИИ-системы могут поступать неравномерно, и это как раз такой случай. На вопрос Network World об отмене заказа компания ответила, что имеет надёжную систему контроля, внимательно следит за работой с надёжными клиентами, управляет рисками и проводит диверсификацию портфеля заказов. Другими словами, по мнению экспертов, HPE потеряла веру в то, что один из её клиентов сможет справиться с контрактными обязательствами, и должным образом отреагировала на эту угрозу. И это важный сигнал для рынка в целом. Одна из основных проблем в том, что системы генеративного ИИ пока слабо окупаются. По данным Sequoia Capital, ИИ-индустрия потратила в прошлом году почти $50 млрд на чипы NVIDIA, но выручка за тот же период составила всего $3 млрд. Подчёркивается, что скидки и прочие привилегии больше не являются необходимой частью распространения ИИ-продуктов.

Источник изображения: HPE По мнению экспертов, сейчас спрос превышает предложение, поэтому HPE может позволить себе отдавать преимущество отдельным сегментам рынка и продуктам, поскольку объёмы доступной ИИ-инфраструктуры ограничены. Похожий дисбаланс спроса и предложения наблюдался несколько лет назад во время пандемии COVID-19. Выяснить, когда спрос превысит предложение, не так просто — на насыщение цепочки поставок продуктами уходит сравнительно много времени. При этом финансовые директора компаний из списка Fortune 2000 могут счесть перспективы инвестиций в генеративный ИИ не слишком впечатляющими. Это окажет влияние на позиции заказчиков и покупателей. Впрочем, те, кто первыми начали внедрять такие системы, в долгосрочной перспективе, возможно, будут иметь лучшие позиции, более низкую стоимость эксплуатации и т.п. Пока эксперты остерегаются делать чересчур смелые прогнозы. С учётом скорости развития ИИ-инфраструктуры не исключено, что на $1 млн, который можно потратить прямо сейчас, позднее можно будет получить гораздо более выгодное предложение. В то же время не исключено, что полупроводники достигнут физического предела своей производительности и IT-руководителям придётся делать сложный выбор, в числе прочего сделав акценты на повышение «нишевости» и качества ИИ-моделей.

30.11.2024 [15:52], Сергей Карасёв

Iceotope представила KUL AI — GPU-сервер на платформе Gigabyte с необычной СЖОКомпания Iceotope анонсировала сервер KUL AI, предназначенный для поддержания самых требовательных рабочих нагрузок ИИ. Новинка базируется на аппаратной платформе Gigabyte G293, интегрированной с высокоэффективной гибридной СЖО Iceotope Precision Liquid Cooling, сочетающей прямое жидкостное охлаждение с погружным охлаждением в одном шасси. Известно, что в сервере применяются процессоры Intel Xeon. Установлены восемь ускорителей. Устройство имеет аккредитацию NVIDIA Certified-Solutions. Оно оптимизировано по конструкции для жидкостного охлаждения на основе диэлектрических теплоносителей. Утверждается, что благодаря системе Iceotope Precision Liquid Cooling сервер KUL AI обеспечивает бесперебойную и надёжную работу при поддержании оптимальной температуры. При этом достигается защита критически важных компонентов и сводится к минимуму частота отказов даже во время интенсивных и продолжительных ИИ-нагрузок. Устройство имеет размеры 121 × 53 × 13,5 см и весит 99 кг. В набор интерфейсов в зависимости от варианта исполнения входят до четырёх сетевых портов 10Gb RJ-45 и QSFP28 или SFP28, порты USB 3.2 Type-A, аналоговый разъём D-Sub и коннектор 1Gb RJ-45. Говорится о практически бесшумной работе и герметичном исполнении. По заявлениям разработчика, новинка идеально подходит для чувствительных к задержкам периферийных вычислений, включая среды с экстремальными условиями эксплуатации. «KUL AI позволяет организациям развёртывать ИИ везде, где это необходимо, открывая новые возможности в плане операционной эффективности и инноваций даже в самых сложных IT-средах», — заявляет Iceotope.

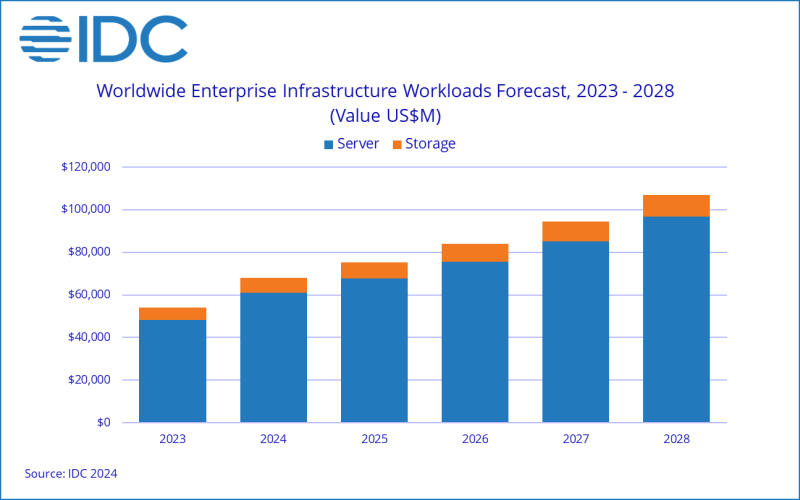

28.11.2024 [10:32], Сергей Карасёв

IDC: мировые расходы на ИИ-инфраструктуру превысят $100 млрд к 2028 годуКомпания International Data Corporation (IDC) обнародовала свежий прогноз по глобальному рынку инфраструктур для приложений ИИ. Отрасль переживает стремительный рост, что обусловлено активным внедрением ИИ и машинного обучения в самых разных сферах. Аналитики учитывают отгрузки серверов и СХД для задач ИИ. По оценкам, в I полугодии 2024-го продажи соответствующего оборудования достигли в денежном выражении $31,8 млрд. Это на 37 % больше по сравнению с показателем за аналогичный период 2023 года. При этом основную часть выручки обеспечили ИИ-серверы — приблизительно 89 % в общем объёме затрат. В исследовании отмечается, что в I половине 2024 года инфраструктура ИИ, развёрнутая в облачных и общедоступных средах, обеспечила 65 % от суммарных продаж. Операторы ЦОД и гиперскейлеры вкладывают значительные средства в расширение своих мощностей. На серверы с ИИ-ускорителями пришлось 58 % от общих расходов на серверную инфраструктуру ИИ, а рост в годовом исчислении зафиксирован на уровне 63 %. IDC прогнозирует, что к 2028 году затраты на ИИ-серверы превысят 60 % от суммарных расходов в соответствующем сегменте. При этом показатель CAGR (среднегодовой темп роста в сложных процентах) прогнозирует в размере 19 % на протяжении пяти лет. Сегмент СХД в I полугодии 2024-го показал рост на 36 % в годовом исчислении, при этом 56 % расходов пришлось на облачные развёртывания. США лидируют на мировом рынке ИИ-инфраструктур с долей почти 50 %. Далее следуют Китай (23 %), Азиатско-Тихоокеанский регион (16 %) и EMEA (10 %). В течение следующих пяти лет, как прогнозирует IDC, Азиатско-Тихоокеанский регион будет демонстрировать показатель CAGR около 20 %, США — 16 %, EMEA — 13 %, Китай — 11 %. К 2028 году, как ожидается, мировые расходы на инфраструктуру ИИ достигнут $107 млрд, при этом серверы, развёрнутые в облачных средах, обеспечат 75 % выручки.

27.11.2024 [00:44], Владимир Мироненко

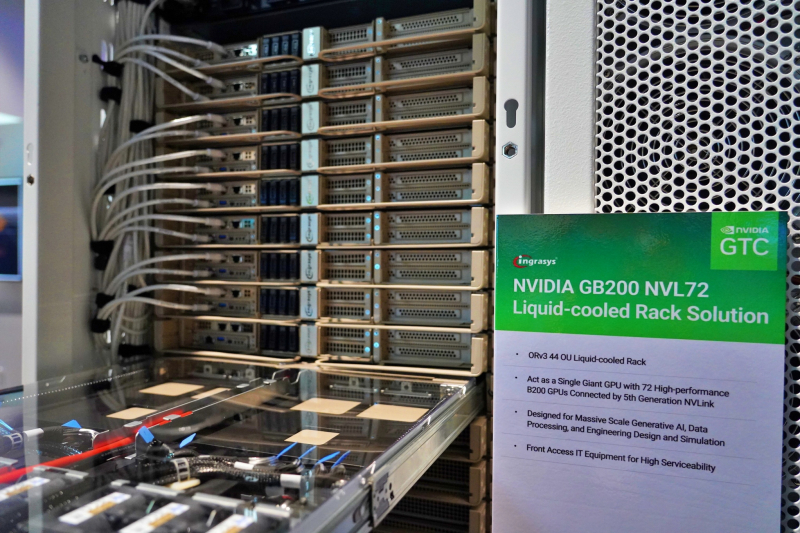

DIGITIMES Research ожидает снижение поставок серверов в IV квартале — «виноваты» будут суперускорители NVIDIA GB200 NVL72Согласно оценкам аналитиков DIGITIMES Research, глобальные поставки серверов в III квартале 2024 года выросли на 4,3 % по сравнению с предыдущим кварталом, превзойдя предыдущие прогнозы, но из-за высоких показателей базового периода поставки в IV квартале, как ожидается, последовательно снизятся. Крупнейшие провайдеры облачных услуг (CSP) США продолжили наращивать закупки серверов общего назначения следующего поколения в III квартале. Большинство CSP также увеличили закупки высокопроизводительных ИИ-серверов по сравнению с предыдущим кварталом, отметили в DIGITIMES Research. Вместе с тем поставки в количественном выражении не оправдали ожиданий, поскольку клиенты сделали упор на закупки ИИ-серверов, отличающихся гораздо более высокой ценой. DIGITIMES Research прогнозирует снижение в IV квартале мировых поставок серверов на 5,2 % по сравнению с III кварталом из-за высокой базы в связи с активными закупками серверов облачными провайдерами из США и ожидаемого начала поставок суперускорителей NVIDIA GB200 NVL72, что должно привести к замедлению темпов поставок серверов общего назначения. Серверные бренды и китайские CSP также снизят динамику поставок в IV квартале, и обе группы, как ожидается, столкнутся с более значительным последовательным снижением поставок по сравнению с конкурентами в сфере облачных услуг из США. DIGITIMES Research отметила, что общий рынок серверов продолжил восстановление в III квартале 2024 года, при этом CSP из США, такие, как Meta✴, Microsoft и Amazon, ускорили внедрение новых платформ, что привело к росту их совокупных поставок на 13 % по сравнению с предыдущим кварталом. Вместе с тем американские серверные бренды — за исключением Dell — столкнулись со спадом поставок в III квартале, что привело к общему снижению поставок на 1,1 % за прошедшие три месяца. Спад в первую очередь связан с более консервативным в сравнении с гиперскейлерами подходом предприятий к инвестициям в ИТ, не связанным с ИИ, что привело к сокращению закупок серверов общего назначения. Как ожидает DIGITIMES Research, в IV квартале 2024 года CSP из США в основном зафиксируют резкий последовательный спад поставок, за исключением Meta✴ и Microsoft, которые, как ожидается, продолжат начавшиеся в предыдущем квартале закупки новых серверов, что приведёт к небольшому росту поставок за квартал. Относительно устойчивые закупки Meta✴ и Microsoft позитивно отразятся на росте показателей их ключевых тайваньских партнёров по производству серверов, Wiwynn и Foxconn. Состояние глобальной экономики в IV квартале останется неопределённым, что повлияет на инвестиции предприятий, сообщила DIGITIMES Research. Поскольку экономика Китая также замедляется, американские бренды и китайские CSP могут столкнуться в последние три месяца 2024 года с резким сокращением заказов. |

|