Материалы по тегу: сервер

|

20.09.2024 [11:52], Руслан Авдеев

Lenovo займётся малотиражным выпуском ИИ-серверов в ИндииКомпания Lenovo объявила о намерении выпускать ИИ-серверы на заводе в Пондичерри (Индия). Как сообщает The Register, дополнительно она уже основала новую лабораторию в Бангалоре, которая займётся инфраструктурными разработками и исследованиями. Завод в Пондичерри потенциально может выпускать 50 тыс. единиц вычислительной техники, называемых Lenovo «корпоративными стоечными ИИ-серверами», а также 2,4 тыс. «модулей на основе GPU класса High-End». Китайский IT-гигант не поделился спецификациями стоечных серверов, но сообщил, что «машины High-End класса» получат по 8 ускорителей. 60 % серверов предназначены для поставки в страны Азиатско-Тихоокеанского региона. По данным компании, Lenovo модернизирует цепочку поставок не только для удовлетворения внутреннего, «домашнего» спроса, но и для экспансии на зарубежные рынки.

Источник изображения: ha11ok/pixabay.com Научно-исследовательский центр в Бангалоре — одна из четырёх площадок для разработок. Остальные расположены в Пекине, Тайбэе и Моррисвилле (Северная Каролина). В Lenovo считают, что он будет ключевым для системного проектирования, разработки и тестирования следующего поколения серверных платформ — оборудования, прошивок, а также для разработки программного обеспечения для них. В компании прогнозируют, что все будущие разработки серверов мейнстрим-сегмента, а также новые технические инициативы будут опробованы здесь. В Lenovo уверены, что два новых объекта в Индии содействуют дальнейшему укреплению присутствия в стране, создавая тысячи экономических возможностей в высокотехнологичном секторе. При этом компания действует на индийском рынке уже довольно давно. Она открыла завод в Пондичерри в 2005 году и, как заявляется, выпустила в стране более 7 млн устройств за финансовый год, закончившийся 31 марта. Также в Индии около 10 лет действует завод Motorola Mobility, который компания приобрела у Google в 2014 году. Индия стремится нарастить производство в стране высокотехнологичных продуктов в рамках инициативы Make in India, запущенной в 2014 году. Последняя предусматривает реформы в политическом секторе, налоговые льготы, субсидии и упрощение процедуры инвестиций. Похоже, план работает, поскольку Foxconn, HP, Cisco, Acer, Asus и Dell в последние пару лет перенесли некоторые производственные процессы именно в Индию. Компании ориентируются на рост внутреннего рынка самой страны, а также пытаются диверсифицировать операции, учтя опыт перебоев в цепочках поставок в период пандемии COVID-19. Немалую роль играют и геополитические мотивы — США в последние годы не приветствуют ведение дел с Китаем и, тем более, инвестиции в Поднебесную, из-за чего зависимость от китайского бизнеса становится всё более рискованной и некоторые компании переносят оттуда производство, в том числе серверов. Мировые продажи серверов должны вырасти до 12 млн в текущем году, поэтому 52,4 тыс. машин, которые Lenovo соберёт в Индии, станут лишь малым вкладом в рынок серверного оборудования. Тем не менее, ИИ-серверы пользуются сегодня таким высоким спросом, что последние инициативы компании будут безусловно приветствоваться в Индии, даже если уровень производства в стране пока невелик. С учётом того, что Lenovo тесно связана с наследием IBM, опыт производства за пределами Китая у компании весьма большой. Ещё в декабре прошлого года сообщалось, что Индия готовится построить собственную ИИ-инфраструктуру. Позже в том же месяце появилась информация о развёртывании мощностей на 80 Эфлопс. Например, сообщалось о намерении страны скупить ускорители NVIDIA, не доставшиеся Китаю из-за санкций, а в марте 2024 года появилась новость о готовности потратить $1,2 млрд на ИИ-суперкомпьютер и собственные LLM.

19.09.2024 [20:06], Юрий Лебедев

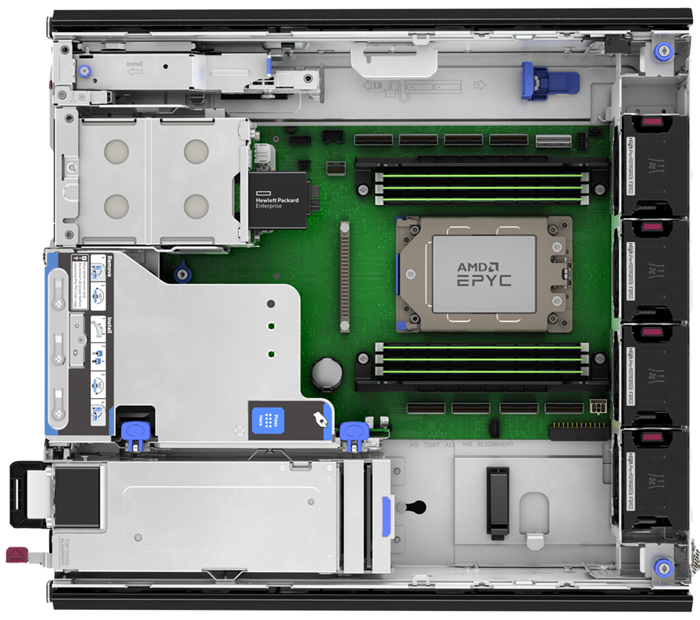

HPE представила компактный edge-сервер ProLiant DL145 Gen11 на базе AMD EPYC SienaHPE представила компактный однопроцессорный 2U-сервер ProLiant DL145 Gen11 на базе AMD EPYC 8004 Siena, предназначенный для перифийных вычислений, для которых характерен дефицит энергии, пространства или возможностей охлаждения. Сервер способен функционировать при температурах от -5 °C до +55 °C, имеет защиту от пыли и устойчив к вибрациям. Возможна установка 64-ядерного CPU с TDP до 200 Вт. Есть шесть слотов (1DPC) для модулей памяти DDR5-4800 ECC суммарной ёмкостью до 768 Гбайт. Дисковая корзина поддерживает установку двух SATA SFF или шести NVMe E3.S-накопителей. Опционально можно установить проприетарный модуль с двумя 480-Гбайт M.2 NVMe SSD, собранных в RAID1, для ОС. Для карт расширения доступно три слота PCIe 5.0 x16: два FHFL и один FHHL. Также есть слот OCP 3.0, тоже PCIe 5.0 x16. Сервер оснащён системой удалённого управления iLO 6 с выделенным 1GbE-портом. Также на заднюю панель выведены четыре порта USB 3.0 Type-A и разъём DisplayPort. Опционально доступен последовательный порт с разъёмом RJ45. Для питания используются один или два (1+1) БП с сертификацией Platinum/Titanium мощностью 700 или 1000 Вт. Доступен и 700-Вт блок питания 48 В DC. Система вентиляции включает четыре вентилятора с резервированием N+1. БП, все порты и слоты для удобства выведены на переднюю панель сервера. Фронтальная крышка может быть оснащена воздушным фильтром для защиты от пыли. Есть датчик вскрытия корпуса, блокировка передней панели и гнездо замка Kensington. Устройство имеет габариты 875 × 359 × 406 мм и весит до 15,6 кг. Возможно размещение как на столе/стене, так и в телекоммуникационной стойке. Новинка будет доступна в рамках HPE GreenLake.

09.09.2024 [11:08], Сергей Карасёв

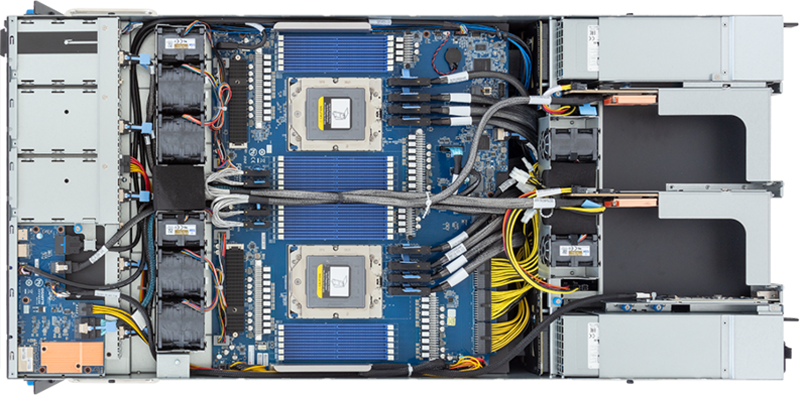

Gigabyte представила серверы с ускорителями NVIDIA HGX H200 и СЖО

amd

coolit systems

emerald rapids

epyc

genoa

gigabyte

h200

hardware

intel

nvidia

sapphire rapids

xeon

сервер

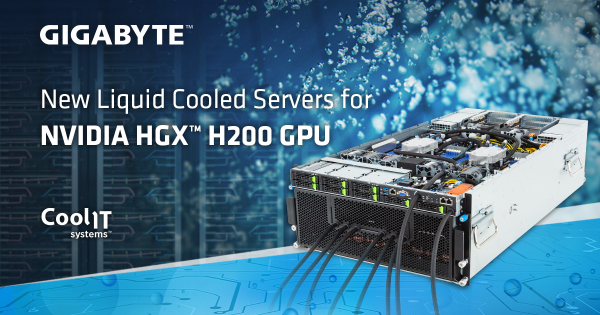

Компания Giga Computing, подразделение Gigabyte, анонсировала серверы G593-ZD1-LAX3 и G593-SD1-LAX3, предназначенные для ресурсоёмких нагрузок, связанных с ИИ. Устройства, оснащённые системой прямого жидкостного охлаждения (DLC) от CoolIT, могут нести на борту до восьми ускорителей NVIDIA HGX H200. Модель G593-ZD1-LAX3 выполнена в форм-факторе 5U. Допускается установка двух процессоров AMD EPYC 9004 поколения Genoa с показателем TDP до 400 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Во фронтальной части расположены отсеки для восьми SFF-накопителей (NVMe/SATA/SAS-4). Есть два коннектора М.2 для SSD типоразмера 2280/22110 с интерфейсом PCIe 3.0 x4 и PCIe 3.0 x1.  Доступны восемь слотов PCIe 5.0 x16 для низкопрофильных карт расширения и четыре разъёма PCIe 5.0 x16 для карт FHHL. В оснащение входят два порта 10GbE (Intel X710-AT2), два выделенных сетевых порта управления 1GbE, два разъёма USB 3.2 Gen1. В свою очередь, сервер G593-SD1-LAX3 рассчитан на два процессора Intel Xeon Emerald Rapids или Sapphire Rapids, величина TDP которых может достигать 350 Вт. Для модулей ОЗУ DDR5-4800/5600 предусмотрены 32 слота. Прочие характеристики (за исключением разъёмов М.2) аналогичны модели на платформе AMD.  Новые серверы укомплектованы шестью блоками питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Присутствует контроллер Aspeed AST2600. Диапазон рабочих температур — от 10 до +35 °C. Система DLC предназначена для отвода тепла от ускорителей NVIDIA HGX H200. При этом в области материнской платы и слотов PCIe установлены вентиляторы охлаждения.

01.09.2024 [20:15], Сергей Карасёв

Для облаков и ИИ: QCT представила серверы на процессорах Intel Xeon 6Компания Quanta Cloud Technology (QCT) анонсировала серверы на процессорах Intel Xeon 6, ориентированные на поставщиков облачных услуг, телекоммуникационных провайдеров и операторов ЦОД. Дебютировали решения серий QuantaGrid и QuantaPlex для различных рабочих нагрузок, включая задачи ИИ и НРС. Отмечается, что серверы QCT построены с применением модульных компонентов, для монтажа которых не требуются инструменты. Доступны варианты с воздушным и жидкостным охлаждением, различной компоновкой подсистемы хранения данных, поддержкой ускорителей одинарной и двойной ширины. Реализована возможность горячей замены отдельных узлов, таких как блоки питания и вентиляторы. Представлены модели QuantaGrid D55X-1U и QuantaGrid D55Q-2U типоразмера 1U и 2U соответственно. Они допускают установку двух чипов Xeon 6700E (Sierra Forest) с TDP до 350 Вт. Возможна установка 32 модулей DDR5-6400 RDIMM или 16 модулей MRDIMM (до 8000 МГц). У 1U-версии конфигурация подсистемы хранения в зависимости от исполнения включает: 12 × SFF NVMe/SATA/SAS SSD, 16 × E1.S NVMe SSD, 20 × E3.S 1T NVMe или 4 × E3.S 1T NVMe + 8 × E3.S 2T CXL. Карты расширения могут монтироваться по схеме 2 × PCIe 5.0 x16 FHHL, 2 × PCIe 5.0 x16 OCP 3.0 SFF и 1 × DC-SCM или 3 × PCIe 5.0 x16 HHHL, 2 × PCIe 5.0 x16 OCP 3.0 SFF и 1 × DC-SCM. Для сервера формата 2U предусмотрены варианты с поддержкой следующих накопителей: 12 × LFF SATA/SAS HDD или 12 × SFF NVMe, 24 × SFF NVMe/SATA/SAS или 12 × E3.S 1T NVMe + 12 × E3.S 2T CXL. Допускаются различные варианты монтажа карт PCIe 5.0 x8 FHHL, PCIe 5.0 x16 FHFL и PCIe 5.0 x8 HHHL. Серверы комплектуются двумя блоками питания с сертификатом 80 Plus Titanium (до 2700 и 3200 Вт соответственно). Кроме того, анонсированы модели QuantaGrid S55R-1U и QuantaGrid S55J-2U формата 1U и 2U с поддержкой чипов Xeon 6700 с производительными P-ядрами (Granite Rapids). Раскрываются характеристики только 1U-сервера: один процессор с TDP до 350 Вт, 16 слотов для модулей DDR5-5200 RDIMM, 12 посадочных мест для SFF-накопителей NVMe/SATA/SAS SSD, два слота PCIe 5.0 x16 FHHL + слот OCP 3.0 NIC SFF, два коннектора M.2 2230/2280 PCIe 5.0, два блока питания 80 Plus Titanium мощностью до 2000 Вт. Дебютировали также серверы QuantaPlex S25Z-2U и QuantaPlex S45Z-2U типоразмера 2U с двумя и четырьмя узлами. Каждый узел рассчитан на один процессор Xeon 6700 с TDP до 350 Вт, 16 модулей DDR5-6400 RDIMM, а также два SSD M.2. Двухузловая версия поддерживает до трёх карт расширения PCIe 5.0 и два SFF-накопителя NVMe/SATA SSD на узел. У четырёхузловой модификации возможна установка одной карты PCIe 5.0, а также двух накопителей E1.S NVMe SSD или трёх устройств SFF NVMe SSD на узел. Вышел 7U-сервер QuantaGrid D74H-7U для ресурсоёмких нагрузок НРС и ИИ. Он допускает установку двух процессоров Intel Xeon Emerald Rapids или Sapphire Rapids с показателем TDP до 350 Вт. Есть 32 слота для модулей памяти DDR5-5600 RDIMM суммарным объёмом до 8 Тбайт. Предусмотрены отсеки для 18 SFF-накопителей NVMe SSD. Возможна установка восьми ускорителей NVIDIA H100 (SXM5). Слоты расширения выполнены по схеме 2 × PCIe 5.0 x16 OCP 3.0 SFF и 10 × PCIe 5.0 x16 OCP 3.0 TSFF. Применены шесть блоков питания 80 Plus Titanium на 4000 Вт. Наконец, представлен высокопроизводительный сервер QuantaGrid D75E-4U формата 4U, который, как утверждается, обеспечивает максимальную гибкость при работе с LLM, ИИ и HPC. Он оснащён двумя процессорами Intel Xeon 6 с TDP до 350 Вт и поддерживает до восьми GPU-ускорителей PCIe следующего поколения с воздушным охлаждением и TDP до 600 Вт.

19.08.2024 [10:10], Сергей Карасёв

Gigabyte представила ИИ-серверы с ускорителями NVIDIA H200 и процессорами AMD и IntelКомпания Gigabyte анонсировала HGX-серверы G593-SD1-AAX3 и G593-ZD1-AAX3, предназначенные для задач ИИ и НРС. Устройства, выполненные в форм-факторе 5U, включают до восьми ускорителей NVIDIA H200. При этом используется воздушное охлаждение. Модель G593-SD1-AAX3 рассчитана на два процессора Intel Xeon Emerald Rapids с показателем TDP до 350 Вт, а версия G593-ZD1-AAX3 располагает двумя сокетами для чипов AMD EPYC Genoa с TDP до 300 Вт. Доступны соответственно 32 и 24 слота для модулей оперативной памяти DDR5.  Серверы наделены восемью фронтальными отсеками для SFF-накопителей NVMe/SATA/SAS-4, двумя сетевыми портами 10GbE на основе разъёмов RJ-45 (выведены на лицевую панель) и выделенным портом управления 1GbE (находится сзади). Есть четыре слота FHHL PCIe 5.0 x16 и восемь разъёмов LP PCIe 5.0 x16. Модель на платформе AMD дополнительно располагает двумя коннекторами М.2 для SSD с интерфейсом PCIe 3.0 x4 и x1.  Питание у обоих серверов обеспечивают шесть блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium. Габариты новинок составляют 447 × 219,7 × 945 мм. Диапазон рабочих температур — от +10 до +35 °C. Есть два порта USB 3.2 Gen1 и разъём D-Sub. Массовое производство серверов Gigabyte серии G593 запланировано на II половину 2024 года. Эти системы станут временной заменой (G)B200-серверов, выпуск которых задерживается.

18.08.2024 [20:47], Руслан Авдеев

Полуфабрикаты: AMD и Supermicro готовы поставлять серверы без CPU, чтобы клиент смог сам выбрать наиболее подхощий чипНа первый взгляд поставка серверного оборудования без процессоров может показаться бессмысленной, но представители AMD и Supermicro рассказали, почему готовы участвовать в подобных проектах. По данным CRN, топ-менеджеры компаний-партнёров заинтересованы в работе с небольшими компаниями, если у тех есть уникальные заказы. В недавнем интервью на конференции SIGGRAPH 2024, один из топ-менеджеров AMD Джеймс Найт (James Knight) заявил, что AMD совместно с Supermicro неоднократно работали по подобной схеме со студиями, участвующими в создании компьютерной графики и другого контента. Сам Найт неоднократно участвовал в создании визуальных эффектов, в том числе для «Аватара», поэтому хорошо знает индустрию изнутри. По его словам, небольшие студии часто ограничены в средствах и просят о поставках серверов без процессоров, поскольку им ещё предстоит определить, какой именно вариант «железа» будет оптимальным по соотношению цена/производительность для их нагрузок. В качестве примера были приведены две (неназванные) студии, спросившие AMD, есть ли у той партнёры среди поставщиков серверов, согласные взяться за такие «полуготовые» решения. AMD в таком случае может предложить потенциальным покупателям несколько процессоров для выбора наилучшего варианта. Многие партнёры AMD на такой запрос категорически отказывались реагировать, желая заранее знать, сколько ни смогут заработать на такой сделке. Тем не менее, в Supermicro, выручка которой выросла на 110 % до $14,9 млрд в 2024 фискальном году, встретили идею с энтузиазмом, не побоявшись работы с небольшими клиентами. Хотя подобные проекты не приносят ощутимой прямой прибыли, они чрезвычайно важны для AMD и Supermicro в медийном плане, причём в итоге всё выливается в рост прибылей обоих партнёров. «Это не капиталистический и не коммерческий подход, но это именно то, что повышает продажи», — заявляют в AMD, при этом, вероятно, немного лукавя. В Supermicro сослались на одну из студий по созданию визуального контента, которая изначально хотела получить рабочую станцию с СЖО на базе новейших Ryzen AMD Threadripper. Однако в ходе общения с AMD и Supermicrco обсуждение перешло к созданию более дорогой кастомной стоечной системы. По словам одного из партнёров AMD и Supermicro, компании могут совместно решить любую проблему клиента, желая проверить и оценить каждую опцию, находящуюся в пределах их совместной компетенции. Утверждается, что у конкурентов совсем другое мировоззрение.

13.08.2024 [11:19], Сергей Карасёв

MSI представила сервер S2301 с поддержкой CXL на базе AMD EPYC TurinКомпания MSI в ходе выставки Future of Memory and Storage 2024 (FMS) анонсировала сервер S2301, предназначенный для работы с резидентными базами данных, НРС-приложениями, платформами для автоматизации проектирования электроники (EDA) и пр. Сервер поддерживает стандарт CXL 2.0 на основе интерфейса PCIe. Технология обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и такими устройствами, как серверные ускорители, буферы памяти и интеллектуальные IO-блоки. На основе CXL 2.0 функционирует высокопроизводительный механизм доступа к памяти, который позволяет модулям расширения напрямую взаимодействовать с иерархией памяти CPU. При этом дополнительные блоки памяти работают так, как если бы они были частью собственной памяти системы. Подключив к серверу модули расширения CXL, можно с высокой эффективностью масштабировать ресурсы для обработки сложных задач. Сервер MSI S2301 поддерживает установку двух процессоров AMD EPYC поколения Turin. Доступны 24 слота для модулей ОЗУ. Возможно применение CXL-модулей в форм-факторе E3.S 2T (PCIe 5.0 x8). Такие решения, в частности, в августе 2023 года представила компания Micron Technology. Устройства имеют вместимость 128 и 256 Гбайт. Кроме того, память DRAM с поддержкой CXL 2.0 предлагает Samsung. Во фронтальной части нового сервера располагаются отсеки для SFF-модулей. Говорится об использовании софта Memory Machine X разработки MemVerge, который оптимизирует затраты и помогает улучшить производительность ИИ-приложений и других ресурсоёмких рабочих нагрузок путём интеллектуального управления памятью.

05.08.2024 [08:16], Сергей Карасёв

Новые кластеры Supermicro SuperCluster с ускорителями NVIDIA L40S ориентированы на платформу Omniverse

emerald rapids

hardware

intel

l40

nvidia

omniverse

sapphire rapids

supermicro

xeon

ии

кластер

сервер

Компания Supermicro расширила семейство высокопроизводительных вычислительных систем SuperCluster, предназначенных для обработки ресурсоёмких приложений ИИ/HPC. Представленные решения оптимизированы для платформы NVIDIA Omniverse, которая позволяет моделировать крупномасштабные виртуальные миры в промышленности и создавать цифровых двойников. Системы SuperCluster for NVIDIA Omniverse могут строиться на базе серверов SYS-421GE-TNRT или SYS-421GE-TNRT3 с поддержкой соответственно восьми и четырёх ускорителей NVIDIA L40S. Обе модели соответствуют типоразмеру 4U и допускают установку двух процессоров Intel Xeon Emerald Rapids или Sapphire Rapids в исполнении Socket E (LGA-4677) с показателем TDP до 350 Вт (до 385 Вт при использовании СЖО). Каждый из узлов в составе новых систем SuperCluster несёт на борту 1 Тбайт оперативной памяти DDR5-4800, два NVMe SSD вместимостью 3,8 Тбайт каждый и загрузочный SSD NVMe M.2 на 1,9 Тбайт. В оснащение включены четыре карты NVIDIA BlueField-3 (B3140H SuperNIC) или NVIDIA ConnectX-7 (400G NIC), а также одна карта NVIDIA BlueField-3 DPU Dual-Port 200G. Установлены четыре блока питания с сертификатом Titanium мощностью 2700 Вт каждый. В максимальной конфигурации система SuperCluster for NVIDIA Omniverse объединяет пять стоек типоразмера 48U. В общей сложности задействованы 32 узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3, что в сумме даёт 256 или 128 ускорителей NVIDIA L40S. Кроме того, в состав такого комплекса входят три узла управления Supermicro SYS-121H-TNR Hyper System, три коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами, ещё два коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами для хранения/управления, два коммутатора управления NVIDIA Spectrum SN2201 Ethernet 1G с 48 портами. При необходимости конфигурацию SuperCluster for NVIDIA Omniverse можно оптимизировать под задачи заказчика, изменяя масштаб вплоть до одной стойки. В этом случае применяются четыре узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3.

22.07.2024 [15:57], Руслан Авдеев

Поставки суперускорителей с чипами NVIDIA GB200 могут задержаться из-за протечек СЖОNVIDIA уже готовилась начать продажи систем на базе новейших ИИ-суперускорителей GB200, однако столкнулась с непредвиденной проблемой — TweakTown сообщает, что в системах жидкостного охлаждения этих серверов начали появляться протечки. Судя по всему, серверы на основе GB200 использовали дефектные компоненты систем СЖО охлаждения, поставляемые сторонними производителями: разветвители, быстросъёмные соединители и шланги. Некорректная работа любого из этих компонентов может привести к утечке охлаждающей жидкости. В случае с моделью GB200 NVL72 стоимостью в $3 млн это может перерасти в большую проблему. К счастью, нарушения в работе новых систем NVIDIA GB200 NVL36 и NVL72 обнаружили до начала массового производства в преддверии запуска поставок ключевым покупателям ИИ-решений. Предполагается, что на сроках поставок проблема не скажется, поскольку её успеют устранить. Впрочем, по данным источников, теперь крупные провайдеры облачных сервисов «нервничают».

Источник изображения: NVIDIA NVIDIA предлагают свою продукцию всё больше тайваньских производителей, способных заменить бракованные компоненты для серверных систем с GB200. Однако сертификация компонентов — процесс довольно сложный, поскольку многие тайваньские компании не специализировались на их выпуске ещё в недавнем прошлом. Тем не менее, когда NVIDIA объявила, что ускорители следующего поколения получат жидкостное охлаждение, многие производители решили попробовать себя в этой сфере. Тайваньские Shuanghong и Qihong уже имеют хороший опыт в выпуске водоблоков, а теперь расширили спектр разрабатываемых товаров, предлагая разветвители, быстросъемные соединители и шланги. Именно эти компании по некоторым данным сейчас предоставляют необходимые комплектующие для замены бракованных в новых суперускорителях NVIDIA GB200 NVL36 и NVL72. Лидером на рынке серверных СЖО остаётся CoolIT, но её услугами NVIDIA, видимо, решила не пользоваться.

19.07.2024 [10:10], Сергей Карасёв

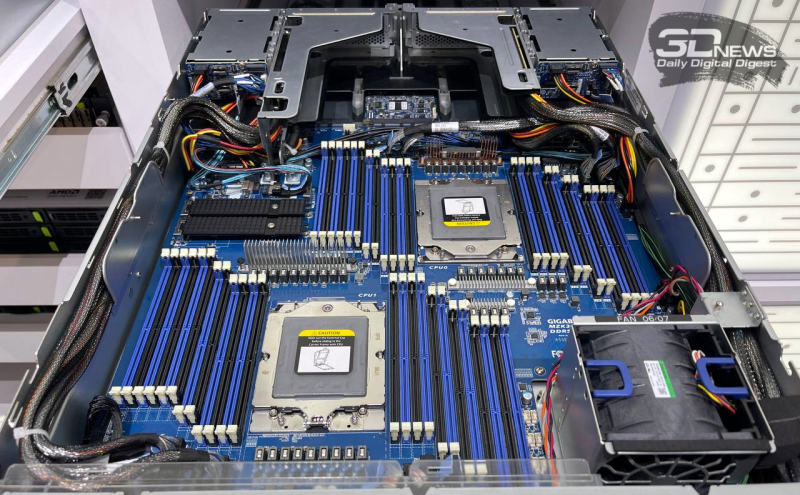

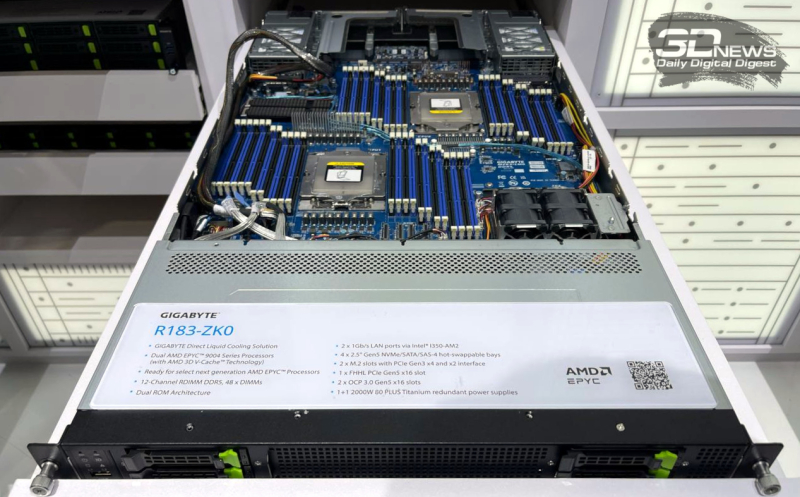

48 слотов DIMM в стандартном корпусе: EPYC-серверы Gigabyte R283-ZK0 и R183-ZK0 предлагают высокоплотное размещение DDR5Компания Gigabyte, по сообщению ресурса Tom's Hardware со ссылкой на ServeTheHome, готовит к выпуску двухпроцессорный сервер R283-ZK0 типоразмера 2U на аппаратной платформе AMD EPYC Genoa. Особенность данной модели заключается в наличии 48 слотов (24 на процессор) для модулей оперативной памяти DDR5, размещённых в уникальной конфигурации. Сервер допускает установку двух чипов в исполнении SP5: в частности, говорится о возможности использования изделий со 128 ядрами (256 потоков) с показателем TDP до 300 Вт. Из-за ограниченного пространства внутри корпуса сформировать систему с 12 каналами DDR5 на процессорный сокет, располагая слоты ОЗУ рядом друг с другом, оказалось невозможно. Поэтому соответствующие разъёмы на материнской плате Gigabyte MZK3-LM0 выполнены лесенкой: с одной стороны каждого процессора они имеют трёхступенчатую конфигурацию 6-2-4, с другой — четырёхступенчатую вида 4-2-2-4. Таким образом, удалось расположить 48 слотов DDR5 в стандартном форм-факторе 2U. Сервер R283-ZK0 оснащён восемью фронтальными отсеками для SFF-накопителей NVMe, четырьмя посадочными местами для SFF-устройств в тыльной части и двумя внутренними коннекторами М.2. Есть четыре слота FHHL для карт расширения с интерфейсом PCIe 5.0 x16, два слота OCP 3.0 и два порта 1GbE. За питание отвечают два блока мощностью 2700 Вт с сертификатом 80 Plus Titanium. Прочие характеристики сервера и сроки его поступления в продажу пока не раскрываются. Нужно отметить, что Gigabyte также готовит схожую модель R183-ZK0 в форм-факторе 1U, которая отличается от 2U-версии наличием всего четырёх слотов SFF NVMe, одного слота FHHL и БП мощностью 2000 Вт. |

|