Материалы по тегу: охлаждение

|

14.10.2025 [02:00], Сергей Карасёв

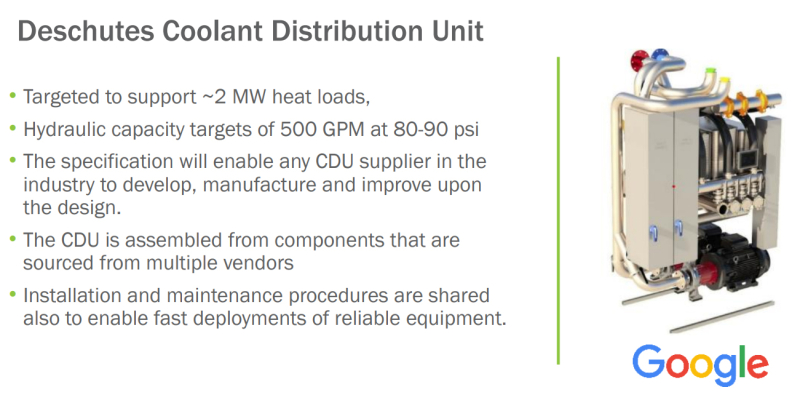

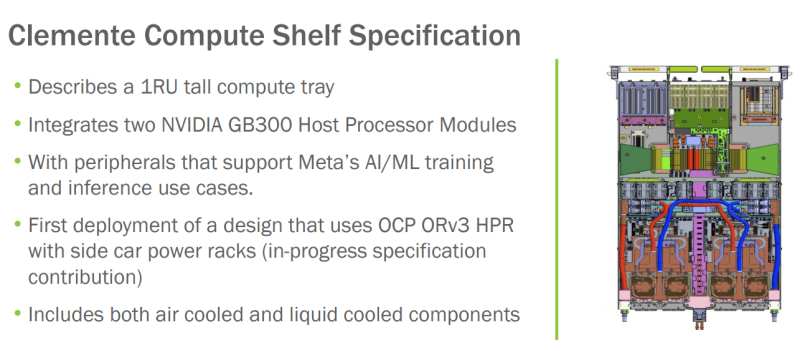

OCP запустила инициативу Open Data Center for AI для стандартизации инфраструктуры передовых ИИ ЦОД с мегаваттными стойкамиНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала инициативу Open Data Center for AI по стандартизации компонентов физической инфраструктуры дата-центров, ориентированных на задачи ИИ и другие ресурсоёмкие нагрузки. Проект Open Data Center for AI является частью программы OCP Open Systems for AI, которая была представлена в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель заключается в разработке открытых стандартов для кластеров ИИ и ЦОД, в которых размещаются такие системы. Запуск Open Data Center for AI продиктован быстрым развитием экосистемы дата-центров, результатами, полученными в рамках OCP Open Systems for AI, и новым открытым письмом о сотрудничестве, подготовленным Google, Meta✴ и Microsoft. В настоящее время, как отмечается, отрасль ЦОД сталкивается с проблемами, связанными с тем, что разрозненные усилия её участников, включая гиперскейлеров и колокейшн-провайдеров, порождают различные требования к проектированию инфраструктуры. Это замедляет внедрение инноваций и увеличивает сроки развёртывания передовых площадок. Цель Open Data Center for AI заключается в том, чтобы стандартизовать требования к системам электропитания, охлаждения и телеметрии, а также к механическим компонентам в ЦОД. Предполагается, что это обеспечит взаимозаменяемость элементов физической инфраструктуры дата-центров. При реализации инициативы Open Data Center for AI планируется использовать уже имеющиеся наработки сообщества OCP в области блоков распределения охлаждающей жидкости (CDU) и блоков распределения питания (PDU). Это, в частности, проект Mt. Diablo, который реализуется Meta✴, Microsoft и Google. Он предполагает создание общих стандартов электрических и механических интерфейсов. Идея заключается в разделении стойки на независимые шкафы для компонентов подсистемы питания и вычислительного оборудования. При этом планируется переход от единой шины питания постоянного тока с напряжением 48 В на архитектуру 400 В DC (Diablo 400). Ещё одним проектом, наработки которого пригодятся в рамках Open Data Center for AI, назван CDU Deschutes, разработанный Google. Это решение с резервными теплообменниками и насосами обеспечивает уровень доступности 99,999 %. Система Deschutes рассчитана на тепловые нагрузки до 2 МВт. Открытая спецификация позволит любой компании совершенствовать конструкцию CDU и производить изделия данного типа. Наконец, упоминаются серверные шасси Clemente, разработанные в Meta✴. Это узлы 1U, содержащие два суперчипа NVIDIA Grace Blackwell GB300 для ресурсоёмких ИИ-нагрузок. Платформа предполагает применение жидкостного охлаждения для CPU, GPU и коммутатора, а также воздушного охлаждения для других компонентов.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

17.09.2025 [17:50], Сергей Карасёв

Мини-ПК MeLE Cyber X1 на базе Intel Twin Lake получил пластиковый корпус-радиаторКомпания MeLE, по сообщению CNX Software, выпустила компьютер небольшого форм-фактора Cyber X1, подходящий для использования в коммерческой и индустриальной сферах. Новинка выполнена на аппаратной платформе Intel Twin Lake с процессором N150 (четыре ядра; до 3,6 ГГц; 6 Вт). Устройство довольствуется пассивным охлаждением. Оно заключено в необычный корпус, верхняя часть которого усеяна шипами из специального пластика с высокой теплопроводностью, которые выполняют функцию радиатора для рассеяния тепла. При этом площадь охлаждающей поверхности, как утверждается, увеличивается в 6,4 раза по сравнению с обычной плоской панелью. Однако при интенсивной нагрузке температура этой зоны может достигать 55–70 °C. Компьютер несёт на борту 16 Гбайт LPDDR5-4800 и NVMe SSD формата M.2 2280 вместимостью 512 Гбайт со скоростью передачи данных до 3940 Мбайт/с. Кроме того, предусмотрен слот для карты microSD. В оснащение входят адаптеры Wi-Fi 5 (802.11ac; частотные диапазоны 2,4/5 ГГц) и Bluetooth 5.1, сетевой контроллер 1GbE. Возможен вывод изображения одновременно на три монитора через два интерфейса HDMI 2.0 и разъём DisplayPort (через USB Type-C): во всех случаях поддерживается разрешение до 4K (60 Гц). Устройство располагает портами USB 3.2 Gen2 Type-A (10 Гбит/с), USB 3.0 Type-A (5 Гбит/с), USB 2.0 Type-A, USB 3.2 Gen2 Type-C (DisplayPort Alt Mode и USB PD 3.0), гнездом RJ45 для сетевого кабеля, 3,5-мм аудиоразъёмом. Питание (12 В / 5 A) подаётся через дополнительный порт USB Type-C. Габариты составляют 131 × 81 × 24 мм, масса — 288 г. Возможен монтаж при помощи крепления VESA. По имеющейся информации MeLE Cyber X1 поставляется с Windows 11. Ориентировочная цена — $230.

01.09.2025 [23:40], Руслан Авдеев

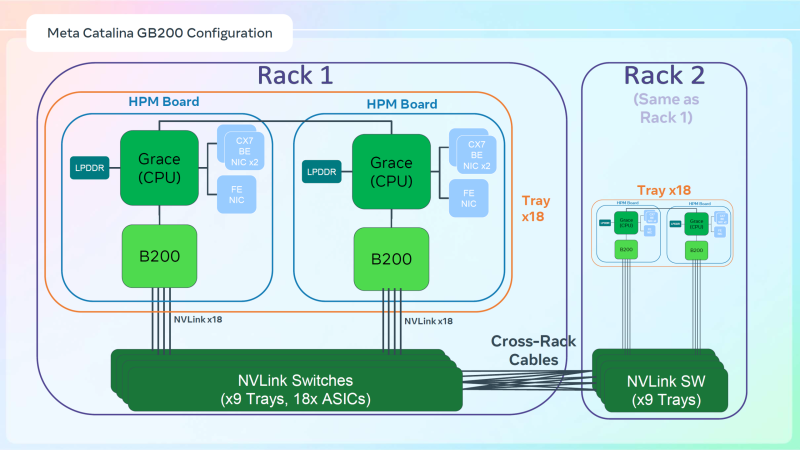

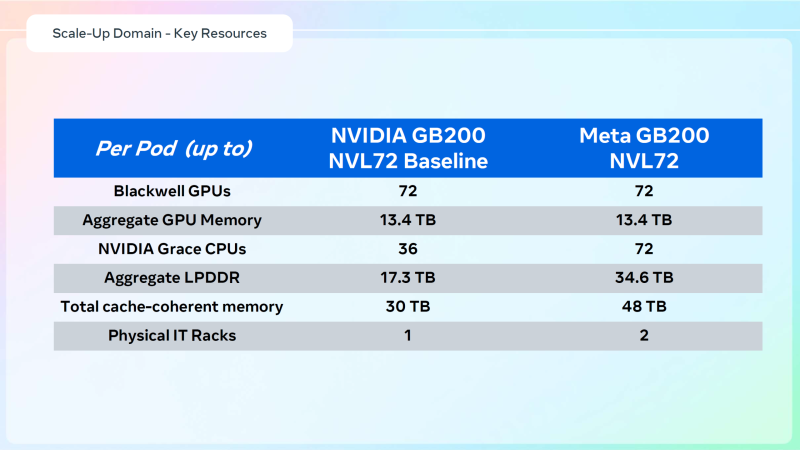

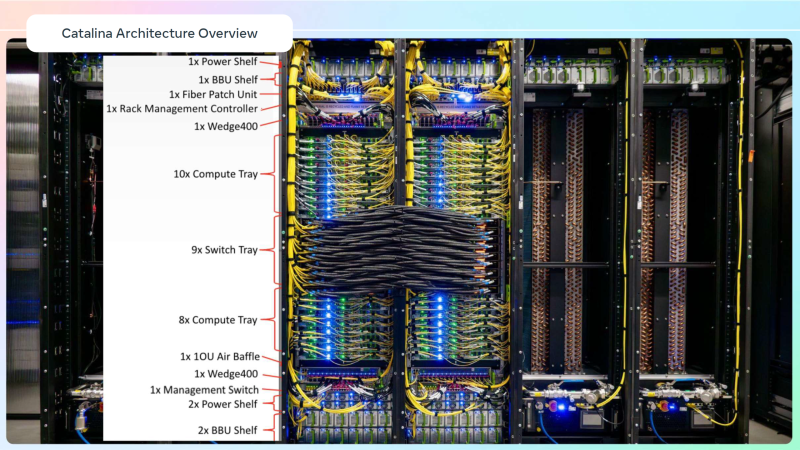

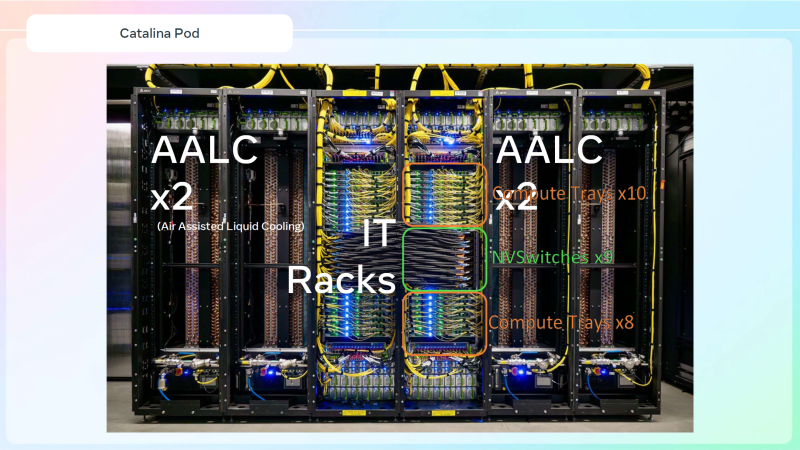

Meta✴ «растянула» суперускорители NVIDIA GB200 NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждениемДля того, чтобы развернуть в традиционных ЦОД с воздушным охлаждением современные высокоплотные стойки с ИИ-ускорителями, приходится идти на ухищрения. Один из вариантов предложила Meta✴, передаёт Wccftech. Хотя у Meta✴ есть собственный полноценный вариант суперускорителя NVIDIA GB200 NVL72 на базе ORv3-стоек Catalina (до 140 кВт) со встроенными БП и ИБП, компания также разработала также вариант, схожий с конфигурацией NVL36×2, от производства которого NVIDIA отказалась, посчитав его недостаточно эффективным. Ускоритель NVL36×2 задумывался как компромиссный вариант для ЦОД с воздушным охлаждением — одна стойка (плата Bianca, 72 × B200 и 36 × Grace) «растянута» на две.

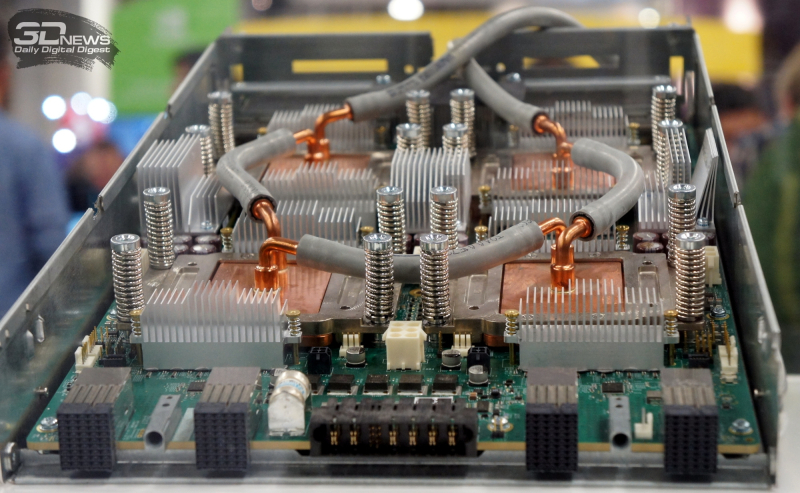

Источник изображений: Meta✴ via Wccftech Meta✴ пошла несколько иным путём. Она точно так же использует две стойки, одна конфигурация узлов другая. Если в версии NVIDIA в состав одно узла входят один процессор Grace и два ускорителя B200, то у Meta✴ соотношение CPU к GPU уже 1:1. Все вместе они точно так же образуют один домен с 72 ускорителями, но объём памяти LPDDR5 в два раза больше — 34,6 Тбайт вместо 17,3 Тбайт. Эту пару «обрамляют» четыре стойки — по две с каждый стороны. Для охлаждения CPU и GPU по-прежнему используется СЖО, теплообменники которой находятся в боковых стойках и продуваются холодным воздухом ЦОД. Это далеко не самая эффективная с точки зрения занимаемой площади конструкция, но в случае гиперскейлеров оплата в арендуемых дата-центрах нередко идёт за потребляемую энергию, а не пространство. В случае невозможности быстро переделать собственные ЦОД или получить площадку, поддерживающую высокоплотную энергоёмкую компоновоку стоек и готовую к использованию СЖО, это не самый плохой вариант. В конце 2022 года Meta✴ приостановила строительство около дюжины дата-центров для пересмотра их архитектуры и внедрения поддержки ИИ-стоек и СЖО. Первые ЦОД Meta✴, построенные по новому проекту, должны заработать в 2026 году, передаёт DataCenter Dynamics. На сегодня у Meta✴ около 30 действующих или строящихся кампусов ЦОД, большей частью на территории США. Планируются ещё несколько кампусов, включая гигаваттные. Также компания выступает крупным арендатором дата-центров, а сейчас в пылу гонки ИИ и вовсе переключилась на быстровозводимые тенты вместо капитальных зданий, лишённые резервного питания и традиционных систем охлаждения. Собственные версии GB200 NVL72 есть у Google, Microsoft и AWS. Причём все они отличаются от эталонного варианта, который среди крупных игроков, похоже, использует только Oracle. Так, AWS решила разработать собственную СЖО, в том числе из-за того, что ей жизненно необходимо использовать собственные DPU Nitro. Google ради собственного OCS-интерконнекта «пристроила» к суперускорителю ещё одну стойку с собственным оборудованием. Microsoft же аналогично Meta✴ добавила ещё одну стойку с теплообменниками и вентиляторами.

27.08.2025 [09:25], Руслан Авдеев

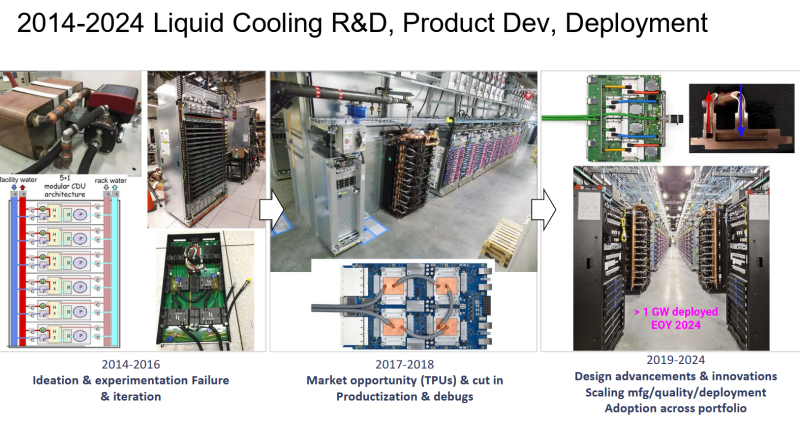

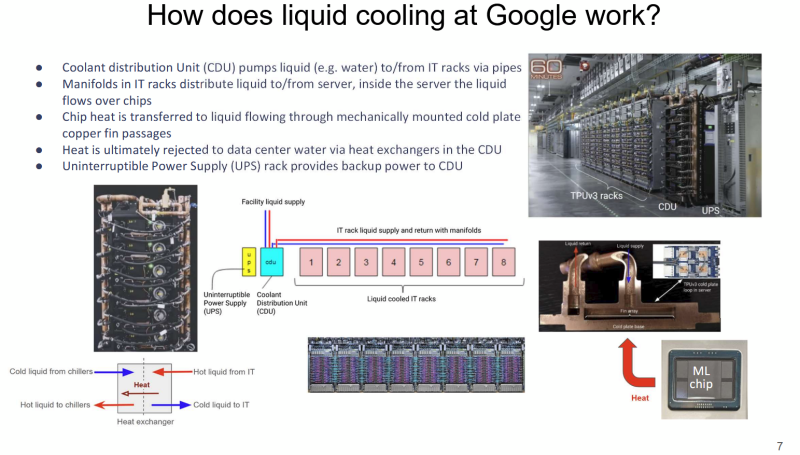

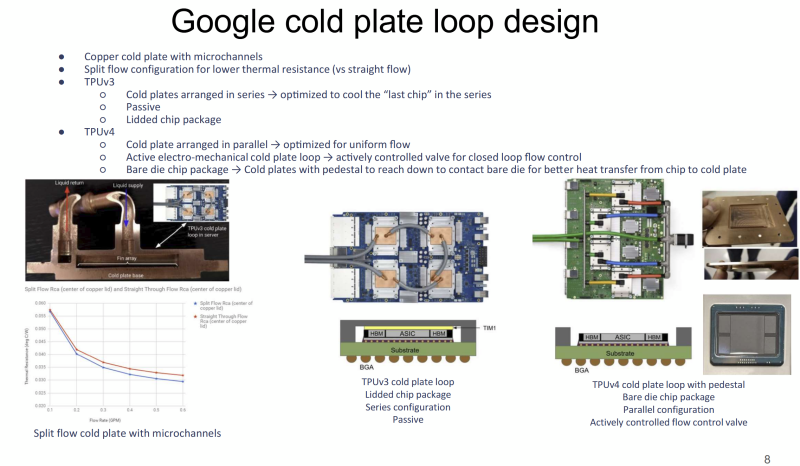

Большому ИИ — большую СЖО: Google рассказала о системе охлаждения TPUЖидкостное охлаждение (СЖО) в ЦОД применяется давно, хотя и не повсеместно. В последнее время оно играет всё более важную роль на фоне роста энергопотребления и тепловыделения ИИ-оборудования. Google рассказала об эволюции охлаждении на уровне дата-центров для своих ИИ-ускорителей TPU, сообщает Chips and Cheese. Google впервые оснастила свои TPU жидкостным охлаждением ещё в 2018 году после ряда экспериментов, и с тех пор совершенствует СЖО. Текущие решения предназначены именно для масштабов ЦОД. Так, стойки с шестью (5+1) блоками распределения жидкости (CDU) обслуживают до восьми стоек с TPU. Применяются гибкие шланги и быстроразъёмные соединения для удобства обслуживания. Во внутреннем контуре чипы в контуре соединены последовательно, что приводит к прогреву теплоносителя, поэтому расчёт охлаждающей мощности ведётся по самому горячему чипу в конце каждого контура. От CDU через теплообменники тепло передаётся в общую систему водоснабжения объекта без смешения жидкостей (в обоих контурах вода). По данным Google, энергопотребление насосов СЖО составляет менее 5 % от мощности вентиляторов, необходимых для воздушного охлаждения. Google применяет водоблок с разделённым потоком жидкости. Для охлаждения TPUv4 применялась система охлаждения открытого кристалла (bare-die). Способ не вполне безопасен, но с случае с TPUv4 такой подход необходим, поскольку такие ускорители потребляют в 1,6 раз больше энергии, чем TPUv3. Кроме того, компании пришлось поработать над проблемами протечек и появления микроорганизмов. Google тщательно проверяет компоненты на герметичность, использует специальные системы оповещения об утечках и проводит плановое обслуживание и фильтрацию. Дополнительно у компании есть набор протоколов реагирования на проблемы и оповещения, что позволяет оперативно устранять угрозы, которые в масштабах ЦОД могут быть весьма существенными. В мае сообщалось, что Google готовит мегаваттные стойки. Строго говоря, компания уже начала использовать 416 В AC на входе в стойки и DC-конвертеры, а также оснащать их встроенными ИБП. Кроме того, она динамически управляет энергопотреблением и производительностью как отдельных TPU, так и стоек в целом.

21.08.2025 [19:51], Руслан Авдеев

NVIDIA тормозит развитие погружных СЖО, но через пару лет ситуация может изменитьсяЭксперименты с иммерсионным охлаждением для мейнфреймов и суперкомпьютеров начали проводиться ещё в 1970-х годах прошлого века, но массовой технология так и не стала из-за высокой стоимости и сложности обслуживания. Примечательно, что сегодня, когда чипы становятся всё более горячими, главным препятствием на пути коммерческого внедрения иммерсионных технологий стала NVIDIA, передаёт ZDNet Korea со ссылкой на источники в индустрии. Возрождение интереса к технологии началось в конце 2000-х гг., когда всерьёз встала проблема повышения энергоэффективности дата-центров. С середины 2010-х крупные облачные компании вроде Microsoft, Google и Alibaba начали эксперименты с двухфазным иммерсионным охлаждением, однако рынок таких систем до сих пор находится в зачаточном состоянии. NVIDIA же «виновата» тем, что не сертифицирует подобные системы. Как заявил один из отраслевых инсайдеров, компания не даёт никаких гарантий при использовании иммерсионных систем со своими ускорителями, поскольку неизвестно, какие проблемы могут возникнуть в долгосрочной перспективе. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно и этого.

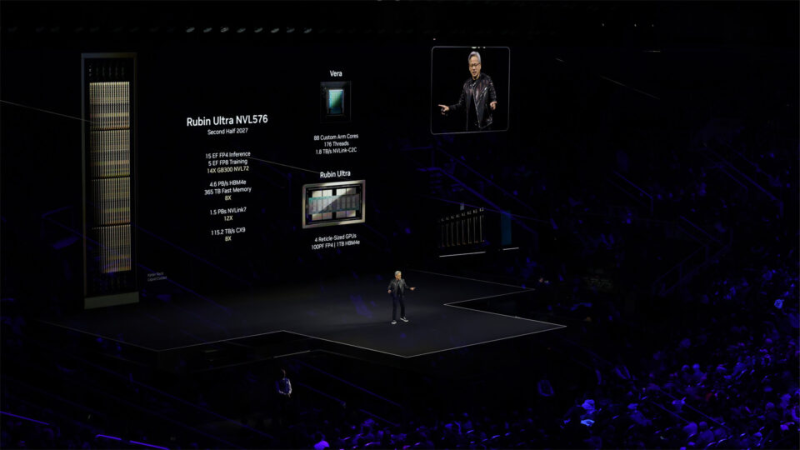

Источник изображения: NVIDIA Влияние на отсутствие повсеместного внедрения иммерсионного охлаждения, вероятно, оказали и экономические причины. Погружные СЖО требуют специальной инфраструктуры, поэтому внедрить их в уже действующие ЦОД с традиционным воздушным охлаждением трудно. При этом системы прямого жидкостного охлаждения (DLC) успешно сочетаются с воздушными системами на базе уже имеющейся инфраструктуры. Эксперты прогнозируют, что настоящий расцвет рынка иммерсионного охлаждения придётся на 2027–2028 гг. Ожидается, что оно будет активно распространяться после выхода ускорителей NVIDIA Rubin Ultra. Так, стойка Rubin Ultra NVL576 будет потреблять 600 кВт, а Google, OCP и Schneider Electric уже проектируют стойки мегаваттного класса. Следующее поколение чипов будет обладать настолько интенсивным тепловыделением, что охладить с помощью привычных СЖО уже не получится, говорит один из инсайдеров. По слухам, NVIDIA активно нанимает специалистов, связанных с иммерсионным охлаждением. Источники свидетельствуют, что в будущем у операторов ЦОД якобы просто не останется выбора. Однако Intel, ZutaCore, CoolIT, Accelsius и др. уже представили водоблоки для чипов с TDP от 1 кВт до 4,5 кВт, так что DLС ещё долго будут сохранять актуальность.

14.08.2025 [13:44], Руслан Авдеев

Apollo Global Management купит разработчика систем охлаждения Kelvion за €2 млрдПодразделение Apollo Global Management решило приобрести немецкого производителя охлаждающего оборудования Kelvion у фонда прямых инвестиций Triton. Последний сохранит за собой миноритарный пакет акций, сообщает Bloomberg. Как сообщили представители продавца, сделку предполагается закрыть в конце этого или в начале следующего года. По данным источников, Kelvion оценивается в €2 млрд ($2,3 млрд), включая долги. Ранее Kelvion была подразделением немецкой GEA Group AG, которое специализировалось на системах теплообмена. Компания также поставляет решения для захвата углерода и производства водорода, и иные промышленные решения. Triton приобрела бизнес в 2014 году за €1,3 млрд (включая долги). В 2019 году инвестиционный фонд Triton провёл реструктуризацию €600 млн облигаций Kelvion, вложив дополнительные средства, чтобы сохранить контроль над компанией.

Источник изображения: Kelvion Как сообщает Datacenter Dynamics, компания была основана в 1920 году и сегодня имеет собственные площадки на американских континентах, в регионе EMEA (Европа, Ближний Восток и Африка), а также в странах Азиатско-Тихоокеанского региона. Для дата-центров предлагаются системы фрикулинга, а также решения для жидкостного охлаждения. За последние пять лет Apollo направила около $58 млрд на климатические проекты и проекты энергоперехода. В июне компания договорилась помочь Electricite de France (EDF) привлечь до £4,5 млрд ($6,1 млрд) посредством частных размещений облигаций для финансирования строительства АЭС Hinkley Point C и других проектов в Великобритании. Также известны инвестиции в оператора ЦОД ToerPoint и производителя чипов Wolfspeed. В текущем месяце компания объявляла о намерении купить Stream Data Centers и даже ведёт переговоры с Meta✴, чтобы помочь той профинансировать недостроенные дата-центры.

14.08.2025 [09:34], Руслан Авдеев

Необычное гелиевое охлаждение для ИИ ЦОД пообещали создать Tidal NRG и Innov8 GasesЗанимающаяся дата-центрами и энергетикой компания Tidal NRG намерена создать гелиевую систему охлаждения для стоек ИИ-серверов. Уже подписано соглашение с Innov8 Gases — специалиста в газовой промышленности, который поможет разработать новый продукт, сообщает Datacenter Dynamics. Таким образом, Tidal заключила на долгий срок соглашение о закупке гелия, а также обеспечит миноритарные инвестиции в акционерный капитал нового партнёра. Как сообщают представители компаний, гелий имеет весомые эксплуатационные преимущества в сравнении с водой или воздухом благодаря высокой теплопроводности, низкой вязкости и инертности газа. Благодаря этому новая система обеспечит большую энергоэффективность в сравнении с конкурирующими решениями и долгосрочную устойчивость. По словам главы Tidal NRG, сотрудничество знаменует собой большой шаг вперёд в развитии устойчивой цифровой инфраструктуры. Он заявил, что гелий позволит повысить эффективность охлаждения, одновременно позволяя не идти на «экологические компромиссы», ставящие под угрозу масштабируемость ИИ-вычислений. Впрочем, всё это пока лишь анонсы.

Источник изображения: Tidal NRG Пока гелий не очень широко используется в качестве хладагента для ЦОД, хотя в последние 10 лет, например, производители HDD вроде Toshiba, Seagate или Western Digital применяют их в своих продуктах вместо воздуха для повышения их ёмкости и эффективности хранения. Tidal NRG представляет собой предприятие, ориентированное на строительство ЦОД гиперскейл-уровня для ИИ-задач и HPC. В июне компания объявила о партнёрстве с Texas Energy Group для совместного строительства дата-центров в Техасе. Подробности о том, когда и где намереваются строить эти дата-центры, есть ли у бизнеса земля под эти цели и кто будет оплачивать эти проекты, пока не разглашаются. На сайте Tidal тем временем утверждается, что компания имеет доступ к 1,5 ГВт электроэнергии.

08.08.2025 [10:05], Руслан Авдеев

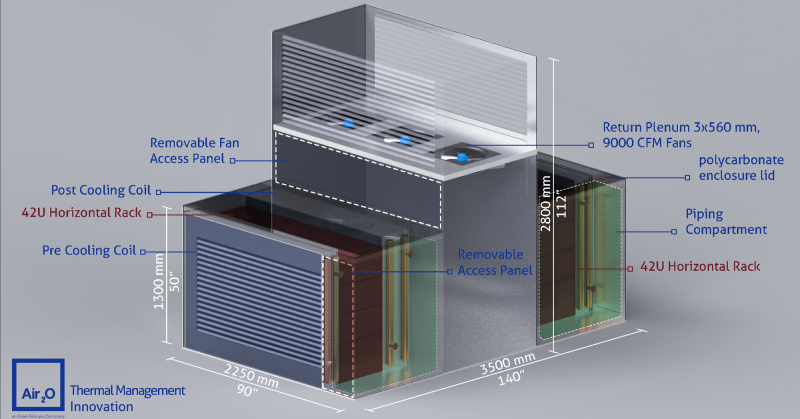

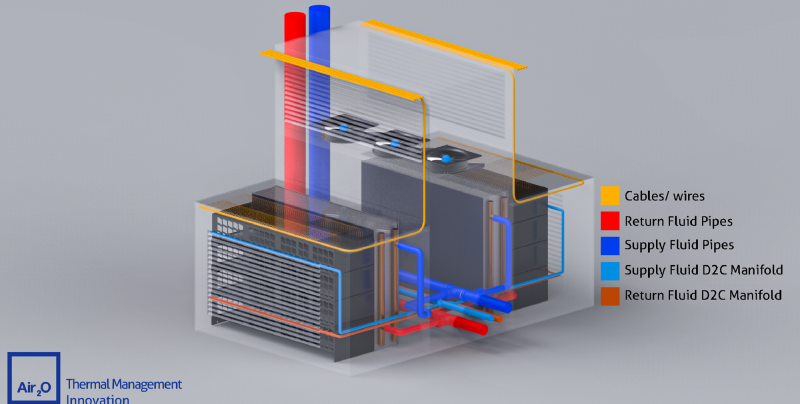

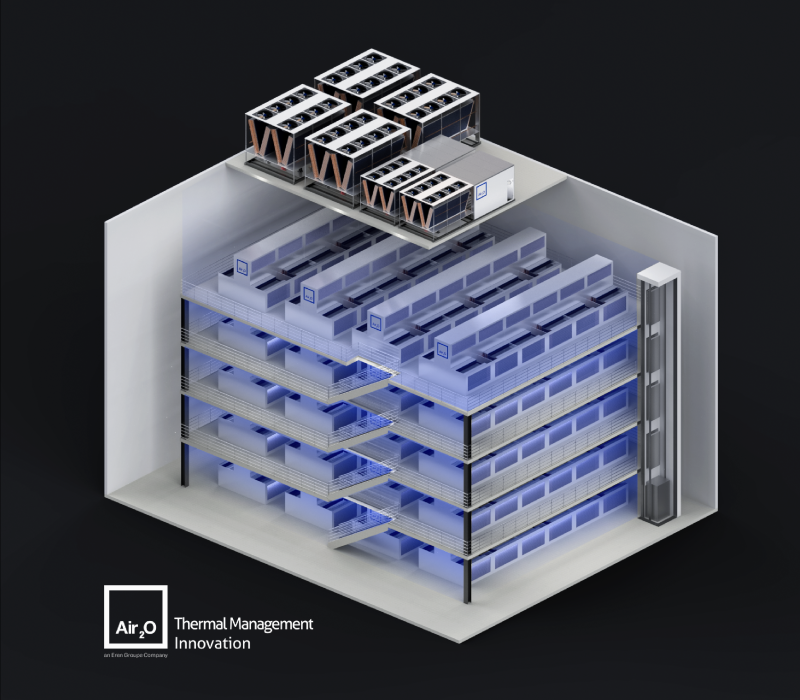

Масштабирование штабелированием: Air2O предложила высокоплотные модули с горизонтальными 42U-стойкамиРазработчик систем охлаждения Air2O предложил необычные модули High Thermal Density Air-Cooled Rack Assembly с двумя горизонтально расположенными 42U-стойками, которые, по словам компании, позволят заметно увеличить плотность размещения вычислительных мощностей, сообщает Datacenter Dynamics. К стойкам с двух сторон прилегают теплообменники, а между стойками находится воздушный коридор с собственными вытяжными вентиляторами высотой 2,8 м. Таким образом, воздух охлаждается до попадания в стойку и после выхода из него, что, по словам, Air2O, упрощает его повторное использование. По данным компании, новые модули обеспечивают энергетическую плотность до 320 кВт при фрикулинге и до 600 кВт при прямом жидкостном охлаждении. В версии с СЖО место одного из теплообменников занимает CDU. Масштабировать модули предполагается путём штабелирования. Air2O заявляет, что способна разместить до 120 соответствующих модулей общей мощностью до 40 МВт в помещении 16 × 25 × 20 м (400 м2), тогда как традиционный ЦОД такой же мощности может занимать более 25 тыс. м2. Каким образом предполагается обслуживать оборудование в таких стойках, компания, к сожалению, не уточняет. Также нет данных, построила ли компания хоть один такой модуль. По словам компании, стандартные 19″ стойки, разработанные AT&T более ста лет назад и используемые в большинстве дата-центров, устарели и никогда не предназначались для оборудования с высокой плотностью тепловой энергии. Подчёркивается, что оборудование современных ЦОД не должно выглядеть, как оснащение телефонной станции столетней давности. Со стойками экспериментируют не только специализированные компании, но и гиперскейлеры. Например, в конце 2024 года Microsoft и Meta✴ представили дизайн ИИ-стойки с раздельными шкафами для питания и IT-оборудования, а в мае 2025 года Google показала мегаваттные стойки с питанием 400 В и СЖО для ИИ-платформ будущего. А NVIDIA предлагает перейти уже к 800 В.

07.08.2025 [15:44], Сергей Карасёв

Стартап YPlasma придумал систему плазменного охлаждения серверовИспанский стартап YPlasma, по сообщению Datacenter Dynamics, провёл инвестиционный раунд на сумму $2,5 млн. Средства будут направлены на разработку технологии безвентиляторного плазменного охлаждения серверного оборудования. Фирма YPlasma отделилась от Национального института аэрокосмических технологий Испании (INTA) в 2024 году. Компания занимается разработкой новой системы воздушного охлаждения, основанной на использовании электростатических полей для формирования воздушного потока. При этом благодаря отсутствию традиционных вентиляторов может быть повышена энергетическая эффективность и улучшена надёжность, говорят разработчики. Технология YPlasma предполагает применение плазменных актуаторов с диэлектрическим барьерным разрядом (Dielectric Barrier Discharge, DBD), которые генерируют ионный ветер. Конструкция включает два тонких медных электрода, один из которых окружён диэлектрическим материалом, таким как тефлон. При подаче высокого напряжения воздух вокруг актуатора ионизируется, создавая плазму непосредственно над поверхностью диэлектрика. Благодаря этому формируется управляемый ламинарный поток заряженных частиц — так называемый ионный ветер, который можно использовать для обдува электронных компонентов. Направление и скорость потока контролируются путём изменения напряжения, проходящего через электроды. Толщина актуаторов составляет всего 2–4 мм, тогда как скорость ионного ветра может достигать 10 м/с. Утверждается, что предложенное решение по эффективности отвода тепла сравнимо с небольшими вентиляторами. У системы отсутствуют подвижные части: это позволяет экономить место внутри корпуса устройств и способствует устранению вибраций, что потенциально может продлить срок службы оборудования. В программе финансирования YPlasma приняли участие венчурный фонд Faber и международная венчурная компания SOSV. Предыдущий инвестиционный раунд был проведён в 2024 году: тогда стартап получил $1,2 млн от SOSV/HAX, Esade Ban и др. |

|