Материалы по тегу: охлаждение

|

24.07.2025 [09:24], Руслан Авдеев

«Атомное» охлаждение: Vertiv и Oklo создают комплексную систему питания и охлаждения ЦОД на базе малых модульных реакторовСтартап Oklo, поддерживаемый главой OpenAI Сэмом Альтманом (Sam Altman), объявил о партнёрстве с компанией Vertiv для разработки передовой технологии управления электропитанием и охлаждением для гиперскейлеров и колокейшн-ЦОД, сообщает Datacenter Knowledge. Компании совместно разработают интегрированную систему электропитания и охлаждения дата-центров, применяющую малые модульные реакторы Oklo и передовые системы управления электропитанием Vertiv. Партнёры объявили, что это обеспечит надёжное выполнение ресурсоёмких задач HPC и ИИ с попутным снижением негативного воздействие на окружающую среду. Система будет использовать пар и электричество, вырабатываемые SMR Oklo. Демонстрация технологии планируется на первом объекте Oklo Aurora Powerhouse в Национальной лаборатории Айдахо. Речь идёт о полноценном коммерческом реакторе, который начнёт вырабатывать электричество к концу 2027 или началу 2028 гг.

Источник изображения: Oklo Компании объявили, что намерены создать комплексные эталонные проекты для дата-центров, желающих интегрировать новую систему охлаждения. Используя тепло реакторов Oklo для питания систем охлаждения Vertiv, можно будет значительно повысить энергоэффективность дата-центров. Партнёры заявили, что разрабатывают концепцию, позволяющую использовать проверенные общедоступные готовые компоненты без внесения существенных изменений в базовую инфраструктуру. Представитель компании сообщил журналистам, что ядерные технологии обеспечивают «чистое», надёжное и предсказуемое электропитание. Компания подчеркивает, что атомные электростанции обладают самым высоким коэффициентом использования установленной мощности (92 %), что значительно выше, чем у геотермальной (74 %) и ветровой (35 %) энергетики, что делает ядерную энергию ключевым решением для стабильного энергоснабжения. К текущему моменту компания заключила предварительные договоры на поставку 14 ГВт.

14.07.2025 [16:29], Руслан Авдеев

Горячая пора: изменение климата угрожает стабильности работы дата-центровСотня ведущих мировых хабов ЦОД может пострадать от глобального потепления, поскольку растущие требования к охлаждению увеличивают стоимость эксплуатации и потребление воды. Более того, отключения оборудования из-за перегрева будут происходить всё чаще, сообщает The Register со ссылкой на данные Verisk Maplecroft. Компания, занимающаяся анализом рисков, способных повлиять на мировые бизнесы и инвесторов, выпустила доклад, посвящённый проблеме возможного перегрева ЦОД в будущем. Дело в том, что значительные части Европы страдают от рекордной жары. Впрочем, выводы касаются в первую очередь конца десятилетия и более позднего периода. Компания отмечает, что ЦОД обычно комплектуются резервными источниками питания вроде генераторов для обеспечения энергией в случае отключения магистральных линий электропередачи. При этом водоснабжение и энергоэффективность регулярно повышаются. Тем не менее, эксперты пришли к выводу, что надёжность многих дата-центров может оказаться под вопросом в период температурных скачков и роста спроса на ИИ-сервисы, хранилища данных и облачные вычисления.

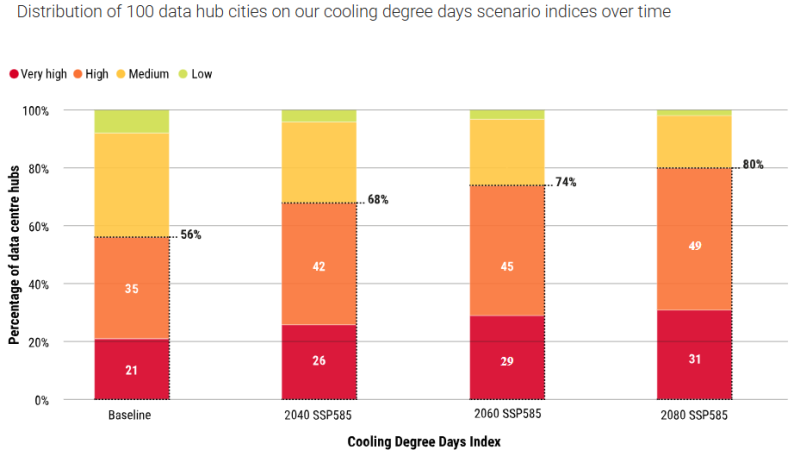

Источник изображения: Maplecroft В Maplecroft утверждают, что для 56 из 100 ведущих хабов ЦОД характерен «высокий» или «очень высокий» риск по индексу Cooling Degree Days (CDD), который отражает частоту и интенсивность превышения температурных порогов, требующих активного охлаждения строений. При наихудшем сценарии SSP585 от CMIP6, предполагающем высокие выбросы парниковых газов, проблемы коснутся 68 хабов к 2040 году, и до 80 — к 2080 году. В любом случае, ¾ мировых ЦОД будут требовать всё большего охлаждения на более длительные сроки каждый год, в результате это приведёт к повышению затрат воды и электроэнергии. 100 ключевых хабов ЦОД в 2030–2080 гг. столкнутся с увеличением на 83 % количества дней, когда будет требоваться активное охлаждение. Maplecroft также отмечает, что спрос на электроэнергию со стороны дата-центров уже становится проблемой в некоторых странах и регионах мира вроде США, Ирландии и Сингапура. Кроме того, средний дата-центр, по данным исследования, использует около 1,4 тыс. м3 воды в день, и расход будет только расти по мере роста температур. Прогнозируется, что 52 % крупнейших хаба ЦОД к 2030 году будут в зонах с ограниченным доступом к питьевой воде, поэтому её нехватка может стать серьёзной косвенной угрозой для компаний, пользующихся такими дата-центрами.

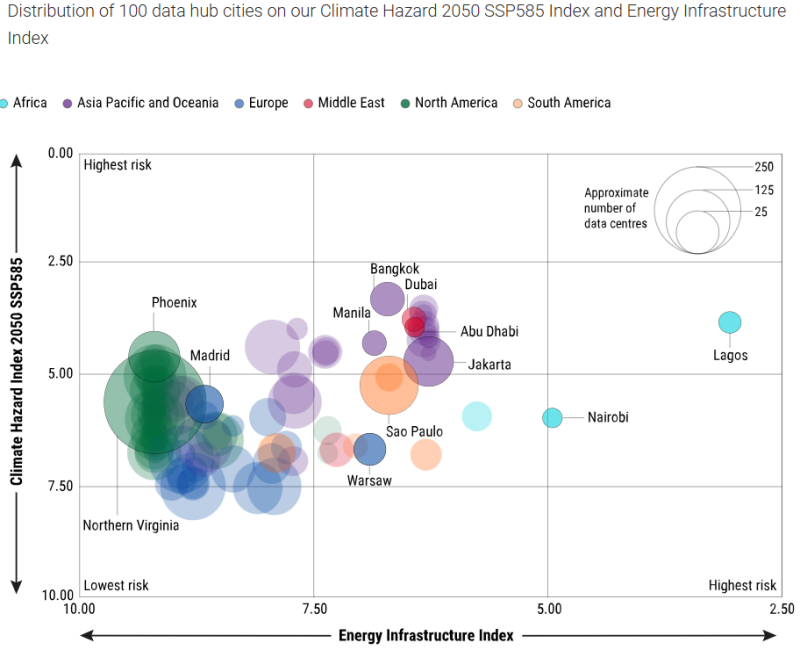

Источник изображения: Maplecroft На ЦОД, по данным Международного энергетического агентства (IEA), уже приходится около 1,5 % мирового спроса на электричество, но к 2030 году этот показатель, вероятно, вырастет вдвое, до 3 %. 40 % этой энергии, по словам Maplecroft сегодня, тратится системами охлаждения, но и этот показатель должен вырасти по мере развития глобального потепления. В целом, в будущем меняющийся климат будет всё больше влиять на стареющие сети энергоснабжения и дата-центры, даже находящиеся на рынках с «низким» уровнем риска. Прогнозирование того, где именно такие риски будут максимальными — стратегическая проблема для всех мировых организаций, выступающих операторами или пользователями ЦОД. Как заявляют в Maplecroft, дата-центры теперь формируют «цифровой костяк» бизнеса, поэтому необходимо понимать и предвидеть все риски, способные повлиять на надёжность работы оборудования. Это особенно важно в свете инициатив, продвигаемых на высшем государственном уровне. Так, в июне сообщалось, что Евросоюз ограничит использование воды дата-центрами в рамках плана по повышению устойчивости всего блока к засухам и улучшению качества воды.

21.06.2025 [08:41], Руслан Авдеев

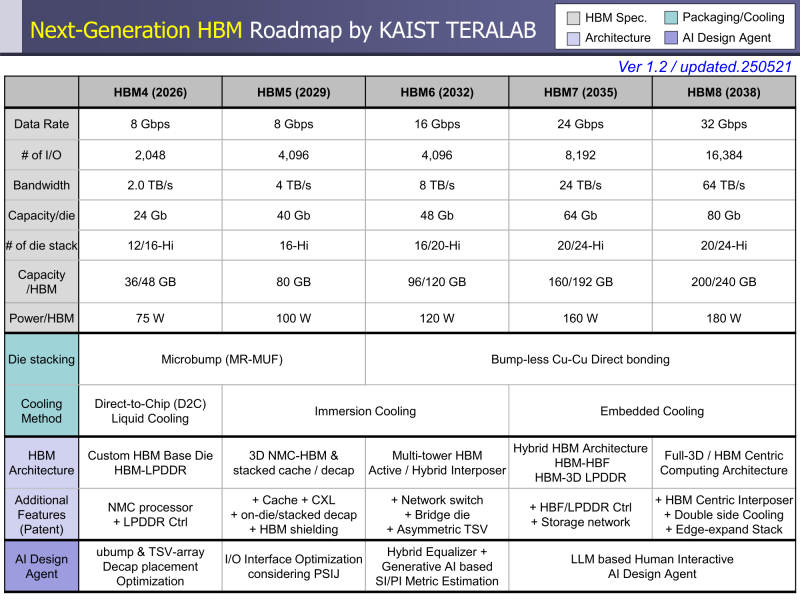

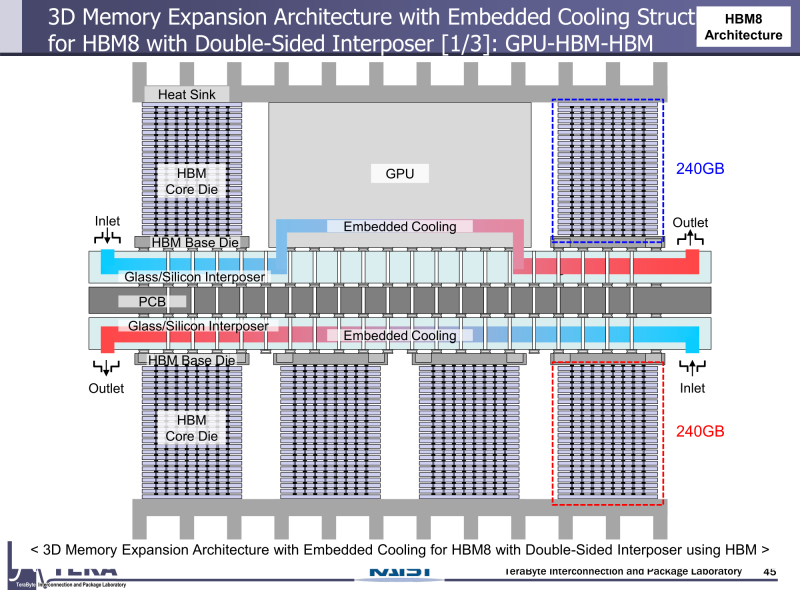

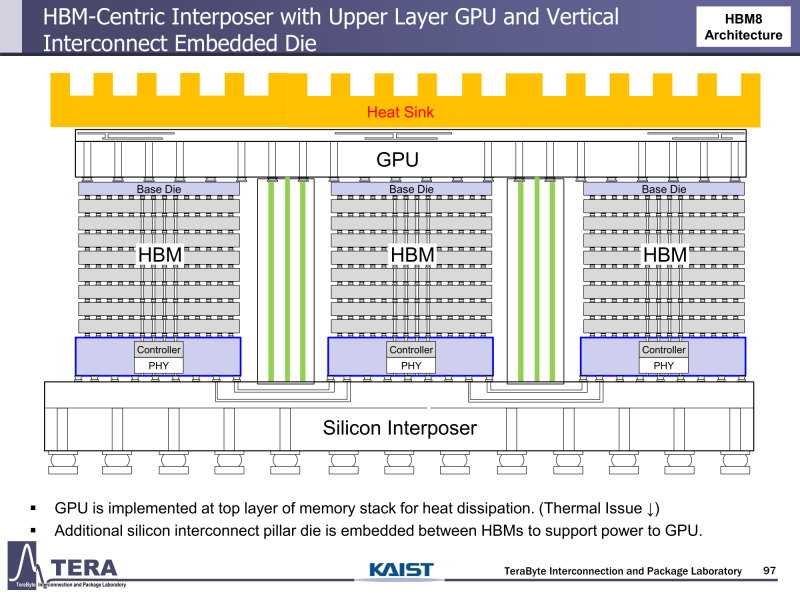

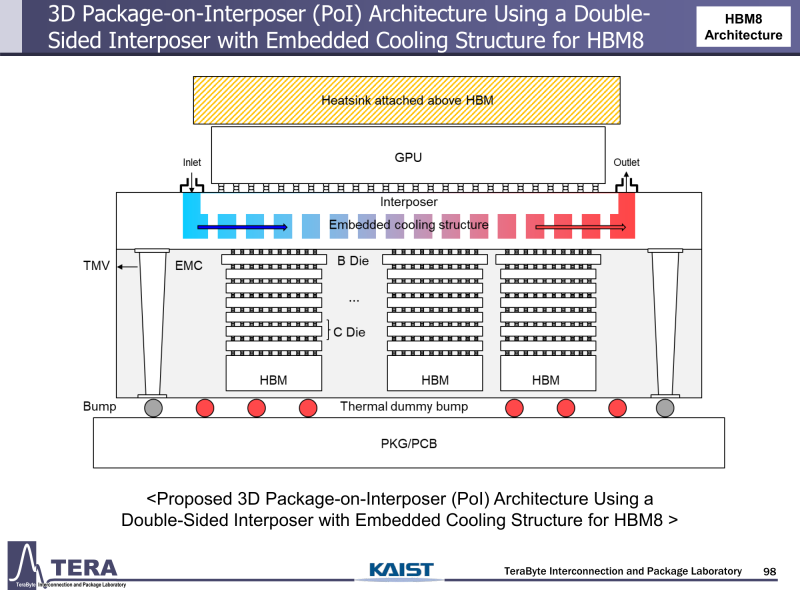

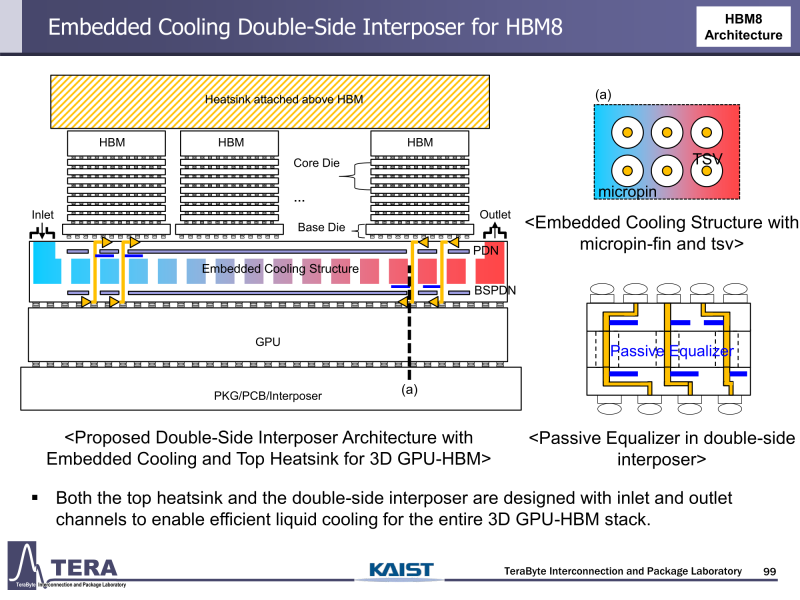

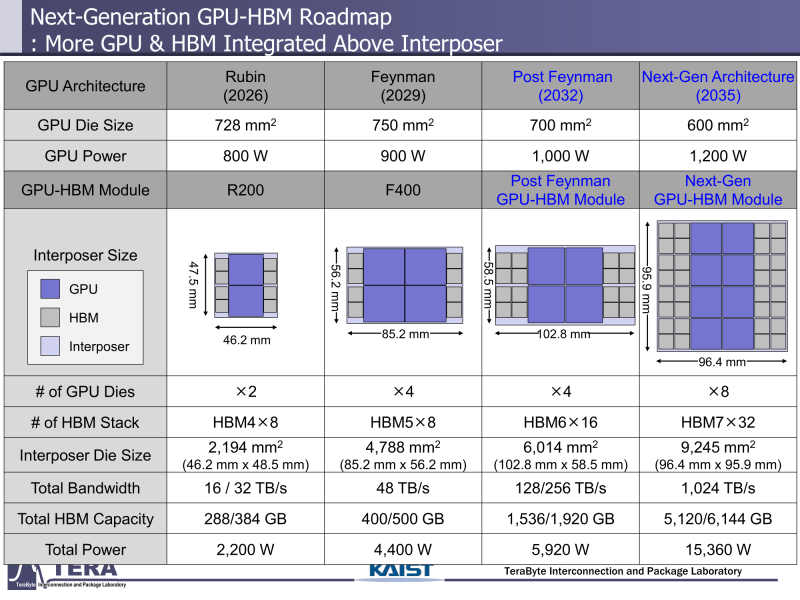

Через 10 лет ИИ-ускорители получат терабайты HBM и будут потреблять 15 кВт — это изменит подход к проектированию, питанию и охлаждению ЦОДИИ-чипы нового поколения не просто будут быстрее — они станут потреблять беспрецедентно много энергии и потребуют кардинально изменить инфраструктуру ЦОД. По данным учёных, к 2035 году энергопотребление ИИ-ускорителей может вырасти до порядка 15 кВт, из-за чего окажется под вопросом способность инфраструктуры современных ЦОД обслуживать их, сообщает Network World. Исследователи лаборатории TeraByte Interconnection and Package Laboratory (TeraLab), подведомственной Корейскому институту передовых технологий (KAIST), подсчитали, что переход к HBM4 состоится в 2026 году, а к 2038 году появится уже HBM8. Каждый этап развития обеспечит повышение производительности, но вместе с ней вырастут и требования к питанию и охлаждению. В лаборатории полагают, что мощность только одного GPU вырастет с 800 Вт до 1200 Вт к 2035 году. В сочетании с 32 стеками HBM, каждый из которых будет потреблять 180 Вт, общая мощность может увеличиться до 15 360 Вт (в таблице ниже дан расчёт для стеков HBM8, а не HBM7 — прим. ред.). Ожидается, что отдельные модули HBM8 обеспечат ёмкость до 240 Гбайт и пропускную способность памяти до 64 Тбайт/с. В рамках ускорителя можно суммарно получить порядка 5–6 Тбайт HBM с ПСП до 1 Пбайт/с. Это приведёт к изменению конструкции самого ускорителя. Ключевым элементом становятся стеки HBM — процессоры, контроллеры и ускорители будут интегрированы в единую подложку с HBM-модулями. Возможен переход к 3D-упаковке с использованием двусторонних интерпозеров-подложек или даже нескольких интерпозеров на разных «этажах» кристаллов.

Источник изображений: KAIST Кроме того, для ускорителей придётся разработать и новые системы охлаждения. К уже традиционным прямому жидкостному охлаждению (DLC) и погружным СЖО, вероятно, придётся добавить системы теплоотвода, интегрированные непосредственно в корпуса чипов. Также будут использоваться «жидкостные сквозные соединения» (F-TSVs) для отвода тепла из многослойных чипов, «бесстыковые» соединения Cu–Cu, термодатчики в кристаллах и интеллектуальные системы управления, позволяющие чипам адаптироваться к температурным изменениям. На уровне ЦОД изменится и контур охлаждения, и температурное зонирование всего объекта. В KAIST подчёркивают, что высокую плотность размещения мощностей объекты в большинстве регионов попросту не смогут поддерживать. Пока гиперскейлеры резервируют гигаватты на десятилетия вперёд, региональным коммунальным службам потребуется 7–15 лет на модернизацию ЛЭП. А где-то этого может и не произойти. Так, в Дублине (Ирландия) по-прежнему действует мораторий на строительство новых ЦОД, во Франкфурте-на-Майне похожий запрет действует до 2030 года, а в Сингапуре сегодня доступно всего лишь 7,2 МВт. Как считают эксперты, электричество превратилось из одной из статей расходов в определяющий фактор — от его доступности будет зависеть сама возможность реализации ИИ-проектов. На электричество приходится 40-60 % операционных расходов в современной инфраструктуре ИИ, облачной и локальной. Как отмечают в TechInsights, один 15-кВт ускоритель при круглосуточной работе может «съедать» энергии на $20 тыс./год, и это без учёта стоимости охлаждения. Компании уже вынуждены пересматривать стратегии развёртывания инфраструктуры, учитывая соответствие регуляторным требованиям, региональные тарифы на электроэнергию и др. Гиперскейлеры получают дополнительное преимущество благодаря более низкому PUE, доступу к возобновляемой энергии и оптимизированным схемам закупки энергии. В новой реальности производительность измеряется не только в долларах или флопсах, но и киловаттах. Более того, меняется география рынка ЦОД. Богатые энергией регионы вроде США, Скандинавии или стран Персидского залива привлекают всё больше инвестиций для строительства дата-центров, а регионы со слабыми энергосистемами рискуют превратиться в «ИИ-пустыни», в которых масштабировать мощности невозможно. Строителям ИИ-инфраструктуры теперь придётся уделять очень много внимания вопросам энергетики: расходами на электричество, наличие источников энергии, прозрачностью выбросов, близостью ЦОД к электросетям и др. Буквально на днях американский регулятор NERC, отвечающий за надзор за электросетями и сопутствующей инфраструктурой в США, заявил, что подключение к сетям ЦОД в настоящее время весьма рискованно из-за непредсказуемости ЦОД.

16.06.2025 [17:59], Руслан Авдеев

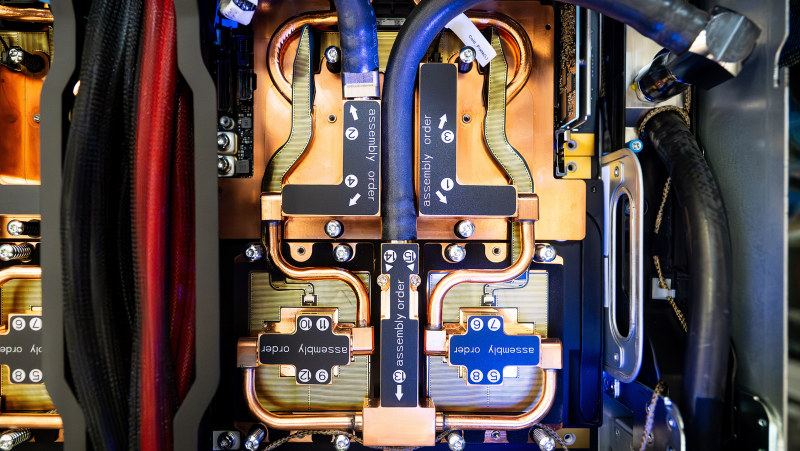

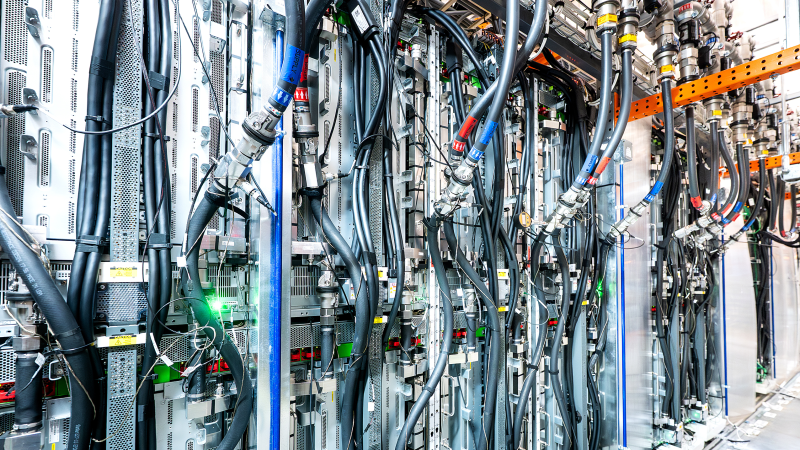

AWS с нуля разработала и начала выпуск собственной СЖО для ИИ ЦОД всего за 11 месяцевAmazon Web Services (AWS) разработала и ввела в эксплуатацию собственную систему жидкостного охлаждения для дата-центров за 11 месяцев — этой быстрый ответ на стремительно растущие запросы всё более мощных ИИ-ускорителей, сообщает пресс-служба компании. Именно охлаждение сегодня переживает революцию: индустрия ЦОД массово переходит с воздушного охлаждения на СЖО, говорит компания. При этом в компании подчёркивают, что цель — не создавать «комфортные» для чипов условия на уровне 20 °C, а защита серверов от перегрева при минимально расходе как воды, так и энергии. Современные ИИ-чипы выделяют очень много тепла, но для повышения производительности их приходится размещать максимально близко друг к другу. В этом случае поток воздуха должен быть столь интенсивным, что классическую схему фрикулинга применять просто неэффективно и дорого. В AWS утверждают, что индустрия миновала порог, после которого использование СЖО выгоднее для теплоотвода. Команда AWS изучила уже имеющиеся на рынке продукты, после чего решила разработать собственный вариант. Было выбрано прямое охлаждение чипов (DLC) — водоблок монтируется непосредственно на ускоритель, через него циркулирует теплоноситель с температурой на уровне «джакузи», отводя тепло к специальной системе для сброса тепла. Цикл замкнутый, т.ч. жидкость циркулирует многократно, не увеличивая расхода воды дата-центром. От формирования концепции до создания готового прототипа прошло четыре месяца. За 11 месяцев AWS завершила проектирование, отрегулировала цепочки поставок, разработала ПО для управления системой, протестировала её и запустила в производство. Важнейшим элементом является собственный модуль распределения жидкости (CDU), который в компании оценивают, как более производительный и экономичный, чем имеющиеся на рынке готовые решения. В AWS подчёркивают, что он сконструирован специально под задачи гиперскейлера, благодаря чему снизились затраты и увеличилась эффективность работ. Первую систему испытали в исследовательском центре AWS, а позже установили в действующем ЦОД. Летом 2025 года должно начаться масштабное внедрение системы — её будут монтировать всё в большем количестве дата-центров компании, с учётом современных потребностей ресурсоёмкой вычислительной инфраструктуры. Ещё в конце 2024 года сообщалось, что Amazon представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную. В частности сообщалось, что новые решения связаны с электропитанием и охлаждением — СЖО предполагалось монтировать даже на уже действующих площадках IT-гиганта. Примечательно, что новые ускорители Tranium 3 действительно требуют эффективных систем охлаждения — их энергопотребление может достигать 1000 Вт.

06.06.2025 [10:19], Руслан Авдеев

Castrol запустила сервис управления оборотом жидкостей для охлаждения дата-центровCastrol представила сервис управления оборотом жидкостей для систсем жидкостного охлаждения (СЖО) дата-центров. Это должно помочь операторам ЦОД в переходе с воздушных систем на жидкостные — последние всё более востребованы при использовании высокоплотных серверных стоек, сообщает Datacenter Dynamics. Принадлежащая BP компания Castrol заявляет, что новый сервис охватывает все четыре фазы жизненного цикла работы СЖО, включая запуск системы, текущее обслуживание, устранение неисправностей, утилизацию жидкостей. Предполагается, что это поможет преодолеть барьеры на пути внедрения СЖО в дата-центрах. В Castrol отмечают, что операторы уже осознали преимущества жидкостного охлаждения, но им нужны гарантии долгосрочной сервисной поддержки. Тем временем Castrol десятилетиями осуществляет её в других сферах, например — в автоиндустрии. Теперь этот опыт будет использован и для обслуживания дата-центров. Новая услуга будет оказываться с помощью партнёрской сети Castrol с привлечением сторонних компаний. Цель — избавиться от «операционной и технической неопределённости», замедлившей внедрение жидкостных систем. Утверждается, что в СЖО охлаждающая жидкость является единственной «точкой отказа» и ухудшение условий эксплуатации снижает эффективность работы оборудования и может привести к его поломке. Тем временем «структурированный» подход Castrol обеспечивает поддержку на каждом этапе. Ранее компания разработала линейку охлаждающих жидкостей для СЖО, включая ON Direct Liquid Cooling PG 25, представленную в декабре 2024 года. В том же году компания ввела в эксплуатацию модульный ЦОД в Оксфордшире (Oxfordshire) на площадке собственного исследовательского центра для тестирования и демонстрации собственных решений. Активно занимаются разработкой технологий и решений для СЖО и другие компании из нефтегазовой и смежных отраслей: Shell, SK Enmove, ExxonMobil, Perstorp, Gulf Oil.

05.06.2025 [11:59], Руслан Авдеев

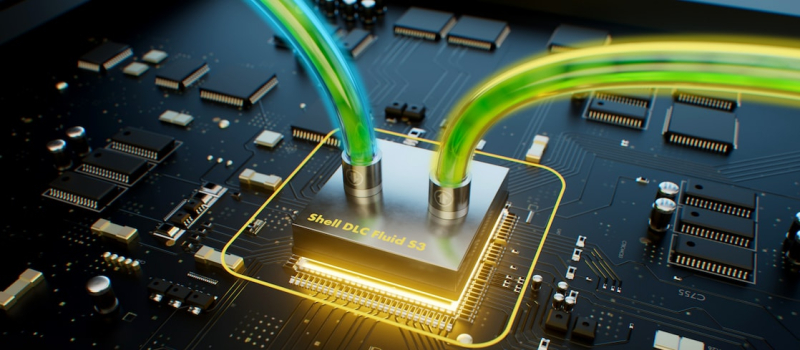

Shell представила свою первую жидкость для DLC СЖОНефтегазовая корпорация Shell представила первую охлаждающую жидкость для серверных систем с прямым жидкостным охлаждением (DLC). В компании заявляют, что жидкость Shell DLC Fluid S3 разработана для ЦОД, предназначенных для ИИ- и HPC-задач, сообщает Datacenter Dynamics. За основу жидкости взят пропиленгликоль, предполагается, что она дополнит существующую линейку продуктов Shell, предназначенных для систем иммерсионного охлаждения, которые она продаёт уже несколько лет. Как заявляют в Shell, вариант S3 разработан для долговременной защиты от коррозии DLC-систем. Жидкость совместима с самыми разными материалами и способна прослужить более шести лет — на четыре года дольше, чем варианты конкурентов на основе неорганических кислот. Сообщается, что жидкость соответствует спецификациям Open Compute Project PG25, в том числе — в части, касающейся стандартов совместимости материалов. Обеспечивается защита от замерзания при температурах до -10 °C.

Источник изображения: Shell По словам Shell Lubricants, растущий ассортимент не только позволяет удовлетворить самые разные потребности современных ЦОД сегодня и в будущем — проект подкрепляется мощью глобальной сети Shell, с её цепочками поставок и пятью центрами разработки по всему миру. Прочие нефтяные компании и их «дочки», включая Castrol, ExxonMobil, Perstorp, Gulf Oil и SK Enmove, также представили охлаждающие жидкости для дата-центров. Более того, собственные продукты предлагает американский пищевой гигант Cargill и производитель химикатов — компания Chemours. Не так давно появилась информация, что ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев.

01.06.2025 [14:33], Сергей Карасёв

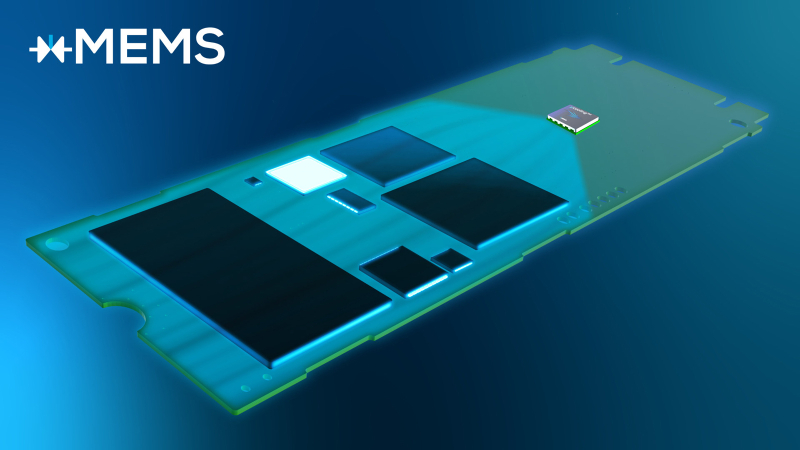

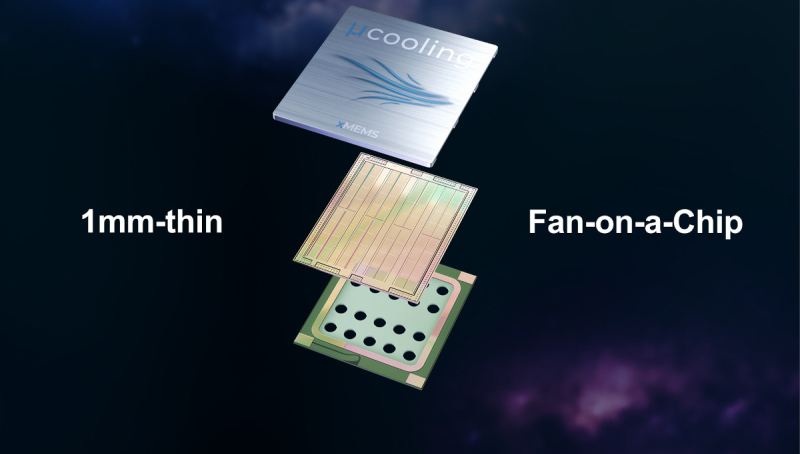

xMEMS готовит ультразвуковые кулеры µCooling для E3.S и M.2 SSDКомпания xMEMS Labs, по сообщению ресурса CNX Software, начала поставки образцов твердотельных кулеров µCooling для серверных и клиентских SSD. Представленные изделия используют технологию piezoMEMS на основе микроэлектромеханических систем (MEMS). xMEMS ранее уже анонсировала решения семейства µCooling, включая охладители для DSP в составе оптических трансиверов. Напомним, принцип работы piezoMEMS базируется на обратном пьезоэлектрическом эффекте: при подаче напряжения крошечные кремниевые структуры начинают колебаться на ультразвуковых частотах, в результате чего формируется поток воздуха для отвода тепла от определённых компонентов. В случае µCooling для SSD охлаждающий модуль будет размещаться в определенном месте на печатной плате накопителя — а не на контроллере или чипах флеш-памяти. xMEMS готовит изделия для SSD в форм-факторах E3.S и М.2. Устройства первого из этих типов обычно имеют TDP на уровне 9,5 Вт или выше. Моделирование показало, что применение µCooling обеспечивает отвод 3 Вт, снижение средней температуры более чем на 18 % и уменьшение термического сопротивления более чем на 25 %. В случае решений М.2 достигается падение средней температуры более чем на 20 % и сокращение термического сопротивления примерно на 30 %. В целом, благодаря µCooling повышаются надёжность и стабильность работы накопителей при высоких нагрузках, например, во время ИИ-инференса. Размеры охлаждающего модуля составляют 9,3 × 7,6 × 1,13 мм. При необходимости могут быть задействованы несколько таких блоков для повышения эффективности отвода тепла. Благодаря отсутствию подвижных частей достигается долговечность и сокращаются расходы на обслуживание. Кроме того, твердотельный кулер не производит шума при работе. Массовое производство запланировано на I квартал 2026 года.

21.05.2025 [12:57], Руслан Авдеев

ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев

hpc

microsoft

microsoft azure

software

ии

ии-агент

квантовые вычисления

погружное охлаждение

разработка

сжо

химия

Компания Microsoft запустила для корпоративных пользователей в тестовом режиме ИИ-платформу Microsoft Discovery, использующую ИИ-агентов и HPC для помощи учёным, которым не придётся самостоятельно писать код для своих исследований. Потенциал системы продемонстрировали на примере самой Microsoft — ИИ помог создать новейшую жидкость для погружного охлаждения всего за 200 часов вместо нескольких месяцев или даже лет, сообщает VentureBeat. Microsoft Discovery использовали для поиска охлаждающей жидкости без «вечных» PFAS-химикатов, часто применяемых в иммерсионных СЖО. Регуляторы во всём мире всё чаще запрещают производство и использование этого класса вещества. ИИ Microsoft проверил 367 тыс. веществ-кандидатов, после чего химикат синтезировал один из партнёров компании. Однако сфера применения такого ИИ простирается далеко за пределы создания охлаждающих жидкостей — новые материалы и химикаты требуются в самых разных сферах, но на их поиск часто уходят годы. Microsoft Discovery позволяет взаимодействовать с «невероятными возможностями» ИИ, используя естественный язык, что полностью меняет весь процесс исследований, говорит компания. Обычно учёным приходилось изучать программирование для того, чтобы создавать вычислительные инструменты. Такая демократизация науки сыграет на руку малым исследовательским группам, у которых нет ресурсов на изучение программирования или привлечения сторонних специалистов в этой сфере. Более того, со временем платформа научится работать и с квантовыми компьютерами, написание кода для которых — ещё более сложная задача.

Источник изображения: National Cancer Institute/unsplash.com Работа выполняется с помощью специальных ИИ-агентов, специально обученных для выполнения отдельных научных задач — от написания литературного обзора до создания компьютерной симуляции. По словам Microsoft, ИИ-агенты — это чуть ли не целая команда учёных с докторскими степенями в различных науках. Платформа интегрирует друг с другом базовые модели, занимающиеся общим планированием, и модели, специализирующиеся на физике, химии или, например, биологии. Также Microsoft Discovery позволяет комбинировать закрытые исследовательские данные и результаты уже опубликованных научных исследований по разным дисциплинам, сохраняя прозрачность моделей и контролируя процесс «рассуждений». Для работы с платформой используется интерфейс Copilot, который занимается оркестрацией агентов. Одновременно интерфейс служит и центральным хабом, в котором учёные управляют своей виртуальной ИИ-командой.

Источник изображения: National Cancer Institute/unsplash.com В платформу встроены защитные механизмы — системе заданы «этические координаты». Также применяется модерация контента с проактивным подходом к выявлению злоупотреблений возможностями платформы — маркируются потенциально вредоносные алгоритмы и действия, поскольку все ИИ-инструменты фактически имеют «двойное назначение». С их помощью можно изобретать не только лекарства, но и опасные биологически опасные субстанции. Для своей платформы Microsoft выстраивает экосистему с участием представителей самых разных отраслей, от фармацевтики (GSK) до индустрии красоты (Estée Lauder). NVIDIA интегрирует с Discover микросервисы ALCHEMI и BioNeMo NIM для биотехнологий и фармацевтики. В полупроводниковой сфере Microsoft планирует интеграцию решений Synopsys для ускорения разработки чипов. Адаптацией под конкретные отраслевые задачи, развёртыванием и масштабированием платформы займутся Accenture и Capgemini.

Источник изображения: Microsoft Успех Microsoft Discovery будет зависеть от того, насколько эффективно систему смогут интегрировать в текущие научные процессы — многие учёные скептически относятся к новым методикам, так что компании придётся показать всё, на что способен ИИ. По словам Microsoft, будущее науки именно за сочетанием умственных возможностей человека и масштабного ИИ. Microsoft уже провела предварительную демонстрацию Discovery для ограниченного круга структур. Цены на платформу пока не названы, но доступ к к ней будет организован посредством Azure.

15.05.2025 [15:40], Руслан Авдеев

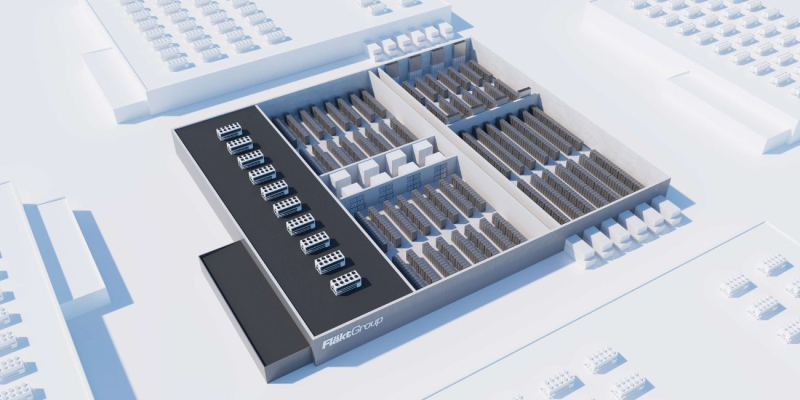

Samsung купила за €1,5 млрд поставщика систем охлаждения для ЦОД и предприятий FläktGroupSamsung Electronics приобрела за €1,5 млрд ($1,69 млрд) поставщика HVAC-систем FläktGroup. Последняя поставляет оборудования для охлаждения и CDU-модули для дата-центров и крупных промышленных площадок, сообщает Datacenter Dynamics. Пока компания принадлежит инвестиционным фондам под эгидой европейской компании Triton. Ожидается, что сделку закроют до конца года. FläktGroup основана в октябре 2016 года в результате слияния DencoHappel, ранее входившей в принадлежащую Triton группу специалистов по теплообменным решениям Galapagos, и разработчика систем охлаждения FläktWoods. После слияния FläktGroup расширила своё портфолио и вышла на рынки ЦОД, крупных производственных комплексов и фармацевтических компаний. В число клиентов FläktGroup, судя по данным на официальном сайте, входят дата-центры по всей Великобритании и даже штаб-квартира Microsoft в Дублине. По словам Triton, работать с компанией и её руководством было одновременно удовольствием и «привилегией». Команда компании вывела её на передовые позиции в своей отрасли и открыла пути для будущего роста. Сделка с Samsung позволит вывести FläktGroup на новый уровень развития, выразили уверенность в пресс-службе Triton. Samsung подчёркивает, что благодаря покупке ключевого игрока в области HVAC-решений она закладывает основу для того, чтобы самой стать лидером на мировом рынке HVAC, предлагающим полный спектр соответствующих решений. В компании намерены продолжать инвестировать в быстрорастущий бизнес HVAC, который станет одним из ключевых двигателей будущего роста. Ранее конкурирующая LG Electronics (LG) представила собственные комплексные решения для охлаждения ЦОД.

15.05.2025 [09:36], Руслан Авдеев

СЖО с гарантией: Intel и Shell предложили сертифицированные системы погружного охлаждения для платформ на базе XeonПоскольку внедрение ИИ и HPC увеличивает потребность операторов ЦОД в мощной инфраструктуре, необходимы и более экоустойчивые, эффективные и масштабируемые решения для охлаждения оборудования. Компания Intel совместно с Shell Global Solutions предложили сертифицированное комплексное решение для иммерсионного охлаждения серверов с процессорами Intel Xeon Emerald Rapids или Sapphire Rapids, сообщает пресс-служба Intel. По информации Dell’Oro Group, системы жидкостного охлаждения становятся всё популярнее и к 2028 году на них будет приходиться 36 % выручки от общих продаж систем терморегуляции дата-центров. Однако внедрение высокоэффективного погружного охлаждения до недавнего времени тормозилось из-за отсутствия сертифицированных, прошедших проверки и готовых к развёртыванию продуктов. Intel и Shel провели валидацию полной системы иммерсионного охлаждения для ЦОД на основе оборудования Supermicro и Submer. Решение Intel Data Center Certified for Immersion Cooling называется первым в своём роде и задаёт новый отраслевой стандарт по эффективности и надёжности в долгосрочной перспективе. Масштабное тестирование и строгая валидация в лабораториях Intel позволяет операторам ЦОД внедрять проверенную инфраструктуру, будучи уверенными в её готовности к современным рабочим нагрузкам ИИ и HPC, говорится в пресс-релизе.

Источник изображения: Intel В рамках процесса сертификации Intel предлагает дополнительную гарантию на использование процессоров Xeon с однофазным иммерсионным охлаждением Xeon Processor Single-Phase Immersion Warranty Rider, подтверждающей надёжность и эффективность инфраструктуры, а также её совместимость с охлаждающими жидкостями Shell. Дополнительно исследуется возможность будущего сотрудничества для сертификации новейших поколений процессоров компании с жидкостями Shell.

Источник изображения: Intel Как заявил представитель Intel, по мере роста потребностей ЦОД, сертифицированные Intel решения для погружного охлаждения станут играть ключевую роль в обеспечении работы энергоэффективной и масштабируемой вычислительной инфраструктуры — ЦОД получили доступ к проверенным, готовым к внедрению технологиям охлаждения. Другими словами, операторы ЦОД смогут получить доступ к решениям с повышенной производительностью, минуя этап пилотного проекта — можно сразу переходить к внедрению предварительно проверенных вариантов с высокой энергоэффективностью и малым воздействием на окружающую среду. При этом такие решения обеспечены первыми в отрасли сертификатами и гарантиями Intel. |

|