Материалы по тегу: компьютер

|

05.07.2024 [16:42], Руслан Авдеев

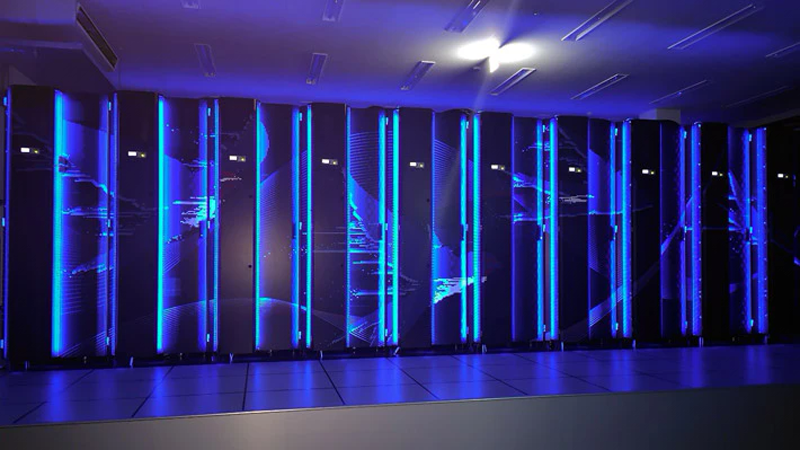

TotalEnergies запустила гибридный суперкомпьютер Pangea 4 для ускорения «зелёного перехода»Французская нефтегазовая компания TotalEnergies ввела в эксплуатацию гибридный суперкомпьютер Pangea 4. Машина находится в Научно-техническом центре Жана Феже в По (Jean Féger Scientific and Technical Center at Pau) на юго-западе Франции и состоит из вычислительных мощностей, размещённых на самой площадке, и облачных ресурсов Pangea@Cloud. Pangea 4 компактнее и энергоэффективнее предшественницы Pangea II — она использует на 87 % меньше энергии. Компания не раскрывает производительность новой машины, хотя и указывает, что она вдвое производительнее одной из предыдущих машин. Машина Pangea III с теоретической пиковой FP64-производительностью 31,7 Пфлопс, ставшая в своё время самым мощным индустриальным суперкомпьютером, продолжит свою работу. Pangea 4 была создана HPE, которая также строит суперкомпьютер HPC6 для итальянской нефтегазовой компании Eni. Pangea 4 будет использоваться не только для традиционных геофизических расчётов, но и для проектов по улавливанию и захоронению CO2, моделированию биотоплива и полимеров, расчётов механик снижения метановых выбросов, моделирования воздушных потоков для проектирования ветроэнергетических установок и т.д. А комбинация on-premise вычислений с облачными отвечает растущим запросам бизнеса, особенно с сфере новой энергетики — для того, чтобы помочь реализовать стратегию «зелёного перехода». Впрочем, приверженность компании «зелёным» ценностям находится под вопросом. TotalEnergies входит в одну из семи крупнейших нефтяных компаний. В прошлом году исследователи Oil Change International сообщили, что TotalEnergies занимала третье место по одобрению новых проектов расширения нефте- и газодобычи и использовала рекордную выручку для удвоения инвестиций в ископаемое топливо.

30.06.2024 [14:28], Сергей Карасёв

В Австралии запущен ИИ-суперкомпьютер Virga [Обновлено]Государственное объединение научных и прикладных исследований Австралии (CSIRO) сообщило о вводе в эксплуатацию высокопроизводительного вычислительного комплекса Virga. Система, предназначенная для ИИ-задач, ускорит научные открытия, а также поможет развитию промышленности и экономики страны. Суперкомпьютер располагается в дата-центре Hume компании CDC в Канберре. Его созданием занималась компания Dell: в основу положены серверы PowerEdge XE9640, оснащённые двумя процессорами Intel Xeon Sapphire Rapids 8452Y (36C/72T, 2,0/3,2 ГГц, 300 Вт), до 512 Гбайт RAM и четырьмя 61,44-Тбайт NVMe SSD. Задействованы ИИ-ускорители NVIDIA H100 с 96 Гбайт памяти HBM3 — всего 448 шт. Система занимает 14 стоек, а в качестве интерконнекта используется Infiniband NDR. Dell заключила контракт на создание Virga в 2023 году: сумма изначально составляла $9,65 млн, однако фактическое строительство комплекса обошлось в $10,85 млн. Новый суперкомпьютер придёт на смену НРС-системе CSIRO предыдущего поколения под названием Bracewell, но унаследует от неё BeeGFS-хранилище, также построенное на оборудовании Dell. В нынешнем рейтинге TOP500 машина занимает 72 место с пиковой и практической FP64-производительностью 18,46 Пфлопс и 14,94 Пфлопс соответственно. Комплекс Virga получил своё имя в честь метеорологического эффекта «вирга» — это дождь, который испаряется, не достигая земли: видеть его можно в виде полос, выходящих из-под облаков. Систему Virga планируется использовать для таких задач, как прогнозирование пожаров, разработка вакцин нового поколения, проектирование гибких солнечных панелей, анализ медицинских изображений и пр. Пока подробные технические характеристики Virga и показатели быстродействия не раскрываются. Отмечается лишь, что в составе комплекса применена гибридная система прямого жидкостного охлаждения. Говорится также, что CDC оперирует двумя кампусами дата-центров Hume. Площадка Hume Campus One объединяет три ЦОД и имеет мощность 21 МВт, тогда как в состав Hume Campus Two входят два объекта суммарной мощностью 51 МВт.

27.06.2024 [12:58], Сергей Карасёв

В Японии запущен суперкомпьютер TSUBAME4.0 с ускорителями NVIDIA H100 для ИИ-задачГлобальный научно-информационный вычислительный центр (GSIC) Токийского технологического института (Tokyo Tech) в Японии объявил о вводе в эксплуатацию вычислительного комплекса TSUBAME4.0, созданного компанией HPE. Новый суперкомпьютер будет применяться в том числе для задач ИИ. В основу машины легли 240 узлов HPE Cray XD665. Каждый из них несёт на борту два процессора AMD EPYC Genoa и четыре ускорителя NVIDIA H100 SXM5 (94 Гбайт HBM2e). Объём оперативной памяти DDR5-4800 составляет 768 Гбайт. Задействован интерконнект Infiniband NDR200. Вместимость локального накопителя NVMe SSD — 1,92 Тбайт. В состав НРС-комплекса входит подсистема хранения данных HPE Cray ClusterStor E1000. Сегмент на основе HDD имеет ёмкость 44,2 Пбайт — это в 2,8 раза больше по сравнению с суперкомпьютером предыдущего поколения TSUBAME 3.0. Кроме того, имеется SSD-раздел ёмкостью 327 Тбайт. Пиковая производительность TSUBAME4.0 достигает 66,8 Пфлопс (FP64), что в 5,5 больше по отношению к системе третьего поколения. Быстродействие на операциях половинной точности (FP16) поднялось в 20 раз по сравнению с TSUBAME3.0 — до 952 Пфлопс.

Источник изображения: Tokyo Tech На сегодняшний день TSUBAME4.0 является вторым по производительности суперкомпьютером в Японии после Fugaku. Эта система в нынешнем рейтинге TOP500 занимает четвёртое место с показателем 442 Пфлопс. Лидером в мировом масштабе является американский комплекс Frontier — 1,21 Эфлопс.

25.06.2024 [17:01], Сергей Карасёв

Второй в Европе экзафлопсный суперкомпьютер Alice Recoque разместится во Франции, а его создание обойдётся в €544 млнЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о подписании соглашения с французским национальным агентством высокопроизводительных вычислений (GENCI) о размещении второго в Европе суперкомпьютера экзафлопсного класса. Напомним, первым европейским HPC-комплексом с производительностью более 1 Эфлопс станет Jupiter, который расположится в Юлихском исследовательском центре (FZJ) в Германии. В создании системы участвуют NVIDIA, ParTec, Eviden и SiPearl. В состав суперкомпьютера войдут модули NVIDIA Quad GH200, а также энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea. Машина будет развёрнута на базе модульного ЦОД. Ввод в эксплуатацию запланирован в 2024 году. Второй в Европе экзафлопсный суперкомпьютер получил имя Alice Recoque) — в честь французского учёного, компьютерного инженера и специалиста по компьютерной архитектуре. Она работала над созданием мини-компьютеров в 1970-х годах и руководила исследованиями, связанными с ИИ. Стоимость создания машины оценивается в €544 млн. Управление суперкомпьютером возьмёт на себя Французская комиссия по альтернативным источникам энергии и атомной энергии (CEA). Комплекс будет смонтирован на территории Брюйер-ле-Шатель, к юго-западу от Парижа. Для размещения и эксплуатации машины выбран французско-нидерландский консорциум Жюля Верна. Известно, что в основу суперкомпьютера ляжет модульная энергоэффективная архитектура. По мере необходимости в состав системы могут добавляться дополнительные узлы на базе GPU или квантовых процессоров. Комплекс, в частности, будет построен на Arm-чипах SiPearl Rhea2, которые в настоящее время находятся в разработке. Не исключается также применения высокопроизводительных RISC-V процессоров EPI EPAC. Запуск Alice Recoque предварительно намечен на 2026 год, но может затянуться до 2027–2028 гг. Система будет доступна академическим организациям, государственным структурам и промышленным предприятиям. Использовать её планируется для выполнения ресурсоёмких задач в области ИИ и НРС.

22.06.2024 [22:16], Владимир Мироненко

Илон Маск намерен построить сразу два крупнейших в мире ИИ-кластераНа этой неделе на платформе YouTube появился видеоролик блогера Брэда Слоана (Brad Sloan), посвящённый строительству новых объектов гигафабрики Tesla в Техасе (Gigafactory Texas), включая ЦОД, где будет размещён ИИ-кластер на базе суперкомпьютера Dojo. В соцсети X глава Tesla Илон Маск (Elon Musk) заявил, что уже в этом году энергопотребление этой системы составит 130 МВт, а через 18 месяцев этот показатель вырастет до 500 МВт и данный кластер станет крупнейшим в мире. Строительство ЦОД стартовало в октябре прошлого года. Хотя компания не стала предавать гласности график строительства и намеченные сроки завершения, пока всё идёт не так, как планировалось Маском. В частности, есть сложности с доставкой материалов в Остине. Также наблюдаются задержки со строительством под площадкой дата-центра туннеля для передвижения электрических пикапов Cybertruck, за которое несёт ответственность основанная Маском компания Boring Company. После посещения площадки Маск уволил директора по строительной инфраструктуре проекта, а также провёл кадровые перестановки. Также сообщается, что миллиардер отложил и даже отменил некоторые проекты Tesla, чтобы направить все строительные ресурсы на этот объект. Илон Маск уточнил в комментариях, что ИИ-кластер будет использовать не только чипы собственной разработки Tesla D1, но и ускорители NVIDIA, а также других поставщиков, хотя ранее он говорил, что в основу суперкомпьютера Dojo лягут только фирменные ускорители Tesla. Как сообщается, затраты Tesla на проект Dojo в этом году составят более $1 млрд. Маск уверен, что ИИ ускорит обучение систем автономного вождения электромобилей и разработку инновационных технологий для роботизированных автомобилей. Вместе с тем, Маск уделяет большое внимание строительству стартапом xAI «крупнейшего в мире» кластера ускорителей в Северной Дакоте. С его помощью он планирует расширить возможности чат-бота Grok благодаря совершенствованию больших языковых моделей, стоящих за ним. Недавно Маск подтвердил передачу ускорителей NVIDIA H100, ранее заказанных Tesla, социальной сети X и ИИ-стартапу xAI. Это вызвало вопросы у акционеров Tesla по поводу того, какой проект на самом деле является приоритетным для Илона Маска. Для xAI, в частности, планируется создать систему с 300 тыс. NVIDIA B200.

21.06.2024 [12:05], Сергей Карасёв

«ИИ-гигафабрику» для xAI построят Dell и SupermicroОборудование для мощнейшего ИИ-суперкомпьютера компании xAI, курируемой Илоном Маском (Elon Musk), как сообщает Datacenter Dynamics, будут поставлять Dell и Supermicro. Речь идёт о серверах, оборудованных высокопроизводительными ускорителями NVIDIA. После анонса акции обеих компаний выросли в цене. Напомним, что xAI реализует проект по созданию самого мощного в мире вычислительного комплекса, ориентированного на задачи ИИ. Строительство суперкомпьютера будет осуществляться в несколько этапов. Так, в ближайшее время должна быть запущена система, содержащая 100 тыс. ускорителей NVIDIA H100. А летом 2025 года планируется ввести в эксплуатацию кластер из 300 тыс. новейших ускорителей NVIDIA B200. О том, что участие в масштабном проекте xAI принимает корпорация Dell, сообщил её генеральный директор Майкл Делл (Michael Dell). Эти сведения подтвердил и сам Маск: по его словам, Dell «соберёт половину стоек, которые войдут в состав суперкомпьютера». За строительство оставшейся части системы будет отвечать Supermicro. По имеющейся информации, огромный дата-центр xAI, прозванный «ИИ-гигафабрикой», расположится в окрестностях Мемфиса (штат Теннесси). О том, в какой пропорции работы по строительству машины будут распределены между Dell и Supermicro, на данный момент нет. Стоимость проекта оценивается в миллиарды долларов. xAI в настоящее время арендует около 16 тыс. ускорителей NVIDIA H100 в облаке Oracle Cloud, а также использует веб-сервисы Amazon и свободные мощности на ЦОД-площадках X/Twitter. В мае 2024 года стартап осуществил раунд финансирования Series B, в ходе которого было привлечено $6 млрд. В результате, рыночная стоимость xAI достигла $24 млрд. Создаваемый суперкомпьютер будет использоваться в том числе для поддержания работы чат-бота xAI Grok следующего поколения.

20.06.2024 [12:19], Сергей Карасёв

Запущен первый в Германии гибридный квантовый компьютер: система IQM интегрирована с суперкомпьютером SuperMUC-NGВ Суперкомпьютерном центре Лейбница (LRZ) Баварской академии наук заработал первый в Германии гибридный квантовый компьютер. Проект реализован консорциумом Q-Exa, в который входят разработчик квантовых платформ IQM Quantum Computers (IQM), а также Eviden и HQS Quantum Simulation. В ходе работ 20-кубитная квантовая система была интегрирована с суперкомпьютером SuperMUC-NG. Последний базируется на серверах Lenovo ThinkSystem SD650-I V3 Neptune DWC с прямым жидкостным охлаждением. Установлены 240 узлов, в состав которых входят в общей сложности 480 процессоров Intel Xeon Platinum 8480L и 960 ускорителей Data Center GPU Max. Производительность комплекса достигает 17,19 Пфлопс (FP64). В квантовой части кубиты генерируются с помощью сверхпроводящих цепей. Платформа закладывает основы для исследований и дальнейшего развития квантовых вычислений, а также для ускорения высокопроизводительных вычислений с помощью квантовых чипов (QPU). В настоящее время гибридная система готовится к повседневной эксплуатации, и в скором времени доступ к ней будет предоставлен некоторым исследовательским коллективам. Среди ключевых характеристик платформы названы: 20-кубитный квантовый процессор; состояние квантовой запутанности Гринбергера — Хорна — Цайлингера для 19 кубитов без устранения ошибок чтения; полностью запутанное состояние GHZ для 20 кубитов с компенсацией ошибок. Средняя точность двухкубитного вентиля составляет 99,46 % для 30 пар кубитов, а максимальная точность для одной пары достигает 99,74 %. Говорится также, что специалисты LRZ и партнёрских учреждений Мюнхенской квантовой долины (Munich Quantum Valley) разработали прототип Мюнхенского квантового программного стека (MQSS). Он помогает встроить квантовые вычисления в рабочие процессы традиционных суперкомпьютеров. Софт будет доступен исследователям в виде продукта с открытым исходным кодом.

17.06.2024 [22:49], Илья Коваль

Три квантовых компьютера, NVIDIA DGX Quantum, немножко HPC и облако: в Израиле открыт уникальный центр квантовых вычислений IQCC

aws

gh200

grace

hardware

hpc

nvidia

quantum machines

израиль

квантовые вычисления

квантовый компьютер

облако

разработка

Стартап Quantum Machines, разработчик систем управления квантовыми компьютерами, открыл Израильский центр квантовых вычислений (Israeli Quantum Computing Center, IQCC). Площадка, создание которой было частично профинансировано правительством страны, располагается в Тель-Авивском университете. По словам основателей, это первый в мире центр, располагающий квантовыми компьютерами разных типов, которые интегрированы с системой NVIDIA DGX Quantum, HPC-инфраструктурой и облаком. Приоритетный доступ со скидкой получат исследовательские организации Израиля, но в целом центр будет открыт для компаний со всего света. Как говорят создатели, IQCC — это лучший в мире полигон для создания новых технологий в области квантовых вычислений, а открытая архитектура площадки позволяет регулярно проводить обновления и упрощает дальнейшее масштабирование возможностей и вычислительных мощностей. Сейчас в IQCC установлены 21-кубитный компьютер Galilee от Quantware на сверхпроводящих кубитах (ещё один такой же используется в качестве тестовой платформы) и фотонный компьютер Negev от ORCA (8 кумод). Системы управляются контроллерами OPX1000 от самой Quantum Machines. HPC-инфраструктура представлена DGX A100, четырьмя GH200 и 128 vCPU на базе AMD EPYC 9334 (Genoa). Дополнительные ресурсы можно арендовать в облаке AWS. Для Galilee и Negev доступна интеграция с DGX Quantum, платформой для гибридных квантово-классических вычислений, которая была создана NVIDIA и Quantum Machines и впервые в мире развёрнута именно в IQCC. Управлять компьютерами и разрабатывать ПО можно с использованием Qiskit, QUA, OpenQASM3, QBridge, а также Classiq. К системе организован облачный доступ. В ближайшие месяцы в IQCC будут развёрнуты ещё несколько квантовых компьютеров и QPU.

17.06.2024 [08:53], Руслан Авдеев

Cerebras и Dell предложат заказчикам современные ИИ-платформыРазработчик ИИ-суперчипов Cerebras Systems анонсировал сотрудничество с Dell. Вместе компании займутся созданием передовых вычислительных инфраструктур для генеративного ИИ. В рамках сотрудничества будут создаваться масштабируемые решения для ИИ-суперкомпьютеров Cerebras с платформами Dell на базе процессоров AMD EPYC Genoa. По словам участников проекта, новые технологические решения дадут возможность обучать модели, на порядки более крупные, чем те, что есть на данный момент. В частности, будут задействованы системы Dell PowerEdge R6615 на базе AMD EPYC 9354P, которые предоставят потоковый доступ к 82 Тбайт памяти — для обучения моделей практически любого размера. Совместные платформы Cerebras и Dell будут включать ИИ-системы и суперкомпьютеры. Также будет предложена тренировка ИИ-моделей и иные сервисы поддержки машинного обучения. Как утверждают в самой Cerebras, сотрудничество с Dell станет поворотной точкой, открывающие каналы глобальной дистрибуции. Компании предоставят ИИ-оборудование, ПО и экспертизу, что позволит заказчикам упростить и ускорить внедрении современных ИИ-технологий, попутно снизив TCO. В марте Cerebras представила новейшие суперчипы Cerebras WSE-3, а в мае появилась новость, что совместно с Core42 из ОАЭ компания создаст суперкомпьютер Condor Galaxy 3 (CG-3) со 172,8 млн ИИ-ядер.

16.06.2024 [16:25], Сергей Карасёв

Холодный приём: новый национальный суперкомпьютер Норвегии разместят в руднике и охладят водой из фьордаВласти Норвегии, по сообщению ресурса HPC Wire, подписали контракт стоимостью Kr225 млн ($21 млн) с корпорацией HPE, предусматривающий создание нового национального суперкомпьютера A2 (постоянное имя системе дадут позже). Он станет самым мощным в истории страны и значительно ускорит исследования и разработки в различных областях, в том числе в сфере ИИ. За закупку и эксплуатацию НРС-систем в Норвегии отвечает государственная компания Sigma2 AS. Вычислительные услуги предоставляются в сотрудничестве с университетами Бергена, Осло, Тромсё, а также Норвежским университетом естественных и технических наук (NTNU) в рамках проекта NRIS. В основу нового суперкомпьютера ляжет платформа HPE Cray EX4000. Известно, что в состав комплекса войдут 76 узлов с четырьмя гибридными суперчипами NVIDIA GH200 (всего 304 ускорителя), 252 узла с двумя 128-ядерными AMD EPYC Turin (64 512 ядер) и 5,3-Пбайт хранилище HPE Cray ClusterStor E1000. Узлы объединит интерконнект HPE Slingshot. Ожидаемая производительность системы составит порядка 10 Пфлопс. Монтаж системы планируется выполнить в течение весны–лета 2025 года. Машина расположится в дата-центре Лефдаль (Lefdal Mine Datacenter, LMD), развёрнутом на базе бывшего рудника. Этот объект имеет большую площадь и предоставляет гибкие возможности в плане масштабирования. Новый суперкомпьютер HPE станет первой национальной высокопроизводительной системой, установленной в этом ЦОД.

Источник изображения: Sigma2 Несмотря на то, что готовящийся комплекс будет значительно мощнее высокопроизводительных вычислительных систем Sigma2 предыдущего поколения, его энергопотребление окажется меньше примерно на 30 %. Для охлаждения будет использоваться холодная вода из близлежащего фьорда. Нагретая вода затем может быть направлена на нужды местных предприятий, в том числе, например, рыбных ферм. Ожидается, что суперкомпьютер сможет удовлетворить потребности Норвегии в НРС-ресурсах в течение следующих пяти лет. Он будет доступен исследователям по всей стране. В дальнейшем суперкомпьютер может дополнительно получить 119 808 CPU-ядер и/или 224 ускорителя. В целом же Норвегия рассчитывает, что современные ЦОД станут для страны «новой нефтью». |

|