Материалы по тегу: software

|

06.06.2025 [18:46], Руслан Авдеев

AMD продолжает шоппинг: компания купила стартап Brium для борьбы с доминированием NVIDIAВ последние дни компания AMD активно занимается покупками компаний, так или иначе задействованных в разработке ИИ-технологий. Одним из последних событий стала покупка стартапа Brium, специализирующегося на инструментах разработки и оптимизации ИИ ПО, сообщает CRN. AMD, по-видимому, всерьёз обеспокоилась развитием программной экосистемы после того, как выяснилось, что именно ПО не даёт раскрыть весь потенциал ускорителей Instinct. О покупке Brium, в состав которой входят «эксперты мирового класса в области компиляторов и программного обеспечения для ИИ», было объявлено в минувшую среду. Финансовые условия сделки пока не разглашаются. По словам представителя AMD, передовое ПО Brium укрепит возможности IT-гиганта «поставлять в высокой степени оптимизированные ИИ-решения», включающие ИИ-ускорители Instinct, которые играют для компании ключевую роль в соперничестве с NVIDIA. Дополнительная информация изложена в пресс-релизе AMD. В AMD уверены, что разработки Brium в области компиляторных технологий, фреймворков для выполнения моделей и оптимизации ИИ-инференса позволят улучшить эффективность и гибкость ИИ-платформы нового владельца. Главное преимущество, которое AMD видит в Brium — способность стартапа оптимизировать весь стек инференса до того, как модель начинает обрабатываться аппаратным обеспечением. Это позволяет снизить зависимость от конкретных конфигураций оборудования и обеспечивает ускоренную и эффективную работу ИИ «из коробки». В частности, команда Brium «немедленно» внесёт вклад в ключевые проекты вроде OpenAI Triton, WAVE DSL и SHARK/IREE, имеющие решающее значение для более быстрой и эффективной эксплуатации ИИ-моделей на ускорителях AMD Instinct. У технического директора Brium Квентина Коломбета (Quentin Colombet) десятилетний опыт разработки и оптимизации компиляторов для ускорителей в Google, Meta✴ и Apple.

Источник изображения: AMD Компания сосредоточится на внедрении новых форматов данных вроде MX FP4 и FP6, которые уменьшают объём вычислений и снижают энергопотребление, сохраняя приемлемую точность моделей. В результате разработчики могут добиться более высокой производительности ИИ-моделей, снижая затраты на оборудование и повышая энергоэффективность. Покупка Brium также поможет ускорить создание open source инструментов. Это даст возможность AMD лучше адаптировать свои решения под специфические потребности клиентов из разных отраслей. Так, Brium успешно адаптировала Deep Graph Library (DGL) — фреймворк для работы с графовыми нейронными сетями (GNN) — под платформу AMD Instinct, что дало возможность эффективно запускать передовые ИИ-приложения в области здравоохранения. Такого рода компетенции повышают способность AMD предоставлять оптимальные решения для отраслей с высокой добавленной стоимостью и расширять охват рынка. Brium — лишь одно из приобретений AMD за последние дни для усиления позиций в соперничестве с NVIDIA, доминирование которой на рынке ИИ позволило получить в прошлом году выручку, более чем вдвое превышавшую показатели AMD и Intel вместе взятых. В числе последних покупок — стартап Enosemi, работающий над решениями в сфере кремниевой фотоники, поставщик инфраструктуры ЦОД ZT Systems, а также софтверные стартапы Silo AI, Nod.ai и Mipsology. Кроме того, совсем недавно компания купила команду Untether AI, не став приобретать сам стартап.

03.06.2025 [10:10], Владимир Мироненко

Благодаря ИИ Microsoft из отстающих вышли в лидеры по темпам роста своих акцийПосле нескольких месяцев затишья акции Microsoft возобновили рост, вплотную приблизившись к рекордному максимуму на фоне признаков возвращения к норме бизнеса Azure, пишет Bloomberg. Сейчас акции Microsoft торгуются всего на 2 % меньше рекордного уровня, достигнутого в июле прошлого года, после роста на 16 % в мае, что сделало его лучшим месяцем для компании за более чем три года. Рост акций был обусловлен более широким восстановлением позиций акций американских компаний, а также лучшими, чем ожидали на Уолл-стрит, результатами Azure. Как полагают инвесторы, эта тенденция сохранится, поскольку ИИ становится драйвером роста бизнеса. «ИИ становится всё более важной составляющей доходов», — отметила Нэнси Тенглер (Nancy Tengler), гендиректор инвестиционной компании Laffer Tengler Investments. Темпы роста акций Microsoft резко увеличились по сравнению с прошлым годом, когда из-за опасений инвесторов по поводу отставания компании в гонке ИИ и разочаровывающего роста Azure по сравнению с облачными платформами конкурентов акции софтверного гиганта выросли всего на 12 %. Это был худший показатель среди так называемой «великолепной семёрки», также включающей Apple, NVIDIA, Alphabet, Amazon, Meta✴ и Tesla. В этом году Microsoft с ростом акций на 9 % обошла всех участников семёрки, за исключением Meta✴, у которой рост акций составил 10 %. Помимо того, что Microsoft значительно улучшила финансовое положение, она, в отличие от многих конкурентов, выиграла от введения пошлин новой администрацией США, пишет Bloomberg. Аналитики TD Cowen опубликовали прогноз, согласно которому выручка Azure, связанная с ИИ, вырастет примерно до $24 млрд в 2026 финансовом году с около $4 млрд в 2024 финансовом году. Аналитики повысили целевую цену акций до $540 с $490, что подразумевает потенциальный прирост примерно на 18 % по сравнению с ценой на момент закрытия торгов в прошлую среду. Из 72 аналитиков, опрошенных Bloomberg, которые отслеживают деятельность Microsoft, никто не рекомендует продавать её акции. При прогнозируемом соотношении цены и прибыли на акцию в 30 на следующие 12 месяцев Microsoft оценивается с премией к среднему показателю Nasdaq 100 и собственному 10-летнему среднему показателю в размере около 26, пишет Bloomberg. По мнению Кевина Уолкуша (Kevin Walkush), управляющего портфелем в Jensen Investment Management, акции Microsoft продолжат расти, поскольку компания будет генерировать растущую долю дохода от ИИ-сервисов. «Microsoft, вероятно, является одной из лучших долгосрочных возможностей в ИИ», — заявил он.

03.06.2025 [08:40], Владимир Мироненко

Broadcom: на рынке происходит «облачная перезагрузка» — доверие к частным облакам только растёт

broadcom

software

гибридное облако

ии

информационная безопасность

исследование

конфиденциальность

миграция

облако

частное облако

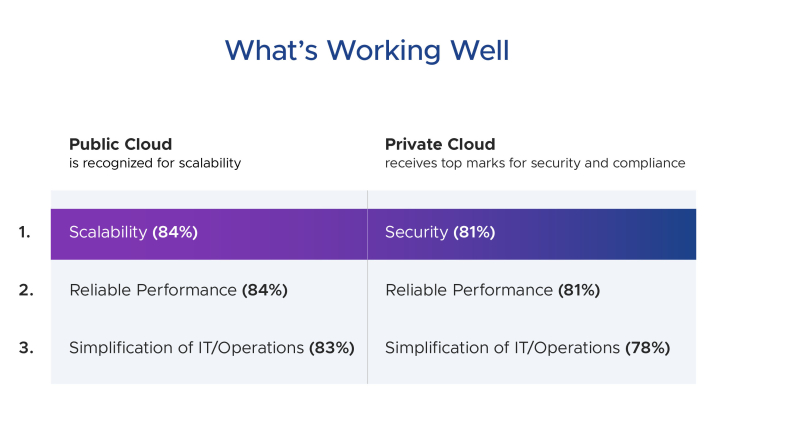

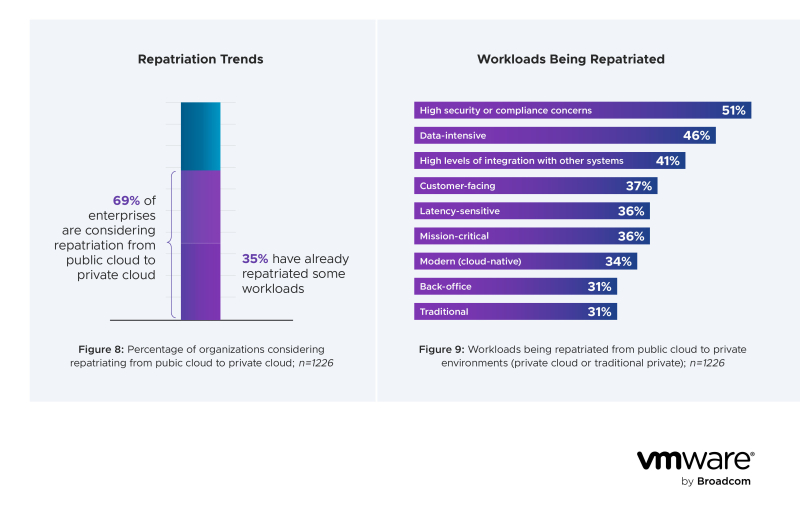

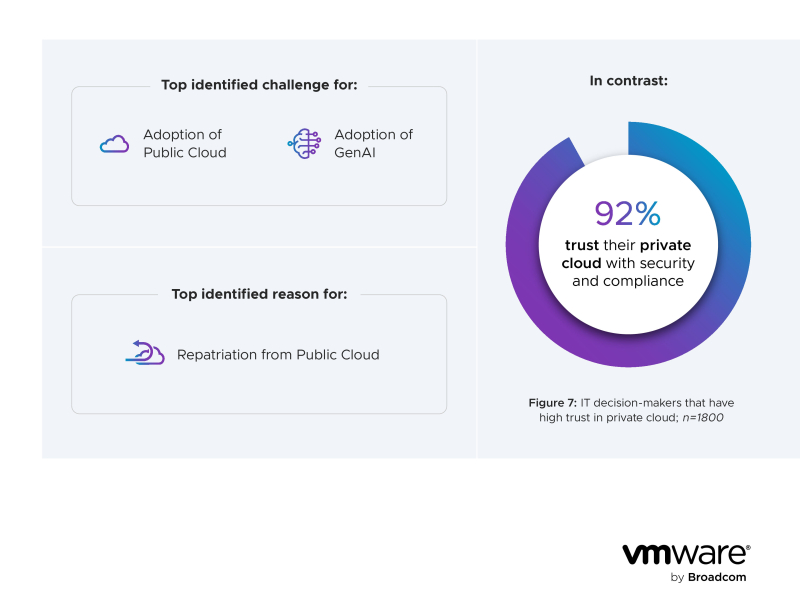

Облако остаётся основой для модернизации инфраструктуры и приложений, однако организации изменили свой подход к нему. Частное облако больше не является второстепенным решением. Предприятия пересматривают свои облачные стратегии, выбирая для рабочих нагрузок среду, которая наилучшим образом соответствует их требованиям, часто помещая частное облако в центр своей стратегии. В настоящее время на рынке происходит «облачная перезагрузка» — таков ключевой вывод исследования Private Cloud Outlook 2025, выполненного Illuminas по поручению Broadcom. В рамках исследования весной 2025 года были проведены глубинные интервью 1800 старших ИТ-руководителей компаний в Америке, Европе и Азиатско-Тихоокеанском регионе. Респонденты представляли различные секторы экономики, включая финансовые услуги, государственное управление, здравоохранение, страхование и фармацевтику. Более половины (53 %) участников опроса указали частное облако в качестве приоритетного при развёртывании новых рабочих нагрузок в течение следующих трёх лет, 69% рассматривают возможность возвращения рабочих нагрузок из публичного облака в частное, а треть уже сделала это. Это знаменует собой завершение эпохи, когда публичное облако было выбором по умолчанию, отметил ресурс StorageReview. Частное облако теперь также является стратегически равным для обработки облачных и ИИ-приложений, при этом 66% респондентов предпочитает запускать контейнерные и основанные на Kubernetes приложения в частном или гибридном облаках. 55% предпочитают частное облако для обучения, тюнинга и инференса ИИ-моделей. Безопасность и соответствие требованиям стали значимыми факторами при принятии решений в отношении выбора типа облака. Подавляющее большинство ИТ-руководителей (92 %) доверяют частному облаку в плане обеспечения требований к безопасности и соответствию законодательству, нормативным актам и т.д. При этом 66 % респондентов указали, что «очень» или «крайне» обеспокоены соответствием публичного облака различным требованиям, а безопасность назвали в качестве главного фактора возвращения нагрузок из публичного облака в частное. Использование генеративного ИИ также повлияло на изменение предпочтений в отношении облака. 49% респондентов назвали главными проблемами при внедрении генеративного ИИ проблемы конфиденциальности и безопасности данных. В результате частное облако теперь выбирают для рабочих нагрузок ИИ почти с той же частотой, что и публичное облако (55 % против 56 %). Предсказуемость затрат — еще один критический фактор при выборе в пользу частного облака. 90 % респондентов ценят финансовую прозрачность и предсказуемость, предлагаемые частным облаком. Напротив, 94 % сообщают о некотором уровне расточительства в расходах на публичное облако, причем почти половина (49 %) считает, что более 25 % их расходов на публичное облако тратятся впустую. Это создаёт значительные возможности для оптимизации и контроля затрат в средах частного облака, отмечено в исследовании. Реальный опыт использования публичного облака, быстрый рост рабочих нагрузок генеративного ИИ и растущие требования к безопасности, соответствию и предсказуемости затрат являются движущими силами «облачной перезагрузки», говорится в исследовании. Стоит отметить, что Broadcom кровно заинтересована в развитии VMware и частных облаков, поскольку изменение лицензионной политики уже запустило процессы девиртуализации и ревиртуализации. Чтобы в полной мере воспользоваться преимуществами частного облака, организациям необходимо решить две ключевые проблемы: преодолеть разрозненность ИТ-команд и сохраняющийся разрыв в навыках. Разрозненность ИТ-команд представляет наибольшую проблему для внедрения частного облака, считает 33 % респондентов, а 30 % назвали существенным препятствием отсутствие внутренних навыков/опыта. Согласно опросу, 81 % компаний теперь выстраивают свои структуры вокруг платформенной команды, а не технологических разрозненных команд. Это позволяет сосредоточиться на повышении квалификации персонала, чтобы устранить разрыв в навыках и снизить зависимость от профессиональных сервисов.

30.05.2025 [09:34], Руслан Авдеев

Microsoft закрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентовКомпания Microsoft сделала серьёзную заявку на мировое лидерство в сфере искусственного интеллекта, в своё время инвестировав $13 млрд в стартап OpenAI. Позже компания использовала GPT-модели OpenAI в качестве основы для собственного бота Copilot AI, интегрировав его во многие свои продукты, а теперь вышла на новый уровень, сообщает Computer World. Компания запустила хостинг LLM и ИИ-сервисов крупнейших в мире ИИ-компаний и стартапов, включая собственных конкурентов — всего более 1900 моделей, от Llama AI (Meta✴) до разработок xAI и европейских стартапов Mistral и Black Forest Labs, а также китайского DeepSeek и др. Другими словами, даже если Copilot не оправдает ожиданий Microsoft в полной мере, она в какой-то степени разделит и успехи своих конкурентов и, вероятно, останется крупнейшей в мире ИИ-компанией. ЦОД Microsoft стали залогом её успеха на рынке искусственного интеллекта. Благодаря сделке с OpenAI сама Microsoft получает отчисления от каждого подписчика OpenAI. Для монетизации ИИ-решений в 2023 году Microsoft запустила сервис Azure OpenAI, позволяющий клиентам Azure создавать приложения с использованием моделей OpenAI. По некоторым данным, в сервисе зарегистрировано около 60 тыс. клиентов.

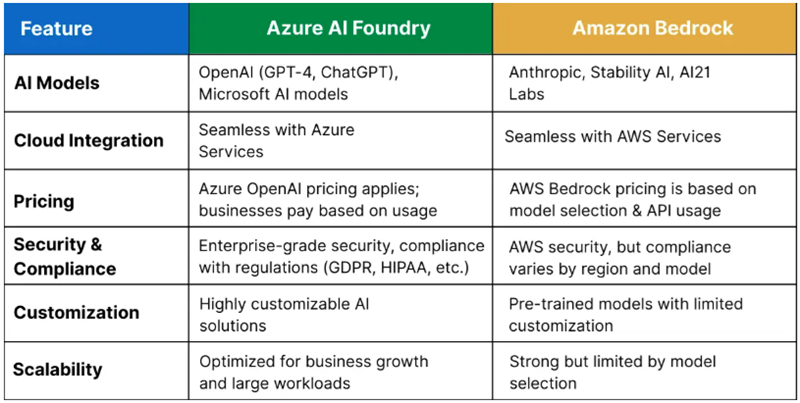

Источник изображения: Craig Sybert/unsplash.com Бизнес компании растёт и благодаря договорённостями с другими ИИ-разработчиками. В середине мая Microsoft объявила о размещении моделей Grok в сервисе Azure AI Foundry. Кроме того, в облаке Microsoft размещены и другие популярные модели. Таким образом, Microsoft получает больше денег даже в том случае, когда конкуренты добиваются новых успехов. Недавно компания подробно рассказала о видении того, каким образом компании смогут создавать ИИ-агентов для выполнения широкого спектра задач. В центре внимания — Azure AI Foundry, позволяющий клиентам создавать ИИ-агентов, использую любую из почти 2 тыс. моделей и объединяя их возможности, в том числе, например, для работы на GutHub. Другими словами, заказчикам не придётся подписываться на использование моделей у каждой из компаний по отдельности.

Источник изображения: Q Service Хотя крупнейшим облачным оператором в мире является Amazon (AWS), Microsoft постепенно сокращает разрыв, а подобные площадки для работы с разными ИИ-моделями обеспечивают ей большую фору. Amazon с аналогом Azure AI Foundry — Amazon Bedrock пыталась повторить нечто подобное, но ИИ-моделей у неё гораздо меньше. Высока вероятность, что в этой схватке первенство останется за Microsoft. По расчётам экспертов Q Services, предложение Bedrock лучше подходит разве что для стартапов и компаний, занимающихся разработкой, а Microsoft доминирует на более широком рынке, в том числе сотрудничая с крупными корпорациями. Большое преимущество компании — в использовании всех продуктов, от Microsoft 365 до Azure для продажи существующим клиентам сервисов Azure AI Foundry. У Amazon такая уникальная возможность отсутствует.

29.05.2025 [11:46], Владимир Мироненко

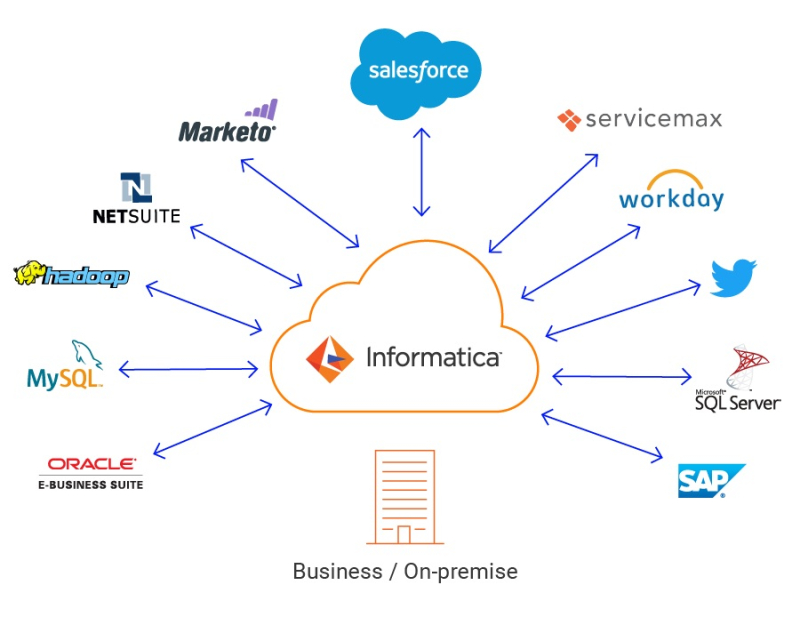

Salesforce приобрела за $8 млрд Informatica ради улучшения платформы ИИ-агентов AgentforceАмериканская компания Salesforce, разработчик одноимённой CRM-платформы, объявила о покупке компании по управлению облачными данными Informatica. Согласно условиям сделки стоимостью $8 млрд за вычетом текущих инвестиций Salesforce в Informatica, держатели обыкновенных акций Informatica классов A и B-1 получат $25 наличными за акцию. Как сообщает Reuters, в прошлом году Salesforce отложила переговоры о сделке с Informatica, после того как компании не смогли договориться об условиях сделки. По данным источников агентства, переговоры возобновились в начале апреля, когда несколько потенциальных покупателей, включая Thoma Bravo и Cloud Software Group, начали проявлять интерес к покупке Informatica. Salesforce заявила, что объединение обширного каталога Informatica, функций интеграции данных, систем контроля качества и конфиденциальности данных, системы управления политиками доступа и сервиса Master Data Management (MDM) с платформой Salesforce создаст единую архитектуру для агентского ИИ, что позволит ИИ-агентам работать безопасно, ответственно и масштабируемо в рамках предприятия. «По-настоящему автономным, заслуживающим доверия ИИ-агентам необходимо максимально полное понимание своих данных, — сказал Стив Фишер (Steve Fisher), президент и главный технический директор Salesforce. — Сочетание расширенных возможностей каталога и метаданных Informatica с нашей платформой Agentforce именно это и обеспечивает». «Представьте себе ИИ-агента, который выходит за рамки простого наблюдения за точечными данными и понимает их полный контекст — происхождение, трансформацию, уровень качества и политики управления. Эта ясность, полученная от унифицированного решения Salesforce и Informatica, позволит всем типам предприятий автоматизировать более сложные процессы и принимать более надежные решения на основе ИИ», — добавил он. Как указано в пресс-релизе, эффективный ИИ корпоративного уровня требует не только данных — он требует прозрачности данных, глубокого контекстного понимания и строгого управления:

По словам Марка Бениоффа (Marc Benioff), председателя и гендиректора Salesforce, совместными усилиями Salesforce и Informatica создадут «самую полную, готовую для агентов платформу данных в отрасли». Он заявил, что благодаря объединению возможностей Data Cloud, MuleSoft и Tableau с передовыми возможностями Informatica по управлению данными автономные ИИ-агенты смогут предоставлять более интеллектуальные, безопасные и масштабируемые результаты для каждой компании. Это позволит компании значительно укрепить позиции на рынке корпоративных данных стоимостью более $150 млрд. Сообщается, что интеграция решений двух компаний откроет новые возможности для корпоративного стека данных Salesforce, предоставляя комплексное решение для ИИ-задач:

Как ожидается, сделка будет закрыта в начале 2027 финансового года Salesforce. Её уже одобрили советы директоров Salesforce и Informatica. Акционеры, владеющие в совокупности примерно 63 % голосующих акций Informatica классов A и B-1, предоставили письменное согласие на одобрение сделки. Её финансирование будет осуществляться за счёт денежных средств на балансе Salesforce и заёмных средств. После закрытия сделки Salesforce планирует быстро интегрировать технологический стек Informatica в свою экосистему. За последние годы Salesforce заключила целый ряд сделок с целью расширения своего продуктового портфеля и увеличения доли рынка. В частности, она купила Slack в 2021 году за $27,7 млрд, Tableau в 2019 году за $15,7 млрд и MuleSoft в 2018 году за $6,5 млрд.

27.05.2025 [15:41], Руслан Авдеев

OpenAI нанимает сотрудников для офиса в Южной КорееOpenAI обзавелась юридическим лицом в Южной Корее — компания стремится содействовать дальнейшему внедрению собственных ИИ-технологий в стране, которые и без того пользуются там высоким спросом. Создатели ChatGPT намерены открыть официальный офис в Сеуле, сообщает Bloomberg. По информации издания, открытие состоится в ближайшие месяцы, а компания уже начала нанимать сотрудников «для поддержки партнёрских отношений с бизнесом и властями». Согласно статистике OpenAI, Южная Корея по количеству подписчиков на платную версию ChatGPT занимает второе место в мире после США. Офис в Южной Корее станет третьим в Азии — первые два открыли в Японии и Сингапуре (40 и 20 сотрудников соответственно). На этой неделе с турне по Азии путешествует новый директор по стратегии Джейсон Квон (Jason Kwon), стремящийся встретиться с государственными служащими и отраслевыми партнёрами для обсуждения будущей ИИ-инфраструктуры и использование ПО OpenAI.

Источник изображения: Mathew Schwartz/unsplash.com По словам Квона, полноценная ИИ-экосистема в Южной Корее сделает её одним из самых перспективных рынков в мире для значимого внедрения искусственного интеллекта, охватывающего все уровни, как технические, от аппаратного обеспечения до ПО, так и социальные — от студентов до пожилых людей. Впрочем, за последние дни это не первая новость о значимых инициативах компании в Азии. Так, недавно сообщалось, что OpenAI и G42 построят 5-ГВт кампус в Абу-Даби (ОАЭ), он значительно крупнее, чем 1,2-ГВт кампус Stargate в Техасе, хотя компания принимает активное участие и в этом проекте.

23.05.2025 [08:26], Руслан Авдеев

Google вслед за Microsoft заявила о готовности поддержать клиентов из Евросоюза и представила новые решения для защиты цифрового суверенитетаВ рамках стратегии создания суверенного облака для Евросоюза компания Google анонсировала новые инструменты защиты цифрового суверенитета. Меры направлены на снижение алармистских настроений европейских регуляторов, связанных с возможной зависимостью блока от американских IT-гигантов, сообщает Datacenter Dynamics. Компания намерена более активно сотрудничать с региональными партнёрами, в частности — в Германии и Франции. Это делается для того, чтобы обеспечить клиентам гарантии хранения и обработки данных исключительно в пределах «домашних» регионов. Поводом стала обеспокоенность европейских властных структур возможной зависимостью от американских облачных платформ Google Cloud, AWS, Microsoft Azure и др. Такая зависимость потенциально может использоваться администрацией США для политического и экономического давления в рамках продолжающихся торговых переговоров. Европейские облачные компании ссылаются на недавние действия Белого дома, связанные с кризисом НАТО, новыми пошлинами на европейскую продукцию и даже ситуация вокруг Гренландии. Это сильные доводы для перехода в суверенные облака. В Google же подчёркивают, что раньше цифровой суверенитет был нишевым требованием, связанным преимущественно со строго регулируемыми отраслями, но теперь о нём начали задумываться буквально все. В пакет новых предложений для суверенных облаков входит функция Google Cloud Data Boundary, позволяющая пользователям формировать границы допустимого хранения данных с указанием конкретной страны. Также Google предлагает новую функцию User Data Shield, в рамках которой компания Mandiant может осуществить независимую валидацию безопасности облачных приложений, действующих в рамках заданных границ. Google Cloud Dedicated предлагает платформу Trust Cloud by S3NS, где пользователи получают доступ к передовым облачным сервисам функциями Google Cloud, в том числе к ускорителям, но управляется платформа французской S3NS (совместный проект Thales и Google с 2021 года) в соответствии со стандартами SecNumCloud. Параллельно с Thales было заключено аналогичное соглашение и с немецкой T-Systems. Суверенное облако в Германии существует в формате Supervised Cloud. Физическое управление отдано T-Systems, облако полностью изолировано от прочей экосистемы Google Cloud. Заявление Google прозвучало всего через несколько дней после анонса Microsoft, сообщившей об усилении своего присутствия в Европе и обещавшей увеличить мощности ЦОД в регионе на 40 % в ближайшие два года. В Microsoft отмечали, что учитывают реалии и понимают, что европейские власти будут рассматривать дополнительные варианты, в том числе финансирование «домашних» решений. В компании объявили о готовности сотрудничать, благо компания уже имеет опыт создания суверенных облаков в Евросоюзе. В крайнем случае Microsoft даже готова судиться с правительством США. Стоит отметить, что Google и Microsoft не первый год перетягивают одеяло на европейском рынке. Не так давно Microsoft достигла соглашения с ассоциацией облачных операторов CISPE, которое, впрочем, не включает Google. Однако CISPE недавно предупредила, что Microsoft пока «отклонилась от курса» в вопросе внесения изменений условий лицензирования своего ПО в Европе и всё ещё не создала продукта, удовлетворяющего требованиям европейских провайдеров.

21.05.2025 [12:57], Руслан Авдеев

ИИ-платформа Microsoft Discovery создала жидкость для СЖО за 200 часов вместо нескольких месяцев

hpc

microsoft

microsoft azure

software

ии

ии-агент

квантовые вычисления

погружное охлаждение

разработка

сжо

химия

Компания Microsoft запустила для корпоративных пользователей в тестовом режиме ИИ-платформу Microsoft Discovery, использующую ИИ-агентов и HPC для помощи учёным, которым не придётся самостоятельно писать код для своих исследований. Потенциал системы продемонстрировали на примере самой Microsoft — ИИ помог создать новейшую жидкость для погружного охлаждения всего за 200 часов вместо нескольких месяцев или даже лет, сообщает VentureBeat. Microsoft Discovery использовали для поиска охлаждающей жидкости без «вечных» PFAS-химикатов, часто применяемых в иммерсионных СЖО. Регуляторы во всём мире всё чаще запрещают производство и использование этого класса вещества. ИИ Microsoft проверил 367 тыс. веществ-кандидатов, после чего химикат синтезировал один из партнёров компании. Однако сфера применения такого ИИ простирается далеко за пределы создания охлаждающих жидкостей — новые материалы и химикаты требуются в самых разных сферах, но на их поиск часто уходят годы. Microsoft Discovery позволяет взаимодействовать с «невероятными возможностями» ИИ, используя естественный язык, что полностью меняет весь процесс исследований, говорит компания. Обычно учёным приходилось изучать программирование для того, чтобы создавать вычислительные инструменты. Такая демократизация науки сыграет на руку малым исследовательским группам, у которых нет ресурсов на изучение программирования или привлечения сторонних специалистов в этой сфере. Более того, со временем платформа научится работать и с квантовыми компьютерами, написание кода для которых — ещё более сложная задача.

Источник изображения: National Cancer Institute/unsplash.com Работа выполняется с помощью специальных ИИ-агентов, специально обученных для выполнения отдельных научных задач — от написания литературного обзора до создания компьютерной симуляции. По словам Microsoft, ИИ-агенты — это чуть ли не целая команда учёных с докторскими степенями в различных науках. Платформа интегрирует друг с другом базовые модели, занимающиеся общим планированием, и модели, специализирующиеся на физике, химии или, например, биологии. Также Microsoft Discovery позволяет комбинировать закрытые исследовательские данные и результаты уже опубликованных научных исследований по разным дисциплинам, сохраняя прозрачность моделей и контролируя процесс «рассуждений». Для работы с платформой используется интерфейс Copilot, который занимается оркестрацией агентов. Одновременно интерфейс служит и центральным хабом, в котором учёные управляют своей виртуальной ИИ-командой.

Источник изображения: National Cancer Institute/unsplash.com В платформу встроены защитные механизмы — системе заданы «этические координаты». Также применяется модерация контента с проактивным подходом к выявлению злоупотреблений возможностями платформы — маркируются потенциально вредоносные алгоритмы и действия, поскольку все ИИ-инструменты фактически имеют «двойное назначение». С их помощью можно изобретать не только лекарства, но и опасные биологически опасные субстанции. Для своей платформы Microsoft выстраивает экосистему с участием представителей самых разных отраслей, от фармацевтики (GSK) до индустрии красоты (Estée Lauder). NVIDIA интегрирует с Discover микросервисы ALCHEMI и BioNeMo NIM для биотехнологий и фармацевтики. В полупроводниковой сфере Microsoft планирует интеграцию решений Synopsys для ускорения разработки чипов. Адаптацией под конкретные отраслевые задачи, развёртыванием и масштабированием платформы займутся Accenture и Capgemini.

Источник изображения: Microsoft Успех Microsoft Discovery будет зависеть от того, насколько эффективно систему смогут интегрировать в текущие научные процессы — многие учёные скептически относятся к новым методикам, так что компании придётся показать всё, на что способен ИИ. По словам Microsoft, будущее науки именно за сочетанием умственных возможностей человека и масштабного ИИ. Microsoft уже провела предварительную демонстрацию Discovery для ограниченного круга структур. Цены на платформу пока не названы, но доступ к к ней будет организован посредством Azure.

19.05.2025 [19:36], Руслан Авдеев

Microsoft «провалила» облачную реформу в ЕвропеНесмотря на свои обещания, Microsoft всё ещё не создала продукта, удовлетворяющего требованиям соглашения с ассоциацией европейских облачных провайдеров CISPE. В рамках действующей под эгидой CISPE инициативы European Cloud Competition Observatory (ECCO) было решено, что относительно действий компании всё ещё «существуют опасения, хотя предложены меры для исправления», сообщает Datacenter Dynamics. В июле 2024 года Microsoft заключила антимонопольное соглашение с CISPE, утверждавшей, что условия контрактов, предлагаемых компанией, вредят европейскому облачному бизнесу. Чтобы замять скандал, Microsoft заплатила €20 млн ($21,7 млн), а также согласилась разработать специальную версию платформы Azure Stack HCI (Azure Local) для европейских облачных провайдеров, которая позволит участникам CISPE запускать ПО Microsoft на их собственных облачных мощностях по ценам, эквивалентным предлагаемым для Microsoft Azure. Попытки Google «перекупить» мнение участников альянса не увенчались успехом. Дополнительно компания согласилась компенсировать членам CISPE упущенную за последние два года выручку, связанную со стоимостью лицензирования её ПО. Инициативу ECCO учредили для того, чтобы отслеживать динамику выполнения обязательств. В первом отчёте ECCO, опубликованном в феврале 2025 года, компания также получила «янтарный» статус — по мнению альянса, Microsoft «отклонилась от курса», а Azure Local всё ещё не отвечает оговоренным требованиям. Новейший доклад констатирует, что и Microsoft, и CISPE согласны с тем, что Azure Local не обеспечит полного выполнения соглашения. В связи с этим стороны завершили «первую фазу» работ, чтобы приступить к поиску альтернативного решения. До 10 июля Microsoft должна представить новое предложение. Стоит отметить, что недавно Microsoft и сама вступила в CISPE, желая активнее влиять на европейский облачный рынок, а AWS, отчасти в ответ на это, покинула организацию. Кроме того, Microsoft и AWS попали в поле зрения британского регулятора CMA. В группе Open Cloud Coalition (OCC), фактически созданной Google и призванной обеспечить конкуренцию на облачном рынке, заявили, что Microsoft неоднократно ловили за несоблюдением обещаний. В OCC считают, что текущая ситуация ничем не отличается от прошлых, а инициатива ECCO никоим образом не заменит официальное антимонопольное расследование. У заинтересованных компаний и сформированной ими структуры не хватает полномочий, чтобы призвать кого-либо к ответственности, поэтому облачный рынок остро нуждается во вмешательстве регуляторов, поскольку использование ПО Microsoft в сторонних облаках кратно дороже, чем в Azure.

19.05.2025 [14:48], Владимир Мироненко

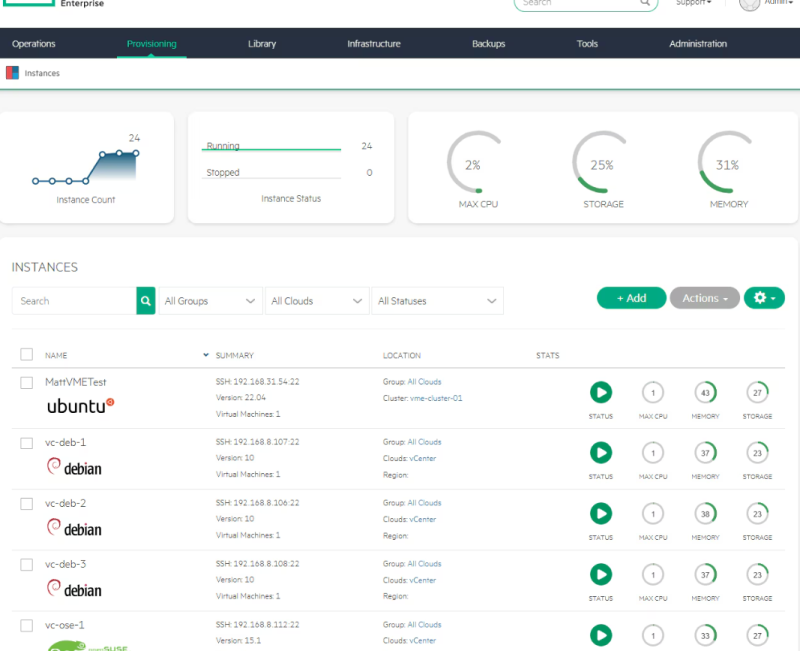

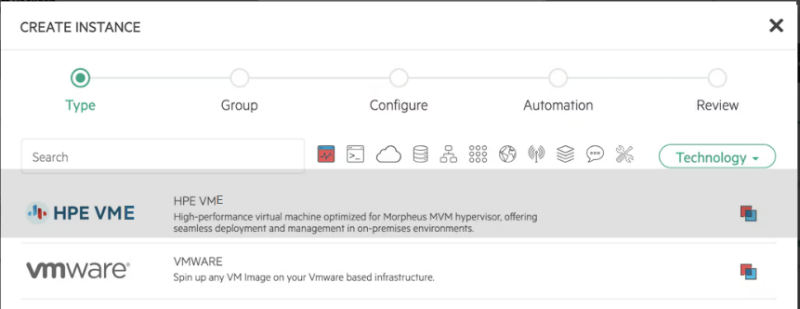

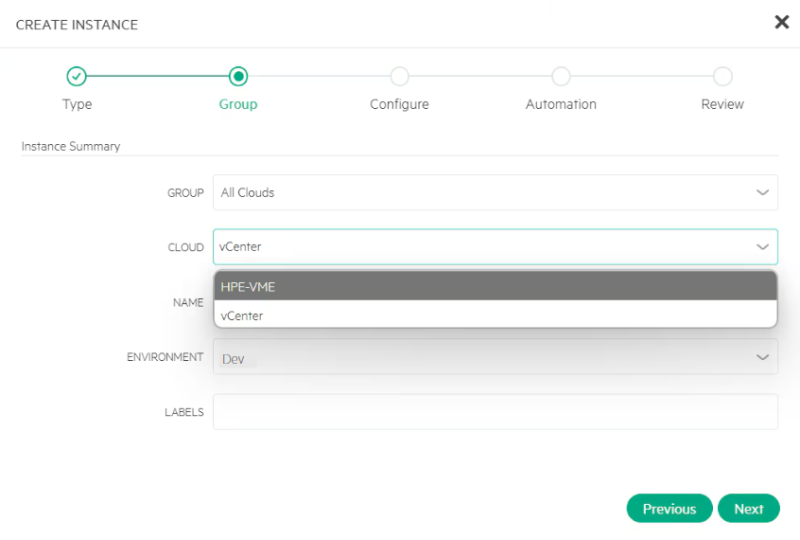

HPE предложила клиентам VMware новые решения с Morpheus VM EssentialsКомпания Hewlett Packard Enterprise (HPE) объявила о новых предложениях, направленных на упрощение модернизации гибридных ИТ-решений, а также повышение киберустойчивости, доступности данных и энергоэффективности для клиентов, использующих хранилища. В августе прошлого года HPE завершила приобретение создателя облачной платформы управления Morpheus Data, который поставлял ПО, используемое в подписных предложениях HPE GreenLake. Компания объединила функции Morpheus со своим собственным предложением виртуализации на основе KVM для создания VM Essentials в стремлении привлечь клиентов VMware, недовольных политикой Broadcom. Решение может работать автономно или на собственных системах HPE и позволяет управлять не только виртуальными машинами HPE, но и традиционными (VMware) ВМ.

Источник изображений: HPE Следующим шагом стало объявление об интеграции HPE Morpheus VM Essentials с HPE Private Cloud Business Edition, что позволяет снизить до 90 % стоимость лицензий на ВМ с поддержкой нескольких гипервизоров и самостоятельным потреблением облачных ресурсов. Эта экономия добавляется к предполагаемому снижению совокупной стоимости владения (TCO) в 2,5 раза, обеспечиваемому дезагрегированной гиперконвергентной инфраструктурой (dHCI). HPE Private Cloud Business Edition, доступная в формате dHCI или HCI, предоставляет организациям гибкость в выборе оптимальной архитектуры для рабочих нагрузок ВМ как на периферии, так и в ЦОД, говорит HPE. Семейство ПО HPE Morpheus, включающее решения HPE Morpheus VM Essentials для виртуализированных рабочих нагрузок и HPE Morpheus Enterprise Software для унифицированного управления облаками, теперь находится в открытом доступе. Обе версии включают гипервизор HVM от HPE и лицензируются по сокетам для снижения совокупной стоимости владения. Клиенты VM Essentials также смогут перейти на полную версию HPE Morpheus Enterprise. Как сообщает компания, решение VM Essentials разработано для глобального развёртывания и поддерживается комплексными корпоративными службами, охватывающими всё, от инфраструктуры до рабочих нагрузок. При этом используется ИИ на всех этапах — от настройки до эксплуатации. С его помощью HPE автоматизирует настройку инфраструктуры и управление жизненным циклом платформы Business Edition. Возможности AIOps позволяют прогнозировать и предотвращать до 86 % операционных проблем, высвобождая ИТ-ресурсы, а также повышая производительность и надежность. Ресурс Blocks & Files отметил, что софт Morpheus Enterprise позволяет ИТ-отделу клиента стать внутренним поставщиком ИТ-услуг. Он имеет графический интерфейс и API, поддерживает подход инфраструктура-как-код или подключаемые модули ITSM, и позволяет управлять как собственными средами KVM и Kubernetes HPE, так и другими приложениями на физическом, локальном и публичном облачных ресурсах. Продукт не зависит от гипервизора, оборудования и облака и интегрируется с окружающими наборами инструментов, такими как ServiceNow, DNS, системами резервного копирования и инструментами оркестрации задач для сквозного управления зависимостями приложений (end-to-end). HPE утверждает, что он ускоряет подготовку нагрузок до 150 раз, сокращает расходы на облако до 30 % и снижает риски за счёт детального управления доступом на основе ролей (RBAC). Commvault станет первым партнером экосистемы VM Essentials, который будет поддерживать резервное копирование и восстановление виртуальных машин на основе образов с предстоящим релизом в мае. Morpheus Enterprise и VM Essentials недавно были протестированы для работы на серверах Dell PowerEdge и массивах NetApp AFF, а также на серверах HPE ProLiant Compute Gen11 и Gen12. По данным HPE, комбинация VM Essentials и HPE Aruba Networking CX 10000 снижает совокупную стоимость владения до 48 %, увеличивает производительность до 10 раз, обеспечивает микросегментацию, ускорение благодаря DPU и повышенную безопасность. VM Essentials также обеспечивает простое, детализированное управление хранилищем HPE Alletra Storage MP B10000. HPE Advisory and Professional Services также теперь предлагает услуги модернизации виртуализации с аналитикой затрат, инструментами миграции, схемами оркестрации и интеграцией конвейера DevOps. HPE Services предоставляет специализированную оценку, комплексный процесс для создания надёжных зон посадки, а также услуги по перенастройке рабочих нагрузок, модернизации инфраструктуры, миграции данных, обучению членов команды и управлению инфраструктурой для снижения накладных расходов. ПО Morpheus Enterprise уже доступно как отдельное ПО и в составе HPE Private Cloud Business Edition с Morpheus VM Essentials. Новые системы Business Edition с HPE SimpliVity будут доступны в III квартале. Интеграция ПО Morpheus для Alletra Storage MP B10000 доступна уже сейчас, для HPE Aruba Networking CX 10000 — в июне. |

|