Материалы по тегу: hardware

|

28.08.2025 [14:01], Руслан Авдеев

NVIDIA жалуется на многомиллиардные потери из-за торговой войны США и КитаяNVIDIA призвала Вашингтон скорее одобрить продажу ускорителей Blackwell в КНР. Призыв прозвучал в ходе финансового отчёта компании за II квартал 2025 года, сообщает The Register. Как говорят в компании, её продукты разрабатываются и продаются для коммерческого использования, и каждая продажа принесёт выгоду американской экономике. Если компании дадут возможность конкурировать по всему миру, её ИИ-стек станет повсеместным стандартом. По мнению главы NVIDIA Дженсена Хуанга (Jensen Huang), только в этом году Китай мог бы обеспечить компании рынок объёмом $50 млрд, если бы она могла удовлетворить спрос конкурентоспособными продуктами. отсутствии H20 китайские компании переходят на подержанные ускорители NVIDIA A100/H100. При этом весьма вероятно, что к слабым моделям покупатели возвращаться не захотят вовсе. Сейчас NVIDIA готовит для Китая более производительный ИИ-ускоритель на архитектуре Blackwell и ожидает разрешение Вашингтона на выдачу экспортных лицензий. Президент США уже давал понять, что он открыт для этой идеи, а Хуанг критиковал запрет на продажи, утверждая, что это только усилит конкурентоспособность Китая. В

Источник изображения: NVIDIA Тем временем NVIDIA ожидает потери времени и денег из-за затормозившихся продаж ослабленного ускорителя H20 в Поднебесной. Кроме того, в компании отмечают, что власти объявили о 15-% «налоге» на продажи ускорителей в КНР, но реальные правовые механизмы для регулирования этого процесса пока отсутствуют. По данным компании, если Вашингтон всё-таки даст «добро», NVIDIA могла бы увеличить выручку ещё на $2–$5 млрд — помимо $54 млрд, которые компания, вероятно, получит в III квартале. Хотя NVIDIA всё ещё не может продать запас H20 в Китае, компании удалось найти другого покупателя, на которого ограничения не распространяются. NVIDIA продала ему соответствующих ускорителей на $650 млн, высвободив благодаря сделке «зарезервированные» $180 млн.

28.08.2025 [13:03], Руслан Авдеев

Китайский бизнес переходит на подержанные ускорители NVIDIA A100 и H100 из-за проблем с поставками H20Китайская ИИ-индустрия постепенно переходит на восстановленные или подержанные ИИ-ускорители NVIDIA A100 и H100 после того, как очередные экспортные ограничения на NVIDIA H20 заставили компании искать альтернативы этому продукту. Искусственно ослабленный ускоритель H20 должен был сохранить присутствие NVIDIA на китайском рынке, но чип фактически «оказался на обочине» даже после того, как на его продажи вновь дали зелёный свет после временного запрета — китайские регуляторы поставили под сомнение его безопасность, сообщает Tom’s Hardware со ссылкой на Digitimes. Всё это привело к стремительному росту спроса на старые модели A100 и H100, китайские компании проводят некую «реконфигурацию» таких ускорителей для использования в недорогих, но высокопроизводительных системах инференса. Последний требует значительно меньше ресурсов, чем обучение ИИ-моделей, рабочие нагрузки могут эффективно выполняться на относительно слабом оборудовании. Именно поэтому даже A100 с 80 Гбайт HBM2e (2 Тбайт/с), представленный ещё в 2020 году, в некоторых случаях остаётся вполне востребованным. Хотя архитектура Ampere уступает Hopper по пиковой производительности, она всё ещё эффективна для инференса благодаря относительно большому объёму памяти и развитой экосистеме ПО CUDA. Для чат-ботов и рекомендательных систем экономически эффективно использовать системы без самых современных чипов. Представленные в 2022 году H100 значительно производительнее A100 в задачах, связанных с обучением. В то же время H20 изначально был оптимизирован для менее ресурсоёмкого инференса, но его возможности урезали так сильно, что производительность в сравнении с H100 у этой модели ниже в 3–7 раз, а в задачах, связанных с вычислениями FP64, он медленнее более чем в 30 раз. Другими словами, даже A100 всё ещё могут быть привлекательнее для китайских покупателей, чем новые H20.

Источник изображения: NVIDIA Поскольку пока никому не удалось создать что-то сопоставимое с программной экосистемой NVIDIA CUDA, старые GPU вполне востребованы. Тем более что оборудование для инференса менее требовательно во всех отношениях, а китайские ЦОД, по-видимому, не испытывают проблем с энергий и готовы платит за восстановленную устаревшую электронику, даже с пониженной надёжностью. В результате NVIDIA оказалась в странном положении. Компания в своё время списала $5,5 млрд из-за нераспроданных запасов H20 — когда в США решили полностью запретить их поставки в Китай. После снятия запрета компания резко нарастила выпуск H20, но теперь столкнулась уже с нежеланием властей КНР видеть эти чипы в стране. Тем не менее, её ускорители по-прежнему являются одним из главных катализаторов бума ИИ в Китае. Другими словами, чипы компании по-прежнему доминируют на рынке Поднебесной, но активность на теневых рынках может снизить выгоду от бизнеса с Китаем. Впрочем, уже появилась информация о разработке нового ускорителя на основе современной архитектуры Blackwell — хотя и тоже ослабленного.

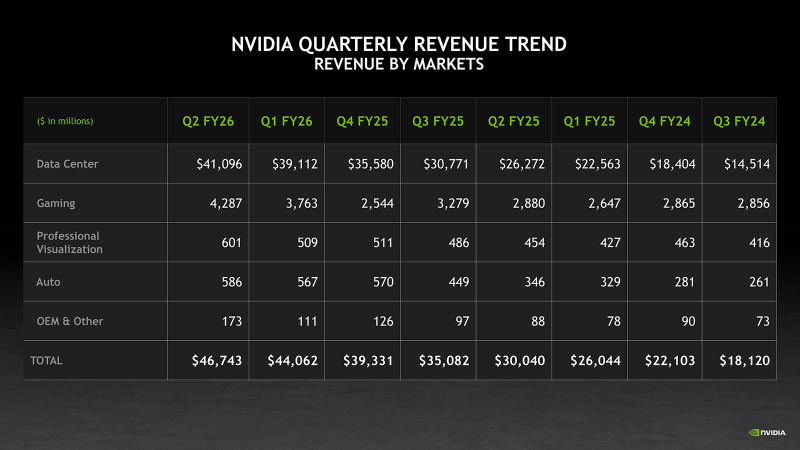

28.08.2025 [12:16], Владимир Мироненко

Рекордные продажи NVIDIA не впечатлили инвесторов из-за слабой выручки в сегменте ЦОД и неопределённости с поставками в КитайNVIDIA сообщила финансовые результаты за II квартал 2026 финансового года, завершившийся 27 июля 2025 года. Прибыль и выручка компании превзошли ожидания аналитиков. Также было заявлено, что рост продаж в III квартале сохранится на уровне выше 50 %, что стало для Уолл-стрит сигналом о том, что спрос на ИИ-инфраструктуру не будет снижаться, пишет ресурс CNBC. Выручка составила $46,74 млрд, что на 6 % больше, чем в предыдущем квартале, и на 56 % больше, чем годом ранее, а также больше прогноза аналитиков, опрошенных LSEG, в размере $46,06 млрд. Скорректированная чистая прибыль (Non-GAAP) составила $25,78 млрд или $1,05 на разводнённую акцию, что выше консенсус-прогноза аналитиков, по данным от LSEG, в размере $1,01 на разводнённую акцию. Несмотря на достигнутые результаты, акции компании упали в ходе расширенных торгов на 2,3 %, поскольку выручка от продуктов для ЦОД второй квартал подряд оказалась ниже прогнозов, составив $41,1 млрд (рост год к году на 56 %) при прогнозе StreetAccount в $41,34 млрд. Как полагает ресурс The Guardian, это также свидетельствует о том, что опасения инвесторов по поводу пузыря ИИ и последствий торговых войн Дональда Трампа (Donald Trump) не утихли. Рост выручки NVIDIA год к году превышает 50 % уже девять кварталов подряд, начиная с середины 2023 года, когда начался бум генеративного ИИ. Однако II квартал был отмечен для NVIDIA самым слабым ростом за этот период. NVIDIA также значительно увеличила чистую прибыль по сравнению с прошлым годом — до $26,42 млрд или $1,08 на разводнённую акцию, что на 59 % больше, чем за аналогичный период прошлого года. В сегменте продуктов для ЦОД выручка от поставки решений для вычислений выросла на 50 % год к году до $33,84 млрд, а выручка от продаж сетевого оборудования выросла за квартал на 98 % до $7,25 млрд. Более половины выручки в этом сегменте принесли крупные клиенты. Выручка от решений с архитектурой Blackwell увеличилась год к году на 17 % до $27 млрд. В прошедшем квартале продажи H20 китайским клиентам не осуществлялись. NVIDIA реализовала из ранее зарезервированных запасов H20 на сумму $180 млн клиентам за пределами Китая. Финансовый директор Колетт Кресс (Colette Kress) заявила, что NVIDIA может получить от $2 до $5 млрд выручки от продажи H20 в Китай в течение квартала, если позволит геополитическая обстановка. По её словам, некоторые компании выразили заинтересованность в приобретении H20, и первая группа компаний уже получила лицензии на его покупку. Гендиректор NVIDIA Дженсен Хуанг (Jensen Huang) подчеркнул важность для компании китайского рынка, продажи на котором, по его словам, могут составить до $50 млрд в этом году. «Мы обсуждаем с администрацией важность того, чтобы американские компании имели возможность работать на китайском рынке», — сказал Хуанг. Он также заявил, что помимо одобрения продаж H20 в Китае компаниям, не подпадающим под санкции, у NVIDIA есть потенциальная возможность в конечном итоге продавать в этой стране версию ускорителя на архитектуре Blackwell. Напомним, что американским компаниям было разрешено продавать чипы в Китай при условии уплаты 15 % экспортной пошлины в госбюджет. Предложенную правительством схему юристы назвали неконституционным злоупотреблением властью. Колетт Кресс дала понять, что отсутствие поставок в Китай в минувшем квартале был вызвано неопределённостью этой схемы, которая официально не закреплена в федеральном законодательстве. «Хотя некоторые наши китайские клиенты получили лицензии за последние несколько недель, — сказала Кресс, — мы не отгружали ни одного ускорителя H20 по этим лицензиям». Что касается других направлений деятельности NVIDIA, то выручка от игрового бизнеса в отчётном квартале выросла на 49 % по сравнению с прошлым годом до $4,29 млрд. Автомобильное и робототехническое подразделение компании увеличило продажи год к году на 69 % до $586 млн. В сегменте профессиональной визуализации продажи выросли на 32 % до $601 млн. NVIDIA прогнозирует выручку в текущем квартале в размере $54 млрд ± 2 %. Компания уточнила, что её прогноз не учитывает поставки H20 в Китай. По данным LSEG, аналитики ожидают выручку в финансовом III квартале в размере $53,1 млрд. Хуанг заявил, что компания ожидает, что к концу десятилетия расходы на ИИ-инфраструктуру составят от $3 до $4 трлн, пишет TechCrunch.

28.08.2025 [09:28], Владимир Мироненко

ASUS Cloud увеличит вычислительные мощности Тайваня на 50 %, построив 250-Пфлопс ИИ-суперкомпьютерASUS Cloud в партнёрстве с Taiwan AI Cloud (Taiwan Web Service Corp) и Национальным центром высокопроизводительных вычислений Тайваня (National Center for High-performance Computing, NCHC) в Тайнане (Тайвань) построит суперкомпьютер на ускорителях NVIDIA. Об этом сообщил гендиректор ASUS Cloud и Taiwan AI Cloud Питер Ву (Peter Wu, на фото ниже) в интервью газете South China Morning Post (SCMP). Питер Ву рассказал, что суперкомпьютер с начальной производительностью 80 Пфлопс (точность не уточняется) будет работать на 1700 ускорителях NVIDIA H200. Его запуск запланирован на декабрь, а со временем производительность новой системы вырастет до 250 Пфлопс. Ранее сообщалось, что NVIDIA также поставит два суперускорителя GB200 NVL72 и узлы HGX B300 для данной машины. По словам Ву, после запуска суперкомпьютера общая вычислительную мощность HPC-систем Тайваня вырастет минимум на 50 %. В феврале 2025 года Национальный совет по науке и технологиям Тайваня (NSTC) объявил о планах по увеличению общей вычислительной мощности систем страны примерно до 1200 Пфлопс к 2029 году с имеющихся 160 Пфлопс. Как отметил DataCenter Dynamics, ASUS ранее сотрудничала с NVIDIA в развёртывании суперкомпьютеров на Тайване, включая 9-Плфопс машину Taiwania 2. В 2022 году ASUS и NVIDIA построили на Тайване суперкомпьютер для медицинских исследований. Taiwan AI Cloud уже реализовала аналогичные нынешнему проекты по созданию ИИ-инфраструктуры в других странах. Среди них — ЦОД в Сингапуре, а также объект во Вьетнаме с 200 ускорителями NVIDIA, который строят для государственного оператора Viettel. Этот проект стартовал в начале 2025 года после того, как правительство США одобрило поставку чипов NVIDIA. Ву отметил рост популярности агентного ИИ. Министерство цифровых технологий острова (MODA) «рекомендовало нам предоставить открытую архитектуру с фреймворком агентного ИИ», чтобы помочь местным компаниям использовать или модернизировать свои существующие приложения, сказал он. Говоря о материковом Китае, Питер Ву заявил, что компании будет «непросто» реализовывать там аналогичные проекты «из-за ситуации с поставками GPU». Китайский подход, заключающийся в «стекировании и кластеризации» малопроизводительных чипов для достижения производительности, аналогичной системам с передовыми ИИ-ускорителями, может быть осуществим с точки зрения инференса. Ву отметил, что запуск DeepSeek «рассуждающей» модели R1 в январе спровоцировал рост спроса на инференс, поскольку эта модель превосходно справляется с такими задачами. «Если рабочая нагрузка аналогична [инференсу], будет легче внедрить альтернативную технологическую схему с существующими [чипами]», — сказал Ву, добавив, что разработчики «могут столкнуться с проблемами в выборе GPU», если проект предполагает обучение или тонкую настройку ИИ-систем. Говоря о будущем, Ву сообщил, что ожидает дальнейшего развития трёх сегментов ИИ в будущем: вычислительной геномики, квантовых вычислений и так называемых цифровых двойников. «Приложение-убийца [для цифровых двойников] может появиться в сфере ухода за пожилыми людьми, помогая им получать лекарства, еду или принимать душ», — прогнозирует Ву.

28.08.2025 [01:20], Владимир Мироненко

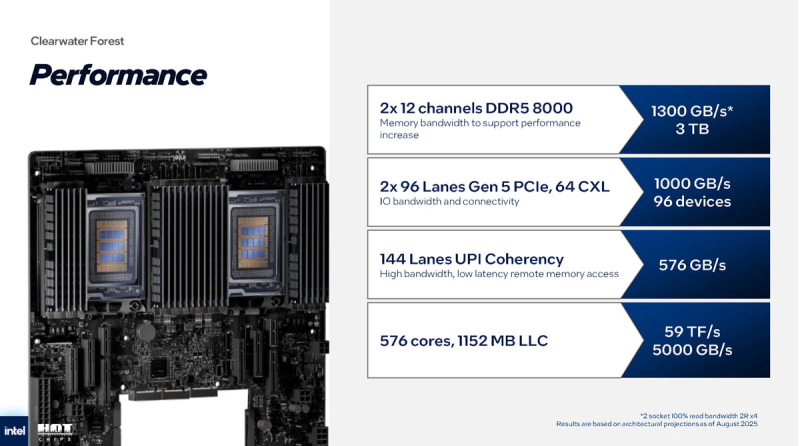

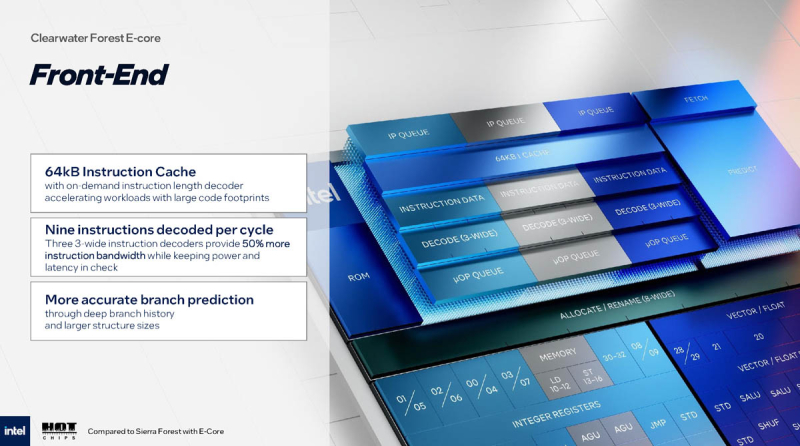

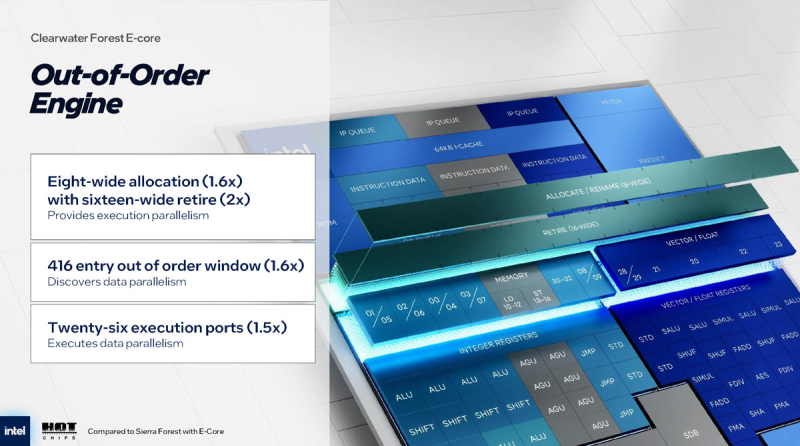

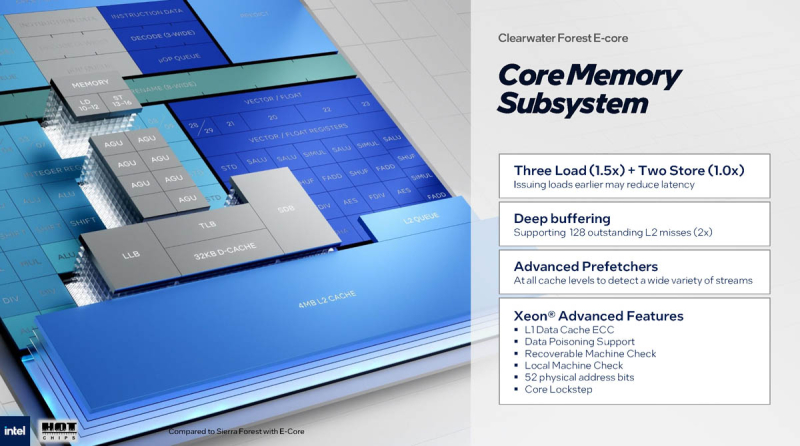

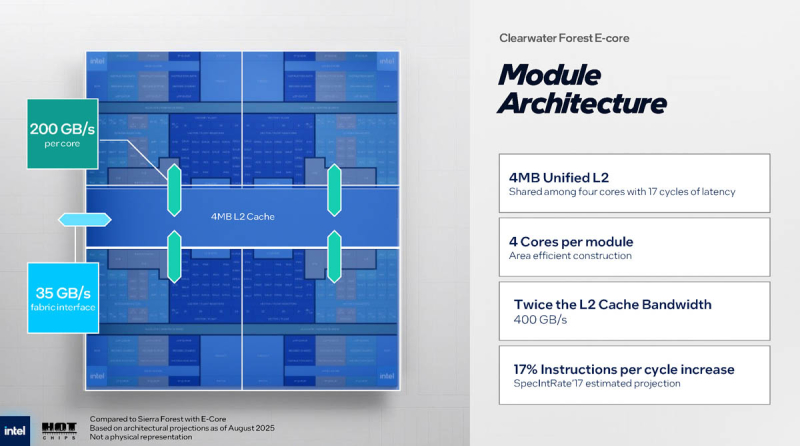

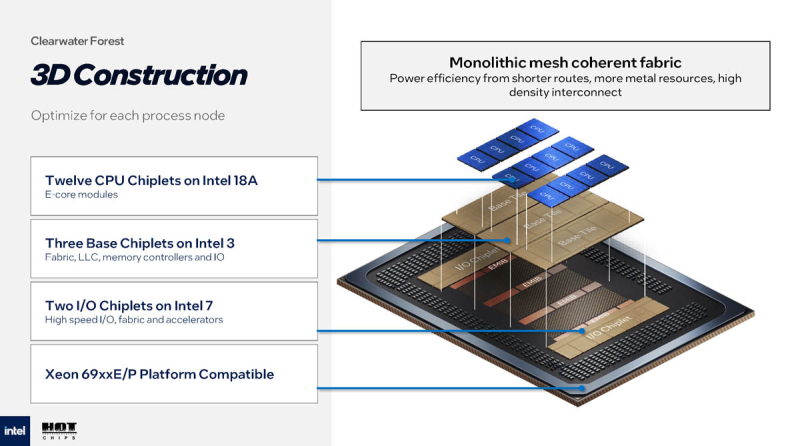

288 E-ядер и 576 Мбайт L3-кеша: Intel поделилась подробностями о Xeon 7 Clearwater ForestIntel сообщила подробности о новом поколении серверных процессоров Xeon 7 с кодовым названием Clearwater Forest, выполненных по техпроцессу Intel 18A с использованием технологии 3D-упаковки. Сообщается, что новые процессоры представляет собой значительный шаг вперёд по сравнению с предыдущим поколением Sierra Forest, предлагая увеличенный объём кеша, более быстрые энергоэффективные ядра (E-Core) и более высокую пропускную способность памяти. Как отметил ресурс ServeTheHome, использование только ядер E-Core делает Clearwater Forest ориентированным на рабочие нагрузки, требующие выполнения множества потоков с высокой энергоэффективностью, но не обязательно требующие максимально возможной производительности в однопоточном режиме, что характерно для массивных задач виртуализации. Чипы Xeon 6900E (Sierra Forrest-AP) тоже были ориентированы на гиперскейлеров и облака, но популярности не снискали. Это один из первых чипов, созданных по техпроцессу Intel 18A, который обеспечивает значительный скачок энергоэффективности, а также улучшение архитектуры ядра. Также важным фактором является переход на 3D-стекирование кристаллов, реализованное с помощью Foveros Direct 3D. Именно проблемы с техпроцессом и упаковкой вынудили компанию перенести запуск чипов на 2026 год. По словам Intel, в Clearwater Forest в рамках архитектуры Darkmont, которая является обновлением Sierra Glen E-Core, задействованной в Sierra Forest, используется девятипоточное декодирование (вместо шестипоточного в Sierra Forest) с помощью трёх трёхпоточных декодеров. Также был улучшен механизм предсказания ветвлений, чтобы соответствовать более широкому окну и повысить общую точность. Объём L1-кеша инструкций составляет 64 Кбайт на ядро. Что касается бэкэнда, то возможность отправки операций вне очереди увеличилась с 5 до 8. В общей сложности за такт можно выполнить 16 операций, что вдвое больше, чем у Sierra Forest. Система OOE (Out-of-Order Engine) также обновлена. Теперь возможно передавать в планировщик (или в буфер переупорядочивания) 8 инструкций за такт (+60 %) и завершать исполнение до 16 операций за такт (вдвое больше). Количество целочисленных и векторных вычислительных блоков увеличено вдвое, количество блоков генерации адресов загрузки — в полтора раза, а количество блоков генерации адресов сохранения — в два раза. Размер буфера внеочередного исполнения увеличен на 60 % до 416 блоков. Количество портов исполнения также значительно увеличилось — до 26, и это несмотря на небольшой показатель эффективности ядра. Подсистема памяти ядра теперь может выполнять три загрузки (1,5x) и два сохранения (без изменений) за раз. Более ранняя отдача от операций загрузки может помочь снизить задержку. Глубокая буферизация поддерживает до 128 промахов L2 (увеличение в два раза). Общее увеличение IPC составляет 17 % согласно тесту SpecIntRate17. Сообщается, что в Clearwater Forest также реализованы усовершенствованные предвыборки на всех уровнях кеша, а список специфических функций Xeon E-Core включает:

Один модуль Clearwater Forest состоит из четырёх ядер со совместным доступом к 4 Мбайт общего L2-кеша, как и в Sierra Forest. Пропускная способность L2-кеша до 400 Гбайт/с. Каждое ядро может общаться с L2-кешем на скорости 200 Гбайт/с, тогда как между модулями реализован интерконнект с пропускной способностью 35 Гбайт/с. 72 модуля формируют 288 ядер + 576 Мбайт общего L3-кеша. Всего на чип приходится 12 каналов памяти DDR5-8000 (о MRDIMM речи нет) для модулей общей ёмкостью 1,5 Тбайт. В отличие от Sierra Forest, основанного на 2,5D-дизайне, а Clearwater Forest используется 3D-дизайн с чиплетами CPU, расположенными поверх более крупных базовых тайлов, вместе с остальными компонентами. Конфигурация Clearwater Forest включает 12 чиплетов E-Core (Intel 18A), 3 базовых тайла (Intel 3) и 2 чиплета I/O (Intel 7). Для межкристальных соединений используется EMIB. I/O-подсистема включает 96 линий PCIe 5.0, из которых 64 могут работать с CXL. По словам компании, двухсокетная система на базе Clearwater Forest предлагает 576 ядер с 1152 Мбайт L3-кеша, 144 линии UPI (576 Гбайт/с), до 3 Тбайт RAM (чтение до 1300 Гбайт/с). Intel утверждает, что стойки на базе Clearwater Forest могут обеспечить с предыдущим поколением чипа 3,5-кратный прирост производительности на Вт. У AMD же есть 192-ядерные Turin Dense с ядрами Zen 5c с 384 Мбайт L3-кеша, 12 каналами DDR5-6000, 128 линиями PCIe 5.0 (64 CXL; до 160 линий в двухсокетной платформе), а также поддержкой SMT и AVX-512.

27.08.2025 [15:17], Руслан Авдеев

Малайзия анонсировала первый собственный ИИ-ускоритель SkyeChip MARS1000Малайзия анонсировала собственный 7-нм ИИ-ускоритель SkyeChip MARS1000, сообщает Bloomberg. Новый чип — первый в стране ускоритель для периферийных ИИ-вычислений. По данным Ассоциации полупроводниковой промышленности Малайзии (Malaysia Semiconductor Industry Association) этот компонент будет применяться в самых разных устройствах от автомобилей до роботов. Чип для периферийных ИИ-вычислений намного слабее, чем передовые решения компаний вроде NVIDIA, которые стоят за работой ИИ ЦОД, обучением больших ИИ-моделей и др. Тем не менее это ключевой шаг на пути создания передовых технологий в соответствующей сфере. Пока нет данных, где именно будет производиться ускоритель. Малайзия давно стремится стать более значимым игроком в мировой цепочке поставок полупроводников, получая выгоду от бума ИИ. Страна уже давно стала ключевым игроком в области упаковки чипов и является производственным хабом для множества поставщиков IT-оборудования. Местные власти поставили долговременную задачу по развитию разработки микросхем, производства полупроводниковых пластин и строительству дата-центров. Правительство обязалось потратить на рост значимости Малайзии в глобальной цепочке «создания стоимости» не менее RM25 млрд ($6 млрд). Попутно Малайзия стремится стать региональным IT-хабом на фоне дефицита мощностей и площадей в соседнем Сингапуре. Правда, усилия осложняются позицией руководства США, которое предложило ограничить поставки ИИ-полупроводников в Малайзию и Таиланд, подозревая, что контрабандисты будут использовать эти страны как перевалочные базы для перепродажи ИИ-ускорителей в государства, находящиеся под западными санкциями — в первую очередь, в Китай. Недавно Малайзия приняла меры по ужесточению реэкспорта ИИ-ускорителей, в которых применяются американские технологии. Власти заявили, что «не потерпят» использования своего государства для незаконной (с точки зрения США) торговли. Не так давно они уже объявляли, что китайская Huawei якобы обеспечит создание суверенной ИИ-инфраструктуры в стране, но вскоре новость была опровергнута на высшем уровне, по мнению экспертов — под давлением Соединённых Штатов.

27.08.2025 [13:31], Руслан Авдеев

Humain начала строительство двух ИИ ЦОД в Саудовской АравииИИ-стартап Humain, за которым стоит правительство Саудовской Аравии, начал строительство своих двух первых дата-центров в стране. Ускорители и другое оборудование будет закупаться в США, сообщает Bloomberg. Один ЦОД будет расположен Эр-Рияде (Riyadh), второй — в восточной провинции Даммам (Dammam). Первая очередь — по 100 МВт на каждый кампус — заработает в 2026 году. Фонд Humain Ventures на $10 млрд заработал этим летом и уже начал выделять инвестиции. Пока Humain находится в процессе закупки полупроводников у американских производителей, включая NVIDIA. Саудовская компания получила одобрение регуляторов США на покупку 18 тыс. новейших ускорителей NVIDIA (по некоторым данным — GB300). Помимо этих ускорителей, вопрос с которыми уже практически решён, речь идёт о ещё «сотнях тысяч». Компания также заключила сделку с AWS на $5 млрд для создания кластера AI Zone, а также сделку с AMD по созданию ИИ-инфраструктуры на 500 МВт. Глава компании Тарэк Амин (Tareq Amin) в ходе мероприятия, посвящённого запуску чат-бота Humain, отметил, что успех этих планов зависит от соблюдения правил управления, протоколов и одобрения правительства США — формальности, через которые Humain намерена пройти в ближайшее время.

Источник изображения: Matteo Di Iorio/unsplash.com Хотя Амин отказался назвать точные сроки реализации планов компании, его комментарии свидетельствуют, что Саудовская Аравия активно добивается импорта ИИ-чипов. Визит президента США Дональда Трампа (Donald Trump) в мае 2025 года в Эр-Рияд в рамках первого крупного зарубежного турне второго срока стал ключевым событием, открывшим королевству расширенный доступ к передовым полупроводникам от компаний вроде NVIDIA и AMD. Humain принадлежит саудовскому суверенному фонду благосостояния и основана лишь в мае 2025 года. Местные власти рассчитывают превратить страну в региональную ИИ-сверхдержаву, строя в регионе дата-центры, ИИ-инфраструктуру и облачные мощности. Humain намерена добавить к 2030 году ЦОД общей мощностью 1,9 ГВт, а в течение 10 лет — 6,6 ГВт, сообщает Datacenter Dynamics. Компания уже имеет партнёрские связи с калифорнийской Groq для обеспечения работы чат-бота Humain Chat и прочей ИИ-инфраструктуры. Humain Chat пока доступен только в Саудовской Аравии, но в октябре должен заработать и в других странах Ближнего Востока. Саудовская компания также является партнёром AMD, совместное предприятие является частью подписанной ранее сделки на $10 млрд. В рамках партнёрства AMD, вероятно, получит долю в специальном инвестиционном фонде, создаваемом в Саудовской Аравии. Humain заключила меморандум о взаимопонимании с Qualcomm, на ранней стадии находятся переговоры со стартапом xAI о возможном строительстве ЦОД в Саудовской Аравии.

27.08.2025 [12:51], Руслан Авдеев

Проект одного из крупнейших в мире ЦОД Project Sale оказался под угрозой срываЖители округа Ковета (Coweta) в Джорджии (США) взбунтовались против строительства крупного кампуса ЦОД за $17 млрд в рамках инициативы Project Sale. Представитель округа уже заявил, что власти решили ввести мораторий на строительство дата-центров, пока собираются дополнительные данные, сообщает The Register. По данным DeSmog, лоббисты сектора ЦОД предприняли усилия, направленные на ослабление экологических норм в строительных регламентах. Согласно исследованию DeSmog, они добились удаления ключевых положений, в частности тех, которые касались обязательной оценки воздействия на окружающую среду, тогда как местные жители добиваются ужесточения контроля уровня шума, уровня загрязнения воздуха, а также ограничений на строительство таких объектов в сельской местности. Представитель округа заявил, что местный совет активно разрабатывает проект нормативного акта, который будет регулировать процесс планирования и строительства дата-центров. Для местных властей возведение ЦОД — сравнительно новый способ освоения земель, которому не уделяется достаточного внимания в правилах зонирования. Поскольку интерес к дата-центрам в стране растёт, необходимо удостовериться, что такие объекты не только поддерживают экономический рост на местах, но служат и долговременным интересам сообщества. Мораторий обеспечит достаточно времени, чтобы получить обратную связь от участников проекта, изучить, как схожие проблемы решают в других округах, и сформировать информированное решение.

Источник изображения: Elena Ivanov/unsplash.com Активисты из группы Stop Project Sail утверждают, что в случае Project Sail речь идёт о создании одного из четырёх крупнейших кампусов ЦОД на планете. На площади 336 га планировалось возвести 13 крупных объектов, которым потребуется 900 МВт энергии и более 34 тыс. м3 воды в день. Помимо прочего, это потребует обновления местной энергетической инфраструктуры, и жители опасаются, что это приведёт к увеличению счетов или налогов. Площадка была куплена специалистом по промышленной недвижимости Prologis, а Atlas Development выступает якорным арендатором. Авторы проекта сократили количество запланированных объектов с 13 до 9 и пояснили, что место для ЦОД выбрано из-за близости к действующим линиям электропередачи. Также заявляется о будущем создании рабочих мест, инвестициях в местные дороги, экстренные службы и школы. По словам экспертов IDC, при строительстве большинства дата-центров не возникает значимых проблем, но с ЦОД гиперскейл-уровня вроде Project Sail дело обстоит иначе. Кроме того, не секрет, что ЦОД обычно создают не особенно много рабочих мест после ввода в эксплуатацию. По некоторым данным, даже в крупнейших дата-центрах обычно работает менее 150 постоянных сотрудников, а некоторым хватает и 25 человек. Новый проект — не первый, столкнувшийся с противодействием местных активистов. Например, в июне подали в суд на xAI за использование газовых турбин для суперкомпьютера Colossus.

27.08.2025 [09:25], Руслан Авдеев

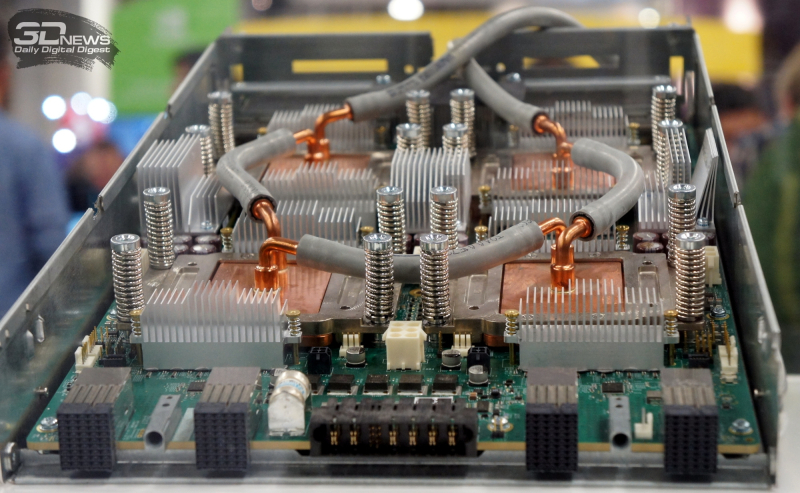

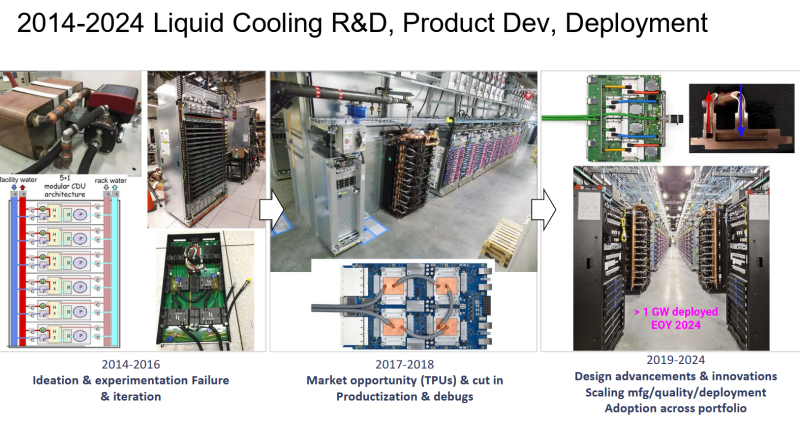

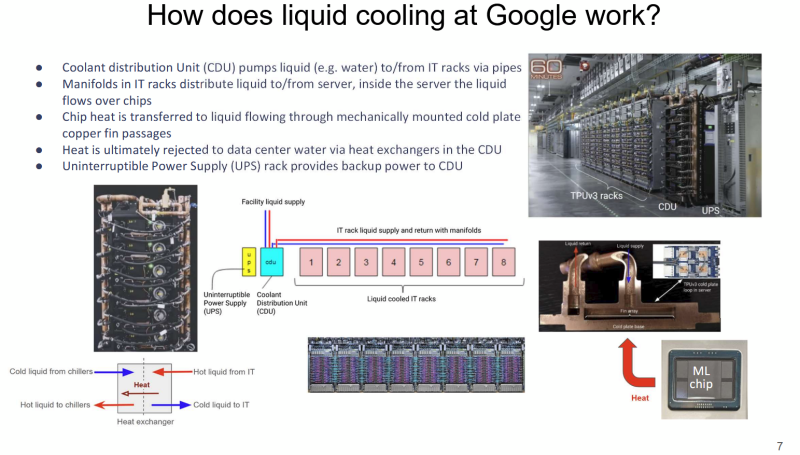

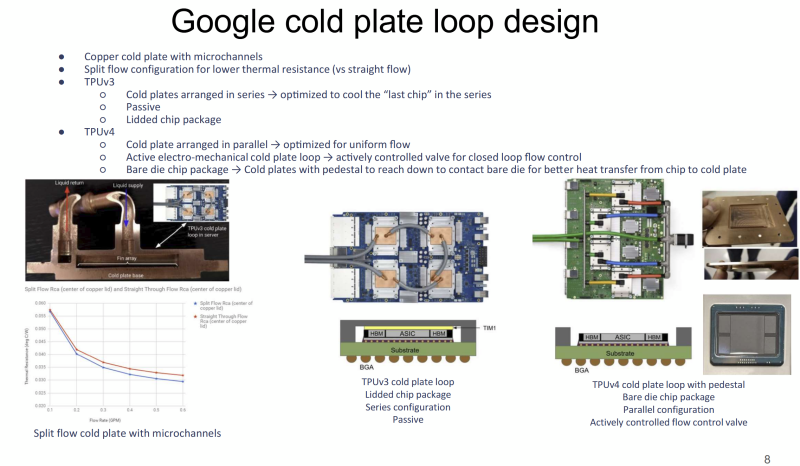

Большому ИИ — большую СЖО: Google рассказала о системе охлаждения TPUЖидкостное охлаждение (СЖО) в ЦОД применяется давно, хотя и не повсеместно. В последнее время оно играет всё более важную роль на фоне роста энергопотребления и тепловыделения ИИ-оборудования. Google рассказала об эволюции охлаждении на уровне дата-центров для своих ИИ-ускорителей TPU, сообщает Chips and Cheese. Google впервые оснастила свои TPU жидкостным охлаждением ещё в 2018 году после ряда экспериментов, и с тех пор совершенствует СЖО. Текущие решения предназначены именно для масштабов ЦОД. Так, стойки с шестью (5+1) блоками распределения жидкости (CDU) обслуживают до восьми стоек с TPU. Применяются гибкие шланги и быстроразъёмные соединения для удобства обслуживания. Во внутреннем контуре чипы в контуре соединены последовательно, что приводит к прогреву теплоносителя, поэтому расчёт охлаждающей мощности ведётся по самому горячему чипу в конце каждого контура. От CDU через теплообменники тепло передаётся в общую систему водоснабжения объекта без смешения жидкостей (в обоих контурах вода). По данным Google, энергопотребление насосов СЖО составляет менее 5 % от мощности вентиляторов, необходимых для воздушного охлаждения. Google применяет водоблок с разделённым потоком жидкости. Для охлаждения TPUv4 применялась система охлаждения открытого кристалла (bare-die). Способ не вполне безопасен, но с случае с TPUv4 такой подход необходим, поскольку такие ускорители потребляют в 1,6 раз больше энергии, чем TPUv3. Кроме того, компании пришлось поработать над проблемами протечек и появления микроорганизмов. Google тщательно проверяет компоненты на герметичность, использует специальные системы оповещения об утечках и проводит плановое обслуживание и фильтрацию. Дополнительно у компании есть набор протоколов реагирования на проблемы и оповещения, что позволяет оперативно устранять угрозы, которые в масштабах ЦОД могут быть весьма существенными. В мае сообщалось, что Google готовит мегаваттные стойки. Строго говоря, компания уже начала использовать 416 В AC на входе в стойки и DC-конвертеры, а также оснащать их встроенными ИБП. Кроме того, она динамически управляет энергопотреблением и производительностью как отдельных TPU, так и стоек в целом.

27.08.2025 [08:58], Руслан Авдеев

Южнокорейские энергетики помогут AWS и X-energy развернуть в США сеть малых модульных реакторов для ИИ ЦОДAmazon (AWS) и разработчик малых модульных реакторов (SMR) X-energy заключили соглашения о партнёрстве с южнокорейскими Korea Hydro & Nuclear Power и Doosan Enerbility с целью развёртывания в США более 5 ГВт атомных мощностей на базе SMR Xe-100 к 2039 году — в первую очередь для удовлетворения потребностей ЦОД в электричестве, сообщает Datacenter Dynamics. Компании намерены привлечь до $50 млрд государственных и частных инвестиций для постройки Xe-100 и расширения цепочек поставок. В X-energy заявляют, что партнёрство объединяет южнокорейские энергетические и атомные технологии с передовыми реакторными и топливными технологиями X-energy, чтобы решить «историческую» энергетическую задачу, ускорив вывод Xe-100 на рынок. Утверждается, что сотрудничество США и Южной Кореи в этом секторе жизненно важно для сохранения лидерства США в гонке за ИИ. Соглашение будет способствовать более тесному сотрудничеству между ядерными секторами Южной Кореи и США, с опорой на существующие отношения X-energy. В частности, предусмотрено сотрудничество в сфере проектирования реакторов, развития цепочек поставок, планирования строительных проектов, в сфере инвестиционных стратегий и долгосрочной эксплуатации реакторов для комбинации атомных и ИИ-проектов. В AWS подчёркивают, что потребности ИИ ЦОД в электроэнергии растут, поэтому новое партнёрство позволит развить инновационные безуглеродные решения и технологии в этой сфере, что поможет получить США более 5 ГВт новых генерирующих мощностей.

Источник изображения: X-energy Xe-100 представляет собой высокотемпературный газовый реактор, использующий топливные элементы размером с бильярдный шар, каждый из которых содержит тысячи фрагментов уранового топлива. Реактор будет вырабатывать 80 МВт электрической и 200 МВт тепловой энергии. В феврале X-energy завершила раунд финансирования серии C-1, аккумулировав $700 млн. Средства потратят на завершение проектирования и лицензирования SMR, строительство первой очереди завода по производству топлива TRISO-X в США, а также на проекты, в которых предполагается использовать SMR X-energy. В прошлом году Amazon уже объявила о партнёрстве с X-energy и инвестициях в стартап. В рамках соглашения с Amazon будет поставлено четыре SMR консорциуму государственных коммунальных предприятий Energy Northwest. Ожидается, что реакторы станут генерировать порядка 320 МВт на начальном этапе, но с возможностью увеличения общей мощности до 960 МВт. Ввод в эксплуатацию первых мощностей запланирован на начало 2030-х гг. На днях также стало известно, что американская TerraPower поможет SK Group сформировать в Южной Корее экосистему малых модульных реакторов. Ранее в августе поддерживаемая Google компания Kairos Power подписала соглашение о покупке 50 МВт электроэнергии с Tennessee Valley Authority (TVA) для поставок электричества в дата-центры Google. А Equinix подписала три крупных соглашения с передовыми разработчиками атомных реакторов на поставку до 774 МВт электроэнергии. Кроме того, за последний год Data4, Oracle, Switch и Endeavour также подписали соглашения с разработчиками SMR. |

|