Материалы по тегу: hardware

|

27.08.2025 [09:25], Руслан Авдеев

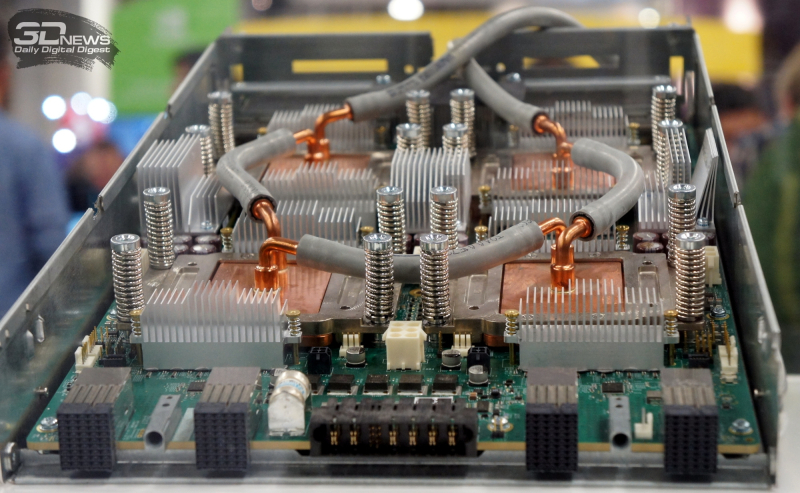

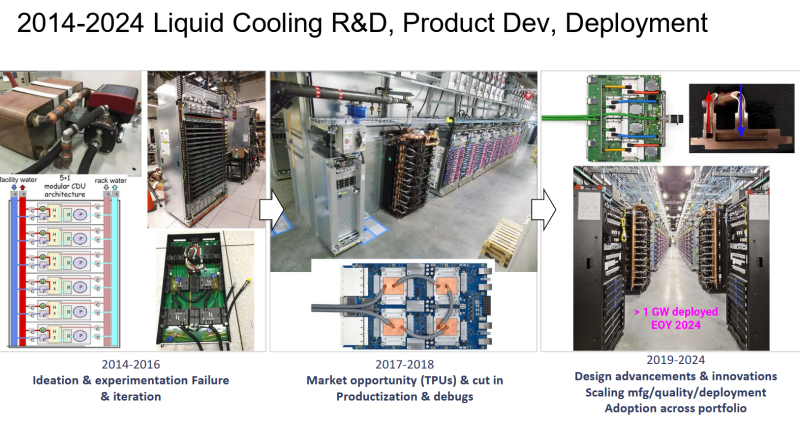

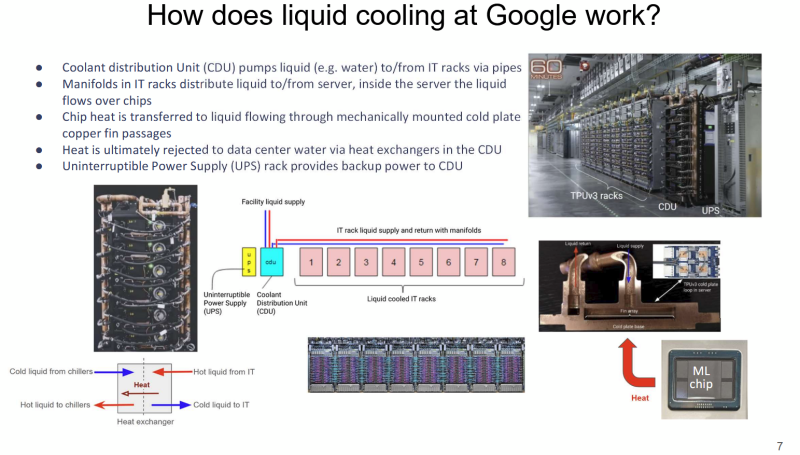

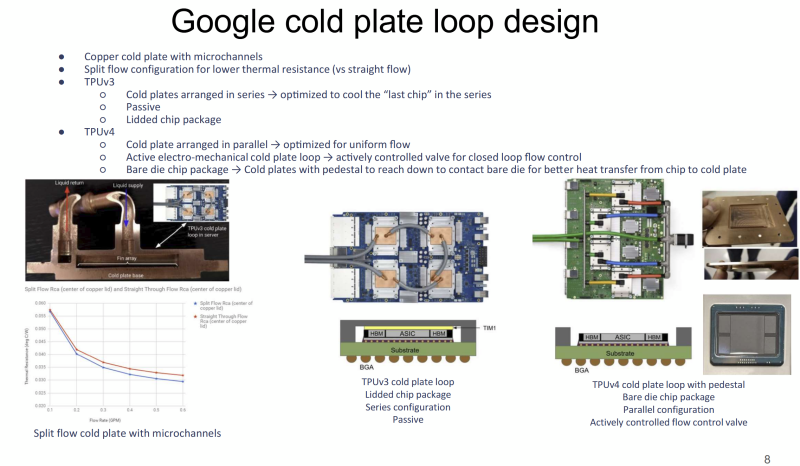

Большому ИИ — большую СЖО: Google рассказала о системе охлаждения TPUЖидкостное охлаждение (СЖО) в ЦОД применяется давно, хотя и не повсеместно. В последнее время оно играет всё более важную роль на фоне роста энергопотребления и тепловыделения ИИ-оборудования. Google рассказала об эволюции охлаждении на уровне дата-центров для своих ИИ-ускорителей TPU, сообщает Chips and Cheese. Google впервые оснастила свои TPU жидкостным охлаждением ещё в 2018 году после ряда экспериментов, и с тех пор совершенствует СЖО. Текущие решения предназначены именно для масштабов ЦОД. Так, стойки с шестью (5+1) блоками распределения жидкости (CDU) обслуживают до восьми стоек с TPU. Применяются гибкие шланги и быстроразъёмные соединения для удобства обслуживания. Во внутреннем контуре чипы в контуре соединены последовательно, что приводит к прогреву теплоносителя, поэтому расчёт охлаждающей мощности ведётся по самому горячему чипу в конце каждого контура. От CDU через теплообменники тепло передаётся в общую систему водоснабжения объекта без смешения жидкостей (в обоих контурах вода). По данным Google, энергопотребление насосов СЖО составляет менее 5 % от мощности вентиляторов, необходимых для воздушного охлаждения. Google применяет водоблок с разделённым потоком жидкости. Для охлаждения TPUv4 применялась система охлаждения открытого кристалла (bare-die). Способ не вполне безопасен, но с случае с TPUv4 такой подход необходим, поскольку такие ускорители потребляют в 1,6 раз больше энергии, чем TPUv3. Кроме того, компании пришлось поработать над проблемами протечек и появления микроорганизмов. Google тщательно проверяет компоненты на герметичность, использует специальные системы оповещения об утечках и проводит плановое обслуживание и фильтрацию. Дополнительно у компании есть набор протоколов реагирования на проблемы и оповещения, что позволяет оперативно устранять угрозы, которые в масштабах ЦОД могут быть весьма существенными. В мае сообщалось, что Google готовит мегаваттные стойки. Строго говоря, компания уже начала использовать 416 В AC на входе в стойки и DC-конвертеры, а также оснащать их встроенными ИБП. Кроме того, она динамически управляет энергопотреблением и производительностью как отдельных TPU, так и стоек в целом.

27.08.2025 [08:58], Руслан Авдеев

Южнокорейские энергетики помогут AWS и X-energy развернуть в США сеть малых модульных реакторов для ИИ ЦОДAmazon (AWS) и разработчик малых модульных реакторов (SMR) X-energy заключили соглашения о партнёрстве с южнокорейскими Korea Hydro & Nuclear Power и Doosan Enerbility с целью развёртывания в США более 5 ГВт атомных мощностей на базе SMR Xe-100 к 2039 году — в первую очередь для удовлетворения потребностей ЦОД в электричестве, сообщает Datacenter Dynamics. Компании намерены привлечь до $50 млрд государственных и частных инвестиций для постройки Xe-100 и расширения цепочек поставок. В X-energy заявляют, что партнёрство объединяет южнокорейские энергетические и атомные технологии с передовыми реакторными и топливными технологиями X-energy, чтобы решить «историческую» энергетическую задачу, ускорив вывод Xe-100 на рынок. Утверждается, что сотрудничество США и Южной Кореи в этом секторе жизненно важно для сохранения лидерства США в гонке за ИИ. Соглашение будет способствовать более тесному сотрудничеству между ядерными секторами Южной Кореи и США, с опорой на существующие отношения X-energy. В частности, предусмотрено сотрудничество в сфере проектирования реакторов, развития цепочек поставок, планирования строительных проектов, в сфере инвестиционных стратегий и долгосрочной эксплуатации реакторов для комбинации атомных и ИИ-проектов. В AWS подчёркивают, что потребности ИИ ЦОД в электроэнергии растут, поэтому новое партнёрство позволит развить инновационные безуглеродные решения и технологии в этой сфере, что поможет получить США более 5 ГВт новых генерирующих мощностей.

Источник изображения: X-energy Xe-100 представляет собой высокотемпературный газовый реактор, использующий топливные элементы размером с бильярдный шар, каждый из которых содержит тысячи фрагментов уранового топлива. Реактор будет вырабатывать 80 МВт электрической и 200 МВт тепловой энергии. В феврале X-energy завершила раунд финансирования серии C-1, аккумулировав $700 млн. Средства потратят на завершение проектирования и лицензирования SMR, строительство первой очереди завода по производству топлива TRISO-X в США, а также на проекты, в которых предполагается использовать SMR X-energy. В прошлом году Amazon уже объявила о партнёрстве с X-energy и инвестициях в стартап. В рамках соглашения с Amazon будет поставлено четыре SMR консорциуму государственных коммунальных предприятий Energy Northwest. Ожидается, что реакторы станут генерировать порядка 320 МВт на начальном этапе, но с возможностью увеличения общей мощности до 960 МВт. Ввод в эксплуатацию первых мощностей запланирован на начало 2030-х гг. На днях также стало известно, что американская TerraPower поможет SK Group сформировать в Южной Корее экосистему малых модульных реакторов. Ранее в августе поддерживаемая Google компания Kairos Power подписала соглашение о покупке 50 МВт электроэнергии с Tennessee Valley Authority (TVA) для поставок электричества в дата-центры Google. А Equinix подписала три крупных соглашения с передовыми разработчиками атомных реакторов на поставку до 774 МВт электроэнергии. Кроме того, за последний год Data4, Oracle, Switch и Endeavour также подписали соглашения с разработчиками SMR.

26.08.2025 [22:13], Руслан Авдеев

IBM и AMD займутся разработкой новых вычислительных архитектур на стыке квантовых и классических подходовAMD и IBM анонсировали разработку нового поколения вычислительных архитектур, в основе которых лежат квантовые компьютеры и HPC-системы. Речь идёт о т.н. «квантово-центричных супервычислениях», сообщает пресс-служба AMD. Команды намерены продемонстрировать первые результаты до конца текущего года. Компании сотрудничают над разработкой масштабируемых, open source платформ, способствующих переосмыслению будущего вычислений с использованием лидерства IBM в сфере квантовых компьютеров и ПО для них, а также ведущей роли AMD в сфере HPC и ИИ-ускорителей. По словам главы IBM Арвинда Кришны (Arvind Krishna), квантовые вычисления со временем позволят «симулировать» реальный мир и представлять информацию принципиально новым способом. Комбинация технологий IBM и AMD позволят построить мощную гибридную модель, оставляющую позади традиционные вычисления. В новой архитектуре квантовые компьютеры будут работать в тандеме с HPC-кластерами и ИИ-инфраструктурой с использованием CPU, ИИ-ускорителей и прочих вычислительных модулей. При таком гибридном подходе различные части задачи решаются оптимальным для них типом оборудования. Например, в будущем квантовые компьютеры смогут моделировать поведение атомов и молекул, а классические ИИ-суперкомпьютеры — анализировать большие массивы данных. Вместе эти технологии смогут решать реальные задачи в беспрецедентном масштабе и с беспрецедентной скоростью, говорят компании.

Источник изображения: Yue WU/unsplash.com Компании изучают способы интеграции CPU, FPGA и ИИ-ускорителей AMD с квантовыми компьютерами IBM для совместного ускорения выполнения принципиально новых алгоритмов. Ключевым планом сотрудничества является разработка систем коррекции ошибок, что является важнейшим шагом на пути к созданию отказоустойчивых квантовых компьютеров, которые IBM планирует выпустить к 2030 году. Также компании планируют изучить, как именно open source решения вроде Qiskit могли бы выступить катализаторами развития и внедрения новых алгоритмов, использующих квантово-центричные супервычисления. IBM уже начала работать в направлении интеграции квантовых и традиционных систем. Недавно она заключила соглашение с японским НИИ RIKEN о подключении своего модульного квантового компьютера IBM Quantum System Two к одному из самых быстрых суперкомпьютеров мира Fugaku. Суперкомпьютеры Frontier в Ок-Риджской национальной лаборатории (ORNL) и El Capitan в Ливерморской национальной лаборатории (LLNL) полагаются на CPU и ускорители AMD. Другими словами, на чипах AMD работают два из быстрейших суперкомпьютеров из мирового рейтинга TOP500.

26.08.2025 [14:40], Руслан Авдеев

Не дадут в Серверной Вирджинии — построим рядом: Oasis Digital Properties получила разрешение на ЦОД мощностью 1,2 ГВтКомпания Oasis Digital Properties получила разрешение властей округа Кинг-Джордж (King George) в Вирджинии (США) на строительство кампуса ЦОД из нескольких объектов. Кампус разместят в Дальгрене (Dahlgren), расположенном неподалёку от Фредериксбурга (Fredericksburg) — одного из ключевых городов штата, сообщает Datacenter Dynamics. По имеющимся данным, кампус разместится на территории более 196 га. Oasis намерена построить на участке 10 строений ЦОД общей площадью более 631 тыс. м2. Ожидается, что совокупная мощность составит 1,2 ГВт. После ввода объекта в эксплуатацию его обслуживанием будет заниматься 50–60 постоянных сотрудников, а ежегодные налоговые поступления в казну штата составят $100–$120 млн налоговых поступлений. По имеющимся данным, площадку выбрали потому, что она расположена за пределами Северной Вирджинии. Amazon (AWS) также намеревалась построить ЦОД в округе Кинг-Джордж (King George). Проект отклонили, но в мае компания подала ходатайство о пересмотре решения.

Источник изображения: Dahlgren West Oasis Digital Properties основали, исходя из того положения, что строительство ЦОД в Северной Вирджинии «задушено», поэтому теперь компания реализует ряд проектов в других округах штата. Ещё в 2024 году Potomac Development Group предложила возвести кампус из 10-15 объектов (836 тыс. м2) на участке площадью более 200 га, расположенном в том же районе. Примечательно, что Ник Овер (Nick Over), ранее руководивший Potomac Development Group, сегодня — один из учредителей Oasis. Будучи крупнейшим в мире рынком ЦОД, регион Северная Вирджиния стал местом серьёзных споров по поводу векторов дальнейшего развития. Ранее в августе разрешение на зонирование давно планировавшегося проекта Digital Gateway в округе Принс-Уильям (Prince William) отозвали после иска местных жителей. Хотя развитие рынка ЦОД часто критикуется в регионе, объекты приносят местным властям значительные доходы за счёт налогов. Так, округ Лаудон (Loudoun) рассчитывает получить $795 млн только от налогов на оборудование ЦОД в 2026 году. При этом североамериканский рынок колокации оказался в критической ситуации — в местных дата-центрах осталось всего 2,3 % свободных мощностей на фоне высокого спроса.

26.08.2025 [13:47], Руслан Авдеев

Crusoe расширит ИИ-мощности в исландском ЦОД atNorth ICE02Crusoe Energy и atNorth объявили о расширении мощностей Crusoe Cloud на 24 МВт в ЦОД ICE02 в Исландии. Дата-центр принадлежит atNorth и работает на «чистой» энергии. Новый проект должен удовлетворить растущий спрос на услуги Crusoe Cloud в Европе и Северной Америке, сообщает пресс-служба Crusoe. Для поддержки новой инициативы Crusoe получила от инвестиционной группы Victory Park Capital (VPC) кредитную линию на $175 млн. Расширение предусматривает использование современных решений NVIDIA, в том числе GB200 NVL72, а также внедрение СЖО. Дата-центр atNorth ICE02 на 100 % снабжается геотермальной энергией и энергией ГЭС. По словам Crusoe, расширения мощностей позволит ускорить удовлетворение «невероятного» спроса на Crusoe Cloud. atNorth сообщает, что в компании рады успехам Crusoe, достигнутым в обслуживании клиентов с использованием её исландского ЦОД. Расширение ICE02 — ключевой этап стратегии развития Crusoe в Европе, реализация которой стартовала в декабре 2023 года. Площадка предлагает доступ к телеком-сетям с низкими задержками и подключение по нескольким подводным кабелям — доступ к ресурсам получат не только европейские клиенты, но и компании из Северной Америки. Расширение регионального присутствия компании также включает и ввод в эксплуатацию недавно анонсированного ЦОД в Норвегии.

Источник изображения: Crusoe Crusoe Cloud представляет собой масштабируемую платформу для выполнения ИИ-задач нового поколения. Crusoe Cloud считается экономичным решением, позволяющим разработчикам и иным IT-специалистам сосредоточиться на инновациях, не уделяя лишнего внимания инфраструктуре. В марте сообщалось, что Crusoe окончательно избавилась от криптобизнеса для концентрации усилий на ИИ-проектах. Тогда же компания привлекла $225 млн на закупку чипов NVIDIA для развития облачной ИИ-инфраструктуры. Компания является одним из ключевых подрядчиков проекта OpenAI Stargate, но попутно развивает и собственное ИИ-облако.

26.08.2025 [13:36], Сергей Карасёв

Advantech представила ИИ-систему MIC-743 на базе NVIDIA Jetson ThorКомпания Advantech анонсировала компьютер небольшого форм-фактора MIC-743, предназначенный для решения ИИ-задач на периферии. Устройство, в частности, может использоваться для работы с большими языковыми моделями (LLM) и визуально-языковыми моделями (VLM). В основу новинки положена аппаратная платформа NVIDIA Jetson Thor с вычислительным модулем Jetson T5000. Он содержит CPU с 14 ядрами Arm Neoverse-V3AE с максимальной тактовой частотой 2,6 ГГц и 2560-ядерный GPU на архитектуре Blackwell с частотой до 1,57 ГГц (96 тензорных ядер пятого поколения). Объём памяти LPDDR5X составляет 128 Гбайт. ИИ-производительность достигает 2070 Тфлопс (FP4 Sparse).

Источник изображения: Advantech Компьютер может быть оснащён SSD формата M.2 2280 с интерфейсом PCIe x4 (NVMe). Есть слоты M.2 2230 E-Key (PCIe x1 и USB 2.0) для адаптера Wi-Fi и M.2 3052/3042 B-Key (USB 3.0 и USB 2.0) для сотового модема (имеется слот Nano SIM). Предусмотрены сетевые порты 5GbE RJ45 и QSFP28 (4 × 25 GbE), интерфейс HDMI с поддержкой разрешения до 3840 × 2160 при частоте обновления 60 Гц, четыре порта USB 3.2 Gen2, аудиогнёзда на 3,5 мм. MIC-743 имеет размеры 195 × 200 × 71,5 мм и весит примерно 2 кг. Диапазон рабочих температур простирается от -10 до +35 °C. Применяется программное обеспечение NVIDIA JetPack 7.0. Для новинки заявлена бесшовная интеграция с различными датчиками, камерами и периферийными устройствами для быстрого создания комплексных решений на базе ИИ. Устройство подходит для применения на промышленных предприятиях, в исследовательских лабораториях, центрах разработки и пр.

26.08.2025 [11:31], Сергей Карасёв

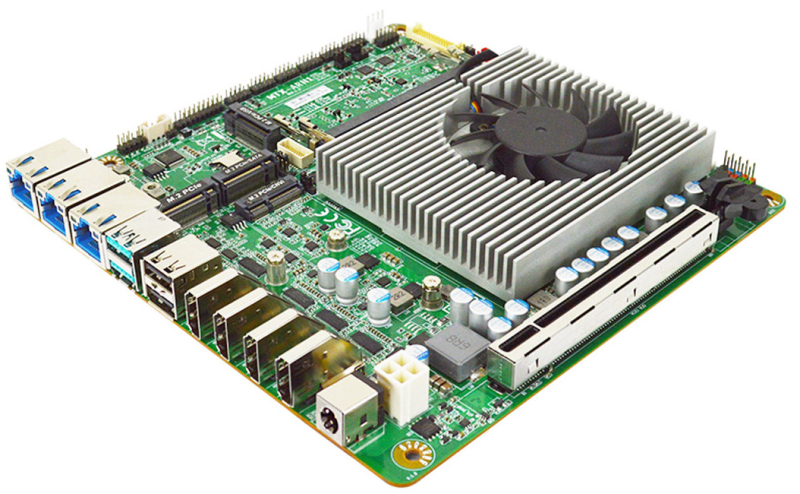

Индустриальная плата Jetway MTX-ARH1 формата Thin mini-ITX оснащена процессором Intel Arrow Lake-HКомпания Jetway представила материнскую плату MTX-ARH1 типоразмера Thin mini-ITX, предназначенную для использования в промышленной и коммерческой сферах. Новинка, в частности, подходит для создания индустриальных компьютеров, периферийных ИИ-устройств, оборудования интернета вещей и пр. В основу изделия положена аппаратная платформа Intel Arrow Lake-H. Младшая версия оснащена 14-ядерным процессором Core Ultra 5 225H (4P + 8E + 2LPE) с максимальной тактовой частотой 4,9 ГГц: этот чип располагает графическим ускорителем Intel Arc 130T (63 TOPS) и модулем Intel AI Boost (13 TOPS). Более производительная модификация получила 16-ядерный процессор Core Ultra 7 255H (6P + 8E + 2LPE) с частотой до 5,1 ГГц, который содержит блоки Intel Arc 140T GPU (74 TOPS) и Intel AI Boost (13 TOPS). За охлаждение отвечает кулер с радиатором и вентилятором. Плата оборудована двумя слотами SO-DIMM для модулей оперативной памяти DDR5-6400 суммарным объёмом до 96 Гбайт. Есть порт SATA-3 для подключения SSD или HDD, коннектор M.2 M-Key 2242 для NVMe SSD с интерфейсов PCIe 4.0 x4 и разъём M.2 M-Key 2242/2280 для ещё одного SSD с интерфейсом PCIe 4.0 x4 или SATA-3. Кроме того, доступны коннектор M.2 B-Key 3042/3052 (PCIe 3.0 x1; USB 3.2 Gen2; USB 2.0 плюс Nano-SIM) для сотового модема 4G/5G и разъём M.2 E-Key 2230 (USB 2.0; PCIe x1) для адаптера Wi-Fi/Bluetooth. Материнская плата получила один сетевой порт 2.5GbE на базе контроллера Intel I226-LM и два порта 2.5GbE на основе Intel I226-V. Имеется слот PCIe 5.0 x8 для карты расширения. Реализованы четыре разъёма HDMI 2.1 с поддержкой разрешения 3840 × 2160 пикселей (60 Гц) и интерфейс LVDS с поддержкой разрешения 1920 × 1200 точек (60 Гц). Предусмотрены три гнезда RJ45 для сетевых кабелей, по два порта USB 3.2 Gen2 x1 и USB 2.0. Через разъёмы на плате могут быть задействованы ещё два порта USB 3.2 и четыре порта USB 2.0, а также шесть последовательных портов (2 × RS-232/422/485 и 4 × RS-232). Новинка имеет размеры 170 × 170 мм. Питание (12–36 В) может подаваться через DC-разъём. Диапазон рабочих температур простирается от -20 до +60 °C. Заявлена совместимость с Linux, Windows 10/11.

25.08.2025 [18:15], Руслан Авдеев

China Mobile заказала CUDA-совместимые ИИ-ускорители Kunlunxin на сумму более ¥1 млрдKunlunxin, «дочка» китайского IT-гиганта Baidu, получила от China Mobile заказ на ИИ-ускорители, совместимые с программной экосистемой NVIDIA CUDA, на сумму более ¥1 млрд ($140 млн), сообщает передаёт Reuters. Чипы достанутся поставщикам China Mobile, включая H3C и ZTE. Кроме того, компания закупит ускорители у Huawei. Заключение контракта — часть более широкой стратегии Китая по обретению технологического суверенитета в ИИ-секторе. В апреле Baidu успешно развернула кластер и 30 тыс. чипов собственной разработки — ИИ-ускорителей третьего поколения P800 Kunlun, способных обучать модели уровня DeepSeek. Технологический прогресс подчеркивает потенциал китайских разработок и позиционирует Baidu и Kunlunxin как ключевых игроков на рынке ИИ-ускорителей. Успех Kunlunxin и других китайских бизнесов может иметь важные последствия для мировой индустрии ИИ-ускорителей, в которой пока доминирует NVIDIA. По мере прогресса китайских технологий, позиции NVIDIA могут оказаться под вопросом, особенно в Поднебесной и на других рынках. Развитие технологий происходит на фоне технологического соперничества между США и Китаем. Практически сразу после послаблений США на поставки H20 Китай развернул активную кампанию против этих чипов, поэтому NVIDIA затормозила выпуск H20 и готовит для местного рынка другой, более мощный ускоритель. Глава NVIDIA Дженсен Хуанг (Jensen Huang) критиковал запреты на экспорт ИИ-полупроводников в Китай, подчёркивая, что из-за этого прогресс собственных технологий в КНР только ускорится.

25.08.2025 [16:55], Руслан Авдеев

TerraPower поможет SK Group сформировать в Южной Корее экосистему малых модульных реакторовАтомный стартап TerraPower, поддерживаемый Биллом Гейтсом (Bill Gates), выразил надежду на более тесное сотрудничество с SK Group — вторым по масштабу многопрофильным конгломератом Южной Кореи, сообщает агентство Yonhap. В ходе встречи между Гейтсом и председателем SK Group Чей Тхэ Вон (Chey Tae-won) обсуждалось сотрудничество в разных отраслях, от строительства малых модульных реакторов (SMR) до создания вакцин. По словам TerraPower, компания высоко оценивает поддержку со стороны SK Group. SK Group — один из стратегических инвесторов TerraPower с 2022 года. SK Inc., холдинговая компания SK Group и SK Innovation Co., инвестировала в TerraPower $250 млн, став вторым по величине акционером и получив место в совете директоров. В TerraPower заявили о стратегическом единстве между технологическими решениями TerraPower и ключевыми бизнесами SK, что позволит расширить сотрудничество в Южной Корее и на мировом рынке. В SK Group уверены, что SMR представляют собой инновационную технологию, которая позволит снизить углеродные выбросы и обеспечить энергетическую безопасность. В компании заявляют, что стратегическое партнёрство с TerraPower позволит SK Innovation сыграть ведущую роль в формировании домашней SMR-экосистемы и выйти на глобальный рынок. По данным The Korea Times, в марте 2023 года SK Innovation, Korea Hydro & Nuclear Power и TerraPower подписали меморандум о взаимопонимании для разработки и коммерциализации АЭС нового поколения, с фокусом на коммерческих реакторах IV поколения с охлаждением с помощью жидкого натрия на базе технологий TerraPower. SMR TerraPower Natrium с типовой мощностью 345 МВт получит встроенное энергохранилище гигаваттного масштаба. Он будет функционировать при атмосферном давлении, а его пиковая электрическая мощность может составлять более 500 МВт. После встречи топ-менеджеров, представители SK встретились с функционерами Министерства промышленности и других государственных ведомств для обсуждения государственной поддержки коммерциализации SMR-технологий, развития цепочек поставок и стратегий глобального сотрудничества. В июне 2025 года сообщалось, что NVIDIA также инвестировала в TerraPower.

25.08.2025 [11:20], Сергей Карасёв

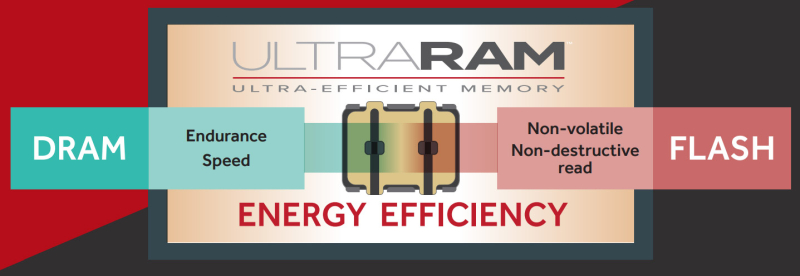

Энергонезависимая память UltraRAM стала на шаг ближе к реальностиБританская компания QuInAs Technology, по сообщению ресурса Blocks & Files, ещё на шаг приблизилась к серийному производству своей универсальной памяти UltraRAM, сочетающей такие характеристики, как высокая скорость DRAM, энергонезависимость NAND и низкое энергопотребление. В разработке технологий, лежащих в основе UltraRAM, приняли участие исследователи из Университета Ланкастера (Lancaster University) и Университета Уорика (University of Warwick). Утверждается, что UltraRAM потребляет в 100 раз меньше энергии, чем DRAM, и в 1000 раз меньше, чем NAND-флеш. Данные в новой памяти могут храниться на протяжении 1000 лет. Кроме того, UltraRAM обладает высокой надёжностью: она может быть перезаписана не менее 10 млн раз. Принцип работы UltraRAM основан на эффекте квантового туннелирования электронов через энергетический барьер в ячейку. Этот барьер формируется путём чередования тонкоплёночных слоёв антимонида галлия (GaSb) и антимонида алюминия (AlSb). В обычной памяти 3D NAND оксидный плавающий затвор в ячейке постепенно разрушается, тогда как у UltraRAM затвор практически не подвержен внешним воздействиям, говорят создатели. Благодаря этому обеспечивается большое количество циклов записи/стирания. Партнёром QuInAs в рамках проекта по организации массового производства UltraRAM выступает компания IQE, тогда как грантовое финансирование предоставляет Innovate UK. Специалисты IQE разработали производственный процесс получения структур для UltraRAM с использованием эпитаксии (нарастание одного кристаллического материала на другом). В настоящее время QuInAs и IQE обсуждают возможности коммерциализации памяти нового типа с производственными предприятиями и стратегическими партнёрами. Ожидается, что UltraRAM сможет найти применение в самых разных устройствах — от автономных изделий интернета вещей (IoT) и смартфонов до ноутбуков и оборудования для дата-центров. |

|