Материалы по тегу: h100

|

23.04.2025 [16:15], Руслан Авдеев

GPU под роспись: Amazon резко ужесточила использование дефицитных ИИ-ускорителей внутри компании в рамках Project GreenlandВ прошлом году ретейл-бизнес Amazon столкнулся с острой нехваткой ИИ-ускорителей для внутреннего пользования. Это привело к задержкам при реализации ключевых проектов. На фоне глобального бума ИИ-технологий и дефицита чипов NVIDIA компания вынужденно пересмотрела принципы доступа к ускорителям для собственных нужд, сообщает Business Insider. В июле 2024 года началась реализация т. н. Project Greenland. Фактически речь идёт о платформе для централизованного распределения ресурсов ускорителей. Платформа позволяет отслеживать их использование, перераспределяет мощности в случае простоя и даёт возможность оперативно реагировать на изменения спроса. Теперь все заявки на доступ к ускорителям подаются только через Greenland, а приоритет получают проекты с высоким уровнем возврата инвестиций (ROI), чётким графиком и заметным влиянием на снижение затрат или рост выручки. У проектов с низкой эффективностью доступ к вычислительным мощностям могут вообще отозвать в пользу более перспективных инициатив. Amazon выделила восемь принципов распределения ускорителей среди сотрудников компании:

Источник изображения: Centre for Ageing Better/unsplash.com Amazon уже активно использует искусственный интеллект в различных проектах. В числе ключевых инициатив:

По оценкам Amazon, ИИ-проекты розничного подразделения в 2024 году принесли $2,5 млрд операционной прибыли, попутно сэкономив $670 млн. В 2025 году ретейл-подразделение Amazon намерено вложить $1 млрд в ИИ-проекты розничного сегмента и увеличить расходы на облако AWS до $5,7 млрд (с $4,5 млрд в 2024 году). Если во II полугодии 2024 года розница Amazon нуждалась в более 1 тыс. дополнительных инстансов P5 с NVIDIA H100, то в 2025 году ситуация, как свидетельствуют внутренние прогнозы, должна стабилизироваться. А к концу года внутренние запросы полностью удовлетворят с помощью чипов собственной разработки Amazon Tranium, «но не раньше». Тем не менее, в Amazon не теряют бдительности, постоянно задаваясь вопросом: «Как получить больше ускорителей?».

13.03.2025 [15:55], Руслан Авдеев

ESA запустила суперкомпьютер Space HPC для европейских космических исследованийЕвропейское космическое агентство (ESA) запустило суперкомпьютерную платформу ESA Space HPC, специально разработанную для развития космических исследований и технологий в Евросоюзе. Открытие нового объекта состоялось на территории принадлежащего ESA центра ESRIN в Италии, сообщает HPC Wire. ESA Space HPC обеспечит поддержку исследований и развития технологий в рамках всех программ ESA, обеспечивая учёным и малому и среднему бизнесу из стран Евросоюза доступ к вычислительным мощностям. Инициатива призвана развить использование высокопроизводительных вычислений (HPC) в аэрокосмическом секторе ЕС, она станет основой для более масштабных инициатив в будущем. Как сообщается на сайте проекта, Space HPC построен при участии HPE. Суперкомпьютер включает порядка 34 тыс. ядер процессоров Intel и AMD последних поколений, 156 Тбайт RAM, 108 ускорителей NVIDIA H100, All-Flash подсистему хранения ёмкостью 3,6 Пбайт и пропускной способностью 500 Гбайт/с, а также 400G-интерконнект InfiniBand. Общая пиковая производительность кластера составляет 5 Пфлопс (FP64). Space HPC использует прямое жидкостное охлаждение, а PUE системы не превышает 1,09. Избыточное тепло отправляется на нужды отопления кампуса. Локальная солнечная электростанция обеспечивает более половины энергетических нужд кластера. Представители итальянских властей заявили, что технологические инновации в космическом секторе являются приоритетом для обеспечения безопасности и «стратегической автономии», а также будут способствовать конкурентоспособности европейской промышленности. Также отмечено, что местный аэрокосмический хаб Lazio стал домом для 250 компаний и играет ключевую роль в развитии авионики, электроники, радаров, спутниковых технологий и материаловедения. В руководстве ESA отметили потенциал Space HPC для инноваций в космической индустрии Евросоюза. Новый объект обеспечит агентству гибкую суперкомпьютерную инфраструктуру для исследований и разработок, тестирования и бенчмаркинга, поддержки программ ESA и промышленных предприятий. Доступ к вычислениям будет иметь и малый и средний бизнес, стартапы и т.п. Также отмечается, что дебют Space HPC наглядно продемонстрировал, ESA не только берёт ресурсы у государств-участников, но и много может дать им взамен. Утверждается, что одной из ключевых сфер деятельности, где требуются HPC-платформы, для ESA является наблюдение за Землёй. Новые мощности обеспечат управление наблюдениями, разработку новых приложений и сервисов. Space HPC будет поддерживать сложные нагрузки, включая моделирование, инженерные симуляции, обучение ИИ-моделей, аналитику данных и визуализацию, а также прочие эксперименты, которые помогут снизить риски будущих космических проектов. Это позволит ESA повысить финансовую эффективность проектов и обеспечит возможность обмена данными между разными программами агентства. В конце 2024 года сообщалось, что в 2025 году в Евросоюзе появится сразу семь ИИ-фабрик EuroHPC, а в середине минувшего февраля появилась информация, что Евросоюз направит €200 млрд на развитие ИИ, чтобы не отстать от США и Китая в этой сфере. В прошлом году было отмечено, что реализация миссий NASA задерживается из-за устаревших и перегруженных суперкомпьютеров.

27.02.2025 [12:33], Сергей Карасёв

Cisco представила MGX-сервер UCS C845A M8 на базе AMD EPYC 9005 Turin с поддержкой восьми PCIe-ускорителей NVIDIAКомпания Cisco анонсировала сервер UCS C845A M8 для рабочих нагрузок ИИ, построенный на модульной архитектуре NVIDIA MGX. Устройство поддерживает установку от двух до восьми ускорителей NVIDIA H200 NVL, H100 NVL и L40S), а также адаптеров NVIDIA BlueField-3 SuperNIC и ConnectX-7. Новинка выполнена в форм-факторе 4U с применением аппаратной платформы AMD EPYC 9005 Turin: максимальная конфигурация включает два 96-ядерных процессора EPYC 9655. Доступны 32 слота для модулей DDR5-4400/5200. Система может нести на борту два загрузочных SSD формата M.2 с интерфейсом SATA вместимостью 960 Гбайт каждый, а также до 20 накопителей E1.S NVMe. Предусмотрены пять слотов PCIe 5.0 x16 для сетевых 400G-адаптеров типоразмера FHHL: один для внешней сети, четыре для внутренней сети кластера. Задействовано воздушное охлаждение. За питание отвечают четыре блока мощностью 3200 Вт с возможностью горячей замены. Имеется слот OCP 3.0 под сетевую карту Intel X710-DA2 с двумя портами 10GbE для управления. По заявлениям Cisco, при разработке модели UCS C845A M8 особое внимание было уделено конструкции системы: говорится об улучшенной прокладке кабелей для оптимального воздушного потока и упрощении обслуживания, включая замену компонентов.

Источник изображения: Cisco В зависимости от количества установленных GPU и объема памяти сервер подходит для решения таких задач, как обучение и тонкая настройка ИИ-моделей, аналитика и визуализация данных, приложения НРС, проектирование и моделирование, обработка естественного языка, разговорный ИИ, рендеринг, облачные приложения и пр. В качестве потенциальных покупателей названы крупные предприятия, научно-исследовательские институты, государственные учреждения и облачные провайдеры.

11.02.2025 [13:47], Руслан Авдеев

Tesla запустила суперкомпьютер Cortex с 50 тыс. ускорителей NVIDIA H100, а общие затраты компании на ИИ уже превысили $5 млрдКомпания Tesla завершила ввод в эксплуатацию ИИ-кластера из 50 тыс. ИИ-ускорителей NVIDIA H100 в IV квартале прошлого года. В презентации для акционеров отмечалось, что кластер Cortex заработал на принадлежащем Tesla объекте Gigafactory в Остине (Техас), сообщает Datacenter Dynamics. Информация впервые появилась в отчёте компании за IV квартал и 2024 финансовый год. Новый кластер не имеет отношения к суперкомпьютеру Dojo, предназначенному для технологий автономного вождения FSD, имеющего собственную архитектуру и оснащенного кастомными чипами D1. При этом в презентации, посвящённой отчёту, Dojo не упоминается вообще. Хотя компания не уточняет, когда именно в IV квартале началось развёртывание системы, на конференции по финансовым вопросам в октябре 2024 года представитель Tesla заявил, что компания находится «на пути к развёртыванию 50 тыс. ускорителей в Техасе к концу текущего месяца». По имеющимся данным, проект реализован с опозданием, поскольку Илон Маск уволил руководителя строительством ещё в апреле, а также приказал передать xAI 12 тыс. ускорителей H100, изначально предназначавшихся Tesla.

Источник изображения: Tesla В презентации сообщается, что именно Cortex уже помог в создании «автопилота» FSD V13 (Supervised). Новая версия повысила безопасность и комфорт вождения благодаря увеличению объёма данных в 4,2 раза, повышению разрешения видеопотока, а также другим усовершенствованиям. Заодно компания сообщила о продолжении работ над программной и аппаратной частями робота Optimus, в т.ч. рук нового поколения и механизмов передвижения. Также осуществлялось обучение выполнению дополнительных задач перед началом пилотного производства в 2025 году. Что касается доходов компании в IV квартале, в конце января Илон Маск (Elon Musk) сообщил, что бизнес продолжает инвестировать в обучающую инфраструктуру за пределами штаб-квартиры в Техасе. В конце января сообщалось, что Tesla наращивает вычислительные мощности для обучения Optimus. По словам миллиардера, на обучение Optimus необходимо потратить, как минимум, в 10 раз больше ресурсов в сравнении с полноценным обучением систем автомобиля. Капитальные затраты Tesla в 2024 году составили $10 млрд, столько же компания намерена потратить в ближайшие два года, хотя большая часть затрат придётся на инфраструктуру для электромобилей. В отчёте о доходах за IV квартал упоминалось, что общие капитальные затраты компании, связанные с ИИ, включая инфраструктуру, превысили $5 млрд.

18.11.2024 [13:38], Руслан Авдеев

Foxlink запустила мощнейший на Тайване суперкомпьютер для малого и среднего бизнесаFoxlink Group (Cheng Uei Precision Industry) открыла крупнейший на Тайване суперкомпьютерный центр Ubilink (Ubilink.AI). По данным DigiTimes, центр предназначен для обслуживания предприятий малого и среднего бизнеса (SME), которые не могут позволить себе собственных вычислительных мощностей. Хотя основной деятельностью Foxlink является производство разъёмов, компания расширяет бизнес, осваивая решения для управления электропитанием и коммуникаций, а также выпуск энергетических модулей. Центр Ubilink создан дочерней Shinfox Energy совместно с Asustek Computer и японской Ubitus, занимающейся предоставлением облачных услуг. В Ubitus сообщили, что инфраструктура Ubilink включает 128 серверов Asus, 1024 ускорителя NVIDIA H100 и интерконнект NVIDIA Quantum-2 InfiniBand. Конфигурация обеспечивает до 45,82 Пфлопс (FP64) — система занимает 31-е место в рейтинге TOP500. В будущем станут применять и более современные B100 и B200 — когда те будут доступны. Ожидается, что в 2025 году суммарно будет установлено 10 240 ускорителей H100, B100 и B200. Представители местных властей уже заявили, что Ubilink существенно улучшит позиции Тайваня на рынке ИИ-вычислений, на котором территория сегодня занимает 26-е место. В Asustek добавляют, что достигнутая производительность в 45,82 Пфлопс заметно превышает плановые 40 Пфлопс. Кроме того, центр имеет PUE на уровне 1,2 — ранее ожидалось, что удастся добиться энергоэффективности лишь на уровне 1,38. Благодаря использованию опыта Shinfox Energy в области возобновляемой энергетики, Ubilink стал первым в Азии суперкомпьютерным центром, использующим «зелёные» источники энергии — клиенты могут воспользоваться вычислениями без существенного ущерба окружающей среде.

Источник изображения: UBITUS Предполагается, что Ubilink компенсирует отсутствие мощностей для местных малых и средних компаний, не имеющих доступа к значительным вычислительным ресурсам. Предлагая доступные вычислительные мощности, центр позволяет таким бизнесам расширить свои портфели предложений и конкурировать даже на мировом уровне. Суперкомпьютер уже востребован местными разработчиками чипов, компаний, занимающихся их упаковкой и тестированием, биотехнологическими бизнесами, а также исследовательскими институтами различной направленности. Из-за высокого спроса Foxlink уже рассматривает вторую и третью фазы расширения проекта.

01.11.2024 [11:14], Сергей Карасёв

Марк Цукерберг: для обучения ИИ-модели Llama-4 используются более 100 тыс. ускорителей NVIDIA H100Председатель правления и генеральный директор Meta✴ Марк Цукерберг (Mark Zuckerberg), по сообщению ресурса Tom's Hardware, раскрыл масштабы кластера, который используется для обучения ИИ-модели нового поколения Llama-4. По его словам, для этих целей задействованы более 100 тыс. ускорителей NVIDIA H100. Напомним, в начале сентября нынешнего года стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске ИИ-суперкомпьютера Colossus, в основу которого положены 100 тыс. штук H100. В дальнейшем количество ускорителей в составе Colossus планируется увеличить вдвое. Теперь об эксплуатации кластера схожего масштаба рассказал Цукерберг. Глава Meta✴ не стал вдаваться в подробности о характеристиках Llama-4, ограничившись лишь фразами вроде «новые модальности», «более сильные рассуждения» и «повышенное быстродействие». Ранее Meta✴ заявляла о намерении потратить в 2024-м от $30 млрд до $37 млрд на развитие своей инфраструктуры — прежде всего для задач ИИ. Кроме того, говорилось, что к концу текущего года компания рассчитывает оперировать мощностями, эквивалентными более чем 500 тыс. ускорителей NVIDIA H100.

Источник изображения: Meta✴ Вместе с тем, как отмечается, возникают сложности при обеспечении питанием столь масштабных ИИ-кластеров. Дело в том, что один современный GPU может потреблять до 3,7 МВт·ч электроэнергии в год. Это означает, что массив из 100 тыс. таких ускорителей потребует не менее 370 ГВт·ч в год, чего достаточно для обеспечения энергией более 34 млн среднестатистических американских домохозяйств. Цукерберг признаёт, что трудности, связанные с доступностью энергоресурсов, в перспективе могут ограничить темпы роста отрасли ИИ. Как добавляет ComputerWeekly, Meta✴ также отказалась от практики увеличения срока службы серверов с целью сокращения расходов. Ранее компания сообщила о продлении периода эксплуатации оборудования до пяти лет вместо прежних четырёх с половиной: это, как ожидалось, даст экономию в $1,5 млрд. Однако теперь финансовый директор Meta✴ Сьюзан Ли (Susan Li) заявила, что компания в свете стремительного развития ИИ намерена применять серверы последнего поколения, чтобы максимально эффективно использовать доступную ёмкость существующих дата-центров.

31.10.2024 [11:33], Сергей Карасёв

Cisco представила ИИ-сервер UCS C885A M8 на базе NVIDIA H100/H200 или AMD Instinct MI300XКомпания Cisco анонсировала сервер высокой плотности UCS C885A M8, предназначенный для решения задач в области ИИ, таких как обучение больших языковых моделей (LLM), тонкая настройка моделей, инференс, RAG и пр. Устройство выполнено в форм-факторе 8U. В зависимости от модификации устанавливаются два процессора AMD EPYC 9554 поколения Genoa (64 ядра; 128 потоков; 3,1–3,75 ГГц; 360 Вт) или два чипа EPYC 9575F семейства Turin (64 ядра; 128 потоков; 3,3–5,0 ГГц; 400 Вт). Доступны 24 слота для модулей DDR5-600 суммарным объёмом 2,3 Тбайт. В максимальной конфигурации могут быть задействованы восемь SXM-ускорителей NVIDIA H100, H200 или AMD Instinct MI300X. Каждый ускоритель дополнен сетевым адаптером NVIDIA ConnectX-7 или NVIDIA BlueField-3 SuperNIC. Кроме того, в состав сервера входит DPU BlueField-3. Слоты расширения выполнены по схеме 5 × PCIe 5.0 x16 FHHL плюс 8 × PCIe 5.0 x16 HHHL и 1 × OCP 3.0 PCIe 5.0 x8 (для карты X710-T2L 2x10G RJ45 NIC). Новинка оборудована загрузочным SSD вместимостью 1 Тбайт (M.2 NVMe), а также 16 накопителями U.2 NVMe SSD на 1,92 Тбайт каждый. Установлены два блока питания мощностью 2700 Вт и шесть блоков на 3000 Вт с возможностью горячей замены. Cisco также представила инфраструктурные стеки AI POD, адаптированные для конкретных вариантов использования ИИ в различных отраслях. Они объединяют вычислительные узлы, сетевые компоненты, средства хранения и управления. Стеки, как утверждается, обеспечивают хорошую масштабируемость и высокую эффективность при решении ИИ-задач.

29.10.2024 [20:28], Сергей Карасёв

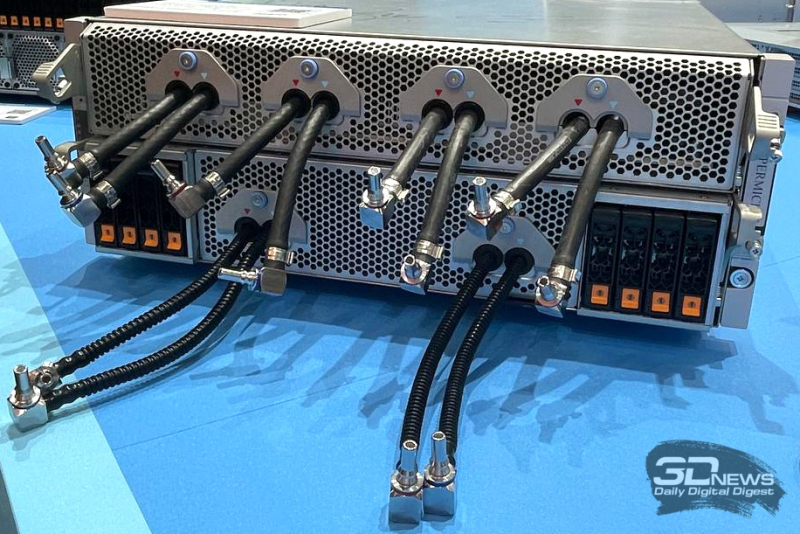

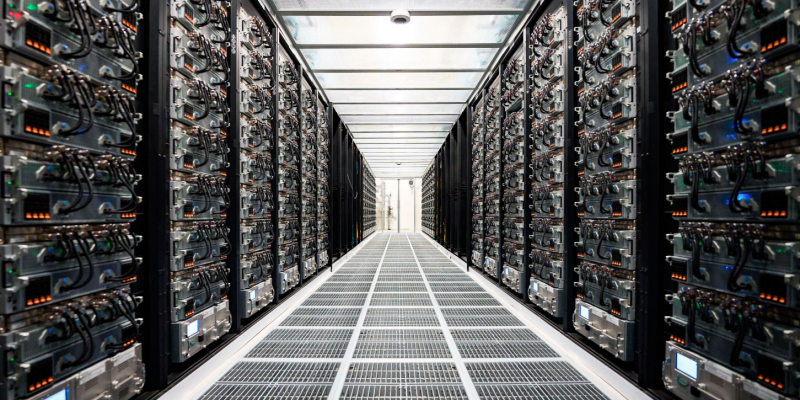

Раскрыты подробности архитектуры ИИ-кластера xAI Colossus со 100 тыс. ускорителей NVIDIA H100Портал ServeTheHome рассказал подробности об архитектуре вычислительного кластера xAI Colossus, предназначенного для обучения крупных ИИ-моделей. Эта система использует 100 тыс. NVIDIA H100, а в дальнейшем количество ускорителей планируется увеличить вдвое. Это самый крупный из известных ИИ-кластеров на текущий момент. Оборудование для него поставили компании Dell и Supermicro. Стартап xAI, курируемый Илоном Маском (Elon Musk), объявил о запуске суперкомпьютера Colossus в начале сентября нынешнего года. Утверждается, что на создание системы потребовалось всего 122 дня. Причём с момента установки первой стойки с серверами до начала обучения ИИ-моделей прошло только 19 суток. Впрочем, как отмечают эксперты, поскольку машина является «однозадачной», т.е. в отличие от традиционных суперкомпьютеров предназначенной только для работы с ИИ, ускорить строительство было не так уж сложно, хотя результат всё равно впечатляющий. Как сообщается, в составе Colossus применены серверы на платформе NVIDIA HGX H100, оборудованные системой жидкостного охлаждения. Каждый узел Supermicro серии TNHR2-LCC типоразмера 4U содержит восемь ускорителей NVIDIA H100 и два CPU. Узел разделён на две половинки, одна с CPU и PCIe-коммутаторами и одна с HGX-платой, которые могут извлекаться независимо для простоты обслуживания. CPU, коммутаторы и ускорители охлаждаются посредством СЖО. Вентиляторы в шасси тоже есть. Воздух от них попадает на теплообменники на задней двери, которые уносят остаточное тепло. Холодных и горячих коридоров в ЦОД нет, воздух имеет одинаковую температуру во всём зале. В нижней части стоек располагается ещё один 4U-блок Supermicro для CDU с резервированием и поддержкой горячей заменой насосов. Каждый сервер имеет четыре блока питания с резервированием и возможностью горячей замены, которые подключены к трёхфазным PDU. Одна стойка объединяет восемь узлов NVIDIA HGX H100, между которыми располагаются коллекторы СЖО в формате 1U. Таким образом, каждая стойка насчитывает 64 экземпляра H100. Стойки организованы в группы по восемь штук, которые образуют малые кластеры из 512 ускорителей H100. Они в свою очередь объединены в т.н. «острова» по 25 тыс. ускорителей, каждому из которых полагается собственный машинный зал. Общее количество стоек в составе Colossus превышает 1500. Помимо узлов с ускорителями также есть CPU-узлы и узлы хранения All-Flash (1U). Как отмечает NVIDIA, в кластере Colossus задействована сетевая платформа Spectrum-X Ethernet. Применены коммутаторы Spectrum-X SN5600 и сетевые карты на базе чипа BlueField-3. Компания говорит об использовании трёхуровневой Ethernet-сети с 400GbE-подключением, но точная топология не указана. Судя по всему, выделенной сети для работы с хранилищем не предусмотрено. Каждом ускорителю полагается один 400GbE-адаптер SuperNIC, который и объединяет их в RDMA-сеть. Кроме того, у каждого GPU-узла есть ещё один 400GbE DPU, а также подключение к сервисной сети. Сетевые карты находятся в собственных лотках, благодаря чему их можно заменять без демонтажа шасси. По словам NVIDIA, уровень утилизации сети достигает 95 %. В качестве энергетического буфера между электросетью и суперкомпьютером используются аккумуляторные банки Tesla Megapack ёмкостью 3,9 МВт·ч каждый. Они необходимы для того, чтобы компенсировать всплески потребляемой мощности, когда нагрузка на ускорители резко возрастает в силу выполняемых ИИ-задач. Впрочем, вероятно, есть и ещё одна причина для такого решения — на первом этапе Colossus был лишён подключения к основной энергосети и в вопросе питания во многом полагался на генераторы.

26.10.2024 [14:00], Сергей Карасёв

Дженсен Хуанг и король Фредерик X запустили самый производительный в Дании ИИ-суперкомьютер GefionОснователь и генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) и король Дании Фредерик X объявили о запуске крупнейшего в стране суверенного суперкомпьютера для задач ИИ. Система получила название Gefion («Гевьон») — в честь скандинавской богини плодородия. НРС-комплекс эксплуатируется Датским центром инноваций в области искусственного интеллекта (DCAI), который был создан при поддержке фонда Novo Nordisk Foundation и Датского фонда экспорта и инвестиций. В церемонии ввода Gefion в эксплуатацию, проходившей в Копенгагене, приняла участие Надя Карлстен (Nadia Carlsten), генеральный директор DCAI. Суперкомпьютер объединяет 191 систему DGX H100, что в общей сложности даёт 1528 ускорителей NVIDIA H100. Задействованы 382 процессора Intel Xeon Platinum и интерконнект NVIDIA Quantum-2 InfiniBand. Прочие технические характеристики, а также показатели быстродействия системы пока не раскрываются. Пиковая теоретическая FP64-производительность должна составить около 52 Пфлопс, а в FP8-расчётах с разреженностью — порядка 6 Эфлопс. Сообщается, что Gefion будет применяться для решения сложных задач в области квантовых вычислений, «зелёной» энергетики, биотехнологий и пр. В частности, исследователи из Копенгагенского университета (UCPH) намерены задействовать машину для проведения крупномасштабного распределённого моделирования квантовых компьютерных схем. Кроме того, UCPH, Технический университет Дании (DTU), Novo Nordisk и Novonesis совместно разработают многомодальную геномную ИИ-модель для анализа мутаций заболеваний и разработки вакцин. Доступ к Gefion также получат стартапы, реализующие перспективные проекты в области обработки текста, изображений и видео. Суперкомпьютер размещён в одном из дата-центров Digital Realty на территории Дании. Этот объект на 100 % получает питание от возобновляемых источников энергии. Сборкой и установкой вычислительного комплекса занимались специалисты Eviden.

26.10.2024 [00:53], Владимир Мироненко

Tesla до конца месяца запустит ИИ-кластер из 50 тыс. NVIDIA H100Tesla планирует ввести в эксплуатацию ЦОД с 50 тыс. ускорителей NVIDIA H100 в конце этого месяца, пишет Data Center Dynamics (DCD) со ссылкой на заявление компании. «Мы начали использовать кластер на базе нашего завода раньше срока и находимся на пути к развертыванию 50 тыс. GPU в Техасе к концу этого месяца», — сообщил финансовый директор Вайбхав Танеджа (Vaibhav Taneja) в ходе отчёта о финансовых результатах за III квартал. Предполагается, что именно этот кластер, размещённый в Остине (Техас) отставал от графика, из-за чего гендиректор Илон Маск (Elon Musk) уволил в апреле руководителя строительства. В июне по распоряжению Маска 12 тыс. ускорителей H100, предназначавшихся Tesla, были переданы xAI. Сама xAI в сентябре запустила ИИ-кластер со 100 тыс. ускорителей NVIDIA H100. Капитальные затраты Tesla достигли $3,5 млрд в отчётном квартале, «последовательно увеличившись в основном из-за инвестиций в ИИ-вычисления», а капитальные затраты за год, как ожидается, превысят $11 млрд, что на $1 млрд больше год к году. При этом Танеджа сообщил, что компания «очень разумно подходит к расходам на ИИ», пытаясь наилучшим способом использовать существующую инфраструктуру, прежде чем делать дальнейшие инвестиции. Маск заявил, что Tesla продолжает расширять возможности обучения ИИ, чтобы удовлетворить как потребности в обучении автопилота Full Self Driving (FSD), так и роботов Optimus, отметив, что в настоящее время компания не испытывает дефицита вычислительных ресурсов. В квартальном отчёте не упоминается Dojo, ИИ-инфраструктура Tesla на базе ускорителей собственной разработки. |

|