Материалы по тегу: облако

|

13.10.2025 [16:45], Руслан Авдеев

Microsoft не хватает ЦОД и серверов в США, причём не только для ИИПроблемы с дата-центрами Microsoft сохранятся дольше, чем рассчитывала компания. Это подчёркивает трудности, с которыми она сталкивается в своём стремлении удовлетворить спрос на облачные технологии, сообщает Bloomberg. Источники, знакомые с внутренними прогнозами Microsoft, сообщают, что во многих облачных регионах на территории США не хватает физического пространства и/или серверов. В некоторых ключевых регионах, включая Северную Вирджинию и Техас, новые подписки на сервисы Azure ограничат до I половины 2026 года. Это дольше, чем компания заявляла ранее. В июле её представитель сообщал, что действующие ограничения сохранятся до конца 2025 года. Нехватка мощностей касается как оборудования с ИИ-ускорителями, так и традиционных серверов, долгое время бывших костяком классических облачных сервисов. Двигателем роста Microsoft является облачное подразделение Azure, которое в 2025 финансовом году принесло более $75 млрд. По темпам развития оно опережает крупнейших конкурентов AWS и Google Cloud. Нехватка серверов для сдачи в аренду клиентам постоянно препятствует выполнению планов гиперскейлеров. В ходе шести последних квартальных отчётов Microsoft последовательно заявляла о неспособности удовлетворить спрос на облачные услуги, у AWS и Google проблемы очень похожие. Представитель Microsoft, впрочем, заявлял, что Azure в США имеет достаточно ресурсов для роста, на пиковые периоды компания может использовать специальные методы распределения мощностей, позволяющие распределить нагрузку между ЦОД, чтобы обеспечить стабильную работу всех пользователей, избегая дефицита ресурсов в отдельных регионах. В норме клиенты Azure выбирают облачные регионы с учётом их физической близости и доступных сервисов, но в некоторых случаях, если ресурсов недостаточно, менеджеры Microsoft рекомендуют другие объекты. Тем не менее такие обходные пути могут усложнить работу и увеличить время передачи данных между ЦОД и клиентом. В Hexaware Technologies сообщают, что те, кому не хватает ресурсов Azure, переносят нагрузки в другие места, используют несколько регионов Azure или отправляют в облако только критически важные нагрузки до высвобождения ресурсов. В исключительных случаях Microsoft даже компенсирует дополнительные непредвиденные расходы. По имеющимся данным, Microsoft только за последний год увеличила мощность ЦОД более чем на 2 ГВт. Интенсивные вычислительные потребности ИИ привели к необходимости создания новых дата-центров. Впрочем, сегодня Microsoft не достаёт и ресурсов традиционной облачной инфраструктуры. По словам источников, OpenAI сегодня является крупнейшим облачным клиентом Microsoft, использующим серверы на основе CPU. Кроме того, такие машины применяет и сама Microsoft для обеспечения работы своих приложений. По слухам, некоторые внутренние проекты закрываются в проблемных регионах для экономии ресурсов. На ввод в эксплуатацию нового ЦОД «с нуля» могут уйти годы. Впрочем, за пределами США доступность ЦОД значительно выше. Например, многие европейские регионы Microsoft могут регистрировать новых клиентов без ограничений. По словам Microsoft, если в январе 2025 года она надеялась, что соотношение спроса и предложения в США улучшится к июню, то позже в компании стали говорить, что оптимистичным сценарием будет улучшение ситуации к декабрю. Впрочем, развитие компании не прекращается. Недавно пресс-служба отчиталась о введении в действие новых мощностей в Азии. Кроме того, Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72. Сейчас компания достраивает «самый передовой» ИИ ЦОД в мире Fairwater, а потом потратит $4 млрд на ещё один такой же.

13.10.2025 [13:50], Руслан Авдеев

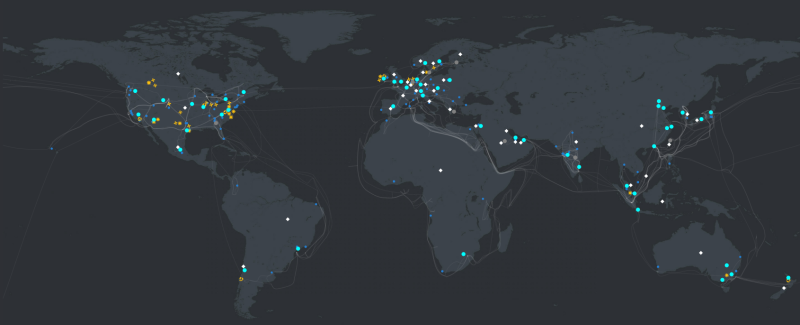

Microsoft запустила новые облачные регионы в Малайзии и Индонезии и откроет дополнительные в Индии и на ТайванеMicrosoft активно участвует в цифровой трансформации Азии, расширяя свою облачную инфраструктуру в регионе. В 2025 году компания запустила новые мощности Azure в Малайзии и Индонезии и планирует дальнейшее расширение с открытием новых облачных регионов в Индии и на Тайване в 2026 году, сообщает пресс-служба компании. Дополнительно IT-гигант намерен открыть второй регион в Малайзии — Southeast Asia 3. На азиатских рынках компания вкладывает миллиарды долларов в расширение собственной ИИ-инфраструктуры, внедряя передовые вычислительные и сетевые технологии, а также системы хранения. Инвестиции позволят бизнесам по всей Азии легко масштабироваться и использовать новые возможности для роста. Глобальная инфраструктура Microsoft охватила более 70 регионов 33 стран — это больше, чем у любого поставщика облачных услуг, утверждает компания. В Азии, где местный бизнес глубоко интегрирован в мировую экономику, дата-центры Microsoft обеспечивают бесперебойную масштабируемость, низкие задержки и соблюдение необходимых нормативов. Имея в распоряжении десяток регионов ЦОД в Азии, компания вкладывает значительные средства в расширение присутствия на континенте.

Источник изображения: Esmonde Yong/unspalsh.com В Восточной Азии исторически сложился рынок в Японии и Корее, который, как ожидается, продемонстрирует дальнейший рост и расширение. В апреле 2025 года компания запустила зоны доступности Azure в регионе Japan West, повысив надёжность и эффективность инфраструктуры в рамках двухлетнего плана инвестиций в ИИ и облачную инфраструктуру в стране. Дополнительно компания объявила о запуске Microsoft 365 и связанных решений для коммерческих клиентов в облачном регионе Taiwan North. Сервисы Azure также доступны в регионе некоторым клиентам, а в 2026 году, как ожидается, к ним получат доступ все желающие. В Юго-Восточной Азии компания тоже усиливает свои позиции, наращивая инвестиции. В мае 2025 года она запустила облачные регионы в Индонезии и Малайзии: ЦОД гиперскейл-уровня, готовность к ИИ-проектам, три зоны доступности и малая задержка для местных клиентов. Недавно введённый в эксплуатацию регион Indonesia Central — долгожданное для бизнеса дополнение, предлагающее комплексные сервисы Azure и локальную доступность Microsoft 365. Ожидается, что постоянные инвестиции в Индонезию приведут к значительному расширению местных кластеров, что позволит региону стать одним из крупнейших в Азии. Ещё весной 2024 года компания обещала вложить $1,7 млрд в облака и ИИ в Индонезии.

Источник изображения: Ernests Vaga/unsplash.com Malaysia West является первым облачным регионом в стране, с Azure и Microsoft 365. Возможностями региона уже пользуются нефтегазовый гигант из Малайзии — PETRONAS. В Малайзии Microsoft намерена открыть новый регион Southeast Asia 3 в городе Джохор-Бару (Johor Bahru). Когда регион нового поколения запустят, он будет предлагать наиболее современные и важные облачные сервисы Microsoft для сложных рабочих нагрузок. Дополнительно в 2024 году Microsoft объявила о развитии облачных технологий и ИИ-сервисов в Таиланде. В Индии уже есть несколько действующих регионов ЦОД, присутствие компании в стране будет только расширяться с запуском региона India South Central в Хайдарабаде (Hyderabad) в 2026 году. Это часть инвестиций в объёме $3 млрд, которые компания направит в течение двух лет на индийскую облачную и ИИ-инфраструктуру. В Microsoft утверждают, что инвестиции компании в инфраструктуру в Азии обусловлены потребностью в большей гибкости и оперативности в современной облачной среде. Благодаря значительным инвестициям в Азию, Microsoft может предлагать новые и более экономичные регионы Azure, подходящие как для малых, так и для крупных организаций. Новые регионы вроде Indonesia Central позволяют компаниям оптимизировать расходы на облака, сохраняя высокую производительность и доступность.

10.10.2025 [15:25], Владимир Мироненко

Бизнес Oracle по сдаче в аренду ИИ-мощностей оказался не таким прибыльным, как ожидалосьБизнес Oracle по сдаче в аренду ИИ-серверов оказался гораздо менее прибыльным, чем ранее прогнозировали фондовые аналитики, сообщил ресурс The Information после ознакомления со внутренними документами компании, о чём пишет DataCenter Dynamics. Средняя валовая рентабельность Oracle по сделкам с такими компаниями, как OpenAI, составила всего лишь 16 %, хотя выручка за последний год утроилась. Что касается новейших ускорителей NVIDIA, то компания терпит убытки, составившие почти $100 млн от сдачи в аренду чипов Blackwell за I квартал 2026 финансового года, закончившийся в августе. По данным The Information, за последний квартал Oracle выручила $900 млн от сдачи в аренду ИИ-серверов, получив валовую прибыль в размере $125 млн, или 14 центов на каждый доллар продаж. Компания не раскрывает финансовые показатели по использованию ИИ-серверов. На рентабельность влияют различные факторы, включая зарплату, стоимость электроэнергии и другие эксплуатационные расходы ЦОД Oracle, а также амортизационные расходы на оборудование. Кроме того, существует разрыв во времени между покупкой чипов и началом их использования клиентами. Oracle сообщила, что на конец I квартала 2026 финансового года благодаря подписанию многомиллиардных контрактов с тремя клиентами объём оставшихся обязательств по контрактам (RPO) составил более $455 млн. Позже выяснилось, что был заключён контракт с OpenAI на $300 млрд. Аналитики полагают, что для финансирования этой сделки Oracle может потребоваться привлечь до $100 млрд заёмных средств в течение следующих четырёх лет для наращивания мощностей. В прошлом месяце Oracle продала серию облигаций инвестиционного уровня на сумму $18 млрд для расширения бизнеса и строительства ИИ-инфраструктуры. Следует отметить, что речь идёт лишь о части бизнес-предложения Oracle. Как полагает The Information, если доля аренды ИИ-серверов в общем объёме бизнеса Oracle продолжит расти, общая валовая рентабельность снизится с нынешних 70 %. Ресурс предупредил, что это затронет всех основных провайдеров облачных услуг, поскольку ИИ-серверы на чипах NVIDIA значительно дороже традиционных серверов и их использование требует дополнительных расходов, в том числе на специализированное сетевое оборудование и электроэнергию. Чтобы привлечь клиентов, поставщики облачных услуг предлагают скидки, что также отражается на прибыльности бизнеса. The Information назвал такую ситуацию плохой новостью для Oracle, но не все эксперты разделяют это мнение. По мнению ряда аналитиков, рентабельность вполне соответствует ожиданиям. Например, согласно отчёту Investor's Business Daily, аналитик Stifel Брэд Рибак (Brad Reback) ранее прогнозировал валовую рентабельность облачного бизнеса Oracle примерно в 16 %. Он также указал в аналитической записке для инвесторов, что «по мере масштабирования этого сегмента OCI валовая рентабельность должна существенно вырасти». Аналитик Guggenheim Джон ДиФуччи (John DiFucci) тоже считает, что вышеупомянутый разрыв между вводом мощностей в эксплуатацию и оплатой клиентами не следует воспринимать как дурное предзнаменование. «Мы не удивимся, если увидим более низкую валовую рентабельность в начале сделки по обучению ИИ до начала получения дохода, но мы считаем разумным ожидать, что любая сделка будет обеспечивать не менее 25 % валовой рентабельности в течение всего срока её действия — иначе Oracle её не подпишет», — заявил ДиФуччи. Следует также учесть мнение NVIDIA по этому поводу, генеральный директор которой Дженсен Хуанг (Jensen Huang) отверг критику финансового положения Oracle, заявив, что компания «будет невероятно успешна». «Когда вы только начинаете внедрять новую технологию, вполне вероятно, что поначалу вы можете не заработать, но со временем система станет невероятно прибыльной», — сказал Хуанг.

10.10.2025 [14:50], Руслан Авдеев

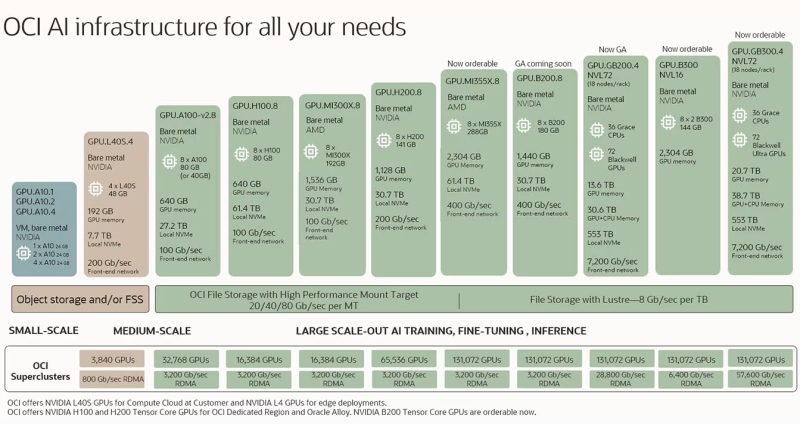

Не для себя стараемся: Microsoft развернула для OpenAI первый в мире ИИ-кластер на базе суперускорителей NVIDIA GB300 NVL72Microsoft представила первый в мире ИИ-кластер, использующий более 4,6 тыс. NVIDIA Blackwell Ultra в составе суперускорителей NVIDIA GB300 NVL72, объединённых интерконнектом Quantum-X800 InfiniBand. Этот кластер — лишь первый из многих. Компания развернёт сотни тысяч ускорителей Blackwell Ultra в ИИ ЦОД по всему миру. Благодаря им Microsoft намерена стать первой, поддерживающей обучение для моделей с сотнями триллионов параметров. Как сообщают в Microsoft, запуск в Microsoft Azure суперкластера NVIDIA GB300 NVL72 стал важным шагом в развитии передовых ИИ-технологий. Разработанная совместно с NVIDIA система представляет собой первый в мире масштабируемый ИИ-кластер на основе GB300, обеспечивающий вычислительные мощности, необходимые OpenAI для обслуживания моделей с триллионами параметров. Речь идёт о новом стандарте ускоренных вычислений, говорят компании. Новые инстансы Azure ND GB300 v6 оптимизированы для рассуждающих моделей, агентных систем и мультимодального генеративного ИИ. Каждая стойка GB300 NVL72 обслуживает 18 виртуальных машин, а сам суперускоритель с производительностью до 1,44 Эфлопс (FP4 Tensor Core) включает:

Источник изображения: Microsoft Создание передовой инфраструктуры требует переосмысления всех уровней системы, включая вычисления, память, системы охлаждения и питания, ЦОД в целом как единой структуры. Новая архитектура стоек обеспечивает высокую пропускную способность инференса при меньших задержках на крупных моделях, это позволяет агентным и мультимодальным ИИ-системам быть более масштабируемыми и эффективными, чем когда-либо, говорит компания. Для масштабирования за пределы стойки используется NVIDIA Quantum-X800 InfiniBand, что гарантирует обучения сверхбольших моделей с применением десятков тысяч ИИ-ускорителей с минимальными накладными расходами на их синхронизацию, что дополнительно повышает производительность.

Источник изображения: Microsoft Передовые системы охлаждения Azure используют автономные теплообменники, чтобы свести к минимуму расход воды и поддерживать температурную стабильность для высокоплотных кластеров. Также продолжается разработка и внедрение новых моделей распределения питания, обеспечивающих высокую энергетическую плотность и динамический баланс нагрузок. Дополнительную помощь в оптимизации работы оказывает и модернизированное программное обеспечение. Ранее Microsoft обладала эксклюзивными правами на предоставление облачных сервисов компании OpenAI, но в январе 2025 года появилась новость, что ИИ-стартапу разрешили пользоваться и облаками других провайдеров, если у Microsoft не хватит собственных мощностей. Разногласия между компаниями продолжают нарастать. Формально первенство по создание кластера на базе GB300 NVL72 принадлежит CoreWeave, имеющей тесные отношения с NVIDIA и обслуживающей OpenAI — как напрямую, так и при посредничестве Microsoft.

07.10.2025 [00:50], Владимир Мироненко

Бэкапов нет, работа стоит, надежд мало: 858 Тбайт правительственных данных безвозвратно утеряны из-за пожара в ЦОД в Южной КорееВ Южной Корее продолжаются восстановительные работы в ЦОД Национальной службы информационных ресурсов (NIRS) Южной Кореи в Тэджоне, где 26 сентября произошёл масштабный пожар, который привёл к сбою в работе 647 государственных сервисов, пишет газета The Korea JoongAng Daily. В результате пожара утеряно множество важных данных, для которых не делались бэкапы, так что некоторые подразделения теперь вынуждены по крупицам собирать сохранившуюся информацию. Как стало известно, из-за пожара было уничтожено правительственное облачное хранилище G-Drive (никак не связано с Google). Утеряно 858 Тбайт данных примерно 750 тыс. госслужащих. Платформа является обязательной для хранения документов и других файлов госслужащих. Каждому сотруднику на эти цели было выделно порядка 30 Гбайт пространства. По словам NIRS, из-за большой ёмкости и низкой производительности системы внешние резервные копии не создавались, что привело к безвозвратной потере данных. В Министерстве внутренних дел и безопасности Южной Кореи пояснили, что структура G-Drive не позволяет создавать внешние резервные копии, хотя данные большинства систем подлежат резервному копированию в хранилище в этом же ЦОД и на ещё одном физически удалённом объекте. В свою очередь, Data Center Dynamics со ссылкой южнокорейские СМИ сообщил, что G-Drive была одной из 96 полностью уничтоженных в результате пожара систем. Вместе с тем, у остальных 95 систем сохранились резервные копии данных в онлайн- или офлайн-форматах. Некоторые департаменты не пользовались G-Drive, но те, кто использовал, столкнулись с серьёзными проблемами. Сильнее всего пострадало Министерство управления персоналом, издавшее распоряжение хранить всю документацию исключительно на G-Drive. Сейчас оно собирает все оставшиеся на ПК чиновников файлы, а также почтовые сообщения, официальные документы и даже распечатки. Министерство внутренних дел и безопасности Южной Кореи отметило, что официальная отчётность также хранится в правительственной системе OnNara и может быть восстановлена после возобновления её работы. «Заключительные отчёты и официальные документы, представленные правительству, также хранятся в OnNara, поэтому это не полная потеря данных», — заявил директор по государственным услугам Министерства внутренних дел и безопасности Южной Кореи. К прошедшим выходным удалось восстановить лишь 115 из 647 пострадавших сервисов. Ожидается, что полное восстановление займёт около месяца. Правительство заявило, что будут предложены альтернативные варианты на замену наиболее важных сервисов.

03.10.2025 [17:24], Руслан Авдеев

UKPN начнёт отапливать дома британских малоимущих кластерами из сотен Raspberry Pi

hardware

raspberry pi

великобритания

кластер

микро-цод

облако

отопление

периферийные вычисления

погружное охлаждение

сжо

экология

Британская UK Power Networks (UKPN) в рамках программы SHIELD (Smart Heat and Intelligent Energy in Low-income Districts) начала устанавливать микро-ЦОД на базе одноплатных компьютеров Raspberry Pi — для отопления домохозяйств, нуждающихся в деньгах для оплаты коммунальных услуг, сообщает The Register. Выбранные домохозяйства оснастят солнечными элементами питания и аккумуляторными системами, треть из них получит и систему HeatHub — сверхкомпактный ЦОД размером с большой тепловой насос, который заменит традиционные газовые котлы. Полученные в рамках пробного развёртывания данные используют для масштабирования SHIELD, к 2030 году UKPN намерена ежегодно развёртывать 100 тыс. систем. Платформа HeatHub разработана компанией Thermify. Она предназначена для запуска облачных контейнеризированных нагрузок. Каждый HeatHub включает до 500 модулей Raspberry Pi CM4 или CM5, погружённых в масло. Полученное тепло передаётся в системы отопления и горячего водоснабжения, а сам HeatHub легко установить вместо бойлера. HeatHub имеет собственное выделенное интернет-подключение. Над внедрением «низкоуглеродных» технологий SHIELD компания UKPN сотрудничает с Power Circle Projects, жилищной ассоциацией Eastlight Community Homes и Essex Community Energy. Также она участвует над установлением нового социального тарифа на отопление на востоке и юго-востоке Англии. Малоимущие клиенты будут платить фиксированную ставку в £5,60 ($7,52) ежемесячно, а SHIELD поможет им сократить счета за электричество на 20–40 %. Куратор SHIELD со стороны Eastlight Community Homes заявил, что результаты пилотного проекта обнадёживают, его планируют опробовать ещё в сотнях домов. Это поможет семьям поддерживать комфортные условия проживания, не беспокоясь о росте цен на энергию. Для обычных пользователей у Thermify иные условия — модуль для типового дома с тремя спальнями обойдётся в £2500 ($3365), ещё £500 ($673) возьмут за установку, а за отопление будут брать £50/мес. ($67/мес.). В особых случаях плата может быть снижена вдвое, а в экстремальных ситуациях тепло будет предоставляться бесплатно. Это уже не первый проект подобного рода. Так, Heata — изначально принадлежавшая British Gas, предлагает использовать серверы в качестве домашних водонагревателей, что позволяет сократить расходы на электричество для домовладельцев. Тепло вырабатывается за счёт рабочих нагрузок облачного оператора Civo. Также пару лет назад начала работать британская Deep Green — она обеспечивает теплом предприятия и бассейны с помощью мини-ЦОД, размещаемых на их территории.

03.10.2025 [12:06], Руслан Авдеев

ВМС США с головой погрузились в облако Microsoft Azure и никак не могут выбратьсяВоенно-морские силы США объяснили, почему не могут отказаться от использования своей обособленной среде Microsoft Azure без полной реконструкции собственной облачной платформы. По данным The Register, ВМС опубликовали специальное письмо, в котором детально рассказали, почему заключили с Microsoft соглашение Strategic Cloud Platform — Enterprise Mission Integration. В документе констатируется, что для облачной среды NAVSEA, обеспечивающей доступ к программам ВМС и Министерства обороны (Министерства войны), возможен только один исполнитель, способный предоставить необходимые для работы услуги и решения. Для того, чтобы продолжать операции в среде NAVSEA, необходимо использовать сервисы Microsoft — Azure Data Transfer, Azure Kubernetes Service (AKS), Azure Structured Query Language (SQL) platform-as-a-service (PaaS), Azure Key Vault, Azure Monitor и ExpressRoute, размещённые в Microsoft GovCloud. В документе отмечается, что для смены облачного провайдера потребовалось бы переделать всё решение для военных с нуля, что потребует интеграции новой облачной среды и переделки прикладных решений, поддерживающих Defensive Cyber Operations (DCO). Это приведёт к перерыву в работе и неизбежным провалам миссий. Фактически единственным подходящим облачным провайдером является та же Microsoft, а все попытки организовать перенос с платформы компании на мощности другого провайдера столкнутся с проблемами совместимости, не соответствующими требованиям для правительственных сервисов.

Источник изображения: Sven Piper/unsplash.com Подобные выводы, по данным ВМС, подтвердились в ходе консультаций со всеми участниками программы Joint Warfighting Cloud Capability (JWCC), включая AWS, Google и Oracle. В будущем в рамках проекта NAVSEA планируется строить облачную инфраструктуру с использованием открытых стандартов контейнеризации, чтобы избежать зависимости от одного облачного провайдера-монополиста. Примечательно, что ранее в этом году Microsoft попала под прицел критиков за передачу на аутсорс в рамках программы Digital Escorts поддержки военных сервисов сотрудникам своего китайского подразделения. Сообщается, что подобная практика уже прекращена. Microsoft не впервые оказывается в центре скандала. В Евросоюзе Google целенаправленно ведёт с монополистом борьбу, обвиняя того в кратном завышении цен при использовании ПО Microsoft сторонними облачными провайдерами. Как сообщает Datacenter Dynamics, участие в программе JWCC, оцениваемой в $9 млрд, одобрили в декабре 2022 года AWS, Microsoft Azure, Google и Oracle. Она заменила предыдущее соглашение Joint Enterprise Defense Infrastructure (JEDI) от 2018 года, рассчитанное на 10 лет и $10 млрд, которое отменили из-за того, что он целиком достался Microsoft. В июле 2025 года американское правительственное Агентство оборонных информационных систем (DISA) раскрыло, что ищет новых партнёров, готовых присоединиться к программе, например, более мелких облачных провайдеров.

02.10.2025 [21:02], Владимир Мироненко

Microsoft потратит $33 млрд на доступ к 100+ тыс. NVIDIA GB300 в неооблаках, но со временем хочет перейти на свои ИИ-ускорителиВ Сети появились новые подробности о сделке стоимостью до $19,4 млрд, заключённой Microsoft с Nebius Group NV в начале сентября. Как сообщает Bloomberg со ссылкой на информированные источники, Microsoft получит пятилетний доступ к выделенной инфраструктуре на базе более чем 100 тыс. суперускорителей NVIDIA GB300. Ранее сообщалось, что речь идёт о мощностях нового ЦОД Nebius в Вайнленде (Нью-Джерси, США). Как пишет Forbes, Nebius отличается от многих облачных провайдеров тем, что фокусируется только на рабочих нагрузках ИИ и МО, что позволяет лучше оптимизировать архитектуру ЦОД в отличие от гиперскейлеров, которые занимаются решением множества задач. Кроме того, Nebius отличается от других неооблаков, таких как CoreWeave, тем, что предоставляет инструменты и сервисы для разработчиков, которые позволяют совершенствовать ИИ-модели, выполнять инференс и разрабатывать кастомные решения, а не просто фокусируется на «чистой» вычислительной мощности. При этом Nebius начала наращивать вычислительные мощности ещё до того, как возник спрос на эти ресурсы, отметил Forbes. Подобные контракты Microsoft заключила с ещё несколькими неооблаками (neocloud), включая CoreWeave, Nscale и Lambda, на общую сумму в $33 млрд, и они обеспечивают её большую выгоду. Вместо того, чтобы тратить огромные ресурсы на строительство собственных ЦОД, Microsoft обращается к проверенному поставщику ИИ-инфраструктуры, благодаря чему может быстрее совершенствовать свою ИИ-инфраструктуру с меньшими первоначальными затратами, используя высвободившиеся мощности для предоставления клиентам прибыльных услуг на базе ИИ. Вдобавок такой подход позволяет Microsoft быстрее менять стратегию, чем при использовании собственных дата-центров. В начале бума ИИ Microsoft арендовала мощности даже у Oracle, своего прямого конкурента, для поддержки ИИ-функций в поиске Bing. Эти сделки также устраняют для Microsoft значительную часть финансовых рисков, связанных со строительством собственных ЦОД. Она не только сразу получает необходимые мощности для своих ИИ-сервисов, вместо того чтобы тратить годы на строительство ЦОД, но и перекладывает на других вопросы строительства, финансирования и управление этими ЦОД, что даёт компании большую финансовую гибкость. Так, Microsoft может отнести некоторые затраты к операционным, а не капитальным, что, по словам аналитика Bernstein Марка Мёрдлера (Mark Moerdler), даёт потенциальные преимущества для денежного потока, налогообложения и способа представления прибыли в финотчётах. Компания использует серверы неооблаков не только для обучения ИИ-моделей, но и для сложного инференса. Сделки с неооблаками становятся популярными и у конкурентов Microsoft, хотя им далеко до её масштабов. В мае 2025 года OpenAI расширила с конкурирующей с Nebius компанией CoreWeave контракт стоимостью $11,9 млрд на $4 млрд, после чего заключила ещё одно соглашение на $6,5 млрд, увеличив общую сумму соглашений до $22,4 млрд. Ещё один технологический гигант Meta✴ подписал сделку с CoreWeave на сумму в $14,2 млрд, обеспечив себе доступ к её облачным ИИ-сервисов на период до 2031 года. Вместе с тем в долгосрочной перспективе Microsoft намерена переключиться на ИИ-ускорители собственной разработки, которые обеспечивают лучший показатель TCO, передаёт CNBC. Два года назад компания представила первые ИИ-чипы Maia 100. Следующее поколение этих чипов, как ожидается, появится в 2026 году. При этом компания сосредоточится не на чипах в отдельности, а будет использовать более системный подход, учитывающий вопросы охлаждения, интерконнекта и т.д. Пока что, признаёт Microsoft, в течение многих лет решения NVIDIA обеспечивали лучшее соотношение цены к производительности.

02.10.2025 [16:54], Руслан Авдеев

Затраты — выше, безопасность — ниже: Google снова посетовала на заградительное лицензирование Microsoft

google

google cloud platform

microsoft

microsoft azure

software

евросоюз

информационная безопасность

конкуренция

лицензия

облако

В Google Cloud рассказали о результатах жалобы в Еврокомиссию, поданной в связи с неконкурентными практиками лицензирования облачных сервисов компанией Microsoft. В частности, речь шла о введении денежных штрафов для компаний, использующих Windows Server на облачных платформах конкурентов Azure, сообщается в блоге Google. В компании утверждают, что Microsoft не испугало внимание со стороны регуляторов — компания намерена сохранить «заградительное лицензирование» для большинства облачных клиентов, а ситуация в целом становится только хуже. Недавно Microsoft заявила, что усилия по стимуляции клиентов к переходу в Azure «далеки от завершения» и это — один из трёх «столпов», стимулирующих рост бизнеса. Теперь Microsoft вносит новые изменения в лицензионную политику, чтобы переманить в своё облако больше клиентов, в том числе запрещая поставщикам управляемых услуг размещать некоторые рабочие нагрузки на платформах альтернативных облачных провайдеров. Это не осталось без внимания регуляторов. Так, в рамках комплексного расследования Управление по конкуренции и рынкам Великобритании (CMA) установило, что подобное лицензирование вредит пользователям облаков, мешает конкуренции, тормозит экономический рост и инновации. За поведением Microsoft, как утверждают в Google, следят всё больше регуляторов по всему миру. Отмена заградительных мер может способствовать ускорению роста экономики по всему миру. Microsoft всё ещё применяет наценку в 400 % для клиентов, решающих перенести старые рабочие нагрузки в облака конкурентов. В результате клиенты вынуждены пользоваться Azure, если хотят использовать ПО Microsoft — иначе переход будет слишком дорогим. По информации CMA, повышение цен на облачные услуги на 5 % из-за отсутствия конкуренции обходится британским компаниям в £500 млн/год. Исследование в Евросоюзе показало, что «заградительное лицензирование» обходится местным компаниям в €1 млрд/год, а в США отсутствие сильной конкуренции из-за лицензионной практики Microsoft ведёт к перерасходу средств госучреждениями на $750 млн/год.

Источник изображения: Michał Mancewicz/unsplash.com Страдают и кибербезопасность и надёжность сервисов, поскольку Microsoft фактически вынуждает клиентов работать в небезопасной единой экосистеме, в которой атаки на небезопасное ПО Microsoft распространяются даже на государственные учреждения и критически важные отрасли. А в условиях массового внедрения ИИ прекращение неконкурентной политики Microsoft является чрезвычайно важным, поскольку клиентам для доступа к ИИ в значимых масштабах приходится переходить в облака и именно клиенты должны решать, о чьих облаках идёт речь. В CMA утверждают, что с момента ужесточения условий лицензирования в последние годы облако Azure привлекало клиентов вдвое-втрое быстрее, чем конкуренты, главным образом из-за ограниченности выбора, влияющего на конкурентоспособность Европы в целом. Согласно недавним европейским исследованиям, отмена «запретительного лицензирования» может помочь ЕС высвободить €1,2 трлн дополнительного ВВП к 2030 году и обеспечить в год €450 млрд на экономии бюджетных средств и повышении производительности. Спустя год после жалобы в Еврокомиссию позиция Google остаётся прежней — ограничительное лицензирование в сфере облачных технологий вредит бизнесу и подрывает его конкурентоспособность. Для обеспечения инноваций и роста регуляторы должны положить конец антиконкурентной практике уже сейчас. Ранее сообщалось, что Google предлагала деньги европейским облачным бизнесам, входящим в ассоциацию CISPE и имевшим претензии к Microsoft, чтобы те не отзывали жалобы. Тем не менее, результатов добиться не удалось, а мелкий бизнес из Евросоюза не пошёл на конфронтацию с Microsoft, оставив в одиночестве AWS и Google Cloud. Попытки создать альтернативные решения Microsoft тоже «провалила».

01.10.2025 [14:01], Руслан Авдеев

Meta✴ подписала контракт на $14,2 млрд с ИИ-облаком CoreWeaveIT-гигант Meta✴ намерен потратить $14,2 млрд на облачные ИИ-сервисы CoreWeave до 14 декабря 2031 года. Компания станет очередным крупным клиентом «неооблачных» провайдеров, услугами которых уже пользуются Microsoft, NVIDIA и OpenAI, сообщает Datacenter Dynamics. Как заявляют в CoreWeave, соглашение подчёркивает, что за каждым технологическим прорывом в области ИИ стоят бизнес-партнёрства, которые делают его возможным. Ранее на прошой неделе CoreWeave расширила соглашение с OpenAI на $6,5 млрд, доведя общую сумму контрактов до $22,4 млрд. В августе NVIDIA объявила о намерении выкупить все нераспроданные вычислительные мощности CoreWeave до 2032 года на сумму $6,3 млрд. Microsoft же и так была якорным заказчиком компании, хотя и действовала в интересах OpenAI. CoreWeave намерена расширить клиентскую базу после того, как в ходе IPO весной её раскритиковали на концентрацию бизнеса на малом числе клиентов. Meta✴ стремится как увеличить собственные вычислительные мощности, так и облачную инфраструктуру. Компания давно создаёт собственную инфраструктуру дата-центров, и сейчас строит ЦОД мощностью более 1 ГВт. На очереди — гигантская площадка на 5 ГВт. В 2025 году прогнозируются капитальные затраты на уровне $66–$72 млрд, значительный рост затрат ожидается в 2026 году. В то же время Meta✴ остаётся крупным оптовым арендатором и клиентом облачных сервисов. В 2021 году Meta✴ объявила, что намерена расширить партнёрство с Amazon, чтобы использовать платформу для покупок компаний, уже пользующихся сервисами AWS, а также для исследований и разработок в сфере ИИ. В августе 2025 года она подписала контракт с Google Cloud на сумму $10 млрд сроком на шесть лет. Сейчас компания ведёт переговоры и с Oracle — об облачном соглашении на $20 млрд. |

|