Материалы по тегу: ии

|

08.08.2025 [11:50], Руслан Авдеев

Tesla отказалась от развития ИИ-суперкомпьютеров DojoTesla распускает команду, стоявшую за суперкомпьютером Dojo, сообщает TechCrunch со ссылкой на Bloomberg. Как сообщают анонимные источники, глава проекта Питер Бэннон (Peter Bannon) покидает компанию, а оставшихся участников команды переведут на работу с другими вычислительными проектами Tesla. О закрытии Dojo стало известно после ухода из Tesla порядка 20 сотрудников, основавших собственный ИИ-стартап DensityAI, который займётся разработкой чипов, аппаратного и программного обеспечения для ИИ ЦОД, связанных с робототехникой, ИИ-агентами и автомобильными приложениями. DensityAI основана бывшим руководителем Dojo Ганешем Венкатарамананом (Ganesh Venkataramanan), причём в не самый удачный для Tesla момент, поскольку глава компании Илон Маск (Elon Musk) ранее настоял на том, чтобы акционеры рассматривали компанию как бизнес, занимающийся ИИ и робототехникой. Решение о закрытии Dojo стало значительным изменением стратегии. Ранее Маск утверждал, что суперкомпьютер станет краеугольным камнем для удовлетворения амбиций компании в сфере ИИ и основная цель — добиться полной автономии машин благодаря способности Dojo обрабатывать огромные массивы видеоданных. В 2023 году Morgan Stanley посчитал, что Dojo может поднять капитализацию Tesla на $500 млрд за счёт новых источников дохода — проектов роботакси и программных сервисов. В 2024 году Маск сообщил, что команда Tesla, занятая искусственным интеллектом, «удвоит ставку» на Dojo перед презентацией роботакси. Тем не менее разговоры о Dojo уже в августе того же года постепенно сошли на нет, когда Маск начал продвигать ИИ-кластер Cortex (на базе ускорителей NVIDIA) при штаб-квартире Tesla в Остине (Техас). Проект Dojo включал в себя как суперкомпьютер, так и предполагал собственное производство ИИ-ускорителей. Ещё в 2021 году Tesla во время официального анонса Dojo представила чип D1, который должен был бы использоваться совместно с ускорителями NVIDIA для обеспечения работы Dojo. Также сообщалось, что ведутся работы над чипом D2, в котором будут устранены недостатки предшественника. По данным источников Bloomberg, теперь Tesla намерена сделать ставку преимущественно на NVIDIA, а также других сторонних партнёров вроде AMD, а Samsung будет выпускать чипы на заказ. В прошлом месяце с Samsung подписан контракт на выпуск инференс-чипов AI6, которые будут работать как с автопилотами Tesla, так и использоваться в роботах Optimus и дата-центрах. Ранее Маск намекнул, что в случае с Dojo 3 (D3) и инференс-чипом AI6, речь, возможно, будет идти о едином чипе. Недавно совет директоров Tesla предложил Маску пакет акций на $29 млрд, чтобы тот оставался в Tesla и продвигал ИИ-разработки компании, вместо того чтобы отвлекаться на другие бизнесы.

08.08.2025 [09:13], Руслан Авдеев

Сбавить обороты: Google сократит энергопотребление ИИ ЦОД в периоды пикового спросаGoogle объявила о новых соглашениях с американскими энергокомпаниями Indiana Michigan Power (I&M) и Tennessee Valley Authority (TVA). Договоры направлены на сокращение потребления ИИ ЦОД в периоды высокого спроса, сообщает Tech Republic. Поскольку ИИ-модели становятся всё сложнее, их обучение и запуск требует немало гигаватт энергии, иногда в течение нескольких часов или даже дней подряд, к чему энергосети не всегда готовы. Google в соглашениях с I&M и TVA обязалась переносить или вовсе приостанавливать ИИ-нагрузки небольшой срочности, если энергосеть будет перегружена — например, из-за плохой погоды или высокого спроса. Новый план разработан на основе результатов экспериментального соглашения с Omaha Public Power District (OPPD), в результате которого энергопотребление, связанное с машинным обучением, неоднократно и успешно снижалось в 2024 году. В Google подчёркивают, что подобная гибкость помогает снизить потребности в строительстве новых ЛЭП, электростанций и помогает операторам эффективнее управлять энергосетями. Компания начала внедрять перераспределение нагрузок между своими ЦОД в разных регионах в 2020 году, а два года назад она начала учитывать состояние энергосетей и перемещать или откладывать некритичные нагрузки. Похожую систему создала и Microsoft, правда, в обоих случаях изначально ставилась задача не повышения устойчивости энергосетей, а улучшение экологических показателей.

Источник изображения: Andrey Metelev/unspalsh.com По данным Indiana Michigan Power, по мере добавления в систему новых крупных нагрузок компания вынуждена сотрудничать с клиентами для эффективного управления генерацией и передачей энергии. Способность Google перераспределять рабочие нагрузки будет очень ценными «инструментом» для удовлетворения растущих потребностей в питании. Впрочем, некоторые рабочие нагрузки вроде поиска, карт, задач клиентов Google Cloud или заказчиков из сферы здравоохранения приостановить нельзя, поэтому внедрять технологии «гибкого спроса» будут только на некоторых площадках — там, где это не повлияет на надёжность обслуживания. Как сообщает Datacenter Dynamics, это не первая попытка Google координации с энергетиками и управления ресурсами. В апреле принадлежащий компании проект Tapestry договорился с PJM Interconnection об использовании ИИ для упрощения и ускорения присоединения объектов к энергосети. На первом этапе будут автоматизированы процессы, сегодня выполняющиеся специалистами-планировщиками. Со временем предполагается разработать для электросетей сервис наподобие Google Maps. Помимо Google, некоторые компании в последние месяцы уже объявили о намерении использовать ИИ для «умного» координирования задач в зависимости от спроса на электричество. В мае GridCare объявила о запуске проекта, который позволит находить в действующей энергосети «географические» и «временные» возможности использования электричества, что, по словам компании, позволит сократить время на подключение ЦОД к сети до 6–12 месяцев.

07.08.2025 [17:36], Руслан Авдеев

Dell'Oro Group: мировые капитальные затраты на ЦОД достигнут $1,2 трлн к 2029 году — половина придётся на гиперскейлеровПо расчётам экспертов, капитальные затраты (CAPEX) на дата-центры продолжат расти и достигнут рекордных значений благодаря инвестициям в ИИ-инфраструктуру. Аналитики Dell'Oro Group выступили с прогнозом на ближайшие годы, сообщает Datacenter Dynamics. По данным группы, прогнозируется мировой совокупный среднегодовой темп роста (CAGR) на уровне 21 %, капитальные затраты к 2029 году достигнут $1,2 трлн. Это на $200 млрд больше, чем прогноз от февраля 2025 года. По словам компании, прогноз повышен в связи с быстрым внедрением ИИ. По мнению экспертов, на GPU и ASIC сегодня приходится около трети от общего объёма капитальных затрат на дата-центры, что превращает их в крупнейшие драйверы роста соответствующего рынка. Ожидается, что расходы на вспомогательную инфраструктуру вроде стоек, вычислительных мощностей общего назначения, хранилищих, сетей и здания также окажутся высокими. Ожидается, что на долю крупнейших гиперскейлеров, включая Amazon (AWS), Google, Meta✴ и Microsoft придётся половина расходов. IT-гиганты активно разрабатывают вертикально интегрированные решения полного цикла и кастомизированные архитектуры, чтобы максимизировать производительность ИИ-вычислений и снизить их стоимость.

Источник изображения: Satyawan Narinedhat/unsplash.com Всё это в сочетании с продолжающимися инвестициями со стороны государственного и частного секторов стимулирует волну глобального расширения инфраструктуры ЦОД. Ожидается, что прочие поставщики облачных сервисов, включая т.н. неооблака, будут расти в среднем по 39 % в год. По прогнозам экспертов, в следующие пять лет гиперскейлеры, «необлачные» операторы и колокейшн-провайдеры получат около 50 ГВт новых мощностей. Хотя в 2025 году не исключается кратковременное замедление рынка, ожидается, что долгосрочные инвестиции поддержат рост в течение всего прогнозируемого периода. К 2029 году расходы на обучение ИИ и специальные рабочие нагрузки могут составить около половины расходов на инфраструктуру ЦОД. Столь оптимистичный прогноз появился после новостей о том, что в этом году капитальные расходы на ИИ лидировали в экономике США. В Renaissance Macro Research подчёркивают, что капитальные затраты на ИИ за последние два квартала сделали больший вклад в рост ВВП США, чем все потребительские расходы вместе взятые. В 2025 году на долю крупнейших гиперскейлеров — Amazon, Google, Meta✴ и Microsoft — придётся почти половина капитальных затрат мира на ЦОД. Microsoft намерена потратить на расширение инфраструктуры $80 млрд, Google — $85 млрд, а Meta✴ до $72 млрд. В лидерах Amazon, которая планирует вложит в инфраструктуру рекордные $118 млрд.

06.08.2025 [16:30], Руслан Авдеев

Cerebras Systems может привлечь частное финансирование на $1 млрд, это способно привести к задержке IPOРазрабатывающая гигантские микросхемы компания Cerebras Systems намерена привлечь до $1 млрд частных инвестиций. Это может привести к отсрочке ранее запланированного выхода компании на IPO, сообщает The Information. По сведениям издания, обсуждение дополнительного финансирования продолжается. Если новые меры по привлечению средств будут реализованы, это, вероятно, отсрочит публичное размещение акций Cerebras, которое изначально было запланировано на конец года. В 2024 году компания подала заявку на IPO в Комиссию по ценным бумагам и биржам США (SEC). Цена акций и ожидаемая рыночная капитализация не раскрывались. Тем не менее, компания до сих пор не вышла на биржу, поскольку оказалась под пристальным вниманием регуляторов и спецслужб из-за своих клиентов. На момент подачи заявки 87 % выручки компании за I полугодие 2024 года приходились на компанию G42 из ОАЭ, со штаб-квартирой в Абу-Даби (Abu Dhabi).

Источник изображения: UX Indonesia/unspalsh.com Отмечалось, что соотношение выручки с 2023 года не изменилось. В июле того же года компании анонсировали инвестиции G42 на $900 млн в ИИ-платформу в США на базе суперчипов Cerebras. Кроме того, в марте G42 планировала приобрести более 22 млн акций Cerebras в ходе IPO, однако по запросу регулятора компания изменила условия соглашения: теперь G42 может купить только неголосующие акции. При этом Cerebras и G42 уже открыли дата-центры в Калифорнии, Техасе и Миннесоте. Со временем появилась информация, что выход Cerebras на IPO откладывается из-за нехватки чиновников и подозрениях в тайных связях G42 с Китаем. Ещё в конце 2024 года сообщалось, что США опасаются, что Китай получит доступ к ИИ-суперчипам при посредничестве ОАЭ.

06.08.2025 [15:23], Руслан Авдеев

Meta✴ заказала ИИ-серверы Santa Barbara с кастомными ASICMeta✴ разместила заказ на поставку ИИ-серверов нового поколения на базе ASIC-модулей у тайваньского производителя Quanta Computer. Компания заказала до 6 тыс. стоек и намерена начать развёртывание серверов Santa Barbara к концу 2025 года, сообщает Datacenter Dynamics. Новые серверы заменят существующие решения Minerva. В отчёте также указано, что серверы нового поколения будут иметь TDP более 180 кВт и потребуют тщательно кастомизированных корпусов, систем водяного охлаждения и других компонентов. Все компоненты будут поставляться компанией SynMing Electronics. По данным отчёта, поставкой ASIC займётся Broadcom, а сборкой серверов — Quanta Computer. Окончательный дизайн будет утверждён в текущем квартале, а пробное производство начнётся в IV квартале 2025 года. Как сообщают «источники в цепочке поставок», IT-гигант завершил разработки проектных решений для двух–трёх новых серверов с кастомными ИИ-ускорителями. Хотя прямо ASIC не упоминается, Meta✴ давно работает над собственными ИИ-чипами Meta✴ Training and Inference Accelerator (MTIA), которые разрабатываются с 2023 года. Компания рассчитывает внедрить чипы в собственные дата-центры, чтобы снизить зависимость от NVIDIA.

Источник изображения: UX Indonesia/unspalsh.com С началом бума генеративного ИИ Meta✴ стремится расширить серверную ИИ-инфраструктуру и самостоятельно разрабатывать ASIC. В феврале 2024 года компания, похоже, искала специалистов по ASIC-решениям, размещая объявления о поиске соответствующих сотрудников в Индии и Калифорнии. В марте 2025 года южнокорейская FuriosaAI, занимающийся разработкой микросхем, отклонила предложение Meta✴ о покупке бизнеса за $800 млн. На прошлой неделе были опубликованы результаты за II квартал 2025 года, согласно которым выручка составила $47,5 млрд, что на 22 % больше по сравнению с аналогичным периодом прошлого года. Прибыль компании выросла на 36 %, составив $18,3 млрд за три месяца, заканчивающиеся 30 июня, но расходы Meta✴ также увеличились на 12 %, до $27 млрд, что связано с ростом затрат на дата-центры, серверы и исследователей в области ИИ. На пресс-конференции, посвящённой финансовым результатам компании, было объявлено, что наибольшая часть капитальных затрат в будущем будет направлена на серверы. Также было заявлено, что компания всё ещё решает, когда будут развёртываться новые мощности.

05.08.2025 [17:01], Руслан Авдеев

ИИ-серверы победили электромобили — Foxconn сменит профиль предприятия в Лордстауне [Обновлено]Тайваньский контрактный производитель Foxconn продал в США завод по выпуску электромобилей. Вместо этого площадка будет использоваться для производства ИИ-серверов, сообщает The Register, и, возможно, получит ИИ ЦОД Stargate. В понедельник компания подала заявление о продаже завода в Лордстауне (Lordstown, Огайо), который Foxconn приобрела в 2022 году у стартапа Lordstown Motors. При этом компания сохранит своё присутствие на объекте и займётся другими видами деятельности. Сообщается, что завод был продан, поскольку североамериканский рынок электромобилей производитель посчитал слишком слабым — производственные мощности значительно превышают спрос. О переходе на выпуск ИИ-серверов сообщили несколько известных изданий, включая The Wall Street Journal и Nikkei. Новость появилась через несколько дней после объявления о заключении стратегического альянса с тайваньской TECO Electric & Machinery. Предполагается, что альянс поможет партнёрам развивать бизнес в сфере ИИ ЦОД. TECO выпускает энергетическую инфраструктуру, необходимую для строительства дата-центров, а Foxconn производит практически всё, что нужно их клиентам.

Источник изображения: Michael Bowman/unsplash.com Foxconn уже пообещала расширить присутствие в США, чтобы производить ИИ-оборудование для Apple и других локальных клиентов. Смена профиля завода в Лордстауне с электромобилей на ИИ-серверы поможет компании развивать более прибыльный бизнес. Впрочем, ранее компания обещала создать базовую платформу для электромобилей, чтобы иметь возможность получать заказы от автоконцернов. Будущее этого плана теперь под вопросом. Foxconn не впервые отказывается от масштабных проектов в США — ранее она не стала строить обещанный завод по выпуску ЖК-дисплеев в Висконсине, который сегодня не пользуется прежним спросом. Площадка досталась Microsoft, которая намеревелась построить ИИ ЦОД в интересах OpenAI, но потом отложила эту затею. Тем не менее, очередная смена профиля завода Foxconn вполне соответствует новому плану президента США, который решительно настроен добиться первенства США в сфере ИИ. В частности, иностранным компаниям, вложившимся в местное производство, обещаны скидки на пошлины. В минувший понедельник совет директоров Tesla объявил о выделении главе компании Илону Маску (Elon Musk) 96 млн акций стоимостью $29 млрд, поскольку «сохранение Илона сейчас важнее, чем когда-либо», т.к. компания переходит от «лидерства в сфере электромобилей и источников энергии к достижению лидерства в области ИИ, робототехники и связанных с ними услуг». Возможно, это будет означать, что Tesla также будет закупать ИИ-серверы у Foxconn или поручит тайваньской компании производить своих роботов. Сама Tesla отказалась от развития собственных ИИ-суперкомпьютеров Dojo. UPD 08.08.2025: по данным Bloomberg, покупателем завода станет SoftBank, которая, возможно, со временем развернёт тут же и дата-центр в рамках проекта Stargate. Сумма сделки составит $375 млн.

05.08.2025 [15:16], Владимир Мироненко

Великобритания не станет соревноваться с США и Китаем в гонке ИИ, а сосредоточится на его внедренииБритании не следует пытаться конкурировать с Америкой, Китаем и странами Персидского залива, которые вливают сотни миллиардов долларов в огромные, энергоёмкие ЦОД для обучения ИИ, поскольку для этого у неё нет ни достаточного количества денег, ни свободной земли, ни энергетических ресурсов, заявил Институт глобальных изменений Тони Блэра (Tony Blair Institute for Global Change, TBI), передаёт The Register. Вместо этого TBI предлагает сосредоточиться на широком внедрении ИИ, хотя и это потребует увеличения местных вычислительных мощностей. Великобритании необходимо «серьёзно относиться к инфраструктуре», чтобы оставаться конкурентоспособной в эпоху ИИ и решать системные проблемы, которые невозможно решить в одночасье, указала в отчёте TBI, добавив, что для этого строительство ЦОД должно стать национальным стратегическим приоритетом. Правительство должно сосредоточиться на развёртывании и широком внедрении ИИ, «демонстрируя миру, как эффективно применять его в таких секторах, как здравоохранение, образование, государственное управление, оборона и наука». Именно здесь будут экономические выгоды, способствующие повышению производительности, улучшению государственных услуг и стимулированию инноваций во всей экономике, утверждает TBI. Институт Тони Блэра назвал нынешнюю ситуацию «катастрофической», поскольку Великобритания поставила ИИ в центр своих целей роста и безопасности, но при этом не имеет достаточной инфраструктуры для их реализации. При нынешних темпах строительства ЦОД Великобритания, вероятно, не достигнет целевого показателя к 2030 году — 6 ГВт ИИ-мощностей. Этому препятствуют задержки в планировании и выдаче разрешений, ограничения национальной энергосети и стремительный рост цен на промышленную электроэнергию. Опасения института подтверждает отчёт fDi Intelligence (подразделение Financial Times), в котором утверждается, что Великобритания может столкнуться к 2030 году с дефицитом необходимых вычислительных мощностей ЦОД до 5 ГВт. Отчёт основан на анализе, проведённом по заказу Министерства науки, инноваций и технологий (DSIT) Великобритании. Согласно документу, предложение ЦОД почти удвоится с нынешних 1,8 ГВт мощностей до 3,3 ГВт, в то время как ожидаемый спрос составит от 5,1 ГВт до 8,5 ГВт. TBI также отметил, что большая часть вычислительных мощностей сосредоточена вокруг Лондона и не оптимизирована для ИИ. Институт рекомендует правительству следовать стратегии «ускоренной диверсификации», что означает быстрое создание устойчивой инфраструктуры, для чего необходимо внести изменения в законодательство для привлечения новых инвестиций, а также распределить вычислительные мощности по регионам для повышения устойчивости и поддержания сильной внутренней экосистемы. Кроме того, Национальный оператор энергетической системы (NESO) обязан учесть спрос на ЦОД (по оценкам DSIT) в национальных планах и поддерживал их «динамические обновления». Институт отметил, что Совет по энергетике ИИ (AI Energy Council), сформированный в прошлом году, было поручено решение этих задач, но он действует в условиях традиционной для британского правительства атмосферы секретности. Поэтому рекомендуется вместо этой структуры сформировать в рамках NESO группу экспертов по ИИ и ЦОД для поддержки планирования спроса и ускорения интеграции ИИ в энергосистему. Также предлагается ускорить процесс планирования, чтобы решения принимались в течение восьми месяцев, и использовать полномочия министерских комиссий для проектов ЦОД и энергетики. Как сообщает The Register, правительство уже приступило к реализации этих предложений, присвоив ЦОД статус критически важной национальной инфраструктуры (CNI). Присвоение им статуса инфраструктурных проектов национального значения (NSIP) позволяет обращаться в центральную Инспекцию по планированию (PINS) за разрешением на строительство, минуя местные органы власти. Рекомендации также включают создание серии гигаваттных АЭС и реформирование регулирования атомной энергетики для ускорения строительства и снижения затрат. Заодно предложены и шаги, аналогичные тем, что были сделаны в США: разрешение размещать ИИ ЦОД рядом с источниками энергии, выделение государственных земель для строительства ЦОД и электростанций, сотрудничество с частным девелоперами. Вместе с тем The Register говорит об опасениях, что все эти инвестиции в ИИ могут оказаться просто раздуванием пузыря. В отчёте McKinsey & Company сообщается о беспокойстве инвесторов по этому поводу, поскольку никто точно не знает, каким будет уровень спроса на ИИ в будущем. В то же время другие исследования показали, что генеративный ИИ до сих пор не оказал существенного влияния на заработки или количество отработанных часов ни в одной из профессий, несмотря на уже потраченные миллиарды долларов на создание и обучение ИИ-моделей. Точность агентского ИИ недавно оказалась в центре внимания общественности, когда Gartner опубликовал прогноз, согласно которому к концу 2027 года 40 % ИИ-проектов будут закрыты из-за роста затрат, неясной ценности для бизнеса или недостаточного контроля рисков.

05.08.2025 [12:11], Руслан Авдеев

Hyundai поможет Fermi America построить в Техасе «ядерный» ЦОД HyperGridЯдерная энергетика в США переживает своеобразное возрождение — гиперскейлеры и компании поменьше столкнулись с ненасытными аппетитами ИИ. На этом фоне Fermi America выбрала южнокорейскую Hyundai для поддержки развёртывания до 6 ГВт ядерных мощностей в рамках проекта HyperGHrid в Амарилло (Amarillo, Техас), сообщает The Register. Проект строительства «крупнейшего в мире энергетического кампуса» поддержан политиками и инвесторами. Его цель — превратить Техас в крупнейший энергетический и вычислительный центр США. Строительство в Амарилло первого из четырёх реакторов Westinghouse AP1000 планируется начать в 2026 году. Согласно меморандуму, к 2032 году АЭС будет снабжать электричеством ЦОД напрямую. Пока нет гарантий, что проект площадью 2,3 тыс. га действительно будет реализован полностью, но курировать его в любом случае будет Hyundai. Компания хорошо разбирается в атомной энергетике и уже участвовала в развёртывании 22 реакторов. Проект будет довольно дорогим. Один реактор AP1000 оценивался два года назад в $6,8 млрд. Впрочем, с масштабами проектов гиперскейлеров и облачных гигантов это несопоставимо — они ежегодно тратят десятки миллиардов долларов. Правда, строительство может оказаться не таким уж дешёвым и быстрым. Например, на строительство двух аналогичных реакторов в Джорджии ушло 15 лет и более $36 млрд. Конечно, ситуацию не улучшило и банкротство Westinghouse в 2017 году, в самый разгар строительства.

Источник изображения: Gabriel Tovar/unsplash.com Как именно Fermi America намерена оплатить строительство хотя бы одного реактора AP1000, не говорится. Известно, что Hyundai также поддержит развертывание газовых электростанций с парогазовым циклом мощностью 4 ГВт, 1 ГВт солнечных электростанций и накопителей, а также малых модульных реакторов (SMR) на 2 ГВт. Кто именно будет поставщиком SMR, пока не сообщается. На данный момент только NuScale ближе всех к запуску своего первого SMR. Пока Fermi America и Hyundai решают вопросы с регуляторами относительно ядерного проекта, строительство «газовой» части 11-ГВт мегапроекта уже началось. В июле Fermi America сообщила о намерении купить газогенераторы мощностью 600 МВт для поддержки первых дата-центров, которые должны быть запущены до конца текущего года. Речь идёт о шести газовых турбинах Siemens Energy SGT800, и одной паровой турбине SST600, которые в совокупности обеспечат 478 МВт. Также Fermi America объявила о покупке «восстановленных» турбин GE Frame 6B мощностью 135 МВт. По словам компании, новые генераторы на треть «чище» традиционных, а использование специальных каталитических систем дополнительно сократит выбросы. К концу 2026 года Fermi America намерена довести генерацию до 1 ГВт. Впрочем, это далеко не первая компания, предложившая концепцию «атомных» ЦОД. За последние годы появилось множество подобных инициатив. Ещё в 2023 году Green Energy Partners представила концепцию строительства огромного ЦОД в Вирджинии, полностью работающего на SMR и водородных генераторах. Не так давно Amazon потратила $650 млн, чтобы приобрести объекты Cumulus Data у АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle заявлила о намерении развернуть три SMR общей мощностью более 1 ГВт.

05.08.2025 [11:28], Владимир Мироненко

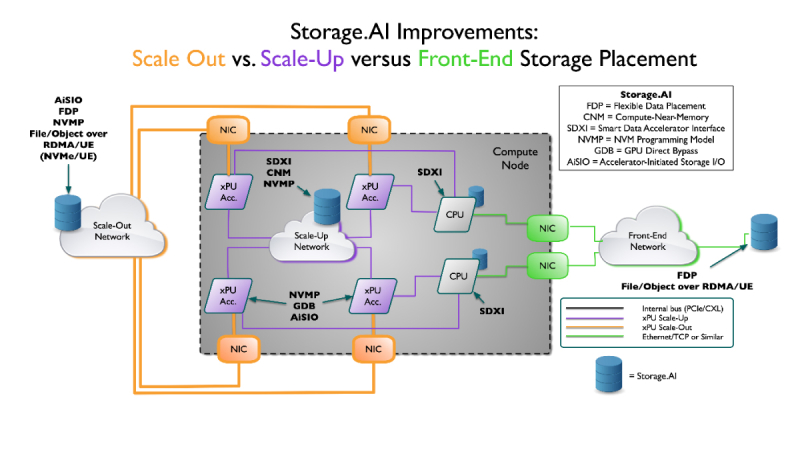

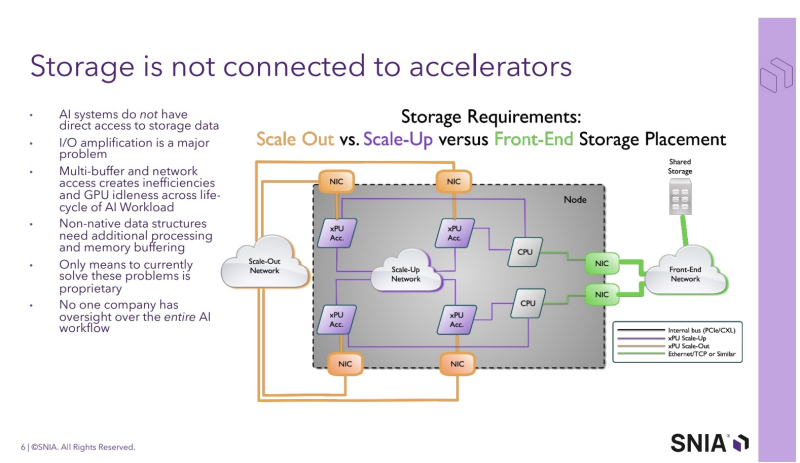

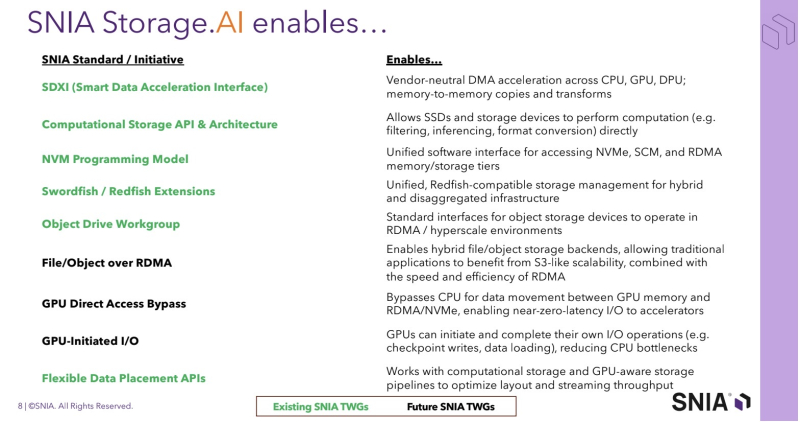

SNIA анонсировала проект Storage.AI для стандартизации обработки ИИ-нагрузокStorage Networking Industry Association (SNIA) — некоммерческая организация, специализирующаяся на технологиях обработки и оптимизации данных — анонсировала проект Storage.AI, основанный на открытых стандартах для эффективных сервисов обработки данных, связанных с рабочими ИИ-нагрузками. Проект будет сфокусирован на стандартных для отрасли, непатентованных и нейтральных подходах к решению задач, связанных с обработкой данных для ИИ, с целью оптимизации производительности, энергоэффективности и экономичности соответствующих рабочих процессов. К инициативе уже присоединились AMD, Cisco, DDN, Dell, IBM, Intel, KIOXIA, Microchip, Micron, NetApp, Pure Storage, Samsung, Seagate, Solidigm и WEKA. Отдельно отмечается отсутствие NVIDIA — крупнейшего поставщика ИИ-ускорителей. Как указано в пресс-релизе, рабочие ИИ-нагрузки чрезвычайно сложны и ограничены такими факторами, как задержки, доступное пространство, энергопотребление и охлаждение, объём памяти и стоимость. Решение этих проблем в рамках открытой отраслевой инициативы рассматривается как наиболее быстрый путь к оптимизации и широкому внедрению ИИ. По словам Дж. Метца (J Metz), председателя SNIA, беспрецедентные требования со стороны ИИ требуют целостного взгляда на весь конвейер данных — от храненилищ и памяти до сетевых технологий и вычислений. Он подчеркнул, что Storage.AI предоставляет отраслевому сообществу независимую от вендоров платформу, предназначенную для координации широкого спектра сервисов обработки данных и создания эффективных, открытых решений, необходимых для ускоренного внедрения ИИ-технологий. Инициатива координирует ряд технических спецификаций, которые до сих пор существовали обособленно и не были адаптированы под нужды ИИ-нагрузок. Первоначальный набор спецификаций включает:

Предполагается, что в рамках проекта Storage.AI будет создана открытая экосистема эффективных сервисов обработки данных, способных справляться с наиболее сложными задачами, связанными с ИИ-нагрузками, и устранять текущие пробелы в обработке и доступе к данным. В обеспечении широкой поддержки экосистемы также примут участие партнёры SNIA, включая UEC, NVM Express, OCP, OFA, DMTF и SPEC.

04.08.2025 [16:21], Руслан Авдеев

AEP увеличит мощности подключений ЦОД на 18 ГВт к 2029 году — Exelon, PPL и PG&E прогнозируют ещё десяткиКлючевая для США коммунальная группа American Electric Power (AEP) сообщила о планах увеличить электрические мощности для ЦОД на 18 ГВт к 2029 году. Не менее впечатляющие цифры обнародовали и некоторые другие коммунальные компании США, а некоторые даже превзошли AEP, сообщает Datacenter Dynamics. В финансовом отчёте AEP за II квартал говорится о росте операционной прибыли на акцию, что в первую очередь обусловлено увеличением числа подключаемых дата-центров. Именно на их долю придётся наибольшая часть новой нагрузки из 24 ГВт, прогнозируемой к концу десятилетия. Благодаря развитию рынка ЦОД объём проектов в очереди на подключение к сети вырос до 190 ГВт, что привело к увеличению пятилетнего инвестиционного плана на 30 % — до $70 млрд. Средства распределены на развитие передачи электроэнергии (50 %), генерации (40 %) и распределительных сетей (10 %). Сообщается, что на все 24 ГВт уже подписаны будущие соглашения, что защищает от возможных колебаний спроса.

Источник изображения: Randy Laybourne/unsplash.com Энергокомпания зафиксировала рост пикового спроса на электроэнергию более чем на 4 ГВт по сравнению с прошлым годом. Основная причина — ввод в эксплуатацию новых ЦОД в Индиане, Огайо и Техасе. По словам руководства компании, район её ответственности чрезвычайно привлекателен для операторов ЦОД: здесь есть достаточное количество оптоволоконных соединений, доступ к воде и крупнейшая в стране ЛЭП, включая магистральную сеть на 765 кВ. Впрочем, в компании признают, что в сфере ЦОД остаётся немало нерешённых задач. Приоритет AEP — предложение инновационных решений. Особо отмечено соглашение с AWS и Cologix о поставке электроэнергии с помощью твёрдооксидных топливных элементов Bloom Energy. В прошлом году AEP Ohio подписала с Bloom соглашение о поставке до 1 ГВт для ЦОД. Также подчёркивается важность нового законодательства для ЦОД. Недавно регуляторы в Огайо утвердили нормы, согласно которым новые дата-центры должны будут оплачивать не менее 85 % заявленной ежемесячной потребности в энергии, даже если фактическое потребление окажется меньше, — для покрытия расходов на инфраструктуру. Тем временем Exelon объявила, что в очереди на подключение к её сетям находятся ЦОД общей мощностью 33 ГВт. Компания обслуживает более 10 млн клиентов в Делавэре, Иллинойсе, Мэриленде, Нью-Джерси, Пенсильвании и Вашингтоне, контролируя шесть коммунальных предприятий. Из этих 33 ГВт 17 ГВт уже находятся в очереди на подключение, а ещё 16 ГВт, вероятно, будут официально добавлены в этом году. От общего объёма 10 % должны быть подключены к 2028 году, ещё треть — к 2030-му и 75 % — к 2034-му. Для удовлетворения спроса владелец сетей даже рассматривает возможность строительства собственных электростанций. Правда, в нескольких штатах такая практика запрещена по антимонопольным соображениям, но законы могут пересмотреть на фоне энергодефицита. В целом финансовые показатели компании заметно различаются по штатам.

Источник изображения: Miguel Bruna/unsplash.com Также появились данные о показателях за II квартал крупнейшей в Калифорнии коммунальной компании Pacific Gas and Electric Company (PG&E). Сейчас в очереди на подключение к её сетям находятся ЦОД суммарной мощностью 10 ГВт, которые должны быть подключены в течение ближайших десяти лет. Ещё в мае речь шла о 8,7 ГВт, а в феврале — о 5,5 ГВт. Из этих 10 ГВт 17 проектов дата-центров суммарной мощностью 1,5 ГВт находятся в завершающей стадии проектирования. Их ввод в эксплуатацию намечен на 2026–2030 гг. Большинство объектов расположено в Кремниевой долине. Предполагается, что подключения благоприятно скажутся на стоимости электричества для налогоплательщиков, обеспечив экономию на уровне 1–2 % в месяц. Кроме того, рост спроса позволит активнее использовать энергетическую инфраструктуру: по данным PG&E, в зоне ответственности компании она задействована лишь на 45 %. При этом компания сможет получать за это больше дохода. Однако, несмотря на прогресс в подключении ЦОД, финансовые показатели PG&E во II квартале оказались слабыми: операционные и эксплуатационные расходы выросли на 3,7 %. Ранее компанию обвиняли в причастности к пожарам из-за неудовлетворительного обслуживания сетей, что вынудило увеличить расходы. В прошлом году компания объявила о планах построить три ЦОД в Сан-Хосе (San Jose) общей мощностью 200 МВт. Проект реализуется совместно с Westbank. В прошлом месяце PG&E подписала первое в своём роде соглашение с Сан-Хосе об оптимизации и гарантиях поставок энергии для дата-центров и других крупных клиентов. Также недавно компания заключила соглашение с бизнесом Smart Wires о проекте по повышению надёжности сети и поддержке роста энергопотребления ЦОД в Сан-Хосе. Наконец, PPL Electric, которая в основном обслуживает Пенсильванию, объявила, что запросы со стороны ЦОД вырастут с 800 МВт в 2026 году до 14,4 ГВт в 2034-м. Часть проектов общей мощностью 5 ГВт уже были публично анонсированы. Среди них гигантский ИИ ЦОД AWS стоимостью $20 млрд, а также целый ряд других объектов поменьше. В конце 2024 года сообщалось, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. |

|