Материалы по тегу: ии

|

10.09.2025 [12:44], Сергей Карасёв

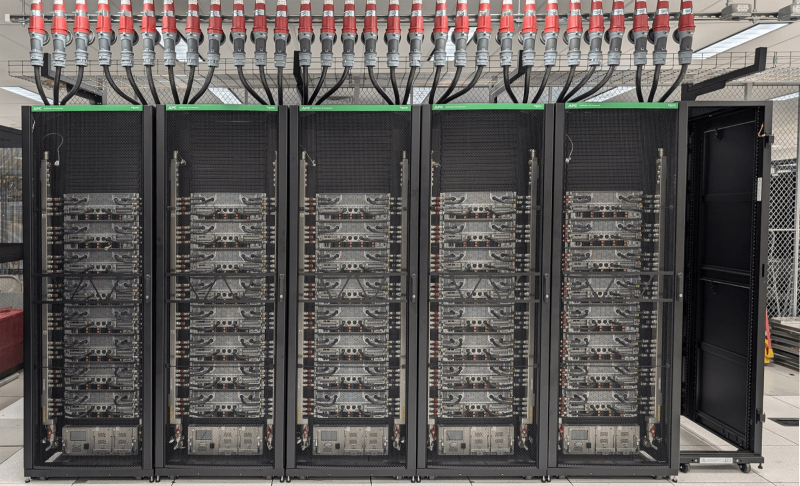

В облаке Vultr по всему миру стали доступны ускорители AMD Instinct MI355XЧастный облачный провайдер Vultr объявил о том, что в его глобальной инфраструктуре стали доступны ускорители AMD Instinct MI355X, официально представленные в июне нынешнего года. Утверждается, что эти изделия устанавливают новый стандарт соотношения цены и производительности для ресурсоёмких ИИ-задач, в частности, инференса. Решение Instinct MI355X построено на архитектуре AMD CDNA 4-го поколения. Устройство располагает 288 Гбайт памяти HBM3E, пропускная способность которой достигает 8 Тбайт/с. Применяется жидкостное охлаждение. Упомянута поддержка программного стека AMD ROCm. На сайте Vultr говорится, что теоретическая производительность ИИ при использовании в конфигурации 8 × Instinct MI355X OAM достигает 20,1 Пфлопс в режиме FP16, 40,3 Пфлопс на операциях INT8/FP8 и 80,5 Пфлопс в режиме FP4. При развёртывании ускорителей Instinct MI355X в своём облаке Vultr тесно сотрудничала с AMD и Supermicro. Благодаря 32 облачным регионам на шести континентах Vultr гарантирует низкую задержку и высокую доступность вычислительных мощностей. Стоимость услуг, как утверждается, ниже по сравнению с аналогичными предложениями гиперскейлеров. Ускорители Instinct MI355X подходят не только для инференса и обучения ИИ-моделей, но и для других нагрузок HPC, таких как симуляции, сложное моделирование или обработка больших массивов данных.

09.09.2025 [23:00], Руслан Авдеев

Fermi America, стоящая за мегапроектом 11-ГВт ИИ ЦОД HyperGrid с питанием от АЭС, собралась на биржу

fermi america

hardware

ipo

westinghouse

аэс

ии

полезные ископаемые

сша

финансы

цод

электропитание

энергетика

Стоящая за проектом строительства 11-ГВт кампуса ИИ ЦОД HyperGrid в Амарилло (Техас) Fermi America подала заявку на IPO. Она намерена разместить обыкновенные акции на бирже Nasdaq Global Select Market, но их количество и ценовой диапазон пока не определены, сообщает пресс-служба компании. UBS Investment Bank, Cantor и Mizuho станут главными андеррайтерами, а Macquarie Capital, Stifel и Truist Securities — дополнительными. По данным Datacenter Dynamics, Fermi работает над Project Matador, в рамках которого и предполагается построить 11-ГВт кампус площадью 167 га. В проекте участвует объединение технических университетов штата (Texas Tech University System). Кампус построят на территории Техасского технологического университета (Texas Tech University, TTU). Сооснователем компании является бывший министр энергетики и бывший губернатор Техаса Рик Перри (Rick Perry). Ввод в эксплуатацию первой очереди на 1 ГВт запланирован на конец 2026 года, но само строительство ещё не начато. Fermi будет использовать локальные источники энергии, включая газовые, солнечные и ветряные электростанции. В июле компания приобрела более 600 МВт мощностей в рамках двух сделок — в том числе девять газовых генераторов, которые в 2026 помогут получть ЦОД до 1 ГВт. Впрочем, газовые турбины будут основным источником энергии лишь в краткосрочной перспективе — Fermi намерена разместить на площадке четыре PWR-реактора Westinghouse AP1000 поколения III+ c электрической мощностью около 1,1 ГВт. Fermi и Westinghouse подали регуляторам совместную заявку Combined Operating License Application (COLA), чтобы ускорить получение разрешений.

Источник изображения: Fermi America Параллельно Fermi подписала два других «атомных» соглашения — меморандумы о взаимопонимании с южнокорейскими Hyundai и Doosan Enerbility, поскольку есть риск не уложиться в сроки и бюджеты. Последний энергоблок AP1000 заработал в США в 2023 году, на семь лет позже запланированного. На АЭС ушло на $17 млрд больше запланированного, причём сама Westinghouse в процессе строительства прошла через банкротство. В сентябре Fermi успешно привлекла $100 млн в раунде финансирования серии C, который возглавила австралийская Macquarie Group. Последняя также открыла для Fermi кредитную линию на $250 млн. Это не первая компания, предложившая концепцию прямого питания ЦОД от АЭС. AWS потратила $650 млн, чтобы приобрести кампус около АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle объявила о намерении развернуть три SMR общей мощностью более 1 ГВт.

09.09.2025 [17:00], Владимир Мироненко

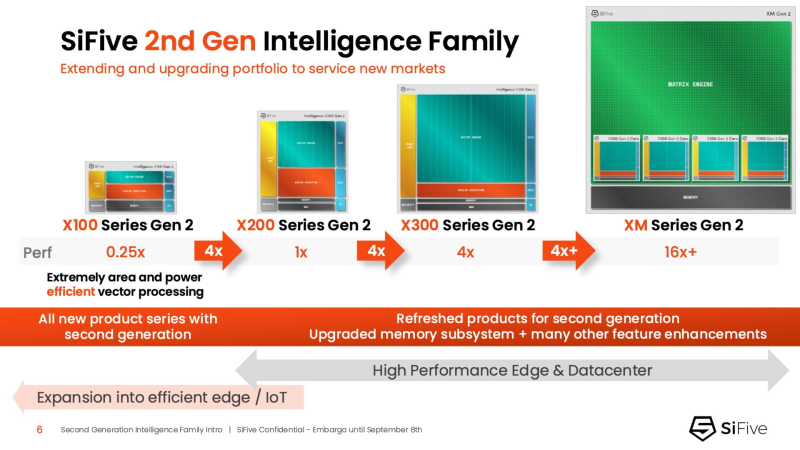

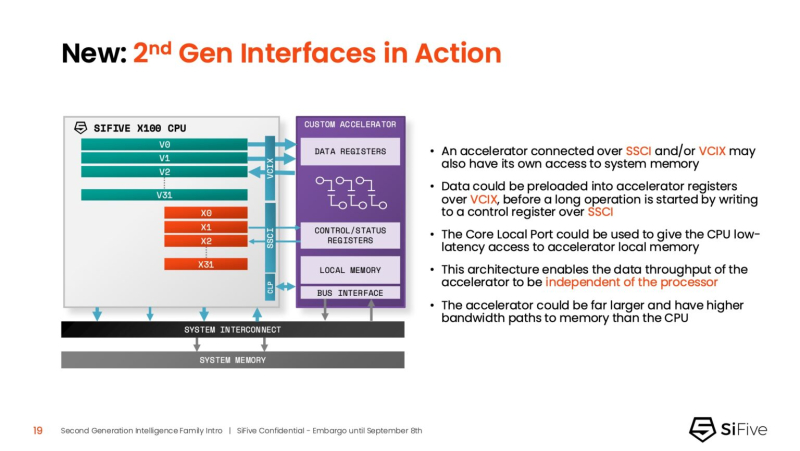

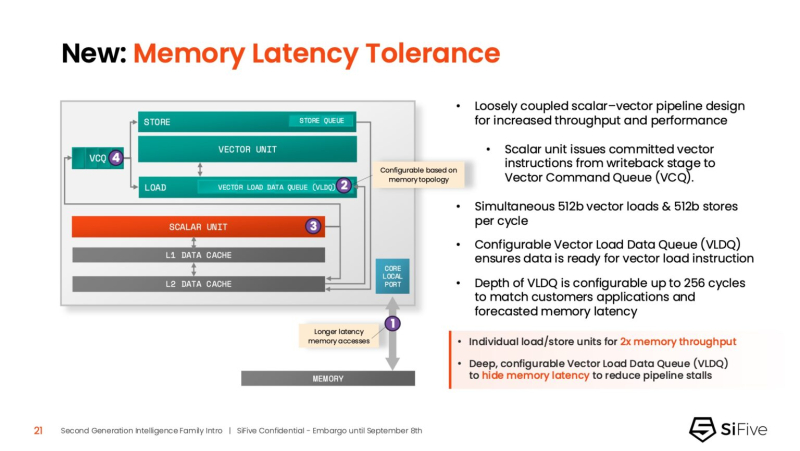

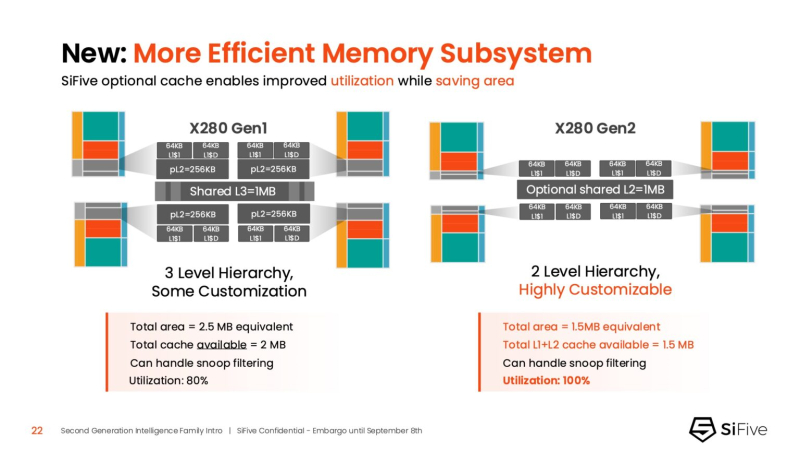

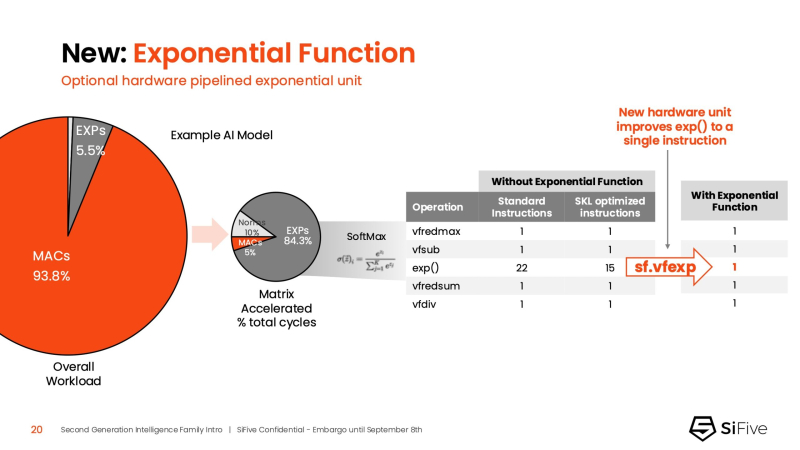

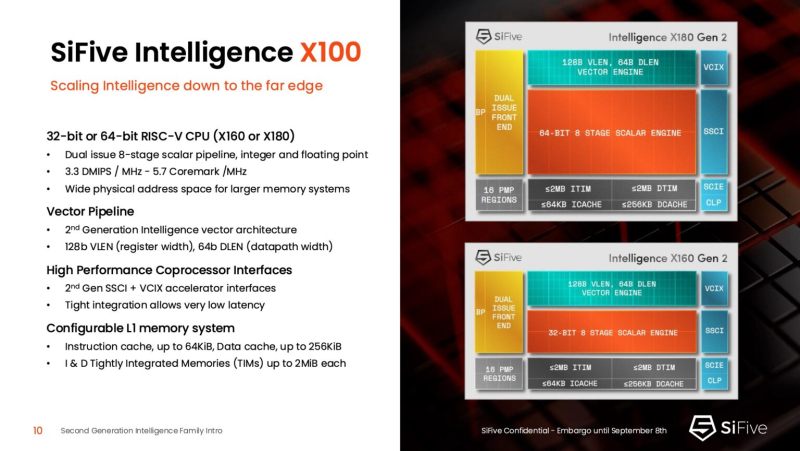

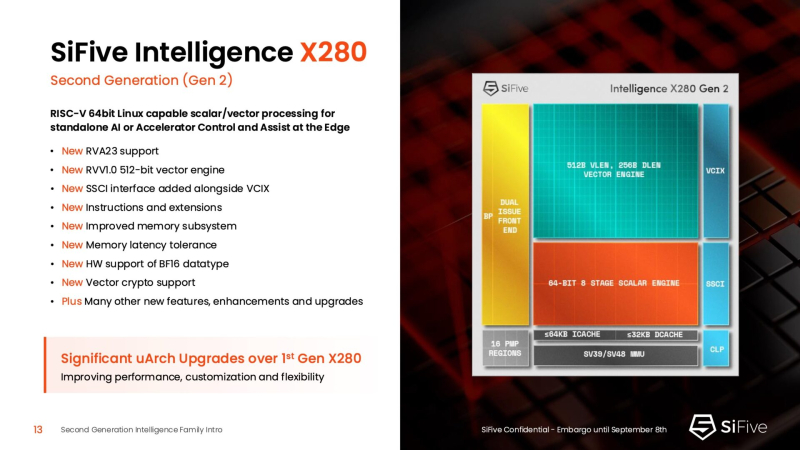

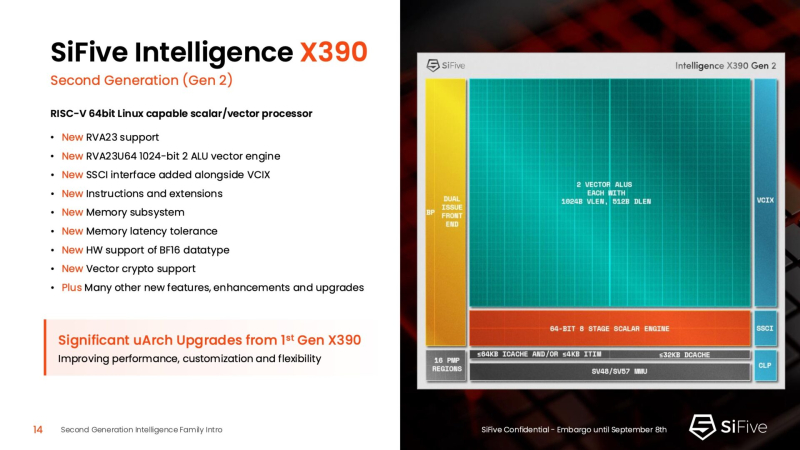

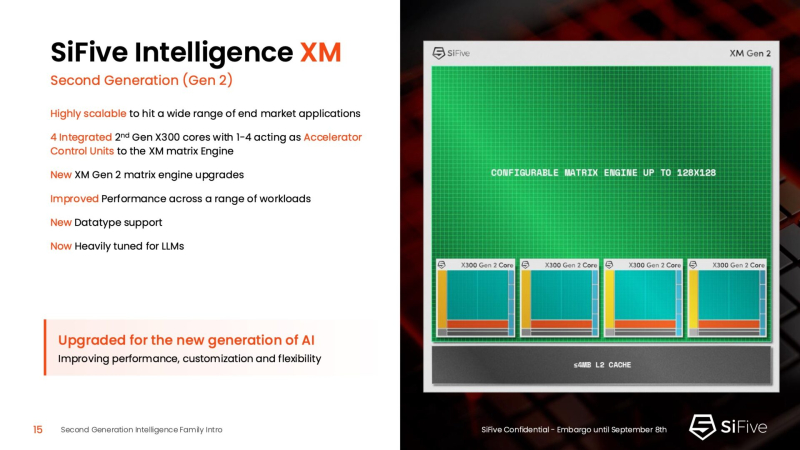

Быстрее и «умнее»: SiFive представила второе поколени RISC-V-ядер IntelligentSiFive представила семейство ядер Intelligent второго поколения с архитектурой RISC-V, включающее новые ядра X160 Gen 2 и X180 Gen 2, а также обновлённые решения X280 Gen 2, X390 Gen 2 и XM Gen 2. Новые решения разработаны для расширения возможностей скалярной, векторной и, в случае серии XM, матричной обработки данных, адаптированных для современных задач в сфере ИИ. Как отметил ресурс EE Times, анонсируя новую линейку продуктов, SiFive стремится воспользоваться быстрорастущим спросом на решения для обработки ИИ-нагрузок, который, по прогнозам Deloitte, вырастет как минимум на 20 % во всех технологических средах, включая впечатляющий скачок на 78 % в сфере периферийных вычислений с использованием ИИ. Ядра SiFive второго поколения позволяют решать критически важные задачи в области внедрения ИИ, в частности, в области управления памятью и ускорения нелинейных функций. Ключевым нововведением в процессорах серии X является их способность функционировать в качестве блока управления ускорителем (ACU). Это позволяет ядрам SiFive обеспечивать основные функции управления и поддержки для ускорителя заказчика через интерфейсы SiFive Scalar Coprocessor Interface (SSCI) и Vector Coprocessor Interface eXtension (VCIX). Данная архитектура позволяет заказчикам сосредоточиться на инновациях в обработке данных на уровне платформы, оптимизируя программный стек. Джон Симпсон (John Simpson), главный архитектор SiFive, сообщил ресурсу EE Times, что интеллектуальные ядра SiFive обеспечивают гибкость, сокращают трафик системной шины за счёт локальной обработки на чипе ускорителя и обеспечивают более тесную связь для задач пред- и постобработки. Он рассказал, что SiFive представила два важных усовершенствования в архитектуре, которые напрямую устраняют узкие места производительности: устойчивость к задержкам памяти и более эффективную подсистему памяти. Функцию Memory Latency Tolerance позволяет снизить задержку загрузки. Симпсон рассказал, что блок скалярных вычислений, обрабатывающий все инструкции, отправляет векторные инструкции в очередь векторных команд (VCQ). При обнаружении такого инструкции одновременно отправляется запрос в подсистему памяти (кеш L2 или выше). Ранняя отправка запросов, отделённая от исполнения, позволяет быстрее получить ответ от памяти и поместить его в переупорядочиваемую настраиваемую очередь загрузки векторных данных (VLDQ). Это гарантирует готовность данных к моменту, когда инструкция в конечном итоге покинет VCQ, что приводит к «загрузке вектора в течение одного цикла». Симпсон подчеркнул конкурентное преимущество решения, отметив: «Xeon, представленный на Hot Chips, может обслуживать 128 невыполненных запросов, и это топовый показатель для Xeon, а в нашем четырёхъядерном процессоре этот показатель составляет 1024». Эта «прекрасная технология» обеспечивает непрерывную обработку данных, эффективно предотвращая простои конвейера. Более эффективная подсистема памяти, которая представляет собой ещё одно существенное обновление, основана на переходе от инклюзивной к неинклюзивной иерархии кешей. В инклюзивной системе кеширования предыдущего поколения данные из общего кеша L3 реплицировались в частные кеши L1/L2, что компания посчитала неэффективным расходом «кремния». Конструкция ядер второго поколения исключает копирование, что, по словам Симпсона, даёт «в 1,5 раза большую производительность по сравнению с первым поколением» при меньшей занимаемой площади на кристалле. SiFive также интегрировала новый аппаратный конвейерный экспоненциальный блок. В то время как MAC-операции доминируют в рабочих ИИ-нагрузках, возведение в степень становится следующим серьёзным узким местом. Например, в BERT LLM, ускоренных матричным движком, операции softmax, включающие возведение в степень, занимают более 50 % оставшихся циклов. Программными оптимизациями SiFive сократила выполнение функции возведения в степень с 22 до 15 циклов, а новый аппаратный блок сокращает её до одной инструкции, уменьшая общее время выполнения функции до пяти циклов. Программный стек для семейства Intelligence второго поколения поддерживает масштабируемость. В серии XM среда выполнения машинного обучения уже распределяет рабочие нагрузки между несколькими кластерами XM на одном кристалле. Впрочем, пока масштабирование за пределы одного кристалла требует дальнейшей разработки библиотеки межпроцессорного взаимодействия (IPC). Флагманские решения X160 Gen 2 и X180 Gen 2 могут быть настроены для работы под управлением операционной системы реального времени, пишет SiliconANGLE. 32-бит IP-ядро Intelligence X160 разработано для оптимизации энергоэффективности и приложений с жесткими ограничениями по площади кристалла, в то время как 64-бит IP-ядро Intelligence X180 обеспечивает более высокую производительность и лучшую интеграцию с более крупными подсистемами памяти, сообщил ресурс CNX-Software. X160 поставляется с кеш-памятью объёмом до 200 КиБ и памятью объёмом 2 МиБ. Помимо промышленного оборудования, ядро может найти применение в потребительских устройствах, таких как фитнес-трекеры. Кроме того, X160 можно установить в системах с несколькими ИИ-ускорителями для управления чипами и предотвращения изменения прошивки. Благодаря двум встроенным кешам общей ёмкостью более 4 МиБ ядро позволяет работать с большим объёмом данных. По данным SiFive, X160 подходит для обучения ИИ-моделей и использования в оборудовании ЦОД. В свою очередь, ядро X280 ориентировано на потребительские устройства, такие как гарнитуры дополненной реальности, а X390 также может использоваться в автомобилях и инфраструктурных системах. Последнее ядро выполняет векторную обработку в четыре раза быстрее, чем X280. Все пять продуктов Intelligence Gen 2 уже доступны для лицензирования, а появление первых чипов на их основе ожидается во II квартале 2026 года. SiFive сообщила, что два ведущих американских производителя полупроводников лицензировали новую серию X100 ещё до её публичного анонса. Они используют IP-ядро X100 в двух различных сценариях: одна компания задействует сочетание скалярного векторного ядра SiFive с матричным движком, выступающим в качестве блока управления ускорителем, а вторая использует векторный движок в качестве автономного ИИ-ускорителя.

09.09.2025 [15:46], Сергей Карасёв

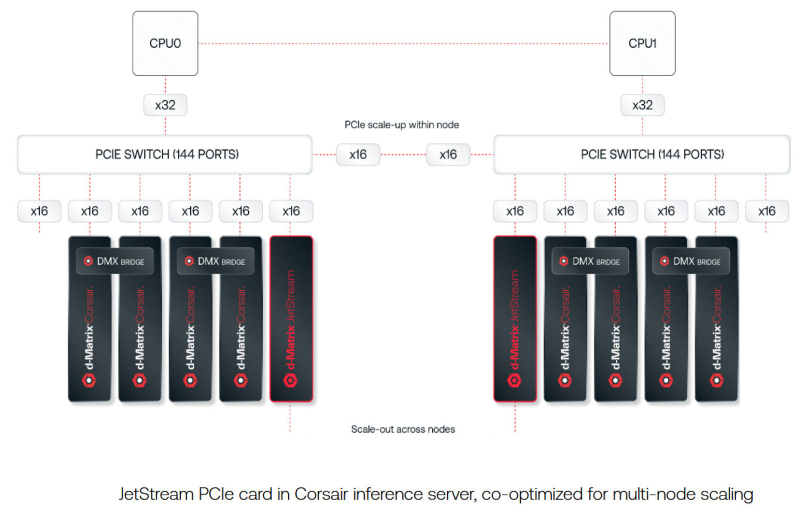

d-Matrix представила 400GbE-адаптер JetStream для объединения своих ИИ-ускорителейСтартап d-Matrix анонсировал специализированную IO-карту JetStream, предназначенную для распределения нагрузок ИИ-инференса между серверами в дата-центре. Устройство ориентировано на использование в связке с ускорителями d-Matrix Corsair, архитектура которых основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC). JetStream использует стандарт Ethernet, благодаря чему обладает совместимостью с уже существующими коммутаторами. Новинка выполнена в виде платы расширения с интерфейсом PCIe 5.0 х16. Используются корзины QSFP-DD. Могут быть задействованы два 200GbE-порта со скоростью 200 Гбит/с или один 400GbE-порт. Архитектура серверов d-Matrix для ИИ-инференса предполагает установку ускорителей Corsair с DMX-мостом между каждыми двумя такими картами для обеспечения высокой пропускной способности без использования PCIe. Затем пары ускорителей объединяются посредством коммутатора PCIe. В эталонном дизайне один NIC JetStream обслуживает до четырёх экземпляров Corsair. d-Matrix утверждает, что сетевую задержку в такой конфигурации удалось сократить до 2 мкс. По заявлениям d-Matrix, карты JetStream могут применяться в существующих ЦОД без необходимости замены дорогостоящих инфраструктурных компонентов. В связке с ИИ-ускорителями Corsair и ПО d-Matrix Aviator решения JetStream способны справляться с ИИ-моделями, насчитывающими более 100 млрд параметров. При этом, как утверждает разработчик, обеспечивается в 10 раз более высокая производительность, в три раза лучшая экономическая эффективность и втрое большая энергоэффективность по сравнению с решениями на базе GPU. Энергопотребление JetStream составляет около 150 Вт. Адаптер оснащён системой охлаждения с радиатором и тепловыми трубками, которые охватывают зону QSFP-DD. Пробные поставки новинки уже начались, а массовое производство запланировано на конец текущего года.

09.09.2025 [12:21], Сергей Карасёв

Microsoft потратит почти $20 млрд на аренду ИИ-инфраструктуру у NebiusКорпорация Microsoft, по сообщению Datacenter Dynamics, подписала пятилетнее соглашение на использование вычислительной инфраструктуры компании Nebius (бывшая материнская структура «Яндекса»). Речь идёт об аренде серверов на основе GPU для ресурсоёмких нагрузок ИИ. Nebius, напомним, занимается созданием ИИ-инфраструктуры с использованием ускорителей NVIDIA. У компании, в частности, есть площадки в Финляндии и во Франции. Кроме того, в конце 2024 году Nebius объявила о формировании своего первого вычислительного ИИ-кластера на территории США: система развёрнута на базе дата-центра Patmos в Канзас-Сити (штат Миссури). По условиям заключённого договора, Microsoft с конца текущего года начнёт использовать вычислительные мощности нового дата-центра Nebius в Вайнленде (Vineland) на территории Нью-Джерси (США). Этот объект имеет мощность 300 МВт с перспективой наращивания ещё на 400 МВт.

Источник изображения: Nebius Стоимость контракта между Microsoft и Nebius составляет $17,4 млрд на пять лет. Причём, по условиям соглашения, сумма может быть увеличена до $19,4 млрд — если корпорации Microsoft потребуются дополнительные услуги и (или) мощности. После анонса сделки стоимость акций Nebius подскочила примерно на 60 %. Предполагается, что сотрудничество с Microsoft поможет Nebius значительно расширить бизнес. При этом для выполнения условий контракта Nebius планирует в ближайшее время привлечь заёмные средства. Нужно отметить, что Microsoft также арендует вычислительные мощности у CoreWeave: на эти цели редмондский гигант потратит почти $10 млрд в период с 2023-го по 2030 год. В 2024 году на долю Microsoft пришлось около 62 % выручки CoreWeave, которая достигла $1,9 млрд.

09.09.2025 [09:49], Руслан Авдеев

Дональд Трамп пообещал IT-гигантам решить проблемы с энергоснабжением ЦОДПрезидент США Дональд Трамп (Donald Trump) пообещал представителям крупного IT-бизнеса решить проблему с электроснабжением и присоединением к энергосетям. Индустрия ЦОД сталкивается с дефицитом электричества в Соединённых Штатах, сообщает The Register. На ужине в Белом доме присутствовали нынешние и бывшие топ-менеджеры IT-гигантов: Билл Гейтс (Bill Gates), Тим Кук (Tim Cook), Сэм Альтман (Sam Altman), Сундар Пичаи (Sundar Pichai), Арвинд Кришна (Arvind Krishna), Марк Цукерберг (Mark Zuckerberg) и др. Президент пообещал устраненить препятствия для подключения дата-центров к электросети на федеральном уровне, хотя многие проблемы, вероятно, придётся решать на уровне отдельных штатов. В любом случае, предполагается значительно упростить процесс присоединения. На долю США уже приходится значительная часть мощностей мировых дата-центров, но увлечение бизнеса ИИ-проектами и одержимость Вашингтона конкуренцией с Китаем в гонке ИИ-технологий привели к росту инвестиций в новые ЦОД. В августе сообщалось, что капитальные затраты на дата-центры только AWS превысят $100 млрд в год, что сопоставимо с ВВП ряда стран. В июле Meta✴ объявила о намерении построить несколько кампусов ЦОД мультигигаваттного уровня. Проблема лишь в поиске достаточных объёмов электроэнергии и её доставки до ЦОД. В июне Deloitte Insights предупреждала, что потребность всех крупных объектов в США в энергии может увеличиться более чем в 30 раз за десятилетие, уже сегодня сроки ожидания по заявкам на подключение нередко достигают семи лет.

Источник изображения: Heidi Kaden/unsplash.com К 2030 году счета американцев на электроэнергию могут вырасти на 70 %, если не принять срочные меры по увеличению мощностей электростанций и электросетей. В июле Трамп уже издал указ об упрощении ряда нормативов, касающихся дата-центров и энергетической инфраструктуры для них, в т.ч. линий электропередачи и электростанций. Это способно ускорить процесс одобрения проектов и подключения к сетям. А в конце июля Министерство энергетики США выделило бизнесу свои земли для ускоренного строительства ЦОД и электростанций. Администрация Трампа лояльнее всего относится к атомной энергетике. Белый дом уже объявил о вложении Hitachi Energy $1 млрд в местное производство. В компании заявили, что инвестиции включают $457 млн на крупный завод для выпуска трансформаторов в Вирджинии, а также значительное расширение предприятий компании по всей стране. В Hitachi объявили, что перенос выпуска крупных трансформаторов на территорию США имеет решающее значение для создания прочной внутренней цепочки поставок и устранения «узких мест» в производстве, поскольку спрос на трансформаторы растёт вместе со спросом на электричество.

08.09.2025 [19:09], Сергей Карасёв

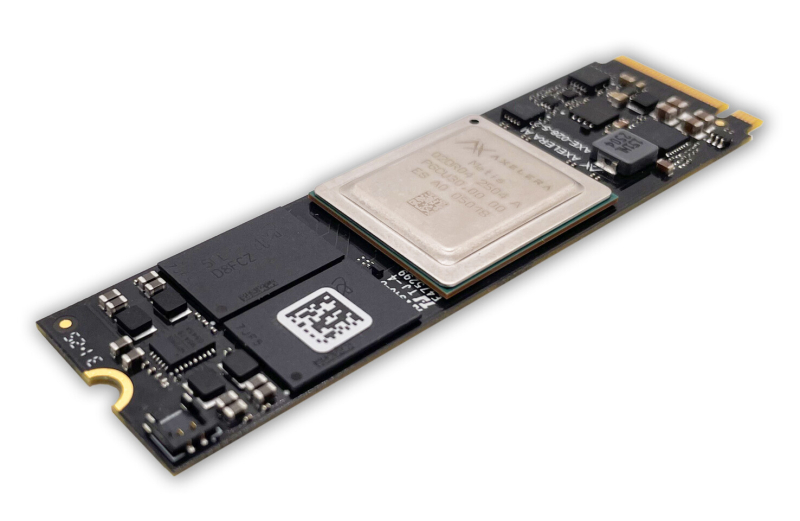

Axelera AI представила ускоритель Metis M.2 Max для ИИ-задач на периферииСтартап Axelera AI B.V. из Нидерландов анонсировал ускоритель Metis M.2 Max, предназначенный для ИИ-инференса на периферии. Новинка может использоваться, в частности, для работы с большими языковыми моделями (LLM) и визуально-языковыми моделями (VLM). Metis M.2 Max представляет собой улучшенную версию изделия Metis M.2, дебютировавшего в 2023 году. В основу положен чип Axelera Metis AIPU, содержащий четыре ядра с открытой архитектурой RISC-V: ИИ-производительность достигает 214 TOPS на операциях INT8. Ускорители выполнены в форм-факторе M.2 2280, а для обмена данными служит интерфейс PCIe 3.0 x4. У модели Metis M.2 Max по сравнению с оригинальной версией в два раза повысилась пропускная способность памяти (точные значения не приводятся). Её объём в зависимости от модификации составляет 1, 4, 8 или 16 Гбайт. Реализованы расширенные средства обеспечения безопасности, включая защиту целостности прошивки. Новинка будет предлагаться в вариантах со стандартным и расширенным диапазоном рабочих температур: в первом случае он простирается от -20 до +70 °C, во втором — от -40 до +85 °C. Благодаря этому, как утверждается, Metis M.2 Max подходит для применения в самых разных областях, в том числе в промышленном секторе, розничной торговле, в сферах здравоохранения и общественной безопасности и пр. Разработчикам компания Axelera AI предлагает комплект Voyager SDK, который позволяет полностью раскрыть потенциал чипа Metis AIPU и упрощает развёртывание коммерческих приложений. Продажи ИИ-ускорителя Metis M.2 Max начнутся в IV квартале текущего года. Устройство будет поставляться отдельно и в комплекте с опциональным низкопрофильным радиатором охлаждения.

08.09.2025 [17:48], Владимир Мироненко

Microsoft предоставила скидки госагентствам США на более чем $6 млрд

microsoft

microsoft 365

microsoft azure

microsoft copilot

software

госзакупки

ии

облако

сделка

сша

финансы

Управление общих служб США (GSA) объявило о заключении соглашения с Microsoft в рамках новой политики закупок OneGov, введённой администрацией Дональда Трампа (Donald Trump) и призванной консолидировать ИТ-расходы через единый канал. Вместо того чтобы каждое ведомство заключало собственные контракты, OneGov предписывает им осуществлять закупки через GSA. Новое соглашение предусматривает значительные скидки на пакет облачных сервисов, который Microsoft предоставит агентствам США, включая Microsoft 365, Copilot, Azure, Dynamics 365, а также инструменты кибербезопасности и мониторинга, и даже семинары по внедрению, адаптации и оптимизации, что позволит сэкономить им $3,1 млрд в первый год. В частности, Microsoft 365 Copilot будет предоставляться бесплатно клиентам Microsoft G5 в течение до 12 месяцев с дополнительными скидками в последующие годы, что свидетельствует о намерении Microsoft сделать своего ИИ-помощника стандартным элементом правительственных рабочих процессов. Microsoft 365 G3 и G5 — планы лицензирования для государственных учреждений с различными уровнями безопасности и функциональности. G5 специально разработан для сред, требующих повышенной безопасности, и включает в себя дополнительные функции, такие как аналитика в режиме реального времени, защита от угроз, Power BI Pro и расширенные возможности корпоративной телефонии. Федеральные агентства могут воспользоваться всеми этими предложениями или любыми из них до сентября 2026 года, при этом скидки на некоторые продукты будут действовать до 36 месяцев. Чтобы получить право на льготы, агентства должны пройти процедуру GSA в рамках OneGov. Не все агентства имеют право на более низкие ставки. За полный трёхлетний период общая экономия правительственных агентств может превысить $6 млрд, что делает предоставляемые Microsoft скидки одними из самых крупных среди предоставленных компаниями правительству, отметил ресурс Windows Central. Генеральный директор Microsoft Сатья Наделла (Satya Nadella) лично участвовал в подписании соглашения, пообщавшись напрямую с Джошем Грюнбаумом (Josh Gruenbaum), главой Федеральной службы закупок (Federal Acquisition Service), что демонстрирует, насколько важна эта сделка для компании. Сделки с GSA в рамках OneGov заключил целый ряд компаний. Adobe предложила скидку 70 % на своё решение для безбумажного правительства, доступное до ноября 2025 года. Соглашение с Amazon предполагает предоставление всем агентствам облачных кредитов на сумму до $1 млрд на модернизацию их инфраструктуры, а также большую экономию в рамках прямых контрактов. В свою очередь, Google представила скидку 71 % на Google Workspace. В сфере ИИ скидки ещё более внушительные. Claude for Enterprise от Anthropic доступен для всех трёх ветвей власти всего за $1 на агентство, OpenAI предлагает ChatGPT Enterprise по такой же цене. Однако соглашение действует только один год. GSA контролирует около $110 млрд расходов на общие товары и услуги, предоставляемые многими агентствами, включая около $80 млрд расходов, связанных с ИТ. Годовой доход Microsoft от правительственных контрактов, вероятно, составляет несколько миллиардов долларов, сказал Грюнбаум, о чём сообщает CNBC. Вместе с тем некоторые эксперты считают продукты Microsoft угрозой национальной безопасности из-за многочисленных уязвимостей. Кроме того, компанию подозревали в антиконкурентном поведении ради сохранения правительственных контрактов.

08.09.2025 [17:26], Владимир Мироненко

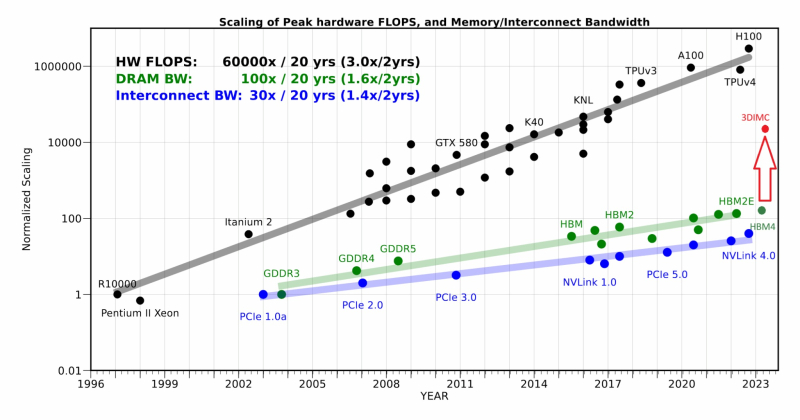

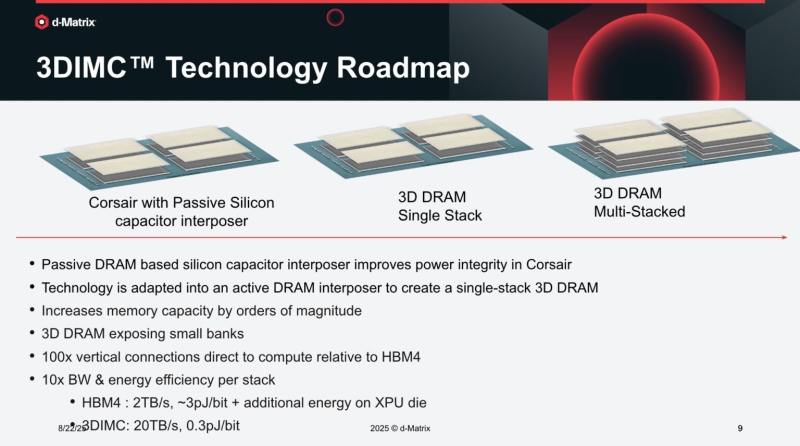

d-Matrix начала тестирование чипа Pavehawk с поддержкой 3DIMCСтартап d-Matrix объявил о разработке новой реализации технологии 3D-вычислений в памяти (3DIMC), которая обещает в 10 раз ускорить работу ИИ-моделей и в 10 раз повысить энергоэффективность по сравнению с текущим отраслевым стандартом HBM4, пишет ресурс SiliconANGLE. Технический директор Судип Бходжа (Sudeep Bhoja) сообщил в блоге, что первый чип компании с поддержкой 3DIMC, d-Matrix Pavehawk, разработка которого заняла более двух лет, сейчас проходит тестирование. В Pavehawk логический блок, изготовленный с использованием 5-нм техпроцесса TSMC, располагается поверх чипа памяти и интегрирован с ним посредством технологии F2F (face-to-face). По словам Бходжи, отраслевые тесты показывают, что производительность вычислений растёт примерно в 3 раза каждые два года, в то время как пропускная способность памяти — всего в 1,6 раза. Этот разрыв постоянно увеличивается, память уже стала узким местом в масштабировании ИИ. Компания утверждает, что простое увеличение количества ускорителей в ЦОД не решит проблему «стены памяти». HPCwire цитирует гендиректора: d-Matrix Сида Шета (Sid Sheth): «Модели быстро развиваются, и традиционные системы памяти HBM становятся очень дорогими, энергоёмкими и ограниченными по пропускной способности». По его словам, узким местом ИИ-инференса является память, а не только количество операций с плавающей запятой, но 3DIMC меняет правила игры. «Стекируя память в трёх измерениях и обеспечивая её более тесную интеграцию с вычислениями, мы значительно сокращаем задержку, увеличиваем пропускную способность и открываем новые возможности повышения эффективности», — подчеркнул он. Компания отметила, что инференс, а не обучение, быстро становится доминирующей рабочей ИИ-нагрузкой. По словам Бходжи, CoreWeave недавно заявила, что 50 % её рабочих нагрузок теперь приходится на инференс, и аналитики прогнозируют, что в течение следующих двух-трех лет инференс будет составлять более 85 % всех корпоративных рабочих ИИ-нагрузок. Он подчеркнул, что компания не занимается перепрофилированием архитектур, созданных для обучения ИИ-моделей, — она с нуля разрабатывает решения, ориентированные на инференс. Бходжа сообщил, что первые пользователи ИИ-ускорителей Corsair, среди которых есть и гиперскейлеры, и неооблака, убедились, что архитектура с упором на память может значительно повысить пропускную способность, энергоэффективность и скорость генерации токенов по сравнению с GPU. Он также отметил, что конструкция на основе чиплетов обеспечивает не только большую пропускную способность памяти, но и «невероятную» гибкость, позволяя внедрять технологии памяти нового поколения быстрее и эффективнее, чем монолитные архитектуры. Бходжа заявил, что 3DIMC на порядок увеличит пропускную способность памяти и производительность для задач ИИ-инференса и обеспечит провайдерам сервисов и предприятиям возможность масштабировать их эффективно и экономично по мере появления новых моделей и приложений. С выводом Pavehawk на рынок компания занялось созданием следующего поколения архитектуры обработки в оперативной памяти, использующей 3DMIC, под названием Raptor. «Наша архитектура следующего поколения Raptor будет включать 3DIMC и опираться на опыт, полученный нами и нашими клиентами в ходе тестирования Pavehawk. Благодаря вертикальному размещению памяти и тесной интеграции с вычислительными чиплетами, Raptor обещает преодолеть барьер в области памяти и выйти на совершенно новый уровень производительности и совокупной стоимости владения», — утверждает Бходжа. Он добавил, что, поставив требования к памяти во главу угла при разработке своих решений — от Corsair до Raptor и далее — компания гарантирует, что инференс будет быстрее, доступнее и стабильнее при масштабировании. d-Matrix провела два раунда финансирования. В раунде A в 2022 году было привлечено $44 млн, а в раунде B в 2023 году – $110 млн, что в общей сложности составляет $154 млн. Компания сотрудничает с поставщиком решений компонуемых систем GigaIO.

08.09.2025 [13:27], Руслан Авдеев

Gemini стал доступен в частных облаках Google Distributed Cloud

gemini

google cloud platform

hardware

ии

информационная безопасность

конфиденциальность

облако

частное облако

Компания Google анонсировала общую доступность ИИ-моделей Gemini в облаках Google Distributed Cloud (GDC), предназначенных для развёртывания на мощностях самих клиентов. В частности, генеративный ИИ будет доступен в частных корпоративных и правительственных платформах, сообщает Network World. GDC является вариантом облака Google Cloud, предназначенным для жёстко регулируемых отраслей вроде здравоохранения или финансовых сервисов. Фактически такие облака скрываются на мощностях клиентов, прячась от внешнего мира за защитными системами компаний. Запуск Gemini в GDC позволяет организациям, обязанным соблюдать жёсткие требования к размещению данных и соответствовать ряду правил по некоторым другим параметрам, внедрять системы генеративного ИИ, не теряя контроля над конфиденциальной информацией. GDC строятся на ускорителях семейств NVIDIA Hopper и Blackwell с автоматизированным распределением нагрузки, без необходимости дополнительных вмешательств для обновления ПО. В системе реализованы функции безопасности вроде аудита и контроля доступа, обеспечивающие клиентам максимальную прозрачность. Платформа также поддерживает функцию «конфиденциальных вычислений» Confidential Computing как для CPU (с Intel TDX), так и ИИ-ускорителями (с применением технологий NVIDIA) для защиты конфиденциальных данных и предотвращения их подделки и утечки. Модели Gemini обеспечивают обработку контента и мультимодальное понимание текста, изображений, аудио и видео. В Google заявляют, что это открывает множество возможных способов применения, включая многоязыковое, в том числе международное сотрудничество, автоматизированное составлении резюме документов и др., поддерживаются чат-боты и генерация кода с помощью искусственного интеллекта.

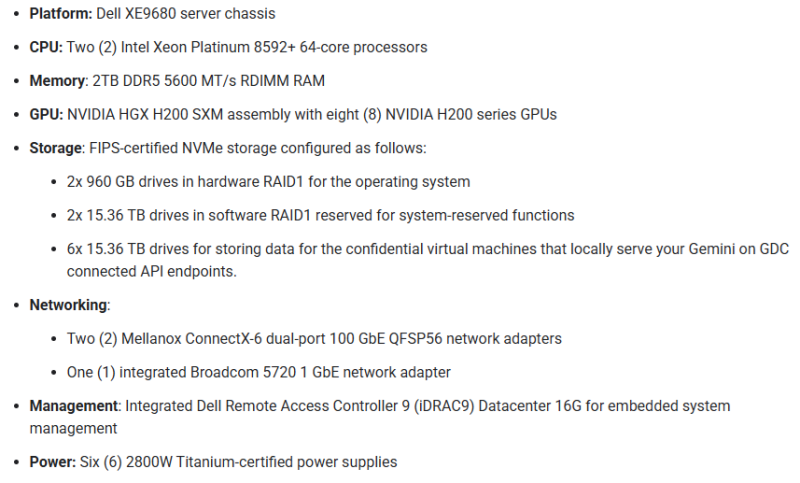

Источник изображения: Google Для работы Gemini требуется сертифицированное Google оборудование. Среди такового пока есть только одна модификация HGX H200 на базе Dell XE9680. |

|