Материалы по тегу: ии

|

11.09.2025 [14:01], Сергей Карасёв

OpenAI заключила контракт стоимостью $300 млрд на покупку вычислительных мощностей у OracleКомпания OpenAI, по сообщению газеты The Wall Street Journal, заключила пятилетнее соглашение о приобретении вычислительных мощностей у Oracle для задач ИИ. Стоимость контракта составляет $300 млрд, что многократно превышает годовую выручку OpenAI, которая по итогам 2025-го ожидается на уровне $12,7 млрд. Сама Oracle на днях сообщила, что объём заказов (RPO) достиг почти $0,5 трлн. Стартап OpenAI в настоящее время использует облачную инфраструктуру Microsoft Azure, но этих ресурсов недостаточно для обслуживания масштабных ИИ-нагрузок. В сложившейся ситуации в марте нынешнего года OpenAI заключила соглашение по использованию облачной инфраструктуры CoreWeave: договор стоимостью $11,9 млрд подписан на пять лет. Позднее OpenAI заключила ещё одну сделку с CoreWeave — на $4 млрд. Вместе с тем OpenAI активно развивает партнёрские отношения с Oracle. В октябре прошлого года сообщалось, что ИИ-стартап намерен арендовать у Oracle кампус ЦОД мощностью 2 ГВт. Кроме того, OpenAI объявила о заключении соглашения с Oracle о строительстве дополнительных дата-центров мощностью 4,5 ГВт в США в рамках расширенного партнёрства, что является частью масштабного проекта Stargate. Сама Oracle рассчитывает найти для OpenAI 5 ГВт на обучение ИИ к концу 2026 года. Как отмечает The Wall Street Journal, контакт на $300 млрд между OpenAI и Oracle является одной из крупнейших сделок в истории облачных вычислений. Соглашение вступит в силу в 2027 году. По оценкам, речь идёт о мощностях на уровне 4,5 ГВт, что сопоставимо с суммарным потреблением энергии примерно 4 млн среднестатистических домохозяйств. Ресурс TechCrunch подчёркивает, что OpenAI остро нуждается в дополнительных вычислительных ресурсах, в связи с чем активно заключает партнёрские соглашения. Так, минувшим летом стартап подписал договор об использовании облачной платформы Google Cloud для обработки своих ИИ-нагрузок — несмотря на то, что Google является прямым конкурентом OpenAI в сфере ИИ. Предполагается, Google Cloud поможет в поддержании операций OpenAI в США, Великобритании, Нидерландах, Норвегии и Японии.

11.09.2025 [10:51], Руслан Авдеев

Индия изучит возможность переоборудования старых угольных шахт в дата-центрыИндийская государственная компания Coal India Limited (CIL) рассматривает возможность переоборудования выведенных из эксплуатации уголных шахт в дата-центры. Компания начала разработку технико-экономического обоснования с привлечением консультантов, сообщает Datacenter Dynamics. В расчёт будут приниматься прогнозы спроса, региональные и иные тенденции, проблемы с законодательством и иные потенциальные препятствия для развёртывания объектов — включая доступность энергии, охлаждения и сетей связи. Как сообщают источники Times of India, предстоит комплексное исследование рынка дата-центров. Его целью является изучение текущего состояния индустрии, сравнение его с мировыми стандартами и анализ различных моделей ЦОД (гиперскейл-класса, колокейшн, для периферийных вычислений) с последующей оценкой влияния на спрос со стороны ИИ-технологий, облаков, IoT, 5G и др. CIL управляет сотнями угольных шахт с помощью дочерних компаний. По данным Times of India, пока в «шорт-лист» вошли четыре участка: угольный разрез Umrer в штате Махараштра под управлением Western Coalfields Limited (WCL); участок Saraipali около Корбы (штат Чхаттисгарх) под управлением South Eastern Coalfields Limited (SECL); участок Himgir–Rampur возле Джарсугуды (штат Одиша) под управлением Mahanadi Coalfields Limited (MCL); угольный разрез Nigahi в районе Синграули (штат Мадхья-Прадеш) под управлением Northern Coalfields Limited (NCL). Компания не исключает использования на объектах энергии из возобновляемых источников. Пока же Индия сильно зависит в генерации от угля, обеспечивающего около 60 % потребления. Хотя в последнее время использование угля несколько сократилось, планы полного отказа от этого энергоносителя не озвучиваются. В 2023 году правительство призвало коммунальные компании отложить прекращение эксплуатации угольных электростанций до 2030-х гг. Страна даже увеличила добычу угля для удовлетворения растущего спроса, в 2023–2024 гг. зарегистрирован абсолютный исторический максимум в 997 млн тонн. Особо интересным уголь стал в 2024 году, поскольку для дата-центрам остро не хватает электроэнергии. В декабре 2024 года Международное энергетическое агентство (IEA) объявило, что из-за развития рынка ИИ растёт и потребление угля, в первую очередь в Китае и Индии. А в апреле 2025 года президень США Дональд Трамп (Donald Trump) поддержал угольный сектор в США ради удовлетворения спроса ИИ ЦОД на энергию. Впрочем, в случае с CIL шахты планируется использовать не по прямому назначению. Похожие прецеденты уже есть. В январе 2024 года сообщалось, что заброшенные шахты могут стать хранилищами «мусорного» тепла эдинбургского суперкомпьютера. В марте 2025-го появилась информация, что Public Power Corp (PPC) представила план строительства ЦОД в старых угольных шахтах Греции.

11.09.2025 [08:48], Руслан Авдеев

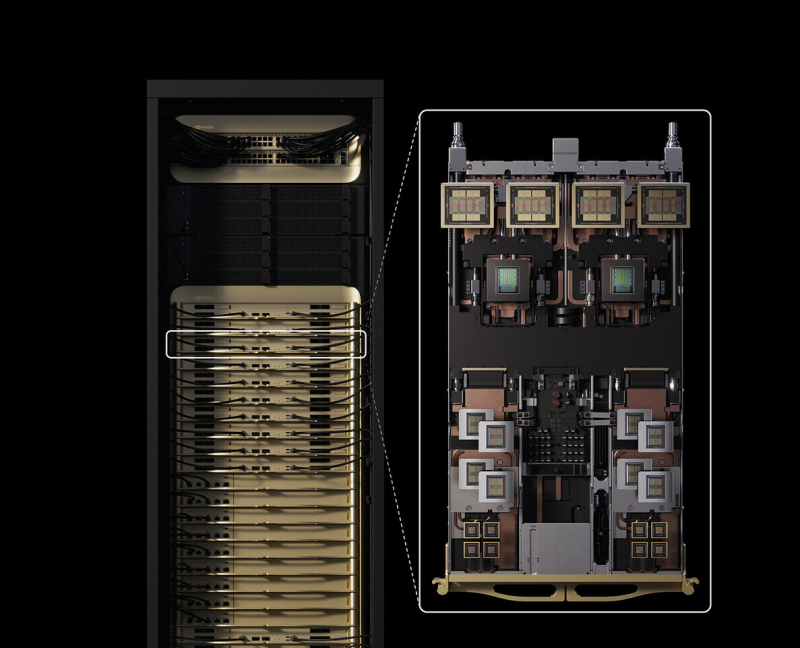

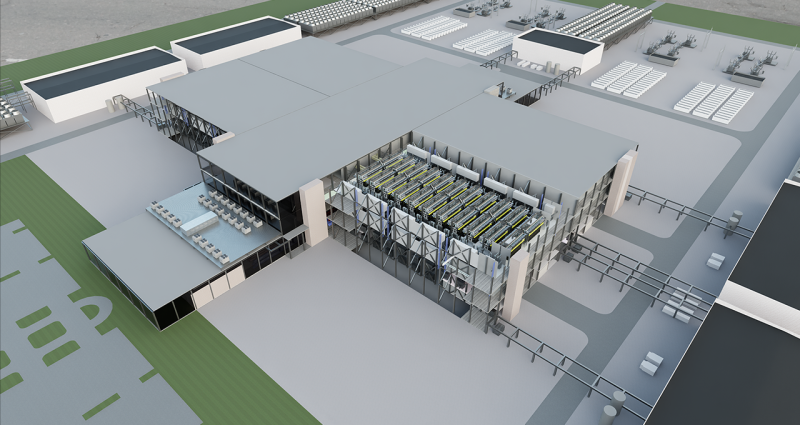

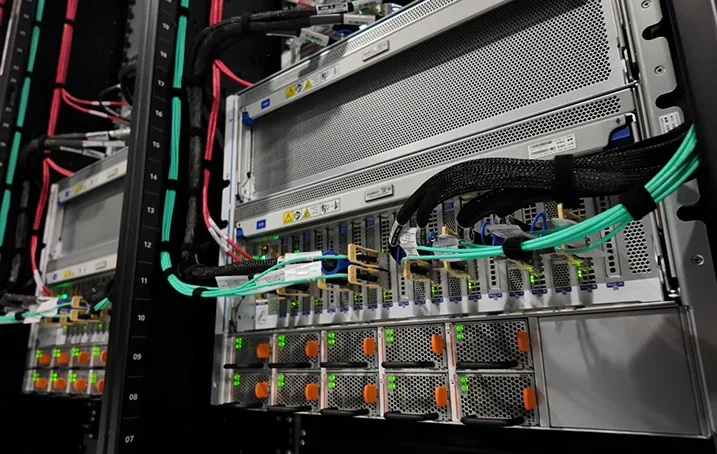

NVIDIA работает над эталонным дизайном гигаваттных ИИ-фабрикNVIDIA анонсировала разработку эталонного дизайна дата-центров гигаваттного уровня с использованием технологии цифровых двойников. Эталонные проекты ИИ ЦОД будут доступны компаниям-партнёрам по всему миру. В разработке нового решения компании помогают Schneider Electric, Siemens, Vertiv, Cadence, emeraldai, E Tech Group, phaidra.ai, PTC и Vertech. Для создания высокопроизводительной ИИ-инфраструктуры будет предложена технология цифровых двойников Omniverse Blueprint, позволяющая создавать высокопроизводительную и энергоэффективную ИИ-инфраструктуру. Технология позволяет заказчикам объединять все данные, связанные с созданием дата-центра, в единую универсальную модель, отражающую как можно больше деталей виртуального и физического строения объектов. Благодаря этому можно проектировать и моделировать оборудование с высокой энергетической и вычислительной плотностью. Модели ИИ-фабрики можно подключить к более масштабным системам: энергосетям, системам водоснабжения и транспортным артериям, что требует координации и моделирования на протяжении всего жизненного цикла кампусов ЦОД. В модель включаются локальные генерирующие мощности, энергохранилища, технологии охлаждения и даже ИИ-агенты для управления работой ЦОД. В компании заявляют, что только одновременное проектирование инфраструктуры и технологического стека обеспечивает настоящую оптимизацию, при которой питание, охлаждение, ускорители и ПО рассматриваются как единое целое.

Источник изображения: NVIDIA В марте 2024 года сообщалось, что NVIDIA и Siemens внедрят ИИ в промышленное проектирование и производство с помощью интеграции NVIDIA Omniverse Cloud API в платформу Xcelerator. Тогда же Schneider Electric и NVIDIA объявили о разработке эталонных проектов инфраструктур ИИ ЦОД. В рамках объявленного сотрудничества AVEVA, дочерняя компания Schneider Electric, должна была подключить свою платформу цифровых двойников к NVIDIA Omniverse, создав единую среду для виртуального моделирования и совместной работы.

10.09.2025 [18:51], Владимир Мироненко

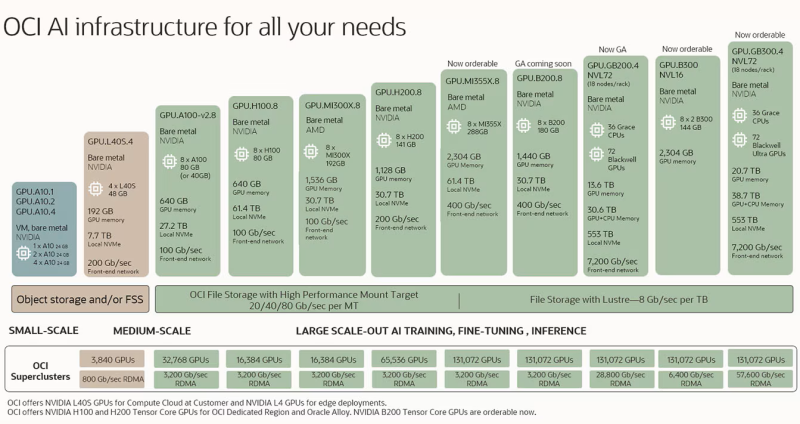

Новость о заказах на $0,5 трлн привела к рекордному за 26 лет росту акций OracleOracle сообщила финансовые результаты I квартала 2026 финансового года, закончившегося 31 августа 2025 года. Несмотря на то, что прибыль и выручка оказались ниже прогнозов Уолл-стрит, акции Oracle взлетели на 27 %, продемонстрировав самый большой однодневный рост за 26 лет (с июня 1999 года, согласно данным FactSet, приведенным SiliconANGLE), поскольку инвесторов впечатлил её прогноз по доходам от облачных технологий, сообщил CNBC. Основатель компании Ларри Эллисон (Larry Ellison) стал самым богатым человеком Земли — благодаря росту акций его доля в Oracle теперь оценивается в $393 млрд. Общая выручка за I квартал составила $14,93 млрд увеличившись год к году на 12 % при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $15,04 млрд. Скорректированная чистая прибыль (Non-GAAP) за квартал выросла на 8 % до $4,28 млрд или $1,47 на разводнённую акцию, что ниже консенсус-прогноза от LSEG в размере $1,48 на разводнённую акцию. Чистая прибыль (GAAP) осталась на прежнем уровне, составив $2,93 млрд, или $1,01 на акцию, по сравнению с $2,93 млрд, или $1,03 на акцию, за аналогичный квартал предыдущего финансового года. Выручка облачного сегмента составила 7,19 млрд, в том числе выручка от облачной инфраструктуры (OCI, IaaS) — $3,3 млрд (рост год к году на 55 %), выручка от облачных приложений — (OCA, SaaS) — $3,8 млрд (рост — 11 %). Выручка от разработки ПО равняется $5,72 млрд (снижение на 1 %). Продажи оборудования выросли на 2 % до $670 млн, сервисы принесли компании $1,35 млрд (рост — 7 %). Во II финансовом квартале Oracle ожидает общую скорректированную прибыль (Non-GAAP) на акцию в размере $1,61–1,65 при росте выручки на 14–16 %. Аналитики прогнозируют прибыль в размере $1,62 на акцию при выручке в $16,21 млрд, что предполагает рост на 15 %. Гендиректор Oracle Сафра Кац (Safra Catz) сообщила, что в отчётном квартале компания подписала четыре многомиллиардных контракта с тремя клиентами. В результате объём оставшихся обязательств по контрактам (RPO) вырос год к году на 359 % до $455 млрд. Она отметила, что спрос на инфраструктуру будет расти и дальше. «В ближайшие несколько месяцев мы ожидаем привлечения нескольких новых многомиллиардных клиентов, и RPO, вероятно, превысит полтриллиона долларов», — сообщила Кац.  По её словам, такой рост показателя RPO позволяет компании существенно пересмотреть свой долгосрочный прогноз выручки от облачной инфраструктуры в сторону повышения. Она сообщила, что выручка от OCI, как ожидается, достигнет $18 млрд в текущем финансовом году, затем вырастет до $32 млрд в 2027 финансовом году, до $73 млрд в 2028 финансовом году, до $114 млрд в 2029 финансовом году и до $144 млрд к 2030 финансовому году. Прогноз Evercore на 2029 год чуть меньше — $108 млрд выручки. Прогноз Oracle демонстрирует существенный рост её облачного бизнеса по сравнению с основными конкурентами. В июле корпорация Microsoft сообщила о выручке от Azure за 12 месяцев в размере $75 млрд, в то время как выручка AWS за тот же период составила около $112 млрд. Капитальные затраты Oracle в 2026 финансовом году составят около $35 млрд, что соответствует росту на 65 %, сообщила Кац. Однако затраты других игроков намного выше. По словам Дэйва Велланте (Dave Vellante), главного аналитика CUBE Research (SiliconANGLE Media), цифры свидетельствуют о том, что Oracle вошла в число гиперскейлеров. «Бизнес набирает обороты, поэтому инвесторы не будут обращать внимания на этот квартал», — отметил он. Аналитик Valoir Ребекка Веттеманн сообщила SiliconANGLE, что цифры отражают то, что огромные инвестиции Oracle в облачную инфраструктуру за последние несколько лет действительно начинают ей приносить дивиденды: «Рынок реагирует как на уверенность Oracle, так и на её квартальные отчёты». «Oracle прогнозирует рост прибыли в сфере инфраструктуры на годы вперёд, что действительно необычно для этой отрасли, особенно учитывая неопределённость относительно объёма и роста будущих рабочих ИИ-нагрузок, зависящих от облачной инфраструктуры», — добавила аналитик. Председатель и технический директор Oracle Ларри Эллисон (Larry Ellison) сообщил, что выручка от баз данных MultiCloud в облаках Amazon, Google и Azure в I финансовом квартале росла невероятными темпами — на 1529 %.«Мы ожидаем, что выручка от MultiCloud будет существенно расти каждый квартал в течение нескольких лет, поскольку мы предоставим ещё 37 ЦОД нашим трём партнёрам-гиперскейлерам, доведя их общее количество до 71», — завил он. В октябре корпорация представит облачный сервис Oracle AI Database, который позволит клиентам использовать выбранную ими LLM, включая Gemini, ChatGPT, Grok и т.д., непосредственно поверх Oracle Database для лёгкого доступа и анализа всей информации в базах данных. «Этот революционный облачный сервис позволит десяткам тысяч наших клиентов мгновенно раскрывать ценность своих данных, делая их легкодоступными для самых передовых ИИ-моделей. Oracle AI Cloud Infrastructure и Oracle MultiCloud AI Database внесут свой вклад в резкое увеличение спроса и потребления облачных услуг в течение следующих нескольких лет. ИИ меняет всё», — заявил Эллисон.

10.09.2025 [17:29], Сергей Карасёв

CoreWeave сформировала венчурное подразделение для поддержки проектов в области ИИПровайдер облачных услуг для ИИ-задач CoreWeave объявил о создании венчурного подразделения CoreWeave Ventures, которое займётся поддержкой компаний и основателей проектов в области искусственного интеллекта и перспективных вычислительных технологий. Отмечается, что на фоне стремительного развития ИИ спрос на специализированные инструменты и приложения, а также сопутствующую инфраструктуру продолжает расти. CoreWeave Ventures поможет ускорить вывод новых разработок на коммерческий рынок путём предоставления финансирования, технической экспертизы и вычислительных мощностей. Поддержку планируется оказывать по нескольким направлениям. Это, в частности, различные модели капиталовложений, которые помогут компаниям в разработке продуктов и масштабировании операций. Кроме того, CoreWeave будет предоставлять упрощённый доступ к своей облачной платформе, специально оптимизированной для ИИ-нагрузок. Компании также смогут воспользоваться средами тестирования для оценки реальных сценариев использования ИИ-решений. Дополнительно CoreWeave предоставит аналитику стратегий создания продуктов и их вывода на рынок на основе сотрудничества с сотнями предприятий и организаций в сфере ИИ. В целом, CoreWeave Ventures в обмен на акционерный капитал планирует обеспечивать поддержку на протяжении всего жизненного цикла проекта — от начала реализации до выхода на рынок. Новое венчурное подразделение уже сотрудничает с рядом компаний, включая разработчиков больших языковых моделей (LLM) и инфраструктурных решений. Отметим, что во II квартале текущего года CoreWeave получила $1,21 млрд выручки, что в три раза больше по сравнению с результатом годичной давности, когда показатель составлял $395,37 млн. При этом компания понесла чистые убытки в размере $290,51 млн против $323,02 млн во II четверти 2024 года. Более того, CoreWeave продолжает наращивать долги, хотя до конца 2026 года обязана вернуть кредиторам порядка $8 млрд.

10.09.2025 [13:35], Сергей Карасёв

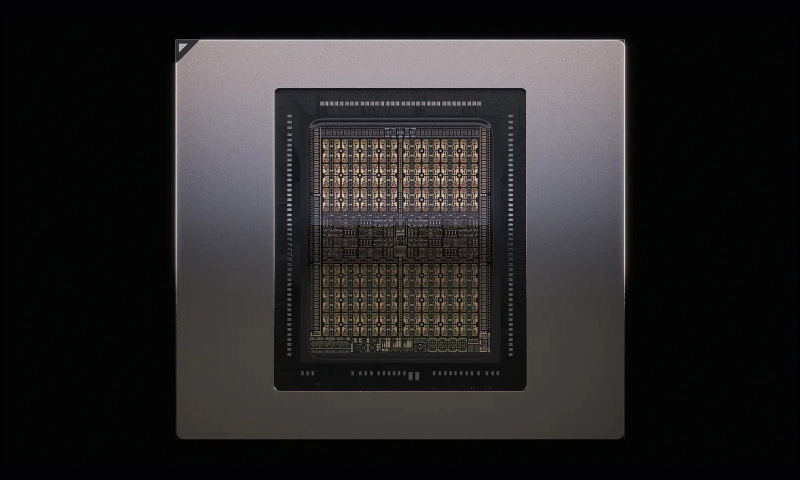

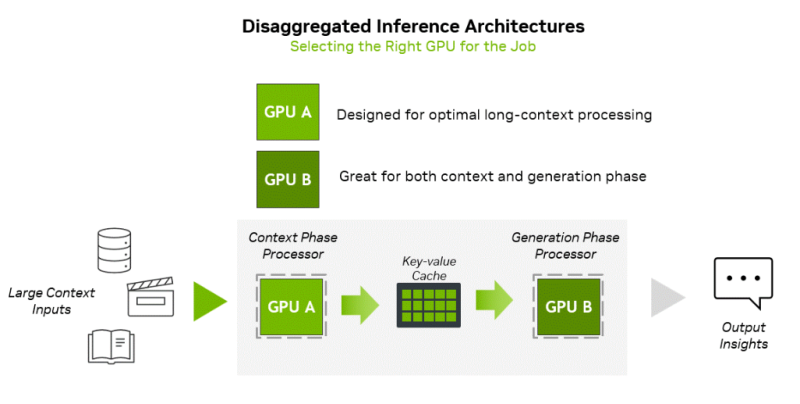

NVIDIA представила соускоритель Rubin CPX со 128 Гбайт GDDR7 для масштабных задач ИИ-инференсаNVIDIA неожиданно анонсировала чип Rubin CPX — GPU нового класса, спроектированный для масштабных задач ИИ-инференса и работы с моделями, использующими длинный контекст. Поставки решения планируется организовать в конце 2026 года. Чип Rubin CPX выполнен в виде монолитного кристалла и оснащён 128 Гбайт памяти GDDR7. Заявленная ИИ-производительность достигает 30 Пфлопс в режиме NVFP4. Предусмотрены по четыре блока NVENC и NVDEC для кодирования и декодирования видеоматериалов. Новинка дополнит другие ускорители компании. Оркестрацией нагрузок будет заниматься платформа NVIDIA Dynamo, распределяющая нагрузки между подходящими для каждой задачи ускорителями. Изделие Rubin CPX предназначено для использования вместе с Arm-процессорами Vera и ускорителями Rubin в составе новой стоечной платформы NVIDIA Vera Rubin NVL144 CPX. Эта система будет объединять 144 чипа Rubin CPX, 144 чипа Rubin и 36 процессоров Vera (88 кастомных 3-нм Arm-ядер). Говорится об использовании суммарно 100 Тбайт памяти с агрегированной пропускной способностью 1,7 Пбайт/с. Общая производительность на операциях NVFP4 — до 8 Эфлопс, что примерно в 7,5 раза больше по сравнению с системами NVIDIA GB300 NVL72. Задействована система жидкостного охлаждения. Кроме того, NVIDIA планирует выпуск двухстоечного решения, включающего стойку Vera Rubin NVL144 CPX и «обычную» стойку Vera Rubin NVL144. «Платформа Vera Rubin ознаменует собой новый скачок производительности в области вычислений ИИ, предлагая как GPU следующего поколения Rubin, так и чип нового класса CPX. Это первый CUDA GPU, специально разработанный для ИИ с длинным контекстом, когда модели одновременно обрабатывают миллионы токенов», — отмечает Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. Основная задача Rubin CPX — работа с контекстом в больших моделях и создание KV-кеша. Эта операция ограничена вычислительными способностями чипа, тогда как генерация токенов зависит уже от пропускной способности памяти и интерконнекта для быстрого обмена данными. NVIDIA предложила разделить эти этапы и на аппаратном уровне. CPX лишён HBM, зато операции возведения в степень он делает втрое быстрее, чем Blackwell Ultra.

10.09.2025 [12:52], Руслан Авдеев

Microsoft уменьшит зависимость от OpenAI, подключив ИИ Anthropic к Office 365Компания Microsoft намерена снизить зависимость от давнего партнёра в лице OpenAI, прибегнув к помощи стартапа Anthropic. В частности, его технологии будут применяться в приложениях Office 365 для реализации новых функций наряду с решениями OpenAI, сообщает TechCrunch со ссылкой на данные источников The Information. Использование конкурентного ИИ в Word, Excel, Outlook и PowerPoint положит конец монополии OpenAI в этой сфере. Ранее Microsoft фактически зависела от разработчика ChatGPT для обеспечения ИИ-функций в своём офисном пакете. Попытки Microsoft диверсифицировать партнёрство в сфере ИИ происходят на фоне растущих разногласий с OpenAI, реализующей собственные инфраструктурные проекты. Кроме того, компания является потенциальным конкурентом LinkedIn, социальная сеть почти десять лет принадлежит Microsoft. Сделка с Anthropic состоялась на фоне переговоров с OpenAI об обновлении соглашения, которое, вероятно, позволит IT-гиганту получать доступ к новейшим технологиям OpenAI и в будущем, даже после реструктуризации последней в коммерческую компанию. Впрочем, по данным The Information, в Microsoft считают, что новейшие модели Anthropic, включая Claude Sonnet 4, фактически лучше решений OpenAI по ряду параметров, например — при создании презентаций PowerPoint.

Источник изображения: BoliviaInteligente/unsplash.com Это не первый эпизод расширения ИИ-сотрудничества Microsoft. Хотя модели OpenAI предлагаются «по умолчанию», через GitHub Copilot можно получить доступ и к моделям Grok (xAI) и Claude (Anthropic). Также компания не так давно представила и собственные модели — MAI-Voice-1 и MAI-1-preview. OpenAI може стремится выйти из сферы влияния Microsoft. На прошлой неделе компания запустила платформу для поиска работы, способную конкурировать с LinkedIn, а СМИ сообщают, что OpenAI намерена наладить выпуск собственных ИИ-чипов совместно с Broadcom в 2026 году. Другими словами, компания сможет обучать и запускать ИИ-модели на собственном оборудовании, не полагаясь на ресурсы Microsoft Azure. Впрочем, по словам представителя Microsoft, OpenAI продолжит быть партнёром компании в области передовых ИИ-моделей, и техногигант по-прежнему привержен долгосрочному сотрудничеству.

10.09.2025 [12:44], Сергей Карасёв

В облаке Vultr по всему миру стали доступны ускорители AMD Instinct MI355XЧастный облачный провайдер Vultr объявил о том, что в его глобальной инфраструктуре стали доступны ускорители AMD Instinct MI355X, официально представленные в июне нынешнего года. Утверждается, что эти изделия устанавливают новый стандарт соотношения цены и производительности для ресурсоёмких ИИ-задач, в частности, инференса. Решение Instinct MI355X построено на архитектуре AMD CDNA 4-го поколения. Устройство располагает 288 Гбайт памяти HBM3E, пропускная способность которой достигает 8 Тбайт/с. Применяется жидкостное охлаждение. Упомянута поддержка программного стека AMD ROCm. На сайте Vultr говорится, что теоретическая производительность ИИ при использовании в конфигурации 8 × Instinct MI355X OAM достигает 20,1 Пфлопс в режиме FP16, 40,3 Пфлопс на операциях INT8/FP8 и 80,5 Пфлопс в режиме FP4. При развёртывании ускорителей Instinct MI355X в своём облаке Vultr тесно сотрудничала с AMD и Supermicro. Благодаря 32 облачным регионам на шести континентах Vultr гарантирует низкую задержку и высокую доступность вычислительных мощностей. Стоимость услуг, как утверждается, ниже по сравнению с аналогичными предложениями гиперскейлеров. Ускорители Instinct MI355X подходят не только для инференса и обучения ИИ-моделей, но и для других нагрузок HPC, таких как симуляции, сложное моделирование или обработка больших массивов данных.

09.09.2025 [23:00], Руслан Авдеев

Fermi America, стоящая за мегапроектом 11-ГВт ИИ ЦОД HyperGrid с питанием от АЭС, собралась на биржу

fermi america

hardware

ipo

westinghouse

аэс

ии

полезные ископаемые

сша

финансы

цод

электропитание

энергетика

Стоящая за проектом строительства 11-ГВт кампуса ИИ ЦОД HyperGrid в Амарилло (Техас) Fermi America подала заявку на IPO. Она намерена разместить обыкновенные акции на бирже Nasdaq Global Select Market, но их количество и ценовой диапазон пока не определены, сообщает пресс-служба компании. UBS Investment Bank, Cantor и Mizuho станут главными андеррайтерами, а Macquarie Capital, Stifel и Truist Securities — дополнительными. По данным Datacenter Dynamics, Fermi работает над Project Matador, в рамках которого и предполагается построить 11-ГВт кампус площадью 167 га. В проекте участвует объединение технических университетов штата (Texas Tech University System). Кампус построят на территории Техасского технологического университета (Texas Tech University, TTU). Сооснователем компании является бывший министр энергетики и бывший губернатор Техаса Рик Перри (Rick Perry). Ввод в эксплуатацию первой очереди на 1 ГВт запланирован на конец 2026 года, но само строительство ещё не начато. Fermi будет использовать локальные источники энергии, включая газовые, солнечные и ветряные электростанции. В июле компания приобрела более 600 МВт мощностей в рамках двух сделок — в том числе девять газовых генераторов, которые в 2026 помогут получть ЦОД до 1 ГВт. Впрочем, газовые турбины будут основным источником энергии лишь в краткосрочной перспективе — Fermi намерена разместить на площадке четыре PWR-реактора Westinghouse AP1000 поколения III+ c электрической мощностью около 1,1 ГВт. Fermi и Westinghouse подали регуляторам совместную заявку Combined Operating License Application (COLA), чтобы ускорить получение разрешений.

Источник изображения: Fermi America Параллельно Fermi подписала два других «атомных» соглашения — меморандумы о взаимопонимании с южнокорейскими Hyundai и Doosan Enerbility, поскольку есть риск не уложиться в сроки и бюджеты. Последний энергоблок AP1000 заработал в США в 2023 году, на семь лет позже запланированного. На АЭС ушло на $17 млрд больше запланированного, причём сама Westinghouse в процессе строительства прошла через банкротство. В сентябре Fermi успешно привлекла $100 млн в раунде финансирования серии C, который возглавила австралийская Macquarie Group. Последняя также открыла для Fermi кредитную линию на $250 млн. Это не первая компания, предложившая концепцию прямого питания ЦОД от АЭС. AWS потратила $650 млн, чтобы приобрести кампус около АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle объявила о намерении развернуть три SMR общей мощностью более 1 ГВт.

09.09.2025 [17:00], Владимир Мироненко

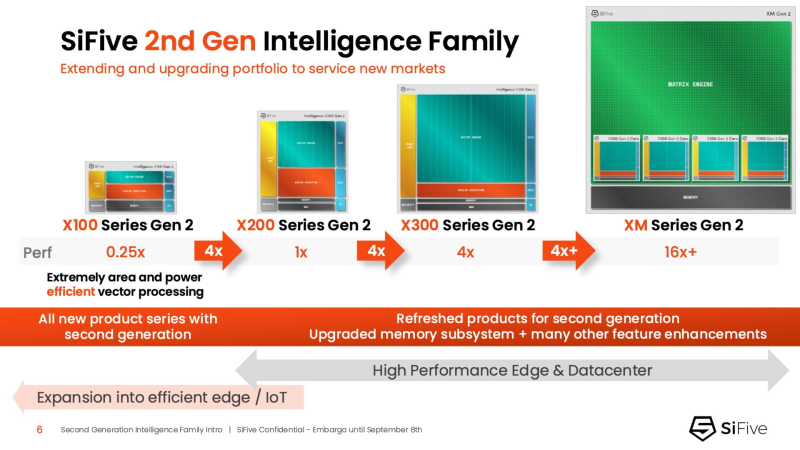

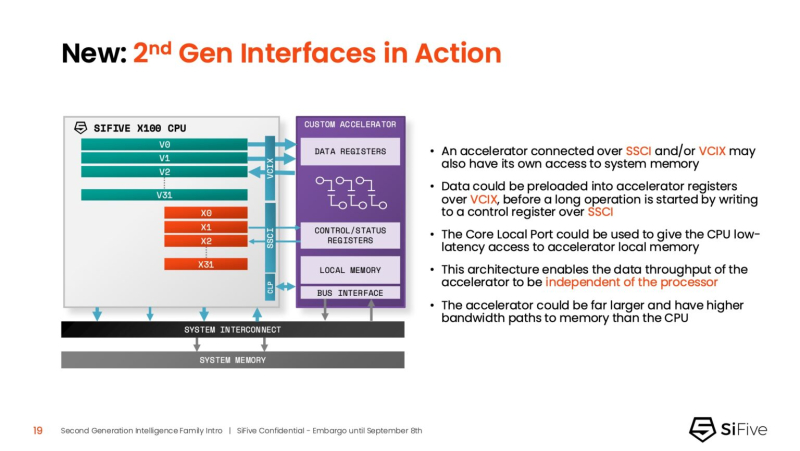

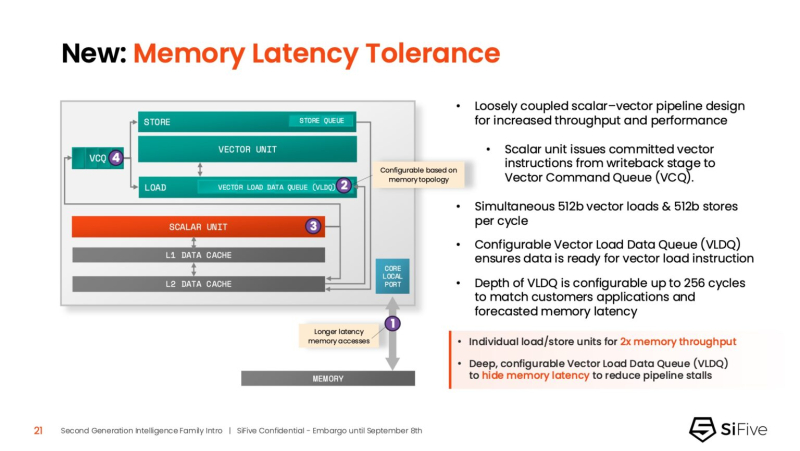

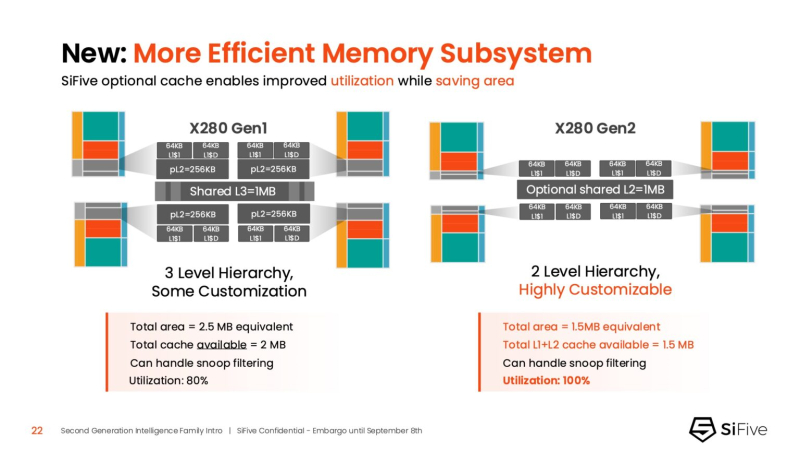

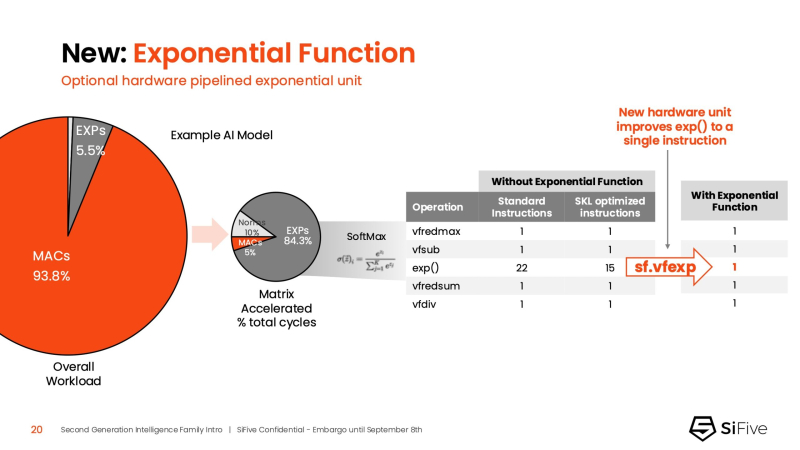

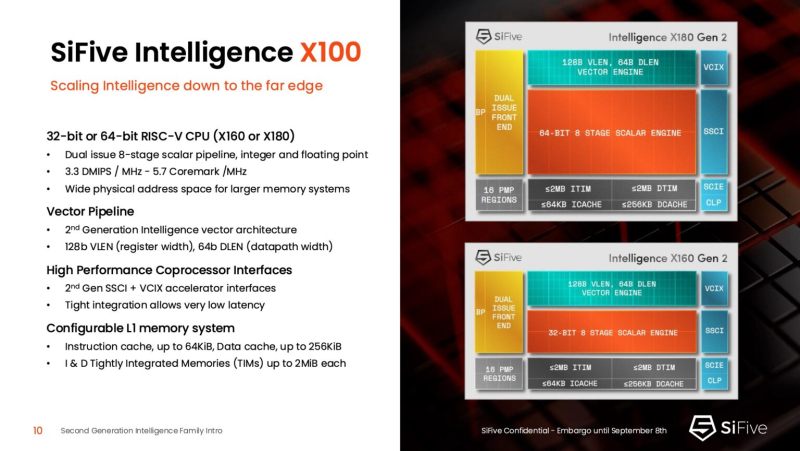

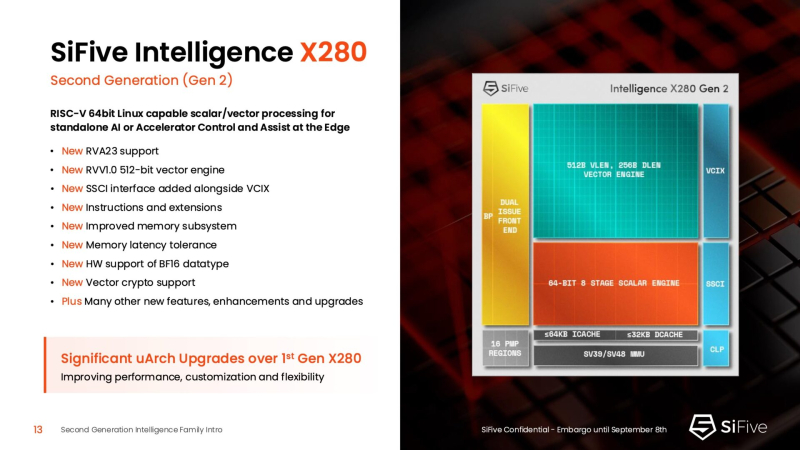

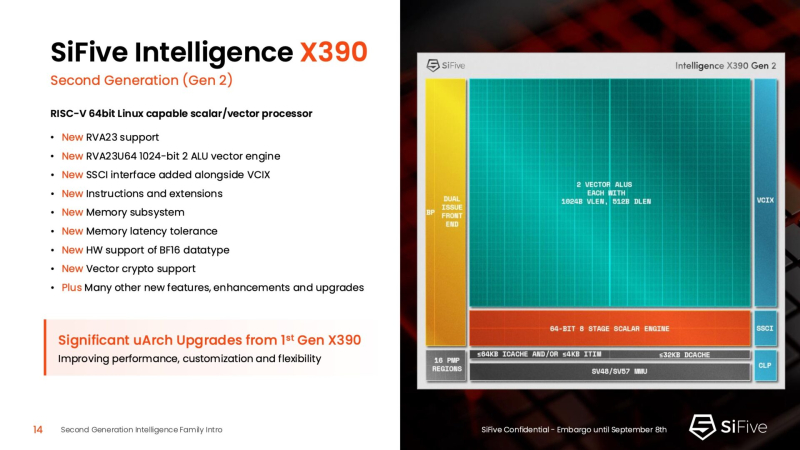

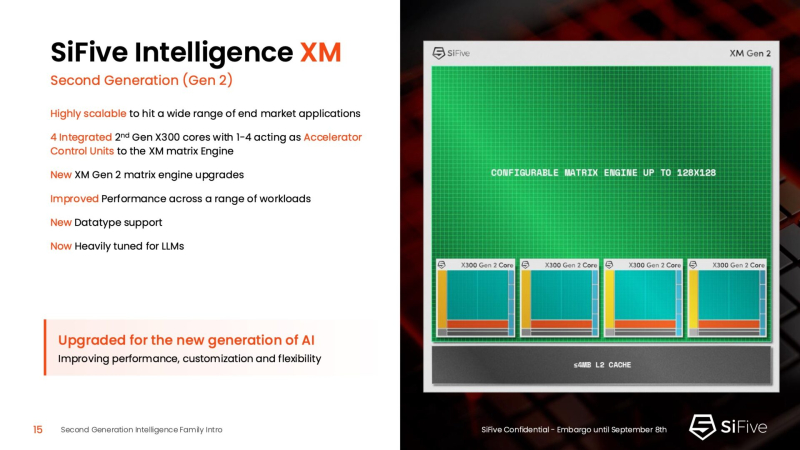

Быстрее и «умнее»: SiFive представила второе поколени RISC-V-ядер IntelligentSiFive представила семейство ядер Intelligent второго поколения с архитектурой RISC-V, включающее новые ядра X160 Gen 2 и X180 Gen 2, а также обновлённые решения X280 Gen 2, X390 Gen 2 и XM Gen 2. Новые решения разработаны для расширения возможностей скалярной, векторной и, в случае серии XM, матричной обработки данных, адаптированных для современных задач в сфере ИИ. Как отметил ресурс EE Times, анонсируя новую линейку продуктов, SiFive стремится воспользоваться быстрорастущим спросом на решения для обработки ИИ-нагрузок, который, по прогнозам Deloitte, вырастет как минимум на 20 % во всех технологических средах, включая впечатляющий скачок на 78 % в сфере периферийных вычислений с использованием ИИ. Ядра SiFive второго поколения позволяют решать критически важные задачи в области внедрения ИИ, в частности, в области управления памятью и ускорения нелинейных функций. Ключевым нововведением в процессорах серии X является их способность функционировать в качестве блока управления ускорителем (ACU). Это позволяет ядрам SiFive обеспечивать основные функции управления и поддержки для ускорителя заказчика через интерфейсы SiFive Scalar Coprocessor Interface (SSCI) и Vector Coprocessor Interface eXtension (VCIX). Данная архитектура позволяет заказчикам сосредоточиться на инновациях в обработке данных на уровне платформы, оптимизируя программный стек. Джон Симпсон (John Simpson), главный архитектор SiFive, сообщил ресурсу EE Times, что интеллектуальные ядра SiFive обеспечивают гибкость, сокращают трафик системной шины за счёт локальной обработки на чипе ускорителя и обеспечивают более тесную связь для задач пред- и постобработки. Он рассказал, что SiFive представила два важных усовершенствования в архитектуре, которые напрямую устраняют узкие места производительности: устойчивость к задержкам памяти и более эффективную подсистему памяти. Функцию Memory Latency Tolerance позволяет снизить задержку загрузки. Симпсон рассказал, что блок скалярных вычислений, обрабатывающий все инструкции, отправляет векторные инструкции в очередь векторных команд (VCQ). При обнаружении такого инструкции одновременно отправляется запрос в подсистему памяти (кеш L2 или выше). Ранняя отправка запросов, отделённая от исполнения, позволяет быстрее получить ответ от памяти и поместить его в переупорядочиваемую настраиваемую очередь загрузки векторных данных (VLDQ). Это гарантирует готовность данных к моменту, когда инструкция в конечном итоге покинет VCQ, что приводит к «загрузке вектора в течение одного цикла». Симпсон подчеркнул конкурентное преимущество решения, отметив: «Xeon, представленный на Hot Chips, может обслуживать 128 невыполненных запросов, и это топовый показатель для Xeon, а в нашем четырёхъядерном процессоре этот показатель составляет 1024». Эта «прекрасная технология» обеспечивает непрерывную обработку данных, эффективно предотвращая простои конвейера. Более эффективная подсистема памяти, которая представляет собой ещё одно существенное обновление, основана на переходе от инклюзивной к неинклюзивной иерархии кешей. В инклюзивной системе кеширования предыдущего поколения данные из общего кеша L3 реплицировались в частные кеши L1/L2, что компания посчитала неэффективным расходом «кремния». Конструкция ядер второго поколения исключает копирование, что, по словам Симпсона, даёт «в 1,5 раза большую производительность по сравнению с первым поколением» при меньшей занимаемой площади на кристалле. SiFive также интегрировала новый аппаратный конвейерный экспоненциальный блок. В то время как MAC-операции доминируют в рабочих ИИ-нагрузках, возведение в степень становится следующим серьёзным узким местом. Например, в BERT LLM, ускоренных матричным движком, операции softmax, включающие возведение в степень, занимают более 50 % оставшихся циклов. Программными оптимизациями SiFive сократила выполнение функции возведения в степень с 22 до 15 циклов, а новый аппаратный блок сокращает её до одной инструкции, уменьшая общее время выполнения функции до пяти циклов. Программный стек для семейства Intelligence второго поколения поддерживает масштабируемость. В серии XM среда выполнения машинного обучения уже распределяет рабочие нагрузки между несколькими кластерами XM на одном кристалле. Впрочем, пока масштабирование за пределы одного кристалла требует дальнейшей разработки библиотеки межпроцессорного взаимодействия (IPC). Флагманские решения X160 Gen 2 и X180 Gen 2 могут быть настроены для работы под управлением операционной системы реального времени, пишет SiliconANGLE. 32-бит IP-ядро Intelligence X160 разработано для оптимизации энергоэффективности и приложений с жесткими ограничениями по площади кристалла, в то время как 64-бит IP-ядро Intelligence X180 обеспечивает более высокую производительность и лучшую интеграцию с более крупными подсистемами памяти, сообщил ресурс CNX-Software. X160 поставляется с кеш-памятью объёмом до 200 КиБ и памятью объёмом 2 МиБ. Помимо промышленного оборудования, ядро может найти применение в потребительских устройствах, таких как фитнес-трекеры. Кроме того, X160 можно установить в системах с несколькими ИИ-ускорителями для управления чипами и предотвращения изменения прошивки. Благодаря двум встроенным кешам общей ёмкостью более 4 МиБ ядро позволяет работать с большим объёмом данных. По данным SiFive, X160 подходит для обучения ИИ-моделей и использования в оборудовании ЦОД. В свою очередь, ядро X280 ориентировано на потребительские устройства, такие как гарнитуры дополненной реальности, а X390 также может использоваться в автомобилях и инфраструктурных системах. Последнее ядро выполняет векторную обработку в четыре раза быстрее, чем X280. Все пять продуктов Intelligence Gen 2 уже доступны для лицензирования, а появление первых чипов на их основе ожидается во II квартале 2026 года. SiFive сообщила, что два ведущих американских производителя полупроводников лицензировали новую серию X100 ещё до её публичного анонса. Они используют IP-ядро X100 в двух различных сценариях: одна компания задействует сочетание скалярного векторного ядра SiFive с матричным движком, выступающим в качестве блока управления ускорителем, а вторая использует векторный движок в качестве автономного ИИ-ускорителя. |

|