Лента новостей

|

26.07.2025 [15:54], Сергей Карасёв

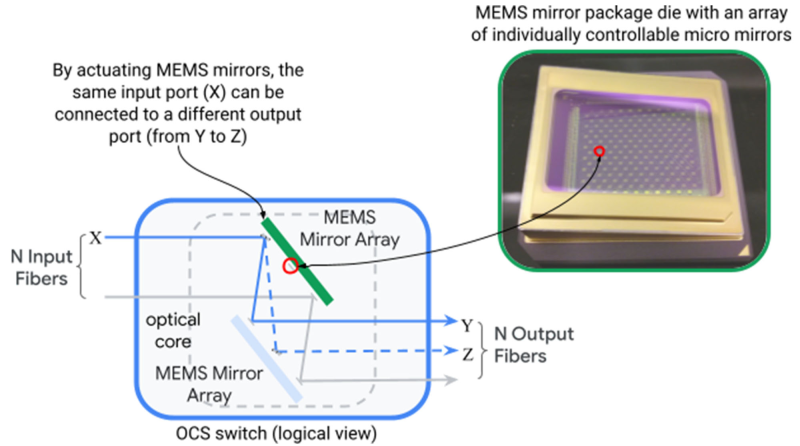

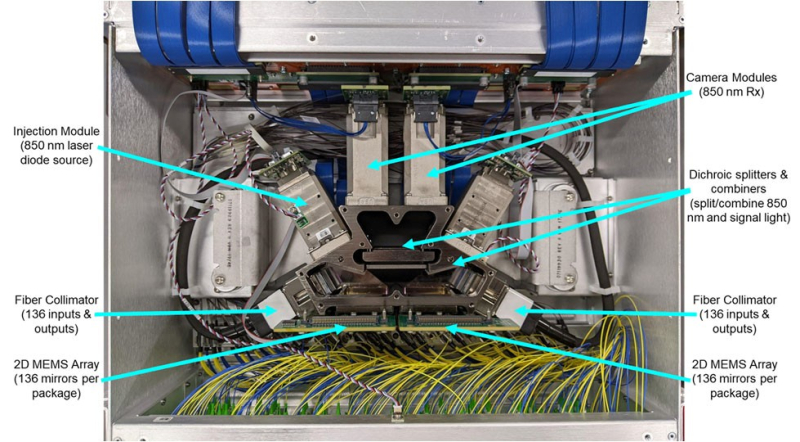

OCP запустила проект OCS по развитию оптической коммутации в ИИ ЦОДНекоммерческая организация Open Compute Project Foundation (OCP) анонсировала проект Optical Circuit Switching (OCS), направленный на ускорение внедрения технологий фотонной (оптической) коммутации в ИИ ЦОД. Цель инициативы — повышение пропускной способности, снижение задержек и улучшение энергоэффективности инфраструктур с интенсивным обменом данными. Проект возглавляют iPronics и Lumentum, а в число его участников входят Coherent, Google, Lumotive, Microsoft, nEye, NVIDIA, Oriole Networks и Polatis (Huber+Suhner). Нужно отметить, что разработкой фотонных решений для высоконагруженных платформ ИИ и дата-центров занимаются многие компании. В их число входят DustPhotonics, Oriole Networks, Lightmatter, Celestial AI, Xscape Photonics, Ayar Labs и пр. В отличие от традиционной электрической коммутации, решение OCS базируется на оптической маршрутизации данных. Новый интерконнект планируется использовать в кластерах ИИ, поддерживающих ресурсоёмкие нагрузки, включая генеративные сервисы и большие языковые модели (LLM). Предполагается, что проект OCS позволит создать масштабируемое и надёжное решение для обработки больших объёмов данных, поддерживающее бесшовную интеграцию с различными сетевыми протоколами. Упомянута совместимость с такими программными фреймворками, как gNMI, gNOI, gNSI и OpenConfig. В заявлении OCP говорится, что инициатива OCS будет способствовать сотрудничеству между ведущими игроками отрасли, гиперскейлерами и поставщиками для создания совместимых открытых продуктов, которые помогут стимулировать инновации в области оптических сетей. В частности, планируется выпуск компактных и гибко настраиваемых оптических коммутаторов для ИИ ЦОД. На практике оптическую коммутацию массово использует, по-видимому, только Google. В 2022 году компания рассказала об OCS Apollo, которые используют MEMS-переключатели для перенаправления лучей света. Эти коммутаторы обслуживают кластеры TPU.

26.07.2025 [14:55], Сергей Карасёв

В Европе запущена первая метаоблачная ИИ-платформа Fact8raКомпания OpenNebula Systems объявила о запуске Fact8ra — это, как утверждается, первая в Европе платформа «ИИ как услуга» (AI-as-a-Service) на основе мультиоблачной архитектуры. Инициатива является важным этапом на пути формирования европейской суверенной инфраструктуры ИИ. Любопытно, что в Китае создаётся похожая платформа, но по совсем иным причинам — в результате не слишком удачного планирования значительная часть вычислительных мощностей простаивает без дела. Система Fact8ra предлагает многопользовательскую среду для развёртывания частных экземпляров больших языковых моделей (LLM) с открытым исходным кодом. Платформа объединяет НРС-мощности, публичное облако и периферийные ресурсы по всему ЕС. Fact8ra основана на суверенном облачном стеке ИИ, включающем решения OpenNebula, а также другие европейские технологии open source, такие как openSUSE и MariaDB. Поначалу Fact8ra объединит GPU-серверы в восьми странах ЕС: Франции, Германии, Италии, Латвии, Нидерландах, Польше, Испании и Швеции. Отмечается, что Fact8ra способна агрегировать ресурсы поставщиков публичных облачных сервисов, периферийных площадок, суперкомпьютерных центров и финансируемых ЕС фабрик ИИ. В частности, будут объединены мощности Arsys, CloudFerro, IONOS, Leaseweb, OVHcloud, Scaleway, StackScale и Tiscali. Говорится о расширенной поддержке ИИ-ускорителей NVIDIA. Fact8ra поддерживает работу с различными LLM, включая Mistral Nemo 12B, EuroLLM 9B, Salamandra 7B и Italia 9B. Кроме того, реализована интеграция с внешними каталогами ИИ-моделей, в том числе Hugging Face. Поначалу пользователям будут доступны возможности инференса, а затем появятся функции тонкой настройки и обучения моделей ИИ. Fact8ra реализуется как часть программы IPCEI-CIS (Important Project of Common European Interest on Next Generation Cloud Infrastructure and Services) — это европейский проект развития облачной инфраструктуры и услуг следующего поколения. Инициатива стоимостью €3 млрд была одобрена Европейской комиссией в декабре 2023 года. Проект поддерживается 12 государствами-членами ЕС и более чем 120 индустриальными партнёрами. Целями являются стимулирование исследований и увеличение инвестиций в технологии периферийных и облачных вычислений в ЕС, а также создание децентрализованной периферийной инфраструктуры. Ранее в рамках IPCEI-CIS была анонсирована суверенная облачная платформа Virt8ra.

26.07.2025 [14:46], Руслан Авдеев

Внеплановая экономика: Китай создаст метаоблако для продажи избыточных вычислительных мощностейКНР принимает меры по формированию сети продаж вычислительных мощностей и сдерживания неконтролируемого развития рынка ЦОД. Дело в том, что тысячи поддерживаемых местными властями дата-центров, уже построенных в Китае, привели к переизбытку предложения, сообщает Reuters. Государственные органы проводят оценку соответствующего рынка в общенациональном масштабе после трёхлетнего бума строительства дата-центров. По словам одного из представителей органов местной власти, Пекин также намерен создать общегосударственный облачный сервис для использования «лишних» вычислительных мощностей. Так, Министерство промышленности и информационных технологий взаимодействует с тремя государственными телеком-компаниями Китая для разработки способов объединения ЦОД в рамках единой платформы для продаж незадействованных вычислительных мощностей. В гонке с США за лидерство в ИИ-секторе неиспользуемые мощности и финансово нестабильные ЦОД — значимая проблема Пекина, способная помешать претворению в жизнь его амбиций. По словам местных исследователей и чиновников, к 2028 году Китай намерен стандартизировать доступ к вычислительным мощностям в стране, но некоторые эксперты сулят плану технические проблемы. Бум строительства ЦОД в Китае начался в 2022 году, после запуска амбициозного проекта «Восточные данные, Западные вычисления» (Eastern Data, Western Computing), в рамках которого планировалось построить множество ЦОД в западных регионах КНР, где стоимость энергии ниже, для обработки данных восточных регионов, где сосредоточена основная экономическая деятельность страны. В июне было заявлено, что на сегодня лицензии выданы не менее 7 тыс. вычислительных центров. Согласно анализу Reuters государственных закупок, в прошлом году инвестиции Китая в эту сферу выросли на порядок — с ¥2,4 млрд юаней в 2023 году до ¥24,7 млрд ($3,4 млрд). В текущем году в эти ЦОД уже инвестировано ¥12,4 млрд юаней, большая часть из них находится в Синьцзяне. Возможно, это связано с проектом гигантского комплекса ИИ ЦОД для 115 тыс. ускорителей NVIDIA. Тем не менее, если в 2023 году отменили лишь 11 проектов строительства ЦОД, то за последние 18 месяцев таковых стало более сотни — местные власти обеспокоены окупаемостью инвестиций. По данным источников Reuters, уровень загрузки построенных ЦОД крайне низок, порядка 20–30 %. Некоторые эксперты уже заявили, что инвесторы и местные власти, ожидающие заказы от правительства и госкомпаний, строят ЦОД без учёта реальных потребностей рынка. При этом идея строительства на западе страны изначально лишена экономического обоснования, поскольку снижение расходов идёт рука об руку со снижением производительности и доступности. Ранее уже сообщалось, что многочисленные и наспех построенные дата-центры в западных регионах попросту оказались невостребованными. Проблема и в архитектуре ЦОД, и в их удалённости. В рамках проекта Eastern Data, Western Computing планировалось добиться задержки 20 мс к 2025 году — это пороговое значение, необходимое для приложений вроде сверхбыстрой алгоритмической торговли и других сервисов в финансовом секторе. Тем не менее, многие объекты до сих пор не соответствуют этому стандарту, а аренда каналов связи восток–запад всё ещё очень дорога. Фактически многие предприятия предпочитают хранить данные в дата-центрах на западе, но не обрабатывать их там. Кроме того, построенные ИИ ЦОД опираются как на ускорители NVIDIA, так и на локальные альтернативы вроде Huawei Ascend, что усложняет интеграцию различных полупроводников, требующих разного аппаратного и программного обеспечения, что затрудняет создание единого облачного сервиса. Тем не менее, власти оптимистичны и рассчитывают преодолеть эти различия — по их словам, пользователям нового сервиса достаточно будет указать свои требования вроде необходимого объёма вычислений и пропускной способности сети. Для регулирования развития сектора ЦОД комиссия NDRC, занимающаяся планированием в Китае, в начале года инициировала ужесточение контроля за новыми проектами дата-центров, строительство которых запланировано после 20 марта. Кроме того, местным органам власти запретили участвовать в мелких проектах по созданию вычислительной инфраструктуры. Предположительно, NDRC желает предотвратить нерациональное использование ресурсов, устанавливая пороговые требования — вроде наличия соглашения о покупке запланированных мощностей и минимального уровня загрузки. Таким образом предполагается отсеять «мусорные» проекты.

26.07.2025 [01:05], Руслан Авдеев

Несмотря на запреты США в Китай «просочились» передовые ускорители NVIDIA на $1 млрдЗа три месяца действия новых правил США по ужесточению контроля за экспортом ИИ-чипов в КНР всё равно попали ускорители NVIDIA на сумму не менее $1 млрд. Возможности Вашингтона по борьбе с контрабандой оказались весьма ограниченными, сообщает The Financial Times. Проведённый анализ самых разных коммерческих документов и беседы с информаторами позволили выяснить, что наиболее востребованы ускорители NVIDIA B200. Причём они широко доступны на чёрном рынке, хотя их продажа клиентам из КНР запрещена. По данным The Financial Times, в мае некоторые китайские дистрибуторы начали продавать B200 для местных ИИ ЦОД — вскоре после того, как Трамп ограничил поставки в Китая ослабленных ускорителей H20. Юристы утверждают, что в Китае активно поддерживается «параллельный импорт» — ввоз новинок в страну вполне легален, если оплатить таможенные пошлины. При этом поставщики нарушают законы США. По словам экспертов, после появления слухов об ограничении поставок ускорителей в Юго-Восточную Азию, покупатели поспешили с заказами, стремясь создать запасы до того, как правила вступят в силу. Не так давно глава NVIDIA Дженсен Хуанг (Jensen Huang) жёстко раскритиковал запрет на поставки ускорителей NVIDIA в Китай, а на днях объявил, что администрация Трампа снова разрешила их поставку в страну. Правда, три месяца запретов не помешали китайским дистрибьюторам довольно свободно продавать B200, H100 и H200, а также другие ускорители, ввоз которых в КНР запрещён. В NVIDIA подчёркивают, что доказательства причастности производителей к контрабанде отсутствуют, а использование чипов с чёрного рынка вообще неэффективно, поскольку для них нужна официальная поддержка. Решения на базе B200 пользуются повышенным спросом из-за их относительной простоты и высокой производительности.

Источник изображения: Christian Lue/unsplash.com Тем не менее попавшие, в руки журналистов документы свидетельствуют о том, что компания из провинции Аньхой, название которой переводится как Gate of the Era («Врата эпохи»), была основана в феврале 2025 года шанхайской бизнес-группой. Чипы продавались в составе готовых платформ с восемью B200, необходимым ПО и вспомогательным оборудованием. Текущая рыночная цена — $489 тыс. за единицу — примерно на 50 % больше, чем в США. С середины мая компания получила как минимум две партии стоек по несколько сотен штук, продано оборудования на сумму около $400 млн. Крупнейшим акционером бизнеса является китайская ИИ-компания China Century (Huajiyuan). Судя по сайту последней, у неё есть даже офис в Кремниевой долине и узел цепочки поставок в Сингапуре, а также более 100 деловых партнёров, включая AliCloud, ByteDance Huoshan Cloud и Baidu Cloud, хотя представители некоторых бизнесов опровергают факт сотрудничества. В самой China Century сообщают, что занимаются умными городами и никаких чипов NVIDIA не закупали. Как показало расследование The Financial Times, многие решения, проданные Gate of the Era и другими китайскими дистрибьюторами за последние месяцы, были произведены Supermicro, Dell и Asus. Правда, предполагать причастность производителей к контрабанде оснований нет. По словам одного из китайских ЦОД, экспортный контроль США не эффективен и лишь даёт огромные прибыли посредникам, готовым рисковать. Некоторые китайские поставщики открыто предлагают стойки B200 в социальных сетях и даже предлагают протестировать их. А некоторые компании уже рекламируют грядущие поставки B300, которые должны появиться к концу года.

Источник изображения: Gene Brutty/unsplash.com Конечно, экспортный контроль США не мог не повлиять на структуру рынка ускорителей. Доходит до того, что многие китайские компании пользуются услугами облачных посредников из третьих стран, которым разрешено покупать ускорители. Впрочем, эксперты ожидают, что возобновление продаж H20 в КНР приведёт к их массовой закупке, хотя они и значительно слабее B200. По данным дистрибуторов, продажи B200 и других чипов упали после объявления об ослаблении запрета на H20. Впрочем, утверждается, что спрос на передовые продукты всегда будет. По словам отраслевых экспертов, китайский бизнес активно скупал «запрещённые» чипы в странах Юго-Восточной Азии. Министерство торговли США уже обсуждает возможность ограничить экспорт в страны вроде Таиланда. Малайзия ужесточила экспортный контроль, ограничив возможность перепродажи передовых ИИ-чипов другим страна, в первую очередь — в Китай. Впрочем, даже если эти лазейки закроют, китайские отраслевые эксперты уверены, что появятся новые маршруты поставок. Более того, они якобы уже начались через европейские страны, не попадающие под экспортные ограничения. По словам одного из дистрибуторов, история уже не раз доказывала, что, с учётом огромной прибыли, посредники всегда найдут способ обойти ограничения.

25.07.2025 [17:41], Сергей Карасёв

SoftBank развернула крупнейшую в мире ИИ-платформу на базе NVIDIA DGX B200Японский холдинг SoftBank объявил о расширении вычислительной ИИ-инфраструктуры на платформе NVIDIA DGX SuperPOD: развёрнуты системы DGX B200, насчитывающие в общей сложности 4 тыс. ускорителей поколения Blackwell. О планах SoftBank по созданию первого в мире ИИ-суперкомпьютер на базе NVIDIA DGX B200 стало известно в конце прошлого года. Вычислительная система использует интерконнект Quantum-2 InfiniBand и поддерживается программной платформой NVIDIA AI Enterprise. Холдинг SoftBank изначально внедрил DGX SuperPOD с более чем 2 тыс. ускорителями поколения NVIDIA Ampere в сентябре 2023 года: на тот момент производительность достигала 0,7 Эфлопс на операциях ИИ (точность вычислений не раскрывается). В октябре 2024 года завершился первый этап модернизации, в ходе которого были добавлены 4000 ускорителей семейства NVIDIA Hopper. В результате, суммарное быстродействие поднялось до 4,7 Эфлопс. После установки DGX B200 показатель вырос до 13,7 Эфлопс. Отмечается, что на сегодняшний день новая вычислительная инфраструктура SoftBank является крупнейшей в мире ИИ-платформой на основе DGX B200. При этом в общей сложности задействованы свыше 10 тыс. ускорителей. Изначально систему будет использовать SB Intuitions Corp. — дочерняя структура SoftBank, которая специализируется на разработке собственных больших языковых моделей (LLM), адаптированных для Японии. SB Intuitions уже создала LLM с примерно 460 млрд параметров, а в текущем 2025 финансовом году, который заканчивается 31 марта 2026-го, компания планирует представить коммерческую ИИ-модель Sarashina mini с 70 млрд параметров. Нужно отметить, что ранее SoftBank и OpenAI объявили о формировании совместного предприятия SB OpenAI для развития корпоративных ИИ-сервисов в Японии. Кроме того, SoftBank участвует в мегапроект Stargate — это совместное предприятие с OpenAI и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. Впрочем, пока проект продвигается с большим трудом.

25.07.2025 [17:26], Руслан Авдеев

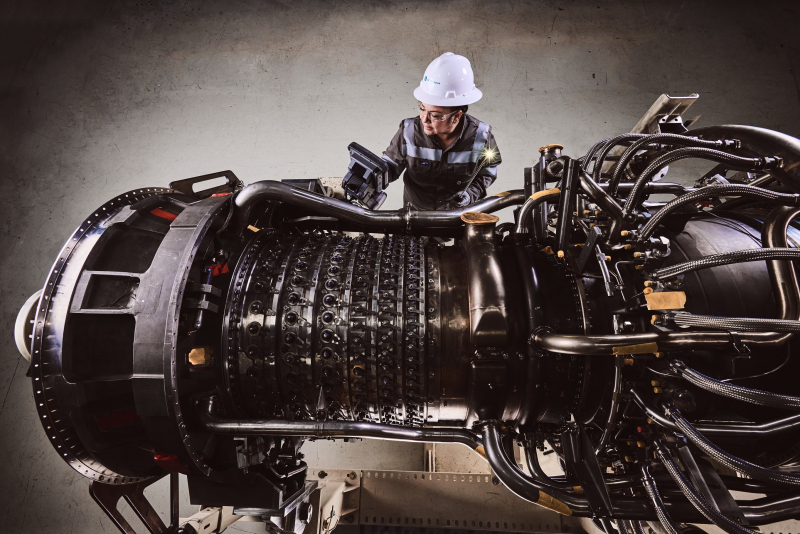

По пути Маска: Crusoe заказала 29 газовых турбин для ИИ ЦОД, часть которых достанется OpenAICrusoe заказала у GE Vernova ещё 19 газотурбинных установок LM2500XPRESS на основе авиационных двигателей, сообщает Datacenter Dynamics. В общей сложности Crusoe получит 29 турбин — с учётом заказанных в декабре 2024 года. Ожидается, что в совокупности они обеспечат мощность 1 ГВт. Сейчас Crusoe строит в интересах OpenAI 1,2-ГВт кампус Stargate I в Абилине (Техас), который частично будет запитан именно от газовых турбин. По словам Crusoe, экспоненциальный рост ИИ требует энергетических решений с возможностью быстрого развёртывания. В том числе рассматривает строительство генерирующих мощностей непосредственно рядом с дата-центрами, чтобы обеспечить последние устойчивым и контролируемым энергоснабжением. В компании заявляют, что создают ИИ-фабрики с рекордной скоростью, а технология GE Vernova является ключевым фактором, ускоряющим энергообеспечение клиентов и партнёров. Кроме того, компания использует аккумуляторы и готова подключиться к солнечным и ветряным электростанциям, а в перспективе рассматривает возможность установки малых модульных реакторов. LM2500XPRESS — это мобильная газотурбинная электростанция мощностью до 35 МВт на базе авиационного двигателя General Electric LM2500, адаптированного для наземного использования, включающая газовый компрессор и систему контроля выбросов. В GE Vernova заявили, что выбросы сокращаются за счёт каталитического нейтрализатора, преобразующего окиси азота в водяной пар и безвредный азот. В результате генератор обеспечивает на 90 % меньше выбросов, чем традиционные поршневые двигатели на газе или дизельном топливе. Ранее в этом году Crusoe создала совместное предприятие с инвестиционной компанией Engine No. 1 из Сан-Франциско для закупки газовых турбин на 4,5 ГВт у GE Vernova и Chevron. Производители газовых турбин столкнулись с резко возросшим спросом со стороны дата-центров, особенно из-за бума ИИ и высоких энергозатрат на вычисления. Тем не менее, расширять производство они пока опасаются. Очередь на турбины растянулась как минимум до 2030 года, что создаёт задержки в строительстве энергомощностей для новых дата-центров. Дело в том, что операторы ЦОД не желают годами ждать присоединения к энергосетям, пока не готовым к столь высоким нагрузкам. Примечательно, что активным освоением газовой энергетики занимается не только Crusoe. ИИ-стартап xAI Илона Маска (Elon Musk) в своё время установил газовые генераторы на территории своего кампуса ЦОД и даже получил разрешение на 15 турбин из оставшихся 24-х. Конечно, довольны этим далеко не все, и компания встретила жёсткое противодействие со стороны местных жителей. Впрочем, ещё в мае сообщалось, что второй ЦОД в Мемфисе, вероятно, тоже получит газовые генераторы, тем более, что Маск анонсировал запуск нового суперкомпьютера Colossus 2, которому тоже понадобится немало энергии.

25.07.2025 [17:04], Руслан Авдеев

Anthropic: к 2028 году для ИИ в США потребуется 50 ГВт электроэнергии, а для передовых ИИ-моделей — 5-ГВт ЦОДКомпания Anthropic объявила, что для сохранения лидерства в гонке ИИ США потребуется «не менее 50 ГВт электричества» для нужд искусственного интеллекта к 2028 году. При этом в компании уверены, что для обучения передовых ИИ-моделей потребуются дата-центры мощностью по 5 ГВт, сообщает Datacenter Dynamics. OpenAI тоже мечтает о 5-ГВт ЦОД. Если раньше Anthropic сообщала, что 50 ГВт нужно ввести в эксплуатацию до 2027 года, то теперь сроки перенесены на год. Из них к 2028 году 20–25 ГВт пойдёт на обучение передовых ИИ-систем в нескольких локациях. Эксперты расходятся в оценках, но даже если эти цифры приблизительно верны, удовлетворить потребности ИИ в энергии будет нелегко. По прогнозам Национальной лаборатории им. Лоуренса в Беркли (LBNL) при Министерстве энергетики США, в 2028 году ЦОД разных типов потребуется 74–132 ГВт. При этом отмечается, что за последний год КНР ввела в эксплуатацию более 400 ГВт генерирующих мощностей, а в США речь идёт лишь о нескольких десятках гигаватт. Как отмечают в компании, строить соответствующую энергетическую инфраструктуру трудно, поскольку приходится добиваться «дублирующих» разрешений на местном уровне, уровне штатов и федеральном уровне. Дополнительно необходимы разрешения на линии электропередачи, возможны задержки с подключением объектов к сети. Anthropic уже внесла ряд предложений, в основном связанных с сокращением регулирования и количества разрешений в целом — что вполне соответствует новому плану администрации США. Среди предложений — разрешить арендовать земли Министерства обороны (DoE) и Министерства энергетики США (DoE) для строительства дата-центров. Ещё при прошлом президенте власти поручили им рассмотреть возможность выдачи участков для ЦОД. Работы продолжились и при новой администрации, в апреле объявлено о выборе 16 площадок, но официально ни одного проекта ещё не анонсировали. Правда, попутно администрация отказалась от проектов «зелёной» энергетики и зачем-то уволила специалистов DoE по ЛЭП. Дополнительно Anthropic призывает ускорить пересмотр Закона о национальной политике в области охраны окружающей среды (NEPA), провести реформы, касающиеся сетевых соединений и создать магистрали передачи электроэнергии в интересах страны. Также необходимо ускорить выдачу разрешений на использование геотермальной, газовой и атомной энергетики, нарастить национальное производство важнейших компонентов электросетей и турбин, а также обучить рабочих. В целом предложения походят на прошлогодние рекомендации OpenAI для правительства. Стоит отметить, что крупнейшие обучающие кластеры Anthropic управляются её ключевым инвестором в лице AWS. Облачный гигант в рамках Project Rainier создаёт для Anthropic масштабный вычислительный кластер с чипами Trainium2, размещёнными сразу в нескольких ЦОД. Поскольку OpenAI намерена развернуть часть кампусов Stargate в ОАЭ, руководство Anthropic неохотно признало, что компании тоже придётся пойти на сотрудничество с ближневосточными режимами, иначе компания просто не выдержит конкуренции.

25.07.2025 [15:29], Владимир Мироненко

400 жертв уязвимости в Microsoft SharePoint — лишь верхушка айсбергаНесмотря на призывы Microsoft к пользователям платформы SharePoint Server установить свежие обновления софта для защиты от вируса-вымогателя Warlock, который может быть внедрён в их системы через цепочку уязвимостей ToolShell, не все компании выполнили это и по-прежнему остаются беззащитными перед хакерами, передаёт Computer Weekly. 19 июля 2025 года Центр реагирования на угрозы безопасности Microsoft (MSRC) опубликовал в блоге сообщение, посвящённое активным атакам, использующим уязвимости CVE-2025-49706 и CVE-2025-49704, которые затрагивают только on-premise серверы SharePoint, но не затрагивают SharePoint Online в Microsoft 365. Microsoft сообщила, что выпустила новые комплексные обновления безопасности для всех поддерживаемых версий SharePoint Server (Subscription Edition, 2019 и 2016), которые защищают от этих и новых уязвимостей CVE-2025-53770 и CVE-2025-53771. Microsoft рекомендует немедленно установить апдейты. «Лаборатория Касперского» обнаружила, что новые уязвимости связаны с уязвимостью CVE-2020-1147, которая была обнаружена в 2020 году и, по-видимому, не была корректно закрыта. По словам Глобального центра исследования и анализа угроз в «Лаборатории Касперского» (Kaspersky GReAT), эксплойт для CVE-2020-1147 похож на эксплойт ToolShell. Ранее компания заявила, что среди тех, кто эксплуатировал уязвимости, были выявлены якобы поддерживаемые правительством Китая группировки Linen Typhoon и Violet Typhoon, а также пока не классифицированная группировка Storm-2603, которая в прошлом демонстрировала связи с группировками, занимающимися вирусами-вымогателями, такими как LockBit. Ряд кибератак на пользователей SharePoint Server был связан с использованием программ-вымогателей. Установив связь с Warlock, Microsoft обновила информацию об атрибуции, индикаторах компрометации (IoC), рекомендациях по смягчению последствий и защите, а также об обнаружении и поиске угроз. По данным Shadowserver Foundation, по состоянию на 23 июля в Великобритании доступны через интернет около 600 экземпляров SharePoint, а в мире их число приближается к 11 тыс. Около 424 экземпляров SharePoint имеют уязвимости безопасности CVE-2025-53770 и CVE-2025-53771. Примерно четверть их находится в США. В заявлении Национального центра кибербезопасности Великобритании (NCSC) указано, что Microsoft и NCSC осведомлены о существовании эксплойта наблюдают активные атаки, направленные на SharePoint Serve. Кевин Робертсон (Kevin Robertson), главный технический директор компании Acumen Cyber, специализирующейся на управляемом обнаружении и реагировании (MDR), заявил, что отсутствие исправлений для ранее обнаруженных уязвимостей CVE-2025-49704 и CVE-2025-29706, которые бы полностью устранили предыдущие проблемы, оставило организации полностью беззащитными. Он отметил, что публичные данные о 400 скомпрометированных жертвах могут быть каплей в море. Кроме того, не все организации ещё успели установить патч, а значит, их среды по-прежнему полностью уязвимы.

25.07.2025 [14:36], Владимир Мироненко

Выход нового поколения мейнфреймов подстегнул рост выручки IBMIBM сообщила финансовые результаты II квартала 2025 года, превысившие прогнозы аналитиков Уолл-стрит по основным показателям. Выручка компании выросла год к году на 8 % до $16,98 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $16,59 млрд. Это намного лучше, чем в предыдущем квартале, когда выручка компании выросла в годичном исчислении менее чем на 1 %. Скорректированная прибыль (Non-GAAP) на акцию тоже превзошла ожидания Уолл-стрит, составив $2,80 против $2,64 согласно прогнозу. Чистая прибыль (GAAP) составила $2,19 млрд, превысив показатель в $1,83 млрд годом ранее. По состоянию на закрытие торгов в среду акции IBM выросли на 28 % с начала 2025 года, в то время как индекс S&P 500 за тот же период вырос примерно на 8 %. В значительной степени рост выручки был достигнут благодаря инфраструктурному подразделению, запустившему поставки мейнфреймов z17. Продажи этого подразделения выросли год к году на 14 % до $4,14 млрд, превысив прогноз Уолл-стрит в $3,66 млрд, пишет Bloomberg. Финансовый директор IBM Джим Кавано (Jim Kavanaugh) назвал в интервью Bloomberg нынешний первоначальный запуск мейнфрейма самым успешным в истории компании. Высокий спрос, по его словам, был обусловлен заказами крупных предприятий, особенно в финансовой сфере и розничной торговле. Аналитик Constellation Research Хольгер Мюллер (Holger Mueller) отметил, что мейнфрейм IBM был в центре внимания в этом квартале, в целом очень успешном для IBM. Он добавил, что ценностное предложение IBM в области ПО для ИИ продолжает расти, а платформа watsonX всё чаще рассматривается как «Швейцария» среди ИИ-стеков благодаря своей портативности. Анонсированная ранее платформа watsonx Orchestrate, по словам IBM, позволяет компаниям создавать автономных ИИ-агентов, способных выполнять задачи без человеческого контроля, менее чем за пять минут. «Благодаря watsonX можно работать в любом облачном стеке, поэтому предприятиям не нужно беспокоиться о рисках, связанных с привязкой к облаку, — пояснил аналитик. — Это даёт IBM преимущество, и, учитывая, что новый цикл обновления мейнфреймов только начинается, мы можем ожидать усиления динамики развития инфраструктуры в следующих кварталах». Арвинд Кришна (Arvind Krishna) заявил, что геополитическая напряжённость побуждает некоторых клиентов действовать осторожно, хотя в целом не является определяющим фактором. «Федеральные расходы США также были несколько ограничены в I половине года, но мы не ожидаем, что это создаст долгосрочные препятствия», — добавил он. Кришна отметил, что портфель заказов IBM в сфере генеративного ИИ продолжает расти и в настоящее время составляет $7,5 млрд, тогда как в I квартале этот показатель составлял $6 млрд. «Благодаря нашим высоким показателям в I полугодии мы повышаем наш годовой прогноз по свободному денежному потоку, который, как мы ожидаем, превысит $13,5 млрд», — сообщил гендиректор IBM. Выручка от разработки ПО выросла примерно на 10 % до $7,39 млрд, что ниже консенсус-прогноза аналитиков, опрошенных StreetAccount, в $7,43 млрд. Вместе с тем, выручка в категории гибридного облачного ПО, включающей Red Hat, показала рост на 16 %, что немного выше прогнозов. Валовая рентабельность подразделения ПО в размере 83,9 % оказалась лишь немного ниже консенсус-прогноза StreetAccount в 84,0 %. Выручка подразделения по автоматизации увеличилась год к году на 16 %, выручка подразделения по обработке данных и ИИ — на 9 %. Снижение выручки вызвано тем, что многие клиенты «переориентировали свои расходы на аппаратное обеспечение», сообщил Кришна. Он пояснил, что всё больше предприятий переключают своё внимание на расходы на расширение ИИ-инфраструктуры из-за неопределённой макроэкономической обстановки. В свою очередь, Кавано заявил, что продажи ПО Red Hat, как ожидается, продолжат расти в пределах 15–16 %. Выручка от консалтинговых услуг в отчётном квартале выросла почти на 3 % до $5,31 млрд, что выше консенсус-прогноза StreetAccount в $5,16 млрд. «Задержки с принятием решений, особенно по необязательным проектам, а также продления контрактов в прошлом году повлияли на наши контракты в течение отчётного периода», — отметил Джим Кавано. Вместе с тем, по словам Кришны, компании всё чаще обращаются к ним за помощью, поскольку им сложно самостоятельно интегрировать ИИ в свои системы. Они также стремятся оптимизировать свои IT-операции, чтобы иметь возможность быстрее реагировать на быстро меняющуюся экономическую ситуацию. Компания не предоставила прогноз на текущий квартал, отметив, что по-прежнему прогнозирует рост выручки не менее чем на 5 % при постоянном курсе валюты за год. Джим Кавано заявил, что компания также надеется на расширение своего бизнеса за счёт новых приобретений. «То, что мы наблюдали за последние четыре месяца, вселяет в нас оптимизм и позволяет нам надеяться на то, что мы находимся в условиях рационального регулирования, где разумные сделки слияния и поглощения будут одобрены в разумные сроки», — сказал он.

25.07.2025 [09:23], Владимир Мироненко

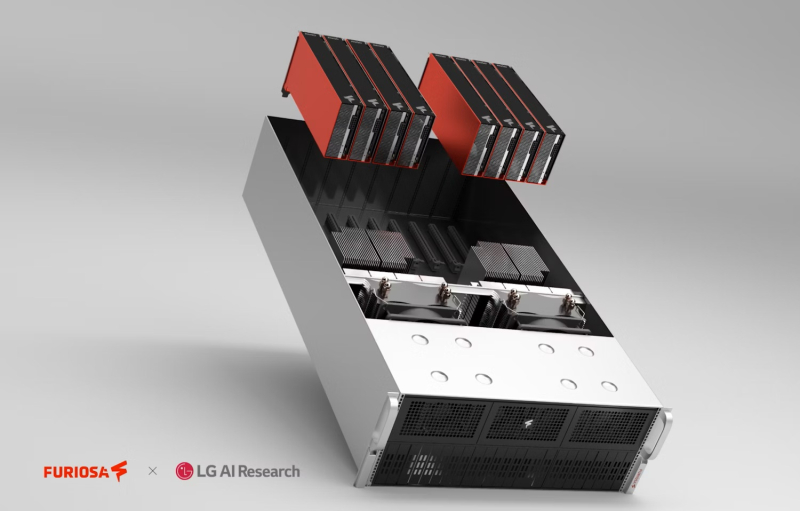

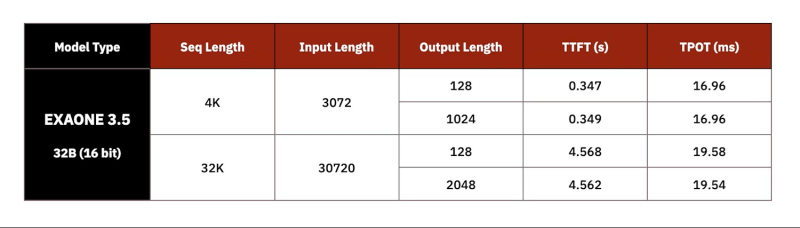

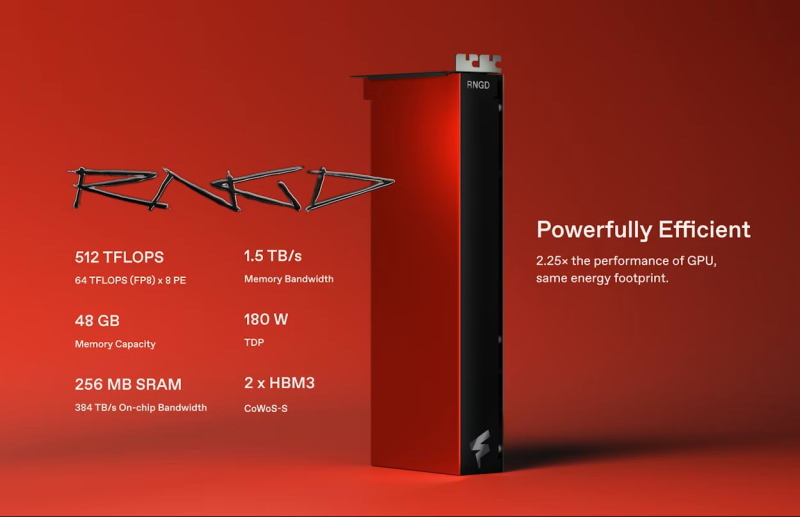

Импортозамещение по-южнокорейски: LG AI Research выбрала ускорители FuriosaAI RNGD для своих ИИ-серверовКомпания LG AI Research (ИИ-подразделение LG Group) из Южной Кореи заключила соглашение с южнокорейским стартапом FuriosaAI о выпуске серверов с ИИ-ускорителями RNGD для работы с собственным семейством LLM Exaone, сообщил The Register. Как сообщил генеральный директор FuriosaAI Джун Пайк (June Paik) изданию EE Times, серверы LG с чипами RNGD будут ориентированы на предприятия, использующие модели ExaOne в сфере электроники, финансов, телекоммуникаций и биотехнологий. Серверы поступят в продажу в конце этого года. «После тщательного тестирования широкого спектра опций мы пришли к выводу, что RNGD — высокоэффективное решение для развёртывания моделей Exaone», — заявил Киджонг Чон (Kijeong Jeon), руководитель подразделения продуктов LG AI Research. «RNGD обеспечивает убедительное сочетание преимуществ: превосходную производительность в реальных условиях, значительное снижение совокупной стоимости владения и удивительно простую интеграцию», — добавил он. Подобно системам на базе NVIDIA RTX Pro Blackwell, серверы LG RNGD будут включить до восьми ускорителей с интерфейсом PCIe 5.0. Эти системы будут работать на базе того, что FuriosaAI описывает как высокоразвитый программный стек, включающий библиотеку vLLM. LG также предложит собственную платформу агентского ИИ ChatExaone, которая адаптирована для корпоративных сценариев использования. Она объединяет ряд фреймворков для анализа документов, глубоких исследований, анализа данных и RAG. LG AI Research протестировала работу модели ExaOne-32B на восьмичиповом 4U-сервере c воздушным охлаждением, который был разработан совместно с Supermicro. В 15-кВт стойке можно разместить пять таких серверов. По словам Пайка, LG AI Research протестировала оборудование от нескольких поставщиков оборудования из Южной Кореи и других стран, взяв за основу ускорители NVIDIA A100. «LG AI Research также тестировала облачные решения, но, по их словам, наше решение на данный момент оказалось единственным, отвечающим их требованиям», — сказал Пайк. Как полагает The Register, выбор для сравнения ускорителя NVIDIA A100, дебютировавшего в 2020 году, а не более свежих моделей, вызван тем, что LG AI Research больше интересует энергоэффективность оборудования, чем производительность. И, как отметил Джун Пайк, хотя за пять лет с момента появления A100 ускорители NVIDIA, безусловно, стали мощнее, но произошло это за счёт увеличения энергопотребления и площади кристалла. Сообщается, что LG AI фактически использовала четыре PCIe-ускорителя RNGD, задействовав тензорный параллелизм для запуска модели Exaone 32B с 16-бит точностью. По словам Пайка, у LG были очень чёткие целевые показатели производительности, которые она стремилась достичь при валидации чипа. В частности, ограничения включали время до отдачи первого токена (TTFT) — примерно 0,3 с для небольших запросов на 3 тыс. токенов или 4,5 с для более крупных запросов на 30 тыс. токенов. Результат в 60 токенов/с достигается для контекстного окна размером 4 тыс. токенов или 50 токенов/с для контекстного окна размером 32 тыс. токенов. По словам Пайка, тесты проводились в режиме BF16, поскольку сравниваемые A100 не имеет встроенной поддержки FP8, так что использование RNGD в FP8-режиме позволит удвоить эффективность инференса и снизить TTFT. Кроме того, сервер продемонстрировал в 2,25 раза более высокую производительность инференса LLM на Ватт по сравнению с A100, а полная стойка сможет генерировать в 3,75 раза больше токенов, чем стойка с A100 при том же энергопотреблении. Чип FuriosaAI RNGD обеспечивает производительность 512 Тфлопс (FP8) при TDP 180 Вт. В отличие от ускорителей NVIDIA, оснащённых высокоскоростным интерконнектом NVLink (600 Гбайт/с), FuriosaAI использует интерфейс PCIe 5.0 (128 Гбайт/с). По словам FuriosaAI, чтобы избежать узких мест и накладных расходов, связанных с интерконнектом, компилятор компании помогает оптимизировать процесс обмена данными и собственно вычисления. |

|