Материалы по тегу: ии

|

25.06.2025 [13:34], Руслан Авдеев

SambaNova делает ставку на инференс и партнёрство с облачными провайдерами и госзаказчикамиРазработчик ИИ-ускорителей SambaNova Systems объявил о стратегическом изменении профиля деятельности. Теперь основное внимание будет уделено инференсу, а не обучению ИИ-моделей, сообщает EE Times со ссылкой на главу компании Родриго Ляна (Rodrigo Liang). Тот считает, что в ближайшие годы инференс станет ключевым направлением в ИИ-секторе. Переосмысление стратегии привело к увольнению 77 сотрудников в апреле 2025 года. Компания всё ещё будет поддерживать обучение ИИ-моделей, но признаёт, что спрос на крупные кластеры для этих целей заметно снизился. Многие клиенты переходят на открытые модели, адаптируя и дообучая их — разработчики не желают создавать свои LLM с нуля. Поэтому теперь SambaNova будет предоставлять предприятиям и правительственным структурам инструменты для развёртывания открытых и доработанных моделей, в том числе «рассуждающих». Основными клиентами компании сегодня являются крупные предприятия и «суверенные» государственные заказчики, заинтересованные в сокращении затрат. У госзаказчиков особые требования, в частности — независимость от США и других стран. Кроме того, они используют модели, обученные на локальных данных и ориентированные на специфику национальных экономик. Поскольку стойки компании потребляют всего по 10 кВт, позволить их себе могут даже страны со слабой энергетической инфраструктурой.

Источник изображения: Magnet.me/unsplash.com Хотя у SambaNova есть собственная облачная инфраструктура с поддержкой открытых моделей, компания не намерена строить крупные кластеры для инференса. Вместо этого она организует партнёрство с облачными провайдерами, предоставляя им технологии для создания ИИ-облаков. Некоторыми партнёрами стали региональные облачные провайдеры, намеренные развернуть собственные ИИ-экосистемы. Платформа SambaNova Cloud играет роль демонстрационной площадки и не претендует на конкуренцию с другими провайдерами, являясь шаблоном, по образцу которого можно развёртывать аналогичные схемы «под ключ». Технологии SambaNova позволяют запускать до 100 разных копий Llama-70B в одной стойке. Это отличный вариант для компаний, которым нужны разные варианты моделей для финансового, юридического и других отделов, для разных целей. По словам компании, у конкурентов для каждой версии модели требуется стойка на 140 кВт, в то время как SambaNova позволяет использовать стойки на 10 кВт для запуска множества моделей, причём переключение с одной на другую осуществляется «за миллисекунду». Это позволяет компаниям экономить значительные средства. Осенью 2024 года SambaNova объявила о запуске самой быстрой на тот момент облачной платформы для ИИ-инференса. В этом она соревнуется с Cerebras и Groq, которые пытаются составить конкуренцию NVIDIA. Стоит отметить, что Groq также сменила бизнес-подход, отказавшись от продажи отдельных ускорителей в пользу оснащения целых ИИ ЦОД для инференса. Cerebras совместно с партнёрами создаёт крупные ИИ-суперкомпьютеры и кластеры. От обучения моделей она не отказывается.

25.06.2025 [09:04], Руслан Авдеев

Недоступность ИИ-инфраструктуры усилит цифровое, экономическое и политическое неравенство

hardware

африка

гиперскейлер

дефицит

ии

импортозамещение

информационная безопасность

исследование

китай

конфиденциальность

облако

сша

цод

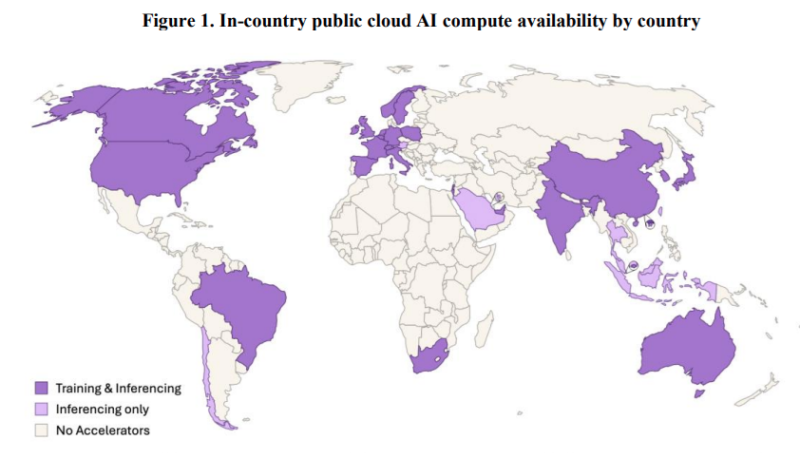

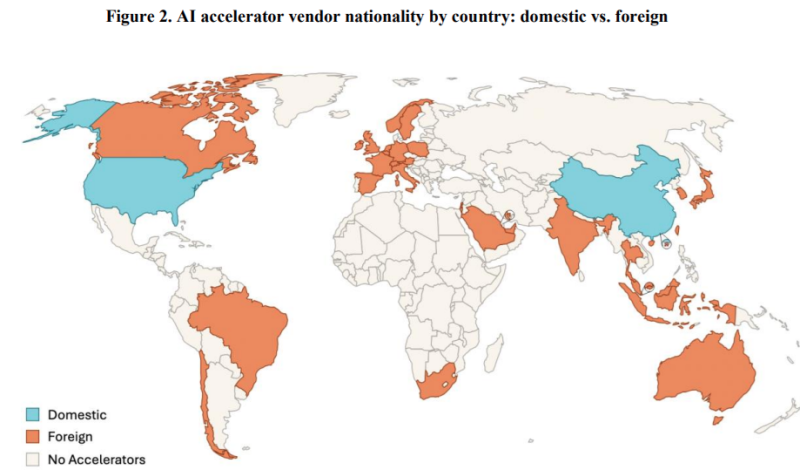

Искусственный интеллект становится основой глобальных инноваций, поэтому для развития стран наличия одних только талантов и идей мало, важно и наличие оборудование для работы с ИИ. Согласно исследованию учёных из Оксфордского университета, всего три десятка стран в мире обладают специализированными ИИ ЦОД, причём расположены они преимущественно в Северном полушарии планеты. Большинство же доступа к подобным технологиям не имеет, передаёт Tech Republic. В докладе подчёркивается, что только в США и Китае эксплуатируются более 90 % ИИ ЦОД. Американские техногиганты, включая AWS, Microsoft и Google, управляют 87 крупными ИИ ЦОД по всему миру, китайские компании — 39 площадками, а европейские — всего шестью. Африка, Южная Америка и Россия на карте фактически не отмечены, хотя в России ИИ-суперкомпьютеры есть. Кроме того, Гонконг и Тайвань посчитаны как отдельные страны. Так или иначе, более чем в 150 странах мира полноценная инфраструктура ИИ ЦОД отсутствует полностью, а без доступа к таким технологиям они рискуют отстать в освоении ИИ, в научных исследованиях и в экономическом развитии. Есть и ещё один важный фактор — технологический суверенитет. Многие государства вынужденно полагаются на мощности иностранных IT-гигантов, аренда которых обходится дорого, да и находятся они в чужой юрисдикции. Для стартапов и исследователей из ряда регионов Африки, Южной Америки и Юго-Восточной Азии это большая проблема. По словам президента Microsoft Брэда Смита (Brad Smith), эра ИИ может усугубить отставание Африки. Так, в Кении стартапы вроде Qhala разрабатывают ИИ-модели на африканских языках, но без местных ЦОД они вынуждены арендовать мощности на зарубежных серверах. Для сравнения: один только Институт Кемпнера (Kempner Institute) Гарвардского университета обладает большей вычислительной мощностью, чем все африканские ИИ-объекты вместе взятые.

Источник изображения: University of Oxford Подобное неравенство ведёт к печальным последствиям для слабых в технологическом отношении стран. Так, в Аргентине учёные жалуются на регулярный отъезд лучших студентов в США и Евросоюз для получения доступа к вычислительным мощностям. Проблема не просто техническая, поскольку без доступа к ИИ ЦОД страны лишаются инноваций, инвестиций и талантов. Например, некоторые страны открещиваются от сотрудничества с Китаем, чтобы не попасть под давление США. Впрочем, действительно и обратное — в Африке политики ведут переговоры с Huawei о переделке существующих ЦОД для размещения китайских ускорителей в попытке избавиться от зависимости от американской NVIDIA. Как отмечают исследователи, в недалёком будущем производители вычислительной техники смогут получить влияние, сопоставимое с тем, какое имеют поставщики нефти.

Источник изображения: University of Oxford Для того, чтобы преодолеть цифровое неравенство, Индия субсидирует создание собственной суверенной ИИ-инфраструктуры, Бразилия намерена выделить на аналогичные задачи $4 млрд, а Евросоюз готовится инвестировать €200 млрд. В Африке местный бизнес продвигает проект строительства пяти ЦОД стоимостью $500 млн, хотя даже это удовлетворит лишь малую часть запросов. Если раньше цифровое неравенство выражалось в неравномерном доступе к телефонным линиям или интернету, то теперь речь идёт о том, кто контролирует ИИ-инфраструктуры или распределение поставок её компонентов. Разрыв не только технологический, но и экономический и даже политический.

24.06.2025 [13:54], Владимир Мироненко

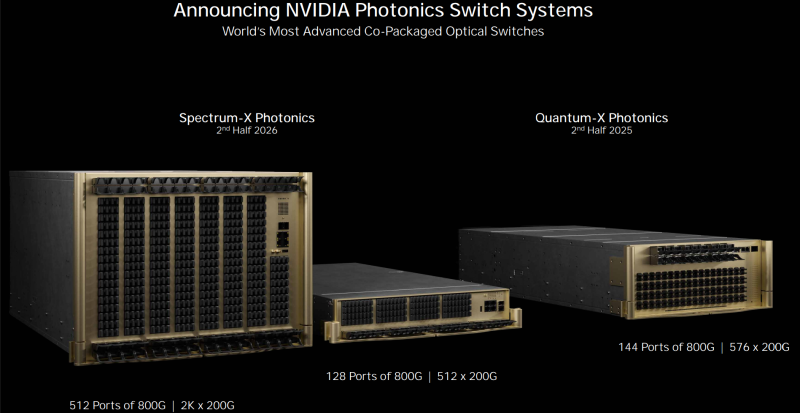

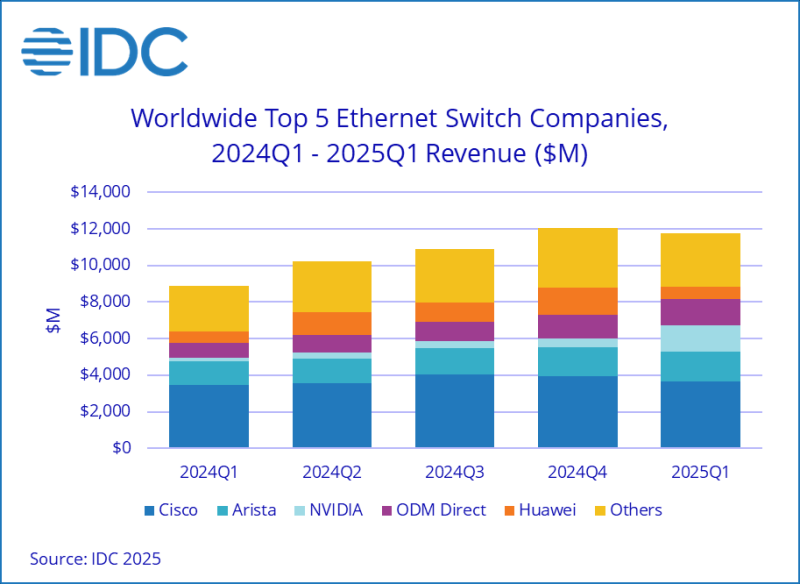

Продажи Ethernet-коммутаторов NVIDIA за год выросли на 760 % благодаря спросу на ИИIDC опубликовала отчёт о рынке Ethernet-коммутаторов по итогам I квартала 2025 года, согласно которому доход от продаж устройств составил $11,7 млрд, что на 32,3 % больше в годовом исчислении, пишет The Register. IDC утверждает, что этот бум обусловлен растущим развёртыванием «сетевой инфраструктуры с высокой пропускной способностью и малой задержкой для поддержки ИИ-нагрузок». Продажи коммутаторов 200/400GbE, которые большей частью используются в ЦОД, выросли год к году в 2,9 раза (189,7 %). Исходя из данных IDC и построенной на их основании модели ресурс The Next Platform пришёл к выводу, что сегменты 200 и 400 GbE вместе принесли около $4,5 млрд, более 18 млн портов в отчётном квартале. IDC также впервые опубликовала данные о 800GbE-коммутаторах, которые принесли $350,1 млн, что составляет 5,1 % общего объёма глобальных продаж Ethernet-коммутаторов за отчётный период. The Next Platform отметил, что IDC не сообщила о продажах Ethernet-коммутаторов стандарта 100 GbE, которые используются на рынке high-end кампусов, в корпоративных сетях и сетях поставщиков услуг, а также о продажах устройств стандарта 10 GbE, которые начали поставляться в больших объёмах в 2023 году. По оценкам The Next Platform, устройства 100 GbE принесли около $3 млрд дохода в I квартале, а коммутаторы 10 GbE — более $500 млн. Продажи устройств 2,5 GbE, 5 GbE, 25GbE и 50 GbE для использования в кампусах и на периферии составляют большую часть оставшейся суммы.

Источник изображения: NVIDIA IDC также начала отдельно отслеживать статистику NVIDIA. Выручка компании выросла год к году на 760,3 % и на 183,7 % последовательно до $1,46 млрд, что составило 12,5 % рынка коммутаторов. Доходы Cisco от продаж Ethernet-коммутаторов выросли на 4,7 % до $3,64 млрд, компания занимает чуть меньше трети рынка. При этом выручка Cisco от продаж коммутаторов для ЦОД упал на 3,2 %. Arista Networks увеличила продажи в годовом исчислении на 27,1 % до $1,63 млрд, благодаря чему её доля рынка составила 13,9 %. Продажи коммутаторов HPE, которые в основном связаны с беспроводными решениями Aruba, упали год к году на 5 %. Продажи Huawei составили $704 млн, что на 15,4 % больше в годовом исчислении, но более чем вдвое меньше, чем в предыдущем квартале. I квартал традиционно является очень слабым для Huawei. ODM-производители, в подавляющем большинстве поставляющие коммутаторы для ЦОД, в совокупности увеличили продажи до $1,41 млрд, показав рост на 67,5 % в годовом исчислении и на 18,6 % — последовательно. Продажи Ethernet-коммутаторов для ЦОД выросли в I квартале на 54,6 % до $6,92 млрд, составив 59,1 % от общего объёма продаж. В период с I квартала 2020 года по IV квартал 2022 года, когда начался бум генеративного ИИ, средняя доля рынка Ethernet-коммутаторов для ЦОД составляла 43,5 %. Это большой скачок в расходах на Ethernet для ЦОД, и он полностью связан с развёртыванием ИИ-кластеров для обучения и всё большего инференса, считают аналитики ресурса The Next Platform.

Источник изображения: IDC Часть рынка, не связанная с ЦОД, включающая устройства для кампусов и периферии, составила $4,78 млрд, увеличившись на 9,5 % год к году. Чуть больше половины этой суммы приходится на поставки коммутаторов стандарта 2,5 GbE для использования в кампусах. Лидером продаж в сегменте Ethernet-коммутаторов для ЦОД является Arista Networks, которая лидирует в этой категории с IV квартала 2023 года. Её продажи в I квартале составили $1,48 млрд, что на 26,4 % больше в годовом исчислении, обеспечив ей долю рынка в размере 21,3 %. К ней вплотную подобралась NVIDIA, увеличившая продажи до $1,46 млрд, что принесло ей долю рынка коммутаторов для ЦОД в 21,1 %. Как полагают аналитики The Next Platform, NVIDIA достаточно заключить ещё пару крупных сделок, и она опередит в этой категории сетевых устройств Arista Networks. В этом NVIDIA поможет расширение сотрудничества с Cisco, занявшей третье место в этой категории с продажами Ethernet-оборудования в $1,25 млрд, что на 17,7 % больше в годовом исчислении. ODM-производители, как уже сообщалось, увеличили выручку на 67,5 % до $1,41 млрд. В их числе около дюжины компаний, которые производят сетевое оборудование в заметных объёмах.

24.06.2025 [11:42], Сергей Карасёв

Lenovo анонсировала новые системы для дата-центров, оптимизированные для ИИКомпания Lenovo анонсировала новые гибридные платформы, оптимизированные для решения ресурсоёмких ИИ-задач в дата-центрах. Представлены системы различного уровня, созданные в партнёрстве с NVIDIA, Cisco и IBM. В частности, дебютировала модель ThinkSystem SR680a V4 на аппаратной платформе Intel. Полностью характеристики платформы не раскрываются. Известно, что применены процессоры семейства Xeon 6, в которое входят изделия на основе энергоэффективных E-ядер (Sierra Forest) и производительных P-ядер (Granite Rapids). Система несёт на борту восемь ускорителей NVIDIA Blackwell B200, а также восемь карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Утверждается, что по сравнению с серверами предыдущего поколения модель ThinkSystem SR680a V4 обеспечивает семикратный рост вычислительной производительности, тогда как объём памяти увеличился в четыре раза. Скорость инференса при работе с большими языковыми моделями (LLM) поднялась приблизительно в 11 раз. Кроме того, Lenovo представила ИИ-систему Hybrid AI на платформе IBM watsonx. В основу этого решения положены серверы Lenovo ThinkSystem SR675 (V3), оснащённые системой жидкостного охлаждения Neptune. Ещё одна система Lenovo Hybrid AI создана в партнёрстве с Cisco: она объединяет коммутаторы Cisco Nexus с технологией NVIDIA Spectrum-X для ускорения развёртывания ИИ-фабрик на предприятиях. Задействован сервер ThinkSystem SR675 V3, который может содержать до восьми ускорителей NVIDIA RTX Pro 6000 Blackwell Server Edition. Говорится о поддержке карт NVIDIA SuperNIC и NVIDIA BlueField-3 DPU. Платформа призвана ускорить переход организаций от ИИ-вычислений на базе CPU к средам на основе GPU.

23.06.2025 [16:53], Владимир Мироненко

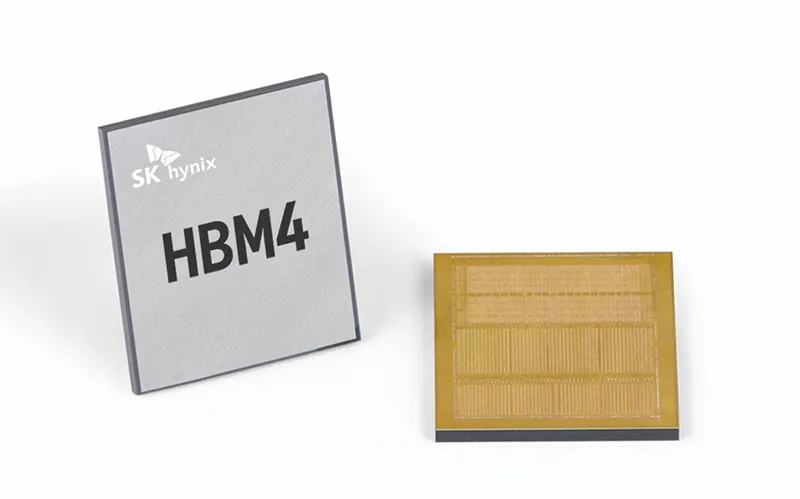

SK hynix выпустит кастомную HBM4E-память для NVIDIA, Microsoft и BroadcomСогласно данным The Korea Economic Daily, южнокорейская компания SK hynix заключила контракты на поставку кастомной памяти HBM с NVIDIA, Microsoft и Broadcom, опередив конкурента Samsung Electronics на рынке кастомной HBM, который, по прогнозам TrendForce и Bloomberg Intelligence к 2033 году вырастет до $130 млрд с $18,2 млрд в 2024 году. Ожидается, что поставки SK hynix кастомных чипов начнутся во второй половине 2025 года. По данным отраслевых источников, Samsung также ведёт переговоры с Broadcom и AMD о поставках кастомной HBM4. Ранее, в ходе квартального отчёта в апреле компания сообщила, что начнёт поставки памяти HBM4 в I половине 2026 года. Для наращивания производства HBM и передовой памяти DRAM компания SK hynix переоборудовала свой завод M15X в Чхонджу (Cheongju), изначально предназначенный для производства флеш-памяти NAND. Объём запланированных инвестиций составляет ₩20 трлн ($14,5 млрд). Кастомные HBM, предназначенные для удовлетворения конкретных потребностей клиентов, пользуются всё большим спросом, поскольку крупные технологические компании, стремясь оптимизировать производительность своих ИИ-решений, отказываются от использования универсальной памяти. О заключении контрактов стало известно примерно через 10 месяцев после того, как SK hynix объявила о получении запросов на поставку кастомной HBM от «Великолепной семёрки»: Apple, Microsoft, Google, Amazon, NVIDIA, Meta✴ и Tesla.

Источник изображения: SK hynix По словам источника The KED в полупроводниковой отрасли, «учитывая производственные мощности SK hynix и сроки запуска ИИ-сервисов крупными технологическими компаниями, удовлетворить все запросы “Великолепной семёрки” не представляется возможным». Тем не мене, он допустил, что SK hynix с учётом условий рынка может заключить контракты ещё с несколькими клиентами. Ранее SK hynix сообщила, что с поколением HBM4E она полностью перейдет на модель индивидуального производства. Текущее массовое внедрение сосредоточено вокруг HBM3E, а отрасль готовится в ближайшем будущем к переходу на шестое поколение памяти HBM — HBM4. По словам источников, выпуск кастомной памяти седьмого поколения HBM4E компания освоит во II половине 2026 года, а массовое производство HBM4 начнёт во второй II 2025 года. Начиная с HBM4, логические кристаллы для памяти SK hynix выпускает TSMC, поскольку усовершенствованный чип требует более продвинутых техпроцессов. До этого компания обходилась собственными мощностями. По данным TrendForce, SK hynix контролирует половину мирового рынка HBM, за ней следуют Samsung и Micron с долями рынка в размере 30 % и 20 % соответственно.

23.06.2025 [14:46], Владимир Мироненко

Broadcom представила VMware Cloud Foundation 9 — основу основ для современного частного облака

broadcom

kubernetes

nvidia

software

vmware

виртуализация

ии

информационная безопасность

частное облако

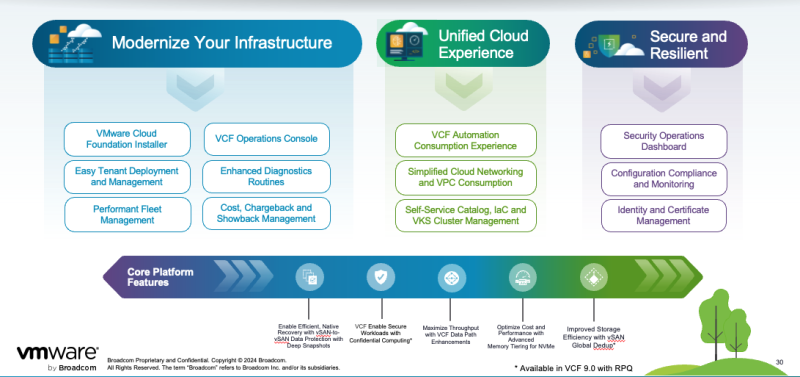

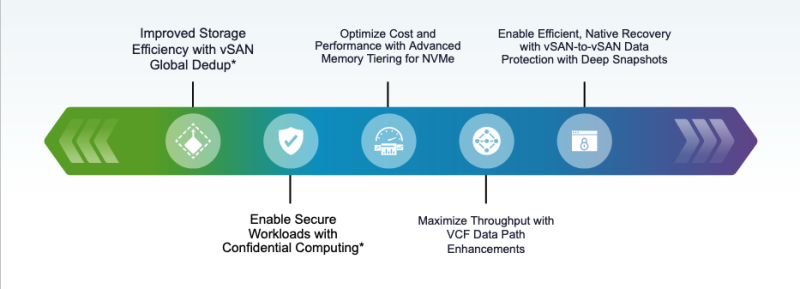

Broadcom объявила о выходе платформы VMware Cloud Foundation (VCF) 9.0, которая предоставляет клиентам согласованную операционную модель для частного облака, охватывающую ЦОД, периферию и управляемую облачную инфраструктуру. VCF 9.0 сочетает в себе гибкость и масштабируемость публичных облаков с безопасностью, производительностью, архитектурным контролем и низкой совокупной стоимостью владения (TCO) локальных сред. VCF 9.0 является единой унифицированной платформой с поддержкой традиционных, современных и ИИ-приложений, говорит компания. Согласованные операции, управление и контроль в среде частного облака, а также возможность самообслуживания позволяет разработчикам сосредоточиться на своих приложениях, а не на инфраструктуре. Именно для этого при создании VCF 9.0 была выбрана совершенно новая архитектура. VCF 9.0 получила унифицированный интерфейс для администраторов облака, обеспечивающий целостное представление о его работе. Новое приложение Quick Start значительно сокращает время и сложность настройки. Встроенные политики управления и предварительно настроенные шаблоны помогают поддерживать соответствие требованиям всем развёртываниям, сокращая ручные задачи и гарантируя повторяемость инфраструктуры. Разработчики получают доступ к автоматизированным и эластичным самообслуживаемым IaaS.

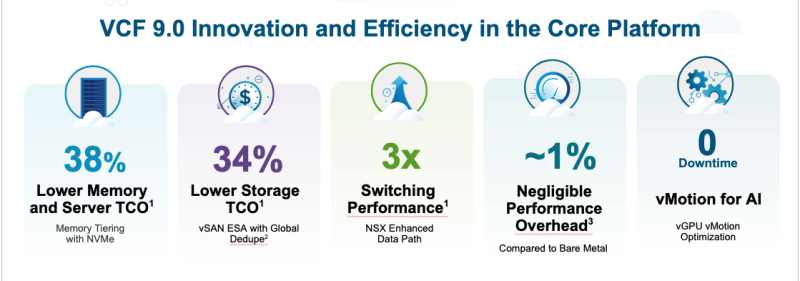

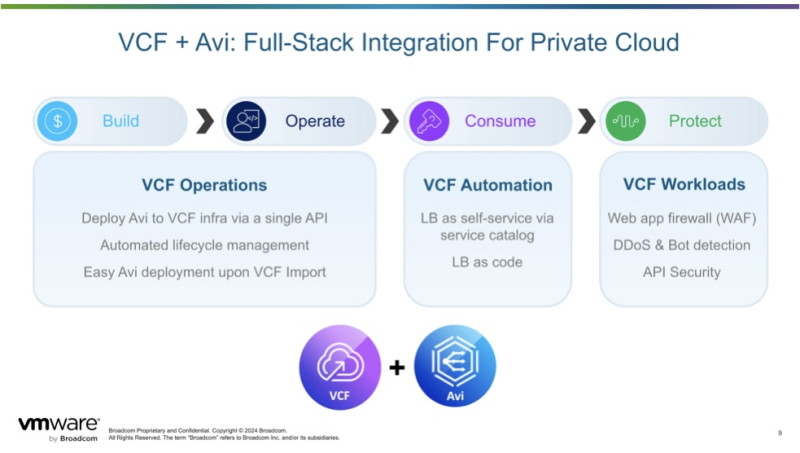

Источник изображений: Broadcom Встроенная службы vSphere Kubernetes Service (VKS) позволяет одинаково работать как с виртуальными машинами (ВМ), так и с контейнерами. Унифицированный подход позволяет клиентам создавать, развёртывать и запускать контейнеризированные и виртуализированные рабочие нагрузки вместе, снижая потребность в сложных стеках DevOps и интеграциях. VCF 9.0 предлагает явные преимущества в плане прогнозируемости и прозрачности затрат по сравнению с публичным облаком, позволяя организациям получить полное представление о совокупной стоимости владения и обеспечивая чёткую видимость рентабельности инвестиций в инфраструктуру, говорит Broadcom. Ключевой особенностью VCF 9.0 является и новая панель управления SecOps, обеспечивающая консолидированное представление безопасности платформы и управления данными, включая интегрированные политики соответствия и нормативные ограничения для согласованного управления. VMware vDefend обеспечивает встроенное обнаружение и реагирование на угрозы, микросегментацию на уровне зон и приложений, сокращение поверхности атак и принудительное применение принципа нулевого доверия в VCF. vDefend расширяет возможности как администраторов инфраструктуры, так и владельцев VPC, оптимизирует миграцию и обеспечивает последовательное предотвращение угроз в многоэкземплярных развёртываниях VCF. Обновления коснулись и подсистем хранения и сетей. Расширенное многоуровневое хранение для NVMe позволяет обеспечить снижение до 38 % совокупной стоимости владения, а VMware vSAN ESA с Global Dedupe позволяет на 34 % снизить совокупную стоимость владения хранилищем. Новая защита данных vSAN-to-vSAN с «глубокими» снапшотами обеспечивает более эффективное восстановление после сбоев или атак программ-вымогателей. VCF обеспечивает практически нулевую потерю производительности по сравнению с bare metal, поддерживая при этом vMotion без простоев для рабочих ИИ-нагрузок. VMware Live Recovery обеспечивает унифицированное управление кибер- и аварийным восстановлением во всех развертываниях VCF с повышенным суверенитетом данных за счёт локальных изолированных сред восстановления. Поддерживает до 200 неизменяемых снапшотов на ВМ и обеспечивает более эффективное масштабирование за счёт возможности расширения хранилища независимо от вычислений с помощью кластеров хранения vSAN. Наконец, в VMware NSX обеспечен трёхкратный рост производительности коммутации VMware Private AI Foundation с NVIDIA повышает кибербезопасность, позволяя развернуть облаки с поддержкой изоляции (air gap) и GPU-as-a-Service. В службе также появилась видимость профилей vGPU и новые инструменты мониторинга (v)GPU. А Model Runtime упрощает использование и масштабирование ИИ-моделей, в то время как Agent Builder Service обеспечивает более эффективное создание ИИ-агентов. VMware Data Services Manager (DSM) предлагает поддержку PostgreSQL и MySQL с Microsoft SQL Server в Tech Preview. Интеграция с VCF Automation позволяет ИТ-отделам предоставлять DBaaS, а дополнительные усовершенствования повышают эффективность для управления большими парками баз данных. Еще одним ключевым обновлением является интеграция балансировщика нагрузки VMware Avi с VMware Cloud Foundation (VCF) 9.0. Он обеспечивает единую облачную операционную модель для балансировки по всем рабочим нагрузкам, предлагает plug-and-play балансировку для ВМ и Kubernetes, а также единый API для администраторов и разработчиков инфраструктуры.

23.06.2025 [13:48], Руслан Авдеев

xAI воспользуется облаком Oracle для обучения и инференса GrokOracle частично раскрыла список компаний, использующих облачную инфраструктуру Oracle Cloud Infrastructure (OCI) для обучения ИИ-моделей и инференса. В их числе, несмотря на наличие собственных мощностей, оказался и стартап Илона Маска (Elon Musk) xAI, сообщает Datacenter Dynamics. xAI намерена использовать ИИ-инфраструктуру OCI для обучения моделей нового поколения, стоящих за чат-ботом Grok. Кроме того, OCI будет применяться и для инференса в интересах xAI. Также модели будут предлагаться через ИИ-сервис OCI, предлагающий доступ к моделям генеративного ИИ. По словам представителей xAI, Grok 3 знаменует собой прорыв в возможностях ИИ, а платформа Oracle ускорит его внедрение в корпоративном секторе. У xAI есть собственный ИИ-суперкомпьютер Colossus, который будет расширяться. Компания также намерена построить ещё один ЦОД. Правда, xAI столкнулась с судебным иском, связанным с увеличением мощности импровизированной электростанции из газовых генераторов.

Источник изображения: xAI Помимо xAI клиентами Oracle является множество других компаний. Как сообщил облачный оператор, в их число входят Fireworks AI, Hedra, Numenta, Soniox и даже Meta✴, у которой тоже есть собственные вычислительные мощности. Представители OCI подчёркивают, что площадка является предпочтительным местом для обучения и инференса в любых масштабах. ИИ-инфраструктура OCI обеспечивает доступ к сверхскоростной сети, «оптимизированному» хранилищу и передовым ускорителям, на которые клиенты полагаются для очередных инноваций. Кроме того, Oracle является участником проекта Stargate.

23.06.2025 [12:51], Руслан Авдеев

Бум ИИ-технологий заставляет Wistron оперативно масштабировать производство серверовСпрос на ИИ-технологии в мире по-прежнему остаётся устойчивым, а перспективы отрасли — весьма благоприятными. Президент и генеральный директор Wistron Джефф Лин (Jeff Lin) объявил, что большинство клиентов размещают долгосрочные 12-месячные заказы на оборудование компании и востребованность её продуктов останется высокой до мая 2026 года, сообщает DigiTimes. По словам директора, недавно введённый в эксплуатацию AI Smart Campus Wistron в Чжубэе (Zhubei), вероятно, уже столкнётся с дефицитом мощностей в 2026 году. Открытие кампуса, одновременно являющегося новой штаб-квартирой компании для глобальных операций, состоялось 19 июня. На мероприятии присутствовал ряд руководителей Wistron, а также представители поставщиков разных уровней. Глава NVIDIA Дженсен Хуанг (Jensen Huang), чья компания является ключевым клиентом Wistron, прислал специальное видеопоздравление. В интервью после мероприятия Джефф Лин сообщил, что новый объект будет использоваться для выпуска ИИ-серверов. Пока осуществляется монтаж оборудования, а производство начнётся после его установки. Исходя из текущих заказов ожидается, что завод выйдет на полную мощность к 2026 году. В феврале Wistron объявила, что для удовлетворения растущего спроса компания подписала договор с компанией Lien Fa Textile на аренду объекта площадью 56 тыс. м2. Он послужит дополнительной площадкой для выпуска ИИ-серверов. Аренда на 10 лет обойдётся не дороже NT$2,503 млрд ($84 млн).

Источник изображения: Wistron Хотя конкретики о параметрах масштабирования кампуса в Чжубэе немного, известно, что с использованием нового арендованного объекта Wistron рассчитывает существенно расширить производство на Тайване. В конце прошлого года уже сообщалось о намерении Wistron расширить мировое присутствие и укрепить производство ИИ-серверов. Линь признал, что загрузка производственных мощностей произошла неожиданно быстро, заставив компанию активно расширяться. Теперь у неё три производственных площадки в Синьчжу (Hsinchu), увеличиваются штаты исследователей и разработчиков, а также специалистов по продажам. Кроме того, новый головной офис в Тайбэе (Taipei) достроят к 2027 году, но действующий офис в Сичжи (Xizhi) пока сохранят из-за нехватки свободных площадей. Что касается производства ИИ-серверов за пределами Тайваня, небольшие партии выпускаются лишь в Техасе. Завод выпускает те же модели серверов, что и кампус в Чжубэе, предполагается расширить производство в 2026 году. Компания уже сообщала выделить на расширение производства в США $50 млн. На вопрос журналистов о возможности переноса выпуска вычислительной техники в США, Лин сообщил, что некоторые клиенты запросили подготовку технико-экономического обоснования. Впрочем, такие обсуждения пока находятся на ранней стадии и никакие решения ещё не приняты. При этом планирование цепочки поставок заметно усложнилось, поскольку приходится учитывать неопределённость тарифной политики США.

22.06.2025 [23:30], Руслан Авдеев

Meta✴ ведёт переговоры о покупке венчурного фонда NFDG, у которого есть собственный ИИ-кластер AndromedaMeta✴ Platforms решила обновить свои компетенции в сфере ИИ, наняв ведущих отраслевых игроков — Ната Фридмана (Nat Friedman) и Дэниэла Гросса (Daniel Gross). Также компания намерена выкупить их венчурный фонд NFDG, сообщает The Information. Марк Цукерберг (Mark Zuckerberg) сначала пытался купить ИИ-стартап Safe Superintelligence (SSI) бывшего «главным учёным» OpenAI Ильи Суцкевера (Ilya Sutskever). После отказа Цукерберг попросту собрался нанять генерального директора SSI — Гросса. Ранее тот руководил ИИ-разработками в Apple и был партнёром Y Combinator. Фридман был главой GitHub и советником Midjourney. Гросс и Фридман были соучредителями инвестиционного фонда NFDG. NFDG имеет доли в в известных ИИ-компаниях, включая SSI, Perplexity и Character.ai. Ранее компания инвестировала в Weights & Biases, которую приобрела CoreWeave. NFDG занимается не только финансированием компаний, но и предлагает программу грантов, в рамках которой стартапам предоставляется финансирование на $250 тыс., а также $250 тыс. в виде облачных кредитов Microsoft Azure. В период дефицита ИИ-ускорителей NFDG построил собственный суперкомпьютер. Кластер Andromeda изначально включал 2512 ускорителей NVIDIA H100. С тех пор он вырос до 3 200 H100 в 400 узлах и ещё 432 H100 в 54 узлах, связанных 400G-интерконнектом InfiniBand, а также 768 A100 с 200G InfiniBand. Теперь Andromeda могут арендовать и компании, которые не относятся к NFDG, за $2,4–$3 за ускоритель в час. Сейчас можно арендовать до 2 тыс. H100 и получить доступ к ним в течение нескольких часов.

Источник изображения: Amina Atar/unspalsh.com Помимо возможного найма Гросса и Фридмана, Meta✴ ведёт переговоры, конечной целью которых является выкуп значительной части активов NFDG и вывод из него партнёров за сумму более $1 млрд. При этом сделка не даст Meta✴ контроля над фондом или информации о бизнесе. Кому достанется Andromeda, не уточняется. Если сделка будет завершена, она войдёт в число более масштабных реформ в Meta✴, связанных с ИИ. Цукерберг планирует сформировать новую лабораторию по разработке «суперинтеллекта» и пересмотреть стратегию выкупа продуктов. В этом месяце Meta✴ уже подтвердила, что намерена потратить порядка $14 млрд на долю в Scale AI, специализирующейся на разметке данных для обучения ИИ.

21.06.2025 [08:41], Руслан Авдеев

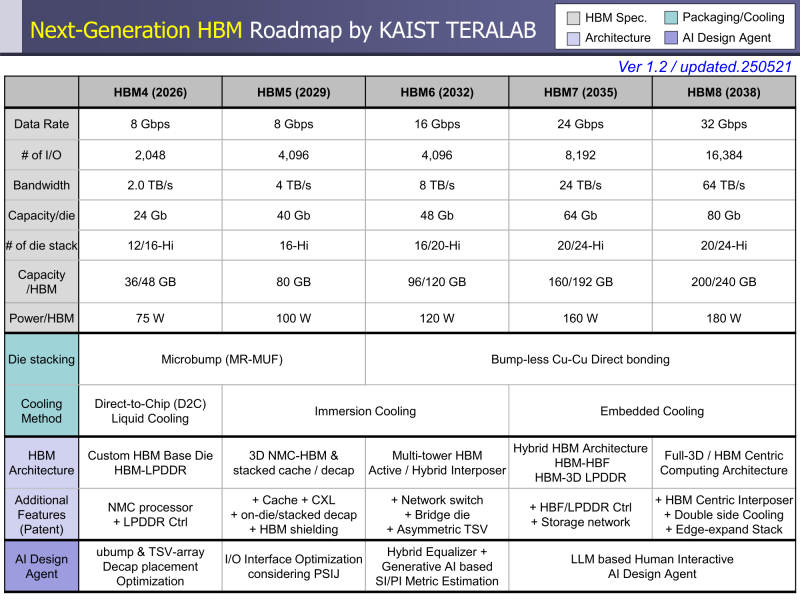

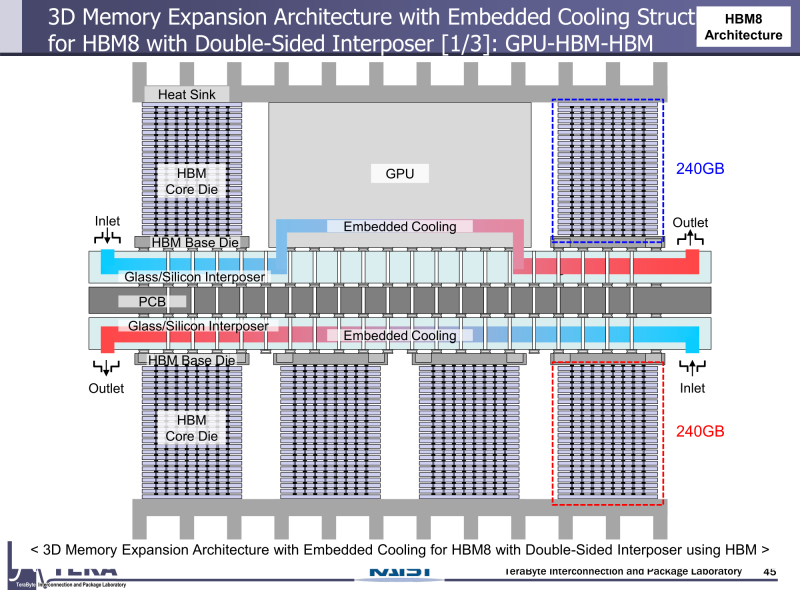

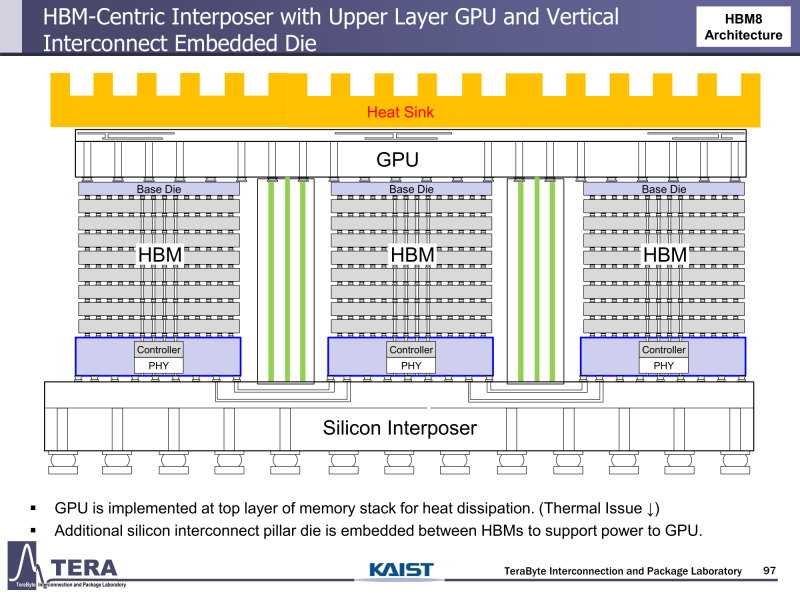

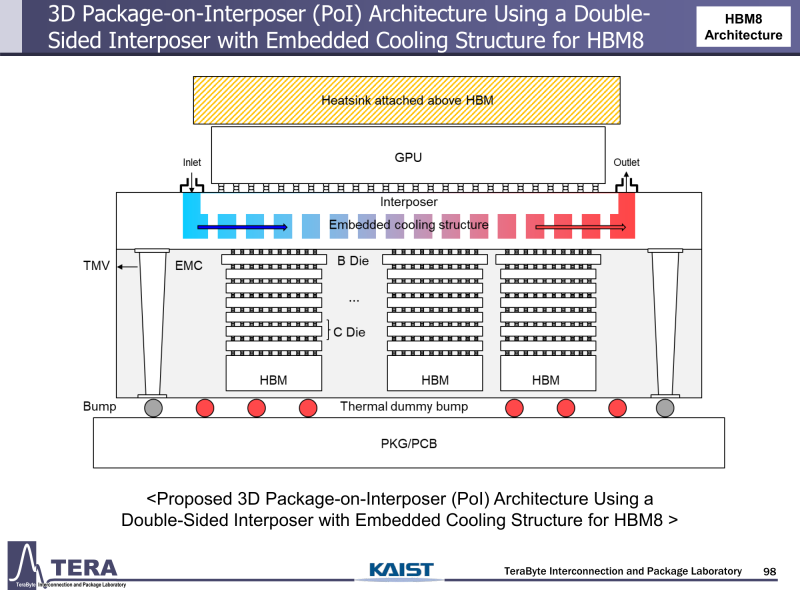

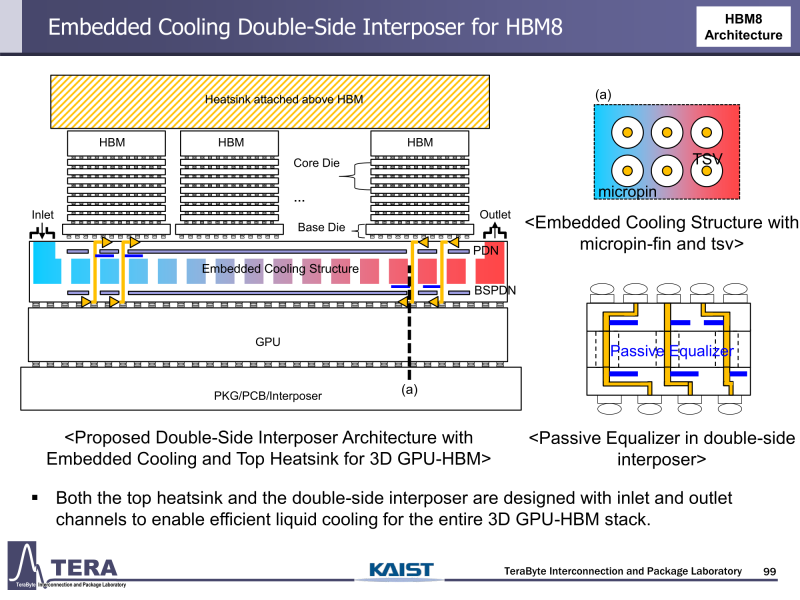

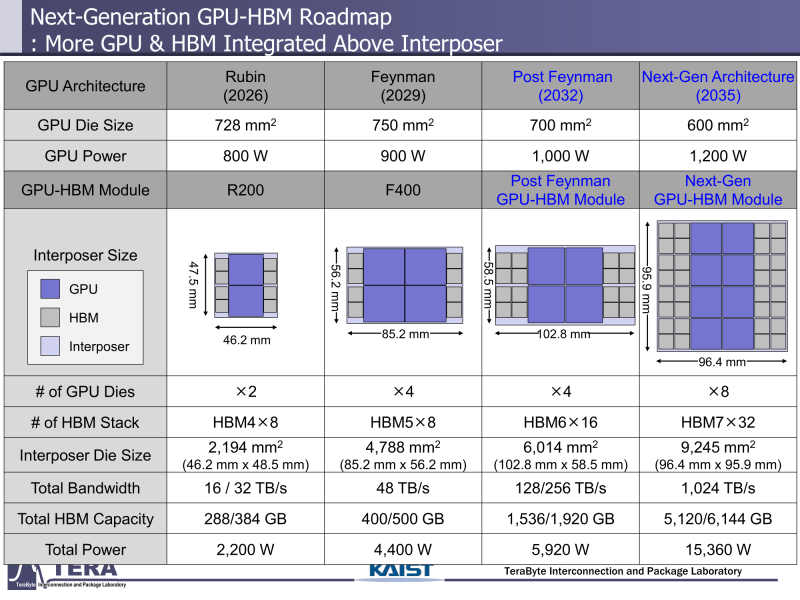

Через 10 лет ИИ-ускорители получат терабайты HBM и будут потреблять 15 кВт — это изменит подход к проектированию, питанию и охлаждению ЦОДИИ-чипы нового поколения не просто будут быстрее — они станут потреблять беспрецедентно много энергии и потребуют кардинально изменить инфраструктуру ЦОД. По данным учёных, к 2035 году энергопотребление ИИ-ускорителей может вырасти до порядка 15 кВт, из-за чего окажется под вопросом способность инфраструктуры современных ЦОД обслуживать их, сообщает Network World. Исследователи лаборатории TeraByte Interconnection and Package Laboratory (TeraLab), подведомственной Корейскому институту передовых технологий (KAIST), подсчитали, что переход к HBM4 состоится в 2026 году, а к 2038 году появится уже HBM8. Каждый этап развития обеспечит повышение производительности, но вместе с ней вырастут и требования к питанию и охлаждению. В лаборатории полагают, что мощность только одного GPU вырастет с 800 Вт до 1200 Вт к 2035 году. В сочетании с 32 стеками HBM, каждый из которых будет потреблять 180 Вт, общая мощность может увеличиться до 15 360 Вт (в таблице ниже дан расчёт для стеков HBM8, а не HBM7 — прим. ред.). Ожидается, что отдельные модули HBM8 обеспечат ёмкость до 240 Гбайт и пропускную способность памяти до 64 Тбайт/с. В рамках ускорителя можно суммарно получить порядка 5–6 Тбайт HBM с ПСП до 1 Пбайт/с. Это приведёт к изменению конструкции самого ускорителя. Ключевым элементом становятся стеки HBM — процессоры, контроллеры и ускорители будут интегрированы в единую подложку с HBM-модулями. Возможен переход к 3D-упаковке с использованием двусторонних интерпозеров-подложек или даже нескольких интерпозеров на разных «этажах» кристаллов.

Источник изображений: KAIST Кроме того, для ускорителей придётся разработать и новые системы охлаждения. К уже традиционным прямому жидкостному охлаждению (DLC) и погружным СЖО, вероятно, придётся добавить системы теплоотвода, интегрированные непосредственно в корпуса чипов. Также будут использоваться «жидкостные сквозные соединения» (F-TSVs) для отвода тепла из многослойных чипов, «бесстыковые» соединения Cu–Cu, термодатчики в кристаллах и интеллектуальные системы управления, позволяющие чипам адаптироваться к температурным изменениям. На уровне ЦОД изменится и контур охлаждения, и температурное зонирование всего объекта. В KAIST подчёркивают, что высокую плотность размещения мощностей объекты в большинстве регионов попросту не смогут поддерживать. Пока гиперскейлеры резервируют гигаватты на десятилетия вперёд, региональным коммунальным службам потребуется 7–15 лет на модернизацию ЛЭП. А где-то этого может и не произойти. Так, в Дублине (Ирландия) по-прежнему действует мораторий на строительство новых ЦОД, во Франкфурте-на-Майне похожий запрет действует до 2030 года, а в Сингапуре сегодня доступно всего лишь 7,2 МВт. Как считают эксперты, электричество превратилось из одной из статей расходов в определяющий фактор — от его доступности будет зависеть сама возможность реализации ИИ-проектов. На электричество приходится 40-60 % операционных расходов в современной инфраструктуре ИИ, облачной и локальной. Как отмечают в TechInsights, один 15-кВт ускоритель при круглосуточной работе может «съедать» энергии на $20 тыс./год, и это без учёта стоимости охлаждения. Компании уже вынуждены пересматривать стратегии развёртывания инфраструктуры, учитывая соответствие регуляторным требованиям, региональные тарифы на электроэнергию и др. Гиперскейлеры получают дополнительное преимущество благодаря более низкому PUE, доступу к возобновляемой энергии и оптимизированным схемам закупки энергии. В новой реальности производительность измеряется не только в долларах или флопсах, но и киловаттах. Более того, меняется география рынка ЦОД. Богатые энергией регионы вроде США, Скандинавии или стран Персидского залива привлекают всё больше инвестиций для строительства дата-центров, а регионы со слабыми энергосистемами рискуют превратиться в «ИИ-пустыни», в которых масштабировать мощности невозможно. Строителям ИИ-инфраструктуры теперь придётся уделять очень много внимания вопросам энергетики: расходами на электричество, наличие источников энергии, прозрачностью выбросов, близостью ЦОД к электросетям и др. Буквально на днях американский регулятор NERC, отвечающий за надзор за электросетями и сопутствующей инфраструктурой в США, заявил, что подключение к сетям ЦОД в настоящее время весьма рискованно из-за непредсказуемости ЦОД. |

|