Материалы по тегу: nvidia

|

01.12.2023 [11:50], Сергей Карасёв

В основу ИИ-суперкомпьютера NCSA DeltaAI лягут суперчипы NVIDIA GH200 Grace HopperНациональный центр суперкомпьютерных приложений (NCSA) при Университете Иллинойса в Урбане-Шампейне (США) сообщил о том, что в 2024 году в эксплуатацию будет введён вычислительный комплекс DeltaAI. Его основой послужат суперчипы NVIDIA GH200 Grace Hopper. Система DeltaAI создаётся с прицелом на ресурсоёмкие приложения ИИ. В рамках проекта NCSA в июле нынешнего года получил $10 млн от Национального научного фонда США (NSF). Инициатива DeltaAI направлена на расширение использования возможностей ИИ при реализации различных исследовательских задач. Комплекс DeltaAI станет дополнением к суперкомпьютеру Delta, который заработал в NCSA в 2022 году. Данная система занимает 199-е место в ноябрьском рейтинге TOP500 с быстродействием около 3,81 Пфлопс. Теоретическая пиковая производительность достигает 8,05 Пфлопс. В основу положены процессоры AMD EPYC 7763 Milan и интерконнект Slingshot-10. Отмечается, что DeltaAI утроит вычислительные мощности NCSA, ориентированные на задачи ИИ, и значительно расширит ресурсы, доступные в НРС-экосистеме, финансируемой NSF. Благодаря использованию передовых интерфейсов система DeltaAI будет более доступна для различных исследовательских ИИ-проектов. Производительность DeltaAI пока не раскрывается. Нужно отметить, что суперчип GH200 Grace Hopper ляжет в основу более чем 40 ИИ-суперкомпьютеров по всему миру. Это, в частности, первый европейский суперкомпьютер экзафлопсного класса Jupiter, британский комплекс Isambard-AI в Бристольском университете и пр.

30.11.2023 [13:52], Сергей Карасёв

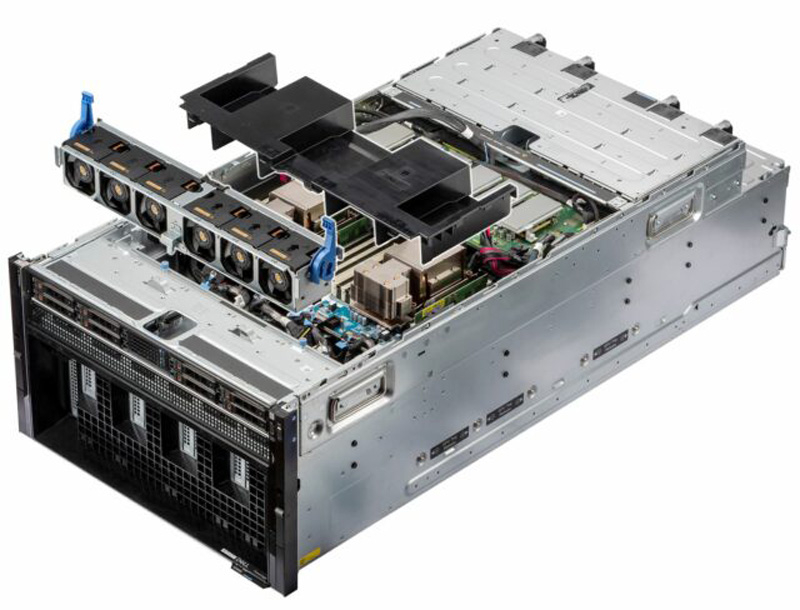

Dell построит ИИ-кластер из 10 тыс. NVIDIA H100 для компании ImbueНезависимая исследовательская ИИ-компания Imbue и Dell Technologies объявили о заключении соглашения по созданию нового высокопроизводительного вычислительного кластера на основе серверов PowerEdge для обучения базовых моделей. Проект оценивается в $150 млн. Imbue разрабатывает собственные базовые ИИ-модели, оптимизированные специально для рассуждений: они способны при необходимости запрашивать дополнительную информацию, анализировать и критиковать свои собственные результаты, а также разбивать сложную задачу на несколько более простых для повышения эффективности выполнения.

Источник изображения: Dell Imbue уже использует кластер на базе серверов Dell PowerEdge XE9680 с ускорителями NVIDIA H100. Новый проект предполагает развёртывание платформы, насчитывающей почти 10 тыс. чипов H100. Отмечается, что Imbue и Dell разработали систему, включающую в себя сравнительно небольшие кластеры, которые позволяют проводить эксперименты с ИИ-моделями на новых архитектурах. Такие узлы могут быть объединены в крупный кластер для эффективного обучения крупномасштабных базовых моделей. Основная цель Imbue заключается в создании специализированных ИИ-агентов, не требующих постоянного контроля со стороны пользователей. Они смогут выполнять самые разные задачи, включая написание программного кода, анализ сложных данных и пр. Ранее в текущем году Imbue привлекла на развитие $200 млн. Деньги поступили в том числе от NVIDIA.

29.11.2023 [23:40], Руслан Авдеев

NVIDIA NeMo Retriever позволит компаниям дополнять ИИ-модели собственными даннымиNVIDIA представила сервис NeMo Retriever, позволяет компаниям дополнять данные для чат-ботов, ИИ-помощников и похожих инструментов специализированными сведениями — для получения более точных ответов на запросы. Сервис стал частью облачного семейства инструментов NVIDIA NeMo, позволяющих создавать, настраивать и внедрять модели генеративного ИИ. RAG (Retrieval Augmented Generation), метод улучшения производительности больших языковых моделей (LLM), позволяет повысить точность и безопасность ИИ-инструментов благодаря заполнению пробелов в «знаниях» языковых моделей с помощью сведений из внешних источников. Обучение каждой модели — чрезвычайно ресурсоёмкий процесс — обычно осуществляется довольно редко, а то и вовсе единожды. При этом до следующего обновления модель не имеет доступа к полной и актуальной информации, что может привести к неточностям, ошибкам и т.н. галлюцинациям. NeMo Retriever позволяет быстро дополнить LLM свежими сведениями в виде баз данных, HTML-страниц, PDF-файлов, изображений, видео и т.п. Другими словами, базовая модель с добавлением специализированных материалов станет заметно эрудированнее и «сообразительнее». При этом данные могут храниться где угодно — как в облаках, так и на собственных серверах компаний. Технология чрезвычайно полезна, поскольку обеспечивает сотрудникам компании работу с полезными данными, закрытыми для широкой публики, при этом пользуясь всеми преимуществами ИИ. В отличие от открытых RAG-инструментов, NVIDIA, по данным самой компании, предлагает готовое к коммерческому использованию решение для доступных на рынке ИИ-моделей, уже оптимизированных для RAG и имеющих поддержку, а также регулярно получающих обновления безопасности. Другими словами, корпоративные клиенты могут брать готовые ИИ-модели и дополнять их собственными данными без отдельной ресурсоёмкой тренировки. NeMo Retriever позволит добавить соответствующие возможности универсальной облачной платформе NVIDIA AI Enterprise, предназначенной для оптимизации разработки ИИ-приложений. Регистрация разработчиков для раннего доступа к NeMo Retriever уже началась. Cadence Design Systems, Dropbox, SAP SE и ServiceNow уже работают с NVIDIA над внедрением RAG в свои внутренние ИИ-инструменты.

28.11.2023 [18:11], Руслан Авдеев

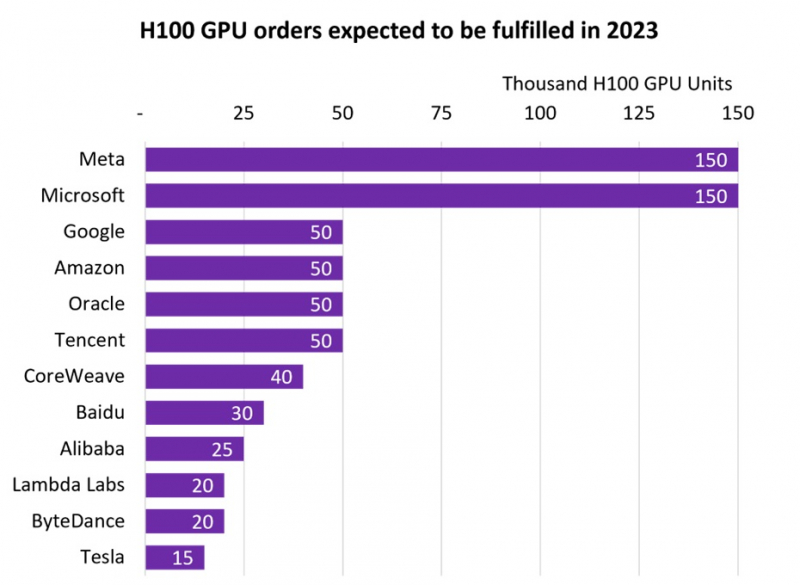

NVIDIA продала более 500 тыс. ИИ-ускорителей H100, но менее дефицитными они не сталиВ III квартале 2024 фискального года, завершившегося в октябре 2023-го, компания NVIDIA заработала впечатляющие $14,5 млрд на решениях для дата-центров. Как сообщает Tom’s Hardware, значительная часть выручки приходится на передовые ускорители H100 для ИИ и HPC-систем. Данные опубликовала компания Omdia, отслеживающая активность на рынке IT-решений. Согласно её анализу, крупнейшими покупателями ускорителей H100 стали гиперскейлеры вроде Meta✴ и Microsoft, значительно обогнавших по объёмам закупок Google, Amazon, Oracle и Tencent. Если Microsoft и Meta✴ приобрели по 150 тыс. ускорителей, то их «коллеги» по IT-рынку — по 50 тыс. При этом гиперскейлерам отдаётся очевидный приоритет при выполнении заказов. В Omdia пришли к выводу, что до конца года будет поставлено почти 650 тыс. H100. В то же время срок выполнения новых заказов на серверы на базе ускорителей компании вырос с 36 до 52 недель. Так, Dell, HPE и Lenovo не могут полностью удовлетворить свои потребности в ускорителях для своих серверов в кратчайшие сроки. В итоге год к году поставки серверов в количественном выражении рухнут на 17–20 %, однако общая выручка поднимется на 6–8 %.

Источник изображения: Omdia В 2027 году рынок серверов должен вырасти до $195,6 млрд, причём основное предпочтение будет отдаваться специализированным вариантам под конкретные задачи, оснащённым специальными сопроцессорами. Запрос на серверы с кастомными конфигурациями становится новой нормой по мере того, как заказчики осознали экономическую эффективность применения сопроцессоров и ускорителей. Пионерами в этой сфере стали компании, связанные с ИИ и медиаконтентом, но привлекательность таких решений, как ожидается, в ближайшем будущем будет оценена и в других секторах.

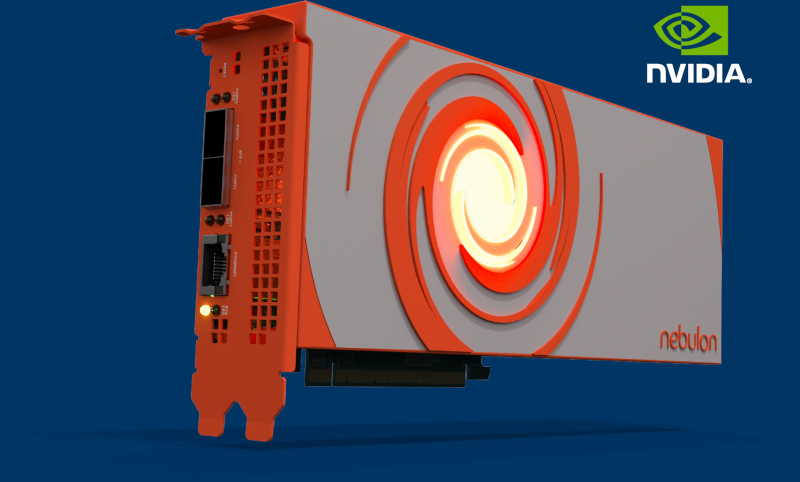

26.11.2023 [22:48], Сергей Карасёв

Nebulon представила ускорители Medusa2 на базе DPU NVIDIA BlueField-3Компания Nebulon анонсировала специализированные ускорители обработки сервисов (Services Processing Unit, SPU) — устройства серии Medusa2. Эти решения обеспечивают разгрузку, ускорение и изоляцию широкого спектра процессов в работе сети, СХД и подсистемы безопасности, включая обнаружение программ-вымогателей. В основу Medusa2 лёг DPU BlueField-3 разработки NVIDIA с шестнадцатью ядрами Arm Cortex-A78, тогда как первое поколение укорителей, изначально называвшихся Storage Processing Unit, было выполнено на собственной аппаратной платформе. Nebulon Medusa2 представляют собой карты расширения с интерфейсом PCIe 5.0 (х8). Они оснащены 48 Гбайт памяти DDR5 с пропускной способностью до 80 Гбайт/с. SPU подключается напрямую к внутренним накопителям NVMe (а также SAS и SATA). Ускорители оснащены двумя сетевыми портами 10/25/50/100GbE и портом управления 1GbE. SPU создает на сервере безопасную зону, отделённую от ОС и приложений — область Nebulon Secure Enclave. При этом платформа nebOS разгружает ресурсы, беря на себя выполнение таких задач, как дедупликация и сжатие данных, шифрование (AES), моментальные снимки, зеркалирование и пр. Обеспечена интеграция со средами VMware vSphere, Microsoft Server/Hyper-V и Linux/KVM. Medusa2 SPU не зависит от ОС и приложений и не требует установки каких-либо дополнительных драйверов или программных агентов. Предусмотрен криптографический сопроцессор со сверхзащищенным аппаратным хранилищем ключей и криптографическими контрмерами, которые усиливают защиту от любых потенциальных угроз, связанных с ПО. Например, обнаружение программ-вымогателей осуществляется менее чем за 2,5 мин., а на восстановление после атак таких зловредов требуется менее 4 мин. Реализованы средства безопасной загрузки. В целом, компания сравнивает свои SPU с AWS Nitro. Также анонсирован компактный ускоритель Medusa2i для edge-серверов. Он, как и старший собрат, использует DPU BlueField-3, но количество ядер Cortex-A78 уменьшено до 8, а объём памяти DDR5 — до 24 Гбайт. Возможна установка четырёх SSD формата M.2 вместимостью до 32 Тбайт каждый. Утверждается, что благодаря Medusa2 количество рабочих нагрузок на один сервер может быть увеличено на 33 %, что снижает эксплуатационные расходы и затраты на приобретение лицензий на ПО. При этом требования к мощности и площади дата-центра снижаются на 25 %. Интерес к ускорителям проявили Dell, HPE, Lenovo и Supermicro.

22.11.2023 [11:18], Сергей Карасёв

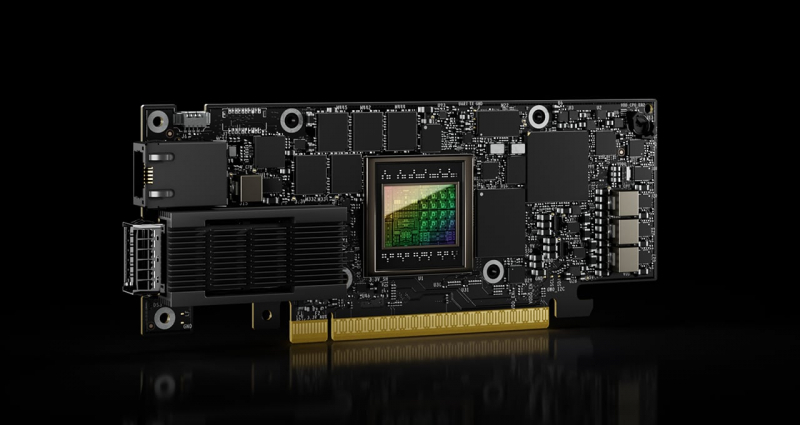

NVIDIA представила сетевой ускоритель SuperNIC для гипермасштабируемых ИИ-нагрузокКомпания NVIDIA анонсировала аппаратное решение SuperNIC — это сетевой ускоритель нового типа, предназначенный для масштабных рабочих нагрузок ИИ в системах на базе Ethernet. Устройство обеспечивает скорость передачи данных до 400 Гбит/с с использованием RDMA (RoCE). Новинка выполнена на основе DPU BlueField-3: это часть сетевой 400G/800G-платформы Spectrum-X, которая предусматривает использование коммутаторов на базе ASIC NVIDIA Spectrum-4 (51,2 Тбит/с). Отмечается, что сообща BlueField-3 SuperNIC и Spectrum-4 составляют основу вычислительной системы, специально разработанной для ускорения ИИ-нагрузок. При этом платформа Spectrum-X обеспечивает высокую эффективность сети, превосходя по производительности традиционные среды Ethernet. По заявления NVIDIA, DPU предоставляет множество расширенных функций, таких как высокая пропускная способность, подключение с небольшой задержкой и пр. Среди ключевых особенностей SuperNIC называются: высокоскоростное переупорядочение пакетов; расширенный контроль перегрузок с использованием данных в реальном времени и специализированных сетевых алгоритмов; возможность программирования ввода-вывода (I/O); энергоэффективный низкопрофильный дизайн; полная оптимизация для ИИ (включая вычисления, сети, хранилище, системное ПО, коммуникационные библиотеки). В одной системе могут быть задействованы до восьми SuperNIC, что позволяет добиться соотношения 1:1 с GPU. А это даёт возможность максимизировать производительность при выполнении сложных задач ИИ.

22.11.2023 [10:39], Сергей Карасёв

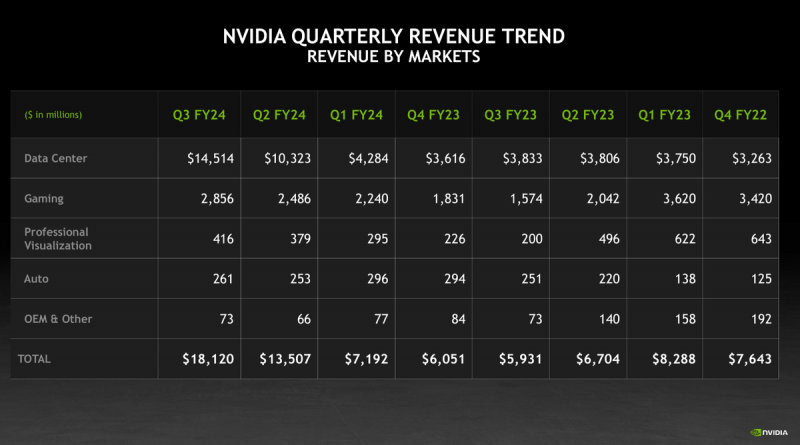

Выручка NVIDIA от ускорителей, сетевых и ИИ-решений за год выросла на 279 % до рекордных $14,51 млрдКомпания NVIDIA отчиталась о результатах работы в III четверти 2024 финансового года, которая была закрыта 29 октября. Выручка за трёхмесячный период достигла $18,12 млрд, что на 206 % больше прошлогоднего результата, равного $5,93 млрд. В квартальном исчислении рост зафиксирован на отметке 34 %. Чистая прибыль NVIDIA составила $9,24 млрд против $680 млн годом ранее. Это соответствует росту на 1259 % год к году. Прибыль в пересчёте на одну ценную бумагу увеличилась с $0,27 до $3,71. Стремительный рост показателей объясняется прежде всего высоким спросом на решения для дата-центров. Выручка в соответствующем подразделении в III квартале 2024 финансового года достигла исторического максимума — $14,51 млрд. Это на 279 % больше по сравнению с прошлогодним результатом и на 41 % больше по отношению ко II четверти текущего финансового года. В сегменте профессиональной визуализации квартальная выручка поднялась на 108 % год к году, составив приблизительно $416 млн. Решения для автомобильной промышленности принесли $261 млн, что на 4 % больше по сравнению с III кварталом прошлого финансового года. Среди ключевых событий недавнего времени NVIDIA выделяет анонс ускорителей H200 с памятью HBM3e, выход суперчипов GH200 Grace Hopper, которые станут основой более 40 ИИ-суперкомпьютеров, появление передовой Ethernet-платформы Spectrum-X и пр.

22.11.2023 [01:23], Владимир Мироненко

NVIDIA в рекордные сроки завершила строительство первой фазы израильского ИИ-суперкомпьютера Israel-1Компания NVIDIA объявила во вторник о досрочном завершении сборки первой фазы ИИ-суперкомпьютера Israel-1, анонсированного летом этого года. Сообщается, что суперкомпьютер уже доступен для использования исследовательскими и опытно-конструкторскими группами компании, а также её отдельными партнёрами. После завершения строительства Israel-1 станет самым мощным ИИ-суперкомпьютером в Израиле. По данным NVIDIA, первая фаза компьютерной системы была построена менее чем за 20 недель или почти на два месяца раньше намеченных сроков — это намного быстрее, чем требуется для создания традиционных суперкомпьютеров, которые могут создаваться и несколько лет. Первая фаза Israel-1, обеспечивающая производительность при обработке ИИ-нагрузок в 4 Эфлопс (FP8) и при научных вычислениях в 65 Пфлопс (FP64), послужит испытательным стендом для разработанной в Израиле сетевой Ethernet-платформы NVIDIA/Mellanox Spectrum-X, предназначенной для повышения производительности и эффективности облачных ИИ-сервисов. В конечном итоге Israel-1 будет содержать 256 систем NVIDIA HGX H100, включающих в общей сложности 2048 ускорителей NVIDIA H100 с более чем 34 млн ядер CUDA и 1 млн тензорных ядер четвёртого поколения, 2560 единиц DPU BlueField-3 и 80 коммутаторов Spectrum-4. Первая фаза суперкомпьютера включает 128 серверов Dell PowerEdge XE9680 на базе платформы NVIDIA HGX H100, 1280 единиц DPU BlueField-3 и более 40 коммутаторов Spectrum-4.

21.11.2023 [09:51], Сергей Карасёв

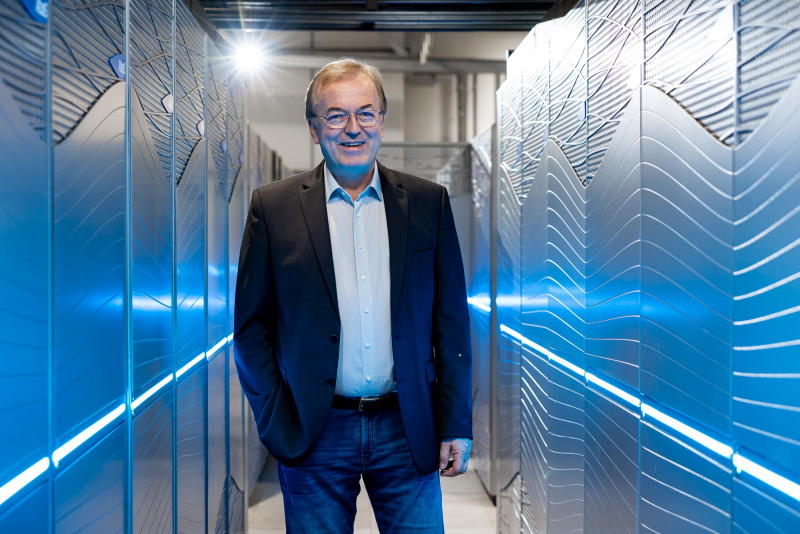

Европейский экзафлопсный суперкомпьютер Jupiter получит универсальный блок cCuster на европейских Arm-процессорах SiPearl RheaВ 2024 году в Юлихском исследовательском центре (FZJ) в Германии заработает вычислительный комплекс Jupiter — первый европейский суперкомпьютер экзафлопсного класса. Профессор Томас Липперт (Thomas Lippert; на фото ниже) из FZJ рассказал об особенностях конфигурации этой системы. Ранее сообщалось, что в состав Jupiter будет включён высокомасштабируемый блок ускорителей (Booster). Речь идёт об использовании платформы Eviden BullSequana XH3000 с прямым жидкостным охлаждением, а в состав каждого узла войдут модули NVIDIA Quad GH200. Общее количество суперчипов GH200 Grace Hopper составит почти 24 тыс. Блок Booster предназначен для решения особо ресурсоёмких задач. Как сообщил господин Липперт, второй составляющей НРС-комплекса станет универсальный блок cCuster, который сможет поддерживать приложения всех типов: это, в частности, операции с высокой интенсивностью использования данных. Оба блока можно будет использовать по отдельности или вместе, что позволит добиться максимальной эффективности при реализации различных проектов. В основе cCuster — энергоэффективные высокопроизводительные Arm-процессоры SiPearl Rhea. Эти изделия обеспечивают высокое соотношение производительности к пропускной способности — 0,5 байт/флоп. Поэтому процессоры хорошо подходят для сложных приложений с интенсивным использованием данных. Все вычислительные узлы Jupiter подключены к высокопроизводительной сети NVIDIA Mellanox InfiniBand. Быстродействие на операциях обучения ИИ составит до 93 Эфлопс, а FP64-производительность «незначительно превысит 1 Эфлопс». Общая стоимость проекта составит €273 млн, включая доставку, установку и обслуживание Jupiter.

21.11.2023 [04:04], Владимир Мироненко

Scaleway предложила экономичные ИИ-инстансы на базе Ampere Altra и расширила сотрудничество с NVIDIAФранцузский провайдер инфраструктуры облачных вычислений Scaleway SAS объявил о доступности так называемых оптимизированных по стоимости (Cost-Optimized) инстансов на базе архитектуры Arm (COP-ARM), предназначенных для обработки нагрузок ИИ и HPC. Инстансы COP-ARM используют процессоры Ampere Altra. Компания утверждает, что процессоры Altra могут стать более доступным вариантом для клиентов, желающих запускать обучение и инференс больших языковых моделей (LLM). По словам компании, они специально созданы для обработки рабочих нагрузок ИИ в реальном времени, таких как чат-боты, анализ данных и анализ видеоконтента. Директор по продуктам Ampere Джефф Виттич (Jeff Wittich) заявил, что CPU идеально подходят для инференса. «В целом модели ИИ станут меньше и более ориентированными на конкретные задачи», — прогнозирует Виттич. Именно здесь может потребоваться энергоэффективность инстансов Scaleway. Он заявил, что запуск модели OpenAI Whisper на 128-ядерном процессоре Altra Max потребляет в 3,6 раза меньше энергии, чем при использовании ускорителя NVIDIA A10. Scaleway также объявила о сотрудничестве с NVIDIA с целью предоставить европейским стартапам доступ к ускорителям NVIDIA, программному обеспечению NVIDIA AI Enterprise и сервисам для ускорения разработки больших языковых моделей (LLM) и приложений генеративного ИИ. В рамках бесплатной программы NVIDIA Inception, предоставляющей техническое руководство, обучение и скидки, стартапы полагаются на возможности суверенных облачных вычислений инфраструктуры Scaleway. В частности, новый суперкомпьютер Scaleway Nabuchodonosor на базе NVIDIA DGX SuperPOD со 127 узлами DGX H100 поможет стартапам во Франции и по всей Европе масштабировать рабочие нагрузки ИИ. Региональные участники Inception также получат доступ к ПО NVIDIA AI Enterprise на Scaleway Marketplace, включая платформу NVIDIA NeMo и предварительно обученные LLM, NVIDIA RAPIDS, а также NVIDIA Triton и NVIDIA TensorRT-LLM. |

|