Материалы по тегу: mi300

|

20.04.2024 [20:50], Сергей Карасёв

ИИ-облако TensorWave получит 20 тыс. ускорителей AMD Instinct MI300XВ то время как многие операторы облачных платформ и дата-центров закупают ускорители NVIDIA H100 для задач ИИ и НРС, стартап TensorWave, по сообщению ресурса The Register, сделал выбор в пользу решений AMD. Ожидается, что такой подход позволит ускорить развёртывание сервисов и снизить стоимость услуг для заказчиков. Системы класса bare metal будут предлагаться для аренды на определённый период времени по цене от $1/ч/GPU. TensorWave приступила к созданию облачной ИИ-системы на базе ускорителей Instinct MI300X. К концу 2024 года TensorWave планирует установить около 20 тыс. ускорителей MI300X на двух объектах, объединённых RoCE-фабрикой. В 2025-м, как ожидается, будут введены в эксплуатацию дополнительные мощности с СЖО. В дальнейшем планируется внедрение технологии GigaIO FabreX на базе PCIe 5.0, позволяющей объединить до 5750 ускорителей в одном домене с более чем 1 Пбайт памяти НВМ.

Источник изображения: AMD TensorWave использует системы с восемью ускорителями MI300X в одном узле. В одной стойке будут располагаться четыре таких узла. Упомянуто применение системы охлаждения с теплообменниками на задней двери. Судя по фотографиям, стартап использует 8U-серверы Supermicro AS-8125GS-TNMR2. Расчётная мощность составляет приблизительно 40 кВт на стойку. В долгосрочной перспективе TensorWave нацелена на внедрение технологии прямого жидкостного охлаждения чипов, что позволит повысить мощность и плотность размещения оборудования. Соучредитель TensorWave Джефф Татарчук (Jeff Tatarchuk) отмечает, что применение MI300X обеспечивает ряд преимуществ перед изделиями NVIDIA. Это отсутствие столь серьёзного дефицита, более высокая производительность и меньшая стоимость аренды для потребителей облачных ИИ-услуг. Однако, по словам Татарчука, препятствием при коммерциализации сервисов на базе ускорителей AMD может стать то, что потенциальные клиенты выражают неуверенность по поводу возможностей MI300X в сравнении с H100.

30.03.2024 [15:06], Сергей Карасёв

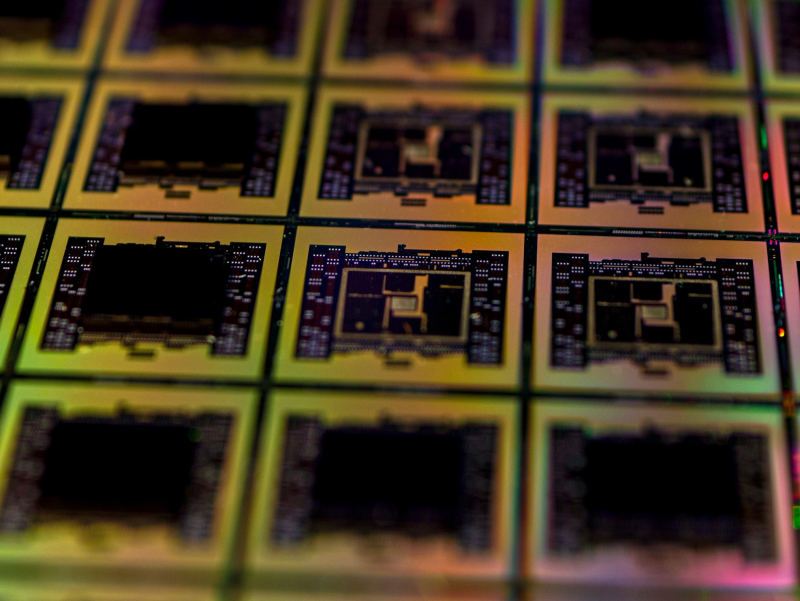

AMD готовит ускоритель Instinct MI388XКомпания AMD, по сообщению ресурса VideoCardz, направила в Комиссию по ценным бумагам и биржам США (SEC) документацию, в которой говорится о подготовке нового продукта семейства Instinct — изделия с обозначением MI388X. Судя по имеющейся информации, это производительное решение, не предназначенное для поставок на китайский рынок. Технические характеристики новинки не раскрываются. Известно лишь, что в основу Instinct MI388X положена архитектура CDNA3. Предусмотрено использование 5-нм и 6-нм техпроцессов TSMC.

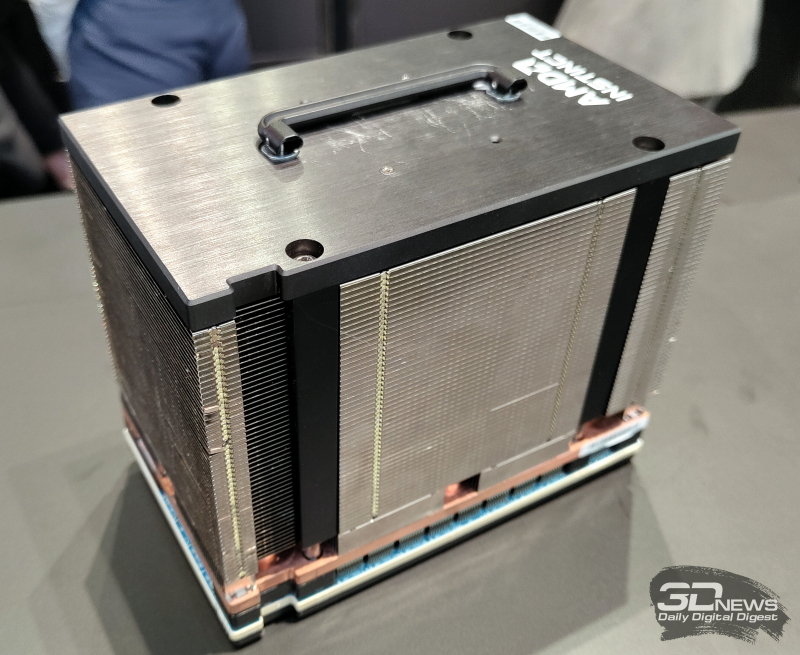

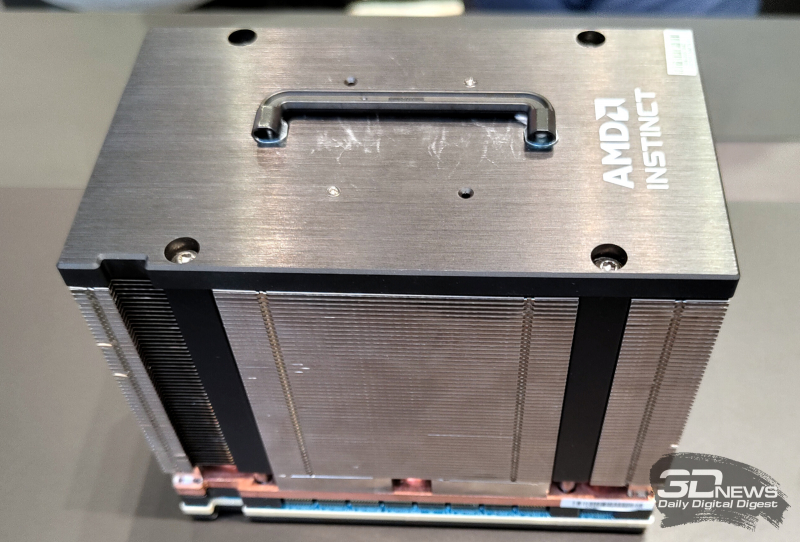

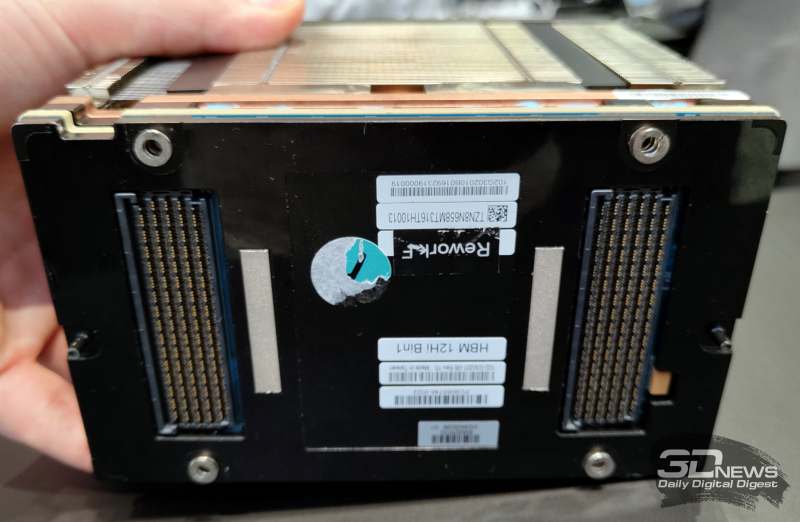

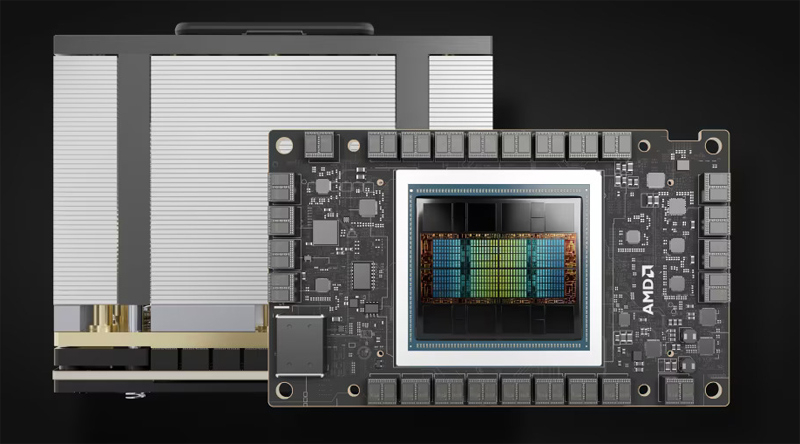

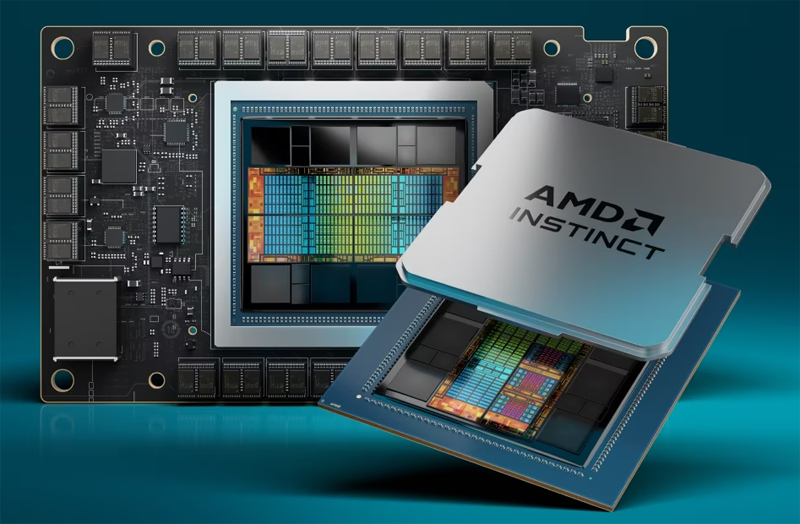

Источник изображения: AMD Судя по наличию индекса «Х» в обозначении, новое изделие представляет собой самостоятельный ИИ-ускоритель (как и Instinct MI300X), а не гибридное решение, как в случае MI300A, которое наделено x86-ядрами Zen4. Высказываются предположения, что новинка могла проектироваться под нужды какого-либо конкретного заказчика или для определённого рыночного сегмента. Более того, есть вероятность, что изначально ускоритель Instinct MI388X создавался именно для КНР, но AMD не получила экспортное разрешение на его поставки на китайский рынок. Нужно отметить, что ранее AMD была вынуждена отказаться от поставок в Китай ускорителей Instinct MI309: они оказались слишком мощными, а поэтому попали под американские санкции. Решения MI300X и MI300A также запрещены для отгрузок китайским заказчикам. Между тем в феврале был продемонстрирован вариант Instinct MI300X, оснащённый 12-слойной памятью HBM3E. Суммарный объём такой памяти у модифицированного ускорителя может достигать 288 Гбайт против 192 Гбайт у стандартной версии MI300X.

05.03.2024 [21:32], Руслан Авдеев

Ускорители AMD Instinct MI309 оказались недостаточно слабы, чтобы США позволили продавать их КитаюПо неподтверждённым пока данным, компания AMD провалила попытку снизить производительность своих ИИ-ускорителей таким образом, чтобы те соответствовали экспортным ограничениям США. Bloomberg сообщает, что по этой причине Вашингтон пока запретил поставлять их в Китай. Это довольно распространённая тактика среди производителей чипов — Китай является одним из крупнейших рынков полупроводников в мире и отказываться от него по политическим соображениям компании не хотели бы, поскольку должны учитывать интересы акционеров, рассчитывающих на максимальную прибыль. Возможно, рынок заметно вырастет в ближайшее время, поскольку Пекин огласил планы сделать ИИ сердцем экономического развития. Другими словами, выпуск продуктов для Китая — очень выгодный бизнес. В Bloomberg предполагают, что в AMD посчитали новые ускорители, известные как MI309, пригодными для продажи в Поднебесную, но Министерство торговли США, ответственное за выдачу экспортных лицензий, посчитало чипы чересчур производительными. Речь идёт об урезанной версии MI300, при этом ускорители MI210 в Китай поставляются. Упрощённые ускорители A800 и H800 уже выпускала NVIDIA, но после ужесточения запретов в октябре 2023 года она разработала новые варианты (H20, L20 и L2) с ещё более скромной производительностью. Пока же её продажи в КНР упали. Тем временем китайские IT-гиганты накопили огромные запасы ускорителей впрок и компании вроде Baidu и Tencent сообщают, что складских остатков хватит на год-два бесперебойного обеспечения ИИ-проектов. Примечательно, что Baidu говорит о своих разработках в контексте их сравнения с мировыми, а не местными конкурентами. При этом Baidu закупила и местные ИИ-ускорители Huawei Ascend 910B. Хотя китайские лидеры полупроводниковой отрасли хотя и отстают от AMD, Intel и NVIDIA, сбрасывать со счетов их не стоит. При этом некоторые китайские производители чипов занимаются созданием совместимых с CUDA решений. Это косвенно свидетельствует о том, что просто качественного «железо» для успеха мало — необходима совершенная программная среда для его эксплуатации. Это пока является слабым местом китайских разработок, отмечает The Register.

28.02.2024 [15:31], Сергей Карасёв

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

27.02.2024 [21:44], Сергей Карасёв

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных.

21.12.2023 [14:51], Сергей Карасёв

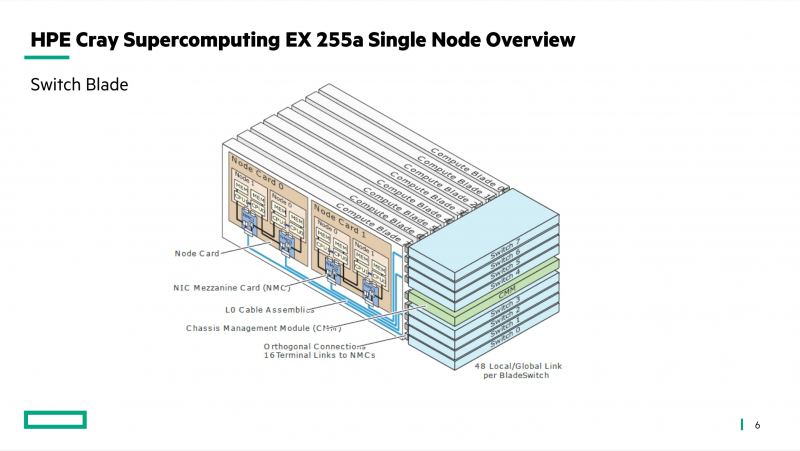

Германия построит суперкомпьютер Herder экзафлопсного уровняЦентр высокопроизводительных вычислений HLRS в Штутгарте (Германия) объявил о заключении соглашения с компанией HPE по созданию двух новых суперкомпьютеров — систем Hunter и Herder. Они, как утверждается, предоставят «инфраструктуру мирового класса» для моделирования, ИИ, анализа данных и других ресурсоёмких задач в различных областях. Hunter заменит нынешний флагманский суперкомпьютер HLRS под названием Hawk. В основу Hunter ляжет платформа HPE Cray EX4000: в общей сложности планируется задействовать 136 таких узлов, каждый из которых будет оснащён четырьмя адаптерами HPE Slingshot. Архитектура Hunter предусматривает применение СХД нового поколения Cray ClusterStor, специально разработанной с учётом жёстких требований к вводу/выводу. Кроме того, будет задействована среда HPE Cray Programming Environment, которая предоставляет полный набор инструментов для разработки, портирования, отладки и настройки приложений.

Источник изображения: HLRS Суперкомпьютер Hunter получит ускорители AMD Instinct MI300A. Утверждается, что это позволит сократить энергопотребление по сравнению с Hawk примерно на 80 % при пиковой производительности. Быстродействие Hunter составит около 39 Пфлопс против 26 Пфлопс у Hawk. Систему планируется ввести в эксплуатацию в 2025 году. Суперкомпьютер экзафлопсного класса Herder заработает не ранее 2027 года. Архитектура предусматривает применение ускорителей, но окончательная конфигурация комплекса будет определена только к концу 2025-го. Общая стоимость Hunter и Herder оценивается в €115 млн. Финансирование будет осуществляться через Центр суперкомпьютеров Гаусса (GCS), альянс трёх национальных суперкомпьютерных центров Германии. Половину средств предоставит Федеральное министерство образования и исследований Германии (BMBF), оставшуюся часть — Министерство науки, исследований и искусств земли Баден-Вюртемберг. Нужно отметить, что в 2024 году в Юлихском исследовательском центре (FZJ) в Германии заработает вычислительный комплекс Jupiter — первый европейский суперкомпьютер экзафлопсного класса. Кроме того, систему такого уровня намерена создать Великобритания.

09.12.2023 [23:16], Сергей Карасёв

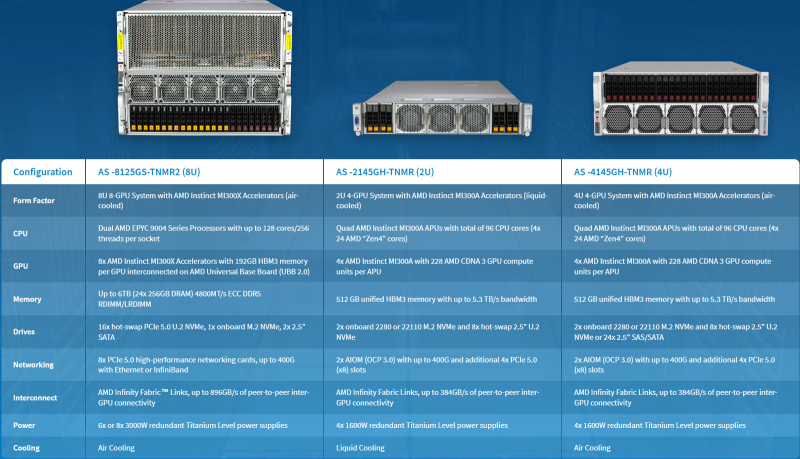

Supermicro представила ИИ-серверы с ускорителями AMD Instinct MI300 и СЖОКомпания Supermicro анонсировала серверы AS-8125GS-TNMR2, AS-4145GH-TNMR и AS-2145GH-TNMR, предназначенные для задач НРС и ИИ, в том числе для обучения больших языковых моделей (LLM). Новинки выполнены на аппаратной платформе AMD и оборудованы ускорителями серии Instinct MI300. Модель AS-8125GS-TNMR2 соответствует типоразмеру 8U. Она оснащена двумя процессорами AMD EPYC Genoa с показателем TDP до 400 Вт и восемью ускорителями Instinct MI300X со 192 Гбайт памяти HBM3. Объём оперативной памяти DDR5-4800 RDIMM/LRDIMM может достигать 6 Тбайт (24 слота). Доступны 18 отсеков для SFF-накопителей NVMe/SATA и коннектор M.2 NVMe. Предусмотрены восемь слотов для карт PCIe 5.0 x16 LP и два слота для карт PCIe 5.0 x16 FHFL. Задействована система воздушного охлаждения. Питание обеспечивают шесть или восемь блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium.

Источник изображений: Supermicro Серверы AS-4145GH-TNMR и AS-2145GH-TNMR выполнены в форм-факторе 4U и 2U соответственно. Первый наделён системой воздушного охлаждения, второй — жидкостного. При этом оба получили четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Устройство AS-4145GH-TNMR располагает 24 отсеками для накопителей SFF NVMe/SAS/SATA с возможностью горячей замены и двумя разъёмами для модулей M.2 NVMe или SATA. Есть шесть слотов PCIe 5.0 x16 FHHL и два разъёма PCIe 5.0 x16 AIOM. Задействованы четыре блока питания на 1600 Вт с сертификатом 80 Plus Titanium. Сервер AS-2145GH-TNMR получил восемь посадочных мест для накопителей SFF NVMe/SAS/SATA и два разъёма для SSD M.2 NVMe или SATA. Доступны четыре слота PCIe 5.0 x16 FHHL и два слота PCIe 5.0 x16 AIOM. За питание отвечают четыре блока на 1600 Вт с сертификатом 80 Plus Titanium.

08.12.2023 [16:31], Сергей Карасёв

Gigabyte представила серверы с ускорителями AMD Instinct MI300 для задач ИИ и HPCКомпания Giga Computing (Gigabyte) анонсировала серверы G383-R80, G593-ZX1 и G593-ZX2 на аппаратной платформе AMD, предназначенные для решения ресурсоёмких задач: это могут быть приложения ИИ и HPC. Все новинки оборудованы ускорителями серии Instinct MI300. Модель G383-R80, выполненная в формате 3U, несёт на борту четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Во фронтальной части расположены 8 отсеков для SFF-накопителей NVMe SSD.

Источник изображений: Gigabyte Могут быть задействованы до 12 слотов расширения для карт FHFL с интерфейсом PCIe 5.0. Есть слот для SSD стандарта М.2 2280/22110 с интерфейсом PCIe 5.0 x4, два сетевых порта 10GbE (Broadcom BCM57416), выделенный порт управления 1GbE, контроллер Aspeed AST2600, два порта USB 3.2 Gen1 и разъём D-Sub. Питание обеспечивают четыре блока мощностью 2200 Вт каждый с сертификатом 80 Plus Titanium. Серверы G593-ZX1 и G593-ZX2, в свою очередь, имеют типоразмер 5U. Они комплектуются двумя процессорами AMD EPYC Genoa с показателем TDP до 300 Вт и восемью ускорителями Instinct MI300X OAM со 192 Гбайт памяти HBM3. Для модулей ОЗУ стандарта DDR5-4800 доступны 24 разъёма. Спереди находятся восемь отсеков для SFF-накопителей NVMe SSD.  Эти серверы оборудованы двумя слотами для SSD формата М.2 2280/22110 с интерфейсом PCIe 3.0 (по одному х1 и х4), двумя портами 10GbE (Intel X710-AT2), выделенным сетевым портом управления 1GbE, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 и разъёмом D-Sub. Предусмотрены четыре слота PCIe 5.0 x16 для карт FHHL и восемь слотов PCIe 5.0 x16 для LP-карт. Версия G593-ZX1 получила восемь root-портов, модель G593-ZX2 — четыре. Установлены шесть блоков питания на 3000 Вт с сертификатом 80 Plus Titanium.

07.12.2023 [23:02], Владимир Мироненко

Dell выпустит серверы с ИИ-ускорителями AMD Instinct MI300XDell и AMD объявили о расширении портфеля решений Dell Generative AI Solutions с целью ускорения обработки сложных рабочих нагрузок и предоставления компаниям больше возможностей для развёртывания приложений генеративного ИИ. Новые решения включают серверы Dell PowerEdge XE9680 с ускорителями AMD Instinct MI300X. Сервер будет оснащён восемью ускорителями, что даст общую ёмкость HBM3 1,5 Тбайт и FP16-производительность более 10 Пфлопс. Использование PowerEdge XE9680 с MI300X позволит компаниям сократить занимаемую площадь в ЦОД, снизить совокупную стоимость владения и получить конкурентное преимущество, говорит Dell. Для масштабирования нагрузок компания предлагет Ethernet-фабрику с 400G-коммутаторами PowerSwitch Z9664F-ON. PowerEdge XE9680 поставляется с приложением Dell OpenManage Enterprise для администрирования и мониторинга систем. Также сообщается, что сервер обеспечивает высокую защищённость данных благодаря интегрированной киберзащите и использованию концепции Zero Trust.

Источник изображения: Dell Dell также пополнила платформу Dell Generative AI Solutions решением Dell Validated Design for Generative AI with AMD, которое упрощает надёжное развёртывание генеративного ИИ. Его выход ожидается в следующем году с ИИ-платформами на базе AMD ROCm и открытых больших языковых моделей (LLM). Dell PowerEdge XE9680 с ускорителями AMD Instinct MI300X и Dell Validated Design for Generative AI with AMD появится на рынке в I половине 2024 года.

07.12.2023 [16:54], Сергей Карасёв

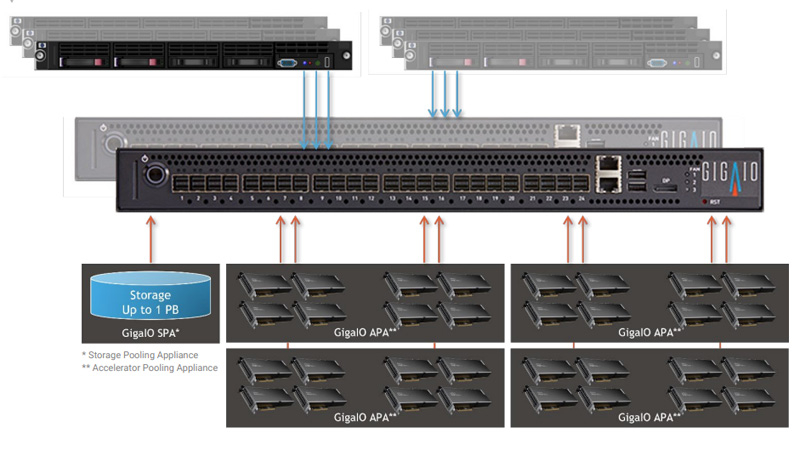

GigaIO создаст уникальное ИИ-облако с тысячами ускорителей AMD Instinct MI300XКомпания GigaIO объявила о заключении соглашения по созданию инфраструктуры для специализированного ИИ-облака TensorNODE, которое создаётся провайдером TensorWave. В составе платформы будут применяться ускорители AMD Instinct MI300X, оснащённые 192 Гбайт памяти HBM3. Основой TensorNODE послужат мини-кластеры SuperNODE, дебютировавшие летом уходящего года. Особенность этого решения заключается в том, что оно позволяет связать воедино 32 и даже 64 ускорителя посредством распределённого интерконнекта на базе PCI Express. TensorWave будет использовать FabreX для формирования пулов памяти петабайтного масштаба. На первом этапе в начале 2024 года платформа TensorNODE объединит до 5760 ускорителей Instinct MI300X в одном домене. Таким образом, при решении сложных задач можно будет получить доступ более чем к 1 Пбайт памяти с любого узла. Это, как отмечается, позволит обрабатывать даже самые ресурсоёмкие нагрузки в рекордно короткие сроки.

Источник изображения: GigaIO В течение следующего года планируется развернуть несколько систем TensorNODE. Архитектура GigaIO обеспечит улучшенную гибкость по сравнению с традиционными решениями: инфраструктуру можно будет оптимизировать «на лету» для удовлетворения как текущих, так и будущих потребностей в области ИИ и больших языковых моделей (LLM). Отмечается, что TensorNODE полностью базируется на ключевых компонентах AMD. Помимо ускорителей Instinct MI300X, это процессоры EPYC Genoa. Облако TensorWave обеспечит снижение энергозатрат и общей стоимости владения благодаря исключению из конфигурации избыточных серверов и связанного с ними сетевого оборудования. |

|