Материалы по тегу: gb200

|

08.05.2025 [19:22], Сергей Карасёв

Cadence представила суперкомпьютер Millennium M2000 на базе NVIDIA BlackwellКомпания Cadence анонсировала суперкомпьютер Millennium M2000, спроектированный для выполнения сложного моделирования с использованием ИИ. Новая НРС-система предназначена для ускорения проектирования микрочипов, разработки лекарственных препаратов следующего поколения и пр. Суперкомпьютер построен на платформе NVIDIA HGX B200. Кроме того, задействованы карты NVIDIA RTX Pro 6000 Blackwell Server Edition, оснащённые 96 Гбайт памяти GDDR7. Применены библиотеки NVIDIA CUDA-X и специализированное ПО для решения ресурсоёмких задач. Утверждается, что Millennium M2000 обеспечивает до 80 раз более высокую производительность по сравнению с системами на базе CPU в области автоматизации проектирования электроники (EDA), создания и анализа систем (SDA) и разработки медикаментов. При этом глубоко оптимизированный программно-аппаратный стек помогает существенно сократить общее энергопотребление. В качестве примера приводится моделирование подсистемы питания на уровне полупроводниковых чипов. В случае вычислительных комплексов на основе сотен традиционных CPU на выполнение такой задачи может потребоваться около двух недель. Суперкомпьютер Millennium M2000 позволит получить результат менее чем за один день. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил, что компания планирует приобрести десять суперкомпьютерных систем Millennium на базе GB200 NVL72 для ускорения проектирования собственных продуктов. Сторонние заказчики смогут получить доступ к Millennium M2000 через облако или купить устройство для установки в собственном дата-центре. Базовая конфигурация включает около 32 ускорителей и стоит $2 млн, но это не финальная цена.

29.04.2025 [14:44], Сергей Карасёв

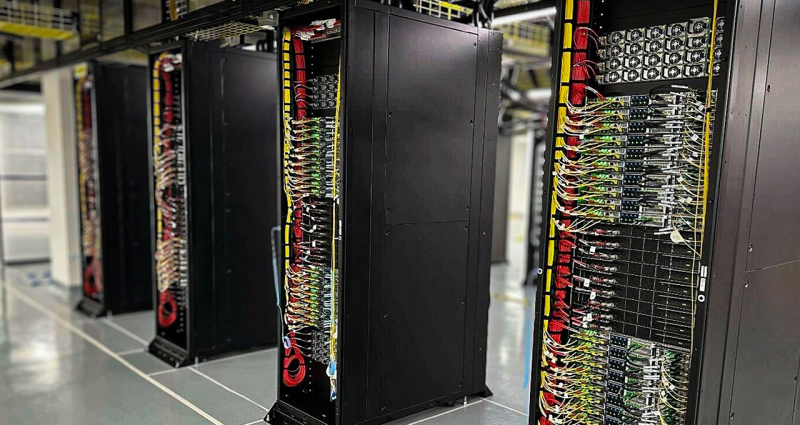

Oracle развернула в облаке суперускорители NVIDIA GB200 NVL72Корпорация Oracle ввела в эксплуатацию в своих дата-центрах первые суперускорители NVIDIA GB200 NVL72. Тысячи GPU семейства Blackwell доступны клиентам через облако NVIDIA DGX Cloud и инфраструктуру Oracle Cloud Infrastructure (OCI) для создания и запуска ИИ-агентов и «рассуждающих» моделей следующего поколения. Решение GB200 NVL72 объединяет 18 узлов 1U в одной стойке: каждый из них содержит два ускорителя GB200, что в сумме даёт 72 чипа B200 и 36 процессоров Grace. Задействована система жидкостного охлаждения. Платформа Oracle включает высокоскоростные сетевые решения NVIDIA Quantum-2 InfiniBand и Spectrum-X Ethernet. Отмечается, что Oracle планирует сформировать один из самых крупных в мире кластеров с ИИ-ускорителями поколения Blackwell. Системы OCI Supercluster смогут масштабироваться до более чем 100 тыс. GPU для удовлетворения стремительно растущих потребностей в вычислительных ресурсах для задач инференса и НРС. При этом Oracle предлагает гибкие варианты развёртывания, позволяющие клиентам использовать Blackwell через публичные, государственные и суверенные облака, а также собственные дата-центры. О намерении задействовать мощности OCI GB200 уже заявили ряд крупных клиентов. В их число входят технологические компании, корпоративные заказчики, государственные учреждения, а также региональные поставщики облачных услуг. Ранее о запуске общедоступных инстансов на основе NVIDIA GB200 NVL72 объявила компания CoreWeave, предоставляющая облачные сервисы для ИИ-задач. Кластеры Supermicro на базе NVIDIA GB200 NVL72 предложит клиентам Eviden (подразделение Atos Group). Эти суперускорители также взяла на вооружение облачная платформа Google Cloud. xAI также приступил к монтажу NVIDIA GB200 NVL72 для ИИ-кластера Colossus.

18.03.2025 [23:26], Владимир Мироненко

Dell представила сервер PowerEdge XE8712 на базе NVIDIA GB200 NVL4Компания Dell представила сервер PowerEdge XE8712, предназначенный для обработки разнообразных ИИ-нагрузок и HPC, включая обучение ИИ-моделей, молекулярное моделирование, геномное секвенирование, а также моделирование процессов на финансовых рынках.

Источник изображений: Dell В основе PowerEdge XE8712 лежит плата NVIDIA GB200 NVL4. Сервер оснащён суперчипом GB200 Grace Blackwell Superchip, включающим четыре ускорителя B200 Blackwell и два 72-ядерных Arm-процессора NVIDIA Grace. Как отмечает производитель, благодаря возможности установки до 144 ускорителей NVIDIA Blackwell (36 узлов) в одну стойку Dell серии IR7000, XE8712 обеспечивает одну из самых высоких в отрасли плотностей размещения GPU. Это позволяет выполнять больше рабочих нагрузок ИИ и HPC в меньшем физическом пространстве, снижая эксплуатационные расходы без ущерба для вычислительной мощности. Для отвода тепла в XE8712 используется технология прямого жидкостного охлаждения (DLC) — до 264 кВт на стойку. Dell IR7000 отличается раздельными полками питания с общей шиной питания мощностью до 480 кВт. Эта модульная ORv3-стойка легко интегрируется в различное окружения и будет совместима с серверами Dell PowerEdge следующего поколения.

17.03.2025 [16:51], Руслан Авдеев

CoreWeave развернёт крупный ИИ-кластер NVIDIA GB200 NVL72 в норвежском ЦОД Bulk N01Компания CoreWeave выбрала дата-центр Bulk Infrastructure в Норвегии для размещения кластера суперускорителей NVIDIA GB200 NVL72, объединённых интерконнектом Quantum-2 InfiniBand. Кластер, который, по словам компании, станет одной из крупнейших в Европе ИИ-системой на базе чипов NVIDIA, должен заработать уже к лету 2025 года, сообщает Datacenter Dynamics. Ранее CoreWeave пообещала развернуть крупнейший в Европе ИИ-кластер на базе NVIDIA Blackwell в Швеции. В CoreWeave подчеркнули, что компания рада сотрудничать с Bulk в деле расширения своего присутствия в регионе и в Европе вообще для обеспечения растущих потребностей в ИИ и HPC. Отдельно подчёркивается приверженность Bulk к созданию масштабируемой экобезопасной инфраструктуры. По словам самой Bulk Infrastructure, соглашение с CoreWeave — важнейшая веха в развитии норвежского бизнеса. С 2020 года Bulk Infrastructure привлекла в общей сложности $700 млн инвестиций, в том числе $380 млн от BOG. ЦОД N01, по словам компании, по-своему уникален и подходит для размещения ИИ-инфраструктуры. Кампус расположен на участке площадью 3 км2 рядом с электроподстанцией близ города и коммуны Кристиансанна (Kristiansand) фюльке Агдер (Agder). Кампус на 100 % запитан от многочисленных ГЭС. Всего площадка может получить до 400 МВт, но возможно расширение до 1 ГВт. В январе 2024 года Bulk начала строительство на территории кампуса нового объекта мощностью 42 МВт. CoreWeave анонсировала планы инвестировать $3,5 млрд в европейские ЦОД, в том числе $1,3 млрд в Великобритании, где уже заработали два первых объекта. К концу 2024 года она намеревалась открыть по всему миру 28 дата-центров, ещё 10 новых планировали ввести в эксплуатацию в 2025 году. Сейчас компания готовится к IPO.

17.03.2025 [07:56], Сергей Карасёв

Eviden предложит клиентам кластеры Supermicro на базе NVIDIA GB200 NVL72Компании Eviden (подразделение Atos Group) и Supermicro объявили о заключении соглашения о стратегическом сотрудничестве. Договор предполагает, что Eviden начнёт предлагать клиентам ИИ-системы Supermicro SuperCluster на базе суперускорителей NVIDIA GB200 NVL72. Система Supermicro SuperCluster оснащена накопителями E1.S с интерфейсом PCIe 5.0, а также жидкостным охлаждением. Соглашение между Eviden и Supermicro распространяется на различные географические рынки, включая Европу, Индию, Ближний Восток и Южную Америку. Eviden предложит клиентам в этих регионах возможность использования платформ Supermicro SuperCluster на основе NVIDIA GB200 NVL72 в рамках своего более масштабного инфраструктурного предложения. Предполагается, что благодаря данному партнёрству Supermicro сможет получить доступ к обширной сети клиентов Eviden вкупе с опытом этой компании в области развертывания и управлении крупными проектами в сфере ИИ. Кроме того, Eviden обеспечит обслуживание и поддержку оборудования.

Источник изображения: Supermicro Сотрудничество является частью более широкой стратегии Eviden и Supermicro по укреплению положения на рынке ИИ-платформ корпоративного класса. Компании стремятся объединить свои сильные стороны с целью предоставления заказчикам инновационных решений, которые стимулируют цифровую трансформацию и улучшают бизнес-результаты.

08.03.2025 [22:45], Владимир Мироненко

Первый ЦОД Stargate получит 64 тыс. ИИ-ускорителей NVIDIA GB200 к концу 2026 годаВ ближайшие месяцы OpenAI и Oracle в рамках ИИ-мегапроекта Stargate начнут установку оборудования в первом ЦОД в техасском городе Абилин (Abilene), сообщил Bloomberg со ссылкой на информированные источники. По словам собеседника Bloomberg, к концу 2026 года в этом дата-центре будет размещено 64 тыс. ИИ-ускорителей NVIDIA GB200. Монтаж оборудования в нескольких залах дата-центра будет выполнен в несколько этапов. К лету на первом этапе здесь будет установлено 16 тыс. чипов NVIDIA GB200. Стоимость оборудования не раскрывается, но строительство только одного объекта Stargate, по оценкам, обойдётся в несколько миллиардов долларов. Представитель OpenAI рассказал Bloomberg, что стартап работает вместе с Oracle над архитектурой и поставками для первого ЦОД в Абилине, и что Oracle отвечает за развёртывание и эксплуатацию суперкомпьютера, который строится в данном ЦОД. Ранее OpenAI сообщала, что в рамках проекта Stargate будет построено 10 ЦОД на территории США, включая несколько дата-центров на территории Техаса. Желание поддержать проект выразили 16 штатов, включая Аризону, Калифорнию, Флориду, Луизиану, Мэриленд, Неваду, Нью-Йорк, Огайо, Орегон, Пенсильванию, Юту, Техас, Вирджинию, Вашингтон, Висконсин и Западную Вирджинию. В стремлении нарастить вычислительные мощности совместное предприятие Stargate далеко не одиноко. Недавно стартап xAI, курируемый Илоном Маском (Elon Musk), заключил с Dell сделку стоимостью $5 млрд на поставку ИИ-серверов для суперкомпьютера Colossus в Мемфисе. Более года назад Meta✴ заявила, что к концу 2024 года планирует достичь вычислительной мощности, равной 600 тыс. ИИ-ускорителей NVIDIA H100. А CoreWeave заявила, что у неё есть более 250 тыс. ускорителей NVIDIA, размещённых в 32 ЦОД.

22.02.2025 [22:45], Сергей Карасёв

В облаке Google Cloud появились инстансы A4X на базе суперускорителей NVIDIA GB200 NVL72Облачная платформа Google Cloud объявила о запуске виртуальных машин A4 с ускорителями NVIDIA B200 и A4X на основе суперускорителей NVIDIA GB200 NVL72 поколения Blackwell. Эти инстансы ориентированы на ресурсоёмкие приложения ИИ. По заявлениям Google, виртуальные машины A4 обеспечивают высокий уровень производительности при работе с ИИ-моделями на различных архитектурах. Инстансы подходят для таких рабочих нагрузок, как обучение и тонкая настройка. В свою очередь, экземпляры A4X специально созданы для обучения и обслуживания самых требовательных и сверхмасштабных задач ИИ, включая большие языковые модели (LLM) с наиболее ёмкими контекстными окнами и «рассуждающие» модели. Суперускорители GB200 NVL72 объединяют в одной стойке 72 чипа B200 и 36 процессоров Grace. Применяются шина NVLink 5 и инфраструктура жидкостного охлаждения Google третьего поколения. Каждая система GB200 NVL72 обеспечивает быстродействие до 1,44 Эфлопс в режиме FP4 и до 720 Пфлопс в режиме FP8. По заявлениям Google, достигается четырёхкратное увеличение производительности при обучении LLM по сравнению с виртуальными машинами A3 на базе ускорителей NVIDIA H100. Инстансы A4X допускают масштабирование до десятков тысяч графических процессоров Blackwell. Говорится об интеграции с сервисами хранения Cloud Storage FUSE, Parallelstore и Hyperdisk ML, что обеспечивает доступ к данным с малой задержкой (менее 1 мс) и высокую пропускную способность. Новые виртуальные машины будут развёрнуты в различных регионах Google Cloud. Нужно отметить, что ранее о запуске общедоступных инстансов на базе NVIDIA GB200 NVL200 объявила компания CoreWeave, предоставляющая облачные услуги для ИИ-задач. Скоро эти суперускорители станут доступны и в облаке Lambda Labs.

05.02.2025 [12:07], Сергей Карасёв

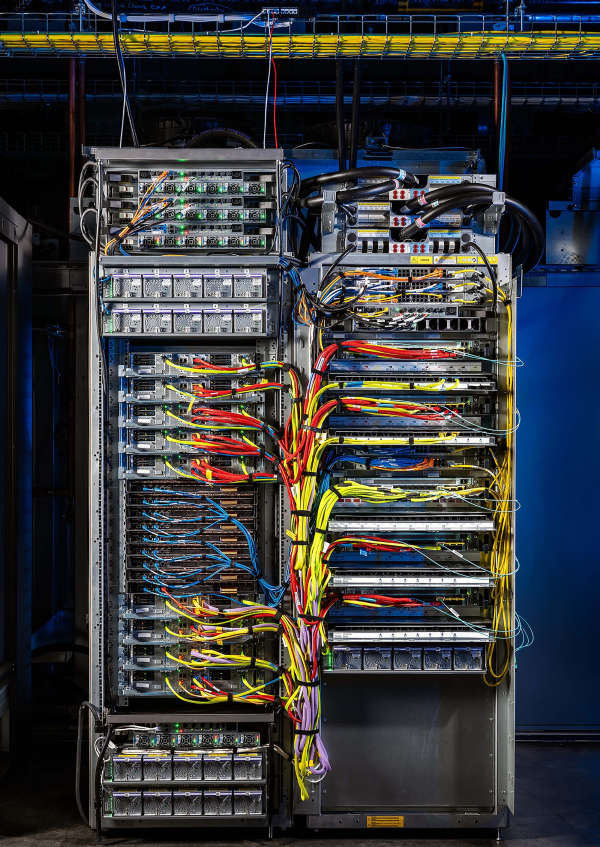

В облаке CoreWeave появились суперускорители NVIDIA GB200 NVL72Компания CoreWeave, предоставляющая облачные услуги для ИИ-задач, объявила о запуске первых в отрасли общедоступных инстансов на базе NVIDIA Blackwell. Они предназначены для наиболее ресурсоёмких нагрузок, включая работу с «рассуждающими» моделями ИИ. Инстансы используют суперускорители NVIDIA GB200 NVL72. Такие устройства объединяют в одной стойке 18 узлов 1U, каждый из которых содержит два ускорителя GB200: в сумме это даёт 72 чипа B200 и 36 процессоров Grace. Применяются шина NVLink 5 и система жидкостного охлаждения. Экземпляры CoreWeave на основе GB200 NVL72 оснащены интерконнектом NVIDIA Quantum-2 InfiniBand, который обеспечивает пропускную способность 400 Гбит/с в расчёте на GPU. Возможно формирование кластеров, насчитывающих до 110 тыс. графических процессоров. Платформа мониторинга CoreWeave Observability Platform в режиме реального времени предоставляет информацию о производительности NVLink, загрузке GPU и температуре узлов. В составе инстансов также задействованы DPU NVIDIA BlueField-3.

Источник изображения: NVIDIA По заявлениям CoreWeave, новые экземпляры обеспечивают прирост производительности до четырёх раз при обучении больших языковых моделей (LLM) по сравнению с решениями предыдущего поколения. Совокупная стоимость владения сокращается в 25 раз и во столько же снижается энергопотребление на задачах инференса в реальном времени. Вместе с тем быстродействие инференса может быть увеличено до 30 раз. Ожидается, что запуск инстансов с суперускорителями NVIDIA GB200 NVL72 поможет в создании моделей следующего поколения и ИИ-агентов. На сегодняшний день экземпляры доступны через CoreWeave Kubernetes Service в регионе US-WEST-01 — пара GB200 обойдётся в $42/час.

28.01.2025 [12:10], Сергей Карасёв

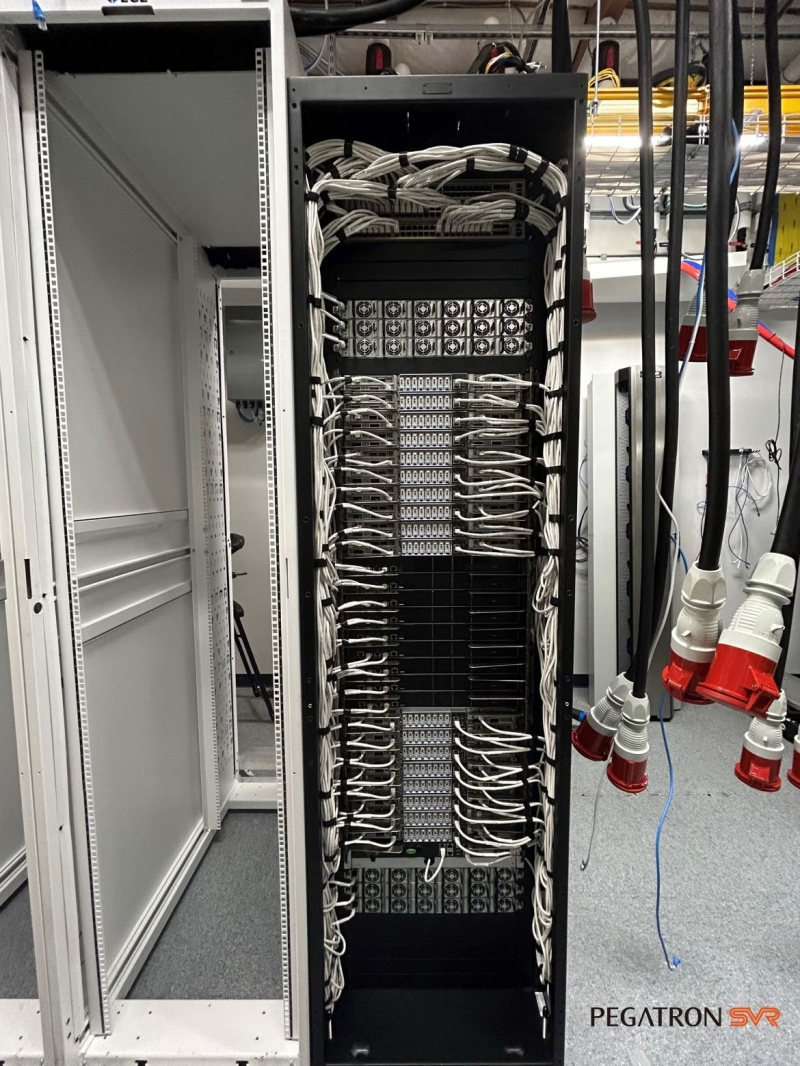

Pegatron поставит суперускорители NVIDIA GB200 NVL72 ИИ-стартапу Lambda LabsСтартап Lambda Labs, по сообщению ресурса Datacenter Dynamics, заключил партнёрское соглашение с серверным подразделением тайваньского ODM-производителя компьютерных комплектующих Pegatron. В рамках договора Pegatron развернёт суперускорители NVIDIA GB200 NVL72 для ИИ-инфраструктуры Lambda Labs. Напомним, фирма Lambda Labs была основана в 2012 году. Она предоставляет услуги облачных ИИ-вычислений с использованием собственных систем, оснащённых ускорителями NVIDIA, а также процессорами AMD и Intel. Кроме того, компания продаёт рабочие станции на базе GPU и предоставляет услуги колокации. Lambda Labs провела несколько раундов финансирования: полученные средства направляются на наращивание вычислительных мощностей и увеличение штата. В июле 2024 года сообщалось, что у суперускорителей с чипами NVIDIA GB200 возникли проблемы с СЖО: из-за дефектных компонентов фиксировались протечки. А в ноябре появилась информация, что стойки NVL72 перегревались, в связи с чем NVIDIA была вынуждена обратиться к поставщикам с просьбой внести ряд изменений в конструкцию стоек. Кроме того, NVIDIA и Schneider Electric занялись разработкой эталонной архитектуры охлаждения для ЦОД на основе GB200 NVL72. Впрочем, на текущий момент все проблемы устранены, а NVIDIA и партнёры организовали полномасштабное производство серверов на базе Blackwell. При этом клиенты уже приступили к монтажу суперускорителей GB200 NVL72. Такие системы, в частности, устанавливает стартап xAI Илона Маска (Elon Musk). Как отмечается, стратегическое партнёрство с Lambda Labs позволит Pegatron выйти на стремительно расширяющийся рынок ИИ-серверов. Первая система GB200 NVL72 (производства Supermicro), принадлежащая Lambda, была запущена на прошедших выходных в «водородном» дата-центре EdgeCloudLink.

18.01.2025 [22:31], Владимир Мироненко

CoreWeave поставит IBM ИИ-суперкомпьютер на базе NVIDIA GB200 NVL72 для обучения моделей GraniteCoreWeave и IBM заключили соглашение о сотрудничестве, в рамках которого стартап поставит IBM один из первых своих ИИ-суперкомпьютеров на базе NVIDIA GB200 NVL72 с интерконнектом Quantum-2 InfiniBand. В качестве хранилища будет использоваться высокопроизводительная All-Flash СХД IBM Storage Scale System. IBM будет использовать облачную платформу CoreWeave для обучения семейства больших языковых моделей (LLM) Granite. Сообщается, что облачная платформа CoreWeave специально создана для обеспечения ведущей в отрасли производительности, надёжности и отказоустойчивости с безопасностью корпоративного уровня. Фирменный набор ПО и облачные сервисы предоставляют инструменты, необходимые для управления самой сложной и масштабной ИИ-инфраструктурой. В рамках соглашения о сотрудничестве клиенты CoreWeave получат доступ к платформе IBM Storage. По словам вице-президента по ИИ в IBM Research, платформа CoreWeave позволит дополнить возможности IBM при разработке передовых, производительных и экономичных моделей для поддержки корпоративных приложений и ИИ-агентов. В свою очередь, IBM Storage Scale System расширяет возможности CoreWeave. «В рамках сотрудничества мы будем использовать этот суперкомпьютер для продвижения открытых технологий, таких как Kubernetes, которые будут поддерживать вычисления ИИ в гибридной облачной среде», — добавил представитель IBM. Вероятно, IBM не хватает собственных вычислительных ресурсов — в ноябре появилась информация о том, что компания готова арендовать у AWS ИИ-ускорители за почти полмиллиарда долларов. |

|