Материалы по тегу: ff

|

19.01.2024 [01:35], Владимир Мироненко

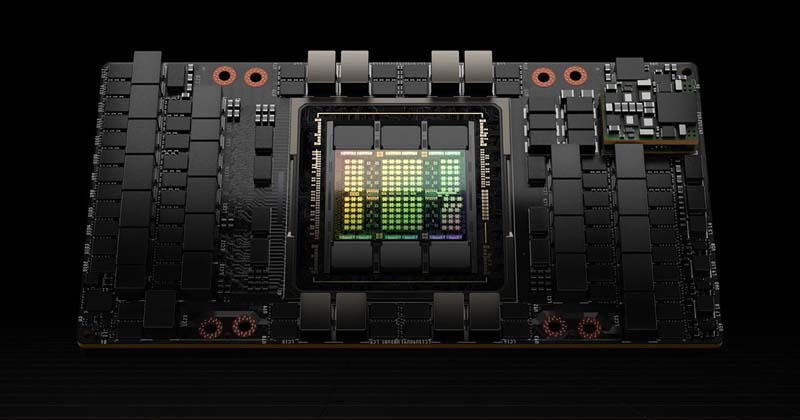

У Meta✴ будет уже 350 тыс. ускорителей NVIDIA H100 к концу 2024 годаК концу 2024 года компания Meta✴ планирует иметь в распоряжении 350 тыс. ускорителей NVIDIA H100. А общая произвдительность всех ИИ-чипов компании будет эквивалента 600 тыс. H100. Об этом сообщил основатель Meta✴ Марк Цукерберг в своём Instagram✴. Meta✴ заинтересовалась ускорителями AMD Instinct MI300, а также разработала собственный ИИ-чип MTIA. В интервью ресурсу The Verge глава Meta✴ уточнил , что для создания продуктов, которые компания хотела бы иметь в своём портфолио, необходимо разработать сильный искусственный интеллект (AGI). В настоящее время компания занимается проектом по развёртыванию метавселенной, который приносит ей пока только миллиардные убытки. но Meta✴ верит, что за сочетанием ИИ и метавсленными будущее.

Источник изображения: NVIDIA В рамках реализации планов по совершенствованию технологий ИИ компания пересмотрела находящиеся на стадии разработки проекты, отменив часть из них, что привело к падению капитальных затрат по сравнению с предыдущим годом. В IV квартале компания потратила $6,8 млрд, что на $3 млрд меньше год к году. При этом компания увеличивает вложения в ИИ и разработала новую архитектуру ЦОД, которая позволит повысить эффективность использования ИИ-кластеров. Всего в 2023 году капвложения Meta✴, по оценкам, составят $27–29 млрд. В 2024 году компания планирует потратить на эти цели $30–35 млрд, причём рост будет обусловлен инвестициями в серверы (включая оборудование, не связанное с ИИ), а также в дата-центры на базе обновлённой архитектуры.

11.01.2024 [21:04], Сергей Карасёв

Gigabyte представила сервер хранения S183-SH0 для больших языковых моделей

all-flash

edsff

emerald rapids

gigabyte

hardware

intel

nvme

pci express 5.0

sapphire rapids

xeon

схд

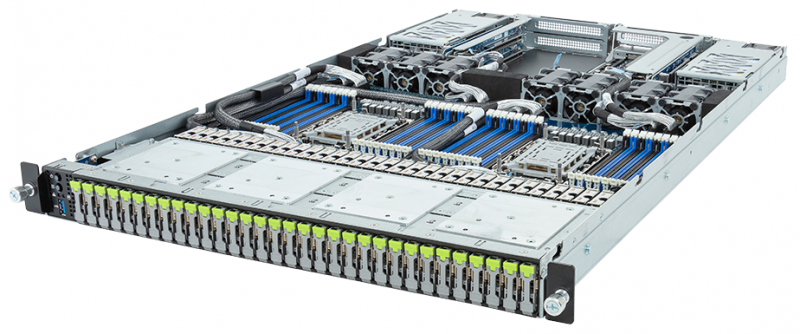

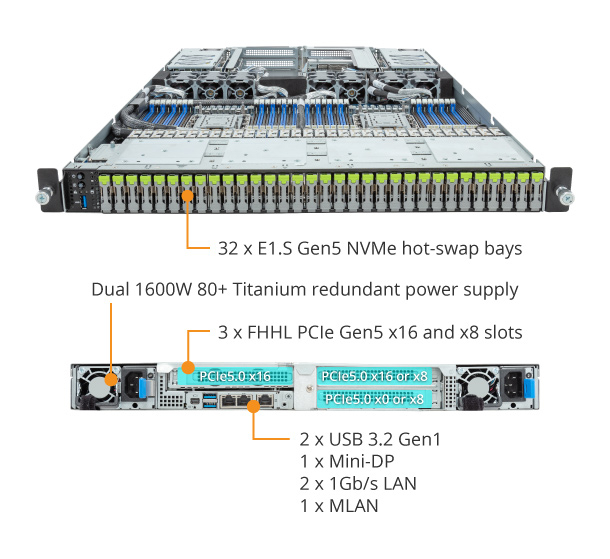

Компания Gigabyte анонсировала сервер хранения S183-SH0, предназначенный, как она сама говорит, для работы с большими языковыми моделями (LLM). Новинка, выполненная в форм-факторе 1U, допускает установку двух процессоров Intel Xeon Sapphire Rapids или Emerald Rapids.

Источник изображений: Gigabyte Во фронтальной части сервера расположены 32 посадочных места для накопителей E1.S NVMe SSD с возможностью горячей замены. Это позволяет сформировать сверхбыстрое хранилище для обработки данных LLM. Кроме того, предусмотрены два коннектора для накопителей M.2 с интерфейсом PCIe 3.0 x4 или SATA 3.0. Доступны 32 слота для модулей оперативной памяти DDR5-4800/5600. Могут быть установлены три карты FHHL с интерфейсом PCIe 5.0 x16 или x8. В оснащение входит контроллер Aspeed AST2600. Есть два сетевых порта 1GbE (Intel I350-AM2) с поддержкой NCSI и выделенный сетевой порт управления. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Габариты сервера составляют 438 × 43,5 × 730 мм. Имеются три порта USB 3.2 Gen1 (один выведен на лицевую панель), интерфейс Mini-DP и гнёзда RJ-45 для сетевых кабелей. Реализована система воздушного охлаждения с семью вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C.

03.11.2023 [22:48], Владимир Мироненко

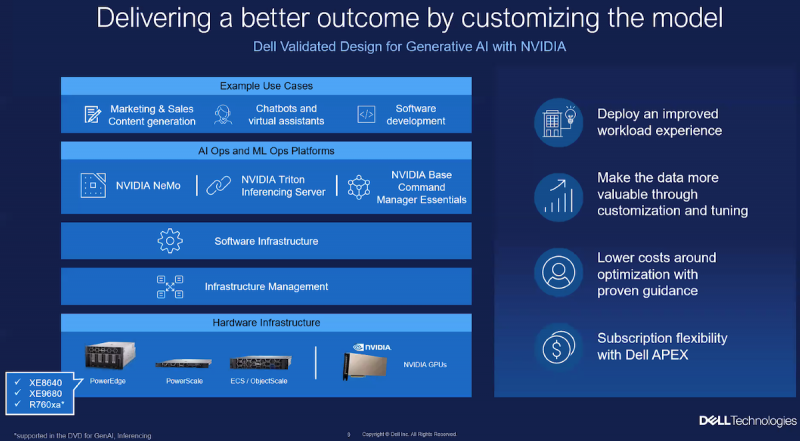

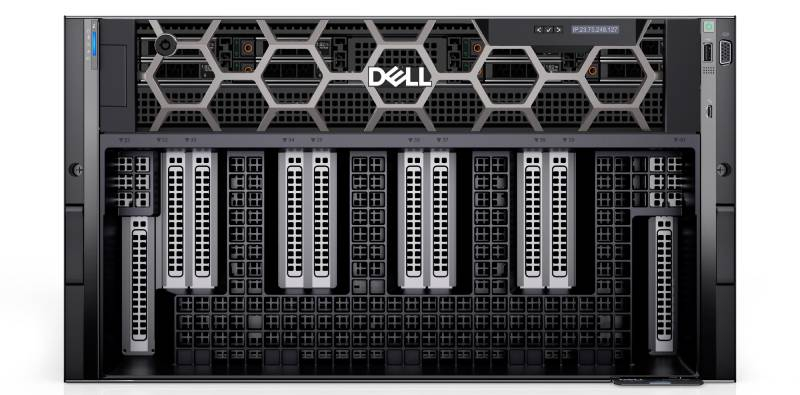

Llama 2 в хорошие руки: Dell и Meta✴ предложили готовый программно-аппаратный комплекс для локального развёртывания ИИDell и Meta✴ предложили совместную разработку для повышения эффективности работы компаний в области генеративного ИИ, основанную на использовании большой языковой модели Meta✴ Llama 2 и инфраструктуры Dell. Запуск таких приложений генеративного ИИ, как чат-боты, виртуальные помощники, в том числе для написания кода, предполагает обучение моделей на собственных данных компаний. Однако решения в публичных облаках хотя и удобны, часто имеют определённые ограничения, включая риски безопасности, связанные с суверенитетом данных, а также непредсказуемые затраты и проблемы с соблюдением регуляторных требований.

Источник изображения: Dell Локальное развёртывания открытых больших языковых моделей (LLM) вроде Llama 2 обеспечивает клиентам предсказуемые затраты и полный контроль над своими данными, снижая риск для безопасности и утечки интеллектуальной собственности, а также обеспечивая соответствие нормативным требованиям, говорит Dell. Решения Dell Generative AI Solutions вместе с Dell Validated Design for Generative AI предлагают клиентам готовый, предварительно протестированный программно-аппаратный, специально созданный для работы с генеративным ИИ. Теперь же Dell в сотрудничестве с Meta✴ расширила свой портфель предложений для работы с генеративным ИИ — клиентам доступно упрощённое развёртывание и тюнинг ИИ-моделей Meta✴ Llama 2 от Meta✴ в локальной среде. Решение Dell Validated Design for Generative AI вместе с Llama 2 предоставляет компаниям готовую инфраструктуру, ПО и сервисы Dell для оптимизации развёртывания и управления локальными ИИ-проектами. Llama 2 протестирована и проверена Dell, в том числе при работе с (SFT), LoRA и p-tuning на моделях с 7, 13 и 70 млрд параметров Благодаря руководству по развёртыванию и настройке компании смогут быстро запустить свою ИИ-инфраструктуру и использовать Llama 2 с большей предсказуемостью. В частности, доступны анализ использования памяти, задержек и эффективности LLM. «Наша цель — стать предпочтительным поставщиком локальной инфраструктуры для клиентов, развёртывающих Llama 2, и предоставить нашим клиентам лучшие в своём классе генеративные решения ИИ», — сообщила компания. Аппаратная основа включает серверы PowerEdge XE9680, а также PowerEdge R760xa (с NVIDIA L40S).

28.10.2023 [14:13], Сергей Карасёв

Квартальные капвложения Meta✴ в ЦОД и серверы рухнули почти на третьКомпания Meta✴ опубликовала отчёт о работе в III четверти 2023 финансового года, которая была завершена 30 сентября. Говорится, что капиталовложения в серверы, дата-центры и сетевую инфраструктуру в годовом исчислении сократились приблизительно на треть, что объясняется прежде всего пересмотром и приостановкой ряда крупных ЦОД-проектов. За трёхмесячный период Meta✴ получила выручку в размере $34,15 млрд, что на 23 % больше прошлогоднего результата. Чистая прибыль при этом взлетела на 164 % — с $4,40 млрд до $11,58 млрд. Прибыль в пересчёте на одну ценную бумагу составила $4,39 против $1,64 в III квартале 2022-го.

Источник изображения: Meta✴ В свете сложившейся макроэкономической ситуации и стремительного развития рынка ИИ Meta✴ инициировала масштабную трансформацию. В конце 2022 года компания объявила о пересмотре архитектуры своих дата-центров с прицелом на ИИ и СЖО. С тех пор были приостановлены около десятка проектов по всему миру. Meta✴ также сообщила о сокращении расходов на ЦОД на $4 млрд и об отказе от дальнейшего внедрения инференс-чипов собственной разработки в пользу ускорителей NVIDIA. По итогам закрытого квартала капвложения Meta✴ в ЦОД и серверы оказались на отметке $6,8 млрд, тогда как годом ранее этот показатель равнялся $9,52 млрд. Компания ожидает, что её капитальные затраты в 2023 году в целом составят $27–$29 млрд, а не $27–$30 млрд, как предполагалось ранее. В 2024 году это значение окажется в диапазоне от $30 до $35 млрд: планируемый рост будет обусловлен инвестициями в серверы, включая оборудование, не связанное с ИИ, и в дата-центры. По состоянию на 30 сентября 2023 года численность штата Meta✴ в глобальном масштабе составляла 66 185 сотрудников. Это на 24 % меньше, нежели годом ранее.

22.10.2023 [22:00], Руслан Авдеев

400-Тбит/с транслатлантический интернет-кабель Amitié готов к коммерческой эксплуатацииВозглавляемый Meta✴ проект Amitié с участием ряда других телеком-компаний подошёл к завершению первой стадии и готов к реализации следующего этапа. Как сообщает Datacenter Dynamics, 400-Тбит/c трансатлантический кабель протяжённостью 6800 км, соединяющий Францию и США, готов к коммерческому применению. Изначально строительство Amitié анонсировали в 2020 году, кабель должны были ввести в строй ещё в прошлом году. Фактически работы по прокладке завершились ещё в июле, но официальный ввод в эксплуатацию состоялся только сейчас. Amitié объединяет 16 оптоволоконных пар. Посадочные станции расположены в Линне близ Бостона (принадлежит дочерней структуре Meta✴ — Edge USA), в Буде (Англия), в также дата-центре Equinix в Бордо (Франция). Meta✴ имеет наибольшую долю в проекте (80 %), а в число партнёров входят Aqua Comms, Microsoft и Vodafone. Оператором станции в Бордо является телеком-провайдер Orange, владеющий частями кабеля протяжённостью до 22,2 км, тянущимися от побережья Франции. Известно, что компании принадлежит право на использование двух оптоволоконных пар кабеля. По словам представителей Orange, комбинация кабелей Amitié и Dunant обеспечила Франции размещение в сердце межконтинентальных обменов информацией — между Европой и Соединёнными Штатами, а также Азией и Африкой.

Источник изображения: IntelligentVisualDesing/pixabay.com Задержка при прохождении сигнаоа от Бордо до Нью-Йорка составляет 34 мс. Для сравнения, принадлежащий Google трансатлантический кабель Dunant может предложить 38 мс. В 860 километрах от побережья Франции и 650 километрах от берегов Великобритании имеется дополнительный блок управления, позволяющий эффективно менять настройки передачи сигнала между отдельными посадочными станциями, переключаясь между длинами волн или волокнами.

18.10.2023 [13:53], Сергей Карасёв

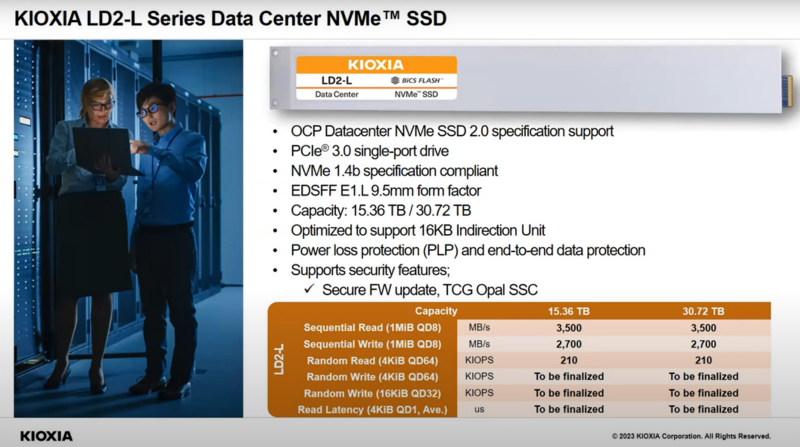

Kioxia представила SSD серии LD2-L в формате E1.L вместимостью до 30,72 ТбайтКомпания Kioxia на мероприятии Open Compute Project (OCP) Global Summit анонсировала SSD семейства LD2-L, предназначенные для дата-центров. На базе новинок могут формироваться массивы большой ёмкости. Изделия выполнены в форм-факторе EDSFF E1.L с толщиной 9,5 мм. Для обмена данными служит интерфейс PCIe 3.0 (спецификация NVMe 1.4b). В серию LD2-L вошли две модификации — вместимостью 15,36 и 30,72 Тбайт. Заявленная скорость последовательного чтения информации у обоих устройств достигает 3500 Мбайт/с, скорость последовательной записи — 2700 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) приводится только для режима произвольного чтения данных блоками по 4 Кбайт — на уровне 210 тыс. Отмечается, что в стоечное шасси типоразмера 1U могут быть установлены до 32 накопителей LD2-L. В результате, суммарная вместимость составит 983,04 Тбайт. Такая СХД, по заявлениям Kioxia, сможет обеспечить пропускную способность до 100 Гбайт/с при чтении информации. Изделия LD2-L не могут похвастаться рекордной производительностью — у самой Kioxia есть более быстрые серверные SSD с интерфейсами PCIe 4.0 и PCIe 5.0. Вместо этого новинки призваны обеспечить максимальную плотность хранения данных в системах формата 1U.

23.05.2023 [19:36], Руслан Авдеев

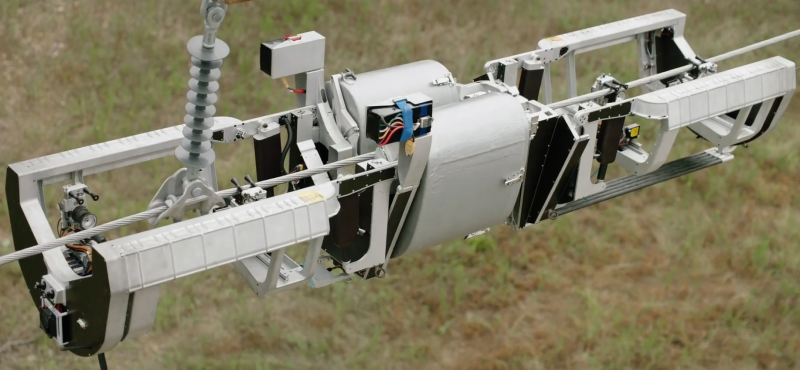

Meta✴ лицензирует робота Bombyx, предназначенного для прокладки оптоволоконных интернет-кабелей по ЛЭПРобот Meta✴ Bombyx — это специальное устройство, способное прокладывать оптоволоконные кабели, передвигаясь по линиям электропередач. Bombyx переводится с латыни как «мотылёк шелкопряда». Разработка робота была начата Facebook✴ и ULC Robotics ещё в 2018 году. Теперь Meta✴ сделала ставку на сторонний бизнес, который готов взять реализацию проекта на себя — робота лицензируют для дальнейшей разработки японской IT-компанией. Лицензию получит японская Hibot, обладающая десятилетиями опыта в разработке роботов различного назначения. В компании уже заявили, что считают большой честью получение лицензии и намерены работать над проектом уже существующими партнёрами и теми, кто пожелает присоединиться к разработке. Робот Bombyx поддержит прокладку оптических линий в труднодоступных местностях, где проникновение интернета оставляет желать лучшего.

Источник изображения: Meta✴ В дополнение к возможности прокладки кабеля, Hibot будет использовать инновационные технологии Meta✴ для создания машины, пригодной для проверки уже существующей инфраструктуры и, возможно, для модернизации электросетей. Хотя оптоволоконные кабели являются недорогими и эффективным решением для создания информационных сетей, сама прокладка обычно обходится значительно дороже самого кабеля и представляет собой относительно сложный процесс.

Источник изображения: Meta✴ В случае Bombyx кабель обвивается вокруг проводов на линиях электропередач. При этом снятие напряжения не требуется, а протяжённость кабеля может быть весьма велика. Правда, речь идёт о специальном кабеле в кевларовой рубашке, который значительно легче традиционных вариантов (менее 13 кг/км). Bombyx может преодолевать препятствия, используя механизмы машинного зрения и сенсоры для ориентации в пространстве.

19.05.2023 [10:20], Сергей Карасёв

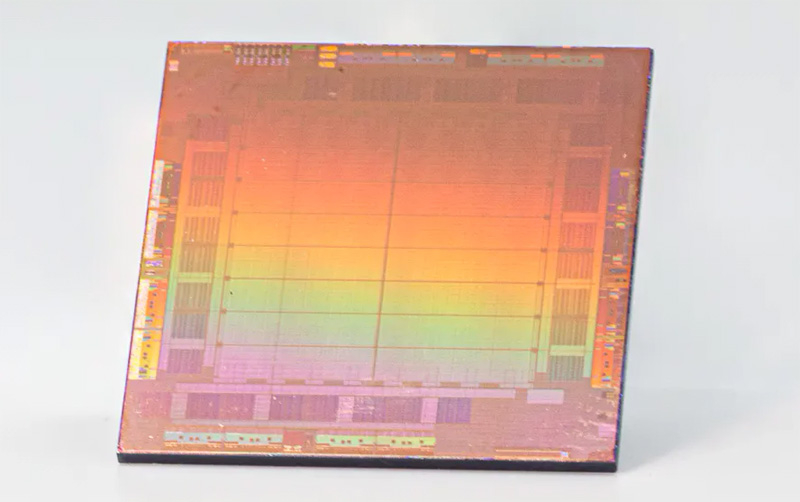

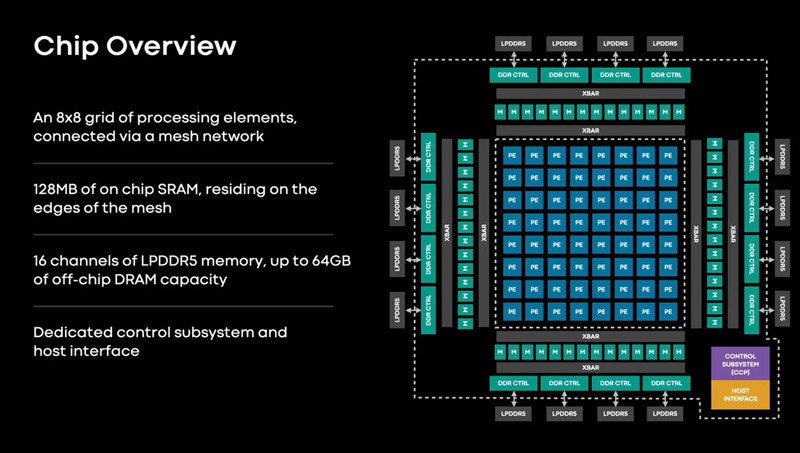

Meta✴ представила ИИ-процессор MTIA для дата-центров — 128 ядер RISC-V и потребление всего 25 ВтMeta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие получило название MTIA v1, или Meta✴ Training and Inference Accelerator: оно оптимизировано для обработки рекомендательных моделей глубокого обучения. Проект MTIA является частью инициативы Meta✴ по модернизации архитектуры дата-центров в свете стремительного развития ИИ-платформ. Утверждается, что чип MTIA v1 был создан ещё в 2020 году. Это интегральная схема специального назначения (ASIC), состоящая из набора блоков, функционирующих в параллельном режиме.

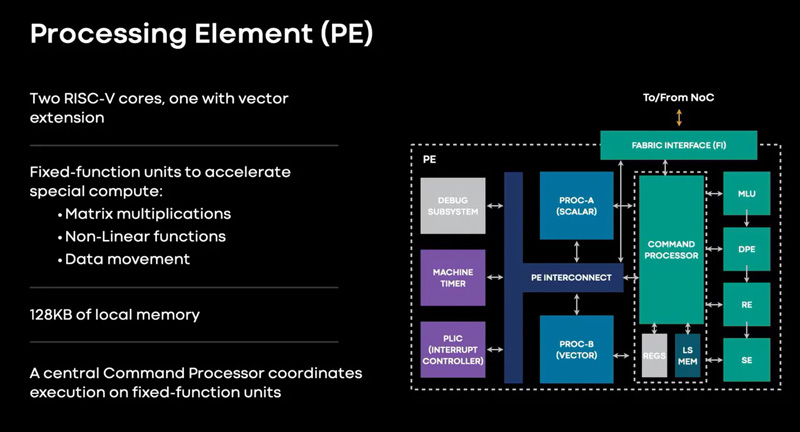

Источник изображений: Meta✴ Известно, что при производстве MTIA v1 используется 7-нм технология. Конструкция включает 128 Мбайт памяти SRAM. Чип может использовать до 64/128 Гбайт памяти LPDDR5. Задействован фреймворк машинного обучения Meta✴ PyTorch с открытым исходным кодом, который может применяться для решения различных задач в области компьютерного зрения, обработки естественного языка и пр.  Процессор MTIA v1 имеет размеры 19,34 × 19,1 мм. Он содержит 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра с архитектурой RISC-V. Тактовая частота достигает 800 МГц, заявленный показатель TDP — 25 Вт. Meta✴ признаёт, что у MTIA v1 присутствуют «узкие места» при работе с ИИ-моделями большой сложности: требуется оптимизация подсистем памяти и сетевых соединений. Однако в случае приложений низкой и средней сложности платформа, как утверждается, обеспечивает более высокую эффективность по сравнению с GPU.  В дальнейшем в семействе MTIA появятся более производительные изделия, но подробности о них не раскрываются. Ранее говорилось, что Meta✴ создаёт некий секретный чип, который подойдёт и для обучения ИИ-моделей, и для инференса: это решение может увидеть свет в 2025 году.

26.04.2023 [19:50], Сергей Карасёв

Meta✴ вынужденно пересмотрела архитектуру своих ЦОД из-за отказа от выпуска собственных ИИ-чипов в пользу ускорителей NVIDIAКомпания Meta✴, по сообщению Reuters, была вынуждена пересмотреть конфигурацию своих дата-центров из-за отставания от конкурентов в плане развития ИИ-платформ. Компания, в частности, решила отказаться от дальнейшего внедрения инференс-чипов собственной разработки. Отмечается, что до прошлого года Meta✴ применяла архитектуру, в которой традиционные CPU соседствуют с кастомизированными решениями. Однако выяснилось, что такой подход менее эффективен по сравнению с применением ускорителей (GPU). При этом ранее компания отказалась от ИИ-ускорителей Qualcomm, указав на недоработки ПО, которые, судя по всему, были устранены только недавно. А с Esperanto, вероятно, отношения у Meta✴ пока не сложились. Впрочем, теперь компании интересен генеративный ИИ, а не только рекомендательные системы, что накладывает иные требования к оборудованию.

Источник изображения: Meta✴ В течение почти всего 2022 года Meta✴ активно инвестировала в развите инфраструктуры, однако в конце года стало известно, что она приостановила строительство целого ряда ЦОД, а затем пересмотрела расходы на дата-центры. Компания решила кардинально переосмыслить архитектуру своих ЦОД, сделав ставку на СЖО. Как теперь выясняется, связано это с тем, что Meta✴ отказалась от собственных ИИ-чипов в пользу ускорителей NVIDIA: объём заказов последних исчисляется «миллиардами долларов». Соответствующую платформу Grand Teton компания показала в конце прошлого года.

Источник изображения: Meta✴ Но ускорители потребляют больше энергии и выделяют больше тепла, нежели CPU или узкоспециализированные ASIC. Кроме того, ускорители должны физически находиться довольно близко друг к другу, хотя с интерконнектом компания тоже уже экспериментирует. Всё это влияет на архитектуру ЦОД. Тем не менее, Meta✴ всё же разрабатывает некий секретный чип, который сгодится и для обучения ИИ-моделей, и для инференса. Ожидается, что это решение увидит свет в 2025 году. Пока что для обучения ИИ компания намерена использовать собственный ИИ-суперкомпьютер RSC и облачные кластеры Microsoft Azure. Похожий путь избрала Microsoft, решившая создать свой ИИ-чип, не отказываясь пока от ускорителей NVIDIA. The Information добавляет, что вице-президент Microsoft по разработке «кремния» Жан Буфархат (Jean Boufarhat) присоединится к Meta✴. Он возглавит команду Facebook✴ Agile Silicon Team (FAST), чтобы помочь компании в реализации проектов по созданию чипов. Ранее Meta✴ переманила из Intel руководителя разработки сетевых решений для дата-центров. У Google и Amazon уже есть свои ИИ-чипы для обучения и инференса.

22.04.2023 [00:15], Алексей Степин

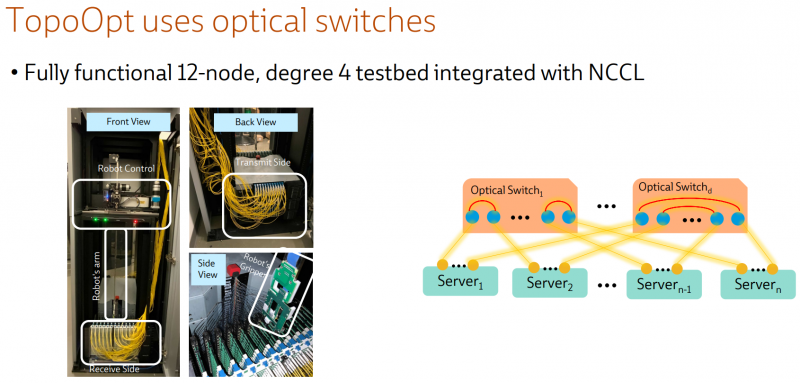

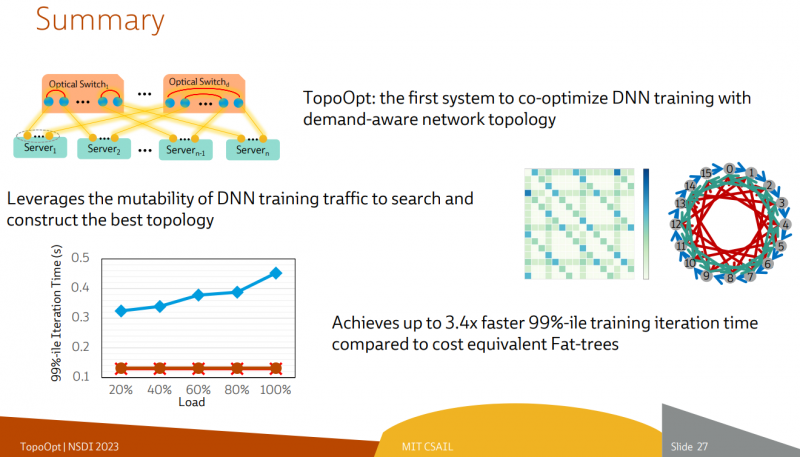

Ловкость роборук: TopoOpt от Meta✴ и MIT поможет ускорить и удешевить обучение ИИТехнологии искусственного интеллекта (ИИ) сегодня бурно развиваются и требуют всё более серьёзных вычислительных мощностей. Но наряду с наращиванием этих мощностей растут требования и к сетевой подсистеме, поэтому крупные компании и исследовательские организации ищут всё новые способы оптимизации инфраструктуры. Компания Meta✴ в сотрудничестве с Массачусетским технологическим институтом (MIT) и рядом прочих исследовательских организаций опубликовала данные любопытного эксперимента, в котором ИИ-кластер мог менять топологию своего интерконнекта с помощью механической «роборуки». Система получила название TopoOpt, поскольку вычислительные узлы в ней использовали полностью оптическую сеть с оптической же патч-панелью. Эта сеть объединяла 12 вычислительных узлов ASUS ESC4000A-E10, каждый из которых был оснащён ускорителем NVIDIA A100, сетевыми адаптерами HPE и Mellanox ConnectX-5 (100 Гбит/с) с оптическими трансиверами. Наиболее интересное устройство в эксперименте — оптическая патч-панель Telescent, оснащённая механическим манипулятором, способным производить перекоммутацию на лету. Эта «роборука» работала под управлением специализированного ПО, целью которого ставилось нахождение оптимальной сетевой топологии и сегментации сети применительно к различным задачам машинного обучения.

Система с перекоммутируемой оптической сетью не требует энергоёмких высокоскоростных коммутаторов и обеспечивает ряд других преимуществ Такая роботизированная патч-панель не столь расторопна, как оптические коммутаторы Google с микрозеркальной механикой, но стоит впятеро дешевле и имеет больше портов. Опубликованные экспериментальные данные уверенно свидетельствуют о том, что топология «толстого дерева» (fat tree), использующая несколько слоёв коммутаторов, не оптимальна и даже избыточна для ряда нейросетевых задач. К тому же перекоммутируемая оптическая сеть без традиционных высокоскоростных коммутаторов требует меньше оборудования, а значит, может быть не только быстрее сети fat tree в ряде ИИ-задач, но и существенно дешевле в развёртывании и поддержании в рабочем состоянии — как минимум за счёт отсутствия затрат на питание множества коммутаторов. |

|