Материалы по тегу: ff

|

11.04.2024 [02:16], Владимир Мироненко

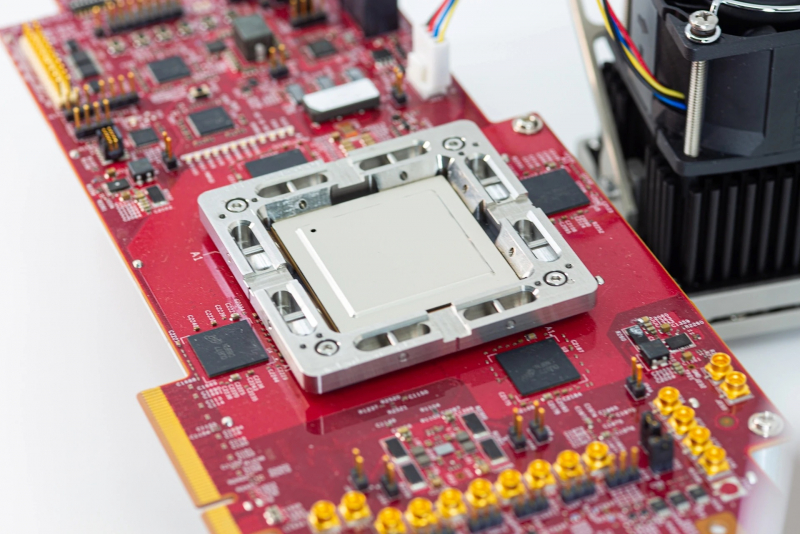

Второе поколение ИИ-ускорителей Meta✴ MTIA втрое быстрее первогоКомпания Meta✴ поделилась подробностями о следующем собственных ИИ-ускорителей Meta✴ Training and Inference Accelerator. Новый чип отличается более высокой производительностью по сравнению со чипом MTIA v1, представленным в мае прошлого года, и будет играть решающую роль в обеспечении работы ИИ-моделей Meta✴. Следующее поколение крупномасштабной инфраструктуры Meta✴ рассчитано на поддержку новых продуктов и услуг в области генеративного ИИ, рекомендательных систем и передовых исследований в области ИИ. Создание нового чипа является частью инвестиций в инфраструктуру. В ближайшие годы, как ожидается, затраты в этом направлении будут расти, поскольку требования к вычислительным ресурсам для поддержки моделей будут расти вместе с усложнением последних.

Источник изображений: Meta✴ Архитектура чипа ориентирована на обеспечение «правильного баланса вычислений, пропускной способности и объёма памяти» даже при относительно небольших размерах обрабатываемых последовательностей. MTIA v2 в сравнении с MTIA v1 в 3,5 раза быстрее в обычных вычислениях и в 7 раз — в разреженных. Новый чип изготавливается по 5-нм техпроцессу TSMC и имеет габариты 25,6 × 16,4 мм (упаковка 40 × 50 мм). Ускоритель работает на частоте 1,35 ГГц, а его TDP составляет 90 Вт, тогда как 7-нм MTIA v1 работал на частоте 800 МГц и имел TDP всего 25 Вт. Готовая стоечная система вмещает до 72 ускорителей и состоит из трёх шасси с 12 платами, на каждой из которых размещено по два ускорителя. Для дальнейшего масштабирования можно добавить RDMA-сеть.  Чип состоит из 64 вычислительных элементов (PE). У каждого PE есть небольшой блок локальной памяти объёмом 384 Кбайт с ПСП 1 Тбайт/с. На весь чип приходится 256 Мбайт SRAM (2,7 Тбайт/с), а внешняя память представлена 128 Гбайт LPDDR5 (204,8 Гбайт/с). Для подключения к хосту используется интерфейс PCIe 5.0 x8 (32 Гбайт/с). При работе с матрицами чип развивает 177 (FP16/BF16) и 354 (INT8) Тфлопс, в разреженных вычислениях — вдвое больше. SIMD-блоки выдают 2,76 Тфлопс для FP32 и 5,53 Тфлопс для INT8/FP16/BF16. В векторных расчётах значения те же, только для INT8 показатель составляет уже 11,06 Тфлопс. MTIA v2 совместим с кодами, разработанными для MTIA v1. Стек MTIA ориентирован на PyTorch 2.0 и включает компилятор Triton-MTIA. Предварительные испытания MTIA v2 на четырёх ключевых ИИ-моделях компании показали, что он втрое быстрее MTIA v1 чип первого поколения. А на уровне платформы достигнуто шестикратное увеличение пропускной способности модели и рост производительности на Вт в 1,5 раза. Чипы MTIA уже развёрнуты в ЦОД компании. Правда, для обучения Meta✴ их пока не использует.

24.03.2024 [02:19], Сергей Карасёв

WEKApod для SuperPOD: WekaIO представила платформу хранения данных для ИИ-кластеров NVIDIAКомпания WekaIO, разработчик решений для хранения данных, анонсировала высокопроизводительное All-Flash хранилище WEKApod, оптимизированное для работы с платформой NVIDIA DGX SuperPOD на базе NVIDIA DGX H100. Новинка объединяет специализированное ПО WekaIO и «лучшее в своем классе оборудование». Хранилище WEKApod спроектировано для ресурсоёмких нагрузок ИИ. Базовая конфигурация состоит из восьми 1U-узлов, обеспечивающих суммарную вместимость в 1 Пбайт. Показатель IOPS (операций ввода-вывода в секунду) достигает 18,3 млн. Заявленная пропускная способность при чтении составляет до 720 Гбайт/с, при записи — до 186 Гбайт/с. Утверждается, что восемь узлов WEKApod обеспечивает производительность, необходимую для 128 систем NVIDIA DGX H100. При этом WEKApod может масштабироваться до сотен узлов блоками по четыре узла. Таким образом, можно сформировать систему необходимой вместимости с высокой отказоустойчивостью для обучения больших языковых моделей (LLM), ИИ-приложений, работающих в реальном времени, и пр.

Источник изображения: WekaIO Отмечается, что архитектура WEKApod обеспечивает снижение энергопотребления благодаря оптимальному использованию пространства, улучшенному охлаждению и средствам энергосбережения в режиме простоя. В результате, достигается потенциальное сокращение углеродного следа до 260 т/Пбайт. WEKApod использует адаптеры NVIDIA ConnectX-7 и NVIDIA Base Command Manager для мониторинга и управления. Каждый из узлов несёт на борту процессор AMD EPYC 9454P (48C/96T; 2,75–3,80 ГГц; 290 Вт) и 384 Гбайт памяти DDR5-4800. Есть посадочные места для 14 накопителей формата E3.S с интерфейсом PCIe 5.0. Производительность в расчёте на узел достигает 90 Гбайт/с при чтении и 23,3 Гбайт/с при записи, а величина IOPS равна 2,3 млн при произвольном чтении и 535 тыс. при произвольной записи.

14.03.2024 [00:06], Сергей Карасёв

Meta✴ подала в суд на бывшего вице-президента за кражу сверхсекретных планов ЦОДКомпания Meta✴, по сообщению ресурса The Register, подала в суд на бывшего вице-президента по инфраструктуре Дипиндера Сингха Хурану (Dipinder Singh Khurana), который подозревается в краже «сверхсекретных планов», касающихся дата-центров. Хурана, также известный как Т. С. Хурана (T. S. Khurana), проработал в Meta✴ / Facebook✴ в общей сложности приблизительно 12 лет. Он покинул эту корпорацию в июне 2023 года, перейдя на должность старшего вице-президента по операциям в некоем стартапе, который всё ещё работает в скрытом режиме. Название этой фирмы в судебных документах не раскрывается.

Источник изображения: Meta✴ После подачи заявления об уходе Хурана якобы использовал имеющиеся у него права доступа для кражи «проприетарных, крайне секретных, конфиденциальных и закрытых документов о бизнесе и сотрудниках Meta✴». Говорится, что похищенные файлы содержат внутреннюю информацию о дата-центрах Meta✴, поставщиках компании и проектах, связанных с технологиями ИИ. Кроме того, в этих документах содержатся данные о бизнес-операциях Meta✴ и расходах, связанных с закупками. Meta✴ подчёркивает, что при уходе из компании Хурана получил «щедрую компенсацию», но, тем не менее, решил похитить корпоративные данные. Украденные файлы якобы были загружены в его персональные аккаунты Google Drive и Dropbox. Более того, многие из этих файлов были скопированы в папки с именем нового работодателя. Meta✴ считает, что похищенные сведения использовались в том числе для поиска сотрудников для нового работодателя, который специализируется на облачных ИИ-технологиях. Meta✴ выдвинула против Хураны пять обвинений, включая нарушение условий контракта, неосновательное обогащение и нарушение фидуциарных обязанностей. Истцы требуют от своего бывшего вице-президента возмещения ущерба.

07.03.2024 [14:58], Руслан Авдеев

Кеш на 10–20 МВт: Meta✴ изучает возможность строительства в Индии небольшого ЦОД для обслуживания ReelsDatacenter Dynamics сообщает со ссылкой на публикации в местных СМИ о планах Meta✴ по строительству своего первого в Индии дата-центра для удовлетворения роста спроса на её сервисы в регионе. По данным одного из локальных источников, речь идёт о небольшом ЦОД ёмкостью 10–20 МВт для кеширования материалов социальных сетей. Отчасти рост потребностей Meta✴ в местном дата-центре связан с увеличением спроса на платформу Reels, конкурирующую с TikTok по всему миру. В Индии TikTok находится под запретом, поэтому обеспечить здесь инфраструктуру для Reels особенно важно для компании. Пока единственный дата-центр Meta✴ в Азитаско-Тихоокеанском регионе расположен в Сингапуре, многочисленные кампусы ЦОД имеются у компании в США и несколько — в Евросоюзе. Индия запретила TikTok и ещё более 100 китайских приложений ещё в июне 2020 года, сославшись на угрозу национальной безопасности. Принадлежащий Meta✴ сервис Reels доступен пользователям через социальные сети Instagram✴ и Facebook✴, где он появился в 2020 и 2021 гг. соответственно.

23.02.2024 [19:06], Сергей Карасёв

Meta✴ ищет в Индии и США специалистов для разработки ИИ-ускорителей и SoC для дата-центровКомпания Meta✴, по сообщению The Register, опубликовала множество объявлений о поиске специалистов для разработки интегральных схем специального назначения (ASIC). Речь идёт о создании собственных ускорителей для машинного обучения и ИИ, а также SoC для дата-центров. Сейчас для ИИ-задач Meta✴ массово применяет решения NVIDIA. Кроме того, компания присматривается к ускорителям AMD Instinct MI300. С целью снижения зависимости от сторонних поставщиков и сокращения расходов Meta✴ также проектирует собственные аппаратные компоненты. В частности, весной прошлого года Meta✴ анонсировала свой первый кастомизированный процессор, разработанный специально для ИИ-нагрузок. Изделие под названием MTIA v1 (Meta✴ Training and Inference Accelerator) представляет собой ASIC в виде набора блоков, функционирующих параллельно. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра RISC-V. Кроме того, компания создала чип MSVP (Meta✴ Scalable Video Processor) для обработки видеоматериалов. В разработке также находятся собственные ИИ-ускорители Artemis.

Источник изображения: Meta✴ Как теперь сообщается, Meta✴ ищет ASIC-инженеров с опытом работы в области архитектуры, дизайна и тестирования. Необходимы специалисты в Бангалоре (Индия) и Саннивейле (Калифорния, США). В некоторых вакансиях работодателем указана собственно Мета✴, тогда как в других случаях указан Facebook✴. От кандидатов в числе прочего требуется «глубокий опыт в одной или нескольких ключевых сферах, связанных с созданием сложных SoC для дата-центров». Тестировщикам необходимо иметь опыт проверки проектов для ЦОД, связанных с машинным обучением, сетевыми технологиями и пр. Некоторые вакансии были впервые опубликованы в соцсети LinkedIn в конце декабря 2023 года и обновлены в феврале нынешнего года. Претендентам обещаны неплохие зарплаты. Для каких именно задач компании Meta✴ требуются аппаратные решения, не уточняется. Но сетевые источники отмечают, что это может быть инференс, создание новых ИИ-платформ и т.п.

10.02.2024 [01:53], Владимир Мироненко

Pure Storage, намеревающаяся изжить жёсткие диски, сократила 4 % штатаКомпания Pure Storage, специализирующаяся на All-Flash СХД, провела очередной раунд увольнений, уволив до 275 сотрудников, сообщил ресурс Blocks & Files. По данным издания, сокращения затронули направление по защите данных, а также специалистов в области ИИ, аналитики, баз данных, альянсов и в сфере неструктурированных данных. Представитель Pure рассказал изданию, что компания продолжает масштабироваться и поддерживать высокие темпы роста и инноваций. Нынешнее сокращение призвано привести структуру штата в соответствие с приоритетами компании и областями, которые являются стратегическими для бизнеса. Уволенным сотрудникам предоставили право подать заявки на открытые вакансии, а также предложили помощь в трудоустройстве за пределами Pure.

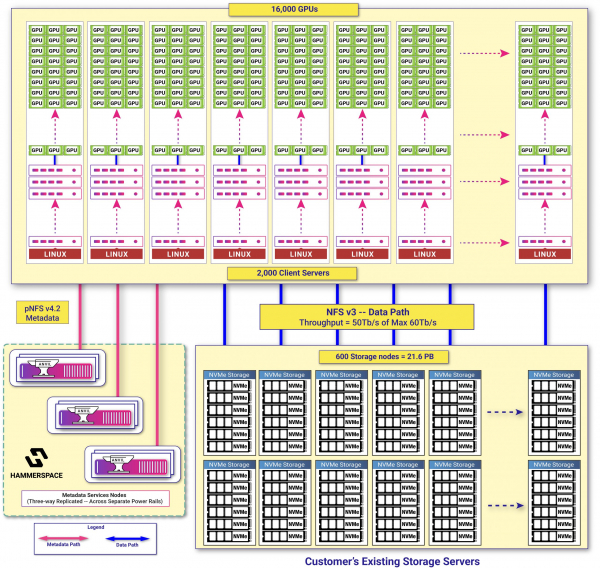

Изображение: Meta✴ Pure показала хорошие результаты в III квартале 2024 финансового года, завершившемся 5 ноября. Выручка выросла на 13 % в годовом исчислении до $762,8 млн, а прибыль составила $70,4 млн в то время, как год назад у компании были небольшие убытки. Вместе с тем Pure прогнозирует в IV квартале снижение выручки год к году на 3,5 % до $782 млн. Снижение показателя объясняется переходом на подписку, а также отсрочкой поставок на $41 млн. По словам Blocks & Files, Meta✴, а это один из крупных заказчиков Pure Storage, не вполне довольна её СХД. Для обучения больших языковых моделей (LLM) Meta✴ строит кластеры из тысячи узлов хранения с суммарной пропускной способностью 100 Тбит/с, используя при этом L3-коммутацию без RDMA и NVMe-oF. Источник издания утверждает, что Meta✴, как и другим гиперскейлерами, нужна масштабируемая POSIX-совместимая файловая система на базе типовых серверов. Этим условиям удовлетворяет Hammerspace. Источники издания также сообщили, что решение VAST Data, которое как раз и базируется на типовых серверах и предлагает NVMe-oF, дорого и не может масштабироваться более чем на 30 узлов без заметного падения производительности.

04.02.2024 [21:02], Сергей Карасёв

Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis в качестве альтернативы решениям NVIDIA и AMDВ 2024 году компания Meta✴, по сообщению The Register, после многих лет разработки может начать массовое внедрение собственных ИИ-чипов. Они станут альтернативой ускорителям NVIDIA и AMD, что поможет снизить зависимость от продукции сторонних поставщиков. В 2024 году компания намерена потратить до $37 млрд на развитие своей инфраструктуры. В настоящее время для поддержания ИИ-нагрузок Meta✴ применяет такие решения, как NVIDIA H100. Ожидается, что к концу 2024 года компания будет иметь в своём распоряжении 350 тыс. этих ускорителей. Вместе с тем Meta✴ проявляет интерес и к изделиям AMD Instinct MI300. Ранее компания высоко оценила возможности Qualcomm Cloud AI 100, но отказалась от них из-за несовершенства ПО. Не приглянулись Meta✴ и чипы Esperanto. Сейчас Meta✴ ведёт разработку собственных ИИ-ускорителей.

Источник изображения: Meta✴ Весной 2023 года стало известно, что компания создала свой первый ИИ-процессор. Чип под названием MTIA (Meta✴ Training and Inference Accelerator; на изображении) представляет собой ASIC в виде набора блоков, функционирующих в параллельном режиме. Задействованы 64 вычислительных элемента в виде матрицы 8 × 8, каждый из которых объединяет два ядра с архитектурой RISC-V. Конструкция включает 128 Мбайт памяти SRAM, а также до 64/128 Гбайт памяти LPDDR5. Показатель TDP равен 25 Вт. Заявленная производительность на операциях INT8 достигает 102,4 TOPS, на операциях FP16 — 51,2 Тфлопс. Процессор производится по 7-нм технологии TSMC.

Источник изображения: Meta✴ Как теперь сообщается, в 2024-м Meta✴ намерена начать активное использование собственных ИИ-ускорителей с кодовым именем Artemis. В их основу лягут компоненты MTIA первого поколения. Чип Artemis, оптимизированный для инференса, будет применяться наряду с ускорителями сторонних поставщиков. При этом, как отметили представители компании, изделия Artemis обеспечат «оптимальное сочетание производительности и эффективности при рабочих нагрузках, специфичных для Meta✴».

Источник изображения: Meta✴ Компания пока не раскрывает ни архитектуру Artemis, ни конкретные рабочие нагрузки, которые будет поддерживать чип. Участники рынка полагают, что Meta✴ будет запускать готовые ИИ-модели на собственных специализированных ASIC, чтобы высвободить ресурсы ускорителей для развивающихся приложений. По данным SemiAnalysis, Artemis получит улучшенные ядра, а компоненты LPDDR5 уступят место более быстрой памяти, использующей технологию TSMC CoWoS. Нужно добавить, что Amazon и Google уже несколько лет используют собственные чипы для ИИ-задач. Например, Amazon недавно ИИ-ускорители Trainium2 и Inferenetia2, тогда как Google в 2023 году представила сразу два новых ускорителя: Cloud TPU v5p и TPU v5e. А Microsoft сообщила о создании ИИ-ускорителя Maia 100.

04.02.2024 [00:06], Сергей Карасёв

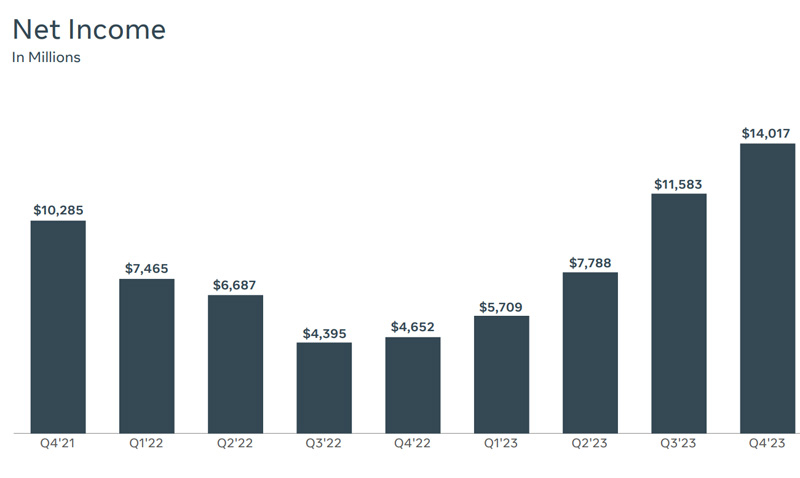

Meta✴ потратит в 2024 году до $37 млрд на развитие своей инфраструктуры, в основном для ИИMeta✴ отрапортовала о работе в IV квартале и 2023 финансовом году в целом, который был завершён 31 декабря. По ключевым показателям зафиксирован значительный рост, что корпорация связывает с успешной реализацией ряда инициатив, в том числе в области ИИ. Суммарная выручка за последнюю четверть 2023-го поднялась в годовом исчислении на 25 % — с $32,17 млрд до $40,11 млрд. Годовое значение увеличилось на 16 %, достигнув $134,90 млрд против $116,61 млрд в 2022-м. Чистая квартальная прибыль Meta✴ в годовом исчислении взлетела на 201 % — с $4,65 млрд до $14,02 млрд, а прибыль в пересчёте на одну ценную бумагу составила $5,33 (около $1,76 в IV квартале 2022-го). Годовая прибыль зафиксирована на отметке $39,10 млрд: это на 69 % больше по сравнению с 2022 годом, когда компания заработала $23,20 млрд. Прибыль на акцию поднялась с $8,59 до $14,87.

Источник изображения: Meta✴ Учитывая, что финансовые перспективы оказались лучше, чем ожидалось, Meta✴ сообщила о намерении увеличить капитальные затраты (CapEx) в 2024 году: они составят от $30 млрд до $37 млрд. Таким образом, верхняя граница поднялась на $2 млрд. Средства пойдут на развитие инфраструктуры. В частности, планируется закупка дополнительного оборудования, включая серверы, для обучения и поддержания работы ИИ-приложений. Кроме того, компания продолжит расширять экосистему своих дата-центров.

Источник изображения: Meta✴ Финансовый директор Meta✴ Сьюзан Ли (Susan Li) отмечает, что итоговая сумма капитальных затрат будет зависеть от спроса на услуги ИИ, а также от доступности компонентов. Речь идёт прежде всего о высокопроизводительных ускорителях на базе GPU. Компания также не исключает рост инвестиций в цифровую инфраструктуру после 2024 года. Отметим, что Meta✴ пересматривает архитектуру своих ЦОД в связи с повсеместным внедрением ИИ. Компания делает ставку на СЖО и новые средства управления питанием. Meta✴ также стремится использовать больше собственных чипов в дата-центрах, чтобы уменьшить зависимость от изделий таких поставщиков, как NVIDIA.

28.01.2024 [00:16], Сергей Карасёв

Meta✴ поселит свой ИИ в «зелёный» дата-центр стоимостью $800 млнКорпорация Meta✴, по сообщению Bloomberg, построит в Индиане (США) один из своих первых дата-центров, специально спроектированных для генеративного ИИ. Ожидается, что затраты на реализацию этого масштабного проекта составят приблизительно $800 млн. Об инициативе объявили губернатор штата Индиана и руководители Meta✴. ЦОД расположится в центре River Ridge в Джефферсонвилле, заняв площадь около 65 тыс. м2. Планируется, что объект будет получать питание исключительно от возобновляемых источников энергии. Дата-центр будет оснащён стойками высокой плотности. Говорится о применении собственных чипов и сторонних ускорителей. Серверы и сетевые компоненты будут использовать одну и ту же физическую инфраструктуру. Жидкостное охлаждение планируется реализовать по схеме Direct-to-chip.

Источник изображения: pixabay.com В процесс строительства ЦОД будут вовлечены около 1250 инженеров и рабочих. Запустить объект в эксплуатацию компания Meta✴ намерена к 2026 году. Он же даст работу примерно сотне высокооплачиваемых специалистов. По условиям соглашения с властями штата, Meta✴ получит 35-летнее освобождение от налога с продаж в Индиане. Причём этот срок может быть увеличен, если компания решит и дальше развивать свои кампусы ЦОД в регионе.

20.01.2024 [23:35], Сергей Карасёв

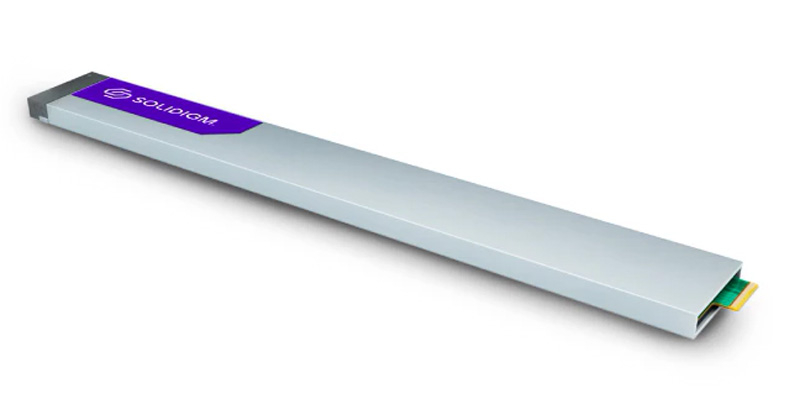

Solidigm начала продажи самого ёмкого в мирe NVMe SSD — 61,44 Тбайт стоят менее $4000Компания Solidigm, по сообщению TechRadar, начала приём заказов на самый вместительный в мире QLC NVMe SSD, предназначенный для применения в СХД высокой плотности для дата-центров. Речь идёт об изделии D5-P5336, способном вмещать 61,44 Тбайт информации. Устройство было представлено летом прошлого года. Оно имеет формат E1.L; задействован интерфейс PCIe 4.0 x4 (NVMe 1.4). В конструкции применены 192-слойные микрочипы флеш-памяти QLC 3D NAND. Стоит отметить, что данный накопитель является наиболее ёмким среди «обычных» NVMe SSD. Проприетарные решения Pure Storage DFM и IBM FlashCore предлагают до 75 Тбайт и до 114 Тбайт (с учётом компрессии) соответственно. Кроме того, существуют SATA-накопители Nimbus ExaDrive ёмкостью 64 Тбайт (QLC) и 100 Тбайт (TLC), которые три года назад оценивались в $11 тыс. и $40 тыс. соответственно.

Источник изображения: Solidigm D5-P5336 подходит для рабочих нагрузок с интенсивным чтением, таких как ИИ, машинное обучение, сети доставки контента и объектное хранилище. Заявленная скорость последовательного чтения данных достигает 7000 Мбайт/с, скорость последовательной записи — 3000 Мбайт/с. Величина IOPS при произвольном чтении блоками по 4 Кбайт, согласно техническим характеристикам, составляет до 1 005 000, при произвольной записи — до 43 800. Устройство может выдерживать 0,58 перезаписи в сутки (показатель DWPD), а значение MTBF составляет 2 млн часов. Энергопотребление в активном режиме равно 23 Вт, в режиме простоя — 5 Вт. Диапазон рабочих температур — от 0 до +70 °C. Отмечается, что накопитель D5-P5336 вместимостью 61,44 Тбайт доступен для заказа у ряда ретейлеров. Так, на площадке PCNation устройство можно приобрести по цене примерно $3975, тогда как Tech-America предлагает его за $3692 на момент написания материала. Производитель предоставляет на изделие пятилетнюю гарантию. |

|