Материалы по тегу: aws

|

21.09.2024 [21:02], Владимир Мироненко

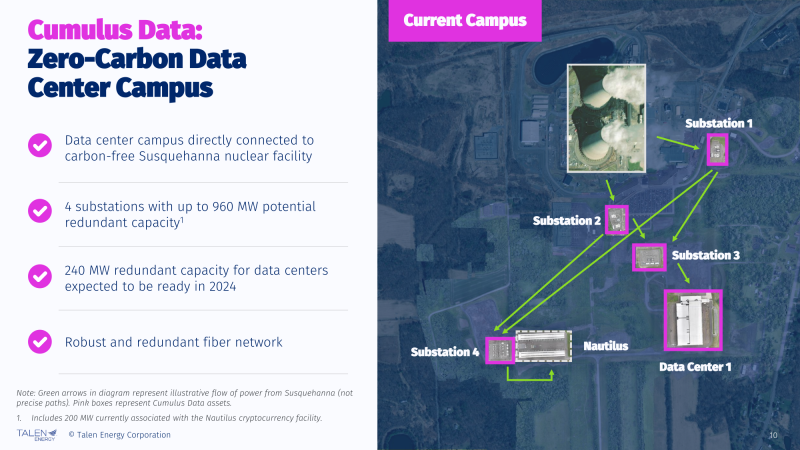

AWS ищет главного инженера-атомщика, который поможет запитать ИИ ЦОД от АЭС и SMRПосле приобретения у Talen Energy Corporation кампуса ЦОД у АЭС Susquehanna в Пенсильвании (США) компания Amazon Web Services (AWS) разместила на сайте вакансию главного инженера-атомщика, который будет отвечать за развитие малых модульных реакторов и налаживание отношения с традиционными АЭС, пишет DatacenterDynamics (DCD). Претендент на эту должность должен иметь опыт проектирования и эксплуатации как АЭС для коммунальных нужд, так и малых модульных реакторов (SMR). Указано, что он будет разрабатывать «внутренние и внешние стратегические планы по ядерным продуктам и топливу» для дата-центров AWS. Также претендент должен уметь проводить комплексную проверку «конкретных энергетических проектов». В его обязанности будет входить выстраивание отношений с Министерством энергетики США и регулирующими органами, а также работа с внешними партнёрами в рамках проектирования «эксплуатационно эффективных и безопасных модульных атомных электростанций» для поддержки растущих потребностей в энергии. В связи с ростом потребности в электроэнергии для ИИ ЦОД, AWS и другие облачные провайдеры обратились к сектору атомной энергетики. Как стало известно на днях, Microsoft заключила с крупнейшим оператором АЭС в США Constellation Energy 20-летний контракт на поставку электроэнергии (PPA) с АЭС Three Mile Island в Пенсильвании, которую вновь введут в эксплуатацию, а также сформировала целую команду по работе над атомной энергетикой и наняла целый ряд квалифицированных специалистов. По неофициальным данным, Microsoft будет платить за энергию порядка $800 млн/год. При этом начальные затраты только на восстановление работоспособности Three Mile Island составят $1,6 млрд. В апреле этого года Equinix подписала 20-летнее PPA-соглашение на поставку 500 МВт от модульных реакторов Oklo с возможностью его продления в дальнейшем. Спустя два месяца Wyoming Hyperscale (теперь Prometheus Hyperscale) подписала с Oklo PPA на 100 МВт. Кроме того, в этом месяце Oracle сообщила, что построит в США 1-ГВт кампус ЦОД с питанием от трёх малых модульных реакторов (SMR).

17.09.2024 [10:57], Руслан Авдеев

Intel будет выпускать для AWS кастомные Xeon 6 и ИИ-ускорителиIntel и Amazon Web Services (AWS) объявили о намерении совместно инвестировать в разработку и выпуск кастомных чипов в рамках многомиллиардного многолетнего проекта, в котором будет задействовано производство Intel. Пресс-служба компании сообщает, что расширение сотрудничества поможет клиентам AWS справиться почти с любыми рабочими нагрузками и повысить производительность ИИ-приложений. Intel будет выпускать ИИ-ускорители для AWS по техпроцессу Intel 18A в рамках инициативы AI Fabric, а также кастомные процессоры серии Xeon 6 по техпроцессу Intel 3. По словам руководства Intel и AWS, взаимодействие на новом уровне для работ в сфере ИИ и машинного обучения не только будут способствовать росту обеих компаний, но и обеспечат устойчивую цепочку поставок ИИ-решений непосредственно на территории США. При этом производственное подразделение Intel Foundry фактически превратится в независимую дочернюю компанию Intel. Заявление о расширенном сотрудничестве подкрепляет обязательства компаний по ускоренной организации производства полупроводников на территории США и созданию динамичной ИИ-экосистемы в Огайо. Intel по-прежнему планирует создание передовых производств полупроводников в этом штате (в районе Нью-Олбани), а AWS намерена вложить $7,8 млрд в расширение ЦОД в Центральном Огайо — помимо тех $10,3 млрд, которые уже инвестированы в штат с 2015 года. Власти Огайо приветствуют инициативу и предполагают, что это поможет укрепить позиции штата в качестве лидера ИИ-сферы и демонстрирует приверженность Intel развитию национальных производственных площадок, а AWS — инвестициям в штат в качестве оператора ЦОД. В AWS подчёркивают, что сотрудничество с Intel началось ещё в 2006 году с создания EC2-инстансов на чипах последней. История отношений Intel и AWS насчитывает более 18 лет. В дальнейшем компании намерены изучить потенциал новых разработок на основе техпроцесса Intel 18A, а также перспективных Intel 18AP и Intel 14A. Соответствующие технологии будут, как ожидается, внедряться на фабрике в Огайо, которую ещё предстоит построить. Правда, в своём пресс релизе Intel не преминула добавить стандартную приписку, что заявления относительно выгод и влияния сотрудничества на бизнес основаны на ожиданиях руководства компаний и влекут за собой «риски неопределённости», поскольку многие факторы находятся вне контроля партнёров.

13.09.2024 [11:07], Сергей Карасёв

AWS вложит $1,8 млрд в расширение инфраструктуры ЦОД в БразилииОблачная платформа Amazon Web Services (AWS), по сообщению Reuters, намерена инвестировать R$10,1 млрд (около $1,8 млрд) в развитие своей инфраструктуры ЦОД в Бразилии. Масштабная инициатива рассчитана на десять лет — до 2034 года. Средства, как отмечается, пойдут на «расширение, строительство, подключение, эксплуатацию и обслуживание дата-центров». В 2011–2023 гг. AWS уже вложила в создание экосистемы ЦОД в этой стране около R$19,2 млрд ($3,39 млрд). У AWS есть облачный регион в Сан-Паулу с тремя зонами доступности, который был запущен в 2011 году. Кроме того, развёрнуты edge-площадки в Рио-де-Жанейро, Сан-Паулу и Форталезе. В 2020 году компания объявила, что в течение следующих двух лет инвестирует $240 млн в свою бразильскую облачную инфраструктуру, хотя подробности о том, на что будут потрачены эти деньги, не разглашались. Другие ведущие облачные провайдеры также развивают инфраструктуру в Бразилии. В частности, Microsoft запустила регион São Paulo Azure (Brazil South) в Кампинасе (Campinas) в 2014 году. В 2021-м он был расширен до трёх зон доступности. В текущем году компания начала работу над дополнительными ЦОД в штате Сан-Паулу. В свою очередь, Google запустила бразильский облачный регион, также расположенный в Сан-Паулу, в 2017 году. А на днях принадлежащая DigitalBridge компания Scala Data Centers объявила о намерении построить огромный кампус ИИ ЦОД Scala AI City в бразильском штате Риу-Гранди-ду-Сул (Rio Grande do Sul).

11.09.2024 [16:25], Владимир Мироненко

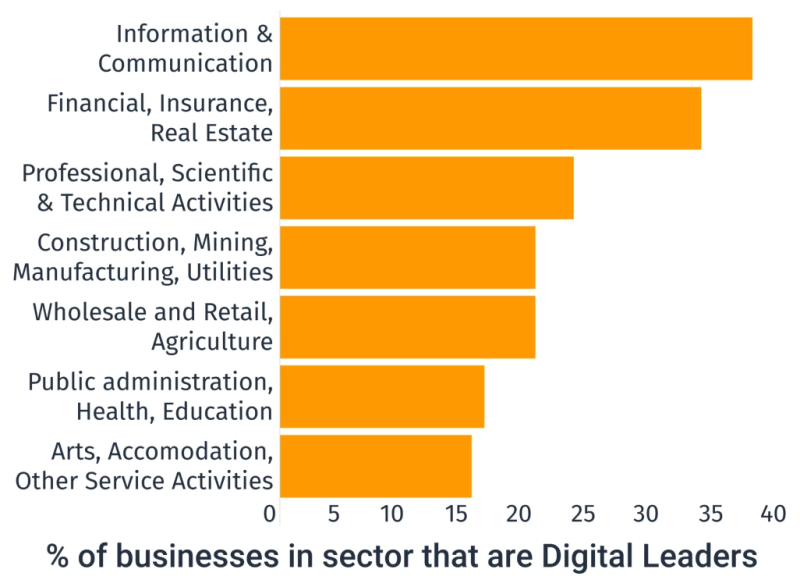

AWS инвестирует £8 млрд в расширение облачного бизнеса в ВеликобританииAmazon Web Services (AWS) объявила о планах инвестировать £8 млрд ($10,45 млрд) в 2024–2028 гг. в расширение своего облачного бизнеса в Великобритании. Компания отметила, что эти инвестиции являются частью её долгосрочных обязательств по поддержке роста и производительности в стране и, по оценкам, добавят £14 млрд в ВВП Великобритании до 2028 года, а также обеспечат в среднем более 14 тыс. рабочих мест на местных предприятиях из цепочки поставок ЦОД AWS. Amazon запустила свой первый облачный регион AWS в Великобритании в декабре 2016 года. За последние несколько лет компания добавила три зоны доступности (AZ), две зоны WaveLength Zone, две периферийных локации и Regional Edge Cache. За период с 2020 по 2023 год компания инвестировала в страну £3 млрд, обеспечив работой 6 тыс. жителей. Аналогичные долгосрочные инвестиционные проекты AWS запустила в Германии, Мексике, США, Саудовской Аравии и Сингапуре. AWS, крупнейший в мире поставщик услуг облачных вычислений и хранения данных, стремится с помощью инвестиций укрепить свои позиции на фоне растущей конкуренции со стороны Microsoft, которая наращивает собственную глобальную инфраструктуру. В пресс-релизе AWS отмечено, что инвестиции позволят Великобритании в полной мере воспользоваться растущими преимуществами облачных вычислений и ИИ. Согласно анализу Telecom Advisory Services, общее экономическое влияние облачных вычислений в Великобритании превысило £42 млрд в 2023 году. Это эквивалентно 1,6 % ВВП. И это больше, чем сектор автомобилестроения Великобритании. Как утверждает компания, облачные вычисления позволили стартапам, малому бизнесу и государственным органам получить доступ к тем же технологиям, которыми пользуются крупнейшие предприятия, и это помогло им быстрее внедрять инновации, сокращать расходы и конкурировать на мировой арене. Также AWS приводит результаты исследования независимой консалтинговой компании Public First, в рамках котороо она опросила более 2000 руководителей бизнеса и построила новую экономическую модель связей между цифровыми технологиями и производительностью бизнеса. Согласно опросу Public First, 84 % респондентов, являющихся клиентами AWS, заявили, что в результате инвестирования в облачную инфраструктуру они сэкономили средства, при этом в среднем экономия составила 28 % по сравнению с использованием локальной инфраструктуры. Респонденты также заявили, что использование AWS сокращает время развертывания нового ПО более чем на четверть (27 %). Кроме того, 82% клиентов AWS считают, что облачные вычисления позволили им вывести свой бизнес на глобальный уровень, а 85 % — облегчило конкуренцию с более крупными компаниями. В свою очередь, ресурс The Register отметил, что инвестиции облачного гиганта вовсе не бескорыстны. В прошлом году AWS увеличила доходы в Великобритании на 30,1 % до £3,78 млрд, а также получила на 76 % больше прямых доходов в государственном секторе от правительства Великобритании в течение предыдущего финансового года. В декабре прошлого года стало известно, что AWS получила контракт на услуги облачного хостинга для Министерства внутренних дел Великобритании на сумму почти полмиллиарда фунтов стерлингов (£450 281 369). Вместе с тем Amazon подверглась критике за недостаточную прозрачность в отношении налоговых выплат, поскольку доходы AWS UK были представлены как часть бюджета Amazon Web Services EMEA SARL. Газета Guardian сообщила в прошлом году, что материнская компания облачного гиганта Amazon второй год подряд не платила корпоративный налог после получения налоговых льгот на свои инвестиции в инфраструктуру. Также известно, что в Великобритании сейчас проводится антимонопольное расследование по поводу возможного применения AWS антимонопольных практик. Марк Буст (Mark Boost), генеральный директор британского оператора облачных вычислений Civo, подверг критике инвестиции AWS, заявив: «Дорогая инфраструктура ЦОД и оборудование ИИ <…> не производятся и не продаются британскими компаниями». «Британские новаторы в области ЦОД заслуживают справедливого шанса сыграть свою роль в цифровом будущем страны, без чрезмерной зависимости от гиперскейлеров исключительно из-за масштаба, который они могут предложить», — добавил он.

11.09.2024 [01:18], Владимир Мироненко

Oracle построит гигаваттный ИИ ЦОД с питанием от малых модульных реакторовАкции Oracle выросли во вторник более чем на 10 % после публикации отчёта за I квартал 2025 финансового года, завершившегося 31 августа. Выручка компании выросла на 7 % с $12,5 млрд годом ранее до $13,3 млрд при консенсус-прогнозе аналитиков, опрошенных FactSet, в $13,2 млрд. Скорректированная прибыль на акцию (Non-GAAP) составила $1,39 при прогнозе аналитиков $1,33. Выручка Oracle от облачных сервисов (IaaS и SaaS) выросла год к году на 21 % до $5,6 млрд. Выручка от лицензирования облачных продуктов увеличилась на 7 % до $870 млн, а выручка сегмента Cloud Infrastructure (IaaS) увеличилась на 45 % до $2,2 млрд. «Поскольку облачные сервисы стали крупнейшим бизнесом Oracle, рост как нашего операционного дохода, так и прибыли на акцию ускорился», — указала в пресс-релизе гендиректор Oracle Сафра Кац (Safra Catz). Чистая прибыль (GAAP) компании составила $2,9 млрд или $1,03 на акцию, по сравнению с $2,4 млрд или $0,86 на акцию годом ранее (рост — 21 %). Кац также сообщила в отчёте о заключении соглашения с AWS о размещении СУБД-инфраструктуры Oracle Database. AWS является крупнейшим поставщиком облачных сервисов по доле рынка. В отдельном пресс-релизе, посвящённом сделке, председатель и главный технический директор Ларри Эллисон (Larry Ellison) сообщил, что Oracle видит «огромный спрос» со стороны клиентов на работу с несколькими провайдерами облачных услуг. Таким образом, Oracle смогла склонить к сотрудничеству всё трёх ключевых игроков облачного рынка — ранее аналогичные сделки были заключены с Google и Microsoft. «Чтобы удовлетворить этот спрос и предоставить клиентам выбор и гибкость, которые им нужны, Amazon и Oracle бесшовно соединяют сервисы AWS с новейшей технологией Oracle Database, включая Oracle Autonomous Database», — сказал Эллисон. «Благодаря развёртыванию инфраструктуры Oracle Cloud внутри ЦОД AWS мы можем предоставить клиентам максимально возможную производительность базы данных и сети», — добавил он. Эллисон рассказал, что у Oracle есть 162 действующих и строящихся облачных ЦОД по всему миру. Самый большой из них имеет будет ёмкость 800 МВт, что позволит разместить множество кластеров ускорителей NVIDIA для обучения крупномасштабных моделей ИИ. А площадки для размещения ускорителей компании очень нужны, поскольку в отчётном квартале Oracle подписала 42 дополнительных контракта на облачные GPU на общую сумму $3 млрд, но не смогла заключить $10-млрд сделку с xAI. Однако это не предел и компания «скоро» начнёт строительство ЦОД мощностью более 1 ГВт. По словам Эллисона, для одного из этих проектов уже выбрано место, и он находится в процессе проектирования. ЦОД будет работать на атомной энергии, поскольку Oracle получила разрешение на три малых модульных ядерных реакторов (SMR). Аналогичные проекты разрабатываются с участием компании Oklo, поддерживаемой главой OpenAI Сэмом Альтманом (Sam Altman). Впрочем, последняя уже присматривается к термоядерной энергетике. Microsoft, тесно связанная с OpenAI, тоже изучает SMR. Amazon же не стала мудрствовать и просто приобрела кампус, напрямую запитанный от обычной АЭС. В текущем финансовом квартале компания ожидает получить скорректированную прибыль (Non-GAAP) в пределах $1,45–1,49 на акцию при росте выручки год к году на 7–9 %. Согласно консенсус-прогнозу аналитиков, опрошенных FactSet, скорректированная прибыль Oracle составит $1,48 на акцию.

06.09.2024 [12:04], Руслан Авдеев

AWS потратит $2 млрд на строительство новых ЦОД в ИндииIT-гигант Amazon Web Services (AWS) намерен инвестировать ещё $2 млрд в дата-центры в штате Телингана на юге Индии. По данным Datacenter Dynamics, гиперскейлер уже обсуждает с властями штата условия расширения своего парка ЦОД на данной территории. По словам представителя местных властей, Amazon проявила интерес к инвестициям $2 млрд в дата-центры в Телингане, причём они не ограничатся столицей штата — Хайдарабадом. В ходе обсуждений выяснилось, что компания намерена направлять инвестиции в следующие 4–5 лет, особый акцент будет сделан на строительстве ЦОД. Облачный регион AWS запустила в Хайдарабаде в ноябре 2022 года, а планы его создания обнародовали ещё в 2020 году. Всего компания рассчитывает вложить в город и штат $2,8 млрд. Планы расширения региона ЦОД в Хайдарабаде обнародовали в августе 2024 года, после визита представителей властей штата в Калифорнию для встречи с топ-менеджерами AWS. Местные власти сообщают, что основным драйвером расширения мощностей стали технологии ИИ. Amazon осознаёт их потенциал и готовит серьёзные вложения в регион. В свою очередь, Телинган готова предоставить многочисленные локации для новых кампусов.

Источник изображения: Motamarri Phani/unsplash.com В 2023 году сообщалось, что AWS намерена вложить почти $13 млрд в расширение в Индии облачной инфраструктуры. До этого в 2016 году в Мумбаи был запущен облачный регион с тремя зонами доступности.

23.08.2024 [16:00], Владимир Мироненко

Китайские компании нашли лазейку в законах США для доступа к передовым ИИ-ускорителям и моделям в облаках AWS и AzureГосударственные китайские организации используют облачные сервисы Amazon, Microsoft и их конкурентов для доступа к передовым американским чипам и технологиям ИИ, пишет Reuters со ссылкой на тендерную документацию, размещённую в общедоступных китайских базах данных. О попытках китайских компаний получить доступ к ИИ-ускорителям на территории США в условиях запрета на их поставки в Китай сообщалось и ранее. Правительство США ограничивает экспорт высокопроизводительных чипов ИИ в КНР в течение последних двух лет в связи с потенциальной возможностью их использования для укрепления военного потенциала Поднебесной. Однако предоставление доступа к таким чипам или передовым ИИ-моделям в облаках не является нарушением законодательства США, которым регулируется в данном случае только экспорт или передача товара, ПО или технологии, отметило Reuters. Согласно 50 тендерным документам, с которыми ознакомилось агентство, по крайней мере 11 китайских организаций пытались получить доступ к подпадающим под ограничение технологиям США или облачным сервисам. В четырёх случаях Amazon Web Services (AWS) явно названа поставщиком облачных услуг, хотя компании получили доступ к облачным услугам через посредников, а не напрямую у AWS. Таким образом, не только китайские компании обходят ограничения, но и американские компании извлекают выгоду из растущего в Китае спроса на вычислительные мощности. «AWS соблюдает все применимые законы США, включая торговые законы, в отношении предоставления услуг AWS внутри и за пределами Китая», — заявил представитель облачного бизнеса Amazon. По данным Synergy Research Group, AWS контролирует почти треть мирового рынка облачной инфраструктуры. А согласно данным исследовательской компании IDC, AWS является в Китае шестым по величине поставщиком облачных услуг. «Эта лазейка беспокоит меня уже годы, и нам давно пора её устранить», — заявил агентству Reuters председатель Комитета по иностранным делам Палаты представителей США Майкл Маккол (Michael McCaul), имея в виду удалённый облачный доступ иностранных субъектов к передовым вычислительным решениям США. В апреле в Конгресс США был внесён законопроект, дающий Министерству торговли полномочия регулировать удалённый доступ к технологиям США, но пока неясно, будет ли он принят и когда. В январе Министерство торговли США также предложило изменения в законодательства с требованием к сервисам облачных вычислений проверять пользователей крупных моделей ИИ и сообщать регулирующим органам об обучения крупных моделей ИИ, способных на «злонамеренную киберактивность». Поправки также дают ведомству право налагать запрет на доступ тех или иных клиентов. Но этот документ всё ещё находится в стадии доработки. Китайские организации также стремятся получить доступ к облачным сервисам Microsoft. Например, в апреле Сычуаньский университет указал в тендерной документации, что он создаёт платформу генеративного ИИ и закупает 40 млн токенов Microsoft Azure OpenAI. В мае токены поставила компания Sichuan Province Xuedong Technology Co Ltd. В связи с этим OpenAI сообщила Reuters, что её собственные сервисы не поддерживаются в Китае, а сервисы Azure OpenAI работает в соответствии с политикой Microsoft. Наконец, Институт перспективных исследований Сучжоуского университета науки и технологий Китая (USTC) сообщил в тендерной документации в марте этого года, что хотел бы арендовать 500 облачных серверов с восемью ускорителями NVIDIA A100 в каждом. Согласно апрельским документам, тендер был выполнен компанией Hefei Advanced Computing Center Operation Management Co Ltd, но в них не был указан поставщик облачных услуг, и Reuters не удалось его идентифицировать. USTC был добавлен Минторгом США в чёрный список Entity List в мае этого года из-за получения доступа к американской технологии квантовых вычислений, которая могла бы использоваться военно-промышленным комплексом Китая и помочь в развитии ядерной программы. Согласно тендерным документам, Amazon предоставляет китайским организациям доступ не только к передовым ИИ-чипам, но и к передовым моделям ИИ, таким как Claude от Anthropic, к которым они не могут получить доступ иным образом, пишет Reuters. Да и сама AWS в сообщениях на китайском языке подчёркивает возможность опробовать «модели ИИ мирового класса» и упоминает китайскую игровую фирму Source Technology как одного из своих клиентов, использующих Claude. После того как Reuters обратилось к Amazon за разъяснением, компания добавила в десятки постов на своих китаеязычных каналах примечание о том, что некоторые из услуг недоступны в китайских облачных регионах. Она также удалила несколько рекламных постов, включая пост об Source Technology.

23.08.2024 [12:51], Руслан Авдеев

AWS запустила облачный регион в МалайзииAmazon Web Services (AWS) объявила о запуске облачного региона в Малайзии. Как сообщают в компании, регион AWS Asia Pacific (Malaysia) Region с тремя зонами доступности получит идентификатор ap-southeast-5. Планами создания соответствующего региона впервые поделились в марте 2023 года, к 2037 году AWS обещает инвестировать в Малайзию $6 млрд — страна намерена конкурировать Сингапуром и стать новым региональными IT-хабом. Новый регион в Малайзии сыграет поворотную роль в поддержке стратегической инициативы Madani Economy Framework, направленной на улучшение жизненного уровня в стране к 2030 году и поддержку инноваций. В AWS считают, что новый облачный регион добавит около $12,1 млрд к ВВП Малайзии и будет поддерживать ежегодно в среднем 3500 рабочих мест на полную ставку в связанных «внешних» компаниях до 2038 года.

Источник изображения: Pexels/pixabay.com Amazon Web Services (AWS) присутствует в Малайзии с 2016 года, участвуя в проектах самого разного профиля, в том числе образовательных и экологических. Последние особенно активно поощряются. Сегодня компания строит объект в Сайберджая (Cyberjaya), к югу от Куала-Лумпура. В Азиатско-Тихоокеанском регионе действуют и другие облачные регионы AWS — в Сингапуре, Джакарте, Сеуле, Токио, Хайдарабаде, Мумбаи, Мельбурне, Осаке и Гонконге, а также в материковом Китае. Компания занимается строительством нового региона и в Таиланде. Основными хабами для ЦОД в Малайзии стали Куала-Лумпур, Джохор и Сайберджая. Microsoft также анонсировала планы создания региона в Куала-Лумпуре в апреле 2021 года, но он до сих пор не открылся. Google анонсировала планы строительства облачного региона в Малайзии в августе 2022 года, а также инвестицию на $2 млрд ранее в 2024 году. Участвуют другие гиперскейлеры и компании поменьше. Малайзия в последние годы активно инвестирует в бизнес ЦОД, пытаясь перетянуть к себе клиентов Сингапура, фактически установившего мораторий (с некоторыми послаблениями) на строительство ЦОД в 2019 году.

08.08.2024 [17:50], Руслан Авдеев

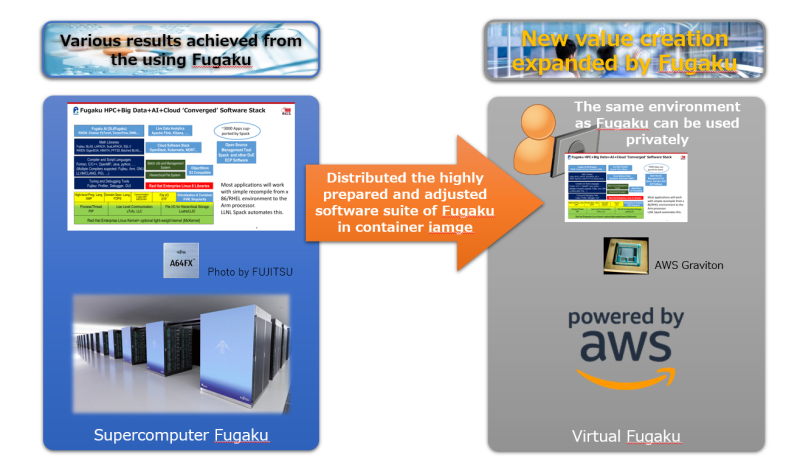

Виртуальный суперкомпьютер Fugaku теперь можно запустить в облаке AWSЯпонская научная группа RIKEN Center for Computational Science представила виртуальную версию принадлежащего ей Arm-суперкомпьютера, которую можно развернуть в облаке AWS. По данным The Register, суперкомпьютер считался самым производительным в мире в 2020 году, пока его не потеснила первая экзафлопсная машина Frontier двумя годами позже.

Источник изображения: RIKEN Центр намерен упростить желающим использование системы Fugaku, поэтому в RIKEN и решили создать виртуального двойника, способного работать в облаке или даже на суперкомпьютерах, принадлежащих другим компаниям. Представители центра сообщили, что построить машину из 160 тыс. узлов недостаточно, ведь необходимы ещё и программные решения. Другими словами, в облаке полностью воспроизвели программную HPC-экосистему Fugaku, которая включает массу оптимизированных для Arm пакетов и специализированного ПО. Первая версия Virtual Fugaku доступна в виде Singularity-образа. Она предназначена для запуска на Arm-процессорах Amazon Graviton3E, которые оптимизированы для задач HPC/ИИ. Как и процессоры Fujitsu A64FX, используемые в Fugaku, они предлагают инструкции Scalable Vector Extension (SVE). Основная ОС — RHEL 8.10. ПО собрано с использованием GCC 14.1 и библиотеки OpenMPI, которая поддерживает EFA. В Amazon крайне довольны выбором AWS в качестве базовой платформы для Virtual Fugaku. В будущем возможно портирование Virtual Fugaku и на другие архитектуры, но на какие бы платформы его ни перенесли, в RIKEN надеются, что инстансы «продолжат дело» своего родителя. Исследователи заявили, что результаты использования Fugaku, включая разработки, связанные с контролем заболеваний, созданием новых материалов и лекарств, хорошо известны. В ходе эксплуатации специалисты получили богатый опыт обращения с суперкомпьютером и намерены поделиться им с обществом. В RIKEN даже рассматривают Virtual Fugaku как стандартную платформу для использования программных HPC-решений — если суперкомпьютерные центры по всему миру примут этот формат, пользователи оценят богатство библиотеки ПО. Впрочем, некоторые эксперты считают, что такая концепция не вполне жизнеспособна — HPC-задачи часто связаны с использованием оборудования, оптимизированного под конкретные цели, поэтому маловероятно, что одна программная платформа подойдёт всем заинтересованным сторонам.

03.08.2024 [00:33], Владимир Мироненко

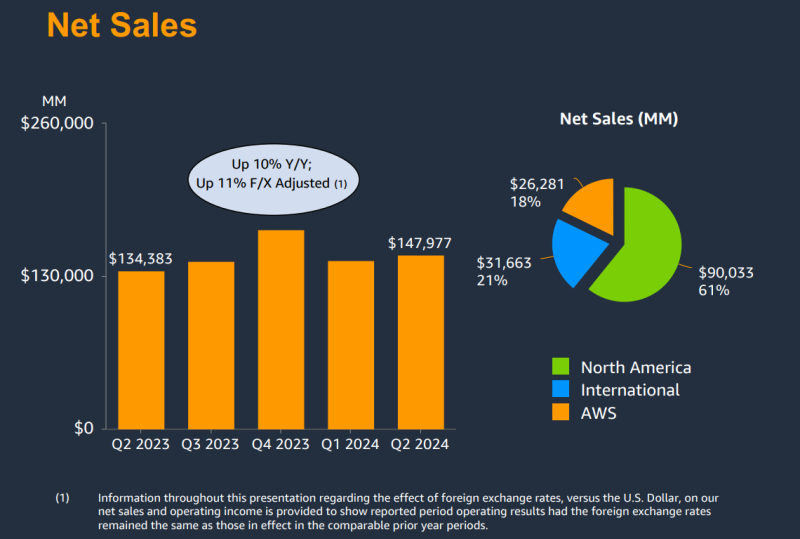

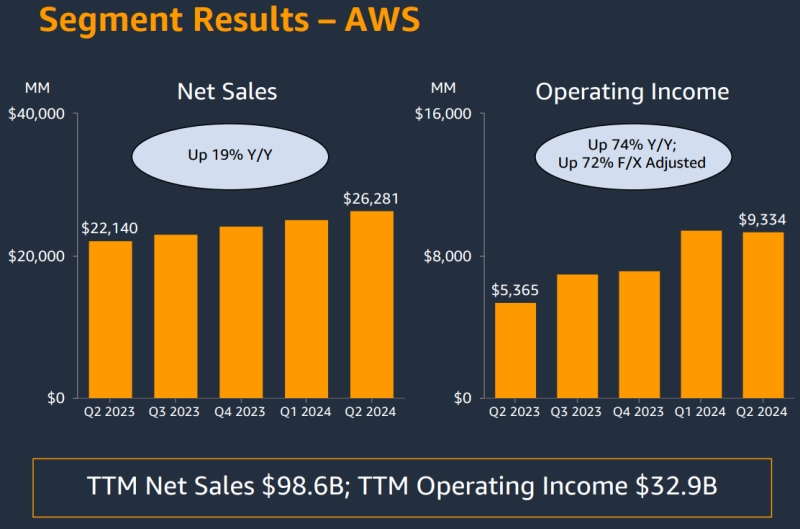

AWS увеличила выручку на 19 %, но по-прежнему отстаёт по темпам роста от Microsoft Azure и Google CloudКомпания Amazon.com, Inc. объявила результаты II квартала 2024 года, завершившегося 30 июня 2024 года. В связи с более низким, чем прогнозировали аналитики Уолл-стрит доходом, а также слабым прогнозом, акции компании упали на 6 % на расширенных торгах. Тем не менее, компания продолжает вкладывать всё больше средств в развитие облачной инфраструктуры, в том числе для ИИ-нагрузок. Выручка Amazon составила $147,98 млрд, превысив на 10 % показатель аналогичного периода прошлого года, равный $134,38 млрд. Вместе с тем выручка оказалась ниже консенсус-прогноза аналитиков, опрошенных LSEG, в размере $148,56 млрд. Операционная прибыль компании выросла до $14,67 млрд с $7,68 млрд годом ранее. Чистая прибыль увеличилась с $6,75 млрд ($0,65 на разводнённую акцию) в прошлом году до $13,48 млрд ($1,26 на разводнённую акцию) при консенсус-прогнозе аналитиков Уолл-стрит $1,03 на разводнённую акцию. Облачное подразделение Amazon Web Services (AWS) увеличило продажи год к году на 19 % до $26,28 млрд за квартал с $22,14 млрд годом ранее при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в размере $26,0 млрд. Операционная прибыль увеличилась с $5,36 млрд во II квартале 2023 года до $9,33 млрд. Хотя AWS превзошло прогнозы аналитиков по выручке, темпы роста у него ниже чем у облачных подразделений Microsoft и Google, увеличивших продажи на 29 %. Впрочем, объявленные ими цифры включают не только облачную инфраструктуру. В связи с высоким спросом на технологии ИИ Amazon тратит значительные суммы на расширение своей облачной инфраструктуры AWS. Капитальные затраты Amazon и лизинг составили $30,5 млрд за I половину года, и ожидается, что эта цифра вырастет во II половине года, говорит финансовый директор Amazon Брайан Олсавски (Brian Olsavsky). «Большая часть расходов будет направлена на поддержку растущей потребности в инфраструктуре AWS, поскольку мы по-прежнему видим высокий спрос как на генеративный ИИ, так и на негенеративный ИИ», — цитирует ресурс GeekWire его слова. Amazon прогнозирует выручку в текущем квартале в диапазоне от $154 до $158,5 млрд, что представляет собой рост на 8–11 % в годовом исчислении. Средняя точка этого диапазона, $156,25 млрд, отстаёт от средней оценки аналитиков, опрошенных LSEG, в $158,24 млрд. |

|