Материалы по тегу: ии

|

09.07.2025 [16:30], Руслан Авдеев

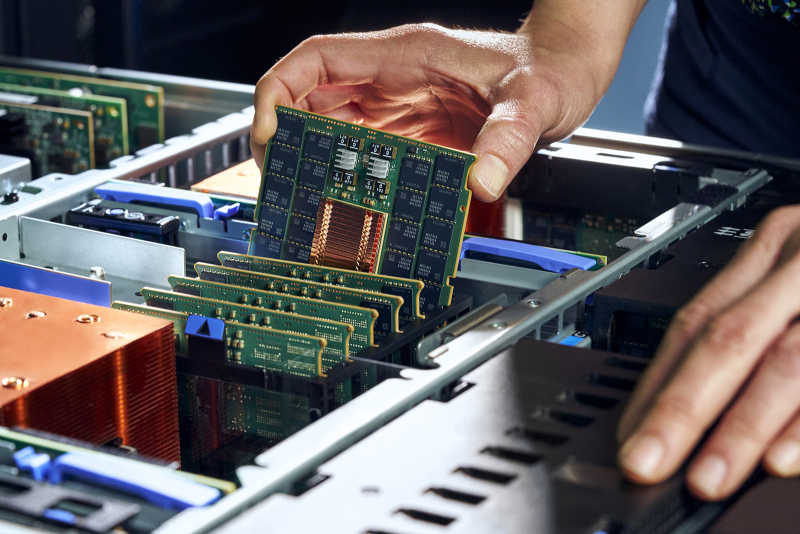

SambaManaged превратит почти любой ЦОД в ИИ ЦОД всего за три месяцаРазработчик ИИ-ускорителей SambaNova анонсировал решение SambaManaged на базе SN40L. Это первый в отрасли продукт, оптимизированный для инференса, внедрить который можно всего за 90 дней — намного быстрее, чем обычно требуется для систем такого уровня (18–24 мес.), говорит компания. Модульная платформа разработана специально для быстрого развёртывания и позволяет существующим дата-центрам почти немедленно организовать ИИ-инференс с минимальными модификациями инфраструктуры. По мере того, как стремительно растёт спрос на ИИ-задачи, связанные именно с инференсом, традиционные дата-центры сталкиваются с новыми проблемами — на внедрение систем, оптимизированных для таких задач, требуется от полутора до двух лет, много энергии, а также дорогостоящие обновления оборудования. Решение SambaManaged позволяет устранить эти барьеры, быстро развернув прибыльные инференс-сервисы, используя уже имеющуюся силовую и сетевую инфраструктуру. SambaManged формируется из стоек SambaRack SN40L-16, каждая из которых включает 16 ускорителей (RDU в терминологии SambaNova) SN40L с BF16-производительностью 10,2 Тфлопс. Платформа оснащена двумя 64-ядерными хост-процессорами, 2 Тбайт DDR4, четырьмя загрузочными 960-Гбайт SSD (RAID1 + два hot-spare) и шестью 7,6-Тбайт NVMe SSD в RAID10 для данных. Энергопотребление составляет всего 7–14,5 кВт (типовое 10 кВт). Стойка весит 485 кг. Рабочая температура — от +15 до +30 °C. Фактически это переименованная платформа DataScale SN40L, только теперь разработчик не говорит о возможности обучения моделей. Как подчёркивают в SambaNova, дата-центры сталкиваются с проблемами энергоснабжения и охлаждения, недостатком компетенций и др. на фоне роста спроса на ИИ. Система SambaManaged обеспечивает высокую ИИ-производительность при низком энергопотреблении и минимальных изменениях инфраструктуры. Преимуществами для ЦОД и облачных провайдеров называются рекордная производительность на каждый затраченный Вт, позволяющая снизить совокупную стоимость владения (TCO) и быстрее вернуть инвестиции. Систему можно внедрить всего за 90 дней. При этом обеспечивается невероятно быстрый инференс с ведущими open source моделями, что позволяет избежать привязки к конкретному вендору и гарантирует совместимость с будущими технологиями. Модульный дизайн позволяет быстро строить даже большие инференс-системы, включая т.н. Token Factory мощностью до 1 МВт (100 стоек). Систему можно масштабировать по мере изменения бизнес-потребностей. Можно выбрать полностью управляемое решение или взять на себя часть контроля за операциями. SambaManaged уже внедряется крупной публичной компанией в США, потребляющей немало энергии. Платформа обеспечивает максимальную пропускную способность для моделей вроде DeepSeek и ей подобных, помогая клиентам увеличивать доход от инференса и оптимизировать энергоэффективность (PUE). В SambaNova заявляют, что SambaManaged меняет правила игры для организаций, желающих ускорить реализацию ИИ-проектов без ущерба скорости, масштабу или эффективности. Везде, где есть доступ к Сети и электроэнергии, можно обеспечить необходимую инфраструктуру в рекордные сроки. В конце июня 2025 года сообщалось, что SambaNova делает ставку на инференс и партнёрство с облачными провайдерами и госзаказчиками из США. Groq, ещё один поставщик решений для инференса, первым сменил бизнес-подход, отказавшись от продажи ускорителей в пользу формирования целых ИИ ЦОД. Cerebras совместно с партнёрами также создаёт крупные ИИ-суперкомпьютеры и кластеры.

09.07.2025 [14:35], Владимир Мироненко

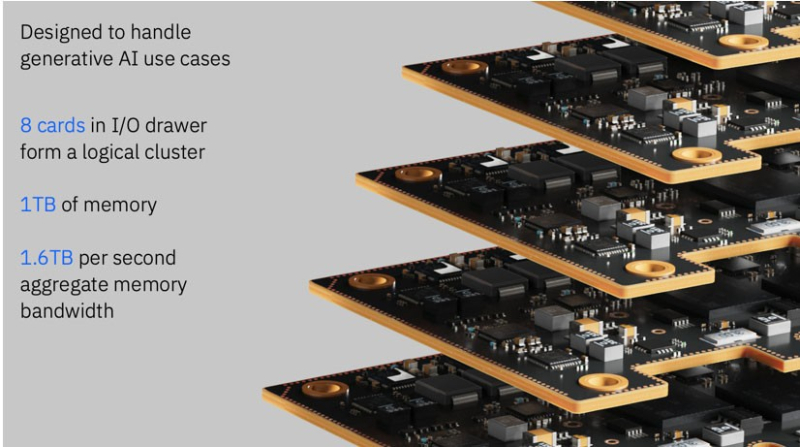

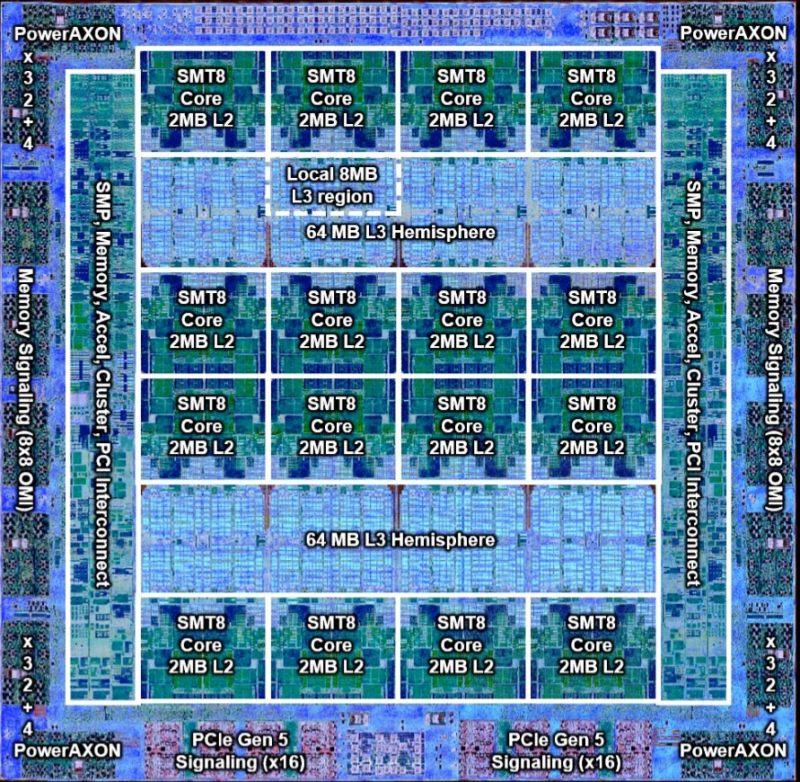

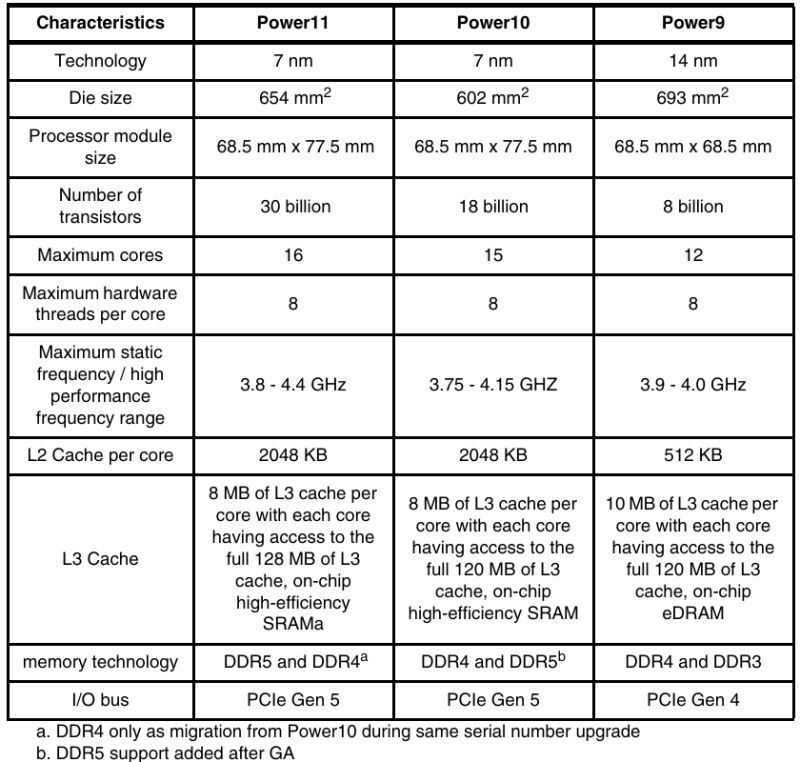

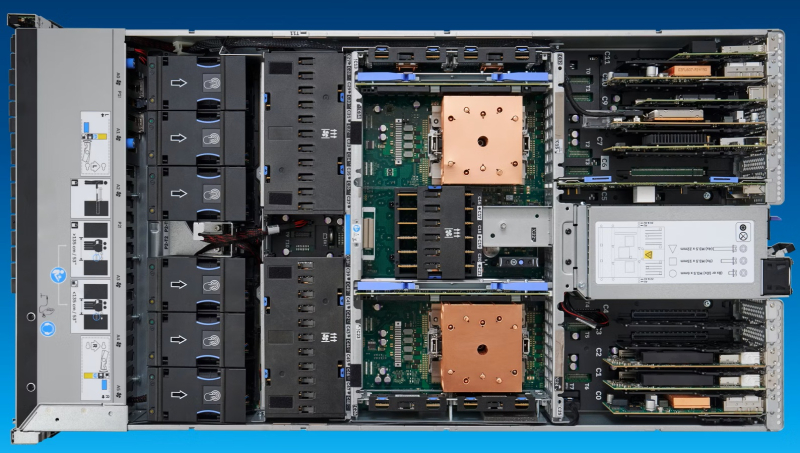

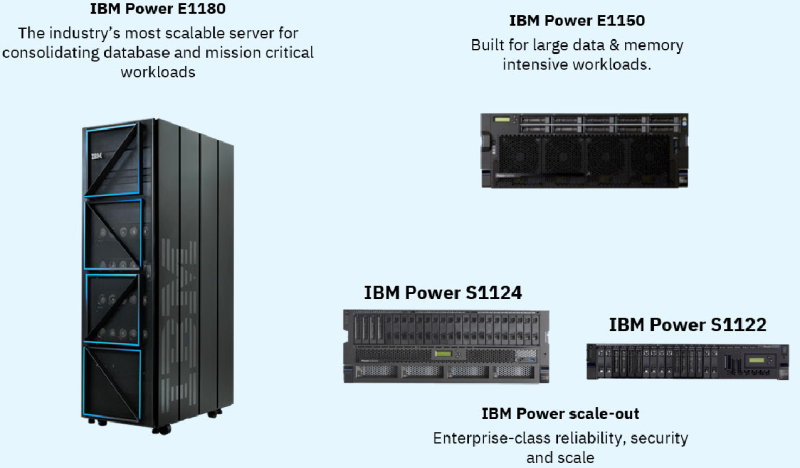

256 ядер, 2048 потоков и 64 Тбайт DDR5: IBM анонсировала «бесперебойные» серверы POWER11IBM представила серверы POWER11, получившие усовершенствованные процессоры, аппаратную архитектуру и программный стек виртуализации. Как заявила компания, POWER11 разработаны для обеспечения доступности, отказоустойчивости, производительности и масштабируемости, которые требуются предприятиям для бесшовного гибридного развёртывания on-premise или в облаке IBM Cloud. POWER11 представляет собой самый отказоустойчивый сервер в истории платформы IBM POWER с доступностью на уровне 99,9999 %, заявляет компания. Вместе с нулевым запланированным простоем для обслуживания системы и менее чем одной минутой гарантированного обнаружения угроз программ-вымогателей с помощью IBM POWER Cyber Vault, POWER11 устанавливает новую планку непрерывности ведения бизнеса, говорит IBM. Впервые общедоступная версия POWER11 будет одновременно включать высокопроизводительные серверы, модели среднего и начального уровня, а также решение IBM POWER Virtual Server (POWERVS) в IBM Cloud, обеспечивающее быстрый доступ в облако для рабочих нагрузок POWER и сертифицированное как гипермасштабируемая платформа для пакета RISE with SAP. POWER11 также является первым сервером семейства IBM POWER, поддерживающим 32-ядерные 5-нм ИИ-ускорители IBM Spyre Accelerator, которые будут доступны в IV квартале 2025 года. Они же используются в семействе мейнфреймов IBM z17. Процессор POWER11 изготавливается по 7-нм техпроцессу Samsung с использованием 18 слоёв металла и 2.5D-упаковки. Чип состоит из 30 млрд транзисторов, площадь кристалла, как и у предшественника, составляет 602 мм2. Процессор имеет 16 вычислительных ядер с поддержкой SMT8 15. Каждое ядро получило четыре блока MMA (Matrix Math Accelerator) для задач инференса. Как отмечает IT Jungle, в отличие от POWER10, 16-е ядро теперь является запасным, и может быть активировано в случае нештатной ситуации. Объём кеша L2 составляет 2 Мбайт на ядро, объём кеша L3 — 8 Мбайт на ядро, но суммарный объём L3 — до 120 Мбайт. Интерфейс POWERAXON/OMI обеспечивает пропускную способность до 2 Тбайт/с (32 ГТ/с). Возможна установка до 64 Тбайт DDR5 в модулях DDIMM, но в некоторых случаях осталась поддержка DDR4. Доступны 64 линии PCIe 5.0 и SMP-соединение для объединения до 16 сокетов. Для расширения доступны дисковые полки (24 × NVMe) и шасси с PCIe-слотами. Для обеспечения гибкости и масштабируемости POWER11 использует разные способы упаковки. Для высокопроизводительного сервера POWER E1180 задействован одночиповый вариант Single Chip Module (SCM), который обеспечивает один чип на сокет и до шестнадцати сокетов на систему. Для сервера среднего уровня POWER E1150 использовалась упаковка с двумя чипами на сокет Dual Chip Module (DCM) с поддержкой до четырёх сокетов на систему. Версия DCM также используется в линейке масштабируемых серверов POWER S1122/L1122 и POWER S1124/L1124 с двумя сокетами на систему. Также есть третий вариант упаковки — Single Core Module (eSCM), который используется для систем начального уровня POWER S1122 (4 или 10 ядер). POWER11 обеспечивает до 55 % более высокую производительность ядер по сравнению с POWER9 и до 45 % большую ёмкость с большим количеством ядер в системах начального и среднего уровня по сравнению с POWER10. Благодаря этому с POWER11 предприятия получат повышенную гибкость и безопасность, что повысит эффективность корпоративных процессов за счёт автоматизации, говорит IBM. Нулевой запланированный простой для обслуживания системы. POWER11 позволяет избежать дорогостоящего запланированного простоя и помочь снизить операционный риск. Благодаря использованию таких технологий, как автономное исправление и автоматизированное перемещение нагрузок, запланированные события по обслуживанию системы могут происходить без остановки критически важных приложений. Кроме того, IBM POWER будет взаимодействовать с IBM Concert, используя генеративный ИИ, чтобы помочь выявить операционные риски и автоматизировать их исправление, в том числе в области безопасности. Обнаружение угроз программ-вымогателей менее чем за минуту достигается с помощью IBM POWER Cyber Vault, интегрированного решения по обеспечению киберустойчивости, которое соответствует стандартам NIST. Cyber Vault умеет идентифицировать и автоматически реагировать на киберугрозы, защищая от кибератак, таких как повреждение данных и шифрование, с помощью проактивных неизменяемых снимков, которые автоматически создаются, сохраняются и тестируются по заданному пользователем расписанию. POWER 11 также использует одобренную NIST встроенную квантово-безопасную криптографию, предназначенную для защиты систем от атак с отложенной расшифровкой (HNDL) и атак на целостность встроенного ПО. IBM также отметила, что POWER11 обеспечивает значительный рост эффективности во всём ИТ-стеке. С точки зрения энергоэффективности POWER11 предлагает вдвое большую производительность на Вт (SPECint2017_rate) по сравнению с сопоставимыми x86-серверами — до двух раз в случае Intel Xeon Emerald Rapids. Кроме того, теперь разница в энергопотреблении между режимами максимальной производительности и режимом энергосбережения достигает 28 %, при этом пропускная способность падает всего на 6 %. Как утверждает ресурс StorageReview.com, этот режим будет полезен для сред разработки и тестирования с интенсивной загрузкой CPU. Вариант с прямым жидкостным охлаждением поддерживает 75 кВт на стойку (64 сокета в 42U), по сравнению с примерно 28 кВт для аналогичных x86-систем с воздушным охлаждением. Ожидается, что серверы IBM POWER11 — POWER E1180 (до 256 ядер, до 64 Тбайт DDR5), POWER E1150 (до 120 ядер, до 16 Тбайт DDR5), POWER S1124 (до 60 ядер, до 8 Тбайт DDR5) и POWER S1122 (до 60 ядер, до 4 Тбайт DDR5) поступят в продажу 25 июля.

08.07.2025 [14:55], Руслан Авдеев

Groq запустила свой первый европейский ЦОД в ХельсинкиКомпания Groq, предлагающая сервисы ИИ-инференса, объявила о расширении своей сети дата-центров, открыв свой первый в Европе ЦОД в Хельсинки (Финляндия). Это поможет удовлетворить растущие потребности европейских клиентов, сообщает пресс-служба компании. Как заявил глава Groq Джонатан Росс (Jonathan Ross), спрос на ИИ-инференс растёт всё быстрее, а европейский дата-центр позволит местным клиентам получить минимальную задержку и готовую инфраструктуру для инференса уже сегодня. Кроме того, данные хранятся на территории Европы. Новый объект создан в Хельсинки на площадке Equinix. Партнёрство Equinix и Groq позволяет клиентам Equinix Fabric организовать инференс на платформе GroqCloud. Новые и действующие пользователи в США и EMEA получат доступ к мощностям для инференса через инфраструктуру Equinix Fabric — публичную, частную или суверенную. В Equinix подчеркнули, что Скандинавия — отличное место для ИИ-инфраструктуры. Благодаря политике поддержки экоустойчивой энергетики, возможности использования фрикулинга для охлаждения и надёжности электросети Финляндия стала приоритетным выбором для размещения новых мощностей. Европейские государственные и негосударственные структуры рассчитывают получить полный контроль над развёртываемой инфраструктурой, в местах, которые выбирают они сами — они пытаются сохранить баланс между потребностью в обеспечении суверенитета данных и защиты их конфиденциальности и обеспечением мобильности этих данных. Благодаря новому проекту клиенты могут получать доступ к GroqCloud через частные подключения. Экспансия в Европе расширяет мощности Groq на площадках Equinix и DataBank в США, Bell Canada в Канаде и HUMAIN в Саудовской Аравии. Они уже генерируют более 20 млн токенов в секунду по всей сети Groq. В некоторой степени это отражает спрос на ИИ-ускорители Groq LPU (Language Processing Unit). Чуть более года назад Groq объявила, что больше не продаёт свои ИИ-ускорители, предлагая вместо этого совместно создавать ЦОД и облачные сервисы. Как заявляют в Groq, компания обеспечивает самую низкую стоимость за токен без ущерба качеству, что делает масштабное использование ИИ экономически выгодным как для ИИ-стартапов, так и для крупных корпораций по всему миру.

08.07.2025 [09:44], Руслан Авдеев

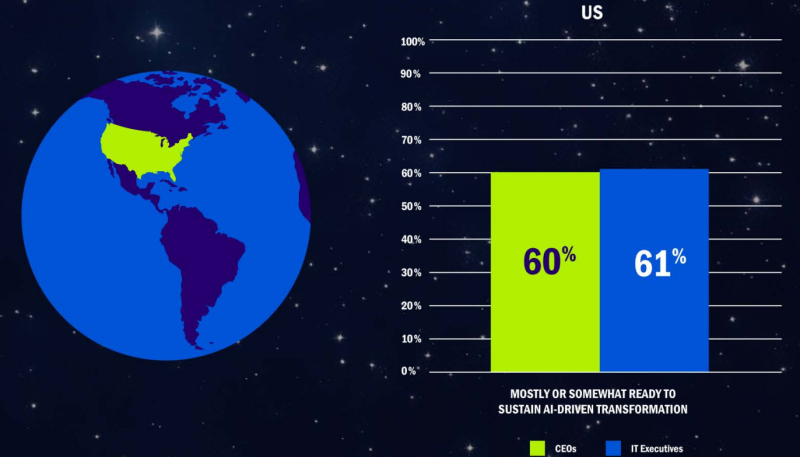

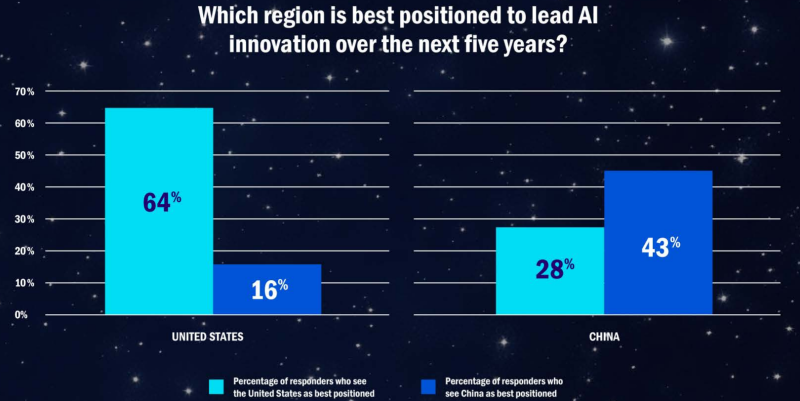

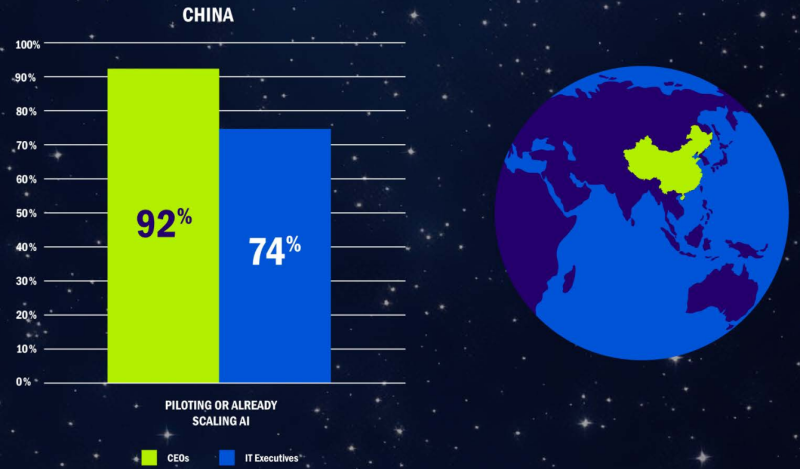

В гонке за лидерство в сфере ИИ поможет инфраструктура, а не хайпВ докладе AI Space Race («Космическая гонка ИИ») NetApp собрала мнения топ-менеджмента компаний нескольких стран относительно возможности стать лидерами в сфере ИИ-инноваций. Судя по представленным данным, для победы игрокам потребуется развитая ИИ-инфраструктура. Выводы вполне ожидаемые для поставщика подобных решений, сообщает Blocks & Files. В представленном материале гонка за лидерство в сфере ИИ сравнивается с космической гонкой с участием СССР и США 1960-х годов, когда государства активно инвестировали в научные изыскания и инновации. Предполагается, что результат «космической гонки» в сфере ИИ определит мироустройство на десятилетия вперёд. NetApp опросила 400 генеральных директоров и IT-руководителей из китайских, индийских, британских и американских компаний в мае текущего года. 43 % из них заявили, что в следующие пять лет лидером в сфере ИИ будут США. Гораздо меньше из них сделали ставку на Китай, Индию или Великобританию. В докладе сообщается, что 92 % китайских генеральных директоров сообщили об активной реализации ИИ-проектов, но только 74 % китайских IT-руководителей согласны с ними. В США 77 % CEO доложили об активных ИИ-проектах, а едины с ними во мнениях 86 % IT-руководителей.

Источник изображений: NetApp Другими словами, в Китае отмечается критическое несоответствие мнений CEO и IT-руководителей, что может ослабить потенциал в КНР в будущем. Успешная реализация проектов зависит не только от амбиций руководства, но и от согласованности реализации ИИ-стратегий на разных уровнях. Тем не менее, не исключается, что китайские организации просто активнее реализуют ИИ-проекты под патронажем CEO, опережая в этом США. Ещё одно отличие Китая от других стран в том, что КНР делает ставку на масштабируемость — 35 % компаний фокусируются на этом (против 24 % в среднем по миру), что отражает стремление к быстрому развёртыванию ИИ-решений. Другие страны больше ориентированы на интеграцию — встраивание ИИ в существующие системы и процессы. Безопасность и иные факторы оказались наименее важными для всех участников опроса — лишь 10 % директоров и IT-руководителей считают эти вопросы приоритетными. Утверждается, что больше респондентов считают, что США, а не Китай в долгосрочной перспективе будут лидировать в сфере ИИ. 64 % респондентов в США назвали Соединённые Штаты вероятным лидером в ИИ-инновациях в следующие пять лет, в среднем в мире на США делают ставку 43 % респондентов (считая и американских). В Китае будущим лидером считают родину 43 % опрошенных, и только 22 % от общего числа респондентов. У Индии и Великобритании ситуация ещё хуже. Эти страны считают будущими лидерами 40 % и 34 % местных респондентов соответственно. В целом по миру шансы Индии и Соединённого Королевства стать лидерами дают 16 % и 19 % от всех опрошенных соответственно. Главным драйвером для внедрения ИИ CEO и IT-руководители видят необходимость использования ИИ для принятия решений и сохранения конкурентоспособности (26 %). Индия (29 %) и Великобритания (32 %) ощущают необходимость догонять явных лидеров — США и КНР. Примечательно, что в Китае одним из главных драйверов является реальный пользовательский спрос (21 % против 13 % в среднем по миру). На деле речь идёт о практическом внедрении 83% пилотных решений и программ в Китае против 81% в мире (разница не очень большая). 51 % респондентов назвали собственные организации конкурентоспособными в сфере ИИ, но, похоже, никто не видит себя безусловным лидером. 88 % считают, что их организации в основном или полностью готовы поддержать ИИ-трансформацию, а 81 % уже реализуют пилотные ИИ-проекты или масштабируют ИИ. В NetApp пришли к выводу, что одним из важнейших факторов успеха в новой «космической гонке» будет наличие инфраструктуры и эффективное управление данными при поддержке гибких, безопасных и масштабируемых облачных решений. Просто «хайп» не поможет вне зависимости от размера компании, отрасли, её местоположения и др. Хотя по материалам NetApp очевидно, что ключевым поставщиком инфраструктуры компания видит себя, в Blocks & Files напоминают, что сильные позиции занимают и другие игроки в разных сферах, включая Dell, HPE, IBM, Pure Storage, VAST Data и др. — они также активно развивают решения для хранения неструктурированных данных, векторных баз данных и интеграции с ускорителями NVIDIA. Особое внимание уделяется технологиям вроде GPUDirect, IO500-оптимизированным системам, а также поставщикам систем резервного копирования и облачных файловых сервисов, которые всё чаще внедряют ИИ в свои продукты. Кроме того, практически все крупные IT-игроки вообще — от поставщиков баз данных до гигантов вроде Huawei активно развивают ИИ-направление, часто в партнёрстве с NVIDIA. Это связано с тем, что любое отставание в поддержке ИИ-инициатив клиентов может привести к потере целых направлений в пользу конкурентов. За пределами США значительную роль играют китайские вендоры, например, всё та же Huawei, что только усиливает глобальную конкуренцию. В июне учёные Оксфордского университета пришли к выводу, что в обозримом будущем недоступность ИИ-инфраструктуры усилит цифровое, экономическое и политическое неравенство.

08.07.2025 [00:23], Владимир Мироненко

CoreWeave всё-таки купила оператора ЦОД Core Scientific, но в девять раз дороже, чем когда-то планировалаCoreWeave объявила о приобретении Core Scientific, поставщика инфраструктуры ЦОД, за $9 млрд. Благодаря этой сделке CoreWeave получит 1,3 ГВт мощности ЦОД Core Scientific с возможностью добавления более чем 1 ГВт. Год назад CoreWeave уже пыталась купить Core Scientific за $1 млрд, но та посчитала предложенную сумму слишком маленькой. В итоге CoreWeave постепенно нарастила аренду мощностей, став ключевым клиентом Core Scientific. Согласно условиям сделки, акционеры Core Scientific получат 0,1235 новых выпущенных акций CoreWeave класса A за каждую акцию Core Scientific на основе фиксированного обменного коэффициента. Выплата производится исходя из стоимости обыкновенных акций CoreWeave класса A по состоянию на 3 июля 2025 года и премии примерно в 66 % к стоимости акции Core Scientific по состоянию на 25 июня текущего года. Окончательная стоимость сделки будет определена во время её завершения, которое ожидается в IV квартале 2025 года. По оценкам CoreWeave, после закрытия сделки доля акционеров Core Scientific в объединённой компании составит менее 10 %. «Это приобретение ускоряет реализацию нашей стратегии по масштабированию рабочих нагрузок ИИ и HPC», — заявил Майкл Интратор (Michael Intrator), генеральный директор, председатель совета директоров и соучредитель CoreWeave. После объявления о сделке, акции CoreWeave упали на 4,4 % в ходе предварительных торгов в Нью-Йорке, пишет Bloomberg. Акции Core Scientific потеряли в цене 14 %. Core Scientific, как и сама CoreWeave, ранее предлагавшая услуги майнинга, сейчас на фоне дефицита мощностей ЦОД и сложности с их обеспечением электроэнергии из-за бума ИИ-технологий решила выйти за рамки криптовалютного рынка. Согласно прогнозу JPMorgan от октября прошлого года, у криптомайнеров осталось всего девять месяцев, чтобы переключиться на ИИ.

Источник изображения: Core Scientific Согласно пресс-релизу CoreWeave, компания рассчитывает получить значительную экономию средств путём оптимизации бизнес-операций и устранения накладных расходов на аренду ЦОД. Также отмечено, что возможности создания дата-центров Core Scientific дополняют и расширяют обширный опыт CoreWeave в области закупок электроэнергии и земли, строительства и управления инфраструктурными активами. Попутно CoreWeave сокращает зависимость от других колокейшн-партнёров. Как отметил ресурс The Register, у Core Scientific есть десять кампусов ЦОД разной степени готовности в Алабаме, Джорджии, Кентукки, Северной Каролине, Северной Дакоте, Оклахоме и Техасе. Около 500 МВт из 1,3 ГВт имеющихся у Core Scientific мощностей ЦОД в настоящее время потребляются майнинговыми установками. Ещё 590 МВт было выделена CoreWeave в аренду. Провайдеры облачной инфраструктуры спешат расширять свои ЦОД, чтобы идти в ногу со спросом на вычислительные мощности компаний в сфере ИИ, отметил Bloomberg. На прошлой неделе ресурс сообщил, что Oracle дополнительно арендует у Oracle 4,5 ГВт мощностей ЦОД в США. В свою очередь, CoreWeave заключила в начале июня соглашение с Applied Digital об аренде сроком на 15 лет 250 МВт ЦОД за $7 млрд в кампусе в Эллендейле (Ellendale, Северная Дакота). Ещё 200 МВт CoreWeave получила от Galaxy Digital, которая тоже отказалась от криптомайнинга.

07.07.2025 [15:40], Владимир Мироненко

CoolIT за полтора года в 25 раз увеличила производство СЖО для ИИ-серверов и ЦОДCoolIT Systems сообщила о 25-кратном увеличении объёмов производства систем жидкостного охлаждения за последние 18 месяцев в Северной Америке и Азии на фоне роста спроса на ИИ-инфраструктуры. Это стало возможным во многом благодаря новому производственному предприятию Starfield в Калгари (Канада), а также лабораториям Liquid Lab в Канаде и на Тайване, которые занимаются разработкой передовых СЖО для ЦОД. На заводе Starfield, занимающем участок площадью 10,4 тыс. м2, размещены сквозные производственные линии для всего спектра продуктов прямого жидкостного охлаждения CoolIT — от водоблоков до блоков распределения охлаждающей жидкости (CDU). CoolIT сообщила, что ставит во главу угла скорость и качество, оперативно реагируя на потребности рынка.

Источник изображения: CoolIT Systems Портфолио интеллектуальной собственности CoolIT включает более чем 100 патентов, касающихся, в том числе её фирменной технологии Split-Flow для водоблоков. Созданная с её использованием герметичный водоблок OMNI All-Metal Coldplate был выпущен в 2024 году. Как утверждает CoolIT, сейчас прототип OMNI All-Metal Coldplate можно создать и доставить заказчику за недели, на что ранее потребовались бы месяцы. Производственные линии CoolIT сертифицированы в соответствии со стандартом ISO9001:2015. Подразделения CoolIT используют при производстве оптический скрининг на основе ИИ и роботизированную автоматизацию (RPA) для поддержания строгих стандартов качества. Каждый продукт проходит 100% тестирование на герметичность и функциональность. Критически важные компоненты поставляются из двух источников и подвергаются выборочной проверке на основе статистики для выявления любых отклонений перед отправкой продукции, сообщила CoolIT. Как утверждает компания, в числе инвесторов которой KKR и Mubadala, традиционное воздушное охлаждение достигло своих физических пределов. Жидкостное охлаждение, особенно Direct-to-chip решения, которые предлагает CoolIT, обеспечивает отличное управление температурой и энергоэффективность. Технология CoolIT может сократить потребление энергии в ЦОД до 30 % по сравнению с воздушным охлаждением, утверждает компания.

07.07.2025 [15:11], Руслан Авдеев

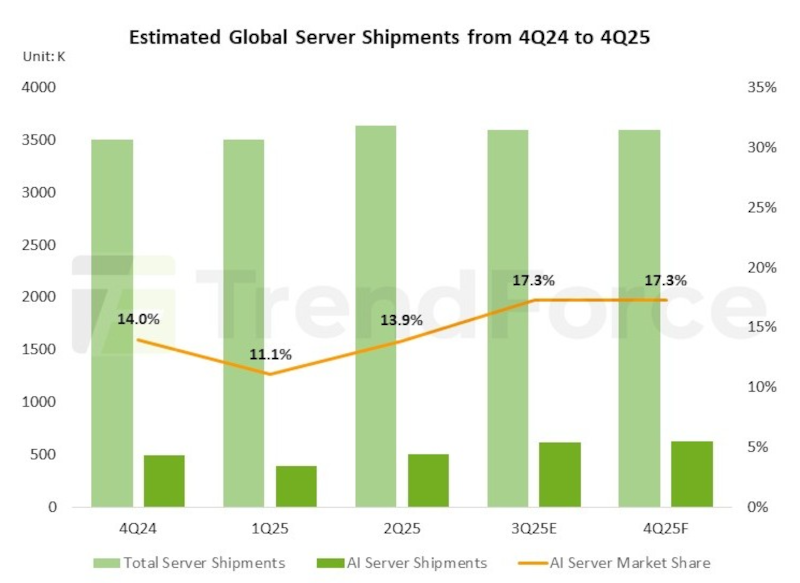

Пошлины США и геополитическая напряжённость притормозили рост поставок ИИ-серверов в 2025 годуКлючевые облачные провайдеры из США продолжают оставаться главными драйверами роста рынка ИИ-серверов. Устойчивый спрос поддерживают и операторы ЦОД «второго уровня», а также суверенные облачные проекты в Европе и на Ближнем Востоке — но в расчёт приходится принимать и негативные факторы, сообщает TrendForce. Впрочем, если спрос со стороны американских облачных гигантов и OEM-клиентов сохранится, поставки в процентном отношении в 2025 году сохранят двузначный рост. Тем не менее, как сообщает агентство, геополитическая напряжённость и экспортные ограничения со стороны США, негативно влияющие на китайский рынок, уже заставили TrendForce частично пересмотреть прогноз. Сейчас рост мировых поставок ИИ-серверов в годовом исчислении ожидается на уровне 24,3 %. В 2025 году Microsoft сохраняет фокус на закупках ИИ-серверов в ущерб системам общего назначения. В первую очередь используются ИИ-ускорители NVIDIA. Прогресс в разработке собственных ASIC идёт довольно медленно. Прогнозируется, что чипы Maia нового поколения начнут выпускать в 2026 году. Meta✴, тем временем, нарастила спрос на серверы общего назначения, в основном на базе платформ AMD, после завершения строительства новых дата-центров. Впрочем, компания работает и над собственными решениями, включая ASIC. Ожидается, что поставки чипов MTIA вырастут вдвое к 2026 году. Google отметила рост спроса на серверы, вызванный потребностями клиентов в создании суверенных облаков и завершением строительства новых ЦОД в Юго-Восточной Азии. Компания уже начала массовое внедрение ускорителей TPU v6e, ставших мейнстримом в I половине 2025 года. AWS также уделяет немало внимания собственному ускорителю Tranium 2. Компания уже начала разработку чипов Trainium 3, но их массовое производство начнётся, вероятно, только в 2026 году. Благодаря расширению платформы Tranium и активной внутренней ИИ-стратегии, AWS, вероятно, вдвое увеличит поставки собственных ASIC в 2025 году, став по этому показателю лидером среди американских облачных провайдеров.

Источник изображения: TrendForce Среди облачных гигантов Oracle выделяется покупкой готовых ИИ-серверов, а также серверов для работы с in-memory базами данных. В текущем году компания намерена более активно развёртывать инфраструктуру ИИ-серверов и интегрировать собственные облачные базы данных с ИИ-приложениями. Увидев запрос на суверенные облака в США, компания также увеличила спрос на решения NVIDIA GB NVL72. На II половину года многие OEM-производители пересматривают рыночные стратегии из-за изменений международной тарифной политики, инициированной США. Сегодня TrendForce считает, что суммарные поставки серверов (как для ИИ, так и общего назначения), вырастут год к году на 5 %, что в целом соответствует предыдущим прогнозам. В феврале уже сообщалось, что эксперты прогнозируют охлаждение рынка ИИ-серверов в 2025 году. Впрочем, как утверждалось, даже в таких условиях он может превысить 30 % — Microsoft, Meta✴, Amazon и Google готовы увеличить капитальные затраты на ИИ-инфраструктуру. Уже тогда ожидалось, что это будет способствовать поддержке спроса на ИИ-серверы.

07.07.2025 [14:05], Сергей Карасёв

Суперкомпьютер Doudna получит смешанное All-Flash хранилище IBM и VAST DataНациональная лаборатория им. Лоуренса в Беркли (Berkeley Lab), принадлежащая Министерству энергетики США (DOE), сообщила о том, что суперкомпьютер Doudna получит передовую подсистему хранения данных на основе технологий IBM и VAST Data. Эта платформа сможет с высокой эффективностью справляться с интенсивными нагрузками, связанными с обучением ИИ-моделей и инференсом. НРС-комплекс Doudna (NERSC-10) расположится в Национальном вычислительном центре энергетических исследований США (NERSC) в составе Berkeley Lab. Основой суперкомпьютера послужат системы Dell Integrated Rack Scalable Systems и серверы PowerEdge с ускорителями NVIDIA Vera Rubin. По предварительным данным, машина обеспечит FP64-быстродействие до 790 Пфлопс при потреблении 5,8–8,7 МВт. С целью достижения стабильной и предсказуемой производительности в задачах, требующих анализа данных в режиме, близком к реальному времени, для Doudna выбрана гибридная подсистема хранения, включающая зоны QSS (Quality-of-service Storage System) и PSS (Platform Storage System). Первая ориентирована прежде всего на ИИ-нагрузки: предполагается применение решений VAST Data, включая платформу VAST AI OS. Эта платформа, как утверждается, «объединяет возможности хранения информации, базы данных, вычислений, обмена сообщениями и рассуждений в единую инфраструктуру, созданную с нуля для ИИ и программных агентов». В свою очередь, PSS использует в качестве основы программно-определяемое решение IBM Storage Scale: этот сегмент будет функционировать как быстродействующая параллельная файловая система. Говорится о высокой производительности, масштабируемости и эффективности, что поможет устранить узкие места и оптимизировать рабочие процессы, связанные с обработкой данных. Для обоих сегментов СХД предусмотрено использование архитектуры All-Flash, то есть, будут задействованы исключительно SSD. Как отмечает Berkeley Lab, гибридная подсистема хранения обеспечит в пять раз более высокую производительность, нежели нынешний НРС-комплекс NERSC. Это позволит справляться с крупномасштабными рабочими нагрузками в таких областях исследований, как молекулярная динамика и геофизическое моделирование. Ввести суперкомпьютер в эксплуатацию планируется в 2026 году.

07.07.2025 [10:15], Руслан Авдеев

DPU-революция так и не состоялась, но развитие ИИ может изменить ситуациюВ 2013 году AWS представила инстансы EC2 C3, вскользь упомянув о расширенных сетевых возможностях благодаря появлению Intel Virtual Function. Позже компания пояснила, что кастомные сетевые адаптеры позволили перенести на них часть нагрузок вроде межсетевого экрана, что высвободило ресурсы серверов. Данное решение оставалось нишевым, но развитие ИИ может всё изменить, сообщает The Register. Решение нашло отклик и у других гиперскейлеров. Они начали создавать собственные SmartNIC или DPU. Mellanox в 2017 году представила DPU BlueField, изначально предназначенный для ускорения перемещения данных All-Flash хранилищ. Чуть позже VMware начала адаптацию своего гипервизора для работы со SmartNIC, предусматривающую запуск сетевых функций на DPU. Потенциал разработки оценила и NVIDIA, которая и приобрела Mellanox, а позже — ещё и Nebulon. В 2021 году Intel вместе с Google разработала Infrastructure Processing Unit (IPU), а годом позже AMD купила разработчика DPU Pensando. В 2022 году VMware представила vSphere Distributed Services Engine, предназначенный для управления SmartNIC и реализации на них распределённого файрвола. Хотя за SmartNIC стояли ключевые игроки IT-отрасли вроде VMware, Intel, AMD и NVIDIA, у каждой из которых было немало клиентов из сферы дата-центров, никакой революции с массовым применением DPU не произошло. VMware признала, что Distributed Services Engine не получил всеобщего признания, а эксперты отрасли подчеркнули, что основными потребителями DPU являются AWS и Microsoft Azure, сдающие мощности конечным заказчикам. ⅔ развёртываний DPU и SmartNIC приходится именно на этих двух гиперскейлеров, а за пределами облачного сегмента особенного прогресса нет.

Источник изображения: Microsoft Впрочем, намечаются и новые сценарии применения DPU, например — в Ethernet-коммутаторах или даже в качестве замены CPU. Потенциально это поможет расширить клиентскую базу. Например, Cisco применяет DPU в «защитных» продуктах Hypershield и смарт-коммутаторах N9300, а первыми DPU в свои коммутаторы CX 1000 внедрила Aruba ещё в 2021 году. Но такие продукты массовыми так и не стали. Ситуацию может изменить стремительное развитие ИИ-технологий. Недавно аналитики Gartner представили «эталонную» архитектуру для работы с ИИ на периферии и в Kubernetes-средах. В обоих случаях рекомендуется использовать DPU. Аналогичный подход в архитектуре для ИИ-облаков поддерживает и NVIDIA. Red Hat тоже поддержала идею использования DPU для виртуальных коммутаторов, балансировщиков, межсетевых экранов, для оптимизации работы баз данных или аналитических нагрузок за счёт прямого взаимодействия с NVMe и даже для инференса. Так, в OpenShift скоро появится DPU Operator. Пять лет назад Fungible объявила, что DPU должны стать «третьим сокетом» наравне с CPU и GPU, а через два года она была куплена Microsoft. И ей ещё повезло, потому что, например, Kalray оказалась вынуждена продать часть своего бизнеса. Возможно, в жизни этой компании и других стартапов наступит светлая полоса — революция в сфере ИИ может привести и к революционному развитию DPU.

07.07.2025 [08:57], Руслан Авдеев

Непредсказуемые пошлины США и общая геополитическая нестабильность ведут к увеличению стоимости и сроков строительства ЦОД в ЕвропеОператоры дата-центров Северной Европы уверены, что вводимые США тарифы и растущая геополитическая нестабильность приведут к росту расходов и задержкам строительства ЦОД, сообщает The Register. Ситуация усугубляется тем, что за последние два года благодаря ИИ спрос на мощности значительно вырос. Проведённый Onnec Nordics опрос показал, что за последние 12 месяцев рабочие нагрузки ИИ выросли в среднем на 42 %, а почти ⅔ операторов заявили, что требования к обеспечению работы ИИ-систем оказались выше, чем ожидалось, из-за чего приходится увеличивать ёмкость как действующих, так и планируемых площадок. В исследовании приняли участие 250 топ-менеджеров из Великобритании, Ирландии и стран Северной Европы. 69 % опрошенных отметили, что непредсказуемая тарифная политика и другие геополитические проблемы увеличивают стоимость и время строительства дата-центров. Ещё в апреле производители оборудования предупреждали, что пошлины, вероятно, приведут к росту цен на серверы, а финансовые аналитики подчёркивали, что неопределённость оставила технологическую отрасль в «подвешенном» состоянии, поскольку оборудование и комплектующие часто поступают из разных источников, из-за чего работа с цепочками поставок усложняется. В Onnec также подчеркнули, что протекционистская политика заставляет операторов принимать решения исходя из необходимости минимизации затрат, что не может не влиять на качество конечной инфраструктуры. В отчёте сообщается, что более 50 % операторов ожидают, что бум ИИ сократит сроки службы действующих ЦОД — ИИ-нагрузки нередко превышают возможности систем питания и охлаждения и пропускной способности сетей. 74 % представителей операторов утверждают, что стратегии энергоснабжения, охлаждения и размещения ЦОД пришлось пересмотреть для создания готовых к использованию ИИ-оборудования объектов. Это уже коснулось некоторых крупных игроков. Не так давно сообщалось, что Microsoft отменила аренду некоторых объектов — возможно, исходя из новых требований к энергопотреблению и охлаждению оборудования. Как сообщает Savills, работающая в сфере недвижимости, затраты на строительство ЦОД в Европе уже выросли в 2024 году, в среднем на 6,5 % год к году, до $9,1 млн/МВт. Дороже всего их строительство в Цюрихе, Лондоне и Франкфурте, основные затраты приходятся на землю, собственно здания, инженерные коммуникации, механические системы и охлаждение. 79 % респондентов назвали нехватку квалифицированных кадров ещё одним фактором, способным замедлить реализацию проектов строительства ЦОД. Решение ряда проблем и снижение ценового давления станет ключом к созданию ИИ-инфраструктуры, отвечающей долгосрочным потребностям операторов. Также слабым звеном называется кабельная инфраструктура — 70 % представителей операторов согласны с тем, что некачественные кабели могут поставить под угрозу производительность дата-центров и снизить их надёжность. |

|