Материалы по тегу: ии

|

13.07.2025 [11:21], Сергей Карасёв

Французский разработчик фотонных ИИ-чипов Arago получил на развитие $26 млнСтартап Arago, занимающийся созданием фотонных чипов, по сообщению Datacenter Dynamics, провёл «посевной» раунд финансирования на сумму в $26 млн. Полученные средства компания намерена использовать для ускорения разработки и коммерциализации продуктов, а также для расширения штата. Arago базируется в Париже (Франция). Стартап был основан в 2024 году Николасом Мюллером (Nicolas Muller), Элиоттом Сарреем (Eliott Sarrey) и Амбруазом Мюллером (Ambroise Muller). Компания создаёт фотонный ускоритель под названием JEF для ресурсоёмких нагрузок ИИ. Arago заявляет, что в настоящее время развитие ИИ сдерживается возможностями современного оборудования на основе кремния. По мнению стартапа, повышение эффективности и производительности ИИ-систем подразумевает выход за рамки традиционных транзисторных технологий. Предполагается, что изделие JEF на основе фотоники поможет решить существующие проблемы, обеспечив значительное повышение быстродействия в расчёте на 1 Вт и $1 по сравнению с доступными на рынке решениями. В основу чипа положена проприетарная фотонная технология Arago, которая, по утверждениям самой компании, даёт возможность «обойти технические барьеры», традиционно ограничивавшие производительность фотонных процессоров. Стартап подчёркивает, что JEF способен обеспечить десятикратное снижение энергопотребления по сравнению с передовыми ИИ-ускорителями на базе GPU при сопоставимых производительности и стоимости. Говорится о полной совместимости с существующей экосистемой ИИ, вычислительной инфраструктурой и технологическими процессами производства микросхем. Программный стек Arago Carlota может взаимодействовать с фреймворком PyTorch, позволяя разработчикам развёртывать и масштабировать модели ИИ без изменения имеющейся кодовой базы. В раунде финансирования на $26 млн приняли участие Earlybird, Protagonist, Visionaries Tomorrow, Generative IQ и C4 Ventures, а также бывший вице-президент Apple Бертран Серле (Bertrand Serlet), главный управляющий Arm Кристоф Фрей (Christophe Frey) и соучредитель Hugging Face Томас Вольф (Thomas Wolf). На сегодняшний день разработкой фотонных решений для ИИ-систем и дата-центров занимаются и многие другие компании. В их число входят DustPhotonics, Oriole Networks, Lightmatter, Celestial AI, Xscape Photonics, Ayar Labs и пр.

13.07.2025 [11:21], Владимир Мироненко

Вопреки слухам IBM рассчитывает на дальнейшее расширение присутствия в КитаеПо мере обострения торговой войны между США и Китаем деятельность американских компаний в стране сталкивается со всё большими трудностями, пишет ресурс DIGITIMES. IBM объявила о массовых увольнениях в Китае и закрыла центр исследований и разработок в Пекине, что можно было бы расценивать как признаки её грядущего исхода. Но генеральный директор IBM в Азиатско-Тихоокеанском регионе Ханс Деккерс (Hans Dekkers) утверждает, что это не так. В недавнем интервью DIGITIMES Деккерс заявил, что присутствие IBM в Китае фактически увеличилось как в плане персонала, так и в разрезе бизнеса. Он добавил, что IBM присутствует на рынке Китая уже 40 лет и продолжит здесь работу в течение следующих 40 лет. 43-летний Деккерс был назначен на должность гендиректора в августе 2024 года. В IBM он работает около 18 лет, до этого курировал такие регионы как Шанхай, Сингапур и Европа. Деккерс заявил, что IBM продолжит работу на долгосрочной основе в Китае, являющемся экономическим гигантом. Он допустил, что центр исследований и разработок, о закрытии которого ходят слухи, возможно, был перенесён в другой город. Деккерс отметил, что не разделяет позицию многих компаний, которые делят свой глобальный бизнес на «китайские» и «некитайские» территории. Он пояснил, что с точки зрения бизнеса важно, где клиенты хотят развиваться и какие возможности для этого им могут предоставить технологии IBM. Геополитические ситуации могут меняться, но конечная цель — поддержка клиентов, заявляется менеджер. Онднако несмотря на то, что и Китай, и Тайвань входят в регион «Большого Китая» IBM, уровень их доступа к конфиденциальным технологиям различается, сообщил Деккерс. Многие китайские компании по-прежнему ценят и используют технологии и сервисы IBM, особенно в сфере финансов и производства. Будучи глобально интегрированной компанией, IBM имеет все возможности для помощи клиентам в расширении их бизнеса, заявил Деккерс. Сюйдун Чэнь (Xudong Chen), председатель и генеральный директор IBM Greater China, заявил в июне во время визита в Шаньдун, что фокус IBM в Китае сместился на частные предприятия и иностранные компании, дав тем самым понять, что компания не будет развивать связи с китайскими госпредприятиями. В последнее время IBM сосредоточилась на гибридном облаке, ИИ и квантовых вычислениях как на трёх основных стратегиях, хотя в Китае IBM не участвует в проектах, связанных с квантовыми технологиями. Вместе с тем она продолжает развивать сотрудничество в области квантовых технологий с компаниями в Японии, Южной Корее и на Тайване. Недавно компания представила серверы POWER11. Китайский же рынок считается одним из ключевых для POWER-платформ.

13.07.2025 [10:57], Сергей Карасёв

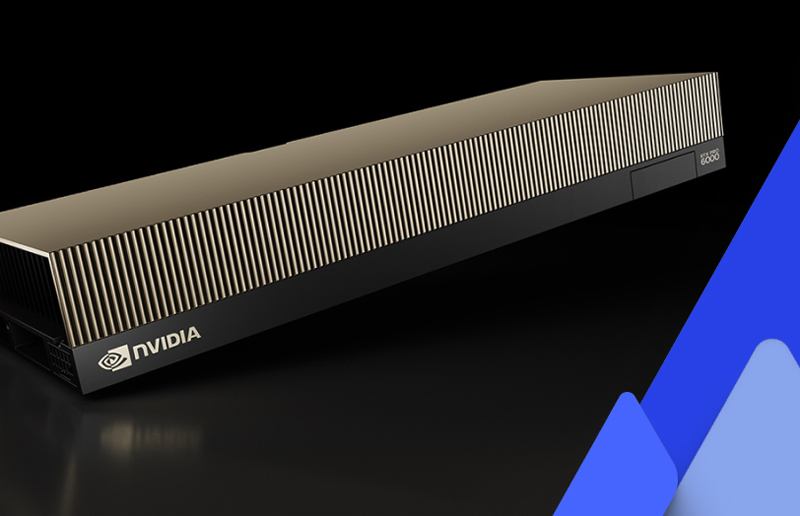

CoreWeave запустила первые общедоступные инстансы на базе NVIDIA RTX Pro 6000 Blackwell Server EditionОператор ИИ-облака CoreWeave объявил о запуске инстансов с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition для генеративных приложений, рендеринга в реальном времени и работы с большими языковыми моделями (LLM). Утверждается, что это первые общедоступные облачные экземпляры, построенные на базе названных GPU. Изделия RTX Pro 6000 Blackwell Server Edition на архитектуре Blackwell насчитывают 24 064 ядра CUDA, 752 тензорных ядра пятого поколения и 188 ядер RT четвёртого поколения. В оснащение входят 96 Гбайт памяти GDDR7 с пропускной способностью до 1,6 Тбайт/с. CoreWeave заявляет, что по сравнению с инстансами на основе NVIDIA L40S новые экземпляры обеспечивают 5,6-кратное повышение производительности при LLM-инференсе, 3,5-кратное увеличение быстродействия на операциях преобразования текста в видео и более чем 2-кратное повышение скорости тонкой настройки ИИ-моделей. Заявленная ИИ-производительность в режиме FP4 достигает 3,8 Пфлопс.

Источник изображения: CoreWeave / NVIDIA Инстансы CoreWeave с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition доступны в конфигурациях, насчитывающих до восьми GPU. Задействованы два процессора Intel Xeon поколения Emerald Rapids, а также DPU NVIDIA BlueField-3. Экземпляры предоставляют свыше 7 Тбайт пространства для хранения данных на основе NVMe SSD. Говорится о поддержке служб CoreWeave Observability Services, которые отвечают за детальный мониторинг использования ресурсов, а также предоставляют данные о системных ошибках, температуре и пр. Это помогает быстро обнаруживать и устранять проблемы, минимизируя сбои в рабочих процессах. Новые инстансы доступны посредством CoreWeave Kubernetes Service (CKS) и Slurm on Kubernetes (SUNK) в американском регионе CoreWeave US-EAST-04.

12.07.2025 [01:00], Руслан Авдеев

NVIDIA, Cisco и Indosat помогут Индонезии встать на ИИ-рельсы

cisco

indosat ooredoo hutchison

llm

nvidia

software

ии

индонезия

информационная безопасность

конфиденциальность

обучение

разработка

Индонезия сделала важный шаг к созданию суверенного ИИ, объявив о создании «Центра передового опыта в сфере ИИ» (AI Center of Excellence, CoE). Проект реализуется под руководством Министерства цифровых коммуникаций и информации (Komdigi) и при поддержке NVIDIA, Cisco и телеком-оператора Indosat Ooredoo Hutchison (IOH). Центр станет частью национальной инициативы «Золотое видение 2045» (Golden 2045 Vision), направленной на цифровую трансформацию экономики и развитие инноваций. В задачи CoE входят развитие локальной ИИ-инфраструктуры, подготовка кадров и поддержка стартапов. Частью CoE станет NVIDIA AI Technology Center, который обеспечит поддержку исследований в области ИИ, предоставит доступ к программе NVIDIA Inception для стартапов и предложит обучение в экосистеме NVIDIA Deep Learning Institute. Также CoE получит типовую суверенную ИИ-фабрику с новейшими ускорителями Blackwell. Дополнительно курируемый государством форум разработает надёжные ИИ-фреймворки для создания решений, соответствующих местным ценностям. Важное внимание уделяется вопросам кибербезопасности. На базе центра заработает система Sovereign Security Operations Center Cloud Platform, разработанная Cisco, сочетающая ИИ-распознавание угроз, локальное управление данными и управляемые сервисы обеспечения безопасности. Проект строится на четырёх стратегических столпах:

Источник изображения: Jeremy Bishop/unspalsh.com Уже сейчас около 30 независимых разработчиков и стартапов используют ИИ-инфраструктуру IOH на базе NVIDIA. С учётом того, что Indosat покрывает связью весь индонезийский архипелаг, компания может обслуживать сотни миллионов носителей индонезийского языка (Bahasa Indonesia) с помощью приложений на основе специальных LLM, таких как Indosat Sahabat-AI. В будущем Indosat и NVIDIA намерены внедрять технологии AI-RAN, позволяющие охватывать ещё более широкий круг людей, которые смогут пользоваться ИИ с помощью беспроводных сетей. Индонезия давно стала весьма привлекательным рынком для инвесторов. Так, Microsoft намерена в течение четырёх лет инвестировать в облачную инфраструктуру и ИИ-проекты Индонезии $1,7 млрд. А NVIDIA и Indosat Ooredoo Hutchison планируют построить ИИ-центр стоимостью $200 млн в Центральной Яве, $500 млн намерена инвестировать Tencent. Даже «Яндекс» имеет там собственные интересы.

11.07.2025 [09:09], Сергей Карасёв

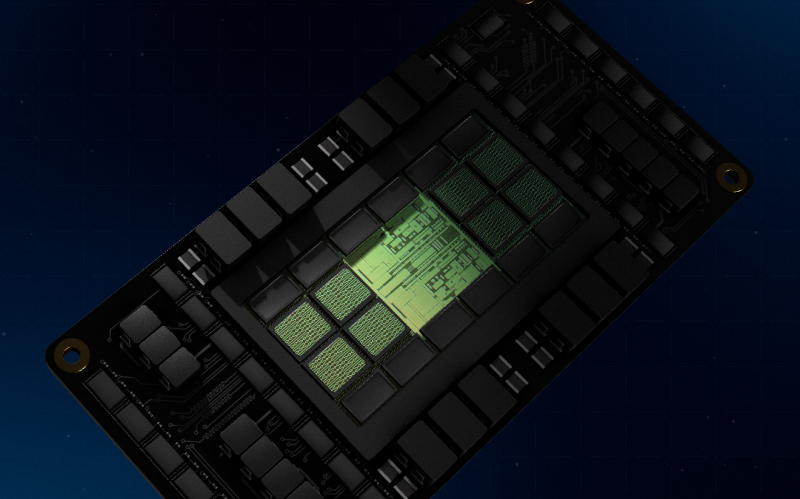

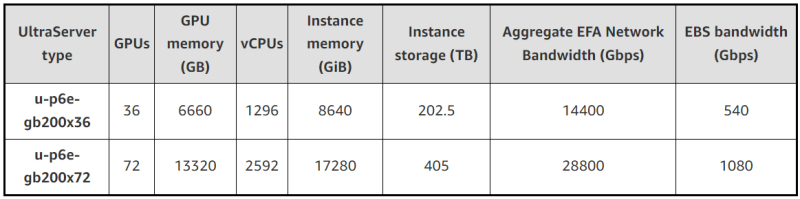

В облаке AWS появились инстансы EC2 P6e-GB200 UltraServer на базе ИИ-суперускорителей NVIDIA GB200 NVL72Облачная платформа AWS объявила о доступности высокопроизводительных инстансов EC2 P6e-GB200 UltraServer, рассчитанных на наиболее ресурсоёмкие нагрузки ИИ. В основу экземпляров положены суперускорители NVIDIA GB200 NVL72. Система GB200 NVL72 объединяет в одной стойке 18 узлов 1U, каждый из которых содержит два ускорителя GB200, что даёт в общей сложности 72 чипа B200 и 36 процессоров Grace. Задействована шина NVLink 5. Инстансы u-p6e-gb200-x72 предоставляют доступ к 72 чипам поколения Blackwell в одном домене NVLink, включая примерно 13,4 Тбайт памяти HBM3e. Производительность в режиме FP8 достигает 360 Пфлопс. Количество vCPU составляет до 2592, объём памяти — до 17 280 ГиБ. Кроме того, предоставляется до 405 Тбайт пространства для хранения данных. Используются адаптеры AWS Elastic Fabric Adapter (EFAv4) с низкой задержкой, агрегированной скоростью передачи данных 28,8 Тбит/с и поддержкой NVIDIA GPUDirect RDMA. Пропускная способность EBS достигает 1080 Гбит/с. Также доступны u-p6e-gb200-x36 с вдвое меньшими характеристиками.

Источник изображений: AWS Применяется система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Инстансы EC2 P6e-GB200 UltraServer объединяются в кластеры EC2 UltraCluster, что обеспечивает возможность безопасного и надёжного масштабирования до десятков тысяч ускорителей. AWS отмечает, что новые экземпляры подходят для работы с передовыми ИИ-моделями, насчитывающими триллионы параметров. При этом может использоваться сочетание экспертных и рассуждающих моделей. После резервирования ёмкости стоимость за инстанс списывается авансом, и цена не меняется после оплаты.

11.07.2025 [08:53], Руслан Авдеев

Агентство по охране окружающей среды США посетовало на непрекращающиеся попытки бездумного внедрения ИИПо словам Агентства по охране окружающей среды (EPA) США, стартапы очень часто бездумно обращаются к ИИ без чёткого плана действий и проверенных данных. В результате предприниматели терпят неудачи и удивляются, почему ничего не сработало, передаёт The Register, отмечая, что на практике ставка на ИИ окупается лишь в четверти случаев. Глава информационной службы EPA заявил, что ИИ — не панацея от всех проблем, как считают многие. ИИ необходимо внедрять в бизнес с учётом конкретных сценариев использования, но некоторые видят, как ИИ внедряется в других организациях, и стремятся к тому же, «не задавая правильных вопросов». По словам чиновника, часто для решения задачи вовсе не нужен ИИ, а попытка угнаться за модой может замедлить рост компании, а не ускорить его. Примечательно, что в последнее время доходность инвестиций в ИИ оказалась довольно низкой. EPA вторит и компания Maximus, ответственная за разработку IT-решений для госслужб США. Компания сообщила о жалобах на большое количество ботов «на службе» у государственных учреждений. В Maximus разработали процесс оценки решения задач — оказалось, что в некоторых случаях ИИ действительно вовсе не нужен. По словам EPA, простое делегирование текущих задач искусственному интеллекту не всегда позволяет добиться нужного эффекта. Например, в гипотетической ситуации, когда компания перекладывает заполнение некой формы, являющееся частью бизнес-процесса, на ИИ без изучения логики бизнес-процесса может оказаться, что задачу передали машине без особой необходимости и с затратой лишних ресурсов. Тщательный анализ процесса поможет ответить на действительно важный вопрос: нужно ли вообще выполнение конкретной задачи с помощью ИИ, если её обработка вручную будет в несколько раз дешевле? Другими словами, любой ИИ-проект настолько хорош, насколько хороши данные, использованные при его планировании. Сейчас EPA среды ведёт реестр ИИ-приложений для поиска «наилучших вариантов использования ИИ». При этом крупный IT-бизнес, наоборот, заинтересован в повсеместном внедрении ИИ. Так, Microsoft планомерно укрепляет лидерство в сфере ИИ, предлагая клиентам почти 2 тыс. моделей, в том числе от конкурентов.И это далеко не единственная платформа такого рода на рынке.

10.07.2025 [17:30], Сергей Карасёв

Bloomberg: Китай строит в пустыне гигантский комплекс ИИ ЦОД для 115 тыс. ускорителей NVIDIA, поставки которых запрещены СШАНа окраине пустыни Гоби в Синьцзяне (автономный район на северо-западе Китая), по сообщению Bloomberg News, ведутся активные работы по строительству кампуса ЦОД для ИИ-задач. Согласно имеющейся информации, в этих дата-центрах будут применяться серверы с ускорителями NVIDIA, поставки которых запрещены в КНР в соответствии с американскими санкциями. Специалисты Bloomberg News проанализировали сведения, содержащиеся в инвестиционных одобрениях, тендерных документах и заявках китайских компаний. Утверждается, что масштабные планы Китая в отношении развития ИИ прямо предусматривают использование «запрещённых» продуктов NVIDIA, а не только местных решений вроде Huawei Ascend. В частности, в IV квартале 2024 года власти Синьцзяна (Xinjiang) и соседней провинции Цинхай (Qinghai) одобрили создание в общей сложности 39 дата-центров, в которых будет задействовано более 115 тыс. ИИ-ускорителей NVIDIA. Причём во всех случаях речь идёт об H100 и H200. Операторы ЦОД в Синьцзяне намерены разместить львиную долю этих ускорителей в одном крупном комплексе, который будет использоваться для обучения передовых ИИ-моделей и других ресурсоёмких нагрузок. Строительные работы организованы в уезде Иу (Yìwū). Сотрудникам Bloomberg News не удалось установить, каким способом китайские компании намерены приобретать изделия NVIDIA, закупки которых запрещены без получения специальных лицензий от правительства США. Местные операторы дата-центров, государственные чиновники и представители центрального правительства в Пекине отказались давать какие-либо комментарии по данному вопросу. Между тем, как отмечается в публикации, стоимость 115 тыс. указанных ИИ-ускорителей может составить миллиарды долларов, исходя из цен на чёрном рынке Китая. И всё же строительство комплекса ЦОД продолжается. Синьцзян, и особенно регион Хами (Hāmì), включающий уезд Иу, богаты ветровой и солнечной энергией, а также углём. Это позволит решить вопросы, связанные с энергообеспечением дата-центров. Дополнительными достоинствами выбранного региона являются доступность больших территорий, низкая стоимость земли и прохладный климат в высотных районах. Согласно тендерной документации, полученной Bloomberg, по состоянию на июнь 2025 года по семи проектам ЦОД в Синьцзяне либо начаты строительные работы, либо выиграны тендеры на услуги ИИ-вычислений. В частности, один из крупнейших проектов связан с энергокомпанией Nyocor из Тяньцзиня (Tianjin), которая специализируется на солнечной и ветровой энергетике. Инициатива предусматривает создание дата-центра на базе 625 серверов с ускорителями H100. Nyocor продаёт вычислительные мощности корпорации Infinigence AI — одной из крупнейших организаций в сфере ИИ-инфраструктуры в Китае. В документах по 27 другим проектам ЦОД, одобренным в Синьцзяне и Цинхае в прошлом году, упоминаются в общей сложности более 9 тыс. серверов и около 72 тыс. ускорителей H100/H200. Два высокопоставленных чиновника американской администрации заявили, что по их оценкам, в Китае имеется примерно 25 тыс. запрещенных ИИ-ускорителей NVIDIA: такое количество, как утверждается, не вызывает серьёзного беспокойства. Более того, даже в случае приобретения ещё 115 тыс. карт NVIDIA масштабы соответствующих ИИ-платформ в КНР окажутся несопоставимы с мощью развитой инфраструктурой ИИ в США. Нужно отметить, что за последние годы власти Китая потратили $6,1 млрд на строительство крупных кампусов ЦОД, тогда как ещё $28 млрд вложили частные инвесторы. Площадки дата-центров появились в регионе Внутренняя Монголия, провинциях Нинся, Ганьсу, Гуйчжоу, регионе Пекин-Тяньцзинь-Хэбэй, а также в дельте Янцзы и на других территориях. Однако многие подобные объекты оказались невостребованными из-за переоценённого спроса и архитектурных недоработок.

10.07.2025 [10:03], Руслан Авдеев

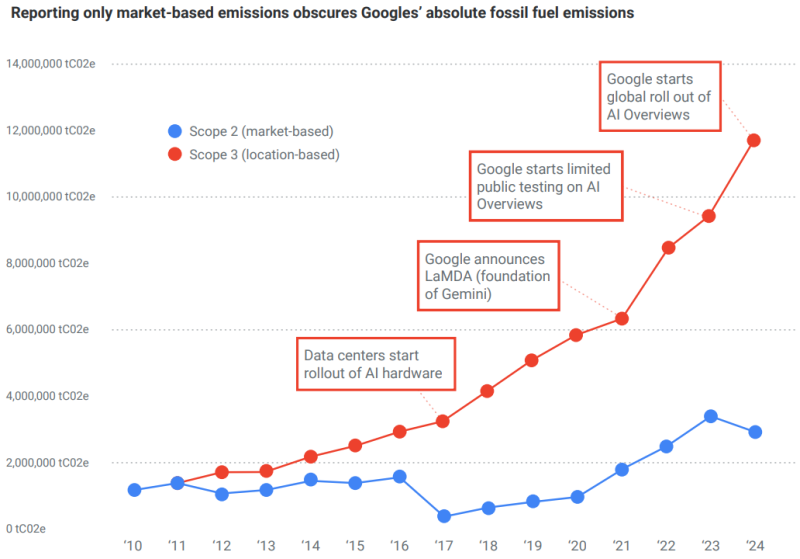

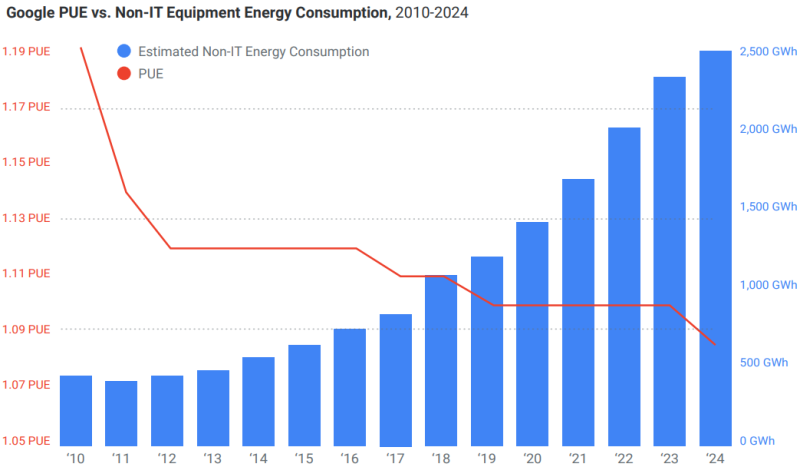

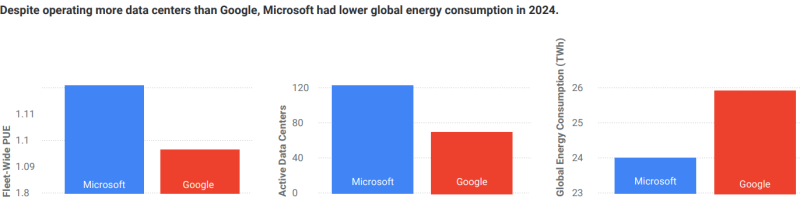

Углеродные выбросы Google выросли на 1515 % за 14 лет, но компания уверяет, что экоактивисты перевирают фактыGoogle негативно отреагировала на доклад НКО Kairos Fellowship, где говорится о «пробелах» в данных Google о сокращении углеродных выбросов. В Google утверждают, что анализ, проведённый НКО, «искажает факты» из ежегодных отчётов об экоустойчивости, сообщает Computer Weekly. В докладе Kairos Fellowship утверждается, что Google использует отчёты об экоустойчивости, чтобы ввести в заблуждение общество относительно прогресса в деле сокращения углеродных выбросов. Kairos Fellowship заявила, что 2,5 года работала над освещением вклада техногигантов в климатический кризис. Были тщательно проанализированы публичные отчёты Google, связанные с охраной окружающей среды, и проведены подробные расчёты и анализ представленных экологических данных. В результате НКО пришла к выводу, что данные о прогрессе Google в сокращении выбросов в 2024 календарном году не соответствуют истине. В отчёте Google говорится о сокращении выбросов ЦОД на 12 % несмотря на увеличение энергопотребления на 27 %. Также сообщается, что общие выбросы парниковых газов Scope 1, 2 и 3 выросли год к году на 6,2 %, они растут третий год подряд вместе с ростом бизнеса. Утверждается, что большая часть выбросов — косвенные, связанные с цепочкой поставок (Scope 3). При этом выбросы Scope 1 и 2 сократились на 8 % и 11 % соответственно год к году.

Источник изображения: Ella Ivanescu/unsplash.com Выбросы Scope 3 выросли на 22 %, во многом из-за роста мощностей ЦОД. Подчёркивается, что выбросы Scope 3 будут возникать в процессе производства и развёртывания ИИ-инфраструктуры, сопутствующей логистики, а также в процессе строительства самих дата-центров. Хотя в целом выбросы и увеличились, Google по-прежнему намерена достичь нулевых выбросов к 2030 году благодаря инвестициям в технологические решения, связанные с удалением углерода.

Источник: Kairos Fellowship Вместе с тем в отчёте признаётся, что отрасль ЦОД переживает переломный момент из-за быстрого внедрения ИИ и ситуация вносит значительную неопределённость, способную повлиять на будущие показатели. Одной из главных проблем является потенциальная возможность «нелинейного» роста ИИ из-за высоких темпов его развития и неизвестно, сколько для этого потребуется энергии и инфраструктуры, что затрудняет возможность прогнозирования. В Kairos Fellowship утверждают, что выбросы парниковых газов Google росли не три года, а почти 15 лет. В НКО уверены, что Google вводит общественность в заблуждение относительно сокращения выбросов. Так, расследование показало, что с 2010 по 2024 гг. они выросли на 1515 %. Другими словами, в 2024 году Google выбросила на 21,9 млн т больше, чем 14 лет назад. Снижение выбросов, связанных с энергопотреблением, рассчитывается по «рыночному» методу, который учитывает покупку «зелёной» энергии (включая экологические сертификаты), но не отражает физические выбросы от работы дата-центров.

Источник: Kairos Fellowship В том, что ИИ виновен в росте выбросов, выводы Google и Kairos Fellowship совпадают. В НКО заявили, что агрессивные инвестиции в генеративный ИИ и сопутствующую инфраструктуру — один из главных факторов, влияющих на климатические проблемы. Выбросы Scope 2, связанные с энергией, покупаемой Google для своих ЦОД, выросли с 2010 года на 820 %. Более того, с 2019 года Google сумела фактически сократить только выбросы Scope 1, составляющие лишь 0,31 % от общего объёма выбросов в 2025 году. Главная проблема, по мнению Kairos Fellowship, в том, что Google представляется добросовестным игроком, в то же время скрывая рост выбросов углерода и прочие подробности вроде объёмов использования питьевой воды, играя терминологией и т.п. Данные скрываются или маскируются, поэтому часто остаются незамеченными.

Источник: Kairos Fellowship Google заявила, что факты искажает сама Kairos Fellowship. Выбросы компании, как утверждается, подсчитываются в соответствии с распространённым Протоколом по парниковым газам (Greenhouse Gas Protocol) и подтверждаются независимыми экспертами. В частности, амбиции положительно оценила ведущая отраслевая организация Science Based Targets. Выбросы не просто сократились на 12 % — в этом году запущено более 25 проектов в области чистой энергетики. Правда, в прошлом году компания сама призналась, что из-за ИИ за пять лет выбросы парниковых газов выросли на 48 %.

09.07.2025 [16:44], Руслан Авдеев

Mistral AI хочет привлечь $1 млрд для конкуренции с OpenAIФранцузский ИИ-стартап Mistral AI ведёт переговоры с базирующимся в Абу-Даби (ОАЭ) фондом MGX и другими структурами о привлечении до $1 млрд акционерного капитала, сообщает Bloomberg со ссылкой на осведомлённые источники. По информации источников, кроме акционерного финансирования Mistral пытается привлечь сотни миллионов евро в кредит — переговоры ведутся с французскими компаниями, включая Bpifrance SACA. На данный момент Bpifrance уже является инвестором Mistral AI. Пока переговоры носят предварительный характер и условия возможной сделки могут быть изменены. Нет точных данных, какой станет капитализация компании после привлечения инвестиций. В самих Mistral, MGX и Bpifrance информацию пока не комментируют. Предполагается, что сделка укрепит связи Франции и ОАЭ в сфере ИИ, где в последнее время всё отчётливее доминируют США и Китай. Mistral — крупнейший в Европе ИИ-стартап, с момента основания в 2023 году привлёкший более €1 млрд ($1,17 млрд). Его капитализация составила $5,8 млрд после прошлогоднего раунда финансирования. Впрочем, компания не успевает угнаться за конкурентами вроде американской OpenAI, поэтому старается переориентироваться на индивидуальные сервисы. Тем не менее, она сохраняет ключевую роль в планах Франции добиться суверенитета в сфере ИИ. Mistral, MGX и NVIDIA уже объединили усилия для строительства крупнейшего в Европе кампуса ИИ ЦОД, а власти ОАЭ обещали выделить €50 млрд на ИИ-проекты в стране.

Источник изображения: Rodrigo Kugnharski/unsplash.com Французские официальные лица заявили, что MGX предоставит первоначальный капитал для инвестиций ОАЭ. Этот фонд является активным инвестором в ИИ и уже поддерживал OpenAI и xAI. Также это участник проекта Stargate, курируемого OpenAI и другого мегафонда для ЦОД, в который входят NVIDIA и Microsoft. Ранее в этом году руководство Mistral заявило, что компания потратит несколько миллиардов евро на вычислительные мощности. В том числе предусмотрено строительство ЦОД, оснащённого новейшими чипами, близ Парижа. В июне 2025 года NVIDIA объявила о намерении содействовать развитию ИИ-облака Mistral Compute во Франции с использованием 18 тыс. новых ускорителей Grace Blackwell. По данным источников, знакомых с планами Mistral, заёмные средства, о которых компания ведёт переговоры, будут истрачены на Mistral Compute. Инвесторами Mistral уже являются Microsoft и американские венчурные фонды Lightspeed Venture Partners, General Catalyst и Andreessen Horowitz.

09.07.2025 [16:30], Руслан Авдеев

SambaManaged превратит почти любой ЦОД в ИИ ЦОД всего за три месяцаРазработчик ИИ-ускорителей SambaNova анонсировал решение SambaManaged на базе SN40L. Это первый в отрасли продукт, оптимизированный для инференса, внедрить который можно всего за 90 дней — намного быстрее, чем обычно требуется для систем такого уровня (18–24 мес.), говорит компания. Модульная платформа разработана специально для быстрого развёртывания и позволяет существующим дата-центрам почти немедленно организовать ИИ-инференс с минимальными модификациями инфраструктуры. По мере того, как стремительно растёт спрос на ИИ-задачи, связанные именно с инференсом, традиционные дата-центры сталкиваются с новыми проблемами — на внедрение систем, оптимизированных для таких задач, требуется от полутора до двух лет, много энергии, а также дорогостоящие обновления оборудования. Решение SambaManaged позволяет устранить эти барьеры, быстро развернув прибыльные инференс-сервисы, используя уже имеющуюся силовую и сетевую инфраструктуру. SambaManged формируется из стоек SambaRack SN40L-16, каждая из которых включает 16 ускорителей (RDU в терминологии SambaNova) SN40L с BF16-производительностью 10,2 Тфлопс. Платформа оснащена двумя 64-ядерными хост-процессорами, 2 Тбайт DDR4, четырьмя загрузочными 960-Гбайт SSD (RAID1 + два hot-spare) и шестью 7,6-Тбайт NVMe SSD в RAID10 для данных. Энергопотребление составляет всего 7–14,5 кВт (типовое 10 кВт). Стойка весит 485 кг. Рабочая температура — от +15 до +30 °C. Фактически это переименованная платформа DataScale SN40L, только теперь разработчик не говорит о возможности обучения моделей. Как подчёркивают в SambaNova, дата-центры сталкиваются с проблемами энергоснабжения и охлаждения, недостатком компетенций и др. на фоне роста спроса на ИИ. Система SambaManaged обеспечивает высокую ИИ-производительность при низком энергопотреблении и минимальных изменениях инфраструктуры. Преимуществами для ЦОД и облачных провайдеров называются рекордная производительность на каждый затраченный Вт, позволяющая снизить совокупную стоимость владения (TCO) и быстрее вернуть инвестиции. Систему можно внедрить всего за 90 дней. При этом обеспечивается невероятно быстрый инференс с ведущими open source моделями, что позволяет избежать привязки к конкретному вендору и гарантирует совместимость с будущими технологиями. Модульный дизайн позволяет быстро строить даже большие инференс-системы, включая т.н. Token Factory мощностью до 1 МВт (100 стоек). Систему можно масштабировать по мере изменения бизнес-потребностей. Можно выбрать полностью управляемое решение или взять на себя часть контроля за операциями. SambaManaged уже внедряется крупной публичной компанией в США, потребляющей немало энергии. Платформа обеспечивает максимальную пропускную способность для моделей вроде DeepSeek и ей подобных, помогая клиентам увеличивать доход от инференса и оптимизировать энергоэффективность (PUE). В SambaNova заявляют, что SambaManaged меняет правила игры для организаций, желающих ускорить реализацию ИИ-проектов без ущерба скорости, масштабу или эффективности. Везде, где есть доступ к Сети и электроэнергии, можно обеспечить необходимую инфраструктуру в рекордные сроки. В конце июня 2025 года сообщалось, что SambaNova делает ставку на инференс и партнёрство с облачными провайдерами и госзаказчиками из США. Groq, ещё один поставщик решений для инференса, первым сменил бизнес-подход, отказавшись от продажи ускорителей в пользу формирования целых ИИ ЦОД. Cerebras совместно с партнёрами также создаёт крупные ИИ-суперкомпьютеры и кластеры. |

|