Материалы по тегу: ии

|

31.08.2025 [15:51], Руслан Авдеев

Alibaba разработала собственный ИИ-ускоритель для инференсаНа фоне нарастающего давления со стороны китайских властей, стремящихся избавиться от зависимости от ИИ-чипов NVIDIA и и других западных аналогов, Alibaba разработала собственный ИИ-ускоритель. В пятницу появились данные, что новейший чип китайского IT-гиганта ориентирован на инференс, сообщает The Register. Подразделения Alibaba T-Head довольно давно работает над собственными ИИ-решениями. В 2019 году он представила вариант Hanguang 800, но в отличие от современных моделей NVIDIA и AMD, он в первую очередь предназначен для классических ML-моделей машинного обучения (таких как ResNet), а не для современных больших языковых моделей (LLM). Утверждается, что новый чип будет справляться с более разнообразными нагрузками. В обозримом будущем для обучения Alibaba, вероятно, будет по-прежнему использовать ускорители NVIDIA. По имеющимся данным, в отличие от ускорителей Huawei Ascend, продукт Alibaba совместим с программной платформой NVIDIA, что позволяет лишь немного переработать используемый код. При этом использование инструментов CUDA не является необходимым для инференса. Alibaba, вероятно, ориентируется на более высокоуровневые варианты вроде PyTorch или TensorFlow. Так или иначе, чип придётся выпускать в Китае из-за санкций США. Кто именно займётся непосредственно выпуском не указывается, но весьма вероятно, что речь идёт о SMIC. Кроме того, Китаю запрещено продавать высокоскоростную память HBM2e и более новые версии — если они уже не интегрированы в готовый ускоритель. Это значит, что Alibaba или будет использовать «медленную» память GDDR или LPDDR, а также накопленные запасы HBM, пока не появятся собственные аналоги. Новости об очередных полупроводниках китайского производства появились на фоне призывов китайского правительства не использовать ускорители NVIDIA H20 из соображений безопасности. Впрочем, NVIDIA, которой не так давно вновь разрешили поставлять H20 в Китай, все обвинения решительно отрицает. По некоторым данным, ведётся разработка нового ускорителя семейства Blackwell, специально для Китая. Впрочем, в текущем квартале компания всё равно не рассчитывает на доходы в КНР, поскольку механизмы возобновления продажи и взимания 15-процентной экспортной пошлины ещё не отработаны. Тем временем китайские лидеры ИИ-отрасли ищут альтернативы продуктам компании. DeepSeek переориентировала свои модели на использование нового поколения китайских чипов. Компания не назвала поставщика, но, по некоторым данным, перенести обучение на Ascend не удалось. Впрочем, сама Huawei старается ускорить и инференс. Стартап Enflame, поддерживаемый Tencent, разрабатывает новый ускоритель L600, который получит 144 Гбайт (3,6 Тбайт/с) и поддержку FP8-вычислений. MetaX анонсировала модель C600 со 144 Гбайт HBM3e, но производство, вероятно, будет ограничено имеющимися резервами памяти. Наконец, Cambricon Technologies также работает над собственным ускорителем Siyuan 690, который, как ожидается, будет лучше NVIDIA H100.

31.08.2025 [15:31], Владимир Мироненко

Новый урок арифметики от NVIDIA: Дженсен Хуанг назвал фантастическую сумму капзатрат на ИИ-инфраструктуруГендиректор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил в ходе отчёта за II квартал 2026 финансового года, что капзатраты четырёх крупнейших гиперскейлеров (Amazon Web Services, Google, Microsoft и Meta✴ Platforms) составят около $600 млрд в год. По его словам, эта сумма удвоилась всего за два года и является движущей силой текущего развития ИИ-инфраструктуры. Как отметил ресурс SiliconANGLE, последние квартальные отчёты гиперскейлеров, а также аналитические данные экспертов, освещающих их деятельность, говорят о том, что их совокупный прогноз капитальных затрат гораздо ниже объявленной Хуангом суммы, хотя этот показатель стремительно растёт благодаря спросу на ИИ-технологии. NVIDIA в ответ на просьбу объяснить столь большое расхождение уточнила, что эта сумма отражает общие расходы отрасли на инфраструктуру ЦОД, а не только расходы ведущих поставщиков облачных сервисов. Если говорить о планах по объёмам капзатрат на текущий год (календарный или финансовый), то гиперскейлеры прогнозируют следующее:

Согласно выводам аналитиков (Jefferies, Investing.com) по «большой тройке» с Meta✴ и Oracle прогноз капзатрат на облаке на 2025 год составляет $417 млрд, что на 64 % больше, чем годом ранее, и почти в три раза больше, чем в 2023 году. Налицо существенное расхождение между объявленными Хуангом $600 млрд и данными аналитиков, а также прогнозами самих гиперскейлеров. Возможные причины расхождения по версии SiliconANGLE:

Названная главой NVIDIA сумма в $600 млрд не подтверждается прогнозами ведущих гиперскейлеров на 2025 год и расчётами аналитиков, которые предполагают, что совокупные капзатраты составят $400–$450 млрд. Разрыв, как пишет SiliconANGLE, обусловлен как неопределённостью масштаба (что именно считается капиталовложениями у гиперскейлеров), так и намерением Хуанга подчеркнуть, что NVIDIA находится в центре ИИ-бума. NVIDIA известна порой довольно вольным обращением с цифрами и прогнозами. Это касается заявлений производительности платформ без явного указания точности и формата вычислений (так в мгновение ока появились экзафлопсные суперкомпьютеры, которые в более традиционных FP64-расчётах не сильны), учёта количества GPU в узлах (несколько лет компанию не беспокоило, что в состав одного ускорителя входило два GPU-чиплета), или отхода от привычных способов указания пропускной способности интерфейсов (для NVLink суммируется скорость передачи данных в обе стороны).

29.08.2025 [23:15], Владимир Мироненко

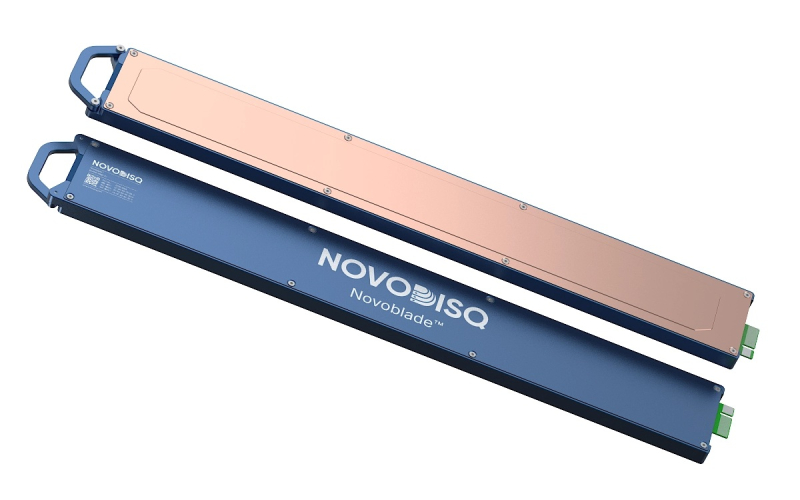

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

29.08.2025 [17:53], Руслан Авдеев

ИИ и IIoT помогли Aramco сократить время простоев на 40 % и снизить расходы на техобслуживание на 30 %Внедрение ИИ позволило нефтегазовой компании Aramco из Саудовской Аравии весьма эффективно оптимизировать бизнес, сообщает VAST Data. Благодаря комбинации алгоритмов машинного обучения с сетями IoT-датчиков в инфраструктуре компании — на буровых установках, трубопроводах предприятиях по нефтепереработке и т.д. — Aramco добилась сокращения времени незапланированных простоев на 40 % и снижении расходов на техническое обслуживание на 30 %. Системы компании позволяют выявлять признаки перегрузки оборудования задолго до того, как произойдёт серьёзный инцидент, своевременно предотвратив поломки и каскад аварий. Важен и экологический аспект. Сжигание попутного и «лишнего» газа всегда было неприятным пятном на репутации отрасли. Теперь ИИ Aramco использует более 18 тыс. датчиков для прогнозирования того, где и когда придётся сжигать газ и можно ли этого избежать. В результате с 2010 года сжигание сократилось более чем наполовину и уже более десяти лет сжигается менее 1 % от общего уровня добычи газа. На одном из крупнейших в мире месторождении Хурайс (Khurais) Aramco развёрнуто 40 тыс. датчиков на 500 нефтяных скважинах, потоки данных интегрируются в системы машинного обучения и роботизированные платформы. Фактически создан «живой» цифровой двойник месторождения с постоянным обновлением данных и возможностью моделирования процессов. Знаковой стала разработка первой в своём роде ИИ-модели Aramco METABRAIN c 7 млрд параметров, созданной из датасета на основе данных, накопленных компанией за 90 лет. В своём роде это всезнающий промышленный консультант. Модель обеспечивает предиктивную аналитику, оптимизирует рабочие процессы и поддерживает принятие тех или иных решений. Фактически речь идёт о банке памяти, объединённом с «рассуждающей» моделью, в том числе обрабатывается историческая информация для получения рекомендаций. Мегапроекты вроде реализуемого в Хурайсе, предусматривают использование не периодической отчётности, а данных от многочисленных сенсоров, поэтому стратегическое планирование поддерживается ИИ METABRAIN. С появлением ИИ роль руководителя проекта меняется от административного контроля к стратегической интерпретации. Контроль всё ещё важен, но теперь он тесно связан с непрерывным использованием ИИ-технологий, говорит компания. ИИ может порекомендовать перераспределить ресурсы или сообщить о вероятном сбое, но общение с другими людьми всё равно остаётся прерогативой человека. Aramco активно участвует в ИИ-проектах в Саудовской Аравии. Так, в сентябре 2024 года Aramco Digital объявила о партнёрстве с Cerebras, Groq и Qualcomm для развития ИИ и 5G IoT в стране. В феврале 2025 года Groq и Aramco Digital объявили об открытии крупнейшего в EMEA вычислительного ИИ-центра для инференса.

29.08.2025 [17:19], Руслан Авдеев

Санкции США не особо помешали успехам Huawei в 5G-секторе, а полная «зачистка сетей» так и не удаласьСогласно отчёт Omdia, Huawei остаётся крупнейшим вендором RAN-инфраструктуры в трёх из пяти крупных регионов мира, попавших в поле зрения исследователей — несмотря на жесточайшие санкции США. Сегодня Huawei является сильной как никогда, в прошлом году её продажи были только на 4 % ниже, чем в 2020 году, т.е. до начала давления США на компанию и её партнёров, сообщает блог IEEE ComSoc. В Азии и Океании, на Ближнем Востоке и в Африке, в Латинской Америке и Карибском бассейне компания остаётся ключевым вендором RAN. В Европе она занимает третье место, а в Северной Америке вовсе отсутствует, поскольку местному бизнесу запрещено иметь с ней дело. Но даже в Европе положение Huawei остаётся довольно прочным. Испанская Telefónica остаётся крупным клиентом Huawei в Бразилии и Германии, хотя ещё в 2020 году предполагалось «очистить сети» на этих рынках. Deutsche Telekom и Vodafone также активно пользуются решениями Huawei. Ericsson и Nokia отмечают, что Европа не может отказаться от продуктов Huawei и предупреждают инвесторов, что та «агрессивно» конкурирует в некоторых регионах. На рынке телекоммуникационного оборудования, как заявляют в Ericsson, западные компании сталкиваются с растущим давлением со стороны Huawei и других китайских вендоров. В Ericsson констатируют, что попытки вытеснить Huawei из Европы под предлогом «высоких рисков» провалились, и теперь китайские конкуренты активно осваивают рынки не только в Европе, но и в Латинской Америке. Вместо того чтобы ввязываться в ценовую войну, Ericsson выбирает стратегию сохранения финансовой устойчивости, пусть и с потерей некоторых контрактов. С другой стороны, пока нет и признаков того, что европейские телеком-компании заменяют китайскими решениями финские и шведские продукты. Доля Nokia на рынке RAN практически не изменилась в I и II квартале, на компанию приходится 17,6 %. Впрочем, во II квартале Huawei, похоже, превзошла конкурента за счёт других вендоров и успехов на развивающихся рынках, где позиции компании традиционно сильны. Сыграли роль и некоторые другие факторы. Huawei по-прежнему высоко ценится клиентами за качество продукции. Компания была пионером в разработке 5G-решений, в том числе TDD и Massive MIMO, и первой вывела на рынок высокоэффективные GaN-усилители, опередив своих основных конкурентов.

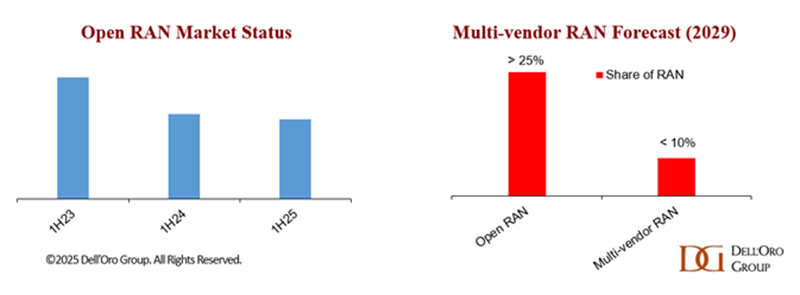

Источник изображения: Dell'Oro Group Санкции не повлияли на Huawei так, как рассчитывали эксперты. Хотя компанию отрезали от партнёрства с производителями самых передовых чипов, она смогла организовать выпуск компонентов для новейших смартфонов в Китае. Сетевое оборудование компании меньше зависит от передовых техпроцессов, поэтому продажи в этом секторе не пострадали вне рынков, где ввели жёсткие ограничения. В США, отрезая Huawei от поставок решений для телеком-сетей, рассчитывали на успех американских компаний в области Open RAN, но чуда не произошло. Главный фаворит — Mavenir — из-за финансовых трудностей и невыполнения планов вынужденно провёл реструктуризацию, покинул часть рынков, провёл масштабные увольнения и отказался от активной разработки собственного аппаратного обеспечения, сосредоточившись на ПО. Parallel Wireless также разрабатывает ПО для Open RAN, SDR-решения, программный стек для 5G-SA, не зависящий от конкретного аппаратного обеспечения, и платформу Open RAN Aggregator для объединения оборудования разных вендоров. В Dell’Oro Group предсказывают, что ежегодная выручка от многовендорных RAN-решений достигнет $3 млрд к 2029 году, т.е. менее 10 % от всего рынка RAN к тому моменту. Эксперты считают, что «высокая концентрация» рынка поставщиков оборудования Open RAN угрожает ключевому принципу архитектуры — разнообразию вендоров. Практически во всех регионах доминируют несколько крупных игроков (Huawei, Ericsson, Nokia, ZTE и Samsung), что противоречит самой концепции Open RAN. На рынке с такой высокой концентрацией и фактически «провалившихся» американских санкций RAN-технологии Huawei всё ещё очень востребованы.

29.08.2025 [15:05], Руслан Авдеев

Microsoft, OpenAI и NVIDIA предупредили, что ИИ теперь может физически навредить энергосетямГодами эксперты в области кибербезопасности уделяли внимание защите критической инфраструктуры в основном от цифровых атак с помощью самых разных систем, не позволявших создать угрозу электросетям. Однако новое исследование, проведённое специалистами из Microsoft, OpenAI и NVIDIA, показывает, что главной угрозой электросетям выступают отнюдь не хакеры, а ИИ. Исследование «Стабилизация энергоснабжения для обучающих ИИ ЦОД» (Power Stabilization for AI Training Datacenters) выявило интересную тенденцию, связанную с быстрым внедрением ИИ в больших масштабах. В процессе эксплуатации ускорителей есть два основных этапа: вычислительный, когда они активно выполняют сложные математические операции, потребляя много энергии, и коммуникационный, когда они обмениваются данными между собой. Во время перехода от первого этапа ко второму происходит резкий спад энергопотребления, а от второго к первому — его стремительный рост. В случае с гиперскейлерами скачки могут составлять десятки или сотни мегаватт, что негативно сказывается на состоянии электросетей в целом. Дело не просто в неэффективном использовании ресурсов — речь идёт об угрозе критически важной инфраструктуре. В докладе говорится, что колебания потребления могут совпасть с резонансными частотами ключевых компонентов энергосистемы, включая генераторы и оборудование ЛЭП, что потенциально приводит к дестабилизации сети, повреждению оборудования и масштабным авариям. Другими словами, активность ИИ представляет прямую физическую угрозу для аналоговой инфраструктуры электросетей.

Источник изображения: American Public Power Association/unsplash.com Для решения этой проблемы предлагаются три основных подхода. Во-первых, во время простоя на ускорителях можно решать второстепенные (или вообще бессмысленные, как делала Meta✴) задачи, держа оборудование на «холостом ходу» без полной остановки вычислений. Метод простой, но не самый лучший — общая энергоэффективность не растёт, снижение производительности при выполнении основной задачи вполне возможно. Во-вторых, можно непосредственно на уровне ИИ-ускорителей задавать минимальный порог энергопотребления, что тоже не способствует энергоэффективности. Наконец, в-третьих, можно использовать аккумулирующие энергию системы: в моменты низкого потребления они заряжаются, а во время скачка нагрузки отдают накопленную в них энергию вместо того, чтобы резко увеличивать потребление от общей электросети. Подобные системы позволяют избежать скачков и сгладить рост и снижение потребляемой мощности. Так, Google уже давно размещает литий-ионных ячейки непосредственно в стойках. Для стоек GB300 NVL72 NVIDIA дополнила блоки питания буфером, который позволяет смягчить колебания потребления и снизить пиковую нагрузку на сеть до 30 %. Энергосети давно являются частью критической инфраструктуры, но новые угрозы для них теперь находятся на стыке цифрового и реального мира. Получив неавторизованный доступ к крупному ИИ-кластеру, злоумышленники могут намеренно изменить паттерн энергопотребления так, чтобы навредить материальной инфраструктуре. Другими словами, злоумышленники могут повредить электростанцию или энергосети, даже не приближаясь к ним. В докладе Microsoft, OpenAI и NVIDIA заинтересованные стороны прямо отмечают, что масштаб ИИ вырос до отметки, на которой цифровая активность ведёт к важным физическим последствиям. Специалистам по кибербезопасности придётся уделять время не только цифровой реальности, но и заняться защитой критически важной инфраструктуры и учитывать последствия разрабатываемых и внедряемых алгоритмов. Примером может служить инцидент, произошедший летом 2024 года в Вирджинии, когда миллисекундный сбой привёл к одномоментному отключению 60 дата-центров мощностью 1,5 ГВт на несколько часов.

28.08.2025 [22:32], Владимир Мироненко

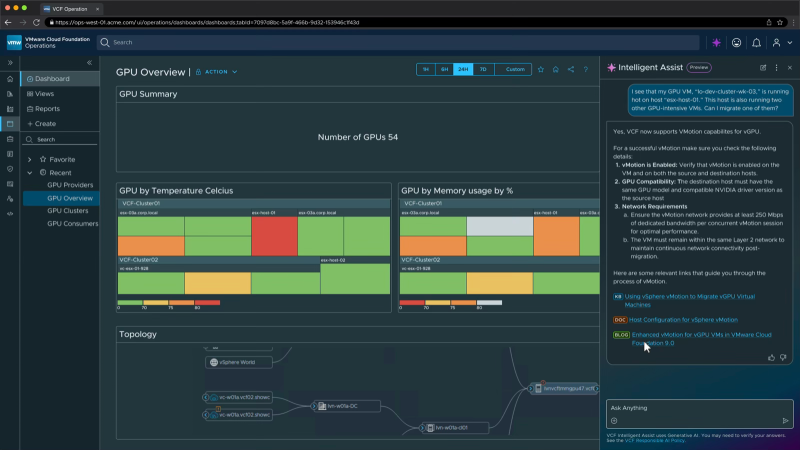

Broadcom интегрировала в VCF ИИ-сервисы и поддержку новейших ускорителей AMD и NVIDIA — всё это будет доступно бесплатноBroadcom объявила об интеграции ИИ-сервисов VMware Private AI в платформу VMware Cloud Foundation (VCF) без дополнительных затрат для клиентов. Компании смогут пользоваться ИИ-функциями в рамках подписки на VCF, начиная с I квартала 2026 года. По словам компании, это упростит и ускорит внедрение новых ИИ-сервисов заказчиков. Некоторые эксперты считают, что дальнейшая модернизации VMware и повышение привлекательности пакета VCF для компаний благодаря интеграции частных ИИ-сервисов могут стать важным шагом для сохранения клиентской базы VMware. Компании получат множество преимуществ: от расширенного планирования инфраструктуры и балансировки нагрузки, предоставляемых с помощью распределенного планировщика ресурсов (DRS), до схем автоматизации, позволяющих развёртывать сложные ИИ-сервисы за считанные минуты, используя оптимизированные драйверы устройств, ядра для конкретных ускорителей и многое другое, обещает Broadcom. VMware Private AI Services помогут компаниям развёртывать и управлять ИИ-приложениями в современной частной облачной инфраструктуре, сохраняя конфиденциальность и безопасность данных. ИИ-сервисы включают среду выполнения моделей, хранилище моделей, мониторинг ускорителей, службу индексации и поиска данных, векторную базу данных, шлюз API и конструктор ИИ-агентов. Целью проекта является создание более интегрированного, безопасного и удобного для разработчиков решения, которое будет выглядеть и работать как публичное облако с точки зрения получения услуг, безопасности и масштабируемости. Это означает большую автоматизацию, больше API и лучшую прозрачность производительности и затрат, отметил ресурс SiliconANGLE. Разработчикам будет помогать генеративный ИИ-помощник VCF Intelligent Assist. Он поможет диагностировать и решить проблемы инфраструктуры, используя базу знаний Broadcom. В дальнейшем будет добавлена функция автоматического исправления ошибок. Broadcom сообщила, что в ближайшее время VCF 9.0 получит поддержку протокола Model Context Protocol (MCP), позволяющего ИИ-агентам подключаться к внешним источникам данных и инструментам и использовать их для совместной работы с другими агентами. Также платформа будет поддерживать функцию Multi-accelerator Model Runtime, которая обеспечивает гибкое развёртывание ИИ-моделей на различном оборудовании, включая ускорители AMD и NVIDIA. Кроме того, клиенты получат многопользовательский доступ к моделям (Multi-tenant Models-as-a-service), что поможет снизить затраты за счёт безопасного доступа арендаторов или отдельных подразделений к общим ИИ-моделям. Broadcom добавила в платформу VCF поддержку оборудования и ПО NVIDIA, в том числе систем Blackwell, включая RTX Pro 6000, и адаптеров ConnectX-7. Также Broadcom заявила о сотрудничестве с AMD, что позволит организациям использовать VCF с ускорителями AMD Instinct серии MI350 и ПО ROCm. Заодно Broadcom объявила о расширенном сотрудничестве с Canonical, благодаря которому клиенты смогут использовать Ubuntu в своих частных облаках с полной корпоративной поддержкой, включая ускоренное управление патчами и повышенную кибербезопасность.

28.08.2025 [17:31], Руслан Авдеев

Foxconn инвестировала более $200 млн в производство в Мексике, вероятно — для выпуска ИИ-серверовТайваньская Foxconn (Hon Hai Technology Group) вложила $213 млн в дочернее предприятие, базирующееся в Мексике. Согласно документам, поданным Тайваньской фондовой бирже, 13 августа компания инвестировала $45 млн в мексиканскую FII AMC Mexico при посредничестве ещё одной дочерней структуры, Cloud Network Technology Singapore, сообщает Datacenter Dynamics. 25 августа, в ходе второго этапа инвестиций, Foxconn потратила ещё $168 млн. Средства, вероятно, направят на финансирование выпуска ИИ-серверов — ещё в октябре 2024 года производитель заявил о намерении построить завод в Гвадалахаре (Guadalajara), который будет выпускать серверы на базе Blackwell. По информации тайваньских СМИ, 18 августа руководство Foxconn сообщило Ассоциации производителей электротехники и электроники Тайваня (Taiwan Electrical and Electronic Manufacturers’ Association), что намерена построить технопарки в США или Мексике, чтобы избежать 20-% пошлин, которые США планирует ввести в отношении Тайваня.

Источник изображения: Andrés Sanz/unsplash.com Foxconn уже работает в Мексике. В феврале 2025 года компания подписала меморандум о взаимопонимании с северо-западным штатом Сонора (Sonora) для разработки решений для «умного города» в сфере транспорта, общественной безопасности и портов. В отчёте Foxconn о финансах за II квартал 2025 года отражается, что впервые в истории компании её подразделение, отвечающее за облачные и сетевые продукты, зафиксировало более высокую выручку, чем подразделение по выпуску умной бытовой электроники. В июле 2025 года Foxconn объявилао партнерстве с производителем электродвигателей и дата-центров — Teco Electric and Machinery для создания модульных ЦОД. Кроме того, компания, напрмиер,будет выпускать ИИ-оборудование для проектаStargate на заводе в США, которыйона же продала SoftBank.

28.08.2025 [14:01], Руслан Авдеев

NVIDIA жалуется на многомиллиардные потери из-за торговой войны США и КитаяNVIDIA призвала Вашингтон скорее одобрить продажу ускорителей Blackwell в КНР. Призыв прозвучал в ходе финансового отчёта компании за II квартал 2025 года, сообщает The Register. Как говорят в компании, её продукты разрабатываются и продаются для коммерческого использования, и каждая продажа принесёт выгоду американской экономике. Если компании дадут возможность конкурировать по всему миру, её ИИ-стек станет повсеместным стандартом. По мнению главы NVIDIA Дженсена Хуанга (Jensen Huang), только в этом году Китай мог бы обеспечить компании рынок объёмом $50 млрд, если бы она могла удовлетворить спрос конкурентоспособными продуктами. отсутствии H20 китайские компании переходят на подержанные ускорители NVIDIA A100/H100. При этом весьма вероятно, что к слабым моделям покупатели возвращаться не захотят вовсе. Сейчас NVIDIA готовит для Китая более производительный ИИ-ускоритель на архитектуре Blackwell и ожидает разрешение Вашингтона на выдачу экспортных лицензий. Президент США уже давал понять, что он открыт для этой идеи, а Хуанг критиковал запрет на продажи, утверждая, что это только усилит конкурентоспособность Китая.

Источник изображения: NVIDIA Тем временем NVIDIA ожидает потери времени и денег из-за затормозившихся продаж ослабленного ускорителя H20 в Поднебесной. Кроме того, в компании отмечают, что власти объявили о 15-% «налоге» на продажи ускорителей в КНР, но реальные правовые механизмы для регулирования этого процесса пока отсутствуют. По данным компании, если Вашингтон всё-таки даст «добро», NVIDIA могла бы увеличить выручку ещё на $2–$5 млрд — помимо $54 млрд, которые компания, вероятно, получит в III квартале. Хотя NVIDIA всё ещё не может продать запас H20 в Китае, компании удалось найти другого покупателя, на которого ограничения не распространяются. NVIDIA продала ему соответствующих ускорителей на $650 млн, высвободив благодаря сделке «зарезервированные» $180 млн.

28.08.2025 [13:03], Руслан Авдеев

Китайский бизнес переходит на подержанные ускорители NVIDIA A100 и H100 из-за проблем с поставками H20Китайская ИИ-индустрия постепенно переходит на восстановленные или подержанные ИИ-ускорители NVIDIA A100 и H100 после того, как очередные экспортные ограничения на NVIDIA H20 заставили компании искать альтернативы этому продукту. Искусственно ослабленный ускоритель H20 должен был сохранить присутствие NVIDIA на китайском рынке, но чип фактически «оказался на обочине» даже после того, как на его продажи вновь дали зелёный свет после временного запрета — китайские регуляторы поставили под сомнение его безопасность, сообщает Tom’s Hardware со ссылкой на Digitimes. Всё это привело к стремительному росту спроса на старые модели A100 и H100, китайские компании проводят некую «реконфигурацию» таких ускорителей для использования в недорогих, но высокопроизводительных системах инференса. Последний требует значительно меньше ресурсов, чем обучение ИИ-моделей, рабочие нагрузки могут эффективно выполняться на относительно слабом оборудовании. Именно поэтому даже A100 с 80 Гбайт HBM2e (2 Тбайт/с), представленный ещё в 2020 году, в некоторых случаях остаётся вполне востребованным. Хотя архитектура Ampere уступает Hopper по пиковой производительности, она всё ещё эффективна для инференса благодаря относительно большому объёму памяти и развитой экосистеме ПО CUDA. Для чат-ботов и рекомендательных систем экономически эффективно использовать системы без самых современных чипов. Представленные в 2022 году H100 значительно производительнее A100 в задачах, связанных с обучением. В то же время H20 изначально был оптимизирован для менее ресурсоёмкого инференса, но его возможности урезали так сильно, что производительность в сравнении с H100 у этой модели ниже в 3–7 раз, а в задачах, связанных с вычислениями FP64, он медленнее более чем в 30 раз. Другими словами, даже A100 всё ещё могут быть привлекательнее для китайских покупателей, чем новые H20.

Источник изображения: NVIDIA Поскольку пока никому не удалось создать что-то сопоставимое с программной экосистемой NVIDIA CUDA, старые GPU вполне востребованы. Тем более что оборудование для инференса менее требовательно во всех отношениях, а китайские ЦОД, по-видимому, не испытывают проблем с энергий и готовы платит за восстановленную устаревшую электронику, даже с пониженной надёжностью. В результате NVIDIA оказалась в странном положении. Компания в своё время списала $5,5 млрд из-за нераспроданных запасов H20 — когда в США решили полностью запретить их поставки в Китай. После снятия запрета компания резко нарастила выпуск H20, но теперь столкнулась уже с нежеланием властей КНР видеть эти чипы в стране. Тем не менее, её ускорители по-прежнему являются одним из главных катализаторов бума ИИ в Китае. Другими словами, чипы компании по-прежнему доминируют на рынке Поднебесной, но активность на теневых рынках может снизить выгоду от бизнеса с Китаем. Впрочем, уже появилась информация о разработке нового ускорителя на основе современной архитектуры Blackwell — хотя и тоже ослабленного. |

|