Лента новостей

|

25.06.2020 [21:10], Алексей Степин

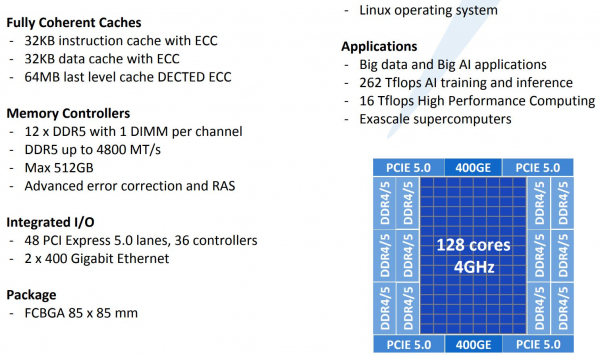

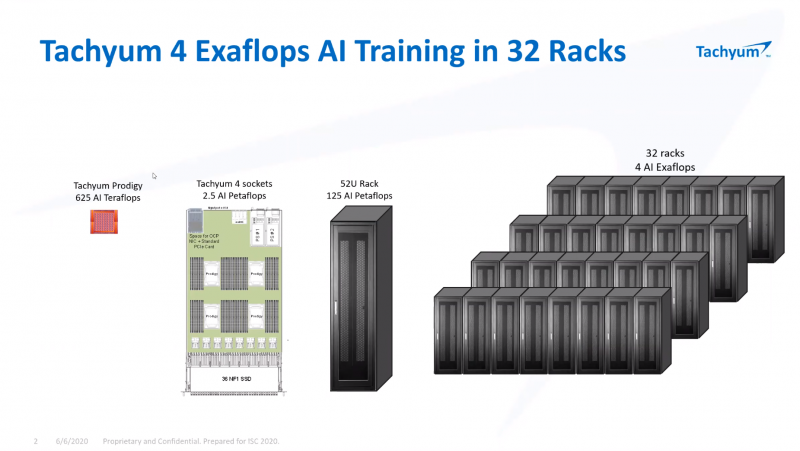

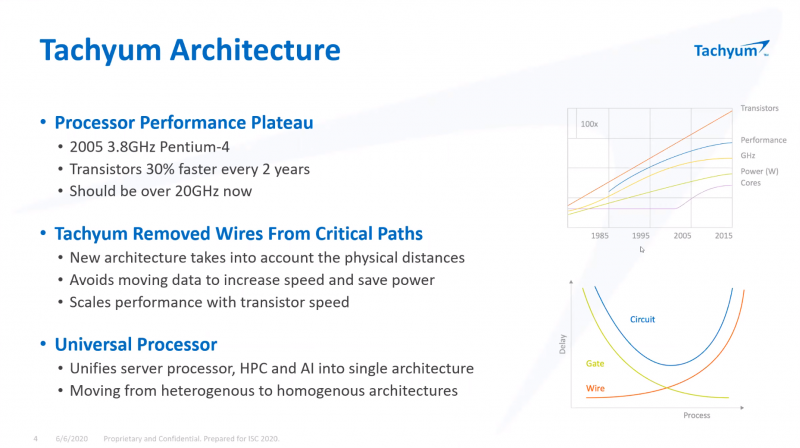

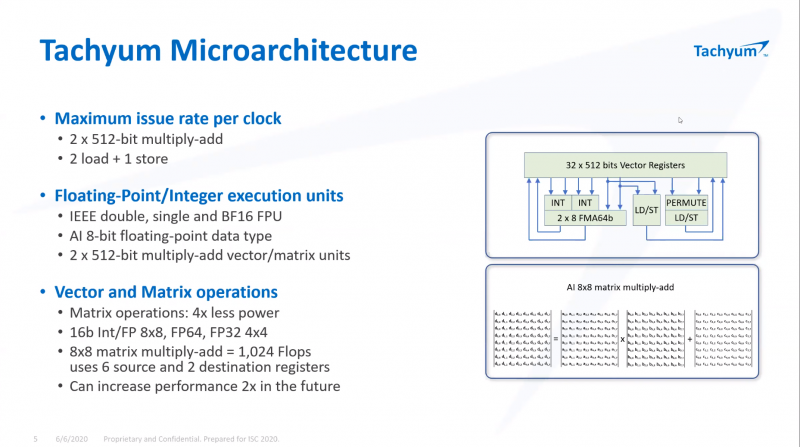

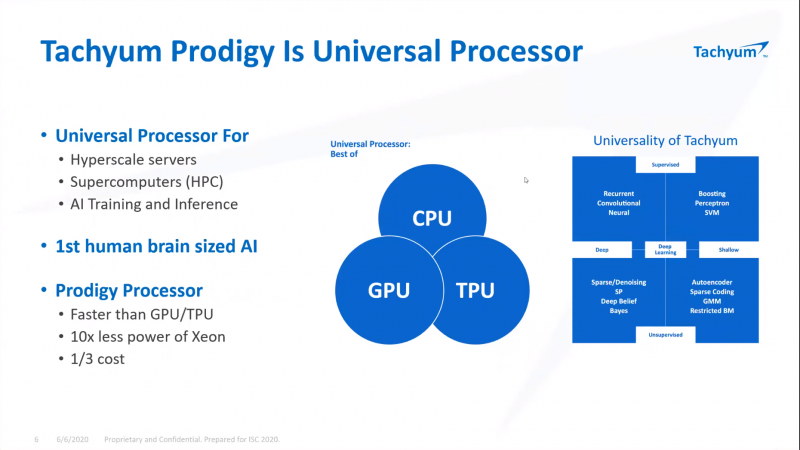

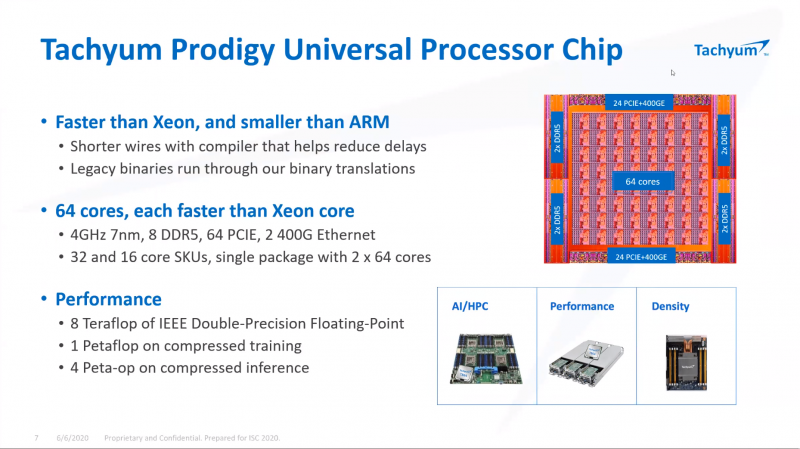

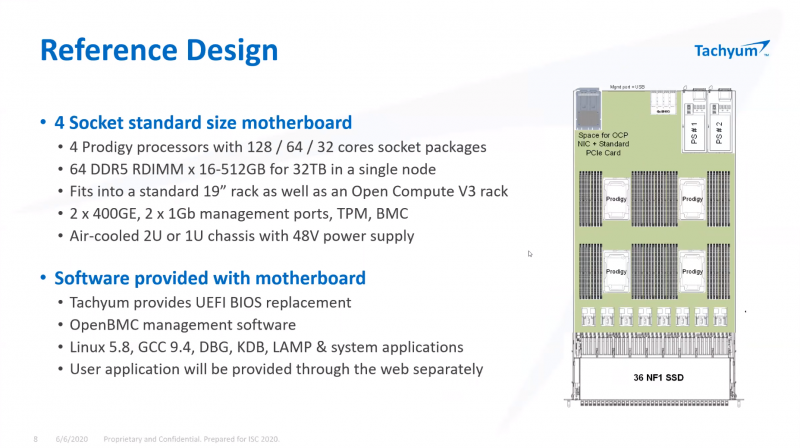

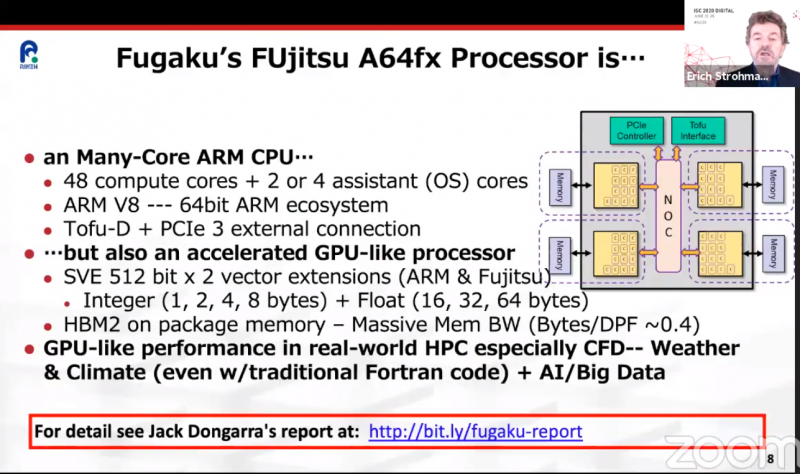

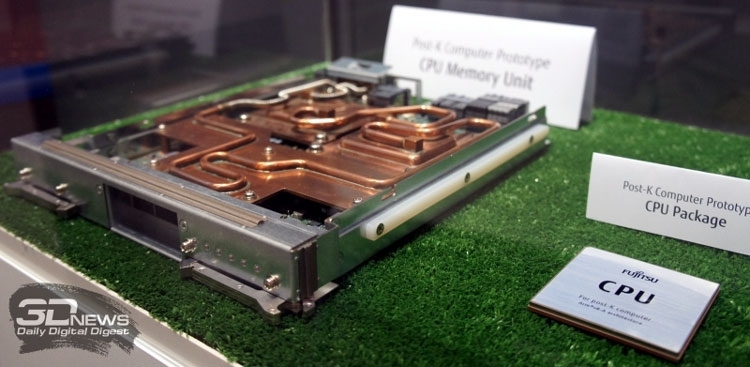

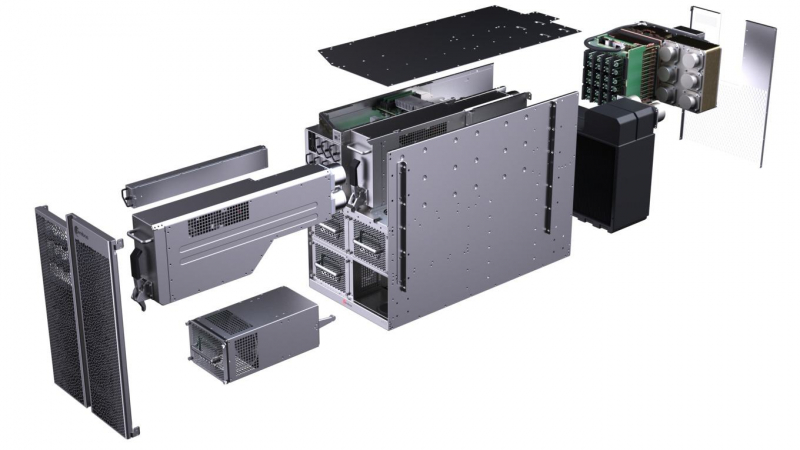

ISC 2020: Tachyum анонсировала 128-ядерные ИИ-процессоры Prodigy и будущий суперкомпьютер на их основеМашинное обучение в последние годы развивается и внедряется очень активно. Разработчики аппаратного обеспечения внедряют в свои новейшие решения поддержку оптимальных для ИИ-систем форматов вычислений, под этот круг задач создаются специализированные ускорители и сопроцессоры. Словацкая компания Tachyum достаточно молода, но уже пообещала выпустить процессор, который «отправит Xeon на свалку истории». О том, что эти чипы станут основой для суперкомпьютеров нового поколения, мы уже рассказывали читателям, а на конференции ISC High Performance 2020 Tachyum анонсировала и сами процессоры Prodigy, и ИИ-комплекс на их основе. Запуск готовых сценариев машинного интеллекта достаточно несложная задача, с ней справляются даже компактные специализированные чипы. Но обучение таких систем требует куда более внушительных ресурсов. Такие ресурсы Tachyum может предоставить: на базе разработанных ею процессоров Prodigy она создала дизайн суперкомпьютера с мощностью 125 Пфлопс на стойку и 4 экзафлопса на полный комплекс, состоящий из 32 стоек высотой 52U. Основой для новой машины является сервер-модуль собственной разработки Tachyum, системная плата которого оснащается четырьмя чипами Prodigy. Каждый процессор, по словам разработчиков, развивает до 625 Тфлопс, что дает 2,5 Пфлопс на сервер. Компания обещает для новых систем трёхкратный выигрыш по параметру «цена/производительность» и четырёхкратный — по стоимости владения. При этом энергопотребление должно быть на порядок меньше, нежели у традиционных систем такого класса. Архитектура Prodigy представляет существенный интерес: это не узкоспециализированный чип, вроде разработок NVIDIA, а универсальный процессор, сочетающий в себе черты ЦП, ГП и ускорителя ИИ-операций. Структура кристалла построена вокруг концепции «минимального перемещения данных». При разработке Tachyum компания принимала во внимание задержки, вносимые расстоянием между компонентами процессора, и минимизировала их. Процессор Prodigy может выполнять за такт две 512-битные операции типа multiply-add, 2 операции load и одну операцию store. Соответственно то, что каждое ядро Prodigy имеет восемь 64-бит векторных блока, похожих на те, что реализованы в расширениях Intel AVX-512 IFMA (Integer Fused Multiply Add, появилось в Cannon Lake). Блок вычислений с плавающей точкой поддерживает двойную, одинарную и половинную точность по стандартам IEEE. Для ИИ-задач имеется также поддержка 8-битных типов данных с плавающей запятой. Векторные и матричные операции — сильная сторона Prodigy. На перемножении-сложении матриц размерностью 8 × 8 ядро развивает 1024 Флопс, используя 6 входных и 2 целевых регистра (в сумме есть тридцать два 512-бит регистра). Это не предел, разработчик говорит о возможности увеличения скорости выполнения этой операции вдвое. Tachyum обещает, что система на базе Prodigy станет первым в мире ИИ-кластером, способным запустить машинный интеллект, соответствующий человеческому мозгу. С учётом заявлений о 10-кратной экономии электроэнергии и 1/3 стоимости от стоимости Xeon, это заявление звучит очень сильно. Но Prodigу — не бумажный продукт-однодневка. Tachyum разработала не только сам процессор, но и всю необходимую ему сопутствующую инфраструктуру, включая и компилятор, в котором реализованы оптимизации в рамках «минимального перемещения данных». Новинка разрабона с использованием 7-нм техпроцесса, максимальное количество ядер с вышеописанной архитектурой — 64. Помимо самих ядер, кристалл T864 содержит восьмиканальный контроллер DDR5, контроллер PCI Express 5.0 на 64 (а не 72, как ожидалось ранее) линии и два сетевых интерфейса 400GbE. При тактовой частоте 4 ГГц Prodigy развивает 8 Тфлопс на стандартных вычислениях FP32, 1 Пфлоп на задачах обучения ИИ и 4 Петаопа в инференс-задачах. Самая старшая версия, Tachyum Prodigy T16128, предлагает уже 128 ядер с частотой до 4 ГГц, 12 каналов памяти DDR5-4800 (но только 1DPC и до 512 Гбайт суммарно), 48 линий PCI Express 5.0 и два контроллера 400GbE. Производительность в HPC-задачах составит 16 Тфлопс, а в ИИ — 262 Тфлопс на обучении и тренировке. Системные платы для Prodigy представлены, как минимум, в двух вариантах: полноразмерные четырёхпроцессорные для сегмента HPC и компактные однопроцессорные для модульных систем высокой плотности. Полноразмерный вариант имеет 64 слота DIMM и поддерживает модули DDR5 объёмом до 512 Гбайт, что даёт 32 Тбайт памяти на вычислительный узел. Сам узел полностью совместим со стандартами 19″ и Open Compute V3, он может иметь высоту 1U или 2U и поддерживает питание напряжением 48 Вольт. Плата имеет собственный BIOS UEFI, но для удалённого управления в ней реализован открытый стандарт OpenBMC. Tachyum исповедует концепцию универсальности, но всё-таки узлы для HPC-систем на базе Prodigy могут быть нескольких типов — универсальные вычислительные, узлы хранения данных, а также узлы управления. В качестве «дисковой подсистемы» разработчики выбрали SSD-накопители в формате NF1, подобные представленному ещё в 2018 году накопителю Samsung. Таких накопителей в корпусе системы может быть от одного до 36; поскольку NF1 существенно крупнее M.2, поддерживаются модели объёмом до 32 Тбайт, что даёт почти 1,2 Пбайт на узел. Стойка с модулями Prodigy будет вмещать до 50 модулей высотой 1U или до 25 высотой 2U. Согласно идее о минимизации дистанций при перемещении данных, сетевой коммутатор на 128 или 256 портов 100GbE устанавливается в середине стойки. Такая конфигурация работает в системе с числом стоек до 16, более масштабные комплексы предполагается соединять между собой посредством коммутатора высотой 2U c 64 портами QSFP-DD, причём поддержка скорости 800 Гбит/с появится уже в 2022 году. 512 стоек могут объединяться посредством высокопроизводительного коммутатора CLOS, он имеет высоту 21U и также получит поддержку 800 Гбит/с в дальнейшем. Компания активно поддерживает открытые стандарты: применён загрузчик Core-Boot, разработаны драйверы устройств для Linux, компиляторы и отладчики GCC, поддерживаются открытые приложения, такие, как LAMP, Hadoop, Sparc, различные базы данных. В первом квартале 2021 года ожидается поддержка Java, Python, TensorFlow, PyTorch, LLVM и даже операционной системы FreeBSD. Любопытно, что существующее программное обеспечение на системах Tachyum Prodigy может быть запущено сразу в виде бинарных файлов x86, ARMv8 или RISC-V — разумеется, с пенальти. Производительность ожидается в пределах 60 ‒ 75% от «родной архитектуры», для достижения 100% эффективности всё же потребуется рекомпиляция. Но в рамках контрактной поддержки компания обещает помощь в этом деле для своих партнёров. Разумеется, пока речи о полномасштабном производстве новых систем не идёт. Эталонные платформы Tachyum обещает во второй половине следующего года. Как обычно, сначала инженерные образцы получают OEM/ODM-партнёры компании и системные интеграторы, а массовые поставки должны начаться в 4 квартале 2021 года. Однако ПЛИС-эмуляторы Prodigy появятся уже в октябре этого года, инструментарий разработки ПО — и вовсе в августе. Планы у Tachyum поистине наполеоновские, но её разработки интересны и содержат целый ряд любопытных идей. В чём-то новые процессоры можно сравнить с Fujitsu A64FX, которые также позволяют создавать гомогенные и универсальные вычислительные комплексы. Насколько удачной окажется новая платформа, говорить пока рано.

23.06.2020 [19:23], Алексей Степин

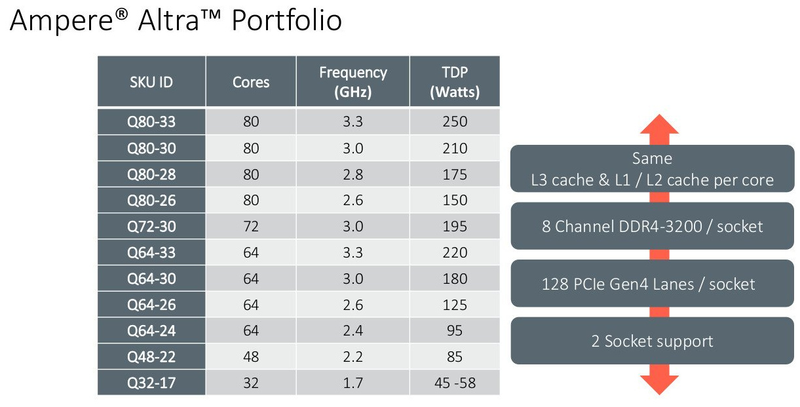

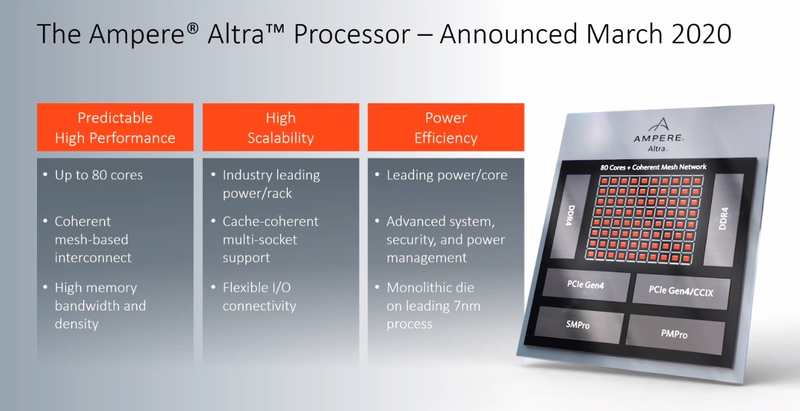

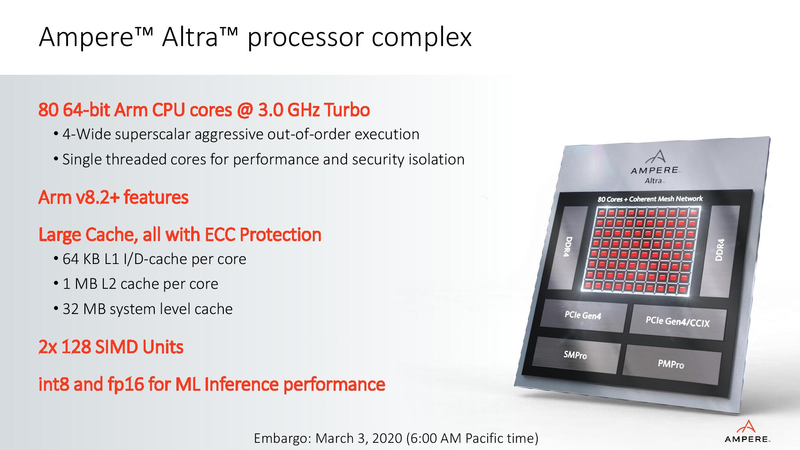

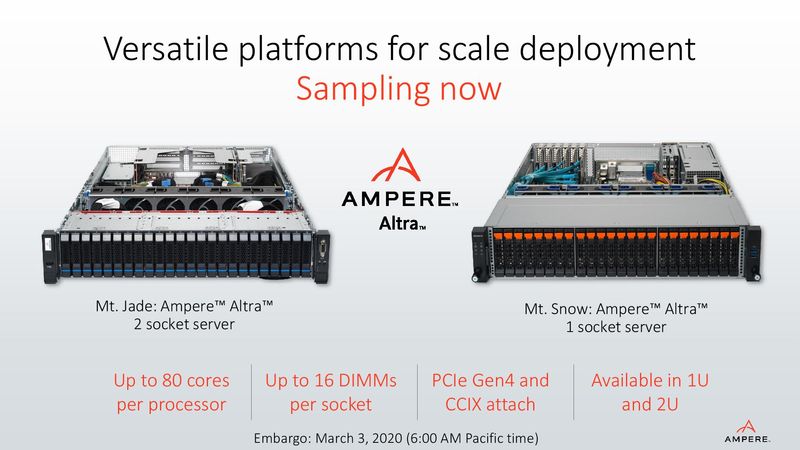

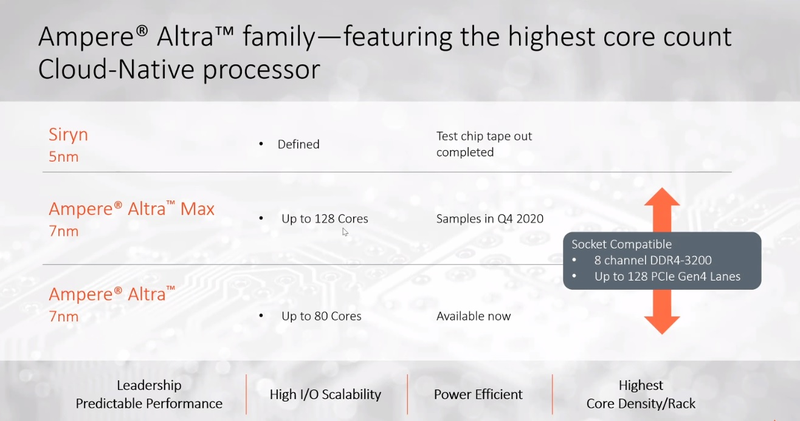

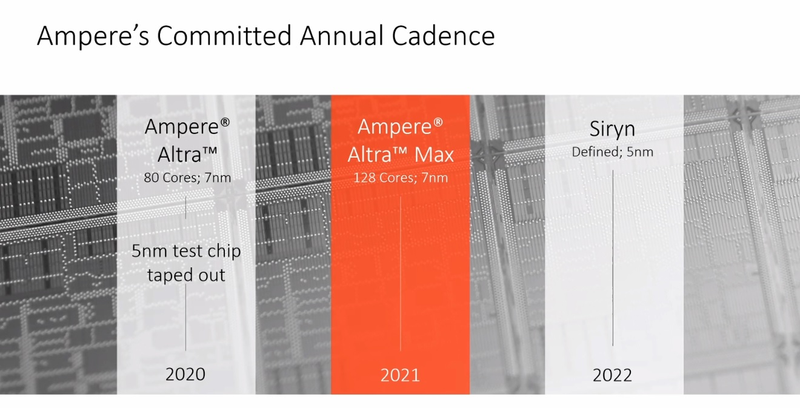

128 ядер ARM: Ampere Computing анонсировала процессоры Altra MaxНа первый взгляд, позиции архитектуры x86 в мире высокопроизводительных вычислений выглядят незыблемыми: примерно 94% всех систем класса HPC используют в качестве основы процессоры Intel и ещё 2,2% занимает AMD. Однако запуск кластера Fugaku доказал, что ARM — соперник весьма и весьма опасный. Система на базе процессоров Fujitsu A64FX использует именно архитектуру ARM. И наступление ARM продолжается и на других фронтах: к примеру, AWS предлагает инстансы на собственных ARM-процессорах Graviton2. Не дремлет Ampere Computing, анонсировавшая сегодня новые процессоры Altra и Altra Max.  Разработкой мощных многоядерных процессоров с архитектурой ARM компания занимается довольно давно: в конце прошлого года она уже рассказывала о втором поколении своих продуктов, чипах QuickSilver. В их основу лег дизайн ядра ARM Neoverse N1 (ARM v8.2+), количество самих ядер достигло 80, появилась поддержка интерфейса PCI Express 4.0, чего, например, до сих пор нет в процессорах Intel Xeon Scalable. Серверные процессоры с архитектурой ARM доказали своё превосходство в энергоэффективности перед x86, что сделало их отличным выбором для облачных сервисов — в таких ЦОД плотность упаковки вычислительных мощностей максимальна и такие параметры, как удельная производительность, энергопотребление и тепловыделение играют крайне важную роль. Новые процессоры Ampere под кодовым именем Altra нацелены именно на этот сектор рынка.  В основе Altra также лежит ядро Neoverse N1 — оно же применено и в проекте Amazon Graviton2 — но Ampere Computing намеревается охватить с помощью Altra остальных крупных провайдеров облачных услуг, которые также заинтересованы в высокоплотных энергоэффективных ЦП. При этом утверждается, что Altra превосходит Graviton2; по крайней мере, на бумаге это выглядит убедительно. Всего в серии Altra анонсировано 12 процессоров, с количеством ядер от 32 до 80, частотами от 1,7 до 3,3 ГГц и теплопакетами от 45 до 250 Ватт. Все они располагают восьмиканальным контроллером памяти DDR4-3200 (до 4 Тбайт на процессор) и предоставляют в распоряжение системы 128 линий PCI Express 4.0, чем пока могут похвастаться разве что AMD Rome. Применена очень простая система наименований: например, «Q72-30» означает, что перед нами 72 ядерный процессор поколения QuickSilver с частотой 3 ГГц.  Altra следует большинству современных тенденций в процессоростроении: процессоры располагают солидным массивом кешей (1 Мбайт на ядро, 32 Мбайт L3), ядра имеют два 128-битных блока инструкций SIMD, а также поддерживают популярные в задачах машинного интеллекта и инференс-комплексах форматы вычислений INT8 и FP16. Что касается удельной энергоэффективности, то ядро AMD Rome потребляет около 3 Ватт при полной нагрузке на частоте 3 ГГц, а для Altra Q80-30 этот показатель равен 2,6 Ватта; турборежима у Altra, впрочем, нет и максимальные частоты справедливы для всех ядер.  В настоящий момент компания поставляет образцы платформ Altra двух типов: однопроцессорную Mt. Snow и двухпроцессорную Mt. Jade. В число партнёров компании входят такие производители, как GIGABYTE и Wiwynn, заявлен также ряд контрактов с производителями более низких эшелонов. В основе Mt. Jade, вероятнее всего, лежит системная плата GIGABYTE MP32-AR0, о ней мы уже рассказывали нашим читателям.  Цены новых решений пока не разглашаются, однако, заинтересованные в процессорах Ampere провайдеры уже в течение двух месяцев тестируют новые платформы; в их число входят такие компании, как Packet и CloudFlare, причём Packet уже предоставляет своим клиентам «ранний доступ» к услугам, запускаемым на новых платформах Ampere. Более массовых поставок следует ожидать в августе и сентябре текущего года.  80 ядер — весьма солидное количество, даже в арсенале AMD таких процессоров ещё нет, семейство EPYC всё ещё ограничено 64 ядрами, но с SMT. Однако на достигнутом Ampere не останавливается и позднее в этом году планирует представить миру настоящего монстра — 128-ядерный процессор Altra Max, на базе всё той же архитектуры QuickSilver/Neoverse. Этот чип имеет кодовое имя Mystique, он будет базироваться на новом дизайне кристалла, однако отличия здесь количественные, качественно это всё та же Altra, но с большим количеством ядер, оптимизированная с учётом возможностей сохранённой неизменной подсистемой памяти. Сохранится даже совместимость по процессорному разъёму. Образцы Altra Max если и существуют, то только в лаборатории Ampere Computing, а публичного появления сэмплов этих процессоров следует ожидать не ранее 4 квартала с началом производства в 2021 году.  Таким образом, можно утверждать, что технологическая ступень 7 нм компанией освоена. Она штурмует новую высоту — образцы процессоров Siryn, построенные с использованием 5-нм техпроцесса TSMC должны появиться ближе к концу следующего года. Некоторые блоки Siryn уже существуют в кремнии. Эти процессоры получат и новую платформу, а, возможно, и поддержку таких технологий, как PCI Express 5.0 и DDR5.

22.06.2020 [18:20], Игорь Осколков

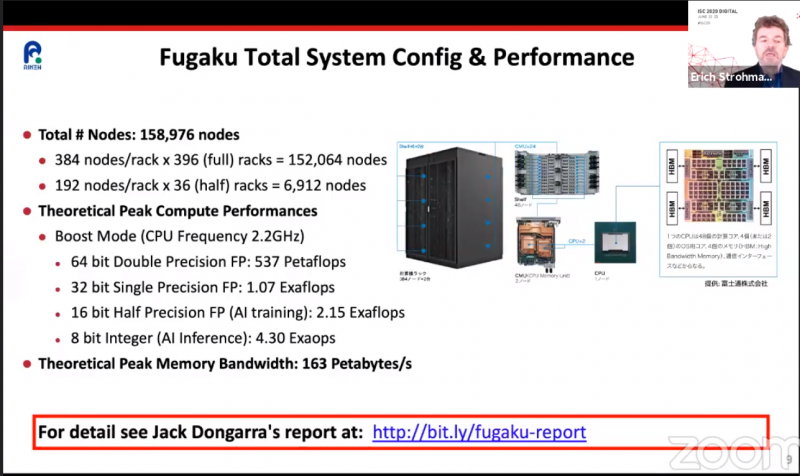

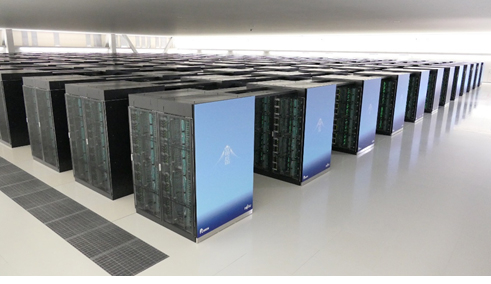

ARM-суперкомпьютер Fugaku поднялся на вершину рейтингов TOP500, HPCG и HPL-AIКонечно же, речь идёт о японском суперкомпьютере Fugaku на базе ARM-процессоров A64FX, который досрочно начал трудиться весной этого года. Эта машина стала самым мощным суперкомпьютером в мире сразу в трёх рейтингах: классическом TOP500, современном HPCG и специализированном HPL-AI.  Суперкомпьютер состоит из 158976 узлов, которые имеют почти 7,3 млн процессорных ядер, обеспечивающих реальную производительность на уровне 415,5 Пфлопс, то есть Fugaku почти в два с половиной раза быстрее лидера предыдущего рейтинга, машины Summit. Правда, оказалось, что с точки зрения энергоэффективности новая ARM-система мало чем отличается от связки обычного процессора и GPU, которой пользуется большая часть суперкомпьютеров. Так что на первое место в Green500 она не попала. Однако на стороне Fugaku универсальность — понижение точности вычислений вдвое приводит к удвоение производительности. Так что машина имеет впечатляющую теоретическую пиковую скорость вычислений 4,3 Эопс на INT8 и не менее впечатляющие 537 Пфлопс на FP64. Это помогло занять её первое место в бенчмарке HPL-AI, которые использует вычисления разной точности. А общая архитектура процессора, включающего набортную память HBM2, и системы, использующей интерконнект Tofu, способствовали лидерству в бенчмарке HPCG, который оценивает эффективность машины в целом.

22.06.2020 [12:39], Илья Коваль

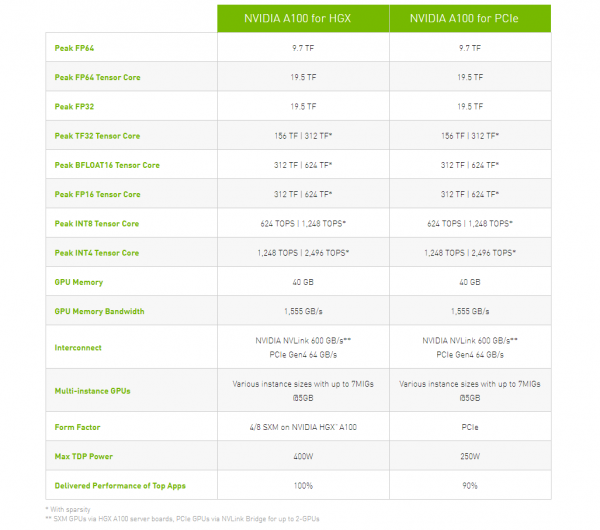

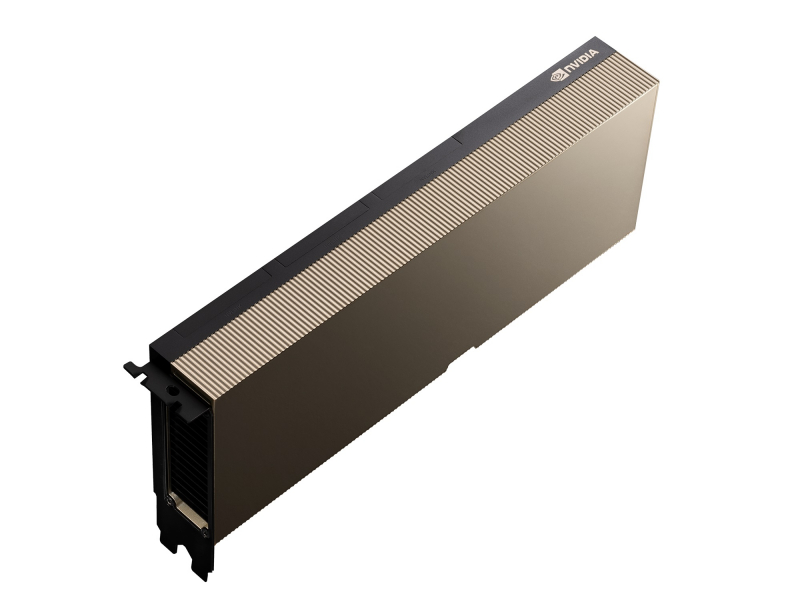

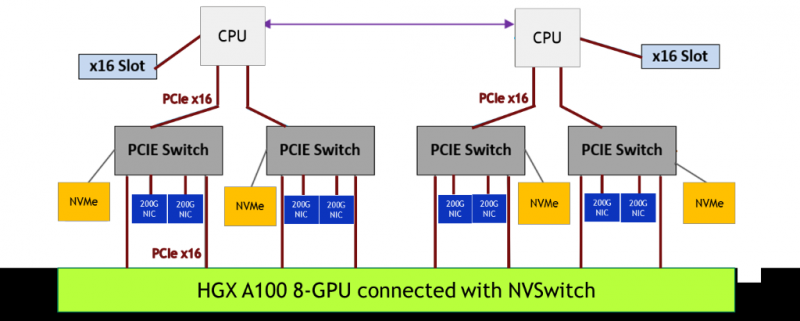

NVIDIA представила PCIe-версию ускорителя A100Как и предполагалось, NVIDIA вслед за SXM4-версией ускорителя A100 представила и модификацию с интерфейсом PCIe 4.0 x16. Обе модели используют идентичный набор чипов с одинаковыми характеристикам, однако, помимо отличия в способе подключения, у них есть ещё два существенных отличия. Первое — сниженный с 400 Вт до 250 Вт показатель TDP. Это прямо влияет на величину устоявшейся скорости работы. Сама NVIDIA указывает, что производительность PCIe-версии составит 90% от SXM4-модификации. На практике разброс может быть и больше. Естественным ограничением в данном случае является сам форм-фактор ускорителя — только классическая двухслотовая FLFH-карта с пассивным охлаждением совместима с современными серверами. Второе отличие касается поддержки быстрого интерфейса NVLink. В случае PCIe-карты посредством внешнего мостика можно объединить не более двух ускорителей, тогда как для SXM-версии есть возможность масштабирования до 8 ускорителей в рамках одной системы. С одной стороны, NVLink в данном случае практически на порядок быстрее PCIe 4.0. С другой — PCIe-версия наверняка будет заметно дешевле и в этом отношении универсальнее. Производители серверов уже объявили о поддержке новых ускорителей в своих системах. Как правило, это уже имеющиеся платформы с возможностью установки 4 или 8 (реже 10) карт. Любопытно, что фактически единственным разумным вариантом для плат PCIe 4.0, как и в случае HGX/DGX A100, является использование платформ на базе AMD EPYC 7002.

19.06.2020 [18:09], Юрий Поздеев

HPE анонсировала Superdome Flex 280: 224 ядра Cooper Lake и 24 Тбайт RAMHPE анонсировала Superdome Flex 280 с поддержкой процессоров Intel Xeon третьего поколения, которые вышли недавно. Данная модель дополняет портфель HPE Superdome Flex и ориентирована на средние предприятия, для которых избыточна масштабируемость до 32 сокетов. Оптимально данная модель подойдет для больших баз Oracle, SAP HANA или SQL-сервера. Новинка выпускается в форм-факторе 5U и поддерживает установку 2 или 4 процессоров Intel Xeon Gold или Intel Xeon Platinum. Это выгодно отличает Superdome Flex от других подобных систем, в которых можно использовать только Intel Xeon Platinum, который стоит значительно дороже.  Недавно анонсировали новые процессоры Intel Xeon третьего поколения, в которых не только добавили функции ускорения ИИ, но и поддержку более быстрой памяти DDR4-3200, что должно положительным образом сказаться на производительности. Максимально в одну платформу можно установить до 24 Тбайт оперативной памяти, а если и этого недостаточно, то можно использовать Intel Optane PMem 200 .  Слотов расширения PCIe тоже достаточно для большинства задач — до 32 на одну платформу, при этом можно установить до 16 графических ускорителей NVIDIA. Для локального хранилища можно использовать до 20 накопителей SAS/SATA/NVMe. Масштабируется платформа Superdome Flex 280 до 8 процессоров с шагом в 2 CPU, что позволяет работать с большими базами данных и моделями для ИИ, для которых требуется большой объем оперативной памяти. Суммарно можно получить до 224 ядер и до 24 Тбайт общей памяти. HPE Superdome Flex 280 будет доступен в 4 квартале 2020 года.

18.06.2020 [19:38], Владимир Мироненко

AWS Snowcone — мини-облако в дорогуКомпания Amazon анонсировала AWS Snowcone, нового представителя семейства устройств AWS Snow, предназначенных для периферийных вычислений, хранения и передачи данных из удалённых сред или мест, где отсутствует подключение к сети. Snowcone весит всего 2,1 кг и имеет габариты 227 × 148,6 × 82,65 мм. Мини-облако поддерживает запуск малых инстансов Amazon EC2:

Внутри у него неназванный x86-процессор c минимум двумя ядрами и 4 Гбайт оперативной памяти. Также у устройства имеется хранилище ёмкостью 8 Тбайт. AWS Snowcone можно подключать как к проводным, так и беспроводным сетям — у него есть два порта 1/10GbE и адаптер Wi-Fi 802.11a/b/g/n/ac. Питается устройство от порта USB Type-C (мин. 61 Вт), возможно подключение внешнего аккумулятора. Устройство защищено от внешнего воздействия согласно стандарту IP65. Диапазон рабочих температур: 0°...38° C. Максимальный расчётный срок службы составляет 4 года.  Перед отправкой клиенту Amazon загрузит в устройство желаемый образ AMI, в том числе с IoT Greengrass. Для обмена данными с внешним миром используется NFSv4. Устройство можно использовать с существующими локальными серверами и файловыми приложениями для чтения и записи данных. Как и в случае других решений семейства Snow, Snowcone с загруженными клиентом данными можно отправить назад в Amazon, чтобы они были перемещены в S3-хранилище в выбранном клиентом облачном регионе. В настоящий момент AWS Snowcone можно арендовать лишь в США: $60 за заказ + $6 за каждый день использования. В дальнейшем AWS будет предлагать эту услугу в других регионах.

18.06.2020 [16:00], Алексей Степин

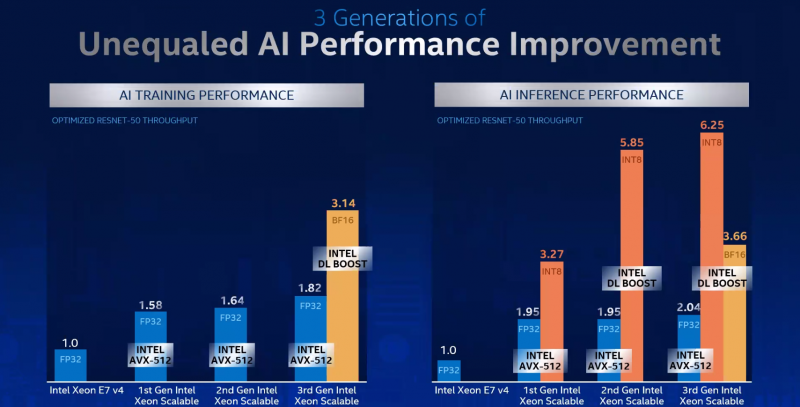

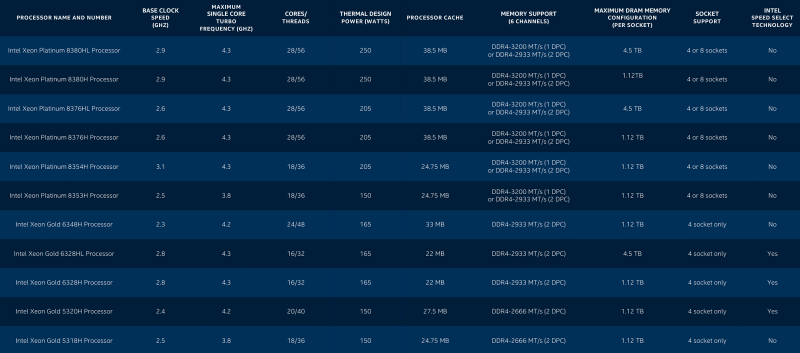

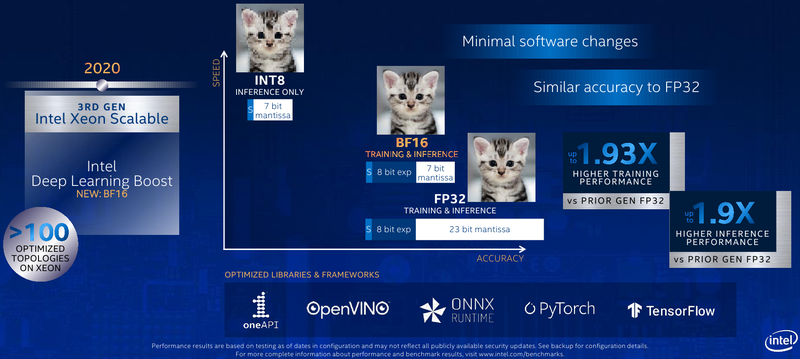

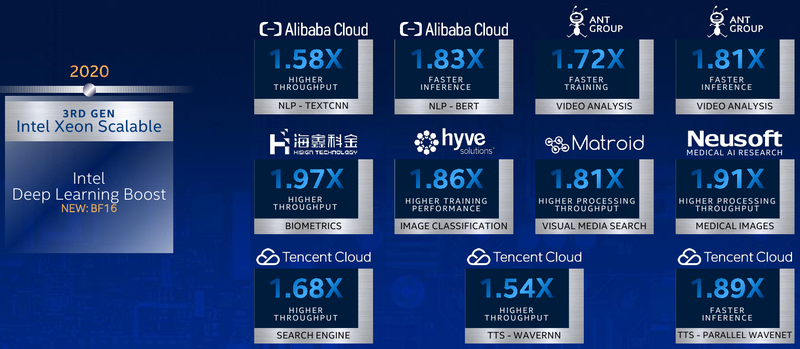

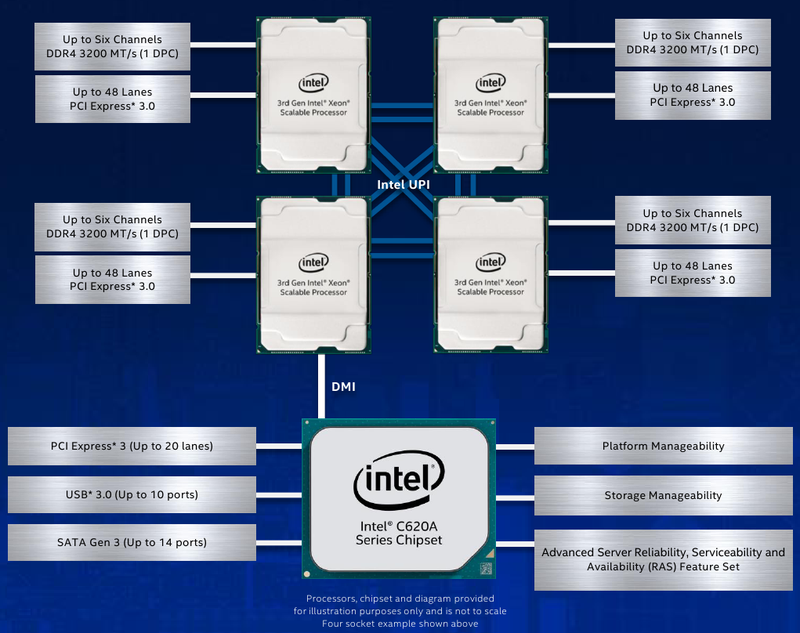

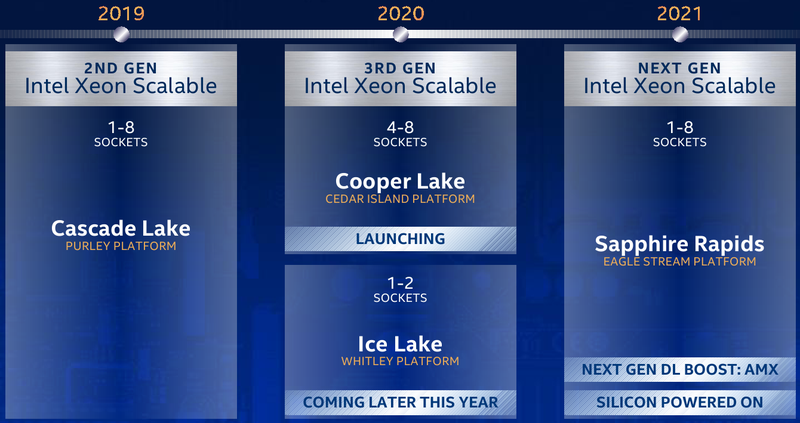

Intel представила Xeon Cooper Lake, третье поколение Scalable-процессоровКрупнейший в мире производитель процессоров с архитектурой x86, компания Intel, представила новую платформу, нацеленную на быстро растущий рынок машинного обучения, аналитики и периферийных вычислений. Хотя платформа состоит из нескольких компонентов, главным из них являются новые процессоры Intel Xeon Scalable — это уже третье поколение серии Scalable.  Первое поколение Xeon Scalable (Skylake) отличалось наличием поддержки векторных расширений с длиной 512 бит, хотя эта поддержка была наиболее полной в других процессорах с разъёмом LGA 3647, ныне почивших Xeon Phi 72xx. Во втором поколении Xeon Scalable, известном под кодовым именем Cascade Lake, появились расширения AVX-512 VNNI (Vector Neural Network Instructions, они же DL Boost), и это был первый реверанс в сторону машинного обучения со стороны Intel — расширения позволялил работать с INT8 и подходили для инференса.  Третье поколение, получившее имя Cooper Lake, ещё больше продвинулось в сторону поддержки нетипичных для традиционной архитектуры x86 форматов вычислений. Главным нововведением здесь является поддержка формата bfloat16, который часто используется в комплексах машинного обучения и системах принятия решений (инференс). Он требует меньше вычислительных мощностей, нежели традиционные форматы FP32/64, но при этом в большинстве случаев обеспечивает достаточную точность вычислений, а итоговый выигрыш в производительности может быть почти двухкратным.  Популярные фреймворки, такие как TensorFlow и Pytorch, уже давно поддерживают bfloat16, а Intel-оптимизированные версии доступны в комплекте Intel AI Analytics Toolkit. Компания также оптимизировала среды OpenVINO и ONNX с учётом возможностей новых процессоров Xeon Scalable. Собственно говоря, самое главное в Cooper Lake то, что их теперь можно использовать и для обучения нейронных сетей, а не только для инференса. Intel отдельно подчёркивает универсальность новых CPU. Что касается самих процессоров, то максимальное количество ядер сохранилось, их в серии Xeon Gold 53xx/63xx и Xeon Platinum 83xx по-прежнему 28 при поддержке SMT2. Однако улучшения есть, и достаточно серьёзные. Серия Xeon Platinum поддерживает память до DDR4-3200 (1DPC) и DDR4-2933 (2DPC), хотя младшие пяти- и шеститысячники так же ограничены 2666 и 2933 MT/с. Зато все они поддерживают память Intel Optane DCPMM 2-го поколения. Число каналов память осталось прежним, их шесть. Существенное отличие от Cascade Lake в том, что теперь у всех CPU есть 6 линий UPI — они могут может «бесшовно» устанавливаться в системы с четырьмя или восемью процессорными разъёмами. Другое важное отличие — серия 53xx теперь имеет два FMA-порта для AVX-512, а не один как раньше. Часть новинок поддерживает Intel Speed Select. У «ёмких» моделей с суффиксом HL максимальный объём оперативной памяти достиг 4,5 Тбайт, а у базовых H — до 1,12 Тбайт. Несколько подросли тактовые частоты, в серии есть модели с частотной формулой 2,9 ‒ 4,3 ГГц, причём большая часть новинок имеет частоту в турборежиме более 4 ГГц. Исключение — модели с пониженным энергопотреблением. Всё это делает новые процессоры привлекательными для крупных предприятий, облачных провайдеров и гиперскейлеров вообще. Если даже на секунду забыть все новововведения для ИИ, Cooper Lake всё равно останется многосокетной платформой, а это значит, что он подходит для работы с большими СУБД, анализа больших объёмов данных в реальном времени, OLTP и виртуализации. В области 4S/8S-платформ у Intel давно крепкие позиции, так что новинки наверняка приглянутся определённому кругу заказчиков. Но массовыми Cooper Lake в текущем виде не станут.  Основной системный чипсет — Intel C620A, то есть обновлённый Lewisburg. В серию пока входит всего три модели, две из которых поддерживают технологию Intel QAT, ускоряющую работы по компресии и шифрованию. Так это обновление уже имеющихся чипсетов, поддержки PCI Express 4.0 нет. Сами процессоры Xeon Scalable третьего поколения по-прежнему могут предоставить в распоряжение системы до 48 линий PCIe 3.0. С учётом того, что ориентированы они на 4-сокетные системы, этого может быть вполне достаточно.  Однако другие процессоры Xeon Scalable «Ice Lake», для одно-двухсокетных платформ Whitley, которые Intel планирует представить позднее в этом году, уже получат поддержку PCI Express 4.0. Также известно, что четвёртое поколение Xeon Scalable под именем Sapphire Rapids получит набор новых матричных расширений (Advanced Matrix Extensions, AMX), которые, вероятно, буду напоминать тензорные ядра. Она увидит свет уже в 2021 году. Для массовых одно- и двухсокетных платформ пока предлагается использовать Cascade Lake Refresh. Вместе с Intel Xeon Cooper Lake компания также анонсировала второе поколение памяти Intel Optane DCPMM 200, накопители Intel D7-P5500 и D7-5600 с интерфейсом PCIe 4.0 и новую FPGA Intel Stratix 10 NX.

09.06.2020 [19:49], Юрий Поздеев

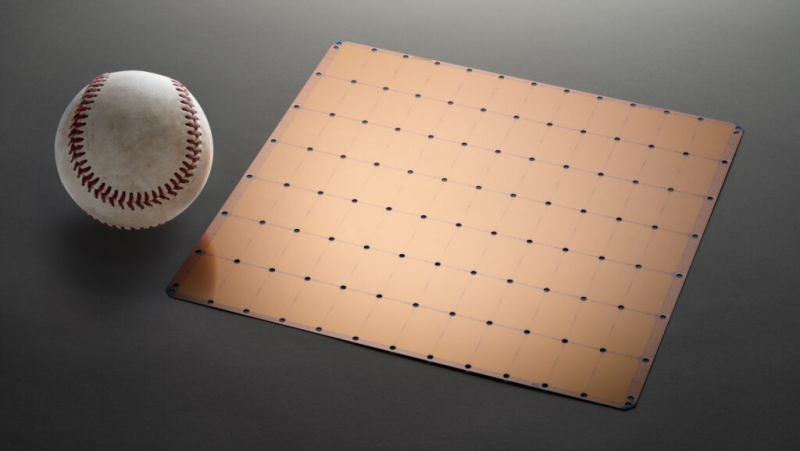

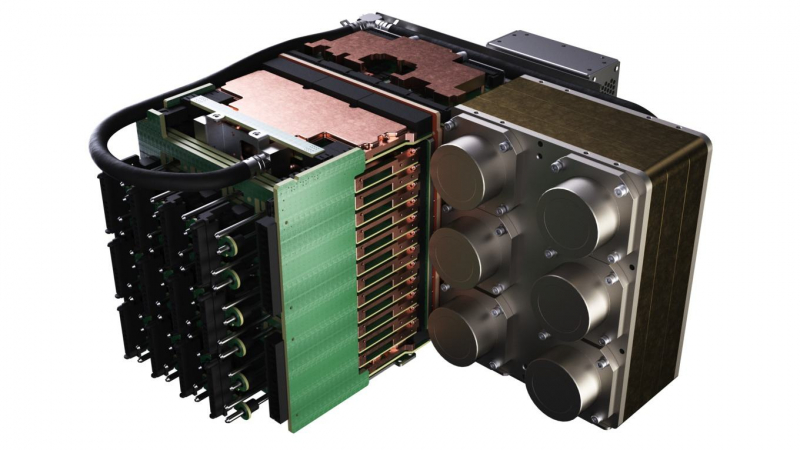

Суперкомпьютер Neocortex: 800 тыс. ядер Cerebras для ИИПиттсбургский суперкомпьютерный центр (PSC) получит $5 млн от Национального научного фонда на создание суперкомпьютера нового типа Neocortex, который объединяет ИИ-серверы Cerebras CS-1 и HPE SuperDome Flex в единую систему с общей памятью. Планируется, что решение будет введено в эксплуатацию до конца 2020 года.  Каждый сервер Cerebras CS-1 имеет процессор Cerebras Wafer Scale Engine (WSE), который содержит 400 000 ядер, оптимизированных для работы с ИИ (46 225 мм2, 1,2 трлн транзисторов). В паре с ними работает HPE SuperDome Flex, который используется для предварительной обработки информации и постобработки после Cerebras. SuperDome Flex представлен в максимальной комплектации, то есть с 32 процессорами Intel Xeon, 24 Тбайт оперативной памяти, 205 Тбайт флеш-памяти и 24 интерфейсными картами.  Каждый сервер Cerebras CS-1 подключается к SuperDome Flex через 12 каналов со скоростью 100 Гбит/с каждый. Процессор WSE способен обрабатывать 9 Пбайт данных в секунду, что, по подсчетам Nystrom, эквивалентно примерно миллиону фильмов в HD-качестве. Характеристики решения действительно впечатляют!

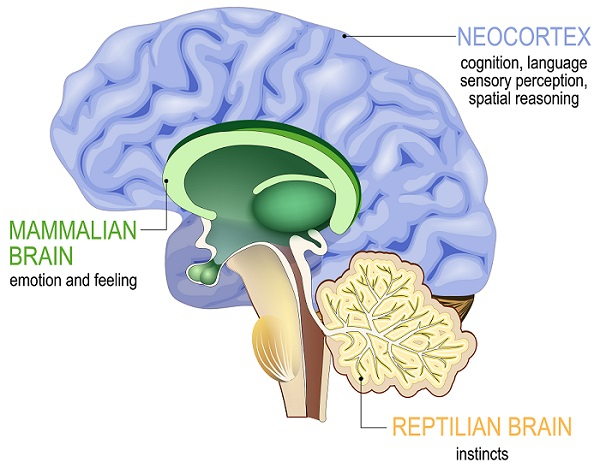

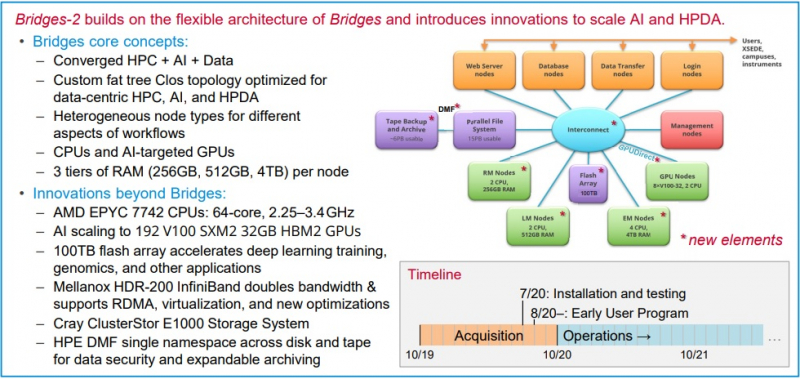

Neocortex назван в честь области мозга, отвечающей за функции высокого порядка, включая когнитивные способности, сновидения и формирование речи Архитектура решения строилась таким образом, чтобы не пришлось разбивать вычислительные блоки на множество узлов — это позволило снизить задержки в обработке информации и ускорить обучение моделей ИИ. Cerebras CS-1 разрабатывался специально для ИИ, поэтому он имеет преимущества перед серверами с графическими ускорителями, которые хорошо справляются с матричными операциями, но имеют многие конструктивные ограничения.  По заявлениям Neocortex, сервер CS-1 будет на несколько порядков мощнее системы PSC Bridges-AI. Один сервер Neocortex CS-1 будет эквивалентен примерно 800-1500 серверов с традиционной архитектурой с использованием графических ускорителей. Задачи, в которых Neocortex покажет себя максимально эффективно относятся к классу нейронных сетей DCIGN (deep convolutional inverse graphics networks) и RNN (recurrent neural networks). Если говорить простыми словами, то это более точное прогнозирование погоды, анализ геномов, поиск новых материалов и разработка новых лекарств.  PSC, помимо Neocortex, запускает еще и новое поколение системы Bridges-2, которое будет развернуто осенью 2020 года. Таким образом, до конца этого года будут введены в эксплуатацию два мощных суперкомпьютера для ИИ. Neocortex и Bridges-2 будут поддерживать самые популярные фреймворки машинного обучения, что позволит создать гибкую и мощную экосистему для ИИ, анализа данных, моделирования и симуляции. До 90% машинного времени Neocortex будет выделяться через XSEDE (Extreme Science and Engineering Discovery Environment), финансируемую NSF организацию, которая координирует совместное использование передовых цифровых услуг, включая суперкомпьютеры и ресурсы для визуализации и анализа данных, с исследователями на национальном уровне.

05.06.2020 [23:23], Алексей Степин

Предложение Huawei отказаться от TCP/IP восторгов не вызвалоСтеку TCP/IP, благодаря которому существует всемирная сеть, уже не один десяток лет. DARPA начало исследования по этой теме ещё в конце 60-х, и не все согласны с тем, что данная технология продолжает отвечать требованиям времени: Huawei предложила Международному союзу электросвязи (ITU) план по отказу от TCP/IP и переходу на более современное и безопасное, по её мнению, решение New IP. Определённый резон в этом есть: современные сети чрезвычайно сложны, они базируются на весьма разнообразном оборудовании, и что такое «кибервойна» сегодня, пожалуй, знают все, кто хоть сколько-то интересуется тематикой информационных технологий. Достаточно хотя бы сделать на нашем сайте поиск по слову «уязвимость» — и становится понятным, что понятия «интернет» и «безопасность» сегодня сочетаются не очень хорошо.

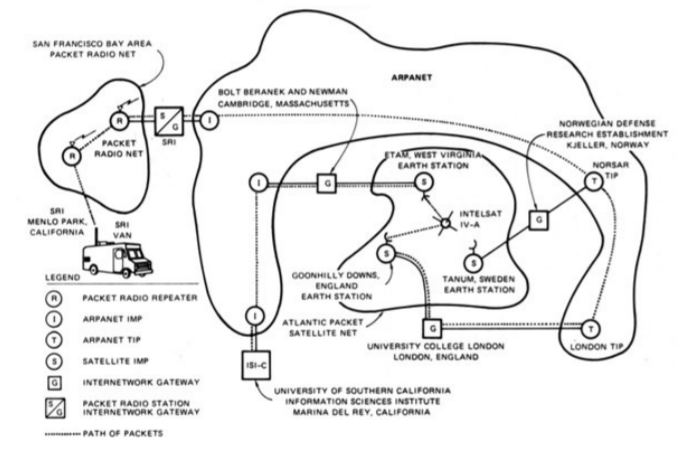

Демонстрация TCP/IP, объединяющая сети ARPANET, PRNET и SATNET. 1977 год Корпорация Huawei выступила в ITU с предложением отказаться от стека TCP/IP и перейти на использование более гибких и безопасных технологий. Понять позицию китайской компании можно: она находится в состоянии «войны» с США и желание продвинуть собственные технологии для нее совершенно естественно. Позиции, предлагаемые Huawei, выглядят довольно привлекательно:

Технических деталей, к сожалению, в публичном доступе пока нет. Реакция на предложение Huawei оказалась достаточно негативной: оно было охарактеризовано, как попытка внедрения централизации и «тоталитарных» методов. В частности, предложенный механизм отсечения частей сети можно использовать не только для защиты от DDoS-атак. Сама Huawei обвинения в «тоталитаризме» отвергла, заявив, что не связывает технологию с политикой. Еврокомиссия опубликовала свой ответ: в нём говорится, что за время своего существования модель TCP/IP доказала свою жизнеспособность, продемонстрировав нужную степень отказоустойчивости и масштабируемости. Аналогичной точки зрения придерживается Cisco, считая TCP/IP достаточно гибкой технологией, чтобы отвечать вызовам времени.

О дивный, новый Интернет! Нужда в усовершенствовании сетевых технологий существует, но это следует делать в рамках существующих стандартов. Евросоюз планирует защищать «видение единого, открытого, нейтрального, свободного и нефрагментированного интернета». («the vision of a single, open, neutral, free and unfragmented internet»). Тем не менее, война технологий, скорее всего, в ближайшее время продолжится. Предсказать исход пока не представляется возможным, но Huawei явно не собирается сдаваться просто так и будет продвигать инициативу New IP далее.

14.05.2020 [18:52], Рамис Мубаракшин

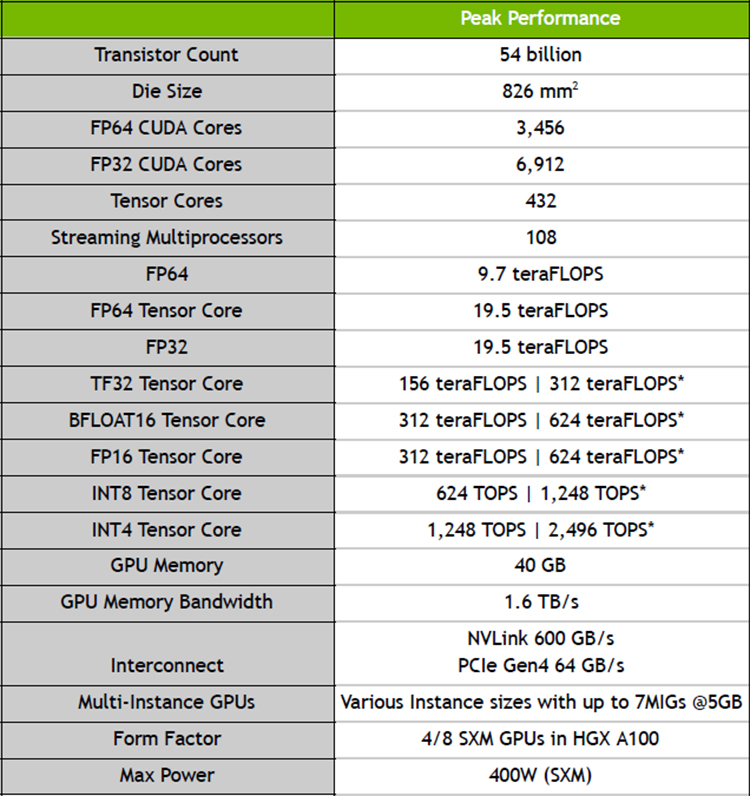

NVIDIA представила ускорители A100 с архитектурой Ampere и систему DGX A100 на их основеNVIDIA официально представила новую архитектуру графических процессоров под названием Ampere, которая является наследницей представленной осенью 2018 года архитектуры Turing. Основные изменения коснулись числа ядер — их теперь стало заметно больше. Кроме того, новинки получили больший объём памяти, поддержку bfloat16, возможность разделения ресурсов (MIG) и новые интерфейсы: PCIe 4.0 и NVLink третьего поколения. NVIDIA A100 выполнен по 7-нанометровому техпроцессу и содержит в себе 54 млрд транзисторов на площади 826 мм2. По словам NVIDIA, A100 с архитектурой Ampere позволяют обучать нейросети в 40 раз быстрее, чем Tesla V100 с архитектурой Turing.

Характеристики A100 Первой основанной на ней вычислительной системой стала фирменная DGX A100, состоящая из восьми ускорителей NVIDIA A100 с NVSwitch, имеющих суммарную производительность 5 Пфлопс. Стоимость одной системы DGX A100 равна $199 тыс., они уже начали поставляться некоторым клиентам. Известно, что они будут использоваться в Аргоннской национальной лаборатории для поддержания работы искусственного интеллекта, изучающего COVID-19 и ищущего от него лекарство. Так как некоторые группы исследователей не могут себе позволить покупку системы DGX A100 из-за ее высокой стоимости, их планируют купить поставщики услуг по облачным вычислений и предоставлять удалённый доступ к высоким мощностям. На данный момент известно о 18 провайдерах, готовых к использованию систем и ускорителей на основе архитектуры Ampere, и среди них есть Google, Microsoft и Amazon.

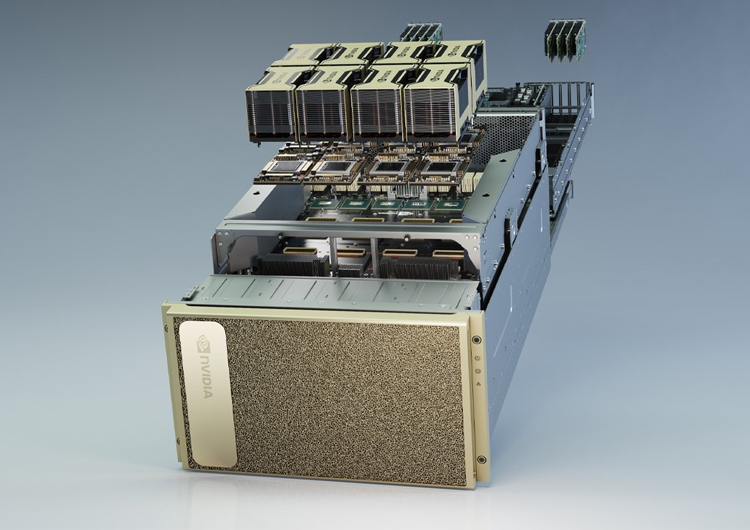

Система NVIDIA DGX A100 Помимо системы DGX A100, компания NVIDIA анонсировала ускорители NVIDIA EGX A100, предназначенная для периферийных вычислений. Для сегмента интернета вещей компания предложила плату EGX Jetson Xavier NX размером с банковскую карту. |

|