Материалы по тегу: суперкомпьютер

|

09.05.2025 [01:40], Владимир Мироненко

Первая фаза ИИ-кластера xAI Colossus полностью обеспечена энергией1 мая ИИ-кластер xAI Colossus в Мемфисе (Теннесси, США), менее чем через год после запуска проекта, достиг полной готовности для эксплуатации в рамках первой фазы развёртывания, поскольку оборудование подключили к основной энергосети посредством недавно построенной электрической подстанции, сообщается на сайте Торговой палаты Большого Мемфиса. Питание ИИ-кластера в пределах 150 МВт будут обеспечивать энергоснабжающие компании Memphis Light, Gas, and Water (MLGW) и Tennessee Valley Authority (TVA). Кроме того, площадка оборудована аккумуляторными системами Tesla Megapack на 150 МВт (ёмкость явно не указана), предназначенными для использования в качестве резервного источника питания на случай аварийных отключений сети или повышенного спроса, говорится в сообщении. «xAI привержена Мемфису посредством своих устойчивых экологических практик. Компания участвует в программе Demand Response, как указала MLGW, и изучает способы подачи энергии в сеть на благо общества, особенно в чрезвычайных ситуациях или других случаях необходимости. По мере роста xAI будет расти и Мемфис», — отметила Торговая палата Большого Мемфиса. xAI запустила ИИ-кластер xAI Colossus в июле прошлого года. В нём было установлено 100 тыс. ускорителей NVIDIA H100. В связи с тем, что ИИ-кластер был построен в рекордные сроки — всего за 19 дней — на период строительства подстанций для подключения к сетям операторов, для обеспечения его энергией установили временные газовые генераторы, а также энергохранилища Tesla Megapack. Торговая палата сообщила, что примерно половина газовых турбин будет демонтирована в течение двух месяцев. Остальная часть продолжит функционировать до ввода в эксплуатацию второй подстанции на 150 МВт, строительство которой должны закончить осенью 2025 года, после чего газовые турбины переведут в резервную систему электропитания. Таким образом, власти косвенным образом признали, что xAI действительно воспользовалась лазейкой в законах, развернув 35 турбин вместо изначально разрешённых 15. Как сообщает The Register, всего в качестве резерва в дальнейшем будет использоваться 15 газовых турбин: восемь новых, оснащённых системами селективного каталитического восстановления (SCR) для снижения выбросов, и семь модернизированных, которые будут соответствовать существующим требованиям Закона о чистом воздухе США. По словам основателя xAI Илона Маска (Elon Musk), со временем в ИИ-кластере будет развернуто до 1 млн ускорителей. В феврале сообщалось, что xAI рассматривает возможность строительства ещё одного ЦОД.

08.05.2025 [19:22], Сергей Карасёв

Cadence представила суперкомпьютер Millennium M2000 на базе NVIDIA BlackwellКомпания Cadence анонсировала суперкомпьютер Millennium M2000, спроектированный для выполнения сложного моделирования с использованием ИИ. Новая НРС-система предназначена для ускорения проектирования микрочипов, разработки лекарственных препаратов следующего поколения и пр. Суперкомпьютер построен на платформе NVIDIA HGX B200. Кроме того, задействованы карты NVIDIA RTX Pro 6000 Blackwell Server Edition, оснащённые 96 Гбайт памяти GDDR7. Применены библиотеки NVIDIA CUDA-X и специализированное ПО для решения ресурсоёмких задач. Утверждается, что Millennium M2000 обеспечивает до 80 раз более высокую производительность по сравнению с системами на базе CPU в области автоматизации проектирования электроники (EDA), создания и анализа систем (SDA) и разработки медикаментов. При этом глубоко оптимизированный программно-аппаратный стек помогает существенно сократить общее энергопотребление. В качестве примера приводится моделирование подсистемы питания на уровне полупроводниковых чипов. В случае вычислительных комплексов на основе сотен традиционных CPU на выполнение такой задачи может потребоваться около двух недель. Суперкомпьютер Millennium M2000 позволит получить результат менее чем за один день. Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) сообщил, что компания планирует приобрести десять суперкомпьютерных систем Millennium на базе GB200 NVL72 для ускорения проектирования собственных продуктов. Сторонние заказчики смогут получить доступ к Millennium M2000 через облако или купить устройство для установки в собственном дата-центре. Базовая конфигурация включает около 32 ускорителей и стоит $2 млн, но это не финальная цена.

05.05.2025 [13:28], Сергей Карасёв

GigaIO и d-Matrix предоставят инференс-платформу для масштабных ИИ-развёртыванийКомпании GigaIO и d-Matrix объявили о стратегическом партнёрстве с целью создания «самого масштабируемого в мире» решения для инференса, ориентированного на крупные предприятия, которые разворачивают ИИ в большом масштабе. Ожидается, что новая платформа поможет устранить узкие места в плане производительности и упростить внедрение крупных ИИ-систем. В рамках сотрудничества осуществлена интеграция ИИ-ускорителей d-Matrix Corsair в состав НРС-платформы GigaIO SuperNODE. Архитектура Corsair основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC), работающих на скорости около 150 Тбайт/с. По заявлениям d-Matrix, ускоритель обеспечивает непревзойдённую производительность и эффективность инференса для генеративного ИИ. Устройство выполнено в виде карты расширения с интерфейсом PCIe 5.0 х16. Быстродействие достигает 2,4 Пфлопс с (8-бит вычисления). Изделие имеет двухслотовое исполнение, а показатель TDP равен 600 Вт. В свою очередь, SuperNODE использует фирменную архитектуру FabreX на базе PCIe, которая позволяет объединять различные компоненты, включая GPU, FPGA и пулы памяти. По сравнению с обычными серверными кластерами SuperNODE обеспечивает более эффективное использование ресурсов.

Источник изображения: d-Matrix Новая модификация SuperNODE поддерживает десятки ускорителей Corsair в одном узле. Производительность составляет до 30 тыс. токенов в секунду при времени обработки 2 мс на токен для таких моделей, как Llama3 70B. По сравнению с решениями на базе GPU обещаны трёхкратное повышение энергоэффективности и в три раза более высокое быстродействие при сопоставимой стоимости владения. «Наша система избавляет от необходимости создания сложных многоузловых конфигураций и упрощает развёртывание, позволяя предприятиям быстро адаптироваться к меняющимся рабочим нагрузкам ИИ, при этом значительно улучшая совокупную стоимость владения и операционную эффективность», — говорит Alan Benjamin (Алан Бенджамин), генеральный директор GigaIO.

03.05.2025 [16:00], Руслан Авдеев

В Рио-де-Жанейро построят крупнейший в Латинской Америке кампус ЦОД Rio AI CityВ Рио-де-Жанейро объявлено о строительстве нового ИИ ЦОД. После завершения проекта кампус дата-центров станет крупнейшим в Латинской Америке и одним из крупнейших в мире, сообщает Datacenter Dynamics. Кампус Rio AI City расположится на территории Olympic Park. Первые 1,8 ГВт намерены ввести в строй к 2027 году, а к 2032 году возможно расширение до 3 ГВт. Ожидается, что в кампусе будут обеспечены условия для развёртывания новейших суперкомпьютеров. По словам мэра города, анонсировавшего проект, главная цель строительства нового кампуса — повысить роль Рио в развитии ИИ и закрепить за городом статус «столицы инноваций Латинской Америки». Город намерен стать движущей силой «ИИ-революции» и обеспечить гарантии того, что развитие искусственного интеллекта пойдёт обществу на благо. Мэр пообещал, что кампус будет целиком обеспечиваться «чистой» энергией и получит «неограниченный» запас воды для охлаждения оборудования. Кампус напрямую связан с проектом Porto Maravilha, предполагающим восстановление в городе старого портового района. По словам муниципальных властей, район станет центром экоустойчивых инноваций, а вычислительные мощности Rio AI City станут использовать для поддержки роста локальных стартапов. По данным Data Center Map, в Рио-де-Жанейро в настоящее время действует 21 дата-центр. В городе работают операторы Ascenty, Elea и Equinix. В прошлом месяце Equinix запустила в городе свой третий ЦОД — RJ3. Буквально на днях появилась информация, что ByteDance рассматривает строительство в Бразилии дата-центра TikTok, но он будет находиться в отдалении от Рио, в штате Сеара.

28.04.2025 [14:48], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO Gryf обеспечит производительность до 30 ТфлопсКомпания GigaIO объявила о доступности системы Gryf — так называемого ИИ-суперкомпьютера в чемодане, разработанного в сотрудничестве с SourceCode. Это сравнительно компактное устройство, как утверждается, обеспечивает производительность ЦОД-класса для периферийных развёртываний. Первая информация о Gryf появилась около года назад. Устройство выполнено в корпусе с габаритами 228,6 × 355,6 × 622,3 мм, а масса составляет примерно 25 кг. Система может эксплуатироваться при температурах от +10 до +32 °C. Конструкция предусматривает использование модулей Sled четырёх типов: это вычислительный узел Compute Sled, блок ускорителя Accelerator Sled, узел хранения Storage Sled и сетевой блок Network Sled. Доступны различные конфигурации, но суммарное количество модулей Sled в составе Gryf не превышает шести. Плюс к этому в любой комплектации устанавливается модуль питания с двумя блоками мощностью 2500 Вт. Узел Compute Sled содержит процессор AMD EPYC 7003 Milan с 16, 32 или 64 ядрами, до 512 Гбайт DDR4, системный SSD формата M.2 (NVMe) вместимостью 512 Гбайт и два порта 100GbE QSFP56. Блок Storage Sled объединяет восемь накопителей NVMe SSD E1.L суммарной вместимостью до 492 Тбайт. Модуль Network Sled предоставляет два порта QSFP28 100GbE и шесть портов SFP28 25GbE. За ИИ-производительность отвечает модуль Accelerator Sled, который может нести на борту ускоритель NVIDIA L40S (48 Гбайт), H100 NVL (94 Гбайт) или H200 NVL (141 Гбайт). В максимальной конфигурации быстродействие в режиме FP64 достигает 30 Тфлопс (3,34 Пфлопс FP8), а пропускная способность памяти — 4,8 Тбайт/с.

Источник изображения: GigaIO Архитектура новинки обеспечивает возможность масштабирования путём объединения в единый комплекс до пяти экземпляров Gryf: в общей сложности можно совместить до 30 модулей Sled в той или иной конфигурации. Заказы на Gryf уже поступили со стороны Министерства обороны США, американских разведывательных структур и пр.

16.04.2025 [14:20], Сергей Карасёв

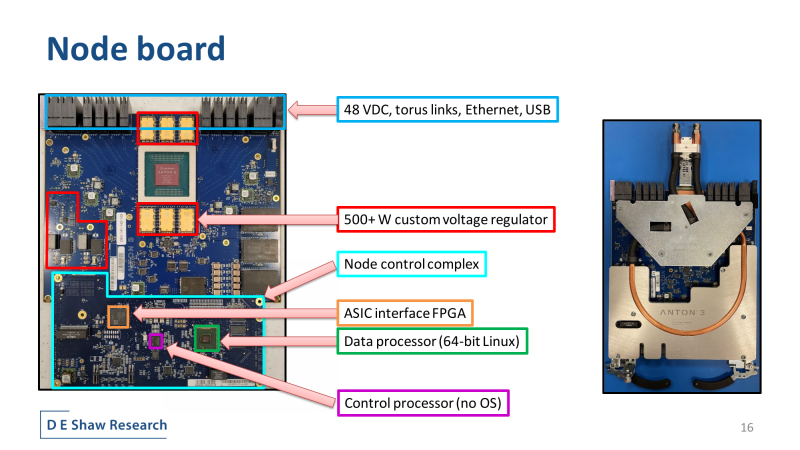

Уникальный суперкомпьютер Anton 3 для задач молекулярной динамики введён в эксплуатациюПиттсбургский суперкомпьютерный центр (PSC) ввёл в эксплуатацию вычислительный комплекс Anton 3 — специализированный суперкомпьютер следующего поколения, предназначенный для биомолекулярного моделирования. Система позволяет ускорить исследование ферментов, создание новых лекарственных препаратов, ремоделирование мембран и пр. Проект Anton реализуется частной компанией D. E. Shaw Research. Данная серия суперкомпьютеров названа в честь Антони ван Левенгука (Antoni van Leeuwenhoek) — нидерландского натуралиста, конструктора микроскопов и пионера микробиологии. Системы Anton разрабатываются специально для ускорения процесса моделирования молекулярной динамики. С помощью этих суперкомпьютеров исследователи могут получить ценную информацию о движениях и взаимодействиях белков и других биологически важных молекул. Многие из решаемых на базе Anton задач не могут быть выполнены за разумное время с помощью любого другого современного суперкомпьютера общего назначения или программного обеспечения для молекулярной динамики, доступного академическому сообществу. Комплекс Anton 3 имеет 64-узловую конфигурацию. Задействованы 512 кастомных ASIC, а энергопотребление суперкомпьютера находится на уровне 400 кВт. Anton 3 обеспечивает быстродействие до 980 тыс. шагов моделирования в секунду (timesteps per second, TPS). По производительности на задачах молекулярной динамики система, как утверждается, на два порядка превосходит существующие универсальные суперкомпьютеры. Впрочем, по словам Cerebras, её царь-ускорители справляются и с этой задачей. «Благодаря новейшей системе Anton мы сможем предоставить исследователям уникальный ресурс, способный за считанные дни выдавать результаты, на которые при использовании любого другого суперкомпьютера ушли бы годы», — отмечает доктор Филип Блад (Philip Blood), научный директор PSC. Разработкой систем для ускорения расчётов молекулярной динамики также занимается RIKEN в рамках проекта MDGRAPE.

08.04.2025 [13:29], Сергей Карасёв

Eviden создаст для Сербии суперкомпьютер стоимостью €36 млнВласти Сербии, по сообщению ресурса Datacenter Dynamics, заключили контракт с Eviden (подразделение Atos Group) на создание нового суперкомпьютера. Речь идёт о приобретении системы BullSequana последнего поколения, которая будет поставлена к концу текущего года. Технические подробности проекта пока не раскрываются. Отмечается лишь, что контракт с Eviden является частью более широкого соглашения стоимостью €50 млн, подписанного между правительствами Сербии и Франции. Из этой суммы €36 млн пойдёт непосредственно на создание суперкомпьютера. Оставшаяся часть средств будет потрачена на ИИ-инициативы в таких сферах, как здравоохранение, энергетика, транспорт и государственное управление. На сегодняшний день, как отмечается, Сербия эксплуатирует как минимум один неназванный НРС-комплекс, созданный NVIDIA и размещённый в государственном дата-центре в Крагуеваце (столица административного региона Шумадия). Система, запущенная в декабре 2021 года, обошлась в €30 млн. В перспективе в модернизацию этого суперкомпьютера планируется инвестировать €40 млн, что позволит поднять его производительность в семь раз.

Источник изображения: Правительство Сербии Глава сербского управления по IT и электронному правительству Михайло Йованович (Mihailo Jovanovic) заявил, что новый суперкомпьютер, поставкой которого займётся Eviden, будет насчитывать «в 20 раз больше чипов, чем [нынешняя] система NVIDIA», и получит почти в 30 раз больше памяти. Какие именно чипы имеются в виду, Йованович уточнять не стал. Работа над государственным ЦОД в Крагуеваце стоимостью €30 млн началась в 2019 году, а открытие состоялось в 2020-м. Дата-центр состоит из двух объектов общей площадью около 14 тыс. м2 — это примерно в пять раз больше по сравнению с прежней ЦОД-площадкой в Белграде. Комплекс в Крагуеваце соответствует стандарту Tier IV: он предоставляет услуги хостинга для предприятий и правительственных структур.

06.04.2025 [14:05], Сергей Карасёв

Начато создание европейского суперкомпьютера Daedalus с производительностью 89 ПфлопсЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) сообщило о подписании соглашения с компанией НРЕ на создание суперкомпьютера Daedalus, который расположится в Греции и будет интегрирован с ИИ-фабрикой Pharos. Контракт с НРЕ заключён при участии Национальной инфраструктуры исследований и технологий GRNET S.A. в Афинах. Общая стоимость создания Daedalus оценивается в €36 млн. Из этой суммы 35 % предоставит EuroHPC JU, а остальные 65 % будут привлечены в рамках Национального плана восстановления и обеспечения устойчивости «Греция 2.0». В проекте также участвуют Кипр, Черногория и Северная Македония, вошедшие в специально сформированный консорциум Daedalus. Производительность нового суперкомпьютера составит более 89 Пфлопс (FP64). С таким показателем быстродействия в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500 комплекс Daedalus мог бы занять 17-е или 18-е место. Для НРС-платформы предусмотрено применение возобновляемых источников энергии и передовых систем охлаждения, которые значительно повысят энергетическую эффективность. Суперкомпьютер Daedalus станет доступен в начале 2026 года широкому кругу пользователей по всей Европе, включая научное сообщество, промышленную сферу и государственный сектор. Машина расположится в новом дата-центре в здании бывшей электростанции Технологического культурного парка Лаврион Национального технического университета Афин (NTUA). Доступ к вычислительным ресурсам комплекса будет совместно управляться EuroHPC JU и консорциумом Daedalus пропорционально их инвестициям. Ожидается, что Daedalus ускорит научные достижения Европы в различных областях, включая ИИ, медицину, метеорологию, анализ больших данных и разработку интеллектуальных транспортных систем. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они разместятся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Аналогичные комплексы также появятся в Австрии, Болгарии, Франции, Германии, Польше и Словении.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

23.03.2025 [14:08], Сергей Карасёв

Итальянский суперкомпьютер Leonardo будет интегрирован с квантовым компьютером IQM Radiance на 54 кубитаИтальянский суперкомпьютерный центр Cineca объявил о заключении соглашения с компанией IQM Quantum Computers на поставку самого мощного в стране квантового вычислительного комплекса. Речь идёт о системе IQM Radiance в конфигурации с 54 кубитами. Cineca является одним из крупнейших вычислительных центров Италии. Некоммерческий консорциум состоит из 69 итальянских университетов и 21 национальной исследовательской организации. Своей задачей консорциум ставит поддержку итальянского научного сообщества путём предоставления суперкомпьютеров и инструментов визуализации. Монтаж IQM Radiance планируется осуществить в IV квартале нынешнего года. Это будет первый локальный квантовый компьютер на площадке Cineca в Болонье. Суперкомпьютерный центр намерен использовать новую систему для оптимизации квантовых приложений, квантовой криптографии, квантовой связи и квантовых алгоритмов ИИ. Комплекс IQM Radiance 54 будет интегрирован с вычислительной системой Leonardo, которая является одним из самых быстрых суперкомпьютеров в мире. В ноябрьском рейтинге TOP500 эта машина занимает девятое место с теоретической пиковой производительностью 306,31 Пфлопс. В основу суперкомпьютера положены платформы Atos BullSequana X2610 и X2135. Система построена в рамках сотрудничества EuroHPC, которое сейчас занято развёртыванием сети европейских квантовых компьютеров и ИИ-фабрик. Компания IQM Quantum Computers основана в Хельсинки (Финляндия) в 2018 году. Она поставляет полнофункциональные квантовые компьютеры и специализированные решения для HPC, научно-исследовательских институтов, университетов и предприятий. Ранее IQM заявляла, что к выпуску готовится версия Radiance со 150 кубитами, которую планировалось представить в I квартале 2025 года. |

|