Материалы по тегу: ии

|

02.08.2025 [15:12], Сергей Карасёв

Нордический Stargate: OpenAI получит в Норвегии 230-МВт ИИ ЦОД со 100 тыс. ИИ-ускорителей NVIDIAКомпания OpenAI анонсировала проект Stargate Norway — это первый в Европе дата-центр для задач ИИ, создающийся в рамках программы OpenAI for Countries. Объект расположится в Норвегии, в Квандале (Kvandal) неподалёку от Нарвика (Narvik) на севере страны. В проекте принимают участие компания Nscale, поставщик ИИ-инфраструктуры с опытом предоставления облачных решений в Европе и Северной Америке, а также инжиниринговая фирма Aker. На начальном этапе мощность нового ЦОД составит 230 МВт с перспективой добавления ещё 290 МВт. К концу 2026 года в дата-центре будут размещены 100 тыс. ИИ-ускорителей NVIDIA, а в последующие годы планируется «значительное расширение». Территория Нарвика выбрана не случайно. Обилие гидроэнергии, её низкая стоимость, прохладный климат и развитая промышленная база региона делают его оптимальным местом для масштабного и устойчивого развития ИИ-платформ. Новый дата-центр будет получать питание исключительно от возобновляемых источников энергии. Упомянуто применение прямого жидкостного охлаждения для дальнейшего повышения энергетической эффективности. Избыточное тепло будет использоваться для централизованного теплоснабжения. Управлять новым ЦОД предстоит совместному предприятию Nscale и Aker с равным долевым участием. Компании выделили около $1 млрд на начальный этап проекта, включая более $250 млн в виде акционерного капитала. Утверждается, что это одна из самых крупных инвестиций в ИИ-инфраструктуру в Европе на сегодняшний день. Площадка в Нарвике обладает потенциалом десятикратного масштабирования и, помимо OpenAI, может использоваться другими клиентами. Aker и Nscale будут в приоритетном порядке предоставлять ресурсы Stargate Norway норвежским стартапам в области ИИ и научным организациям. Излишки мощностей станут доступны государственным и частным пользователям в Великобритании и странах Северной Европы. Добавим, что мегапроект Stargate — это совместное предприятие OpenAI, SoftBank и Oracle по развитию ИИ-инфраструктуры в США. Предполагается, что суммарные затраты на реализацию Stargate достигнут $500 млрд. При этом один из крупнейших ИИ ЦОД Stargate расположится в Объединённых Арабских Эмиратах (ОАЭ): мощность этого кампуса составит 5 ГВт. Впрочем, пока развитие проекта идёт ни шатко, ни валко — OpenAI предпочитает искать ресурсы напрямую.

01.08.2025 [12:34], Руслан Авдеев

Европа намерена строить не только ИИ-фабрики, но и сверхмощные гигафабрикиЕвросоюз рассчитывает, помимо ИИ-фабрик, заняться строительством более производительных, гигаваттных объектов. В ЕС намерены компенсировать отставание от США и Китая, реализуя комплексные проекты высочайшей производительности, чему готова способствовать компания NVIDIA, сообщает CNBC. В ЕС описывают ИИ-фабрики как «динамическую экосистему», объединяющую вычислительные мощности, данные и таланты для создания ИИ-моделей и приложений. Блок долгое время отставал как от США, так и от КНР в гонке за первенство на рынке ИИ. Евросоюз обычно довольно долго согласует изменения законов, а высокие цены на электричество, острая необходимость модернизации энергосистем и задержки с выдачей всевозможных разрешений только усугубляют проблему. Местные чиновники подчёркивают, что Евросоюз в теории обладает большим потенциалом, чем США — в нём на 30 % больше ИИ-исследователей на душу населения, чем в Соединённых Штатах, действуют около 7 тыс. ИИ-стартапов, но главным препятствием для развития является нехватка вычислительных мощностей. Гигафабрики будут вчетверо превосходить по вычислительным мощностям крупнейшие ИИ-проекты, и уже есть всё необходимое для обеспечения технологического суверенитета и конкурентоспособности. На данный момент в ЕС выделили €10 млрд ($11,8 млрд) на создание 13 ИИ-фабрик и €20 млрд в качестве стартовой инвестиции на создание фабрик гигаваттного уровня. Утверждается, что это крупнейшие инвестиции в ИИ в мире. При этом потребуются немалые частные инвестиции для реализации проекта — заинтересованность в проекте уже выразили десятки структур из 16 стран Евросоюза. В 2025 году в Европе должны заработать семь ИИ-фабрик EuroHPC.

Источник изображения: Dzmitry Pylypiu/unsplash.com Гигафабрики описываются как «универсальные центры» для ИИ-компаний, способные имитировать полный цикл производственных процессов на заводах — только вместо классического сырья на гигафабрику будут поступать «сырые» исходные данные, а на выходе получаться готовые ИИ-продукты. По сути, речь идёт о ЦОД с дополнительной инфраструктурой, зависящей от того, как будет внедряться технология. По словам экспертов, необходимо строить ЦОД с ускорителями, которые смогут как обучать ИИ-модели, так и заниматься инференсом. Дополнительно нужно создать инфраструктуру, которая обеспечит доступ к ресурсам малым и средним предприятиям из стран ЕС, не готовым создавать собственные мощности. Например, телеком-компания Telenor уже изучает возможности использования гигафабрик. Она запустила собственную ИИ-фабрику в Норвегии в ноябре 2024 года. Теперь компания располагает кластером ускорителей для тестирования своих разработок перед дальнейшим масштабированием. При этом подчёркивается, что решающее значение имеет суверенитет европейских данных. Компания сотрудничает с разработчиками BabelSpeak — ПО, которое называют норвежской версией ChatGPT. Технология позволяет вести с помощью ИИ конфиденциальные диалоги, — например, ею пользуются в пилотном проекте пограничники, не готовые применять публичные сервисы из-за проблем с безопасностью. Еврочиновники сообщают, что первая ИИ-фабрика в регионе заработает в ближайшие недели, а один из крупнейших проектов будет запущен в Мюнхене (Германия) в первых числах сентября. С гигафабриками всё несколько сложнее.

Источник изображения: Etienne Girardet/unsplash.com Потребуются очень крупные инвестиции, поскольку объекты в четыре раза мощнее классических ИИ-фабрик по вычислительным мощностям. Речь идёт о миллиардах долларов, каждой фабрике потребуется €3–5 млрд вложений. Поэтому планируется создать консорциум партнёров, а в конце года будет объявлен конкурс инвестиций. Пока неизвестно, в каких объёмах средства потребуются из частных фондов в дополнение к государственным, а производительность заводов тоже пока не ясна. Один из ключевых вопросов — потребление энергии. Создание гигафабрики может занять 1–2 года, а вот строительство электростанции для неё потребует гораздо больше времени. Впрочем, уже было заявлено, что для современных ускорителей NVIDIA потребуется не менее 1 ГВт на гигафабрику. Хватит ли для этого возможностей европейских электросетей — пока неизвестно. По словам экспертов UBS, нынешняя установленная мощность всех ЦОД в мире составляет порядка 85 ГВт, предполагается, что скоро она вырастет вдвое благодаря растущему спросу. Мощность каждой ИИ-фабрики в ЕС может составить 100–150 МВт, а всего — 1,5–2 ГВт. Это может добавить около 15 % к доступным в Европе вычислительным ресурсам, что является существенным приростом даже на фоне достижений США, на которые сегодня приходится около трети мировых мощностей. Ранее сообщалось, что ЕС намерен утроить ёмкость ЦОД в ближайшие годы. Впрочем, как считают эксперты, купить чипы у NVIDIA и создать фабрики относительно просто, но запустить их и сделать экономически выгодными — гораздо сложнее. Не исключается, что ЕС, вероятно, придётся начать с меньших масштабов, поскольку сразу создать собственные передовые ИИ-модели из-за их дороговизны не получится. Однако со временем, с развитием собственной инфраструктуры и созданием собственных ИИ-моделей, эту цель, возможно, удастся достичь.

01.08.2025 [09:37], Владимир Мироненко

Meta✴ увеличит капитальные расходы: инвестиции в ИИ и дата-центры продолжают растиMeta✴ Platforms объявила финансовые результаты II квартала 2025 года, завершившегося 30 июня. Акции компании выросли в цене в ходе расширенных торгов на 11 %, поскольку выручка и прибыль значительно превысили прогнозы Уолл-стрит, сообщило агентство Reuters, отметив, что ИИ по-прежнему является движущей силой её основного рекламного бизнеса. Выручка Meta✴ за отчётный квартал выросла год к году на 22 %, составив $47,52 млрд, что превзошло консенсус-прогноз аналитиков, опрошенных LSEG, в $44,80 млрд. Прибыль в размере $7,14 на акцию также превысила прогноз Уолл-стрит в $5,92. За год прибыль увеличилась на 36 % — с $13,47 млрд до $18,34 млрд. В ходе телефонной конференции с аналитиками генеральный директор Марк Цукерберг (Mark Zuckerberg) заявил, что технология ИИ позволила Meta✴ «повысить эффективность и прибыль рекламной системы». Выручка компании от рекламы составила $46,56 млрд, превысив прогноз Уолл-стрит в $43,97 млрд. В текущем III квартале Meta✴ прогнозирует выручку от $47,5 до $50,5 млрд, что выше прогноза Уолл-стрит в $46,14 млрд. Meta✴ также повысила нижнюю границу своего прогноза годовых капитальных затрат на $2 млрд, до диапазона от $66 до $72 млрд. Рост расходов на создание инфраструктуры ЦОД и компенсаций, связанных с наймом персонала, — Meta✴ переманивает исследователей, предлагая им огромные зарплаты, — может привести к тому, что темпы роста расходов в 2026 году превысят темпы роста в 2025 году, заявила Meta✴. Компания также планирует увеличить капитальные расходы в следующем году. Ранее в этом году Meta✴ сообщила, что планирует потратить до $72 млрд на капитальные вложения в 2025 году, в основном на инвестиции в ИИ. На прошлой неделе Цукерберг заявил, что компания инвестирует сотни миллиардов долларов в строительство нескольких «мультигигаваттных» дата-центров по всей стране. Один из таких кампусов под названием Hyperion, в конечном итоге, будет иметь мощность в 5 ГВт. Отвечая на вопрос о растущих капитальных расходах компании, финансовый директор Meta✴ Сьюзан Ли (Susan Li) заявила, что Meta✴ «изучает возможности сотрудничества с финансовыми партнёрами для совместного развития ЦОД». «У нас нет каких-либо окончательных сделок, о которых мы могли бы объявить, но мы в целом полагаем, что здесь будут модели, которые привлекут значительное внешнее финансирование для поддержки крупномасштабных проектов ЦОД, разрабатываемых с использованием наших возможностей по созданию инфраструктуры мирового класса», — сказала Ли. Meta✴ не предоставила прогноз по продажам в IV квартале, лишь сообщив, что рост выручки в годовом исчислении будет ниже, чем в III квартале. «Инвестиции Meta✴ в рекламный бизнес, основанные на ИИ, продолжают приносить прибыль... Но непомерные расходы Meta✴ на свои разработки в сфере ИИ продолжат вызывать вопросы и пристальное внимание инвесторов, жаждущих увидеть прибыль», — говорит старший аналитик Emarketer Минда Смайли (Minda Smiley). Аналитик указала на проблемы с регуляторами, с которыми Meta✴ сталкивается в США и за рубежом, что добавляет неопределённости в её будущее. Американские антимонопольные органы подали в суд на Meta✴, требуя реструктуризации или продажи Instagram✴ и WhatsApp, утверждая, что компания стремится монополизировать рынок социальных сетей.

31.07.2025 [18:53], Руслан Авдеев

G42 готова завершить сделку с Northern Data для получения доступа к ЦОД в ЕвропеКомпании G42 (ОАЭ) и Northern Data AG (Германия) близки к заключению сделки, в рамках которой первая получит доступ к мощностям ЦОД в Европе, сообщает Bloomberg. Это связано с расширением деятельности G42 за пределами Ближнего Востока, в частности — в Евросоюзе. Как свидетельствуют источники, Northern Data предоставит Core42 — подразделению G42, занятому облачными вычислениями — доступ к почти половине из 23 тыс. ИИ-ускорителей NVIDIA. По информации источников, условия сделки ещё могут измениться. Northern Data выступает оператором ЦОД в США, Швеции, Норвегии и Португалии. Если ранее она предлагала мощности для майнинга криптовалют, то ИИ-бум заставил её изменить профиль. В 2025 году от облачного подразделения Taiga, предлагающего сервисы генеративного ИИ, ожидается рост выручки на 74 % год к году. Правда, с начала года акции Northern Data упали более чем на 50 %. G42, базирующаяся в Абу-Даби (ОАЭ) намерена расширить деятельность в Азии, Африке и США. В июне 2025 года компания открыла офис в Лондоне для продаж ИИ-решений частным структурами и государственным учреждениям. Компания тесно связана с государственным аппаратом своей страны и может привлекать значительные ресурсы, полученные ОАЭ от нефтяных доходов.

Источник изображения: Xenofon Tsantilas/unsplash.com ОАЖ уже участвуют в инвестиционных проектах в Европе. В частности, речь идёт о вложениях в объёме €50 млрд ($58 млрд) во французские ЦОД и значительных инвестициях в итальянский ЦОД мощностью 1 ГВт. В мае NVIDIA и поддерживаемый G42 инвестиционный фонд MGX совместно с суверенным фондом благосостояния Mubadala Investment Co. объединились с французским бизнесом для создания «крупнейшего в Европе» кампуса ИИ-ЦОД. Как сообщает Bloomberg, недавно Northern Data заявила о наличии «стратегического интереса» к продаже своих подразделений Taiga Cloud и Ardent, занятых строительством и обслуживанием ЦОД, хотя ни одна сделка ещё не заключена. Также рассматривался вариант их вывода на IPO. Подразделение компании, отвечающее за криптомайнинг, должно пройти реструктуризацию и может быть выставлено на продажу.

31.07.2025 [14:56], Руслан Авдеев

Выручка Vertiv выросла на 35 % на фоне «беспрецедентного роста ЦОД», но новые тарифы мешают бизнесуВо II квартале 2025 года выручка компании Vertiv выросла на 35 % по сравнению с аналогичным периодом прошлого года. Компания, поставляющая системы электропитания, охлаждения, серверные стойки и другое оборудование для дата-центров, отмечает продолжение роста рынка ЦОД, особенно с учётом увеличения крупных ИИ-объектов, сообщает Datacenter Dynamics. За указанный квартал выручка составила $685 млн, объём «органических» заказов увеличился на 15 % по сравнению с аналогичным периодом прошлого года и на 11 % по сравнению с 1 кварталом 2025 года. Задолженность компании составила $8,5 млрд, а соотношение балансовой стоимости и счетов за квартал — примерно 1,2х. Тем временем операционная прибыль увеличилась на 32 % и составила $442 млн (скорректированная операционная прибыль — на 28 %, до $489 млн). Однако скорректированная операционная маржа снизилась на 110 базисных пунктов до 18,5 %, что в основном связано с новыми тарифами. По данным Vertiv, затраты на цепочку поставок и дополнительные расходы, связанные с изменением производственных процессов для смягчения тарифов, оказались выше, чем ожидалось.

Источник изображения: Vertiv Компания также отметила операционную неэффективность и сложности в исполнении заказов, вызванные более быстрым, чем ожидалось, ростом спроса. Vertiv рассчитывает решить обе проблемы к концу года и повысила прогноз по скорректированной разводнённой прибыли на акцию (diluted EPS), выручке, скорректированной операционной прибыли и свободному денежному потоку на год. Представители компании заявили, что результаты второго квартала показали прочность рыночных позиций Vertiv и её способность масштабироваться. Показатели отражают как высокий рыночный спрос, так и расширенные возможности для удовлетворения всё более сложных инфраструктурных потребностей клиентов. В компании утверждают, что стратегически инвестируют в расширение мощностей и ускоряют разработку инновационных решений, чтобы извлечь выгоды из беспрецедентного роста рынка ЦОД, особенно в сфере ИИ-инфраструктуры. В июле 2025 года Vertiv приобрела производителя стоек Great Lakes за $200 млн, удвоив инвестиции в свой портфель решений для дата-центров. Кроме того, компания совместно с Oklo создаёт комплексную систему питания и охлаждения ЦОД на базе малых модульных реакторов. По словам представителя Vertiv, происходящие сегодня изменения в индустрии ЦОД выходят далеко за рамки ближайших лет. Речь идёт о технологической трансформации, которая станет залогом устойчивого долгосрочного роста. За последние несколько дней акции компании выросли более чем на 10 %, хотя ещё недавно разработка AWS собственной СЖО для NVIDIA GB200 NVL72 привела к некоторому падению акций Vertiv.

31.07.2025 [14:25], Владимир Мироненко

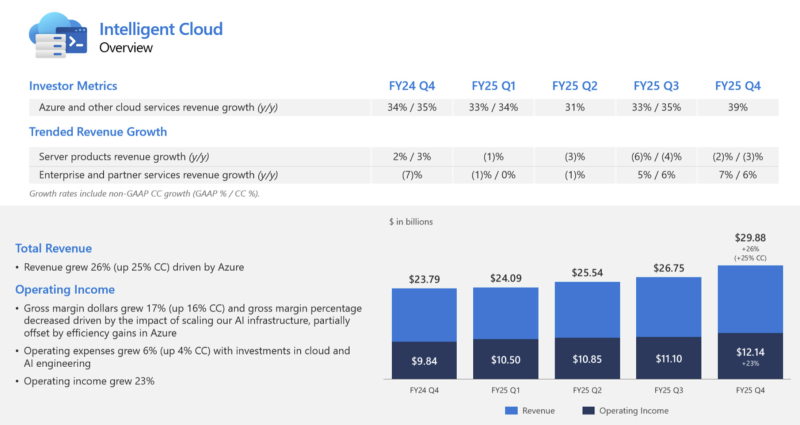

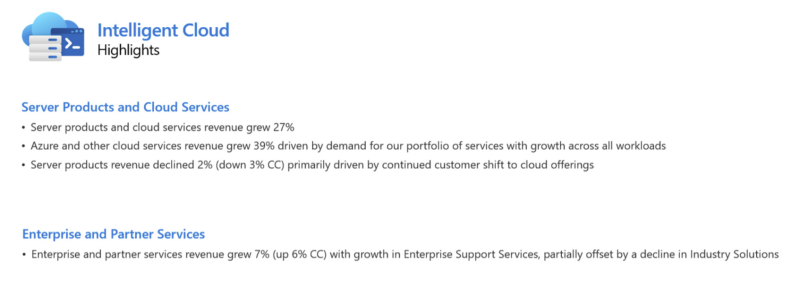

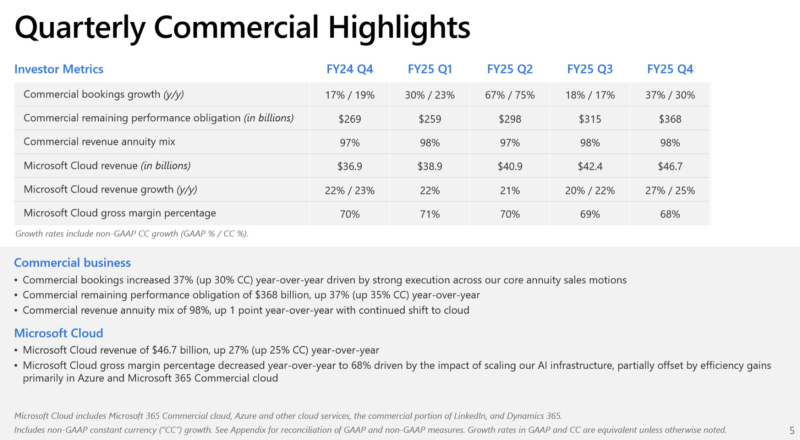

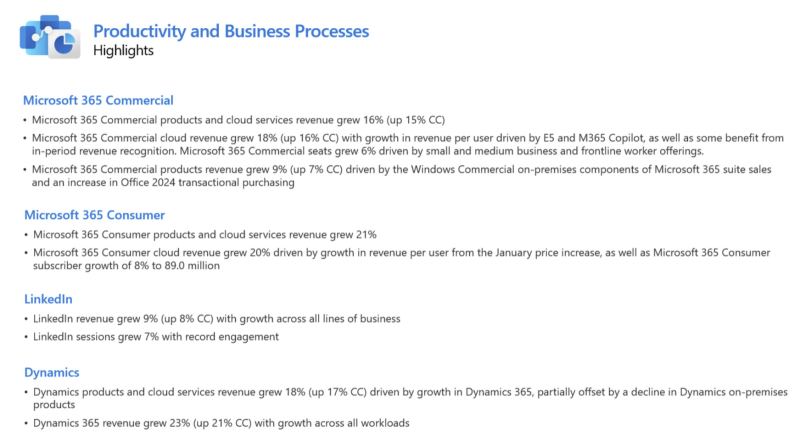

Microsoft увеличила выручку и впервые раскрыла цифры по AzureАкции Microsoft выросли на 9 % в ходе расширенных торгов после публикации компанией отчёта за IV квартал 2025 финансового года, согласно которому её прибыль и выручка превысили ожидания аналитиков. Благодаря росту акций рыночная капитализация Microsoft превысила отметку в $4 трлн, всё же уступая NVIDIA, которая преодолела данный рубеж ранее в этом месяце, отметил ресурс Siliconangle. Microsoft также впервые раскрыла годовой доход облачной платформы Azure, что позволило акционерам получить представление о её положении в облачном сегменте по сравнению с Amazon и Google. Выручка Microsoft за отчётный период выросла на 18 % до $76,44 млрд, превысив консенсус-прогноз аналитиков, опрошенных LSEG, в размере $73,81 млрд. Это самый быстрый рост показателя за более чем три года. Чистая прибыль увеличилась на 24 % до $27,23 млрд с $22,04 млрд годом ранее. Чистая прибыль на акцию составила $3,65 по сравнению с $3,37 согласно консенсус-прогнозу аналитиков, опрошенных LSEG. «Мы завершили финансовый год с сильным кварталом, о чем свидетельствует выручка от Microsoft Cloud, достигшая $46,7 млрд, что на 27 % больше по сравнению с аналогичным периодом прошлого года», — отметила Эми Худ (Amy Hood), исполнительный вице-президент и финансовый директор Microsoft. Выручка подразделения Microsoft Intelligent Cloud, в которое входят облачные сервисы Azure, а также Windows Server, SQL Server, GitHub, Nuance, Visual Studio и корпоративные сервисы, составила $29,88 млрд (рост год к году на 26 %), что превзошло консенсус-прогноз StreetAccount в $28,92 млрд. Компания сообщила, что выручка облачной платформы Microsoft Azure за 2025 финансовый год превысила $75 млрд, что на 34 % больше, чем годом ранее. Это обусловлено не только спросом на ИИ, но и «ростом во всех рабочих нагрузках», указал генеральный директор Microsoft Сатья Наделла (Satya Nadella) в отчёте. Для сравнения, согласно данным Alphabet, о чём сообщает The Wall Street Journal, годовая выручка Google Cloud превысила $50 млрд, а у AWS — более $111 млрд (с учётом итогов завершившегося в марте квартала). В IV финансовом квартале выручка Azure выросла на 39 %. Аналитики, опрошенные StreetAccount и CNBC, прогнозировали рост Azure на 34,4 % и 35,3 % соответственно. Компания заявила, что ожидает рост на 37 % в текущем квартале, что превзошло прогнозы аналитиков в 33,5 % (согласно данным Visible Alpha), о чём сообщает Reuters. Выручка подразделения Microsoft Productivity and Business Processes составила $33,11 млрд (рост год к году на 16 %), превысив консенсус-прогноз в $32,12 млрд аналитиков, опрошенных StreetAccount. Сатья Наделла рассказал о том, как ставка компании на ИИ, включая значительные инвестиции в OpenAI и многомиллиардные затраты на чипы NVIDIA, способствует росту продаж ПО в этом подразделении. Он отметил, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода на одного пользователя таких продуктов, как Office. В настоящее время насчитывается более 100 млн активных пользователей инструментов Copilot в месяц, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для потребителей в Windows. Ставка Microsoft на ИИ, включая инвестиции в OpenAI и миллиарды долларов, потраченные на чипы NVIDIA, способствует росту продаж бизнес-ПО, отметил Сатья Наделла. Он подчеркнул, что интеграция Microsoft 365 Copilot с инструментами повышения производительности привела к заметному росту дохода в расчёте на пользователя таких продуктов, как Office. Количество активных пользователей продуктов Copilot, включая Microsoft 365 Copilot для коммерческих клиентов и помощника Copilot для пользователей Windows, составляет 100 млн ежемесячно, сообщил Наделла. Аналитик Valoir Ребекка Веттеманн (Rebecca Wettemann) сообщила SiliconANGLE, что комментарии Наделлы обнадёживают, но отметила, что компания всё ещё испытывает трудности с ростом популярности ИИ по сравнению с некоторыми конкурентами. «Microsoft медленнее, чем некоторые конкуренты, добивается успеха в области ИИ», — сказала аналитик. «Поскольку конкуренты начинают хвастаться корпоративными референциями и говорить о цифрах внедрения, Microsoft необходимо последовать их примеру, чтобы опровергнуть мнение о том, что Copilot всё ещё слишком дорог для широкого внедрения среди клиентов», — предложила она. Подразделение More Personal Computing увеличило выручку на 9 % до $13,45 млрд, что выше консенсус-прогноза StreetAccount в размере $12,68 млрд. Капитальные затраты Microsoft выросли год к году на 27 % до $24,2 млрд, по сравнению с прогнозом аналитиков в $23,08 млрд (согласно Visible Alpha), поскольку компания продолжает активно развивать инфраструктуру ИИ ЦОД. Ещё $1,71 млрд списаны на другие расходы, включая убытки от инвестиций в долевое участие в компаниях, включая OpenAI. Эми Худ сообщила, что компания прогнозирует выручку за I финансовый квартал в пределах от $74,7 до $75,8 млрд со средним показателем в размере $75,25 млрд, превосходящем консенсус-прогноз LSEG в $74,09 млрд Прогноз по операционной рентабельности в размере 46,6 % превышает консенсус-прогноз аналитиков, опрошенных StreetAccount, в 45,7 %. Прогноз Microsoft включает более $30 млрд на капзатраты и активы, приобретённые по финансовой аренде, что в итоге обеспечит рост год к году более 50 %. Аналитики, опрошенные Visible Alpha, ожидают около $24,23 млрд. Microsoft заявила, что её капитальные расходы несколько сместились в сторону активов с длительным сроком службы, таких как ЦОД, хотя ранее компания сообщила инвесторам, что в 2026 финансовом году структура капитальных расходов сместится в сторону активов с малым сроком службы, таких как чипы.

31.07.2025 [13:14], Руслан Авдеев

Google рассчитывает построить в Индии 1-ГВт ЦОД Vizag за $6 млрдКомпания Google намерена построить в индийском штате Андхра-Прадеш (Andhra Pradesh) дата-центр Vizag мощностью 1 ГВт. Штат расположен на юге страны, строительство ЦОД предусматривает инвестиции в объёме $6 млрд, сообщает Reuters. Центр обработки данных планируют построить в портовом городе Вишакхапатнам (Visakhapatnam), при этом $2 млрд будут направлены на создание возобновляемых источников энергии для его питания. Он станет крупнейшим по мощности и объёму инвестиций объектом IT-гиганта в Азии и будет лишь частью многомиллиардного проекта по расширению портфолио дата-центров странах региона, вроде Сингапура, Малайзии и Таиланда. В апреле компания объявила, что по-прежнему намерена направить около $75 млрд на наращивание мощностей ЦОД несмотря на глобальную неопределённость, вызванную противоречивой политикой США. В Google новость не комментируют, от комментариев воздержались и представители властей штата, пообещав предоставить дополнительную информацию о строительстве новых объектов в октябре. Штат Андхра-Прадеш ещё в 2014 году был разделён на две части, в результате чего бывшая столица Хайдарабад осталась в новом штате Телангана (Telangana), как и значительная часть доходов. С тех пор Андхра-Прадеш стремится привлечь инвестиции. Сообщается, что штат уже инвестировал в строительство ЦОД общей мощностью 1,6 ГВт, а в течение следующих пяти лет планируется построить новые объекты совокупной мощностью 6 ГВт практически с нуля. Ожидается, что первые 1,6 ГВт введут в эксплуатацию в течение следующих 24 месяцев. По данным экспертов компании Anarock, сейчас в стране действует дата-центров суммарной мощностью 1,4 ГВт. Кроме того, в Вишакхапатнаме ведётся строительство трёх кабельных посадочных станций для создания сети, которая будет вдвое крупнее существующей в Мумбаи.

Источник изображения: Chaitanya Chunduri/unspalsh.com Посадочные станции обычно строятся на побережье вблизи дата-центров, нуждающихся в надёжном и быстром соединении с глобальными сетями. Они используются для размещения приёмо-передающего оборудования, работающего с подводными кабелями. Подчёркивается, что штат намерен развивать энергетическую инфраструктуру: по прогнозам чиновников, в ближайшие пять лет потребность в генерирующих мощностях составит до 10 ГВт. В конечном итоге большая часть этих мощностей будет приходиться на «зелёную» энергетику. Тем не менее, часть электростанций продолжит работать на угле, поскольку дата-центрам необходимы стабильные и мощные источники энергии в течение всего дня, вне зависимости от погодных условий и времени суток. По данным Datacenter Dynamics, в 2017 году Google Cloud открыл регион в Мумбаи, а в 2021 году — в Дели. Дополнительно в текущем году компания планирует запустить суверенное облако совместно с Airtel Business. Ожидается, что в IV квартале 2025 года в эксплуатацию будет введён индийский участок подводного кабеля Google Blue Raman, который пройдёт через Мумбаи на западе страны. Ещё в 2020 году было объявлено, что в течение 5–7 лет компания направит на цифровизацию Индии $10 млрд. В том же году Google инвестировала $4,5 млрд в индийскую телекоммуникационную компанию Reliance Jio.

31.07.2025 [12:37], Руслан Авдеев

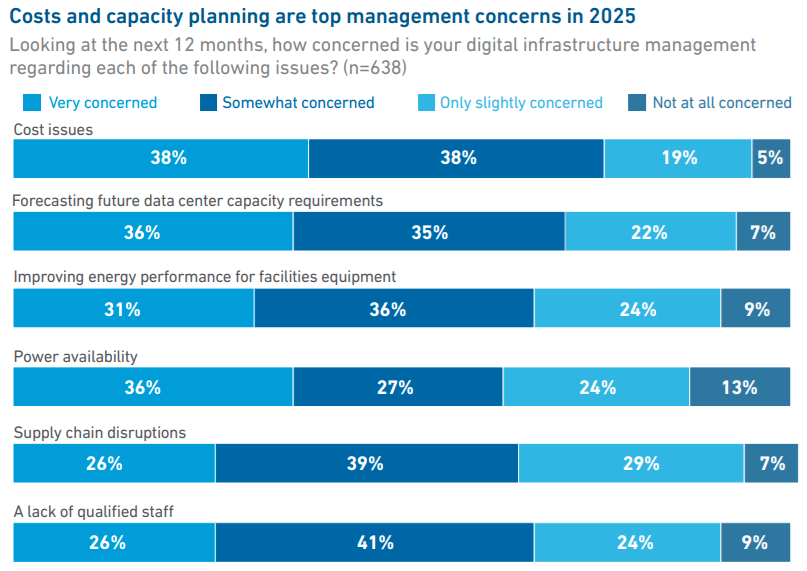

Uptime Institute: лишь треть владельцев и операторов ЦОД занимаются обучением ИИ-моделей или инференсомСогласно данным ежегодного глобального опроса, проводимого Uptime Institute, в 2025 году лишь около трети владельцев и операторов ЦОД занимаются задачами, связанными с обучением ИИ-моделей и инференсом, сообщается в докладе организации. В документе отмечается, что те, кто сегодня использует ИИ-технологии, находятся на «ранней стадии развития», но значительно больше игроков намерены последовать их примеру. Новый отчёт является результатом опроса, полученного от более чем 800 владельцев и операторов ЦОД с апреля по май 2025 года, из которых 43 % находятся в Европе и Северной Америке. По информации Uptime Institute, опрошенные представители бизнеса больше всего обеспокоены вопросами затрат (38 % — крайне обеспокоены), а на втором месте — вопросы прогнозирования будущих потребностей в мощностях ЦОД (36 %). На третьем месте — повышение энергоэффективности, на четвёртом — доступность электроэнергии.

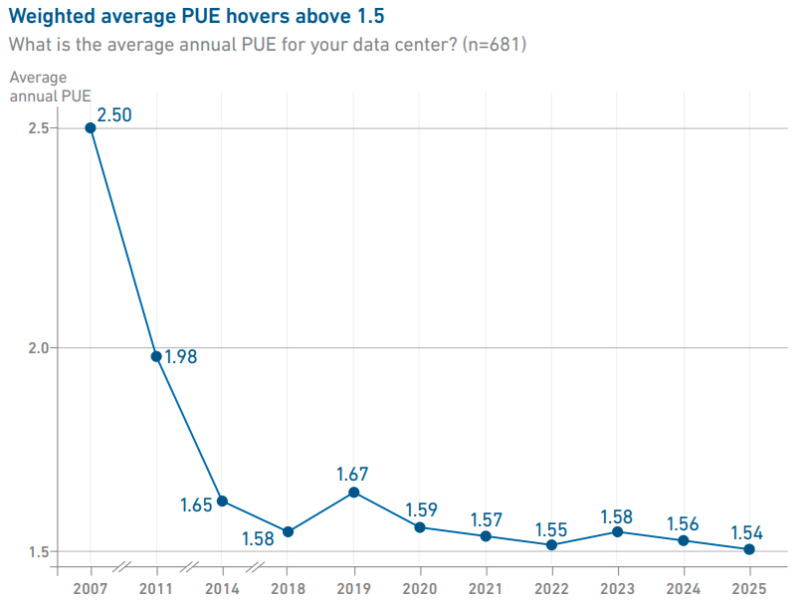

Источник изображения: Uptime Institute Хотя плотность мощности в стойках продолжает расти, в среднем она находится на уровне 10–30 кВт. В Uptime уверены, что лишь немногие проекты используют стойки мощностью более 30 кВт, но «экстремальные» плотности пока встречаются довольно редко. Тем временем уровень PUE по-прежнему остаётся относительно стабильным, среднее значение в текущем году составило 1,54 — уже шестой год подряд оно практически не меняется.

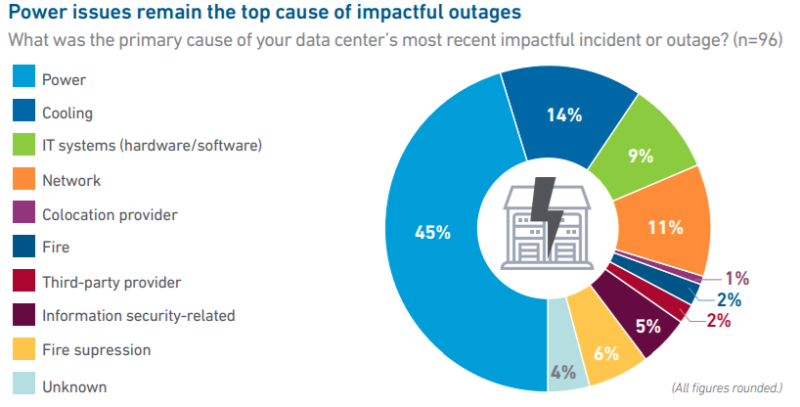

Источник изображения: Uptime Institute Примечательно, что число «значимых» сбоев в работе ЦОД сокращается с учётом общего роста IT-рынка, хотя число публикаций об отказах в работе дата-центров, наоборот, растёт. В отчёте это объясняют просто растущей заметностью и важностью цифровой инфраструктуры в жизни людей. Большинство отключений всё ещё связаны со сбоями электроснабжения (45 %), а также некоторыми другими причинами — впрочем, в 2024 году этот показатель был на уровне 54 %. В отчёте предполагают, что начали окупаться инвестиции в резервирование электропитания и достижения в сфере распределённых и программных архитектур обеспечения отказоустойчивости. Отдельное исследование свидетельствует, что сбои в электропитании в основном связаны с отказами ИБП, а также проблемами с отказами генераторов и переключателями питания.

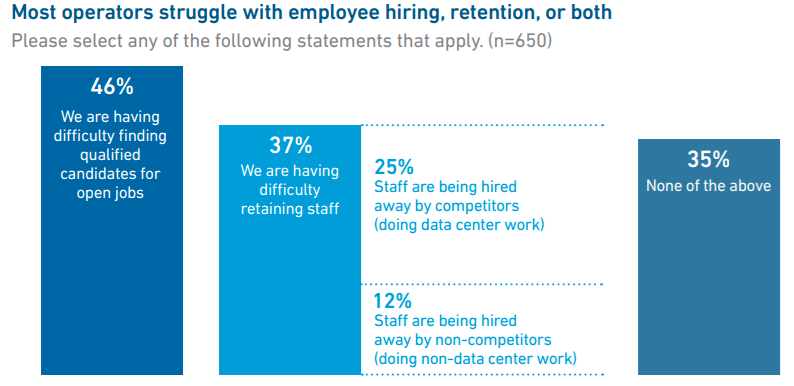

Источник изображения: Uptime Institute Что касается вопроса облачных и локальных вычислений, в Uptime считают, что сейчас около 55 % рабочих нагрузок в той или иной мере размещены вне локальной инфраструктуры, и лишь 45 % приходятся на локальные дата-центры. Вероятно, доля облачных вычислений к 2027 году вырастет до 58 %. Одним из важнейших остаётся кадровый вопрос — почти половина операторов сообщает, что затрудняется с поиском сотрудников, а около 37 % имеют проблемы с удержанием персонала. По словам представителя Uptime Institute, данные организации показывают, что операторам одновременно приходится решать ряд стратегических задач, от прогнозирования технологических изменений до планирования масштабирования бизнеса и подготовки к непредсказуемому спросу на ИИ-вычисления и их поддержку. Подчёркивается, что впервые стало сложнее нанимать и удерживать руководителей старшего звена, чем людей на более низких позициях. Многие опытные руководители уходят на пенсию на фоне нового этапа бурного роста индустрии и нехватки управленцев.

Источник изображения: Uptime Institute В числе прочих выводов — данные о том, что показатели устойчивого развития пострадали из-за коммерческого интереса бизнеса к ИИ и частичного смягчения регуляторных требований в отрасли. В январе 2025 года Uptime Institute сообщал, что развитие ИИ в ЦОД может привести к невыполнению обязательств, взятых операторами по достижению целей устойчивого развития. Также в Uptime отметили использование операторами дата-центров ИИ-решений, в том числе для повышения эффективности объектов (58 %), снижения риска человеческих ошибок (51 %) и повышения производительности труда персонала (48 %).

30.07.2025 [16:06], Руслан Авдеев

Microsoft близка к заключению сделки о постоянном доступе к самым передовым технологиям OpenAIКомпания Microsoft активно ведёт переговоры с давним партнёром — OpenAI. В результате новой сделки IT-гигант, возможно, получит постоянный доступ к критически важным технологиям OpenAI. Такое соглашение могло бы устранить ключевое препятствие на пути превращения OpenAI в коммерческую компанию, сообщает гонконгская SCMP. По словам источников, знакомых с ситуацией, партнёры обсуждают новые условия, которые позволили бы Microsoft использовать новейшие ИИ-модели OpenAI и другие технологии, даже если стартап достигнет своей цели по созданию «общего искусственного интеллекта» (AGI), способного соперничать с человеческим разумом или даже превосходить его. В соответствии с действующим соглашением между компаниями, создание AGI компанией OpenAI рассматривается как важнейшая веха, после которой Microsoft потеряет часть прав на технологии партнёра, хотя в настоящее время является крупнейшим его инвестором. Команды переговорщиков регулярно встречаются для обсуждения условий возможных договорённостей, которые, по данным трёх независимых источников, могут быть достигнуты в течение нескольких недель. Ранее в этом месяце глава OpenAI Сэм Альтман (Sam Altman) и его коллега из Microsoft Сатья Наделла (Satya Nadella) обсуждали возможную реструктуризацию на конференции Allen & Co в Айдахо.

Источник изображения: Growtika/unsplash.com Хотя тон переговоров остаётся «позитивным», некоторые предупреждают, что сделка ещё не завершена и может столкнуться с новыми препятствиями. Более того, планы превращения OpenAI в коммерческую компанию могут быть нарушены и по вине других участников отрасли, от регуляторов до Илона Маска (Elon Musk), подавшего на компанию в суд. Илон Маск был одним из основателей OpenAI, но покинул стартап и теперь обвиняет его руководство в обмане инвесторов относительно приверженности «благотворительной» миссии. В ответ OpenAI заявила, что Маск просто пытается замедлить развитие компании. Переговоры о превращении OpenAI в коммерческую компанию ведутся уже несколько месяцев. Microsoft, инвестировавшая в стартап $13,75 млрд, имеет право использовать его интеллектуальную собственность и претендует на значительную долю в обновлённой компании. Этот вопрос, в числе прочих, стал предметом оживлённых обсуждений. Microsoft и OpenAI расширили переговоры о своём партнёрстве, поскольку софтверный гигант стремится гарантировать долгосрочный доступ к технологиям стартапа. Текущее соглашение между компаниями действует до 2030 года, и Microsoft хочет избежать риска внезапной потери доступа к ИИ-разработкам OpenAI в случае изменений в структуре или стратегии стартапа.

30.07.2025 [15:34], Руслан Авдеев

YTL Power и NVIDIA инвестируют $2,3 млрд в ИИ в Малайзии — но связано ли это с предыдущей сделкой на $4,3 млрд?YTL Power International (YTLP) и NVIDIA подписали соглашение о развитии ИИ-инфраструктуры в Малайзии стоимостью $2,36 млрд. Инвестиции будут направлены на создание в стране кластера ускорителей NVIDIA, все они будут работать на экологически чистой энергии, сообщает Datacenter Dynamics. Представители малайзийских властей уже сообщили, что соглашение также включает разработку суверенной языковой модели для Малайзии, а NVIDIA и YTL разработают ИИ-экосистему, сотрудничая с другими партнёрами, поставщиками и местными подрядчиками. Недавно сообщалось о возможном создании суверенной ИИ-экосистемы под эгидой Huawei, но под давлением США информация была дезавуирована малайзийским правительством. Подробности о новом дата-центре, включая мощность, сроки строительства и ввода в эксплуатацию, а также точное местоположение, пока не разглашаются.

Источник изображения: Jia Le/unspalsh.com YTL Power (через дочернюю структуру YTL AI Cloud) уже строит кампус ЦОД YTL Green Data Center Campus в Джохоре, запуск которого намечен на III квартал 2025 года. Мощность ЦОД составит 72 МВт. Ранее в 2025 году компания объявила, что намерена предлагать клиентам ускорители NVIDIA GB200 через облако NVIDIA DGX Cloud, а в будущем — и новейшие ускорители Blackwell Ultra. В декабре 2023 года YTL и NVIDIA объявили о намерении развивать облачную и ИИ-инфраструктуру в Малайзии, проект оценивался в $4,3 млрд. Пока уточняется, связано ли новое инвестиционное обязательство с прежним проектом и будут ли средства выделены из уже названной суммы. YTL Power International является дочерней структурой YTL Corporation — малазийского инфраструктурного конгломерата, одной из крупнейших компаний на фондовой бирже Куала-Лумпура. Также компания управляет дата-центром в Сингапуре и периферийным ЦОД в Сентуле (Sentul), Малайзия. На днях сообщалось, что Малайзия намерена ввести в действие Рамочную программу устойчивого развития дата-центров (Sustainable Data Centre Framework) к октябрю 2025 года. Усилия предпринимаются для упорядочивания развития цифровой инфраструктуры и укрепления позиций страны в качестве регионального хаба для данных. |

|