Материалы по тегу: ии

|

30.07.2025 [14:46], Руслан Авдеев

Groq намерен привлечь $600 млн финансирования — в случае успеха это удвоит капитализацию бизнесаПо данным источников, знакомых с ходом переговоров в ИИ-отрасли, стартап Groq, занимающийся разработкой ИИ-чипов и программного обеспечения, намерен привлечь около $600 млн в рамках очередного раунда финансирования. В результате капитализация компании может достичь порядка $6 млрд, сообщает издание SCMP. Лидером текущего раунда выступает венчурный инвестор VC Disruptive, который, по данным осведомлённых источников, выделил более $300 млн. В самих Groq и VC Disruptive от комментариев отказались. Основанная в 2012 году компания VC Disruptive из Далласа уже инвестировала в такие технологические гиганты, как Palantir Technologies и Airbnb. Итоги раунда финансирования ещё могут измениться, поскольку он пока не завершён. Во вторник издание The Information сообщило, что Groq сократила прогноз выручки на 2025 год более чем на $1 млрд. По словам одного из источников, Groq скорректировала прогнозируемую выручку. Вместе с тем, по его словам, компания рассчитывает компенсировать недополученные доходы в 2026 году. Сама Groq отказалась комментировать данные о продажах. Тем временем, как отмечают источники, новый раунд финансирования оказался масштабнее, чем первоначально планировалось. Благодаря этому общий объём привлечённых средств превысил $2 млрд, а рыночная стоимость компании удвоилась. В 2024 году компания привлекла $640 млн в рамках раунда, организованного фондом BlackRock. Groq занимается разработкой ИИ-ускорителей и стремится в перспективе составить конкуренцию NVIDIA, рыночная капитализация которой превысила $4 трлн на фоне стремительного роста интереса к ИИ. Кроме того, компания инвестирует в создание глобальной распределённой сети, которая позволит пользователям мгновенно получать ответы на свои запросы. Недавно Groq объявила о первой сделке, предусматривающей строительство европейского ЦОД — в Хельсинки (Финляндии).

29.07.2025 [14:58], Руслан Авдеев

Удар по Ирландии: Amazon отказалась от строительства фабрики серверов в стране за €300 млнAmazon отказалась от нового объекта в Дублине. Инвестиции, оцениваемые приблизительно в €300 млн ($353 млн), предназначались для AWS. По имеющимся данным, компания планировала построить новую площадку для производства передовых серверных стоек для ЦОД, сообщает Bloomberg. Отмена такого знакового проекта вызывает особое беспокойство у местных экспертов, учитывая огромную зависимость страны от прямых иностранных инвестиций, в первую очередь из США. Сегодня в Ирландии более 600 тыс. человек работают в иностранных компаниях — это около 20 % от общего числа работающего населения. Инвестиции приносят немалые деньги и государству. В прошлом году Ирландия получила рекордные €39 млрд корпоративного налога. В результате в стране сформировался даже бюджетный профицит — довольно редкое явление для современных европейских стран. В AWS сообщили, что компания разочарована тем, что проект не удалось реализовать, но предполагаются и другие инвестиции в Ирландию, если для этого будут созданы благоприятные условия. На Amazon в стране сегодня уже работает порядка 6,5 тыс. человек. Эта новость усиливает обеспокоенность властей страны нестабильностью корпоративного налога — особенно с учётом того, что президент США и его соратники неоднократно подчёркивали, что профицитом Ирландия обязана именно Америке. С учётом столь значимой угрозы правительство Ирландии уже дало понять, что в текущем году придётся расходовать бюджет более осторожно — в отличие от 2024 года, когда средства буквально «раздавались».

Источник изображения: Dmitry Ant/unsplash.com По данным Bloomberg, решение AWS связано с проблемами энергоснабжения проекта и большими сроками подключения объекта к электросети. Решение Amazon может усилить беспокойство, связанное с нехваткой электричества для ИИ, дата-центров и других передовых технологий — особенно в тех местах, где энергетические сети уже находятся в плохом состоянии и под большой нагрузкой. Хотя бум ИИ позволил выделить на ЦОД миллиарды долларов, строительство некоторых объектов уже пришлось отменить. В марте-апреле сообщалось, что Microsoft отложила реализацию в текущем году ряда проектов, в том числе в Индонезии, Великобритании, Австралии и нескольких штатах США, включая Огайо. Желая повысить конкурентоспособность отрасли ЦОД, правительство Ирландии буквально на днях подписало обновлённый план развития инфраструктуры на €112 млрд, рассчитанный до 2030 года, и направленный на решение проблем с размещением, энергоснабжением и водными ресурсами. Инвестиции в ключевые коммунальные структуры уже пострадали от мирового финансового кризиса, и это стало большим разочарованием для предприятий различного назначения. Ассоциация IBEC (Irish Business and Employers Confederation) — крупнейший лоббист интересов бизнеса в Ирландии — призвала правительство отдать приоритет инфраструктуре в сравнении с другими расходами, включая сокращение налогов. Утверждается, что стране необходимо наверстать десятилетия недостаточных инвестиций и задержек в реализации планов. Американская торговая палата в Ирландии (American Chamber of Commerce in Ireland) также предупредила, что инфраструктура является критически важным приоритетом для её членов. На этом фоне положение с энергоснабжением в стране настолько серьёзное, что в феврале местный регулятор CRU предложил операторам ЦОД самим заняться строительством электростанций и энергохранилищ. Проблема в том, что Ирландские ЦОД за восемь лет увеличили энергопотребление на 473 %. В июне сообщалось, что Ирландия готова разрешить дата-центрам строить не только электростанции, но и частные линии электропередач.

29.07.2025 [14:42], Руслан Авдеев

Crusoe и Tallgrass построят в Вайоминге ИИ ЦОД мощностью 1,8 ГВтCrusoe и Tallgrass намерены построить кампус ИИ-дата-центра мощностью 1,8 ГВт на юго-востоке Вайоминга. Потенциально объект может быть масштабирован до 10 ГВт. Цель партнёрства — удовлетворение растущего спроса на вычислительную инфраструктуру за счёт использования «вертикально интегрированной» модели ИИ ЦОД от Crusoe и значительных энергетических и инфраструктурных активов Tallgrass в регионе, сообщает Converge! Речь идёт об одном из крупнейших кампусов ИИ ЦОД в стране. Строительство будет обеспечиваться за счёт энергии, получаемой из природного газа, с перспективой перехода на возобновляемые источники в будущем. Также свою роль сыграет инфраструктура компании Tallgrass, включая доступ к водным ресурсам и систему захвата и хранения CO₂ для снижения вредных выбросов. Площадка в Вайоминге расширяет портфолио проектов Crusoe до более 20 ГВт, включающее крупные начинания вроде объекта на 1,2 ГВт в Абилине (Техас), предназначенного для проекта Stargate, а также второго ЦОД на 1 ГВт, строительство которого уже начато.

Источник изображения: Mimi Thian/unspalsh.com В своё время Crusoe развёртывала инфраструктуру ЦОД для майнинга с получением энергии за счёт попутного (факельного) газа на нефтеносных полях. Теперь компания окончательно отказалась от майнинга и превратилась в поставщика комплексной ИИ-инфраструктуры, ориентированного на устойчивое развитие и масштабирование. Ожидается, что новый кампус будет поддерживать широкий спектр ИИ-задач. Он позволит создать новые рабочие места в строительстве, производстве, энергетике и технологическом секторе в целом. Tallgrass имеет более чем десятилетний опыт работы в Вайоминге и владеет тысячами километров трубопроводов и ключевой инфраструктурой по всему штату. При поддержке Blackstone компания расширила свою деятельность, занявшись, в частности, улавливанием углекислого газа и производством водорода. Новое партнёрство осуществляется в рамках более масштабных усилий штата и федеральных властей, направленных на ускорение развития внутренней ИИ-инфраструктуры в США и стимулирование экономического роста на местах. Особое значение проект приобретает в контексте растущей нагрузки на энергосистемы США из-за спроса на ИИ-вычисления. Новые проекты, реализуемые совместно поставщиками вычислительной инфраструктуры и энергетическими компаниями, фактически меняют географию размещения будущих ЦОД и принципы их проектирования. Благодаря богатым энергетическим ресурсам и благоприятной нормативно-правовой базе Вайоминг может претендовать на роль ключевого игрока в этих трансформациях. По последним данным Crusoe заказала у GE Vernova 19 газотурбинных установок LM2500XPRESS на основе авиационных двигателей в дополнение к десяти уже купленным. Впрочем, использовать их, вероятно, будут в Техасе.

29.07.2025 [14:30], Владимир Мироненко

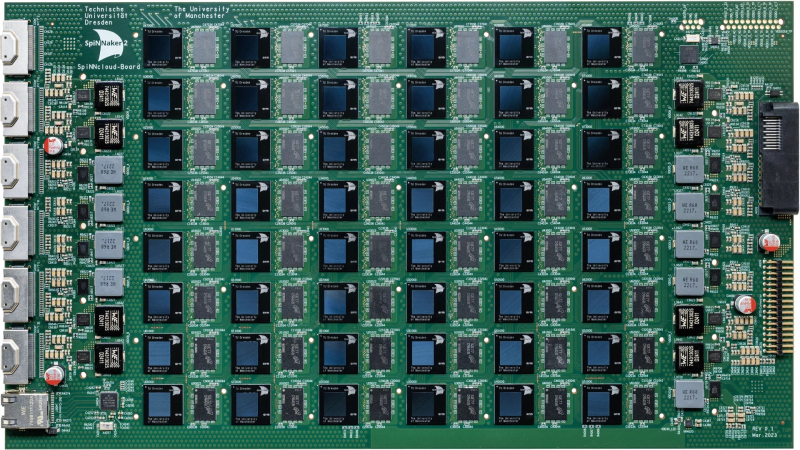

Стартап SpiNNcloud поставит Лейпцигскому университету «нейроморфный» суперкомпьютер для создания новых лекарств in silicoСтартап SpiNNcloud Systems из Дрездена (Германия) сообщил о заключении сделки на поставку Лейпцигскому университету нейроморфного суперкомпьютера, основанного на принципах функционирования человеческого мозга и предназначенного для разработки новых лекарственных препаратов. Суперкомпьютер будет использоваться учёными для моделирования сворачивания белков в рамках исследований в области персонализированной медицины, объединяющей достижения геномики, ИИ, робототехники и новейших диагностических технологий. Стоимость сделки не разглашается. В суперкомпьютере применена высокопараллельная архитектура с 48 чипами SpiNNaker2 на серверной плате, каждый из которых содержит 152 Arm-ядра со специализированными ускорителями и потребляет 0,8–2,5 Вт. Вся система, оснащённая 4320 чипами с 656 640 ядрами, помещается в одну стойку, но университет решил развернуть её в двух стойках, сообщил Гектор Гонсалес (Hector Gonzalez), соучредитель и генеральный директор SpiNNcloud, отметив, что общий энергетический бюджет системы составляет 25 кВт. Новый подход к разработке лекарств использует исключительную параллельность и масштабируемость суперкомпьютера для развёртывания миллионов небольших моделей, которым поручено находить соответствия между молекулами и профилями пациентов. Эта конструкция обеспечивает эффективные, событийно-ориентированные вычисления, позволяя выполнять сложное моделирование и разрабатывать новые персонализированные препараты с более высокой скоростью сходимости и при более низком энергопотреблении по сравнению с традиционными системами на базе GPU. «Точное и детализированное управление процессорами позволяет использовать очень разреженный маршрут, не задействуя все ядра, — поясняет Гонсалес. — Это один из фундаментальных аспектов, который очень сложно реализовать на GPU, поскольку GPU устроен как каскад вычислительных блоков, которые необходимо задействовать максимально полно, чтобы добиться синхронной эффективности». «Архитектура SpiNNcloud делает возможным скрининг миллиардов молекул in silico (виртуальное клиническое исследование)», — сообщил Кристиан Майр (Christian Mayr), соучредитель SpiNNcloud. По его словам, изначально разработанная для моделирования биологических нейронных сетей серверная система SpiNNcloud адаптирована для массивно-параллельного выполнения небольших гетерогенных задач. Прототип нейронной сети позволяет провести скрининг 20 млрд молекул менее чем за час — это на два порядка быстрее, чем на 1000 CPU-ядер. Гонсалес сообщил ресурсу EE Times, что индивидуальный подход к разработке лекарств, используемый в персонализированной медицине, хорошо вписывается в архитектуру SpiNNcloud. «Это множество небольших моделей, которые взаимодействуют друг с другом через чрезвычайно быструю сеть», — пояснил он. «Наша вычислительная архитектура <…> уникально подходит для развёртывания эффективных алгоритмов, требующих динамической разреженности и экстремального параллелизма», — добавил глава SpiNNcloud. «Экстремальный параллелизм SpiNNcloud делает их идеально подходящими для задач, связанных со сворачиванием белков, например, для поиска низкомолекулярных лекарственных препаратов, — отметил Йенс Майлер (Jens Meiler), профессор Института Александра фон Гумбольдта по Интернету и обществу и директор Института поиска лекарственных препаратов Лейпцигского университета. — «Фолдинг белков можно рассматривать как задачу оптимизации, в которой белок стремится найти своё наименьшее энергетическое состояние. Суперкомпьютеры SpiNNcloud хорошо справляются с такими задачами». Самая крупная система, развёрнутая SpiNNcloud на данный момент, включает 30 тыс. чипов (более 5 млрд вычислительных элементов) в Дрезденском университете. «Максимально возможная система, которую мы можем спроектировать, – это 16 стоек, — говорит Гонсалес. — При более чем 16 стойках будет сложно поддерживать достаточную связанность между моделями». По его словам, можно было бы развернуть в Лейпциге и более крупный суперкомпьютер с большим числом ядер, но компании пришлось учитывать финансовые ограничения университета. Как сообщает EE Times, SpiNNcloud также тестирует своё оборудование в новых исследовательских направлениях, основанных на классических методах глубокого обучения, в частности, в работе с MoE-моделями. По словам Гонсалеса, архитектура SpiNNcloud хорошо подходит для таких задач. Разработчик выразил надежду, что архитектуры, вдохновлённые принципами работы мозга, такие как SpiNNcloud, позволят создавать новые типы моделей, невозможные для реализации на массовом оборудовании.

28.07.2025 [14:16], Сергей Карасёв

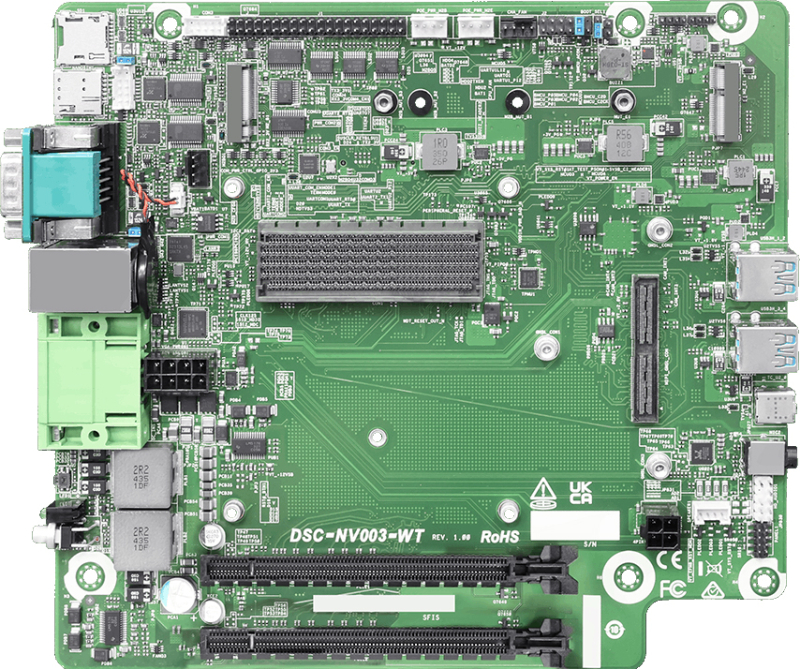

ASRock Industrial представила платформу NVIDIA Jetson AGX Orin для периферийных ИИ-устройствКомпания ASRock Industrial анонсировала комплект для разработчиков NVIDIA Jetson AGX Orin Developer Kit. Решение предназначено для построения периферийных ИИ-устройств, роботов, дронов, дистанционно управляемых систем и пр. В основу новинки положена аппаратная платформа NVIDIA Jetson AGX Orin. Комплект представлен в трёх вариантах — Jetson AGX Orin Industrial (JAOi), Jetson AGX Orin 64GB (JAO 64GB) и Jetson AGX Orin 32GB (JAO 32GB). ИИ-производительность достигает соответственно 248, 275 и 200 TOPS (INT8). Во всех случаях конфигурация включает GPU на архитектуре Ampere, CPU на базе Arm Cortex-A78AE и флеш-модуль eMMC 5.1 вместимостью 64 Гбайт. Версия JAOi несёт на борту 64 Гбайт памяти LPDDR5 DRAM с поддержкой ECC, тогда как модификации JAO 64GB и JAO 32GB укомплектованы соответственно 64 и 32 Гбайт LPDDR5 DRAM. Все варианты располагают коннектором M.2 Key M 2280 для NVMe SSD с интерфейсом PCIe 3.0 x4, разъёмом M.2 Key B 3042/3052/2280 для модема 4G/5G (плюс слот Nano SIM) и коннектором M.2 Key E 2230 (PCIe 3.0 x1; USB 2.0) для адаптера Wi-Fi / Bluetooth. Предусмотрены два разъёма PCIe x16 (на уровне сигналов PCIe 4.0 x8), слот microSD (UHS-I/SDR-50), четыре порта USB 3.2 Gen2x1 Type-A, разъём USB 2.0 Type-C и интерфейс HDMI 2.0. В оснащение входят сетевые контроллеры Marvell_88E1512-A0-NNP2C000 Gigabit Ethernet и Intel I226IT с гнёздами RJ45. Реализованы два последовательных порта RS-232/422/485 через коннектор DB9 и разъём на плате. Кроме того, упомянута 40-контактная колодка с поддержкой I2S, I2C (×2), SPI, UART, CAN(×2), PWM (×2) и пр. Через модули M.2 E Key и B Key, а также карты PCIe могут быть добавлены до 12 портов PoE (IEEE 802.3af) для питания внешних устройств, таких как камеры. Имеется встроенный модуль TPM 2.0 для обеспечения безопасности. Диапазон рабочих температур простирается от -25 до +45 °C. Питание в диапазоне 12–48 В подаётся через DC-разъём. Габариты изделия составляют 190,32 × 210,31 мм.

28.07.2025 [13:35], Сергей Карасёв

Huawei представила ИИ-систему CloudMatrix 384 — конкурента NVIDIA GB200 NVL72Компания Huawei, по сообщению Reuters, представила на Всемирной конференции по искусственному интеллекту (WAIC) в Шанхае (Китай) систему CloudMatrix 384 для ресурсоёмких ИИ-нагрузок. Участники ранка рассматривают эту платформу в качестве прямого конкурента NVIDIA GB200 NVL72. Информация о характеристиках CloudMatrix 384 появилась в апреле нынешнего года: система объединяет 384 ускорителя Huawei Ascend 910C. Для сравнения: NVIDIA GB200 NVL72 содержит в одной стойке 18 узлов 1U, каждый из которых включает два ускорителя GB200 — в сумме это даёт 72 чипа B200 и 36 процессоров Grace. Быстродействие CloudMatrix 384 достигает 300 Пфлопс (BF16) против 180 Пфлопс у NVIDIA GB200 NVL72. Кроме того, решение Huawei в 3,6 раза превосходит конкурирующую платформу по объёму памяти HBM и в 2,1 раза по пропускной способности памяти. Однако для достижения таких показателей потребовалось в пять с лишним раз больше ускорителей. Таким образом, по производительности и энергоэффективности отдельные карты Ascend 910C существенно уступают изделиям NVIDIA GB200. По данным сетевых источников, на коммерческий рынок система CloudMatrix 384 может поступить под именем Atlas 900 A3 SuperPoD. Компания Huawei, не вдаваясь в подробности, отмечает, что машина использует архитектуру «суперузлов», которая позволяет ИИ-ускорителям взаимодействовать на сверхвысоких скоростях. Обещаны ультранизкие задержки. Выход системы призван укрепить позиции Китая в сфере ИИ на фоне американских санкций. Власти США наложили запрет на поставки в КНР передовых решений в сфере ИИ. Тем не менее, за три месяца действия новых правил по ужесточению контроля над экспортом таких ускорителей в Китай всё равно попали изделия NVIDIA на сумму не менее $1 млрд. А сама компания NVIDIA между тем рассчитывает возобновить отгрузки ИИ-ускорителей H20 китайским заказчикам.

28.07.2025 [10:14], Руслан Авдеев

Мегаваттный Левиафан: Armada представила контейнерный ИИ ЦОД повышенной мощностиКомпания Armada, занимающаяся созданием дата-центров контейнерного типа, привлекла инвестиций на $131 млн и тут же анонсировала модульный ЦОД Leviathan мегаваттного класса, сообщает Datacenter Dynamics. В очередном раунде финансирования приняли участие Pinegrove Veriten и Glade Brook, а также и прежние инвесторы, включая Founders Fund, Lux Capital, Shield Capital, 8090 Industries, венчурный фонд Microsoft M12, Overmatch, Silent Ventures, Felicis и Marlinspike. Вместе с новостями об инвестициях Armada анонсировала и новый модульный ИИ ЦОД Leviathan с СЖО, который входит в серию Galleon и фактически представляет собой «более крупный аналог» ЦОД Triton с десятикратно повышенной вычислительной мощностью. По словам компании, новый ЦОД можно развернуть в удалённых локациях всего за несколько недель. Например, неподалёку от источников природного газа, объектов альтернативной энергетики и даже атомных станций. По оценкам Armada, в США есть порядка 6 ГВт не до конца освоенных источников энергии. Leviathan мог бы помочь задействовать её для ИИ-вычислений. По мнению компании, доминирование США в сфере ИИ и энергетики зависит от быстрого перемещения огромных вычислительных мощностей на периферию, где генерируются подлежащие обработке данные и есть недорогая энергия. Именно для таких проектов и предназначен Leviathan. Каждый модуль Leviathan обеспечивает мегаваттную производительность за значительно меньшее время, чем традиционные ЦОД — благодаря способности адаптироваться к эволюции ИИ-ускорителей и систем охлаждения и использовать всю доступную территорию и энергию. Ввод проекта в эксплуатацию и дополнительное финансирование ускорят миссию по преодолению «цифрового неравенства» и переходу всего мира на американский ИИ-стек. У Armada уже запланированы совместные проекты с Fidelis New Energy и Bakken Energy, которые будут использовать природный газ для энергоснабжения дата-центров. В 2025 году Armada развернула контейнерные периферийные ЦОД совместно с Tampnet — для морских нефтяных платформ, ВМС США, Aramco в Саудовской Аравии и Newlab в Детройте и Эр-Рияде.

28.07.2025 [09:19], Руслан Авдеев

Новый «Манхэттенский проект»: Министерство энергетики США выделило бизнесу свои земли для ускоренного строительства ЦОД и электростанцийМинистерство энергетики США (DoE) выделило четыре площадки для строительства дата-центров и электростанций коммерческими компаниями. Это делается в соответствии с программой AI Action Plan по стимулированию развития ИИ в Америке, сообщает The Register. Ранее заявлялось, что властями уже одобрены 16 площадок, потенциально пригодных для ускоренного строительства ЦОД в соответствии с указами о выделении федеральных земель под проекты такого рода для наращивания вычислительных мощностей. Окончательное одобрение получили Национальная лаборатория Айдахо (Idaho National Laboratory), комплекс ядерных и научных объектов на территории Ок-Ридж (Oak Ridge Reservation), завод по обогащению урана Paducah Gaseous Diffusion Plant и крупный ядерный комплекс Savannah River Site на юге США. Частным компаниям предложат строить на территории этих объектов ИИ ЦОД и необходимые для них энергетические мощности, включая атомные электростанции. По словам DoE, отдавая свои земли, оно способствует ускорению реализации нового «Манхэттенского проекта» в области ИИ и энергетики. По иронии судьбы, территория Ок-Ридж была выделена в рамках исходного Манхэттенского проекта по созданию атомной бомбы в начале 1940-х гг. Здесь находится Национальной лаборатории Ок-Ридж (ORNL), управляющая суперкомпьютером Frontier, также непосредственно задействованном в проектах обеспечения ядерной безопасности. Там же находится Центр национальной безопасности Y-12 (Y-12 National Security Complex), участвующий в создании атомного оружия. Прочие выделенные земли тоже так или иначе связаны с ядерным оружием и энергетикой. Это может косвенно свидетельствовать о намерениях властей обеспечить питание новых ЦОД за счёт «мирного атома».

Источник изображения: Kilian Karger/unsplash.com Министерство сообщило, что получило огромный отклик на ранее опубликованный запрос информации (RFI), связанный с выбором площадок для размещения крупных дата-центров, новых энергетических объектов и другой инфраструктуры. Это помогло выбрать участки, действительно соответствующие требованиям масштабных технологических проектов. В рамках AI Action Plan открывается возможность использовать федеральные земли и ресурсы для скорейшего развития дата-центров мощностью более 100 МВт. Ещё один указ, изданный в мае, призван обеспечить быструю разработку и внедрение ядерных технологий для обеспечения национальной безопасности, в т.ч. с установкой реакторов на объектах DoE. В частности, в документе поставлена цель ввести в эксплуатацию современный ядерный реактор на первой из площадок не позднее через 30 месяцев с даты издания указа, т.е. уже в конце 2027 года. Правда, некоторые эксперты заявляли, что репрессии в отношении «зелёной» энергетики навредят США в гонке за ИИ-лидерство. Учитывая, что времени осталось совсем немного, Министерство энергетики заявляет, что партнёры-исполнители могут быть выбраны уже к концу текущего года.

27.07.2025 [14:43], Сергей Карасёв

Eviden предоставит техническую платформу для европейского оборонного ИИ-проекта AtLaSЕвропейская комиссия выбрала компанию Eviden (входит в Atos Group) в качестве поставщика технической платформы для хостинга и интеграции приложений, разработанных девятью организациями в составе консорциума AtLaS. Проект AtLaS направлен на развитие технологий обработки естественного языка (HLT) в оборонном секторе. Инициатива охватывает четыре ключевых варианта использования: это мониторинг учений НАТО, взаимодействие полевых групп ЕС, отслеживание публикаций в СМИ в рамках операций ЕС и анализ перехваченных сообщений. AtLaS предполагает объединение инструментов ИИ и средств обработки естественного языка (NLP) для анализа низкокачественных и многоязычных данных. Предусмотрено применение передовых технологий обучения и устранения шумов. В целом, проект предполагает решение пяти задач: в их число входят оптимизация для снижения чувствительности к шуму, распознавание речи/документов, генерация многоязычного текста, извлечение информации и адаптация. Результатом должны стать повышение устойчивости системы, высокоточная обработка данных, контекстно-зависимый перевод, структурированное извлечение информации и возможность настройки системы под потребности пользователя. Бюджет инициативы AtLaS составляет около €6 млн, а финансирование осуществляется Европейским союзом. В проекте участвуют Дания, Италия, Испания, Франция, Бельгия, Германия, Австрия, Греция, Кипр и Румыния. Eviden предоставит техническую платформу для конкурса HLTP Challenge: участники консорциума AtLaS получат возможность улучшить взаимодействие и сбор разведывательной информации в сфере обороны, а также создать адаптивные системы для европейской библиотеки языковых технологий. При оценке создаваемых решений будут учитываться их специфические характеристики, такие как эффективность обработки различных диалектов и языков в сложных условиях, включая военные действия. В рамках соглашения с Еврокомиссией Eviden также предоставит собственное инновационное программное обеспечение BARTENDER, которое позволяет обрабатывать тексты на сотнях языков.

26.07.2025 [14:55], Сергей Карасёв

В Европе запущена первая метаоблачная ИИ-платформа Fact8raКомпания OpenNebula Systems объявила о запуске Fact8ra — это, как утверждается, первая в Европе платформа «ИИ как услуга» (AI-as-a-Service) на основе мультиоблачной архитектуры. Инициатива является важным этапом на пути формирования европейской суверенной инфраструктуры ИИ. Любопытно, что в Китае создаётся похожая платформа, но по совсем иным причинам — в результате не слишком удачного планирования значительная часть вычислительных мощностей простаивает без дела. Система Fact8ra предлагает многопользовательскую среду для развёртывания частных экземпляров больших языковых моделей (LLM) с открытым исходным кодом. Платформа объединяет НРС-мощности, публичное облако и периферийные ресурсы по всему ЕС. Fact8ra основана на суверенном облачном стеке ИИ, включающем решения OpenNebula, а также другие европейские технологии open source, такие как openSUSE и MariaDB. Поначалу Fact8ra объединит GPU-серверы в восьми странах ЕС: Франции, Германии, Италии, Латвии, Нидерландах, Польше, Испании и Швеции. Отмечается, что Fact8ra способна агрегировать ресурсы поставщиков публичных облачных сервисов, периферийных площадок, суперкомпьютерных центров и финансируемых ЕС фабрик ИИ. В частности, будут объединены мощности Arsys, CloudFerro, IONOS, Leaseweb, OVHcloud, Scaleway, StackScale и Tiscali. Говорится о расширенной поддержке ИИ-ускорителей NVIDIA. Fact8ra поддерживает работу с различными LLM, включая Mistral Nemo 12B, EuroLLM 9B, Salamandra 7B и Italia 9B. Кроме того, реализована интеграция с внешними каталогами ИИ-моделей, в том числе Hugging Face. Поначалу пользователям будут доступны возможности инференса, а затем появятся функции тонкой настройки и обучения моделей ИИ. Fact8ra реализуется как часть программы IPCEI-CIS (Important Project of Common European Interest on Next Generation Cloud Infrastructure and Services) — это европейский проект развития облачной инфраструктуры и услуг следующего поколения. Инициатива стоимостью €3 млрд была одобрена Европейской комиссией в декабре 2023 года. Проект поддерживается 12 государствами-членами ЕС и более чем 120 индустриальными партнёрами. Целями являются стимулирование исследований и увеличение инвестиций в технологии периферийных и облачных вычислений в ЕС, а также создание децентрализованной периферийной инфраструктуры. Ранее в рамках IPCEI-CIS была анонсирована суверенная облачная платформа Virt8ra. |

|