Материалы по тегу: hpe

|

19.12.2023 [14:40], Руслан Авдеев

Пентагон получил 9-Пфлопс суперкомпьютер Carpenter: 280 тыс. ядер AMD и 563 Тбайт RAMАмериканское военное ведомство ввело в эксплуатацию новый суперкомпьютер. По данным Datacenter Dynamics, Центр исследований и разработок армии США (ERDC) представил систему Carpenter производительностью 9 Пфлопс, названную в честь капрала Уильяма Кайла Карпентера (William Cyle Carpenter). Впервые ERDC поделился планами строительства нового суперкомпьютера в августе прошлого года, изначально ожидалось, что машина получит по два чипа на узел, каждый со 192 ядрами и 384 Гбайт памяти, и 200G-интерконнект. Суперкомпьютер построен в лаборатории Army Computing Lab в Виксбурге (Миссисипи). Система, базирующаяся на платформе HPE Cray EX4000, оснащена 277 248 вычислительными ядрами AMD EPYC и 563 Тбайт памяти. О наличии каких-либо ускорителей не сообщается. Первый суперкомпьютер ERDC получил в 1990 году, а в 1992 году центр начал реализацию проекта High Performance Computing Modernization Program (HPCMP). В частности, она позволяет учёным Пентагона получать доступ к мощностям для разработки, тестирования и оценки оборонных систем. В ведении ERDC также находятся суперкомпьютеры Freeman и Onyx. Последний должны были «отправить на покой» ещё в августе этого года, но он всё ещё числится в ноябрьском списке TOP500, равно как и система Topaz 2015 года.

04.12.2023 [09:36], Владимир Мироненко

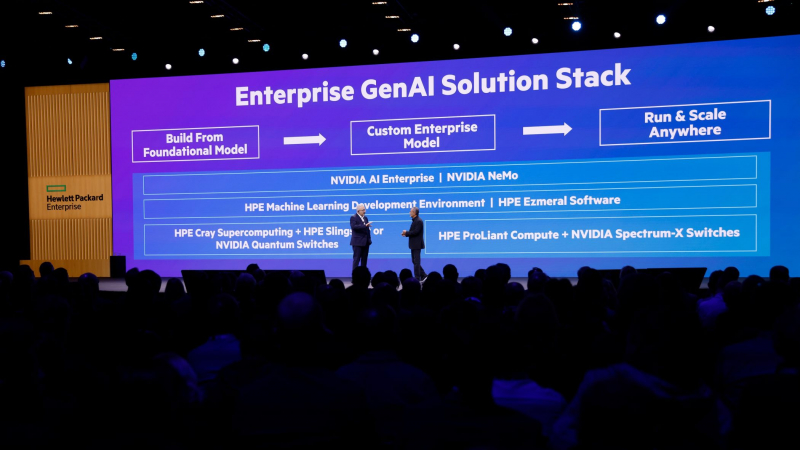

HPE и NVIDIA представили совместное решение для корпоративного ИИ, а HPE анонсировала LLM-платформу Project EthanHewlett Packard Enterprise (HPE) объявила о расширении стратегического сотрудничества с NVIDIA с целью создания инструментов для генеративного ИИ. Совместно разработанное, предварительно настроенное решение позволит предприятиям любого размера использовать собственные данные для быстрой настройки посредством RAG базовых ИИ-моделей, которые были обучены на больших наборах данных и могут быть адаптированы для выполнения различных задач от периферии до облака. HPE и NVIDIA также предоставляют в рамках сотрудничества полнофункциональные готовые решения для обработки приложений ИИ. Эти решения объединяют ПО фирменные среды разработки HPE для машинного обучения, HPE Ezmeral, платформы HPE ProLiant и HPE Cray, а также программный пакет NVIDIA AI Enterprise, включая NVIDIA NeMo. Аппаратная составляющая включает 16 серверов HPE ProLiant DL380a, несущих в общей сложности 64 ускорителя NVIDIA L40S и использующих DPU NVIDIA BlueField-3 и NVIDIA Spectrum-X.

Источник изображений: HPE Программно-аппаратный комплекс, например, позволяет дообучить на собственных данных модель Llama 2 с 70 млрд параметров. Решение включает ПО HPE Machine Learning Development Environment с новыми возможностями в области генеративного ИИ для быстрого прототипирования и тестирования моделей, а также ПО HPE Ezmeral с поддержкой ускорителей, которое упростит развёртывания и ускорит подготовку данных для ИИ-нагрузок в гибридном облаке. Партнёры HPE смогут заказать решение уже в I квартале 2024 года. Заодно HPE анонсировала платформу Project Ethan, ориентированную на оркестрацию ресурсов в локальных или публичных облаках для работы с большими языковыми моделями (LLM). Кроме того, компания сообщила, как планирует более полно адаптировать платформу Greenlake для работы с ИИ. Например, OpsRamp, ИИ-решение для управления ИТ-операциями (IT Operations Management, ITOM), приобретённое компанией в марте этого года, уже доступно по подписке в Greenlake. В OpsRamp добавлен HPE Sustainability Insight Center — инструмент для отслеживания и мониторинга энергопотребления ИТ-ресурсов, которыми управляет организация. Это было сделано для удобства клиентов, которые обучают и используют модели ИИ, и хотят контролировать потребление энергии. Обучение и инференс LLM, по словам компании, требует больших затрат электроэнергии — 1200 МВт·ч и 250 МВт·ч в день соответственно. Инструмент позволит управлять энергопотреблением с учётом возможностей компании. Также HPE представила пакет ПО Greenlake Hybrid Operations, объединяющий Ezmeral, OpsRamp с Sustainability Insight Center и набор решений для резервного копирования и восстановления HPE Data Protection Suite. Он позволит клиентам управлять, контролировать и защищать свои данные и рабочие нагрузки от периферии до облака.  В ближайшее время будет представлено и решение HPE Private Cloud Solutions для ИИ, основанное на аппаратных решениях HPE, обновлённой платформе HPE Greenlake for File Storage (эффективная ёмкость до 250 Пбайт, до 700 Гбайт/с на чтение и до 200 Гбайт/с на запись), OpsRamp и Zerto Cyber Resilience Vault. Последнее решение представляет собой автономную платформу для данных, которая помогает восстановить работу после атаки программы-вымогателя, если данные зашифрованы или удалены. Полная информация и даты доступности новых продуктов не разглашаются. Как сообщает ресурс The Register, решение объявить о них на мероприятии HPE Discover EMEA было принято в последнюю минуту.

29.11.2023 [12:57], Сергей Карасёв

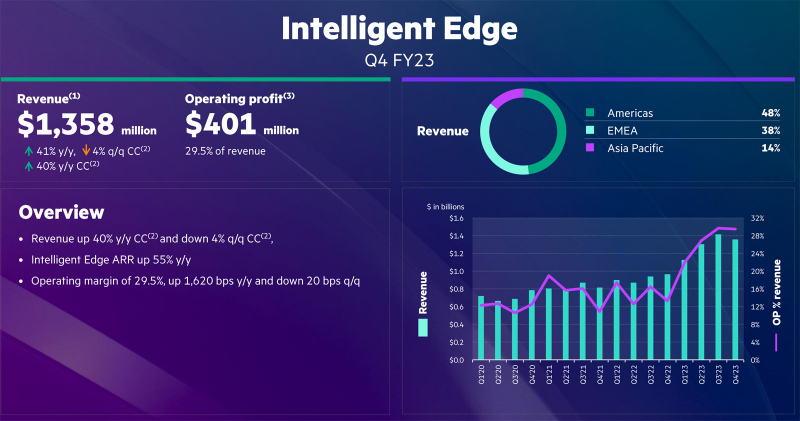

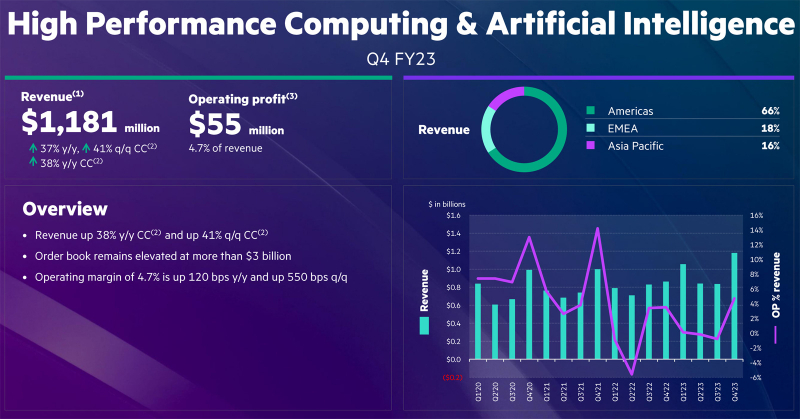

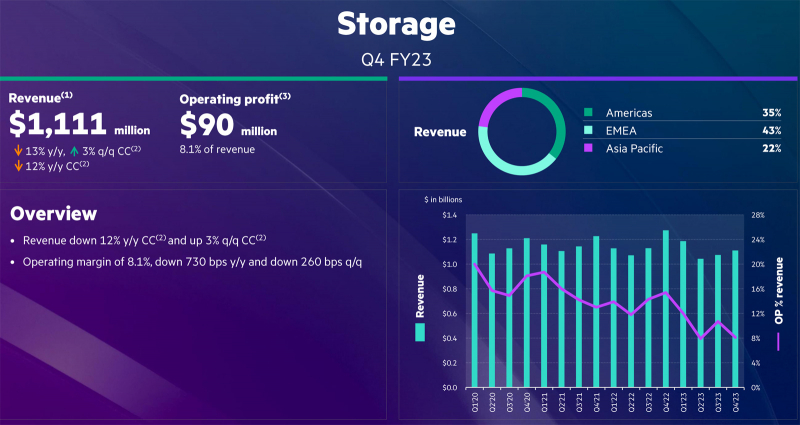

HPE увеличила чистую годовую прибыль более чем в два разаКомпания Hewlett Packard Enterprise (HPE) опубликовала отчёт о работе в последней четверти и 2023 финансовом году в целом, который был закрыт 31 октября. Поставщик оборудования значительно улучшил показатели чистой прибыли, что объясняется растущим спросом на НРС-платформы и стремительным развитием сегмента ИИ. Квартальная выручка составила $7,35 млрд, что находится в середине собственного прогнозного диапазона HPE. Однако это примерно на 7 % меньше прошлогоднего результата, когда компания получила $7,87 млрд. Чистая прибыль составила $642 млн, тогда как годом ранее были продемонстрированы чистые убытки в размере $304 млн. Подразделение Intelligent Edge, отвечающее в числе прочего за продажи продукции для Интернета вещей и сетевой бизнес Aruba, принесло $1,36 млрд, что на 41 % больше, чем годом ранее. Выручка в сегменте ИИ и высокопроизводительных вычислений (HPC & AI) составила $1,18 млрд — это на 37 % больше по сравнению с III четвертью 2022 финансового года. В сфере СХД квартальный объём продаж составил $1,1 млрд, что на 13 % меньше, чем годом ранее. Поступления от платформ для вычислений упали на 31 % год к году — до $2,6 млрд. По итогам 2023 финансового года в целом HPE показала выручку в размере $29,14 млрд против $28,50 млрд в 2022-м. Таким образом, рост оказался на отметке 2 %. При этом чистая прибыль подскочила более чем в два раза — с $868 млн до $2,03 млрд. Годовая выручка подразделения Intelligent Edge поднялась на 42 %, достигнув $5,20 млрд. Бизнес HPC & AI принёс $3,91 млрд, что на 23 % больше прошлогоднего результата. По направлению СХД продажи зафиксированы на отметке $4,42 млрд — минус 4 % год к году. Выручка в сегменте вычислений сократилась на 11 %, составив $11,44 млрд. В I квартале 2024 финансового года HPE ожидает показать выручку от $6,9 до $7,3 млрд, а чистая прибыль составит от 42 до 50 центов на акцию. В целом, в 2024 финансовом году компания намерена получить прибыль от $1,82 до $2,02 на ценную бумагу.

18.11.2023 [23:57], Сергей Карасёв

ИИ-суперкомпьютер «под ключ»: HPE и NVIDIA представили HPC-платформу на базе гибридных суперчипов Grace HopperКомпании HPE и NVIDIA анонсировали модульную суперкомпьютерную систему для генеративного ИИ и обучения моделей на основе частных массивов данных. Комплекс ориентирован на крупные предприятия, исследовательские организации и государственные структуры. В основу решения положена аппаратная платформа Cray EX2500. В состав входят суперчипы NVIDIA GH200 Grace Hopper, содержащие 72-ядерный Arm-процессор NVIDIA Grace и ускоритель NVIDIA H200. Каждый узел системы использует четыре таких суперчипа. Узлы соединены друг с другом при помощи интерконнекта Slingshot. Говорится, что реализованная архитектура позволяет осуществлять масштабирование до тысяч ускорителей. При этом все мощности могут выделяться для решения одной задачи ИИ, что обеспечивает максимальную эффективность использования ресурсов. По сути, новое решение представляет собой мини-версию ИИ-суперкомпьютера Isambard-AI, который разместится в Бристольском университете (Великобритания). HPE и NVIDIA будут предлагать систему в качестве решения «под ключ» с услугами по установке и настройке.

Источник изображения: HPE Кроме того, предусмотрен стек ПО для решения различных ИИ-задач: это среда HPE Machine Learning Development Environment, набор инструментов HPE Cray Programming Environment, а также пакет NVIDIA AI Enterprise. В целом, как отмечается, новая система предлагает заказчикам производительность и масштабируемость, которые позволяют решать наиболее сложные ИИ-задачи, включая обучение больших языковых моделей (LLM) и создание рекомендательных систем.

15.11.2023 [16:56], Сергей Карасёв

Российская «дочка» HPE договорилась с дистрибьютором OCS — взыскания на 2 млрд рублей отмененыДевятый арбитражный апелляционный суд, по сообщению «Интерфакса», отменил два решения Арбитражного суда Москвы, который ранее удовлетворил иски дистрибутора OCS Distribution (ООО «О-си-эс-центр») в отношении российского подразделения корпорации Hewlett Packard Enterprise (HPE) — ООО «Хьюлетт паккард энтерпрайз». Стороны заключили мировые соглашения. Российская «дочка» HPE в сложившейся геополитической обстановке прекратила деятельность на российском рынке. При этом компания не выполнила обязательства по договорам и осталась должна партнёрам миллиарды рублей. В этой связи против поставщика оборудования корпоративного класса посыпались многочисленные судебные иски.

Источник изображения: pixabay.com Со стороны ООО «О-си-эс-центр» к российской структуре HPE были поданы два иска: на 1,44 млрд руб. от 31 октября 2022 года и на 551 млн руб. от 5 апреля 2023-го. Оба были полностью удовлетворены минувшим летом. Однако со стороны ООО «Хьюлетт паккард энтерпрайз» была подана апелляция. Как теперь стало известно, оба постановления отменены: суд объявил о прекращении производств по этим делам и утверждении мировых соглашений. Подробности договорённостей между сторонами не раскрываются, поскольку слушания проходили в закрытом режиме. Между тем к российской «дочке» HPE недавно были поданы новые крупные иски на сотни миллионов рублей. Среди них — претензии ООО «Компания Комплит» на сумму 4 859 645,7 руб., ООО «Треолан» на сумму 653 291 714,32 руб. и ООО «Компинтегро» на сумму 2 035 715,33 руб.

15.11.2023 [13:57], Сергей Карасёв

Французский суперкомпьютер Adastra одним из первых получит новейшие ускорители AMD Instinct MI300AФранцузское национальное агентство по высокопроизводительным вычислениям (GENCI), по сообщению HPCwire, проводит масштабное обновление суперкомпьютера Adastra, о запуске которого было объявлено два года назад. После апгрейда система сможет решать сложные задачи в области ИИ. Комплекс Adastra находится под управлением Национального вычислительного центра высшего образования Франции (CINES). Система использует платформу HPE Cray EX235A с оптимизированными процессорами AMD EPYC Milan (64 ядра; 2,0 ГГц) и ускорителями AMD Instinct MI250X. Апгрейд предусматривает использование гибридных чипов Instinct MI300A в составе платформы HPE Cray EX4000, оснащённой 14 серверами HPE Cray EX255a Accelerator Blade. В общей сложности будут задействованы 28 узлов, каждый из которых содержит четыре чипа Instinct MI300A. Таким образом, суммарное количество использованных изделий Instinct MI300A равно 112. Задействован 200G-интерконнект HPE Slingshot 11. Об итоговой производительности обновлённого суперкомпьютера Adastra данных пока нет. Но в прежнем виде система занимает 17-ю строку в ноябрьском рейтинге TOP500 с быстродействием 46,1 Пфлопс (FP64). А в мировом рейтинге самых энергоэффективных НРС-систем GREEN500 комплекс Adastra находится на третьей позиции с показателем 58,021 Гфлопс/Вт.

02.11.2023 [21:49], Руслан Авдеев

Британия получит 200-Пфлопс ИИ-суперкомпьютер Isambard-AI на гибридных Arm-чипах NVIDIA GH200Правительство Великобритании о выделении £225 млн ($273 млн) на строительство самого мощного в стране суперкомпьютера Isambard производительностью более 200 Пфлопс в FP64-вычислениях и более 21 Эфлопс в ИИ-задачах. Как сообщает The Register, новая машина на базе тысяч гибридных Arm-суперчипов NVIDIA Grace Hopper (GH200) разместится в Бристольском университете и будет построена HPE. Ожидается, что машина будет введена в эксплуатацию в следующем году и поможет в выполнении самых разных задач, от автоматизированной разработки лекарств до анализа климатических изменений, от изучения и внедрения нейросетей в робототехнике до задач, связанных с обеспечением национальной безопасности и обработкой больших данных. Isambard-AI войдёт в десятку самых быстрых суперкомпьютеров мира. Пока что самый быстрый суперкомпьютер Великобритании — это 20-Пфлопс система Archer2, занимающая 30-ю позицию в рейтинге TOP500 и введённая в строй всего пару лет назад. Isambard-AI получит 5448 гибридных чипов NVIDIA GH200 GraceHopper с 96/144 Гбайт HBM-памяти. Используется платформа HPE Cray EX с интерконнектом Slingshot 11 и СЖО. 25-Пбайт хранилище использует СХД Cray ClusterStor E1000. Система будет размещена в ЦОД с автономным охлаждением, а система утилизации избыточного тепла позволит обогревать близлежащие здания. Первыми выгодоприобретателями проекта Isambard-AI станут команды Frontier AI Task Force и AI Safety Institute, намеренные смягчить угрозу со стороны ИИ национальной безопасности Великобритании. Компанию Isambard-AI составит ранее анонсированный Arm-суперкомпьютер Isambard-3, который также построит HPE. Эту машину введут в эксплуатацию следующей весной, она обеспечит британским учёным ранний доступ к вычислительным мощностям на первом этапе реализации проекта Isambard-AI. Isambard-3 получит 384 суперчипа NVIDIA Grace, а его пиковое быстродействие в FP64-вычислениях составит 2,7 Пфлопс. Всего в различные ИИ-проекты британские власти вложат порядка £900 млн ($1,1 млрд). В частности, вместе с Isambard-AI был объявлен и суперкомпьютер Dawn, который разместится в Кембридже. Хотя ранее NVIDIA описывала Isambard-AI как самый быстрый в стране, создатели Dawn утверждают, что быстрейшим будет именно он. Система будет полагаться на серверы Dell PowerEdge XE9640 с процессорами Sapphire Rapids и ускорителями Max.

25.10.2023 [11:49], Сергей Карасёв

Экзафлопсный суперкомпьютер Frontier назван лучшим изобретением 2023 года по версии TimeЕжегодно американский журнал Time публикует список из лучших изобретений человечества в самых разных сферах. В нынешнем году в рейтинг вошли 200 продуктов и технологий, которые сгруппированы более чем в 35 категорий. Это, в частности, ПО, связь, виртуальная и дополненная реальность, ИИ, потребительская электроника, чистая энергии, здравоохранение, безопасность, робототехника и многое другое. Одним из направлений являются экспериментальные системы и устройства. В данной категории победителем назван вычислительный комплекс Frontier — самый мощный суперкомпьютер 2023 года. Исследователи уже используют его для самых разных целей: от изучения чёрных дыр до моделирования климата. «Специалисты сравнивают это с эквивалентом высадки на Луну с точки зрения инженерных достижений. Это больше, чем чудо. Это статистическая невозможность», — сказал Ник Дюбе (Nic Dubé), руководитель проекта в HPE. Система Frontier, созданная специалистами HPE, установлена в Национальной лаборатории Окриджа (ORNL) Министерства энергетики США. Она занимает первое место в рейтинге TOP500 с производительностью 1,194 Эфлопс. В составе системы применяются процессоры AMD EPYC Milan, ускорители Instinct MI250X и интерконнект Cray Slingshot. В общей сложности задействованы 8 699 904 вычислительных ядра. Теоретическое пиковое быстродействие достигает 1,680 Эфлопс.

22.10.2023 [14:06], Сергей Карасёв

Видео дня: строительство 2-Эфлопс суперкомпьютера El CapitanЛиверморская национальная лаборатория им. Э. Лоуренса (LLNL) Министерства энергетики США опубликовала видео (см. ниже), демонстрирующее процесс сборки вычислительного комплекса El Capitan, которому предстоит стать самым мощным суперкомпьютером мира. В текущем рейтинге TOP500 лидирует система Frontier, установленная в Национальной лаборатории Окриджа (ORNL), также принадлежащей Министерству энергетики США. Быстродействие Frontier достигает 1,194 Эфлопс. Суперкомпьютер El Capitan сможет демонстрировать производительность более 2 Эфлопс (FP64). Сборка комплекса началась в июле нынешнего года, а ввод в эксплуатацию запланирован на середину 2024-го. Стоимость проекта оценивается приблизительно в $600 млн. В основе El Capitan — платформа HPE Cray Shasta. Применена гибридная архитектура AMD с APU Instinct MI300A: изделие содержит 24 ядра с микроархитектурой Zen 4 общего назначения, блоки CDNA 3 и 128 Гбайт памяти HBM3.

Источник изображения: LLNL Отмечается, что в проекте El Capitan задействованы сотни сотрудников LLNL и отраслевых партнёров. Суперкомпьютер состоит из тысяч вычислительных узлов и требует столько же энергии, сколько город среднего размера. В течение нескольких лет специалисты готовили инфраструктуру для El Capitan, создавая подсистемы электропитания и охлаждения, устанавливая компоненты и монтируя сетевые соединения. После запуска суперкомпьютер будет использоваться для решения задач в сферах ядерной энергетики, национальной безопасности, здравоохранения, изменений климата и пр.

20.10.2023 [14:46], Сергей Карасёв

Три поколения EPYC, A100, L40 и немного Xeon: HPE создала для Франции ИИ-суперкомпьютер Austral на базе Cray XD2000Компания Hewlett Packard Enterprise (HPE) объявила о вводе в эксплуатацию нового ИИ-суперкомпьютера под названием Austral, разработанного в интересах Регионального центра информатики и цифровых приложений Нормандии (CRIANN) во Франции. В основу вычислительного комплекса положена платформа Cray XD2000. Задействованы 11 двухпроцессорных узлов на базе AMD EPYC 7543 Milan (32 ядра на сокет; 2,8 ГГц; 512 Гбайт оперативной памяти DDR4-3200). Каждый из этих узлов использует восемь ускорителей NVIDIA A100 с 80 Гбайт памяти. Кроме того, в состав суперкомпьютера входят 124 двухпроцессорных узла с чипами AMD EPYC 9654 Genoa (96 ядер на сокет; 2,4 ГГц; 768 Гбайт оперативной памяти DDR5-4800). Есть и один специализированный узел с процессором AMD EPYC 7313P Rome (16 ядер; 3,0 ГГц; 96 Гбайт оперативной памяти DDR4-3200). Плюс к этому установлены пять двухсокетных узлов визуализации на основе AMD EPYC 9654 — каждый с двумя ускорителями NVIDIA L40 с 48 Гбайт памяти и 768 Гбайт ОЗУ DDR5-4800. Наконец, предусмотрен один узел HPE Superdome Flex 280 с восемью чипами Intel Xeon 8376H (28 ядер; 2,6 ГГц) и 6 Тбайт оперативной памяти DDR4-3200. Применяется 200G-интерконнект HPE Slingshot. Ёмкость хранилища достигает 2 Пбайт. Программная платформа основана на решениях Red Hat.

Источник изображения: HPE Заявленная пиковая FP64-производительность составляет 966 Тфлопс для CPU-части DP и 1034 Тфлопс — для GPU-блока. Применять суперкомпьютер планируется для проведения моделирования и анализа в таких областях, как изменения климата, биотехнологии, здравоохранение и материаловедение. |

|