Материалы по тегу: hardware

|

05.08.2024 [10:34], Руслан Авдеев

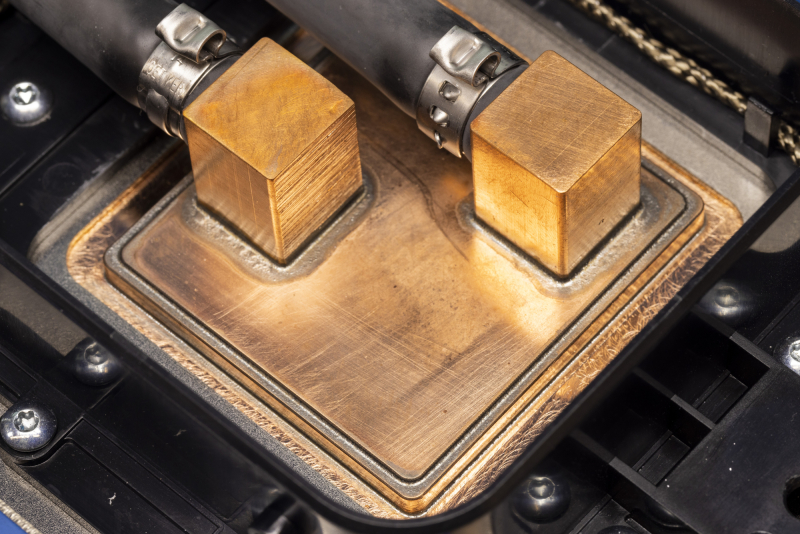

Microsoft начала активно внедрять прямое жидкостное охлаждение в своих ЦОД и приступила к прикладному изучению микрогидродинамикиКомпания Microsoft стала активно применять прямое жидкостное охлаждение чипов в серверах своих ЦОД. Datacenter Dynamics сообщает, что IT-гигант приступил и к изучению более передовой технологии, основанной на принципах микрогидродинамики. Как свидетельствует недавний пост в блоге компании, посвящённый использованию воды и применяемым СЖО разных поколений, сейчас разрабатывается новая архитектура дата-центров, оптимизированных для прямого жидкостного охлаждения чипов. Это требует переосмысления конструкции серверов и серверных стоек для внедрения новых методов терморегуляции и управления энергией. Компания уже использует sidekick-СЖО в действующих ЦОД. Впервые они были представлены во время анонса процессоров Cobalt и ИИ-ускорителей Maya. Последние будут развёрнуты в кастомных стойках и кластерах Ares. Серверы для них шире 19″ и даже OCP-стоек и нуждаются именно в жидкостном охлаждении — других конфигураций не предусмотрено. Каждый сервер получит по четыре ускорителя Maya, а стойка будет вмещать восемь серверов. А рядом с ней будет ещё одна стойка с компонентами охлаждения. Аналогичный дизайн использует Meta✴, которая также была вынуждена пересмотреть архитектуру своих ЦОД из-за ИИ. Не менее интересны и разработки в сфере микрогидродинамики. Этот подход предусматривает размещение микроканалов для подачи жидкости буквально внутри самих чипов, что обеспечивает ещё более высокую эффективность охлаждения. В компании утверждают, что все эти разработки оптимизированы для поддержки ИИ-нагрузок в ЦОД и в то же время дружественны к экологии. Благодаря инновациям можно значительно снизить потребление чистой воды, одновременно обеспечивая повышенную ёмкость серверных стоек, благодаря чему возрастает польза от каждого задействованного квадратного метра. Microsoft намерена стать «водно-положительной» к 2030 году. В ESG-докладе 2023 года компания заявила, что использовала в 2022 году 6,4 млн м3, преимущественно для своих ЦОД. В докладе 2024 года показатель увеличился уже до 7,8 млн м3 в 2023 году. Проблемы с потреблением воды вообще характерны для IT-гиганта и его партнёров. Запись в блоге Microsoft также свидетельствует о том, что компания расширила использование восстановленной и переработанной воды на площадках в Техасе, Вашингтоне, в Калифорнии и Сингапуре. В Нидерландах, Ирландии и Швеции компания собирает дождевую воду и намерена расширить эту практику на Канаду, Великобританию, Финляндию, Италию, Южную Африку и Австрию. В Нидерландах, правда, всё оказалось не так хорошо, как обещала компания. Как заявляют Microsoft, с первого поколения собственных дата-центров в начале 2000-х годов до текущего поколения в 2020-х, использование воды на кВт·ч снизилось более чем на 80 %. Ранее компания сотрудничала с разработчиком систем двухфазного погружного жидкостного охлаждения LiquidStack, который поддерживается одним из поставщиков Microsoft — Wiwynn. В прошлом году LiquidStack представила однофазную систему иммерсионного охлаждения для ИИ-систем, а также запустила в США производство СЖО, но для кого именно она их выпускает, не уточняется.

05.08.2024 [08:16], Сергей Карасёв

Новые кластеры Supermicro SuperCluster с ускорителями NVIDIA L40S ориентированы на платформу Omniverse

emerald rapids

hardware

intel

l40

nvidia

omniverse

sapphire rapids

supermicro

xeon

ии

кластер

сервер

Компания Supermicro расширила семейство высокопроизводительных вычислительных систем SuperCluster, предназначенных для обработки ресурсоёмких приложений ИИ/HPC. Представленные решения оптимизированы для платформы NVIDIA Omniverse, которая позволяет моделировать крупномасштабные виртуальные миры в промышленности и создавать цифровых двойников. Системы SuperCluster for NVIDIA Omniverse могут строиться на базе серверов SYS-421GE-TNRT или SYS-421GE-TNRT3 с поддержкой соответственно восьми и четырёх ускорителей NVIDIA L40S. Обе модели соответствуют типоразмеру 4U и допускают установку двух процессоров Intel Xeon Emerald Rapids или Sapphire Rapids в исполнении Socket E (LGA-4677) с показателем TDP до 350 Вт (до 385 Вт при использовании СЖО). Каждый из узлов в составе новых систем SuperCluster несёт на борту 1 Тбайт оперативной памяти DDR5-4800, два NVMe SSD вместимостью 3,8 Тбайт каждый и загрузочный SSD NVMe M.2 на 1,9 Тбайт. В оснащение включены четыре карты NVIDIA BlueField-3 (B3140H SuperNIC) или NVIDIA ConnectX-7 (400G NIC), а также одна карта NVIDIA BlueField-3 DPU Dual-Port 200G. Установлены четыре блока питания с сертификатом Titanium мощностью 2700 Вт каждый. В максимальной конфигурации система SuperCluster for NVIDIA Omniverse объединяет пять стоек типоразмера 48U. В общей сложности задействованы 32 узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3, что в сумме даёт 256 или 128 ускорителей NVIDIA L40S. Кроме того, в состав такого комплекса входят три узла управления Supermicro SYS-121H-TNR Hyper System, три коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами, ещё два коммутатора NVIDIA Spectrum SN5600 Ethernet 400G с 64 портами для хранения/управления, два коммутатора управления NVIDIA Spectrum SN2201 Ethernet 1G с 48 портами. При необходимости конфигурацию SuperCluster for NVIDIA Omniverse можно оптимизировать под задачи заказчика, изменяя масштаб вплоть до одной стойки. В этом случае применяются четыре узла Supermicro SYS-421GE-TNRT или SYS-421GE-TNRT3.

04.08.2024 [15:25], Сергей Карасёв

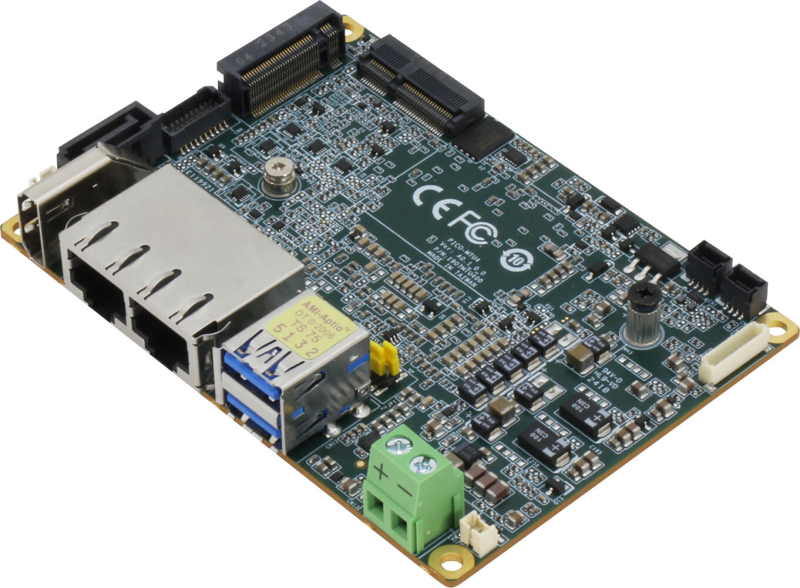

AAEON представила Pico-MTU4 — самый компактный одноплатный компьютер на базе Intel Core UltraКомпания AAEON анонсировала одноплатный компьютер Pico-MTU4. На сегодняшний день, как утверждается, это самое компактное устройство в своём классе, построенное на платформе Intel Core Ultra (Meteor Lake). Новинка подходит для создания индустриальных робототехнических систем, edge-устройств, оборудования с ИИ-функциями и пр. Плата соответствует типоразмеру Pico-ITX: габариты составляют 100 × 72 мм. Доступны модификации с различными процессорами — вплоть до Core Ultra 7 165U с 12 ядрами (2P+10E; 14 потоков; до 4,9 ГГц; 15 Вт). В состав чипа входят графический блок Intel Graphics Xe и нейромодуль Intel AI Boost NPU для ускорения выполнения операций, связанных с ИИ. Поддерживается до 32 Гбайт памяти LPDDR5-6400. Для подключения накопителей доступны порт SATA-3 и коннектор M.2 2280 M-Key (PCIe 4.0 x4 / SATA). В слот M.2 2230 E-Key (PCIe 4.0 x1 / USB 2.0) может быть установлен адаптер Wi-Fi 6. В оснащение включены сетевые контроллеры Intel I226 2.5GbE и Intel I219 1GbE. За безопасность отвечает модуль TPM 2.0. В набор разъёмов входят два порта USB 3.2 Gen2, два гнезда RJ-45 для сетевых кабелей, порт HDMI 1.4 (3840 × 2160 пикселей; 30 Гц). Кроме того, поддерживаются интерфейсы eDP1.4, USB 2.0 (×2), GPIO, COM (два последовательных порта RS232/422/485). Для одноплатного компьютера Pico-MTU4 заявлена совместимость с Windows 10 и Ubuntu 22.04.2. Диапазон рабочих температур простирается от -20 до +70 °C. Питание (12 В) подаётся через коннектор Phoenix. AAEON предлагает для новинки различные аксессуары, включая соединительные кабели и активный кулер. Последний оснащён вентилятором со скоростью вращения крыльчатки 5200 об/мин. Габариты охладителя составляют 100 × 72 × 14 мм.

04.08.2024 [15:25], Сергей Карасёв

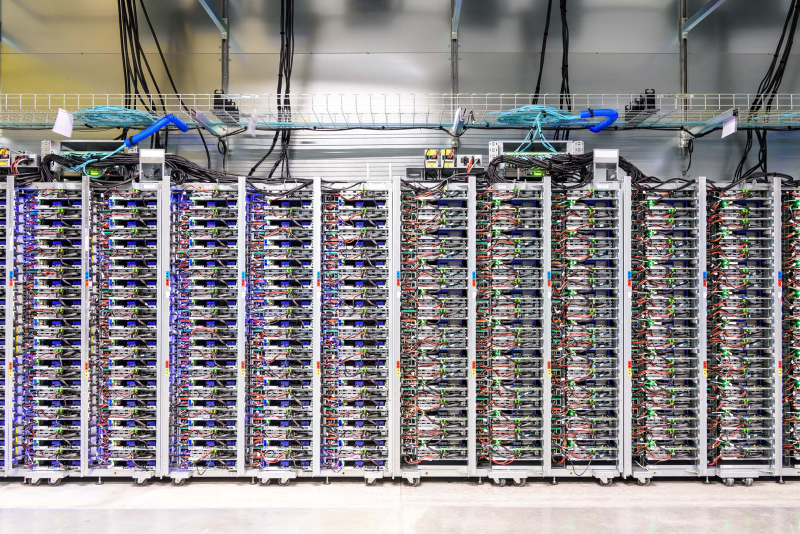

В Google Cloud появился выделенный ИИ-кластер для стартапов Y CombinatorОблачная платформа Google Cloud, по сообщению TechCrunch, развернула выделенный субсидируемый кластер для ИИ-стартапов, которые поддерживаются венчурным фондом Y Combinator. Предполагается, что данная инициатива поможет Google привлечь в своё облако перспективные компании, которым в будущем могут понадобиться значительные вычислительные ресурсы. Отмечается, что для ИИ-стартапов на ранней стадии одной из самых распространённых проблем является ограниченная доступность вычислительных мощностей. Крупные предприятия обладают достаточными финансами для заключения многолетних соглашений с поставщиками облачных услуг на доступ к НРС/ИИ-сервисам. Однако у небольших фирм с этим возникают сложности. Ожидается, что Google Cloud поможет в решении данной проблемы. Google предоставит выделенный кластер с приоритетным доступом для стартапов Y Combinator. Платформа базируется на ускорителях NVIDIA и тензорных процессорах (TPU) самой Google. Каждый участник программы получит кредиты на сумму $350 тыс. для использования облачных сервисов Google в течение двух лет. Кроме того, Google предоставит стартапам кредиты в размере $12 тыс. на расширенную поддержку и бесплатную годовую подписку Google Workspace Business Plus. Молодые компании также смогут консультироваться с экспертами Google в области ИИ. Оказав поддержку ИИ-стартапам, Google в дальнейшем сможет рассчитывать на заключение с ними долгосрочных контрактов на обслуживание. Говорится, что за последние 18 лет примерно 5 % стартапов Y Combinator стали единорогами с оценкой $1 млрд и более. Такие компании могут принести облачной платформе Google значительную выручку в случае заключения соглашения о сотрудничестве. С другой стороны, фонд Y Combinator сможет привлечь больше перспективных ИИ-проектов, предлагая вычислительные ресурсы Google вместе со своей поддержкой. Аналогичные программы есть и у других игроков. Так, венчурный инвестор Andreessen Horowitz (a16z) тоже запасается ИИ-ускорителями, чтобы стать более привлекательным для ИИ-стартапов. AWS предлагает ИИ-стартапам доступ к облаку и сервисам, а Alibaba Cloud готова предоставить ресурсы в обмен на долю в стартапе. Сама Google на днях наняла основателей стартапа Character.AI и лицензировал его модели. Стартапу, по-видимому, не хватило средств на ИИ-ускорители для дальнейшего развития.

03.08.2024 [21:10], Владимир Мироненко

В Великобритании отложили планы по строительству экзафлопсного суперкомпьютера — нет денегНовый состав правительства Великобритании, сформированный в июле, отменил решение предыдущей администрации о выделении £1,3 млрд на финансирование технологических и ИИ-проектов, включая строительство в Центре передовых вычислений Эдинбургского университета (ACF) экзафлопсного суперкомпьютера при поддержке национального центра AI Research Resource (AIRR), который должен был быть запущен в эксплуатацию в 2025 году. Об этом сообщил ресурс DatacenterDynamics (DCD). В прошлом году правительство консерваторов выделило £800 млн на экзафлопсный суперкомпьютер и £500 млн на дополнительное финансирование AIRR. Однако нынешнее лейбористское правительство заявило, что в планах расходов предыдущего правительства не было выделено нового финансирования для этой программы, и поэтому проекты не будут продолжены. В Центре передовых вычислений Эдинбургского университета (ACF) уже есть суперкомпьютер, и после объявления в октябре 2023 года о предстоящем строительстве нового, им был израсходован £31 млн на строительство дополнительного помещения в здании для центра Edinburgh Parallel Computing Centre (EPCC). Что дальше будет с этим проектом пока неясно. Отвечая на просьбу DCD прокомментировать ситуацию, представитель Департамента науки, инноваций и технологий Великобритании (DSIT) заявил, что в правительстве по-прежнему привержены созданию технологической инфраструктуры, но приходится принимать сложные решения для восстановления экономической стабильности и реализации национальной миссии по росту экономики. Следует отметить, что в прошлом месяце правительство Великобритании объявило о планах инвестировать £100 млн в пять новых центров квантовых исследований в Глазго, Эдинбурге, Бирмингеме, Оксфорде и Лондоне.

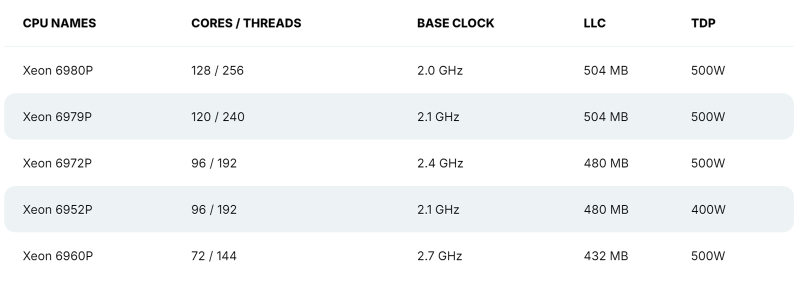

03.08.2024 [12:33], Сергей Карасёв

128 P-ядер, 504 Мбайт кеша и TDP 500 Вт: утекли характеристики Intel Xeon Granite RapidsВ распоряжении сетевых источников, по сообщению ресурса VideoCardz, оказалась информация о характеристиках части процессоров Intel Xeon 6 семейства Granite Rapids, в основу которых лягут производительные ядра P-core. Речь идёт о чипах Xeon 6900P, которые, как ожидается, появятся на рынке в текущем квартале. Формальная презентация Xeon 6 Granite Rapids состоялась в начале июня текущего года — вместе с изделиями Xeon 6 Sierra Forest, построенными на энергоэффективных ядрах E-core. Для платформы Xeon 6 предусмотрено использование разъёмов LGA-4710 и LGA-7529: в первом случае заявлена поддержка чипов с TDP до 350 Вт и 8-канальной памяти, во втором — 500 Вт и 12-канальной памяти. При этом в обоих вариантах возможно построение двухсокетных серверов. Как стало известно, в семейство Xeon 6 Granite Rapids войдут модели с 32, 44, 56, 72, 96, 120 и 128 ядрами Redwood Cove. Они получат поддержку SMT и до 504 Мбайт L3-кеша. Величина TDP составит до 500 Вт. В частности, говорится о подготовке процессоров Xeon Platinum 6980P, 6979P, 6972P, 6952P и 6960P. Их базовая тактовая частота варьируется от 2,0 до 2,7 ГГц (см. характеристики). Для чипов Xeon 6 Granite Rapids заявлена поддержка памяти DDR5-6400 и MCR-8800, до 96 линий PCIe Gen 5.0/CXL 2.0 и до 6 линий UPI 2.0.

03.08.2024 [10:01], Сергей Карасёв

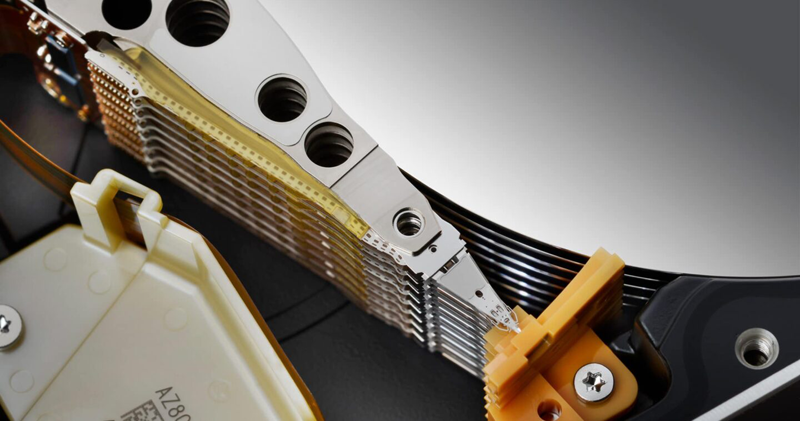

Western Digital начала пробные поставки SMR HDD вместимостью 32 ТбайтКомпания Western Digital сообщила о начале пробных отгрузок nearline-накопителей ёмкостью 32 Тбайт, ориентированных на гиперскейлеров. Устройства, выполненные по технологии черепичной магнитной записи (SMR), на сегодняшний день являются самыми вместительными HDD производства Western Digital. Как отмечает AnandTech, в новинках задействованы наиболее передовые технические решения Western Digital. Это, в частности, технология магнитной записи с энергетической поддержкой (EAMR/ePMR 2), а также система черепичной магнитной записи нового поколения UltraSMR, которая повышает плотность хранения данных на 20 % по сравнению с методикой традиционной магнитной записи (CMR).

Источник изображения: Western Digital Кроме того, в накопителях применены трёхступенчатые приводы для улучшения позиционирования головок и система двухмерной магнитной записи TDMR (Two-Dimensional Magnetic Recording), которая представляет собой методику считывания дорожки при помощи двух головок одновременно. Реализована также технология OptiNAND, использующая встроенную флеш-память iNAND для выполнения основных функций по обслуживанию: благодаря этому повышается надёжность, улучшается производительность и снижается энергопотребление. Упомянуты проприетарные средства коррекции ошибок ECC. «Мы поставляем образцы наших nearline-дисков UltraSMR/ePMR вместимостью 32 Тбайт избранным клиентам», — сказал Дэвид Гекелер (David Goeckeler), исполнительный директор Western Digital. Нужно отметить, что ранее корпорация Toshiba продемонстрировала HDD на базе HAMR (магнитная запись с подогревом), способный хранить 32 Тбайт данных. До этого Seagate смогла выпустить HAMR-накопители объёмом 30 Тбайт с классической геометрией записи благодаря технологии Mozaic 3+, тогда как отметка в 32 Тбайт была достигнута путём использования SMR.

02.08.2024 [22:44], Владимир Мироненко

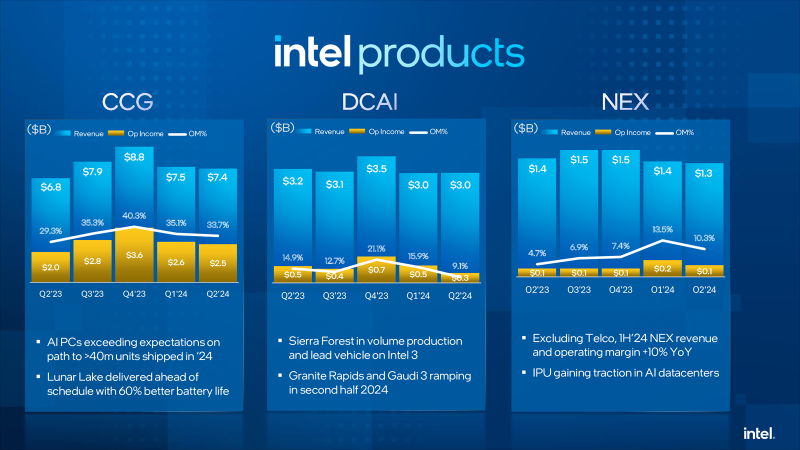

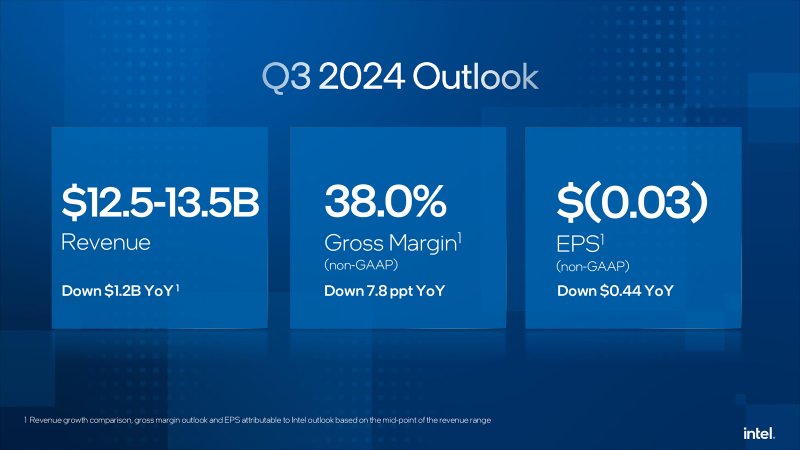

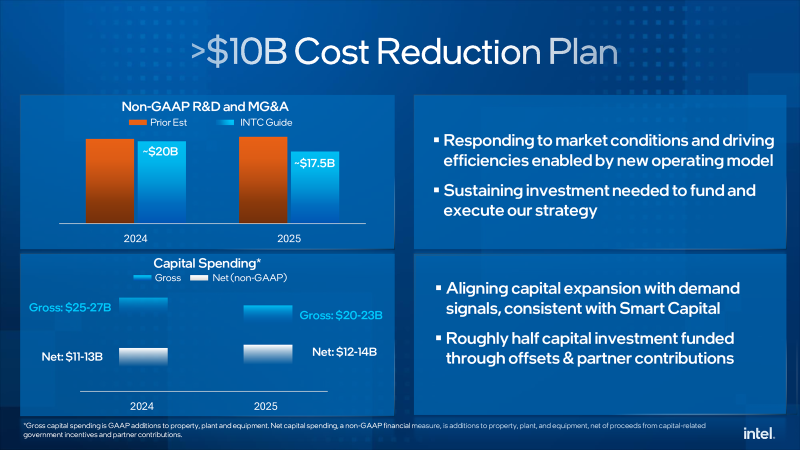

Intel пережила рекордное падение стоимости акций, но надеется со временем отыграться благодаря сегменту ЦОД и ИИКомпания Intel объявила результаты II квартала 2024 года, завершившегося 29 июня. Выручка компании составила $12,83 млрд, что меньше на 1 % год к году, а также ниже консенсус-прогноза аналитиков, опрошенных LSEG, равного $12,94 млрд. Intel завершила квартал с убытками в размере $1,61 млрд или $0,38 на акцию, хотя годом ранее у неё была чистая прибыль в размере $1,48 млрд или $0,35 на акцию. Скорректированная прибыль (Non-GAAP) составила $85 млн или $0,02 на акцию (падение год к году на 85 %), что ниже консенсус-прогноза аналитиков в размере $0,10 на акцию. Рынок отреагировал на результаты Intel, а также слабый прогноз на текущий квартал падением стоимости акций, обрушившейся на 26 % после открытия торгов в Нью-Йорке в пятницу, сократив рыночную стоимость компании примерно на $32 млрд. Это было самое большое дневное падение акций по крайней мере с 1982 года, пишет Bloomberg. Выручка когда-то самого прибыльного подразделения Datacenter and AI Group (DCAI), поставляющего решения для ЦОД и платформ ИИ, снизилась по сравнению с аналогичным кварталом прошлого года на 3 % до $3,05 млрд, оказавшись также ниже консенсунс-прогноза StreetAccount в размере $3,14 млрд. Как отметил ресурс Bloomberg, «это подразделение пока не достигло ничего похожего на присутствие на рынке NVIDIA в чипах-ускорителях, используемых в системах ИИ». Intel объявила, что более 130 млн процессоров Intel Xeon обеспечивают работу ЦОД по всему миру. У подразделения Network and Edge Group (NEX), специализирующегося на сетевых продуктах и периферийных вычислениях, выручка сократилась на 1 % до $1,34 млрд. Выручка подразделения Intel Foundry Service, занимающегося контрактным производством чипов, составила $4,32 млрд (рост год к году — 4 %). Группа Intel Client Computing, которая производит чипы для ПК, принесла $7,41 млрд, превысив прошлогодний результат на 9 % при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $7,42 млрд. В III квартале Intel прогнозирует скорректированный чистый убыток в размере $0,03 на акцию при выручке в ранее объявленном диапазоне $12,5–$13,5 млрд. Согласно прогнозу аналитиков, опрошенных LSEG, у компании показатель скорректированной прибыли составит $0,35 на акцию при выручке $14,35 млрд. По словам финансового директора Intel Дэйва Зинссера (Dave Zinsser), доход DCAI должен последовательно расти во II половине финансового года, «поскольку спрос на традиционные серверы немного улучшается». В текущем квартале компания планирует начать выпуск процессоров Xeon 6 на базе производительных ядер P-core (Granite Rapids). Также готовятся к выпуску в этом квартале ИИ-ускорители Gaudi3. Intel также объявила план сокращения расходов, включающий ряд инициатив по созданию устойчивого финансового драйвера, который ускорит рост прибыли и обеспечит дальнейшую операционную эффективность и гибкость, а также создаст возможности для постоянных стратегических инвестиций в технологии и лидерство в производстве. План предполагает структурную и операционную перестройку компании, сокращение штата, а также снижение операционных расходов и капитальных затрат более чем на $10 млрд в 2025 году. Так, компания намерена оптимизировать свою деятельность и существенно сократит расходы и численность персонала (более чем на 15 %,), сократив траты на НИОКР и маркетинг, общие и административные расходы (MG&A) без учёта GAAP примерно на $20 млрд в 2024 году и примерно на $17,5 млрд в 2025 году, с дальнейшим сокращением в 2026 году. Большую часть увольнений, которые коснутся по подсчётам ресурса The Verge около 19 тыс. сотрудников, компания намерена произвести до конца 2024 года. Также предполагается сократить валовые капитальные затраты в 2024 году более чем на 20 % по сравнению с предыдущими прогнозами, в результате они составят за год от $25 до $27 млрд, а чистые капитальные затраты в 2024 году будут находиться в диапазоне от $11 до $13 млрд. В 2025 году компания планирует валовые капитальные расходы от $20 до $23 млрд и чистые капитальные расходы от $12 до $14 млрд. Также, начиная с IV квартала, компания прекращает выплачивать дивиденды.

02.08.2024 [18:01], Руслан Авдеев

ИИ и ЦОД: капитальные затраты Meta✴ во II квартале выросли до $8,5 млрдВ Meta✴ продолжают активно вкладывать средства в серверы, дата-центры и сетевую инфраструктуру — компания выстраивает экосистему для искусственного интеллекта. По информации Datacenter Dynamics, капитальные затраты во II квартале составили $8,5 млрд, ожидается, что они будут расти и в дальнейшем. Выручка за отчётный период превзошла прогнозы экспертов и составила $39,07 млрд, на 22 % больше в сравнении с аналогичным периодом прошлого года. Чистая прибыль в прошедшем квартале — $13,46 млрд, рост составил 73 %. Прогноз выручки на следующий квартал — $38,5-$41 млрд. Капитальные затраты оказались несколько ниже ($8,5 млрд), чем предполагали отраслевые эксперты ($9,51 млрд), тем не менее рост составил 32,8 % год к году. Компания ожидает и дальнейшего значительного роста капитальных вложений в 2025 году, при этом имеется достаточный запас гибкости. Та же инфраструктура, что построена для обучения генеративного ИИ, будет использована и для инференса. Кроме того, инфраструктуру можно будет модифицировать для других задач, включая ранжирование, рекомендательные системы и др. Как утверждают в Meta✴, несмотря на рост инвестиций, генеративный ИИ не должен стать значимым драйвером выручки в 2024 году. Впрочем, по словам главы компании Марка Цукерберга (Mark Zuckerberg), он скорее рискнёт создать лишнюю ёмкость до того, как она понадобится, чем станет добиваться её строительства с опозданием, с учётом довольно длительной реализации новых внутренних проектов. Ожидается, что для тренировки ИИ-модели Llama 4 понадобится почти в 10 раз больше вычислительных мощностей, чем было необходимо для Llama 3. Для последующих моделей потребуется ещё больше. К концу года компания будет использовать ускорители эквивалентные по вычислительной способности 600 тыс. экземпляров NVIDIA H100. По словам финансового директора Meta✴ Сьюзан Ли (Susan Li), компания применяет стратегию поэтапного строительства ЦОД, позволяющую быстро увеличивать общую ёмкость для удовлетворения спроса. При этом в будущем капитальные затраты снизятся, поскольку не будет необходимости сразу сдавать большие объекты.

02.08.2024 [17:55], Руслан Авдеев

ЦОД на дровах: Google заключила уникальное соглашение о покупке «зелёной» энергии в СингапуреGoogle заключила довольно необычное 10-летнее соглашение о покупке возобновляемой энергии (PPA) для своих дата-центров в Сингапуре. По данным Datacenter Dynamics, это первый в своём роде вариант PPA, который предусматривает получение возобновляемой энергии из деревянных отходов. Подобная «чистая» энергия будет обеспечивать экобезопасные операции Google в Сингапуре и, в конечном счёте, содействовать достижению компанией нулевого углеродного выброса к 2030 году. Google заключила контракт с энергокомпанией PacificLight Energy (PLE), которая будет поставлять возобновляемую энергию от электростанции Rexus Bioenergy (Rexus). Сама Rexus утверждает, что её электростанция класса WWtE («отходы древесины в энергию») мощностью 13,2 МВт будет первой в своём роде в Сингапуре. Для питания будут использоваться не подлежащие традиционное переработке древесные остатки. Это и отходы сельского хозяйства, и отходы логистических компаний вроде грузовых поддонов. Этот мусор будет не только сжигаться, но и использоваться для получения биомассы, которая, вероятно, тоже будет источником энергии. Также установка будет связана с системой захвата углеродных выбросов (CO2). Начало коммерческого использования электростанции запланировано на 2026 год. Google управляет в Сингапуре тремя ЦОД и недавно выделила ещё $5 млрд на развитие инфраструктуры в стране. С 2019 года в Сингапуре действует мораторий на строительство новых дата-центров — не хватает как энергии, так и места для размещения ЦОД. Впрочем, ранее в этом году было решено «разблокировать» ещё 300 МВт. В PacificLight намерены развивать зелёную биоэнергетику и со временем стать «низкоуглеродной» компанией, что соответствует целям города-государства. |

|