Материалы по тегу: h100

|

27.02.2024 [21:44], Сергей Карасёв

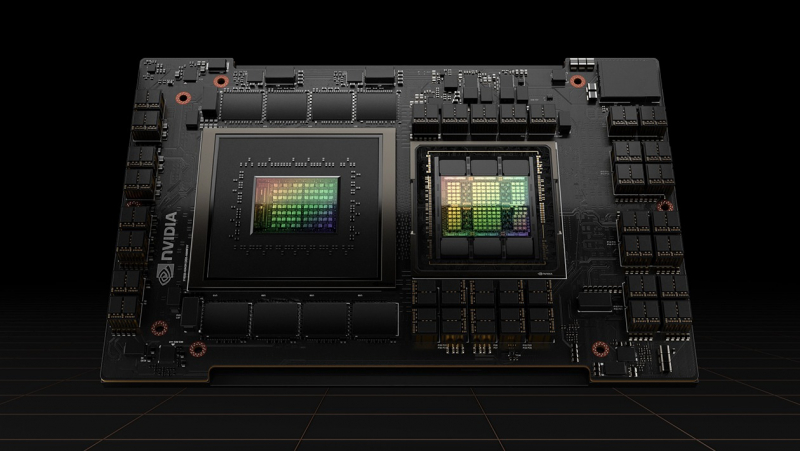

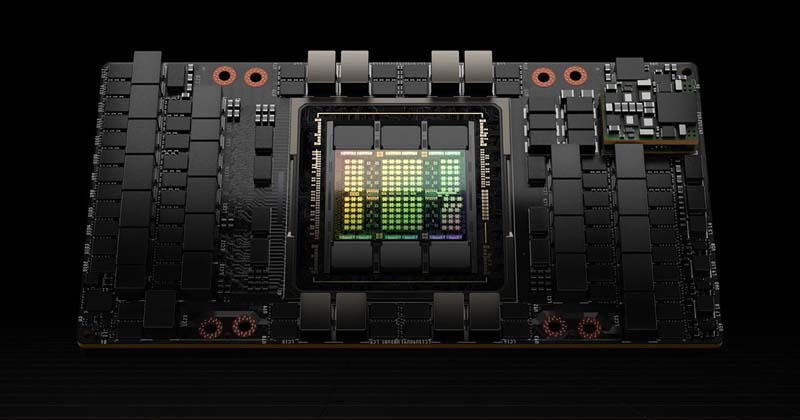

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных.

22.02.2024 [13:34], Сергей Карасёв

HBM мало не бывает: суперкомпьютер OSC Cardinal получил чипы Intel Xeon Max и ускорители NVIDIA H100Суперкомпьютерный центр Огайо (OSC) анонсировал проект Cardinal по созданию нового кластера для задач HPC и ИИ. Гетерогенная система, построенная на серверах Dell PowerEdge с процессорами Intel, будет введена в эксплуатацию во II половине 2024 года. В состав кластера войдут узлы, оборудованные процессорами Xeon Max 9470 семейства Sapphire Rapids. Эти чипы содержат 52 ядра (104 потока) с максимальной тактовой частотой 3,5 ГГц и 128 Гбайт памяти HBM2e. В общей сложности будут задействованы 756 таких процессоров. Каждый узел получит 512 Гбайт DDR5 и NVMe SSD вместимостью 400 Гбайт. Узлы входят в состав серверов Dell PowerEdge C6620. Компанию им составят 16 узлов Dell PowerEdge R660, тоже с двумя Xeon Max 9470, но с 2 Тбайт DDR5 и 12,8 Тбайт NVMe SSD. Все эти узлы объединит 200G-интерконнект Infiniband. Кроме того, будут задействован 32 узла Dell PowerEdge XE9640 с двумя чипами Xeon 8470 Platinum (52C/104T; до 3,8 ГГц), четырьмя ускорителями NVIDIA H100 с 96 Гбайт памяти HBM3 и 1 Тбайт DDR5. Говорится о применении четырёх соединений NVLink и 400G-платформы Quantum-2 InfiniBand. Заявленная пиковая ИИ-производительность (FP8) — около 500 Пфлопс. Суперкомпьютер обеспечит общую FP64-производительность на уровне 10,5 Пфлопс. Таким образом, по быстродействию кластер приблизительно на 40 % превзойдёт три нынешние машины OSC вместе взятые. При этом Cardinal занимает всего девять стоек и требует пару CDU для работы СЖО. Отмечается, что Cardinal — это результат сотрудничества OSC, Dell Technologies, Intel и NVIDIA. Новый суперкомпьютер придёт на смену системе Owens, которая используется в OSC с 2016 года.

20.02.2024 [23:25], Сергей Карасёв

Поменьше и побольше: у NVIDIA оказалось сразу два ИИ-суперкомпьютера EOSНа днях NVIDIA снова официально представила суперкомпьютер EOS для решения ресурсоёмких задач в области ИИ. Издание The Register обратило внимание на нестыковки в публичных заявлениях компании относительно конфигурации и производительности машины. В итоге NVIDIA признала, что у неё есть две архитектурно похожих системы под одним и тем же именем. Впрочем, полной ясности это не внесло. НРС-комплекс EOS изначально был анонсирован почти два года назад — в марте 2022-го. Тогда речь шла о кластере, объединяющем 576 систем NVIDIA DGX H100, каждая из которых содержит восемь ускорителей H100 — в сумме 4608 шт. Суперкомпьютер, согласно заявлениям NVIDIA, обеспечивает ИИ-быстродействие на уровне 18,4 Эфлопс (FP8), тогда как производительность на операциях FP16 составляет 9 Эфлопс, а FP64 — 275 Пфлопс. Вместе с тем в ноябре 2023 года NVIDIA объявила о том, что ИИ-суперкомпьютер EOS поставил ряд рекордов в бенчмарках MLPerf Training. Тогда говорилось, что комплекс содержит 10 752 ускорителя H100, а его FP8-производительность достигает 42,6 Эфлопс. Представители компании сообщили, что суперкомпьютер, использованный для MLPerf Training с 10 752 ускорителями H100, «представляет собой другую родственную систему, построенную на той же архитектуре DGX SuperPOD». Вместе с тем комплекс, занявший 9-е место в TOP500 от ноября 2023 года — это как раз версия EOS с 4608 ускорителями, представленная на днях в рамках официального анонса. Но... цифры всё не сходятся! В TOP500 FP64-производительность EOS составляет 121,4 Пфлопс при пиковом значении 188,7 Пфлопс. Сама NVIDIA, как уже было отмечено выше, называет цифру в 275 Пфлопс. Таким образом, суперкомпьютер, участвующий в рейтинге TOP500, мог содержать от 2816 до 3161 ускорителя H100 из 4608 заявленных. С чем связано такое несоответствие, не совсем ясно. Высказываются предположения, что у NVIDIA могли возникнуть сложности с обеспечением стабильности кластера на момент составления списка TOP500, поэтому система была включена в него в урезанной конфигурации.

07.02.2024 [22:31], Владимир Мироненко

Северный браузерный ИИ: Opera развернёт в исландском дата-центре atNorth кластер NVIDIA DGX SuperPOD для обучения чат-бота AriaНорвежская компания Opera Software, разработчик браузера Opera, объявила о предстоящем запуске в этом месяце ИИ-кластера на базе NVIDIA DGX SuperPOD в дата-центре atNorth в Кеблавике (Исландия). Принадлежащий atNorth ЦОД ICE02 ёмкостью более 80 МВт имеет площадь 13 750 м2 и вмещает около 3000 стоек. С помощью нового кластера Opera будет обучать встроенный в браузер чат-бот Aria на основе ИИ. Как сообщается в пресс-релизе ИИ-кластер спроектирован так, чтобы оказывать минимально возможное воздействие на окружающую среду. Он использует гидроэлектрическую и геотермальную энергию для получения энергии, и пользуется преимуществами прохладного климата Исландии для охлаждения оборудования. Кластер на базе NVIDIA DGX SuperPOD оснащён ускорителями NVIDIA H100 и программной платформой NVIDIA AI Enterprise. «Aria быстро развивается, и мы продолжаем расширять его возможности в качестве помощника в навигации для наших пользователей», — сообщил Кристиан Зубель (Krystian Zubel), вице-президент ИТ-группы компании Opera. Как отметил представитель NVIDIA Карло Руис (Carlo Ruiz), компаниям, модернизирующим свой бизнес с помощью ИИ, требуется мощная инфраструктура для разработки больших языковых моделей (LLM) и создания приложений генеративного ИИ. «NVIDIA DGX SuperPOD с ускорителями NVIDIA H100 предоставляет Opera расширенные возможности супервычислений на базе ИИ, помогая разработчикам создавать новые функции, которые сделают опыт генеративного ИИ доступным для пользователей», — заявил он.

02.02.2024 [13:29], Сергей Карасёв

Lenovo построит в Германии энергоэффективный суперкомпьютер на базе AMD EPYC Genoa и NVIDIA H100

amd

epyc

genoa

h100

hardware

hpc

lenovo

nvidia

германия

отопление

суперкомпьютер

энергоэффективность

Компания Lenovo объявила о заключении контракта с Падерборнским университетом в Германии (University of Paderborn) на создание нового НРС-комплекса, мощности которого будут использоваться для обеспечения исследований в рамках Национальной программы высокопроизводительных вычислений (NHR). В основу суперкомпьютера лягут двухузловые серверы ThinkSystem SD665 V3. Конфигурация каждого узла включает два процессора AMD EPYC Genoa и до 24 модулей оперативной памяти DDR5-4800. Применена технология прямого жидкостного охлаждения Lenovo Neptune Direct Water Cooling (DWC). Кроме того, НРС-комплекс будет использовать GPU-серверы ThinkSystem SD665-N V3, несущие на борту четыре ускорителя NVIDIA H100, связанные между собой посредством NVLink. Общее количество ядер составит более 136 тыс. Для подсистемы хранения выбрана платформа IBM ESS 3500, обеспечивающая возможности гибкого использования SSD (NVMe) и HDD. Новый суперкомпьютер расположится в Падерборнском центре параллельных вычислений (PC2). Монтаж оборудования планируется произвести во II половине текущего года. За интеграцию будет отвечать pro-com DATENSYSTEME GmbH. Ожидается, что по сравнению с нынешней системой центра Noctua 2 (на изображении), построенной Atos, готовящийся суперкомпьютер будет обладать примерно вдвое более высокой производительностью. Быстродействие Noctua 2 составляет до 4,19 Пфлопс (Linpack) для CPU-ядер и до 1,7 Пфлопс (Linpack) для GPU-блоков.

Источник изображения: University of Paderborn Особое внимание при строительстве суперкомпьютера будет уделяться энергетической эффективности. Благодаря использованию источников питания с жидкостным охлаждением и полностью изолированных стоек более 97 % вырабатываемого тепла может быть передано непосредственно в систему циркуляции тёплой воды. Применение теплообменников и блоков распределения охлаждающей жидкости (CDU) обеспечивает температуру носителя в обратном контуре выше 45 °C, что позволяет повторно использовать генерируемое тепло.

19.01.2024 [19:16], Руслан Авдеев

В DigitalOcean Paperspace появились ускорители NVIDIA H100Облачный провайдер DigitalOcean Holdings Inc. заявил о доступности ускорителей NVIDIA H100 на платформе Paperspace, купленной в июле 2023 года. Решение ориентировано на представителей малого и среднего бизнеса. Ускорители доступны по запросу, но можно и зарезервировать их на заданный период. В компании подчёркивают, что доступ к NVIDIA H100 предоставляется малому и среднему бизнесу и стартапам в то время, как многие другие облачные провайдеры предпочитают обслуживать крупных клиентов — это снижает порог вхождения мелких игроков на рынок высокопроизводительных вычислений. Ожидается, что новые решения обеспечат работу стартапов следующего поколения, дав доступ к инструментам, необходимым для создания передовых ИИ-продуктов. Paperspace предлагает готовую среду для разработки, обучения и развёртывания ИИ. Доступно два варианта инстансов: с одним H100, 20 vCPU и 250 Гбайт RAM или с восемью H100 (NVLink 3,2 Тбайт/с), 128 vCPU и 1536 Гбайт RAM. Зарезервировать можно оба варианта, а вот по запросу доступен только первый. В обоих случаях используется хранилище на базе SSD с поддержкой снимков, а инстансы работают под управлением Ubuntu. Инстанс с одним ускоритель пока что предлагается по промо-цене $6/час (посекундная тарификация), но со временем цена вырастет до $8,96/час. Стоимость зарезервированных инстансов начинается от $2,24/час за каждый ускоритель при бронировании на три года.

19.01.2024 [01:35], Владимир Мироненко

У Meta✴ будет уже 350 тыс. ускорителей NVIDIA H100 к концу 2024 годаК концу 2024 года компания Meta✴ планирует иметь в распоряжении 350 тыс. ускорителей NVIDIA H100. А общая произвдительность всех ИИ-чипов компании будет эквивалента 600 тыс. H100. Об этом сообщил основатель Meta✴ Марк Цукерберг в своём Instagram✴. Meta✴ заинтересовалась ускорителями AMD Instinct MI300, а также разработала собственный ИИ-чип MTIA. В интервью ресурсу The Verge глава Meta✴ уточнил , что для создания продуктов, которые компания хотела бы иметь в своём портфолио, необходимо разработать сильный искусственный интеллект (AGI). В настоящее время компания занимается проектом по развёртыванию метавселенной, который приносит ей пока только миллиардные убытки. но Meta✴ верит, что за сочетанием ИИ и метавсленными будущее.

Источник изображения: NVIDIA В рамках реализации планов по совершенствованию технологий ИИ компания пересмотрела находящиеся на стадии разработки проекты, отменив часть из них, что привело к падению капитальных затрат по сравнению с предыдущим годом. В IV квартале компания потратила $6,8 млрд, что на $3 млрд меньше год к году. При этом компания увеличивает вложения в ИИ и разработала новую архитектуру ЦОД, которая позволит повысить эффективность использования ИИ-кластеров. Всего в 2023 году капвложения Meta✴, по оценкам, составят $27–29 млрд. В 2024 году компания планирует потратить на эти цели $30–35 млрд, причём рост будет обусловлен инвестициями в серверы (включая оборудование, не связанное с ИИ), а также в дата-центры на базе обновлённой архитектуры.

06.12.2023 [13:19], Сергей Карасёв

Yotta анонсировала Shakti Cloud — самую мощную в Индии ИИ-платформу на базе NVIDIA H100Компания Yotta Data Services объявила о заключении соглашения о сотрудничестве, в рамках которого планируется развёртывание облачной инфраструктуры Shakti Cloud — самой высокопроизводительной в Индии платформы для задач ИИ на основе GPU. По условиям договора, Yotta закупит крупную партию ускорителей NVIDIA H100. К январю 2024 года планируется ввести в эксплуатацию 4096 ускорителей. Ещё 16 384 ускорителя войдут в состав Shakti Cloud к июню наступающего года. А к концу 2025-го инфраструктура Yotta будет насчитывать 32 768 ускорителей. Yotta развернёт первый кластер из 16 384 ускорителей на площадке NM1 — это крупнейший в Азии дата-центр класса Tier IV, расположенный в Нави-Мумбаи на западном побережье индийского штата Махараштра. Затем Yotta создаст кластер аналогичного масштаба в D1 — своём новейшем ЦОД гиперскейл-уровня в Грейтер-Нойде недалеко от Дели. Проектная мощность Shakti Cloud составит 16 Эфлопс на операциях ИИ. На базе облака Yotta Shakti Cloud клиентам будут предоставляться различные услуги PaaS. Заказчики смогут обучать большие языковые модели (LLM), запускать ресурсоёмкие ИИ-задачи и другие рабочие нагрузки. Ожидается, что платформа поможет удовлетворить растущий спрос на услуги НРС со стороны исследовательских лабораторий, корпоративных пользователей и стартапов. Кроме того, Yotta намерена использовать решения NVIDIA InfiniBand для формирования GPU-кластеров, предназначенных для поддержания масштабных проектов, связанных с инференсом, обучением крупных ИИ-моделей и пр. В целом, партнёрство с NVIDIA поможет Индии укрепить позиции на стремительно растущем мировом рынке ИИ.

30.11.2023 [13:52], Сергей Карасёв

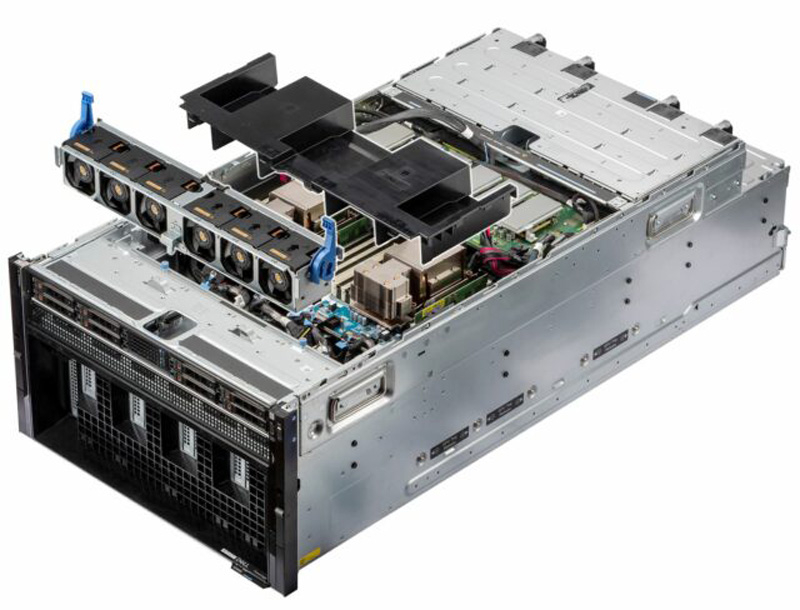

Dell построит ИИ-кластер из 10 тыс. NVIDIA H100 для компании ImbueНезависимая исследовательская ИИ-компания Imbue и Dell Technologies объявили о заключении соглашения по созданию нового высокопроизводительного вычислительного кластера на основе серверов PowerEdge для обучения базовых моделей. Проект оценивается в $150 млн. Imbue разрабатывает собственные базовые ИИ-модели, оптимизированные специально для рассуждений: они способны при необходимости запрашивать дополнительную информацию, анализировать и критиковать свои собственные результаты, а также разбивать сложную задачу на несколько более простых для повышения эффективности выполнения.

Источник изображения: Dell Imbue уже использует кластер на базе серверов Dell PowerEdge XE9680 с ускорителями NVIDIA H100. Новый проект предполагает развёртывание платформы, насчитывающей почти 10 тыс. чипов H100. Отмечается, что Imbue и Dell разработали систему, включающую в себя сравнительно небольшие кластеры, которые позволяют проводить эксперименты с ИИ-моделями на новых архитектурах. Такие узлы могут быть объединены в крупный кластер для эффективного обучения крупномасштабных базовых моделей. Основная цель Imbue заключается в создании специализированных ИИ-агентов, не требующих постоянного контроля со стороны пользователей. Они смогут выполнять самые разные задачи, включая написание программного кода, анализ сложных данных и пр. Ранее в текущем году Imbue привлекла на развитие $200 млн. Деньги поступили в том числе от NVIDIA.

28.11.2023 [18:11], Руслан Авдеев

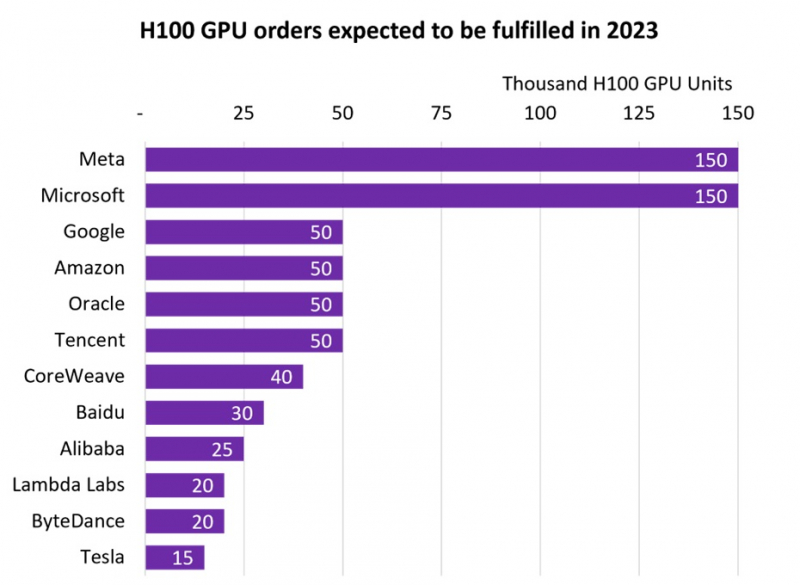

NVIDIA продала более 500 тыс. ИИ-ускорителей H100, но менее дефицитными они не сталиВ III квартале 2024 фискального года, завершившегося в октябре 2023-го, компания NVIDIA заработала впечатляющие $14,5 млрд на решениях для дата-центров. Как сообщает Tom’s Hardware, значительная часть выручки приходится на передовые ускорители H100 для ИИ и HPC-систем. Данные опубликовала компания Omdia, отслеживающая активность на рынке IT-решений. Согласно её анализу, крупнейшими покупателями ускорителей H100 стали гиперскейлеры вроде Meta✴ и Microsoft, значительно обогнавших по объёмам закупок Google, Amazon, Oracle и Tencent. Если Microsoft и Meta✴ приобрели по 150 тыс. ускорителей, то их «коллеги» по IT-рынку — по 50 тыс. При этом гиперскейлерам отдаётся очевидный приоритет при выполнении заказов. В Omdia пришли к выводу, что до конца года будет поставлено почти 650 тыс. H100. В то же время срок выполнения новых заказов на серверы на базе ускорителей компании вырос с 36 до 52 недель. Так, Dell, HPE и Lenovo не могут полностью удовлетворить свои потребности в ускорителях для своих серверов в кратчайшие сроки. В итоге год к году поставки серверов в количественном выражении рухнут на 17–20 %, однако общая выручка поднимется на 6–8 %.

Источник изображения: Omdia В 2027 году рынок серверов должен вырасти до $195,6 млрд, причём основное предпочтение будет отдаваться специализированным вариантам под конкретные задачи, оснащённым специальными сопроцессорами. Запрос на серверы с кастомными конфигурациями становится новой нормой по мере того, как заказчики осознали экономическую эффективность применения сопроцессоров и ускорителей. Пионерами в этой сфере стали компании, связанные с ИИ и медиаконтентом, но привлекательность таких решений, как ожидается, в ближайшем будущем будет оценена и в других секторах. |

|