Материалы по тегу: ff

|

09.05.2025 [12:17], Сергей Карасёв

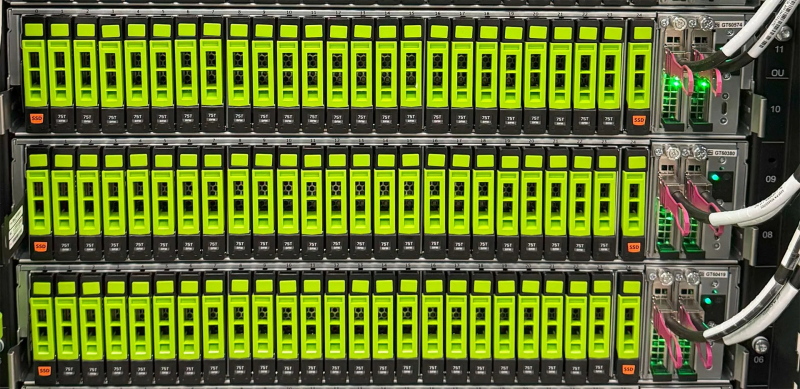

ADATA создала бренд Trusta для SSD корпоративного классаКомпания ADATA Technology анонсировала бренд Trusta, под которым будут выпускаться накопители корпоративного класса — в том числе для ИИ-серверов и дата-центров. При разработке изделий Trusta основное внимание планируется уделять производительности, надёжности и энергетической эффективности. Первыми продуктами под новым брендом стали SSD-семейства T7 и T5. Эти решения предназначены для широкого спектра приложений корпоративного уровня, включая обучение ИИ-моделей и инференс, векторные базы данных, HPC-задачи, платформы виртуализации и пр. В частности, дебютировали накопители Trusta T7P5 с интерфейсом PCIe 5.0, которые будут предлагаться в форм-факторах U.2, E1.S (9,5 мм / 15 мм / 25 мм) и E3.S. Вместимость варьируется от 1,92 до 15,36 Тбайт. Заявленная скорость чтения информации достигает 13 500 Мбайт/с, скорость записи — 10 400 Мбайт/с. В устройствах реализована технология Flexible Data Placement (FDP). В серию Trusta T7 также вошли накопители T7P4 с интерфейсом PCIe 4.0 ёмкостью до 7,68 Тбайт. У этих SSD скорости чтения/записи составляют до 7400/5050 Мбайт/с. Устройства подходят для ИИ-приложений и облачных вычислений среднего уровня. Кроме того, разрабатываются модели Trusta T7 большой вместимости на основе чипов флеш-памяти QLC и изделия с интерфейсом PCIe 6.0 для удовлетворения растущих потребностей крупномасштабных ЦОД. Семейство Trusta T5, в свою очередь, представлено накопителями T5P4B, T5S3B и T5S3, оснащёнными интерфейсами PCIe 4.0 и SATA-3. В этих изделиях также предусмотрена система Power Loss Protection (PLP). Устройства могут использоваться в качестве загрузочных SSD в серверах и корпоративном оборудовании.

06.05.2025 [21:12], Руслан Авдеев

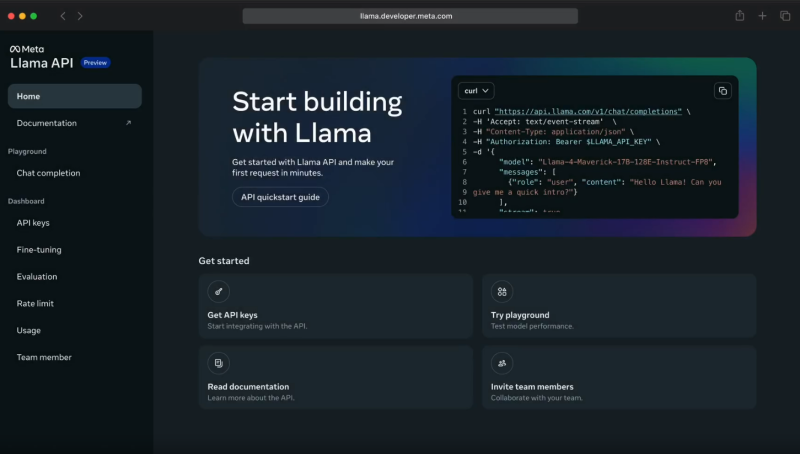

Meta✴ Llama API задействует ИИ-ускорители Cerebras и GroqMeta✴ объединила усилия с Cerebras и Groq для инференс-сервиса с применением API Llama. Открыв API-доступ к собственным моделям, Meta✴ становится чуть более похожа на облачных провайдеров. Как утверждают в Cerebras, разработчики, применяющие API для работы с моделями Llama 4 Cerebras, могут получить скорость инференса до 18 раз выше, чем у традиционных решений на базе GPU. В компании объявили, что такое ускорение позволит использовать новейшее поколение приложений, которые невозможно построить на других ИИ-технологиях. Речь, например, идёт о «голосовых» решениях с низкой задержкой, интерактивной генерации кода, мгновенном многоэтапном рассуждении и т. п. — многие задачи можно решать за секунды, а не минуты. После запуска инференс-платформы в 2024 году Cerebras обеспечила для Llama самый быстрый инференс, обрабатывая миллиарды токенов через собственную ИИ-инфраструктуру. Теперь прямой доступ к альтернативам решений OpenAI получит широкое сообщество разработчиков. По словам компании, партнёрство Cerebras и Meta✴ позволит создавать ИИ-системы, «принципиально недосягаемые для ведущих облаков». Согласно замерам Artificial Analysis, Cerebras действительно предлагает самые быстрые решения для ИИ-инференса, более 2600 токенов/с для Llama 4 Scout.

Источник изображения: Meta✴ При этом Cerebras не единственный партнёр Meta✴. Она также договорилась с Groq об использовании ускорителей Language Processing Units (LPU), которые обеспечивают высокую скорость (до 625 токенов/с), низкую задержку и хорошую масштабируемость при довольно низких издержках. Groq использует собственную вертикально интегрированную архитектуру, полностью контролируя и железо, и софт. Это позволяет добиться эффективности, недоступной в облаках на базе универсальных ИИ-чипов. Партнёрство с Meta✴ усиливает позиции Groq и Cerebras в борьбе с NVIDIA. Для Meta✴ новое сотрудничество — очередной шаг в деле выпуска готовых open source ИИ-моделей, которые позволят сосредоточиться на исследованиях и разработке, фактически передав инференс надёжному партнёру. Разработчики могут легко перейти на новый стек без необходимости дообучения моделей или перенастройки ускорителей — API Llama совместимы с API OpenAI. Пока что доступ к новым API ограничен. Цены Meta✴ также не сообщает. Meta✴ активно работает над продвижением своих ИИ-моделей. Так, она даже выступила с довольно необычной инициативой, предложив «коллегам-конкурентам» в лице Microsoft и Amazon, а также другим компаниям, поделиться ресурсами для развития и обучения моделей Llama.

03.05.2025 [16:30], Владимир Мироненко

Новые пошлины США обойдутся Meta✴ в несколько миллиардов долларов — снижать темпы развития ИИ ЦОД компания не намеренаMeta✴ Platforms сообщила финансовые результаты I квартала 2025 года, завершившегося 31 марта. Основные показатели компании превысили прогнозы аналитиков, а прогноз на II квартал оказался в пределах ожиданий Уолл-стрит, благодаря чему акции компании выросли в цене на расширенных торгах на 5 %, пишет CNBC. Выручка Meta✴ увеличилась год к году на 16 % до $42,31 млрд, что также выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $41,40 млрд. Чистая прибыль подскочила на 35 % до $16,64 млрд по сравнению с $12,37 млрд годом ранее. Прибыль на разводнённую акцию увеличилась на 37 % до $6,43 с $4,37 в прошлом году, также превысив консенсус-прогноз аналитиков LSEG, равный $5,28 на разводнённую акцию. Капитальные затраты составили $13,69 млрд. Meta✴ ожидает, что выручка во II квартале составит от $42,5 до $45,5 млрд. Это соответствует среднему прогнозу аналитиков в $44,03 млрд. Также компания сообщила о планируемом сокращении общих расходов в 2025 году с прежних целевых показателей $114 – $119 млрд до $113 – $118 млрд.

Источник изображений: Meta✴ Вместе с тем Meta✴ объявила о решении увеличить свои капитальные расходы на 2025 год до $64–$72 млрд, что выше предыдущего прогноза в $60–$65 млрд. «Этот обновленный прогноз отражает дополнительные инвестиции в ЦОД для поддержки наших усилий в области ИИ, а также увеличение ожидаемой стоимости инфраструктурного оборудования», — заявила финансовый директор Сьюзан Ли (Susan Li). «Большая часть наших капитальных затрат в 2025 году по-прежнему будет направлена на наш основной бизнес», — добавила она. Отвечая на вопрос о том, являются ли более высокие капитальные затраты Meta✴ на инфраструктуру ЦОД результатом введения новых торговых пошлин администрацией США, Сьюзан Ли сообщила: «Более высокие расходы, которые мы ожидаем понести на инфраструктурное оборудование в этом году, на самом деле исходят от поставщиков, которые закупают продукцию из стран по всему миру. И вокруг этого просто много неопределенности, учитывая продолжающиеся торговые дискуссии». Как отметил The Register, дело не только в пошлинах. Заявление Ли также свидетельствует о том, что компания не просто платит больше за компоненты для ИИ ЦОД, но и развёртывает больше таких объектов. Ли сообщила, что пересмотренный прогноз капитальных вложений также отражает стремление компании увеличить мощности своих ИИ ЦОД. Ожидается, что дата-центры следующего поколения будут поддерживать как внутреннее обучение базовых моделей, так и инференс в экосистеме Meta✴, включая умные очки, помощников на базе LLM и функции «Семейного доступа». Она добавила, что Meta✴ работает над повышением эффективности рабочих нагрузок своих ЦОД. «Многие инновации, полученные в результате нашей работы по ранжированию, направлены на повышение эффективности наших систем, — сказала Ли. — Этот акцент на эффективность помогает нам стабильно получать высокую отдачу от наших основных инициатив в области ИИ». Ранее Meta✴ объявила о намерении ввести в эксплуатацию около 1 ГВт вычислительных мощностей в 2025 году и иметь к концу года более 1,3 млн ускорителей для обучения и обслуживания ИИ-моделей.

30.04.2025 [11:55], Сергей Карасёв

Innodisk выпустила 128-Тбайт E3.L SSD с интерфейсом PCIe 5.0Компания Innodisk анонсировала SSD с интерфейсом PCIe 5.0 х4 для дата-центров и систем корпоративного класса. Устройства, разработанные в соответствии со спецификацией OCP Data Center NVMe SSD v2.0, подходят для задач с интенсивной обработкой данных, таких как обучение ИИ-моделей и аналитика. В семейство вошли накопители в различных форм-факторах: U.2 5TS-P, E1.S 5TS-P, E3.S 5TS-P и E3.L 5QS-P. Все устройства оснащены технологией PLP (iCell), которая гарантирует защиту критически важных данных и отсутствие потерь информации при сбоях питания. Реализована поддержка AES и TCG Opal 2.0. Изделия U.2 5TS-P, E1.S 5TS-P и E3.S 5TS-P выполнены на основе чипов флеш-памяти 3D eTLC. Вместимость варьируется от 1,92 до 7,68 Тбайт. Заявленная скорость последовательного чтения информации достигает 14 Гбайт/с, скорость последовательной записи — 10 Гбайт/с. Гарантированный объём записанной информации (показатель TBW) составляет до 14 тыс. Тбайт. Максимальное энергопотребление — 25 Вт. В свою очередь, SSD серии E3.L 5QS-P выполнены на флеш-чипах QLC. Скоростные показатели не раскрываются, а энергопотребление не превышает 40 Вт. Эти изделия обладают ёмкостью до 128 Тбайт. Все накопители могут эксплуатироваться при температурах от 0 до +70 °C. Показатель MTBF (средняя наработка на отказ) заявлен на уровне 2 млн часов. Производитель предоставляет на устройства пятилетнюю гарантию. Новинки поддерживают функцию Secure Boot, которая проверяет подлинность цифровых подписей при обновлении прошивки, предотвращая несанкционированные изменения и обеспечивая использование только проверенного встроенного ПО. Говорится о бесшовной интеграции с платформами VMware. Продажи накопителей начнутся в текущем квартале.

24.04.2025 [16:38], Руслан Авдеев

Meta✴ предложила Amazon и Microsoft «скинуться» на обучение ИИ-моделей LlamaMeta✴ уже вложила миллионы долларов в создание и развитие открытых ИИ-моделей семейства Llama, но обучение крупных LLM требует всё больше средств. Поэтому, как сообщает The Information, Meta✴ попросила помощи у своих «коллег», Microsoft и Amazon, что довольно странно, поскольку Meta✴ сама располагает огромными вычислительными ресурсами. Четыре источника сообщили, что Meta✴ предложила этим компаниям некие «стимулы» вроде возможности влиять на развитие будущих ИИ-моделей Llama. В чём выгода Microsoft и Amazon в этом случае, не совсем понятно, поскольку они сами работают над ИИ-проектами, причём в основном коммерческими, тогда как Meta✴ зарабатывает преимущественно на рекламе. Кроме того, Llama относится к open source проектам, так что спонсировать создание сильного конкурента на рынке не слишком выгодно. По данным минимум двух источников, помимо «наиболее серьёзных» дискуссий с Amazon и Microsoft, переговоры также велись с Databricks, IBM, Oracle и представителями как минимум одного ближневосточного инвестора. Meta✴ также обсуждала с компаниями создание группы Llama Consortium в начале 2025 года. В ходе дискуссий, по слухам, она в первую очередь просила денег, а также серверы или другие ресурсы, которые компенсировали бы стоимость обучения моделей. Дополнительно обсуждались иные формы поддержки потенциальных партнёров. Например, высокопоставленные представители Meta✴ могли бы поучаствовать в конференциях партнёров или более подробно рассказать о процессе обучения моделей. Окончательные результаты переговоров не опубликованы, но в обозримом будущем, вероятно, можно будет отследить, в каких мероприятиях конкурентов будут активно участвовать представители Meta✴. В ноябре 2024 года сообщалось, что для обучения новейшей на тот момент модели Llama-4 использовалось более 100 тыс. ускорителей NVIDIA H100. А в марте NVIDIA анонсировала ИИ-модели Llama Nemotron с регулируемым «уровнем интеллекта» на базе решений Meta✴.

09.04.2025 [08:26], Владимир Мироненко

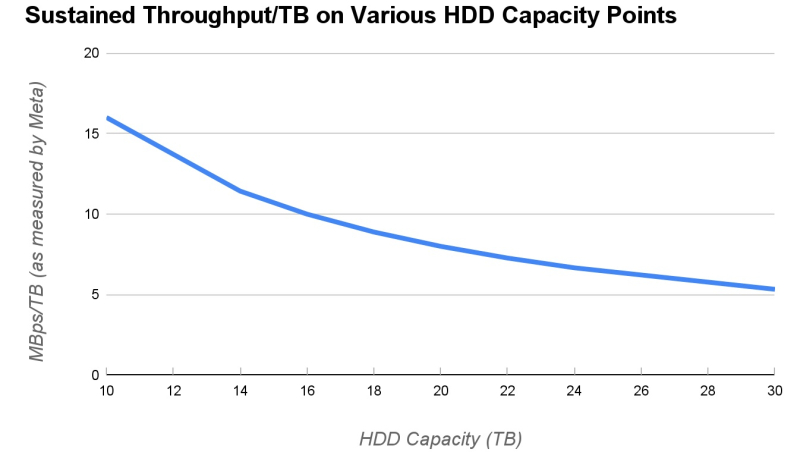

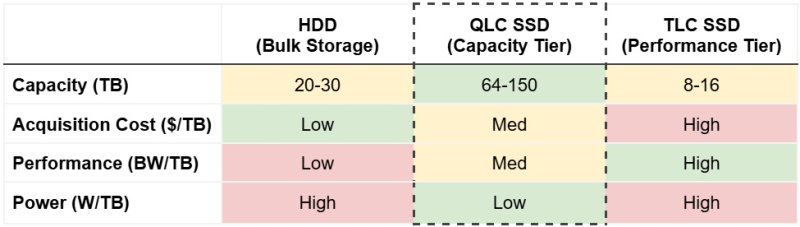

QLC SSD начали вытеснять HDD из дата-центров Meta✴ — они более ёмкие и эффективныеВ ходе последнего квартального отчёта Pure Storage с гордостью сообщила о заключении сделки с неназванным гиперскейлером, что позволило внедрить её решения DirectFlash в крупномасштабные среды, где традиционно доминируют жёсткие диски. Как и предполагалось, речь шла о сделке с Meta✴, которой Pure поставит фирменные флеш-накопители, пишет ресурс Blocks & Files. Подразумевается, что закупки HDD гиперскейлером существенно снизятся в результате этой сделки. Сама Pure Storage надеется, что после 2028 года SSD полностью вытеснят HDD из ЦОД. Blocks & Files также отмечает, что финансовые аналитики Wedbush рассматривают сделку как «чрезвычайно позитивный результат для Pure Storage, учитывая существенное количество Эбайт, который она, вероятно, поставит» По словам Pure, её технология «станет стандартом де-факто для хранения данных Meta✴, за исключением некоторых очень требовательных нагрузок». Blocks & Files полагает, что Meta✴ работает с Pure Storage над накопителями, контроллерами и управляющим ПО (Purity), так что поставщикам готовых массивов All-Flash, по-видимому, не удастся заключить крупные контракты с Meta✴. Pure Storage утверждает, что её проприетарные QLC-накопители DFM (Direct Flash Module) ёмкостью 150 Тбайт (а вскоре и 300 Тбайт) позволят значительно сэкономить место в стойке и снизить затраты на питание и охлаждение по сравнению с хранением стольких же Эбайт данных на жёстких дисках ёмкостью 30–50 Тбайт. В блоге Pure Storage говорится, что «DFM радикально снижают энергопотребление по сравнению с устаревшими решениями на базе HDD, позволяя гиперскейлерам консолидировать несколько уровней хранения на единой платформе».

Источник изображений: Meta✴ Кроме того, «Pure Storage предоставляет гиперскейлерам и предприятиям единую оптимизированную архитектуру, которая поддерживает все уровни хранения, от экономичных архивных решений до высокопроизводительных критически важных рабочих нагрузок и самых требовательных рабочих ИИ-нагрузок, поскольку технология DirectFlash обеспечивает «оптимальный баланс цены, производительности и плотности». В блоге Meta✴ отмечается, что «HDD растут по плотности, но не производительности, а флеш-память TLC остаётся в ценовом диапазоне, который ограничивает масштабирование. Технология QLC решает эти проблемы, занимая промежуточный уровень между HDD и TLC SSD. QLC обеспечивает более высокую плотность, улучшенную энергоэффективность и лучшую стоимость, чем существующие TLC SSD». Также отмечается, что целевые рабочие нагрузки требуют высокой пропускной способности при чтении при сравнительно низких требованиях к пропускной способности при записи. «Поскольку основная часть энергопотребления в любом флеш-носителе NAND приходится на запись, мы ожидаем, что наши рабочие нагрузки будут потреблять меньше энергии с QLC SSD», — сообщили в Meta✴, добавив, что компания сотрудничает с Pure Storage, используя её накопители DFM и платформу DirectFlash для формирования надёжного хранилища на базе QLC. Компания сообщила, что также работает с другими поставщиками NAND для интеграции стандартных NVMe QLC SSD в свои ЦОД. Meta✴ предпочитает форм-фактор U.2 вместо EDSFF E.3, поскольку «он позволяет потенциально масштабировать ёмкость до 512 Тбайт… DFM от Pure Storage можно масштабировать до 600 Тбайт с той же технологией упаковки NAND». Сервер с поддержкой DFM позволяет также использовать накопители в формате U.2. «Эта стратегия позволяет нам извлечь максимальную выгоду из конкуренции по стоимости, скорости внедрения, энергоэффективности и разнообразия поставщиков», — сообщила Meta✴. Таким образом, Meta✴ признаёт потенциал флеш-памяти QLC в области оптимизации стоимости хранения, производительности и энергопотребления для рабочих нагрузок ЦОД. Поскольку поставщики флеш-памяти продолжают инвестировать в развитие памяти и увеличивают объёмы производства QLC, следует ждать существенного снижения затрат на её использование. Это не сулит ничего хорошего для производителей HDD, которые надеются, что технология HAMR позволит сохранить существующую разницу в цене между HDD и SSD. «Мы хотели бы отметить, что хотя Pure Storage, вероятно, вытеснит часть жёстких дисков, мы также считаем, что требования Meta✴ к HDD должны вырасти в 2025–2026 гг.», — сообщили аналитики Wedbush. Другими словами, из-за флеш-памяти Meta✴ пока не стала отказываться от жёстких дисков, но ограничила темпы роста использования HDD. «Любой значимый переход с HDD на SSD в облачных средах, по-видимому, должен привести к более высокому долгосрочному среднегодовому темпу роста флеш-памяти, что в конечном итоге должно положительно сказаться на поставщиках памяти (Kioxia, Micron, Sandisk и т. д.)», — подытожили в Wedbush.

08.04.2025 [14:11], Руслан Авдеев

Meta✴ планирует потратить почти $1 млрд на ЦОД в ВисконсинеMeta✴ Platforms намерена потратить около $1 млрд на строительство кампуса ЦОД в Висконсине (США). Это лишь часть проекта IT-гиганта по наращиванию инвестиций в ИИ и облачную инфраструктуру, сообщает Bloomberg. По информации издания, в феврале штат заключил «стимулирующую» сделку с неназванной компанией, предусматривающей строительство кампуса ЦОД с многолетними инвестициями общим объёмом $837 млн. По данным источников, за проектом стоит именно Meta✴. В самом IT-гиганте информацию комментировать отказались, а представитель Wisconsin Economic Development Corporation заявил, что традиционно принято публично называть компании, с которыми заключен договор только после того, как получено официальное одобрение сделки. В последние годы ключевые IT-компании стремятся увеличить ёмкость доступных дата-центров для удовлетворения запроса на облачные вычислительные мощности, также учитывая рост сложности ИИ-моделей. Meta✴ заявила, что всего в текущем году намерена потратить до $65 млрд на инфраструктуру, основной фокус — на ИИ ЦОД, в том числе крупный кампус в Луизиане. У IT-гигант уже есть дата-центры на Среднем Западе, в том числе в Айове и в Иллинойсе.

Источник изображения: taro ohtani/unsplash.com Впрочем, инвесторы задаются вопросом — стоит ли строить новые ЦОД, особенно на фоне отказа Microsoft от некоторых своих проектов, развития семейств менее ресурсоёмких ИИ-моделей, а также потенциального негативного эффекта от пошлин, вводимых администрацией США. Meta✴ применяет ИИ во всех сферах своего бизнеса, от подбора контента в лентах пользователей соцсетей до таргетирования рекламы. Также ИИ применяется и в пользовательском оборудовании, от AR-гарнитур Meta✴ Quest до серии очков Ray-Ban Meta✴. В январе глава компании Марк Цукерберг (Mark Zuckerberg) заявил, что Meta✴, вероятно, потратит на ИИ сотни миллиардов долларов. В феврале власти города Бивер-Дам (Beaver Dam) в лице Beaver Dam Area Development Corporation сообщили, что планируют с Alliant Energy строительство ЦОД стоимостью около $500 млн. Сообщалось, что предварительно одобрены соглашения о строительстве и водоснабжении, но пока требуется разрешение центральных органов власти США. Для проекта Stargate компании OpenAI Висконсин также назван в качестве одной из локаций для строительства наряду с, например, Техасом.

31.03.2025 [17:50], Руслан Авдеев

Дата-центры Meta✴ в Сингапуре запитает плавучая солнечная электростанция SembcorpСингапурская компания Sembcorp, специализирующаяся на солнечной энергетике, подписала 25-летнее соглашение с местной дочерней структурой Meta✴ — Malkoha Pte. Предполагается, что Sembcorp построит, будет владеть и управлять солнечным энергопроектом мощностью 150 МВт, а вырабатываемая энергия будет поставляться дата-центрам Meta✴, сообщает Datacenter Dynamics. Проект будет реализован принадлежащей Sembcorp компанией Sembcorp Solar Singapore. Планируется размещение солнечных панелей в водах водохранилища Кранджи (Kranji Reservoir) на севере Сингапура. Строительство должно начаться в I половине 2027 года после получения разрешения от местных властей. Соглашение станет одним из первых, связанных с плавучими солнечными электростанциями. Речь идет об экспериментальной концепции, предполагающей размещение солнечных панелей на поверхности водохранилища или озера. Обычно такие панели прикрепляются якорями ко дну или берегам для большей стабильности. Ранее Meta✴ подписала с Sunseap соглашение о покупке электроэнергии (PPA) на 5 МВт от плавучей солнечной электростанции и 100 МВт — от солнечных панелей, установленных на крышах. Впервые Meta✴ вышла на сингапурский рынок в 2018 году, начав строительство дата-центра Tanjong Kling. Он был официально введён в эксплуатацию в 2022 году, его площадь составляет 170 тыс. м². Также в Сингапуре действуют некоторые другие операторы ЦОД, включая Equinix (не всегда успешно), Global Switch, Telehouse, Digital Realty и Iron Mountain. В результате соглашения о покупке возобновляемой энергии стали популярным товаром для «декарбонизации» своих объектов, хотя бы формально. На прошлой неделе Digital Realty объявила, что добилась 100% обеспечения своих объектов возобновляемой энергией, заключив соглашение с крупным поставщиком — Tuas Power. До этого Equinix подписала долгосрочное PPA с Sembcorp, источником энергии для которого тоже станет солнечный энергопроект в Сингапуре. Штаб-квартира Sembcorp находится в Сингапуре. Энергетическое портфолио компании составляет 25,1 ГВт, из которых 17 ГВт приходится на возобновляемые энергопроекты в 11 странах. Помимо соглашения с Equinix, Sembcorp заключила долгосрочный PPA с телекоммуникационным оператором Singtel. Использование прибрежных и внутренних водоемов для размещения инфраструктурных объектов становится все популярнее в Азиатско-Тихоокеанском регионе из-за дефицита свободных земель. Так, недавно консорциум японских компаний и финансовых институтов объявил о намерении построить прибрежный плавучий дата-центр вблизи Иокогамы, который также получит солнечные элементы питания.

26.03.2025 [10:39], Сергей Карасёв

SMART Modular представила энергонезависимые CXL-модули памяти NV-CMM-E3SКомпания SMART Modular Technologies объявила о начале пробных поставок улучшенных энергонезависимых модулей памяти CXL (Non-Volatile CXL Memory Module, NV-CMM), соответствующих стандарту CXL 2.0. Изделия ориентированы на применение в дата-центрах, которые поддерживают такие нагрузки, как резидентные базы данных, аналитика в реальном времени и приложения НРС. Новинка (NV-CMM-E3S) объединяет память DDR4-3200 DRAM, флеш-память NAND и источник резервного питания в форм-факторе E3.S 2T (EDSFF). Задействован интерфейс PCIe 5.0 x8. Применяются контроллеры на базе ASIC и FPGA. Устройство NV-CMM имеет ёмкость 32 Гбайт, а максимальная пропускная способность заявлена на уровне 32 Гбайт/с. Поддерживается шифрование информации по алгоритму AES-256. Интегрированный источник аварийного питания обеспечивает сохранность критически важных данных при непредвиденных отключениях электроэнергии, что повышает надёжность и доступность системы в целом. В случае сбоя в центральной сети энергоснабжения производится копирование данных из DRAM в NAND, а после восстановления подачи энергии выполняется обратный процесс. Изделие обеспечивает более быструю перезагрузку виртуальных машин и сокращает время простоя в облачных инфраструктурах.

Источник изображения: SMART Modular Technologies Устройство имеет размеры 112,75 × 15 × 76 мм. Эксплуатироваться модуль может при температурах окружающей среды до +40 °C. Отмечается, что внедрение NV-CMM на основе стандарта CXL знаменует собой важную веху в удовлетворении растущих потребностей платформ ИИ, машинного обучения и аналитики больших данных.

24.03.2025 [23:55], Владимир Мироненко

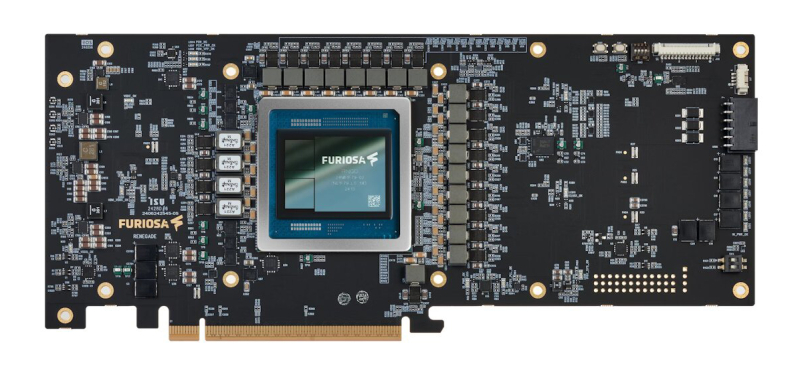

Разработчик ИИ-ускорителей FuriosaAI отказался «влиться» в Meta✴ за $800 млнСтартап FuriosaAI из Южной Кореи, представивший в прошлом году ИИ-ускоритель RNGD для работы с большими языковыми моделями (LLM) и мультимодальным ИИ, отклонил предложение о поглощении со стороны Meta✴ Platforms, которая была готова заплатить за это $800 млн. FuriosaAI намерена и дальше развивать бизнес в качестве независимой компании. Об этом сообщил Bloomberg со ссылкой на информированный источник. По словам собеседника Bloomberg, Meta✴ вела переговоры о приобретении FuriosaAI из Сеула с начала этого года. После того как в феврале появились слухи о возможном поглощении стартапа, начали расти в цене акции его крупнейшего инвестора, южнокорейской венчурной компании DSC Investment, но после известий об отказе их стоимость упала в понедельник на 16 %. Ускоритель RNGD, выполненный по 5-нм техпроцессу компании TSMC и использующий чипы памяти HBM3, поставляемые SK Hynix, способен конкурировать чипами NVIDIA, а также других ИИ-стартапов, включая Groq, SambaNova и Cerebras. Персонал FuriosaAI составляет около 150 сотрудников, включая 15 человек, работающих в офисе в Кремниевой долине. В конце прошлого года стартап начал тестирование RNGD и рассылку образцов чипов клиентам, включая LG AI Research (ИИ-подразделение LG Group) и Saudi Aramco. Сообщается, что более десяти потенциальных клиентов будут тестировать образцы RNGD в I половине этого года. По словам источников, FuriosaAI планирует привлечь дополнительный капитал и лишь потом провести первичное публичное размещение акций (IPO). Ожидается, что примерно через месяц компания завершит расширенный раунд финансирования серии C, который позволит получить намеченную сумму. До этого основанная в 2017 году FuriosaAI привлекла за четыре раунда финансирования $115 млн, пишет Data Center Dynamics. В свою очередь, Meta✴ вкладывает значительные средства в ИИ-инфраструктуру, стремясь опередить конкурентов, включая OpenAI и Google. В январе 2025 года гендиректор Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что компания выделит до $65 млрд на развитие ИИ в 2025 году, включая расходы на строительство крупного ЦОД и найм персонала в сфере ИИ. А всего неделю спустя Цукерберг сообщил инвесторам, что Meta✴ планирует потратить сотни миллиардов долларов на инфраструктуру ИИ. Meta✴ также работает над созданием собственных чипов. В 2023 году она представила чип Meta✴ Training and Inference Accelerator (MTIA) для ИИ-нагрузок, а в 2024 году был анонсирован ИИ-ускоритель MTIA второго поколения, втрое превосходящий предшественника по производительности. Сейчас компания ведёт тестирование собственного ускорителя для обучения ИИ-моделей. |

|