Материалы по тегу: сервер

|

15.02.2025 [23:03], Сергей Карасёв

xAI может построить второй ЦОД и купить у Dell ИИ-серверы на $5 млрдСтартап xAI, курируемый Илоном Маском (Elon Musk), по сообщению ресурса The Information, рассматривает возможность строительства второго крупного дата-центра для ИИ-нагрузок. Вместе с тем в распоряжении Bloomberg оказались сведения о том, что xAI может закупить ИИ-серверы у Dell на сумму в $5 млрд. Первым ЦОД компании xAI стала площадка в Мемфисе (Теннесси, США), где располагается ИИ-суперкомпьютер Colossus, запущенный в сентябре прошлого года. Первая очередь системы получила 100 тыс. ускорителей NVIDIA H100, а в дальнейшем количество карт NVIDIA планировалось увеличить вдвое. Позднее xAI получила $6 млрд инвестиций: деньги компания намерена направить на то, чтобы довести число ускорителей в составе Colossus до 1 млн штук. Где именно может расположиться второй дата-центр xAI, не уточняется. Известно, что для финансирования своих масштабных проектов xAI ведёт переговоры о привлечении $10 млрд: в ходе этого раунда стартап может получить оценку на уровне $75 млрд. Средства могут поступить в том числе от существующих инвесторов — Sequoia Capital, Andreessen Horowitz и Valor Equity Partners. Что касается сделки с Dell, то переговоры якобы находятся на «продвинутой стадии», но окончательное решение пока не принято. Речь идёт о закупке машин на базе NVIDIA GB200. В декабре 2024-го сообщалось, что xAI начала монтаж суперускорителей GB200 NVL72 для ИИ-кластера Colossus: предположительно, поставщиком систем является именно Dell. Кроме того, ранее стало известно, что Dell перехватила у Supermicro крупный заказ на ИИ-серверы для xAI. Таким образом, вероятность заключения контракта на $5 млрд между xAI и Dell весьма высока. Предполагается, что Dell сможет поставить серверы в рамках этого соглашения до конца текущего года.

14.02.2025 [13:24], Руслан Авдеев

Эксперты прогнозируют охлаждение рынка ИИ-серверов в 2025 годуТехнологические санкции США и подготовка цепочки поставок к поступлению на рынок новейшего оборудования NVIDIA, вероятно, приведут к снижению объёмов продаж ИИ-серверов в 2025 году, сообщает The Register со ссылкой на мнение независимых экспертов. Так, TrendForce сообщает, что поставки ИИ-серверов в прошлом году выросли на 46 %, преимущественно благодаря заказам провайдеров облачных сервисов (CSP). В частности, производитель серверов Foxconn объяснил недавний рекордный рост выручки именно продажами ИИ-серверов. При этом в TrendForce рассматривают несколько вариантов развития событий на рынке серверов в 2025 году из-за неопределённости, царящей в нише ИИ-решений. Наиболее вероятным считается дальнейшее расширение рынка, но с более низким годовым приростом. Впрочем, даже в таких условиях он может превысить 30 % — Microsoft, Meta✴, Amazon и Google намерены увеличить капитальные затраты на ИИ-инфраструктуру. Как ожидается, это будет способствовать поддержке спроса на ИИ-серверы. Наихудшим сценарием, по оценке TrendForce, причём следующим по вероятности, является рост поставок ИИ-серверов до «всего» 20–25 %. Этот прогноз учитывает ужесточение США экспорта ИИ-чипов в Китай, что создаёт большую неопределённость на рынке. Кроме того, не исключены задержки поставок стоечных решений NVIDIA на основе суперчипов Grace Blackwell — их структура довольно сложна, поэтому масштабное развёртывание откладывается на II половину года.

Источник изображения: Foxconn Более оптимистичный сценарий предполагает, что масштабные проекты в Китае и США (например, Stargate) помогут ускоренному развёртыванию ИИ-серверов. Кроме того, хотя триумф DeepSeek может негативно повлиять на необходимость внедрения большого количества ИИ-ускорителей, он же способен расширить применение искусственного интеллекта, стимулируя рост ИИ на периферии. При удачном стечении обстоятельств поставки ИИ-серверов вырастут в 2025 году почти на 35 %. Недавно глава IBM Арвинд Кришна (Arvind Krishna) уже предсказал, что использование аналогичных решениям DeepSeek экономичных и эффективных технологий не только не приведёт к падению рынка, но, наоборот, значительно увеличит использование оборудования после снижения «порога входа» для применения ИИ-моделей. Схожей позиции придерживаются инвесторы в ИИ-инфраструктуру вроде Blackstone и Brookfield, ожидающие, что спрос на ЦОД и оборудование не уменьшится. В TrendForce ожидают, что влияние DeepSeek будет способствовать переходу облачных операторов на недорогие чипы собственной разработки, поскольку акцент в последнее время смещается с обучения ИИ на инференс. В результате серверы, оптимизированные для запуска моделей, займут большую часть рынка. Вероятно, рынок серверов станет более сегментированным, поскольку крупные облачные игроки продолжат инвестиции в высокопроизводительные решения, а корпоративные заказчики будут отдавать предпочтение более экономичным альтернативам.

13.02.2025 [13:15], Сергей Карасёв

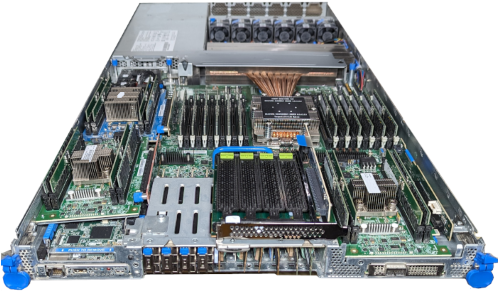

HPE представила серверы ProLiant Compute Gen12 на базе Intel Xeon 6700Компания HPE анонсировала серверы семейства ProLiant Compute Gen12 для рабочих нагрузок с интенсивным использованием данных, включая приложения ИИ, гибридных облачных сред и периферийных вычислений. В основу новинок положены процессоры Intel Xeon 6 серии 6700E (Sierra Forest-SP, до 144 E-ядер). Они же будут совместимы и с 6700P (Granite Rapids-SP, до 86 P-ядер). Отличие от AP-версий не только в количестве ядер, но и в поддержке только восьми каналов памяти (DDR5-6400). Дебютировали шесть моделей Gen12: ProLiant Compute DL320, ProLiant Compute DL340, ProLiant Compute DL360, ProLiant Compute DL380 и ProLiant Compute DL380a для монтажа в стойку, а также ProLiant Compute ML350 в башенном исполнении. Для некоторых вариантов доступно прямое жидкостное охлаждение. Модель ProLiant Compute DL320 Gen12 в форм-факторе 1U допускает установку одного чипа Xeon 6, а также 2 Тбайт оперативной памяти DDR5 (16 слотов DIMM). Подсистема хранения данных может иметь следующую конфигурацию: 20 × EDSFF, 8 × SFF или 4×/10×/12× LFF. Возможен монтаж четырёх GPU одинарной ширины или двух ускорителей двойной ширины. Допускается применение воздушного или жидкостного охлаждения. Сервер ProLiant Compute DL340 Gen12, в свою очередь, имеет типоразмер 2U. Он рассчитан на один процессор Xeon 6. Объём ОЗУ может составлять до 4 Тбайт в виде 16 модулей DDR5. Накопители монтируются по схеме 20 × EDSFF, 8 × SFF или 12 × LFF. Поддерживаются шесть GPU-карт одинарной ширины или четыре ускорителя двойной ширины. Задействовано оптимизированное воздушное охлаждение со стандартными или высокопроизводительными комплектами радиаторов и вентиляторов. ProLiant Compute DL360 Gen12 — двухсокетный сервер 1U, разработанный для высокопроизводительных вычислений, виртуализации, гибридных облачных сред и пр. Он может комплектоваться максимум 8 Тбайт памяти DDR5 в 32 слотах, тремя GPU-ускорителями одинарной ширины. Подсистема хранения может включать следующие накопители: 20 × EDSFF, 10 × SFF или 4 × LFF. Возможно применение воздушного охлаждения, жидкостного охлаждения с замкнутым контуром и прямого жидкостного охлаждения. Сервер ProLiant Compute DL380 Gen12 формата 2U также может оснащаться двумя процессорами и 8 Тбайт памяти DDR5. Заявлена поддержка до восьми ускорителей одинарной ширины или до трёх карт двойной ширины. В зависимости от конфигурации могут монтироваться накопители стандарта EDSFF (×36), SFF (×24) или LFF (×12). Поддерживается воздушное и прямое жидкостное охлаждение. Модель ProLiant Compute DL380a Gen12 в форм-факторе 4U создана для ресурсоёмких задач с ускорением на базе GPU: поддерживаются до 16 карт одинарной ширины или до восьми карт двойной ширины, включая NVIDIA H200 NVL, H100 NVL, L4 и L40S. Сервер может нести на борту два процессора и до 4 Тбайт памяти DDR5 в виде 32 модулей. Могут быть установлены до 16 накопителей EDSFF или до восьми изделий SFF. Наконец, ProLiant Compute ML350 Gen12 — двухсокетный башенный сервер для периферийных вычислений, а также малого и среднего бизнеса. Он поддерживает два чипа Xeon 6 (до 86 ядер), 8 Тбайт оперативной памяти DDR5 в 32 слотах, восемь ускорителей одинарной ширины или четыре карты двойной ширины. Для накопителей доступны следующие варианты монтажа: до 12 × LFF HDD/SSD с интерфейсом SAS/SATA, 24 × SFF HDD/SSD с интерфейсом SAS/SATA, 16 × SFF NVMe SSD, 24 × SFF NVMe SSD или 12 × EDSFF 3.S 1T. Отмечается также, что летом нынешнего года в новое семейство войдут блейд-сервер HPE Synergy 480 и четырёхпроцессорная модель ProLiant Compute DL580 Gen12, но их технические характеристики пока не раскрываются. Все новинки получат систему управления iLO 7.

10.02.2025 [14:40], Руслан Авдеев

Сервер в каждый дом: British Gas и Heata протестируют в Великобритании индивидуальные «цифровые котлы»Компания British Gas заключила соглашение с Heata, в рамках которого в Великобритании в тестовом режиме будет развёрнута облачная платформа с серверами, размещёнными в жилых домах. Каждый сервер подключен к системе домашнего отопления, аккумулирующей тепло в ходе работы сервера. Каждый сервер может отдать до 4 кВт∙ч в день, что в теории позволит сэкономить на счетах за газ или электричество до £340/год. Электричество, потребляемое сервером, оплачивается самой Heata. Испытания будут проводить три месяца, на этот период в домах сотрудников British Gas установят 10 «цифровых бойлеров», ресурсы которых будут сдаваться в аренду клиентам Heata. Компании намерены делиться идеями и знаниями, чтобы сделать технологию массовой. Ранее Heata сотрудничала с Civo в рамках схожей пилотной программы, предусматривавшей отопление домов в Великобритании в 2023 году. Есть и другие аналогичные проекты. Так, Deep Green использует GPU-серверы для подогрева бассейнов в Эксмуте и Йоркшире. Civo тоже является партнёром Deep Green. В 2022 году Qarnot порадовала заказчиков новым поколением отопительных устройств QB, созданных совместно с ITRenew. Эти системы используют OCP-серверы, ранее работавшие в дата-центрах гиперскейлеров. Позже компания в качестве эксперимента использовала серверы для приготовления пищи. Возможно, подход с размещением вычислительных мощностей в непосредственной близости от потребителей тепла окажется эффективнее, чем попытки подключения ЦОД к системам центрального отопления.

13.01.2025 [17:44], Руслан Авдеев

Соцсеть X готова потратить $1 млрд на ИИ-серверы HPEКомпания HPE, судя по всему, станет поставщиком оптимизированных для ИИ-задач серверов социальной сети Илона Маска X (Twitter). Сумма сделки составит более $1 млрд. Соглашение достигнуто в конце 2024 года, сообщает Bloomberg со ссылкой на осведомлённые источники. Заявку на поставки X оборудования также подавали Dell Technologies и SuperMicro. В самой HPE сообщение не комментируют. Спрос на ИИ-вычисления ведёт к процветанию производителей мощных серверов. Tesla и xAI считаются одними из крупнейших покупателей соответствующего оборудования. Так, суперкомпьютер xAI Colossus в Мемфисе (США) использует серверы Dell и Supermicro. Известно, что подконтрольные Маску бизнесы в случае необходимости довольно свободно обмениваются сотрудниками, технологиями и вычислительными мощностями. Новости незначительно сказались на цене акций HPE, Dell и Supermicro. В целом, несмотря на рост, бизнес HPE, связанный с выпуском ИИ-серверов, несколько отстаёт от конкурентов, хотя именно благодаря ИИ-решениям HPE впервые завершила IV квартал с рекордной выручкой в $8,5 млрд и вдвое выросшей прибылью. Сделка с одной из компаний Маска стала своеобразным «вотумом доверия» предложениям HPE.

Источник изображения: HPE По данным Bloomberg Intelligence, аргументом в пользу HPE, возможно, стала фирменная технология жидкостного охлаждения серверов. Правда, хотя крупные сделки хороши для общего объёма продаж, часто они могут оказаться своеобразным тормозом» для маржинальности. Любопытно, что в конце прошлого года HPE отказалась продать неназванному заказчику ИИ-серверы на $700 млн. Supermicro объявила, что продолжает поддерживать прочные партнёрские отношения с контрагентами, включая xAI. Также в компании отмечают, что её технологии пользуются большим спросом. В Dell новости не комментируют. В HPE же ожидают роста внедрения ИИ-систем предприятиями и государствами в 2025 году. При этом в ходе декабрьского отчёта о прибылях утверждалось, что рыночная среда останется высококонкурентной и нестабильной. По данным Synergy Research Group, расходы на инфраструктуру ЦОД в 2024 году взлетели год к году на 34 % до $282 млрд. В минувшем году основным событием рынка ИИ стал взрывной рост NVIDIA. Как заявляют в Synergy Research, об этом косвенно свидетельствует и рост доходов её клиентов — вендоров, занимающихся выпуском ИИ-серверов.

08.01.2025 [22:50], Владимир Мироненко

NVIDIA и партнёры запустили полномасштабное производство серверов на базе BlackwellNVIDIA и её партнёры запустили полномасштабное производство систем с ускорителями Blackwell, заявил глава компании Дженсен Хуанг (Jensen Huang): «Каждый поставщик облачных услуг теперь имеет работающие системы». Первой компанией, которая начала поставки серверов на базе Blackwell, стала Dell. Отдельные провайдеры облачных услуг ещё в середине ноября прошлого года стали обладателями её платформ, передаёт Tom's Hardware. На данный момент, по словам NVIDIA, круг поставщиков заметно расширился. Их предложения включают системы на базе Blackwell в более чем 200 различных конфигурациях. «Есть системы от примерно 15 производителей с 200 различными наименованиями в 200 различных конфигурациях, — сказал Хуанг. — Есть с жидкостным охлаждением, воздушным охлаждением, с чипами x86, с NVIDIA Grace, NVL36×2, NVL72. Целый ряд различных типов систем, которые подойдут практически к любому ЦОД в мире». Он отметил, что такие системы производятся на 45 заводах, что говорит о том, насколько активно отрасль переходит на выпуск систем с ИИ. Blackwell от Nvidia значительно увеличивают производительность вычислений для приложений ИИ и HPC по сравнению с чипами поколения Hopper, но при этом потребляют значительно больше энергии, что предъявляет повышенные требования к мощности ЦОД и его системам охлаждения. Если стойка на базе Hopper потребляет 40 кВт, то суперускоритель GB200 NVL72 потребляет порядка 120 кВт или даже больше.

06.01.2025 [19:00], Владимир Мироненко

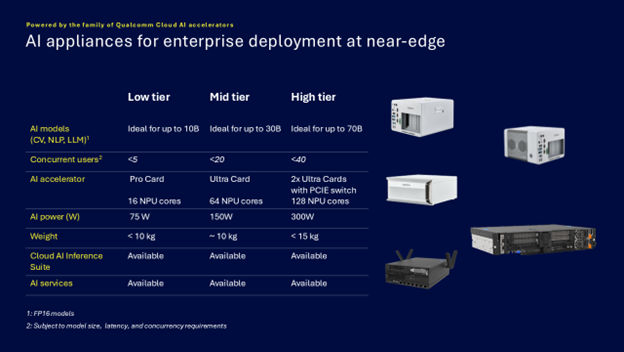

Qualcomm представила энергоэффективные ИИ-микросерверы AI On-Prem Appliance SolutionQualcomm Technologies анонсировала Qualcomm AI On-Prem Appliance Solution — компактное энергоэффективное аппаратное решение для локальной обработки рабочих нагрузок инференса и компьютерного зрения. Также компания представила готовый к использованию набор ИИ-приложений, библиотек, моделей и агентов Qualcomm Cloud AI Inference Suite, способный работать и на периферии, в облаках. Согласно пресс-релизу, сочетание новых продуктов позволяет малым и средним предприятиям и промышленным организациям запускать кастомные и готовые приложения ИИ на своих объектах, включая рабочие нагрузки генеративного ИИ. Qualcomm отметила, что инференс на собственных мощностях позволит значительно снизить эксплуатационные расходы и общую совокупную стоимость владения (TCO) по сравнению с арендой сторонней ИИ-инфраструктуры. С помощью AI On-Prem Appliance Solution совместно с AI Inference Suite клиенты смогут использовать генеративный ИИ на базе собственных данных, точно настроенные модели и технологическую инфраструктуру для автоматизации процессов и приложений практически в любой среде, например, в розничных магазинах, ресторанах, торговых точках, дилерских центрах, больницах, на заводах и в цехах, где рабочие процессы хорошо отлажены, повторяемы и готовы к автоматизации. «Решения AI On-Prem Appliance Solution и Cloud AI Inference Suite меняют TCO ИИ, позволяя обрабатывать рабочие нагрузки генеративного ИИ не в облаке, а локально», — заявила компания, подчеркнув, что AI On-Prem Appliance Solution позволяет значительно снизить эксплуатационные расходы на приложения ИИ для корпоративных и промышленных нужд в самых разных областях. Кроме того, локальное развёртывание обеспечивает защиту от утечек чувствительных данных. Платформа Qualcomm AI On-Prem Appliance Solution работает на базе семейства ускорителей Qualcomm Cloud AI. Сообщается, что новинка поддерживает широкий спектр возможностей, в том числе:

В свою очередь Qualcomm Cloud AI Inference Suite предлагает полный набор инструментов и библиотек для разработки или переноса приложений генеративного ИИ на AI On-Prem Appliance Solution или другие платформы на базе ускорителей Qualcomm Cloud AI. Набор предлагая множество API для управления пользователями и администрирования, для работы чатов, для генерации изображений, аудио и видео. Заявлена совместимость с API OpenAI и поддержка RAG. Кроме того, доступна интеграция с популярными моделями генеративного ИИ и фреймворками. Возможно развёртывание с использованием Kubernetes и bare metal.

04.01.2025 [15:21], Руслан Авдеев

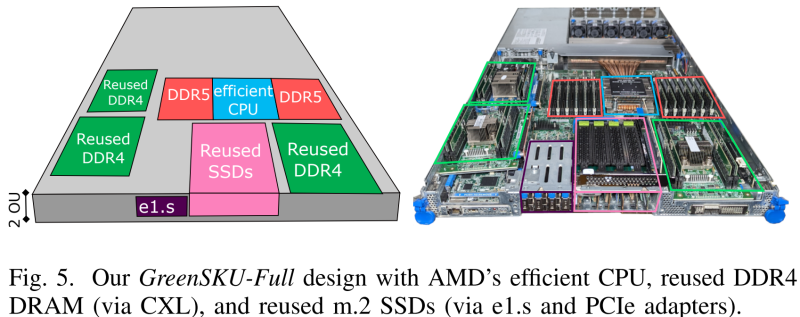

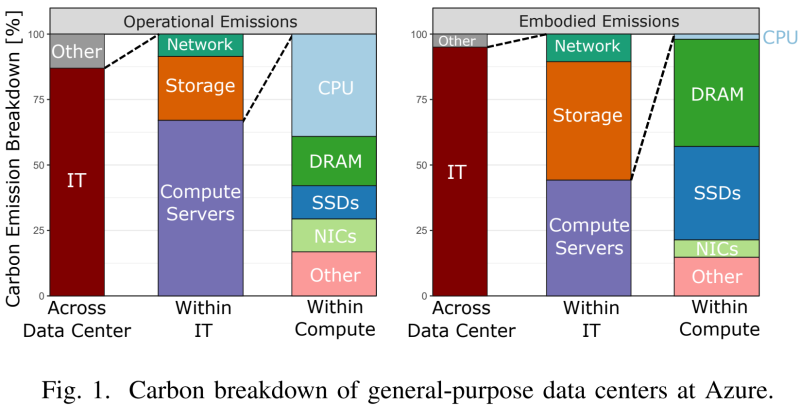

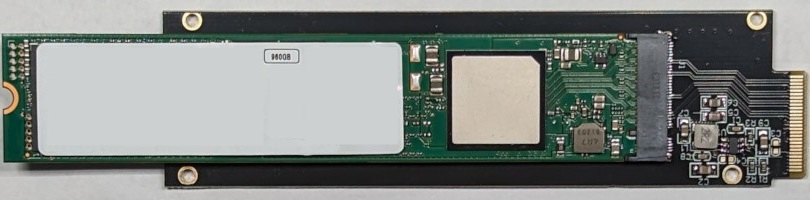

Microsoft совместно с учёными США разработала экологичные облачные серверы GreenSKU, которые используют RAM и SSD из старых системУчёные из Microsoft, Университета Карнеги-Меллона и Вашингтонского университета разработали новый стандарт экологичных серверов GreenSKU, которые позволят снизят углеродные выбросы ЦОД, сообщает IEEE Spectrum. Кроме того, была представлена модель GreenSKU Framework для расчёта целесообразности использования подобных систем в дата-центрах гиперскейлеров и подбора оптимальных конфигураций. Созданные в рамках концепции GreenSKU прототипы серверов были протестированы в ЦОД Azure.

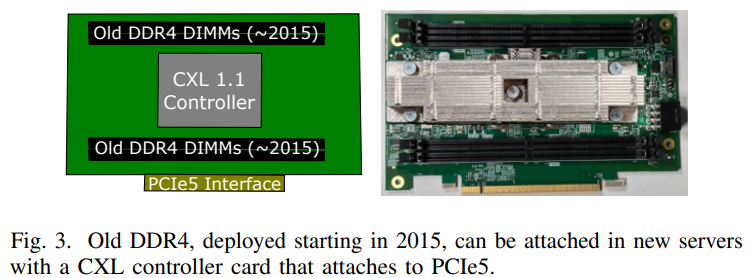

Источник изображений: Microsoft Исследование, вышедшее минувшим летом, изучает возможность использования компонентов из списанных серверов. Это важно, поскольку сегодня во многих случаях при сбое одного компонента из эксплуатации выводится сервер целиком. Кроме того, Microsoft меняет серверы Azure каждые 3–5 лет для оптимизации производительности. И в этом случае работоспособные компоненты всё равно обычно не используются в других серверах. Согласно выкладкам исследователей, уровень сбоев оперативной памяти (AFR) после кратковременного всплеска вскоре после развёртывания остаётся примерно одинаковым на протяжении не менее семи лет. А износ SSD составляет около половины. Впрочем, в данном случае речь идёт об M.2-накопителях. Их надёжность и скорость работы можно повысить простым объединением в RAID-массив. А для их использования в современных платформах с E1.S-корзинами есть готовые пассивные адаптеры, благо стандарт PCIe обладает обратной совместимостью.  С памятью дело обстоит не так просто. Предыдущие поколения серверов использовали DDR4, тогда как актуальные платформы работают только с DDR5. Однако выход есть — в современных CPU появилась поддержка CXL. Точнее, CXL Type 3 (CXL.mem), что позволяет подключать по PCIe пулы DRAM. Они представлены в виде NUMA-узлов без CPU. Такое подключение памяти даёт большую задержку, но современные гипервизоры умеют работать с такими пулами, отправляя в них редко используемые массивы данных.  Старые процессоры переиспользовать не выйдет. Они гораздо менее энергоэффективны и производительны, при этом на CPU приходится основная часть энергопотребления и, соответственно, углеродных выбросов. Исследователи изучили актуальные предложения вендоров и пришли к выводу, что среди доступных на рынке процессоров наилучшим образом для GreenSKU подходят AMD EPYC Bergamo, которые предлагает большое количество ядер и потоков при сравнимом уровне TDP, пусть и при пониженной производительности каждого ядра, а также поддерживают необходимые протоколы CXL. Для распределения нагрузок используется отдельный программный слой, определяющий, какие задачи можно выполнять на серверах GreenSKU, а какие — на стандартных серверах Azure в зависимости от требований к производительности. Как отмечают исследователи, три четверти развёрнутых в Azure инстансов в среднем используют лишь 25 % выделенных ресурсов CPU и около 15 % от доступной пропускной способности памяти. Точно так же далеко не в полной мере используются и SSD. Вместе с тем есть клиенты, которые выживают максимум из каждого инстанcа. Снижение углеродных выбросов имеет большое значение для облачных вычислений, поскольку они могут составить 20 % всех выбросов к 2030 году — об этом свидетельствуют данные НКО Ассоциация вычислительной техники. В пересчёте на ядро выбросы серверов GreenSKU на 28 % ниже, чем выбросы обычных серверов Azure. А на уровне ЦОД с учётом всех накладных расходов снижение выбросов составляет 8 %.

02.01.2025 [15:18], Владимир Мироненко

ИИ останется драйвером роста полупроводниковой отрасли в 2025 году, но политика США может принести сюрпризы

digitimes research

hardware

анализ рынка

ии

импортозамещение

китай

прогноз

производство

санкции

сервер

сша

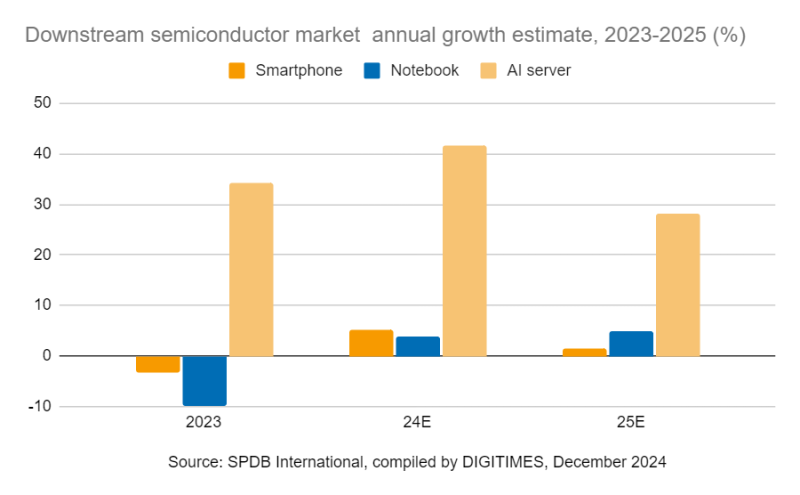

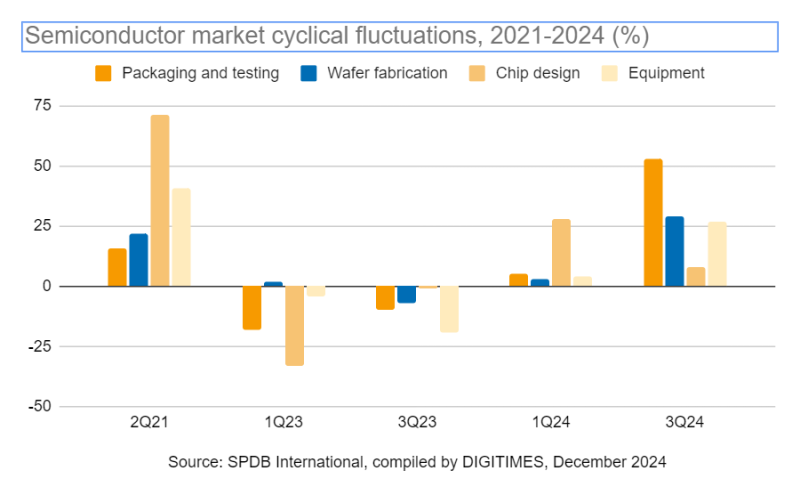

В 2025 году, как и в прошлом, ИИ по-прежнему будет драйвером роста индустрии полупроводников, стимулируя и без того повышенный спрос на производство микросхем. Однако с возвращением Дональда Трампа (Donald Trump) на пост президента США, на рынке возникнет потенциальная неопределённость, поскольку, судя по уже сделанным им заявлениям, политика его администрации может привести к инфляции и экономическому охлаждению, совпадая с прогнозируемым спадом в цикле рынка полупроводников, предупреждают в DIGITIMES Research. По оценкам World Semiconductor Trade Statistics (WSTS), в 2024 году мировой рынок полупроводников вырос в годовом исчислении на 19 %, а в 2025 году его рост может составить 11,2 %. Ключевым фактором этого роста остаётся ИИ. При этом секторы логических микросхем и микросхем памяти, связанные с ИИ, согласно прогнозу, покажут двузначный рост в процентах, тогда как в других сегментах полупроводников ожидается более скромный рост, исчисляемый однозначными числами. Ожидается, что ИИ-серверы покажут двузначный рост, в то время как в сегментах смартфонов и ноутбуков будет наблюдаться однозначный рост. Увеличение популярности генеративного ИИ будет стимулировать рост в технологическом секторе и укреплять динамику полупроводниковой промышленности. От этого тренда лидеры отрасли, включая TSMC и NVIDIA, могут значительно выиграть, поскольку являются ведущими производителями ИИ-ускорителей. Аналитики DIGITIMES Research отметили, что в 2025 году циклические закономерности полупроводниковой промышленности остаются очевидными. Предыдущий подъём отрасли, наблюдавшийся с середины 2019 года до середины 2021 года, продолжался около 25 месяцев, что было обусловлено повышенным спросом на потребительскую электронику и ПК во время пандемии COVID-19, а также стремлением компаний пополнить запасы. Текущая фаза восстановления, стартовавшая во II квартале 2023 года, характеризуется ростом мировых продаж полупроводников год к году, чему будет способствовать рост спроса на ИИ-вычисления, подпитываемый использованием генеративного ИИ, а также возросшей потребностью в микросхемах памяти и электронике, в том числе в смартфонах и ПК. По словам DIGITIMES Research, спрос на ИИ-серверы продолжает расти, и сегмент ИИ-чипов для обучения и инференса в облаке демонстрирует быстрый рост. В то же время выполение ИИ-нагрузок проникает на периферию, что подпитывает спрос на потребительскую электронику, такую как смартфоны и ПК. TSMC является главным бенефициаром роста спроса на микросхемы для ИИ. Ведущие производители ИИ-чипов — NVIDIA, AMD, Qualcomm и MediaTek — по прогнозам, сохранят в текущем году устойчивый рост производства ускорителей для обучения ИИ и мобильных SoC-продуктов. Аналитики отметили, что сохраняющаяся напряжённость во взаимоотношениях США и Китая создает геополитические риски, которые добавляют неопределённости в модель циклического развития полупроводниковой промышленности. Санкции США усилили стремление Поднебесной к достижению самодостаточности. Вместе с тем за последние два-три года мировые бренды значительно расширили литографические мощности в Китае, достигнув пика. Как ожидают в DIGITIMES Research, тренд на импортозамещение получит продолжение в Китае в 2025 году. Во всяком случае, китайские производители электроники всё чаще используют компоненты местного производства, стремясь свести к нулю влияние потенциальных торговых конфликтов. Отмечено, что такие европейские вендоры, как STMicroelectronics, NXP и Infineon, демонстрируют растущий интерес к изготовлению пластин на китайских заводах, что приносит пользу ключевым игрокам рынка, в том числе SMIC и Shanghai Huahong Group. Всё это приведёт в 2025 году к углублению локализации производства полупроводников в Китае.

30.12.2024 [12:56], Сергей Карасёв

Firefly представила серверы CSB1-N10 для создания ИИ-кластеров из одноплатных компьютеровКомпания Firefly Technology, по сообщению ресурса CNX-Software, выпустила серверы серии CSB1-N10 для построения ИИ-кластеров. Устройства, выполненные в форм-факторе 1U, подходят для дата-центров, периферийных развёртываний и локальных площадок. В семейство вошли пять моделей: CSB1-N10S1688, CSB1-N10R3588, CSB1-N10R3576, CSB1-N10NOrinNano и CSB1-N10NOrinNX. Узлы систем оснащены соответственно процессором Sophgo Sophon BM1688 (8 ядер, до 1,6 ГГц), Rockchip RK3588 (8 ядер, до 2,4 ГГц), Rockchip RK3576 (8 ядер, до 2,2 ГГц), NVIDIA Jetson Orin Nano (6 ядер, до 1,5 ГГц) и Jetson Orin NX (8 ядер, до 2,0 ГГц). Первые три из перечисленных узлов комплектуются оперативной памятью LPDDR4 объёмом 8, 16 и 8 Гбайт соответственно, а также флеш-модулем eMMC вместимостью 32, 256 и 64 Гбайт. Варианты Orin оборудованы 8 и 16 Гбайт памяти LPDDR5 и накопителем NVMe SSD на 256 Гбайт. Все серверы содержат десять вычислительных узлов и дополнительный управляющий узел на чипе RK3588. Присутствует слот для SSD с интерфейсом SATA-3. В оснащение входят по два сетевых порта 10GbE (SFP+) и 1GbE (RJ45), выделенный сетевой порт управления 1GbE, аналоговый разъём D-Sub (1080p60), два порта USB 3.0, а также последовательный порт. Применяется воздушное охлаждение. За питание отвечает блок мощностью 550 Вт. Диапазон рабочих температур — от 0 до +45 °C. Кластер на базе CSB1-N10S1688 обеспечивает ИИ-производительность до 160 TOPS на операциях INT8. В случае CSB1-N10R3588 и CSB1-N10R3576 это показатель составляет 60 TOPS. Эти три системы поддерживают работу с большими языковыми моделями (LLM), а также фреймворками TensorFlow, PyTorch, PaddlePaddle, ONNX, Caffe. В случае CSB1-N10NOrinNano и CSB1-N10NOrinNX быстродействие достигает 400 и 1000 TOPS. Говорится о поддержке LLaMa3 и Phi-3 Mini, фреймворков TensorFlow, PyTorch, Matlab и др. Цена варьируется от $2059 до $14 709. |

|