Материалы по тегу: облако

|

10.09.2025 [12:44], Сергей Карасёв

В облаке Vultr по всему миру стали доступны ускорители AMD Instinct MI355XЧастный облачный провайдер Vultr объявил о том, что в его глобальной инфраструктуре стали доступны ускорители AMD Instinct MI355X, официально представленные в июне нынешнего года. Утверждается, что эти изделия устанавливают новый стандарт соотношения цены и производительности для ресурсоёмких ИИ-задач, в частности, инференса. Решение Instinct MI355X построено на архитектуре AMD CDNA 4-го поколения. Устройство располагает 288 Гбайт памяти HBM3E, пропускная способность которой достигает 8 Тбайт/с. Применяется жидкостное охлаждение. Упомянута поддержка программного стека AMD ROCm. На сайте Vultr говорится, что теоретическая производительность ИИ при использовании в конфигурации 8 × Instinct MI355X OAM достигает 20,1 Пфлопс в режиме FP16, 40,3 Пфлопс на операциях INT8/FP8 и 80,5 Пфлопс в режиме FP4. При развёртывании ускорителей Instinct MI355X в своём облаке Vultr тесно сотрудничала с AMD и Supermicro. Благодаря 32 облачным регионам на шести континентах Vultr гарантирует низкую задержку и высокую доступность вычислительных мощностей. Стоимость услуг, как утверждается, ниже по сравнению с аналогичными предложениями гиперскейлеров. Ускорители Instinct MI355X подходят не только для инференса и обучения ИИ-моделей, но и для других нагрузок HPC, таких как симуляции, сложное моделирование или обработка больших массивов данных.

08.09.2025 [17:48], Владимир Мироненко

Microsoft предоставила скидки госагентствам США на более чем $6 млрд

microsoft

microsoft 365

microsoft azure

microsoft copilot

software

госзакупки

ии

облако

сделка

сша

финансы

Управление общих служб США (GSA) объявило о заключении соглашения с Microsoft в рамках новой политики закупок OneGov, введённой администрацией Дональда Трампа (Donald Trump) и призванной консолидировать ИТ-расходы через единый канал. Вместо того чтобы каждое ведомство заключало собственные контракты, OneGov предписывает им осуществлять закупки через GSA. Новое соглашение предусматривает значительные скидки на пакет облачных сервисов, который Microsoft предоставит агентствам США, включая Microsoft 365, Copilot, Azure, Dynamics 365, а также инструменты кибербезопасности и мониторинга, и даже семинары по внедрению, адаптации и оптимизации, что позволит сэкономить им $3,1 млрд в первый год. В частности, Microsoft 365 Copilot будет предоставляться бесплатно клиентам Microsoft G5 в течение до 12 месяцев с дополнительными скидками в последующие годы, что свидетельствует о намерении Microsoft сделать своего ИИ-помощника стандартным элементом правительственных рабочих процессов. Microsoft 365 G3 и G5 — планы лицензирования для государственных учреждений с различными уровнями безопасности и функциональности. G5 специально разработан для сред, требующих повышенной безопасности, и включает в себя дополнительные функции, такие как аналитика в режиме реального времени, защита от угроз, Power BI Pro и расширенные возможности корпоративной телефонии. Федеральные агентства могут воспользоваться всеми этими предложениями или любыми из них до сентября 2026 года, при этом скидки на некоторые продукты будут действовать до 36 месяцев. Чтобы получить право на льготы, агентства должны пройти процедуру GSA в рамках OneGov. Не все агентства имеют право на более низкие ставки. За полный трёхлетний период общая экономия правительственных агентств может превысить $6 млрд, что делает предоставляемые Microsoft скидки одними из самых крупных среди предоставленных компаниями правительству, отметил ресурс Windows Central. Генеральный директор Microsoft Сатья Наделла (Satya Nadella) лично участвовал в подписании соглашения, пообщавшись напрямую с Джошем Грюнбаумом (Josh Gruenbaum), главой Федеральной службы закупок (Federal Acquisition Service), что демонстрирует, насколько важна эта сделка для компании. Сделки с GSA в рамках OneGov заключил целый ряд компаний. Adobe предложила скидку 70 % на своё решение для безбумажного правительства, доступное до ноября 2025 года. Соглашение с Amazon предполагает предоставление всем агентствам облачных кредитов на сумму до $1 млрд на модернизацию их инфраструктуры, а также большую экономию в рамках прямых контрактов. В свою очередь, Google представила скидку 71 % на Google Workspace. В сфере ИИ скидки ещё более внушительные. Claude for Enterprise от Anthropic доступен для всех трёх ветвей власти всего за $1 на агентство, OpenAI предлагает ChatGPT Enterprise по такой же цене. Однако соглашение действует только один год. GSA контролирует около $110 млрд расходов на общие товары и услуги, предоставляемые многими агентствами, включая около $80 млрд расходов, связанных с ИТ. Годовой доход Microsoft от правительственных контрактов, вероятно, составляет несколько миллиардов долларов, сказал Грюнбаум, о чём сообщает CNBC. Вместе с тем некоторые эксперты считают продукты Microsoft угрозой национальной безопасности из-за многочисленных уязвимостей. Кроме того, компанию подозревали в антиконкурентном поведении ради сохранения правительственных контрактов.

08.09.2025 [13:27], Руслан Авдеев

Gemini стал доступен в частных облаках Google Distributed Cloud

gemini

google cloud platform

hardware

ии

информационная безопасность

конфиденциальность

облако

частное облако

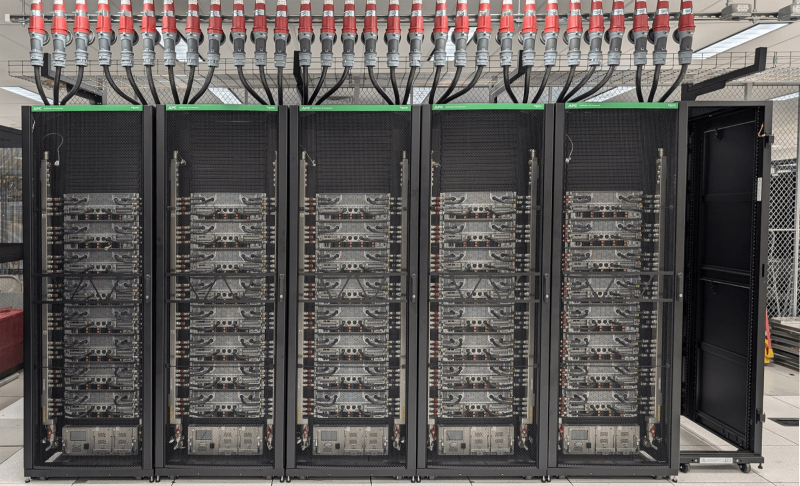

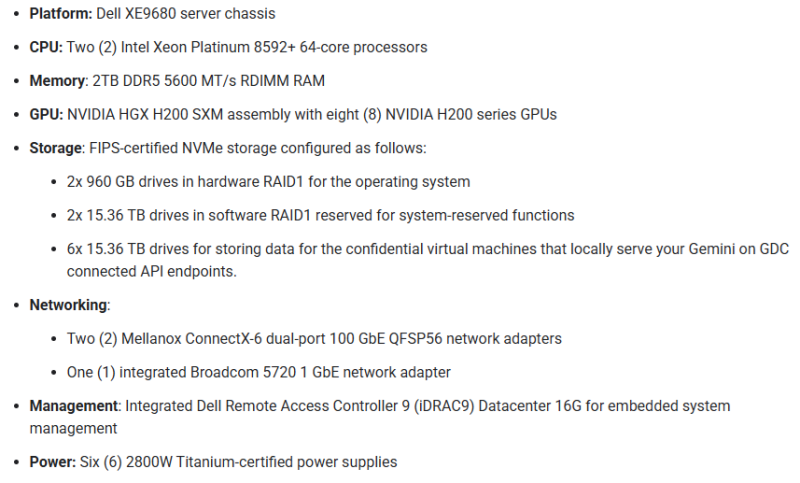

Компания Google анонсировала общую доступность ИИ-моделей Gemini в облаках Google Distributed Cloud (GDC), предназначенных для развёртывания на мощностях самих клиентов. В частности, генеративный ИИ будет доступен в частных корпоративных и правительственных платформах, сообщает Network World. GDC является вариантом облака Google Cloud, предназначенным для жёстко регулируемых отраслей вроде здравоохранения или финансовых сервисов. Фактически такие облака скрываются на мощностях клиентов, прячась от внешнего мира за защитными системами компаний. Запуск Gemini в GDC позволяет организациям, обязанным соблюдать жёсткие требования к размещению данных и соответствовать ряду правил по некоторым другим параметрам, внедрять системы генеративного ИИ, не теряя контроля над конфиденциальной информацией. GDC строятся на ускорителях семейств NVIDIA Hopper и Blackwell с автоматизированным распределением нагрузки, без необходимости дополнительных вмешательств для обновления ПО. В системе реализованы функции безопасности вроде аудита и контроля доступа, обеспечивающие клиентам максимальную прозрачность. Платформа также поддерживает функцию «конфиденциальных вычислений» Confidential Computing как для CPU (с Intel TDX), так и ИИ-ускорителями (с применением технологий NVIDIA) для защиты конфиденциальных данных и предотвращения их подделки и утечки. Модели Gemini обеспечивают обработку контента и мультимодальное понимание текста, изображений, аудио и видео. В Google заявляют, что это открывает множество возможных способов применения, включая многоязыковое, в том числе международное сотрудничество, автоматизированное составлении резюме документов и др., поддерживаются чат-боты и генерация кода с помощью искусственного интеллекта.

Источник изображения: Google Для работы Gemini требуется сертифицированное Google оборудование. Среди такового пока есть только одна модификация HGX H200 на базе Dell XE9680.

08.09.2025 [08:47], Руслан Авдеев

Из грязи в князи: Fluidstack, в штате которой было всего 10 человек, получила многомиллиардный контракт на создание «атомного» ИИ-облака во ФранцииНе самый известный британский стартап Fluidstack в феврале этого года подписал соглашение с французскими властями о создании в стране ИИ-кластера на 1 ГВт, запитанного от французских АЭС. Fluidstack, в которой в 2024 году работало всего 10 штатных сотрудников, стала неожиданным для экспертов исполнителем проекта по созданию «атомного» ИИ ЦОД за $11,6 млрд для 500 тыс. ускорителей, сообщает Forbes. В июне Fluidstack заявила, что общий бюджет проекта французских ЦОД может превысить $46 млрд. Сделка — лишь часть пакета инвестиций в ИИ-инфраструктуру на $113 млрд, которые Макрон анонсировал в феврале. Многомиллиардные обязательства в соответствующей сфере взяли на себя канадский пенсионный фонд Brookfield, французский государственный инвестиционный банк BPIFrance и ИИ-фонд MGX из ОАЭ. Основанная в 2017 году Fluidstack потратила годы на освоения рынка ИИ. Сначала стартап буквально сводил вместе обладателей простаивающих ускорителей и клиентов с небольшими бюджетами. В 2022 году выручка компании составила $1,8 млн, тогда же был запущен ChatGPT. В 2023 году она выросла до $30 млн, а в 2024-м — до 66,2 млн. Правда, за тот же период финансовые показатели изменились с $1,72 млн прибыли до убытков в размере $735 тыс. В 2024 году около половины выручки пришлось на сделки с компаниями из США. Сообщалось о сделках с Meta✴, европейскими Mistral, Black Forest Labs и Poolside.

Источник изображения: Razvan Chisu/unspalsh.com После объявления о сделке с французским правительством компания создала подразделения для операций во Франции, Исландии, Норвегии, Аргентине и США. Fluidstack позиционируется как европейский конкурент американским «неооблакам» вроде CoreWeave или Lambda и традиционным облачным гигантам, включая Google, AWS, Microsoft и Oracle. Стартап всё ещё арендует помещения и ускорители у других компаний. В прошлом месяце заключена сделка с майнером TeraWulf на $3,2 млрд, связанная с арендой 360-МВт ИИ ЦОД в штате Нью-Йорк. Сделку поддержала Google, взявшая на себя обязательство финансово подстраховать Fluidstack и нарастившая долю в Terawulf. Уникальность сделки ещё и в том, что Google, по-видимому, впервые предложила развернуть фирменные ИИ-ускорители TPU не в собственном облаке. Для Fluidstack, публично сообщавшей о привлечении лишь $4,5 млн, это огромная сделка. Годовая отчётность показала, что стартап привлёк в ходе ранее не разглашавшегося раунда SAFE $24,7 млн, а также займы на $37,5 млн в 2024 году. Имена инвесторов и кредиторов не разглашаются. Также сообщалось, что компания ведёт переговоры о привлечении до $200 млн. Впрочем, сумма всё равно невелика в сравнении со средствами, которые привлекли другие игроки вроде CoreWeave, Nebius или Crusoe.

Источник изображения: Guille Álvarez/unsplash.com Для финансирования Fluidstack, похоже, обратилась не к венчурным капиталистам. В апреле она заключила соглашение с австралийским инвестиционным банком Macquarie и другими кредиторами, в рамках которой может получить до $10 млрд под залог ускорителей. CoreWeave первой прибегла к схеме финансирования, при которой ИИ-ускорители используются в качестве обеспечения по кредитам и могут быть изъяты кредитором, и получила суммарно около $8,1 млрд. CoreWeave стала своеобразным индикатором для всего сектора. В июне капитализация компании взлетела до $88 млрд, но сейчас её акции упали. Также усилились опасения инвесторов из-за покупки Core Scientific за $9 млрд, растущих убытков, непогашенной задолженности в размере $7,5 млрд и грядущих расходов на оборудование. Кроме того, более ¾ выручки компании принесли всего два клиента: Microsoft (в интересах OpenAI) и NVIDIA. Банк UBS рассчитал, что в 2025 году компании по всему миру потратят на ИИ-инфраструктуру $375 млрд. В начале сентября сообщалось, что Goldman Sachs допускает крах «пузыря» ИИ на фоне бума в сфере ЦОД. Исследование компании свидетельствует, что к 2027 году мощность ЦОД вырастет на 50 % благодаря спросу на ИИ, а энергопотребление сектора удвоится уже к 2030 году. При этом эксперты отмечают, что массовое внедрение ИИ может не оправдать ожиданий инвесторов.

07.09.2025 [01:30], Владимир Мироненко

NVIDIA потратит $1,5 млрд на аренду собственных ИИ-ускорителей у Lambda, в которую сама же и инвестировалаNVIDIA, являющаяся поставщиком и инвестором Lambda, стала её крупнейшим клиентом. Как сообщает ресурс The Information, компания заключила соглашения со стартапом на общую сумму $1,5 млрд, которая пойдёт на аренду серверов, оснащённых её собственными ускорителями. По данным источников The Information, NVIDIA заключила соглашение под кодовым названием Project Comet об аренде 10 тыс. ускорителей NVIDIA сроком на четыре года на сумму около $1,3 млрд, а также отдельную сделку на $200 млн на аренду еще 8 тыс. ускорителей NVIDIA (возможно, более низкого класса или более старых моделей). Похожую сделку по аренде собственных ускорителей NVIDIA ранее заключила с CoreWeave в которую до этого она же и инвестировала. Такие сделки относятся к разряду «циклических» финансовых соглашений, используемых NVIDIA для продвижения своих чипов и оказания помощи небольшим поставщикам облачных услуг в конкуренции с традиционными гиперскейлерами. В режиме «внутреннего круговорота» ИИ-рынка NVIDIA одновременно выступает поставщиком, инвестором и заказчиком, поддерживая несколько неооблаков. По неофициальным данным, точно такая же ситуация и у AMD с TensorWave. Эти циклические соглашения подчёркивают, насколько ограниченным стало предложение мощных ускорителей. Несмотря на то, что NVIDIA доминирует в разработке и производстве чипов, она предпочитает сотрудничать с более мелкими игроками, такими как Lambda и CoreWeave, чтобы обеспечить себе доступ к готовой ИИ-инфраструктуре. Бизнес-модель Lambda такая же, как у CoreWeave. Она включает в себя аренду площадей в ЦОД, развёртывание серверов, оснащённых ускорителями NVIDIA, с последующим предоставлением мощностей в аренду. Что примечательно, NVIDIA, подобно Amazon и Microsoft, будет использовать арендуемые у Lambda серверы для собственных исследований. Контракты с Amazon и Microsoft принесли Lambda во II квартале почти $114 млн дохода. Как сообщает futunn.com, Lambda ожидает, что её выручка от облачных технологий превысит $1 млрд к 2026 году и $20 млрд к 2030 году и надеется на контракты с крупными разработчиками в сфере ИИ, такими как OpenAI, Google, Anthropic и xAI. Lambda также ожидает, что к 2030 году её мощности достигнут почти 3 ГВт, тогда как во II квартале она составляла всего 47 МВт. К этому моменту компания рассчитывает получить в своё распоряжение 1 млн ускорителей NVIDIA. Сейчас Lambda готовится к выходу на биржу, что упростит расширение деятельность за счёт заёмного финансирования. С Lambda связана и ещё одна необычная сделка — в прошлом году Supermicro, которая является одним из ключевых поставщиков Lambda, впервые арендовала дата-центр и тут же сдала его в субаренду Lambda. По словам экспертов, NVIDIA высоко оценивает сотрудничество с Lambda из-за нескольких факторов, один из которых заключается в том, что Lambda привлекает всё больше клиентов к переходу на её ускорители. Например, недавно Lambda подписала годовое соглашение со стартапом Midjourney, которое позволило ему перейти от ИИ-чипов Google TPU к ускорителям NVIDIA Blackwell. При этом Google, по слухам, тоже предлагает неооблаками свои фирменные ускорители.

04.09.2025 [16:33], Руслан Авдеев

AWS инвестирует $4,4 млрд в новозеландские облачные ЦОДAmazon (AWS) анонсировала открытие в Новой Зеландии облачного региона, а также намерение потратить более NZ$7,5 млрд ($4,4 млрд) на местные дата-центры. Впервые о плане было объявлено ещё в 2021 году, а теперь он получил «второе дыхание», сообщает Bloomberg. Для страны это достаточно значимая инвестиция. AWS создаст облачный регион AWS Asia Pacific, чтобы удовлетворить растущий спрос на облачные сервисы по всей стране. Как сообщают в AWS, строительство, эксплуатация и обслуживание дата-центров позволит ежегодно создавать более 1 тыс. рабочих мест с полной занятостью. Кроме того, увеличится валовый внутренний продукт Новой Зеландии — приблизительно на NZ$10,8 млрд. (более $6.3 млрд). Сроки инвестиций не называются. Новая Зеландия стремится стать новым «магнитом» для иностранных инвестиций в ЦОД, чтобы придать импульс местной экономике, в прошлом году погрузившейся в глубокую рецессию и до сих пор не восстановившейся. Власти специально реформировали градостроительные законы, желая ускорить выдачу разрешений на новые проекты. Кроме того, для привлечения иностранных инвесторов и предпринимателей скорректирован визовый режим. Власти отметили, что по данным Amazon, строительство в Новой Зеландии на 20 % дороже, чем в соседней Австралии, поэтому необходимо менять законы. Новый облачный регион обеспечит уже имеющимся клиентам вроде Xero и Kiwibank возможность локального выполнения любых рабочих нагрузок, локального же хранения данных и предоставления цифровых услуг с малой задержкой. Это, по мнению AWS, позволит быстрее создавать новые облачные продукты. В Новой Зеландии постепенно реализуют всё новые проекты, связанные с дата-центрами и сопутствующей инфраструктурой. Одним из важнейших стал анонсированный весной 2025 года проект Google и Vocus, желающих дотянуть до побережья страны подводный интернет-кабель Honomoana.

04.09.2025 [14:47], Руслан Авдеев

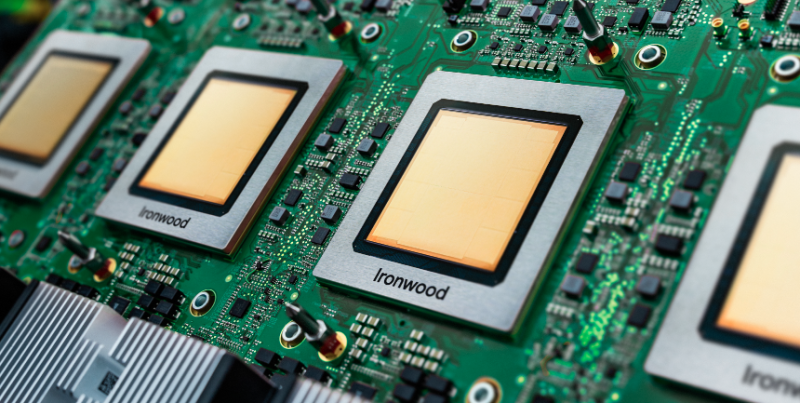

Google бросила вызов NVIDIA, предложив малым облачным провайдерам собственные ИИ-ускорители TPUПо последним данным, Google обратилась к небольшим облачным провайдерам, обычно сдающим в аренду чипы NVIDIA, с необычным предложением — сдавать в аренду её собственные ИИ-ускорители TPU, ранее доступные только в облаке самой Google, сообщает Trendforce со ссылкой на The Information. Это может привести к прямой конкуренции с NVIDIA. Сообщается, что Google уже заключила соглашение как минимум с одним поставщиком облачных сервисов — лондонской Fluidstack. Предполагается разместить TPU в нью-йоркском дата-центре последней. Fluidstack предложены льготы для расширения бизнеса за счёт TPU. Если компания не сможет покрыть расходы на аренду ЦОД в Нью-Йорке, Google обещает предоставить поддержку в объёме до $3,2 млрд. Как утверждается в отчёте, Google ориентируется на молодые компании, в основном на поставщиков облачных услуг, активных пользователей ускорителей NVIDIA. Сообщается, что она уже пыталась заключить аналогичные договоры с другими поставщиками, в настоящее время отдающими предпочтение NVIDIA — включая такие перспективные компании как Crusoe, которая строит ЦОД для OpenAI. Также возможно сотрудничество с CoreWeave, сдающей оборудование NVIDIA в аренду Microsoft (в основном для OpenAI) и также имеющей прямой контракт с OpenAI.

Источник изображения: Google Google довольно давно работает над созданием ИИ-ускорителей. По данным источников The Information, компания рассматривала возможности расширения связанного с TPU бизнеса, чтобы увеличить выручку и снизить зависимость от чипов NVIDIA. По оценкам Morningstar, совокупную стоимость бизнеса TPU и подразделения DeepMind составляет приблизительно $900 млрд. Отмечается, что вышедшие в декабре 2024 года TPU Trillium шестого поколения, весьма востребованы, ожидается и рост спроса на седьмое поколение ускорителей — TPU Ironwood. Это первая модель, разработанная для масштабного инференса. Ранее Google в основном применяла TPU для собственных проектов. Однако некоторое время назад доступность TPU для внешних заказчиков в рамках Google Cloud стала намного выше. Эти чипы использует, например, Apple. Впрочем, и она теперь хочет получить ускорители NVIDIA.

03.09.2025 [18:03], Руслан Авдеев

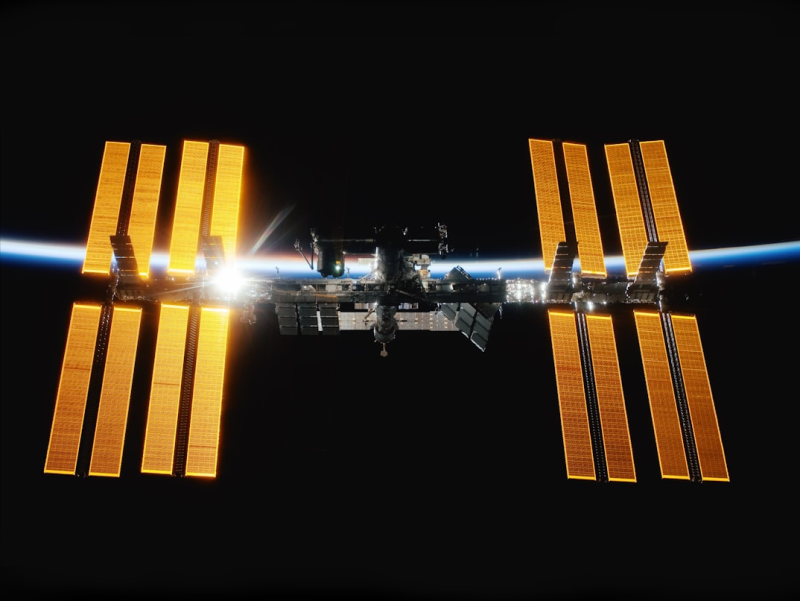

Прототип орбитального ЦОД Axiom Space и Red Hat для экспериментов с периферийными вычислениями прибыл на МКС24 августа Axiom Space и Red Hat отправили на МКС прототип орбитального ЦОД, который уже прибыл на станцию в составе 33-й коммерческой грузовой миссии SpaceX, сообщает Datacenter Knowledge. Целью эксперимента является проверка возможности автономной работы современной вычислительной инфраструктуры в космосе, не полагаясь на зависимость от дорогих спутниковых каналов связи. Новое решение оснащено модулем Axiom Space AxDCU-1, работающем на платформе Red Hat Device Edge, специально разработанной для сред с ограниченными ресурсами. Система использует облегчённый вариант Kubernetes-окружения — платформу Red Hat MicroShift, дающую возможность запускать контейнеризированные рабочие нагрузки в космосе. Задачи выполняются в контейнерах, которые можно удалённо обновлять с Земли. Ключевая особенность системы — её способность работать автономно, без постоянной связи, самостоятельно справляясь с длительными перерывами в коммуникации, которые возникают из-за быстрого движения МКС по орбите. Red Hat Device Edge решает проблему с помощью автоматического отката состояния и функций самовосстановления без вмешательства человека, а также встроенного мониторинга работоспособности и производительности. Для экономии трафика используют дельта-обновления ПО. Сообщается, что дефицит сетевых и вычислительных ресурсов всегда был проблемой на МКС, многие годы было трудно анализировать и передавать данные в режиме реального времени. Орбитальный ЦОД поможет решить эту проблему, с локальной обработкой информации и отправкой на Землю уже готовых результатов. Предполагается, что полезнее всего это будет для экспериментов в сфере естественных наук и биомедицины. В ходе таких исследований часто генерируются большие объёмы данных, но необходимость передавать их на Землю может привести к потерям более ценной и срочной информации. Axiom Space разрабатывает и собственную коммерческую станцию, которая будет оснащена значительными по меркам космоса вычислительными мощностями. По мере развития новой станции будет расти и потребность в масштабируемых, независимых вычислительных средах. «Контейнерный» подход предназначен для поддержки периферийного ИИ, автоматизации и поддержки критически важного ПО на будущих платформах. Впрочем, инновации для космоса найдут место и на Земле, где тоже немало мест с экстремальными условиями. По словам представителя компании-разработчика, извлекаемые «уроки» приносят прямую пользу — повышение надёжности критической инфраструктуры, развитие автономных систем, периферийного ИИ и др. для удалённых или ограниченных в ресурсах регионах напрямую способствуют улучшению качества жизни на Земле.

03.09.2025 [13:39], Руслан Авдеев

SAP инвестирует более €20 млрд в суверенное облако для поддержки европейских клиентовКрупнейший немецкий разработчик ПО — компания SAP объявила о намерении инвестировать в течение 10 лет более €20 млрд ($23,3 млрд) в свою суверенную облачную инфраструктуру в Европе, сообщает CNBC. Компания предложит IaaS на базе собственных дата-центров. Дополнительно будет представлена новая локальная опция, которая позволит пользоваться инфраструктурой SAP в дата-центрах заказчика. В Германии также будет доступно облако Delos Cloud. Цель новой инициативы — обеспечить хранение данных клиентов на территории Евросоюза для соблюдения правил защиты местных данных, включая GDPR. По словам SAP, инновации и суверенитет нераздельны. Он добавил, что европейским компаниям важно получить доступ к новейшим технологиям вроде ИИ в «контексте полного суверенитета». За последний год тема суверенитета стала особенно популярной, на фоне геополитических противоречий компаниям пришлось провести переоценку зависимости от иностранных технологий. Государства всё чаще стараются полагаться на локальную инфраструктуру, необходимую для обучения и эксплуатации ИИ. В результате AWS, Google и Microsoft объявили о новых сервисах в сфере суверенных облаков, призванных хранить европейские данные в ЕС. При этом Microsoft и Google выразили готовность защищать интересы европейских клиентов перед американским правительством.

Источник изображения: Carl Gruner/unsplash.com ЕС считает развитие ИИ одним из приоритетов региона — блок стремиться составить конкуренцию США и Китаю, от которых пока значительно отстаёт в этом отношении. Ранее Еврокомиссия рассказала о планах инвестировать €20 млрд в создание «ИИ-гигабафрик», оснащённых мощнейшими ИИ-суперкомпьютерами. В SAP объявили, что тесно участвуют в создании таких фабрик, но компания не будет в проекте ведущим партнёром. Представитель SAP добавил, что её инвестиции в объёме более €20 млрд, предусматриваемые для европейского суверенного облака, не повлияют на капитальные затраты компании на следующий год, они уже заложены в её финансовые планы. SAP является одним из ключевых европейских игроков в IT-сфере — компания стала самым дорогим публичным бизнесом в Европе. Примечательно, что ещё в июне 2025 года сообщалось, что SAP не видит смысла в строительстве Европой собственной облачной инфраструктуры в противовес американским гиперскейлерам. В конце мая появилась новость, что Евросоюз готов признать, что отказаться от американских облаков «почти невозможно», а в июле Synergy Research Group заявила, что доля европейских облачных провайдеров на местном рынке снизилась до 15 % и остаётся на этом уровне годами.

30.08.2025 [14:19], Руслан Авдеев

Пентагон отказался от китайских сотрудников техподдержки Microsoft, но расследование продолжается

microsoft

microsoft azure

software

аутсорсинг

госзакупки

информационная безопасность

китай

облако

пентагон

поддержка

сша

В Пентагоне осудили использование Microsoft сотрудников китайского подразделения компании для поддержки облачных сервисов Azure, развёрнутых государственными ведомствами США. Военные требуют от Microsoft провести собственное расследование и определить, были ли факты компрометации конфиденциальных данных, сообщает The Register. В июле 2025 года появилась информация, что Министерство обороны США (DoD) невольно почти 10 лет допускало Пекин к своим важнейшим системам. Часть важных задач была передана Microsoft на аутсорс китайским коллегам. При этом власти неоднократно жаловались, что Китай использует уязвимости в IT-системах для разведки и подрыва национальной безопасности США. Делегировать китайским сотрудникам работу с данными Пентагона — весьма странный шаг со стороны Microsoft. Пока ни один из конкурентов компании не признавался в аналогичной «оптимизации» рабочих процессов. По словам министра обороны США Пита Хегсета (Pete Hegseth), несмотря на то что компания специально оптимизировала свою политику работы с китайскими коллегами, чтобы та соответствовала правилам американских государственных контрактов, риск всё равно неприемлем: «Меня поражает, что я вообще говорю такое <…> и что мы вообще позволили этому случиться». Хотя в Microsoft утверждают, что за этими сотрудниками наблюдали сотрудники Пентагона с допуском к государственной тайне, Хегсет объявил о расследование вскрывшихся фактов.

Источник изображения: Jefferson Santos/unsplash.com Разработчики из Китая более не поддерживают информационные системы Министерства обороны США, но расследования Пентагона и самой Microsoft продолжаются. Военные направили Microsoft официальное письмо с «выражением обеспокоенности» и требуют независимого аудита той информации, которая была предоставлена гражданам Китая. Также само Министерство обороны намерено расследовать инцидент в поисках возможного «негативного влияния» на облачные системы Пентагона извне. Кроме того, выявить и прекратить участие китайских специалистов в обеспечении работы облачных сервисов требуют и от других поставщиков ПО военному ведомству. Однажды Microsoft уже уличили в небрежном обращении с государственными данными. В 2023 году Китай, предположительно, взломал Exchange Online Министерства торговли США и Госдепартамента, а в июле злоумышленники использовали уязвимость в Sharepoint для атаки «крупного западного правительства». По словам бывших сотрудников Белого дома, некоторые считают Microsoft угрозой национальной безопасности — удивительно, почему компания до сих пор получает средства, в том числе на обслуживание Пентагона, несмотря на регулярные провалы. Некоторые эксперты утверждают, что китайцы хорошо ориентируются в продуктах Microsoft, поэтому в случае крупного конфликта обязательно нанесут удар по критически важной инфраструктуре посредством сервисов и продуктов компании. При этом отмечается, что недавнее объявление о прекращении поддержки сервисов Microsoft специалистами из Китая касается только военного ведомства и связанных с ним сервисов, но о прекращении поддержки других госучреждений ничего не говорится. Компания лишь сообщила журналистам, что стремится предоставлять правительству «максимально безопасные услуги», включая привлечение партнёров для оценки и корректировки протоколов безопасности по мере необходимости. Предыдущие просчёты не особенно сказались на бизнесе Microsoft, при этом в результате некоторых инцидентов произошла кража конфиденциальных данных. Эксперты надеются, что Трамп разберётся с Microsoft из-за её халатного отношения к безопасности. |

|