Материалы по тегу: облако

|

18.09.2025 [18:20], Руслан Авдеев

Oracle добавит ИИ-сервисы в облако UK Sovereign Cloud в рамках инвестиционного плана на $5 млрд

hardware

oracle

oracle cloud infrastructure

великобритания

ии

инвестиции

конфиденциальность

облако

частное облако

В марте Oracle заявила, что намерена вложить $5 млрд в расширение облака Oracle Cloud Infrastructure (OCI) в Соединённом Королевстве и намерена помочь местному правительству реализовать его видение инноваций и внедрить ИИ-технологии. Теперь компания объявила, что в суверенное облако Oracle UK Sovereign Cloud добавятся и ИИ-функции, сообщает Datacenter Dynamics. Это позволит организациям, относящимся к правительственным и оборонным структурам использовать ИИ-сервисы, соблюдая требования местных законов. Предложение включает как генеративный ИИ, так и платформу ИИ-агентов OCI AI Agent Platform. Предлагаемое суверенное облако позволит создать безопасную техноплатформу для взаимодействия между США, Великобританией и структурами НАТО. В Oracle заявляют, что под руководством США страны-союзницы увеличивают инвестиции в оборону, а компания гордится тем, что предоставляет им передовую облачную и ИИ-инфраструктуру для выполнения критически важных задач как гражданских и военных властей Великобритании, так и стран блока НАТО в Европе. Представители британских властей уже заявили, что защита граждан — важнейшая задача любого правительства, а инвестиции Oracle помогают защищать страну. В компании подчеркнули, что Великобритания и США всегда «плечом к плечу» выступали против глобальных угроз общему «образу жизни». Используя ИИ предполагается гарантировать совместную с союзниками работу над этим же с использованием самых передовых средств защиты.

Источник изображения: Matt Antonioli/unsplash.com В июне 2025 года было объявлено, что НАТО займётся обновлением IT-инфраструктуры. Ответственными за это выбраны французская Thales, занимающаяся проектами в сфере обороны и кибербезопасности — она окажет помощь в интеграции, а бельгийская телеком-компания Proximus предоставит сетевые решения. С приездом главы США в Великобританию несколько американских IT-гигантов взяли на себя обязательства инвестировать в IT-развитие страны. Microsoft объявила о намерении вложить $30 млрд в IT-проекты в стране, собственные планы имеют Google, NVIDIA, OpenAI, CoreWeave и другие американские игроки.

18.09.2025 [17:16], Сергей Карасёв

Стартап Carbon3.ai намерен развернуть в Великобритании экологичную суверенную ИИ-инфраструктуруКомпания Carbon3.ai, по сообщению Datacenter Dynamics, планирует создать в Великобритании общенациональную суверенную ИИ-инфраструктуру, которая в конечном итоге будет насчитывать до 100 тыс. GPU-ускорителей. Партнёрами в рамках масштабного проекта выступают НРЕ, VAST Data и World Wide Technology (WWT). Целью инициативы является развёртывание сети ЦОД, получающих питание исключительно от возобновляемых источников энергии. Все инфраструктурные объекты будут располагаться исключительно на территории Великобритании, соответствуя стандартам национальной безопасности. Предполагается, что сеть свяжет более 50 площадок по всей стране. На сайте Carbon3.ai говорится, что проектом предусмотрено использование ИИ-ускорителей NVIDIA Blackwell для решения ресурсоёмких задач, включая обучение больших языковых моделей (LLM) и инференс. Кроме того, будет задействована программно-аппаратная платформа HPE Private Cloud AI. Carbon3.ai заявляет, что уже получила в Великобритании «значительный первоначальный капитал», рассчитывая в перспективе довести объём привлечённых средств до £1 млрд ($1,36 млрд). Предполагается, что создаваемая суверенная ИИ-инфраструктура поможет клиентам контролировать свои данные, одновременно добиваясь целей в области устойчивого развития.

Источник изображения: Carbon3.ai Нужно отметить, что на днях ряд крупных компании объявили о намерении инвестировать огромные суммы в развитие ИИ в Великобритании. Так, Microsoft планирует вложить в ИИ-проекты на территории этой страны около $30 млрд, BlackRock — примерно $678 млн, а Google — около $6,8 млрд. Кроме того, NVIDIA и партнёры инвестируют до $15 млрд в расширение британских дата-центров, создав ИИ-фабрики со 120 тыс. ускорителей Blackwell. Компания CoreWeave вложит в дата-центры для задач ИИ в Великобритании дополнительно $2 млрд.

16.09.2025 [18:07], Владимир Мироненко

NVIDIA отказалась от активного развития собственного ИИ-облака DGX CloudNVIDIA отказалась от первоначальных планов относительно будущего облачной платформы DGX Cloud, запущенной в 2023 году в партнёрстве с ведущими облачными провайдерами, для которых оно было не очень-то и выгодно. Как сообщает Data Center Dynamics со ссылкой The Information, NVIDIA прекратила предлагать платформу новым клиентам из-за более высоких цен по сравнению с предложениями самих облачных провайдеров и теперь в основном использует её для нужд собственных исследовательских подразделений. Ранее NVIDIA планировала получить $150 млрд дохода от своего облачного бизнеса и даже собиралась арендовать ЦОД для поддержания его работы. Но в отчёте о финансовых результатах NVIDIA за II квартал 2026 финансового года больше нет упоминания DGX Cloud в расходах на облако, как это было в предыдущих кварталах. Вместе с тем в компании выразили несогласие с публикацией The Information по поводу того, что сервис не оправдал ожиданий. «DGX Cloud пользуется большим успехом как облако для собственных исследований и разработок NVIDIA в области ИИ, а также как своего рода “песочница”, в которой мы работаем с облачными партнёрами над оптимизацией их вычислительных стеков и с их разработчиками ИИ-стеков на основе CUDA», — сообщила Алексис Блэк Бьорлин (Alexis Black Bjorlin), руководитель DGX Cloud, изданию The Information. Она подчеркнула, что спрос в разрезе подразделений NVIDIA остаётся высоким, и компания продолжает расширять мощности DGX Cloud. Более того, у сервиса продолжают появляться новые клиенты. В частности, стартап SandboxAQ, работающий в области квантовых вычислений и ИИ, в который инвестировала NVIDIA, сообщил в апреле об использовании для своих разработок DGX Cloud. Ранее в этом году NVIDIA представила DGX Cloud Lepton — торговую площадку, предназначенную для использования разработчиками ускорителей от таких поставщиков, как CoreWeave, SoftBank и Yotta Data Services. Несмотря на то, что это решение открыло новые способы доступа к вычислительным мощностям, оно всё же вызвало конфликты с представителями инфраструктурного бизнеса, расценившими это как попытку NVIDIA найти пути общения с их клиентами напрямую, отметил ресурс Data Center Dynamics. Тем не менее, сервис DGX Cloud Lepton позволил более мелким поставщикам оставаться в экосистеме NVIDIA. Для разработчиков переход с DGX Cloud на Lepton означает более доступную вычислительную мощность по конкурентоспособным ценам в уже используемых ими облаках, а для NVIDIA — меньше конфликтов между каналами продаж и более строгий контроль над потоком рабочих нагрузок GPU по всему миру, отмечает Tom's Hardware.

16.09.2025 [09:00], Владимир Мироненко

NVIDIA обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности за $6,3 млрдCoreWeave подписала с NVIDIA новый контракт в рамках генерального соглашения от 10 апреля 2023 года, согласно которому чипмейкер обязуется выкупить все нераспроданные CoreWeave облачные вычислительные мощности. Контракт с начальной суммой в размере $6,3 млрд действует до 13 апреля 2032 года. Об этом стало известно из документа, направленного CoreWeave в Комиссию по ценным бумагам и биржам США (SEC). На прошлой неделе NVIDIA также заключила два соглашения с Lambda общей стоимостью $1,5 млрд об аренде собственных чипов (до 18 тыс. единиц) в течение следующих четырёх лет. На фоне этой новости акции CoreWeave выросли на 8 %, поскольку для инвесторов эта сделка означает укрепление позиций компании в качестве ключевого партнёра NVIDIA в сфере облачных вычислений и служит ей своего рода защитой в случае возможного снижения спроса на вычислительные мощности для ИИ-нагрузок, пишет Reuters. «Мы считаем это позитивным фактором для CoreWeave, учитывая опасения инвесторов относительно способности компании заполнить мощности центров обработки данных за пределами двух крупнейших клиентов (Microsoft и OpenAI)», — отметили аналитики Barclays. Точный объём вычислительных мощностей не разглашается. Ранее NVIDIA уже заключала с CoreWeave соглашения об аренде её вычислительных мощностей, став вторым по величине заказчиком неооблака. Ключевым же заказчиком (62 % выручки в 2024 году) была Microsoft, которая арендовала мощности в первую очередь для OpenAI. В свою очередь CoreWeave заключила в марте с OpenAI пятилетний контракт на сумму $11,9 млрд. Спустя пару месяцев ими было подписано дополнительное соглашение на аренду вычислительных мощностей на сумму в $4 млрд сроком до апреля 2029 года. Непростые отношения Microsoft и OpenAI потенциально могут негативно сказаться на бизнесе CoreWeave. Вместе с тем активное развитие инфраструктуры на фоне высокого спроса на ИИ-вычисления привело к рекордному росту капзатрат CoreWeave, составивших во II квартале $2,9 млрд. С целью финансовой поддержки и сопровождения проектов в сфере ИИ компания сформировала венчурное подразделение.

15.09.2025 [10:20], Владимир Мироненко

Oracle предоставит НАТО суверенное облако OCI

hardware

oracle

oracle cloud infrastructure

thales

конфиденциальность

миграция

нато

облако

цод

частное облако

Американская корпорация Oracle объявила о заключении контракта с Агентством связи и информации НАТО (NCIA), в рамках которого эта организация перенесет свои критически важные рабочие нагрузки в облачную инфраструктуру Oracle Cloud Infrastructure (OCI). Процесс интеграции OCI в существующую систему НАТО будет контролироваться двумя подразделениями итальянской ИТ-компании Reply — Red Reply и Shield Reply, которые специализируются на системной интеграции и облачных оборонных сервисах соответственно. Как сообщил Филиппо Риццанте (Filippo Rizzante), технический директор Reply, Red Reply и Shield Reply предоставят полный комплекс консалтинговых и управляемых услуг — от поиска и безопасного проектирования до миграции трёх устаревших ЦОД в OCI. Французская компания Thales, специализирующаяся на обороне и кибербезопасности, будет наряду с Red Reply и Shield Reply содействовать интеграции OCI в информационную систему НАТО, гарантируя сквозную безопасность данных и координируя связанную с этим миграцию рабочих нагрузок, а бельгийская телекоммуникационная компания Proximus обеспечит расширенные сетевые возможности. «OCI поможет NCIA управлять, анализировать и защищать данные, а также предоставит больше контроля и уверенности в том, где хранятся данные и выполняются рабочие нагрузки», — заявил Ричард Смит (Richard Smith), исполнительный вице-президент по технологиям и генеральный менеджер Oracle EMEA. Как сообщает Data Center Dynamics, НАТО располагает пятью кампусами и 30 пунктами прямой поддержки по всей Европе и Северной Америке. Основные пункты расположены в Брюсселе, Брен-л'Аллё и Монсе (Бельгия), Оэйраше (Португалия) и Гааге (Нидерланды), а пункты прямой поддержки включают подразделения поддержки CIS (CSU), логистические центры и наземные станции спутниковой связи, которые обеспечивают работу сетей НАТО, проведение операций по обслуживанию, учений и ИТ-инфраструктуры.

15.09.2025 [09:24], Владимир Мироненко

Считавшаяся неудачной сделка по покупке Sun в итоге сделала Oracle облачным гигантом

exadata

hardware

oracle

oracle cloud infrastructure

sun

гиперскейлер

ии

интерконнект

облако

сделка

цод

Когда в апреле 2009 года Oracle, считавшаяся на тот момент третьей в мире по величине софтверной компанией, объявила о покупке Sun Microsystems, все расценили сделку как неудачную. Покупка обошлась в $7,4 млрд ($5,6 млрд с учётом собственных средств и долгов Sun), а решение главы Oracle Ларри Эллисона (Larry Ellison) вызвало лишь один вопрос: зачем компании, занимающейся СУБД и корпоративным ПО, покупать пришедшего в упадок производителя серверов и ПО, принимая на себя бремя расходов по ведению аппаратного бизнеса? На то, чтобы ответ на него стал очевидным, ушло почти 15 лет, приводит SiliconANGLE слова аналитика Тони Баера (Tony Baer). Многие считали, что покупка Sun подорвёт финансовое положение Oracle. Основополагающий бизнес Sun по выпуску SPARC-серверов с ОС Solaris был ослаблен из-за Linux и x86 — мало кто хотел платить за наследника UNIX и дорогое «железо», так что на момент сделки Sun ежемесячно теряла $100 млн. В действительности же всё оказалось не так уж плохо. В следующем после закрытия сделки финансовом году общая выручка Oracle (по GAAP) выросла на 33 %, в основном за счёт ПО, в то время как выручка от аппаратного бизнеса снизилась всего лишь на 6 %. Вместе с тем количество развёрнутых ПАК Oracle Exadata (Oracle Database Machine) по всему миру превысило 1 тыс. Предположительно, выручка от Exadata была учтена в разделе ПО. Если ранее Exadata использовала оборудование HP, то после приобретения Sun компания больше не зависела от сторонних производителей и вскоре её слоганом для Exadata стало «инженерные системы».

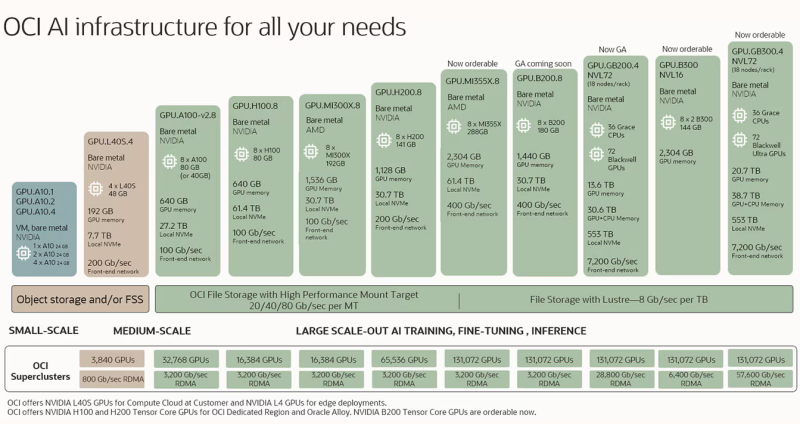

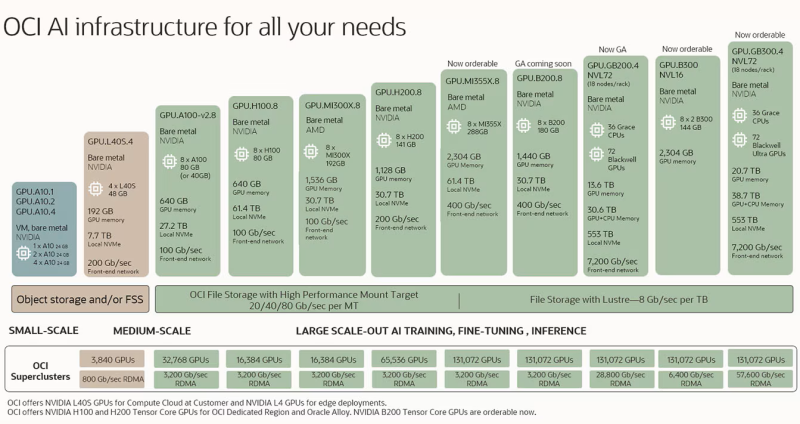

Источник изображений: Oracle Распространённое мнение сводилось к тому, что, купив Sun, Oracle выходит на серверный рынок. На самом деле, приобретение Sun привнесло в Oracle системный подход, который стал ключом не только к её растущему бизнесу по выпуску ПАК Exadata, но и к будущему облачному бизнесу, о котором компания даже не помышляла в 2009 году, отметил SiliconANGLE. Мало кто мог предсказать, что Oracle со временем станет крупным облачным провайдером. Даже сам Эллисон поначалу воспринимал эту идею скептически, назвав в 2008 году облачный бизнес «бессмыслицей». Тем не менее, в 2016 году компания запустила Oracle Cloud Infrastructure (OCI) и… всего через два года решила полностью поменять облачную архитектуру, поняв, что текущая ничем не отличается от AWS, Microsoft Azure или Google Cloud. В частности, для повышения безопасности была обеспечена полная изоляция кода и данных клиентов, а для повышения производительности и масштабируемости была упрощена топология и внедрена поддержка RDMA. Кроме того, Oracle не только опиралась на опыт Sun, но и агрессивно переманивала специалистов AWS и Azure. И хотя сейчас практически каждый гиперскейлер использует ускорители NVIDIA, только OCI может объединить их в суперкластеры из 131 тыс. чипов, а с недавних пор и ускорители AMD. Облачный сервис Oracle Exadata также выиграл: учитывая спрос клиентов и тот факт, что ни один гиперскейлер не может повторить оптимизацию RDMA-интерконнекта, которую сделала Oracle, инфраструктура Exadata теперь размещена как нативный сервис у всех трёх гиперскейлеров в их же ЦОД. За последний год выручка от баз данных MultiCloud выросла более чем в 15 раз. 10 сентября акции Oracle показали рекордный за 26 лет рост, и не столько из-за увеличения выручки, которая оказалась ниже ожиданий Уолл-стрит, сколько благодаря развитию её облачной инфраструктуры. Объём оставшихся обязательств по контрактам (RPO) компании вырос год к году на 359 % до $455 млрд. В тот же день было объявлено о сделке с Open AI на сумму в $300 млрд, вместе с которой Oracle участвует в проекте Stargate. И хотя RPO Oracle намного выше показателей её конкурентов среди гиперскейлеров, она значительно уступает им по размерам дохода, поскольку компании приходится направлять значительно большую часть средств на капитальные вложения. Существуют опасения, что ажиотаж вокруг ИИ может повторить ситуацию с пузырём доткомов. Oracle хеджирует свои риски, не покупая здания или недвижимость для облачных регионов OCI. Оборудование и инфраструктура закупаются только по факту поступления заказов, но большая ставка на одного клиента — Open AI — ставит под сомнение устойчивость её позиций, пишет SiliconANGLE. Кроме того, есть вероятность, что и заказы остальных клиентов будут реализованы в полном объёме. Тем не менее, 15 лет назад вряд ли кто бы подумал, что приобретение Sun Microsystems преобразит Oracle. Хотя в то время серверный бизнес Sun переживал упадок, у неё был системный опыт, который изменил ход событий. И в долгосрочной перспективе именно опыт Sun запустил перемены в основном бизнесе Oracle, превратив поставщика корпоративного ПО в успешного провайдера облачной инфраструктуры.

13.09.2025 [14:01], Сергей Карасёв

Облачные Mac'и с Nitro: AWS запустила инстансы EC2 M4 Mac и M4 Pro MacОблачная платформа AWS анонсировала инстансы EC2 M4 Mac и EC2 M4 Pro Mac на основе компьютеров небольшого форм-фактора Apple Mac Mini с фирменными процессорами семейства M4. Новые экземпляры приходят на смену EC2 M2 Mac, которые были доступны с сентября 2023 года. Инстансы EC2 M4 Mac базируются на модификации Mac Mini с процессором M4. Этот чип объединяет 10 ядер CPU (четыре производительных и шесть энергоэффективных), 10 ядер GPU и 16-ядерный движок Neural Engine. Объём унифицированной памяти составляет 24 Гбайт, а её пропускная способность достигает 120 Гбайт/с. Утверждается, что на задачах сборки приложений экземпляры EC2 M4 Mac обеспечивают на 20 % более высокую производительность по сравнению с EC2 M2 Mac. В свою очередь, инстансы EC2 M4 Pro Mac используют мини-компьютеры Mac Mini с процессором M4 Pro, который содержит 12 ядер CPU (восемь производительных и четыре энергоэффективных), 16 ядер GPU и 16-ядерный движок Neural Engine. В оснащение входят 48 Гбайт унифицированной памяти с пропускной способностью до 273 Гбайт/с. По сравнению с EC2 M2 Pro Mac быстродействие на операциях сборки приложений увеличилось на 15 %.

Источник изображения: Apple Инстансы EC2 M4 Mac и EC2 M4 Pro Mac предполагают наличие локального хранилища вместимостью 2 Тбайт. Применяется система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Благодаря подключению посредством интерфейса Thunderbolt обеспечивается пропускная способность VPC (Virtual Private Cloud) до 10 Гбит/ с и пропускная способность EBS (Elastic Block Store) до 8 Гбит/с. Новые экземпляры совместимы с macOS Sonoma 15.6 и выше. Говорится о простоте интеграции с другими сервисами AWS. Инстансы EC2 M4 Mac и EC2 M4 Pro Mac уже доступны в регионах US East (Северная Вирджиния) и US West (Орегон), а в перспективе география охвата будет расширяться.

13.09.2025 [13:43], Сергей Карасёв

Microsoft расширит вычислительные мощности для обучения собственных ИИ-моделейКорпорация Microsoft, по сообщению Bloomberg, намерена расширить свою вычислительную инфраструктуру для обучения собственных моделей ИИ, которые, как ожидается, смогут составить конкуренцию решениям OpenAI, Anthropic и других ведущих игроков соответствующего рынка. На общем собрании сотрудников Microsoft руководитель потребительского направления ИИ Мустафа Сулейман (Mustafa Suleyman) заявил, что корпорация сделает «значительные инвестиции» в собственные ИИ-кластеры. По его словам, для Microsoft важно иметь возможность быть самодостаточной в области ИИ, если того потребует рыночная ситуация. Вместе с тем, как подчёркивает Сулейман, Microsoft придерживается подхода, предполагающего создание собственных ИИ-продуктов при одновременном углублении связей с OpenAI и поддержании отношений с другими участниками отрасли. В частности, Microsoft и OpenAI останутся партнёрами как минимум до 2030 года. Это сотрудничество предполагает, что OpenAI продолжит использовать облачные сервисы Azure, тогда как Microsoft сохранит доступ к интеллектуальной собственности OpenAI, включая ИИ-модели. Впрочем, компании ещё могут пересмотреть договор. Сулейман, являющийся соучредителем Google DeepMind, присоединился к Microsoft в 2024 году. В прошлом месяце редмондская корпорация представила первые собственные ИИ-модели — MAI-Voice-1 и MAI-1-preview, которые были созданы под руководством Сулеймана. Их обучение проходило на 15 тыс. ускорителей NVIDIA H100. Подчёркивается, что конкуренты вроде Meta✴, Google и xAI для выполнения таких задач используют кластеры в 6–10 раз больше: это, по мнению Microsoft, говорит о высокой эффективности её ИИ-моделей. В целом, Microsoft в 2025 финансовом году намерена инвестировать около $80 млрд в создание дата-центров для ИИ-нагрузок. Кроме того, корпорация подписала пятилетнее соглашение стоимостью почти $20 млрд на использование вычислительной ИИ-инфраструктуры компании Nebius (бывшая Yandex N.V.).

12.09.2025 [11:35], Сергей Карасёв

150 кВт на стойку для тестов: Digital Realty открыла лабораторию DRIL для ускорения внедрения ИИ и гибридного облакаОператор дата-центров Digital Realty объявил об открытии лаборатории инноваций DRIL (Digital Realty Innovation Lab) — специализированной тестовой площадки, призванной ускорить внедрение ИИ и гибридного облака. Партнёрами в рамках данного проекта являются Lenovo, AMD, Cisco и CommScope, которые предоставляют различные аппаратные и инфраструктурные решения. Отмечается, что ИИ оказывает преобразующее влияние на самые разные отрасли. Однако при его масштабном развёртывании предъявляются высокие требования к инфраструктуре ЦОД в плане обеспечения необходимой производительности при одновременной оптимизации энергопотребления. Площадка DRIL призвана помочь компаниям в создании сложных архитектур, ориентированных на ресурсоёмкие задачи ИИ. DRIL предоставляет партнёрам и клиентам полностью поддерживаемую реальную тестовую среду для апробации ИИ-развёртываний и гибридных облачных сред перед их масштабированием. Компании могут запускать собственные рабочие нагрузки с целью проверки эффективности и оптимизации.

Источник изображения: Digital Realty Лаборатория DRIL сформирована на базе кампуса Digital Realty в Северной Вирджинии. На площадке, оснащённой серверами с процессорами AMD EPYC и ускорителями AMD Instinct, могут тестироваться рабочие нагрузки ИИ и HPC. Говорится о высокоплотном размещением оборудования — свыше 150 кВт на серверную стойку. Задействована технология прямого жидкостного охлаждения (DLC) Lenovo Neptune. Лаборатория DRIL, как подчёркивается, позволяет компаниям раскрыть весь потенциал ИИ и корпоративных рабочих нагрузок, даже если у них нет собственного дата-центра с современным оборудованием. Используя DRIL, клиенты могут снизить риски, оптимизировать конфигурацию своих систем и ускорить переход от этапа проверки концепции к фактическому внедрению. Предприятия могут тестировать различные сценарии задержек в разных локациях, оценивать требования к питанию, охлаждению и GPU-ресурсам, а также управлять ИИ-нагрузками.

10.09.2025 [18:51], Владимир Мироненко

Новость о заказах на $0,5 трлн привела к рекордному за 26 лет росту акций OracleOracle сообщила финансовые результаты I квартала 2026 финансового года, закончившегося 31 августа 2025 года. Несмотря на то, что прибыль и выручка оказались ниже прогнозов Уолл-стрит, акции Oracle взлетели на 27 %, продемонстрировав самый большой однодневный рост за 26 лет (с июня 1999 года, согласно данным FactSet, приведенным SiliconANGLE), поскольку инвесторов впечатлил её прогноз по доходам от облачных технологий, сообщил CNBC. Основатель компании Ларри Эллисон (Larry Ellison) стал самым богатым человеком Земли — благодаря росту акций его доля в Oracle теперь оценивается в $393 млрд. Общая выручка за I квартал составила $14,93 млрд увеличившись год к году на 12 % при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $15,04 млрд. Скорректированная чистая прибыль (Non-GAAP) за квартал выросла на 8 % до $4,28 млрд или $1,47 на разводнённую акцию, что ниже консенсус-прогноза от LSEG в размере $1,48 на разводнённую акцию. Чистая прибыль (GAAP) осталась на прежнем уровне, составив $2,93 млрд, или $1,01 на акцию, по сравнению с $2,93 млрд, или $1,03 на акцию, за аналогичный квартал предыдущего финансового года. Выручка облачного сегмента составила 7,19 млрд, в том числе выручка от облачной инфраструктуры (OCI, IaaS) — $3,3 млрд (рост год к году на 55 %), выручка от облачных приложений — (OCA, SaaS) — $3,8 млрд (рост — 11 %). Выручка от разработки ПО равняется $5,72 млрд (снижение на 1 %). Продажи оборудования выросли на 2 % до $670 млн, сервисы принесли компании $1,35 млрд (рост — 7 %). Во II финансовом квартале Oracle ожидает общую скорректированную прибыль (Non-GAAP) на акцию в размере $1,61–1,65 при росте выручки на 14–16 %. Аналитики прогнозируют прибыль в размере $1,62 на акцию при выручке в $16,21 млрд, что предполагает рост на 15 %. Гендиректор Oracle Сафра Кац (Safra Catz) сообщила, что в отчётном квартале компания подписала четыре многомиллиардных контракта с тремя клиентами. В результате объём оставшихся обязательств по контрактам (RPO) вырос год к году на 359 % до $455 млрд. Она отметила, что спрос на инфраструктуру будет расти и дальше. «В ближайшие несколько месяцев мы ожидаем привлечения нескольких новых многомиллиардных клиентов, и RPO, вероятно, превысит полтриллиона долларов», — сообщила Кац.  По её словам, такой рост показателя RPO позволяет компании существенно пересмотреть свой долгосрочный прогноз выручки от облачной инфраструктуры в сторону повышения. Она сообщила, что выручка от OCI, как ожидается, достигнет $18 млрд в текущем финансовом году, затем вырастет до $32 млрд в 2027 финансовом году, до $73 млрд в 2028 финансовом году, до $114 млрд в 2029 финансовом году и до $144 млрд к 2030 финансовому году. Прогноз Evercore на 2029 год чуть меньше — $108 млрд выручки. Прогноз Oracle демонстрирует существенный рост её облачного бизнеса по сравнению с основными конкурентами. В июле корпорация Microsoft сообщила о выручке от Azure за 12 месяцев в размере $75 млрд, в то время как выручка AWS за тот же период составила около $112 млрд. Капитальные затраты Oracle в 2026 финансовом году составят около $35 млрд, что соответствует росту на 65 %, сообщила Кац. Однако затраты других игроков намного выше. По словам Дэйва Велланте (Dave Vellante), главного аналитика CUBE Research (SiliconANGLE Media), цифры свидетельствуют о том, что Oracle вошла в число гиперскейлеров. «Бизнес набирает обороты, поэтому инвесторы не будут обращать внимания на этот квартал», — отметил он. Аналитик Valoir Ребекка Веттеманн сообщила SiliconANGLE, что цифры отражают то, что огромные инвестиции Oracle в облачную инфраструктуру за последние несколько лет действительно начинают ей приносить дивиденды: «Рынок реагирует как на уверенность Oracle, так и на её квартальные отчёты». «Oracle прогнозирует рост прибыли в сфере инфраструктуры на годы вперёд, что действительно необычно для этой отрасли, особенно учитывая неопределённость относительно объёма и роста будущих рабочих ИИ-нагрузок, зависящих от облачной инфраструктуры», — добавила аналитик. Председатель и технический директор Oracle Ларри Эллисон (Larry Ellison) сообщил, что выручка от баз данных MultiCloud в облаках Amazon, Google и Azure в I финансовом квартале росла невероятными темпами — на 1529 %.«Мы ожидаем, что выручка от MultiCloud будет существенно расти каждый квартал в течение нескольких лет, поскольку мы предоставим ещё 37 ЦОД нашим трём партнёрам-гиперскейлерам, доведя их общее количество до 71», — завил он. В октябре корпорация представит облачный сервис Oracle AI Database, который позволит клиентам использовать выбранную ими LLM, включая Gemini, ChatGPT, Grok и т.д., непосредственно поверх Oracle Database для лёгкого доступа и анализа всей информации в базах данных. «Этот революционный облачный сервис позволит десяткам тысяч наших клиентов мгновенно раскрывать ценность своих данных, делая их легкодоступными для самых передовых ИИ-моделей. Oracle AI Cloud Infrastructure и Oracle MultiCloud AI Database внесут свой вклад в резкое увеличение спроса и потребления облачных услуг в течение следующих нескольких лет. ИИ меняет всё», — заявил Эллисон. |

|