Материалы по тегу: ии

|

18.09.2025 [14:48], Сергей Карасёв

Huawei раскрыла планы по выпуску ИИ-ускорителей AscendКитайская компания Huawei, по сообщению The Register, в ходе своей ежегодной конференции Connect обнародовала планы по выпуску ИИ-ускорителей Ascend следующего поколения. Готовящиеся изделия призваны составить конкуренцию передовым чипов NVIDIA, поставки которых в КНР запрещены и США, и ограничены самим Китаем. В настоящее время Huawei предлагает ускоритель Ascend 910C, который позиционируется в качестве конкурента NVIDIA H100: решение обеспечивает производительность на уровне 800 Тфлопс (FP16) и пропускную способность памяти до 3,2 Тбайт/с. Ранее также говорилось о подготовке более производительного изделия Ascend 910D. Как теперь стало известно, в I квартале 2026 года Huawei представит ускоритель Ascend 950PR, который обеспечит производительность до 1 Пфлопс на операциях FP8. Устройство получит 128 Гбайт памяти с пропускной способностью 1,6 Тбайт/с, тогда как скорость интерконнекта составит до 2 Тбайт/с. В последней четверти следующего года ожидается выход решения Ascend 950DT, которое сможет демонстрировать быстродействие на уровне 2 Пфлопс на операциях FP4. Этот ускоритель будет оборудован 144 Гбайт памяти с пропускной способностью 4 Тбайт/с.

Источник изображения: Huawei В 2027 году Huawei планирует выпустить ускоритель Ascend 960: в его оснащение войдут 288 Гбайт памяти с пропускной способностью до 9,6 Тбайт/с. А на 2028-й намечен дебют модели Ascend 970, память которой сможет работать со скоростью 14,4 Тбайт/с. Как отмечает The Register, указанные показатели пропускной способности могут свидетельствовать о том, что Huawei проектирует собственную память HBM. Кроме того, Huawei сообщила о подготовке мощных ИИ-систем SuperPOD, объединяющих 8192 и 15 488 ускорителей Ascend. На основе таких платформ будут формироваться суперкластеры, насчитывающие до 500 тыс. и более экземпляров Ascend. Разработки Huawei имеют большое значение в плане развития ИИ-мощностей в Китае в свете напряжённых отношений с США. На днях стало известно, что Государственное управление по регулированию рынка КНР (SAMR) обвинило NVIDIA в нарушении антимонопольного законодательства. Кроме того, Китай запретил местным компаниям размещать заказы на разработанный специально для Поднебесной ускоритель NVIDIA RTX Pro 6000D.

18.09.2025 [12:43], Руслан Авдеев

China Unicom построила в Китае «огромный» ЦОД с ИИ-ускорителями местного производства — Alibaba T-Head предоставила 16 тыс. PPUКитайский телеком-гигант China Unicom построил «огромный» дата-центр на основе ИИ-ускорителей производства КНР. Новый ЦОД использует чипы, разработанные Alibaba и другими местными компаниями, сообщает Reuters. Объект находится в Синине (Xining) провинции Цинхай (Qinghai). В его строительство вложено порядка $390 млн. Подробные данные о мощности ЦОД пока отсутствуют. По словам местных властей, после полного завершения строительства вычислительная мощность составит 20 Эфлопс, пока же речь идёт о 3,579 Пфлопс. За работу отвечают 23 тыс. чипов местного производства. Точность вычислений не указывается, но вряд ли речь идёт об FP64. По имеющимся данным 72 % чипов разработаны подразделением T-Head компании Alibaba, прочие предоставили компании MetaX, Biren Tech и Zhonghao Xinying. В будущем планируется использовать и чипы стартапов Tecorigin, Moore Threads и Enflame. T-Head также разработала 400-Вт ускорители PPU, имеющие 96 Гбайт HBM2e, интерфейс PCIe 5.0 и 700-Гбайт/с межчиповый интерконнект. Благодаря этому они могут стать конкурентами популярным в Китае, специально ослабленным для местного рынка чипам NVIDIA H20. Ранее в этом месяце Alibaba заявила о разработке нового ускорителя для ИИ-инференса. Сейчас чип проходит тестирование и выпускается китайским производителем. China Unicom получила 16 384 T-Head PPU общей производительностью 1,945 Эфлопс.

Источник изображения: Wang shaohong/unsplash.com Китай активно продвигает широкое внедрение чипов местного производства. 17 сентября интернет-регулятор из КНР запретил ключевым IT-гигантам тестировать и размещать заказы на разработанный специально для Китая ускоритель NVIDIA RTX Pro 6000D. За несколько дней до этого по итогам расследования Государственного управления по регулированию рынка Китая (SAMR) до власти обвинили NVIDIA в нарушении антимонопольного законодательства при покупке Mellanox. Ограничения последовали со стороны китайских властей после того, как местное правительство издало директиву, обязывающую государственные компании, действующие на рынке ЦОД, закупать более 50 % чипов у местных производителей.

18.09.2025 [12:42], Руслан Авдеев

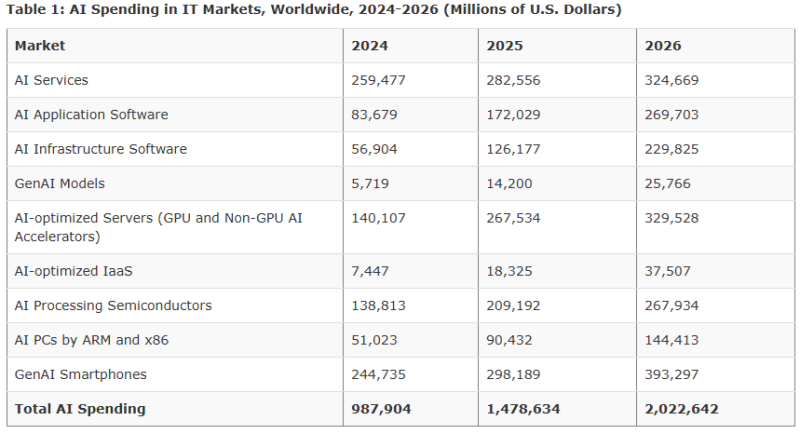

Gartner: в 2026 году расходы на ИИ превысят $2 трлн благодаря инвестициям гиперскейлеровПо прогнозам экспертов, уже в этом году глобальные затраты на ИИ приблизятся к $1,5 трлн, а в 2026 году превысят и $2 трлн. Это произойдёт на фоне неугасающего спроса на строительство новой ИИ-инфраструктуры, сообщает IEEE ComSoc со ссылкой на исследование Gartner. Драйверами столь значительного спроса выступают гиперскейлеры, продолжающие вкладывать средства в строительство ИИ ЦОД, покупку оборудования и комплектующих, включая ИИ-ускорители, а также повсеместное внедрение ИИ в пользовательские устройства. Как заявляют в Gartner, ожидается продолжение инвестиций в расширение ИИ-инфраструктуры, поскольку ключевые гиперскейлеры продолжают наращивать затраты. Инвесторами сегодня выступают не только «традиционные» американские техногиганты, но и компании из Китая и «новые» облачные ИИ-провайдеры вроде Oracle. Более того, способствуют развитию рынка и инвестиции венчурных капиталистов. По некоторым данным, в 2026 году ожидается массовая интеграция ИИ в продукты вроде смартфонов и ПК. Такие смартфоны будут получать чипсеты с мощными нейропроцессорами (NPU), способными запускать довольно производительные ИИ-модели непосредственно на устройствах. Это позволит генерировать контент, расширить возможности ИИ-ассистентов и др. Это тоже способствует общему росту расходов, поскольку многие производители интегрируют такие функции буквально «по умолчанию».

Источник изображения: Gartner По прогнозам IDC, смартфоны с поддержкой генеративного ИИ будут занимать к 2028 году 54 % рынка, а Gartner ожидает, что около 100 % моделей премиум-уровня получат соответствующую функциональность к 2029 году — это увеличить как поставки, так и расходы пользователей. Всё чаще вкладывает средства в решения на основе искусственного интеллекта и бизнес в целом. Впрочем, в этой нише отмечается скорее покупка готовых решений «с полки», чем разработка кастомных продуктов на основе генеративного ИИ. Значительная часть роста приходится на продажи ИИ-оборудования, включая ИИ-ускорители различных типов. По некоторым данным, это почти удвоит рынок ИИ-серверов в 2025 году. В марте Bloomberg Intelligence сообщалось, что ежегодные затраты техногигантов на ИИ превысят $500 млрд уже в следующем десятилетии. Причём большая часть денег пойдёт на инференс.

18.09.2025 [10:52], Сергей Карасёв

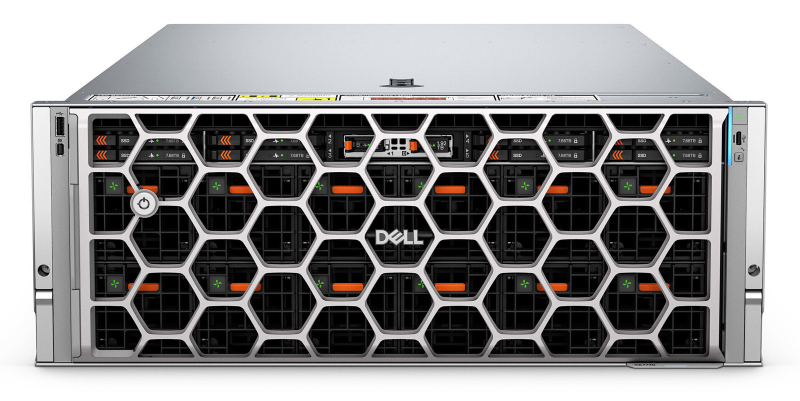

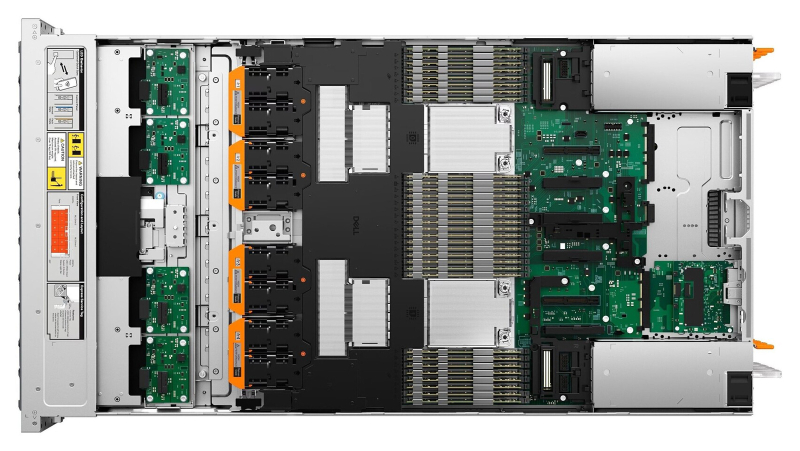

Dell представила ИИ-сервер PowerEdge XE7740 с ускорителями Intel Gaudi 3Компания Dell полностью раскрыла характеристики стоечного сервера PowerEdge XE7740, о подготовке которого впервые стало известно в ноябре 2024 года. Новинка ориентирована на решение ресурсоёмких задач в области ИИ, включая тонкую настройку больших языковых моделей (LLM), инференс, распознавание изображений и речи, выявление мошенничества в сфере финансовых услуг и пр. Сервер, выполненный в форм-факторе 4U, рассчитан на установку двух процессоров Intel Xeon 6 поколения Granite Rapids-SP, которые могут насчитывать до 86 вычислительных ядер. Доступны 32 слота для модулей DDR5-6400 суммарным объёмом до 4 Тбайт. Во фронтальной части расположены восемь отсеков для NVMe SSD стандарта E3.S вместимостью до 122,88 Тбайт. Кроме того, доступны два внутренних коннектора M.2 для загрузочных NVMe-накопителей. Машина может нести на борту до восьми ИИ-ускорителей Intel Gaudi 3. В зависимости от конфигурации возможна установка восьми карт FHFL двойной ширины (до 600 Вт) с интерфейсом PCIe 5.0 x16 или 16 карт FHFL одинарной ширины (75 Вт). Кроме того, есть слот OCP NIC 3.0. Сервер оборудован системой воздушного охлаждения. За питание отвечают блоки мощностью 3200 Вт с сертификатом 80 PLUS Titanium. На лицевую панель выведены по одному порту USB 2.0 Type-A (iDRAC/BMC Direct), USB 2.0 Type-A (опционально) и Mini-DisplayPort. Сзади расположены два порта USB 3.1 Type-A, коннектор D-Sub и выделенный Ethernet-порт (iDRAC). Габариты составляют 899,56 × 482,0 × 174,3 мм, масса — 71,35 кг. Заявлена совместимость с Ubuntu Server LTS, Red Hat Enterprise Linux, SUSE Linux Enterprise Server и VMWare ESXi.

17.09.2025 [23:52], Владимир Мироненко

Глава NVIDIA разочарован запретом Китая на покупку RTX Pro 6000D, но все вопросы будут решаться на высшем уровнеВ Китае вынесли запрет компаниям, включая ByteDance и Alibaba, на тестирование и размещение заказов на разработанный специально для Поднебесной ускоритель NVIDIA RTX Pro 6000D, сообщила в среду Financial Times со ссылкой на источники, знакомые с ситуацией. За несколько дней по итогам расследования Государственного управления по регулированию рынка Китая (SAMR) до власти обвинили NVIDIA в нарушении антимонопольного законодательства при покупке Mellanox. По словам источника, запрет Государственной канцелярии интернет-информации КНР (CAC) поступил после проведения сравнения чипов, изготавливаемых компаниями Huawei и Cambricon, а также Alibaba и Baidu, с продукцией NVIDIA. В итоге регулятор пришёл к выводу, что китайские ИИ-чипы достигли уровня, сопоставимого или превосходящего уровень продукции NVIDIA, разрешённой к экспорту в Китай. В прошлом месяце Financial Times сообщила о планах китайских производителей чипов утроить объём производства ИИ-ускорителей в стране в следующем году.

Источник изображения: NVIDIA | NVIDIA RTX PRO 6000 Blackwell Server Edition Ускоритель RTX Pro 6000D был представлен в июле во время визита гендиректора компании Дженсена Хуанга (Jensen Huang) в Пекин. Тогда же NVIDIA заявила, что Вашингтон ослабляет ранее введенный запрет на экспорт в страну ускорителей H20. Financial Times сообщила, что китайские регулирующие органы в ответ на ослабление ограничений со стороны США ужесточили контроль закупок H20, требуя от компаний предоставить обоснование решения купить эти чипы вместо отечественной продукции. При этом RTX Pro 6000D спросом не пользуется. Комментируя запрет Пекина, Дженсен Хуанг заявил, что разочарован этим. «Мы можем служить рынку, только если страна этого хочет», — сказал он. «Мы рекомендовали всем финансовым аналитикам не включать Китай» в финансовые прогнозы, заявил Хуанг, пояснив, что этот вопрос «в значительной степени будет обсуждаться правительствами США и Китая».

17.09.2025 [23:12], Руслан Авдеев

CoreWeave инвестирует ещё £1,5 млрд в британские ИИ ЦОДCoreWeave намерена инвестировать £1,5 млрд ($2 млрд) в ИИ ЦОД на территории Великобритании. Инвестиции дополняют прежние обязательства вложить £1 млрд ($1,4 млрд) и предусматрвиают развёртывание новых мощностей в ЦОД DataVita в Шотландии, сообщает Datacenter Dynamics. Анонс относится к целой серии инвестиций американских IT-компаний в ИИ-сектор Великобритании — общий объём превышает $40 млрд. Как сообщают в CoreWeave, инвестиции в Великобританию позволят создать одну из крупнейших в мире зон концентрации современных, устойчивых вычислений. Это откроет новые возможности для инноваций, экономического роста и научных открытий, а также позволит обеспечить «непревзойдённую» производительность ИИ с минимальным воздействием на окружающую среду. CoreWeave намерена развернуть ускорители NVIDIA Grace Blackwell Ultra в одном из ЦОД DataVita в Шотландии. DataVita управляет дата-центром DV1 площадью 8 тыс. м2 мощностью до 40 МВт и дата-центром DV2 площадью 1 тыс. м2 мощностью 1 МВт. При развёртывании будут использоваться возобновляемые источники энергии и замкнутые системы охлаждения. В ЦОД можно разместить стойки мощностью до 200 кВт.

Источник изображения: Kristina Gadeikyte Gancarz/unsplash.com В DataVita подчёркивают, что сотрудничество укрепляет роль Шотландии как движущей силы экономики Соединённого Королевства. Благодаря устойчивой платформе компании у Шотландии есть все возможности стать центром реализации британских амбиций в сфере ИИ. Это будет способствовать инновациям, стимулировать экономический рост и поддерживать Великобританию в роли мирового лидера в сфере ИИ. На других объектах CoreWeave намерена развернуть ускорители NVIDIA GB300 и RTX PRO Blackwell Server Edition. В январе компания заняла помещения дата-центрах Digital Realty и Global Switch в Лондоне. По словам премьер-министра страны Кира Стармера (Keir Starmer), искусственный интеллект станет причиной невероятных изменений в стране и обладает потенциалом преобразовать государственные услуги и её инфраструктуру в целом.

17.09.2025 [17:21], Руслан Авдеев

xAI готовится установить рекорд по созданию гигаваттного ИИ ЦОД Colossus 2Хотя 300-МВт ИИ-суперкомпьютер Colossus 1 с десятками тысяч ускорителей стал крупнейшим из функционирующих объединённых кластеров (не считая платформ Google на собственных чипах TPU), компания xAI задаёт новые стандарты проектом Colossus 2. На этот раз xAI готовится потягаться с конкурентами вроде OpenAI, Meta✴ и Anthropic, уже строящих кампусы гигаваттного уровня, сообщает SemiAnalysis. По оценкам аналитиков, новый единый ИИ-кластер xAI превзойдёт аналогичные проекты Meta✴ и Anthropic уже в III квартале 2025 года. Мощности будут готовы для установки ускорителей и создания крупнейшего отдельного кампуса ЦОД в мире. Для покупки чипов xAI ещё предстоит привлечь средства, но квоты на ускорители NVIDIA уже выделила, так что в начале 2026 года можно начать полнофункциональное обучение новых моделей. Работа над Colossus 2 стартовала в марте 2025 года, когда xAI приобрела огромный склад в Мемфисе и две прилегающих площадки общей площадью около 40 га. К 22 августа эксперты насчитали у объекта 119 чиллеров, что примерно соответствует 200 МВт холодоснабжения. Этого достаточно, чтобы обеспечить работу около 110 тыс. GB200 NVL72. По словам главы компании Илона Маска (Elon Musk), часть суперускорителей была развёрнута уже в июле. Утверждается, что за 6 мес. компания сделала то, на что у Oracle, Crusoe и OpenAI ушло 15. Для питания кластера компания выбрала необычную схему. Ранее xAI пообещала не ставить в Мемфисе новые газовые турбины, поскольку столкнулась с активным противодействием экологов и местного населения, и не солгала. Энергетический хаб для Colossus 2 просто разместили «через дорогу» — в штате Миссисипи. В середине 2025 года компания приобрела бывшую электростанцию Duke Energy в Саутхейвене (Southaven), а власти штата дали временное разрешение на использование газовых генераторов до 12 месяцев без специальных бюрократических процедур. Для транспортировки, хранения и распределения энергии строит инфраструктуру, включающую энергохранилища Tesla Megapack и ЛЭП. Для Colossus 2 в Саутхейвене развёрнуто семь турбин Titan 350 общей мощностью 266 МВт. xAI прибегла к аренде генераторов, в частности, у Solaris Energy Infrastructure (SEI). У последней имеются имются газовые турбины общей мощностью 600 МВт, из которых 400 МВт выделено xAI. Общий объём заказов SEI составлят 1,7 ГВт, из которых ⅔ приходится на xAI (1,14 ГВт). Из них 240 МВт отведено для питания Colossus 1 (уже установлено 12 турбин Titan 130 общей мощностью 198 МВт). Оставшиеся 900 МВт получит совместное предприятие Solaris (50,1 %) и xAI (49,9 %). xAI настолько спешит, что часть турбин Solaris сама временно арендовала у других компаний. Капитальные издержки нового бизнеса составили $112 млн во II квартале 2025 года. Solaris рассчитывает, что ко II кварталу 2027 году она сможет предоставить xAI генераторы мощностью более 1,1 ГВт. xAI оставила за собой право дозаказать у Solaris ещё 425 МВт и, вероятно, воспользуется этой возможностью, доведя совокупную мощность генераторов до более чем 1,5 ГВт. Впрочем, запросы будут зависеть от итоговой конфигурации ЦОД. По оценкам SemiAnalysis, у xAI есть несколько вариантов создания единого дата-центра мощностью более 1 ГВт. Будущее проекта предсказать довольно трудно, но с учётом нужды в средствах, не исключена масштабная экспансия на Ближний Восток, с которым Маск имеет довольно тесные связи. Так, саудовская Kingdom Holding Company, фактически контролируемая государством, владела долей в Twitter в 2022 году. Ей же принадлежала $800-млн доля в xAI до её слияния с X. В подконтрольные Маску структуры инвестировали частная Vy Capital, государственный фонд MGX из ОАЭ, катарская QIA и др. По некоторым данным, xAI готовит новый раунд финансирования при оценке компании в $200 млрд, где инвесторы Ближнего Востока могут сыграть немалую роль.

17.09.2025 [13:15], Сергей Карасёв

NVIDIA и партнёры развернут в Великобритании ИИ-фабрики со 120 тыс. ускорителей BlackwellКомпания NVIDIA, как и ожидалось, объявила о масштабных инвестициях в развитие ИИ-инфраструктуры в Великобритании. Инициатива будет реализовываться совместно с партнёрами, в число которых входят Microsoft, оператор ИИ-облака CoreWeave и британский поставщик ИИ-инфраструктуры Nscale. Речь идёт о создании ИИ-фабрик, которые смогут поддерживать наиболее ресурсоёмкие нагрузки, в том числе модели OpenAI. Предполагается, что создание таких площадок позволит Великобритании достичь своих государственных целей в области ИИ и развития инноваций. В рамках масштабного проекта NVIDIA и партнёры инвестируют до £11 млрд ($15 млрд) в расширение британских дата-центров. В общей сложности будут установлены 120 тыс. мощных ускорителей Blackwell Ultra, что станет крупнейшим подобным развёртыванием в истории Великобритании. Компании Nscale, OpenAI и NVIDIA участвуют в программе Stargate UK, предполагающей формирования платформы для передовых ИИ-моделей, в том числе GPT-5.

Источник изображения: NVIDIA Nscale и Microsoft также объявили о планах строительства самого мощного британского суперкомпьютера. Ожидается, что он будет оснащён более чем 24 тыс. ускорителей Grace Blackwell Ultra. Платформу планируется использовать в том числе для предоставления сервисов Microsoft Azure в Великобритании. Кроме того, NVIDIA поможет компании Nscale в масштабировании её инфраструктуры по всему миру: в общей сложности в глобальном масштабе (в США, Португалии, Норвегии и других странах) будут развёрнуты до 300 тыс. Grace Blackwell, включая 60 тыс. в Великобритании. Вместе с тем CoreWeave объявила о создании в Шотландии современного дата-центра на базе Grace Blackwell Ultra, получающего питание от возобновляемых источников энергии. Нужно также отметить, что ранее стало известно о планах американской компании BlackRock инвестировать до £500 млн ($678 млн) в расширение инфраструктуры дата-центров в Великобритании. Кроме того, Google намерена вложить £5 млрд ($6,8 млрд) в развитие ИИ в этой стране.

17.09.2025 [13:15], Руслан Авдеев

Собственный ЦОД Stargate и крупнейший в стране ИИ-суперкомпьютер: американские IT-гиганты вложат более $40 млрд в развитие ИИ в Великобритании

coreweave

google

hardware

microsoft

nscale

nvidia

openai

salesforce

stargate

великобритания

ии

инвестиции

суперкомпьютер

сша

финансы

цод

Microsoft объявила о намерении вложить около $30 млрд в ИИ-проекты на территории Великобритании к 2028 году. $15,5 млрд уйдёт на капитальное расширение в течение трёх лет, а $15,1 млрд — на операции в стране, сообщает CNBC. В частности, инвестиции позволят построить «крупнейший суперкомпьютер» в Великобритании с более 23 тыс. передовых ускорителей (24 тыс. по данным NVIDIA) совместно с британской Nscale. Дата запуска не раскрывалась, но в Nscale ранее объявляли, что новый ЦОД компании заработает в 2026 году и обеспечит доступ к 46 тыс. ускорителей. Планируемая мощность составляет 50 МВт, а всего на площадку выделено 90 МВт. На фоне государственного визита в Великобританию президента США Дональда Трампа (Donald Trump), инвестировать в развитие ИИ в стране пообещали NVIDIA, Google, OpenAI и Salesforce, общая сумма превысит $40 млрд. Эксперты ожидают, что премьер-министр Великобритании Кир Стармер и Дональд Трамп подпишут 17 сентября новое соглашение, открывая путь к инвестициям и сотрудничеству в сфере ИИ, квантовых и ядерных технологий. Президент Microsoft Брэд Смит (Brad Smith) заявил, что его позиция в отношении Великобритании «потеплела» с годами, ранее он критиковал Соединённое Королевство за попытку заблокировать в 2023 году сделку Microsoft по покупке Activision-Blizzard за $69 млрд. Впрочем, в том же году она была одобрена. По словам Смита, его воодушевляют сделанные правительстовм в последние несколько лет шаги для улучшения делового климата — ещё несколько лет назад подобные инвестиции были бы немыслимы из-за действующих норм и практики. Кроме того, не было спроса на такие вложения в ИИ. NVIDIA уже объявила о намерении вложить в Великобританию совместно с Nscale и CoreWeave £11 млрд ($15 млрд). NVIDIA намерена разместить в Соединённом Королевстве 120 тыс. ИИ-ускорителей Blackwell, это станет крупнейшим в этом роде проектом компании в Европе. Утверждается, что это сделает Великобританию действительно «производителем ИИ, а не потребителем».

Источник изображения: chan lee/unsplash.com Инвестировать в ИИ-проекты в Великобритании £5 млрд ($6,8 млрд) намерена Google. Компания откроет новый ЦОД в 19 километрах от центра Лондона. В Google уверены, что новый дата-центр поможет удовлетворить спрос на сервисы компании с ИИ-элементами: Google Cloud, Workspace, Search и Maps. Предполагается, что инвестиции позволят ежегодно создавать 8250 рабочих мест в британских компаниях. Значительный вклад внесёт и OpenAI благодаря проекту Stargate UK. Речь идёт о специализированной местной версии масштабного проекта, совместно реализуемого с SoftBank и Oracle. В Великобритании ИИ-стартап будет сотрудничать над проектом с Nscale и NVIDIA. OpenAI уже заявила, что в начале 2026 года для внедрения в Великобритании будут развёрнуты 8 тыс. ИИ-ускорителей с возможностью расширения мощностей до 31 тыс. в будущем. Первая крупная стройка для Stargate UK запланирована на территории Cobalt Park в Ньюкасле (Newcastle) на севере Англии. Salesforce объявила о планах увеличить инвестиции в Великобритании до $6 млрд, увеличив обязательства в сравнении с 2023 годом до $4 млрд. В Salesforce подчеркнули, что визит Трампа в Великобританию подтверждает важность отношений между Великобританией и США. Наконец, CoreWeave объявила о дополнительных инвестициях в размере £1,5 млрд для увеличения мощности своего ИИ ЦОД в стране. Благодаря этому обязательству общий объем инвестиций CoreWeave в этой стране достигнет £2,5 млрд. Суммарный объём инвестиций IT-гигантов превысит $40 млрд.

17.09.2025 [11:04], Сергей Карасёв

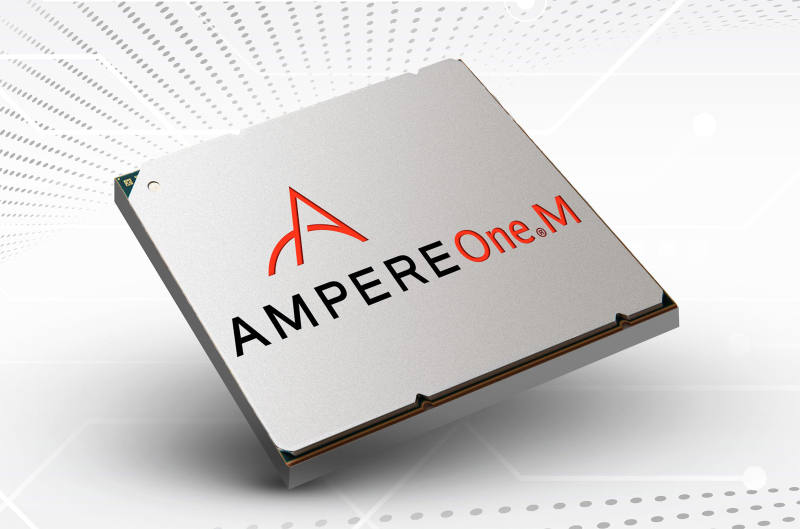

В США появится ИИ-суперкомпьютер с Arm-процессорами AmpereOne M и ускорителями Qualcomm Cloud AIУниверситет штата Нью-Йорк в Стони-Бруке (SBU) объявил о получении гранта в размере $13,77 млн от Национального научного фонда США (NSF) на приобретение и эксплуатацию высокопроизводительного энергоэффективного суперкомпьютера для задач ИИ. Средства получит Институт передовых вычислительных наук (IACS) в составе SBU. В проекте также примет участие Университет штата Нью-Йорк в Буффало (UB). Деньги выделяются в рамках программы Sustainable Cyber-infrastructure for Expanding Participation (Устойчивая киберинфраструктура для расширенной совместной работы). В основу НРС-комплекса, который пока не получил определённого названия, лягут процессоры AmpereOne M, разработанные компанией Ampere Computing специально для ресурсоёмких ИИ-нагрузок в дата-центрах. Эти чипы насчитывают до 192 кастомизированных 64-бит ядер на базе Arm v8.6+ Реализована поддержка 12 каналов DDR5-5600 и 96 линий PCIe 5.0. Кроме того, в состав суперкомпьютера войдут ИИ-ускорители Qualcomm Cloud AI, которые несут на борту до 576 Мбайт SRAM и до 128 Гбайт памяти LPDDR4x с пропускной способностью до 548 Гбайт/с. Расчётные показатели быстродействия машины пока не раскрываются. Ожидается, что комбинация AmpereOne M и Qualcomm Cloud AI обеспечит высокую энергоэффективность, а также значительную производительность, достаточную для работы с крупными ИИ-моделями. Доступ к ресурсам суперкомпьютера планируется предоставлять исследователям, студентам и преподавателям на всей территории США. Новый НРС-комплекс поможет ускорить открытия в области геномики, биоинформатики и в других областях. Кроме того, система будет применяться при реализации проектов в сферах машинного обучения и статистического анализа. |

|