Материалы по тегу: разработка

|

13.12.2023 [15:54], Руслан Авдеев

Задел на 100 лет: Nokia построит в США передовой исследовательский центр Bell LabsКомпания Nokia объявила о намерении перенести к 2028 году кампус из Мюррей Хилл (Нью-Джерси, США) в новейший исследовательско-дизайнерский центр в Нью-Брансуике, расположенный в том же штате. Как сообщает пресс-служба компании, новый центр будет стимулировать дальнейшее развитие подразделения Nokia Bell Labs и инноваций в Нью-Джерси. Как промышленное исследовательское подразделение Nokia, подразделение Nokia Bell Labs всегда было на переднем крае разработок электроники, а кампус в Мюррей Хилл являлся сердцем технологических инноваций. По словам представителей компании, он служил домом для рождения новых технологий более 80 лет. С собой исследователи намерены захватить всё, что делает их исключительными — от культуры технических разработок до интеллектуального потенциала. Всё это объединят с современными исследовательскими мощностями, специально предназначенными для того, чтобы удовлетворить нужды разработчиков «в течение следующих 100 лет».

Источник изображения: Nokia В выборе площадки сыграли важную роль близость экосистемы академических центров, лидеров индустрии и стартапов — это позволит компании разрабатывать передовые технологии в области квантовых вычислений, фотонных и оптических решений, 6G, ИИ и промышленной автоматизации. Новые мощности отвечают специфическим запросам ведущих учёных Nokia Bell Labs. Власти штата считают, что инициатива Nokia не только будет способствовать технологическим инновациям, но и позволит создать в этих местах высокооплачиваемые рабочие места и укрепит статус Нью-Брансуика в качестве нового регионального технохаба. Открытие нового центра запланировано на 2025 год, строительство планируется с участием SJP Properties, New Brunswick Development Corporation (DEVCO), New Jersey Economic Development Authority (NJEDA) и властей Нью-Брансуика. Новый кампус соответствует требованиям LEED Gold, что до некоторой степени поможет достижению Nokia цели по полной декарбонизации деятельности к 2050 году и снижению углеродных выбросов на 50 % к 2030. Дополнительно анонсировано создание венчурной студии в Нью-Джерси, позволяющей раскрыть потенциал Nokia Bell Labs за пределами традиционной сферы интересов компании — при поддержке инвесторов Celesta Capital, America’s Frontier Fund и Roadrunner Venture Studios. Ожидается, что это обеспечит поддержку разработки нового поколения критически важных технологий для США. Благодаря новому сотрудничеству Nokia Bell Labs сможет формировать стратегически важные стартапы и инвестировать средства в подобные предприятия. Сотрудничество направлено на использование преимуществ Nokia Bell Labs для разработок в сфере 5G/6G, полупроводников следующего поколения, разработки и упаковки оптических чипов. Кроме того, предполагается развитие компетенций в сфере ИИ и машинного обучения, сенсоров и квантовых вычислений.

11.12.2023 [20:55], Руслан Авдеев

AMD назвала ЦОД и телеком-отрасль стратегическими векторами роста в Индии и намерена активно развиваться в странеКомпания AMD назвала новые векторы развития своего индийского подразделения. Как сообщает Digitimes Asia, основными направлениями расширения бизнеса техногиганта станет рынок дата-центров и телеком-отрасль. В компании называют драйверами роста цифровизацию правительства, развитие 5G, а также технологий ИИ, больших данных и машинного обучения для бизнеса. В государстве с населением более 1,4 млрд человек всё более востребованы цифровые услуги, услуги производительных и безопасных ЦОД, а политика индийских властей, направленная на локализацию данных, стимулирует открытие многими бизнесами собственных дата-центров. Уже сегодня Индия является крупнейшим рынком ЦОД в Азиатско-Тихоокеанском регионе после Китая, поэтому для AMD открываются большие возможности в банковском, телекоммуникационном и производственном секторах, страховом бизнесе и т.п. В частности, в телеком-сегменте подготовка к внедрению 6G открывает для AMD большие возможности по продаже высокопроизводительных процессоров в ближайшие два-три года. И AMD уже тесно сотрудничает с местными партнёрами в соответствующем направлении. Так, на мероприятии Semicon India 2023 компания пообещала инвестировать $400 млн в развитие бизнеса в Индии в ближайшие пять лет, увеличив к 2028 году штат с 7 тыс. до 10 тыс. человек и наняв 3 тыс. новых инженеров. Кроме того, компания откроет крупный дизайн-центр в Бангалоре — первый кампус AMD Technostar Campus R&D Center был анонсирован в конце ноября. Сейчас AMD ожидает от местных властей принятия мер по развитию полупроводникового производства. В рамках инициативы India Semiconductor Mission компания подготовили для них рекомендации по привлечению талантливых сотрудников со всего мира. Всеиндийский совет по техническому образованию ( AICTE) уже приступил к реформам на основе советов в учреждениях среднего и высшего профессионального образования. В AMD считают, что Индия уже встала на путь создания экосистем для производства полупроводников и дисплеев при поддержке правительства, чем намерена воспользоваться и сама. Предполагается, что Индия является важным рынком сбыта для высокопроизводительных процессоров для серверов и ПК, ИИ-ускорителей, игровых GPU, всевозможных чипсетов и т.п. Местные партнёры с помощью широкого портфолио решений AMD смогут модернизировать существующую корпоративную инфраструктуру, в том числе программную. Считается, что такие обширные планы свидетельствуют об уверенности AMD в большом потенциале роста индийского IT-рынка. В компании подчёркивают, что индийские разработчики приложили руки к созданию практически каждого чипа AMD.

06.12.2023 [00:18], Руслан Авдеев

Индия намерена построить суверенную ИИ-инфраструктуруВ рамках масштабных инициатив, связанных с цифровизацией общества, Индия рассчитывает построить суверенную ИИ-инфраструктуру. Как сообщает Datacenter Knowledge, местные власти уверены в необходимости самостоятельного прогресса в данной сфере. По словам министра электроники Раджива Чандрасекара (Rajeev Chandrasekhar), стране необходим собственный независимый ИИ. Власти не готовы довольствоваться ИИ-экосистемой, управляемой Google, Meta✴, а также некоторыми индийскими стартапами и компаниями. Индия будет принимать участие в американских и европейских инициативах, параллельно разрабатывая собственную стратегию. В правительстве рассчитывают использовать новые технологии для социально-экономического развития. Идею в ходе недавнего визита в Индию поддержал глава IBM Арвинд Кришна (Arvind Krishna), который заявил, что каждая страна должна иметь определённый суверенитет в сфере ИИ, включая собственные большие языковые модели (LLM). Индия уже начала принимать меры по развитию собственных инициатив. Так, Министерство электроники и информационных технологий намерено предоставлять обезличенные данные из правительственных баз стартапам и научным организациям. Предполагается, что это будет способствовать совершенствованию системы управления и развитию экосистемы стартапов. Также рассматривается возможность получать по запросу массивы обезличенных данных и у IT-гигантов вроде Google и Meta✴. В последние годы Индия уделяет большое внимание строительству собственной цифровой инфраструктуры. В частности, она реализует крупные проекты т.н. «цифровой общественной инфраструктуры» (DPI) — вроде Aadhaar и Unified Payment Interface (UPI), вызывающие интерес далеко за пределами государства. Например, Aadhaar предполагает биометрическую идентификацию всех граждан Индии, а UPI представляет собой популярную платёжную платформу. Недавно Индия запустила и глобальный репозиторий Global Digital Public Infrastructure Repository (GDPIR) для объединения ресурсов и идей стран «большой двадцатки» G20 в области проектирования и создания DPI. Репозиторий объединяет программные решения и различные находки. Полученные решения и данные страна в числе прочего намерена использовать для создания «домашнего» ИИ, что поможет ей снизить зависимость от глобальных техногигантов.

30.11.2023 [03:10], Игорь Осколков

ИИ в один клик: llamafile позволяет запустить большую языковую модель сразу в шести ОС и на двух архитектурахMozilla представила первый релиз инструмента llamafile, позволяющего упаковать веса большой языковой модели (LLM) в исполняемый файл, который без установки можно запустить практически на любой современной платформе, причём ещё и с поддержкой GPU-ускорения в большинстве случаев. Это упрощает дистрибуцию и запуск моделей на ПК и серверах. llamafile распространяется под лицензией Apache 2.0 и использует открытые инструменты llama.cpp и Cosmopolitan Libc. Утилита принимает GGUF-файл с весами модели, упаковывает его и отдаёт унифицированный бинарный файл, который запускается в macOS, Windows, Linux, FreeBSD, OpenBSD и NetBSD. Готовый файл предоставляет либо интерфейс командной строки, либо запускает веб-сервер с интерфейсом чат-бота.

Источник: GitHub / Mozilla Ocho Поддерживаются платформы x86-64 и ARM64, причём в первом случае автоматически определяется тип CPU и по возможности используются наиболее современные векторные инструкции. llamafile может использовать ускорители NVIDIA, а в случае платформы Apple задействовать Metal. Разработчики успешно протестировали инструмент в Linux (в облаке Google Cloud) и Windows с картой NVIDIA, в macOS и на NVIDIA Jetson. Впрочем, некоторые нюансы всё же есть. Так, в Windows размер исполняемого файла не может превышать 4 Гбайт, поэтому большие модели вынужденно хранятся в отдельном файле. В macOS на платформе Apple Silicon перед первым запуском всё же придётся установить Xcode, а в Linux, возможно, понадобится обновить некоторые компоненты. Подробности и примеры готовых моделей можно найти в репозитории проекта.

29.11.2023 [23:40], Руслан Авдеев

NVIDIA NeMo Retriever позволит компаниям дополнять ИИ-модели собственными даннымиNVIDIA представила сервис NeMo Retriever, позволяет компаниям дополнять данные для чат-ботов, ИИ-помощников и похожих инструментов специализированными сведениями — для получения более точных ответов на запросы. Сервис стал частью облачного семейства инструментов NVIDIA NeMo, позволяющих создавать, настраивать и внедрять модели генеративного ИИ. RAG (Retrieval Augmented Generation), метод улучшения производительности больших языковых моделей (LLM), позволяет повысить точность и безопасность ИИ-инструментов благодаря заполнению пробелов в «знаниях» языковых моделей с помощью сведений из внешних источников. Обучение каждой модели — чрезвычайно ресурсоёмкий процесс — обычно осуществляется довольно редко, а то и вовсе единожды. При этом до следующего обновления модель не имеет доступа к полной и актуальной информации, что может привести к неточностям, ошибкам и т.н. галлюцинациям. NeMo Retriever позволяет быстро дополнить LLM свежими сведениями в виде баз данных, HTML-страниц, PDF-файлов, изображений, видео и т.п. Другими словами, базовая модель с добавлением специализированных материалов станет заметно эрудированнее и «сообразительнее». При этом данные могут храниться где угодно — как в облаках, так и на собственных серверах компаний. Технология чрезвычайно полезна, поскольку обеспечивает сотрудникам компании работу с полезными данными, закрытыми для широкой публики, при этом пользуясь всеми преимуществами ИИ. В отличие от открытых RAG-инструментов, NVIDIA, по данным самой компании, предлагает готовое к коммерческому использованию решение для доступных на рынке ИИ-моделей, уже оптимизированных для RAG и имеющих поддержку, а также регулярно получающих обновления безопасности. Другими словами, корпоративные клиенты могут брать готовые ИИ-модели и дополнять их собственными данными без отдельной ресурсоёмкой тренировки. NeMo Retriever позволит добавить соответствующие возможности универсальной облачной платформе NVIDIA AI Enterprise, предназначенной для оптимизации разработки ИИ-приложений. Регистрация разработчиков для раннего доступа к NeMo Retriever уже началась. Cadence Design Systems, Dropbox, SAP SE и ServiceNow уже работают с NVIDIA над внедрением RAG в свои внутренние ИИ-инструменты.

29.11.2023 [22:43], Владимир Мироненко

ИИ-ассистент Amazon Q упростит работу IT-специалистов, разработчиков и корпоративных клиентов AWSКомпания Amazon Web Services представила интеллектуального ассистента Amazon Q на базе генеративного ИИ, предназначенного для помощи корпоративным клиентам. Поначалу Amazon Q будет использоваться для нужд разработчиков и поддержки IT-команд. Amazon Q уже доступен в виде превью, причем многие функции бесплатны. В дальнейшем AWS будет брать по $20/мес. за каждого пользователя, а версия с дополнительными функциями для ИТ-специалистов будет стоить $25/мес. «Amazon Q может помочь вам получать быстрые и актуальные ответы на насущные вопросы, решать проблемы, генерировать контент и предпринимать действия, используя данные и опыт, найденные в информационных репозиториях, коде и корпоративных системах вашей компании», — сообщил гендиректор Amazon. Глава AWS считает, что Amazon Q реформирует множество видов деятельности. ИИ-помощник разработан с учётом 17-летнего опыта работы самой AWS и поначалу будет доступен именно внутри экосистемы AWS. Хотя Amazon Q в первую очередь нацелен на разработчиков и ИТ-специалистов, компания планирует в конечном итоге распространить его возможности на весь корпоративный сегмент. Подобно другим ИИ-помощникам он сможет подключаться к различным источникам данных, отвечать на вопросы и составлять резюме, а также предоставлять экспертные сведения или помощь на основе внутренней информации компании. Это потенциально может сделать его конкурентом ChatGPT Enterprise от OpenAI, Copilot for 365 от Microsoft и Duet AI for Workspace от Google. Специалисты смогут получить доступ Amazon Q из консоли AWS. Q расскажет, как использовать сервисы, какие API доступны, к каким сервисам можно подключиться и как они взаимодействуют между собой. Пользователь сможет создавать запросы на естественном языке, а Q подготовит экспертный ответ со ссылками и цитатами. Так, в EC2-консоли Amazon Q даст совет, какой тип инстанса лучше всего подходит для размещения определённого типа приложений в зависимости в зависимости от потребностей клиента. А если возникла проблема с сетью, у Q можно напрямую спросить: «Почему я не могу подключиться по SSH к своему инстансу?». В этом случае помощник подключит его к сетевому анализатору, чтобы устранить неполадки с соединением. AWS интегрировала ИИ-ассистента в поддерживаемые IDE вместе с ИИ-инструментом Amazon CodeWhisperer, так что с Q можно пообщаться непосредственно во время разработки. Например, Amazon Q может разобрать и описать исходный код незнакомого проекта или же в диалоговом режиме в Amazon CodeCatalyst поможет создать новый код, опираясь на описание необходимой функциональности и учитывая лучшие практики, а также имеющуюся кодовую базу и бизнес-сведения. Наконец, функция Amazon Q Transformation, доступная в виде превью для IntelliJ IDEA и Visual Studio Code, позволит автоматизировать обновление кода приложений с Java 8 и 11 до версии 17. А вскоре Q научится преобразовывать .NET-приложения для Windows в кросс-платформенные.

26.11.2023 [02:16], Владимир Мироненко

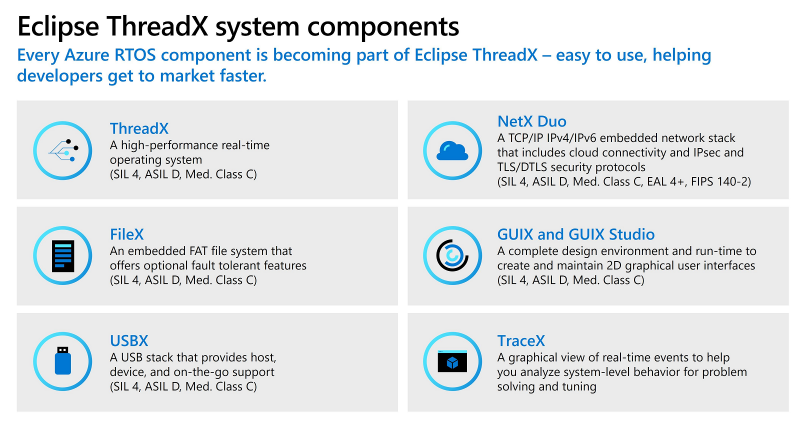

Платформа Microsoft Azure RTOS стала открытой и перешла под эгиду Eclipse FoundationMicrosoft объявила, что набор средств разработки встраиваемых решений Azure RTOS, включающий операционную систему реального времени (ОСРВ) ThreadX, был переведён в категорию решений с открытым исходным кодом под именем Eclipse ThreadX и теперь будет развиваться под эгидой организации Eclipse Foundation. В Eclipse Foundation заявили, что новый проект — «именно то, в чём очень давно нуждался сильно фрагментированный рынок встраиваемого ПО». ThreadX станет первой в мире open source ОСРВ, которая:

Отмечается, что в настоящее время нет аналогичных ОСРВ с открытым исходным кодом, имеющих подобную сертификацию и перечисленные преимущества. Проект Eclipse ThreadX станет доступен в I квартале 2024 года и будет включать ThreadX, NetX Duo, FileX, GUIX, USBX, LevelX, а также соответствующие инструменты и документацию. Microsoft предоставит проекту самые последние сертификаты, чтобы обеспечить непрерывность выпуска сертифицированных релизов. Фонд Eclipse Foundation объявил о создании группы, занимающейся разработкой модели устойчивого финансирования ThreadX, которую согласились поддержать AMD, Cypherbridge, Microsoft, NXP, PX5, Renesas, ST Microelectronics, Silicon Labs и Witekio (Avnet).

18.11.2023 [00:38], Владимир Мироненко

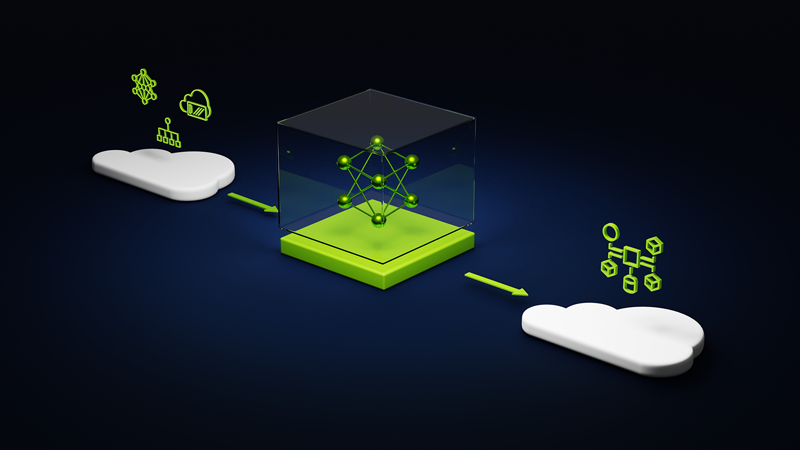

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки.

17.11.2023 [01:21], Сергей Карасёв

Linux Foundation создаст «Фонд высокопроизводительного ПО» для решения НРС-задачНекоммерческая организация Linux Foundation объявила о намерении сформировать «Фонд высокопроизводительного программного обеспечения »(High Performance Software Foundation, HPSF). Задачами данной структуры станут создание и продвижения стека ПО для НРС-приложений. Предполагается, что появление HPSF будет способствовать ускорению решения задач в области НРС и ИИ. Фонд намерен предоставить «нейтральное пространство» для ключевых проектов в экосистеме HPC ПО. Участники отрасли, научные организации и госструктуры смогут сообща работать над софтверным стеком.

Источник изображения: Linux Foundation Сообщается, что в деятельности HPSF примут участие Аргоннская национальная лаборатория, Национальная лаборатория им. Лоуренса в Беркли, Ливерморская национальная лаборатория, Лос-Аламосская национальная лаборатория, Окриджская национальная лаборатория и Сандийские национальные лаборатории (все входят в состав Министерства энергетики США), а также AWS, CIQ, HPE, Intel, Kitware, NVIDIA и др. Фонд планирует использовать инвестиции, сделанные проектом Exascale Computing Project (ECP) Министерства энергетики США, совместным предприятием EuroHPC JU и другими международными структурами. На первом этапе в программный стек HPSF войдут open source решения Spack, Kokkos, AMReX, WarpX, Trilinos, Apptainer, VTK-m, HPCToolkit, E4S и Charliecloud. До начала следующего года HPSF планирует проводить встречи с участниками для согласования структуры и схемы управления. Ожидается, что фонд будет официально сформирован в мае 2024 года.

13.11.2023 [17:42], Владимир Мироненко

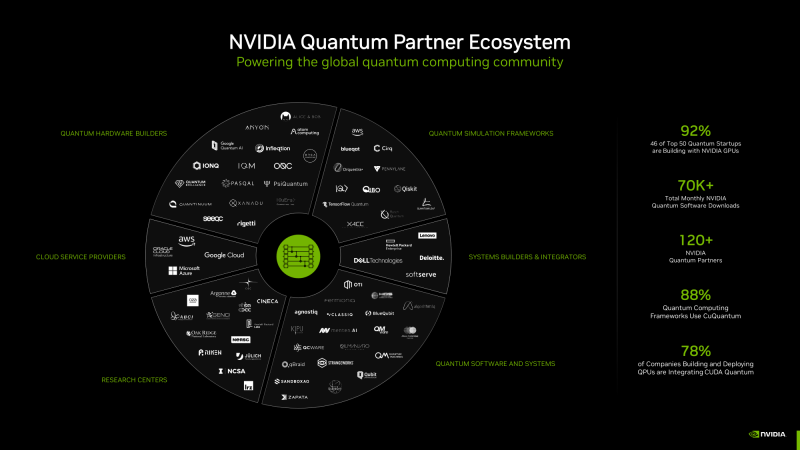

NVIDIA CUDA Quantum позволяет выполнять моделирование процессов, невозможное на обычных компьютерных системахКрупнейшая в мире химическая компания BASF продемонстрировала, как квантовый алгоритм позволяет сделать то, чего не может традиционное моделирование — проверить ключевые свойства перспективного химического соединения FeNTA, с помощью которого можно удалять из городских сточных вод токсичные металлы, такие как железо. Команда BASF смоделировала с помощью ускорителей NVIDIA 24-кубитный квантовый компьютер и продемонстрировала, как он может справиться с новыми задачами. Исследователи BASF полагаются в работе на облако NVIDIA DGX Cloud с ускорителями NVIDIA H100. Вдобавок они уже протестировали первые 60-кубитные симуляции на суперкомпьютере NVIDIA EOS. «Это самая масштабная симуляция квантового алгоритма, которую мы когда-либо запускали», — отметил Майкл Кун (Michael Kuehn) из BASF.

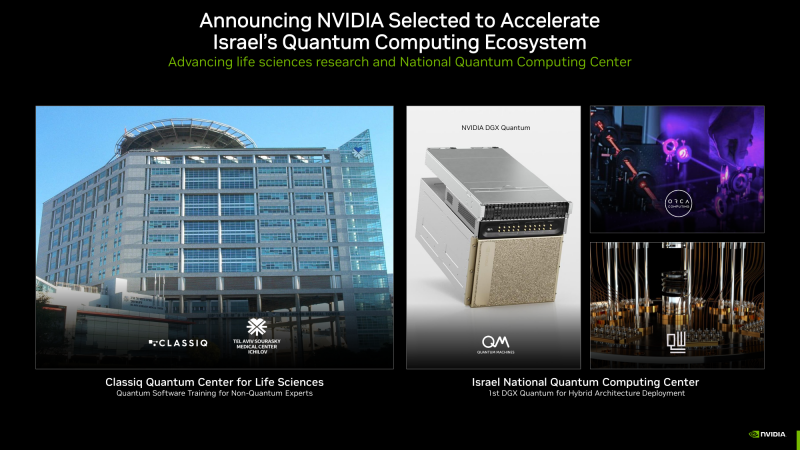

Изображения: NVIDIA BASF выполняет моделирование посредством NVIDIA CUDA Quantum, открытой платформы для интеграции и программирования CPU, ускорителей вычислений (GPU) и квантовых компьютеров (QPU). Разработчик Давид Водола (Davide Vodola) охарактеризовал платформу как «очень гибкую и удобную в использовании, позволяющую создавать сложную симуляцию квантовой схемы из относительно простых строительных блоков <…> Без CUDA Quantum было бы невозможно запустить это моделирование», — сказал он. В дополнение к работе в области химии команда BASF разрабатывает варианты использования квантовых вычислений в машинном обучении, а также для оптимизации логистики и планирования. Другие компании тоже используют CUDA Quantum в научных исследованиях. Например, в SUNY Stony Brook исследователи используют платформу в области физики высоких энергий для моделирования сложных взаимодействий субатомных частиц. «CUDA Quantum позволяет нам проводить квантовое моделирование, которое в противном случае было бы невозможно», — сказал Дмитрий Харзеев, профессор SUNY и научный сотрудник Брукхейвенской национальной лаборатории. В свою очередь, Hewlett Packard Labs применяет суперкомпьютер Perlmutter для крупнейших симуляций в области квантовой химии, которую обычными инструментами реализовать очень сложно. «По мере прогресса в практическом применении квантовых компьютеров классическое HPC-моделирование станет ключевым для создания прототипов новых квантовых алгоритмов, — говорит Кирк Брезникер (Kirk Bresniker), главный архитектор Hewlett Packard Labs. — Моделирование и обучение на основе квантовых данных являются перспективными путями использования потенциала квантовых вычислений». Израильский стартап Classiq, чей новый подход к написанию квантовых программ использует более 400 университетов, объявил о создании вместе с NVIDIA исследовательского центра в Тель-Авивском медицинском центре Сураски. Здесь будут обучать экспертов в области естественных наук написанию квантовых программ, которые помогут в диагностике заболеваний и создании новых лекарств. Classiq создал ПО для проектирования, которое автоматизирует низкоуровневые задачи, позволяя разработчикам не вникать в детали функционирования квантового компьютера. Сейчас его софт интегрируют с CUDA Quantum. Швейцарская Terra Quantum разрабатывает гибридные квантовые приложения для науки о жизни, энергетики и финансов, которые будут работать на CUDA Quantum. Поддержку платформы своим QPU обеспечила и компания IQM из Финляндии. Также известно, что несколько компаний, включая Oxford Quantum Circuits, будут использовать суперчипы NVIDIA Grace Hopper для обеспечения своих гибридных квантовых разработок. Компания Quantum Machines объявила, что Израильский национальный квантовый центр в Тель-Авиве станет первым местом развёртывания NVIDIA DGX Quantum на базе Grace Hopper. Центр будет использовать DGX Quantum в работе квантовых компьютеров от Quantware, ORCA Computing и других компаний. Кроме того, qBraid из Чикаго (США) применяет Grace Hopper в работе над созданием квантового облачного сервиса, а Fermioniq из Амстердама (Нидерланды) — в разработке новых алгоритмов. |

|