Материалы по тегу: облако

|

11.09.2024 [01:18], Владимир Мироненко

Oracle построит гигаваттный ИИ ЦОД с питанием от малых модульных реакторовАкции Oracle выросли во вторник более чем на 10 % после публикации отчёта за I квартал 2025 финансового года, завершившегося 31 августа. Выручка компании выросла на 7 % с $12,5 млрд годом ранее до $13,3 млрд при консенсус-прогнозе аналитиков, опрошенных FactSet, в $13,2 млрд. Скорректированная прибыль на акцию (Non-GAAP) составила $1,39 при прогнозе аналитиков $1,33. Выручка Oracle от облачных сервисов (IaaS и SaaS) выросла год к году на 21 % до $5,6 млрд. Выручка от лицензирования облачных продуктов увеличилась на 7 % до $870 млн, а выручка сегмента Cloud Infrastructure (IaaS) увеличилась на 45 % до $2,2 млрд. «Поскольку облачные сервисы стали крупнейшим бизнесом Oracle, рост как нашего операционного дохода, так и прибыли на акцию ускорился», — указала в пресс-релизе гендиректор Oracle Сафра Кац (Safra Catz). Чистая прибыль (GAAP) компании составила $2,9 млрд или $1,03 на акцию, по сравнению с $2,4 млрд или $0,86 на акцию годом ранее (рост — 21 %). Кац также сообщила в отчёте о заключении соглашения с AWS о размещении СУБД-инфраструктуры Oracle Database. AWS является крупнейшим поставщиком облачных сервисов по доле рынка. В отдельном пресс-релизе, посвящённом сделке, председатель и главный технический директор Ларри Эллисон (Larry Ellison) сообщил, что Oracle видит «огромный спрос» со стороны клиентов на работу с несколькими провайдерами облачных услуг. Таким образом, Oracle смогла склонить к сотрудничеству всё трёх ключевых игроков облачного рынка — ранее аналогичные сделки были заключены с Google и Microsoft. «Чтобы удовлетворить этот спрос и предоставить клиентам выбор и гибкость, которые им нужны, Amazon и Oracle бесшовно соединяют сервисы AWS с новейшей технологией Oracle Database, включая Oracle Autonomous Database», — сказал Эллисон. «Благодаря развёртыванию инфраструктуры Oracle Cloud внутри ЦОД AWS мы можем предоставить клиентам максимально возможную производительность базы данных и сети», — добавил он. Эллисон рассказал, что у Oracle есть 162 действующих и строящихся облачных ЦОД по всему миру. Самый большой из них имеет будет ёмкость 800 МВт, что позволит разместить множество кластеров ускорителей NVIDIA для обучения крупномасштабных моделей ИИ. А площадки для размещения ускорителей компании очень нужны, поскольку в отчётном квартале Oracle подписала 42 дополнительных контракта на облачные GPU на общую сумму $3 млрд, но не смогла заключить $10-млрд сделку с xAI. Однако это не предел и компания «скоро» начнёт строительство ЦОД мощностью более 1 ГВт. По словам Эллисона, для одного из этих проектов уже выбрано место, и он находится в процессе проектирования. ЦОД будет работать на атомной энергии, поскольку Oracle получила разрешение на три малых модульных ядерных реакторов (SMR). Аналогичные проекты разрабатываются с участием компании Oklo, поддерживаемой главой OpenAI Сэмом Альтманом (Sam Altman). Впрочем, последняя уже присматривается к термоядерной энергетике. Microsoft, тесно связанная с OpenAI, тоже изучает SMR. Amazon же не стала мудрствовать и просто приобрела кампус, напрямую запитанный от обычной АЭС. В текущем финансовом квартале компания ожидает получить скорректированную прибыль (Non-GAAP) в пределах $1,45–1,49 на акцию при росте выручки год к году на 7–9 %. Согласно консенсус-прогнозу аналитиков, опрошенных FactSet, скорректированная прибыль Oracle составит $1,48 на акцию.

09.09.2024 [16:00], Владимир Мироненко

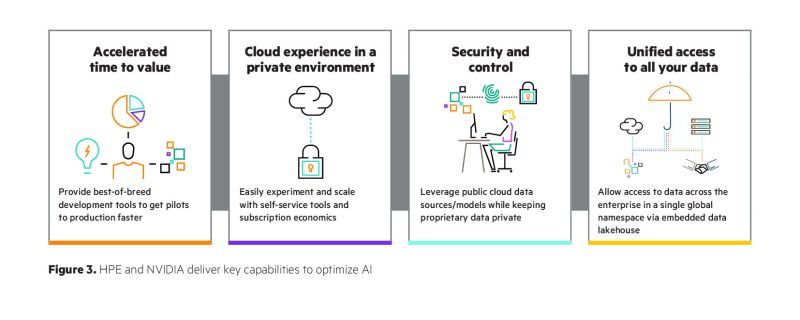

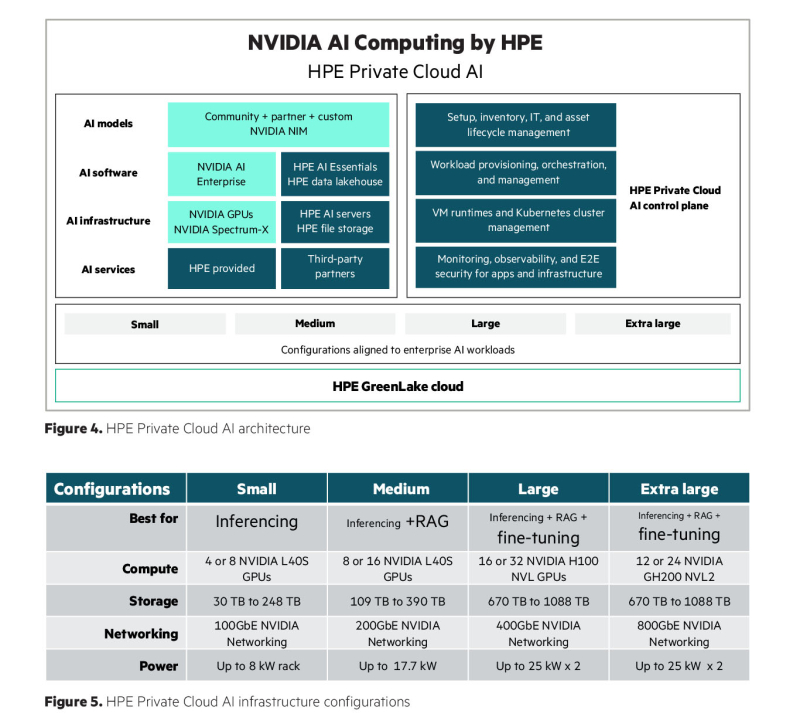

Корпоративная ИИ-платформа под ключ: HPE и NVIDIA объявила о доступности HPE Private Cloud AI(HPE) объявила о доступности входящей в портфель NVIDIA AI Computing by HPE программно-аппаратной платформы HPE Private Cloud AI на базе GreenLake, разработанной совместно с NVIDIA для создания и запуска корпоративных приложений генеративного ИИ. По словам компании, ключевым отличием HPE Private Cloud AI являются решения для автоматизации и оптимизации приложений ИИ, позволяющие предприятию сократить сроки запуска виртуальных помощников с нескольких месяцев до мгновений. К числу таких решений («ускорителей» в терминологии HPE) относится виртуальный помощник на базе генеративного ИИ, который поможет разработчикам быстро создавать интерактивные чат-боты, отвечающие на вопросы на естественном языке, на основе собственных данных организации и открытых больших языковых моделей (LLM). Компании смогут с их помощью настраивать свои приложения ИИ для различных целей, таких как техническая поддержка, формирование коммерческих предложений, создание маркетингового контента и многое другое. Виртуального помощника можно усовершенствовать, добавив в будущем голосовой ввод, возможность работы с изображениями и многокомпонентную поддержку, обеспечивая более продвинутую генерацию контента и работу в режиме многозадачности. Как утверждает HPE, будущие пакеты решений будут включать в себя широко используемые приложения ИИ для вертикальных отраслей, включая финансовые услуги, здравоохранение, розничную торговлю, энергетику и государственный сектор. Они будут основаны на NVIDIA NIM Agent Blueprints, эталонных вариантах ИИ-решений, которые предприятия смогут постоянно совершенствовать на основе собственных данных и отзывов клиентов. «Предприятия ищут ускоренные, настраиваемые инструменты ИИ, подходящие для конкретных вариантов использования с учётом их специфики, — говорит Джастин Бойтано (Justin Boitano), вице-президент по корпоративным программным продуктам ИИ в NVIDIA. — NVIDIA NIM Agent Blueprints позволяет приложениям ИИ, разработанным с помощью HPE Private Cloud AI, совершенствоваться с использованием обратной связи от живых пользователей, улучшая модели в рамках непрерывного цикла обучения». «Ускорители» HPE — это настраиваемые модульные low-code или no-code приложения, использующие микросервисы NVIDIA NIM. Эти проверенные и воспроизводимые решения упрощают развёртывание приложений ИИ, которое обычно включает приобретение новых навыков, принятие сложных рабочих нагрузок, а также интеграцию и настройку агентов, нескольких микросервисов, векторных баз данных, хранилищ данных, разрозненных источников данных, систем управления пользователями, масштабируемых серверов инференса, наборов данных, моделей ИИ и других ИТ-ресурсов. HPE также объявила о запуске партнёрской программы Unleash AI, разработанной для поддержки обширной экосистемы ведущих организаций-партнёров. Unleash AI является частью Technology Partner Program, входящей в инициативу HPE Partner Ready, которая дополнит HPE Private Cloud AI. Новая программа будет включать поставщиков на всех уровнях — от данных, моделей и приложений технологического стека до системных интеграторов и поставщиков услуг консалтинга, проектирования, внедрения и управления комплексными решениями для клиентов на основе ИИ. Решения партнёров, в том числе основанные на NVIDIA NIM Agent Blueprints, будут курироваться и предварительно проверяться для работы в HPE Private Cloud AI. Эта программа дополнит новую стратегию партнёрства в области ИИ, которую HPE объявила в сотрудничестве с NVIDIA.

08.09.2024 [13:28], Сергей Карасёв

CoreWeave и Run:ai помогут заказчикам в обучении ИИКомпания CoreWeave, предоставляющая облачные услуги для ИИ-задач, объявила о заключении партнёрского соглашения со стартапом Run:ai. В рамках сотрудничества клиентам будут предоставляться услуги для эффективного обучения ИИ и улучшения инференса. CoreWeave, учреждённая в 2017 году, изначально занималась майнингом криптовалют, а затем переориентировалась на вычисления общего назначения и хостинг проектов генеративного ИИ. Компания активно развивает инфраструктуру дата-центров. В апреле 2023-го CoreWeave получила $221 млн в ходе раунда финансирования Series B, а позднее привлекла на развитие ещё $200 млн. В августе 2023-го было объявлено о долговом финансировании в размере $2,3 млрд под залог ускорителей NVIDIA. В декабре прошлого года CoreWeave провела ещё один раунд финансирования — на $642 млн. В мае 2024-го компания получила $1,1 млрд, а затем привлекла дополнительно $7,5 млрд в виде долгового финансирования.

Источник изображения: CoreWeave В свою очередь, стартап Run:ai основан в 2018 году: в марте 2022-го он получил $75 млн в ходе раунда финансирования Series C. Фирма специализируется на разработке ПО для управления рабочими нагрузками ИИ. Такие инструменты позволяют более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. В апреле 2024 года NVIDIA заключила соглашение о приобретении Run:ai. Условия сделки не раскрываются, но, по имеющейся информации, стоимость может составлять до $1 млрд. При этом NVIDIA также является и инвестором CoreWeave. В рамках нового партнёрства клиенты CoreWeave смогут управлять рабочими нагрузками ИИ в своей инфраструктуре с помощью платформы Run:ai. Решения Run:ai разработаны для оптимизации использования вычислительных ресурсов в облачных средах. Утверждается, что платформа Run:ai, обеспечивающая масштабируемость, гибкость и экономическую эффективность, идеально дополняет облачную архитектуру CoreWeave. Среди ключевых преимуществ для заказчиков названы:

06.09.2024 [18:32], Руслан Авдеев

NVIDIA и другие инвесторы вложили $160 млн в оператора ИИ ЦОД Applied DigitalВзрывной рост ИИ сделал индустрию ЦОД одной из самых привлекательных сфер для вложения средств. Как сообщает The Register, NVIDIA совместно с другими инвесторами намерена вложить $160 млн в техасского оператора дата-центров Applied Digital, ранее известного как Applied Blockchain. Это не первый заметный игрок на рынке майнинговых ЦОД, которые переключился на ИИ и получил поддержку NVIDIA. Акции Applied Digital торгуются на Nasdaq, но по данным Silicon Angle, в данном случае компания привлекла финансирование посредством т.н. «частного размещения» (private placement), которое предусматривает прямую передачу акций инвесторам без посредничества биржи. При этом в сделке обычно участвуют заранее одобренные компании. Applied Digital выпустила 49,38 млн акций по $3,24 за каждую. Applied Digital занимается строительством дата-центров с СЖО для высокоплотных вычислений. Компания также сдаёт в аренду кластеры ускорителей, в частности, NVIDIA H200 и A40. Облачное подразделение — довольно весомая часть бизнеса Applied Digital. В финансовом году, закончившемся 31 марта, на его долю пришлось $29 млн из $165,6 млн общей выручки. За четыре последних месяца в эксплуатацию введено четыре новых ИИ-кластера, а ещё два запустят в ближайшие месяцы. В августе Applied Digital объявила о строительстве 400 МВт ёмкостей для неназванного американского облачного оператора. Речь идёт о строящемся 100-МВт кампусе в Эллендейле (Северная Дакота) и двух других объектах. По данным СМИ, $160 млн новых инвестиций потратят на создание основы для раундов долгового финансирования, а оно уже будет истрачено на расширение кампуса ЦОД в Северной Дакоте и облачные инициативы компании. Интересно, что именно в этом штате две неизвестных компании готовы потратить $250 млрд на гигантские ИИ ЦОД. Поскольку передовые ускорители NVIDIA стоят порядка $30-40 тыс. каждый, некоторые операторы вынуждены обращаться за крупными займами. Так, в июле оператор CyrusOne занял $7,9 млрд для покупки новейших ускорителей, не считая $1,8 млрд, привлечённых ещё весной. В мае CoreWeave привлекла $1,1 млрд, а несколькими неделями позже убедила инвесторов одолжить ещё $7,5 млрд. Lambda Labs начала текущий год с раунда финансирования на $320 млн, ещё $500 млн она привлекла весной и теперь планирует закупить десятки тысяч новых ускорителей. Помимо традиционных венчурных инвесторов вроде BlackRock, Magnetar Capital и Coatue, в некоторых из подобных проектов участвует и сама NVIDIA, ранее уже поддерживавшая CoreWeave, которая прославилась тем, что взяла в долг $2,3 млрд под залог ускорителей, чтобы купить ещё больше ускорителей. Мотивация NVIDIA очевидна — продавать ускорители компания сможет до тех пор, пока на них есть спрос, а спрос может обеспечить только строительство новых дата-центров.

06.09.2024 [12:04], Руслан Авдеев

AWS потратит $2 млрд на строительство новых ЦОД в ИндииIT-гигант Amazon Web Services (AWS) намерен инвестировать ещё $2 млрд в дата-центры в штате Телингана на юге Индии. По данным Datacenter Dynamics, гиперскейлер уже обсуждает с властями штата условия расширения своего парка ЦОД на данной территории. По словам представителя местных властей, Amazon проявила интерес к инвестициям $2 млрд в дата-центры в Телингане, причём они не ограничатся столицей штата — Хайдарабадом. В ходе обсуждений выяснилось, что компания намерена направлять инвестиции в следующие 4–5 лет, особый акцент будет сделан на строительстве ЦОД. Облачный регион AWS запустила в Хайдарабаде в ноябре 2022 года, а планы его создания обнародовали ещё в 2020 году. Всего компания рассчитывает вложить в город и штат $2,8 млрд. Планы расширения региона ЦОД в Хайдарабаде обнародовали в августе 2024 года, после визита представителей властей штата в Калифорнию для встречи с топ-менеджерами AWS. Местные власти сообщают, что основным драйвером расширения мощностей стали технологии ИИ. Amazon осознаёт их потенциал и готовит серьёзные вложения в регион. В свою очередь, Телинган готова предоставить многочисленные локации для новых кампусов.

Источник изображения: Motamarri Phani/unsplash.com В 2023 году сообщалось, что AWS намерена вложить почти $13 млрд в расширение в Индии облачной инфраструктуры. До этого в 2016 году в Мумбаи был запущен облачный регион с тремя зонами доступности.

04.09.2024 [08:08], Владимир Мироненко

Broadcom анонсировала VMware Cloud Foundation 9 и Tanzu Platform 10

broadcom

kubernetes

software

vmware

виртуализация

гибридное облако

ии

контейнеризация

частное облако

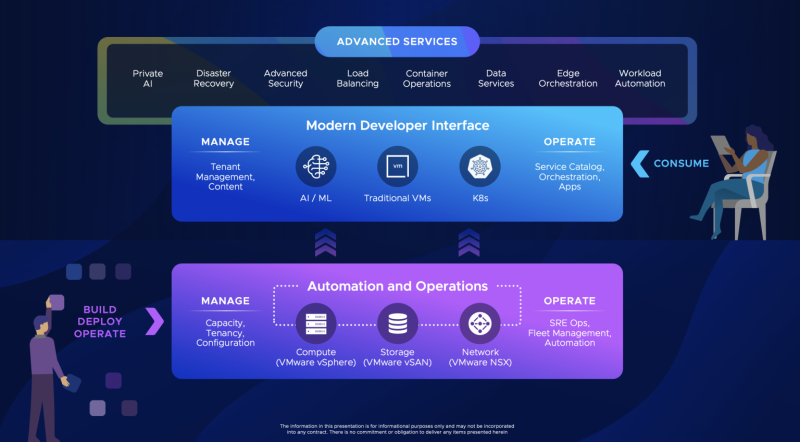

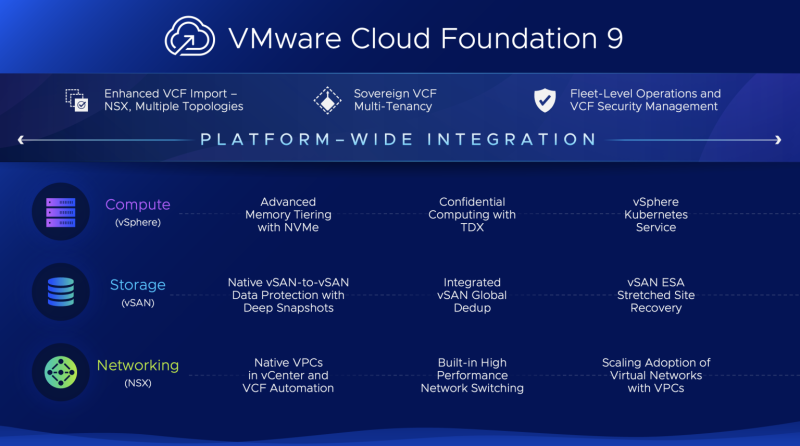

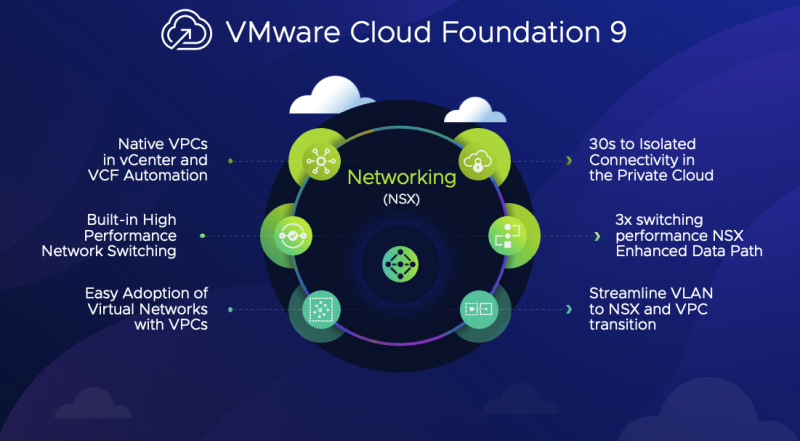

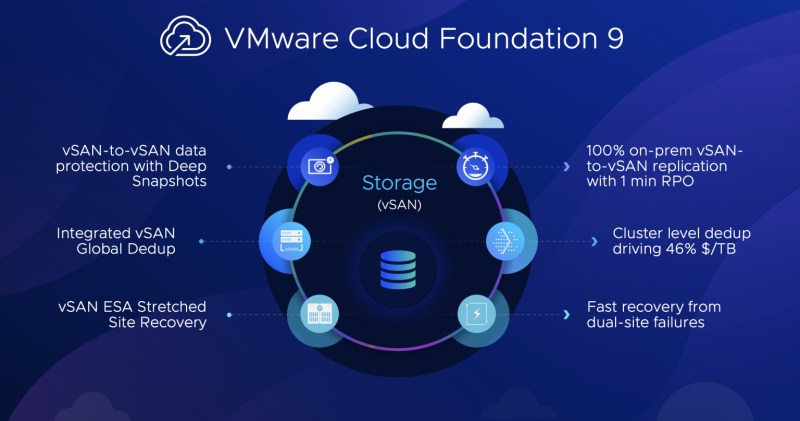

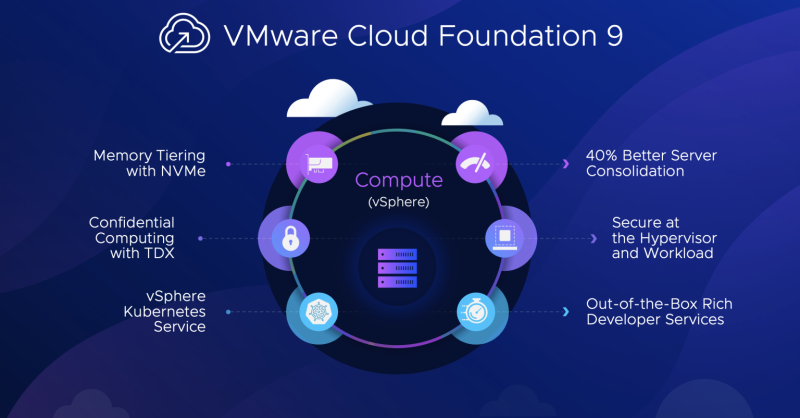

Broadcom представила новейшую версию платформы для управления виртуальными машинами и оркестрации контейнеров VMware Cloud Foundation (VCF) 9, назвав её «будущим» своей платформы частного облака, которая ускорит переход клиентов от разрозненных ИТ-архитектур к унифицированной и интегрированной частной облачной платформе с меньшими затратами и рисками. Основной упор в новой версии сделан на создание частных облаков и, конечно же, ИИ. Broadcom заявила, что VMware Cloud Foundation — первая в отрасли облачная платформа, сочетающая масштабируемость и гибкость публичного облака с безопасностью, устойчивостью и производительностью частного облака и низкой совокупной стоимостью владения. VCF поддержит цифровые инновации клиентов с более быстрой модернизацией инфраструктуры, унифицированным облачным опытом, а также лучшей киберустойчивостью и безопасностью, говорит Broadcom. Компания сослалась на спонсируемое ею исследование IDC, в котором сообщалось, что VCF обеспечивает в среднем на 34 % более низкие затраты на инфраструктуру, на 42 % более низкую общую стоимость эксплуатации и 564 % окупаемости инвестиций в течение трёх лет. VCF помогает организациям быстро перейти на современную и интегрированную инфраструктуру, снижая сложность и время простоя, связанные с ручной миграцией существующих сред в частную облачную платформу. С VMware Cloud Foundation 9 Broadcom добавила возможность клиентам импортировать конфигурации NSX, vDefend, Avi Load Balancer и сложные топологии хранения в существующие среды VCF, а также использовать и интегрировать старые версии существующей инфраструктуры. Этому будет способствовать новый интуитивно понятный пользовательский интерфейс — VCF 9 включает в себя портал самообслуживания с единой консолью управления (вместо десятка с лишним панелей ранее), которая упрощает операции и автоматизацию. Кроме того, компания представила VMware Cloud Foundation (VCF) Advanced Services, каталог готовых к развёртыванию решений, упрощающих работу клиентов в своих частных облачных средах. VMware Cloud Foundation 9Обновлений платформы целое множество. Так, расширение пула DRAM посредством NVMe SSD (CXL) в VCF 9 позволит значительно улучшить работу приложений с интенсивным использованием данных, такие как ИИ, СУБД и аналитика в реальном времени, а также сократит задержку и ускорит передачу информации, что имеет решающее значение для задач обучения и инференса. Также это позволяет масштабировать производительность без чрезмерных затрат. А удалённая репликация снимков между vSAN поддерживает глубокую историю неизменяемых снимков, сокращая время простоя и упрощая оркестрацию аварийного восстановления, в том числе в изолированных on-premise окружениях. Также в VCF 9 включена функциональность VMware Cloud Director, благодаря чему в рамках одной платформы можно поддерживать несколько организаций или, например, групп разработки, сегментируя инфраструктуру на основе их конкретных требований к доступу, управлению рабочими нагрузками, безопасности и конфиденциальности. Кроме того, значительно упростилось создание виртуальных частных облаков (VPC), которые теперь можно формировать буквально в один клик, не занимаясь ручной настройкой VLAN и интеграцией с существующими сетями. Возможности VPC можно расшириить службами VMware vDefend и VMware Avi Load Balancer, которые также получили существенные обновления. Например, Avi Load Balancer лучше оптимизирован для сред VCF и Kubernetes и интегрирован со службой Tanzu Application Service. По словам Broadcom, это сокращает время развёртывания с недель до минут и повышает прозрачность работы на уровне L4–L7. Kubernetes-системы получат расширенными возможности по управлению трафиком и конвейерами CI/CD. vDefend был расширен с помощью распределённого анализа влияния правил брандмауэра и распределённой же системы IPS. Он поддерживает крупные и сложные среды, позволяя провести быструю оценку и профилирование угроз, в том числе в изолированных (air-gapped) окружениях. А в рамках Project Cypress компания готовит для vDefent интеллектуального помощника на базе генеративного ИИ, который будет проактивно находить возможные вектора атак, предлагать возможные варианты защиты, выявлять малоэффектвные политики безопасности и т.д. Пообщаться с ним можно будет на естественном языке. А гипервизор VMware может выступать в качестве датчика угроз для быстрой оценки защиты инфраструктуры. Broadcom также сообщила об обновлении платформы VMware Private AI Foundation with NVIDIA, предназначенный для предприятий, которые хотят использовать возможности ИИ, сохраняя при этом преимущества частного облака, представляющей собой комплексное решение для безопасного и эффективного развёртывания, управления и масштабирования ИИ-приложений на базе VCF. В VCF 9 компания упростила развёртывания платформ генеративного ИИ, расширив возможности управления и мониторинга vGPU и GPU, добавив службу индексации и извлечения данных, а также службу создания ИИ-агентов. Tanzu 10На конференции также была представлена 10-я версия унифицированной платформы VMware Tanzu, с помощью котороый разработчики могут автоматизировать защищённые сборки контейнеров, привязывать сервисы к приложениям, развёртывать код одной командой и легко масштабировать приложения, заявила Broadcom. Tanzu 10 также автоматизирует задачи управления приложениями и платформами, такие как исправление уязвимостей, развёртывание непрерывных обновлений и применение политик. Tanzu предоставляет ряд пакетных сервисов для VCF для автоматизированной и защищённой работы с контейнерами и данными. Новые функции включают поддержку изолированных среды, глобальный балансирощик, расширенные сетевые возможности (Avi Load Balancer), защищённые виртуальные машины, каталог образов с open source ПО. Наконец, встроенная среда разработки ИИ платформы Tanzu позволяет разработчикам создавать приложения Python без знания языка. Решения Tanzu AI Solutions включают, в том числе, такие функции:

Поддержка VMware Private AI Foundation with NVIDIA встроена в сервис GenAI on Tanzu Platform.

31.08.2024 [14:12], Сергей Карасёв

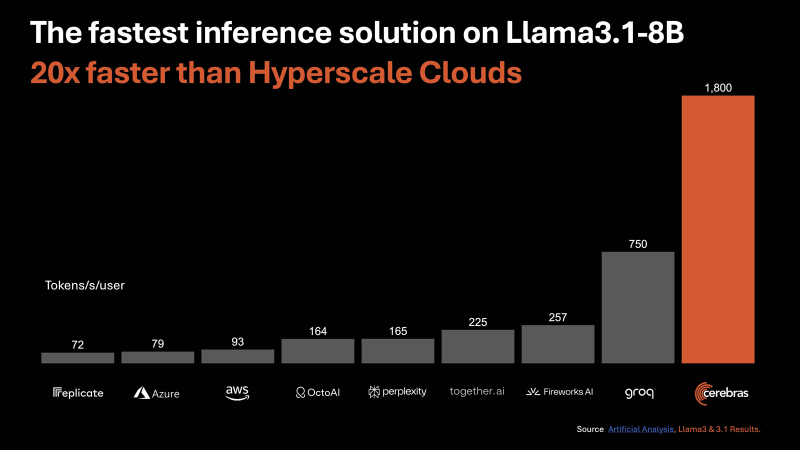

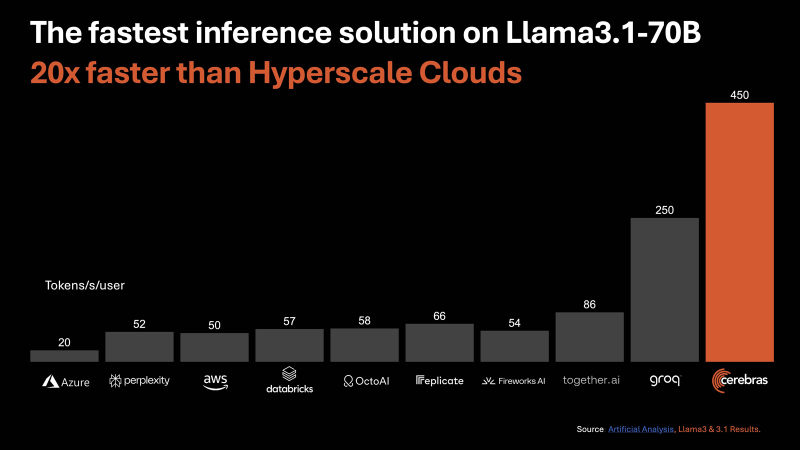

Cerebras Systems запустила «самую мощную в мире» ИИ-платформу для инференсаАмериканский стартап Cerebras Systems, занимающийся разработкой чипов для систем машинного обучения и других ресурсоёмких задач, объявил о запуске, как утверждается, самой производительной в мире ИИ-платформы для инференса — Cerebras Inference. Ожидается, что она составит серьёзную конкуренцию решениям на основе ускорителей NVIDIA. В основу облачной системы Cerebras Inference положены ускорители WSE-3. Эти гигантские изделия, выполненные с применением 5-нм техпроцесса TSMC, содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с, а внутреннего интерконнекта — 214 Пбит/с. Для сравнения: один чип HBM3e в составе NVIDIA H200 может похвастаться пропускной способностью «только» 4,8 Тбайт/с. По заявлениям Cerebras, новая инференс-платформа обеспечивает до 20 раз более высокую производительность по сравнению с сопоставимыми по классу решениями на чипах NVIDIA в сервисах гиперскейлеров. В частности, быстродействие составляет до 1800 токенов в секунду на пользователя для ИИ-модели Llama3.1 8B и до 450 токенов в секунду для Llama3.1 70B. Для сравнения, у AWS эти значения равны соответственно 93 и 50. Речь идёт об FP16-операциях. Cerebras заявляет, что лучший результат для кластеров на основе NVIDIA H100 в случае Llama3.1 70B составляет 128 токенов в секунду. «В отличие от альтернативных подходов, которые жертвуют точностью ради быстродействия, Cerebras предлагает самую высокую производительность, сохраняя при этом точность на уровне 16 бит для всего процесса инференса», — заявляет компания. При этом услуги Cerebras Inference стоят в несколько раз меньше по сравнению с конкурирующими предложениями: $0,1 за 1 млн токенов для Llama 3.1 8B и $0,6 за 1 млн токенов для Llama 3.1 70B. Оплата взимается по мере использования. Cerebras планирует предоставлять инференс-услуги через API, совместимый с OpenAI. Преимущество такого подхода заключается в том, что разработчикам, которые уже создали приложения на основе GPT-4, Claude, Mistral или других облачных ИИ-моделей, не придётся полностью менять код для переноса нагрузок на платформу Cerebras Inference. Для крупных предприятий предлагается план обслуживания Enterprise Tier, который предусматривает тонко настроенные модели, индивидуальные условия и специализированную поддержку. Стандартный пакет Developer Tier предполагает подписку по цене от $0,1 за 1 млн токенов. Кроме того, имеется бесплатный доступ начального уровня Free Tier с ограничениями. Cerebras говорит, что запуск платформы откроет качественно новые возможности для внедрения генеративного ИИ в различных сферах.

30.08.2024 [13:11], Руслан Авдеев

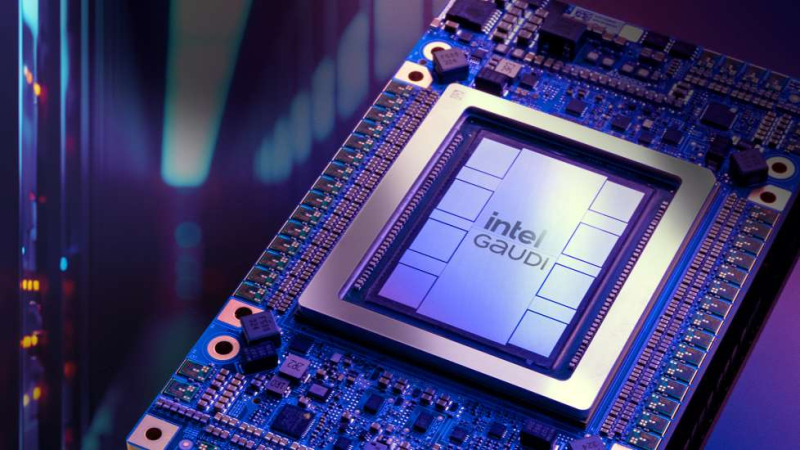

ИИ-ускорители Intel Gaudi 3 дебютируют в облаке IBM CloudКомпании Intel и IBM намерены активно сотрудничать в сфере облачных ИИ-решений. По данным HPC Wire, доступ к ускорителям Intel Gaudi 3 будет предоставляться в облаке IBM Cloud с начала 2025 года. Сотрудничество обеспечит и поддержку Gaudi 3 ИИ-платформой IBM Watsonx. IBM Cloud станет первым поставщиком облачных услуг, принявшим на вооружение Gaudi 3 как для гибридных, так и для локальных сред. Взаимодействие компаний позволит внедрять и масштабировать современные ИИ-решения, а комбинированное использование Gaudi 3 с процессорами Xeon Emerald Rapids откроет перед пользователями дополнительные возможности в облаках IBM. Gaudi 3 будут применяться и в задачах инференса на платформе Watsonx — клиенты смогут оптимизировать исполнение таких нагрузок с учётом соотношения цены и производительности. Для помощи клиентам в различных отраслях, в том числе тех, деятельность которых жёстко регулируется, компании предложат возможности IBM Cloud для гибкого масштабирования нагрузок, а интеграция Gaudi 3 в среду IBM Cloud Virtual Servers for VPC позволит компаниям, использующим аппаратную базу x86, быстрее и безопаснее использовать свои решения, чем до интеграции. Ранее сообщалось, что модель Gaudi 3 готова бросить вызов ускорителям NVIDIA. В своё время Intel выступила с заявлением о 50 % превосходстве новинки в инференс-сценариях над NVIDIA H100, а также о 40 % преимуществе в энергоэффективности при значительно меньшей стоимости. Позже Intel публично раскрыла стоимость новых ускорителей, нарушив негласные правила рынка.

28.08.2024 [12:44], Сергей Карасёв

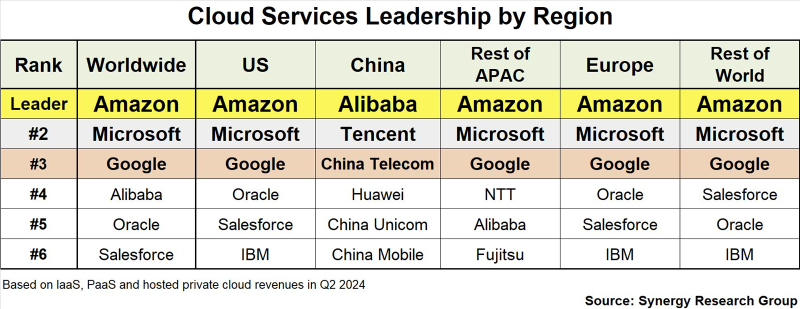

AWS, Microsoft и Google лидируют на облачном рынке во всех регионах мира, кроме КитаяКомпания Synergy Research Group обнародовала результаты исследования мирового облачного рынка во II квартале 2024 года. Глобальные затраты на услуги облачной инфраструктуры (включая IaaS, PaaS и частные сервисы) достигли $79 млрд. Расходы за 12 месяцев (к концу июня) составили примерно $297 млрд. Тройка лидеров в мировом масштабе остаётся неизменной: это компании Amazon (AWS), Microsoft и Google с долями 32 %, 23 % и 12 % соответственно. Далее следуют Alibaba, Oracle и Salesforce. Отмечается, что с географической точки зрения Amazon, Microsoft и Google лидируют во всех регионах мира, кроме Китая. В КНР в тройку ведущих облачных провайдеров входят Alibaba, Tencent и China Telecom, за которыми следуют Huawei, China Unicom и China Mobile. Такая картина объясняется геополитическими факторами, из-за которых западные поставщики облачных услуг ограничены в своих возможностях на китайском рынке. В Европе, Азиатско-Тихоокеанском регионе (за исключением опять же КНР) и других частях мира в рейтинг крупнейших облачных провайдеров также входят IBM, Oracle, NTT и Fujitsu (см. таблицу). В исследовании говорится, что США остаются крупнейшим рынком облачных услуг. Далее следует Китай, который значительно опережает другие страны, включая Японию, Великобританию, Германию и Индию. Сообща США, Китай, Азиатско-Тихоокеанский регион и Европа занимают более 90 % мирового рынка облачных сервисов. Synergy Research Group отмечает, что вместе Amazon, Microsoft и Google оперируют глобальной сетью из более чем 560 дата-центров. Только во II квартале 2024 года эти компании вложили свыше $48 млрд в развитие ЦОД-инфраструктуры: большая часть средств пошла на строительство, оснащение и обновление объектов и связанных с ними сетей.

26.08.2024 [11:34], Сергей Карасёв

По стопам Amazon: благодаря облаку годовая выручка IT-подразделения владельца супермаркетов Lidl достигла €1,9 млрд

software

австрия

германия

евросоюз

ии

импортозамещение

информационная безопасность

конфиденциальность

облако

финансы

Schwarz Group, владелец немецких сетей супермаркетов Lidl и Kaufland, по сообщению газеты Financial Times, активно развивает IT-бизнес. Речь идёт о предоставлении услуг облачных вычислений и кибербезопасности корпоративным клиентам на базе подразделения Schwarz Digits. Развёртыванием IT-сервисов Schwarz Group занялась в 2021 году, начав с системы, предназначенной для внутреннего использования. Целью было прежде всего устранение зависимости от третьих сторон. Поскольку в Германии подходящих провайдеров не было, группа стремилась, по крайней мере, использовать европейских поставщиков услуг во избежание хранения данных в других юрисдикциях. Придя к выводу, что ни один существующий провайдер не может удовлетворить её потребности, компания решила создать собственный облачный сервис — StackIT. В 2023 году подразделение Schwarz Digits стало самостоятельной операционной структурой. Годовая выручка достигла €1,9 млрд, а штат сотрудников составляет около 7500 человек. Клиентами Schwarz Digits являются, в частности, немецкий производитель ПО корпоративного класса SAP, футбольный клуб «Бавария» и порт Гамбурга. Основным преимуществом облачных сервисов Schwarz Digits является то, что все данные клиентов обрабатываются и хранятся исключительно в Германии и Австрии, где действуют строгие законы о конфиденциальности и защите информации. В 2023 году Schwarz Group решила заняться технологиями ИИ, приобретя миноритарную долю в немецком стартапе Aleph Alpha. Эта компания, основанная в 2019 году, занимается разработкой больших языковых моделей (LLM). Стартап делает упор на концепцию «суверенитета данных». Свои LLM фирма предлагает корпоративным заказчикам и государственным учреждениям. В конце прошлого года Aleph Alpha провела раунд финансирования на сумму более $500 млн, а одним из инвесторов стала Schwarz Group. По словам Акселя Опперманна (Axel Oppermann), владельца немецкой IT-консалтинговой компании Avispador, внимание Schwarz Digits к облачным вычислениям, кибербезопасности и ИИ было «хорошо продуманным», поскольку все три области представляют значительный интерес для клиентов. Фактически Schwarz Digits стала серьёзным региональным конкурентом таким гигантам, как Amazon Web Services (AWS), Google Cloud и Microsoft Azure. Однако для выхода на международный уровень, по мнению Опперманна, Schwarz Digits не хватает развитой партнёрской сети. |

|