Материалы по тегу: облако

|

10.03.2025 [17:43], Руслан Авдеев

Goldman Sachs: китайские телеком-операторы станут крупнейшими бенефициарами ИИ-бума, раньше всех взяв на вооружение продукты DeepSeekТри крупнейших китайских телеком-оператора получат максимальную выгоду от бума ИИ-технологий в Китае. Согласно исследованию Goldman Sachs-China, компании China Mobile, China Telecom и China Unicom становятся ключевыми бенефициарами благодаря наличию собственной облачной инфраструктуры и принятию на вооружение продуктов DeepSeek, сообщает блог IEEE Comsoc. Наличие у тройки лидеров крупнейшей в КНР облачной инфраструктуры позволяет обслуживать и другие облачные компании, а также предлагать собственные облачные сервисы конечным пользователям. В частности, их дата-центрами пользуется Alibaba. А собственная развитая сетевая инфраструктура позволяет снизить себестоимость услуг связи. Более того, другим операторам за передачу данных приходится платить именно «большой тройке» по рыночным ценам. Как считают в Goldman Sachs, в некоторых компаниях, предоставляющих в КНР услуги IaaS, например, QingCloud Technology на ЦОД и услуги связи уходит 50–60 % от общих расходов. «Большая тройка» сделала ставку на решения DeepSeek, поэтому имеют все шансы воспользоваться преимуществами раннего внедрения этих ИИ-технологий. При этом государство активно поддерживает использование ИИ на государственных предприятиях, на которые приходится до 30 % выручки телеком-операторов. В последние три недели операторы начали помогать ключевым клиентам в развёртывании LLM DeepSeek. China Mobile поддерживает PetroChina в развертывании полнофункциональной модели, China Telecom предоставляет ту же услугу Sinopec, а China Unicom сотрудничает с Фошаньским муниципальным бюро промышленности и информационных технологий. Более того, 21 февраля Комитет по контролю и управлению государственным имуществом Китая (SASAC) инициировала реализацию плана AI+, призванного стимулировать разработку и коммерческое применение ИИ китайскими государственными предприятиями. China Mobile также объявила, что использует ИИ для преобразования своих телекоммуникационных сетей в рамках стратегии AI+NETWORK, ориентированной на интеграцию ИИ в сетевую инфраструктуру.

07.03.2025 [17:24], Руслан Авдеев

CoreWeave опровергла слухи о расторжении контрактов с Microsoft перед многомиллиардным IPOCoreWeave опровергла сообщения прессы о том, что Microsoft якобы «отозвала» часть договорных обязательств непосредственно перед выходом облачного провайдера на IPO. Ранее об этом говорили источники, «знакомые с вопросом», сообщает Datacenter Dynamics. В частности, со ссылкой на собственные источники, The Financial Times писала, что Microsoft отозвала некоторые соглашения из-за проблем с поставками услуг и несоблюдением «дедлайнов». Microsoft якобы утратила доверие к CoreWeave, но сохраняла несколько ключевых контрактов и оставалась важным партнёром компании. На запрос Datacenter Dynamics в CoreWeave ответили, что «гордятся» партнёрскими отношениями с клиентами и фактов расторжения контрактов и отказов от обязательств не отмечено. «Любые утверждения об обратном являются ложными и вводящими в заблуждение», — подчеркнули в компании. Официального заявления со стороны Microsoft пока не было. CoreWeave подала заявку для выхода на IPO на этой неделе, так что подобные слухи могут крайне негативно сказаться на её будущей оценке. В заявке для Комиссии по ценным бумагам и биржам США (SEC) компания признаёт, что значительная часть доходов приходится на ограниченное число клиентов, так что потеря даже одного из них может отрицательно сказаться на бизнесе, финансовом положении и перспективах. В документе отмечается, что компании ещё предстоит исполнить договорные обязательства на сумму $15,1 млрд.

Источник изображения: Sebastian Herrmann/unsplash.com Около 77 % выручки CoreWeave в 2024 году пришлось всего на двух клиентов, крупнейшим из них является именно Microsoft (62 %). В ноябре того же года Microsoft утверждала, что потратит на услуги CoreWeave $10 млрд. Анализ обстоятельств вероятного IPO CoreWeave экспертами Next Platform свидетельствует о том, что Microsoft, кажется, «менее восторженно» относится к собственным расходам на ИИ — уже появились данные об отказе от некоторых проектов. В конце прошлого месяца появилась информация о том, что Microsoft отменила договоры аренды ИИ ЦОД приблизительно на 200 МВт. В отчёте TD Cowen предполагается, что компания, вероятно, закупила избыточные ёмкости, сделав некорректные прогнозы спроса. Отчасти это может быть связано с тем, что её ключевой партнёр OpenAI стремится перейти на собственную инфраструктуру в рамках проекта Stargate, поскольку это, вероятно, будет дешевле. Другими словами, хотя $15,1 договорных обязательств — весьма внушительный показатель для CoreWeave, не исключено, что основным клиентом остаётся именно Microsoft, которая может прекратить сотрудничество года через три — по имеющимся данным, средняя продолжительность контракта CoreWeave составляет около четырёх лет. В самой Microsoft отметили, что корректировка расходов в некоторых областях не помешает компании активно расти во всех регионах и она по-прежнему намерена потратить $80 млрд на ИИ-инфраструктуру в текущем финансовом году для удовлетворения рекордного спроса клиентов.

06.03.2025 [13:20], Руслан Авдеев

Выходящая на IPO компания CoreWeave купит за $1,7 млрд ИИ-разработчика Weights & BiasesCoreWeave Inc., занимающаяся облачной ИИ-инфраструктурой, объявила о намерении приобрести компанию Weights & Biases. Последняя специализируется на разработке ИИ-моделей, цена пока не раскрывается, сообщила The Information. План покупки компания подтвердила почти сразу после публикации — изначально сообщалось, что сделка оценивается в $1,7 млрд. Weights & Biases из Сан-Франциско привлекла более $250 млн с момента основания в 2017 году и создала платформу с инструментами, ускоряющими разработку ИИ — для управления массивами данных для обучения, тестирования влияния изменений модели на её производительность и др., для устранения технических неполадок. Также компания предлагает и специализированный инструментарий для устранения «галлюцинаций» моделей. Утверждается, что платформу использует более 1 млн ИИ-разработчиков, включая OpenAI, Meta✴, NVIDIA, Snowflake и Toyota Motor.

Источник изображения: CoreWeave Благодаря развитой облачной инфраструктуре CoreWeave клиенты компании могут получить доступ к современным ускорителям NVIDIA H100/H200. CoreWeave намерена интегрировать Weights & Biases в свою облачную платформу. Заказчики смогут не просто запускать свои модели в облаке, но и создавать и тестировать собственные. Уже имеющимся клиентам Weights & Biases обещают разрешить развёртывать свои модели где угодно без привязки к инфраструктуре CoreWeave, хотя рассмотрение такой возможности, вероятно, будет «поощряться». Покупка соответствует «обычным условиям закрытия» сделки и, как ожидается, завершится в I половине 2025 года. Это будет дополнительно способствовать выводу CoreWeave на биржу Nasdaq в конце текущего года. Заявка о выходе на IPO уже подана, бизнес будет торговаться под тикером CRWV. В заявке CoreWeave указывается, что её выручка взлетела на 700 % до $1,92 млрд в 2024 финансовом году. В будущем ожидается ещё больший рост, в «запасе» у CoreWeave есть контракты на сумму более $15 млрд, которые ещё предстоит выполнить. Правда, компания пока всё ещё убыточна, в минувшем году она недосчиталась $863,4 млн.

06.03.2025 [00:21], Владимир Мироненко

Да, платить за Windows Server вчетверо больше — это норма: Microsoft ответила на претензии британского регулятора CMA

microsoft

microsoft azure

software

sql server

windows server

великобритания

конкуренция

лицензия

облако

Призыв Google и AWS «вмешаться и ограничить цену», которую Microsoft взимает с них за лицензирование своего ПО в их облаках, является одновременно «экстраординарным и беспрецедентным», заявила Microsoft в ответ на публикацию Управлением по конкуренции и рынкам Великобритании (CMA) предварительных выводов по проводимому расследованию конкуренции на облачном рынке страны, сообщил The Register. По словам CMA, ситуация с конкуренцией могла бы быть лучше, но действия Microsoft этому не способствуют. Microsoft относит AWS и Google к т.н. зарегистрированным поставщикам, так что клиенты, желающие запустить, например, Windows Server не на платформе Azure, должны платить за лицензию в четыре раза больше. Оба поставщика пожаловались CMA, что это ставит их и их клиентов в невыгодное положение. CMA их поддержала, отметив, что «у Microsoft есть возможность и желание чинить AWS и Google препятствия при использования её программных продуктов» и что «такое поведение наносит ущерб конкуренции в сфере облачных сервисов». Просьбу Amazon и Google к CMA ограничить стоимость использования ПО Microsoft для создания и продажи облачных сервисов своим клиентам и отрегулировать цены на ПО для клиентов Azure редмондская корпорация расценила как «беспрецедентное вмешательство, грубо нарушающее её права на интеллектуальную собственность». «Ни один другой поставщик ПО в отрасли не подвергался бы подобным ограничениям», — заявила Microsoft, отметив, что «единственными бенефициарами этого средства правовой защиты являются Amazon и Google». Правда, клиенты, которые по какой-либо причине не хотят запускать продукты Microsoft в облаке Azure, могут с этим не согласиться, отмечает The Register. По словам Microsoft, клиенты с устаревшим ПО готовы перенести рабочие нагрузки в облако. Для Microsoft предпочтительно, чтобы они выбирали Azure, но её ПО всё равно в AWS, Google Cloud и других облаках. «Мы конкурируем, чтобы привлечь их бизнес различными способами, включая конкурентное ценообразование. Одним из способов является предоставление постоянной скидки на Azure и компенсации части стоимости Windows Server и SQL Server в случае, когда клиенты разворачивают рабочие нагрузки в Azure, которые частично зависят от этого ПО», — заявила Microsoft, подчеркнув, что именно в этом суть конкуренции, которая несёт только выгоду британским клиентам. Microsoft предложила CMA сравнить её стратегию с AWS S3, Aurora, DynamoDB и Google BigQuery, Looker, Google Analytics и другими, задав при этом вопрос: «Предоставляют ли AWS и Google лицензии на свое проприетарное ПО своим конкурентам, хоть за какие угодно деньги?». И сразу ответив на него: «Нет». В связи с этим Microsoft заявила, что чувствует себя несправедливо выбранной среди других. Правда, корпорация почему-то умолчала, что у неё самой есть сервисы, работающие исключительно в рамках Azure. Microsoft вновь заявила, что протесты её основных конкурентов не имеют под собой оснований, поскольку AWS является крупнейшим поставщиком облачных вычислений в Великобритании, где на её долю приходилось до половины от £9 млрд, потраченных клиентами в 2023 году. Доля Microsoft составила от 30 до 40 %. У Google Cloud лишь третья позиция, однако по состоянию на IV квартал прошлого года объём её операций в мире вырос до $36 млрд. Microsoft утверждает, что Google «потратила тысячи, если не миллионы долларов на то, чтобы встать на защиту “торговых ассоциаций”, которые, что неудивительно, повторяют её претензии антимонопольным органам и правительственным чиновникам». Тем временем британские компании уже подали коллективный иск к Microsoft, в котором утверждается, что клиенты AWS, Google Cloud Platform и Alibaba Cloud, вынуждены платить больше за лицензии на Windows Server, чем в Azure. В качестве компенсации пострадавшие требуют выплатить £1 млрд. Наличие платы за уход клиентов с облачных платформ, высокий уровень концентрации рынка и значительные барьеры для при миграции на другую платформу были указаны CMA среди проблем, касающихся всего облачного рынка Великобритании. AWS также подверглась резкой критике, а вот для Google Cloud сделали послабление из-за меньшей доли на рынке. В настоящее время CMA раздумывает, следует ли привлечь Microsoft к ответственности в связи с её практикой лицензирования и сборами за уход на другую платформу. Своё решение регулятор объявит позже в этом году.

05.03.2025 [14:12], Руслан Авдеев

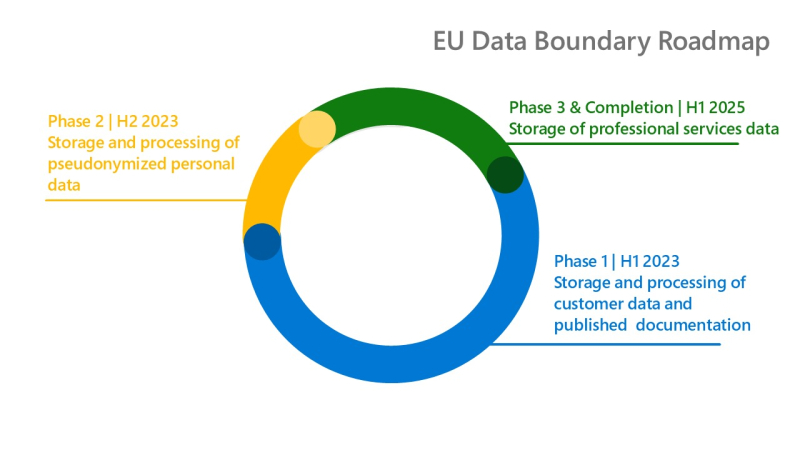

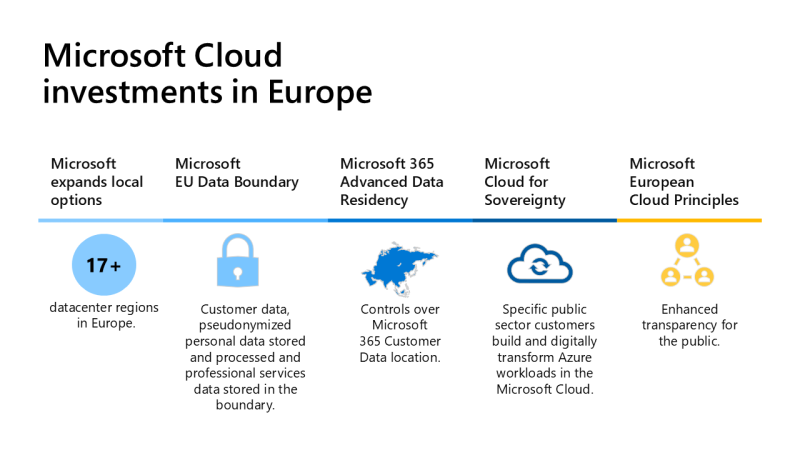

Microsoft завершила проект EU Data Boundary по созданию суверенного облака для пользователей из ЕвросоюзаКомпания Microsoft завершает проект EU Data Boundary, в рамках которого она организовала создание суверенного облака в границах ЕС. По данным компании, европейские клиенты из государственного и коммерческого секторов смогут хранить и обрабатывать данные, которые не будут покидать Евросоюз и территорию действия Европейского соглашения о свободной торговле (ЕАСТ). За последние 16 месяцев, по данным Microsoft, компания инвестировала более $20 млрд в ИИ и облачную инфраструктуру по всему континенту. На соответствующей территории также будут храниться и данные, связанные с профессиональными услугами, например — о контактах с технической поддержкой. В указанных границах правила «суверенного» хранения коснутся Microsoft 365, Dynamics 365, Power Platform и большинства сервисов Azure. При этом для некоторых сервисов Azure могут потребоваться дополнительное действие со стороны клиента, чтобы гарантировать, что данные профессиональных услуг также будут храниться в указанных регионах.

Источник изображения: Microsoft Согласно заявлению компании, EU Data Boundary отражает приверженность Microsoft намерению предоставлять «непревзойдённые» облачные сервисы, поддерживающие европейскую прозрачность, защищающие конфиденциальность и предоставляющие усиленный контроль со стороны пользователей. При этом компания отмечает, что в некоторых случаях, если для обеспечения безопасности требуется скоординированное глобальное реагирование, важные данные всё же могут передаваться с использованием «надёжных средств защиты», обеспечивающих сохранность данных клиентов. Datacenter Dynamics отмечает, что о проекте EU Data Boundary было объявлено в 2022 году, а работы начались в январе 2023-го. В июле того же года Евросоюз и США согласовали рамочную структуру обеспечения конфиденциальности данных — она допускает их передачу при сохранении конфиденциальности и гарантированных мерах защиты. Впрочем, компания и так неоднократно утверждала, что хранит данные облачных сервисов клиентов из Евросоюза на территории самого объединения, «суверенитет» доступен во всех регионах Azure.

Источник изображения: Microsoft Евросоюз традиционно более строго подходит к конфиденциальности и обеспечению суверенитета данных пользователей в сравнении с США. Закон о кибербезопасности (Cybersecurity Act), принятый в 2019 году, стал правовой основой для сертификации поставщиков облачных услуг на территории всего ЕС. Один из ранних проектов предусматривал создание американскими гиперскейлерами совместных предприятий с бизнесами из ЕС, а также хранения и обработки клиентских данных в Европе. Еврокомиссия отменила данное требование в апреле 2024 года. Вместо этого облачных провайдеров обязали предоставлять информацию о месте и времени хранение данных клиентов. Но, например, во Франции американские облачные компании по-прежнему обязаны сотрудничать с местным бизнесом. Например, Microsoft сотрудничает с Capgemini и Orange. Другие компании также развивают «суверенные» площадки. Oracle располагает двумя суверенными облачными регионами в Испании и Германии. AWS рассчитывает построить в Европе собственный облачный регион, первый из них должен появиться в Германии. В январе 2025 года сообщалось, что в Евросоюзе появится суверенная облачная платформа Virt8ra, призванная обеспечить переносимость и совместимость между сервисами различных поставщиков облачных услуг. В целом, по прогнозам IDC, объём мирового рынка суверенных облаков превысит $250 млрд в 2027 году.

04.03.2025 [17:14], Руслан Авдеев

CoreWeave, закупившая более 250 тыс. ИИ-ускорителей NVIDIA, подала заявку на IPO — капитализация компании может превысить $35 млрдПровайдер облачной инфраструктуры CoreWeave готов выйти на IPO и привлечь средства на фоне ненасытного спроса инвесторов буквально на любые продукты, связанные с ИИ, сообщает Silicon Angle. Компания уже выполнила подготовительные «бумажные» работы, связанные со взаимодействием с Комиссией по ценным бумагами и биржам США (SEC). Планируется выход на биржу Nasdaq под тикером CRWV. Первичное размещение будет проведено под руководством Morgan Stanley, также участие примут JPMorgan Chase и Goldman Sachs. Хотя CoreWeave нельзя назвать самым узнаваемым именем на рынке ИИ, компания оказала значимое влияние на индустрию, обеспечивая бизнесам облачный доступ к дефицитным ИИ-ускорителям NVIDIA H100 и H200. Компания уже распоряжается обширной сетью дата-центров, раскинутой от Северной Америки до Европы. В ходе раунда финансирования осенью 2024 года компания заявляла, что располагает 14 ЦОД и планирует увеличит их число до 28 к концу года. До конца 2025 года она планирует развернуть ещё 10 дата-центров. Ранее компания даже попыталась купить своего партнёра по ЦОД Core Scientific, но в итоге просто увеличила аренду. Амбициозные планы компании по созданию инфраструктуры необходимы для поддержки её роста. Выручка в 2024 году взлетела на 700 %, превысив $1,92 млрд. Компания обещает ещё более быстрый рост в будущем и уже подписала контракты на $15 млрд. Впрочем, прибыльности пока добиться не удалось, чистый убыток в минувшем году составил $863,4 млн. В последний квартал выручка составила $747,4 млн, валовая прибыль достигла 76%. Ожидаемая оценка компании по итогам IPO — более $35 млрд. CoreWeave была основана в 2017 году под именем Atlantic Crypto и изначально специализировалась на криптомайнинге. С началом нестабильности на рынке криптовалют в 2022 году компания решила, что иметь дело с ИИ выгоднее, тем более что на тот момент уже «выстрелил» ChatGPT, а у компании был опыт работы с HPC-инфраструктурой. Начались закупки тысяч ИИ-ускорителей, иногда даже под залог уже имеющихся ускорителей. Компания стала настоящим спасением для многих бизнесов, предлагая гибкие и относительно недорогие схемы доступа к ускорителям. Её подход контрастирует с предложениями AWS и Google Cloud. А Microsoft и IBM сами пользуются услугами CoreWeave.  Согласно поданным для IPO документам, сегодня 38 % голосов в компании принадлежит её главе Майклу Интратору (Michael Intrator), 7 % — хеджевому фонду Magnetar и 1 % — NVIDIA. Те же документы свидетельствуют о том, что компания сегодня располагает парком из более чем 250 тыс. ускорителей NVIDIA, хотя большинство из них — относительно старые модели. Производство новейших Blackwell стартовало в ноябре, они лишь начали появляться в портфолио компании. Ускорители AMD и других конкурентов NVIDIA компания не использует. Считается, что речь идёт о первом крупном IPO технологической компании в текущем году, обычно это время для индустрии приходится на «затишье». В прошлом году на торги вышли ServiceTitan, Rubrik, Astera Labs и Reddit. До этого значимых выходов на биржу не было буквально с конца 2021 года, поскольку экономические условия стали довольно неблагоприятными. Скоро примеру CoreWeave, возможно, последует другой интересный стартап. В сентябре 2024 года заявку на IPO подала Cerebras Systems Inc. — прямой конкурент NVIDIA. Впрочем, процесс замедлился, поскольку деятельностью компании заинтересовался Комитет по иностранным инвестициям Министерства финансов США.

03.03.2025 [11:30], Сергей Карасёв

IBM завершила сделку по покупке HashiCorp за $6,4 млрдКорпорация IBM после получения необходимых разрешений со стороны регулирующих органов завершила процедуру поглощения HashiCorp — разработчика набора открытых инструментов для управления облачной инфраструктурой. Стоимость сделки составила $6,4 млрд. О намерении купить HashiCorp компания IBM объявила в апреле прошлого года. Предполагалось, что слияние будет завершено до конца 2024-го, но сделкой заинтересовались различные антимонопольные органы, включая Управление по защите конкуренции и рынкам Великобритании (CMA) и Федеральную комиссию по торговле США (FTC). Одобрения были окончательно получены в феврале. Слияние является частью масштабной инициативы IBM, направленной на развитие концепции гибридного облака и повсеместное внедрение инструментов ИИ. Благодаря интеграции решений HashiCorp и IBM клиенты получат комплексную платформу для автоматизации развёртывания и координации рабочих нагрузок в различных инфраструктурах, включая локальные среды, гипермасштабируемые и частные облака. Особое внимание будет уделено объединению возможностей системы HashiCorp Terraform и платформа Ansible, которую IBM получила в результате приобретения Red Hat в 2018 году. Эти инструменты автоматизации сокращают объём работы, связанной с настройкой IT-инфраструктуры. Terraform ориентирована на предоставление облачных ресурсов, в то время как Ansible можно использовать для настройки ПО, работающего поверх этих ресурсов. Другим направлением совместной деятельности станет интеграция HashiCorp Vault (управление ключами шифрования, паролями и т.п.) с различными продуктами IBM, включая Ansible, OpenShift и Guardium. Кроме того, планируется интеграции Terraform и Cloudability (помогает компаниям отслеживать свои расходы на облако). В целом, как ожидается, покупка HashiCorp поможет IBM укрепить позиции в различных стратегических областях, таких как платформы Red Hat, Watsonx, безопасность данных, IT-автоматизация и консалтинг. Компании уже начали процесс объединения своих программных продуктов.

28.02.2025 [08:33], Руслан Авдеев

Не понимали, на что подписывались: чиновники Бирмингема не имели представления о специфике ERP Oracle Fusion до её провального внедренияСотрудники городского совета Бирмингема, курировавшие провальное внедрение ERP-системы Oracle Fusion, не понимали специфики выбранного программного обеспечения, сообщили аудиторы Grant Thornton. В результате крупнейший муниципалитет Европе остался без возможности управлять своими финансами, сообщает The Register. В апреле 2022 года городской совет Бирмингема принял «на вооружение» ERP-платформу Oracle Fusion на замену устаревшей, как тогда казалось, платформы SAP. С тех пор власти не могли справиться с ней для корректного управления финансами и теперь намерены внедрить продукт «с чистого листа». Общая расчётная стоимость проекта выросла с приблизительно £19 млн ($24,07 млн) до £108 млн ($137 млн). Отчёт независимых аудиторов Grant Thornton свидетельствует, что сотрудники городской совета и цифровой департамент не в полной мере понимали механизмы работы Oracle Fusion, выбранной для закупки в 2019 году. В результате властям приходилось полагаться на внешних партнёров. В то же время отсутствие необходимых знаний у подразделения цифровых и пользовательских сервисов (Digital and Customer Services) означало, что градоуправляющая структура не могла выступать в качестве «квалифицированного заказчика» и мотивированно критиковать работу системного интегратора Evosys и других исполнителей. Таким образом, неспособность должным образом инвестировать в возможности и потенциал ERP и эффективно управлять кадрами на ключевых позициях проекта привела к неудовлетворительным результатам и существенно повлияла на качество управление финансами муниципалитет. Совет заявил, что «примет к сведению» выводы аудиторов, и уже достигнут значительный прогресс в повторном внедрении ПО Oracle и «возвращении финансов в нужное русло». В муниципалитете утверждают, что проводят значительные работы для понимания проблем в системе и «извлечения уроков из того, что пошло не так». Более ранний отчёт показал, что спустя 2,5 года после запуска платформы Oracle система всё ещё не была «безопасной и не соответствовала требованиям». Де-факто она парализовала способность городского совета управлять финансами и отчитываться о движении средств. В Grant Thornton утверждают, что совет не полностью решил вопросы проектирования системы до её запуска и вряд ли получит полностью функционирующую систему до 2026 года — именно тогда запланирована вторая попытка внедрения. Стоит отметить, что бюджет Бирмингемского муниципалитета составляет около £3,2 млрд ($3,98 млрд) — из него покрываются расходы на социальное обеспечение, школы, вывоз мусора и др. Катастрофическое внедрение ERP-системы способствовало тому, что муниципалитет Бирмингема фактически обанкротился в сентябре 2023 года, вплоть до того, что потребовалось снизить яркость освещения на улицах. В апреле 2024 года также выяснилось, что журнал аудита в бухгалтерской системе не вёлся почти 18 месяцев, поэтому не было возможности определить, имели ли место случаи мошенничества в течение полутора лет с использованием системы. По данным агентства Audit Reform Lab, общая стоимость проекта фактически составит £216,5 млн, поскольку власти рассчитывали по итогам внедрения ERP сэкономить £69 млн только в 2023–2024 гг.

26.02.2025 [07:56], Владимир Мироненко

Резервное копирование с ИИ: Microsoft инвестировала в Veeam

microsoft

microsoft azure

software

veeam software

инвестиции

облако

резервное копирование

сотрудничество

Компания Veeam Software, поставщик средств для резервного копирования, восстановления и управления данными, сообщила о расширенном партнёрстве с Microsoft, в рамках которого последняя инвестировала в Veeam нераскрытую сумму средств для создания решений на основе ИИ. В рамках партнёрства Veeam сосредоточится на исследованиях и разработках, архитектурной экспертизе при поддержке Microsoft для создания передовых решений на основе ИИ. Также Veeam интегрирует ИИ-сервисы Microsoft, что позволит ей улучшить свои предложения:

Как сообщается, интеграция решений Veeam с ИИ от Microsoft поможет организациям:

Согласно пресс-релизу, 77 % компаний из списка Fortune 500 и 67 % из списка Global 2000 полагаются на решения Veeam для защиты своих данных от кибератак, сбоев и киберинцидентов. Сервис Veeam Data Cloud, построенный на инфраструктуре Microsoft Azure, предлагает резервное копирование как услугу (BaaS) для Microsoft 365 и Azure. Архитектура платформы построена на принципах Zero Trust и использует хранилище Azure Blob, изолированное от производственных сред. Как отметил ресурс StorageReview.com, партнёрство несёт выгоду обеим компаниям. Для Microsoft сотрудничество с лидером в области устойчивости данных повышает ценность её облачной экосистемы, повышая привлекательность Microsoft 365 и Azure для предприятий, ищущих безопасные и надёжные платформы. Для Veeam инвестиции Microsoft и более тесное сотрудничество с технологическим гигантом позволят ускорить внедрение передовых технологий ИИ в свои предложения, повышая их ценность.

24.02.2025 [12:15], Сергей Карасёв

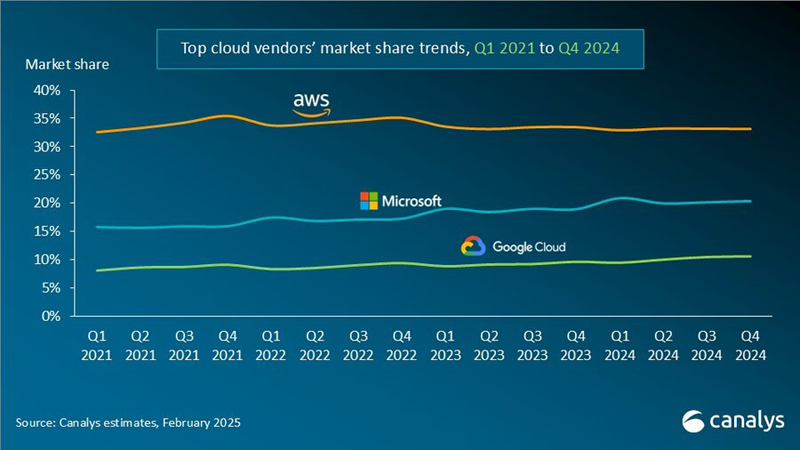

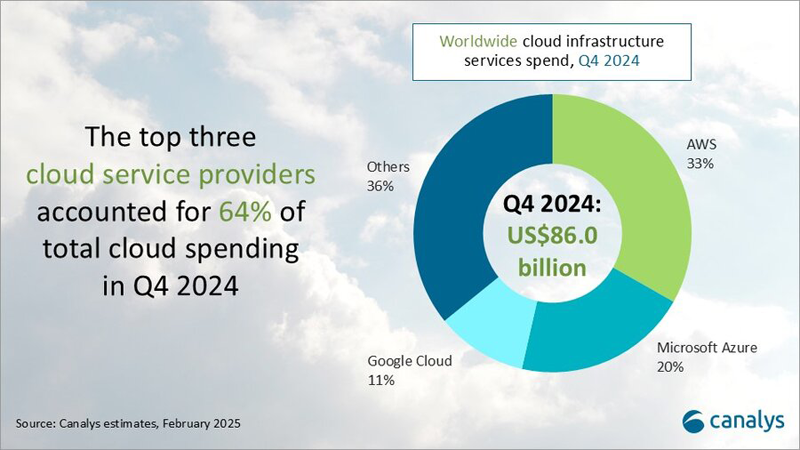

Canalys: объём мирового рынка облачных инфраструктур в 2024 году вырос на 20 %Компания Canalys подвела итоги исследования глобального рынка облачных инфраструктур: затраты в данной сфере продолжают быстро расти, что объясняется стремительным развитием ИИ. Аналитики ожидают, что в дальнейшем данная тенденция сохранится. Объём отрасли в IV квартале 2024-го достиг $86 млрд: это на 20 % больше по сравнению с аналогичным периодом предыдущего года. По итогам 2024 года в целом затраты также увеличились на 20 % — с $267,7 млрд до $321,3 млрд. На трёх ведущих поставщиков облачных услуг — AWS, Microsoft Azure и Google Cloud — пришлось 64 % от всей выручки, что эквивалентно $205,6 млрд.

Источник изображений: Canalys Лидером глобального рынка остаётся AWS с долей около 33 % в IV квартале и ростом на 19 % в годовом исчислении. За весь 2024 год выручка AWS превысила $100 млрд. Квартальные капитальные расходы AWS достигли $26,3 млрд. На втором месте в рейтинге ведущих облачных провайдеров располагается платформа Microsoft Azure, которая по итогам последней четверти 2024 года контролировала 20 % рынка при росте выручки на уровне 31 % год к году. Капитальные расходы Microsoft за квартал достигли $22,6 млрд. Замыкает тройку Google Cloud с 11 % рынка и ростом на 32 % в годовом исчислении. Все прочие игроки рынка в IV квартале 2024 года сообща удерживали приблизительно 36 % отрасли.  Отмечается, что ко II половине 2024 года все ведущие поставщики облачных услуг сообщили о положительной отдаче от инвестиций в ИИ, причём такие сервисы оказали заметное влияние на общую эффективность облачного бизнеса. Аналитики Canalys полагают, что в 2025 году мировые затраты на облачные инфраструктуры увеличатся примерно на 19 %, достигнув $382,3 млрд. |

|