Материалы по тегу: llm

|

29.02.2024 [23:59], Владимир Мироненко

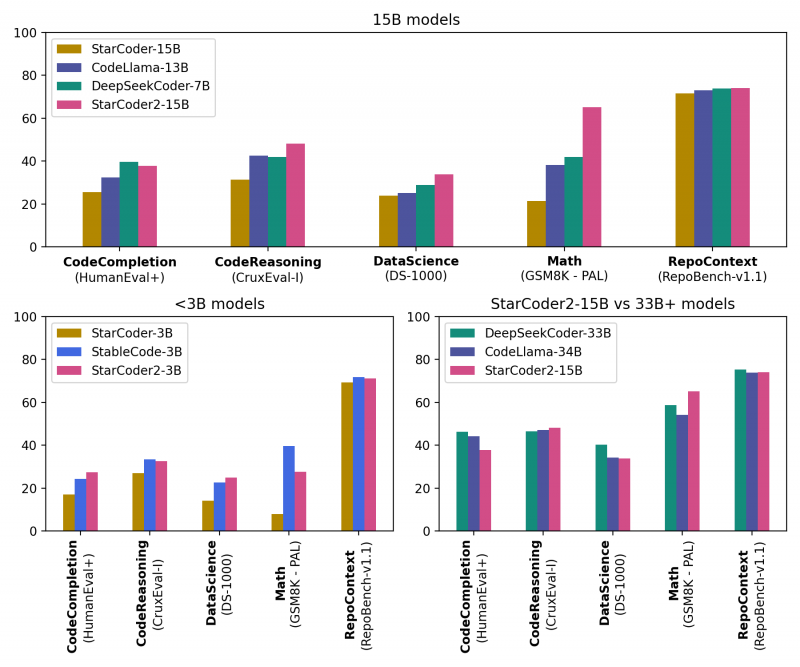

ServiceNow, Hugging Face и NVIDIA представили новое поколение ИИ-моделей StarCoder2 для генерации кодаКомпании ServiceNow, Hugging Face и NVIDIA представили семейство общедоступных больших языковых моделей (LLM) StarCoder2 для генерации кода, призванное помочь разработчикам использовать генеративный ИИ для создания корпоративных приложений. Семейство было разработано NVIDIA в сотрудничестве с исследовательским проектом BigCode, которым управляет ServiceNow, и Hugging Face, разработчиком открытой LLM-платформы. Модели StarCoder2 обучены 619 языкам программирования и могут быть дообучены на собственных данных и встроены в корпоративные приложения для выполнения специализированных задач, таких как генерация кода, управление рабочими процессами, обобщение текста и многое другое. Разработчики могут использовать автодополнение и обобщение кода, извлечение фрагментов кода и другие возможности. Набор StarCoder2 включает три модели: модель с 3 млрд параметров, обученная ServiceNow; модель с 7 млрд параметров, обученная Hugging Face; и модель с 15 млрд параметров, созданная NVIDIA с помощью NVIDIA NeMo. Варианты моделей с меньшим количеством параметров менее требовательны к вычислительной инфраструктуре, при этом модель StarCoder2 с 3 млрд параметров соответствует производительности исходной модели StarCoder с 15 млрд. параметров В основе StarCoder2 лежит новый набор данных Stack v2, который более чем в 7 раз больше, чем Stack v1. Кроме того, новые модели обучены работе с малораспространёнными языками вроде COBOL, «понимают» математику и могут обсуждать исходный код программ. Пользователи могут дообучить и настроить модели StarCoder2, используя данные, специфичные для отрасли или организации, с помощью NVIDIA NeMo или Hugging Face TRL. Разработчики смогут создавать продвинутых чат-ботов для решения более сложных задач обобщения или классификации и разрабатывать персонализированных помощников по программированию. Разработка ПО стала основной областью использования ИИ, чему отчасти способствовали такие инструменты как GitHub Copilot и AWS CodeWhisperer, отметил ресурс SiliconANGLE. Согласно недавнему опросу GitHub, 91 % разработчиков в США используют ИИ-инструменты для создания кода. Впрочем, опрос, проведённый CoderPad Inc., показал, что почти четверть разработчиков скептически относятся к ценности ИИ в работе, а 28 % и вовсе заявили, что их работодатель запрещает им пользоваться ИИ-инструментами. В числе причин негативного отношения — опасения, что ИИ-помощники создают неэффективный или уязвимый код, а также крадут интеллектуальную собственность, генерируя код на основе материалов, защищённых авторским правом, которые использовались при обучении модели. Создатели StarCoder2 подчёркивают, что модели были созданы с использованием данных Software Heritage, крупнейшей, по их словам, общедоступной коллекцию исходных кодов. В целях дальнейшего повышения прозрачности и сотрудничества вспомогательный код модели будет по-прежнему размещаться на странице проекта BigCode на GitHub. Он доступен по лицензии BigCode OpenRAIL-M, обеспечивающей бесплатный доступ и использование. Все модели StarCoder2 также будут доступны для загрузки с Hugging Face, а модель StarCoder2 с 15 млрд параметров доступна в составе NVIDIA AI Foundation.

29.02.2024 [13:01], Владимир Мироненко

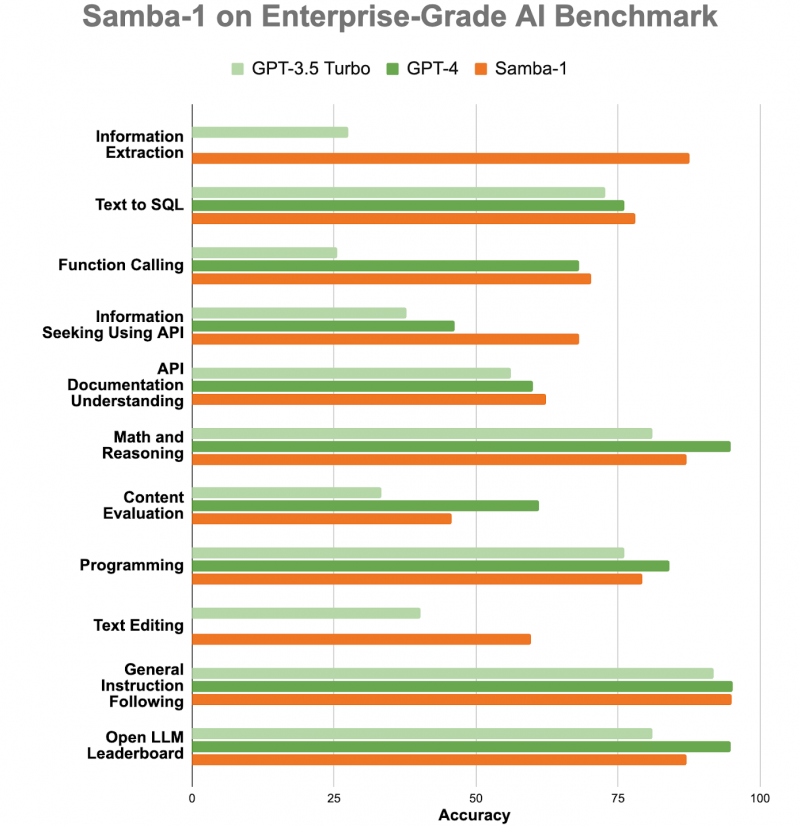

ИИ-консилиум: корпоративная LLM Samba-1 c 1 трлн параметров объединила более 50 открытых моделейСтартап SambaNova Systems представил Samba-1, модель генеративного ИИ с 1 трлн параметров, предназначенную для использования предприятиями. SambaNova описывает новую модель как «объединение экспертных архитектур» (Composition of Experts, CoE), которое включает более 50 открытых моделей генеративного ИИ высочайшего качества, в том числе Llama2 7B/13B/70B, Mistral 7B, DeepSeek Coder 1.3B/6.7B/33B, Falcon 40B, DePlot, CLIP, Llava. В частности, Llama 2 может генерировать текст, создавать программный код и решать математические задачи. Есть и более специализированные LLM, такие как DePlot от Google, которая может вводить информацию из диаграмм и других визуализаций данных в электронную таблицу. Samba-1 уже используется клиентами и партнёрами SambaNova, включая Accenture и NetApp. SambaNova позиционирует Samba-1 как первую модель с 1 трлн параметров для предприятий с регулируемой деятельностью, которая является приватной, безопасной и на порядок более эффективной, чем любая другая модель такого размера. Заказчик может установить контроль доступа к данным для отдельных пользователей. Желающие могут ознакомиться с работой модели. По словам главы SambaNova, Samba-1 оптимизирована для работы с чипом SN40L, выпущенным стартапом прошлой осенью. «Samba-1 способна конкурировать с GPT-4, но она лучше подходит для предприятий, поскольку её можно развернуть как локально, так и в частном облаке, чтобы клиенты могли точно настроить модель с использованием своих личных данных, не отдавая их в открытый доступ», — добавил он. SambaNova утверждает, что инференс этой модели обходится в десять раз дешевле, чем для конкурирующих LLM. Получив запрос, Samba-1 решает, какая из её внутренних моделей лучше всего приспособлена для его обработки, и поручает ей сгенерировать ответ. То есть активируется только одна из относительно небольших моделей, тогда как традиционные монолитные LLM требуют активации целиком. Стартап SambaNova привлёк около $1 млрд инвестиций от ряда компаний, включая Intel Capital и GV (инвестиционное подразделение Alphabet Inc). По итогам раунда финансирования в начале 2021 года рыночная стоимость стартапа оценивается в более чем $5 млрд.

28.02.2024 [13:10], Сергей Карасёв

ИИ-модели Mistral AI появятся на платформе Microsoft AzureКорпорация Microsoft объявила о заключении многолетнего партнёрского соглашения с французской компанией Mistral AI, которая специализируется на технологиях ИИ и разработке больших языковых моделей (LLM). В рамках договора Microsoft приобретёт небольшую долю в этом стартапе, оцениваемом приблизительно в €2 млрд. Сообщается, что Mistral AI сделает свои LLM доступными через облачную инфраструктуру Microsoft Azure. Речь, в частности, идёт о новой модели общего назначения Mistral Large. Она поддерживает французский, немецкий, испанский, итальянский и английский языки. Стороны намерены сотрудничать по трём ключевым направлениям. Одно из них — использование суперкомпьютерной инфраструктуры: Microsoft будет поддерживать Mistral AI с помощью платформы Azure AI, которая, как утверждается, обеспечивает «лучшую в своём классе производительность и масштабируемость» для обучения ИИ и задач инференса. Вторым направлением является вывод моделей Mistral AI на коммерческий рынок: доступ к LLM будет предоставляться по схеме MaaS (модель как услуга) на базе Azure AI Studio и Azure Machine Learning. Кроме того, Microsoft и Mistral AI намерены вести совместные исследования и разработки в области ИИ.

Источник изображения: pixabay.com «Мы очень рады начать партнёрские отношения с Microsoft. Благодаря передовой ИИ-инфраструктуре Azure мы достигнем новой вехи в развитии бизнеса и продвижении передовых решений», — сказал Артур Менш (Arthur Mensch), генеральный директор Mistral AI. Microsoft, которая вкладывает миллиарды долларов в компанию OpenAI, разработчика ИИ-бота ChatGPT, намерена инвестировать в Mistral AI около €15 млн. Это соглашение уже привлекло внимание со стороны Европейской комиссии. Антимонопольный регулятор ЕС хочет проверить условия сделки и оценивать её возможное влияние на рынок.

26.02.2024 [23:34], Владимир Мироненко

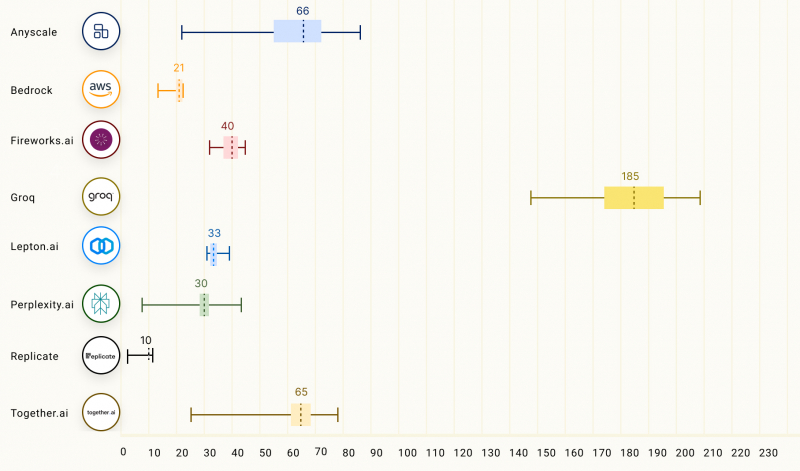

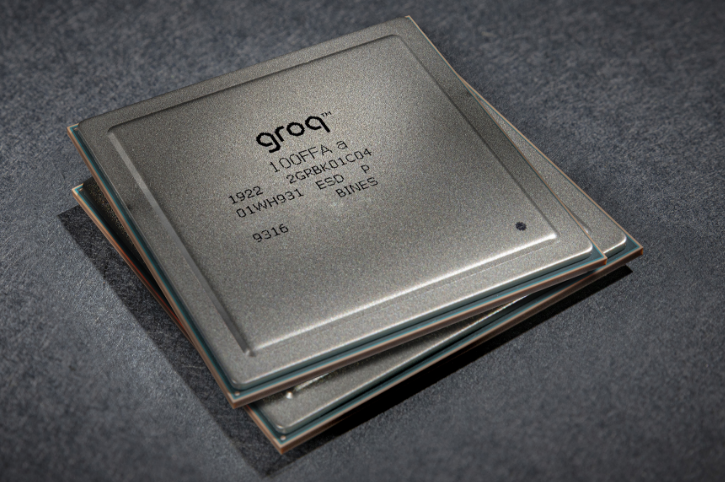

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

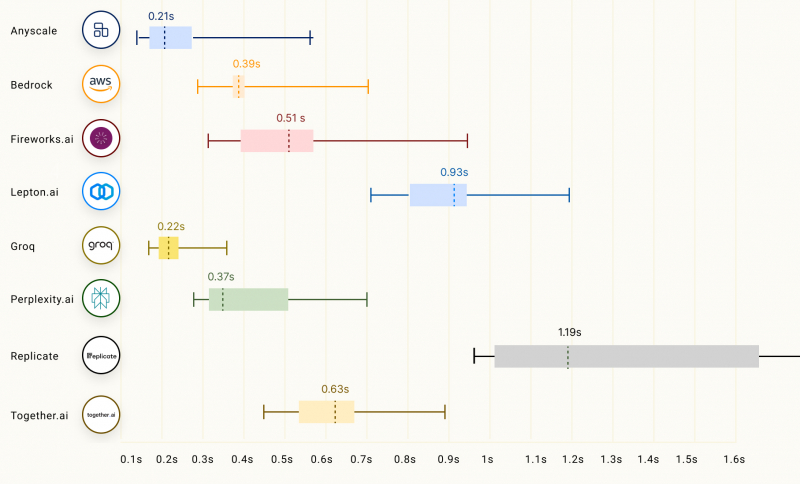

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США.

22.02.2024 [01:25], Владимир Мироненко

ИИ для защиты 5G: Nokia представила ассистента Telco GenAI, который поможет быстро выявить и нейтрализовать атаки на сети связиКомпания Nokia объявила о выходе телекоммуникационного ассистента на базе генеративного ИИ Telco GenAI, который будет интегрирован с облачным SaaS-решением для сетевой безопасности NetGuard Cybersecurity Dome, чтобы предоставить поставщикам услуг связи (CSP) и предприятиям возможность более быстрого и качественного обнаружения и разрешения проблем в условиях, когда киберпреступники всё чаще используют генеративный ИИ для более сложных атак на критическую инфраструктуру. NetGuard Cybersecurity Dome — это XDR-платформа Nokia, которая обеспечивает защиту сетей с помощью ИИ и машинного обучения. Nokia Telco GenAI будет интегрирован в платформу уже во II квартале. Он позволит ещё больше расширить возможности Cybersecurity Dome, быстро объединяя и интерпретируя огромные объёмы информации, связанной с киберугрозами, тем самым повышая эффективность функционирования Cybersecurity Dome при их выявлении и устранении. Nokia Telco GenAI использует сервис Microsoft Azure OpenAI для работы с большими языковыми моделями (LLM), которые были обучены на данных об архитектуре сетей 5G, методах обеспечения их безопасности и на опыте Nokia в сфере телекоммуникаций. Комплексное обучение предусматривало использование различных категорий информации, включая спецификации 3GPP и NIST, топологию 5G, охватывающую RAN, транспорт и ядро, а также MITRE ATT&CK и FiGHT (иерархия угроз). По оценкам Nokia, Telco GenAI позволит почти вдвое ускорить выявление и устранение угроз. Также предполагается существенное сокращение ложноположительных результатов и более эффективное и действенное выявление и обработку инцидентов кибербезопасности. По словам старшего вице-президента Nokia, интеграция NetGuard Cybersecurity Dome с новым ассистентом на базе генеративного ИИ обеспечит поставщикам услуг связи и предприятиям значительно большую гибкость в уменьшении последствий разрушительных атак.

14.02.2024 [23:00], Сергей Карасёв

Поговорить с машинами: Nokia представила ИИ-помощника MX Workmate для промышленных работниковКомпания Nokia анонсировала специализированный набор инструментов MX Workmate, который позволяет работникам промышленных предприятий «общаться» с машинами. В основу решения положены технологии генеративного ИИ и большая языковая модель (LLM). Отмечается, что организации по всему миру сталкиваются с нехваткой квалифицированной рабочей силы. Исследование, проведённое консалтинговой фирмой Korn Ferry, говорит о том, что к 2030 году дефицит технических специалистов в глобальном масштабе может достичь 85 млн человек. Это эквивалентно $8,5 трлн потенциальных потерянных доходов. Внедрение ИИ-инструментов может частично облегчить кадровую проблему. ИИ-помощник MX Workmate использует машинные данные для генерации сообщений на естественном языке. Это облегчает взаимодействие сотрудников предприятий с различным оборудованием, а также повышает эффективность работы и безопасность. В частности, MX Workmate позволяет работникам в режиме реального времени получать понятную информацию о состоянии производства, объемах и качестве выпускаемой продукции и пр. Кроме того, система выдаёт рекомендации по улучшению показателей. Используя Nokia Team Comms, сотрудники смогут задавать вопросы помощнику. Быстро анализируя поступающую информацию, ИИ-инструмент может выдавать ранние предупреждения о возможных неисправностях или грядущих поломках. Это упростит профилактическое обслуживание и поможет избежать серьёзных сбоев оборудования, минимизировав тем самым время простоя. Благодаря непрерывной оценке рисков MX Workmate может оперативно генерировать инструкции для работников в случае возникновения чрезвычайной ситуации: таким образом, сотрудники предприятий смогут действовать максимально безопасно. В целом, как утверждается, Nokia MX Workmate — это первое решение на основе генеративного ИИ, разработанное специально для производственных площадок. Помощник обеспечивает контекстно-зависимый обмен информацией в режиме реального времени между работниками и сложными системами безопасным способом с использованием естественного человеческого языка.

11.02.2024 [21:37], Владимир Мироненко

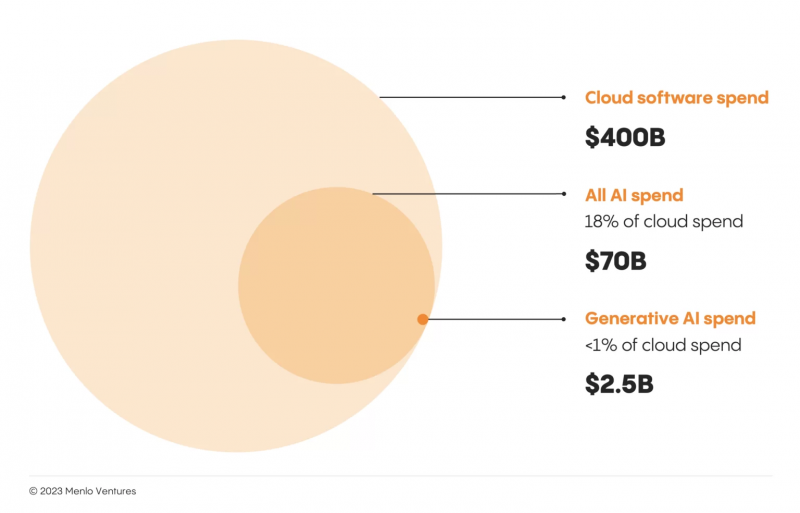

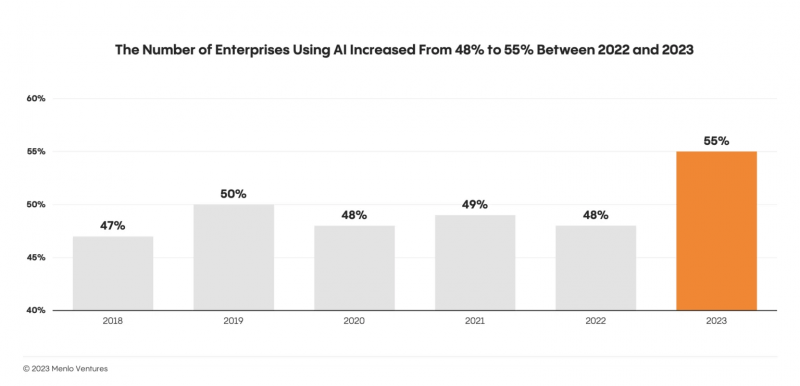

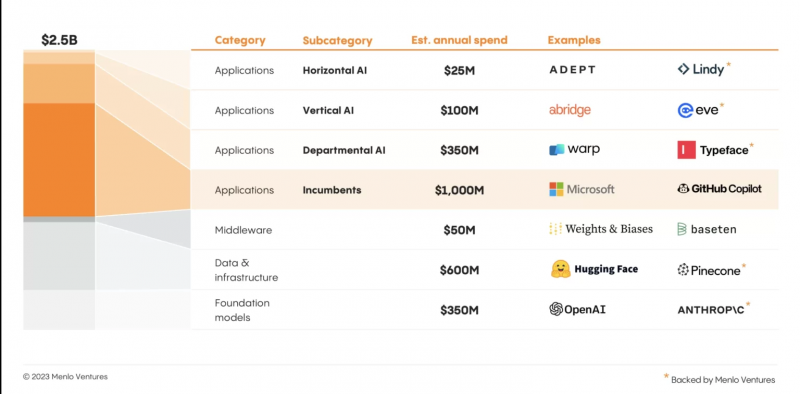

Menlo Ventures: запуск ChatGPT стал поворотным моментом, но рынок генеративного ИИ находится в зачаточном состоянииВенчурная компания Menlo Ventures опубликовала результаты исследования «Состояние генеративного ИИ на предприятиях». Чтобы получить представление о текущем уровне внедрения генеративного ИИ в корпоративном сегменте, исследователи опросили более 450 руководителей предприятий в США и Европе. Несмотря на шумиху вокруг данной технологи, исследование показало, что корпоративные инвестиции в генеративный ИИ по-прежнему малы по сравнению с другими категориями ПО. По оценкам Menlo Ventures, инвестиции предприятий в генеративный ИИ в 2023 году составят $2,5 млрд, что гораздо меньше расходов предприятий на традиционный ИИ ($70 млрд) и облачное ПО ($400 млрд). Следует отметить, что ИИ не является чем-то новым для предприятий, которые использовали традиционные технологии ИИ (компьютерное зрение, глубокое обучение и т. д.) задолго до появления генеративного ИИ. Половина участников опроса до 2023 года внедрила ту или иную форму ИИ, например, в продукты для клиентов или в системы внутренней автоматизации. Но запуск ChatGPT стал поворотным моментом: стратегия развития ИИ внезапно стала горячей темой среди руководителей, а принятие технологии возросло. Исследование показало, что после пяти лет застоя:

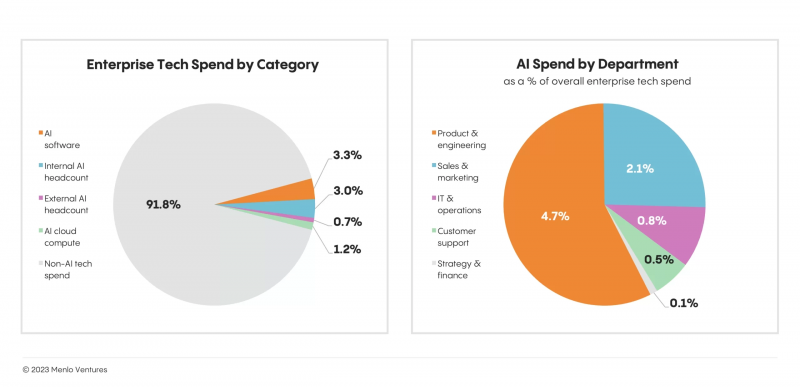

Инвестиции в генеративный ИИ способствовали увеличению расходов на ИИ вообще. При это 80 % респондентов сообщили о покупке стороннего ПО для генеративного ИИ вместо попыток самостоятельно создать такие решения. Говоря об опыте внедрения новых революционных технологий, аналитики отметили, что за первое десятилетие своего существования облако достигло 30 % расходов на корпоративное ПО; уровень проникновения интернета за тот же период достиг 45 %, а мобильной связи — 80 %. В 2023 году предприятия потратили около $2,5 млрд на генеративный ИИ, что способствовало развитию таких инструментов, как GitHub Copilot и Hugging Face (оба заработали десятки миллионов долларов). Но рынок всё ещё находится в зачаточном состоянии и корпоративные инвестиции в генеративный ИИ по-прежнему составляют менее 1 % всех расходов на облако. Что важно, популярность генеративного ИИ также стимулировала спрос на классические платформы для работы с данными, такие как Dataiku и Databricks. В настоящее время больше всего средств на генеративный ИИ тратят продуктовые и инженерные отделы. Причём они тратят больше (4,7 % всех расходов на технологии), чем все остальные отделы вместе взятые (3,5 %). При создании собственных систем ИИ предприятия вкладывают значительные средства в персонал и технологии, поручая традиционным разработчикам и специалистам по обработке данных создавать внутреннюю инфраструктуру, а некоторые нанимают дополнительных специалистов (ML-инженеров, исследователей и т. д.). Предприятия также вкладывают значительные средства в сторонние решения, составляющие основу современного стека ИИ. Как ожидают исследователи, по мере того как решения будут развиваться и приносить большую ценность, инвестиции в генеративный ИИ будут увеличиваться во всех подразделениях компаний. Тем не менее, согласно прогнозу Menlo Ventures, несмотря на ажиотаж, внедрение генеративного ИИ на предприятиях будет носить умеренный характер, как и раннее внедрение облачных технологий. Многие стартапы первой волны все еще пытаются дифференцироваться, что затрудняет завоевание позиций на рынке. Menlo Ventures прогнозирует, что рынок продолжит отдавать предпочтение игрокам, которые внедряют ИИ в существующие продукты. В борьбе за долю рынка генеративного ИИ существующие игроки быстро перешли к «стратегии встроенного ИИ». Исследователи ожидают, что их существующее преимущество сохранится в течение следующих нескольких лет, пока не станут преобладать новые и более мощные подходы вроде автономных агентов и многоэтапного размышления. Кроме того, Menlo Ventures полагает, что мощные контекстно-зависимые рабочие процессы с большим объёмом данных станут ключом к внедрению генеративного ИИ на предприятии. Аналитики Menlo Ventures определили три области, которые имеют огромный потенциал для развития стартапов:

28.01.2024 [21:40], Сергей Карасёв

Google Cloud и Hugging Face упростят создание и внедрение генеративного ИИКомпании Google и Hugging Face объявили о новом стратегическом партнёрстве, которое позволит разработчикам использовать облачную инфраструктуру Google Cloud для всех сервисов Hugging Face. Инициатива нацелена на ускорение разработки приложений генеративного ИИ и инструментов машинного обучения. По условиям соглашения, Google Cloud становится стратегическим облачным партнёром Hugging Face, предоставляя ресурсы для обучения моделей и инференса. Разработчики смогут использовать ИИ-инфраструктуру Google Cloud, включая CPU, тензорные процессоры (TPU) и GPU, для обучения и обслуживания открытых моделей, а также для создания новых приложений генеративного ИИ. В частности, клиенты получат возможность обучать и настраивать модели Hugging Face с применением Vertex AI — комплексной ИИ-платформы Google Cloud. Разработчики смогут применять фирменные ИИ-ускорители Cloud TPU v5e. В будущем появится поддержка инстансов GCE A3 на базе NVIDIA H100. Говорится о поддержке развёртываний Google Kubernetes Engine (GKE). Для управления и выставления счетов на платформе Hugging Face может использоваться сервис Google Cloud Marketplace.

Источник изображения: pixabay.com Hugging Face, основанная в 2016 году, разрабатывает инструменты для создания приложений с использованием машинного обучения. В частности, она предлагает библиотеку Transformers для работы с ИИ-моделями. Ранее Hugging Face заключила соглашение о сотрудничестве с Dell: стороны помогут корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ.

24.01.2024 [15:34], Руслан Авдеев

Oracle представила облачную ИИ-платформу OCI Generative AI, которая готова побороться с Microsoft Azure OpenAIOracle Corp. представила облачный сервис Oracle Cloud Infrastructure Generative AI (OCI Generative AI). Как сообщает пресс-служба компании, многочисленные инновации позволяют крупным компаниям применять новейшие достижения в сфере генеративного искусственного интеллекта для обучения собственных языковых моделей. Сервис позиционируется, как альтернатива решениям Azure OpenAI компании Microsoft. Сервис представляет собой решение, позволяющее бизнесам использовать большие языковые модели (LLM) вроде открытой Llama 2 или решения Cohere Inc., интегрируя их с существующими системами и данными клиентов. Благодаря этому последние смогут автоматизировать многие из процессов, выполнявшихся вручную. Сервис OCI Generative AI поддерживает более 100 языков и обеспечивает оптимизированное управление кластерами ускорителей. В Oracle уверены, что предлагаемые LLM помогут в генерации текстов, составлении резюме материалов и выполнении прочих задач, причём их можно будет интегрировать с уже существующими разработками. Корпоративные пользователи смогут безопасно дообучать модель на своих данных — пока проводится бета-тестирование с опцией тонкой настройки для получения ответов с учётом контекста. Сервис интегрируется с пакетом облачных бизнес-приложений Oracle, включая Oracle Enterprise Resource Planning, Human Capital Management, Supply Chain Management и Customer Experiences. Также будут расширены возможности платформы OCI Data Science, где в следующем месяце появится бета-версия функции AI Quick Actions, обеспечивающей доступ к различным моделям с открытым кодом без необходимости программирования. Это позволит клиентам строить, тренировать и внедрять LLM на основе открытого кода, а также управлять ими. В целом, Oracle ориентирована на предоставление готовых ИИ-сервисов и функций, взаимодействующих друг с другом для помощи клиентам в решении бизнес-задач. Oracle признаёт, что в сфере ИИ отстаёт от Microsoft, Google и Amazon, но возможность интеграции ИИ с ERP, HCM, SCM и CX-приложениями делает новые решения более привлекательными. При этом, по словам компании, у неё есть сразу несколько важных преимуществ перед конкурентами. Во-первых, производительная облачная СУБД, которой пользуются даже Microsoft и NVIDIA. Во-вторых, широкие инвестиции в облако, на что уходит до половины свободного денежного потока компании. В-третьих, решения Oracle для бизнеса обеспечивают уникальный опыт работы с ИИ, который не могут предложить конкуренты, сконцентрированные на PaaS и IaaS. Запуск новой службы должен помочь Oracle привлечь корпоративных клиентов. Кроме того, компания прилагает усилия для того, чтобы стать ключевым инфраструктурным игроком, обеспечивая доступ к передовым ускорителям NVIDIA. В декабре сообщалось, что компания построит 100 новых облачных ЦОД по всему миру. OCI Generative AI уже доступен в нескольких регионах Oracle Cloud, но может быть развёрнут и локально в рамках Dedicated Region.

14.01.2024 [21:18], Владимир Мироненко

Учёные ORNL сумели обучить LLM с 1 трлн параметров, задействовав всего 3072 ускорителя AMD Instinct MI250XКоманда специалистов Национальной лаборатории Ок-Ридж обучила большую языковую модель (LLM) с 1 трлн параметров на суперкомпьютере Frontier, используя лишь 3072 из имеющихся 37 888 ускорителей. LLM такого масштаба сравнима по возможностям с OpenAI GPT4. Кроме того, учёные смогли обучить LLM со 175 млрд параметров, задействовав всего лишь 1024 ускорителя. При обучении LLM с миллиардами параметров требуются значительные вычислительные ресурсы и большой объём памяти. Учёные ORNL занялись исследованием вопроса оптимизации этого процесса и изучили различные фреймворки, методы работы с данными и параллелизацией обучение, оценив их влияние на память, задержку коммуникаций и уровень эффективности использования ускорителей.

Источник изображения: ORNL Прорыва удалось достичь благодаря точной настройке гиперпараметров и оптимизации всего процесса обучения. Команда Frontier провела исчерпывающие тесты с различными параметрами, и в итоге стал возможен процесс обучения LLM с 1 трлн параметров с использованием всего 3 тыс. ускорителей AMD Instinct MI250X. Задача осложнялась тем, что для работы с ними используется ROCm, тогда как для подавляющего большинства ИИ-инструментов требуется поддержка NVIDIA CUDA. Результаты показали, что фактическая пропускная способность ускорителей составила 31,96 % для модели с 1 трлн параметров и 36,14 % для модели с 17 млрд параметров. Кроме того, для обеих моделей исследователи достигли 100-процентной эффективности слабого масштабирования и высокой эффективности сильного масштабирования: 89 % для модели со 175 млрд параметров и 87 % для модели с 1 трлн параметров. Впрочем, в исследовании не уточняется, сколько времени ушло на обучение этих моделей. |

|