Материалы по тегу: llm

|

29.12.2023 [18:10], Руслан Авдеев

Reliance создаст индийскую языковую модель Bharat GPT и развернёт ИИ-экосистему Jio 2.0Глава индийской Reliance Jio Акаш Амбани (Akash Ambani) раскрыл планы компании на ближайшее будущее. По данным DigiTimes, компания намерена расширять работу над генеративными ИИ-решениями и, что не менее важно, обновить мобильную экосистему Jio, представив вариант 2.0, включающий продукты и сервисы на основе искусственного интеллекта. Как свидетельствует опрос, проведённый Automation Anywhere, 63 % индийских компаний инвестируют в ИИ и технологии машинного обучения для автоматизации собственных бизнес-процессов уже в ближайшие 12 месяцев. Рост инвестиций в ИИ-сектор составил 85 % год к году, а 33 % этих компаний полагаются на ИИ как на драйвер будущего роста.

Источник изображения: geralt/pixabay.com По информации индийских и зарубежных СМИ, на мероприятии IIT Bombay TechFest, проводившемся Индийским технологическим институтом Бомбея (IIT Bombay), компанией было объявлено о совместной разработке с институтом ИИ-проекта Bharat GPT. Преимущество Reliance Jio в её многопрофильности — это не просто телеком-оператор, но и поставщик потокового медиаконтента, оператор площадок для электронной коммерции и т.п. Сообщается, что Reliance планирует запустить ИИ-сервисы во всех сферах своей деятельности, включая медиа- и коммуникационные проекты, и даже внедрять их на предлагаемых компанией устройствах. Более того, по данным Амбани компания разрабатывает собственную ОС для смарт-телевизоров и уже обдумывает механизмы её внедрения. Более подробной информации об экосистеме Jio 2.0 бизнесмен не предоставил. Впрочем, о создании большой языковой модели и масштабной ИИ-инфраструктуры компанией Reliance совместно с NVIDIA сообщалось ещё в сентябре. По прогнозам экспертов EY India, генеративный ИИ, вероятно, совокупно добавит $1,2–1,5 трлн в ВВП страны в следующие семь лет. При этом в краткосрочной перспективе развитие отрасли, вероятно, столкнётся с проблемами из-за дефицита кадров.

14.12.2023 [14:53], Сергей Карасёв

Платформа Lightning AI Studios упростит создание и развертывание ИИ-приложенийКомпания Lightning AI, разработчик популярного фреймворка PyTorch Lightning, анонсировала платформу Lightning AI Studios, призванную упростить создание и развертывание ИИ-приложений. Решение предоставляет единую среду для подготовки данных, разработки моделей, распределённого обучения и пр. Новая платформа интегрирована с PyTorch Lightning: этот высокопроизводительный фреймворк, основанный на PyTorch, автоматизирует многие ручные задачи, связанные с разработкой ИИ-приложений. PyTorch Lightning также сокращает объём кода, который приходится писать разработчикам для использования различных аппаратных компонентов, таких как CPU и GPU.

Источник изображения: pixabay.com Благодаря Lightning AI Studios разработчики получают дополнительные инструменты, которые помогают интегрировать модели, созданные с помощью PyTorch Lightning, в полноценные и готовые к использованию ИИ-приложения. Запущенная платформа предоставляет все необходимые средства для реализации ИИ-проектов, говорят создатели. Таким образом, как утверждает Lightning AI, повышается скорость развертывания при одновременном снижении затрат — как для индивидуальных разработчиков, так и для корпоративных клиентов. Платформа Lightning AI Studios предоставляет готовые шаблоны для ускорения создания ИИ-моделей. Упомянута возможность масштабирования путём быстрого переключения с виртуальных машин на базе CPU на более мощные машины с GPU. Система также упрощает обучение больших языковых моделей (LLM) с нуля. Разработчики могут использовать Lightning AI Studios для точной настройки различных LLM, таких как Llama 2, Code Llama и Mistral 7B, на основе собственных данных. Клиенты могут создавать ИИ-продукты на базе облака AWS, которое используется по умолчанию, или же перейти на ресурсы в локальном дата-центре. Затраты отображаются в режиме реального времени, что позволяет эффективно масштабировать вычислительные мощности с учётом имеющегося бюджета.

14.12.2023 [00:49], Владимир Мироненко

ИИ-модель Gemini Pro появилась в Google Vertex AIGoogle объявила о доступности для разработчиков и компаний LLM Gemini Pro в Vertex AI, комплексной ИИ-платформе Google Cloud, включающей различные инструменты, полностью управляемую инфраструктуру и встроенные функции конфиденциальности и безопасности. С помощью Gemini Pro разработчики смогут создавать «агенты», способные обрабатывать входящую информацию и действовать на её основе. Vertex AI позволяет настраивать и развертывать Gemini Pro, обеспечивая возможность создавать новые и дифференцированные приложения, которые могут обрабатывать информацию в виде текста, кода, изображений и видео. Доступ к Gemini Pro осуществляется через Google AI Studio. Это бесплатный веб-инструмент, с помощью которого разработчики могут разрабатывать диалоговые системы, позволяющие тестировать и использовать модель. Даётся бесплатная квоту на обработку до 60 запросов в минуту. Впоследствии будет взиматься плата в размере $0,00025 за ввод 1000 символов или $0,0025 за ввод изображения и $0,00005 за вывод 1000 символов.

Источник изображения: geralt/Pixabay Google предлагает доступ к Gemini Pro, которая представляет собой текстовую модель с контекстным окном на 32 тыс. токенов, и к Gemini Pro Vision, которая принимает текст и изображения или видео в качестве входных данных и выводит текст. Модель поддерживает 38 языков и доступна в 180 странах. Google AI Studio позволяет экспортировать проделанную в работу в другие среды разработки, в том числе в Vertex AI. Для Gemini Pro также доступны комплекты разработки ПО, позволяющие создавать приложения с использованием Python, Node.js, Kotlin (Android), Swift (iOS) и JavaScript. По словам Google, одним из главных преимуществ Vertex AI с Gemini является то, что разработчики и корпоративные пользователи могут выполнять тюнинг моделей с использованием данных компании, а также дополнять их для генерации ответов в соответствии с особенностями стиля бренда или добавлять информацию в реальном времени из общедоступных и частных баз данных. Google также объявила об общедоступности Duet AI for Developers, набора вспомогательных ИИ-инструментов для дополнения и генерации кода. Ассистент Duet AI доступен в нескольких интегрированных средах разработки, используемых для написания, тестирования, компиляции и развёртывания кода: Cloud Shell Editor, Cloud Workstations, PyCharm и Visual Studio Code. Duet AI поддерживает более 20 языков программирования, включая C, C++, Go, Java, JavaScript и Python. В ближайшие недели Duet AI for Developers будет подключён к Gemini.

06.12.2023 [00:18], Руслан Авдеев

Индия намерена построить суверенную ИИ-инфраструктуруВ рамках масштабных инициатив, связанных с цифровизацией общества, Индия рассчитывает построить суверенную ИИ-инфраструктуру. Как сообщает Datacenter Knowledge, местные власти уверены в необходимости самостоятельного прогресса в данной сфере. По словам министра электроники Раджива Чандрасекара (Rajeev Chandrasekhar), стране необходим собственный независимый ИИ. Власти не готовы довольствоваться ИИ-экосистемой, управляемой Google, Meta✴, а также некоторыми индийскими стартапами и компаниями. Индия будет принимать участие в американских и европейских инициативах, параллельно разрабатывая собственную стратегию. В правительстве рассчитывают использовать новые технологии для социально-экономического развития. Идею в ходе недавнего визита в Индию поддержал глава IBM Арвинд Кришна (Arvind Krishna), который заявил, что каждая страна должна иметь определённый суверенитет в сфере ИИ, включая собственные большие языковые модели (LLM). Индия уже начала принимать меры по развитию собственных инициатив. Так, Министерство электроники и информационных технологий намерено предоставлять обезличенные данные из правительственных баз стартапам и научным организациям. Предполагается, что это будет способствовать совершенствованию системы управления и развитию экосистемы стартапов. Также рассматривается возможность получать по запросу массивы обезличенных данных и у IT-гигантов вроде Google и Meta✴. В последние годы Индия уделяет большое внимание строительству собственной цифровой инфраструктуры. В частности, она реализует крупные проекты т.н. «цифровой общественной инфраструктуры» (DPI) — вроде Aadhaar и Unified Payment Interface (UPI), вызывающие интерес далеко за пределами государства. Например, Aadhaar предполагает биометрическую идентификацию всех граждан Индии, а UPI представляет собой популярную платёжную платформу. Недавно Индия запустила и глобальный репозиторий Global Digital Public Infrastructure Repository (GDPIR) для объединения ресурсов и идей стран «большой двадцатки» G20 в области проектирования и создания DPI. Репозиторий объединяет программные решения и различные находки. Полученные решения и данные страна в числе прочего намерена использовать для создания «домашнего» ИИ, что поможет ей снизить зависимость от глобальных техногигантов.

04.12.2023 [09:36], Владимир Мироненко

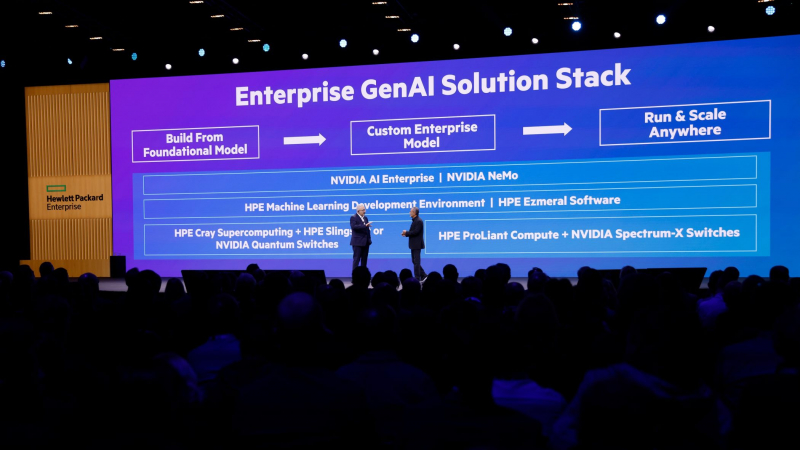

HPE и NVIDIA представили совместное решение для корпоративного ИИ, а HPE анонсировала LLM-платформу Project EthanHewlett Packard Enterprise (HPE) объявила о расширении стратегического сотрудничества с NVIDIA с целью создания инструментов для генеративного ИИ. Совместно разработанное, предварительно настроенное решение позволит предприятиям любого размера использовать собственные данные для быстрой настройки посредством RAG базовых ИИ-моделей, которые были обучены на больших наборах данных и могут быть адаптированы для выполнения различных задач от периферии до облака. HPE и NVIDIA также предоставляют в рамках сотрудничества полнофункциональные готовые решения для обработки приложений ИИ. Эти решения объединяют ПО фирменные среды разработки HPE для машинного обучения, HPE Ezmeral, платформы HPE ProLiant и HPE Cray, а также программный пакет NVIDIA AI Enterprise, включая NVIDIA NeMo. Аппаратная составляющая включает 16 серверов HPE ProLiant DL380a, несущих в общей сложности 64 ускорителя NVIDIA L40S и использующих DPU NVIDIA BlueField-3 и NVIDIA Spectrum-X.

Источник изображений: HPE Программно-аппаратный комплекс, например, позволяет дообучить на собственных данных модель Llama 2 с 70 млрд параметров. Решение включает ПО HPE Machine Learning Development Environment с новыми возможностями в области генеративного ИИ для быстрого прототипирования и тестирования моделей, а также ПО HPE Ezmeral с поддержкой ускорителей, которое упростит развёртывания и ускорит подготовку данных для ИИ-нагрузок в гибридном облаке. Партнёры HPE смогут заказать решение уже в I квартале 2024 года. Заодно HPE анонсировала платформу Project Ethan, ориентированную на оркестрацию ресурсов в локальных или публичных облаках для работы с большими языковыми моделями (LLM). Кроме того, компания сообщила, как планирует более полно адаптировать платформу Greenlake для работы с ИИ. Например, OpsRamp, ИИ-решение для управления ИТ-операциями (IT Operations Management, ITOM), приобретённое компанией в марте этого года, уже доступно по подписке в Greenlake. В OpsRamp добавлен HPE Sustainability Insight Center — инструмент для отслеживания и мониторинга энергопотребления ИТ-ресурсов, которыми управляет организация. Это было сделано для удобства клиентов, которые обучают и используют модели ИИ, и хотят контролировать потребление энергии. Обучение и инференс LLM, по словам компании, требует больших затрат электроэнергии — 1200 МВт·ч и 250 МВт·ч в день соответственно. Инструмент позволит управлять энергопотреблением с учётом возможностей компании. Также HPE представила пакет ПО Greenlake Hybrid Operations, объединяющий Ezmeral, OpsRamp с Sustainability Insight Center и набор решений для резервного копирования и восстановления HPE Data Protection Suite. Он позволит клиентам управлять, контролировать и защищать свои данные и рабочие нагрузки от периферии до облака.  В ближайшее время будет представлено и решение HPE Private Cloud Solutions для ИИ, основанное на аппаратных решениях HPE, обновлённой платформе HPE Greenlake for File Storage (эффективная ёмкость до 250 Пбайт, до 700 Гбайт/с на чтение и до 200 Гбайт/с на запись), OpsRamp и Zerto Cyber Resilience Vault. Последнее решение представляет собой автономную платформу для данных, которая помогает восстановить работу после атаки программы-вымогателя, если данные зашифрованы или удалены. Полная информация и даты доступности новых продуктов не разглашаются. Как сообщает ресурс The Register, решение объявить о них на мероприятии HPE Discover EMEA было принято в последнюю минуту.

30.11.2023 [03:10], Игорь Осколков

ИИ в один клик: llamafile позволяет запустить большую языковую модель сразу в шести ОС и на двух архитектурахMozilla представила первый релиз инструмента llamafile, позволяющего упаковать веса большой языковой модели (LLM) в исполняемый файл, который без установки можно запустить практически на любой современной платформе, причём ещё и с поддержкой GPU-ускорения в большинстве случаев. Это упрощает дистрибуцию и запуск моделей на ПК и серверах. llamafile распространяется под лицензией Apache 2.0 и использует открытые инструменты llama.cpp и Cosmopolitan Libc. Утилита принимает GGUF-файл с весами модели, упаковывает его и отдаёт унифицированный бинарный файл, который запускается в macOS, Windows, Linux, FreeBSD, OpenBSD и NetBSD. Готовый файл предоставляет либо интерфейс командной строки, либо запускает веб-сервер с интерфейсом чат-бота.

Источник: GitHub / Mozilla Ocho Поддерживаются платформы x86-64 и ARM64, причём в первом случае автоматически определяется тип CPU и по возможности используются наиболее современные векторные инструкции. llamafile может использовать ускорители NVIDIA, а в случае платформы Apple задействовать Metal. Разработчики успешно протестировали инструмент в Linux (в облаке Google Cloud) и Windows с картой NVIDIA, в macOS и на NVIDIA Jetson. Впрочем, некоторые нюансы всё же есть. Так, в Windows размер исполняемого файла не может превышать 4 Гбайт, поэтому большие модели вынужденно хранятся в отдельном файле. В macOS на платформе Apple Silicon перед первым запуском всё же придётся установить Xcode, а в Linux, возможно, понадобится обновить некоторые компоненты. Подробности и примеры готовых моделей можно найти в репозитории проекта.

29.11.2023 [23:40], Руслан Авдеев

NVIDIA NeMo Retriever позволит компаниям дополнять ИИ-модели собственными даннымиNVIDIA представила сервис NeMo Retriever, позволяет компаниям дополнять данные для чат-ботов, ИИ-помощников и похожих инструментов специализированными сведениями — для получения более точных ответов на запросы. Сервис стал частью облачного семейства инструментов NVIDIA NeMo, позволяющих создавать, настраивать и внедрять модели генеративного ИИ. RAG (Retrieval Augmented Generation), метод улучшения производительности больших языковых моделей (LLM), позволяет повысить точность и безопасность ИИ-инструментов благодаря заполнению пробелов в «знаниях» языковых моделей с помощью сведений из внешних источников. Обучение каждой модели — чрезвычайно ресурсоёмкий процесс — обычно осуществляется довольно редко, а то и вовсе единожды. При этом до следующего обновления модель не имеет доступа к полной и актуальной информации, что может привести к неточностям, ошибкам и т.н. галлюцинациям. NeMo Retriever позволяет быстро дополнить LLM свежими сведениями в виде баз данных, HTML-страниц, PDF-файлов, изображений, видео и т.п. Другими словами, базовая модель с добавлением специализированных материалов станет заметно эрудированнее и «сообразительнее». При этом данные могут храниться где угодно — как в облаках, так и на собственных серверах компаний. Технология чрезвычайно полезна, поскольку обеспечивает сотрудникам компании работу с полезными данными, закрытыми для широкой публики, при этом пользуясь всеми преимуществами ИИ. В отличие от открытых RAG-инструментов, NVIDIA, по данным самой компании, предлагает готовое к коммерческому использованию решение для доступных на рынке ИИ-моделей, уже оптимизированных для RAG и имеющих поддержку, а также регулярно получающих обновления безопасности. Другими словами, корпоративные клиенты могут брать готовые ИИ-модели и дополнять их собственными данными без отдельной ресурсоёмкой тренировки. NeMo Retriever позволит добавить соответствующие возможности универсальной облачной платформе NVIDIA AI Enterprise, предназначенной для оптимизации разработки ИИ-приложений. Регистрация разработчиков для раннего доступа к NeMo Retriever уже началась. Cadence Design Systems, Dropbox, SAP SE и ServiceNow уже работают с NVIDIA над внедрением RAG в свои внутренние ИИ-инструменты.

19.11.2023 [22:52], Сергей Карасёв

Dell и Hugging Face упростят развёртывание генеративного ИИ на базе локальной инфраструктурыКомпании Dell Technologies и Hugging Face объявили о заключении соглашения о сотрудничестве, цель которого заключается в том, чтобы помочь корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ. Партнёры сформируют новый портал на платформе Hugging Face. Через него будут доступны специальные контейнеры и сценарии, которые помогут заказчикам быстро и безопасно разворачивать открытые ИИ-модели, доступные в репозитории Hugging Face. Ранее похожее решение было представлено для моделей Llama 2.

Источник изображения: pixabay.com Для локального развёртывания ИИ-приложений будет использоваться оборудование Dell — серверы PowerEdge и СХД. Со временем на портале появятся дополнительные контейнеры с оптимизированными моделями для инфраструктуры Dell, предназначенные для внедрения ИИ-систем нового поколения. Ранее компания представила расширеннное портфолио комплексных решений и сервисов для «локализации» генеративного ИИ.

18.11.2023 [00:38], Владимир Мироненко

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки.

13.11.2023 [13:56], Сергей Карасёв

ИИ-стартап Aleph Alpha привлёк более $500 млн, в том числе от HPE и SAPНемецкий стартап Aleph Alpha, специализирующийся на технологиях ИИ, сообщил о проведении крупного раунда финансирования Series B, в ходе которого на развитие получено более $500 млн. Средства предоставили, в частности, HPE и SAP. Фирма Aleph Alpha, сформированная в 2019 году, занимается разработкой больших языковых моделей (LLM). При этом стартап делает упор на концепцию «суверенитета данных». Свои LLM компания предлагает корпоративным заказчикам и государственным учреждениям.

Источник изображения: pixabay.com Aleph Alpha создала семейство LLM под названием Luminous, которое включает три модификации: 13 млрд, 30 млрд и 70 млрд параметров. На веб-сайте компании указано, что также планируется разработка более совершенных языковых моделей с числом параметров до 300 млрд. Модели Aleph Alpha могут обрабатывать текст на английском, немецком, французском, итальянском и испанском языках, а также принимать изображения в качестве входных данных. Эти LLM, как утверждается, подходят для решения самых разных задач — от генерации текста до сортировки документов по темам. Доступ к моделям предоставляется через API, так что разработчики могут интегрировать их в свои продукты. Программу финансирования Series B возглавили Инновационный парк искусственного интеллекта (Ipai), фонд Bosch Ventures и компании Schwarz Group. Деньги выделили упомянутые НРЕ и SAP, а также Christ&Company Consulting и Burda Principal Investments. Стартап вложит полученные средства в дальнейшую разработку LLM и в коммерциализацию своих решений. |

|