Материалы по тегу: hardware

|

15.07.2024 [09:23], Владимир Мироненко

HPE построит самый мощный в Японии ИИ-суперкомпьютер ABCI 3.0 на базе NVIDIA H200Японский национальный институт передовых промышленных наук и технологий (AIST) объявил о планах по строительству в Касива (Kashiwa, префектура Тиба) нового суперкомпьютера AI Bridging Cloud Infrastructure 3.0 (ABCI 3.0), представляющего собой очередное обновление ИИ-платформы ABCI, запущенной в 2018 году. Новый суперкомпьютер будет предлагаться в качестве облачного сервиса как государственным, так и частным организациям страны, сообщается в блоге NVIDIA. В качестве подрядчика выступает HPE, которая построит систему с использованием платформы Cray XD с ускорителями NVIDIA H200, объединённых 200G-интерконнектом NVIDIA Quantum-2 InfiniBand. HPE не стала раскрывать подробности об общем количестве узлов, стоимости системы и сроках её ввода в эксплуатацию. Как полагает ресурс The Register, речь идёт о системе с 5U-узлами Cray XD670, способными вместить восемь ускорителей NVIDIA H200/H100 и пару Intel Xeon Emerald Rapids. Кроме того, готовится машина ABCI-Q на базе ускорителей NVIDIA H100, ориентированная на исследования в области квантовых и гибридных вычислений. HPE сообщила, что ABCI 3.0, как ожидается, станет самым быстрым ИИ-суперкомпьютером в Японии — примерно 6,2 Эфлопс (FP16?) или 410 Пфлопс (FP64). Проект ABCI 3.0 реализуется при поддержке Министерства экономики, торговли и промышленности Японии (METI) с целью укрепления вычислительных ресурсов страны через Фонд экономической безопасности. Это часть более широкой инициативы METI стоимостью $1 млрд, которая включает в себя как программу ABCI, так и инвестиции в облачные вычисления на базе ИИ.

13.07.2024 [22:42], Владимир Мироненко

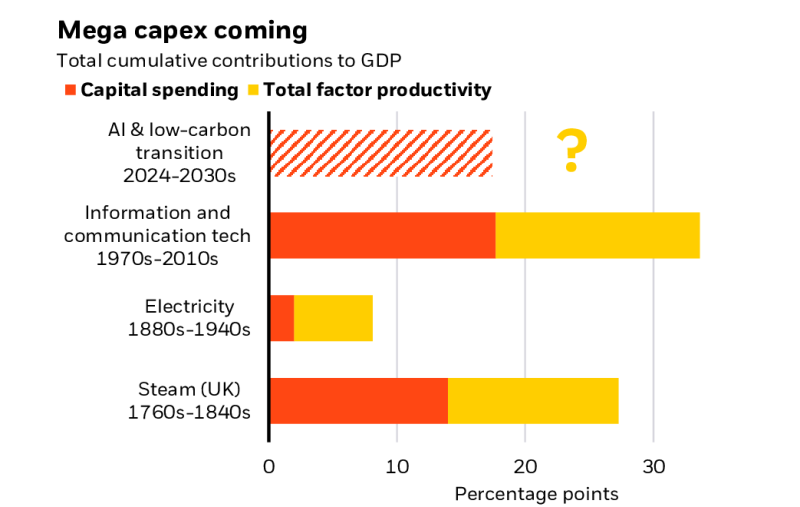

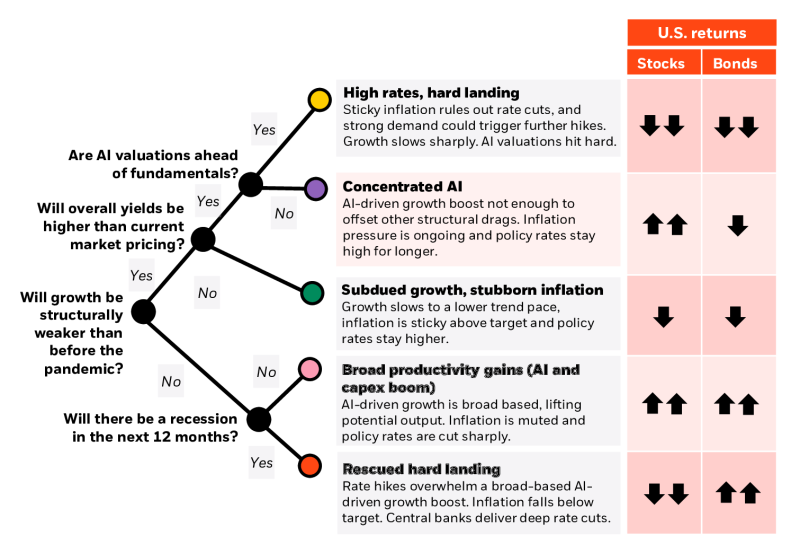

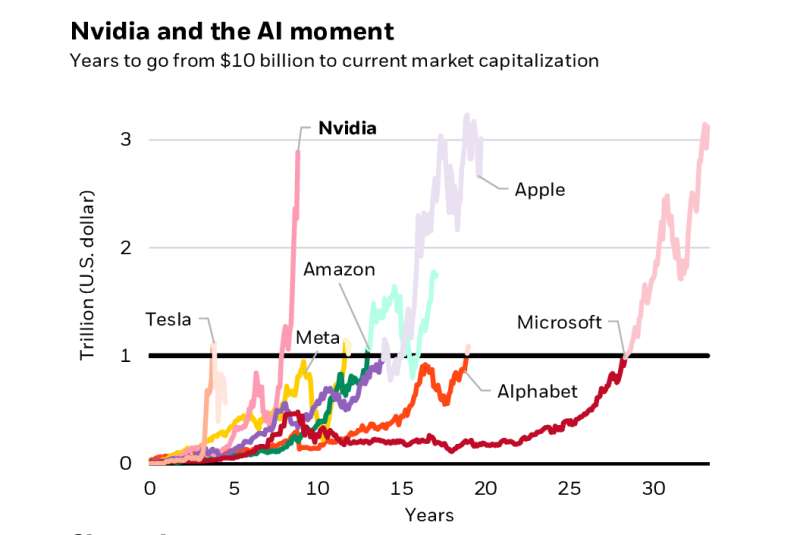

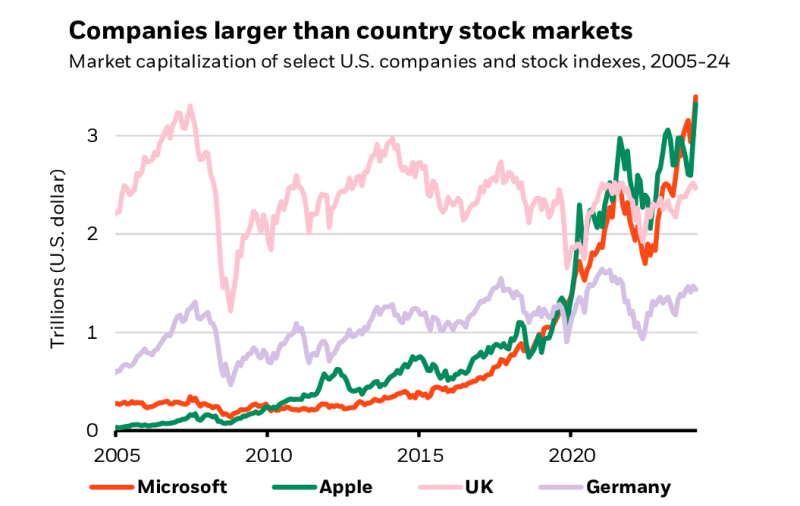

BlackRock: ИИ — это новая промышленная революция, которая подстегнёт быстрое развитие ЦОДСогласно исследованию 2024 Midyear Global Outlook инвестиционной компании BlackRock, опубликованному на прошлой неделе, в ближайшие годы ЦОД будут играть ключевую роль в развитии искусственного интеллекта (ИИ). BlackRock утверждает, что мир переживает технологическую трансформацию, сопоставимую с промышленной революцией, и ожидает, что ЦОД укрепят свои позиции в качестве важнейшего компонента инфраструктуры. Причём на фоне растущего спроса на ИИ потребность в них в ближайшем будущем резко возрастёт. Вэй Ли (Wei Li), главный глобальный инвестиционный стратег BlackRock, сообщил, что рост рынка ЦОД ИИ может составить в ближайшие годы 60–80% в годовом исчислении. Жан Буавен (Jean Boivin), глава Инвестиционного института BlackRock, отметил, что эта оценка во многом основана на ожиданиях отраслевых аналитиков. Ли подчеркнул, что в исследовании показано, как гонка за расширением возможностей ИИ уже стимулирует крупные капитальные расходы. «ИИ и переход к низкоуглеродным технологиям могут стимулировать исторически крупные капитальные расходы — и в гораздо более короткий промежуток времени, чем предыдущие технологические революции», — говорится в исследовании. По оценкам BlackRock, капитальные затраты на ИИ уже сопоставимы с крупнейшими вложениями в истории в рамках крупных глобальных преобразований, включая промышленную революцию. BlackRock тоже стремится извлечь выгоду из бума ИИ, поэтому вкладывает средства в развёртывание ЦОД в Северной Вирджинии (США) и во Франкфурте (Германия). В комментарии Data Center Knowledge главный аналитик Omdia Алан Ховард (Alan Howard) отметил, что бум строительства ЦОД начался давно. «Пандемия стала важным катализатором роста спроса на цифровую инфраструктуру, а затем появился новый спрос на ИИ, который снова увеличил спрос на ЦОД», — пояснил он. Ховард также заявил, что во II половине 2024 года появится ещё больше новостей о новых проектах и инициативах на рынке ЦОД. «Инвестсообщество, особенно фонды прямых инвестиций в инфраструктуру, уже давно вкладывает значительные средства в ЦОД, но возможности ИИ вдохнут новую жизнь в отрасль, поскольку капитала для хорошо проверенных проектов ЦОД предостаточно», — сказал Ховард, добавив, что сдержать взрывной рост ИИ могут проблемы в цепочках поставок оборудования, а также высокие затраты и доступность ЦОД. «Эти факторы могут побудить многих потребителей перейти на ИИ-сервисы гиперскейлеров или других облачных провайдеров уровня Tier 2. Эта эволюция займёт пару лет, и главным вопросом станет то, как производители ИИ-серверов будут конкурировать с NVIDIA», — говорит аналитик.

12.07.2024 [15:48], Руслан Авдеев

Oracle арендует у майнеров Crusoe Energy дата-центр, чтобы разместить там ускорители NVIDIA для OpenAIOracle намерена взять в аренду ЦОД Crusoe Energy, более всего известной проектами в сфере криптомайнинга. По данным Datacenter Dynamics, речь идёт о крупной сделке в интересах облака Oracle Cloud Infrastructure, которое в свою очередь будет обслуживать OpenAI. ИИ-стартап xAI Илона Маска (Elon Musk), отказавшись от сделки с Oracle по созданию крупного ИИ-кластера, походя сообщил о другом партнёре Oracle, готовом разместить в своих ЦОД ускорители NVIDIA GB200. Теперь же выяснилось, что этим партнёром и является Crusoe Energy, а компании уже близки к заключению сделки. Crusoe сдаст ЦОД в аренду Oracle, а та разместит как минимум часть из 100 тыс. ускорителей, предназначенных для нужд Microsoft. Microsoft же предоставит их в пользование OpenAI. Ранее с Crusoe Energy сотрудничала Lancium, строившая ЦОД для криптомайнинга в техасском Абилине (Abilene). Получивший добро в 2021 году Project Artemis описывался как кампус ЦОД с питанием от возобновляемой энергии, площадью более 320 га и ёмкостью до 200 МВт с возможностью расширения до 1 ГВт. Строительство должно было начаться в I квартале 2022 года. Основанная в 2018 году Crusoe Energy начала с поставок контейнерных ЦОД на нефтяные поля, где те могли использовать попутный природный газ из скважин для генерации электричества. Сейчас компания постепенно переходит от размещения модульных ЦОД рядом с нефтяными скважинами к строительству стационарных кампусов ЦОД и предлагает типовой проект ёмкостью до 100 МВт с возможностью размещения до 100 тыс. ускорителей. Также компания предлагает HPC/ИИ-ресурсы, в том числе посредством Crusoe Cloud. В последнем ESG-докладе Crusoe заявляла, что располагает ЦОД ёмкостью порядка, а около трети облака Crusoe Cloud снабжалось энергией за счёт газа с нефтяных скважин, оставшаяся ёмкость приходилась на сторонние ЦОД. Она, в частности, арендует мощности у atNorth и Digital Realty. Также компания намерена получить ещё 100 МВт от ветряной электростанции. Многие криптовалютные компании перепрофилируют деятельность под связанные с ИИ проекты, создавая облака на основе собственных ускорителей и/или размещая чужое оборудование на своих объектах. В числе подобных компаний — CoreWeave, Core Scientific,Northern Data, Hut 8 и Applied Digital.

12.07.2024 [14:17], Руслан Авдеев

Нефтяная компания Gulf Oil выпустит жидкость для систем охлаждения дата-центровОчередная нефтяная компания занялась бизнесом, связанным с ЦОД, наладив выпуск собственных жидкостей для систем охлаждения. По данным Datacenter Dynamics, для Gulf Oil Lubricants India (GOLIL), входящей в Hinduja Group, рынок систем охлаждения для дата-центров является нишевым, но, по словам компании, такие технологии весьма благоприятно влияют на окружающую среду. По словам управляющего директора GOLIL, большинство компаний, выпускающих различные типы ГСМ, могут создавать продукты для сектора СЖО. При этом для полного заполнения, например, индийского рынка достаточно всего 12–14 млн л из расчёта 8,3 л/кВт при ёмкости ЦОД около 1,7 ГВт. Сейчас GOLIL поставляет моторные масла, тормозные жидкости, охлаждающие жидкости для радиаторов и всевозможные смазки для автомобилей, грузовиков и тракторов. Интерес к системам охлаждения для ЦОД в последнее время проявляют и другие нефтегазовые компании, включая Shell, Castrol, ExxonMobil, ENEOS, Petronas и SK Enmove — все они выпустили жидкости для СЖО дата-центров. Впрочем, жидкости предлагают даже продовольственные компании вроде американская Cargill и представители традиционной химической промышленности вроде Chemours (ответвление DuPont).

12.07.2024 [11:32], Руслан Авдеев

SoftBank приобрела британского разработчика ИИ-ускорителей GraphcoreЯпонская SoftBank, уже владеющая британским разработчиком процессоров Arm, приобрела британскую же компанию Craphcore, занятую разработкой ИИ-ускорителей. По данным The Register, сумма потенциальной сделки не называется, но по некоторым оценкам она составит $600 млн — для сравнения, Graphcore привлекла $700 млн в ходе всех раундов финансирования. Graphcore официально объявила о сделке в четверг, а её глава Найджел Тун (Nigel Toon) публично одобрил её, подчеркнув, что спрос на ИИ-вычисления сейчас высок и продолжает расти, а SoftBank является тем партнёром для Graphcore, который поможет «изменить ландшафт» ИИ-технологий. Штаб-квартира компании по-прежнему останется в Бристоле. Ключевые активы компании — ИИ-ускорители Intelligence Processing Units (IPU), а также стек ПО. Хотя вычислительные системы BOW POD16 оказались производительнее NVIDIA DGX A100, процветания в компании не дождались и рассматривали продажу ещё в феврале 2024 года.

Источник изображения: Graphcore Несмотря на первоначальный успех, бизнес не смог стать прибыльным. В 2022 году выручка составила всего $2,7 млн — на 46 % меньше год к году, операционные расходы составили $206,8 млн. После этого начались увольнения — по словам представителей компании, необходимые для того, чтобы удержать бизнес на плаву. Более того, компания даже стала получать иски. Сотрудничество с китайскими бизнесами могло бы вывести Graphcore из тупика, но США ограничили продажи высокопроизводительных ускорителей в КНР. Тем временем NVIDIA закрепила своё влияние на рынке решений для генеративных ИИ-систем. Тун прогнозирует, что SoftBank, наконец, даст возможность Graphcore составить конкуренцию лидерам отрасли. По словам SoftBank Investment Advisers, новое поколение полупроводников и вычислительных систем имеет чрезвычайное значение для работ над т.н. «общим искусственным интеллектом» (AGI), поэтому SoftBank рада сотрудничать с Graphcore. При этом в SoftBank не акцентируют внимание на том, что компания уже является владельцем контрольного пакета акций британской Arm, на решениях которой строятся многие современные полупроводники. Последняя имеет собственные амбиции и намерена представить альтернативу решениям NVIDIA. Graphcore предлагает ещё одну альтернативу и уже имеет готовое техническое решение. С учётом финансовых ресурсов SoftBank и связей с Arm, компания, возможно, получит второе дыхание для нового старта. Другими словами, сектор ИИ-инфраструктуры сможет стать более конкурентным, что в любом случае пойдёт на благо покупателей.

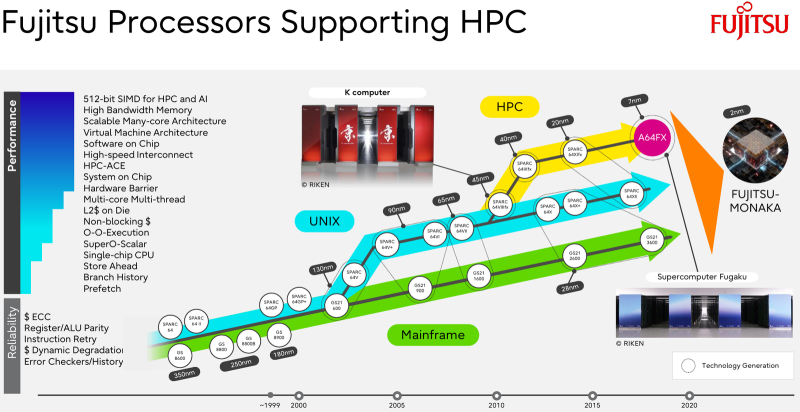

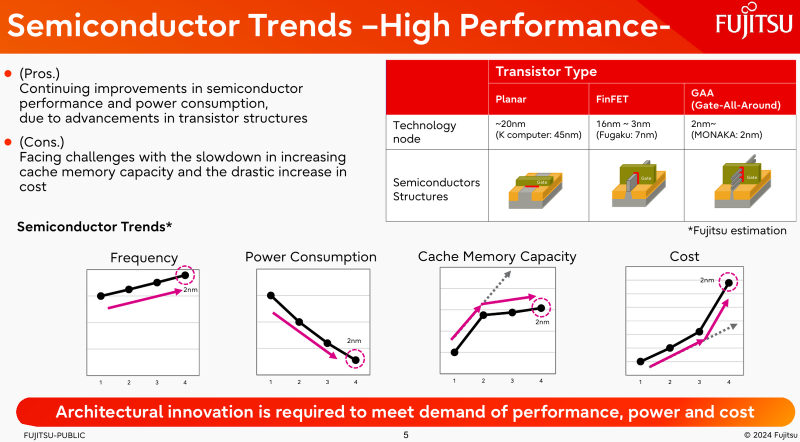

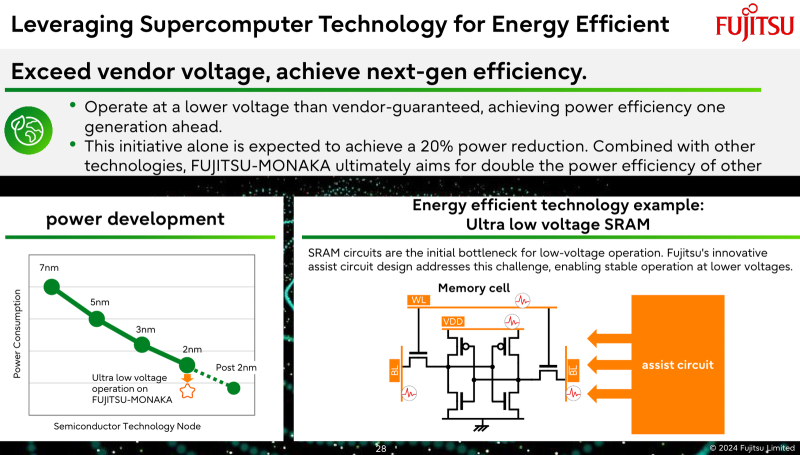

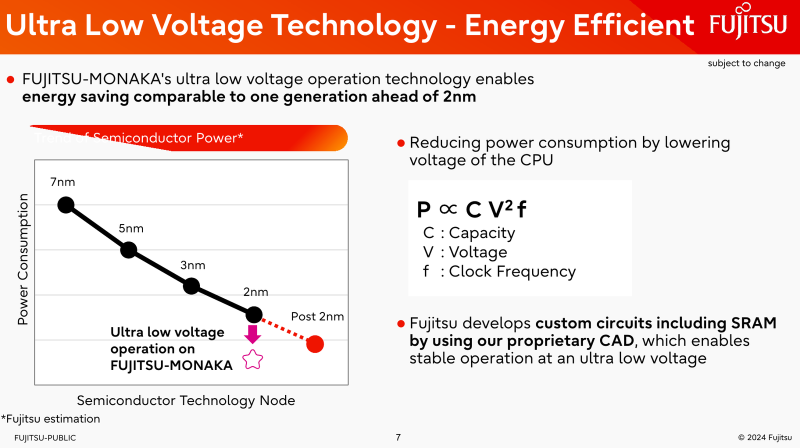

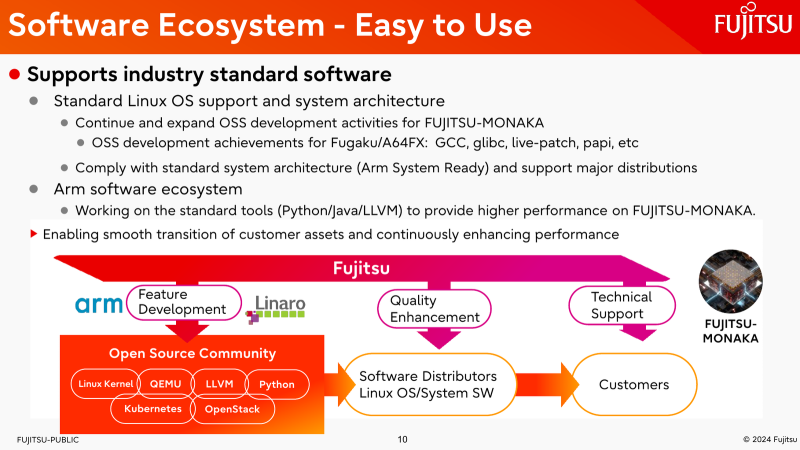

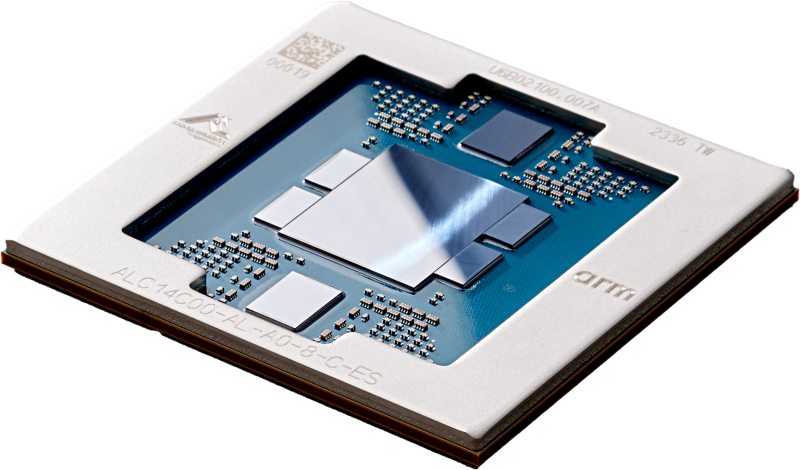

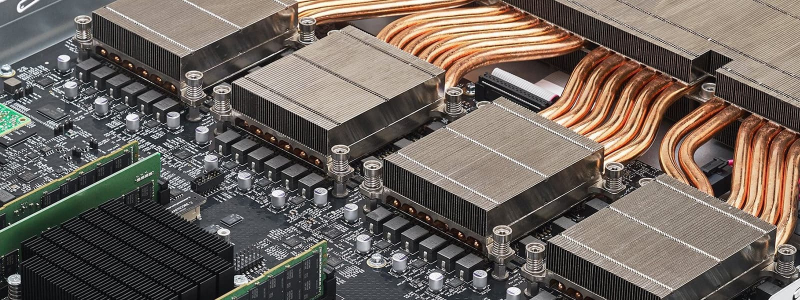

12.07.2024 [09:09], Алексей Степин

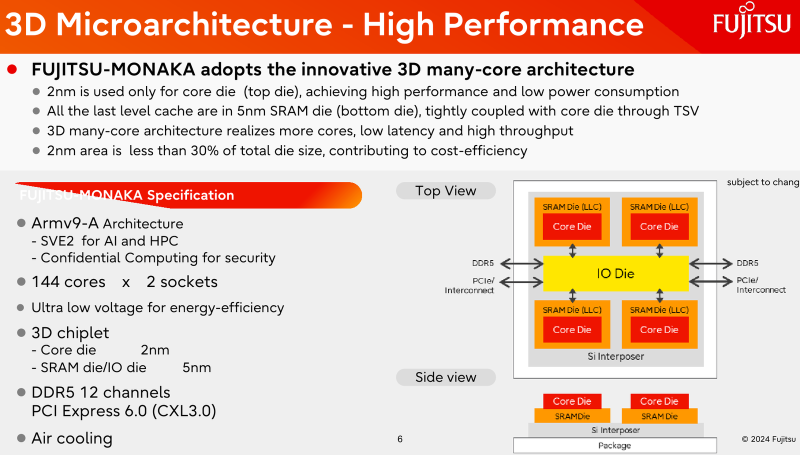

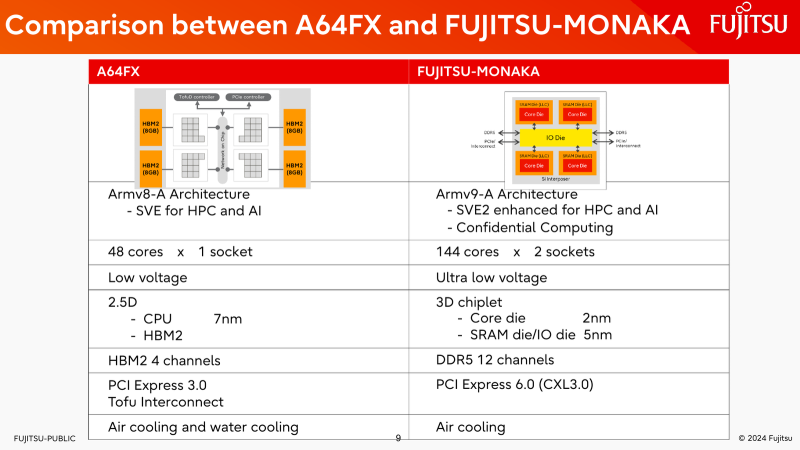

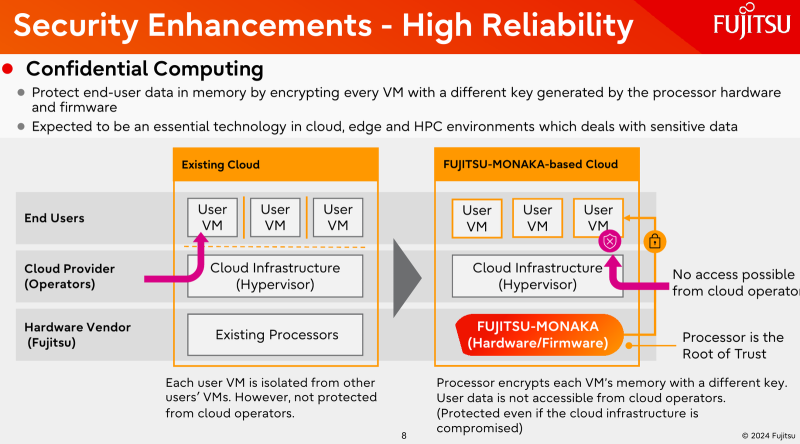

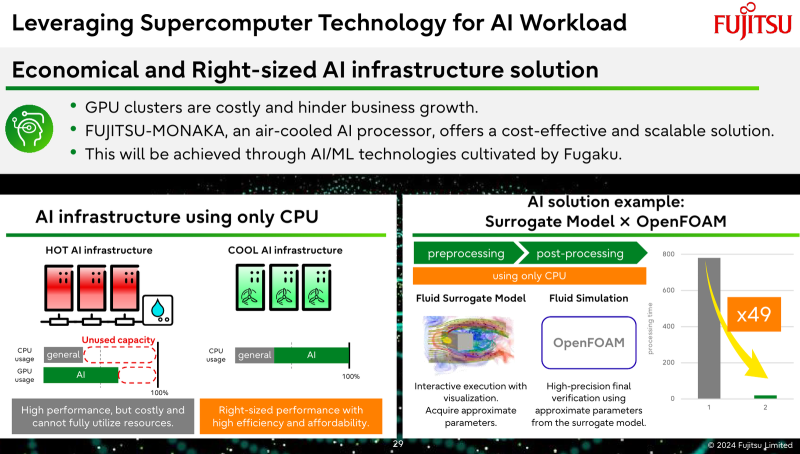

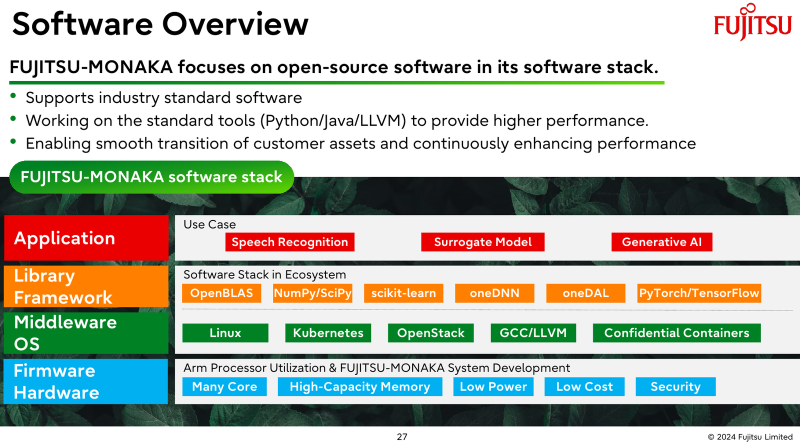

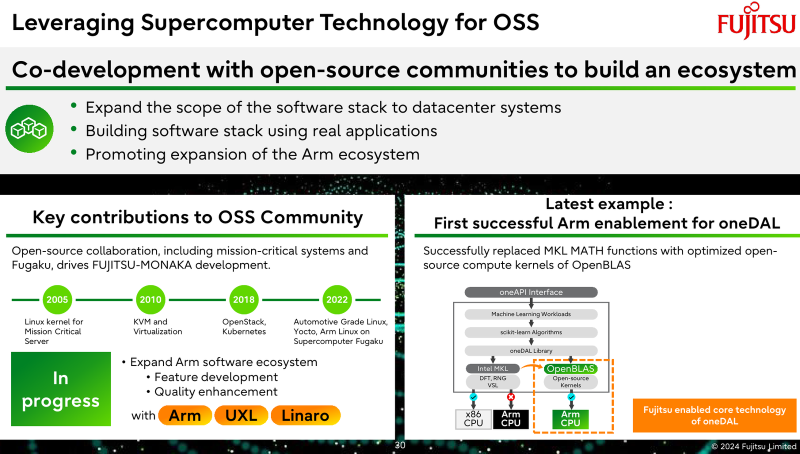

144 ядра, чиплеты, SRAM и 3D-упаковка: Fujitsu поделилась подробностями о грядущих Arm-процессорах MONAKAОпыт японской компании Fujitsu в разработке процессоров и суперкомпьютеров велик и многогранен. Долгое время основной архитектурой для решений Fujitsu была SPARC64, но времена меняются: в 2018 году компания анонсировала разработку собственного процессора на базе архитектуры Arm. Сегодня этот чип мы знаем под именем A64FX. В 2020 году японский кластер Fugaku на основе 48-ядерных A64FX с интегрированными HBM-памятью и интерконнектом занял первое место в рейтинге TOP500 с результатом 537,2 Пфлопс. Однако эти процессоры, которые всё ещё достойно трудятся не только в Fugaku, но и в других суперкомпьютерах, трудно назвать действительно универсальным и доступным. Важность архитектурных нововведений и смену IT-ландшафта в Fujitsu прекрасно осознают. Поэтому компания объявила о разработке нового серверного процессора под кодовым именем MONAKA, для которого она намеревается вдвое увеличить показатели производительности и энергоэффективности, а также учесть растущую популярность задач класса ИИ. А совсем недавно Fujitsu впервые более детально рассказала о технических особенностях будущих CPU. Во-первых, разработчики нового процессора хорошо осознают ограничения, накладываемые текущей транзисторной технологии. Похоже, из FinFET и её аналогов выжаты все или почти все соки и для прорывных решений нового поколения данная технология не подходит. В процессорах MONAKA будут использоваться транзисторы с затвором нового типа, так называемые GAA (Gate-all-Around). Похоже, речь идёт о технологии, которую разрабатывает и собирается внедрить в производство уже в следующем году Samsung в рамках 2-нм техпроцесса SF2. Внедрение 2-нм GAA-транзисторов позволит снизить паразитную ёмкость, а значит, добиться больших тактовых частот при меньшем напряжении питания. При этом новая технология будет применена не только в процессорных ядрах, но и в сборках кеш-памяти, также спроектированных с использованием собственного инструментария Fujitsu. Во-вторых, MONAKA изначально проектируется как модульный процессор. В центре разместится IO-кристалл, содержащий контроллеры DDR5 (12 каналов) и PCI Express 6.0/CXL 3.0. Окружать его будут сборки из 5-нм кристаллов кеш-памяти SRAM и расположенных поверх 2-нм кристаллах с процессорными ядрами. По вертикали соединение обеспечит технология TSV, а по горизонтали — кремниевая подложка-интерпозер. Фактически речь идёт о 3D-компоновке. 12-канальная подсистема памяти обеспечит отсутствие узких мест: у A64FX проблем с пропускной способностью благодаря использованию HBM2 не было, но объем самой памяти был ограничен 32 Гбайт. Зато у MONAKA проблем с расширением не будет — как с помощью классических модулей DIMM, так и посредством банков памяти CXL, благо, за основу сразу взята версия PCIe 6.0 с пропускной способностью 256 Гбайт/с в режиме x16. Сколько будет самих линий, пока не уточняется. Новая платформа изначально проектируется двухсокетной, при этом в количестве ядер Fujitsu также не скромничает: процессоры MONAKA получат 144 ядра, а благодаря новому 2-нм техпроцессу они будут не такими уж горячими. Им хватит воздушного охлаждения, говорят создатели. Процессоры получат набор инструкций Armv9-A с векторными расширениями SVE2 и технологией доверенных вычислений Confidential Computing. Скорее всего, без кастомных инструкций не обойдётся и в этот раз. Последнее особенно важно ввиду того, что MONAKA предназначены не только для рынка HPC, но и для использования в облачных средах. Подсистема конфиденциальных вычислений позволяет шифровать содержимое каждой виртуальной машины собственным ключом, так что доступа к внутренностям ВМ не будет даже у владельцев ЦОД. Впрочем, современные HPC-комплексы всё чаще используют именно облачный подход для доступа к ресурсам. Несмотря на популярность GPU и других специализированных ускорителей, Fujitsu считает, что гетерогенная архитектура имеет существенные недостатки — она заметно дороже, особенно с учётом ценовой политики производителей, склонна к неполной утилизации ресурсов, а также не слишком экономична и зачастую требует специфических систем охлаждения. Компания полагает, что гомогенная архитектура MONAKA этих недостатков лишена и в сочетании с ПО Fujitsu может успешно обрабатывать ИИ-нагрузки. В программной части Fujitsu активно полагается на решения с открытым кодом. Процессоры MONAKA будут отвечать стандартам Arm System Ready и получат полноценную поддержку Linux и сопутствующего инструментария, в частности, GCC, glibc, live-patch, papi и т.д. Разработка ведётся в тесном содружестве с Linaro, организацией, занимающейся консолидацией открытого ПО для Arm, а также с альянсом UXL. Для MONAKA компания подготовит, например, оптимизированную библиотеку OpenBLAS. Также Fujitsu уделяет внимание экологии: напомним, одной из главных черт нового процессора будет его экономичность, что отвечает целям японской национальной программы NEDO, ставящей своей целью достижение 40 % снижения энергопотребления ЦОД к 2030 году. Что касается начала поставок MONAKA, здесь всё идёт по плану: первые партии новых процессоров найдут своё место в серверах и вычислительных узлах уже в 2027 году. Это вполне согласуется с циклом разработки PCI Express, согласно которому появления решений PCIe 6.0 на рынке следует ожидать не ранее 2025 года.

11.07.2024 [15:52], Владимир Мироненко

В Бишкеке появился первый коммерческий ЦОД уровня TIER IIIВ начале июня 2024 года в Бишкеке открыли первый коммерческий ЦОД на 100 стойко-мест, соответствующий уровню надёжности Uptime Institute Tier III, сообщила инжиниринговая компания DataTime (ООО «ДатаТайм»), которая будет управлять новым объектом. ЦОД такого уровня надёжности в Кыргызстане был только у Национального банка Кыргызской Республики. Теперь возможность размещать ИТ-оборудование и сервисы в высоконадежном дата-центре появилась и у госорганов, и у корпоративного бизнеса Кыргызстана, отметила DataTime. По словам главы ООО «ДатаТайм», новый ЦОД позволит банкам, ретейлу и госсектору увеличить отказоустойчивость работы своих ИТ-сервисов, а также обеспечит возможность более надёжного и защищённого хранения цифровых данных. Новый ЦОД рассчитан на 100 серверных стоек суммарной мощностью более 500 кВт, с возможностью расширения в будущем ещё на 20 серверных стоек. Системы кондиционирования ЦОД зарезервированы по схеме N+1, система бесперебойного энергоснабжения — по схеме 4/3N. Для электроснабжения имеются две подстанции. Также есть система ИБП с аккумуляторными батареями, способная обеспечить автономную работу ЦОД в течение 10 минут, и две дизель-генераторные установки мощностью 1 МВт с запасом топлива на 12 часов работы. В качестве технического заказчика в процессе создания дата-центра выступала компания DataDome (ООО «ДатаДом»), специалисты которой разработали техническое задание на проектирование. DataDome осуществляла сопровождение процесса проектирования стадии РД, а также контроль сроков проектирования и строительства, качества проведения строительно-монтажных работ и соблюдения бюджета проекта.

11.07.2024 [15:31], Руслан Авдеев

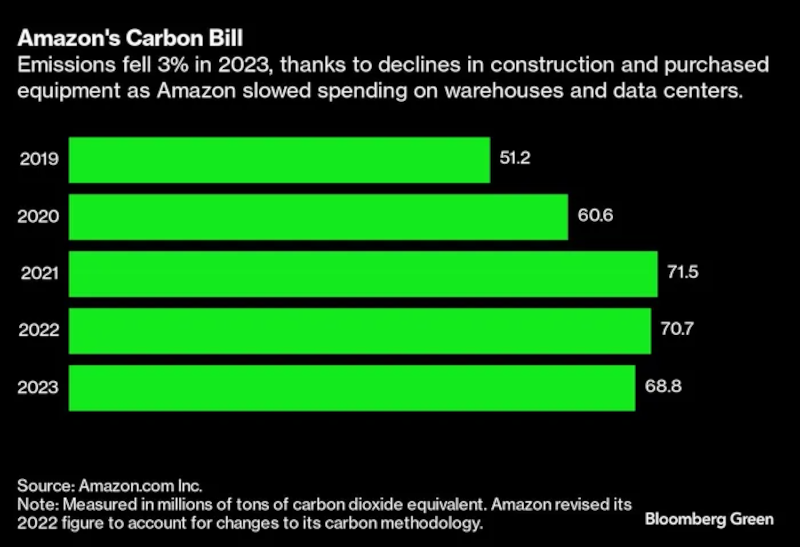

Amazon в отличие от Google и Microsoft смогла снизить выбросы в 2023 году несмотря на рост спроса на ИИКомпания Amazon сообщила о снижении углеродных выбросов в 2023 году второй год подряд. По данным Bloomberg, представители IT-гиганта объясняют это сокращением затрат на новые склады и дата-центры для облачных ИИ-вычислений. В прошлом году выбросы парниковых газов упали на 3 % до 68,82 млн тонн в CO2-эквиваленте. Снижение во многом обусловлено 13 % падением выбросов, связанных со средствами производства, включая строительство и закупки оборудования. Капитальные расходы в 2023 году упали на $10 млрд в связи с избытком складских мощностей, появившегося во время пандемии COVID-19, и сокращением расходов на дата-центры AWS. Данные, опубликованные Amazon, контрастируют со статистикой Microsoft и Google, пытающихся снизить выбросы на фоне роста ресурсоёмких дата-центры для ИИ. Впрочем, Amazon пообещала потратить $150 млрд на ИИ ЦОД в ближайшие 15 лет, поэтому в будущем, возможно, её будут ждать те же проблемы. Запутанная и масштабная логистика Amazon обеспечивает приблизительно тот же уровень выбросов, что и все операции Google вместе взятые, при этом Amazon отдельно не раскрывает статистику по выбросам AWS.

Источник изображения: Tim van der Kuip/unsplash.com Пока компания намерена свести к нулю углеродные выбросы к 2040 году. Отчасти этому уже помогают 100 тыс. электрических фургонов Rivian. Кроме того, компания пытается использовать более экобезопасное авиационное топливо, экологически чистые бетон и сталь в своих зданиях. Для того, чтобы продемонстрировать эффект от новых инициатив, компания включила соответствующие экометрики в свои процессы планирования.

Источник изображения: Amazon/Bloomberg В Amazon подчёркивают, что процесс декарбонизации непрост, но теперь компания располагает инструментами, которых ещё пару лет назад просто не было. Наконец, в 2023 году компания закупила достаточно возобновляемой энергии, чтобы целиком компенсировать собственное энергопотребление. Впрочем, речь о покупке сертификатов на возобновляемую энергию (СВЭ). Фактически объекты компании могут быть запитаны от любых источников энергии, при этом подобные кредиты далеко не всегда способствуют снижению выбросов. Так или иначе Amazon сегодня является одним из главных сторонников использования возобновляемой энергии и, как заявляют в компании, подобные СВЭ покупаются, чтобы поддержать «зелёные» проекты. Интенсивность выбросов углерода компанией на каждый заработанный доллар упала на треть с тех пор, как Безос обнародовал свои экологические цели в 2019 году. За тот же период выбросы в абсолютном выражении выросли на 34 %.

10.07.2024 [17:43], Владимир Мироненко

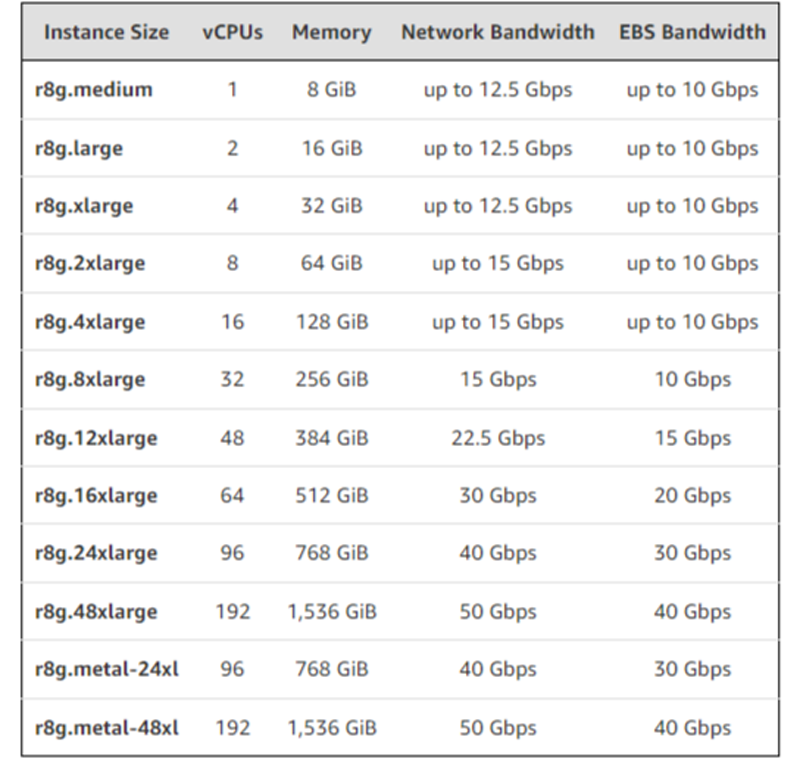

AWS объявила о доступности инстансов EC2 R8g на базе Arm-процессоров Graviton4AWS объявила о доступности инстансов EC2 R8g на базе Arm-процессоров Graviton4. По сравнению с Graviton3 они обладают на 30 % большей вычислительной мощностью, имеют на 50 % больше ядер и на 75 % выше пропускную способность памяти, говорит AWS. Также сообщается, что процессоры Graviton4 до 30 % быстрее в обработке веб-приложений, на 40 % быстрее в работе с базами данных и на 45 % быстрее при запуске больших Java-приложений, чем Graviton3. Инстансы Amazon EC2 R8g позволяют повысить производительность приложений, интенсивно использующих ресурсы памяти, включая высокопроизводительные СУБД, in-memory кеши и системы аналитики Big Data в режиме реального времени. Впрочем, согласно подсчётам The Next Platform, новые инстансы по сравнению с прошлыми по соотношению цены и производительности стали на четверть дороже. По сравнению с EC2 R7g инстансы R8g предлагают более крупные конфигурации: в три раза больше vCPU (до 192 шт.), в три раза больше памяти (до 1,5 Тбайт) и в два раза больше L2-кеша. Инстансы R8g также обеспечивают пропускную способность сети до 50 Гбит/с и пропускную способность EBS до 40 Гбит/с по сравнению с 30 Гбит/с и 20 Гбит/с соответственно у инстансов прошлого поколения. Кроме того, Amazon EC2 R8g — первые инстансы на чипах Graviton, предлагающие две крупные конфигурации bare metal (metal-24xl и metal-48xl).  Как сообщила компания, инстансы R8g идеально подходят для всех рабочих нагрузок на базе Linux, включая контейнерные приложения и приложения на основе микросервисов, созданные с использованием EKS, ECS, ECR, Kubernetes, и Docker, а также приложения, написанные на C/C++, Rust, Go, Java, Python, .NET Core, Node.js, Ruby и PHP. Новые инстантсы используют AWS Nitro. По словам AWS, с момента анонса превью R8g более 100 клиентов, включая Epic Games, SmugMug, Honeycomb, SAP и ClickHouse, протестировали свои рабочие нагрузки на этих инстансах и отметили значительное улучшение производительности по сравнению с сопоставимыми экземплярами на Graviton3. В настоящее время R8g доступны в регионах AWS US East (Северная Вирджиния), US East (Огайо), US Wes (Орегон) и Europe (Франкфурт). Они доступны как по запросу, так в качестве спотовых и зарезервированных инстансов, а также в рамках планов Savings. На текущий момент у AWS есть уже более 2 млн процессоров Graviton разных поколений, а инстансами на их основе пользуются более 50 тыс. клиентов.

10.07.2024 [16:16], Руслан Авдеев

К 2029 году на ИИ-ускорители придётся 1,5 % всего энергопотребления на ЗемлеВ мире ожидается рост энергопотребления системами, связанными с генеративным ИИ. По данным HPC Wire, в следующие пять лет расход электричества на такие системы составит 1,5 % от общемирового — это весьма значимая доля, говорят эксперты. Соответствующее предположение выдвинули аналитики TechInsights. За основу взяты прогнозы Управления энергетической информации США (US Energy Information Administration, EIA) на 2025–2029 гг., в которых глобальное энергопотребление за этот период, по оценкам, составит 153 тыс. ТВт∙ч. Исследователи предполагают, что за то же время на ИИ-ускорители придётся 2318 ТВт∙ч. Расчёты исходят из того, что каждый ускоритель требует 700 Вт, а потребление флагманских NVIDIA Blackwell и вовсе составляет 1200 Вт, хотя новинки намного производительнее решений прошлых поколений. При составлении прогнозов учитывается лишь энергопотребление самих ускорителей — без модулей памяти, сетевого оборудования и прочих компонентов ИИ-систем. По мнению экспертов, «придётся попотеть», чтобы оправдать такие расходы. Согласно опросам McKinsey, 65 % респондентов намерены использовать генеративный ИИ. Для того, чтобы удовлетворить спрос, вкладываются огромные деньги в соответствующую отрасль. Если Microsoft полагается в основном на решения NVIDIA, то Meta✴ реализует и собственный проект, а её вычислительная экосистема будет эквивалентна около 600 тыс. H100. По данным TechInsights, в 2023 году NVIDIA поставила порядка 3,76 млн ускорителей — в сравнении с 2,6 млн в 2022 году. В прошлом году Gartner выступила даже с более смелым прогнозом — по её мнению, ИИ, возможно, будет потреблять и 3,5 % мирового электричества. Впрочем, методика компании не вполне ясна и, возможно, включает энергозатраты на сопутствующую экосистему помимо ускорителей. При этом расходы на электроэнергию в любом случае будут расти, а в случае дефицита поставщики энергии будут просто поднимать цены, а не пытаться разделить доступные мощности между потребителями. Поэтому сейчас всё острее становится вопрос разумного использования энергии. Так, на криптомайнинг в США, по данным EIA, приходится 2,3 % всего энергопотребления в стране, но эксперты сходятся во мнении, что использовать ресурсы для работы ИИ-систем намного рациональнее. Впрочем, и сами майнеры активно переключаются на ИИ-проекты. Кроме того, переход на СЖО и утилизация «мусорного» повышают общую энергоэффективность ЦОД. Но есть и другой путь. Так, Microsoft совместно с производителями «железа» довольно агрессивно продвигает т.н. ИИ ПК (AI PC), оснащённые NPU или иными ускорителями для локальных ИИ-вычислений. Это фактически позволяет перенести часть нагрузок на клиентские устройства, а в облаке обсчитываются те задачи, которые устройствам не под силу. Apple использует похожий подход. |

|