Материалы по тегу: hardware

|

28.02.2024 [15:54], Руслан Авдеев

Доступность ускорителей NVIDIA H100 повысилась, что привело к появлению вторичного рынкаСроки поставок ускорителей NVIDIA H100 значительно сократилось, с 8–11 мес. до всего 3-4. По данным Tom’s Hardware, в результате многие компании, ранее сделавшие огромные запасы, пытаются продать излишки. Кроме того, стало намного легче арендовать ускорители в облаках Amazon, Google и Microsoft. Впрочем, разработчики ИИ-моделей до сих пор испытывают проблемы с доступом к ресурсам ускорителей, поскольку спрос превышает предложение. Как сообщают СМИ, некоторые компании пытаются перепродать доставшиеся им H100, а другие стали заказывать меньше в связи с высокой стоимостью обслуживания складских запасов и окончанием паники на рынке. В прошлом году приобрести подобные ускорители было чрезвычайно сложно. Отчасти улучшение ситуации на рынке связано с тем, что провайдеры облачных сервисов вроде Amazon (AWS) и других крупных игроков упростили аренду H100. Несмотря на то, что доступ к H100 упростился, желающим обучать LLM добраться до ресурсов по-прежнему непросто, во многом потому, что им требуются ускорители в невероятных количествах, в некоторых случаях речь идёт о сотнях тысяч экземпляров, поэтому цены на них до сих пор не упали, а NVIDIA продолжает получать сверхприбыли. При этом рост доступности привёл к тому, что компании всё чаще пытаются сэкономить, ведут себя более избирательно при выборе предложений продажи или аренды, стараются приобрести более мелкие кластеры и внимательнее оценивают их экономическую целесообразность для бизнеса. Кроме того, альтернативные решения становятся все более распространёнными и всё лучше поддерживаются ПО. Это ведёт к формированию сбалансированной ситуации на рынке. Так или иначе, спрос на ИИ-чипы по-прежнему высок, а с учётом того, что LLM становятся всё масштабнее, требуется больше вычислительных мощностей. Поэтому крупные игроки, которые зависят от поставок решений NVIDIA, занялись созданием собственных ускорителей. Среди них Microsoft, Meta✴ и OpenAI.

28.02.2024 [15:31], Сергей Карасёв

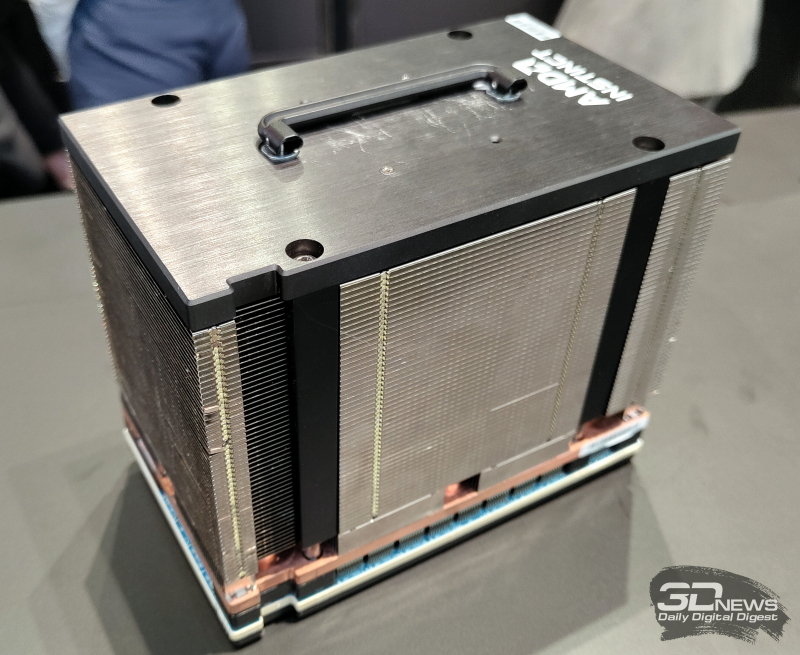

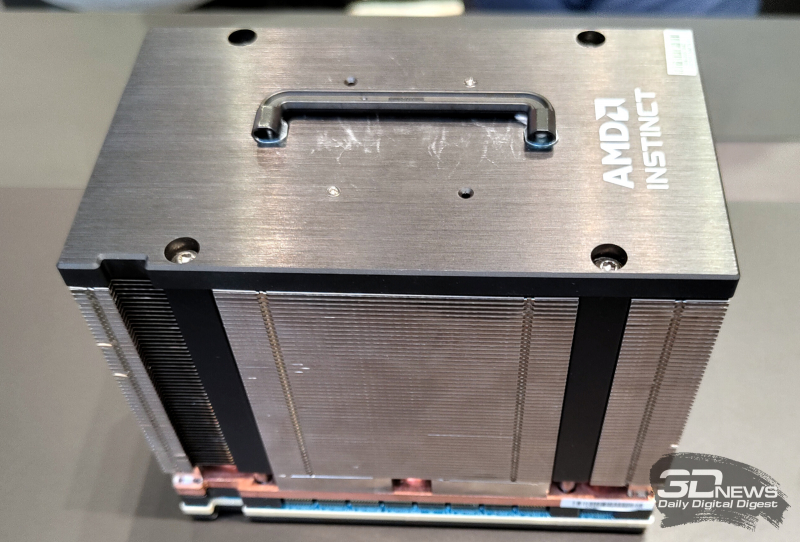

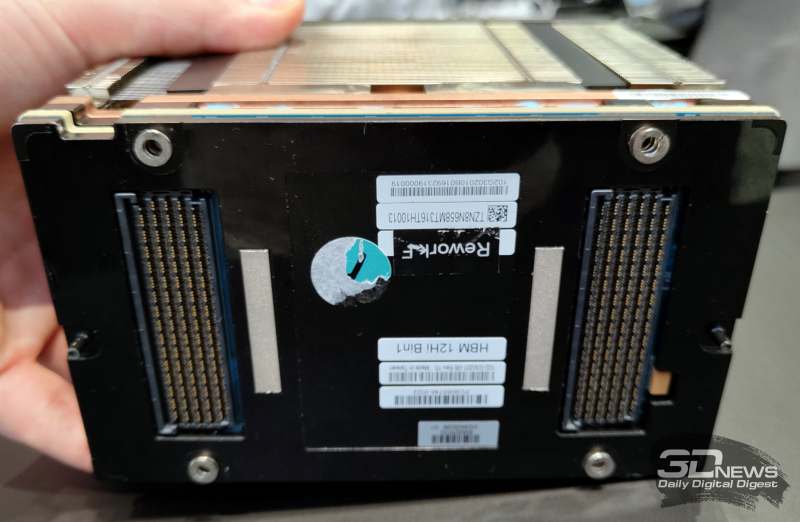

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

28.02.2024 [14:04], Сергей Карасёв

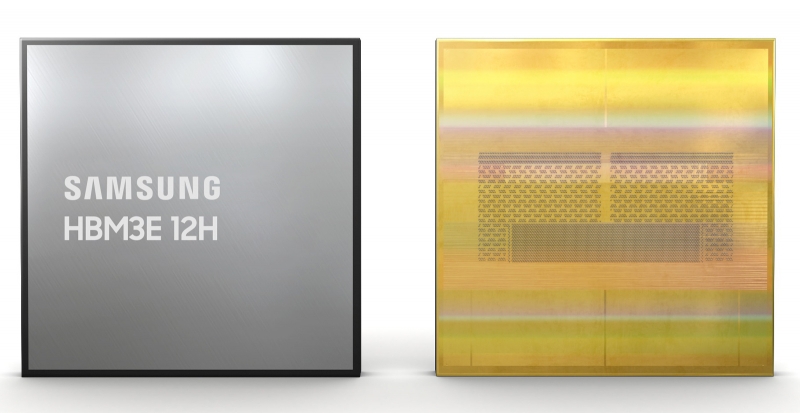

В Samsung разработаны первые в отрасли 12-слойные чипы HBM3E ёмкостью 36 ГбайтКомпания Samsung Electronics объявила о разработке первых в отрасли чипов высокопроизводительной памяти HBM3E в виде 12-ярусных стеков общей ёмкостью 36 Гбайт. Изделия ориентированы на применение в системах ИИ с большой вычислительной нагрузкой. Новые чипы Samsung HBM3E обеспечивают пропускную способность до 1280 Гбайт/с. По этому показателю, как утверждается, решения более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. При изготовлении чипов Samsung применяет технологию термокомпрессии в комплексе с диэлектрической плёнкой. В результате, суммарная высота полученных 12-слойных изделий эквивалентна высоте 8-слойных. Samsung добилась наименьших в отрасли зазоров в стеке — всего 7 мкм, а также устранила пустоты между слоями. Это позволило поднять плотность вертикальной компоновки более чем на 20 % по сравнению с 8-слойными продуктами HBM3. Кроме того, при производстве стеков Samsung использует между слоями памяти контактные выступы разного размера. Небольшие выступы служат для передачи сигналов, тогда как более крупные улучшают отвод тепла. Такой подход, по заявлениям Samsung, также способствует снижению доли брака. В целом, как утверждается, внедрение 12-слойной памяти HBM3E по сравнению с 8-слойными изделиями даёт возможность увеличить скорость обучения ИИ-моделей на 34 %, тогда как количество одновременно обслуживаемых пользователей систем инференса может вырасти в 11,5 раз. Пробные поставки новых чипов уже начались, а массовое производство намечено на I половину 2024 года. Нужно отметить, что буквально на днях компания Micron объявила о начале массового производства 8-слойной памяти HBM3E на 24 Гбайт с пропускной способностью более 1,2 Тбайт/с. Кроме того, Micron уже в марте начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт.

28.02.2024 [14:01], Сергей Карасёв

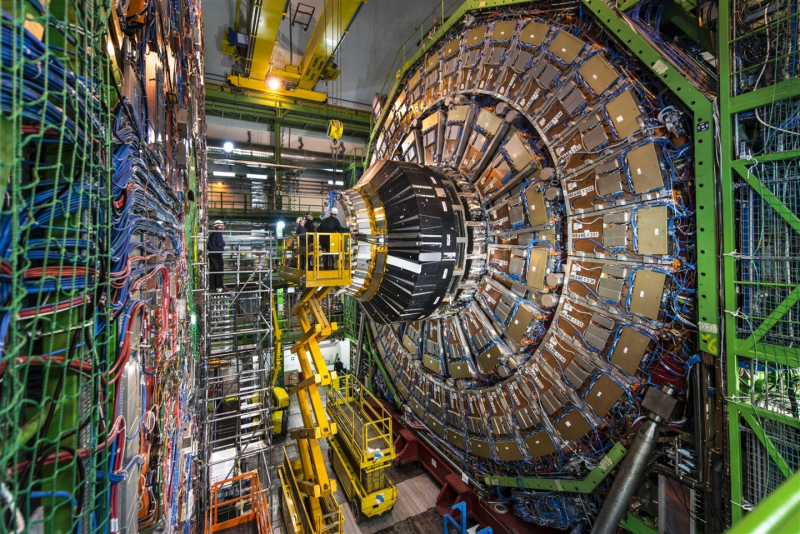

CERN открыла новый дата-центр во Франции для поддержания экспериментов БАКЕвропейская организация по ядерным исследованиям (CERN) объявила об открытии в Превессене во Франции нового ЦОД, который займётся обработкой информации, поступающей от Большого адронного коллайдера (БАК). Объект построен в рекордные сроки — менее чем за два года. Общая площадь дата-центра превышает 6000 м2. Предусмотрены шесть залов для размещения оборудования, каждый из которых рассчитан на мощность в 2 МВт и может вместить до 78 стоек. В ЦОД в основном будут размещены серверы на базе CPU для обработки данных экспериментов, а также небольшое количество систем и хранилищ для обеспечения непрерывности операций и аварийного восстановления. Ожидается, что на полное оснащение площадки оборудованием потребуется около десяти лет. Отмечается, что новый объект соответствует строгим техническим требованиям, обеспечивающим экологическую устойчивость. Развёрнута эффективная система рекуперации тепла, которое будет использоваться для отопления зданий на территории Превессена. Целевой коэффициент PUE составляет 1,1, а показатель эффективности использования воды (WUE) — 0,379 л/кВт·ч. Система охлаждения будет автоматически включаться, когда наружная температура достигнет 20 °C. При этом температура в самих помещениях дата-центра ни при каких условиях не должна превышать 32 °C. БАК в настоящее время генерирует около 45 Пбайт информации в неделю, но ожидается, что этот объём удвоится после модернизации комплекса. Данные экспериментов передаются в глобальную вычислительную сеть Worldwide LHC Computing Grid (WLCG), объединяющую около 170 дата-центров, расположенных в более чем 40 странах. Общая ёмкость хранилищ составляет примерно 3 Эбайт, а для обработки данных задействован примерно 1 млн процессорных ядер. Существующий дата-центр CERN на площадке в Мерене (Швейцария) по-прежнему является основным для организации.

27.02.2024 [21:44], Сергей Карасёв

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных.

27.02.2024 [20:45], Руслан Авдеев

Huawei Cloud запустит облачный регион в Египте и построит ИИ-центр в ГонконгеУже в следующем месяце в Египте должен заработать новый облачный регион компании Huawei. Datacenter Dynamics сообщает, что у компании есть и другие планы — она намерена построить облачный вычислительный ИИ-центр в Гонконге. Это первый проект такого рода за пределами материкового Китая. Регион в Египте станет очередным дополнением к 85 зонам Huawei Cloud, разбросанным по 30 странам и территориям планеты. В Китае Huawei является вторым по величине облачным провайдером, но наращивает и глобальное присутствие. Только в прошлом году она ввела в эксплуатацию облачные регионы в Турции и Саудовской Аравии. Кроме того, компания активно осваивает рынки облачных сервисов Латинской Америки. В частности, ведётся строительство регионов в Бразилии и Мексике. Пока нет данных, в каком ЦОД будет размещён египетский регион. Ещё в 2019 году Huawei сообщала о намерении арендовать ЦОД Telecom Egypt в Каире, но, похоже, с тех пор планы по экспансии в Африке и на Ближнем Востоке изменились. Заодно Huawei поделилась планами создания облачного ИИ-центра в Гонконге. Хотя компания имеет несколько подобных объектов на материковой территории КНР, в Гонконге пока ничего подобного у неё нет. При этом в компании назвали ИИ одним из приоритетов для её облачных проектов. Сейчас у оператора есть облачные объекты в материковом Китае и Гонконге, Ирландии, Нидерландах, Франции, Таиланде, Сингапуре, Индонезии, Саудовской Аравии, Турции, Южной Африке, Бразилии, Аргентине, Перу, Чили и других странах. В то же время многие государства по-прежнему считают компанию поставщиком услуг с высоким риском из-за вероятных тесных связей с китайскими властями и крайне напряжённых отношений с США.

27.02.2024 [16:18], Руслан Авдеев

Южная Корея планирует построить ещё один кампус ЦОД ёмкостью 1 ГВтВ Южной Корее готовятся создать крупный кластер ЦОД ёмкостью 1 ГВт — кампус будет построен в провинции Канвондо (Gangwon ). По данным Datacenter Dynamics, площадка расположена близ населённых пунктов Каннын и Донхэ на востоке страны и потенциально сможет вместить до 50 объектов ёмкостью 20 МВт каждый. Это будет уже второй кампус такой ёмкости, строительство которого запланировано в Южной Корее. В прошлом году власти анонсировали создание крупного комплекса, включающего до 25 ЦОД по 45 МВт, в провинции Южная Чолла (South Jeolla). Эти дата-центры будут строиться поэтапно до 2037 года, первая фаза предусматривает возведение пяти объектов и подстанции мощностью 300 МВт к 2027 году.

Источник изображения: Daniel Bernard/unsplash.com Как сообщают отраслевые источники, корейское Министерство торговли, промышленности и энергетики (Ministry of Trade, Industry, and Energy) поддержало проект и поможет использовать энергию, генерируемую кластером электростанций региона. В провинции находятся несколько угольных и атомных электростанций, но у них есть проблемы с транспортировкой энергии на дальние расстояния и другие ограничения. По словам одного из источников, на восточном побережье страны имеются проблемы с малой энергоёмкостью местной инфраструктуры. Прямые продажи близлежащим ЦОД позволят электростанциям экономить около 20 % ежегодных эксплуатационных расходов. К счастью, недавно принятые законы теперь позволяют напрямую продавать энергию местным потребителям. Правительство намерено организовать строительство ЦОД на уже существующих промышленных площадках, а также на неиспользуемой земле. Дополнительно правительство инвестирует в два ЦОД, предназначенных для поддержки разработки ИИ-чипов. Эти дата-центры будут способствовать росту новых отраслей.

27.02.2024 [16:08], Сергей Карасёв

Supermicro анонсировала ИИ- и телеком-серверы на базе AMD EPYC Siena, Intel Xeon Emerald Rapids и NVIDIA Grace Hopper

5g

amd

emerald rapids

epyc

gh200

grace

hardware

intel

mwc 2024

nvidia

siena

supermicro

ии

периферийные вычисления

сервер

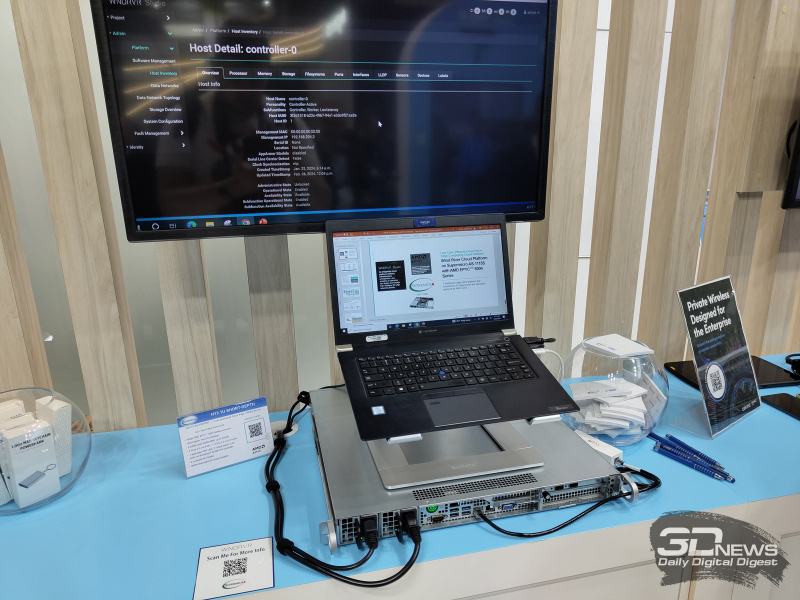

Компания Supermicro представила на выставке мобильной индустрии MWC 2024 в Барселоне (Испания) новые серверы для телекоммуникационной отрасли, 5G-инфраструктур, задач ИИ и периферийных вычислений. Дебютировали модели с процессорами AMD EPYC 8004 Siena, Intel Xeon Emerald Rapids и с суперчипами NVIDIA GH200 Grace Hopper. В частности, анонсирована стоечная система ARS-111GL-NHR высокой плотности в форм-факторе 1U на базе GH200. Устройство наделено двумя слотами PCIe 5.0 x16, восемью фронтальными отсеками для накопителей E1.S NVMe и двумя коннекторами для модулей M.2 NVMe. Сервер предназначен для работы с генеративным ИИ и большими языковыми моделями (LLM). На периферийные 5G-платформы ориентировано решение SYS-211E ультрамалой глубины — 298,8 мм. Модель рассчитана на один процессор Xeon Emerald Rapids в исполнении LGA-4677. Есть восемь слотов для модулей DDR5-5600 общей ёмкостью до 2 Тбайт и до шести слотов PCIe 5.0 в различных конфигурациях для карт расширения. Модификация SYS-211E-FRDN13P для сетей Open RAN предлагает 12 портов 25GbE и поддерживает технологию Intel vRAN Boost. Ещё одна новинка — сервер AS-1115S-FWTRT формата 1U с возможностью установки одного процессора EPYC 8004 Siena (до 64 ядер). Реализована поддержка до 576 Гбайт памяти DDR5-4800 (шесть слотов), двух портов 10GbE, двух слотов PCIe 5.0 x16 FHFL и одного слота PCIe 5.0 x16. Решение предназначено для edge-приложений.

Представлены также многоузловая платформа SYS-211SE-31D/A и система высокой плотности SYS-221HE: обе модели выполнены в формате 2U на процессорах Xeon Emerald Rapids. Второй из этих серверов допускает монтаж до трёх двухслотовых ускорителей NVIDIA H100, A10, L40S, A40 или A2. Наконец, анонсирован сервер AS-1115SV типоразмера 1U с поддержкой процессоров EPYC 8004 Siena, 576 Гбайт памяти DDR5, трёх слотов PCIe 5.0 x16 и 10 накопителей SFF.

27.02.2024 [13:37], Сергей Карасёв

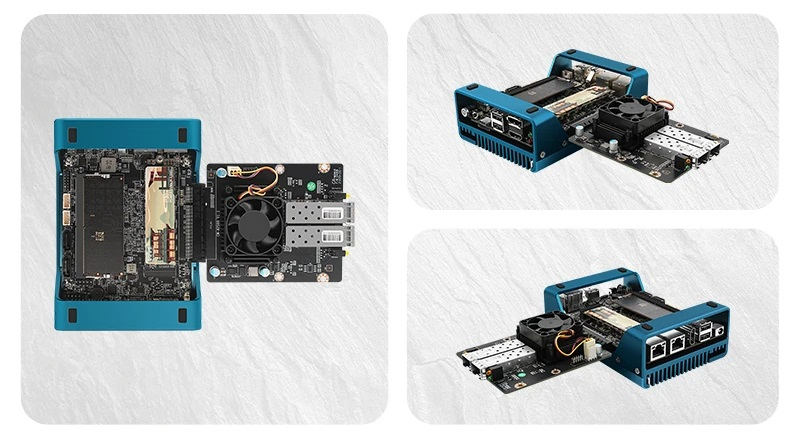

Необычный одноплатный компьютер CWWK Magic Computer на базе Intel Alder Lake-N оснащён слотом PCIe x8Китайская компания CWWK, по сообщению ресурса Liliputing, анонсировала необычный компактный компьютер Magic Computer, на основе которого могут создаваться различные сетевые устройства, оборудование для Интернета вещей, системы хранения и пр. В основу положена аппаратная платформа Intel Alder Lake-N. Изделие имеет оригинальное исполнение. По сути, это одноплатный компьютер, который закреплен в нижней области радиатора охлаждения, одновременно выполняющего функции подставки. Такая конструкция повышает эффективность отвода тепла, но оставляет саму плату незащищённой от внешних воздействий. Доступны модификации с разными процессорами Alder Lake-N, а максимальная конфигурация включает чип Core i3-N305 (8 ядер; 8 потоков; до 3,8 ГГц; 15 Вт). Объём оперативной памяти DDR5-4800/5200/5600 может достигать 32 Гбайт (один слот SO-DIMM). Есть коннектор M.2 (PCIe 3.0 x1) для накопителя формата 2242/2280 (NVMe), два порта SATA-3 и слот microSD. Кроме того, присутствует разъём PCIe x8 (PCIe 3.0 x4) для подключения различных карт расширения, например, сетевого адаптера.

Источник изображения: AliExpress/CWWK Store Устройство располагает двумя коннекторами HDMI 1.4, интерфейсами DisplayPort 1.4 и USB Type-C (DisplayPort Alt mode), двумя сетевыми портами 2.5GbE RJ-45 на базе Intel i226-V, четырьмя портами USB 2.0. Через разъёмы на плате можно задействовать дополнительные интерфейсы, включая последовательный порт. Питание (12–19 В) подаётся через DC-разъём (5,5/2,5 мм) или 4-контактный коннектор. Габариты мини-компьютера составляют 144 × 100 × 48 мм. Диапазон рабочих температур — от 0 до +70 °C. Цена начинается с $214 за barebone-систему и достигает $520 за вариант с 32 Гбайт ОЗУ и SSD вместимостью 2 Тбайт.

27.02.2024 [13:25], Сергей Карасёв

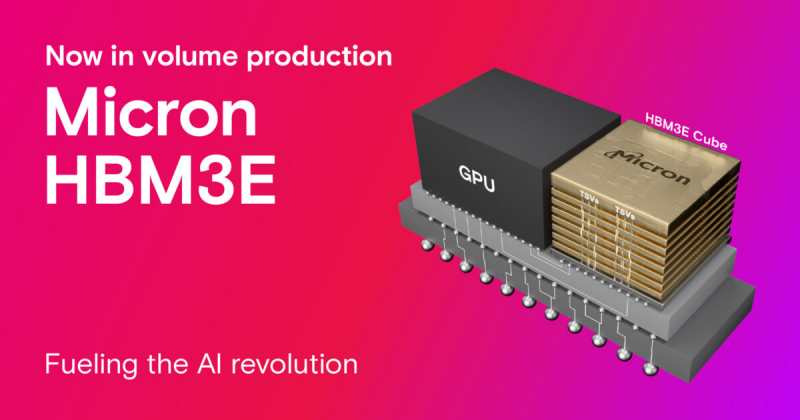

Micron начала массовое производство памяти HBM3E для ускорителей NVIDIA H200Компания Micron Technology объявила о начале массового производства передовой памяти HBM3E. Речь идёт об изделиях ёмкостью 24 Гбайт, предназначенных для ИИ-ускорителей NVIDIA H200, которые появятся на коммерческом рынке во II квартале нынешнего года. Чипы Micron HBM3E выполнены в виде 8-ярусного стека. Заявленная скорость передачи данных превышает 9,2 Гбит/с на контакт, а общая пропускную способность сборки превосходит 1,2 Тбайт/с. Вместе с тем, как утверждается, изделия потребляют примерно на 30 % меньше энергии по сравнению с решениями конкурентов. Micron подчёркивает, что чипы HBM3E объёмом 24 Гбайт позволяют дата-центрам беспрепятственно масштабировать различные ИИ-нагрузки — от обучения сложных нейронных сетей до ускорения инференса. Изделия выполнены по технологии 1β (1-бета) — самому передовому техпроцессу компании. Кроме того, применены другие современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Micron также сообщила, что уже в марте нынешнего года начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт. Они, как и изделия на 24 Гбайт, обеспечат пропускную способность свыше 1,2 Тбайт/с при высокой энергетической эффективности. |

|