Материалы по тегу: amd

|

05.09.2025 [15:30], Руслан Авдеев

«Мрачная научная фантастика»: США намерены заставить NVIDIA и AMD продавать ИИ-ускорители американцам в приоритетном порядкеАмериканские законодатели намерены применить принцип «Америка превыше всего» к продаже передовых полупроводников, предполагающий право преимущественного приобретения чипов местными компаниями, сообщает The Register. В законопроекте «О гарантиях доступа и инноваций для национального ИИ» (GAIN AI Act), представляющим собой поправки в «Закон о национальной обороне», заявляется, что организации США, включая стартапы и университеты, должны получать наилучшие возможности для инноваций и использования потенциала искусственного интеллекта. Если законопроект будет одобрен Конгрессом США и президентом, экспортёров ждут важные изменения. Желающие получить экспортные лицензии в страны, «вызывающие обеспокоенность», должны будут подтвердить, что весь внутренний спрос на их продукцию удовлетворён, а американские покупатели имели приоритетный доступ к чипам. Министерство торговли США будет отказывать в выдаче лицензий на экспорт наиболее производительных ИИ-чипов, если американские организации ожидают поставок. При этом, согласно новым правилам, под экспортные ограничения попадут не только серверные ускорители, но и игровые GPU класса RTX 5090. Вполне ожидаемо, в NVIDIA не восторге от возможных изменений. В компании называют такие правила «мрачной научной фантастикой» — продажи по всему миру якобы ничего не лишают американских клиентов, а лишь расширяют рынок для многих американских бизнесов и целых отраслей. «Подкидывающие» Конгрессу фейковые новости эксперты лишают Америку шанса на лидерство в сфере ИИ, заявляют в NVIDIA. Глава компании Дженсен Хуанг (Jensen Huang) неоднократно говорил, что запреты только помогают Китаю развивать собственные ИИ-компетенции.

Источник изображения: Joe Richmond/unsplash.com NVIDIA считает, что GAIN AI Act опирается на ошибочную логику и фундаментальное непонимание работы цепочек поставок. В документе утверждается, что спрос на ускорители сейчас значительно превышает предложение, но именно так, по мнению NVIDIA, и должен работать свободный рынок. Более того, сами по себе чипы бесполезны, если их негде развернуть. Нужны современные ЦОД, оснащённые современными же системами охлаждения, электропитания и др. По словам Хуанга, NVIDIA отдаёт приоритет покупателям, готовым внедрять новые решения, а иначе ускорители и оборудование будут без дела лежать на складах. Стоит отметить, что законопроект GAIN AI Act запрещает и производство передовых чипов специально для стран, «вызывающих обеспокоенность». Это весьма недвусмысленная отсылка к урезанным ускорителям NVIDIA H20 и AMD MI308 для китайского рынка. Летом США одобрила возобновление их экспорта в обмен на 15 % от всей выручки таких поставок. В GAIN AI Act также утверждается, что большее количество чипов для КНР означает меньшее количество чипов для США, но в законопроекте не учитывается, насколько слабее «оптимизированные» для КНР. H20 основана на технологии трёхлетней давности и практически на порядок менее производителен, чем чипы Blackwell, продаваемые американским клиентам. Более того, H20 опирается на старый техпроцессе TSMC, который не может использоваться для выпуска Blackwell (как рассчитывают авторы законопроекта). Другими словами, новый закон может лишь закрыть крупный рынок для NVIDIA и AMD, в то же время способствуя появлению всё более конкурентоспособных китайских полупроводников.

05.09.2025 [11:39], Сергей Карасёв

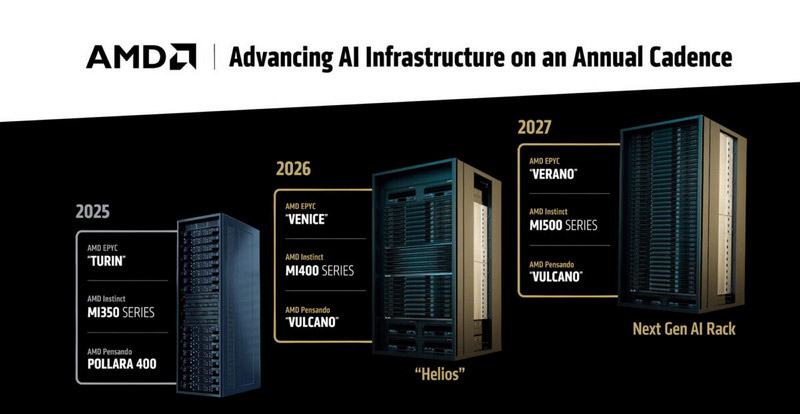

AMD готовит суперускоритель Mega Pod с 256 ускорителями Instinct MI500Компания AMD, по сообщению ресурса Tom's Hardware, готовит платформу MI500 Scale Up MegaPod для наиболее ресурсоёмких нагрузок ИИ. Эта система, как ожидается, выйдет в 2027 году и составит конкуренцию стоечным решениям NVIDIA следующего поколения. Известно, что в основу MI500 Scale Up MegaPod лягут 64 процессора EPYC поколения Verano и 256 ускорителей серии Instinct MI500. Для сравнения: платформа AMD Helios, выход которой запланирован на 2026 год, сможет объединять до 72 ускорителей Instinct MI400, тогда как в состав системы NVIDIA NVL576 на основе стойки Kyber войдут 144 ускорителя поколения Rubin Ultra. В конструктивном плане MI500 Scale Up MegaPod, согласно имеющейся информации, будет представлять собой платформу с тремя серверными стойками. В боковых разместятся по 32 вычислительных лотка с одним процессором EPYC Verona и четырьмя ИИ-ускорителями Instinct MI500, тогда как центральная стойка получит 18 лотков, предназначенных для коммутаторов UALink. В целом, в состав системы войдут 64 узла, насчитывающих в общей сложности 256 ускорителей.

Источник изображения: AMD По сравнению с NVIDIA NVL576 со 144 ускорителями новая платформа AMD обеспечит примерно на 78 % больше карт в расчёте на систему. Однако пока не ясно, сможет ли AMD MI500 Scale Up MegaPod превзойти решение NVIDIA по производительности: NVL576, как ожидается, получит 147 Тбайт памяти HBM4, тогда как быстродействие этой системы будет достигать 14 400 Пфлопс на операциях FP4. Отмечается также, что для AMD MI500 Scale Up MegaPod предусмотрено использование исключительно жидкостного охлаждения — как для вычислительных, так и для сетевых узлов. Предполагается, что система поступит в продажу в конце 2027 года — примерно в то же время, когда, вероятно, дебютирует NVIDIA NVL576.

01.09.2025 [12:05], Сергей Карасёв

Giga Computing представила блейд-серверы B-series на платформах AMD и IntelКомпания Giga Computing, подразделение Gigabyte, объявила о выходе на рынок блейд-серверов, оптимизированных для корпоративных, периферийных и облачных рабочих нагрузок. Первыми системами данного класса стали устройства B343-C40 на аппаратной платформе AMD и B343-X40 с процессорами Intel. Все новинки выполнены в форм-факторе 3U с 10-узловой конфигурацией. Серверы B343-C40 могут комплектоваться чипами EPYC 4005 Grado или Ryzen 9000 с показателем TDP до 170 Вт (один CPU на узел). Доступны четыре слота для модулей оперативной памяти DDR5-5600/3600 в расчете на узел. Каждый из узлов также предлагает слот M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x1, два посадочных места для SFF-накопителей NVMe/SATA, один разъём для карты расширения FHHL с интерфейсом PCIe 5.0 x16 и три слота OCP NIC 3.0 (PCIe 4.0 x4). В семейство B343-C40 вошли три модификации — B343-C40-AAJ1, B343-C40-AAJ2 и B343-C40-AAJ3, у которых каждый из узлов располагает соответственно двумя портами 1GbE (контроллер Intel I350-AM2), 10GbE (Broadcom BCM57416) и 25GbE (Broadcom BCM57502). Кроме того, во всех случаях предусмотрен выделенный сетевой порт управления 1GbE и контроллер ASPEED AST2600 (на узел). За питание системы в целом отвечают четыре блока мощностью 2000 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур — от +10 до +30 °C. Применяется воздушное охлаждение. В свою очередь, у сервера B343-X40 каждый из узлов может оснащаться одним процессором Xeon 6300 с TDP до 95 Вт. Реализованы четыре слота для модулей DDR5-4400/4000/3600 и два порта 1GbE на основе контроллера Intel I350-AM2 (в расчёте на узел). В остальном технические характеристики аналогичны AMD-версиям. При этом в систему установлены два блока питания мощностью 3200 Вт с сертификатом 80 PLUS Titanium.

29.08.2025 [23:15], Владимир Мироненко

11,5 Пбайт в 2U: Novodisq представил блейд-сервер для ИИ и больших данныхСтартап Novodisq представил блейд-сервер формата 2U ёмкостью 11,5 Пбайт с функцией ускорения ИИ и др. задач. Гиперконвергентная кластерная система разработан для замены или дополнения традиционных решений NAS, SAN и публичных облачных сервисов. Новинка поддерживает платформы Ceph, MinIO и Nextcloud (также планируется поддержка DAOS), предлагая доступ по NFS, iSCSI, NVMe-oF и S3. Сервер содержит до 20 модулей Novoblade с фронтальной загрузкой. В каждом из них имеется до четырёх встроенных E2 SSD Novoblade объёмом 144 Тбайт каждый, на базе TLC NAND с шиной PCIe 4.0 x4. Накопители поддерживают NVMe v2.1 и ZNS, обеспечивая последовательную производительность чтения/записи до 1000 Мбайт/с, а на случайных операциях — до 70/30 тыс. IOPS. Надёжность накопителей составляет до 24 PBW. Энергопотребление: от 5 до 10 Вт. Система Novoblade предназначена для «тёплого» и «холодного» хранения данных. Модули Novoblade объединяют вычислительные возможности, ускорители и хранилища. Основной модулей являются гибридные SoC AMD Versal AI Edge Gen 2 (для ИИ-нагрузок) или Versal Prime Gen 2 (для традиционных вычислений) c FPGA, 96 Гбайт DDR5, 32 Гбайт eMMC, модулем TPM2 и двумя интерфейсам 10/25GbE с RoCE v2 RDMA и TSN. Энергопотребление не превышает 60 Вт. Есть функции шифрования накопителей, декодирования видео, ускорения ИИ-обработки, оркестрации контейнеров и т.д. Платформа специально разработана для задач с большими объёмами данных, таких как геномика, геопространственная визуализация, видеоархивация и периферийные ИИ-вычисления. Сервер может работать под управлением стандартных дистрибутивов Linux (RHEL и Ubuntu LTS) с поддержкой Docker, Podman, QEMU/KVM, Portainer и OpenShift. 2U-шасси глубиной 1000 мм рассчитано на установку до двадцати модулей Novodisq и оснащено двумя (1+1) БП мощностью 2600 Вт каждый (48 В DC). Возможно горизонтальное масштабирование с использованием каналов 100–400GbE. В базовой конфигурации шасси включает четыре 200GbE-модуля с возможностью горячей замены, каждый из которых имеет SFP28-корзины, а также управляемый L2-коммутатор. Предусмотрен набор средств управления, включая BMC с веб-интерфейсом, CLI и поддержкой API Ansible, SNMP и Redfish. Novoblade поддерживает локальное и удалённое управление, может интегрироваться в существующий стек или предоставляться с помощью инструментов «инфраструктура как код» (Infrastructure-as-Code). По словам разработчика, система Novoblade обеспечивает плотность размещения примерно в 10 раз выше, чем у сервера на основе жестких дисков, и снижает энергопотребление на 90–95 % без необходимости в механическом охлаждении. Novodisq утверждает, что общая стоимость владения системой «обычно на 70–90 % ниже, чем у традиционных облачных или корпоративных решений в течение 5–10 лет». «Это обусловлено несколькими факторами: уменьшенным пространством в стойке, низким энергопотреблением, отсутствием платы за передачу данных, минимальным охлаждением, длительным сроком службы и значительным упрощением управления. В отличие от облака, ваши расходы в основном фиксированы, а значит, предсказуемы, и, в отличие от традиционных систем, Novodisq не требует дорогостоящих лицензий, внешних контроллеров или постоянных циклов обновления. Вы получаете высокую производительность, долгосрочную надёжность и более высокую экономичность с первого дня», — приводит Blocks & Files сообщение компании. Для сравнения, узлы Dell PowerScale F710 и F910 на базе 144-Тбайт Solidigm SSD ёмкостью 122 Тбайт, 24 отсеками в 2U-шасси и коэффициентом сжатия данных 2:1 обеспечивают почти 6 Пбайт эффективной емкости, что почти вдвое меньше, чем у сервера Novoblade.

28.08.2025 [22:32], Владимир Мироненко

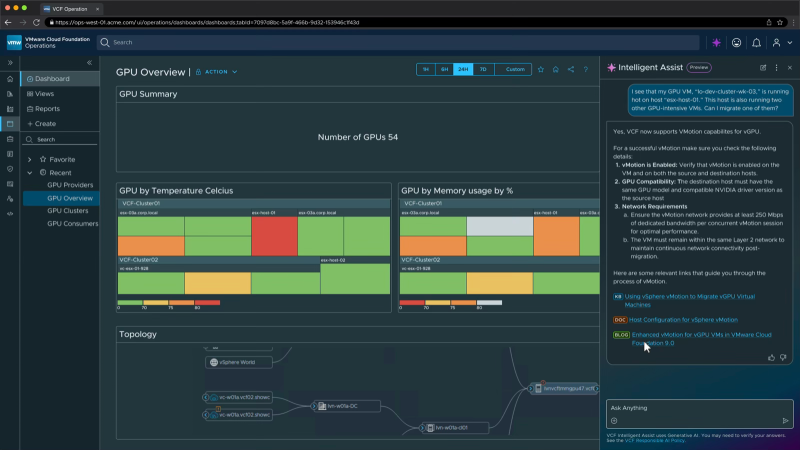

Broadcom интегрировала в VCF ИИ-сервисы и поддержку новейших ускорителей AMD и NVIDIA — всё это будет доступно бесплатноBroadcom объявила об интеграции ИИ-сервисов VMware Private AI в платформу VMware Cloud Foundation (VCF) без дополнительных затрат для клиентов. Компании смогут пользоваться ИИ-функциями в рамках подписки на VCF, начиная с I квартала 2026 года. По словам компании, это упростит и ускорит внедрение новых ИИ-сервисов заказчиков. Некоторые эксперты считают, что дальнейшая модернизации VMware и повышение привлекательности пакета VCF для компаний благодаря интеграции частных ИИ-сервисов могут стать важным шагом для сохранения клиентской базы VMware. Компании получат множество преимуществ: от расширенного планирования инфраструктуры и балансировки нагрузки, предоставляемых с помощью распределенного планировщика ресурсов (DRS), до схем автоматизации, позволяющих развёртывать сложные ИИ-сервисы за считанные минуты, используя оптимизированные драйверы устройств, ядра для конкретных ускорителей и многое другое, обещает Broadcom. VMware Private AI Services помогут компаниям развёртывать и управлять ИИ-приложениями в современной частной облачной инфраструктуре, сохраняя конфиденциальность и безопасность данных. ИИ-сервисы включают среду выполнения моделей, хранилище моделей, мониторинг ускорителей, службу индексации и поиска данных, векторную базу данных, шлюз API и конструктор ИИ-агентов. Целью проекта является создание более интегрированного, безопасного и удобного для разработчиков решения, которое будет выглядеть и работать как публичное облако с точки зрения получения услуг, безопасности и масштабируемости. Это означает большую автоматизацию, больше API и лучшую прозрачность производительности и затрат, отметил ресурс SiliconANGLE. Разработчикам будет помогать генеративный ИИ-помощник VCF Intelligent Assist. Он поможет диагностировать и решить проблемы инфраструктуры, используя базу знаний Broadcom. В дальнейшем будет добавлена функция автоматического исправления ошибок. Broadcom сообщила, что в ближайшее время VCF 9.0 получит поддержку протокола Model Context Protocol (MCP), позволяющего ИИ-агентам подключаться к внешним источникам данных и инструментам и использовать их для совместной работы с другими агентами. Также платформа будет поддерживать функцию Multi-accelerator Model Runtime, которая обеспечивает гибкое развёртывание ИИ-моделей на различном оборудовании, включая ускорители AMD и NVIDIA. Кроме того, клиенты получат многопользовательский доступ к моделям (Multi-tenant Models-as-a-service), что поможет снизить затраты за счёт безопасного доступа арендаторов или отдельных подразделений к общим ИИ-моделям. Broadcom добавила в платформу VCF поддержку оборудования и ПО NVIDIA, в том числе систем Blackwell, включая RTX Pro 6000, и адаптеров ConnectX-7. Также Broadcom заявила о сотрудничестве с AMD, что позволит организациям использовать VCF с ускорителями AMD Instinct серии MI350 и ПО ROCm. Заодно Broadcom объявила о расширенном сотрудничестве с Canonical, благодаря которому клиенты смогут использовать Ubuntu в своих частных облаках с полной корпоративной поддержкой, включая ускоренное управление патчами и повышенную кибербезопасность.

26.08.2025 [22:13], Руслан Авдеев

IBM и AMD займутся разработкой новых вычислительных архитектур на стыке квантовых и классических подходовAMD и IBM анонсировали разработку нового поколения вычислительных архитектур, в основе которых лежат квантовые компьютеры и HPC-системы. Речь идёт о т.н. «квантово-центричных супервычислениях», сообщает пресс-служба AMD. Команды намерены продемонстрировать первые результаты до конца текущего года. Компании сотрудничают над разработкой масштабируемых, open source платформ, способствующих переосмыслению будущего вычислений с использованием лидерства IBM в сфере квантовых компьютеров и ПО для них, а также ведущей роли AMD в сфере HPC и ИИ-ускорителей. По словам главы IBM Арвинда Кришны (Arvind Krishna), квантовые вычисления со временем позволят «симулировать» реальный мир и представлять информацию принципиально новым способом. Комбинация технологий IBM и AMD позволят построить мощную гибридную модель, оставляющую позади традиционные вычисления. В новой архитектуре квантовые компьютеры будут работать в тандеме с HPC-кластерами и ИИ-инфраструктурой с использованием CPU, ИИ-ускорителей и прочих вычислительных модулей. При таком гибридном подходе различные части задачи решаются оптимальным для них типом оборудования. Например, в будущем квантовые компьютеры смогут моделировать поведение атомов и молекул, а классические ИИ-суперкомпьютеры — анализировать большие массивы данных. Вместе эти технологии смогут решать реальные задачи в беспрецедентном масштабе и с беспрецедентной скоростью, говорят компании.

Источник изображения: Yue WU/unsplash.com Компании изучают способы интеграции CPU, FPGA и ИИ-ускорителей AMD с квантовыми компьютерами IBM для совместного ускорения выполнения принципиально новых алгоритмов. Ключевым планом сотрудничества является разработка систем коррекции ошибок, что является важнейшим шагом на пути к созданию отказоустойчивых квантовых компьютеров, которые IBM планирует выпустить к 2030 году. Также компании планируют изучить, как именно open source решения вроде Qiskit могли бы выступить катализаторами развития и внедрения новых алгоритмов, использующих квантово-центричные супервычисления. IBM уже начала работать в направлении интеграции квантовых и традиционных систем. Недавно она заключила соглашение с японским НИИ RIKEN о подключении своего модульного квантового компьютера IBM Quantum System Two к одному из самых быстрых суперкомпьютеров мира Fugaku. Суперкомпьютеры Frontier в Ок-Риджской национальной лаборатории (ORNL) и El Capitan в Ливерморской национальной лаборатории (LLNL) полагаются на CPU и ускорители AMD. Другими словами, на чипах AMD работают два из быстрейших суперкомпьютеров из мирового рейтинга TOP500.

16.08.2025 [14:45], Сергей Карасёв

Dell представила ИИ-серверы PowerEdge R7725 и R770 на базе NVIDIA RTX Pro 6000 Blackwell Server EditionКомпания Dell анонсировала серверы PowerEdge R7725 и PowerEdge R770 в форм-факторе 2U, построенные на аппаратной платформе AMD и Intel соответственно. Новинки оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition. Модель PowerEdge R7725 может нести на борту два процессора AMD EPYC 9005 (Turin), а также до 6 Тбайт оперативной памяти DDR5-6400 в виде 24 модулей. Доступны до восьми слотов PCIe 5.0 x8 или x16. При этом возможна установка двух GPU-ускорителей. Сервер предлагает различные варианты исполнения подсистемы хранения данных с фронтальным доступом: 12 × LFF SAS/SATA, 8/16/24 × SFF SAS/SATA, 16 × SFF SAS/SATA + 8 × U.2/NVMe или 8/16/32/40 × EDSFF E3.S. Имеется выделенный сетевой порт управления 1GbE, а дополнительно предлагается установка адаптеров с поддержкой 1GbE, 10GbE, 25GbE, 100GbE и 400GbE. В свою очередь, вариант PowerEdge R770 комплектуется двумя чипами Intel Xeon 6 Granite Rapids с производительными Р-ядрами или Xeon 6 Sierra Forest с энергоэффективными Е-ядрами. Реализованы 32 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 8 Тбайт. Предлагается широкий набор опций в плане установки накопителей в лицевой и тыльной частях корпуса, включая 24 × SFF SAS/SATA и 40 × EDSFF E3.S. Система может быть укомплектована четырьмя картами OCP NIC 3.0 (вплоть до 400GbE). Есть слоты PCIe 5.0 x8 и x16. Серверы поддерживают воздушное и прямое жидкостное охлаждение (DLC). Мощность блоков питания с сертификатом 80 Plus Titanium достигает 3200 Вт. Заявлена совместимость с Canonical Ubuntu Server LTS, Windows Server (Hyper-V), Red Hat Enterprise Linux, SUSE Linux Enterprise Server и VMware ESXi.

13.08.2025 [11:51], Сергей Карасёв

HPE представила серверы ProLiant с ускорителями NVIDIA RTX Pro 6000 Blackwell Server EditionКомпания HPE анонсировала серверы ProLiant DL385 Gen11 и ProLiant Compute DL380a Gen12, построенные соответственно на аппаратной платформе AMD и Intel. Устройства оснащаются ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition, которые ориентированы на требовательные приложения ИИ и рендеринг высококачественной графики. Модель ProLiant DL385 Gen11 выполнена в форм-факторе 2U. Она может нести на борту два процессора AMD EPYC 9004 (Genoa) или EPYC 9005 (Turin), а также до 6 Тбайт оперативной памяти DDR5-6000 в конфигурации 12 × 512 Гбайт. Поддерживаются до восьми слотов PCIe 5.0 и до двух слотов OCP. Установлены две карты RTX Pro 6000 Blackwell Server Edition. В зависимости от модификации во фронтальной части могут располагаться до 12 отсеков для накопителей LFF HDD/SSD с интерфейсом SAS/SATA, до 24 отсеков для устройств SFF HDD/SSD (SAS/SATA/NVMe), до 36 посадочных мест для изделий EDSFF E3.S 1T или до 48 отсеков для SFF HDD/SSD.  Внутри могут размещаться до восьми устройств SFF SAS/SATA/NVMe или до четырёх LFF SAS/SATA, сзади — два накопителя SFF SAS/SATA/NVMe или четыре LFF SAS/SATA. Кроме того, есть два коннектора M.2 NVMe. Применяется воздушное охлаждение с возможностью опционального развёртывания прямого жидкостного охлаждения Direct Liquid Cooling (DLC). Мощность блоков питания — до 2200 Вт. Сервер оснащён системой удалённого управления iLO 6.  В свою очередь, ProLiant Compute DL380a Gen12 имеет формат 4U. Это устройство комплектуется двумя чипами Intel Xeon 6, насчитывающими до 144 ядер. Объём оперативной памяти DDR5 достигает 4 Тбайт в виде 32 модулей. Допускается установка до восьми GPU, накопителей SFF (NMVe) и EDSFF. Питание обеспечивают восемь блоков. Упомянута система HPE iLO 7. В продажу данная модель поступит в сентябре текущего года.

11.08.2025 [10:55], Руслан Авдеев

NVIDIA и AMD будут выплачивать правительству США 15 % выручки от продажи ИИ-ускорителей в КитаеNVIDIA и AMD пришли к соглашению с американскими властями, в результате которого компании будут обязаны отдавать правительству США 15 % выручки от продажи ИИ-ускорителей в КНР. За это они будут получать лицензии на продажу полупроводников в Поднебесную, сообщает The Financial Times. Как свидетельствуют «осведомлённые источники», экспортные лицензии для китайского рынка получены на днях именно на таких условиях. По словам источника из числа чиновников, NVIDIA согласилась платить за поставки H20 в Китай, AMD придётся раскошелиться за продажи MI308. Как сообщает издание, Министерство торговли США начало выдавать экспортные лицензии на H20 в минувшую пятницу, через два дня после встречи главы NVIDIA Дженсена Хуанга (Jensen Huang) с президентом США Дональдом Трампом (Donald Trump). Ранее Хуанг жёстко раскритиковал ограничения на поставки ИИ-ускорителей в Китай, заявив, что это станет для КНР лишь дополнительным стимулом для развития собственных технологий. По данным источников, лицензии начали выдавать и AMD. Стоит отметить, что такое соглашение считается «беспрецедентным». По словам экспертов, ни одна компания в истории США не соглашалась платить часть выручки за получение экспортных лицензий. Впрочем, вполне вероятно, что администрация США собирает все доступные средства для реиндустриализации самих Соединённых Штатов. Сами вендоры ситуацию не комментируют и лишь заявили, что следуют установленным правительством правилам для обеспечения своего присутствия на мировых рынках.

Источник изображения: Priscilla Du Preez/unsplash.com По словам аналитиков Bernstein, до введения экспортных ограничений прогнозировалось, что NVIDIA могла бы продать в 2025 году Китаю порядка 1,5 млн ускорителей H20, что принесло бы около $23 млрд выручки. В апреле администрация США объявила о запрете поставок H20 в Китай, но этим летом изменила своё решение после встречи с Хуангом. Однако Бюро промышленности и безопасности (BIS) так и не начало выдавать экспортные лицензии до прошлой пятницы. Некоторые американские эксперты по безопасности подчёркивают ошибочность решения, утверждая, что H20 поможет военным КНР и подорвёт лидерство США в сфере ИИ. Некоторые горько шутят, что дальше, вероятно, стоит ожидать продаж Китаю F-35 при условии уплаты 15 % комиссии правительству. Не так давно 20 экспертов по безопасности направили в администрацию письмо, в котором призывали на выдавать лицензии на продажи H20 в Китай. По их словам, это всё ещё достаточно мощный ускоритель, который в конечном счёте будет использоваться китайскими военными. В самой NVIDIA такие предположения опровергают. В субботу, 9 августа, было заявлено, что H20 уже несколько месяцев не поставляются в Китай, но в компании надеются, что экспортные правила позволят Америке конкурировать в Китае и во всём мире. Американский стек ИИ-технологий может стать мировым стандартом при глобальном распространении своих технологий. Сейчас между США и Китаем ведутся торговые переговоры, которые, как надеются в администрации США, будут содействовать организации саммита между президентом Трампом и председателем КНР Си Цзиньпином. Министерству торговли уже приказали заморозить новые меры экспортного контроля в отношении КНР, чтобы не испортить отношения с Пекином. Опасения экспертов возникли на фоне усилий КНР, предпринимаемых чтобы смягчить контроль над поставками HBM-чипов, которые являются важнейшим компонентом современных ИИ-ускорителей. Ещё до ослабления запретов выяснилось, что в КНР «просочились» передовые ускорители NVIDIA на $1 млрд, а в конце июля появилась новость, что NVIDIA заказала у TSMC производство 300 тыс. ИИ-ускорителей H20 в ответ на высокий спрос в Китае — в дополнение к уже имеющимся запасам.

06.08.2025 [10:14], Сергей Карасёв

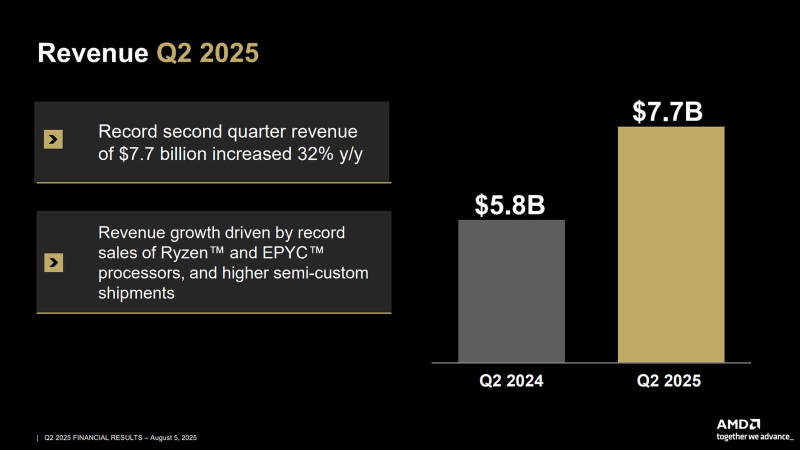

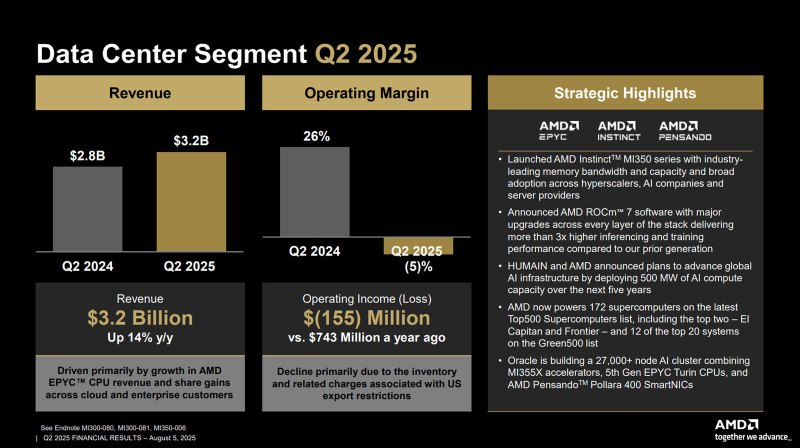

Квартальная выручка AMD в сегменте ЦОД выросла на 14 %, несмотря на упавшие продажи InstinctКомпания AMD отчиталась о работе во II четверти 2025 финансового года, которая была закрыта 28 июня. Выручка достигла $7,7 млрд, что является рекордным результатом: это на 32 % больше по сравнению с предыдущим годом, когда компания получила около $5,8 млрд. Вместе с тем компания не совсем удовлетворена результатами, поскольку обещанных разрешений на поставки ускорителей MI308 в Китай она так и не дождалась. Чистая прибыль AMD увеличилась в годовом исчислении на 229 % — с $265 млн до $872 млн. Прибыль в пересчёте на одну ценную бумагу составила $0,54: для сравнения, во II квартале предыдущего финансового года она равнялась $0,16. Однако компания зафиксировала операционные убытки в размере $134 млн, тогда как годом ранее была показана операционная прибыль на уровне $269 млн. В сегменте дата-центров квартальная выручка AMD достигла $3,2 млрд: это на 14 % больше по сравнению с предыдущим годом, когда был показан результат в $2,8 млрд. Но по отношению к I четверти 2025-го отмечено снижение на 12 %: в январе–марте поставки ЦОД-решений принесли $3,7 млрд. Операционные убытки подразделения дата-центров составили $155 млн, тогда как во II квартале 2024 финансового года компания получила операционную прибыль в объёме $743 млн. В секторе встраиваемых систем квартальные продажи уменьшились в годовом исчислении на 4 % — с $861 млн до $824 млн. Операционная прибыль при этом сократилась на 20 %, составив $275 млн против $345 млн в 2024 году. AMD подчёркивает, что её решения применяются в 172 суперкомпьютерах из списка TOP500, включая две мощнейшие системы — с El Capitan в Ливерморской национальной лаборатории имени Лоуренса (LLNL) и Frontier в Национальной лаборатории Оук-Ридж (ORNL). Кроме того, платформы AMD служат основой 12 из 20 наиболее энергоэффективных систем в рейтинге Green500. В III квартале текущего финансового года AMD рассчитывает получить $8,7 млрд выручки ±$300 млн. Эксплуатационные расходы прогнозируются в размере $2,6 млрд. |

|